04.02.2026 à 08:00

Retravaillez vos PDFs sans crainte

Texte intégral (1503 mots)

Vous avez besoin de retravailler vos PDFs pour compléter un formulaire en ligne ? Voici pourquoi il ne faut pas utiliser de convertisseurs de PDF en ligne qui ne soient pas libres, même gratuits.

Un peu de vocabulaire, pour bien se comprendre :

- « en ligne » = sur internet, sur le réseau, sur le web, connecté

- « le cloud » = les lieux de stockage sur le réseau, là où se trouvent les éléments de votre Drive, les documents partagés, les données des bases de données…

- « en local » = sur votre ordinateur, hors connexion, injoignable depuis l’extérieur.

Les PDFs demandés sont très personnels

Nous devons de plus en plus souvent fournir des documents justificatifs au format PDF, sur les sites des administrations dématérialisées, que ce soit pour nous, pour aider une personne qui ne sait pas faire ou un étranger perdu dans la dématérialisation de la préfecture. Nous scannons des documents papier sur un copieur pour obtenir les documents PDFs puis nous les téléchargeons sur le formulaire de l’administration. Qu’il s’agisse de justificatifs d’identité, de nationalité, de domicile, de travail, diplômes, avis d’imposition, carte de séjour, convocation de la préfecture, permis de conduire ou attestation Vitale, il s’agit de documents personnels qui construisent notre identité. Nous devons donc veiller à ne pas les laisser dans un endroit non sûr.

Scanner les documents au format PDF puis finaliser les PDFs

Un premier conseil : nommez correctement, au fur et à mesure, chaque scan fourni par votre copieur. Par exemple, pour les différents scans des pages de votre passeport, nommez dans l’ordre : passeport1, passeport2, passeport3, et rangez-les dans son sous-dossier /passeport/. Quand vous devrez les réunir en un seul PDF, vous les trouverez dans l’ordre, sans avoir à les regarder pour vérifier.

Le copieur génère les PDFs, mais il nous faut souvent un outil pour les retravailler : réunir certaines pages en un seul document, mettre les pages dans l’ordre et à l’endroit, supprimer les pages inutiles, alléger le PDF final…

Pour cela, on peut utiliser un outil convertisseur en ligne, gratuit : voici pourquoi c’est une mauvaise idée et quel outil utiliser, à la place.

Le cloud, un endroit sûr pour les données personnelles ?

Votre convertisseur en ligne, comme iLovePDF (mais il y en a des dizaines d’autres), travaille vos documents sur le « cloud » (le réseau) : vous envoyez vos PDFs originaux sur le site de iLovePDF, il fait ce que vous lui demandez et vous livre le PDF final.

A noter que vous n’avez pas besoin de créer de compte personnel, tout est en libre accès, ce qui fait son succès. Mais l’avenir des documents est très incertain. Même s’il ne vous le dit pas, il y a de fortes chances qu’il conserve les PDFs envoyés et générés dans sa propre base de données.

Or, vous savez que les données en ligne, même les plus protégées, peuvent être piratées et récupérées par des personnes malveillantes (voir un article sur les cyberattaques en France, novembre 2025 ou le site « C’est qui qui a fuité aujourd’hui ?« ). Vous avez sûrement déjà reçu un mail vous expliquant le piratage de vos données sur l’un de vos comptes : moi, le dernier était la base de données de mon médecin…

Ces attaques valent pour les convertisseurs en ligne : « Attention, des fuites de données touchent ces deux outils PDF en ligne » (article de 2024).

Vos documents risquent donc d’être récupérés et utilisés par des escrocs. La proposition de certains convertisseurs de protéger le fichier en le chiffrant n’est pas sérieuse : il existe autant d’outils « déverrouilleurs de PDF » que d’outils qui les « verrouillent ».

Quels usages pour des escrocs ?

Il existe un important marché de documents de données personnelles, vendues au plus offrant sur des forums illégaux (voir l’article sur le vol des données de la Fédération de tir). Parmi les documents que vous avez retravaillés sur votre convertisseur en ligne, beaucoup peuvent servir à créer une nouvelle identité ou à usurper la vôtre.

En modifiant les documents avec un outil de retouche d’image (comme Photoshop ou Gimp), les pirates peuvent falsifier de vrais documents pour les attribuer à d’autres personnes, par exemple fournir une fausse convocation de la préfecture à un étranger, comportant son nom, son numéro d’étranger (la convocation se monnaye 300 euros). Ou usurper votre identité (voir l’article L’usurpation d’identité). Ou vous rendre visite à l’improviste, puisqu’ils ont votre adresse…

La solution : convertir les PDFs avec un outil sûr

La solution est d’utiliser un outil que vous installez sur votre ordinateur et qui travaille en local ou dont les serveurs sont sécurisés, c’est le cas des logiciels libres. Vos documents restent au chaud et ne s’en vont que dans le bon site web, celui de l’Etat qui vous l’a demandé pour votre démarche. Accessoirement, conserver une copie PDF de vos papiers est une bonne idée, en cas de perte ou de vol : prenez donc soin d’archiver régulièrement les données de votre ordinateur sur un disque dur externe (que de recommandations…).

Les étapes :

- Vous scannez vos documents sur le copieur, en les réunissant dans une clé USB

- Vous veillez à donner un nom clair à chaque document scanné et à les ranger dans un dossier spécifique

- Par la clé USB, vous les récupérez sur votre ordinateur.

- Vous utilisez un outil sûr pour retravailler les documents qui le nécessitent : regrouper les pages, les mettre à l’endroit et dans l’ordre, réduire le poids du PDF total, et vous continuez à donner un nom clair au PDF résultant

- Et vous ne mettez le document en ligne qu’au moment de compléter le formulaire.

Les outils libres, ou en local

- FramaPDF = https://framapdf.org/abc/fr/. FramaPDF fonctionne à partir de votre navigateur, pas d’outil à installer. Si votre modification demande un traitement en ligne (la compression, par exemple), FramaPDF la réalisera sans conserver ni stocker le document. Documentation pour les manipulations simples = https://framablog.org/2025/12/18/framapdf-modifiez-manipulez-signez-vos-pdf-simplement/ ; site pour les manipulations avancées = https://stirling.framapdf.org/?lang=fr_FR

- Suivez ce lien si vous cherchez d’autres outils libres (en) dont certains peuvent être utilisés localement, sans nécessiter de connexion internet une fois installés.

La cerise sur le gâteau : un filigrane sur vos PDFs

Une fois votre PDF finalisé, vous pouvez utiliser le service FiligraneFacile, un service gratuit créé et mis à disposition par l’État, pour sécuriser avec un filigrane numérique les documents à envoyer. Voyez :

- les explications : https://www.francenum.gouv.fr/guides-et-conseils/protection-contre-les-risques/protection-des-donnees/filigranefacile-un-service

- la version beta : https://filigrane.beta.gouv.fr/

Bons PDFs et bonne bagarre avec la dématérialisation !

03.02.2026 à 08:42

Sortir de la matrice : Le combat pour un numérique libre et humain

Texte intégral (3197 mots)

Il est impossible de vivre dans une société orchestrée par les GAFAM !

Les multinationales comme Alphabet (Google), Amazon, Méta (Facebook), Apple et Microsoft sont des entreprises qui s’imposent de plus en plus par leurs pouvoirs économique, politique et technologique.

- Elles font partie des plus grandes capitalisations boursières. Leurs chiffres d’affaires comme leurs bénéfices se comptent en milliards. En milliards, arrivez-vous à concevoir ce genre de fortune ? Tout cet argent, c’est indécent !

- Et elles n’hésitent d’ailleurs pas à l’utiliser pour faire du lobbying que ce soit à Bruxelles, en France et ailleurs, pour lutter contre les tentatives de régulations européennes, comme le DMA, le DSA ou le RGPD. Sans parler de ce qu’il se passe aux États-Unis, où c’est pire. Les droits humains sont beaucoup moins protégés et respectés là-bas.

- Leurs intérêts passent forcément avant le bien commun, avant l’intérêt général des personnes qui peuplent cette terre, avant même la protection de notre environnement, avant la planète.

- Et bien sûr, elles imposent leurs technologies numériques, leurs standards, rendant difficile l’utilisation d’alternatives.

Cela a de très nombreuses conséquences sur le commun des mortel·les comme vous et moi, quasiment invisibles, mais très bien décrites dans de nombreux articles : surveillance massive grâce à l’extraction de données des utilisateurices sans leur consentement « éclairé », dépendance et enfermement dans des services soi-disant gratuits, obsolescence logicielle programmée, perte de contrôle du matériel informatique, monopole par l’achat systématique d’autres entreprises pour éliminer la concurrence, menace pour les libertés par la censure, la captation et la monétisation de l’attention, perte de la souveraineté numérique (influence et dépendance institutionnelles).

Je ne sais pas vous, mais moi, je ne peux vivre dans cette société où je me sens continuellement épiée, manipulée, en colère, esseulée, paranoïaque, désespérée et, pour finir, résignée. Je ne suis pas Winston Smith, le héros de 1984 de Georges Orwell et pourtant notre société ressemble chaque jour de plus en plus à celle d’Océania…

Heureusement, il est encore possible, pour nous, de partager nos doutes, nos pensées, nos tentatives et nos solutions pour s’en sortir avec d’autres personnes.

Une communauté à la rescousse

Depuis plus de trente ans, une irréductible communauté de libristes se bat pour proposer des logiciels libres et respectueux des utilisateurices. Cette communauté suit 4 libertés. Ces libertés ne sont pas de simples recommandations, mais des critères obligatoires qui forment le socle éthique et pratique du mouvement du logiciel libre

-

- la liberté 0 (en informatique, tout commence par 0, faut pas s’étonner) : la liberté d’utiliser les logiciels, qui qu’on soit, où qu’on soit, quel que soit le matériel utilisé. Aucune restriction ;

- la liberté 1 : la liberté d’étudier le fonctionnement du programme et de l’adapter à ses besoins. Bon ok, tout le monde n’a pas forcément cette compétence technique d’accéder au code source. Mais beaucoup l’ont, et peuvent donc aller y jeter un œil et améliorer le dit logiciel. Ensemble on est plus fort ;

- la liberté 2 : la liberté de redistribuer des copies de ce logiciel (ce qui implique la possibilité aussi bien de donner que de vendre ces copies) ;

- la liberté 3 : la liberté d’améliorer le logiciel et de distribuer ces améliorations à d’autres, pour en faire profiter toute la communauté.

Quand j’ai rencontré les libristes, les logiciels libres (dits aussi open source dans le monde entrepreneurial) s’opposaient aux logiciels « propriétaires », maintenant ces derniers sont nommés « privateurs » pour bien montrer qu’ils privent les utilisateurices des libertés qui leur sont offertes par les logiciels libres.

Les valeurs qui en découlent : Transparence, Accessibilité, Coût, Coopération, Indépendance, Sécurité, Innovation et Protection de la vie privée.

J’utilise plusieurs logiciels libres que vous connaissez sans doute déjà :

-

- Firefox qui remplace les navigateurs web comme Chrome, Edge ou Safari.

- Signal ou Matrix/Element pour discuter instantanément. Adieu WhatsApp et Messenger.

- Nextcloud qui offre le partage de fichiers, documents, le calendrier, le traitement de texte collaboratif. Bye bye Google Workplace et AWS.

- LibreOffice la suite bureautique avec tableur, texte, pdf, diaporama. Non à Excel, Word et compagnie !

- Évolution ou Thunderbird, pour gérer ses mails. Ciao Apple mail et Outlook.

- VideoLAN, pour voir et écouter des films et de la musique.

- Inkscape et Gimp, pour dessiner ou retoucher des photos.

Et ce ne sont pas les seuls.

Alors certains détracteurs me diront qu’il sont moins bien, moins beaux, moins connus, moins fonctionnels… Rappelons juste une chose, la communauté libriste s’appuie sur les contributions d’informaticien·nes qui le font sur leur temps libres (bénévolat), il y a également de plus en plus d’entreprises qui paient des salarié·es pour l’amélioration et le maintien de ces logiciels et services libres, sans oublier des fondations à but non lucratif ou encore des universitaires. Merci à toustes. Mais on est très loin, très très très loin des milliards cités plus haut. Bref on fait ce qu’on peut et c’est déjà fabuleux pour moi tout ce qui est produit chaque jour.

Un boycott inconfortable mais indispensable

L’émancipation passe par la reprise de contrôle sur nos outils et nos données et il n’est pas aisé de changer ses habitudes, de sortir de son confort d’utilisation.

Pourquoi arrêter d’utiliser des logiciels et services en ligne qui fonctionnent bien et que l’on maitrise depuis des années ?

Si vous vous posez encore cette question, je vous laisse aller relire la première partie de mon texte.

Si au contraire, vous êtes entré·es dans une démarche d’actions individuelles et que vous voulez réduire votre dépendance au quotidien alors j’ai de bonnes nouvelles.

Il existe une multitude de logiciels libres qui remplacent tous les logiciels privateurs utilisés, voire imposés ces dernières années par les GAFAM et autres entreprises privatrices. Et il y a même un annuaire, Framalibre proposé par Framasoft. Vous pourrez découvrir de nombreux logiciels libres, suivant vos besoins, vos envies ou votre curiosité ! Et derrière chaque logiciel libre, il y a une communauté qui maintient, qui améliore, qui promeut. Et, en France, l’April, dont je suis la présidente, les défend au niveau institutionnel et politique.

Voilà de quoi remplacer tous vos logiciels privateurs installés par un voire plusieurs logiciels libres ! Votre ordinateur se sentira libéré et vous remercie !

Mais il n’y a pas que les logiciels que l’on peut changer. Il y a aussi les mauvaises habitudes en ligne. Tous ces services soi-disant gratuits qui vous espionnent, accèdent à vos données et vous envoient des informations ciblées pour vous manipuler. Rappel : Les GAFAM ne sont pas neutres, ils façonnent nos sociétés, nos lois, nos comportements.

Allez, je continue de vous offrir des informations en cadeau, alors que Noël est déjà passé depuis quelques semaines. C’est toujours grâce à la communauté libriste et à ses nombreuses initiatives pour se libérer.

Vous aimez les images de chats ? Et bien les chatons vont sauver internet ! Si si, absolument ! Initiative lancée d’abord par Framasoft, qui voulait se dégoogliser, le Collectif d’Hébergeurs Alternatifs, Transparents, Ouverts, Neutres, et Solidaires – ça fait CHATONS en acronyme :-D a vu le jour en février 2016 (bon anniversaire des 10 ans ! !), soit il y a plus de huit ans, et est composé de nombreuses organisations (associations, particuliers et entreprises – il y a deux « portées » par an qui en fait augmenter le nombre total). Toutes proposent des services en ligne que vous pouvez utiliser sans rien avoir à installer sur votre ordinateur, juste en lançant votre navigateur web. Est-ce que l’on peut avoir confiance dans ces chatons ? Alors il faut savoir que pour devenir chatons, il faut s’engager à respecter la charte des chatons. Et si votre chatons ne vous plaît plus, comme tout est transparent, ouvert, neutre et solidaire, il est possible d’en adopter un autre. Aucun emprisonnement, ni surveillance, ni manipulation. Ce n’est pas non plus un monde de bisounours, alors n’hésitez pas à soutenir les organisations qui vous offrent ces services, litières, croquettes et sous-sous sont toujours les bienvenus !

Autre initiative fort sympathique : DéMAILnagement. Vous avez capté le jeu de mots ? Comme son nom l’indique, cette initiative vous permet de quitter Gmail, mais aussi d’autres fournisseurs qui ont accès à toutes les données qui circulent dans vos mails (et ne se privent pas pour y accéder) et de découvrir le mail libre ! Ok, ça veut dire avoir une nouvelle adresse mail et cela fait toujours peur, cela peut également prendre du temps à mettre en place, prévenir tous vos contacts, vos banques, employeurs, administrations et autres… mais après, on est un peu plus en sécurité. La transition se fait en douceur, les données sont protégées, et c’est vous qui choisissez ce que vous voulez suivant vos besoins, vos valeurs, vos envies, vos moyens.

Est-ce que vous connaissez PeerTube ? Comme son nom l’indique, c’est une plateforme de vidéos décentralisée qui commence à faire de l’ombre à YouTube. Développée par Framasoft, encore elle, elle donne accès à de nombreuses vidéos et permet de monter sa propre instance pour héberger les siennes et les partager avec d’autres. Et OpenstreetMap ? pour sortir de GoogleMap, Mappy ou autre service de cartographie ? Et Wikipedia ? Cette encyclopédie en ligne qui met en exergue les 4 libertés du logiciel libre ? FFDN, qui regroupe de nombreux fournisseurs d’accès à Internet. Vous n’avez qu’à choisir un près de chez vous. On a parlé des GAFAM, mais il y a aussi d’autres entreprises dont il faut se méfier… genre au hasard X et toutes les possession d’Elon Musc, dernier cadeau de l’article : le Fediverse. C’est un ensemble de plusieurs réseaux sociaux où diverses applications sont compatibles et permettent de discuter ensemble.

Et si on parlait du matériel ? Et de son coût écologique ? Mieux vaut choisir des appareils respectueux, ou du reconditionné. Le ré-emploi c’est la vie qui continue

Tout cela est un bon début mais c’est fragile, comme tous les biens communs. Financièrement déjà. C’est pourquoi les associations qui proposent ces logiciels et services sont souvent en recherche de soutien financier et de contributions, techniques ou pas. C’est valable également pour les entreprises qui codent, développent et maintiennent des logiciels libres. Il faut les favoriser, leur donner la priorité. Mais en plus ils sont régulièrement menacés par différentes lois.

Collectivement : on est plus puissant qu’on ne le croit !

Si les politiques avaient pour but l’intérêt du plus grand nombre et le respect de la vie privée cela se saurait. En tout cas depuis plusieurs année, les questions se posent, soient sur leurs compétences soit sur leur absence de compréhension des conséquences de certains projets de lois.

Il est possible d’agir collectivement et de plein de manières différentes. À vous de choisir comment et combien de temps vous êtes prêt à consacrer. Ensemble, on est plus puissant qu’on ne le croit !

- adhérer à des associations militantes, des syndicats ou des partis politiques. Faîtes entendre votre voix, vos idéaux, mais également vos peurs et coups de gueules ! (c’est plus utile dehors que dedans, ça diminue aussi le nombre de cheveux blancs)

- rejoindredes dynamiques locales : l’Agenda du Libre recense de nombreuses organisations et présentent les évènements autour du numérique organisés partout en France et aussi un peu en Belgique et en Suisse. Allez à leur rencontre ! Iels sont sympa.

- informer le grand public par des campagnes, des ateliers, des conférences ou des stands. Participer aux émissions Libre à vous ! sur Cause commune. C’est une occasion extraordinaire de partager nos idées, nos valeurs, d’échanger sur les dernières nouveautés, d’alerter sur les derniers méfaits des GAFAM et de se sensibiliser sur les sujets du moment.

- s’organiser à plusieurs, mettre en place différents partenariats entre associations et entreprises (je ne vous ai pas encore parlé du CNLL, il n’y a pas que des personnes et des associations dans la communauté libriste, il y a aussi de nombreuses entreprises !).

– profiter de chaque occasion pour lancer des campagnes de sensibilisation. Comme l’opération Adieu Windows, bonjour le Libre ! qui a débuté en octobre 2025, à la date choisie par Microsoft pour arrêter son support gratuit à Windows 10 alors qu’une loi européenne l’obligeait à le maintenir une année supplémentaire. L’opération a pour but de visibiliser au maximum les actions des GULL (Groupe d’Utilisateurices de Logiciels Libres), qui régulièrement organisent des rencontres accessibles à toustes pour libérer les ordinateurs et téléphones des personnes qui le souhaitent des produits des GAFAM. On appelle cela des install’s parties.

– mobiliser l’opinion publique par la mise en place de pétitions ou de plaidoyers destinés aux politiques, sur des sujets importants comme l’éducation au numérique, l’interopérabilité ou la souveraineté technologique. Cela n’est pas toujours évident d’atteindre des chiffres suffisants pour influencer les lois, mais c’est toujours une occasion de voir nos sujets abordés dans la presse. Si vous aimez ce genre de mobilisations, allez sur les sites de la quadrature du net ou d’HOP (Halte à l’Obsolescence Programmée)

– convaincre les candidat·es aux élections de s’engager pour le Libre et les libertés numériques. Par exemple en leur faisant signer un pacte, comme le Pacte du Logiciel Libre. Une occasion de passer à l’action, une chance pour ces personnes de s’engager à donner la priorité aux logiciels libres, à faire respecter la vie privée et aussi à sortir des griffes des GAFAM.

– essayer de faire évoluer la législation, prendre contact avec les député·es, les sénateurices, les membres du gouvernement. Constamment. C’est chronophages et rarement épanouissant mais c’est indispensable. C’est aussi très intimidant. Mais ces personnes sont sensées nous représenter, et comme leurs votes ne correspondent pas toujours à l’intérêt général, il faut leur rappeler qu’on existe ! !

Les actions collectives et les mobilisations créent un rapport de force, tandis que les politiques publiques permettent d’ancrer durablement le logiciel libre dans la société. Les deux sont indispensables pour une transition numérique éthique et durable.

Et parfois, ok trop rarement, il y a de bonnes surprises qui en ressortent comme la loi pour une République numérique, comme l’utilisation des logiciels libres au sein du ministère de l’éducation, l’utilisation par la gendarmerie d’une distribution libre améliorée et adaptée à ses besoins.

Au niveau européen le RGDP (Règlement Général pour la Protection des Données) ou le DMA (Digital Market Act) et le DSA (Digital Service Act). En Europe, on est quand même mieux protégé·es qu’aux États-Unis.

Et pour conclure ?

Chaque geste compte, comme ce conte où un feu de forêt se déclenche, tous les animaux fuient, sauf un petit colibri qui essaie de l’éteindre, goutte d’eau par goutte d’eau. Quand les autres animaux s’en rendent compte, ils décident d’en faire de même et d’essayer de mettre fin à l’incendie ensemble.

Et bien, nous aussi, notre monde brule et il est temps de se rassembler pour changer le système, sortir de nos prisons un peu trop confortables et s’émanciper numériquement.

02.02.2026 à 07:42

Khrys’presso du lundi 2 février 2026

Texte intégral (9571 mots)

Comme chaque lundi, un coup d’œil dans le rétroviseur pour découvrir les informations que vous avez peut-être ratées la semaine dernière.

Tous les liens listés ci-dessous sont a priori accessibles librement. Si ce n’est pas le cas, pensez à activer votre bloqueur de javascript favori ou à passer en “mode lecture” (Firefox) ;-)

Brave New World

- La purge militaire chinoise offre à Taïwan un répit qui pourrait être de courte durée (slate.fr)

Depuis Taipei, l’éviction du général Zhang Youxia et la brusque réorganisation de la commission militaire centrale en Chine ont été suivies de près. À court terme, cela pourrait servir les intérêts taïwanais, mais annonce surtout une armée de plus en plus au service de Xi Jinping, bien déterminé à ce que Taïwan soit contrôlée par la Chine.

- China hacked Downing Street phones for years (telegraph.co.uk)

Spying operation targeted senior government members, including aides to Boris Johnson and Rishi Sunak

- ‘Mother of all deals’ : EU and India sign free trade agreement (theguardian.com)

Tariffs cut to zero for many industrial products, including iron and steel, plastics, chemicals and pharmaceuticals

- Fédération de Russie. Un atome non pacifique (reseau-bastille.org)

- Interpol : Comment Moscou traque ses opposants grâce à l’organisation policière (disclose.ngo)

La Russie use de tous les outils offerts par Interpol pour traquer opposants, journalistes et militants en exil […] Alors que des contrôles renforcés ont été mis en place après l’invasion de l’Ukraine, en 2022, les abus n’ont jamais cessé. Plutôt que de sévir, Interpol a récemment allégé les mesures de surveillance imposées à Moscou.

Voir aussi Révélations sur le détournement d’Interpol par les pays les plus répressifs au monde (disclose.ngo)

Persécutions, traques secrètes, arrestations arbitraires… Révélations sur un système qui permet à des régimes autoritaires comme la Russie, la Turquie ou le Tadjikistan d’utiliser Interpol pour persécuter leurs opposants politiques.

Et Au Tadjikistan, Interpol ferme les yeux sur les persécutions de la dictature (disclose.ngo)

Avec près de 3 500 notices rouges en circulation, le Tadjikistan fait partie des trois pays qui sollicitent le plus Interpol au monde. Sous couvert de lutte contre le terrorisme, ce recours à l’organisation policière permet à la dictature tadjike de pourchasser des opposant·es politiques et des citoyens musulmans sans lien avec des organisations armées.

Et encore Interpol : Des journalistes et militants politiques turcs fichés comme « terroristes » (disclose.ngo)

Depuis une décennie, la Turquie s’appuie sur l’organisation de police criminelle pour mener une traque acharnée contre des opposant·es politiques et des journalistes en exil

- Syrie. À Raqqa, la fin du rêve kurde (orientxxi.info)

Raqqa, 18 janvier. Les soldats de l’armée syrienne se prennent en photo dans la ville, des tirs de célébration claquent, le drapeau syrien flotte. Après sept années sous administration des Forces démocratiques syriennes (FDS), la ville repasse sous le contrôle de Damas, à la faveur d’un accord. Tandis que certains fêtent la « libération », s’éloignent le projet du « Rojava » et l’autonomie kurde.

Voir aussi Syrie : un risque de génocide des kurdes ? Des militantes nous expliquent (humanite.fr)

- Quels sont les moyens militaires que l’armée américaine a déployés à proximité de l’Iran ? (legrandcontinent.eu)

- L’Iran riposte à l’Union européenne et met en garde les États-Unis contre des frappes (huffingtonpost.fr)

En rétorsion à la mesure prise jeudi par l’UE, Téhéran fait des armées européennes des groupes terroristes.

- En Iran, danser devant la mort pour briser le silence (blogs.mediapart.fr)

Quand l’enterrement se change en noce, et le deuil en tactique de résistance… En janvier 2026, les cimetières iraniens sont devenus le théâtre d’une insurrection symbolique. Face à un pouvoir qui administre jusqu’aux cadavres, horaires, silences, signatures, enterrements sous surveillance, des familles endeuillées transforment les funérailles en « mariage ».

- Mozambique : 112 décès, 99 blessés, 3 disparus et 645 000 personnes victimes des inondations (la1ere.franceinfo.fr)

- « Il fait moins de 0°C chez moi » : sans chauffage ni électricité, la survie quotidienne des habitant·es de Kiev (slate.fr)

plus de 90 tentes chauffées ont été installées dans la ville par le Service national des situations d’urgence. Surnommés « points d’invincibilité », ces abris accueillent, 24 heures sur 24, les habitant·es privés d’électricité.

- « Paresseux et complaisants » : des retraités suédois racontent comment la suppression de l’impôt sur la fortune a transformé leur pays (theconversation.com)

- Une première : les Pays-Bas condamnés à mieux protéger une île caribéenne du changement climatique (reporterre.net) – voir aussi « Un précédent d’importance mondiale » pour la justice climatique : les Pays-Bas condamnés pour discrimination envers l’île de Bonaire (humanite.fr)

Un tribunal néerlandais a sommé, mercredi 28 janvier, les Pays-Bas de mieux protéger du changement climatique l’île antillaise de Bonaire et de fixer à l’ensemble de l’économie nationale des objectifs contraignants de réduction des émissions de gaz à effet de serre.

- Zimbabwe, Madagascar, Honduras… Ces crises humanitaires oubliées et aggravées par le changement climatique (reporterre.net)

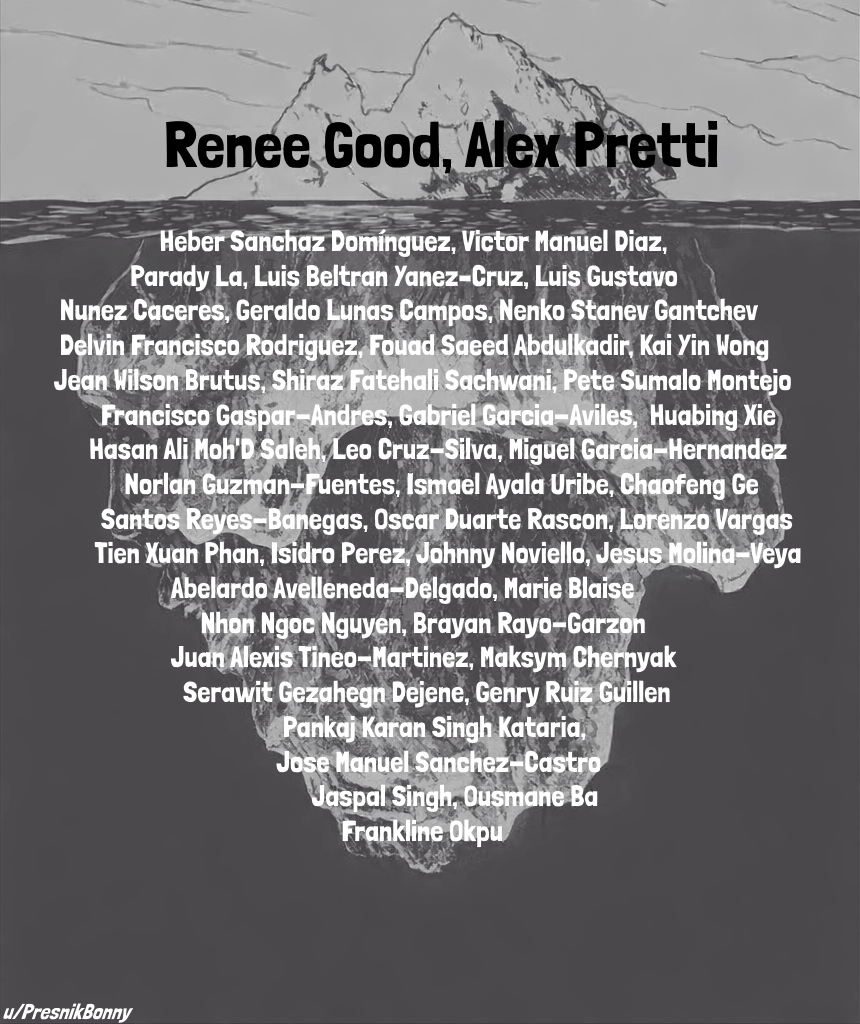

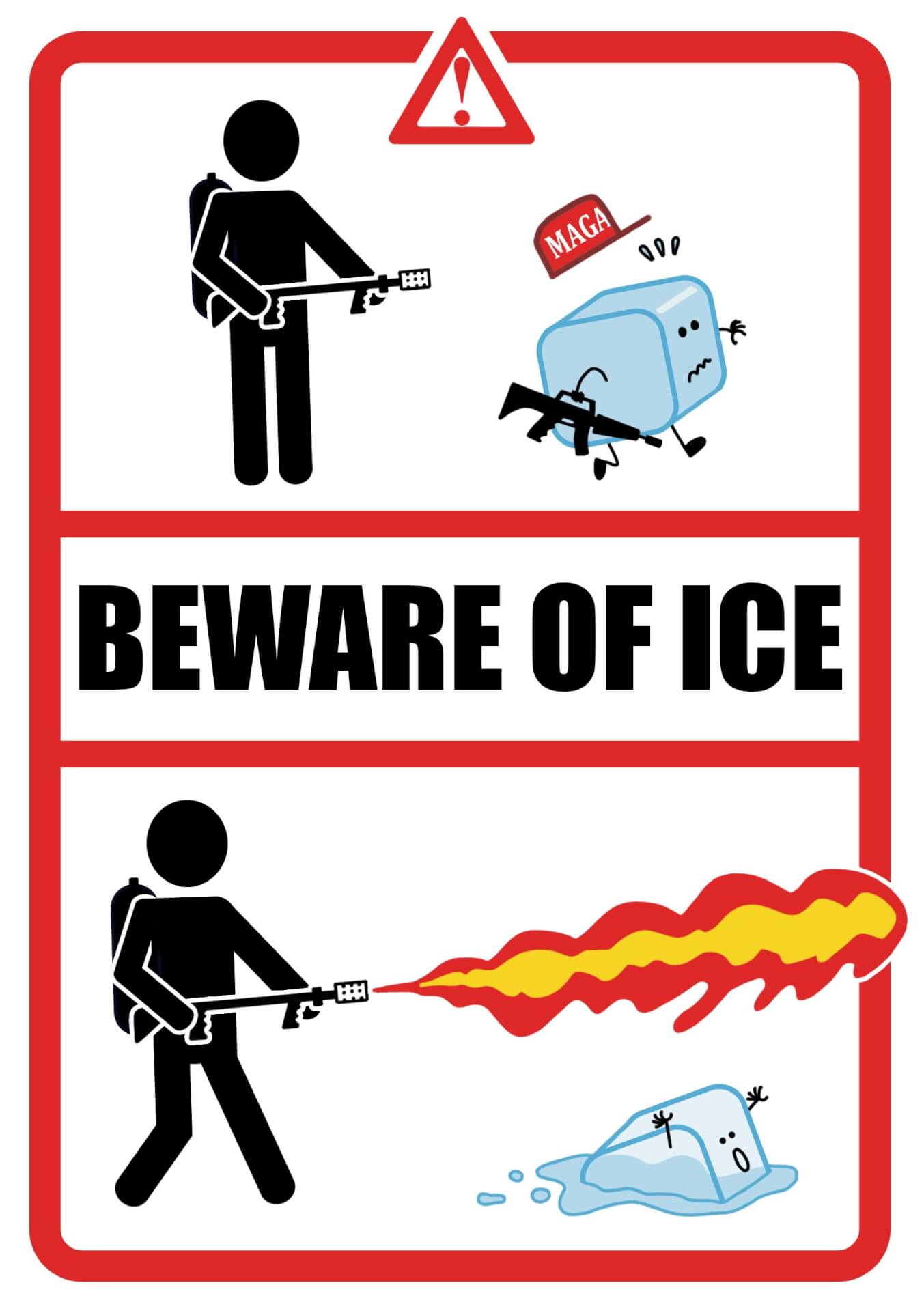

- Milan mayor calls ICE “a militia that kills” and says agents not welcome as part of U.S. Olympic security (cbsnews.com)

- L’exception espagnole qui dérange (politis.fr)

L’Espagne est la preuve qu’une coalition de gauche, lorsqu’elle assume ses désaccords mais partage un cap, peut produire des politiques à la hauteur des attentes populaires.

- UK police to use AI facial recognition tech linked to Israel’s war on Gaza (aljazeera.com)

The United Kingdom’s controversial rollout of facial recognition technology will rely on software that appears to have already been deployed in Gaza, where it is used by the Israeli army to track, trace, and abduct thousands of Palestinian civilians passing through checkpoints.

- Sanctions contre les partenaires de Cuba : Trump accentue l’offensive impérialiste contre l’île (revolutionpermanente.fr)

- ICE knocks on ad tech’s data door to see what it knows about you (theregister.com)

It’s not enough to have its agents in streets and schools ; ICE now wants to see what data online ads already collect about you. The US Immigration and Customs Enforcement last week issued a Request for Information (RFI) asking data and ad tech brokers how they could help in its mission.

- Capgemini participe à traquer les migrant·es pour l’ICE, des millions de dollars à la clé (next.ink) – voir aussi Avant même de signer son nouveau contrat, Capgemini traquait déjà des migrant·es pour l’ICE (multinationales.org)

- États-Unis : après Capgemini, les groupes français Thalès et Parrot sont accusés de fournir des services à ICE (humanite.fr)

- En lien avec Minneapolis, ce que l’on sait de l’arrestation de l’ancienne star de CNN Don Lemon (huffingtonpost.fr)

Ce mois-ci, il avait couvert une action contre la police de l’immigration dans une église à Saint Paul, dans le Minnesota.

- « Leur but, c’est de vous casser » : détenu par l’ICE pendant un mois, ce Français raconte (huffingtonpost.fr)

J’avais fait les choses dans les règles. Je pensais être protégé.

- Minneapolis : un juge ordonne la libération de l’enfant de 5 ans dont l’arrestation a fait le tour du monde (huffingtonpost.fr)

Liam Conejo Ramos et son père avaient été arrêtés par l’ICE le 20 janvier à Minneapolis.

- Los Angeles contre l’ICE (laviedesidees.fr)

À Los Angeles, la résistance des habitant·es et des pouvoirs publics à la politique anti-migrant·es manifeste l’ampleur du militantisme populaire. On voit s’engager là une lutte majeure pour la souveraineté territoriale.

- Alex Pretti : Analysing Footage of Minneapolis CBP Shooting (bellingcat.com)

- Meurtre d’Alex Pretti : la Border Patrol, cette autre police de l’immigration américaine à l’origine du drame (huffingtonpost.fr)

Censée s’occuper des frontières, la Border Patrol accompagne désormais l’ICE dans la vaste campagne d’expulsions lancée par l’administration Trump.

- Après les violences de Minneapolis, les Républicains se prennent les pieds dans le tapis sur le 2e amendement (huffingtonpost.fr)

Pour certains Républicains, le fait qu’Alex Pretti ait pu porter une arme justifierait qu’il ait été abattu par la police.

- Minnesota : un juge fédéral interdit la détention de réfugié·es en situation légale (lemonde.fr)

L’ordonnance du juge John Tunheim exige que tout·e réfugié·e détenu·e dans le cadre du programme, lancé en janvier par les autorités, visant à réexaminer le statut légal d’environ 5 600 réfugié·es de cet État démocrate n’ayant pas encore reçu leur « carte verte », soit « immédiatement remis·e en liberté ».

- Minnesota Proved MAGA Wrong (theatlantic.com)

Maybe they had assumed that they would find only a caricature of “the resistance” […] what they discovered in the frozen North was something different : a real resistance, broad and organized and overwhelmingly nonviolent, the kind of movement that emerges only under sustained attacks by an oppressive state. Tens of thousands of volunteers—at the very least—are risking their safety to defend their neighbors and their freedom.

- The dildo distribution delegation (closertotheedge.net)

I stood there, half-blind, lungs on fire, thinking : We just got tear-gassed over a dildo.Not a brick. Not a Molotov. Not a weapon. A rubber dick. That is how fragile federal masculinity is in 2026. […] We proved that you can bring a trillion-dollar security apparatus to its knees with one well-aimed rubber cock. As I stood there coughing, eyes streaming, lungs on fire, watching cops lose their goddamn minds over a dildo, I realized something sacred and stupid and true : You can’t baton your way out of satire. You can’t gas a punchline. And you absolutely cannot maintain authority while tear-gassing people over a rubber dick.

- ‘Rage knitting’ against the machine : the hobbyists putting anti-ICE messages into crafts (theguardian.com)

They didn’t want to return to the “pussy hats” that symbolized women’s resistance to Donald Trump in 2016, so Paul, their employee, did some research and came back with a proposal : a red knit hat inspired by the topplue or nisselue (woolen caps), worn by Norwegians during the second world war to signify their resistance to the Nazi occupation.

- Bruce Springsteen Revives the Protest Song, Condemns ICE Violence in “Streets of Minneapolis” (openculture.com)

- More ‘No Kings’ protests planned for March 28 as outrage spreads over Minneapolis deaths (winnipegfreepress.com)

- À Minneapolis, Donald Trump cède à la pression avec l’annonce du retrait progressif d’agents fédéraux (huffingtonpost.fr)

Après des semaines de manifestations et deux morts lors d’interventions fédérales, la Maison-Blanche semble infléchir sa stratégie sous la pression des autorités locales et judiciaires.

- Comment Minneapolis a fait reculer l’ICE (revolutionpermanente.fr)

- Luigi Mangione ne risque plus la peine de mort (huffingtonpost.fr)

Le souhait de Pam Bondi concernant la peine de mort de Luigi Mangione n’a pas été écouté par la juge fédérale Margaret M. Garnett. Cette dernière a rejeté les deux chefs d’accusation pour lesquels le parquet avait requis la peine de mort, à savoir le meurtre et l’utilisation d’un pistolet équipé d’un silencieux.

- Quand Donald Trump se prend pour Napoléon Ier avec son projet d’arc de triomphe (slate.fr)

À Washington, le président des États-Unis veut ériger l’« Independence Arch », un arc de triomphe à sa gloire, fortement inspiré de celui de Paris.

- TrumpRx delayed as senators question if it’s a giant scam with Big Pharma (arstechnica.com)

The website is delayed as senators seek answers from health department watchdog.

- Dozens of CDC vaccination databases have been frozen under RFK Jr. (arstechnica.com)

Anti-vaccine Kennedy may be “enacting a self-fulfilling prophecy,” expert says.

- Trump policies at odds with emerging understanding of COVID’s long-term harm (cbsnews.com)

- Custom machine kept man alive without lungs for 48 hours (arstechnica.com)

The artificial lung system was built by the team of Ankit Bharat, a surgeon and researcher at Northwestern. It successfully kept a critically ill patient alive long enough to enable a double lung transplant, temporarily replacing his entire pulmonary system with a synthetic surrogate. The system creates a blueprint for saving people previously considered beyond hope by transplant teams.

- Former astronaut on lunar spacesuits : “I don’t think they’re great right now” (arstechnica.com)

Crew members traveling to the lunar surface on NASA’s Artemis missions should be gearing up for a grind. They will wear heavier spacesuits than those worn by the Apollo astronaut

- Earth’s Lower Orbit Could Rapidly Collapse, Scientists Warn (futurism.com)

With satellites and space junk increasingly cluttering our planet’s low Earth orbit, a team of scientists warn that this entire region could suddenly collapse into a destructive maelstrom of swirling debris, posing a threat to any spacecraft that dares to venture up there, and hurling dangerous missiles of space junk down onto our planet below.

- New fear unlocked : runaway black holes (theconversation.com)

Astronomers have seen clear signs of runaway supermassive black holes tearing through other galaxies, and have uncovered evidence that smaller, undetectable runaways are probably out there too.

Spécial IA

- There are now more than 1 million “.ai” websites, contributing an estimated $70 million to Anguilla’s government revenue last year (sherwood.news)

- Starlink utilise les données personnelles de ses abonné·es à leur insu et par défaut pour entraîner ses modèles d’intelligence artificielle. (01net.com)

- Massive AI Chat App Leaked Millions of Users Private Conversations (apple.slashdot.org)

Chat & Ask AI, one of the most popular AI apps on the Google Play and Apple App stores that claims more than 50 million users, left hundreds of millions of those users’ private messages with the app’s chatbot exposed

- Web portal leaves kids’ chats with AI toy open to anyone with Gmail account (arstechnica.com)

Just about anyone with a Gmail account could access Bondu chat transcripts.

- Google begins rolling out Chrome’s “Auto Browse” AI agent today (arstechnica.com)

- Mozilla is building an AI ‘rebel alliance’ to take on industry heavyweights OpenAI, Anthropic (cnbc.com)

In practice, Mozilla is focused on deploying its roughly $1.4 billion worth of reserves to support “mission driven” tech businesses and nonprofits, including its own

Voir aussi Mozilla veut accroître ses investissements dans l’IA open source de confiance (zdnet.fr)

Mozilla Ventures a investi dans 55 entreprises, dont des start-up de l’IA, et d’autres opérations sont prévues cette année.

- DuckDuckGo Asked Its Users How They Feel About AI Search. 90 % Hate It (pcmag.com)

- ChatGPT cite Grokipedia comme une source pertinente (next.ink)

- EDRi calls for swift action as EU probes X’s Grok over AI-generated harm (edri.org)

The European Commission has opened a DSA investigation into Grok, X’s AI chatbot. EDRi welcomes this decision and is calling for a swift resolution to this matter, to ensure that X complies fully with its DSA obligations and protects its users.

- New OpenAI tool renews fears that “AI slop” will overwhelm scientific research (arstechnica.com)

On Tuesday, OpenAI released a free AI-powered workspace for scientists. It’s called Prism, and it has drawn immediate skepticism from researchers who fear the tool will accelerate the already overwhelming flood of low-quality papers into scientific journals. The launch coincides with growing alarm among publishers about what many are calling “AI slop” in academic publishing.

- Drowning in AI slop, cURL ends bug bounties (thenewstack.io) – voir aussi “Préserver notre santé mentale” : cURL suspend son bug bounty, face aux mauvaises contributions par IA (zdnet.fr)

- Vibe Coding Kills Open Source (arxiv.org)

- AI agents now have their own Reddit-style social network, and it’s getting weird fast (arstechnica.com)

Moltbook lets 32,000 AI bots trade jokes, tips, and complaints about humans.

- Yann LeCun claque la porte de Meta et balance : « Les LLM sont une impasse, la Chine va gagner » (goodtech.info)

Après avoir quitté Meta en novembre 2024 où il était chief AI scientist depuis 12 ans, le pionnier des réseaux de neurones affirme sans détour que les investissements massifs de la Silicon Valley dans les grands modèles de langage (LLM) représentent une « impasse » qui ne mènera jamais à une IA de niveau humain, encore moins superintelligente.

- La bulle de l’IA et l’économie étatsunienne (contretemps.eu)

Selon l’économiste Michael Roberts, la bulle de l’IA masque l’état désastreux de l’économie américaine… en attendant l’inévitable crise qui découlera de son éclatement.

Spécial Palestine et Israël

- UNRWA staff cuts deepen in Gaza as Israel restricts critical aid access (aljazeera.com)

- Al Jazeera Denounces YouTube’s Submission to the Ban of its Broadcast in Israel and Calls for Adherence to International Conventions (network.aljazeera.net)

Al Jazeera Media Network strongly denounces YouTube’s submission to the Israeli authorities’ decision to ban the broadcast of its channels on the platform and the blocking of its websites in Israel. The Network emphasises that this measure represents a flagrant violation of Article 19 of the International Covenant on Civil and Political Rights, which guarantees the right to seek, receive, and impart information freely.

- Palestine : la solidarité syndicale n’est pas un délit ! (snes.edu)

Le SNES-FSU apporte tout son soutien à la délégation de l’Internationale de l’Éducation, stoppée par l’armée israélienne alors qu’elle rendait visite à des camarades et collègues palestinien·nes.

- En France, le gel des avoirs est une arme islamophobe contre le combat palestinien (politis.fr)

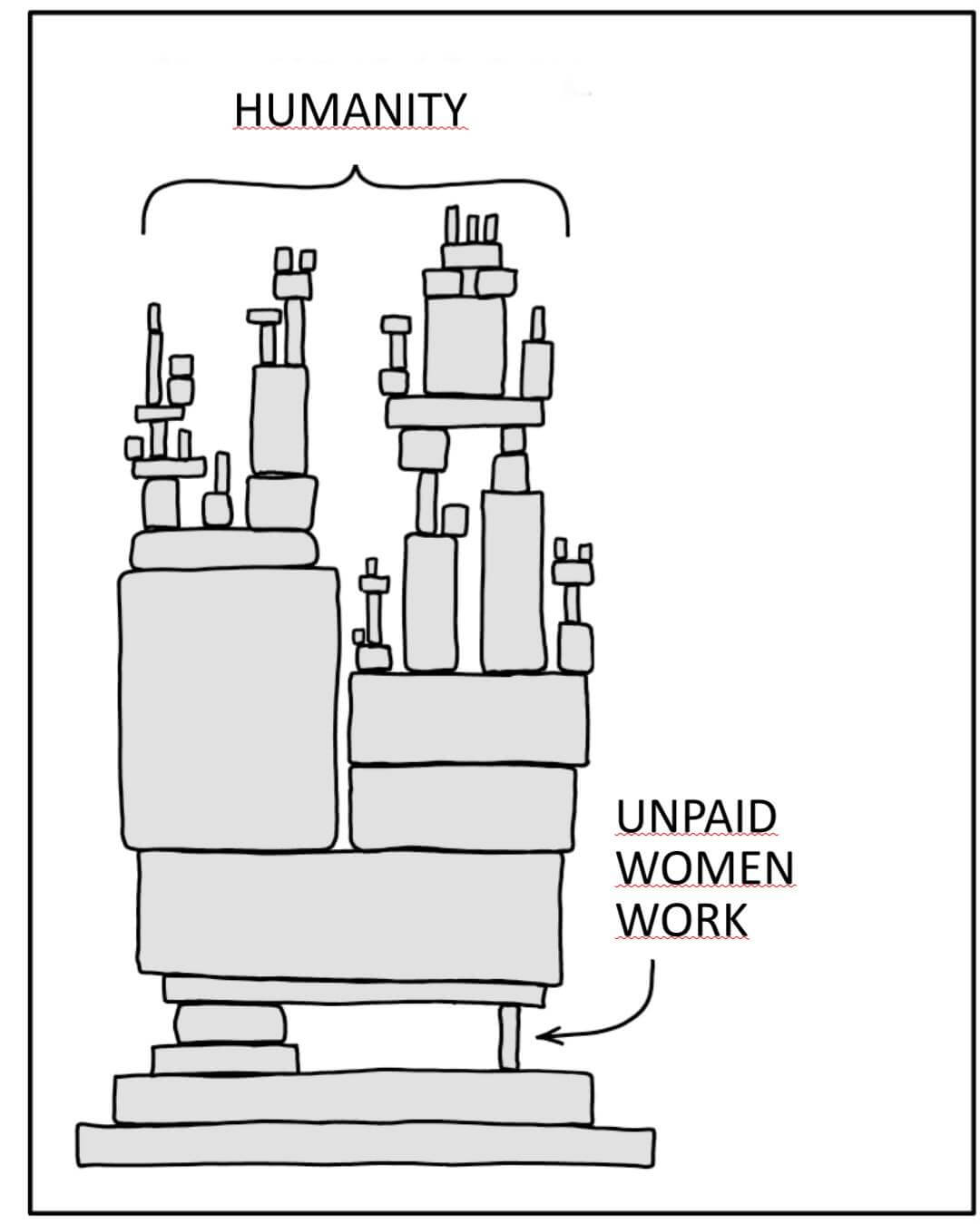

Spécial femmes dans le monde

- Pourquoi y a-t-il autant de « ladyboys » en Thaïlande ? (slate.fr)

Ce n’est qu’à la fin du XIXe siècle, sous l’influence occidentale, que la monarchie thaïlandaise impose une différenciation nette des sexes, à travers les vêtements ou encore les normes sociales. Et, par la même occasion, la notion même de transgenre apparaît dans la société : auparavant, les personnes n’allaient pas « au-delà » (du préfixe latin trans-) d’une norme binaire… puisqu’elle n’existait pas vraiment.

- Kristen Stewart préfère être réalisatrice car « les actrices sont traitées comme de la merde » (huffingtonpost.fr)

La star de « Twilight » dénonce la différence de traitement entre les actrices et les réalisatrices, mais aussi le fait que la vision masculine prime dans le milieu.

- Daniel Bravo suspendu pour des propos sexistes lors de PFC-OM, beIN Sports présente ses excuses (huffingtonpost.fr)

Le consultant de beIN Sports a fait une remarque déplacée à propos de Gaëtane Thiney.

- Musk’s Estranged Daughter Shares Haunting Holiday Memory Following Revelations He Planned Epstein Island Visit (ibtimes.co.uk)

Elon Musk’s estranged daughter has broken her silence following the release of explosive emails showing her father coordinated travel plans with convicted sex offender Jeffrey Epstein, sharing a haunting childhood memory that has intensified scrutiny over the tech mogul’s past connections.

- Les lunettes connectées de Meta sont détournées par les harceleurs et ce sont les femmes qui trinquent (slate.fr)

RIP

- Venus Khoury Ghata, the Lebanese poet who wrote in French, but from right to left (today.lorientlejour.com)

One of the most celebrated icons of Lebanese-origin in Francophone literature, Venus Khoury Ghata left quietly, her heart weary from too much love and suffering, burning with a sometimes otherworldly radiance.

À (ré)écouter : Vénus Khoury-Ghata, poète des fantômes (radiofrance.fr)

Spécial France

- JO d’hiver 2030 : un juge ordonne un débat démocratique sur leur organisation (reporterre.net)

- Usurpation de numéro, spam : l’Arcep ouvre une enquête contre l’ensemble des opérateurs (next.ink)

- Quelle est la véritable situation financière des universités françaises ? (theconversation.com)

- Le Sénat rejette la loi sur l’aide à mourir, le texte renvoyé à l’Assemblée nationale (la1ere.franceinfo.fr)

- Procès FN-RN en appel : Marine Le Pen coule et embarque les coaccusés avec elle (politis.fr)

Devant la cour d’appel, la présidente des députés RN tente de faire tomber l’élément central du jugement, celui qui la place à la tête d’un détournement organisé. Pour y parvenir et sauver 2027, elle concède des « ambiguïtés » et laisse l’addition politique à ses proches.

- Notre-Dame de Bétharram va fermer ses portes. (huffingtonpost.fr)

Au cœur de l’un des plus gros scandales de pédocriminalité de l’histoire de l’école en France, l’établissement béarnais s’apprête à mettre un terme à son activité.

- 35 étudiant·es d’AgroParisTech exclu·es 15 jours après une mobilisation contre l’agro-industrie (reporterre.net)

- Dans les Hauts-de-France, 83 000 personnes boivent une eau contaminée à un fongicide (reporterre.net) – voir aussi PFAS : 83 000 habitants affectés par la pollution de l’eau à un fongicide, dénonce une ONG (humanite.fr)

L’ONG Générations Futures alerte, mercredi 28 janvier, sur la contamination à grande échelle de l’eau du robinet dans 46 communes. En cause : le fluopyram, un produit chimique utilisé pour la culture de fruits, légumes, céréales et des pommes de terre.

- Des traces du pétrole de l’« Erika », échoué en 1999, retrouvées sur des oiseaux dans le Finistère (humanite.fr)

Le Cedre a annoncé ce jeudi 29 janvier, avoir détecté du fioul similaire à celui du pétrolier « Erika », échoué en 1999, sur des oiseaux présents au large de la Bretagne. Leurs plumes sont en cours d’analyse.

- « On nous abandonne » : à La Rochelle, un cluster de cancers à côté des usines (reporterre.net)

- Les victimes des essais nucléaires mieux indemnisées : « Nous sommes de la chair à canon, ils doivent passer à la caisse » (reporterre.net)

Spécial femmes en France

- La promesse de remboursement des protections périodiques toujours pas tenue par le gouvernement (huffingtonpost.fr)

Adopté fin 2023, le remboursement des coupes et culottes menstruelles attend toujours un décret que la ministre Aurore Bergé avait promis pour fin 2025.

- Devoir conjugal : « Pour que les mentalités changent, il faut des propositions de loi comme celle-ci » (huffingtonpost.fr)

C’est une avancée attendue de longue date par les associations féministes. Mercredi 28 janvier, les député·es ont voté à l’unanimité pour entériner dans le droit l’absence de tout devoir conjugal au sein du mariage.

- Près du tiers des collégiennes et un quart des lycéennes ont été victimes d’une forme de cyberviolence au cours de l’année scolaire, selon l’éducation nationale. (huffingtonpost.fr)

- Journaliste cyberharcelée après la CAN : « rien ne justifie les insultes sexistes » dénonce la ministre des Sports (huffingtonpost.fr)

La journaliste de beIN Sports Vanessa Le Moigne a annoncé sa décision de ne plus couvrir le football à la suite d’une vague de cyberharcèlement après la finale de la CAN.

- « Je suis allée voir un ami, j’ai découvert un agresseur » témoigne Sandrine Josso au procès Guerriau (huffingtonpost.fr)

Au tribunal de Paris, l’ex-sénateur et la députée livrent deux récits opposés d’une soirée devenue affaire nationale.

- Affaire Joël Guerriau : “C’est inadmissible”, Sandrine Josso dénonce le manque de soutien et de coopération du président du Sénat Gérard Larcher (ladepeche.fr) – voir aussi “Votre silence m’interroge”. Après la condamnation de Joël Guerriau, la députée Sandrine Josso, interpelle Gérard Larcher, président du Sénat. (france3-regions.franceinfo.fr)

lors du procès de mon agresseur, ce dernier a dévoilé à la barre de nombreuses pratiques illégales ou contraires à l’éthique, notamment le fait que la drogue mise dans mon verre lui avait été remis par un de ses collègues sénateur mais également qu’il avait eu des relations sexuelles avec deux de ses anciennes collaboratrices.

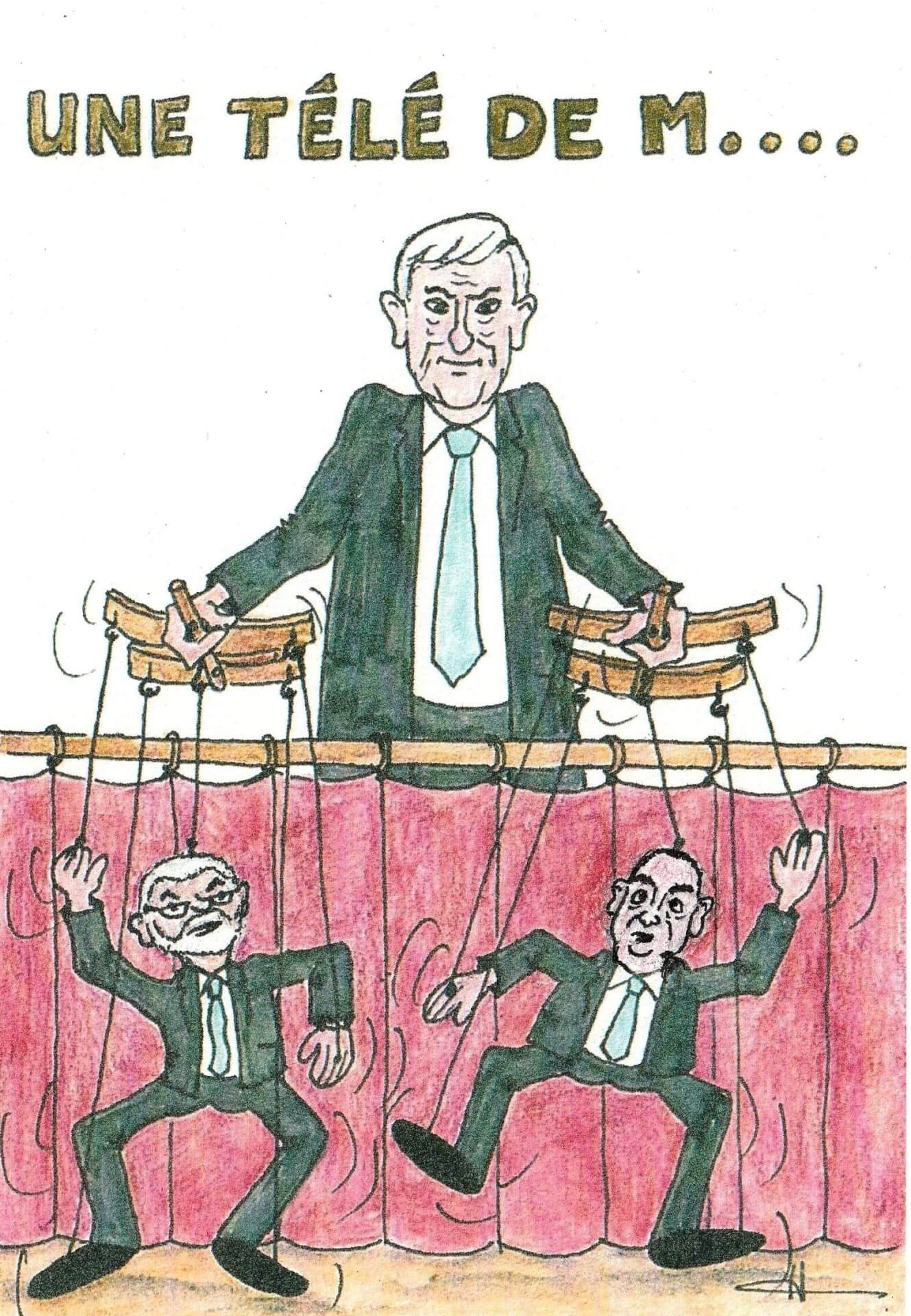

Spécial médias et pouvoir

- Jean-Marc Morandini maintenu sur CNews, la fronde gagne « Le JDD » et symbolise la crise dans l’empire Bolloré (huffingtonpost.fr)

- Sur Franceinfo : Sophie Binet, le patronat et l’extrême droite (politis.fr)

le patronat a oublié la leçon de la Seconde Guerre mondiale et le fait qu’il n’y a pas seulement leurs intérêts économiques, il y a aussi des questions morales

- « 90 % du marché du livre sont aux mains de dix groupes » (politis.fr)

Spécial emmerdeurs irresponsables gérant comme des pieds (et à la néolibérale)

- Budget : que reste-t-il de la taxation des riches dans la copie finale ? (ouest-france.fr)

- Sébastien Lecornu met le remaniement dans l’atmosphère, mais pour quoi faire ? (huffingtonpost.fr)

À quinze mois à peine de la prochaine élection présidentielle, le Premier ministre s’apprête à procéder à un remaniement. Surtout technique, il sera aussi politique.

- Nicolas Sarkozy veut (encore) tenter d’échapper au bracelet électronique malgré sa condamnation (huffingtonpost.fr)

Définitivement condamné dans l’affaire Bygmalion à l’automne dernier, l’ancien président de la République va essayer d’échapper à l’exécution de sa peine.

- Peter Thiel, le fondateur de Palantir attendu à l’Académie des sciences morales pour faire son (fa) show (humanite.fr)

Dépendant de l’Institut de France, cette vieillerie conservatrice qui a récemment intronisé le milliardaire français Bernard Arnault, reçoit ce lundi 26 janvier Peter Thiel.

Vous savez, le mec qui disait en 2010 déjà que la technologie est le moyen de changer le monde sans avoir à obtenir sans cesse le consentement du peuple (tube.fdn.fr)

Pour celleux qui ont envie de se faire mal : Peter Thiel à l’Académie : notes intégrales et commentaires critiques (legrandcontinent.eu) - L’Assemblée nationale adopte l’interdiction des réseaux sociaux aux moins de 15 ans (liberation.fr) – voir aussi Interdiction des réseaux sociaux : surveiller plus que protéger (blogs.mediapart.fr)

Discutée et votée en procédure d’urgence, dans un climat de populisme éducatif, l’interdiction brutale des réseaux sociaux pour les moins de 15 ans en dit probablement davantage sur ses inspirateurs que sur le public visé.

Et Interdire les réseaux sociaux aux moins de 15 ans : la fausse bonne idée autoritaire (frustrationmagazine.fr)

Car quelle est la méthode envisagée ? La “reconnaissance faciale” ou “le téléchargement de documents d’identité”. Il est aussi question de lancer une application de vérification d’âge reliée à la carte d’identité et intégrée à France Identité. Autrement dit : la fin totale de l’anonymat.

Et encore Vérification de l’âge sur les réseaux sociaux : un texte mort-né (projetarcadie.com)l’État serait prêt à « dégainer son application de vérification d’âge, adossée à la carte d’identité électronique, et à la proposer gratuitement aux plateformes ». Cependant […] elle ne permet pas le double anonymat pour préserver la vie privée des utilisateurs, comme l’impose la loi SREN. Car, l’application ou l’outil sera directement adossé à France Identité, gérée par le ministère de l’Intérieur. L’idée est que ce ne seront pas les réseaux sociaux qui auront accès aux identités des utilisateurs, mais l’État lui-même, qui agirait comme tiers de confiance. Sauf que le droit communautaire impose que le tiers de confiance soit un « passeur » et non un « stockeur », notamment pour limiter les risques en cas de piratage. Les incidents de sécurité informatique se multiplient. Il n’y a pas un acteur qui soit épargné par des fuites de données, sauf celles qui ne stockent aucune donnée. […] À ce stade, on pourrait presque parler de mise en open-data des données personnelles.

- Interdiction des réseaux sociaux aux moins de 15 ans : “Ce n’est qu’un début, les VPN, c’est le prochain sujet sur ma liste”, assure Anne Le Hénanff, ministre de l’IA et du Numérique (franceinfo.fr)

- La « loi Duplomb » est de retour : le sénateur va déposer un nouveau texte pour réautoriser l’acétamipride dans certaines cultures (vert.eco)

- « La simplification est un mot magique pour détruire les protections environnementales » (reporterre.net)

- « Avec le “cancer backlash”, les intérêts économiques prévalent toujours sur le reste » (reporterre.net)

- Le syndicat des lunetiers du Jura affirme que les montures des lunettes de soleil d’Emmanuel Macron ne sont pas “Made in France” (franceinfo.fr)

Ces personnes se servent d’une notoriété ancestrale de la fabrication de lunettes dans le Jura et en réalité vont faire certainement fabriquer au mieux en Italie, au pire en Asie

Spécial recul des droits et libertés, violences policières, montée de l’extrême-droite…

- Censure et surveillance : surchauffe au Parlement (laquadrature.net)

- Cette pinata « anti-flics » dans une école d’art de Mulhouse suscite l’indignation de Laurent Nuñez (huffingtonpost.fr) – voir aussi Une voiture de police en carton détruite dans une école d’arts à Mulhouse : le ministre de l’Intérieur dénonce des faits « inadmissibles » (leparisien.fr) et Police et Piñata (mollette.vivaldi.net)

Le Ministre veut des coupables de lèse-police par usage de pinata, tandis que de nombreux élus défilent aujourd’hui même avec les policiers en manif contre le laxisme de la justice. Cette même semaine, d’autres élus ont imaginé de promouvoir une proposition de loi de présomption de légitime défense au profit de la police. C’est beau tous ces élus qui participent collectivement à une nouvelle idéologie à la mode : dégommer l’état de droit et la séparation des pouvoirs.

- Mort d’El Hacen Diarra en garde à vue : l’avocat de la famille dépose une nouvelle plainte et dénonce une “destruction de preuves” (franceinfo.fr)

- La Défenseure des droits dénonce l’usage des lacrymogènes et LBD sur les exilé·es de Calais (reporterre.net)

- « Il faut de grandes rafles d’OQTF » : Arno Klarsfeld veut copier l’ICE et ses méthodes fascistes (revolutionpermanente.fr) – voir aussi Le Conseil d’État engage une procédure disciplinaire contre Arno Klarsfeld après ses propos sur CNews (franceinfo.fr)

L’ancien avocat avait évoqué le lancement de grandes rafles en France, afin d’arrêter des étrangers en situation irrégulière.

- Pas touche aux APL… Sauf pour les étudiant·es étranger·es non européen·nes (basta.media)

Un article du budget entend supprimer les aides au logement pour les étudiant·es étranger·es non citoyen·nes d’un pays de l’Union européenne s’iels ne sont pas boursier·es. La mesure risque de précariser davantage encore des dizaines de milliers de jeunes.

- Discrimination raciale dans l’immobilier : près d’une agence sur deux épinglée par SOS Racisme (lemonde.fr)

Spécial résistances

- Que peuvent faire les syndicats contre la diffusion des idées racistes au sein du salariat ? (basta.media)

- Le Planning familial : l’un des derniers remparts à l’extrême droite en ruralité ? (contretemps.eu)

Association historique luttant pour les droits des femmes et des minorité·es et sur les thématiques liées à la sexualité, le Planning est depuis plusieurs années la cible de l’extrême droite et d’une partie du gouvernement. Pourtant, à l’heure où l’extrême droite pourrait bien accéder au pouvoir […] le rôle politique d’associations comme le Planning Familial est significatif.

- Tribune collective « Immigration : nous constatons les conséquences funestes de la loi Darmanin et de la circulaire Retailleau sur la vie des personnes étrangères » (ripostes.org)

- TRIBUNE « Appel à défendre le Rojava en Syrie » (fondationdaniellemitterrand.org)

- « Ce qu’on a découvert est sidérant » : contre les géants de la chimie, elles défendent 200 citoyen·nes intoxiqué·es aux PFAS (reporterre.net)

- OFF February, le défi collectif de 28 jours pour « se libérer de l’emprise des réseaux sociaux » (huffingtonpost.fr)

Lancé dans quatre pays, dont la France, ce défi invite à supprimer les applications de réseaux sociaux pendant 28 jours, pour en finir avec l’hyperconnexion.

Spécial outils de résistance

- Guide du journaliste pour détecter les contenus générés par l’IA (gijn.org)

- Data Protection Day : 5 misconceptions about data protection, debunked (noyb.eu)

- Masculinismes : neuf idées reçues qui empêchent de qualifier la menace (entreleslignesentrelesmots.wordpress.com)

Spécial GAFAM et cie

- “Instagram is a drug” : Internal messages may doom Meta at social media addiction trial (arstechnica.com)

Anxiety, depression, eating disorders, and death. These can be the consequences for vulnerable kids who get addicted to social media, according to more than 1,000 personal injury lawsuits that seek to punish Meta and other platforms for allegedly prioritizing profits while downplaying child safety risks for years.

- WhatsApp intègre les publicités et vous fait désormais payer pour les supprimer (generation-nt.com)

- Lawsuit Alleges That WhatsApp Has No End-to-End Encryption (pcmag.com) – voir aussi Meta peut accéder à toutes les conversations WhatsApp : un procès accuse l’entreprise d’avoir escroqué des milliards d’utilisateurices grâce à un accès backdoor aux communications privées chiffrées (developpez.com)

- Meta blocks links to ICE List across Facebook, Instagram, and Threads (arstechnica.com)

Mark Zuckerberg’s social media platforms are assisting the Trump administration.

- Apple’s Second-Biggest Acquisition Ever Is a Startup That Interprets Silent Speech (apple.slashdot.org)

Apple has acquired Q.AI, a secretive Israeli startup whose technology can analyze facial skin micro-movements to interpret “silent speech”

- Oui, Microsoft donne les clés BitLocker aux forces de l’ordre. Non, ce n’est pas nouveau (next.ink)

- Microsoft ordered to stop tracking school children (noyb.eu)

The Austrian data protection authority (DSB) has decided that the company illegally installed cookies on the devices of a pupil without consent. According to Microsoft’s own documentation, these cookies analyse user behaviour, collect browser data and are used for advertising. Microsoft now has four weeks to comply and cease the use of tracking cookies.

- Systemd daddy quits Microsoft to prove Linux can be trusted (theregister.com)

- TikTok users say they can’t upload anti-ICE videos. The company blames tech issues (edition.cnn.com) – voir aussi TikTok is investigating why some users can’t write ‘Epstein’ in messages (npr.org) – voir aussi TikTok users “absolutely justified” for fearing MAGA makeover, experts say (arstechnica.com)

TikTok wants users to believe that errors blocking uploads of anti-ICE videos or direct messages mentioning Jeffrey Epstein are due to technical errors—not the platform seemingly shifting to censor content critical of Donald Trump after he hand-picked the US owners who took over the app last week.

- Americans are baffled to discover TikTok is more censored under US ownership than it ever was under China (hespectaclemag.substack.com)

- Altman, Cook et d’autres condamnent les actions de l’ICE alors que leurs sociétés y participent (next.ink)

Les autres lectures de la semaine

- Est-il possible de rapprocher Trump de l’ordre nazi ? Les réponses de Chapoutot (legrandcontinent.eu)

- Technofascisme : quand la Silicon Valley fusionne avec l’autoritarisme trumpiste (synthmedia.fr)

- How to get Doom running on a pair of earbuds (arstechnica.com)

No display ? No problem for the UART-to-web-server “Doombuds” project.

- Infrastructure ou Intrusion ? L’expansion controversée des centres de données en Europe (synthmedia.fr)

- Infrastructures done differently (apc.org)

- Faut-il rendre le vote obligatoire en France ? (usbeketrica.com)

Atteinte à la liberté individuelle fondamentale pour les un·es, remède à l’abstention pour les autres, le vote obligatoire est loin de faire consensus en France, où il est ponctuellement débattu.

- Le microbiote de l’écorce des arbres a un rôle essentiel pour le climat (lareleveetlapeste.fr)

Les chercheureuses montrent que ce microbiote module notamment les flux de gaz en fonction de la disponibilité en oxygène.

- How the Incas Performed Skull Surgery More Successfully Than U.S. Civil War Doctors (openculture.com)

- Les engagé·es de La Réunion, grands oubliés de l’histoire coloniale (afriquexxi.info)

- Le tout premier auteur de l’histoire était une autrice : Enheduanna (theconversation.com)

Longtemps éclipsée par les figures canoniques de la tradition occidentale, Enheduanna est pourtant la première autrice connue de l’histoire. Il y a plus de 4 000 ans, en Mésopotamie, cette grande prêtresse a signé ses textes, mêlant poésie, pouvoir et spiritualité, et laissé une œuvre fondatrice.

Les BDs/graphiques/photos de la semaine

- Télé

- Scandale

- Interdire

- Choquant

- Liberty

- ICE

- Beware

- Cap Gemini

- Iceberg

- Retourne

- No human

- Dark web

- Women

Les vidéos/podcasts de la semaine

- Avec les inculpé·es du 8 décembre (1/2) : Quand l’antiterro’ toque à la porte (audioblog.arteradio.com)

- Avec les inculpé·es du 8 décembre (2/2) : Qui terrorise qui ? Le petit théâtre de la justice d’exception (audioblog.arteradio.com)

- Témoignage du Juge Guillou de la Cour Pénale Internationale – Soirée ISC-PIF 20Janvier 2026 (tube.fdn.fr)

- Face à l’extrême droite, la résistance s’organise (blast-info.fr)

- L’ICE ou l’arsenal technologique en action (radiofrance.fr)

Du ciblage publicitaire à la reconnaissance faciale en passant par les Meta Ray-Ban, les agents de l’ICE déploient en toute impunité un arsenal technologique. Quid de la riposte ?

- Désordre mondial : et si Donald Trump n’était pas le problème ? (humanite.fr)

Trump, le pétrole, Venezuela, droits de douane : et si le problème n’était pas Donald Trump lui-même mais un changement profond du capitalisme mondial ? Sommes-nous en train d’assister à la fin du néolibéralisme ?

- Quand les femmes vieillissent (radiofrance.fr)

Les trucs chouettes de la semaine

- Tesla : 2024 was bad, 2025 was worse as profit falls 46 percent (arstechnica.com)

More than half its profit came from emissions credits as sales fell 8.6 percent.

Voir aussi

- Tesla’s Wile E. Coyote Moment Is Here (prospect.org)

But how long can Elon Musk keep running on air ? Potentially quite a long time.

- Why Linux is safe from viruses (programmerhumor.io)

- Concevoir un site web durable et accessible (gaite-lyrique.net)

- Accessibility For Everyone (accessibilityforeveryone.site)

- Les animaux aussi savent se servir d’outils ! (reporterre.net)

Des vaches sont capables de se gratter avec un balai, des pieuvres se fabriquent des armures en noix de coco… Focus sur ces animaux habiles.

- La première cartographie du réseau souterrain mondial des champignons a été révélée (lareleveetlapeste.fr)

La Société pour la protection des réseaux souterrains (SPUN) a dévoilé une carte unique au monde : celle du monde fongique. Aussi communément appelé le réseau mycorhizien, il est bien qu’invisible, extrêmement vaste et absolument essentiel pour la survie de nombreuses espèces animales et végétales. Les scientifiques à l’origine du projet veulent mieux protéger ce réseau, qui sert à la fois de puits de carbone et réserve de nutriments. La longueur totale du mycélium dans les 10 premiers cm du sol est d’environ la moitié de la largeur de notre galaxie.

Retrouvez les revues de web précédentes dans la catégorie Libre Veille du Framablog.

Les articles, commentaires et autres images qui composent ces « Khrys’presso » n’engagent que moi (Khrys).