15.12.2025 à 15:23

Pourquoi le vert est-il la couleur de la nature ?

Texte intégral (3738 mots)

Les couleurs chatoyantes d’un coquelicot ou d’une mésange attirent le regard, mais elles remplissent également d’innombrables fonctions pour le vivant. Dans son récent livre, « Toutes les couleurs de la nature », paru aux éditions Quae, Frédéric Archaux, ingénieur-chercheur à l’Inrae, explore ces questions couleur par couleur. Nous reproduisons ci-dessous le début du chapitre consacré à la couleur verte.

S’il ne fallait retenir qu’une seule couleur pour caractériser le vivant, ce serait assurément le vert, celui de la chlorophylle : la vie sur Terre n’aurait certainement pas été aussi florissante sans ce pigment révolutionnaire capable de convertir l’énergie du Soleil en énergie chimique.

Et sans les organismes photosynthétiques, des minuscules bactéries océaniques aux immenses séquoias, quel aurait été le destin des animaux ? Certains d’entre eux hébergent même dans leur propre organisme ces précieux alliés !

La photosynthèse ? Un « Soleil vert »

Notre appartenance au règne animal et notre régime alimentaire omnivore nous font oublier à quel point pratiquement tout le vivant repose sur un processus clé assuré presque exclusivement par d’autres règnes : la photosynthèse, ou comment convertir l’énergie lumineuse en énergie chimique stockée dans des molécules organiques.

Cette énergie permet ensuite de créer d’autres molécules, parfois très complexes, de faire marcher nos muscles, de maintenir notre température corporelle, etc. Le vert est la couleur par excellence de cette photosynthèse, celle du pigment majeur qui capte et convertit l’énergie lumineuse, la chlorophylle (du grec khloros, vert, et phullon, feuille).

Bien sûr, tous les organismes photosynthétiques ne sont pas verts, car d’autres pigments (non chlorophylliens) peuvent masquer la chlorophylle. Pour ne citer qu’un exemple parmi tant d’autres, la photosynthèse chez les algues rouges repose exclusivement sur la chlorophylle A (la plus répandue sur Terre et sous l’eau), mais ces algues produisent également des carotènes et des protéines (phycobiliprotéines) de couleurs bleue et rouge, qui capturent l’énergie lumineuse puis la transmettent à la chlorophylle.

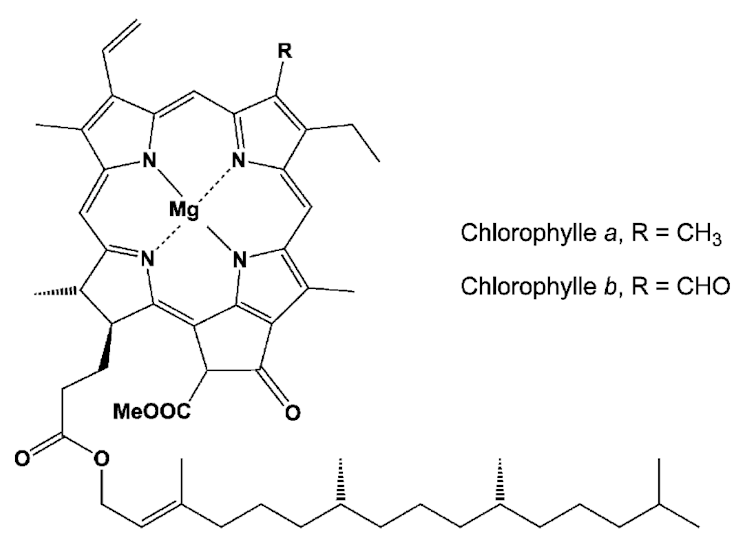

Il n’y a donc pas une mais des chlorophylles, A, B, C, D et F (sans parler des sous-types cl, c2, c3…), et la liste n’est probablement pas terminée (la forme F a été découverte en 2010). Si la chlorophylle A est universelle, la forme B se retrouve surtout chez des plantes, la C chez des algues brunes, des diatomées et des dinoflagellés, la D et la F chez des cyanobactéries. Si la chlorophylle E manque à l’appel, c’est qu’elle a été extraite en 1966 d’une algue, mais n’a toujours pas été décrite !

Du côté de leur composition chimique, ces molécules sont très proches de l’hème de notre hémoglobine, mais avec plusieurs différences de taille : l’ion métallique piégé est un ion magnésium et non ferrique. Surtout, au lieu de capter l’oxygène atmosphérique, la chlorophylle, elle, en rejette en découpant des molécules d’eau pour récupérer les atomes d’hydrogène.

La cascade biochimique est particulièrement complexe : la chlorophylle est la pièce maîtresse, parfois présente en plusieurs centaines d’unités, de photosystèmes qui comprennent d’autres molécules par dizaines. La très grande majorité des molécules de chlorophylle absorbent des photons et transmettent cette énergie d’excitation par résonance aux molécules voisines.

Les chlorophylles absorbent les radiations bleue et rouge, réfléchissant le jaune et le vert : voilà l’explication de la couleur des plantes. Les deux pics d’absorption peuvent varier sensiblement selon les types de chlorophylle. De proche en proche, cette énergie parvient jusqu’à une paire de molécules de chlorophylle, dans le centre de réaction du photosystème dont l’ultime fonction est de produire, d’un côté, les protons H+ et, de l’autre, les électrons.

Ces protons ainsi libérés peuvent alors être combinés au dioxyde de carbone (CO2) de l’air et former du glucose, un sucre vital au métabolisme de la plante et de tous les étres vivants. La réaction, qui consomme de l’eau et du CO, relargue comme déchet du dioxygène (O2).

Au fond, la conséquence la plus importante de l’apparition de la photosynthèse a été d’accroître de manière considérable la production primaire sur Terre, alors que celle-ci était initialement confinée à proximité des sources hydrothermales produisant du dihydrogène et du sulfure d’hydrogène, la photosynthèse a permis au vivant de se répandre partout à la surface du globe, pourvu que s’y trouvent de la lumière et de l’eau.

La photosynthèse capte près de six fois l’équivalent de la consommation énergétique de toute l’humanité pendant que nous relarguons des quantités invraisemblables de CO, par extraction d’énergies fossiles (35 milliards de tonnes chaque année), les organismes photosynthétiques en stockent entre 100 milliards et 115 milliards de tonnes par an sous forme de biomasse. Le joyeux club des consommateurs de CO2, comprend, outre les cyanobactéries à l’origine de la photosynthèse, d’autres bactéries, les algues et les plantes (par endosymbiose d’une cyanobactérie qui liera entièrement son destin à celui de la cellule eucaryote au fil de l’évolution, donnant naissance aux chloroplastastes).

Pourtant, le rendement de la photosynthèse demeure modeste : de l’ordre de 5 % de l’énergie lumineuse incidente est effectivement transformée en énergie chimique, soit dix fois moins que les meilleurs panneaux photovoltaïques actuels.

Viens voir un petit vert à la maison

D’autres règnes du vivant ont fait de la place à ces organismes, au bénéfice de tous les protagonistes (symbioses) ou parfois au détriment des organismes photosynthétiques. Les lichens, qui comprennent environ 20 % des espèces de champignons connues, prennent des teintes variées, qui vont du gris au jaune, à l’orange, au rouge et au vert. Dans tous les cas, ces organismes qui s’accrochent (le mot « lichen » dérive du grec leikho, lécher) sont des assemblages d’espèces auxquels les scientifiques ne cessent d’ajouter des membres.

Pendant près de cent quarante ans, on a pensé qu’il s’agissait d’une simple association entre un champignon ascomycète et une algue, avant de découvrir que la colocation pouvait être partagée avec une cyanobactérie chlorophyllienne ou fixatrice d’azote, plusieurs algues, un autre champignon (une levure basidiomycète, l’autre grand embranchement des champignons), ou encore des protistes (des eucaryotes unicellulaires) et des virus.

En résumé, les lichens sont des mini-communautés qui peuvent regrouper trois règnes du vivant, sans compter les virus ! On continue cependant de placer ces communautés au sein des champignons, car seuls ces derniers réalisent une reproduction sexuée. La grande variabilité de la coloration des lichens provient de la résultante entre les pigments exprimés par tous les colocataires.

Quand des animaux volent les chloroplastes des algues

Le règne fongique n’a pas l’exclusivité de l’endosymbiose avec les algues, tel est aussi le cas par exemple des cnidaires.

On peut citer dans cet embranchement, qui comprend notamment les coraux, l’actinie verte, une anémone que l’on trouve de la Manche à la Méditerranée. Elle héberge dans ses bras verdâtres à pointe rosée des zooxanthelles, des algues photosynthétiques. L’anémone perd sa jolie coloration en l’absence de ses hôtes et dépérit.

Le mouton de mer est une curieuse limace de mer qui présente sur son dos des excroissances fusiformes vertes à pointe rose et jaune, appelées cérates. Cette espèce asiatique, qui mesure moins d’un centimètre, vit à faible profondeur. Elle parvient à ne pas digérer immédiatement les chloroplastes des algues chlorophylliennes qu’elle avale et à les faire migrer vers ses appendices dorsaux. Si le sujet est encore débattu, il semble que ces plastes continuent d’être fonctionnels et de fournir un complément en sucres bienvenu en période de disette.

Ce processus, appelé kleptoplastie (du grec kleptes, voleur), est connu, outre chez ces gastéropodes marins, chez deux autres vers plats et chez divers eucaryotes unicellulaires (certains foraminifères, dinoflagellės, ciliés, alvéolés), chez qui les plastes demeurent fonctionnels une semaine à deux mois après l’ingestion des algues.

Parente américaine de notre salamandre tachetée avec qui elle partage notamment une livrée noire rehaussée de points jaunes (la marque aposématique qu’elle est toxique), la salamandre maculée a noué, elle aussi, un partenariat avec une algue photosynthétique : Oophila amblystomatis.

L’œuf gélatineux dans lequel se développe l’embryon présente une coloration verte causée par la prolifération de l’algue. Il a été démontré expérimentalement que ces algues ont un effet très bénéfique sur la croissance et la survie des embryons de la salamandre, probablement grâce à l’oxygène que libère l’algue tandis que celle-ci bénéficie des déchets azotés produits par le métabolisme de l’embryon. Un véritable cas de symbiose donc.

Pendant plus d’un siècle, on a pensé que les algues présentes dans les mares fréquentées par l’amphibien colonisaient les œufs, mais l’imagerie de pointe associée à la recherche de l’ADN de l’algue dans les tissus des embryons a révélé une tout autre histoire : les algues envahissent les tissus de l’embryon durant son développement, où elles semblent s’enkyster.

La salamandre adulte continue d’ailleurs de contenir ces algues en vie ralentie, bien qu’en quantité de moins en moins importante avec le temps : on retrouve en particulier dans ses voies reproductrices et les femelles semblent capables de transmettre certaines d’entre elles directement à leurs œufs ! Les scientifiques cherchent encore à comprendre comment un vertébré est parvenu dans son évolution à se laisser envahir par une algue sans provoquer une attaque en règle de son système immunitaire !

À lire aussi : Les oiseaux migrent-ils vraiment à cause du froid ? Et font-ils le même trajet à l’aller et au retour ?

Frédéric Archaux ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

15.12.2025 à 11:42

Le « quiet fighting » au travail : les signaux préinsurrectionnels dans une entreprise du CAC 40

Texte intégral (1927 mots)

Gare aux fausses promesses. Si les salariés semblent silencieux, des mouvements souterrains sont à l’œuvre qui pourraient aboutir à une nouvelle forme d’insurrection. Après le « quiet quitting » – ou démission silencieuse, le phénomène de « quiet fighting » pointe maintenant.

Alerte pour les grandes entreprises ! Le fossé entre les discours éthiques et les réalités opérationnelles nourrit à la fois un désengagement manifeste et une confrontation silencieuse qu’il faut traiter sans délai. À côté du quiet quitting, popularisé en 2022 comme la stricte limitation au périmètre du rôle et des efforts des collaborateurs, s’installe un quiet fighting plus insidieux, attisé par un sentiment d’injustice organisationnelle que le cadre théorique de Cropanzano et Folger permet de disséquer (cf. encadré 1).

Si les deux phénomènes possèdent un point commun, un déficit de justice interactionnelle, ces deux dynamiques ne forment pas un continuum. Quand le quiet quitting abaisse l’engagement au minimum, le quiet fighting combine dissidence empêchée et silence de résignation. L’une et l’autre peuvent préparer en sourdine à une confrontation avec l’entreprise. Notre enquête, prolongeant un premier travail réalisé dans le cadre d’une thèse de doctorat, établit que « l’hypocrisie organisationnelle » perçue autour des ambitions éthiques ouvre une brèche entre les entreprises et leurs collaborateurs, qui rejettent désormais l’éthique de façade.

Inégalités « justes » ou injustices illégitimes

Deux vagues d’entretiens approfondis, en 2024 et 2025 selon la méthode des incidents critiques, ont été conduites auprès d’une cinquantaine de collaborateurs volontaires dans le cadre d’une demande faite en commission « qualité de vie au travail » du Conseil social et économique d’un grand groupe du CAC 40. Plus de 120 incidents ont été recensés, croisant la vision de décideurs RH du siège (sur des sujets éthiques, diversité/discrimination) et de salariés d’une direction territoriale au plus près des opérations. Résultat clé : la majorité des situations relève aujourd’hui de sujets de « justice interactionnelle », bien davantage que de « justice distributive » ou « procédurale », telles qu’elles ont été conceptualisées par Cropanzano & Folger.

À lire aussi : « Quiet quitting » : au-delà du buzz, ce que révèlent les « démissions silencieuses »

Dans les organisations, les inégalités entre collaborateurs ne sont ni fortuites ni anormales. Elles sont souvent assumées, voire encouragées, comme des leviers d’incitation fondés sur la différenciation des performances et la hiérarchie des positions. Aux DRH d’en expliciter la légitimité et d’en travailler l’acceptabilité aux yeux des collaborateurs. Dans ce cadre, la grille des stratégies réactionnelles (Exit, Voice, Loyalty, Neglect) proposée par le socioéconomiste Albert Hirschman reste un outil utile pour éclairer les réactions des salariés face à des situations d’insatisfaction au travail (cf. encadré 2).

De la justice à la morale

Or notre étude montre que cette grille, si utile pour repérer et gérer les réactions des collaborateurs, ne suffit plus. La nature des injustices se déplace et suscite de nouvelles stratégies réactionnelles chez les salariés. Ce ne sont plus seulement les règles ou la répartition des résultats qui sont contestées, mais l’écart entre les discours éthiques et les pratiques organisationnelles. Quand l’expérience dément la promesse, le « contrat psychologique » se fissure et la question devient morale, touchant l’identité, la dignité, et une responsabilité qui dépasse les conflits transactionnels. Notre étude montre que l’on ne « négocie » plus une injustice morale jugée illégitime ; on la refuse.

Dans ce contexte, l’approche par l’EVLN apparaît incomplète. Elle saisit justement mal la dimension morale des conflits et l’incohérence ente les politiques affichées et les pratiques. L’épreuve de réalité est amplifiée par les exigences de publication extra-financière imposée par la directive de durabilité (CSRD), la vigilance citoyenne face au diversity/social washing et, en toile de fond, la tension décrite par le juriste Alain Supiot entre l’entreprise marchandise (ius proprietatis) et l’entreprise communauté morale (ius societatis) (cf. encadré 3).

Plus une organisation revendique une raison d’être morale, plus elle doit en apporter la preuve ; sinon, la loyauté de ses collaborateurs se mue en allégeance à contrecœur, porteuse de ressentiment.

Les sources du « quiet fighting »

Depuis les ordonnances « travail » de 2017, l’affaiblissement des médiations et de « dialogue social » ouvre un espace aux minorités actives décrites par Serge Moscovici. Dans notre étude, nous constatons qu’elles sont emmenées par des femmes racisées en position de cadres intermédiaires : elles formulent des récits cohérents et assument le risque de dissidence, mais se heurtent à des procédures neutralisantes et à l’absence de relais hiérarchiques. Il en résulte une [ dissidence empêchée] qui s’appuie en partie sur les travaux de la sociologue Maryvonne David-Jougneau : une mobilisation collective inachevée, dont l’influence reste pour le moment sans effet transformateur, mais qui contribue à accroître l’expérience organisationnelle et la capacité d’agir de ces cadres et des collectifs qu’elles animent.

À l’autre pôle émerge une colère souvent masculine, silencieuse et résignée. Ancrée dans un idéal méritocratique, elle repose sur la conviction que la performance, à elle seule, devrait protéger et « parler d’elle-même », sans qu’il soit besoin de la revendiquer. Cette colère est renforcée par l’attente, souvent déçue, d’une réparation portée par la DRH. Mais lorsque les circuits correctifs internes sont lents, incertains, ou centrés sur la conformité plutôt que sur l’explication et la reconnaissance du tort, la trahison institutionnelle s’impose et l’attente des collaborateurs devient ressentiment, prémisse d’un désir de revanche à fort potentiel déstabilisateur.

Ce silence de résignation, n’est pas un signe de paix sociale : il est la traduction d’une résistance contrainte, une colère froide qui prépare la confrontation, nourrie par l’empilement de micro-injustices, la polarisation, l’usure des institutions de dialogue et l’ascension d’acteurs minoritaires déterminés. Si l’explosion n’advient pas, c’est moins par loyauté que par contraintes économiques et sociales.

Une gouvernance à revoir

À l’échelle managériale, l’exigence est claire : gouverner par la justice interactionnelle. Cette gouvernance implique de :

aligner promesses et pratiques organisationnelles ;

expliquer les décisions sensibles et prévoir des voies d’escalade claires et sûres (manager N+1/N+2 → RH/Business Partner → référent éthique → dispositif d’alerte interne), assorties de garanties explicites de protection : interdiction de toute mesure liée au signalement (blâme, sanction, rétrogradation, baisse de variable, modification de poste, mise à l’écart, licenciement), confidentialité et possibilité d’anonymat, restitution motivée ;

proposer des médiations internes crédibles (médiateur interne formé, IRP ou Employee Resource Group) et en dernier ressort, des recours externes balisés : Inspection du travail, Défenseur des droits), pour pallier la faiblesse des instances de représentation du personnel ;

installer des capteurs précoces (baromètres qualitatifs, création d’espaces de délibération protégés) pour « reconnaître et réparer vite » toute inégalité illégitime ;

intégrer des objectifs de justice interactionnelle dans la performance sociale des dirigeants ;

répondre à la demande croissante des sciences de gestion : rendre compte non seulement de la classique matérialité financière, mais également de la matérialité d’impact, (effets négatifs de l’entreprise sur les parties prenantes), confirmant l’injonction de Supiot d’un ius societatis à assumer.

Réduire l’écart entre discours et réalité

Dans le sillage des travaux de la sociologue Laure Bereni, notre conclusion est une mise en garde aux organisations qui « jouent » encore avec l’éthique. L’écart entre discours et réalités, nourri par le social/diversity washing, alimente une conflictualité dans les organisations dont l’éthique devient l’étendard.

Le quiet fighting est un signal pré-insurrectionnel. Tandis que les coûts de sortie et l’incertitude du marché rendent l’exit improbable, le quiet fighting traduit une conflictualité interne croissante plutôt que des départs : ancré dans des enjeux moraux et identitaires, il s’exprime par une résistance à bas bruit et des coalitions discrètes. Les dirigeants disposent toutefois des leviers essentiels. Ils peuvent faire preuve plutôt que promettre, légitimer plutôt qu’imposer, soigner les interactions autant que les résultats. À ce prix, le quiet fighting s’éteindra et le conflit redeviendra une ressource. Répondre par la justice interactionnelle n’est pas un supplément d’âme mais une condition de viabilité sociale et économique et, désormais, un test décisif de crédibilité et de légitimité managériales.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

15.12.2025 à 11:41

Quand le management a fait des États-Unis une superpuissance

Texte intégral (3245 mots)

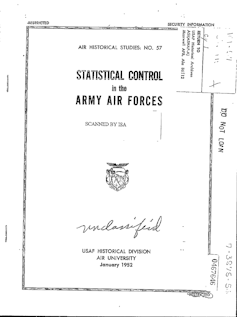

Une étude internationale, impliquant des chercheurs français, états-uniens et brésiliens, a mis au jour une histoire méconnue. Des années 1920 aux années 1960, le management a contribué à faire des États-Unis la puissance hégémonique que l’on connaît aujourd’hui. Son « momentum » : la Seconde Guerre mondiale. Ses armes : les managers formés dans les grandes écoles, les outils d’aide à la décision et la technostructure de l’État fédéral.

Explorer des archives, c’est évoluer dans un monde à la fois silencieux et étrange vu d’aujourd’hui. Comme l’explique l’historienne Arlette Farge dans son livre le Goût de l’archive (1989), le travail de terrain des historiens est souvent ingrat, fastidieux, voire ennuyeux. Puis au fil de recoupements, à la lumière d’une pièce en particulier, quelque chose de surprenant se passe parfois. Un déclic reconfigurant un ensemble d’idées.

C’est exactement ce qui est arrivé dans le cadre d’un projet sur l’histoire du management états-unien (HIMO) débuté en 2017, impliquant une douzaine de chercheurs français, états-uniens et brésiliens.

Notre idée ? Comprendre le lien entre l’histoire des modes d’organisation managériaux du travail et les épisodes de guerre aux États-Unis. D’abord orientée vers le XXe siècle, la période d’étude a été resserrée des années 1920 à la fin des années 1960, avec comme tournant la Seconde Guerre mondiale.

Du taylorisme au management

Au début de notre recherche en 2017, nous nous sommes demandé ce qui guidait cette métamorphose du management des années 1920 aux années 1960.

Au commencement était le taylorisme. On attribue à l’ingénieur américain Frederick Winslow Taylor (1856-1915) l’invention d’une nouvelle organisation scientifique du travail dans The Principles of Scientific Management. Ce one best way devient la norme. Au cœur de cette division du travail, la mutation des rôles des contremaîtres est essentielle.

Leur fonction est d’abord de s’assurer à la fois de la présence des ouvriers et du respect des gestes prescrits par les dirigeants. Avec le management, une révolution copernicienne est en marche. Les contremaîtres sont progressivement remplacés par les techniques de management elles-mêmes. Le contrôle se fait à distance, et devient de l’autocontrôle. Des outils et des systèmes d’information sont développés ou généralisés, comme les pointeuses. Peu à peu, toutes ces informations sont connectées à des réseaux… qui dessinent ce qui deviendra des réseaux informatiques. L’objectif : suivre l’activité en temps réel et créer des rapports à même d’aider les managers dans leur prise de décision.

Outils de gestion de projet

C’est ce que la philosophie nomme le représentationnalisme. Le monde devient représentable, et s’il est représentable, il est contrôlable. Sur un temps long, de nombreux outils de gestion de projet sont créés comme :

le diagramme de Gantt, formalisé et diffusé dans les années 1910 par l’ingénieur du même nom, afin de visualiser dans le temps les diverses tâches ;

le Program Evaluation and Review Technic (PERT), élaboré dans les années d’après-guerre pour analyser et représenter les tâches impliquées ;

ou les Key Performance Indicators (KPI), des indicateurs utilisés pour l’aide à la décision.

Nombre de ces techniques ou standards de management ont une genèse américaine comme l’ont montré notamment les travaux de Locke et Spender, Clegg, Djelic ou D’Iribarne. Des années 1910 aux années 1950, une importance croissante est accordée à la visualisation des situations.

À lire aussi : Les origines néolibérales de la mondialisation : retour sur l’émergence d’un ordre géopolitique aujourd’hui menacé

Notre intuition d’une obsession pour la représentation s’est affinée avec l’exploration d’archives liées aux réseaux du management, de l’Academy of Management, l’American Management Association, et la Society for Advancement of Management.

Management de l’armée

Dans son introduction de la conférence de l’Academy of Management de 1938, l’économiste Harlow Person, acteur clé de la Taylor Society, revient sur le rôle joué par la visualisation. Concrètement, une mission d’amélioration des processus administratifs est réalisée pour l’armée américaine durant la Première Guerre mondiale. L’organisation scientifique du travail déploie plus que jamais ses outils au-delà des chiffres et du texte.

Pendant la Seconde Guerre mondiale, l’obsession pour la représentation est au cœur de la stratégie militaire des États-Unis, en synergie vraisemblablement avec le management. Par exemple, la carte d’état-major doit représenter la situation la plus fidèle possible au champ de bataille. Chaque drapeau, chaque figurine représentant un bataillon ami ou ennemi, doit suivre fidèlement les mouvements de chacun lors du combat. Toutes les pièces évoluant en temps réel permettent au généralissime de prendre les meilleures décisions possibles.

Mise en place d’une technostructure par Franklin Roosevelt

Un président des États-Unis incarne cette rupture managériale dans la sphère politique : Franklin Roosevelt. Secrétaire assistant à la Navy dans sa jeunesse, il assimile l’importance des techniques d’organisation dans les arsenaux maritimes de Philadelphie et New York, pour la plupart mis en œuvre par les disciples de Frederick Winslow Taylor.

Après la crise de 1929, la mise en place de politiques centralisées de relance a pour conséquence organisationnelle d’installer une technostructure. Plus que jamais, il faut contrôler et réguler l’économie. Un véritable État fédéral prend naissance avec la mobilisation industrielle initiée dès 1940.

Lorsque le New Deal est mis en place, Franklin Roosevelt comprend que le management peut lui permettre de changer le rapport de force entre pouvoir exécutif et pouvoir législatif. Progressivement, il oppose la rationalité de l’appareil fédéral et son efficience à la logique plus bureaucratique incarnée par le Congrès. Concrètement, les effectifs de la Maison Blanche passent de quelques dizaines de fonctionnaires avant la Seconde Guerre mondiale à plus de 200 000 en 1943.

Le président des États-Unis dispose désormais de l’appareil nécessaire pour devenir « l’Arsenal de la démocratie », à savoir l’appareil productif des Alliés. Cette transformation contribue à faire des États-Unis la première puissance militaire mondiale au sortir de la Seconde Guerre mondiale, alors qu’elle n’était que 19e avant son commencement.

Standardisation mondiale par le management

Au-delà d’une obsession nouvelle pour la représentation tant organisationnelle que politique, la seconde dimension mise en lumière par cette recherche sur l’histoire du management est plus inattendue. Elle porte sur la mise en place d’une véritable géopolitique états-unienne par le management. Notre travail sur archive a permis de mieux comprendre la genèse de cette hégémonie américaine.

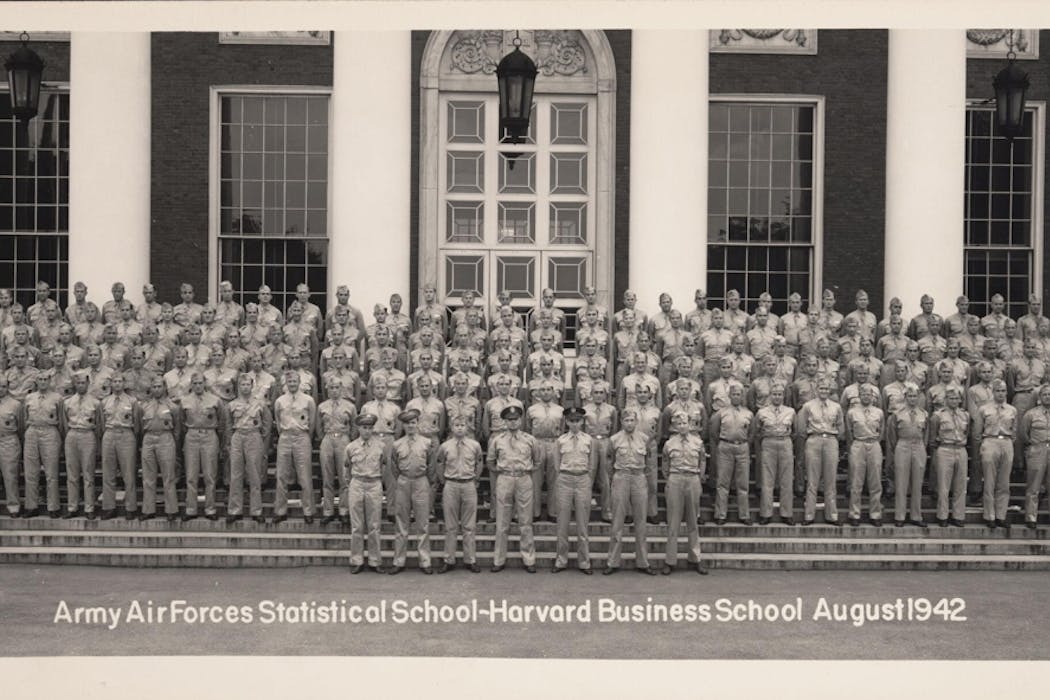

La standardisation des formations au management, en particulier par des institutions telles que la Havard Business School, a contribué subtilement à cette géopolitique américaine. Tout le développement de la connaissance managériale se joue sur le sol des États-Unis et l’espace symbolique qu’il étend sur le reste du monde, du MBA aux publications académiques, dont les classements placent aujourd’hui systématiquement les revues états-uniennes au sommet de leur Olympe.

Il en va de même pour le monde des cabinets de conseil en management de l’après-guerre, dominé par des structures américaines, en particulier pour la stratégie. En 1933, le Glass-Steagall Act impose aux banques la séparation des activités de dépôt de celles d’interventions sur les marchés financiers et de façon connexe, et leur interdit d’auditer et de conseiller leurs clients. Cela ouvre un espace de marché : celui du conseil externe en management, bientôt dopé par la mobilisation industrielle puis la croissance d’après-guerre.

Des cabinets se développent comme celui fondé par James McKinsey en 1926, professeur de comptabilité à l’université de Chicago. Son intuition : les entreprises souffrent d’un déficit de management pour surmonter la Grande Dépression et croître après la Seconde Guerre mondiale. De nombreux cabinets suivent cette tendance comme le Boston Consulting Group créé en 1963.

Près de 500 000 blessés industriels

Un des points les plus frappants de notre recherche est la conséquence du management sur le corps pendant le momentum de la Seconde Guerre mondiale. Plus de 86 000 citoyens des États-Unis meurent dans les usines entre 1941 et 1945, 100 000 sont handicapés sévères et plus de 500 000 sont blessés au travail.

Une partie de nos archives sur le Brooklyn Navy Yard de New York l’illustre tristement. Dans le silence, chacun et chacune acceptent une expérience de travail impossible en considérant que leur fils, leur maris, leurs neveux, leurs amis au combat vivaient des situations certainement bien pires. Le management se fait alors patriote, américain et… mortifère.

Au final, les managers ont continué à taire une évidence tellement visible qu’on ne la questionne que trop peu : celle de l’américanité de ce qui est également devenu « nos » modes d’organisation. Au service d’une géopolitique américaine par le management.

Le projet de recherche HIMO (History of Instittutional Management & Organization) mentionné dans cet article a reçu des financements du PSL Seed Fund, de QLife et des bourses de mobilité de DRM.

15.12.2025 à 11:41

Cinq proverbes qui façonnent notre vision du management

Texte intégral (2480 mots)

« À chaque jour suffit sa peine », « Rendre à César ce qui est à César », « Que chacun balaie devant sa porte », « À l’impossible nul n’est tenu », « Aide-toi et le ciel t’aidera », ces cinq proverbes irriguent notre quotidien et notre vie au travail. Que disent-ils de notre façon de concevoir le management ?

« À chaque jour suffit sa peine »

Le proverbe trouve son origine dans l’Évangile de Jésus-Christ selon saint Matthieu.

Bien sûr, le manager qui ne chercherait pas à anticiper ne remplirait pas totalement son rôle. Mais réaffirmer que chaque journée est en soi une fin, qu’il ne faille pas empiler les difficultés probables ou à venir, est aussi une manière de les traiter dans l’ordre, sans s’y perdre et sans perdre son équipe. Pour le dire autrement, il y a une gestion des temporalités qui nous invite à qualifier et requalifier, sans cesse et avec exigence, les urgences, en les distinguant de ce qui est important – comme nous invite la matrice d’Eisenhower.

Par exemple, la gestion inadaptée des courriels, qui sont pourtant, comme le rappelle la chercheuse en sciences de l’information et de la communication Suzy Canivenc, des outils de communication asynchrone (en dehors du temps réel), illustre notre incapacité à bien gérer notre temps.

Le rôle d’un manager n’est pas nécessairement de tout traiter, de tout lire, d’apporter à toute demande une réponse, de décider de tout. Un temps de germination peut être le bienvenu pour, tout à la fois, laisser se dissoudre d’elles-mêmes certaines requêtes (l’émetteur ayant trouvé la réponse par lui-même ou par une autre voie), voire, qu’une posture managériale souhaitable est précisément de ne pas donner réponse ou audience à tout.

Laisser « reposer à feu doux » un sujet problématique est une façon de ne pas traiter dans l’urgence, et de s’ôter le stress associé. S’en remettre au lendemain, c’est alors faire confiance à cette part de nous-mêmes qui, même au repos, fait que notre cerveau continue à œuvrer.

« Rendre à César ce qui est à César »

Cet emprunt à l’Évangile selon saint Luc pourrait nous inspirer cette réflexion : que chacun se contente de s’attirer les louanges qu’il mérite, sans éprouver le besoin de s’approprier celles d’autrui.

Si la reconnaissance est un enjeu majeur, il semble hélas que nombre d’organisations ont « la mémoire courte ». Elles oublient d’où elles viennent, ce qu’elles ont entrepris, et à qui elles le doivent. Les inspirateurs, les pionniers, les innovateurs ou les transformateurs n’ont pas toujours la reconnaissance qu’ils méritent. Prendre le temps de remercier, aussi, le concours d’un service support (l’informatique, les achats ou la communication), sans lequel un projet n’aurait pu être mené à bien, peut figurer ici.

Si l’on admet avec Adam Smith dans la Théorie des sentiments moraux et Axel Honneth dans la la Lutte pour la reconnaissance, que la reconnaissance est l’un des moteurs de nos vies, alors il convient de garder la trace, de n’oublier aucune contribution dans une réussite qui ne peut, jamais, être le fruit d’une seule entité et d’une seule personne.

« Que chacun balaie devant sa porte et les rues seront nettes »

L’exemplarité, comme le précise la professeure en comportement organisationnel Tessa Melkonian, invite à la congruence. Soit cet alignement entre ce que je dis, ce que je fais et ce que je communique de façon explicite et implicite. Un manager est reconnu pour sa capacité à incarner les valeurs et les postures attendues de chacun, à montrer la voie quand une décision nouvelle doit s’appliquer au collectif de travail.

De même, avant de prononcer une critique, il doit veiller à ce que sa propre pratique ne puisse faire l’objet d’une semblable observation. Devoir être exemplaire en tout requiert de l’énergie, de l’attention, de la constance. C’est une discipline, sans laquelle l’exigence devient un vœu pieux. Mais elle fonctionne dans une logique de réciprocité : ses collaborateurs doivent pouvoir eux-mêmes démontrer leur exemplarité avant de l’exposer à leurs propres critiques.

« À l’impossible nul n’est tenu »

Certaines missions, certaines tâches, excèdent les capacités d’une personne ou d’un collectif. Il est essentiel de le rappeler, dans une époque marquée par la quête de l’exploit et les logiques de « performance ».

Dans ce contexte, oser dire que l’échéance n’est pas tenable, sauf à dégrader la qualité des tâches (ce qui, dans certaines circonstances, peut parfaitement être audible), témoigne plutôt d’une forme de courage. Cette posture implique des contre-propositions, une voie de sortie, et non seulement une fin de non-recevoir.

Le droit à l’erreur prend ici toute sa place. Reconnaître aux équipes et se reconnaître ce même droit en tant que leader, comme nous y invite Tessa Melkonian, c’est l’un des marqueurs de l’époque. Comment rassurer une équipe sur ce droit si le manager lui-même ne sait pas évoquer ses propres échecs et ne s’autorise par des essais-erreurs ?

Il s’agit bien d’oser dire que l’on s’est trompé, que l’on a le droit de se tromper, mais le devoir de réparer, et, surtout, de ne pas reproduire la même erreur. Ici, plus qu’ailleurs peut-être, l’exemplarité managériale aurait un impact fort : entendre un dirigeant reconnaître publiquement une erreur pourrait faire beaucoup. L’ouvrage Un pilote dans la tempête, paru récemment, de Carlos Tavares, l’ancien PDG de Stellantis, constitue un témoignage éloquent de cette absence de remise en question – notamment pour ce qui concerne les décès dus aux dysfonctionnements de certains airbags.

« Aide-toi, le ciel t’aidera »

Ce proverbe popularisé par Jean de La Fontaine dans le Chartier embourbé introduit la notion de care en management. Issue des travaux pionniers de la psychologue Carol Gilligan, cette forme d’éthique nous invite à considérer les relations entre humains à travers le prisme de la vulnérabilité, de facto du soin, reçu et prodigué.

Comme nous le dit le philosophe Éric Delassus :

« L’incapacité à assumer sa vulnérabilité est la cause d’un grand nombre de difficultés dans le monde du travail, tant pour les managers que pour les managés. […] Qu’il s’agisse de difficulté propre au travail ou concernant la compatibilité entre vie professionnelle et vie personnelle ou familiale, on n’ose en parler ni à ses pairs ni à ses supérieurs de peur de passer pour incompétent, pour faible ou incapable. […] Alors, qu’en revanche, si chacun percevait sa propre vulnérabilité et celle des autres avec une plus grande sollicitude, personne n’hésiterait à demander de l’aide et à aider les autres. »

Il s’agit bien d’oser, simplement, requérir l’aide d’un collègue. En entreprise, demander un soutien demeure complexe. L’éthique du care nous ouvre une perspective inédite et bienvenue : aide ton prochain et réciproquement, sollicite son aide. Car l’autre ne m’aidera que si je lui permets de le faire, si j’accepte donc de me révéler dans toute ma vulnérabilité.

Benoît Meyronin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

15.12.2025 à 11:40

Il n’est pas possible de gérer un club sportif professionnel comme une entreprise : voici pourquoi !

Texte intégral (1863 mots)

Même si l’argent joue un rôle important dans le sport de haut niveau, la gestion d’un club sportif, ni vraiment différent ni vraiment semblable à une autre entreprise, obéit à des contraintes particulières. Les raisons ne manquent pas pour expliquer pourquoi leur management ne peut être identique.

Du fait de la professionnalisation de l’univers du sport, la gestion d’un club sportif professionnel (CSP) semble tout à fait comparable à celle d’une entreprise. En France, dans les années 1990-2000, Anny Courtade, à la fois PDG de Locasud (la centrale d’achat des magasins Leclerc dans le sud-est de la France) et du Racing Club de Cannes (volley-ball féminin) a par exemple souvent été présentée comme un brillant exemple de réussite combinée.

Au vu de cet exemple, le transfert de compétences semble assez simple : il faut s’inspirer des facteurs clés de succès existants dans le monde des affaires, en s’adaptant à l’environnement du sport. Et pourtant… Nombreux sont, à l’inverse, les chefs d’entreprise (Laurent Tapie, Laurent Platini, Peter Lim…) qui ont brillamment réussi dans leurs activités professionnelles mais qui ont échoué dans le domaine sportif. Un argument souvent avancé pour expliquer ces échecs est l’aveuglement qui serait lié à la passion conduisant à des problèmes de gouvernance. Notre vision des choses est quelque peu différente pour les sports collectifs.

Des contraintes différentes

Si le management d’un club sportif professionnel (CSP) ne peut pas emprunter les mêmes voies qu’une entreprise classique, c’est d’abord parce que ces deux types d’organisation ne se ressemblent pas autant qu’il pourrait sembler de premier abord.

Les contraintes à gérer sont très différentes, à commencer par le cadre juridique. Si, comme toutes les entreprises, les CSP peuvent choisir des statuts juridiques (SASP ou SARL sportives), ils doivent aussi créer une association sportive pour être affiliés à leur fédération de tutelle. Un lien de dépendance en résulte, notamment en cas de conflit entre l’association et la société commerciale. Cette délégation obligatoire de l’activité professionnelle leur est imposée par le Code du sport (article 2 122-1 et suivants) qui diffère du code de commerce sur de nombreux points. Les modes de régulation sont aussi différents.

Une action scrutée par les supporters

Une autre divergence cruciale concerne l’exposition médiatique : faible pour la majorité des chefs d’entreprise, elle est très forte pour les dirigeants des CSP. Cela produit des obligations très éloignées. À la différence d’un chef d’entreprise qui communique rarement auprès d’un large public mais plutôt auprès d’acteurs ciblés (collaborateurs, actionnaires, fournisseurs, clients…), les décisions, les déclarations, les réactions d’un président de CSP sont scrutées en permanence et peuvent générer de nombreuses crises (médiatiques, avec les supporters, les partenaires…).

À lire aussi : Pernod Ricard et le PSG : quand le territoire se rappelle à l’entreprise

Par répercussion, les horizons temporels de l’action s’opposent : de très court-terme pour un président de CSP, plus lointain pour un chef d’entreprise. Ces différences influent sur leur notoriété, leur popularité, leurs relations avec les parties prenantes et donc leurs motivations. Souvent inconnues du grand public, celles-ci finissent souvent par transparaître et donc par avoir des conséquences sur la légitimité des uns et des autres. Les chefs d’entreprise tirent leur légitimité de leur efficacité économique et de la confiance inspirée aux investisseurs. Celle des présidents de CSP repose sur une combinaison beaucoup plus fragile entre légitimité institutionnelle, populaire, sportive et même souvent symbolique.

La majorité des CSP ambitionnent de maximiser leurs résultats sportifs (se maintenir dans la division dans laquelle ils évoluent, participer aux compétitions européennes) sous contrainte économique (du fait de leur budget ou des décisions des instances de régulation. Les entreprises cherchent à maximiser leurs résultats économiques en prenant en compte les contraintes réglementaires des pays où ils sont implantés.

Un rapport différent à l’incertitude

Indirectement, cela produit un rapport différent à l’incertitude. Les chefs d’entreprise mobilisent des techniques pour la limiter. Les présidents de CSP font de même dans leur gestion courante mais souhaitent la voir perdurer au niveau sportif – on parle même de la glorieuse incertitude du sport- pour maintenir l’intérêt des compétitions et donc des spectacles sportifs.

Autre différence : les marchés sur lesquels interviennent les entreprises sont le plus souvent libres et ouverts, les marchés sur lesquels évoluent les CSP sont davantage encadrés. L’existence de ces réglementations résulte en partie de la nature de la production : elle est jointe. Un CSP ne peut pas produire seul une rencontre sportive, il faut a minima deux équipes pour un match. Cela implique, obligatoirement, une forme de coopération entre les concurrents alors que les entreprises peuvent librement décider de leur stratégie.

La pression des résultats

Ces différences induisent que le management des unes et des autres ne peut pas être le même. Au niveau stratégique, la première différence, concerne la temporalité. Pour les chefs d’entreprise, l’horizon est le moyen ou long terme ; pour les présidents de CSP la saison sportive, soit plus qu’un trimestre. Dans ce domaine, la nature même de l’activité impose une gestion temporelle réactive avec de fréquents ajustements en fonction des blessures, des résultats, de l’évolution de l’effectif.

À l’inverse, dans de nombreuses entreprises, la notion de planification conserve un intérêt. Plus précisément, dans les CSP la diversification, est la seule option envisageable, la stratégie volume/coût étant hors de portée puisqu’il n’est pas possible d’augmenter de façon importante le nombre de matchs joués, ni de réduire drastiquement les coûts de fonctionnement, la majorité d’entre eux étant fixes.

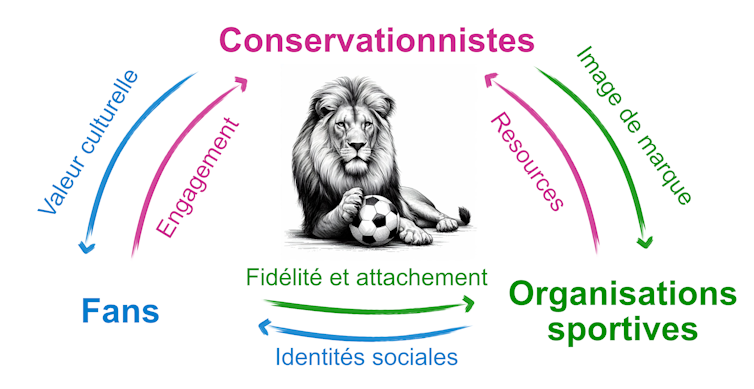

En ce qui concerne le marketing et la gestion commerciale, si la majorité des entreprises définissent et choisissent un positionnement, peu de CSP le font. Les déterminants de l’image de marque diffèrent sur de nombreux points. Il en va de même des déterminants de la valeur perçue et donc indirectement de l’attractivité.

Le poids de l’histoire

Beaucoup plus que dans les entreprises, l’histoire du club joue un rôle dans la perception de la valeur de la marque par les « clients-fans », valeur difficile à apprécier. Les « expériences client » divergent également : elles sont « classiques » dans les entreprises ; dans les CSP « immersives ». Les interactions qui apparaissent entre les fans d’un club (simples spectateurs, supporters, partenaires, élus..) sont primordiales. Ces interactions n’existent quasiment pas dans les entreprises.

Du fait du caractère aléatoire de l’activité de « spectacle sportif », les CSP ont des difficultés pour obtenir d’importants concours bancaires. D’autres sources de financement doivent être recherchées. Trois se dégagent clairement :

la commercialisation de nombreux droits (entrés, TV, image, exposition, appellation, numériques) ;

l’apport en compte courant d’actionnaires ;

à cela s’ajoute pour le football, le trading joueurs soit la pratique consistant à vendre une partie des actifs immatériels détenus par les clubs, c’est-à-dire, certains joueurs « sous contrat ».

En dépit du recours à ces possibilités, l’équilibre budgétaire n’est pas toujours atteint en fin de saison dans les CSP. L’une des causes principales, qui distingue fondamentalement ce secteur de la majorité des autres, réside à la fois dans l’importance des coûts salariaux et dans leur caractère quasiment incompressibles.

Des RH sous contraintes

Pour ce qui est des ressources humaines, les mutations reposent sur des principes différents. Tout d’abord en ce qui concerne l’agenda : possible à tout moment dans l’entreprise, limitées à des périodes précises (mercato) dans les CSP. Les sommes engagées diffèrent également. Dans les entreprises, elles sont plus ou moins explicitement déterminées par des « grilles », dans les CSP elles sont le fruit d’âpres négociations.

Par ailleurs, dans les premières, le plus souvent la décision est prise par l’employeur. Elle l’est fréquemment par les joueurs dans les CSP, ce qui confronte les présidents de club à un dilemme spécifique : faut-il « laisser filer » le joueur au risque d’affaiblir l’équipe ou, au contraire, faut-il le conserver dans l’effectif contre sa volonté, au risque qu’il soit moins performant ?

La question des rémunérations se pose également dans des termes distincts, les possibilités de mesure de la productivité, l’influence de la médiatisation et le rôle des agents de joueurs en étant les principales explications.

Patrice Bouvet ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

14.12.2025 à 17:59

Airbus : D’où vient la panne qui a conduit l’entreprise à immobiliser des milliers d’avions ?

Texte intégral (2103 mots)

Fin octobre, Airbus demande aux compagnies aériennes de maintenir au sol 6 000 A320, à la suite d’un incident survenu en vol. L’entreprise l’explique par une mise à jour logicielle qui serait plus sensible aux rayonnements cosmiques. Si ce genre de problèmes existe, ils sont cependant détectés immédiatement en temps normal.

Le 30 octobre dernier, un vol de Cancún vers le New Jersey de la compagnie JetBlue a rapidement chuté en plein vol, avant que les pilotes puissent rétablir sa trajectoire, au bout de quelques secondes. Après un atterrissage en urgence en Floride, quelques passagers ont reçu des soins. À la suite de cet incident, Airbus a dû changer en urgence un logiciel de pilotage dans 6000 appareils de la famille A320. On a évoqué une « perturbation par une particule isolée » et le rôle des éruptions solaires. Qu’en est-il ?

Le palliatif proposé par Airbus est de faire revenir la version de certains logiciels de pilotage à une version antérieure. Sur les forums spécialisés, on spécule sur les causes techniques de ce dysfonctionnement, sur d’éventuelles fonctionnalités ajoutées entre ces deux versions, qui seraient insuffisamment protégées contre les effets que des rayonnements cosmiques peuvent avoir dans les composants informatiques. Il vaut mieux, toutefois, attendre le rapport officiel de l’enquête sur l’incident. En attendant, nous pouvons revenir sur l’explication invoquée et en quoi elle peut surprendre.

Les rayons cosmiques, ennemis de nos systèmes électroniques

La Terre est en permanence bombardée par des particules venant de l’espace – du Soleil ou de corps plus lointains. La plupart de ces particules sont déviées par le champ magnétique terrestre, une autre partie est absorbée ou transformée par l’atmosphère, mais certaines d’entre elles peuvent atteindre la surface terrestre. Elles forment une partie de la radioactivité naturelle, et sont plus abondantes en périodes d’éruption solaire.

Ces particules arrivant de l’espace ont des effets variés. Dans les régions polaires, moins protégées par le champ magnétique terrestre, elles provoquent de magnifiques aurores dans le ciel de nuit. On leur attribue également les flashes lumineux que les astronautes perçoivent dans leurs yeux. Comme il s’agit de rayonnements ionisants, les particules reçues peuvent avoir des effets sur la santé. Ainsi, Thomas Pesquet, en six mois de séjour dans la station spatiale internationale, a bien dépassé le quota annuel maximum d’exposition aux radiations permis pour un travailleur français.

Les particules issues de l’espace peuvent provoquer des dysfonctionnements dans les circuits électroniques. Par exemple, dans les années 1990, des composants électroniques de puissance, notamment conçus pour des trains, grillaient pour des raisons mystérieuses. Pour trier parmi les diverses hypothèses envisagées, on a essayé ces composants à la surface et dans une mine de sel, sous 140 mètres de roche : les problèmes ne se produisaient pas dans la mine ! Une fois le problème identifié, on a pu concevoir des composants et des modes d’utilisation beaucoup moins vulnérables.

Qu’est-ce qu’une perturbation par une particule isolée ?

Il est plus courant que, plutôt que de griller un composant, les particules modifient une donnée qui y est stockée. Les ordinateurs retiennent les informations sous forme de 0 et de 1, et une particule peut provoquer le basculement d’un 0 en 1 ou l’inverse, ce qu’on appelle une « perturbation par une particule isolée », ou single event upset en anglais.

En 2003, dans la commune belge de Schaerbeek, une liste a obtenu lors d’une élection un excès de précisément 4 096 voix, ce qui correspond exactement au basculement d’un 0 en 1 à l’intérieur d’un nombre écrit en binaire. Un tel basculement s’expliquerait par un single event upset.

Bien évidemment, et notamment pour les applications aérospatiales, particulièrement exposées, on a développé des parades. Certaines parades sont matérielles : par exemple, les mémoires vives peuvent être munies de codes correcteurs d’erreurs fondés sur du matériel spécifique pour coder et décoder très rapidement. C’est habituellement le cas de la mémoire vive des serveurs, les machines qui stockent des données dans les data centers, mais pas des ordinateurs de bureau ou des portables, du fait de leur coût. Ces codes permettent de corriger à coup sûr certaines erreurs et, dans d’autres cas, d’au moins signaler qu’il s’est passé quelque chose d’incorrect.

D’autres parades sont logicielles : procéder régulièrement à certaines vérifications, dupliquer des données à conserver sur de longues durées, éviter de garder trop longtemps des données dans des mémoires vulnérables, enregistrer certaines informations importantes d’une façon telle que le basculement d’un chiffre fournit une valeur absurde, donc détectable… Les possibilités sont nombreuses. Il y a par ailleurs des protocoles de test, y compris consistant à placer les circuits dans le faisceau d’un accélérateur de particules (grand instrument de sciences physiques).

Des commandes de vol électriques touchées par une panne

Voyons maintenant les implications pour l’aviation. La transmission des ordres des pilotes de ligne à leurs gouvernes, les parties mobiles de l’avion qui permettent de contrôler sa trajectoire, se faisait historiquement par des systèmes de câbles, de poulies ou de circuits hydrauliques assez compliqués. Il faut en plus assurer la redondance, c’est-à-dire prévoir plusieurs modes de transmission en cas de panne. Depuis les années 1980, les nouveaux modèles d’avions utilisent des commandes de vol électriques, c’est-à-dire que ces transmissions mécaniques sont remplacées par des câblages et des calculateurs électroniques.

Ces calculateurs diminuent la charge de pilotage (ils automatisent des actions que les pilotes devraient sinon faire manuellement) et augmentent ainsi la sécurité. Ils peuvent vérifier si les pilotes commandent une manœuvre qui sortirait l’avion du domaine des manœuvres qu’il peut faire en sécurité, et peuvent par exemple prévenir le décrochage. La panne qui a valu le rappel des avions Airbus concerne un calculateur appelé ELAC, qui commande les élévateurs et les ailerons, qui sont respectivement des gouvernes situées sur le stabilisateur arrière de l’avion et sur l’arrière du bout des ailes.

Les commandes de vol sont particulièrement sécurisées

Un point qui peut tout d’abord nous rassurer est que les problèmes de particules venues de l’espace se produisent plutôt à haute altitude, lorsqu’il y a moins d’atmosphère protectrice, alors que les étapes les plus dangereuses dans un vol sont plutôt le décollage et l’atterrissage. Ceci n’excuse cependant pas le dysfonctionnement constaté. Voyons un peu pourquoi ce problème n’aurait pas dû se produire.

Les calculateurs informatisés d’aviation civile sont classés, suivant les standards internationaux de l’aviation civile, en cinq niveaux de criticité, selon la sévérité des conséquences possibles d’un dysfonctionnement : du niveau A, où un dysfonctionnement peut provoquer une catastrophe aérienne, au niveau E, où il n’y aurait pas de conséquences pour la sécurité de l’aéronef. Les commandes de vol électriques sont du niveau A, elles sont donc soumises aux normes les plus sévères. On peut donc raisonnablement supposer que les commandes de vol des A320 sont équipées de mécanismes de détection et/ou de remédiation de dysfonctionnements, y compris dus aux radiations.

Sur les Airbus A330/A340, par exemple, il existe deux niveaux de commande de vol, primaires et secondaires. Il y a trois boîtiers de commandes primaires, et lorsqu’un boîtier a subi un problème, il est temporairement désactivé – ce n’est pas grave, car il en a deux autres pour le relayer. S’il y avait un problème générique sur les commandes primaires, on pourrait fonctionner avec les commandes secondaires, qui utilisent d’autres types de composants.

Chaque boîtier de commande de vol primaire consiste en deux calculateurs, l’un qui commande les gouvernes, l’autre qui surveille celui qui commande – ils doivent produire environ les mêmes résultats, sinon le système détecte que quelque chose ne va pas. Normalement, sur un tel système, en cas de dysfonctionnement d’un des calculateurs, le problème est rapidement détecté, le boîtier est désactivé, on passe sur un autre et une chute comme celle qui s’est passée en octobre est impossible.

Pourquoi les systèmes n’ont-ils pas détecté le problème ?

J’ai personnellement travaillé sur l’analyseur statique Astrée, un outil destiné à vérifier que des logiciels de contrôle ne se mettent jamais dans des situations d’erreur. Il a notamment été utilisé par Airbus sur ses commandes de vol électriques. J’ai eu l’occasion, au fil des années, d’apprécier le sérieux et la volonté de cette société de se doter d’approches à la pointe de l’état de l’art en matière de technologies logicielles, notamment de vérification formelle.

Plus récemment, j’ai également travaillé sur des contre-mesures à des erreurs de fonctionnement informatique provoquées volontairement à l’aide de rayonnements électromagnétiques. Il existe en effet la possibilité que des personnes induisent volontairement des pannes afin de les exploiter dans un but frauduleux, c’est donc nécessaire de travailler à prévenir ces tentatives pour des cartes à puce et d’autres équipements sécurisés.

L’hypothèse qu’il s’agisse bien d’une perturbation par une particule isolée reste plausible, mais il est surprenant qu’il ait fallu plusieurs secondes pour traiter le problème. Le système de sécurité du boîtier de commande affecté par l’irradiation aurait dû détecter l’incident, le boîtier touché aurait dû être automatiquement désactivé et l’avion basculé sur un autre, en secours. Il faut donc attendre d’autres éléments pour déterminer si c’est la bonne explication, et comment cela a pu alors se produire, ou si d’autres scénarios sont à envisager.

David Monniaux a reçu des financements de l'ANR (PEPR Cybersécurité). En tant que co-développeur de l'analyseur Astrée, il touche une prime d'intéressement à la valorisation de ce logiciel, donc à ses ventes.

14.12.2025 à 17:58

Changer les algorithmes des réseaux sociaux suffit à réduire l’hostilité politique

Texte intégral (1107 mots)

Les fils d’actualité des réseaux sociaux sont conçus pour capter notre attention. Mais de simples ajustements dans les algorithmes qui les sous-tendent permettent d’apaiser le débat public.

Réduire la visibilité des contenus polarisants dans les fils d’actualité des réseaux sociaux peut diminuer de manière tangible l’hostilité partisane. Pour parvenir à cette conclusion, mes collègues et moi avons développé une méthode permettant de modifier le classement des publications dans les fils d’actualité, une opération jusque-là réservée aux seules plateformes sociales.

Le réajustement des fils pour limiter l’exposition aux publications exprimant des attitudes anti-démocratiques ou une animosité partisane a influencé à la fois les émotions des utilisateurs et leur perception des personnes ayant des opinions politiques opposées.

Je suis chercheur en informatique spécialisé dans l’informatique sociale, l’intelligence artificielle et le web. Comme seules les plateformes de réseaux sociaux peuvent modifier leurs algorithmes, nous avons développé et rendu disponible un outil web open source permettant de réorganiser en temps réel les fils d’actualité de participants consentants sur X, anciennement Twitter.

S’appuyant sur des théories des sciences sociales, nous avons utilisé un modèle de langage pour identifier les publications susceptibles de polariser les utilisateurs, par exemple celles prônant la violence politique ou l’emprisonnement des membres du parti adverse. Ces publications n’étaient pas supprimées ; elles étaient simplement classées plus bas dans le fil, obligeant les utilisateurs à défiler davantage pour les voir, ce qui a réduit leur exposition.

Nous avons mené cette expérience pendant dix jours, dans les semaines précédant l’élection présidentielle américaine de 2024. Nous avons constaté que limiter l’exposition aux contenus polarisants améliorait de manière mesurable ce que les participants pensaient des membres du parti adverse et réduisait leurs émotions négatives lorsqu’ils faisaient défiler leur fil d’actualité. Fait notable, ces effets étaient similaires quel que soit le parti politique, ce qui suggère que l’intervention bénéficie à tous les utilisateurs, indépendamment de leur affiliation.

Pourquoi c’est important

Une idée reçue veut que l’on doive choisir entre deux extrêmes : des algorithmes basés sur l’engagement ou des fils purement chronologiques. En réalité, il existe un large éventail d’approches intermédiaires, selon les objectifs pour lesquels elles sont optimisées.

Les algorithmes de fil d’actualité sont généralement conçus pour capter votre attention et ont donc un impact significatif sur vos attitudes, votre humeur et votre perception des autres. Il est donc urgent de disposer de cadres permettant à des chercheurs indépendants de tester de nouvelles approches dans des conditions réalistes.

Notre travail ouvre cette voie : il montre comment étudier et prototyper à grande échelle des algorithmes alternatifs, et démontre qu’avec les grands modèles de langage (LLM), les plateformes disposent enfin des moyens techniques pour détecter les contenus polarisants susceptibles d’influencer les attitudes démocratiques de leurs utilisateurs.

Quelles autres recherches sont menées dans ce domaine

Tester l’impact d’algorithmes alternatifs sur des plateformes actives est complexe, et le nombre de ces études n’a augmenté que récemment.

Par exemple, une collaboration récente entre des universitaires et Meta a montré que passer à un fil chronologique n’était pas suffisant pour réduire la polarisation. Un effort connexe, le Prosocial Ranking Challenge dirigé par des chercheurs de l’Université de Californie à Berkeley, explore des alternatives de classement sur plusieurs plateformes pour favoriser des résultats sociaux positifs.

Parallèlement, les progrès dans le développement des LLM permettent de mieux modéliser la façon dont les gens pensent, ressentent et interagissent. L’intérêt croît pour donner davantage de contrôle aux utilisateurs, en leur permettant de choisir les principes qui guident ce qu’ils voient dans leur fil – par exemple avec Alexandria, une bibliothèque des valeurs pluralistes ou le système de réorganisation de fil Bonsai. Les plateformes sociales, telles que Bluesky et X, s’orientent également dans cette direction.

Et après

Cette étude n'est qu'un premier pas vers la conception d’algorithmes conscients de leur impact social potentiel. De nombreuses questions restent ouvertes. Nous prévoyons d’étudier les effets à long terme de ces interventions et de tester de nouveaux objectifs de classement pour traiter d’autres risques liés au bien-être en ligne, comme la santé mentale et le sentiment de satisfaction. Les travaux futurs exploreront comment équilibrer plusieurs objectifs – contexte culturel, valeurs personnelles et contrôle par l’utilisateur – afin de créer des espaces en ligne favorisant des interactions sociales et civiques plus saines.

Retrouvez dans le Research Brief de The Conversation US une sélection travaux académiques en cours résumés par leurs auteurs.

Cette recherche a été partiellement financée par une subvention Hoffman-Yee du Stanford Institute for Human-Centered Artificial Intelligence.

14.12.2025 à 11:49

Dans l’Italie du XVIIIe siècle, les femmes s’insurgeaient contre le harcèlement sexiste et sexuel subi dans les confessionnaux

Texte intégral (1718 mots)

Blagues obscènes, questions intrusives, gestes déplacés : les archives inquisitoriales du Vatican montrent que le harcèlement sexuel au confessionnal était une réalité pour de nombreuses femmes dans l’Italie du XVIIIᵉ siècle – et que certaines ont osé le signaler.

L’Institut européen pour l’égalité entre les hommes et les femmes définit le harcèlement sexuel comme « la situation dans laquelle un comportement non désiré à connotation sexuelle, s’exprimant physiquement, verbalement ou non verbalement, survient avec pour objet ou pour effet de porter atteinte à la dignité d’une personne et, en particulier, de créer un environnement intimidant, hostile, dégradant, humiliant ou offensant ». Les agissements sexistes découlent du pouvoir et visent à exercer un contrôle psychologique ou sexuel. Dans les deux cas, les victimes se sentent souvent confuses, seules, et se croient parfois responsables des abus subis.

En tant qu’historienne, je cherche à comprendre comment les femmes ont vécu et affronté ces comportements intimidants. Je m’intéresse en particulier au harcèlement pendant la confession dans l’Italie du XVIIIe siècle. Les femmes catholiques se rendaient au confessionnal pour partager leurs doutes et leurs espoirs sur des sujets allant de la reproduction aux menstruations, mais elles étaient parfois confrontées à des remarques méprisantes ou déplacées qui les déstabilisaient.

Un déséquilibre des pouvoirs

Les archives du Vatican nous montrent que certains des hommes qui ont tenu ces propos avaient tendance à en minimiser la portée, les qualifiant de simples marques de camaraderie ou de curiosité, voire de vantardise. Ils ont pourtant rabaissé les femmes qui, après ces échanges, étaient bouleversées ou en colère. Ces femmes étaient souvent plus jeunes que leurs confesseurs, elles avaient moins de pouvoir et pouvaient subir des menaces les contraignant à se taire. Pourtant, les archives nous montrent également que certaines, jugeant ces échanges inappropriés, se sont opposées à ces abus.

Les archives contiennent les procès-verbaux des tribunaux de l’Inquisition, qui, dans toute la péninsule italienne, traitaient les signalements de harcèlement et d’abus dans les confessionnaux. Pour les femmes, la confession était primordiale car elle dictait la moralité. Le devoir d’un prêtre était de demander aux femmes si elles étaient de bonnes chrétiennes, et la moralité d’une femme était liée à sa sexualité. Les canons de l’Église enseignaient que le sexe devait être uniquement hétérosexuel, génital et se dérouler dans le cadre du mariage.

Mais si la sexualité était encadrée par un code moral de péché et de honte, les femmes étaient des agents sexuels actifs, apprenant par l’expérience et l’observation. Le fonctionnement interne du corps féminin était mystérieux pour elles, mais le sexe ne l’était pas. Alors que les hommes lettrés avaient accès à des traités médicaux, les femmes apprenaient grâce aux connaissances échangées au sein de la famille et avec les autres femmes. Cependant, au-delà de leur cercle quotidien, certaines femmes considéraient le confessionnal comme un espace sûr où elles pouvaient se confier, remettre en question leurs expériences et demander des conseils sur le thème de la sexualité. Les ecclésiastiques agissaient alors comme des guides spirituels, des figures semi-divines capables d’apporter du réconfort, ce qui créait un déséquilibre de pouvoir pouvant conduire à du harcèlement et des abus.

Signaler les cas de harcèlement

Certaines femmes victimes d’abus dans le confessionnal l’ont signalé à l’Inquisition, et les autorités religieuses les ont écoutées. Dans les tribunaux, les notaires ont consigné les dépositions et les accusés ont été convoqués. Au cours des procès, les témoins ont été contre-interrogés afin de corroborer leurs déclarations. Les condamnations variaient : un ecclésiastique pouvait être condamné à jeûner ou à faire des exercices spirituels, à être suspendu, exilé ou envoyé aux galères (travaux forcés).

Les archives montrent qu’au XVIIIe siècle en Italie, les femmes catholiques comprenaient parfaitement les blagues grivoises, les métaphores et les allusions qui leur étaient adressées. En 1736 à Pise, par exemple, Rosa alla trouver son confesseur pour lui demander de l’aide, inquiète que son mari ne l’aime pas, et il lui conseilla « d’utiliser ses doigts sur elle-même » pour éveiller son désir. Elle fut embarrassée et rapporta cet échange inapproprié. Les documents d’archives montrent fréquemment que les femmes étaient interrogées si leur mariage ne produisait pas d’enfants : on leur demandait si elles vérifiaient que leur mari « consommait par derrière », dans le même « vase naturel », ou si le sperme tombait à l’extérieur.

En 1779, à Onano, Colomba a rapporté que son confesseur lui avait demandé si elle savait que pour avoir un bébé, son mari devait insérer son pénis dans ses « parties honteuses ». En 1739, à Sienne, une femme de 40 ans sans enfant, Lucia, s’est sentie rabaissée lorsqu’un confesseur lui a proposé de l’examiner, affirmant que les femmes « avaient des ovaires comme les poules » et que sa situation était étrange, car il suffisait à une femme « de retirer son chapeau pour tomber enceinte ». Elle a signalé cet échange comme une ingérence inappropriée dans sa vie intime.

Les archives du confessionnal montrent des exemples de femmes à qui l’on disait : « J’aimerais te faire un trou » ; qui voyaient un prêtre frotter des anneaux de haut en bas sur ses doigts pour imiter des actes sexuels ; et à qui l’on posait la question suggestive de savoir si elles avaient « pris cela dans leurs mains » – et chacune de ces femmes comprenait ce qui était insinué. Elles comprenaient aussi que ces comportements relevaient du harcèlement. Autant d’actes et de paroles que les confesseurs considéraient, eux, comme du flirt – comme lorsqu’un prêtre invita Alessandra à le rejoindre dans le vignoble en 1659 – étaient jugés révoltants par les femmes qui rapportaient ces événements (Vatican, Archivio Dicastero della Fede, Processi vol. 42).

L’effet déconcertant des abus

À cette époque, le stéréotype selon lequel les femmes plus âgées n’avaient plus de sexualité était très répandu. En effet, on croyait que les femmes dans la quarantaine ou la cinquantaine n’étaient plus physiquement aptes à avoir des rapports sexuels, et leur libido était ridiculisée par la littérature populaire. En 1721, Elisabetta Neri, une femme de 29 ans qui cherchait des conseils pour soulager ses bouffées de chaleur qui la mettaient hors d’état de fonctionner, s’est entendu dire qu’à partir de 36 ans, les femmes n’avaient plus besoin de se toucher, mais que cela pouvait l’aider à se détendre et à soulager son état.

Les femmes étaient également interrogées de manière fréquente et répétée sur leur plaisir : se touchaient-elles lorsqu’elles étaient seules ? Touchaient-elles d’autres femmes, des garçons ou même des animaux ? Regardaient-elles les « parties honteuses » de leurs amies pour comparer qui « avait la nature la plus grande ou la plus serrée, avec ou sans poils » (ADDF, CAUSE 1732 f.516) ? Pour les femmes, ces commentaires représentaient des intrusions inappropriées dans leur intimité. D’après les harceleurs masculins, il s’agissait d’une forme de curiosité excitante et une façon de donner des conseils : un frère franciscain, en 1715, a ainsi démenti avoir fait des commentaires intrusifs sur la vie sexuelle d’une femme (ADDF, Stanza Storica, M7 R, procès 3).

En quête de conseils avisés, les femmes confiaient leurs secrets les plus intimes à ces érudits, et elles pouvaient être déconcertées par l’attitude que leurs confesseurs affichaient souvent. En 1633, Angiola affirmait avoir « tremblé pendant trois mois » après avoir subi des violences verbales (ADDF, vol. 31, Processi). Les remarques déplacées et les attouchements non désirés choquaient celles qui en étaient victimes.

Le courage de s’exprimer

Il est indéniable que la sexualité est un objet culturel, encadré par des codes moraux et des agendas politiques qui font l’objet de négociations constantes. Les femmes ont été sans cesse surveillées, leur corps et leur comportement étant soumis à un contrôle permanent. Cependant, l’histoire nous enseigne que les femmes pouvaient être conscientes de leur corps et de leurs expériences sexuelles. Elles discutaient de leurs doutes, et certaines se sont ouvertement opposées au harcèlement ou aux relations abusives.

Au XVIIIe siècle en Italie, les femmes catholiques n’avaient pas toujours les mots pour qualifier les abus dont elles étaient victimes, mais elles savaient reconnaître qu’elles ne vivaient pas toujours un échange « honnête » dans le confessionnal, et parfois elles ne l’acceptaient pas. Elles ne pouvaient pas y échapper, mais elles avaient le courage d’agir contre un tel abus.

Une culture d’abus sexuels est difficile à éradiquer, mais les femmes peuvent s’exprimer et obtenir justice. Les événements des siècles passés montrent qu’il est toujours possible de dénoncer, comme c’est encore le cas aujourd’hui.

Note de l’auteur : les références entre parenthèses dans le texte renvoient à des documents consultables conservés dans les archives du Vatican.

Giada Pizzoni a reçu une bourse Marie Skłodowska-Curie de la Commission européenne.

14.12.2025 à 11:48

Comment transformer l’aura des stars en multiplicatrice de dons

Texte intégral (1331 mots)

Une recherche met en lumière les stratégies permettant de transformer l’aura des célébrités en crédibilité à l'égard d’une cause d’intérêt général. Alors, ces leaders d’opinion permettent-ils aux associations de récolter davantage de dons ? D’influencer nos élans de générosité ? Explications en graphiques.

Les célébrités, et plus récemment les influenceurs, ne se contentent plus de divertir : ils orientent nos choix. Des marques que nous achetons, jusqu’aux positions que nous adoptons sur des enjeux éthiques, leur empreinte est partout. Ils s’imposent comme de véritables sources d’information pour les consommateurs.

Leur influence ne s’arrête pas aux décisions de consommation. Acteurs, humoristes ou streamers façonnent nos élans de générosité et les causes que nous choisissons de soutenir. De nombreuses personnalités mettent en avant leur engagement caritatif : Pierre Garnier avec Imagine for Margo, Florence Foresti avec la Fondation des femmes ou encore Omar Sy avec les Restaurants du cœur. Côté influenceurs, le ZEvent 2025 a marqué les esprits : en trois jours de marathon sur Twitch, plus de 16,2 millions d’euros ont été récoltés grâce à des figures comme ZeratoR, Kameto ou Baghera Jones.

Pour mieux comprendre ces mécanismes, nous avons mené une série d’études pour comprendre si l’aura des célébrités apportait une crédibilité envers la cause à soutenir. Concrètement, nous avons présenté à des consommateurs plusieurs personnalités, ambassadrices d’une cause, et analysé si elles avaient un impact positif sur la crédibilité des causes d’intérêt général.

Transformer l’aura en crédibilité

Notre première étude, intuitive, consiste à choisir une personnalité dont l’histoire est directement liée à la cause. Par exemple, des personnalités telles que Selena Gomez et Lady Gaga peuvent être des ambassadrices crédibles pour les causes liées à la santé mentale chez les jeunes, compte tenu des traumatismes qu’elles ont vécus dans leur jeunesse. Il en va de même pour le combat d’Emma Watson pour l’égalité homme-femme, renforcé par son expérience des traitements des jeunes femmes et adolescentes dans l’industrie cinématographique.

La seconde étude repose sur ce que les chercheurs appellent le transfert de sens. Dans ce processus, les symboles associés à une personne sont transférés à un produit, une marque ou une organisation. De cette manière, une personnalité peut apporter à la cause son aura culturelle, son univers ou ses valeurs symboliques à une cause, même sans lien direct apparent.

Quand la notoriété devient expertise

Dans une étude auprès de 200 répondants, nous avons testé l’impact de l’attractivité de la personnalité ambassadrice sur son niveau de crédibilité perçue envers la cause et le nombre de dons générés.

À cette fin, nous avons indiqué aux participants de l’étude que le tennisman Andy Muray était le nouvel ambassadeur de « Let’s Green Up ! », une ONG fictive. Dans un premier groupe, nous avons décrit le tennisman en insistant sur son attractivité et son aura. Dans un second groupe, nous avons présenté une description plus neutre du sportif. Nous avons ensuite mesuré la crédibilité perçue de la personnalité grâce à des affirmations telles que « Cet influenceur est une source d’information fiable » ou « Je peux faire confiance à cette personne ».

Les répondants avaient enfin la possibilité de faire un don à l’ONG proposée. Les résultats sont unanimes : la présence de cette aura est une condition essentielle au succès des campagnes de récolte de dons. Elle fait augmenter la chance de faire un don de 43 % à 54 %.

Un passé qui donne du poids

Au-delà de leur aura, certaines célébrités renforcent leur crédibilité en mettant en avant un lien personnel avec la cause qu’elles soutiennent. Lorsque Mika s’engage auprès d’associations venant en aide au Liban, son message gagne en force, car il souligne son attachement à ce pays d’origine.

Pour tester cette hypothèse, nous avons réalisé une seconde étude auprès de 402 répondants. Ces derniers pouvaient soutenir une cause associée à une personnalité, en faisant varier le type de cause et la personnalité. Pour ce faire, nous avons comparé l’efficacité de l’annonce quand la cause est soutenue par Léonardo DiCaprio, célébrité connue pour son aura, et Greta Thunberg, davantage connue pour son activisme. Nous avons d’abord comparé des groupes où ces personnalités soutenaient une campagne pour l’écologie, en lien avec le passé des deux célébrités, et une autre campagne soutenant l’accès à l’éducation. Nous avons ensuite mesuré la crédibilité de la personnalité ambassadrice.

Lorsque ce lien est mis en évidence, la crédibilité de la célébrité ou de l’influenceur envers la cause augmente donc davantage.

Le pouvoir du transfert symbolique

Même lorsqu’elles n’ont pas de lien direct avec une cause, les célébrités peuvent lui donner de la crédibilité en y associant leur univers symbolique. Un humoriste qui prête son image à une campagne solidaire, ou une chanteuse pop qui soutient la recherche médicale, n’est pas forcément expert du sujet. Ce transfert de sens, présenté plus haut, permet aux associations de toucher le public par ricochet, en capitalisant sur l’image culturelle de la personnalité.

Nous avons réalisé une troisième étude auprès de 400 répondants. L’idée : inviter les participants à soutenir une association pour l’écologie. Dans un groupe, la personnalité ambassadrice est Keanu Reeves et dans l’autre, Eminem. Nous avons pu établir au préalable que Eminem démontrait un capital symbolique plus important que Keanu Reeves. Dans les deux cas, nous avons fait varier l’attractivité et l’aura de la personnalité ambassadrice en la présentant dans une posture favorable ou neutre.

Les résultats montrent qu’une personnalité présentant un capital symbolique plus élevé, comme Eminem, est perçue comme étant davantage crédible, ce qui accroît leur capacité à générer un élan de générosité.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

14.12.2025 à 11:47

Football : 30 ans après l’arrêt Bosman, quel bilan pour le marché des transferts ?

Texte intégral (2890 mots)

Le Belge Jean-Marc Bosman, joueur modeste des années 1990, restera peut-être dans l’histoire comme le footballeur qui aura eu le plus grand impact sur son sport. En effet, l’arrêt portant son nom, adopté il y a exactement trente ans, a permis aux joueurs en fin de contrat de rejoindre un autre club sans l’exigence d’une indemnité de transfert. Il a également mis fin à la règle qui prévalait jusqu’alors de trois étrangers maximum par équipe, ouvrant la voie à une aspiration des joueurs du monde entier vers les clubs les plus riches.

« Toi, avec ton arrêt, tu vas rester dans l’histoire, comme Bic ou Coca-Cola », avait dit Michel Platini à Jean-Marc Bosman en 1995. Platini n’avait sans doute pas tort.

Les faits remontent à 1990. Le contrat de travail de Bosman, footballeur professionnel du Royal Football Club (RFC) de Liège (Belgique), arrive à échéance le 30 juin. Son club lui propose un nouveau contrat, mais avec un salaire nettement inférieur. Bosman refuse et est placé sur la liste des transferts. Conformément aux règles de l’Union européenne des associations de football (UEFA) en vigueur à l’époque, le transfert d’un joueur, même en fin de contrat, s’effectue en contrepartie d’une indemnité versée par le club acheteur au club vendeur. Autrement dit, pour acquérir Bosman, le nouveau club devra verser une indemnité de transfert au RFC.