ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

13.10.2025 à 15:33

Catastrophes industrielles, ferroviaires, maritimes… L’erreur individuelle existe-t-elle vraiment ?

Texte intégral (1848 mots)

L’erreur humaine est considérée comme un facteur déterminant dans la survenue d’accidents majeurs. Elle a été ainsi désignée comme une cause principale dans le naufrage du « Titanic », l’explosion de l’usine de pesticide de Bhopal, l’explosion du réacteur de Tchernobyl ou encore la collision aérienne de Tenerife. Lorsque de tels accidents surviennent, les médias mettent souvent en exergue l’erreur commise par l’équipe ou l’opérateur qui pilotait le système et l’associent parfois à la responsabilité individuelle d’une personne. Est-ce vraiment pertinent ?

Prenons l’exemple de la collision frontale entre un train de voyageurs et un convoi de marchandises survenue en Grèce, dans la nuit du 28 février au mercredi 1er mars 2023. Faisant 57 morts et 81 blessés graves, c’est l’accident ferroviaire le plus meurtrier qu’a connu la Grèce. Dans un article paru le 1er mars, le lendemain de la catastrophe, le journal le Monde titrait Accident de train en Grèce : le premier ministre pointe « une tragique erreur humaine », puis précisait plus loin que le chef de la gare de Larissa avait été arrêté et était poursuivi pour « homicides par négligence ».

Deux trains avaient circulé pendant plus de dix minutes sur la même voie, en sens opposé, sans qu’aucun système d’alarme ne soit déclenché avant la collision. Le rapport d’enquête rédigé par la HARSIA (Hellenic Air & Rail Safety Investigation Authority, l’équivalent du Bureau d’enquêtes sur les accidents de transport terrestre en France ou BEA-TT), publié le 27 février 2025, montre que la cause immédiate de l’accident est une erreur d’aiguillage. Le train de passagers IC 62 en provenance d’Athènes aurait dû rester sur la voie principale (ascendante), mais le chef de gare orienta l’aiguillage vers la voie descendante qui était occupée par un train de fret venant en sens inverse.

Malheureusement, le chef de gare ne détecta pas cette erreur et il n’y eut pas de communication claire avec le conducteur du train qui aurait permis de l’identifier. En effet, le chef de gare donna un ordre ambigu qui ne mentionnait pas la voie qu’allait emprunter le train. Le conducteur aurait dû répéter l’ordre en demandant au chef de gare de préciser la voie (ascendante ou descendante). Il s’agit de la procédure dite de « readback/hearback » qui consiste à répéter et à confirmer chaque instruction critique pour éviter tout malentendu. De plus, le conducteur aurait dû contacter le chef de gare lorsqu’il a constaté qu’il ne se trouvait pas sur la voie montante.

Le rapport met en évidence les circonstances dans lesquelles cette erreur a été commise (notamment la charge de travail élevée du chef de gare, un pupitre de contrôle comportant de nombreuses commandes et informations). De plus, il fait ressortir les défaillances du système ferroviaire grec comme constituant des facteurs sous-jacents (infrastructure dégradée et insuffisamment entretenue, sous-effectif chronique, absence de maintenance préventive des dispositifs de contrôle-commande et de la signalisation, problème de formation et de gestion des compétences des personnels, défaillance du système de communication, absence de retour d’expériences qui aurait permis d’apprendre des incidents et accidents passés).

Les auteurs de ce rapport n’examinent donc pas seulement les activités du chef de gare et du conducteur de train ; ils s’intéressent aussi aux décisions d’acteurs institutionnels : la compagnie ferroviaire chargée de l’exploitation des trains, l’entreprise publique gestionnaire du réseau ferré et, donc, l’État.

Cet accident a entraîné de nombreuses manifestations en Grèce ; les manifestants pointant les dysfonctionnements du réseau ferroviaire. Le chef de gare de Larissa a été le premier à être placé en détention provisoire, puis trois autres employés des chemins de fer ont été poursuivis pour « homicide involontaire par négligence ». Le 15 septembre 2025, le procureur d’appel de Larissa a demandé, à l’issue d’un rapport de 996 pages, que 33 autres personnes soient renvoyées devant la cour d’assises. Il s’agit d’acteurs opérationnels ou administratifs responsables de la sécurité ferroviaire.

Cet exemple montre qu’il est important, lors d’un accident majeur, d’opérer un déplacement de point de vue :

ne plus se focaliser sur l’opérateur, mais examiner l’ensemble des éléments qui compose le système au sein duquel il opère ;

ne plus se focaliser sur l’action ou sur la décision d’un opérateur « de première ligne », mais considérer l’impact des décisions prises à tous les niveaux d’une organisation.

Erreur humaine ou défaillances systémiques ?

Nombre de travaux menés depuis la Seconde Guerre mondiale invitent à considérer une action erronée non pas comme une action fautive, mais comme le symptôme d’une mauvaise adéquation entre les capacités de l’opérateur et les caractéristiques de sa situation de travail.

En 1990, le psychologue anglais James Reason publie un ouvrage de référence intitulé Human Error dans lequel il distingue les « erreurs actives » et les « erreurs latentes » ou « conditions latentes ». Les premières ont un effet immédiat. Il s’agit d’actions « erronées » commises par les opérateurs « de première ligne ». Les secondes sont présentes au sein du système depuis parfois de nombreuses années, mais sont « dormantes ». Elles se développent à partir d’activités humaines éloignées de l’activité qui déclenche le dommage (activités de conception, de maintenance, management). C’est en se combinant à d’autres facteurs qu’elles se révèlent et contribuent à l’accident.

Nous avons utilisé ce cadre pour analyser des collisions entre navires. L’analyse menée fait apparaître trois grandes classes d’accidents.

La première classe est typique d’accidents qui surviennent dans des eaux dites « resserrées » (des chenaux principalement) alors qu’un pilote se trouve à bord du navire. Les principaux facteurs d’accidents sont des problèmes de communication (entre navires et au sein de l’équipage). Ce résultat met en exergue l’importance des formations au travail d’équipe, tout particulièrement pour les situations dans lesquelles un pilote doit interagir avec le commandant et l’équipage du navire. Ce facteur fait écho à l’ambiguïté de la communication entre le chef de gare et le conducteur de train qui participa à la collision ferroviaire de Larissa.

La deuxième classe d’accidents résulte de l’interaction de facteurs appartenant à différents niveaux du système : mauvaise visibilité et non-utilisation ou mauvaise utilisation des instruments, planification d’opérations inappropriées à la situation – comme une vitesse excessive au regard des conditions extérieures ou un nombre insuffisant de personnes affectées à la tâche (facteurs relevant du leadership), système de management de la sécurité incomplet (facteur organisationnel).

La troisième classe d’accidents se caractérise, quant à elle, par le non-respect du système de management de la sécurité ; il s’agit, dans ce cas, de violations (erreurs intentionnelles) relevant du leadership.

De l’analyse des erreurs à l’analyse des décisions

Jens Rasmussen, qui fut l’un des chercheurs les plus influents dans le domaine de la sécurité et de l’étude de l’erreur humaine, explique que la notion d’erreur (supposant un écart à une performance définie) n’est pas vraiment pertinente, parce qu’elle entre en contradiction avec la capacité d’adaptation humaine, avec le fait que les acteurs – au sein d’un système – ont une certaine liberté dans la façon de réaliser leur activité et peuvent ainsi opter pour différentes stratégies.

Adaptation et variabilité sont même nécessaires pour garantir la performance des systèmes. S’intéressant aux interactions « verticales » au sein d’une organisation, Rasmussen propose d’identifier tous les acteurs (acteurs étatiques, législateurs, syndicats, concepteurs de système, dirigeants d’entreprises, managers, opérateurs) dont les décisions ont contribué à l’accident ; il souligne que les contraintes et possibilités qui s’imposent à un acteur donné et à un niveau donné dépendent de décisions prises par d’autres acteurs.

Dans le secteur de la pêche maritime, il est intéressant d’analyser l’impact des décisions prises par les législateurs (au niveau national et international) sur les choix réalisés par les concepteurs des navires et des équipements et, finalement, sur les pêcheurs eux-mêmes. Ainsi plusieurs études ont examiné l’impact, sur la sécurité des marins-pêcheurs, du type de quotas de pêche (quotas individuels qui donnent à un opérateur le droit de prélever une quantité déterminée de poissons sur un stock ou quotas collectifs). D’une façon générale, l’allocation individuelle de quotas réduit la « course au poisson » et diminue les prises de risque.

Dans la lignée de ces travaux, nous avons montré que la législation impose aux marins-pêcheurs des contraintes qui ont une forte incidence sur leurs décisions, sur les arbitrages qu’ils font au quotidien et sur la prise de risque.

Il est nécessaire d’adopter une perspective systémique pour comprendre la survenue des accidents. Dans ce cadre, il apparaît plus pertinent de s’intéresser aux décisions des différents acteurs d’un système, et aux interactions entre ces décisions, qu’aux erreurs qu’ils peuvent commettre.

Chauvin Christine ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

13.10.2025 à 12:25

Les secrets de la domination de l’Université Harvard au classement de Shanghai

Texte intégral (2030 mots)

L’élection de Donald Trump met à mal le « business model » de l’Université d’Harvard. Cette université domine le classement de Shanghai grâce à son excellence scientifique, une fondation gérant 53,2 milliards de dollars et un réseau de 420 000 diplômés. À partir de la « théorie des capitaux » de Bourdieu, une étude cherche à comprendre comment la plus prestigieuse université domine son champ scientifique.

Le classement de Shanghai mesure l’excellence scientifique des universités dans le monde. Sur les dix premières, huit sont états-uniennes ; l’université d’Harvard trône à son sommet depuis 2003. Comment expliquer la domination de cette organisation privée à but non lucratif dans un champ universitaire réputé très concurrentiel ?

Avec Rachel Bocquet et Gaëlle Cotterlaz-Rannard, à partir de la « théorie des capitaux » de Pierre Bourdieu, nous décodons le modèle économique, ou business model, des universités de recherche états-uniennes. L’enjeu est de comprendre comment la plus prestigieuse et la plus puissante d’entre elles domine son champ scientifique.

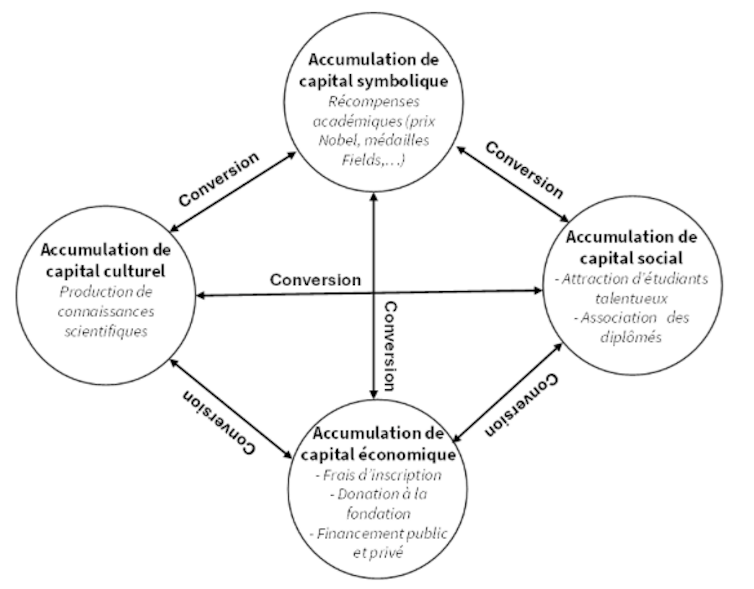

L’excellence scientifique d’Harvard, symboliquement reconnue par le classement de Shanghai, résulte de l’accumulation et de la conversion de capital économique, social, culturel et symbolique. La dimension systémique qui fonde la robustesse du business model le rend difficilement reproductible. Il est lié à cette capacité d’accumuler simultanément les quatre formes de capitaux et de les interconvertir.

Près de 204 560 publications au cours des cinq dernières années

La théorie de Bourdieu articule quatre formes de capitaux : le capital économique, le capital culturel, le capital social et le capital symbolique. Le dernier étant la reconnaissance sociétale de la possession des trois autres. Chaque forme de capital contribue à l’accumulation des autres formes de capital par un processus d’inter-conversion ; le capital culturel est converti en capital économique, social ou symbolique et inversement.

Harvard est une université de recherche. Ses 2 445 professeurs et 3 048 chercheurs affiliés ont pour mission première de produire des connaissances scientifiques – capital culturel. Sur les cinq dernières années, la plateforme Web of Science recense pour Harvard 204 560 publications, dont 16 873 dans des revues à comité de lecture, ce qui en fait l’université qui produit le plus de connaissances scientifiques. Ses chercheurs sont les plus cités par la communauté scientifique.

Ce capital culturel est converti en capital économique par l’obtention de financement : 6,5 milliards de dollars en 2024. La faculté de médecine est l’une des universités états-uniennes qui obtient le plus de financement de l’État fédéral (National Institut of Health).

Fondation de 53,2 milliards de dollars

Ce capital culturel fait l’objet d’une reconnaissance sociétale par l’attribution à ses chercheurs de récompenses prestigieuses : prix Nobel, médaille Fields, prix Turing, prix Pulitzer, etc. Cette reconnaissance correspond à une conversion du capital culturel en capital symbolique, ce qui renforce le prestige de l’institution.

Ce capital symbolique contribue par sa conversion à l’accumulation des autres formes de capitaux, notamment en capital économique en favorisant les donations à la fondation de l’université par des individus ou des entreprises.

En 2024, l’endownment (capital économique) issu de donations représente 53,2 milliards de dollars, soit le plus important fond de dotation au monde pour une université. En 2024, la rentabilité des investissements de la fondation est de 9,6 %. Ces revenus permettent de verser 2,4 milliards de dollars à l’université, soit 40 % de son budget, pour financer des projets de recherche.

Sélection des meilleurs étudiants

Le capital symbolique est également converti en capital économique en justifiant des frais d’inscription importants. En 2025, une inscription au bachelor d’Harvard coûte 61 670 dollars par an, soit une des institutions les plus chères des États-Unis. Les frais d’inscription au programme MBA sont de 81 500 de dollars par an et ceux de la Harvard Law School sont de 82 560 dollars. Certaines grandes fortunes peuvent faire des donations à Harvard pour faciliter l’admission de leur progéniture.

À lire aussi : Harvard face à l’administration Trump : une lecture éthique d’un combat pour la liberté académique

Le prestige académique attire d’excellents étudiants et contribue à l’accumulation de capital social. Pour être admis dans son bachelor, Harvard exige le plus haut score SAT des universités états-uniennes (1500-1580). Son taux d’admission des candidats de 3 % est le plus faible du pays.

Lorsqu’ils sont diplômés, ces étudiants irriguent la société dans ses sphères scientifique – Roy Glauber, George Minot –, politique – huit présidents des États-Unis sont diplômés d’Harvard –, économique pour créer ou diriger de grandes entreprises – Microsoft, JP Morgan, IBM, Morgan Stanley, Amazon, Fidelity Investments, Boeing, etc. –, littéraire – William S. Burroughs, T. S. Eliot – et artistique – Robert Altman, Natalie Portman.

Harvard Alumni Association

Tous ces diplômés, notamment en adhérant à la Harvard Alumni Association, correspondent à une accumulation de capital social qui représente un réseau de 420 000 personnes. L’université mobilise ce réseau pour des levées de fonds, des participations à ses instances de gouvernance ou des évènements.

L’homme d’affaires Kenneth Griffin illustre ce mécanisme. En 1989, Il est diplômé d’Harvard en économie. Il fonde Citadel LLC, un des hedge funds les plus réputés des États-Unis et, accessoirement, devient la 34e fortune mondiale. Il a donné 450 millionsde dollars à son alma mater (université) : 300 millions à la faculté des arts et des sciences et 150 millions à Harvard College. Son objectif est de financer la recherche et de subventionner des étudiants issus de milieux défavorisés. La célébrité de Kenneth Griffin dans les milieux financiers incite des étudiants à venir à Harvard et, à terme, entretenir le processus d’accumulation et de conversion lorsqu’ils travailleront dans la finance.

L’université instaure une compétition symbolique entre ses diplômés sur les montants donnés à la fondation. Les plus importants donateurs sont reconnus par le prestige de voir leur nom attribué à un bâtiment du campus, voir à une faculté. En 2015, John Paulson, diplômé de la Harvard Business School et fondateur d’un des hedge funds les plus importants des États-Unis, a donné 400 millions de dollars à la faculté d’ingénierie et des sciences appliquées qui est devenu la Harvard John A. Paulson School of Engineering and Applied Sciences.

Face à Trump, la vulnérabilité du « business model »

L’élection du président Trump ouvre une période d’hostilité avec Harvard en menaçant son modèle économique.

La première raison est fiscale. Les donations à la fondation de l’université offrent des avantages fiscaux importants aux donateurs en matière de déductions. La fondation est exonérée sur les bénéfices réalisés par nombre de ses investissements. Une révocation de ces deux avantages par l’administration des États-Unis réduirait les montants disponibles pour financer la recherche et la production de capital culturel.

La seconde est liée aux financements fédéraux de la recherche. En 2024, Harvard a reçu 686 millions de dollars de l’État fédéral. Leur suppression limiterait la capacité de l’université à développer des connaissances scientifiques.

La troisième résulte des poursuites pour discrimination menées par l’administration Trump, qui peut nuire à la réputation de l’université et détourner d’Harvard certains donateurs, chercheurs ou étudiants. Kenneth Griffin et Leonard Blavatnik, deux importants donateurs, ont décidé de suspendre leurs dons en raison des accusations d’antisémitisme portées contre Harvard. En 2024, les dons ont diminué de 193 millions dollars, notamment en raison de ces accusations.

La suppression pour Harvard de la possibilité d’attribuer des certificats d’éligibilité, ou DS 2019, aux étudiants étrangers, notamment aux doctorants et post-doctorants, limiterait le nombre d’individus contribuant à la recherche. En 2025, l’Université d’Harvard compte 10 158 étrangers, dont 250 professeurs et 6 793 étudiants, soit 27,2 % de l’ensemble des étudiants.

À lire aussi : Moins d’étudiants étrangers aux États-Unis : une baisse qui coûte cher aux universités

Michel Ferrary ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

12.10.2025 à 08:59

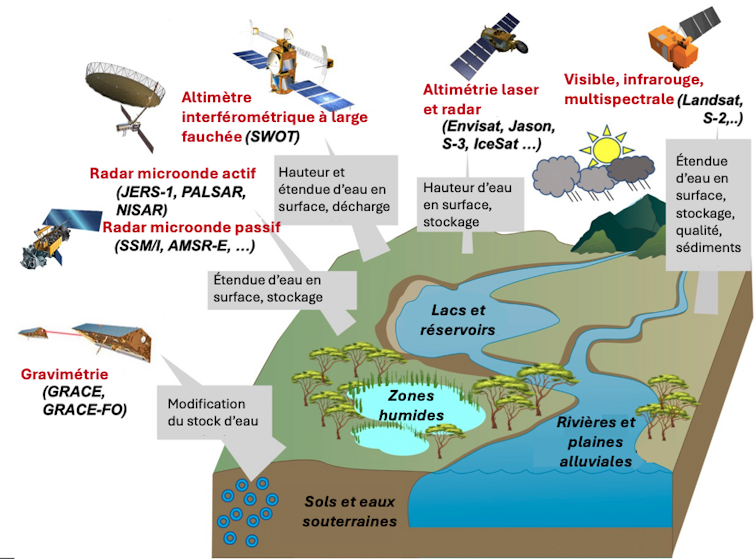

Inondations : satellites et « jumeaux numériques » pour mieux anticiper et agir vite

Texte intégral (3485 mots)

Les précipitations violentes accroissent le risque d’inondations rapides et difficiles à prévoir. Pour mieux se préparer, il faut bien connaître le terrain. En combinant de nombreuses techniques d’imagerie satellite et de modélisation, les chercheurs et experts créent des « jumeaux numériques », c’est-à-dire des répliques virtuelles du territoire. Celles-ci permettent de mieux savoir où et quand l’eau peut monter, et quelles infrastructures sont en zone à risque.

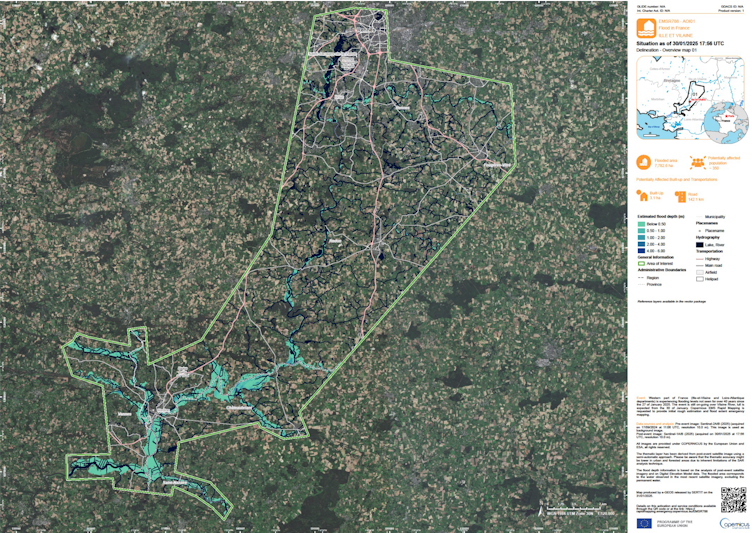

Entre le 26 janvier et le 1er février 2025, des crues exceptionnelles ont touché le département de l’Ille-et-Vilaine avec des hauteurs d’eau record par endroits. Au total, 110 communes ont été reconnues en état de catastrophe naturelle, et des milliers de logements, commerces, entreprises, ont été sinistrés.

Un autre département fréquemment touché par les orages est celui du Var. Le département avait déjà essuyé la tempête Alex en 2020 et ses 50 centimètres de précipitations cumulées en 24 heures à Saint-Martin-Vésubie. Cette année, en mai, ce sont 25 centimètres de pluie qui sont tombés au Lavandou en une heure seulement.

Avec le changement climatique, les évènements hydrométéorologiques sont de plus en plus fréquents et de plus en plus intenses. Les inondations constituent un risque naturel majeur — 43 % des risques naturels mondiaux dans le monde entre 1995 et 2015 — avec une augmentation notable des aléas survenus au cours des dernières années.

En associant données de pointe d’observation de la Terre et modèles physiques et numériques, les jumeaux numériques permettent de mieux prédire les inondations et les risques associés, d’estimer les dommages potentiels et de concevoir des mesures de prévention efficaces pour protéger les biens et les populations.

Gestion de crise et anticipation : un rôle pour le secteur spatial en cas d’inondations

Le caractère soudain et rapide des inondations requiert une réponse très rapide des services de gestion de crise et, pour cela, une excellente préparation et anticipation des impacts potentiels de ces crises est nécessaire.

Deux principaux programmes basés sur des données d’observation de la Terre sont au service de la gestion de crise. La Charte internationale Espace et catastrophes majeures est opérationnelle depuis 2020 et met à la disposition des équipes de secours et d’urgence des images satellites dans les heures qui suivent une catastrophe majeure, n’importe où dans le monde.

En Europe, le Copernicus Emergency Mapping Service fournit un produit de cartographie rapide en appui à la gestion de crise, et un produit de cartographie de risques et de reconstruction destiné à la prévention de risques, à la préparation de crise et à la gestion post-sinistre. Ce service a par exemple été activé par la protection civile française lors des inondations dans le département d’Ille-et-Vilaine de cette année.

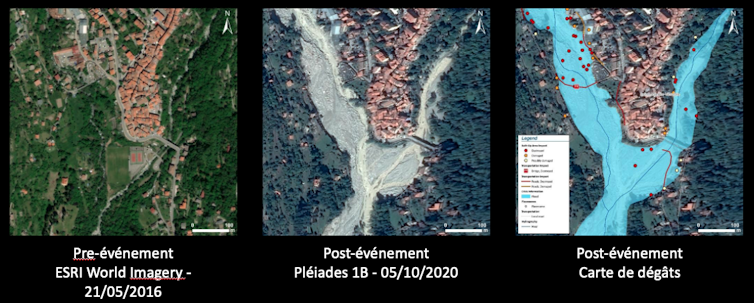

Lors de l’événement majeur concernant la tempête Alex à Saint-Martin-Vésubie en 2020, la sécurité civile française a activé également le service de cartographie rapide dès le 3 octobre 2020. Pour cet événement, le Centre national d’études spatiales (Cnes) a aussi immédiatement programmé les satellites Pléiades (capables de fournir des photographies de très haute résolution dans un temps très court) pour imager la zone pendant 8 jours minimum. Ainsi, en seulement quelques heures, de premières images ont été livrées, permettant au SERTIT de générer la cartographie des dégâts correspondante pour aider à la gestion de crise.

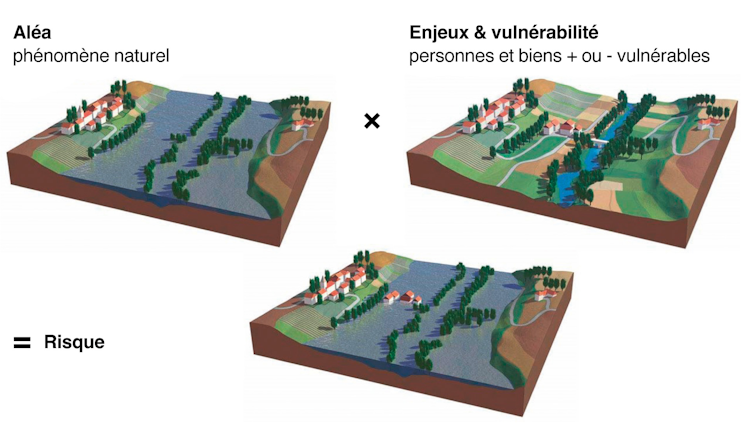

En effet, le risque d’inondation correspond à la conjugaison, en un même lieu, d’un aléa (phénomène naturel aléatoire comme l’inondation) avec les enjeux (humains, biens, économiques et environnementaux) susceptibles de subir des dommages. L’ampleur du risque dépend fortement de la vulnérabilité des enjeux exposés, autrement dit de leur résistance face à un évènement donné.

Outre le contexte climatique, les phénomènes d’inondations sont aggravés depuis des décennies par l’aménagement inadapté du territoire. Populations et biens s’accumulent dans des zones inondables, ce qui provoque notamment la construction de nouvelles routes et centres commerciaux, le développement de l’agriculture intensive, la déforestation ou encore la modification du tracé des cours d’eau. De surcroît, l’imperméabilisation des surfaces amplifie le ruissellement de l’eau et ne fait qu’aggraver encore la situation. Ces aménagements contribuent malheureusement trop souvent encore à la destruction des espaces naturels qui absorbent l’eau en cas de crues et qui sont essentiels au bon fonctionnement des cours d’eau.

Ceci nécessite d’impliquer une chaîne complexe d’acteurs — de l’observation satellite aux équipes sur le terrain.

Observer la Terre pour mieux apprécier les risques d’inondation

Les impacts des inondations peuvent être réduits par une meilleure culture du risque, un système d’alerte précoce, une cartographie précise des zones à risque, des prévisions fondées sur la modélisation, ainsi que par des aménagements du territoire et des infrastructures de protection adaptée – en ligne avec la politique de prévention des risques en France.

Ces informations provenant de données (in situ, IoT, drones, satellites, aéroportées…), et de modèles physiques très précis.

Les moyens d’observation in situ permettent de faire des mesures très précises de la hauteur, du débit et de la vitesse de l’eau alors que les moyens aéroportés (drone ou avion) permettent d’observer l’étendue de l’inondation. Or, il est très compliqué – voire impossible – de faire voler un avion ou un drone dans des conditions météorologiques dégradées. Par conséquent, ces observations sont complétées depuis l’espace. Par exemple, l’imagerie radar permet de faire des observations pendant la nuit et à travers les nuages.

Les données satellites apportent de nombreuses informations, par exemple la mesure du niveau d’eau de réservoirs, l’étendue d’eau ou encore la qualité de l’eau.

Malheureusement, aujourd’hui, ces missions ont une faible résolution temporelle par rapport au besoin d’observation des inondations au moment de la crise elle-me : la fréquence de « revisite » des satellites est de quelques jours au mieux. Les satellites Sentinel 2 par exemple permettent de photographier la Terre entière en 5 jours, alors que le satellite SWOT revient sur la même zone tous les 21 jours. De plus, il n’est pas rare que les passages des satellites ne correspondent pas aux dates de pic des crues pendant la gestion de la crise.

Bien entendu, malgré ces limitations actuelles, il est clair que les données satellites sont déjà d’un grand apport pour la prévention des inondations, la préparation de la crise, et l’analyse postimpact de la crise.

Combiner les observations et faire appel aux modélisations

Aujourd’hui, c’est donc une combinaison des données in situ, drone, aéroportées et spatiales qui permet d’améliorer la description des inondations.

Mais l’observation seule ne permet pas de réaliser des prévisions fiables : l’utilisation des modèles physiques est incontournable pour mieux représenter la dynamique de l’écoulement dans son ensemble, pour faire des prévisions à court terme — ainsi que des projections à long terme sous les différents scénarios dans un climat futur.

Ces combinaisons entre données et modèles permettent de fournir des représentations précises de la dynamique d’écoulement de l’événement d’inondation ainsi que des prévisions pour simuler un comportement futur tel qu’un changement climatique, avec plusieurs scénarios possibles, ainsi que le déploiement de stratégies d’adaptations.

C’est ainsi que sont nés les « jumeaux numériques ».

Les jumeaux numériques pour les inondations

Un jumeau numérique est une combinaison d’une « réplique numérique » d’une zone réelle, associée à des capacités de modélisation et de simulation de plusieurs scénarios de phénomènes climatiques.

S’agissant des inondations, l’objectif de ces simulations est de disposer d’un outil d’aide à la décision dans toutes les phases du cycle de gestion du risque : prévention, surveillance et protection ; alerte et gestion de crise ; analyse post-crise ; reconstruction, résilience et réduction de la vulnérabilité.

Un jumeau numérique permet de faire trois familles d’analyses :

What now ? Un scénario de réanalyse des épisodes passés pour améliorer la compréhension de la dynamique des événements (plan de prévention, aménagement du territoire, assurance…) ;

What next ? Un scénario de prévision en temps réel des crues et des inondations qui représente la façon dont les inondations évolueront dans le futur à court terme à partir de l’état actuel (sécurité civile, gestion de crise…) ;

What if ? Un scénario d’évaluation de l’impact de l’inondation qui représente la façon dont le débit des cours d’eau et les étendues inondées pourraient évoluer sous différents scénarios hypothétiques dans le contexte de changement climatique.

Ainsi, l’Agence spatiale européenne (ESA) et la NASA développent des jumeaux numériques à l’échelle globale pour intégrer les données et modèles des environnements naturels et des activités humaines afin d’accompagner les politiques publiques sur les risques naturels.

À titre d’exemple, le CNES et ses partenaires ont mis en place un démonstrateur de jumeau numérique consacré à l’étude des inondations fluviales par débordement, qui permet de surveiller, détecter et prévoir de manière fiable les inondations à une échelle locale et globale, tandis qu’un autre jumeau numérique se concentre sur les zones côtières dans un contexte de changement climatique.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

11.10.2025 à 08:26

Sommes-nous plus bêtes que nos parents ?

Texte intégral (2691 mots)

Vous avez peut-être entendu parler du déclin de l’intelligence ? C’est cette idée selon laquelle le quotient intellectuel moyen a tendance à diminuer dans le monde occidental. De quoi s’alarmer sur l’état du monde, les politiques publiques, l’éducation et l’avenir de la jeunesse ! Ce déclin existe-t-il vraiment ?

Le déclin de l’intelligence est à la mode depuis quelques années. Le documentaire « Demain, tous crétins ? » diffusé par Arte en 2017 a diffusé cette polémique en France. La presse s'en est rapidement emparée à travers des titres alarmistes, comme « Le QI des Français en chute libre », « Et si l'humanité était en train de basculer dans l'imbécillité ? », ou même « Alerte ! Le QI des Asiatiques explose, le nôtre baisse ».

On s’est inquiété, et comme dans toute panique morale, des coupables ont été désignés. Selon leurs orientations politiques, les commentateurs ont blâmé les pesticides et perturbateurs endocriniens, la désaffection pour la lecture, la réforme de l’orthographe, la construction européenne, ou bien sûr, l’exposition aux écrans.

Une intelligence globale en hausse

Avant de chercher pourquoi l’intelligence déclinerait, encore faut-il être sûrs qu’elle décline. Cette idée d’une diminution de l’intelligence est pour le moins surprenante, car l’intelligence moyenne a plutôt augmenté au cours du XXe siècle. Plusieurs centaines d’études impliquant des millions de participants dans plus de 70 pays montrent qu’en moyenne, chaque génération fait mieux que la précédente sur les tests d’intelligence. Si on préfère parler en termes de quotient intellectuel (QI : le score global à travers un ensemble d’épreuves d’intelligence – sa moyenne est fixée à 100, la plupart des gens se situent entre 85 et 115), le quotient intellectuel moyen a augmenté d’environ 3 points tous les dix ans depuis le début du XXe siècle.

Cette augmentation de l’intelligence moyenne à chaque génération s’appelle l’effet Flynn. On connaît l’effet Flynn depuis les années 1930, et on l’attribue aux grandes améliorations du XXe siècle , telles que la baisse de la malnutrition et des maladies infantiles, ou le développement de la scolarisation. Aujourd’hui, il est ralenti dans les pays développés, mais continue à pleine vitesse dans les pays en voie de développement (les scores d’intelligence y augmentent deux fois plus vite, environ, que dans le monde occidental).

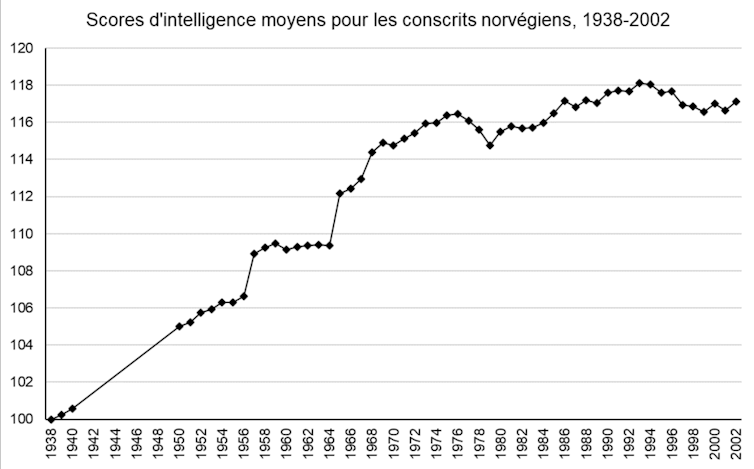

Que notre effet Flynn ralentisse ou s’interrompe, rien d’étonnant : la scolarisation et les qualités de notre système sanitaire ne progressent plus à grande vitesse. Mais un déclin de l’intelligence ? De petites baisses sont bien retrouvées par une poignée d’études, mais elles sont sans commune mesure avec les gains du XXe siècle. L’exemple de la Norvège (Figure 1) est frappant : ces données de grande qualité (jusqu’au début du XXIe siècle, la Norvège a évalué l’intelligence de l’ensemble de sa population masculine dans le cadre du service militaire obligatoire) montrent bien une petite diminution dans les années 2000, mais elle tient plus de la fluctuation aléatoire.

Une étude pour le moins critiquable

D’où vient, alors, l’idée que l’intelligence s’effondrerait en France ? La littérature ne contient qu’une unique étude d'Edward Dutton et Richard Lynn portant sur un échantillon de 79 personnes. C’est un très petit échantillon pour déclencher une panique morale, bien sûr : 79 personnes ne sont pas vraiment représentatives de la France dans son ensemble. Quand on crée un test d’intelligence, on l’étalonne plutôt sur un échantillon d’au moins 1000 personnes pour avoir une bonne estimation de la moyenne (c’est le cas de l’échelle d’intelligence pour adultes de Wechsler, la WAIS, la plus utilisée en France).

Mais le problème de cette étude est surtout dans sa méthode et dans ses résultats. Notre petit groupe de 79 personnes a passé deux tests d’intelligence en 2009 : un ancien test d’intelligence (la WAIS-III, étalonnée en 1999), et un test plus récent (la WAIS-IV, étalonnée en 2009). En comparant les résultats de ce groupe de 79 personnes à la moyenne de l’échantillon de référence pour chacun de ces tests, Dutton et Lynn constatent que les résultats de ce groupe sont légèrement plus faibles que la moyenne sur l’ancien test d’intelligence, et légèrement plus élevés que la moyenne sur le nouveau test ; ils en déduisent qu’il était plus difficile d’obtenir un bon score sur le test de 1999… donc que l’intelligence moyenne a diminué entre 1999 et 2009.

Sur le principe, le constat de Dutton et Lynn est correct : nous avons tendance à faire moins bien sur les anciens tests d’intelligence (nous avons répliqué ce résultat à un peu plus grande échelle). Mais le problème est qu’il y a d’autres raisons qu’un déclin de l’intelligence pour expliquer que les gens fassent moins bien en 2009 sur un test paru en 1999.

Pour bien comprendre, il faut s’intéresser au contenu du test. Un test d’intelligence de type WAIS est composé d’un ensemble d’épreuves qui mesurent des choses différentes : le raisonnement logique abstrait (ce qu’on entend généralement par « intelligence » : compléter une série de figures géométriques, reproduire un dessin abstrait à l’aide de cubes…), mais aussi les connaissances (vocabulaire, culture générale…), la mémoire, ou encore la vitesse de traitement de l’information. Dans l’étude de Dutton et Lynn, les scores sont en fait rigoureusement stables dans le temps pour le raisonnement logique abstrait, la mémoire ou la vitesse de traitement, qui ne déclinent donc pas : les seuls scores qui sont plus faibles en 2009 qu’en 1999, ce sont les scores de connaissances. On retrouve exactement la même chose dans d’autres pays, comme la Norvège : le raisonnement logique abstrait est constant dans le temps tandis que les scores de connaissance deviennent plus faibles sur les anciens tests.

Les tests doivent régulièrement être mis à jour

L’intelligence générale ne décline donc pas, ni en France ni dans le monde occidental. Dans ce cas peut-on au moins se plaindre que les connaissances ont décliné : la culture se perd, les jeunes n’apprennent plus rien ? Même pas : si les gens font moins bien sur les anciennes versions des tests d’intelligence, c’est tout simplement parce que les questions deviennent obsolètes avec le temps. La WAIS-III demandait aux Français de calculer des prix en francs, de comparer les caractéristiques des douaniers et des instituteurs, de citer des auteurs célèbres du XXe siècle. Avec le temps, ces questions sont devenues plus difficiles. Les scores au test ont baissé, mais pas l’intelligence elle-même. Nous avons montré que cette obsolescence suffit à expliquer intégralement les résultats de Dutton et Lynn.

Voici un petit exemple, tiré du tout premier test d’intelligence : il s’agit d’un texte à compléter, destiné à évaluer la présence d’une déficience chez de jeunes enfants. Pouvez-vous faire aussi bien qu’un enfant de 1905 en retrouvant les neuf mots manquants ?

Il fait beau, le ciel est —1—. Le soleil a vite séché le linge que les blanchisseuses ont étendu sur la corde. La toile, d’un blanc de neige, brille à fatiguer les —2—. Les ouvrières ramassent les grands draps ; ils sont raides comme s’ils avaient été —3—. Elles les secouent en les tenant par les quatre —5— ; elles en frappent l’air qui claque avec —6—. Pendant ce temps, la maîtresse de ménage repasse le linge fin. Elle a des fers qu’elle prend et repose l’un après l’autre sur le —7—. La petite Marie, qui soigne sa poupée, aurait bien envie, elle aussi, de faire du —8—. Mais elle n’a pas reçu la permission de toucher aux —9—.

Les mots « amidonnés » (3), « poêle » (7), et « fers » (9) vous ont probablement posé plus de problèmes qu’à un enfant de 1905 ; mais vous conviendrez sûrement que cette difficulté ne dit pas grand-chose de votre intelligence. Les scores d’intelligence sur ce test ont bien décliné, mais c’est plutôt l’évolution technologique du repassage qui rend le test obsolète. De la même façon, la probabilité qu’une personne dotée d’une intelligence moyenne (QI=100) réponde correctement à une question de la WAIS portant sur la pièce de théâtre Faust était de 27 % en 1999, elle est de 4 % en 2019. Ainsi, les scores aux tests de connaissance déclinent naturellement dans le temps, au fur et à mesure que la culture évolue. C’est même pour cette raison que de nouvelles versions des tests d’intelligence paraissent régulièrement : la WAIS est remise à jour tous les dix ans environ (et la WAIS-V devrait paraître en 2026).

Une « erreur » qui sert un agenda politique

Confondre un déclin de l’intelligence avec l’obsolescence des questions du test, c’est tout de même une grosse erreur. Comment Dutton et Lynn ont-ils pu la commettre ? C’est que l’erreur n’est pas innocente, et que ces deux auteurs ne sont pas tout à fait neutres. La discipline d’Edward Dutton est la théologie, Richard Lynn est connu pour défendre l’idée qu’il existe des différences génétiques d’intelligence entre les sexes et les origines ethniques ; les deux ont été éditeurs en chef d’une célèbre revue suprémaciste blanche (Mankind Quarterly) et leurs travaux alimentent directement les mouvements d’extrême droite.

Pour bien saisir l’agenda politique des auteurs, le mieux est peut-être de citer les explications qu’ils envisagent pour un déclin de l’intelligence. Deux extraits, issus des livres de Richard Lynn pour l’illustrer :

« … un grand nombre de gouvernements occidentaux ont contribué au déclin de l’intelligence depuis les années 1960, à travers une politique d’état-providence encourageant les femmes d’intelligence basse, de mauvaise moralité et de faible éducation à avoir des bébés… ».

« … l’immigration de masse de peuples non-européens en Europe de l’ouest, aux États-Unis et au Canada est un sérieux problème dysgénique… ils ont, en moyenne, une plus faible intelligence et une plus faible moralité… ils deviendront une majorité de la population en Europe de l’ouest… l’intelligence continuera à décliner… et la Chine deviendra une superpuissance mondiale »

Les réformes envisagées par les auteurs pour limiter le déclin de l’intelligence en Europe occidentale sont cohérentes avec leur orientation politique : on y trouve, par exemple, « abolir la sécurité sociale », « se retirer de la convention des Nations unies de 1951 sur l’accueil des réfugiés », ou encore « introduire des politiques publiques pour accroître la fertilité de ces femmes (intelligentes) qui ont été éduquées au point de perdre leur fonction reproductive ».

Aujourd’hui, nous avons la certitude qu’il n’y a pas réellement de déclin de l’intelligence en France, même si l’effet Flynn est bel et bien interrompu. Le déclin de l’intelligence dans le monde occidental n’est pas un sujet scientifique, mais plutôt un sujet politique – un argument idéal que les déclinistes utilisent pour faire peur, désigner des coupables, et promouvoir des réformes hostiles au changement.

Si cette idée a autant de succès, c’est probablement qu’elle parle à nos tendances profondes : au second siècle de notre ère, Hésiode se plaignait déjà que les nouvelles générations laissent plus de place à l’oisiveté que les précédentes. Si nous bénéficions d’un droit inaliénable à critiquer les valeurs et les goûts musicaux de nos enfants, une chose est sûre : ils ne sont pas moins intelligents que nous.

Cet article est publié dans le cadre de la Fête de la science (qui a lieu du 3 au 13 octobre 2025), dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « Intelligence(s) ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Corentin Gonthier ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.10.2025 à 11:37

La Fête de la science 2025 met toutes les intelligences à l’honneur

Lire plus (359 mots)

Il est entre parenthèses, mais il donne tout son sens au thème. En ajoutant un « s » à « intelligence », pour son édition 2025, la Fête de la science (dont « The Conversation » est cette année encore partenaire) nous propose d’explorer toutes les formes d’intelligence.

Dans notre dossier spécial, vous trouverez donc aussi bien des articles sur l’IA, sur l’intelligence culturelle ou celle des animaux.

Mais en vidéo, cette année, nous avons voulu mettre l’accent sur deux formes bien spécifiques d’intelligence.

Tout d’abord celle qui permet de lutter contre la bêtise humaine. En poussant les portes de l’Inria, nous avons découvert les travaux de Célia Nouri, doctorante en intelligence artificielle, à la croisée du traitement automatique du langage et des sciences sociales. Elle développe des modèles de détection prenant en compte le contexte social et communautaire des propos haineux, modèle qui sert à mieux lutter contre le harcèlement en ligne.

Le Cnes nous a également ouvert ses portes et avec elles, l’horizon de nos préoccupations. Jacques Arnould, théologien et spécialiste en éthique du Centre national d’études spatiales, il nous encourage à réfléchir aux intelligences extraterrestres. Si demain nous devions en rencontrer, comment arriverions-nous à leur faire reconnaître notre intelligence ? Des pistes de réponse dans cette vidéo.