ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

01.10.2025 à 11:49

Comment débutent les cancers du sein ? Conversation avec la biochimiste Alexandra Van Keymeulen

Texte intégral (3182 mots)

Alexandra Van Keymeulen est biochimiste et spécialiste du cancer du sein. Avec son équipe, elle explore les étapes extrêmement précoces dans le développement des tumeurs, bien avant que celles-ci ne soient détectables. Elle a reçu Elsa Couderc, cheffe de rubrique Science et Technologie, pour expliquer simplement ce qu’est un cancer, et les avancées de la recherche depuis qu’elle a débuté dans le domaine.

The Conversation France : Aujourd’hui, vous êtes une spécialiste reconnue sur l’origine du cancer du sein, mais vous n’avez pas commencé vos recherches par là.

Alexandra Van Keymeulen : J’ai fait ma thèse, en Belgique, sur la thyroïde. J’étudiais les mécanismes qui font que les cellules thyroïdiennes prennent la décision de se diviser. Comme les cellules ne sont pas immortelles, qu’elles vivent moins longtemps que nous, il y a sans arrêt des cellules qui meurent et, donc, des cellules qui se divisent pour donner naissance à de nouvelles cellules. Dans une thyroïde saine, les cellules prennent en permanence la décision de se diviser ou non pour donner naissance à la prochaine génération de cellules.

Je travaillais sur les thyroïdes saines, mais dans un groupe où d’autres personnes étudiaient le cancer de la thyroïde. En effet, les mécanismes de division cellulaire sont dérégulés dans le cas d’un cancer : les cellules se divisent de manière anarchique, sans contrôle. Elles forment une masse, un peu comme un mini-organe. Elles ne répondent plus aux signaux environnants qui leur indiquent de stopper leur croissance. La division cellulaire incontrôlée est la première étape pour former une tumeur.

Mais une tumeur bénigne n’est pas appelée « cancer ». Un cancer a aussi des caractéristiques invasives, c’est-à-dire que ces cellules migrent et envahissent les autres tissus.

Et justement, après ma thèse, je suis partie cinq années à San Francisco en postdoctorat. Là, j’ai travaillé sur la migration cellulaire. Je ne travaillais toujours pas sur des cellules cancéreuses, mais sur les mécanismes intrinsèques, au sein des cellules, qui font qu’elles se déplacent d’un organe à l’autre ; typiquement, ce sont les cellules du système immunitaire qui se déplacent pour aller au site de l’infection.

Ce sont ces mécanismes-là qui sont piratés par les cellules cancéreuses pour former des métastases. Les cellules cancéreuses migrent moins vite que des cellules du système immunitaire, mais elles arrivent à se déplacer.

Après avoir étudié la division cellulaire et la migration des cellules saines, vous êtes rentrée en Belgique pour étudier les cancers du sein ?

A. V. K. : Oui, je suis rentrée en même temps que Cédric Blanpain et j’ai rejoint l’équipe qu’il était en train de monter. Il est spécialiste du cancer de la peau. Très vite, j’ai décidé de travailler sur le sein, qui n’est pas si différent que ça de la peau, car ces deux organes sont composés de cellules épithéliales. Ils ont des caractéristiques communes et donc on peut utiliser les mêmes souris pour les projets qui ont trait au cancer de la peau ou au cancer du sein.

À ce stade, c’était nouveau pour vous comme organe d’étude ?

A. V. K. : Tout était nouveau ! Travailler sur le sein était nouveau, mais je n’avais jamais travaillé non plus avec des souris.

Et quelles étaient les grandes questions de la recherche sur le cancer du sein à l’époque ? Qu’est-ce que vous cherchiez à savoir, dans ce tout nouveau labo, en 2006 ?

A. V. K. : La grande question, c’était de savoir quelles cellules sont à l’origine des cancers du sein. Il y avait déjà à l’époque deux hypothèses. En vingt ans, on a répondu à certaines choses, mais ces deux hypothèses sont toujours là aujourd’hui. Pourquoi y a-t-il différents types de cancer du sein ? Est-ce parce que les patients ont eu différentes mutations génétiques ou parce que les mutations sont survenues dans différents types de cellules de la glande mammaire ? On pourrait avoir aussi une combinaison de ces deux explications.

En ce qui concerne les mutations, on avait déjà repéré que certaines mutations génétiques sont liées à certains types de cancers du sein chez l’humain : on dit que la mutation a un impact sur l’issue tumorale.

Pour explorer l’autre hypothèse – quelles sont les cellules à l’origine d’un cancer, il a d’abord fallu comprendre comment se renouvellent les cellules dans la glande mammaire. Est-ce que tous les types de cellules de la glande mammaire sont maintenus par un seul type de cellule souche, ou bien est-ce qu’à chaque type de cellule correspond une cellule souche ? On appelle ça la « hiérarchie cellulaire ».

Qu’est-ce qu’une cellule souche ?

- Une cellule souche adulte est une cellule capable, à la fois, de générer des cellules spécialisées d’un organe et de se régénérer dans l’organe pour une spécialisation ultérieure.

Comment étudiez-vous d’où viennent les cellules de la glande mammaire et comment elles se renouvellent tout au cours de la vie, pendant une grossesse, l’allaitement, etc. ?

A. V. K. : On a fait du « traçage de lignée » (lineage tracing, en anglais), qui est notre grande spécialité au laboratoire. Cette technique consiste à introduire un marqueur fluorescent dans une cellule. Comme ce marqueur fluorescent est dû à une mutation génétique, le marquage est irréversible : une fois que la cellule est fluorescente, elle va le rester toute sa vie. Et surtout, si elle se divise, toute sa progéniture va être fluorescente aussi… ce qui va nous permettre de suivre le devenir d’une cellule ! Si on a ciblé une cellule qui ne se divise plus, elle va être éliminée après quelques semaines et on n’aura plus de fluorescence. Par contre, si on a ciblé une cellule souche, on va voir qu’elle va donner naissance à de nouvelles cellules qui vont également être fluorescentes.

Avec cette technique, on a pu étudier comment les glandes mammaires sont maintenues au cours du temps et démontrer, en 2011, que ce sont différents types de cellules souches qui renouvellent la glande mammaire.

C’était vraiment un changement de paradigme, car on croyait à l’époque qu’en haut de la hiérarchie cellulaire de la glande mammaire, il y avait des cellules souches « multipotentes » (c’est-à-dire, capables de se différencier en plusieurs types de cellules). On sait aujourd’hui qu’il y a trois types de cellules souches dans la glande mammaire, qui se différencient chacune en un seul type de cellule.

Quels sont ces trois types de cellules dans le sein ?

A. V. K. : Les glandes mammaires contiennent un réseau de tuyaux reliés au mamelon, et qui vont produire le lait à l’intérieur du tube pour l’expulser.

Un premier type de cellules est celui des « cellules basales », aussi appelées myoépithéliales, qui ont des propriétés contractiles et vont se contracter au moment de l’allaitement pour expulser le lait.

Puis, à l’intérieur des tubes, se trouve la couche luminale, qui est composée de deux types de cellules : celles qui sont positives aux récepteurs aux œstrogènes et celles qui sont négatives aux récepteurs aux œstrogènes. Les positives vont sentir la présence des hormones et relayer les signaux hormonaux aux autres cellules, pour dire « Maintenant, on se divise tous ensemble ». Les négatives sécrètent du lait pendant l’allaitement.

Donc aux trois types de cellules dans le sein correspondent trois types de cellules souches « unipotentes ». Mais en ce qui concerne la formation de tumeurs cancéreuses : comment étudiez-vous une tumeur avant même qu’elle existe ? Vous avez une machine à remonter le temps ?

A. V. K. : Eh non ! Il faut prédisposer les souris aux tumeurs. Pour cela, on utilise des souris transgéniques, avec une mutation génétique dont on sait qu’elle est favorable à un cancer du sein. On insère la mutation soit dans les cellules luminales, soit dans les cellules basales. Et on a montré que le type de cancer développé n’est pas le même lorsque la mutation est introduite dans les cellules luminales ou basales.

Comment ça se passe en pratique ? Vous induisez une mutation génétique, mais vous ne pouvez pas être sûre que chaque souris va développer un cancer. Est-ce qu’il faut tuer la souris avant qu’elle développe un cancer, ou on peut faire des prélèvements ?

A. V. K. : Effectivement, toutes les souris prédisposées ne développent pas de cancers. Pour savoir comment ça évolue, nous palpons les souris – comme les palpations qui accompagnent les mammographies dans les examens pour les femmes. Il existe aussi des PET-scanners pour souris, mais mon laboratoire n’est pas équipé.

Si on palpe une tumeur, alors on tue la souris afin de prélever la tumeur et d’étudier le type de cancer qui a été provoqué par la mutation que nous avions induite. C’est comme cela que nous avons démontré, en 2015, qu’une même mutation n’a pas le même effet si elle est introduite sur une cellule basale ou sur une cellule luminale.

Ensuite on a développé un outil pour cibler les cellules luminales, qui sont divisées en deux types, comme on l’a vu : celles qui sont positives aux récepteurs aux œstrogènes et celles qui sont négatives aux récepteurs aux œstrogènes. C’est ce que nous avons publié en 2017. On s’est posé la même question que précédemment : est-ce qu’une même mutation génétique provoque des types de cancers différents ?

Ce sont des recherches qui sont encore en cours, mais, à nouveau, nos résultats semblent montrer que l’issue tumorale dépend de la cellule dans laquelle survient la première mutation.

Vous avez étudié plusieurs mutations connues pour favoriser les cancers du sein ?

A. V. K. : On connaît aujourd’hui des dizaines de mutations génétiques responsables de cancers du sein. Les étudier toutes va prendre du temps, d’autant que cette librairie de mutations est peut-être non exhaustive. Pour l’instant, nous avons étudié une seule mutation, qui est l’une des plus courantes dans le cancer du sein chez la femme.

À lire aussi : Cancer du sein : une nouvelle étude révèle un risque génétique chez les femmes africaines

Est-ce que vous interagissez avec les médecins, avec les patientes ?

A. V. K. : Avec les médecins, oui, bien sûr. On se retrouve aux conférences, et certains de mes collègues sont médecins à l’hôpital universitaire de l’Université libre de Bruxelles, juste à côté de notre laboratoire. Quand j’ai des résultats, je vais en discuter avec un spécialiste du cancer du sein chez l’humain pour essayer de trouver la pertinence pour des cancers chez l’humain.

Je fais aussi partie des experts scientifiques bénévoles pour la Fondation contre le cancer belge – ça fait partie des missions d’un chercheur à l’université que de prendre ce genre de rôle.

Les patientes, je les rencontre plutôt pour de la vulgarisation, avec la Fondation contre le cancer, qui organise tous les ans des visites de laboratoire. Il y a aussi le Télévie, un organisme inspiré du Téléthon, en Belgique francophone et au Luxembourg, où on côtoie des patients et des bénévoles lors d’événements. Ces organismes sont aussi des financeurs de nos recherches.

La prévention est un thème qui me tient à cœur, puisqu’un cancer du sein sur quatre pourrait être évité en éliminant le tabac, l’alcool, le surpoids et en faisant régulièrement de l’activité physique. En particulier, le fait que même une consommation légère d’alcool augmente le risque de cancer du sein est encore très méconnu du grand public, mais démontré scientifiquement.

À lire aussi : Pourquoi l’alcool augmente le risque de cancer, et ce, dès le premier verre

On entend beaucoup parler de certains cancers du sein qui sont liés à des prédispositions génétiques…

A. V. K. : En fait, il n’y a que 10 % des cancers du sein qui viennent de prédispositions génétiques, c’est-à-dire des mutations présentes depuis la naissance, comme c’est le cas d’Angelina Jolie.

La grande majorité des cancers provient de mutations génétiques qui ont lieu au cours de la vie, par exemple à cause de cassures de l’ADN qui sont liées à la consommation de tabac et d’alcool, et qui ont été mal ou pas réparées par l’organisme.

Or, plus un cancer est pris tôt, plus les chances de guérison sont grandes et plus le traitement sera léger. D’où l’intérêt de notre travail sur les étapes extrêmement précoces dans le développement d’une tumeur… mais aussi l’importance pour le patient de consulter dès l’apparition de symptômes.

Justement, vous disiez tout à l’heure que les grandes questions sur l’origine des cancers du sein, qui prévalaient au début de votre carrière, étaient toujours d’actualité aujourd’hui ?

A. V. K. : Tout à fait. Quand on introduit une mutation dans les souris, on doit attendre plusieurs mois – parfois six mois ou un an – avant d’observer l’apparition d’une tumeur. Mais on ne sait pas encore ce qui se passe dans la glande mammaire pendant ce temps-là.

C’est pour cela que je disais tout à l’heure que la question que nous nous posions il y a vingt ans demeure dans une certaine mesure : on cherche toujours ce qu’il se passe dans les cellules qui sont à l’origine du cancer.

En fait, on observe que la mutation change complètement le comportement de ces cellules. La structure extérieure macroscopique de la glande mammaire reste la même, mais, à l’intérieur, les cellules sont tout à fait reprogrammées. Elles deviennent beaucoup plus plastiques, multipotentes – c’est-à-dire qu’elles peuvent donner lieu aux autres types cellulaires.

L’idée serait d’avoir une « fenêtre de tir » thérapeutique entre la mutation et le développement d’une tumeur ?

A. V. K. : Tout à fait : si on comprend ce qui se passe pendant cette période-là, on pourrait imaginer des outils de diagnostic. Par exemple, pour les femmes qui sont prédisposées génétiquement, comme Angelina Jolie, plutôt que d’enlever les seins et les ovaires, on aimerait pouvoir les surveiller de près et, dès que l’on verrait apparaître certaines de ces étapes précoces, intervenir avec un traitement préventif pour inhiber le développement d’une tumeur cancéreuse.

À l’heure actuelle, ça reste hypothétique : nous sommes un laboratoire de recherche fondamentale. Aujourd’hui, on essaye de comprendre ce qui se passe entre l’introduction de la mutation et le début de la tumeur. Auparavant, on devait se contenter d’étudier les tumeurs elles-mêmes, car nous n’avions pas les outils pour étudier cette fenêtre de six mois – je précise que cette durée est évaluée chez les souris, pas chez les humains.

Pour mener à un cancer, il faut une mutation génétique dans une seule cellule, ou bien la même mutation dans plein de cellules différentes, une accumulation progressive ?

A. V. K. : Il faut plusieurs mutations dans une seule cellule – s’il ne fallait qu’une mutation dans une cellule, tout le monde aurait des cancers partout ! C’est une accumulation de probablement sept ou huit mutations bien spécifiques.

Mais quand une cellule est mutée, souvent ce qu’on observe, c’est que ces mutations donnent un avantage à ces cellules par rapport aux cellules avoisinantes. Des études récentes montrent par exemple des « taches » dans la peau des paupières, invisibles à l’œil nu. Ce sont des zones de la peau où toutes les cellules ont les mêmes mutations. Elles proviennent d’une seule et même cellule, qui s’est divisée, au détriment des cellules avoisinantes : en se divisant, les descendantes de la cellule mutée poussent les autres et propagent les mutations. C’est aussi vrai pour d’autres organes, notamment la glande mammaire.

Aujourd’hui, sur les étapes précoces des cancers du sein, nous cherchons donc à savoir comment les cellules à l’origine du cancer sont reprogrammées génétiquement et comment cela leur confère un avantage par rapport aux cellules saines. On explore ainsi petit à petit les grandes étapes qui mènent à une tumeur.

Alexandra Van Keymeulen est consultant scientifique de Cancer State Therapeutics. Ses recherches bénéficient du soutien financier du FNRS, Télévie, Fondation contre le Cancer et du Fonds Gaston Ithier.

01.10.2025 à 11:10

Titanic : le navire qui cache la flotte d’épaves en danger

Texte intégral (2141 mots)

L’épave du « Titanic » est en danger et pourrait se briser d’ici 2030. Ce n’est pourtant qu’un cas parmi des millions d’autres. Saviez-vous que les bactéries sont impliquées dans la dégradation des épaves, mais aussi dans leur transformation en oasis de vie ? Mieux connaître ces microorganismes et leurs interactions avec les navires est urgent pour protéger notre patrimoine historique.

La découverte de l’épave du RMS Titanic en 1985 a provoqué un engouement extraordinaire autour de ce navire, son histoire, sa fin tragique et le repos de cette épave dans l’obscurité des profondeurs glacées de l’Atlantique. Les images ont révélé un navire brisé recouvert d’étranges concrétions ressemblant à des stalactites de rouille appelées rusticles.

Elles sont faites notamment à partir du métal de l’épave et leur origine est liée aux microorganismes qui utilisent le fer de l’épave pour leur développement, participant ainsi à la corrosion.

Les interactions entre les bactéries et les matériaux sont au cœur de mes recherches. Les bactéries qui se multiplient à la surface des matériaux peuvent participer à leur protection ou à leur dégradation. Le cas du fer est particulier, car c’est un élément indispensable aux êtres vivants. Mais la biocorrosion, conséquence de son utilisation par les microorganismes, est un phénomène qui touche de nombreux secteurs : industries, installations en mer, sur terre ou souterraines… et bien sûr les épaves métalliques.

Les plongées successives sur le Titanic ont montré un affaiblissement des structures de l’épave rongées par la corrosion et son effondrement a été évoqué pour 2050, voire 2030. Ceux qui se passionnent pour le Titanic s’alarment : comment sauver cette épave ? Et d’ailleurs, pourquoi faudrait-il sauver le Titanic ?

Qu’est-ce qu’une épave ?

Pourquoi sauver une épave ? Parce qu’elle nous touche, parce qu’elle provoque en nous des sensations, de l’émerveillement. Une épave, c’est un souvenir, un témoin d’une histoire, d’un événement, un vestige d’une création humaine qui a eu une fin le plus souvent tragique. Tout comme un monument historique à terre, une épave gisant sous les eaux témoigne de notre histoire.

La différence, c’est que si tout le monde peut voir le monument, très rares sont ceux qui peuvent voir l’épave. Et pourtant, elle est là, artéfact de notre patrimoine historique. Aux termes de notre législation, c’est un bien culturel maritime. Selon la charte de l’Unesco de 2001, ratifiée par la France en 2013, elle peut faire partie du patrimoine culturel immergé. À ces titres, elle doit être protégée. Est-ce tout ? Non, loin de là. Une épave peut aussi être porteuse d’économie, par les activités de loisirs qui sont menées autour d’elle, comme la plongée sous-marine, ou comme site de ressources halieutiques.

Une oasis de vie

Dès le moment où l’épave se pose sur le fond, sa colonisation commence. Ce sont d’abord des microorganismes planctoniques qui se fixent sur les surfaces. Cette première étape favorise l’arrivée d’autres organismes, notamment des larves d’animaux vivant fixés sur des substrats durs, comme les gorgones ou les coraux, ainsi que des algues. Tout ce petit monde va attirer ceux qui s’en nourrissent, puis les prédateurs de ces derniers et ainsi de suite… pour aboutir à la formation d’un véritable écosystème récifal, dont les limites sont approximativement celles du site de l’épave, même si la zone d’influence de cet écosystème peut aller bien au-delà.

L’épave se transforme en un récif animé, une oasis de vie gisant sur un morne fond de sable à l’apparence d’un désert sous-marin. Ainsi vont les choses, tant que l’épave tient bon. Tempêtes, filets de pêche, corrosion, avec le temps l’épave s’affaiblit et commence à craquer, d’abord dans ses parties les moins solides, puis dans son ossature. C’est la vie ! Ou justement, c’est la fin de la vie… En perdant ses volumes, l’épave offre de moins en moins de surfaces dures à la colonisation. Les populations d’organismes fixés décroissent, ce qui rend le récif moins attirant pour leurs prédateurs. Plus l’épave se désagrège, plus l’oasis de vie se réduit, jusqu’à disparaître avec le vestige. Plus de vestige, plus d’écosystème récifal, donc, mais encore ? Moins d’attrait pour les plongeurs et pour les pêcheurs, donc moins d’intérêt économique. En enfin, c’est la disparition d’un témoignage de notre histoire, d’une partie de notre patrimoine. Lorsqu’un monument historique tombe en ruine, il se trouve souvent quelqu’un pour tenter de le sauver de l’oubli. Pourquoi en serait-il autrement pour une épave ?

Les racines du mal

Quel est le point commun entre le Titanic et nombre d’épaves des deux derniers siècles, dont celles des deux guerres mondiales ? Elles sont en alliages ferreux. Et le fer dans l’eau, ça rouille, surtout en eau salée. En réalité, c’est beaucoup plus compliqué que cela et c’est justement cette complexité qui est au cœur du problème : comment lutter contre un phénomène mal compris ? Pour espérer sauver une épave, il faut d’abord comprendre les mécanismes qui causent sa perte. La corrosion d’une épave métallique n’est pas qu’une affaire de physico-chimie entre l’épave et l’eau dans laquelle elle baigne.

Les microorganismes colonisateurs jouent plusieurs rôles, à la fois dans l’accentuation et dans la protection contre la corrosion. Leur développement a comme effet à court terme l’initiation de l’écosystème récifal. À moyen et long terme, ces bactéries peuvent protéger ou accentuer la corrosion. La prolifération bactérienne s’accompagne de la production de substances organiques qui les enveloppent, formant ainsi ce que l’on appelle un biofilm sur la surface colonisée. D’autres composés peuvent être produits et s’accumuler, par exemple du calcaire. L’ensemble peut agir comme une barrière à l’interface entre le métal et l’eau, avec un effet protecteur. Certains groupes bactériens sont particulièrement attirés par ces épaves, par exemple les zétaprotéobactéries. Elles sont capables d’oxyder le fer. Elles trouvent donc sur ces épaves des conditions favorables à leur développement, avec pour conséquence un rôle dans les mécanismes de la corrosion au cours du temps. Les zétaproteobactéries ne sont pas les seules. La diversité bactérienne colonisant les épaves métalliques est importante. Tout ce petit monde forme des communautés qui varient selon les épaves et les conditions environnementales où elles gisent.

Comprendre la composition et la dynamique des communautés au sein de ces biofilms est nécessaire pour savoir de quelles manières elles participent au devenir de l’épave et pour imaginer des solutions de préservation aussi bien pour les épaves métalliques que pour d’autres structures immergées. En effet, les épaves métalliques ne sont qu’une catégorie de structures immergées. Pour les autres types de structures, les problèmes de conservation, de durabilité de leurs matériaux se posent de la même façon, avec le risque de coûts non négligeables engendrés pour leur entretien. Être en mesure de protéger notre patrimoine historique et culturel immergé va donc bien au-delà. Mais le temps s’écoule et à chaque instant la corrosion poursuit son œuvre, grignotant sans relâche. Les recherches ont besoin de temps et surtout de moyens. Il est difficile de financer des projets regroupant des microbiologistes, des archéologues, des chimistes, des océanographes pour travailler de façon globale sur cette problématique. La rareté des publications scientifiques sur le sujet en atteste et les connaissances sont balbutiantes. Or, dans cette course, il n’y a pas de seconde place : une fois détruite, l’épave est perdue. 2030 pour le Titanic ? Quelle échéance pour les épaves des deux guerres mondiales ? Il y a urgence.

Laurent Urios ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

01.10.2025 à 11:02

Les chats peuvent aussi souffrir de démence : les huit signes à surveiller

Texte intégral (1806 mots)

Tous comme les humains, les chats subissent un déclin cognitif en vieillissant pouvant aller jusqu’à de la démence : quels en sont les signes et comment accompagner, au mieux, votre chat vieillissant ?

De nombreux propriétaires de chats ne réalisent pas que, tout comme les humains, les chats peuvent souffrir de démence. Un article scientifique récent a même mis en évidence de nombreuses similitudes entre la démence féline et la démence humaine, concluant que les troubles cognitifs peuvent se développer de manière similaire.

Certains symptômes de la démence chez les chats sont même similaires à ceux que l’on observe chez les humains, mais pas tous, bien sûr. Il est important de connaître les signes à surveiller afin de pouvoir prodiguer les meilleurs soins à votre animal pendant cette phase de sa vie.

Le syndrome de dysfonctionnement cognitif félin (également appelé démence féline) est un déclin des capacités cognitives d’un chat lié à l’âge. Il se caractérise généralement par des changements de comportement qui ne peuvent être attribués à d’autres troubles médicaux.

La démence féline serait très fréquente chez les chats âgés. Une étude a révélé qu’à l’âge de 15 ans, plus de la moitié des chats présentaient des signes de démence. Cependant, certains comportements associés à cette maladie ont également été observés chez des chats âgés de seulement 7 ans. Une autre enquête menée auprès de propriétaires de chats a également révélé qu’environ 28 % des chats âgés de 11 à 14 ans présentaient au moins un changement de comportement associé à la démence. (NDLT : l’espérance de vie d’un chat domestique varie entre 13 et 20 ans)

Les changements de comportement sont souvent les premiers signes indiquant qu’il pourrait y avoir un problème. Il existe huit signes à surveiller qui peuvent indiquer que votre chat souffre de démence.

1. Vocalisations inhabituelles : votre chat peut commencer à vocaliser de manière excessive ou dans des situations nouvelles. Un exemple courant est celui des miaulements bruyants pendant la nuit.

2. Modifications de leurs interactions avec les humains : les chats atteints de démence peuvent parfois rechercher davantage d’attention ou devenir « collants ». À l’inverse, ils peuvent également interagir moins qu’auparavant, sembler irritables ou ne pas reconnaître les personnes familières.

3. Changements dans leur sommeil : vous remarquerez peut-être des changements dans les habitudes de sommeil de votre chat, qui deviendra souvent agité la nuit et dormira davantage pendant la journée.

4. Souillures dans la maison : les changements dans les habitudes d’élimination peuvent être le signe de plusieurs troubles différents, mais faire ses besoins en dehors du bac à litière peut être un signe courant de démence chez les chats.

5. Désorientation : tout comme les personnes atteintes de démence, les chats peuvent montrer des signes de confusion ou sembler se perdre. Cela peut se traduire par une perte de repères, un regard fixe sur les murs, le fait de rester coincé derrière des objets ou de se diriger du mauvais côté de la porte.

6. Changements de niveau d’activité : Un chat atteint de démence peut être plus ou moins actif que d’habitude. Il peut jouer moins souvent ou être moins enclin à explorer. Vous remarquerez peut-être également qu’il passe moins de temps à prendre soin de lui, par exemple en se toilettant ou en se lavant moins souvent.

7. Anxiété apparente : un chat atteint de démence peut montrer des signes d’anxiété dans des situations où il se sentait auparavant en confiance, par exemple en présence de personnes, dans des lieux ou face à des sons familiers. Un chat anxieux peut se cacher plus souvent, se réfugier sous le lit ou sur les placards pour s’échapper.

8. Problèmes d’apprentissage : Les chats atteints de démence peuvent avoir plus de difficultés à accomplir des tâches qu’ils avaient apprises auparavant, comme trouver leur gamelle, et peuvent avoir du mal à en apprendre de nouvelles.

Bien s’occuper de son chat

Il existe un chevauchement important entre les symptômes de la démence féline et d’autres pathologies courantes, telles que l’arthrite et les maladies rénales. Si vous constatez l’un de ces changements de comportement chez votre chat, consultez votre vétérinaire afin d’écarter ces autres problèmes.

Les recherches sur la démence féline sont limitées. La plupart de nos connaissances en matière de prévention et de traitement sont extrapolées à partir de recherches menées sur les humains et les chiens. Et, comme pour ces autres espèces, il n’existe aucun remède contre la démence chez les chats. Il existe toutefois des moyens de limiter l’impact de la maladie.

Certaines modifications de leur environnement peuvent aider à stimuler les chats, en activant leur cerveau et en favorisant la croissance des nerfs. Mais il faut tenir compte de la gravité de la démence de votre chat avant d’apporter ces changements.

Chez les chats en bonne santé ou légèrement atteints, on pense que le fait de les inciter à jouer ou de simuler la chasse à l’aide de jouets interactifs et de les encourager à explorer leur environnement à travers des jeux de cache-cache permet de retarder la progression des troubles cognitifs.

Mais chez les chats souffrant de troubles cognitifs sévères, changer leur environnement pourrait entraîner de la confusion et de l’anxiété, ce qui aggraverait les symptômes comportementaux.

Des changements alimentaires, notamment l’ajout de compléments alimentaires contenant des antioxydants (vitamines E et C) et des acides gras essentiels, peuvent également contribuer à réduire l’inflammation cérébrale et à ralentir la progression de la maladie.

Cependant, seuls les compléments alimentaires spécifiques aux chiens ont été testés dans le cadre de recherches scientifiques et ont prouvé leur efficacité pour améliorer les capacités cognitives des chiens. Mais si vous souhaitez tout de même donner ces compléments à votre chat, veillez à ne lui donner que des compléments approuvés pour les félins. Les compléments alimentaires pour chiens ne doivent pas être donnés aux chats, car ils peuvent contenir des substances toxiques pour eux, telles que l’acide alpha-lipoïque.

La démence féline est une maladie très répandue et difficile à traiter. Connaître les symptômes à surveiller peut permettre à votre chat d’être diagnostiqué plus tôt. Cela vous permettra également d’apporter les changements nécessaires à son environnement ou à son alimentation, ce qui améliorera sa qualité de vie.

Emily Blackwell reçoit des financements de Cats Protection, Zoetis, Defra et Waltham Petcare Science Institute.

Sara Lawrence-Mills reçoit un financement de Zoetis.

01.10.2025 à 10:53

Fusion nucléaire : les systèmes d’IA changent déjà la donne

Texte intégral (2988 mots)

La fusion nucléaire, qui alimente notre Soleil, est l’un des plus grands espoirs pour produire une énergie propre, abondante et sûre. Elle consiste à fusionner des noyaux légers, par exemple de l’hydrogène, pour former des noyaux plus lourds, en libérant une énorme quantité d’énergie. Contrairement à la fission, elle ne génère pas de déchets radioactifs de longue durée ni de gaz à effet de serre.

Mais recréer cette réaction sur Terre est un défi technologique et scientifique colossal. Les prototypes sont gigantesques et très coûteux, et le numérique prend une place importante pour faciliter les essais. Depuis le milieu des années 2010, et de manière accélérée depuis 2020, des systèmes d’intelligence artificielle sont utilisés pour contrôler le plasma et améliorer la conception de futurs réacteurs.

Pour atteindre la fusion, il faut chauffer les atomes à des températures de plus de 100 millions de degrés. Les atomes forment alors un plasma, un gaz ionisé ultra-chaud impossible à contenir par des matériaux solides.

Les physiciens doivent donc faire preuve d’imagination et deux grandes approches expérimentales sont poursuivies depuis des décennies : l’une avec des champs magnétiques, l’autre avec des lasers.

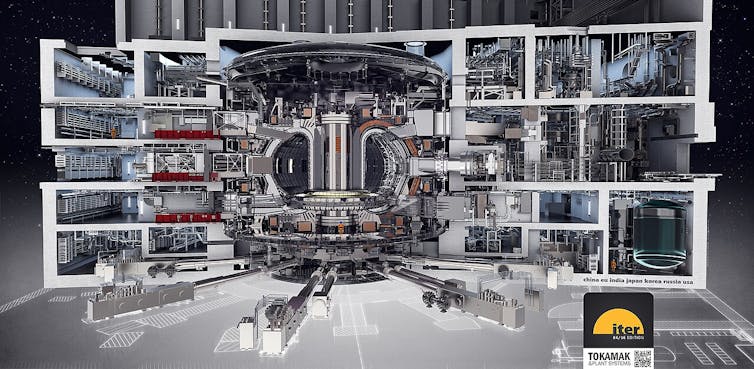

La fusion par confinement magnétique confine le plasma par de puissants champs magnétiques dans un réacteur en forme de tore, appelé « tokamak ». Le projet international ITER, un consortium international impliquant l’Union européenne, le Japon, les États-Unis, la Chine, la Russie, l’Inde et la Corée du Sud et installé en Provence, est l’exemple le plus ambitieux, mais il existe de nombreux tokamaks expérimentaux à travers le monde.

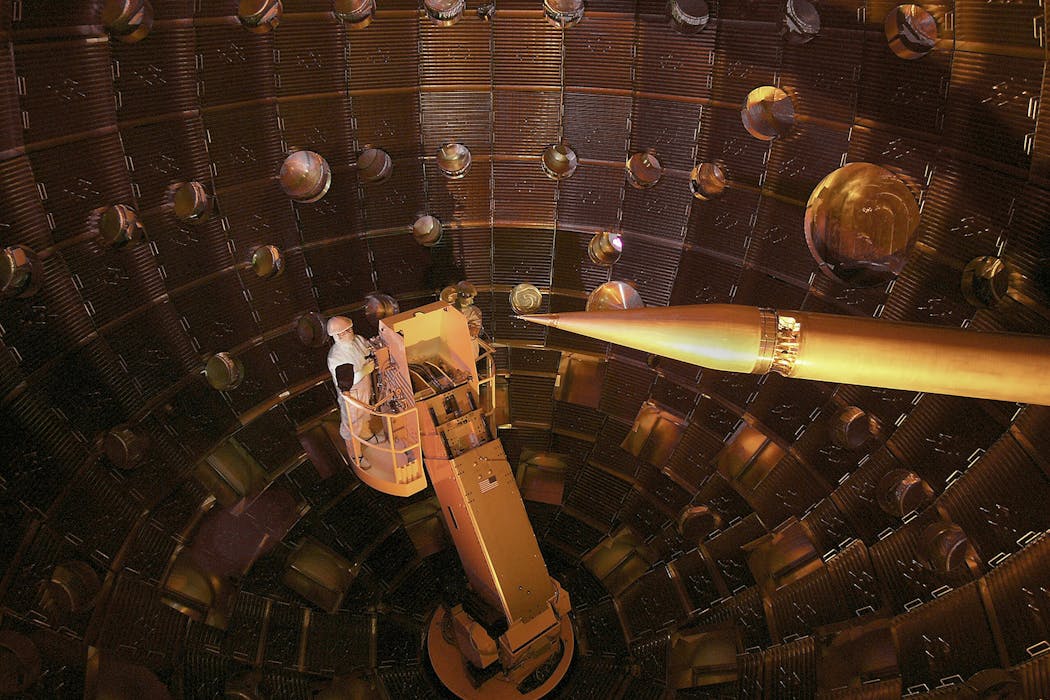

La fusion par confinement inertiel utilise des lasers, incarnée par le laboratoire National Ignition Facility aux États-Unis. Au NIF, les scientifiques utilisent 192 lasers géants pour comprimer et chauffer une capsule de combustible en une fraction de seconde, et pendant une minuscule fraction de seconde.

Les deux approches font face à d’énormes défis : maintenir la stabilité du plasma, éviter les instabilités destructrices, prédire les disruptions (par exemple, dans un tokamak, une « disruption thermique » peut brutalement refroidir le plasma et libérer son énergie sur les parois, risquant de les endommager), optimiser les tirs laser ou la forme du plasma.

Et c’est ici que les systèmes d’intelligence artificielle entrent en scène. L’outil numérique a toujours été vital pour saisir les phénomènes complexes, grâce notamment à l’analyse de données massives. Aujourd’hui, l’IA pousse cette capacité encore plus loin. Notons toutefois que les systèmes d'IA sont très variés, et qu'il ne s'agit pas dans ce cas de système d'IA générative, tels que ceux qui ont donné naissance à ChatGPT ou Dall-E par exemple.

Fusion magnétique : une IA aux commandes du plasma

Dans les tokamaks, des milliards de données sont générées à chaque tir : images, champs magnétiques, températures, densités. En 2022, une avancée spectaculaire a été réalisée dans le tokamak TCV (Tokamak à Configuration Variable) de l’EPFL à Lausanne, qui est un dispositif expérimental de taille moyenne, dédié aux recherches fondamentales. Une intelligence artificielle développée par DeepMind et le Swiss Plasma Center a été utilisée pour contrôler en temps réel la forme et la position du plasma en utilisant l’apprentissage par renforcement profond. Plus spécifiquement, il s'agit d'un système de contrôle en boucle fermée. Les ajustements de l’IA se font en temps réel, à l’échelle de la milliseconde, ce qui correspond aux temps caractéristiques de l’évolution des instabilités dans un plasma de tokamak. Ainsi, l’algorithme peut ajuster les champs magnétiques de manière dynamique pour maintenir le plasma stable, une première mondiale publiée dans la revue Nature.

Autre prouesse : la prédiction des disruptions, ces instabilités soudaines qui peuvent endommager les réacteurs. Des modèles d’apprentissage automatique, comme les réseaux de neurones, sont capables d’identifier les signaux précoces de telles instabilités.

Ainsi, sur le tokamak DIII-D aux États-Unis, une IA entraînée (apprentissage supervisé) uniquement sur des données expérimentales de ce tokamak a pu anticiper une disruption, 300 millisecondes à l’avance, donnant au système le temps de réagir. Cette approche sans modèle physique — c’est-à-dire basée uniquement sur un système d'IA analysant en temps réel les données du réacteur (data-driven) —, a permis d’activer des systèmes d’atténuation (par exemple injection d’impuretés ou modulation des champs) à temps, ce qui a stabilisé le plasma. On conclut qu’une disruption a été évitée non pas parce qu’on l’a « vue » se produire, mais parce que les conditions observées correspondaient à celles qui, dans toutes les campagnes précédentes sans intervention, menaient invariablement à une interruption brutale. Publiés dans Nature en 2024, ces résultats ouvrent la voie à un contrôle plus dynamique des réactions de fusion.

Divers systèmes d'IA, par exemple par exemple des réseaux de neurones convolutifs (CNN) ou des autoencodeurs variationnels (VAE) sont aussi utilisés pour améliorer les diagnostics, repérer les anomalies dans les capteurs, analyser les vidéos de turbulence plasma ou encore accélérer les simulations grâce aux jumeaux numériques.

Un jumeau numérique est une réplique informatique d’un système réel, alimentée en continu par des données expérimentales. Dans le cas de la fusion, il s’agit de modèles capables de reproduire l’évolution d’un plasma. L’IA intervient ici pour accélérer ces modèles (par exemple en remplaçant des calculs très lourds de mécanique des fluides par des approximations apprises) et pour combler les manques des équations physiques là où les théories actuelles sont incomplètes.

Alors que, dans le cas précédent, l’IA prédisait un événement critique (une disruption) à partir de données, les jumeaux numériques assistés par IA permettent d’accélérer des simulations complètes de plasma pour des usages plus prospectifs — l’optimisation de l’architecture d’un réacteur par exemple.

Fusion inertielle : concevoir les meilleurs tirs laser avec l’IA

La fusion inertielle, elle, repose sur la compression ultrarapide de capsules de combustible par des lasers. Les tirs sont rares et coûteux, principalement à cause de l’énergie colossale nécessaire pour alimenter les lasers (et leur préparation), mais aussi du coût des capsules de combustible et du temps de recalibrage entre deux tirs. Dans ces conditions, chaque milliseconde compte.

Ici encore, les systèmes d’IA changent la donne. À l’Université de Rochester, aux États-Unis, une IA (de type optimisation bayésienne) a été entraînée à optimiser la forme des impulsions laser sur le système OMEGA (le plus puissant laser académique au monde, dédié à la recherche sur la fusion par confinement inertiel). OMEGA génère ces tirs avec précision, et des diagnostics mesurent les résultats à des échelles de millionièmes de mètre et de trillionièmes de seconde.

Dans ce cas, le système d’IA est utilisé pour corriger les écarts entre simulations et réalité, optimiser les impulsions laser, et proposer les meilleures configurations expérimentales. Résultat : une augmentation spectaculaire du rendement de fusion, multiplié par trois dans certains cas. Ce type de modèle, publié dans Nature, permet d’explorer rapidement un vaste espace de configurations sans tout tester expérimentalement.

L’IA est aussi utilisée pour corriger les simulations, combler les écarts entre théorie et réalité, et proposer des conceptions inverses : on fixe un objectif (par exemple, atteindre l’ignition) et l’IA propose le meilleur design pour y arriver. C’est ce qui a permis, fin 2022, à NIF d’atteindre pour la première fois un rendement de fusion supérieur à l’énergie injectée par les lasers, un jalon historique.

Enfin, plusieurs types de systèmes d’intelligence artificielle sont utilisés : certains sont spécialisés dans l’analyse d’images pour exploiter les diagnostics, d’autres aident les robots à bien viser et aligner les cibles, et d’autres encore reconnaissent automatiquement quand un tir a échoué. L’objectif à terme est d’automatiser totalement ces expériences, en les rendant adaptatives et intelligentes.

Défis et avenir de l’IA dans la fusion

Alors que d’ici 2035, ITER générera environ 2 pétaoctets de données par jour, on comprend que la science des données se révèlera vitale pour traiter et appréhender toutes les informations.

Intégrer des systèmes d’IA à la fusion n’est pas sans obstacle. Les modèles doivent être rapides (c’est-à-dire capables de donner des résultats quasi en temps réel pour accompagner le pilotage du plasma), robustes (résistants aux erreurs de mesure et aux variations des données), interprétables (leurs décisions doivent pouvoir être comprises par les physiciens et justifiées, et non pas rester une « boîte noire ») et transférables d’une machine à l’autre (un modèle entraîné sur un tokamak donné doit pouvoir être adapté sans repartir de zéro sur un autre dispositif).

Les chercheurs travaillent donc sur des systèmes d’IA informés par la physique, capables d’expliquer leurs décisions et respectueux des lois fondamentales. Les données sont aussi limitées pour certains dispositifs comme NIF, ce qui pousse à combiner expériences et simulations pour enrichir les jeux de données. En effet, plus le volume de données est grand, plus l’IA peut apprendre des régularités complexes du plasma ; tandis qu’un jeu de données limité risque de conduire à des modèles biaisés ou peu généralisables.

Au-delà des limitations techniques actuelles, par exemple la puissance de calcul nécessaire pour traiter en temps réel les données issues de milliers de capteurs, la difficulté à garantir la fiabilité des prédictions face à un plasma chaotique ou encore la rareté de bases de données suffisamment riches pour entraîner correctement les modèles, l’intégration de systèmes d’IA dans des réacteurs de fusion pose aussi des questions de responsabilité. En cas de défaillance d’un algorithme entraînant une perte de confinement ou un dommage matériel, qui serait responsable : les concepteurs du réacteur, les développeurs du logiciel, ou les opérateurs ? Ces enjeux juridiques et éthiques restent encore largement ouverts, mais sont cruciaux au regard des énergies et températures en jeu.

Dans les années à venir, l’intégration de l’IA pourrait accélérer les progrès vers une fusion maîtrisée et commercialement viable. Si la fusion est le rêve énergétique ultime, alors l’intelligence artificielle pourrait bien en être la clé.

Cet article est publié dans le cadre de la Fête de la science (qui a lieu du 3 au 13 octobre 2025), dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « Intelligence(s) ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Sadruddin Benkadda reçoit des financements de Aix Marseille Université, CNRS et de EUROFUSION. Collaboration avec ITER Organisation et l'IRFM (CEA)

Thierry Lehner et Waleed Mouhali ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.

30.09.2025 à 17:00

Et si votre prochain collègue était un agent IA ?

Texte intégral (2243 mots)

Les agents d’IA sont capables d’effectuer différentes tâches de façon plus ou moins autonome. À mesure qu’ils sont intégrés à nos outils et à nos échanges personnels et professionnels, c’est toute la société qui doit décider ce qu’elle souhaite déléguer… et ce qu’elle préfère préserver.

En arrivant au bureau, un mail vous attend. Votre client voulait une mise à jour sur sa commande. Mais un agent IA a déjà consulté les données de livraison et envoyé un message de suivi. Vous n’avez rien eu à faire.

Ce n’est pas de la science-fiction. Les agents IA sont sur le point de transformer en profondeur nos façons de travailler. L’entreprise américaine de conseil Gartner estime que 15 % des décisions professionnelles quotidiennes seront prises par des agents IA d’ici 2028, et 33 % des entreprises utiliseront des agents IA (contre 1 % en 2024). Ces agents ne sont pas de simples assistants mais des entités capables d’agir, décider et parfois collaborer entre elles. Leur émergence pose des questions fondamentales sur le rôle des humains au travail.

Que sont les agents IA ?

Un agent IA est un logiciel (semi)-autonome qui utilise des techniques d’intelligence artificielle pour percevoir, prendre des décisions, accomplir des tâches et atteindre des objectifs prédéterminés, dans des environnements physiques ou numériques. Un agent IA peut agir pour le compte d’un utilisateur ou d’un autre système, par exemple un autre agent logiciel, en concevant son processus de travail et utilisant les outils disponibles.

Certains agents suivent une logique strictement scriptée, tandis que d’autres sont dotés d’une plus grande autonomie : ils déterminent eux-mêmes le bon moment pour agir en fonction du contexte, des objectifs et des informations disponibles. C’est cette autonomie qui caractérise l’« IA agentique ». Cette forme particulièrement autonome d’agent IA, qui ouvre de nouvelles possibilités mais soulève également des enjeux inédits en matière de conception, de contrôle et d’usage. Tous les agents IA ne forment pas une IA agentique, bien que la tendance aille en ce sens.

Par exemple, un « agent IA agentique » pourrait envoyer de lui-même un message aux clients de manière proactive si un message de retard du fournisseur est arrivé. Dans le contexte européen, une telle autonomie n’est pas interdite, mais elle relève des obligations de supervision humaine et de transparence imposées par l’AI Act (2024). Dans ce cadre, supervision ne signifie pas validation systématique de chaque action, mais capacité à tracer, contrôler et reprendre la main à tout moment.

Le marché mondial des agents IA, agentiques ou non, devrait représenter 47,1 milliards de dollars en 2030, 1,896 milliard de dollars en France en 2030.

Les agents IA s’appuient sur différentes briques d’intelligence artificielle : compréhension de requêtes, recherche d’informations, planification, action dans les systèmes, génération de texte. Parmi ces briques, les grands modèles de langage (LLM) jouent un rôle central, mais sont désormais utilisés par les agents IA de manière autonome, sans intervention humaine.

Les agents IA : vers une hyper automatisation du travail ?

Les agents IA fonctionnent en continu, sans fatigue ni pause. Ils permettent aux organisations d’étendre considérablement leur capacité d’action. À ce titre, ils incarnent la promesse d’une productivité accrue et d’une réduction des coûts.

À lire aussi : Les robots collaboratifs, des collègues de travail comme les autres ?

Mais cette automatisation radicale réactive des craintes anciennes : déqualification, dilution des responsabilités, dépendance technologique, perte de contrôle. Ainsi, 75 % des citoyens français pensent que l’IA détruira plus d’emplois qu’elle n’en créera, et 63 % refusent aujourd’hui de se former à ces outils selon le Labo Société Numérique 2024. Aux États-Unis, seuls 23 % des adultes pensent que l’IA améliorera leur façon de travailler, contre 73 % des experts de l’IA.

La rupture est donc aussi sociale que technologique.

Les agents d’IA permettront-ils d’innover davantage ?

Automatiser les processus peut figer une manière de faire, plutôt que d’innover. Selon Erik Brynjolfsson, le véritable potentiel de l’IA réside dans son pouvoir d’augmenter les capacités humaines pour faire de nouvelles choses, pas de les remplacer.

Ainsi, plutôt que de remplacer les humains, les agents IA pourraient élargir leur champ d’action créatif, en leur suggérant des idées nouvelles, en automatisant l’exploration de variantes ou en testant rapidement des pistes qu’un humain seul n’aurait pas le temps d’examiner… par exemple pour ouvrir la voie à des avancées majeures, notamment dans le domaine de la biomédecine.

Mais pour cela, il faut qu’ils soient dignes de confiance. Le fait que 93 % des employés de bureau doutent encore de la fiabilité des résultats produits par l’IA ne relève pas seulement d’un problème d’adoption : cette méfiance renvoie à des failles concrètes des systèmes actuels, qu’il s’agisse d’erreurs, de biais, ou d’un manque de traçabilité et d’explicabilité.

Quelle responsabilité pour les agents d’IA ?

Face à des systèmes capables d’agir de manière autonome tout en faisant des erreurs, qu’il s’agisse de biais, de décisions inadaptées ou d’hallucinations, une question demeure : qui est responsable du résultat ?

Les agents, par nature, ne peuvent ressentir ni assumer la responsabilité de leurs actes. Pourtant, leur rôle peut rester invisible aux yeux des utilisateurs : les employés peuvent ignorer qu’un agent a pris une décision à leur place, ou se retrouver démunis face à un raisonnement biaisé qu’ils ne comprennent pas. Un autre risque tient à l’imprécision des consignes données par l’utilisateur, ou à la manière dont l’agent les comprend. Une interprétation erronée peut amener ce dernier à sélectionner un outil inadéquat ou à en faire un usage détourné, avec des effets indésirables. Ce type de dérive est parfois qualifié d’ « hallucination d’appel de fonction ». Enfin, une étude publiée dans Nature montre que les agents IA sont plus enclins que les humains à suivre des instructions manifestement non éthiques, ce qui demande la mise en place de garde-fous prohibitifs. Lorsque les agents travaillent en mode agentique, en toute autonomie et auto-orchestration, ces questions ont d’autant plus de poids.

Ce sont donc les organisations qui doivent prendre l’initiative de mettre en place des mécanismes de gouvernance robustes, pour assurer à la fois la conformité éthique des usages et le bien-être des salariés exposés à ces systèmes. Les actions des agents IA peuvent aussi des conséquences imprévues, dont les organisations restent responsables, ce qui impose de se doter d’un cadre de gouvernance adéquat. Cela suppose des actions concrètes : une gouvernance robuste de l’IA dans l’entreprise, un niveau suffisant de transparence, et des cadres réglementaires établis.

En pratique, il est essentiel de définir explicitement les responsabilités respectives des humains et des machines, et de former les employés — notamment à la littératie algorithmique — pour leur permettre d’agir en connaissance de cause. Il faut également permettre une collaboration contradictoire, avec un agent IA qui interroge et affine les recommandations de l’agent humain.

D’un point de vue technique, le recours à des audits indépendants et la mise en place de dispositifs d’alerte en cas de dysfonctionnement constituent des garanties indispensables pour un contrôle pertinent des agents IA.

Collaborer… sans humains ? Les limites d’un avenir de systèmes multiagents

Certaines entreprises envisagent de faire collaborer plusieurs agents IA spécialisés pour atteindre des objectifs communs : ce sont les systèmes multiagents. Par exemple, des agents IA pourraient travailler ensemble pour suivre votre réclamation client sur votre dernière commande en ligne, faire des recommandations, remonter la solution, et ajuster votre facture.

Pour y arriver, il reviendra à l’entreprise de bien orchestrer la collaboration entre les agents IA. Elle peut créer un réseau centralisé, avec un serveur qui contrôle les actions et informations des agents et qui peut prendre la main sur le système ; ou alternativement, un réseau décentralisé où les agents IA contrôlent leurs interactions entre eux. Outre les risques d’échec de coordination, l’organisation peut être confrontée à des conflits informationnels entre agents IA et des collusions, et des risques de sécurité.

Plus l’autonomie des agents est élevée, plus il devient essentiel de maintenir une forme de contrôle sur les tâches accomplies. Le règlement européen sur l’intelligence artificielle insiste sur l’importance qu’un humain dans la boucle puisse intervenir pour corriger, interrompre ou valider les actions de l’IA.

Mais le marché de l’agentique propose une autre solution. Des agents gardiens qui peuvent surveiller, guider, et intervenir dans le comportement des autres agents lorsque nécessaire. Ces agents-gardiens, ou contremaîtres, représenteraient 10 à 15 % du marché de l’IA agentique.

Faut-il alors imaginer un futur où les humains deviendraient les contrôleurs des contrôleurs ? Or, ce rôle de supervision sans implication directe dans l’action est loin d’être satisfaisant : il est souvent associé à une baisse de l’engagement et de l’épanouissement professionnel. Pire encore, plus nous déléguons les tâches formatrices à des systèmes automatisés, plus il devient difficile pour les humains d’intervenir efficacement lorsque l’IA échoue, faute d’entraînement ou de compréhension fine de la tâche.

La prochaine fois que vous engagerez une nouvelle tâche… prenez un instant pour vous demander : est-ce vous qui l’accomplirez encore d’ici peu, ou un agent IA à votre place ? Et surtout, en quoi cela changerait-il le sens que vous tirerez de votre travail ? À mesure que les agents IA s’installent dans nos outils et nos échanges, c’est toute la société qui doit décider de ce qu’elle souhaite déléguer… et de ce qu’elle préfère préserver.

Cet article est publié dans le cadre de la Fête de la science (qui a lieu du 3 au 13 octobre 2025), dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « Intelligence(s) ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Stéphanie Gauttier ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.