26.11.2025 à 11:25

Votre chien ou chat vieillit ? Des gestes simples pour prolonger sa qualité de vie

Texte intégral (3179 mots)

Déjà, ses premiers poils gris. Votre chien ou votre chat a pris un petit coup de vieux. Comment prendre soin de lui à présent ? Des chercheurs se sont penchés sur la question et prodiguent quelques conseils faciles à mettre en œuvre.

En France, avec une espérance de vie moyenne de 11,3 ans chez les chiens comme chez les chats, la gériatrie animale est devenue indispensable. Les connaissances progressent rapidement pour mieux accompagner ces animaux. On sait désormais que quelques aménagements simples améliorent nettement le confort et la qualité de vie d’un chat ou d’un chien âgé. L’essentiel pour les propriétaires est de ne pas rester observateur passif du vieillissement de leur compagnon à quatre pattes.

À quel âge mon chien ou mon chat peut-il être considéré comme âgé ?

Une recherche portant sur plus de deux millions de chats et plus de quatre millions de chiens a permis de mieux définir leurs différents stades de vie.

Chez le chat, l’entrée dans le « troisième âge » se situe autour de 10 ans. Le « troisième âge » comprend le stade mature, senior et super-senior.

Selon cette même étude, pour le chien, la situation est moins uniforme : la vitesse de vieillissement dépend fortement de la taille.

Les chiens de petit format (toy et small, des races dont le poids est inférieur à 9 kg, comme les chihuahas ou les cavalier king charles) entrent dans le troisième âge vers 7 ans, puis deviennent seniors autour de 12 ans.

Les chiens de format moyen à grand, de plus de 9 kg, comme les welsh corgis, les golden retrievers ou les bergers australiens par exemple, y accèdent plus tôt : environ 6 ans pour le début du troisième âge, puis 10 ans pour le stade sénior.

Il est important d’être rassuré : passer dans ce nouveau stade ne signifie absolument pas que “la fin” approche. Cela indique surtout qu’il est temps d’être plus attentif à son compagnon et d’adapter progressivement son suivi, son environnement et ses soins pour l’aider à vieillir dans les meilleures conditions.

Qu’est-ce qu’un vieillissement sain ? Comment l’évaluer chez son animal ?

Avant de parler de « vieillissement sain », il est utile de rappeler ce qu’est le vieillissement : un processus naturel, progressif et inévitable. Avec le temps, les animaux tolèrent moins bien les stress de leur environnement et leurs cellules accumulent des dommages, ce qui entraîne des modifications physiologiques variées.

Qu’entend-on alors par un chien ou un chat vieillissant « en bonne santé » ? Un récent article de consensus auquel j’ai participé propose une définition adaptée à nos animaux de compagnie : un animal âgé en bonne santé est celui qui conserve suffisamment de capacités et de résistance pour répondre à ses besoins physiques, comportementaux, sociaux et émotionnels, tout en maintenant une relation stable et positive avec son humain.

Certains signes sont tout à fait normaux : poils qui grisonnent, léger tartre, peau plus fine, perception sensorielle un peu diminuée mais sans impact notable sur la qualité de vie.

En revanche, des difficultés locomotrices entravant l’accès aux ressources (difficulté à se lever, à monter les escaliers ou à interagir facilement avec vous) ne doivent pas être considérées comme de simples manifestations de l’âge. Il en va de même avec les premiers signes de dysfonction cognitive (un syndrome qui présente quelques similitudes avec Alzheimer), lorsqu’un chien ou un chat a du mal à retrouver sa gamelle ou semble perdu dans la maison, par exemple. Ces cas nécessitent un avis vétérinaire.

La qualité de vie devient donc le critère central pour évaluer si un animal suit une trajectoire de vieillissement harmonieuse. Chez le chien et le chat, on utilise désormais la notion de fragilité, issue de la gériatrie humaine (voir tableau ci-dessous).

Comment évaluer la fragilité de son animal ?

Les animaux classés comme fragiles sont plus susceptibles de développer des maladies et doivent faire l’objet d’un suivi plus rapproché.

L’intérêt majeur de cette approche est que, comme chez l’humain, la fragilité repérée tôt pourrait parfois être atténuée. D’où l’importance d’un dépistage régulier et d’un accompagnement précoce pour soutenir au mieux nos compagnons âgés.

Quelques aménagements à mettre en place

La première étape consiste à rendre l’environnement de l’animal plus accessible afin qu’il puisse atteindre facilement toutes ses ressources : nourriture, eau, lieux de repos, espaces de cachette, zones d’interaction… De simples aménagements peuvent déjà faire une vraie différence : petits escaliers pour monter sur le canapé, chauffeuses ou coussins fermes et peu hauts, gamelles surélevées pour les chiens et chats souffrant d’arthrose.

Multiplier les points d’accès est également utile : deux ou trois zones d’alimentation, plusieurs endroits pour dormir, et davantage de litières, faciles à enjamber. Certains bacs du commerce sont trop hauts pour des chats arthrosiques ; un plateau large à rebord bas peut être bien plus confortable.

Maintenir une relation apaisée et positive apparaît essentiel. Un comportement jugé « indésirable » doit toujours être investigué avec un vétérinaire et un comportementaliste (ou un vétérinaire comportementaliste) : il peut en effet traduire un besoin, un inconfort ou une difficulté. Un chat qui griffe le tapis plutôt que son arbre à chat, par exemple, peut simplement chercher une position moins douloureuse. Certains animaux deviennent aussi plus anxieux ou plus réactifs avec l’âge ou certaines conditions médicales ; il est alors important d’en comprendre la cause plutôt que de sanctionner, au risque d’abîmer la relation et de ne pas régler la problématique.

La stimulation cognitive et physique doit se poursuivre, mais en s’adaptant aux capacités de l’animal. Les « puzzle feeders »(ou gamelles interactives, des bols où les animaux doivent résoudre des jeux pour avoir leur ration) restent intéressants, à condition d’être choisis en fonction de son état : un tapis de fouille, une gamelle interactive à pousser du nez seront préférables à un système demandant des mouvements complexes des pattes. Les jeux, les apprentissages et les petits entraînements restent bénéfiques ; il suffit parfois de raccourcir les séances et d’utiliser des récompenses très appétentes (petits morceaux de blanc de poulet ou de saucisses…).

Les promenades peuvent être adaptées notamment en utilisant des sacs confortables et sécuritaires pour porter le chien lorsqu’il est trop fatigué, que ce soit pour une partie ou l’ensemble de la balade, l’important étant de continuer à ce que l’animal ait accès à l’extérieur.

L’alimentation joue enfin un rôle majeur dans l’accompagnement des animaux âgés. Le vieillissement entraîne une modification de la digestion et une perte progressive de masse musculaire. Il est donc recommandé de privilégier une alimentation facilement digestible, dont l’odeur et le goût attirent votre animal, et formulée spécifiquement pour les besoins des seniors. Les rations de viande crue sont à éviter : elles sont souvent déséquilibrées en minéraux, ce qui peut être délétère pour les animaux âgés, particulièrement sensibles aux excès de phosphore ou aux rapports calcium/phosphore inadaptés. Elles présentent également un risque sanitaire accru alors que leur système immunitaire est moins performant.

En revanche, combiner une alimentation sèche (croquettes) et humide (terrine, mousses…) est souvent bénéfique. Une ration cuite et faite maison (en suivant les conseils d’un vétérinaire) peut aussi aider un animal à retrouver l’appétit. Et pour les plus difficiles, une astuce simple peut suffire : tiédir légèrement l’aliment humide pour en renforcer l’odeur et la rendre plus attirante.

À quel moment faire intervenir le vétérinaire ?

Les visites de suivi chez le vétérinaire restent indispensables, notamment pour maintenir à jour le protocole vaccinal et le déparasitage. Avec l’âge, le système immunitaire perd en efficacité : un animal senior est donc plus vulnérable et nécessite une protection régulière contre les maladies infectieuses et les parasites.

Les consultations de gériatrie ont pour objectif de suivre l’évolution du vieillissement qui est propre à chaque individu. La première est souvent la plus longue : elle permet un échange approfondi et inclut, lorsque nécessaire, des examens complémentaires. Ces premiers éléments serviront de référence pour les visites suivantes. L’idéal est d’entamer ce suivi dès le début du « troisième âge ». La fréquence des consultations dépend ensuite de la trajectoire de l’animal : tous les six mois si des signes de fragilité apparaissent, ou une fois par an si son état reste stable.

L’enjeu n’est plus seulement d’allonger la durée de vie de nos compagnons, mais surtout de prolonger leur vie en bonne santé, en préservant leur qualité de vie le plus longtemps possible – une démarche qui rejoint celle adoptée pour les humains.

Sara Hoummady est membre de l'AFGASP (Association Française de Gériatrie Animale et de Soins Palliatifs). Elle a reçu la bourse de la FVE (Federation Veterinaire Européenne) pour ses travaux sur le vieillissement félin. Elle a fait partie d'un comité de réflexion sur le vieillissement sain chez le chien et le chat organisé par un petfooder.

22.11.2025 à 18:08

Effets secondaires des chimiothérapies : une molécule française prometteuse pour lutter contre les neuropathies périphériques, dont souffrent près de 90 % des patients

Texte intégral (1625 mots)

Une nouvelle molécule capable de protéger les neurones des effets toxiques de la chimiothérapie, tout en renforçant l’efficacité de certains traitements anticancéreux, a été découverte et offre des résultats prometteurs chez l’animal. Une start-up a été créée pour continuer son développement et mener des études chez l’humain.

Picotements dans les mains et les pieds, brûlures, douleurs, perte de sensibilité, sensation d’engourdissement… Les neuropathies périphériques figurent parmi les effets secondaires les plus fréquents de la chimiothérapie, touchant jusqu’à 90 % des patients pour certains traitements. Leur sévérité conduit parfois les praticiens à ajuster, voire à réduire les doses de chimiothérapie, ce qui peut en diminuer l’efficacité.

Dans un cas sur quatre, ces atteintes nerveuses persistent des mois, voire des années après la fin du traitement. Elles rappellent alors chaque jour aux patients qu’ils ont eu un cancer – alors même que leurs cheveux ont repoussé et que les nausées ou la fatigue ont disparu. Aucun droit à l’oubli, même une fois la maladie vaincue

À ce jour, hormis le port de gants et de chaussons réfrigérants pendant les séances de chimiothérapie – une méthode pas toujours efficace et souvent désagréable –, aucun traitement préventif n’existe. Quelques médicaments palliatifs sont utilisés, pour atténuer la douleur, avec une efficacité modeste.

Notre équipe, en collaboration avec des chercheurs états-uniens et français, vient de franchir une étape importante avec la découverte d’un composé, baptisé Carba1, capable de protéger les neurones des effets toxiques de la chimiothérapie, tout en renforçant l’efficacité de certains traitements anticancéreux. Ces travaux viennent d’être publiés dans la revue Sciences Advances.

Une molécule, deux cibles

Carba1 appartient à la famille des carbazoles, une classe de molécules développée par les chercheurs du Centre d’études et de recherche sur le médicament de Normandie (CERMN), avec lesquels nous collaborons depuis plus de dix ans.

Nos travaux ont mis en évidence que Carba1 agit sur deux cibles principales.

Premièrement, Carba1 interagit avec la tubuline, la brique de base des microtubules. Selon les besoins de la cellule, ces briques peuvent s’assembler pour former soit des « câbles » capables de tirer et de séparer les chromosomes lors de la division cellulaire, soit des « rails » sur lesquels se déplacent des moteurs moléculaires transportant nutriments et organites comme les mitochondries, assurant ainsi la distribution de l’énergie et des ressources dans toute la cellule.

Ce système de transport est particulièrement essentiel dans les cellules nerveuses, dont les prolongements peuvent atteindre plus d’un mètre de longueur, par exemple les neurones qui partent du ganglion rachidien, près de la moelle épinière et vont innerver la peau des pieds. De nombreux médicaments anticancéreux, tels que le paclitaxel (Taxol) ou le docétaxel (Taxotère), ciblent déjà ces structures afin de bloquer la prolifération des cellules tumorales. Cependant, cette action n’est pas sans conséquence : les neurones, eux aussi dépendants des microtubules pour le transport de leurs constituants, en sont affectés, ce qui constitue l’une des causes majeures des neuropathies.

Nous avons montré que Carba1 modifie subtilement les microtubules : il perturbe leur extrémité, favorisant la liaison du paclitaxel. Cette interaction permet d’utiliser des doses plus faibles du médicament anticancéreux sans perte d’efficacité contre les tumeurs.

Mais ce n’est pas tout.

Des neurones plus résistants

Deuxièmement, en examinant plus en détail les propriétés de Carba1, nous avons découvert qu’il agit également sur un autre front : le métabolisme énergétique. Les neurones figurent parmi les cellules les plus gourmandes en énergie, et la défaillance bioénergétique est considérée comme l’un des principaux facteurs contribuant à la dégénérescence neuronale.

Nos résultats montrent que Carba1 active directement une enzyme clé, la nicotinamide phosphoribosyltransférase (NAMPT), qui relance la production de NAD⁺, molécule cruciale pour la génération d’énergie. Résultat : les neurones deviennent plus résistants au stress métabolique et survivent mieux aux agressions des agents chimiothérapeutiques.

Nous avons confirmé l’effet neuroprotecteur de Carba1 sur des cultures de neurones exposées à trois agents chimiothérapeutiques connus pour induire une neuropathie, via des mécanismes différents : le paclitaxel (ciblant les microtubules), le cisplatine (agent alkylant) et le bortézomib (inhibiteur du protéasome).

Contrairement aux cultures témoins où s’étendent des prolongements neuritiques lisses et vigoureux, dans les cultures traitées par ces médicaments, les prolongements présentent un aspect fragmenté, caractéristique d’un processus de dégénérescence. En revanche, lorsque les neurones sont exposés à ces mêmes traitements en présence de Carba1, leurs prolongements demeurent intacts, indiscernables de ceux des cultures non traitées. Ces observations indiquent que Carba1 protège efficacement les neurones de la dégénérescence induite par ces agents neurotoxiques.

Des résultats encourageants chez l’animal

Pour aller plus loin, nous avons testé Carba1 dans un modèle de neuropathie chez le rat traité au paclitaxel, développé par le Dr David Balayssac à Clermont-Ferrand (unité Neurodol). Ce traitement provoque une hypersensibilité cutanée : les rats réagissent à des pressions très faibles sur leurs pattes, un signe de douleur neuropathique. L’analyse histologique montre également une diminution des terminaisons nerveuses intra-épidermiques, tandis que le sang présente des taux élevés de NfL (chaîne légère de neurofilaments), marqueur de dégénérescence neuronale.

Lorsque Carba1 est administré avant et pendant le traitement, ces altérations disparaissent : les nerfs restent intacts, la concentration de NfL demeure normale et la sensibilité cutanée des animaux reste inchangée. Autrement dit, Carba1 protège les neurones de la dégénérescence induite par le paclitaxel. Signe rassurant, Carba1 n’impacte pas la croissance tumorale.

Comme les neurones, les cellules cancéreuses consomment beaucoup d’énergie. Il était donc essentiel de vérifier que Carba1 n’avait pas d’effet pro-tumoral et qu’il ne diminuait pas l’efficacité du paclitaxel. Pour le savoir, nous avons administré Carba1 seul, ou en association avec une dose thérapeutique de paclitaxel, à des souris porteuses de tumeurs greffées. Les résultats sont clairs : Carba1 n’a provoqué aucun effet toxique, ni altéré la santé générale des animaux, ni stimulé la croissance des tumeurs. Il n’interfère pas non plus avec l’action anticancéreuse du paclitaxel.

Une nouvelle voie vers des traitements mieux tolérés

Cette découverte est particulièrement enthousiasmante, car elle combine deux effets rarement réunis :

renforcer l’efficacité des médicaments anticancéreux de la famille du paclitaxel (taxanes) en permettant d’en réduire la dose ;

préserver les nerfs et améliorer la qualité de vie des patients pendant et après le traitement.

Avant d’envisager un essai clinique chez l’humain, plusieurs étapes restent indispensables. Il faut d’abord confirmer la sécurité de Carba1 chez l’animal, déterminer la dose minimale efficace et la dose maximale tolérée. Enfin, il sera nécessaire de mettre au point une formulation adaptée à une administration chez l’humain.

Cette mission incombe désormais à la start-up Saxol, issue de cette recherche, dont je suis l’une des cofondatrices. Si ces étapes – qui devraient s’étendre sur cinq ans au moins, selon les défis techniques et les levées de fonds – se déroulent comme prévu, Carba1 pourrait devenir le premier traitement préventif contre la neuropathie induite par la chimiothérapie – une avancée majeure qui pourrait transformer la façon dont les patients vivent leur traitement anticancéreux.

Carba1 incarne une innovation à l’interface de la chimie, de la neurobiologie et de l’oncologie. En associant protection neuronale et renforcement de l’efficacité thérapeutique, cette petite molécule pourrait, à terme, réconcilier traitement du cancer et qualité de vie. Pour les millions de patients confrontés à la double épreuve du cancer et de la douleur neuropathique, elle représente un espoir concret et prometteur.

Laurence Lafanechère est cofondatrice et conseillère scientifique de la Société SAXOL. Pour mener ses recherches elle a reçu des financements de : Société d’Accélération de Transfert de Technologies Linksium Maturation grant CM210005, (L.L) Prématuration CNRS (LL) Ligue contre le Cancer Allier et Isère (LL, C.T, D.B.) Ruban Rose (LL)

20.11.2025 à 16:16

Les textes des COP parlent-ils vraiment de climat ? Le regard de l’écolinguistique

Texte intégral (2297 mots)

Derrière les grandes déclarations de la diplomatie climatique, que disent vraiment les textes des COP ? Une étude de leurs discours, passés au crible du « text mining », montre comment les mots des COP sont davantage centrés sur les mécaniques institutionnelles que sur l’urgence environnementale. Le langage diplomatique sur le climat fabrique ainsi un récit institutionnel dont la nature est presque absente.

Alors que la COP30 se tient au Brésil en ce mois de novembre 2025, des voix s’élèvent : ces montagnes onusiennes accoucheraient-elles de souris ? En effet, ces grand-messes du climat aboutissent le plus souvent à des textes consensuels. Certes, ils reconnaissent – sur le papier – la réalité des enjeux climatiques, mais ils ne sont que rarement suivis d’effets. On se souvient, par exemple, du texte de la COP26, à Glasgow (2021), qui évoquait enfin clairement la question de la sortie des énergies fossiles. Mais la mise en œuvre de cette promesse, non réitérée lors de la COP29, à Bakou (2024), reste encore à concrétiser.

Leur processus de décision même est de plus en plus critiqué. Il ne fait intervenir que les délégations nationales à huis clos, tout en donnant un poids important aux lobbies. On y retrouve bien sûr des ONG, mais aussi des grandes entreprises, comme Coca-Cola lors de la COP27, à Charm el-Cheikh (2022). L’occasion pour les États producteurs d’énergie fossile de se livrer à des opérations remarquables d’écoblanchiment – comme les Émirats arabes unis furent accusés de le faire lors de la COP28 à Dubaï. Dans le même temps, les populations autochtones et les mouvements des jeunes pour le climat peinent à se faire entendre à l’occasion de ces événements.

Afin de mieux comprendre l’évolution sémantique dans les déclarations des COP et de voir dans quelle mesure celles-ci reflètent l’urgence climatique, j’ai mené une analyse de discours à partir des déclarations officielles (en anglais) des COP entre 2015 – soit juste après la signature de l’accord de Paris – et 2022. Cela permet de mieux saisir les représentations sociales des instances internationales à propos du changement climatique, dans la mesure où ces discours prennent sens au cours de leur circulation dans la société.

Écolinguistique et text mining, mode d’emploi

Cette étude s’inscrit dans l’approche écolinguistique héritée des travaux d’Arran Stibbe ; une approche qui permet notamment d’explorer la manière dont les institutions cadrent les discours sur l’environnement, tout en aidant à comprendre comment les intérêts divergents d’acteurs différents aboutissent à des positions médianes. Pour le climat comme pour les autres grands sujets politiques internationaux, la façon dont les acteurs en parlent est capitale pour aboutir à des consensus, des prises de décision et des textes engageant les États.

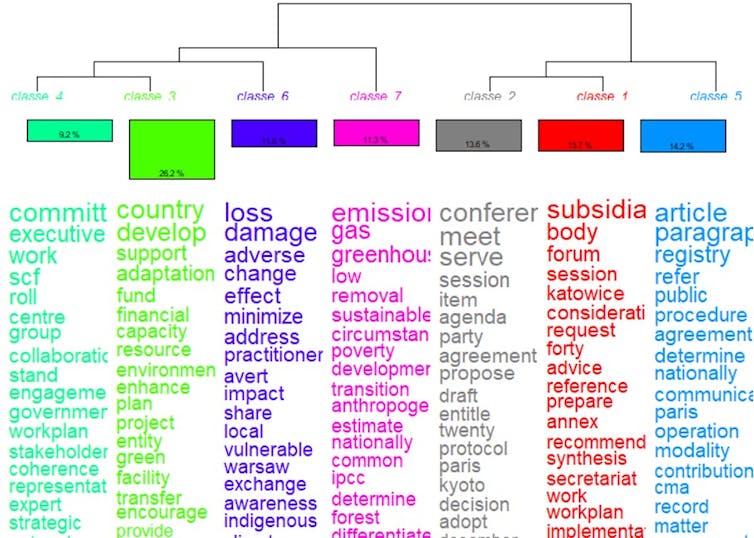

J’ai mené cette analyse grâce à l’outil Iramuteq, développé par Pascal Marchand et Pierre Ratinaud. Il permet une approche statistique du nombre de mots présents dans un corpus textuel, des mots avec lesquels ils apparaissent le plus souvent, mais également de les croiser avec les définitions et leur sens en contexte.

Par ordre de poids statistique, on retrouve ainsi les thèmes suivants :

Fonds de soutien international (26,2 %, en vert fluo, classe 3), qui recoupe les discussions sur l’aide aux pays en voie de développement et la proposition d’un fonds afin de faire face au changement climatique.

Textes des COP (14,2 %, en bleu, classe 5). Cette catégorie intègre les passages qui évoquent le fonctionnement des COP elles-mêmes et des leurs organes administratifs, dont les objectifs sont actés grâce aux textes.

Préparation des COP (13,7 %, en rouge, classe 1). Il s’agit de tout le jargon lié aux coulisses des COP et aux travaux d’organisation qui permettent aux COP d’aboutir et à leurs décisions d’être appliquées de manière concrète.

Organisation des COP (13,6 %, en gris, classe 2). Il s’agit du détail concernant les événements des COP elles-mêmes, c’est-à-dire leur organisation et leur calendrier, avec le fonctionnement par réunions et documents à produire.

Conséquences négatives du changement climatique (11,6 % seulement, en violet, classe 6). Il s’agit des passages où l’accent est mis sur les dommages, les risques et les vulnérabilités, c’est-à-dire les conséquences négatives du réchauffement climatique.

Écologie (11,3 %, rose, classe 7). Cette classe traite des éléments d’ordre écologique liés au changement climatique, ainsi que des causes du réchauffement planétaire.

Gouvernance de la COP (9,2 %, vert pâle, classe 4). Dans cette dernière classe, on retrouve les éléments d’ordre stratégique liés aux COP, à savoir la gouvernance, les parties prenantes, les groupes de travail et les plans à suivre.

À lire aussi : Les mots de la COP : dictionnaire portatif des négociations climatiques

Que retenir de ce découpage ? Les questions strictement climatiques et écologiques ne totalisent que 22,9 % des occurrences dans les textes, ce qui paraît assez faible alors qu’il s’agit des raisons pour lesquelles ces COP existent. Dans une grande majorité des thématiques abordées par le corpus, les COP parlent d’abord d’elles-mêmes.

C’est peu surprenant pour une institution internationale de ce calibre, mais cela pose de sérieuses questions concernant la prise en compte des dimensions extra-institutionnelles du problème.

L’écologie déconnectée des autres mots clés

J’ai ensuite poussé le traitement des données un peu plus loin grâce à une méthode statistique appelée « analyse factorielle de correspondance ». Celle-ci permet de comprendre comment les différentes thématiques sont articulées entre elles dans les discours au sein du corpus.

Les récits en lien avec les thèmes qu’on retrouve au centre droit du graphe, liés aux textes des COP (bleu), à leur préparation (rouge), à leur organisation (gris) et à leur gouvernance (vert pâle) forment ainsi un ensemble homogène.

On note toutefois, dans la partie en bas à gauche, que la gouvernance des COP (vert pâle) a un positionnement hybride et semble jouer le rôle d’interface avec la thématique des conséquences négatives du réchauffement climatique (violet) et celle des fonds de soutien internationaux (vert fluo).

En d’autres termes, ces observations confirment que les COP se donnent bien pour objectif de remédier aux conséquences du changement climatique. Et cela, à travers la gouvernance mise en place par les COP, et avec la proposition d’aides aux pays les plus vulnérables comme moyen.

Quant au thème de l’écologie (en rose), il se retrouve en haut à gauche du graphe. Surtout, il semble comme déconnecté du reste des thématiques. Ceci montre que, dans ces textes, il existe peu de liens entre les propos qui traitent de l’écologie et ceux qui évoquent le fonctionnement des COP ou la mise en œuvre concrète de solutions.

À lire aussi : Les classes populaires en ont-elles vraiment marre de l’écologie ?

L’absence de termes pourtant centraux

Plus intéressant encore, les textes analysés brillent par l’absence relative de certains termes clés.

Ainsi, le terme animal (en anglais) n’est jamais utilisé. Certains termes n’apparaissent qu’une fois dans tous les textes étudiés, comme life, river ou ecological. D’autres apparaissent, mais très peu, comme natural (trois occurrences), earth (quatre occurrences). Des termes comme water, biodiversity ou ocean, aux enjeux colossaux, ne totalisent que six occurrences.

Ainsi, alors que les COP ont pour objectif de s’intéresser aux conséquences du réchauffement climatique sur les sociétés humaines et le vivant en général, il est marquant de constater que la plupart des champs thématiques du corpus parlent non pas des problèmes liés au changement climatiques, mais surtout des COP elles-mêmes, plus précisément de leur fonctionnement.

En d’autres termes, les COP se parlent à elles-mêmes, dans une logique de vase clos qui vise d’abord à s’assurer que les dispositions prises pour respecter l’accord de Paris sont bien respectées.

À lire aussi : À quoi servent les COP ? Une brève histoire de la négociation climatique

Cet état de fait contraste avec les conséquences concrètes du réchauffement climatique. Il illustre la vivacité de représentations d’ordre gestionnaire et institutionnel, qui s’autoalimentent en voyant d’abord l’environnement, la biodiversité et le vivant comme des ressources à préserver ou des objectifs à accomplir. En restant focalisées sur l’accord de Paris, les déclarations officielles voient ainsi le vivant et la biodiversité comme autant d’outils, d’objets ou de cases à cocher pour rendre compte d’engagements pris au niveau international.

C’est compréhensible étant donnée la nature des textes des COP et du contexte socio-institutionnel qui encadrent leur production. Il n’en reste pas moins que cela trahit bon nombre de représentations qui continuent de percoler nos imaginaires. Dans cette logique, les éléments d’ordre naturel, environnemental ou écologique constituent soit des ressources à utiliser ou préserver, soit des éléments à gérer, soit des objectifs à remplir. Or, cette représentation est loin d’être neutre, comme l’explique George Lakoff.

Ici, le changement climatique est donc traité comme un ensemble de problèmes auxquels il s’agit d’apporter de simples solutions techniques ou des mécanismes de compensation, sans que les conditions qui alimentent ce même dérèglement climatique (notamment liées au système économique et aux modes de production et de consommation) ne soient abordées à aucun moment dans les textes.

C’est cette même logique qui semble condamner les instances internationales à tenter de gérer les conséquences du réchauffement climatique, tout en évitant soigneusement d’en traiter les causes.

Albin Wagener ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

20.11.2025 à 16:16

On peut réactiver un souvenir ou le faire disparaître de façon réversible – chez la souris

Texte intégral (1892 mots)

Après avoir démontré que les souvenirs s’inscrivent de façon matérielle dans notre cerveau, les scientifiques s’attèlent à la tâche de réactiver des souvenirs attaqués par des maladies neurodégénératives chez des souris.

Chacun sait ce qu’est un souvenir : un événement, une odeur, une sensation de notre passé que nous pouvons rappeler. Mais à quoi ressemble-t-il dans notre cerveau ?

Il est porté par des groupes de neurones interconnectés. À cette échelle, le support du souvenir est appelé « engramme ». Ce mot désigne le substrat matériel constitué par un réseau spécifique de neurones, dont les interconnexions se sont renforcées durablement lors de la mémorisation. Ainsi, quand on se souvient, une partie de ce réseau est réactivée. Les recherches récentes montrent comment se fait cette réactivation et comment on peut la contrôler de façon réversible chez la souris.

Mieux comprendre les mécanismes cellulaires qui sous-tendent nos souvenirs est un enjeu de taille, car nombre de maladies neurodégénératives et de traumatismes altèrent notre mémoire, non seulement en perturbant l’accès aux images de notre passé, mais aussi en s’attaquant directement au matériel biologique dans lequel ces images sont fixées.

Comment les souvenirs s’inscrivent dans le cerveau

L’idée que nos souvenirs ne sont pas quelque chose d’immatériel mais ont un support physique est ancienne. Déjà Platon imaginait que l’âme recèle des tablettes de cire dans lesquelles se grave ce que nous voulons retenir.

Mais il a fallu bien longtemps pour affiner cette intuition, puis pour la démontrer expérimentalement. À la fin du XIXe siècle, l’Espagnol Santiago Ramon y Cajal pense que les connexions entre certains neurones sont renforcées lors d’activations répétées accompagnant l’apprentissage – ainsi se formerait le souvenir.

Dans les années 1960, ces spéculations commencent à trouver une assise expérimentale. C’est d’abord chez un mollusque marin, l’aplysie, qu’on les démontre. Lorsqu’on stimule mécaniquement une partie de son dos, il rétracte ses branchies pour les protéger. Mais si cette stimulation est répétée quelques fois, le réflexe s’atténue durablement. Cette adaptation repose sur une réduction prolongée de l’excitabilité synaptique et du nombre de synapses dans le circuit moteur qui pilote la rétraction.

À l’inverse, une sensibilisation de ce réflexe, déclenchée par une stimulation nociceptive (douleur déclenchée par une agression de l’organisme, ndlr) appliquée sur la queue de l’animal, provoque une augmentation persistante de l’excitabilité synaptique et fait apparaître des connexions additionnelles. En 1973, un mécanisme du même type est décrit dans l’hippocampe du lapin – il est nommé « potentialisation à long terme ».

Pour désigner l’encodage permanent dans le substrat cérébral des éléments d’une expérience vécue, rappelons la formule laconique de Carla Shatz :

« Neurons that fire together, wire together » (Les neurones qui se coactivent s’interconnectent.) Carla Shatz, 1992, « Scientific American »

Observer directement les souvenirs en « allumant » les neurones interconnectés

Si les neurones coactivés au cours de l’encodage se réactivent pour permettre le rappel d’un souvenir (Figure 1), on doit pouvoir prouver que leur réactivation accompagne le rappel du souvenir et montrer que leur destruction l’empêche.

Pour ce qui est de la réactivation lors du rappel, le groupe de Mark Mayford a appris à des souris à reconnaître un signal sonore annonçant un choc électrique désagréable. Lorsque plus tard, les souris réentendent ce son, leur immobilité traduit la peur, donc une réactivation du souvenir de ce qu’annonce le son.

Pour imager les neurones qui portent la réactivation du souvenir, voici la procédure : avant l’apprentissage, on infecte des cellules de l’amygdale

– une structure cruciale pour les émotions, dont la peur – avec un virus qui permettra de rendre fluorescents les neurones activés pendant l’apprentissage. Ultérieurement, une fois que ces souris ont réentendu le son, elles sont mises à mort et, à l’aide d’un second marquage, on visualise les neurones qui se sont activés pendant ce rappel. Du coup, les neurones doublement marqués auront été activés pendant l’apprentissage et réactivés pendant le rappel. Or, Mayford et ses collègues constatent qu’il y a bien eu augmentation du double marquage chez les souris ayant eu peur pendant le rappel (comparativement aux différentes conditions de contrôle).

Pour ce qui est de la destruction des neurones qui aboutissent à l’anéantissement du souvenir, on utilisera également une stratégie reposant sur une infection virale des neurones de l’amygdale, mais cette fois, les neurones activés pendant l’apprentissage seront tués avant le rappel à l’aide d’une toxine. De cette manière, le groupe de Paul Frankland a pu montrer qu’une destruction de ces neurones faisait disparaître toute réaction de peur chez les souris car, du fait de la mort des neurones « souvenir », elles ont oublié la signification du signal sonore.

Comment réactiver un souvenir ou le faire disparaître de façon réversible ?

Aujourd’hui, les chercheurs ont peaufiné cette démonstration en parvenant à manipuler ponctuellement et réversiblement l’engramme (le réseau de neurones souvenirs) pour induire l’expression ou la disparition d’un souvenir.

C’est là qu’intervient une technique relativement récente : l’optogénétique. Elle permet de contrôler (soit activer, soit inhiber) avec une grande précision l’activité de certains neurones en les exposant à de la lumière par l’intermédiaire d’une fibre optique plongée dans une région d’intérêt du cerveau. Il suffit pour cela de rendre ces neurones sensibles à une longueur d’onde lumineuse par introduction de gènes codant pour des protéines photosensibles. De plus, il est possible de faire dépendre l’expression de ces gènes de l’activation même des neurones.

C’est ainsi que le groupe de Susumu Tonegawa a pu montrer, chez la souris, qu’après l’apprentissage d’un danger lié à un contexte donné, l’activation par la lumière des neurones ayant participé à l’apprentissage induisait un comportement de peur, donc un rappel… et cela dans un contexte sans danger bien connu de la souris, et sans rapport avec celui de l’apprentissage ! Par ailleurs, lorsque ces neurones étaient inhibés par la lumière dans le contexte dangereux, la souris ne manifestait plus aucune peur.

Implanter un faux souvenir

Il y a même mieux, puisque le groupe de Tonegawa a aussi réussi à implanter un faux souvenir dans la mémoire des souris.

Les souris ont d’abord encodé un premier contexte parfaitement neutre. Les neurones ayant été activés pendant l’encodage de ce contexte ont exprimé une protéine photoactivable avec de la lumière bleue. Les chercheurs ont ensuite exposé ces souris à un autre contexte, celui-là désagréable, tout en activant conjointement la trace du premier avec de la lumière bleue.

Lorsque les souris étaient ultérieurement réexposées au premier contexte (pourtant neutre, à la base), elles se sont mises à le craindre.

Enfin, dans un modèle murin de maladie d’Alzheimer, le groupe de Tonegawa est même allé jusqu’à ressusciter un souvenir le temps d’une photoactivation d’un engramme d’abord rendu photoactivable mais ultérieurement oublié, alors même que celui-ci était invalidé du fait de l’évolution d’un processus neurodégénératif.

Pour l’heure, ces résultats, bien que spectaculaires, et avec lesquels s’alignent les données produites par d’autres groupes de recherche, se limitent à des mémoires simples qui pilotent des comportements simples dans des modèles animaux raisonnablement complexes.

Reste à savoir si les travaux menés sur ces modèles sont généralisables sans nuances à l’humain, et par quel mécanisme un motif d’activation neuronale peut générer des images et des impressions passées dans une phénoménologie consciente actuelle.

Cet article est publié dans le cadre de la Fête de la science (qui a eu lieu du 3 au 13 octobre 2025), dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « Intelligence(s) ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Jean-Christophe Cassel a reçu des financements de l'ANR. ANR-14-CE13-0029-01 ANR-23-CE37-0012-02

20.11.2025 à 11:22

L’IA générative est-elle soutenable ? Le vrai coût écologique d’un prompt

Texte intégral (2749 mots)

Circulez, il n’y a rien à voir ? Les estimations du bilan environnemental de l’intelligence artificielle générative, comme celles réalisées à l’été 2025 par Google sur son IA Gemini, semblent rassurantes : seulement 0,003 g de CO2 et cinq gouttes d’eau par « prompt ». Des résultats qui dépendent en réalité beaucoup des choix méthodologiques réalisés, alors que de telles études sont le plus souvent menées en interne et manquent de transparence. Le problème est que ces chiffres font de plus en plus souvent figure d’argument marketing pour inciter à l’utilisation de l’IA générative, tout en ignorant le risque bien réel d’effet rebond lié à l’explosion des usages.

Depuis la sortie de ChatGPT fin 2022, les IA génératives ont le vent en poupe. En juillet 2025, OpenAI annonçait que ChatGPT recevait 18 milliards de « prompts » (instructions écrites par les utilisateurs) par semaine, pour 700 millions d’utilisateurs – soit 10 % de la population mondiale.

Aujourd’hui, la ruée vers ces outils est mondiale : tous les acteurs de la Big Tech développent désormais leurs propres modèles d’IA générative, principalement aux États-Unis et en Chine. En Europe, le Français Mistral, qui produit l’assistant Le Chat, a récemment battu les records avec une capitalisation proche de 12 milliards d’euros. Chacun de ces modèles s’inscrit dans un environnement géopolitique donné, avec des choix technologiques parfois différents. Mais tous ont une empreinte écologique considérable qui continue d’augmenter de façon exponentielle, portée par la démultiplication des usages. Certains experts, dont ceux du think tank spécialisé The Shift Project, sonnent l’alerte : cette croissance n’est pas soutenable.

À lire aussi : L’IA peut-elle vraiment être frugale ?

Or, tous les acteurs du domaine – y compris les consommateurs – sont aujourd’hui bien conscients que du coût environnemental qui accompagne les usages liés au numérique, mais pas forcément des chiffres que cela représente.

Poussés par de multiples raisons (obligations réglementaires, marketing, parfois par conscience environnementale), plusieurs des grands acteurs de la tech ont récemment réalisé l’analyse de cycle de vie (ACV, méthodologie permettant d’évaluer l’impact environnemental global d’un produit ou service) de leurs modèles.

Fin août 2025, Google a publié la sienne pour quantifier les impacts de son modèle Gemini. Que valent ces estimations, et peut-on s’y fier ?

Une empreinte carbone étonnement basse

Un modèle d’IA générative, pour fonctionner, doit d’abord être « entraîné » à partir d’une grande quantité d’exemples écrits. Pour mesurer l’électricité consommée par un « prompt », Google s’est donc concentré sur la phase d’utilisation – et non pas d’entraînement – de son IA Gemini. Selon ses propres calculs, Google annonce donc qu’un prompt ne consommerait que 0,24 wattheure (Wh) en moyenne – c’est très faible : environ une minute de consommation d’une ampoule électrique standard de 15 watts.

Comment les auteurs sont-ils arrivés à ce chiffre, significativement plus faible que dans les autres études déjà réalisées à ce sujet, comme celle menée par Mistral IA en juillet 2025 ?

La première raison tient à ce que Google mesure réellement. On apprend par exemple dans le rapport que l’électricité consommée par un prompt est utilisée pour 58 % par des processeurs spécialisés pour l’IA (l’unité de traitement graphique, ou GPU, et le circuit intégré spécifique Tensor Processing Unit, ou TPU), 25 % par des processeurs classiques et à hauteur d’environ 10 % par les processeurs en veille, et les 7 % restants pour le refroidissement des serveurs et le stockage de données.

Autrement dit, Google ne tient ici compte que de l’électricité consommée par ses propres data centers, et pas de celle consommée par les terminaux et les routeurs des utilisateurs.

Par ailleurs, aucune information n’est donnée sur le nombre d’utilisateurs ou le nombre de requêtes prises en compte dans l’étude, ce qui questionne sa crédibilité. Dans ces conditions, impossible de savoir comment le comportement des utilisateurs peut affecter l’impact environnemental du modèle.

À lire aussi : Impact environnemental du numérique : l’inquiétant boom à venir

Google a racheté en 2024 l’équivalent de la production d’électricité annuelle de l’Irlande

La seconde raison tient à la façon de convertir l’énergie électrique consommée en équivalent CO2. Elle dépend du mix électrique de l’endroit où l’électricité est consommée, tant du côté des data centers que des terminaux des utilisateurs. Ici, on l’a vu, Google ne s’intéresse qu’à ses propres data centers.

Depuis longtemps, Google a misé sur l’optimisation énergétique, en se tournant vers des sources décarbonées ou renouvelables pour ses centres de données répartis partout dans le monde. Selon son dernier rapport environnemental, l’effort semble porter ses fruits, avec une diminution de 12 % des émissions en un an, alors que la demande a augmenté de 27 % sur la même période. Les besoins sont colossaux : en 2024, Google a consommé, pour ses infrastructures de calcul, 32 térawattsheures (TWh), soit l’équivalent de la production d’électricité annuelle de l’Irlande.

À lire aussi : Un data center près de chez soi, bonne ou mauvaise nouvelle ?

De fait, l’entreprise a signé 60 contrats exclusifs de fourniture en électricité à long terme en 2024, pour un total de 170 depuis 2010. Compte tenu de l’ampleur des opérations de Google, le fait d’avoir des contrats d’électricité exclusifs à long terme compromet la décarbonation dans d’autres secteurs. Par exemple, l’électricité à faibles émissions qui alimente les prompts pourrait être utilisée pour le chauffage, secteur qui dépend encore fortement des combustibles fossiles.

Dans certains cas, ces contrats impliquent la construction de nouvelles infrastructures de production d’énergie. Or, même pour la production d’énergie renouvelable décarbonée, leur bilan environnemental n’est pas entièrement neutre : par exemple, l’impact associé à la fabrication de panneaux photovoltaïques est compris entre 14 gCO2eq et 73 gCO2eq/kWh, ce que Google ne prend pas en compte dans ses calculs.

Enfin, de nombreux services de Google font appel à de la « colocation » de serveurs dans des data centers qui ne sont pas nécessairement décarbonés, ce qui n’est pas non plus pris en compte dans l’étude.

Autrement dit, les choix méthodologiques réalisés pour l’étude ont contribué à minimiser l’ampleur des chiffres.

Cinq gouttes d’eau par prompt, mais 12 000 piscines olympiques au total

La consommation d’eau douce est de plus en plus fréquemment prise en compte dans les rapports environnementaux liés au numérique. Et pour cause : il s’agit d’une ressource précieuse, constitutive d’une limite planétaire récemment franchie.

L’étude de Google estime que sa consommation d’eau pour Gemini est de 0,26 ml – soit cinq gouttes d’eau – par prompt. Un chiffre qui semble dérisoire, ramené à l’échelle d’un prompt, mais les petits ruisseaux font les grandes rivières : il faut le mettre en perspective avec l’explosion des usages de l’IA.

Globalement, Google a consommé environ 8 100 millions de gallons (environ 30 millions de mètres cubes, l’équivalent de quelque 12 000 piscines olympiques) en 2024, avec une augmentation de 28 % par rapport à 2023.

Mais là aussi, le diable est dans les détails : le rapport de Google ne comptabilise que l'eau consommée pour refroidir les serveurs (selon un principe très similaire à la façon dont nous nous rafraîchissons lorsque la sueur s’évapore de notre corps). Le rapport exclut de fait la consommation d’eau liée à la production d’électricité et à la fabrication des serveurs et autres composants informatiques, qui sont pourtant prises en compte pour le calcul de son empreinte carbone, comme on l’a vu plus haut. En conséquence, les indicateurs d’impact environnemental (carbone, eau…) n’ont pas tous le même périmètre, ce qui complique leur interprétation.

À lire aussi : Les métaux de nos objets connectés, face cachée de l’impact environnemental du numérique

Des études encore trop opaques

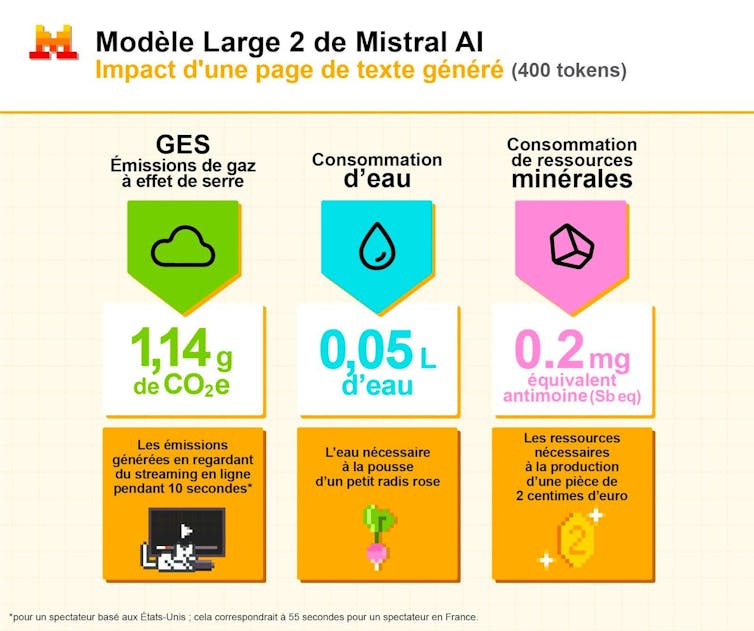

Comme la plupart des études sur le sujet, celle de Google a été menée en interne. Si on comprend l’enjeu de secret industriel, un tel manque de transparence et d’expertise indépendante pose la question de sa légitimité et surtout de sa crédibilité. On peut néanmoins chercher des points de comparaisons avec d’autres IA, par exemple à travers les éléments présentés par Mistral IA en juillet 2025 sur les impacts environnementaux associés au cycle de vie de son modèle Mistral Large 2, une première.

Cette étude a été menée en collaboration avec un acteur français reconnu de l’analyse du cycle de vie (ACV), Carbone4, avec le soutien de l’Agence de l'environnement et de la maîtrise de l’énergie (Ademe), ce qui est un élément de fiabilité. Les résultats sont les suivants.

Pendant les dix-huit mois de durée de vie totale du modèle, environ 20 000 tonnes équivalent CO2 ont été émises, 281 000 m3 d’eau consommée et 660 kg équivalent antimoine (indicateur qui prend en compte l’épuisement des matières premières minérales métalliques).

Mistral attire l’attention sur le fait que l’utilisation du modèle (inférence) a des effets qu’ils jugent « marginaux », si on considère un prompt moyen utilisant 400 « tokens » (unités de traitement corrélées à la taille du texte en sortie) : ce prompt correspond à l’émission de 1,14 g équivalent CO2, de 50 ml d’eau et 0,5 mg équivalent antimoine. Des chiffres plus élevés que ceux avancés par Google, obtenus, comme on l’a vu, grâce à une méthodologie avantageuse. De plus, Google s’est basé dans son étude sur un prompt « médian » sans donner davantage de détails statistiques, qui seraient pourtant bienvenus.

En réalité, l’une des principales motivations, que cela soit celles de Google ou de Mistral, derrière ce type d’étude reste d’ordre marketing : il s’agit de rassurer sur l’impact environnemental (ce qu’on pourrait qualifier de « greenwashing ») de l’IA pour pousser à la consommation. Ne parler que de l’impact venant des prompts des utilisateurs fait également perdre de vue la vision globale des coûts (par exemple, ceux liés à l’entraînement des modèles).

À lire aussi : Comment rendre l’électronique plus soutenable ?

Reconnaissons que le principe d’effectuer des études d’impacts est positif. Mais l’opacité de ces études, même lorsqu’elles ont le mérite d’exister, doit être interrogée. Car, à ce jour, Mistral pas plus que Google n’ont pas dévoilé tous les détails des méthodologies utilisées, les études ayant été menées en interne. Or, il faudrait pouvoir disposer d’un référentiel commun qui permettrait de clarifier ce qui doit être pris en compte dans l’analyse complète du cycle de vie (ACV) d’un modèle d’IA. Ceci permettrait de réellement comparer les résultats d’un modèle à l’autre et de limiter les effets marketing.

Une des limites tient probablement à la complexité des IA génératives. Quelle part de l’empreinte environnementale peut-on rattacher à l’utilisation du smartphone ou de l’ordinateur pour le prompt ? Les modèles permettant le fine-tuning pour s’adapter à l’utilisateur consomment-ils plus ?

La plupart des études sur l’empreinte environnementale des IA génératives les considèrent comme des systèmes fermés, ce qui empêche d’aborder la question pourtant cruciale des effets rebonds induits par ces nouvelles technologies. Cela empêche de voir l’augmentation vertigineuse de nos usages de l’IA, en résumant le problème au coût environnemental d’un seul prompt.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.