26.02.2026 à 09:53

Lifting the lid on unknown coral microbiomes living in the Pacific ocean

Texte intégral (1191 mots)

For decades, we have thought of coral reefs as the “rainforests of the sea:” vibrant, complex ecosystems full of fish, sponges, and coral. However, our recent findings suggest we’ve been overlooking a crucial part of this picture. By looking beyond the colourful life into the microscopic world, we have uncovered a “hidden chemical universe” that could hold the key to the next generation of life-saving medicines.

Our work, published in Nature, is the result of an international collaborative effort between the Sunagawa, Paoli, and Piel labs, alongside the Tara Ocean Foundation: France’s first foundation to be recognised as promoting public interest in the world’s oceans, founded by Agnès Troublé alias French Fashion designer agnès b. By combining our expertise in marine ecology, microbiology, and biotechnology, we have taken a closer look at corals. Far more than just individual animals, we prefer to think of them as super-organisms: bustling cities where the coral animal provides the living architecture, while trillions of microbes inhabit them, carrying out vital services.

What we found within these microscopic communities was staggering. After analysing 820 samples from 99 coral reefs across the Pacific, we reconstructed the genomes of 645 microbial species living within the corals. The surprise? More than 99% of them were completely new to science. Deciphering their genetic code revealed that these tiny residents are not silent “germs,” but prolific chemical engineers. They harbour a greater variety of biosynthetic blueprints for natural products than has been documented in the entire global open ocean so far.

How we found out

Our discovery didn’t happen in a single laboratory. It began aboard the 118-foot research schooner Tara, designed to withstand Arctic ice. After completing an extensive exploration of plankton across the global ocean, Tara served as our floating laboratory for the Tara Pacific mission. Over several years, our team visited 99 reefs across the Pacific. Life on Tara combined rugged seafaring with high-tech biology: while the crew managed the ship, teams of divers collected coral samples from remote archipelagos thousands of miles apart.

Back on land, the real detective work began. DNA sequencing at the French National Center of Sequencing (Genoscope) and genome reconstruction using ETH Zurich’s supercomputers allowed us to decode the genetic information from these microbes.

This enabled us to map Pacific coral microbiomes at an unprecedented scale. We found that microbes are highly specific to their coral hosts; each coral species has its own unique microbial fingerprint, shaped over millions of years of evolution.

Why it matters

Most current medical drugs were originally discovered in nature, many from soil bacteria. But we are running out of new “soil” leads, and antibiotic-resistant “superbugs” pose a growing global threat.

Here is where the tiny but mighty “chemical engineers” come in. Within their DNA, these microbes encode Biosynthetic Gene Clusters: instruction manuals for building diverse biochemical molecules, including antibiotics. Because coral-associated microbes live in the highly competitive reef environment, they have evolved sophisticated chemical weapons to defend their hosts or fight rivals. By identifying these Biosynthetic Gene Clusters, we have uncovered a “molecular library” written in a language we are only just beginning to translate. These chemicals may provide solutions to biotechnological challenges and human diseases.

What is next

Our discovery of new microbial species and biochemical diversity in corals is just the beginning. The Tara Pacific expedition studied only a handful of coral species, while at least 1,500 have been described worldwide, highlighting the enormous potential for scientific breakthroughs. But a tragedy is unfolding: as climate change warms the oceans, reefs are dying. When a reef disappears, we don’t just lose a beautiful ecosystem, we witness the “burning” of this library before we’ve had a chance to read the books.

The journey that began on Tara is now a race against time to unlock the secrets contained in the microbiomes of coral and other reef organisms before they are lost forever. Protecting reefs is critical, not only for the environment and the millions of people who directly depend on them, but also for preserving the biological pharmacy that could safeguard human health for generations to come.

Shinichi Sunagawa received funding from the Swiss National Science Foundation.

Chris Bowler ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

25.02.2026 à 17:08

Lever le voile sur les microbiotes inconnus des coraux du Pacifique à bord de Tara

Texte intégral (1448 mots)

Depuis des décennies, nous voyons les récifs coralliens comme les « forêts tropicales aquatiques » : des écosystèmes colorés et complexes regorgeant de poissons, d’éponges et de coraux. Cependant, nos recherches récentes suggèrent que cette vision passe sous silence un aspect crucial des récifs coralliens. Au-delà de leurs couleurs si vivaces, ils abritent tout un monde microscopique. Cet univers caché se compose de nombreux ingénieurs chimistes, qui pourraient détenir les clés d’une prochaine génération de médicaments vitaux.

Nos travaux, publiés aujourd’hui dans Nature, fruit d’une collaboration internationale entre mon laboratoire et ceux des professeurs Paoli et Piel avec la Fondation Tara Océan, montrent que les coraux ne sont pas de « simples » animaux individuels, mais plutôt des « super-organismes ». On pourrait les imaginer comme des villes animées où le récif corallien fournit un habitat vivant à des milliards de microbes qui y accomplissent des fonctions vitales.

Ce que nous avons découvert au sein de ces communautés microscopiques nous a stupéfiés : en analysant 820 échantillons provenant de 99 récifs coralliens à travers le Pacifique, nous avons reconstitué le génome de 645 espèces microbiennes vivant dans les coraux… dont plus de 99 % étaient totalement inconnues.

Qui plus est, nos études génétiques montrent que ces minuscules résidents ne sont pas passifs, mais des ingénieurs chimistes prolifiques : ils abritent dans leur ADN une immense variété de « plans » biosynthétiques (qui visent la formation de composés chimiques par des êtres vivants, des bactéries par exemple). Cette variété est plus grande que ce qui a été documenté jusqu’à présent dans l’ensemble des océans du monde.

Comment avons-nous fait cette découverte ?

Notre découverte a commencé à bord de la goélette de recherche Tara, longue de 36 mètres et conçue pour résister à la glace arctique. Après avoir mené une exploration approfondie du plancton dans les océans du globe, Tara nous a servi de laboratoire flottant pour la mission Tara Pacific. Pendant plusieurs années, notre équipe a visité 99 récifs à travers le Pacifique. La vie à bord de Tara, c’est l’unique combinaison d’une navigation pas toujours paisible et d’une biologie high tech : tandis que l’équipage gérait le navire, des équipes de plongeurs collectaient des échantillons de coraux dans des archipels éloignés de plusieurs milliers de kilomètres.

De retour à terre, un vrai travail de détective a commencé. Le séquençage de l’ADN au Centre National de Séquençage français (Genoscope) et la reconstruction des génomes à l’aide des supercalculateurs de l’ETH Zurich nous ont permis de décoder les informations génétiques des microbes coralliens.

Ainsi est apparue une carte des microbiomes coralliens du Pacifique, à une échelle inédite. Nous avons découvert que les microbes sont très spécifiques à leurs hôtes coralliens ; chaque espèce de corail possède sa propre empreinte microbienne façonnée au cours de millions d’années d’évolution.

En quoi cette découverte est-elle importante ?

La plupart des médicaments actuels ont été découverts dans la nature, le plus souvent à partir de bactéries du sol. Mais aujourd’hui, les bactéries résistantes aux antibiotiques constituent une menace mondiale croissante et nous sommes à court de nouvelles pistes dans le sol.

À lire aussi : De la médecine traditionnelle au traitement du cancer : le fabuleux destin de la pervenche de Madagascar

C’est là que les minuscules mais puissants « ingénieurs chimistes » des récifs coralliens prennent toute leur importance en termes d’applications potentielles. Dans leur ADN, ces microbes codent des ensembles de gènes biosynthétiques : des manuels d’instructions pour construire diverses molécules biochimiques, y compris des antibiotiques.

En effet, comme les microbes associés aux coraux vivent dans l’environnement hautement compétitif des récifs, ils ont développé des armes chimiques sophistiquées pour défendre leurs hôtes ou combattre leurs rivaux. En identifiant ces ensembles de gènes biosynthétiques, nous avons donc découvert une « bibliothèque moléculaire » écrite dans un langage que nous commençons seulement à traduire. Ces substances chimiques pourraient peut-être apporter des solutions aux défis biotechnologiques et aux maladies humaines.

Quelle est la prochaine étape ?

Notre découverte de nouvelles espèces microbiennes et de la diversité biochimique des coraux n’est qu’un début. L’expédition Tara Pacific n’a étudié qu’une poignée d’espèces de coraux, alors qu’au moins 1500 ont été décrites dans le monde entier, ce qui suggère un énorme potentiel de percées scientifiques.

Mais une tragédie est en train de se dérouler : à mesure que le changement climatique réchauffe les océans, les récifs coralliens meurent. Lorsqu’un récif disparaît, nous ne perdons pas seulement un magnifique écosystème, nous assistons à la « combustion » de cette bibliothèque, avant même d’avoir eu la chance d’en lire les livres.

Le voyage qui a commencé sur Tara est désormais une course contre la montre pour percer les secrets contenus dans les microbiomes des coraux et autres organismes récifaux avant qu’ils ne disparaissent à jamais. Il est essentiel de protéger les récifs, non seulement pour l’environnement et les millions de personnes qui en dépendent directement, mais aussi pour préserver la pharmacie biologique qui pourrait protéger la santé humaine pour les générations à venir.

Shinichi Sunagawa a reçu des financements de la Swiss National Science Foundation.

Chris Bowler ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

25.02.2026 à 16:48

Un singe star du Net, sa peluche et une expérience vieille de 70 ans : ce que Punch nous dit de la théorie de l’attachement

Texte intégral (1556 mots)

La vidéo d’un petit singe blotti contre une peluche a ému la planète. Derrière l’émotion, elle rappelle une leçon majeure de la psychologie : on ne grandit pas seulement avec de la nourriture, mais avec du lien.

Sa quête de réconfort a ému des millions d’internautes. Punch, un bébé macaque, est devenu une célébrité d’Internet. Abandonné par sa mère et rejeté par le reste de son groupe, il s’est vu offrir par les soigneurs du zoo municipal d’Ichikawa, au Japon, une peluche d’orang-outan pour lui servir de mère de substitution. Les vidéos le montrant agrippé au jouet ont depuis fait le tour du monde.

Mais l’attachement de Punch à son compagnon inanimé ne se résume pas à une vidéo bouleversante. Il renvoie aussi à l’histoire d’une célèbre série d’expériences en psychologie, menées dans les années 1950 par le chercheur américain Harry Harlow.

Les résultats de ces travaux ont nourri plusieurs des principes fondamentaux de la théorie de l’attachement, selon laquelle le lien entre le parent et l’enfant joue un rôle déterminant dans le développement de ce dernier.

En quoi consistaient les expériences de Harlow ?

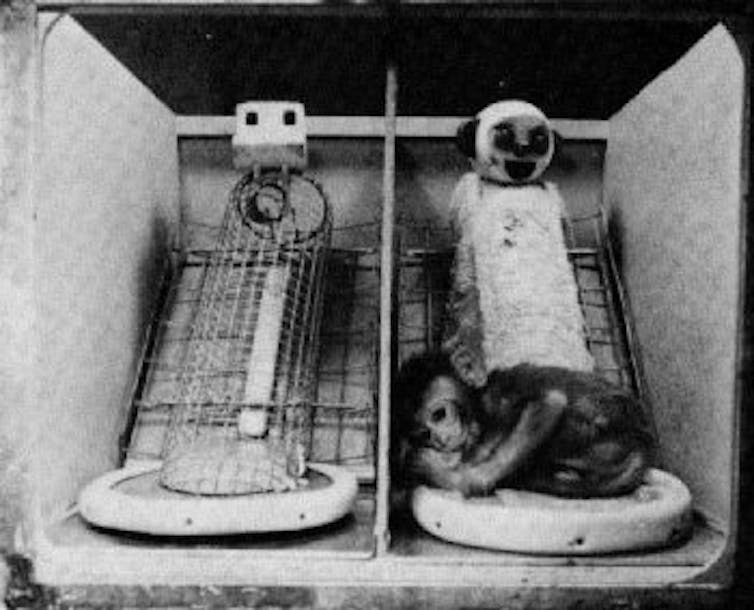

Harry Harlow a séparé des singes rhésus de leur mère dès la naissance. Ces petits ont ensuite été élevés dans un enclos où ils avaient accès à deux « mères » de substitution.

La première était une structure en fil de fer, à laquelle on avait donné la forme d’une guenon, équipée d’un petit dispositif permettant de fournir nourriture et boisson.

La seconde était une poupée en forme de singe, recouverte d’éponge et de tissu éponge. Douce et réconfortante, elle n’apportait pourtant ni nourriture ni eau : ce n’était guère plus qu’une silhouette moelleuse à laquelle le petit pouvait s’agripper.

On se retrouve donc avec, d’un côté, une « mère » qui offre du réconfort mais ni nourriture ni boisson, et, de l’autre, une structure froide, dure et métallique, qui assure l’apport alimentaire.

Ces expériences répondaient au béhaviorisme, courant théorique dominant à l’époque. Les béhavioristes soutenaient que les bébés s’attachent à celles et ceux qui satisfont leurs besoins biologiques, comme la nourriture et l’abri.

Harlow a ainsi battu en brèche cette théorie en affirmant qu’un bébé ne se construit pas seulement à coups de biberons : il a besoin de contact, de chaleur et d’attention pour s’attacher.

Selon une lecture strictement béhavioriste, les petits singes auraient dû rester en permanence auprès de la « mère » en fil de fer, celle qui les nourrissait. C’est l’inverse qui s’est produit. Ils passaient l’essentiel de leur temps agrippés à la « mère » en tissu, douce mais incapable de leur donner à manger.

Dans les années 1950, Harlow a ainsi démontré que l’attachement repose d’abord sur le réconfort et la tendresse. Face au choix, les bébés privilégient la sécurité affective à la simple satisfaction des besoins alimentaires.

En quoi cela a-t-il influencé la théorie moderne de l’attachement ?

La découverte de Harlow a marqué un tournant, car elle a profondément remis en cause la vision béhavioriste dominante à l’époque. Selon cette approche, les primates – humains compris – fonctionneraient avant tout selon des mécanismes de récompense et de punition, et s’attacheraient à celles et ceux qui répondent à leurs besoins physiques, comme la faim ou la soif.

Dans ce cadre théorique, la dimension affective n’avait pas sa place. En menant ses expériences, Harlow a renversé cette grille de lecture : il a montré que l’attachement ne se réduit pas à la satisfaction des besoins biologiques, mais repose aussi, et surtout, sur le lien émotionnel.

La préférence des petits singes pour la « nourriture émotionnelle » – en l’occurrence les câlins à la mère de substitution recouverte de tissu éponge – a posé les bases de la théorie de l’attachement.

Selon cette théorie, le développement harmonieux d’un enfant dépend de la qualité du lien qu’il tisse avec la personne qui s’occupe de lui. On parle d’attachement « sécurisé » lorsque le parent ou le proche référent apporte chaleur, attention, bienveillance et disponibilité. À l’inverse, un attachement insécure se construit dans la froideur, la distance, la négligence ou la maltraitance.

Comme chez les singes rhésus, nourrir un bébé humain ne suffit pas. Vous pouvez couvrir tous ses besoins alimentaires, mais sans affection ni chaleur, il ne développera pas de véritable attachement envers vous.

Que nous apprend le cas de Punch ?

Le zoo ne menait évidemment aucune expérience. Mais la situation de Punch reproduit, presque malgré elle, le dispositif imaginé par Harlow. Cette fois, ce n’est plus un laboratoire, mais un environnement bien réel – et pourtant, le résultat est étonnamment similaire. Comme les petits singes de Harlow qui privilégiaient la « mère » en tissu éponge, Punch s’est attaché à sa peluche Ikea.

Dans le cas du zoo, il manque évidemment un élément clé de l’expérience originale : il n’y a pas, en face, d’option dure mais nourricière avec laquelle comparer. Mais au fond, ce n’est pas ce que cherchait le singe. Ce qu’il voulait, c’était un refuge doux et rassurant – et c’est précisément ce que lui offrait la peluche.

Les expériences de Harlow étaient-elles éthiques ?

Aujourd’hui, une grande partie de la communauté internationale reconnaît aux primates des droits qui, dans certains cas, s’apparentent à ceux accordés aux humains.

Avec le recul, les expériences de Harlow apparaissent comme particulièrement cruelles. On n’envisagerait pas de séparer un bébé humain de sa mère pour mener une telle étude ; pour beaucoup, il ne devrait pas davantage être acceptable de l’infliger à des primates.

Il est frappant de voir à quel point ce parallèle avec une expérience menée il y a plus de 70 ans continue de fasciner. Punch n’est pas seulement la nouvelle star animale d’Internet : il nous rappelle l’importance du réconfort et du lien.

Nous avons tous besoin d’espaces doux. Nous avons tous besoin d’endroits où nous sentir en sécurité. Pour notre équilibre et notre capacité à avancer, l’amour et la chaleur humaine comptent bien davantage que la simple satisfaction des besoins physiques.

Mark Nielsen a reçu des financements de l'Australian Research Council.