26.11.2025 à 11:25

L’Univers a-t-il un début ? Le Big Bang contre la théorie de l’état stationnaire

Texte intégral (2419 mots)

La question de l’évolution de l’Univers a attisé de nombreux débats au cours de l’histoire de la physique. Au début du XXe siècle, deux camps de scientifiques s’affrontèrent : d’un côté, les tenants d’un Univers stable et ayant toujours existé, de l’autre, les physiciens qui adhèrent au modèle d’un atome primitif, ancêtre de notre théorie du Big Bang.

Au cours du XXe siècle, la cosmologie a été bouleversée par deux visions concurrentes du Cosmos. D’un côté, Georges Lemaître proposait l’hypothèse d’un « atome primitif », précurseur du Big Bang, selon laquelle l’Univers a une histoire et un commencement. De l’autre, Fred Hoyle, Thomas Gold et Hermann Bondi défendaient en 1948 une alternative : l’état stationnaire, un modèle où l’Univers, en expansion, reste inchangé à grande échelle grâce à une création continue de matière.

Cette théorie séduisait par son élégance : elle évitait l’idée d’un début absolu et renouait avec de vieilles intuitions philosophiques – puisqu’elles remontent à la Grèce antique – selon lesquelles le Cosmos était éternel et immuable. Mais elle allait bientôt se heurter à l’épreuve des observations. Le déclin de cette théorie fascinante s’inscrit dans une querelle scientifique majeure, au terme de laquelle le modèle de l’atome primitif de Georges Lemaître s’est imposé.

Le modèle de l’état stationnaire : un Univers éternel et immuable

En 1948, Fred Hoyle, Thomas Gold et Hermann Bondi introduisent le modèle cosmologique de l’état stationnaire. Leur approche repose sur deux principes fondamentaux. D’une part, le principe cosmologique parfait : non seulement l’Univers est homogène et isotrope dans l’espace – cela signifie qu’à grande échelle, l’Univers présente les mêmes propriétés en tout point et dans toutes les directions d’observation, aucun lieu ni direction n’est privilégiés – mais il l’est aussi dans le temps – ses propriétés sont globalement les mêmes à toutes les époques. D’autre part, ils postulent la création continue de matière pour compenser l’expansion observée de l’Univers mise en évidence par Hubble, de la matière est continuellement créée à un rythme très faible (de l’ordre d’un atome d’hydrogène par mètre cube tous les milliards d’années).

Ce modèle évite un commencement à l’Univers, et par conséquent la question philosophique et scientifique de la création de quelque chose à partir du néant. Il offre un cadre élégant, statique à grande échelle, dans lequel l’Univers n’a ni origine ni fin. D’un point de vue philosophique, il s’inscrit dans la continuité d’une vision éternelle du Cosmos, une position qui était majoritaire parmi les savants de l’Antiquité jusqu’au XVIIIe siècle, une idée déjà défendue par les stoïciens ou Aristote. À noter qu’Aristote s’interroge sur les limites de l’Univers et rejette l’idée d’un Univers infini, qu’il juge physiquement insoutenable.

Pourquoi le modèle de l’état stationnaire a-t-il séduit ?

Le modèle de l’état stationnaire a longtemps bénéficié d’un certain prestige pour plusieurs raisons. D’abord, sa simplicité philosophique, que l’on vient de décrire, mais aussi sa stabilité mathématique, puisqu’il repose sur des solutions simples des équations cosmologiques formulées par Einstein dans le cadre de sa relativité générale. Enfin, il séduit aussi du fait de son esthétique scientifique : un Univers inchangé dans le temps apparaît comme harmonieux et prévisible.

Le modèle de l’état stationnaire avait donc tout pour plaire. Sûr de sa théorie, c’est Fred Hoyle, en voulant se moquer et tourner en dérision le modèle concurrent de l’atome primitif qu’il considérait comme absurde, qui forge le terme de Big Bang lors d’une émission de radio sur la BBC en 1949. Et pourtant…

Le modèle de l’atome primitif de Lemaître : un précurseur du Big Bang

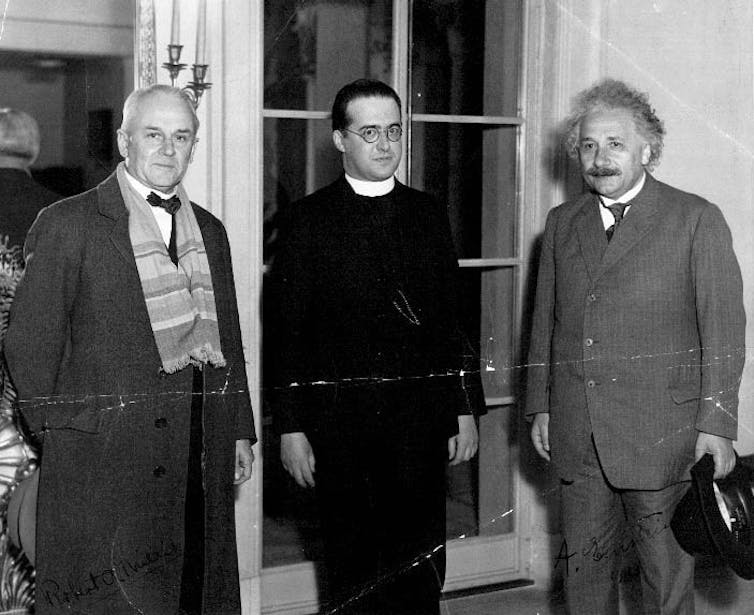

Avant même la formulation du Big Bang moderne tel que nous le concevons aujourd’hui, le prêtre et physicien belge Georges Lemaître avait développé en 1931 une hypothèse audacieuse : le modèle de l’atome primitif. Selon lui, l’Univers aurait été créé à partir de la désintégration d’un « atome cosmique », un point originel dense et chaud, à l’origine de l’expansion de l’espace. Il complète ainsi un modèle qu’il avait commencé à formuler dès 1927, dans lequel il proposait déjà un Univers en expansion.

Vous avez tout à fait raison sur le point historique concernant Lemaître : dans son article de 1927, il obtient des solutions dynamiques des équations d’Einstein, établit déjà la relation distance-vitesse et en donne une première estimation, à partir notamment des redshifts mesurés par Slipher, sans s’appuyer sur Hubble. Les travaux de Hubble, publiés ensuite, ont surtout apporté la confirmation observationnelle systématique et ont contribué à populariser cette loi aujourd’hui appelée loi de Hubble-Lemaître. Il conçoit un Univers en expansion, mais doté d’un passé à la fois physique et avec un commencement. Lemaître imaginait l’atome primitif comme un noyau contenant toute la matière de l’Univers dont la fission aurait déclenché l’expansion cosmique. Il interprétait les rayons cosmiques, récemment découverts, comme des résidus de cette désintégration initiale. Cette hypothèse s’est avérée inexacte puisqu’ils proviennent en réalité de phénomènes astrophysiques situés dans notre environnement cosmique proche.

Lemaître accepte l’idée d’un début de l’Univers, tout en distinguant clairement cette question cosmologique de la Création au sens religieux, qu’il considère relever d’un tout autre registre. Le modèle de l’atome primitif est le précurseur direct de ce que l’on appellera par découvertes successives le modèle du Big Bang, qui s’imposera plus tard, notamment grâce à ses prédictions observables.

Les preuves observationnelles contre l’état stationnaire

Malgré son attrait initial, le modèle de l’état stationnaire a commencé à vaciller face à des données de plus en plus précises. Le coup le plus dur arrive en 1964, quand Arno Penzias et Robert Wilson détectent par hasard un signal radio bruité provenant de toutes les directions d’observation. Ce bruit, appelé rayonnement cosmologique, est en fait la lueur fossile laissée par l’Univers très jeune, exactement comme l’avaient prédit les partisans du Big Bang. Le modèle stationnaire, lui, n’a aucun moyen d’expliquer un tel vestige. Le fond diffus cosmologique, découvert en 1965, est le témoin le plus direct du Big Bang. Ses détails ont ensuite été étudiés par les satellites COBE (1992), WMAP (2003) et Planck (2009).

D’autres indices vont dans le même sens : les galaxies lointaines – dont l’image qui nous parvient d’elle date du moment où elles étaient encore jeunes – n’ont pas la même apparence que les galaxies actuelles. De plus, les quasars, sortes de noyaux galactiques hyperactifs, étaient bien plus nombreux dans le passé qu’aujourd’hui. Ces différences montrent que l’Univers évolue au fil du temps, contrairement à ce qu’affirmait l’état stationnaire.

Enfin, le Big Bang prédit avec une grande précision les proportions des éléments légers (hélium, deutérium, lithium) formés durant les toutes premières minutes. Les mesures des éléments fossiles qui sont parvenus jusqu’à nous confirment ces valeurs. Le modèle stationnaire, qui n’inclut pas de phase chaude et dense initiale, est incapable de les expliquer.

L’évolution de la cosmologie moderne

Face à ces observations, la communauté scientifique adopte progressivement le modèle du Big Bang comme modèle standard. Pourtant, Fred Hoyle, dans les années 1990, refusant d’abandonner son hypothèse, propose un modèle dit quasi stationnaire, mais il reste marginal.

Aujourd’hui, le modèle ΛCDM (Lambda Cold Dark Matter), une version étendue du Big Bang qui intègre la constante cosmologique, l’idée selon laquelle il existe une minuscule énergie du vide, identique partout, exerçant une pression qui accélère l’expansion de l’Univers, est considéré comme le cadre le plus complet pour décrire l’évolution de l’univers. Introduite par Einstein en 1917 pour contrecarrer l’effet de la gravité dans un Univers qu’il pensait lui-même statique, elle a été réhabilitée sous le nom d’énergie sombre pour expliquer l’accélération observée, est considéré comme le cadre le plus complet pour décrire l’évolution de l’Univers.

Le modèle de l’état stationnaire illustre un cas typique d’élégance théorique confrontée à la rigueur de l’expérimentation. Cette controverse a stimulé les débats, inspiré des développements mathématiques et permis une meilleure compréhension de ce qu’est une bonne théorie scientifique : cohérente, testable, et surtout, réfutable.

Elle rappelle aussi que la science avance non par dogme, mais par confrontation avec la réalité du cosmos. Et si certaines théories comme celle de la simulation ou du multivers flirtent aujourd’hui avec la frontière de ce que l’on est capable de tester, elles perpétuent une tradition millénaire : tenter de comprendre ce qui, depuis toujours, nous dépasse.

Waleed Mouhali ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

26.11.2025 à 11:25

Votre chien ou chat vieillit ? Des gestes simples pour prolonger sa qualité de vie

Texte intégral (3179 mots)

Déjà, ses premiers poils gris. Votre chien ou votre chat a pris un petit coup de vieux. Comment prendre soin de lui à présent ? Des chercheurs se sont penchés sur la question et prodiguent quelques conseils faciles à mettre en œuvre.

En France, avec une espérance de vie moyenne de 11,3 ans chez les chiens comme chez les chats, la gériatrie animale est devenue indispensable. Les connaissances progressent rapidement pour mieux accompagner ces animaux. On sait désormais que quelques aménagements simples améliorent nettement le confort et la qualité de vie d’un chat ou d’un chien âgé. L’essentiel pour les propriétaires est de ne pas rester observateur passif du vieillissement de leur compagnon à quatre pattes.

À quel âge mon chien ou mon chat peut-il être considéré comme âgé ?

Une recherche portant sur plus de deux millions de chats et plus de quatre millions de chiens a permis de mieux définir leurs différents stades de vie.

Chez le chat, l’entrée dans le « troisième âge » se situe autour de 10 ans. Le « troisième âge » comprend le stade mature, senior et super-senior.

Selon cette même étude, pour le chien, la situation est moins uniforme : la vitesse de vieillissement dépend fortement de la taille.

Les chiens de petit format (toy et small, des races dont le poids est inférieur à 9 kg, comme les chihuahas ou les cavalier king charles) entrent dans le troisième âge vers 7 ans, puis deviennent seniors autour de 12 ans.

Les chiens de format moyen à grand, de plus de 9 kg, comme les welsh corgis, les golden retrievers ou les bergers australiens par exemple, y accèdent plus tôt : environ 6 ans pour le début du troisième âge, puis 10 ans pour le stade sénior.

Il est important d’être rassuré : passer dans ce nouveau stade ne signifie absolument pas que “la fin” approche. Cela indique surtout qu’il est temps d’être plus attentif à son compagnon et d’adapter progressivement son suivi, son environnement et ses soins pour l’aider à vieillir dans les meilleures conditions.

Qu’est-ce qu’un vieillissement sain ? Comment l’évaluer chez son animal ?

Avant de parler de « vieillissement sain », il est utile de rappeler ce qu’est le vieillissement : un processus naturel, progressif et inévitable. Avec le temps, les animaux tolèrent moins bien les stress de leur environnement et leurs cellules accumulent des dommages, ce qui entraîne des modifications physiologiques variées.

Qu’entend-on alors par un chien ou un chat vieillissant « en bonne santé » ? Un récent article de consensus auquel j’ai participé propose une définition adaptée à nos animaux de compagnie : un animal âgé en bonne santé est celui qui conserve suffisamment de capacités et de résistance pour répondre à ses besoins physiques, comportementaux, sociaux et émotionnels, tout en maintenant une relation stable et positive avec son humain.

Certains signes sont tout à fait normaux : poils qui grisonnent, léger tartre, peau plus fine, perception sensorielle un peu diminuée mais sans impact notable sur la qualité de vie.

En revanche, des difficultés locomotrices entravant l’accès aux ressources (difficulté à se lever, à monter les escaliers ou à interagir facilement avec vous) ne doivent pas être considérées comme de simples manifestations de l’âge. Il en va de même avec les premiers signes de dysfonction cognitive (un syndrome qui présente quelques similitudes avec Alzheimer), lorsqu’un chien ou un chat a du mal à retrouver sa gamelle ou semble perdu dans la maison, par exemple. Ces cas nécessitent un avis vétérinaire.

La qualité de vie devient donc le critère central pour évaluer si un animal suit une trajectoire de vieillissement harmonieuse. Chez le chien et le chat, on utilise désormais la notion de fragilité, issue de la gériatrie humaine (voir tableau ci-dessous).

Comment évaluer la fragilité de son animal ?

Les animaux classés comme fragiles sont plus susceptibles de développer des maladies et doivent faire l’objet d’un suivi plus rapproché.

L’intérêt majeur de cette approche est que, comme chez l’humain, la fragilité repérée tôt pourrait parfois être atténuée. D’où l’importance d’un dépistage régulier et d’un accompagnement précoce pour soutenir au mieux nos compagnons âgés.

Quelques aménagements à mettre en place

La première étape consiste à rendre l’environnement de l’animal plus accessible afin qu’il puisse atteindre facilement toutes ses ressources : nourriture, eau, lieux de repos, espaces de cachette, zones d’interaction… De simples aménagements peuvent déjà faire une vraie différence : petits escaliers pour monter sur le canapé, chauffeuses ou coussins fermes et peu hauts, gamelles surélevées pour les chiens et chats souffrant d’arthrose.

Multiplier les points d’accès est également utile : deux ou trois zones d’alimentation, plusieurs endroits pour dormir, et davantage de litières, faciles à enjamber. Certains bacs du commerce sont trop hauts pour des chats arthrosiques ; un plateau large à rebord bas peut être bien plus confortable.

Maintenir une relation apaisée et positive apparaît essentiel. Un comportement jugé « indésirable » doit toujours être investigué avec un vétérinaire et un comportementaliste (ou un vétérinaire comportementaliste) : il peut en effet traduire un besoin, un inconfort ou une difficulté. Un chat qui griffe le tapis plutôt que son arbre à chat, par exemple, peut simplement chercher une position moins douloureuse. Certains animaux deviennent aussi plus anxieux ou plus réactifs avec l’âge ou certaines conditions médicales ; il est alors important d’en comprendre la cause plutôt que de sanctionner, au risque d’abîmer la relation et de ne pas régler la problématique.

La stimulation cognitive et physique doit se poursuivre, mais en s’adaptant aux capacités de l’animal. Les « puzzle feeders »(ou gamelles interactives, des bols où les animaux doivent résoudre des jeux pour avoir leur ration) restent intéressants, à condition d’être choisis en fonction de son état : un tapis de fouille, une gamelle interactive à pousser du nez seront préférables à un système demandant des mouvements complexes des pattes. Les jeux, les apprentissages et les petits entraînements restent bénéfiques ; il suffit parfois de raccourcir les séances et d’utiliser des récompenses très appétentes (petits morceaux de blanc de poulet ou de saucisses…).

Les promenades peuvent être adaptées notamment en utilisant des sacs confortables et sécuritaires pour porter le chien lorsqu’il est trop fatigué, que ce soit pour une partie ou l’ensemble de la balade, l’important étant de continuer à ce que l’animal ait accès à l’extérieur.

L’alimentation joue enfin un rôle majeur dans l’accompagnement des animaux âgés. Le vieillissement entraîne une modification de la digestion et une perte progressive de masse musculaire. Il est donc recommandé de privilégier une alimentation facilement digestible, dont l’odeur et le goût attirent votre animal, et formulée spécifiquement pour les besoins des seniors. Les rations de viande crue sont à éviter : elles sont souvent déséquilibrées en minéraux, ce qui peut être délétère pour les animaux âgés, particulièrement sensibles aux excès de phosphore ou aux rapports calcium/phosphore inadaptés. Elles présentent également un risque sanitaire accru alors que leur système immunitaire est moins performant.

En revanche, combiner une alimentation sèche (croquettes) et humide (terrine, mousses…) est souvent bénéfique. Une ration cuite et faite maison (en suivant les conseils d’un vétérinaire) peut aussi aider un animal à retrouver l’appétit. Et pour les plus difficiles, une astuce simple peut suffire : tiédir légèrement l’aliment humide pour en renforcer l’odeur et la rendre plus attirante.

À quel moment faire intervenir le vétérinaire ?

Les visites de suivi chez le vétérinaire restent indispensables, notamment pour maintenir à jour le protocole vaccinal et le déparasitage. Avec l’âge, le système immunitaire perd en efficacité : un animal senior est donc plus vulnérable et nécessite une protection régulière contre les maladies infectieuses et les parasites.

Les consultations de gériatrie ont pour objectif de suivre l’évolution du vieillissement qui est propre à chaque individu. La première est souvent la plus longue : elle permet un échange approfondi et inclut, lorsque nécessaire, des examens complémentaires. Ces premiers éléments serviront de référence pour les visites suivantes. L’idéal est d’entamer ce suivi dès le début du « troisième âge ». La fréquence des consultations dépend ensuite de la trajectoire de l’animal : tous les six mois si des signes de fragilité apparaissent, ou une fois par an si son état reste stable.

L’enjeu n’est plus seulement d’allonger la durée de vie de nos compagnons, mais surtout de prolonger leur vie en bonne santé, en préservant leur qualité de vie le plus longtemps possible – une démarche qui rejoint celle adoptée pour les humains.

Sara Hoummady est membre de l'AFGASP (Association Française de Gériatrie Animale et de Soins Palliatifs). Elle a reçu la bourse de la FVE (Federation Veterinaire Européenne) pour ses travaux sur le vieillissement félin. Elle a fait partie d'un comité de réflexion sur le vieillissement sain chez le chien et le chat organisé par un petfooder.

22.11.2025 à 18:08

Effets secondaires des chimiothérapies : une molécule française prometteuse pour lutter contre les neuropathies périphériques, dont souffrent près de 90 % des patients

Texte intégral (1625 mots)

Une nouvelle molécule capable de protéger les neurones des effets toxiques de la chimiothérapie, tout en renforçant l’efficacité de certains traitements anticancéreux, a été découverte et offre des résultats prometteurs chez l’animal. Une start-up a été créée pour continuer son développement et mener des études chez l’humain.

Picotements dans les mains et les pieds, brûlures, douleurs, perte de sensibilité, sensation d’engourdissement… Les neuropathies périphériques figurent parmi les effets secondaires les plus fréquents de la chimiothérapie, touchant jusqu’à 90 % des patients pour certains traitements. Leur sévérité conduit parfois les praticiens à ajuster, voire à réduire les doses de chimiothérapie, ce qui peut en diminuer l’efficacité.

Dans un cas sur quatre, ces atteintes nerveuses persistent des mois, voire des années après la fin du traitement. Elles rappellent alors chaque jour aux patients qu’ils ont eu un cancer – alors même que leurs cheveux ont repoussé et que les nausées ou la fatigue ont disparu. Aucun droit à l’oubli, même une fois la maladie vaincue

À ce jour, hormis le port de gants et de chaussons réfrigérants pendant les séances de chimiothérapie – une méthode pas toujours efficace et souvent désagréable –, aucun traitement préventif n’existe. Quelques médicaments palliatifs sont utilisés, pour atténuer la douleur, avec une efficacité modeste.

Notre équipe, en collaboration avec des chercheurs états-uniens et français, vient de franchir une étape importante avec la découverte d’un composé, baptisé Carba1, capable de protéger les neurones des effets toxiques de la chimiothérapie, tout en renforçant l’efficacité de certains traitements anticancéreux. Ces travaux viennent d’être publiés dans la revue Sciences Advances.

Une molécule, deux cibles

Carba1 appartient à la famille des carbazoles, une classe de molécules développée par les chercheurs du Centre d’études et de recherche sur le médicament de Normandie (CERMN), avec lesquels nous collaborons depuis plus de dix ans.

Nos travaux ont mis en évidence que Carba1 agit sur deux cibles principales.

Premièrement, Carba1 interagit avec la tubuline, la brique de base des microtubules. Selon les besoins de la cellule, ces briques peuvent s’assembler pour former soit des « câbles » capables de tirer et de séparer les chromosomes lors de la division cellulaire, soit des « rails » sur lesquels se déplacent des moteurs moléculaires transportant nutriments et organites comme les mitochondries, assurant ainsi la distribution de l’énergie et des ressources dans toute la cellule.

Ce système de transport est particulièrement essentiel dans les cellules nerveuses, dont les prolongements peuvent atteindre plus d’un mètre de longueur, par exemple les neurones qui partent du ganglion rachidien, près de la moelle épinière et vont innerver la peau des pieds. De nombreux médicaments anticancéreux, tels que le paclitaxel (Taxol) ou le docétaxel (Taxotère), ciblent déjà ces structures afin de bloquer la prolifération des cellules tumorales. Cependant, cette action n’est pas sans conséquence : les neurones, eux aussi dépendants des microtubules pour le transport de leurs constituants, en sont affectés, ce qui constitue l’une des causes majeures des neuropathies.

Nous avons montré que Carba1 modifie subtilement les microtubules : il perturbe leur extrémité, favorisant la liaison du paclitaxel. Cette interaction permet d’utiliser des doses plus faibles du médicament anticancéreux sans perte d’efficacité contre les tumeurs.

Mais ce n’est pas tout.

Des neurones plus résistants

Deuxièmement, en examinant plus en détail les propriétés de Carba1, nous avons découvert qu’il agit également sur un autre front : le métabolisme énergétique. Les neurones figurent parmi les cellules les plus gourmandes en énergie, et la défaillance bioénergétique est considérée comme l’un des principaux facteurs contribuant à la dégénérescence neuronale.

Nos résultats montrent que Carba1 active directement une enzyme clé, la nicotinamide phosphoribosyltransférase (NAMPT), qui relance la production de NAD⁺, molécule cruciale pour la génération d’énergie. Résultat : les neurones deviennent plus résistants au stress métabolique et survivent mieux aux agressions des agents chimiothérapeutiques.

Nous avons confirmé l’effet neuroprotecteur de Carba1 sur des cultures de neurones exposées à trois agents chimiothérapeutiques connus pour induire une neuropathie, via des mécanismes différents : le paclitaxel (ciblant les microtubules), le cisplatine (agent alkylant) et le bortézomib (inhibiteur du protéasome).

Contrairement aux cultures témoins où s’étendent des prolongements neuritiques lisses et vigoureux, dans les cultures traitées par ces médicaments, les prolongements présentent un aspect fragmenté, caractéristique d’un processus de dégénérescence. En revanche, lorsque les neurones sont exposés à ces mêmes traitements en présence de Carba1, leurs prolongements demeurent intacts, indiscernables de ceux des cultures non traitées. Ces observations indiquent que Carba1 protège efficacement les neurones de la dégénérescence induite par ces agents neurotoxiques.

Des résultats encourageants chez l’animal

Pour aller plus loin, nous avons testé Carba1 dans un modèle de neuropathie chez le rat traité au paclitaxel, développé par le Dr David Balayssac à Clermont-Ferrand (unité Neurodol). Ce traitement provoque une hypersensibilité cutanée : les rats réagissent à des pressions très faibles sur leurs pattes, un signe de douleur neuropathique. L’analyse histologique montre également une diminution des terminaisons nerveuses intra-épidermiques, tandis que le sang présente des taux élevés de NfL (chaîne légère de neurofilaments), marqueur de dégénérescence neuronale.

Lorsque Carba1 est administré avant et pendant le traitement, ces altérations disparaissent : les nerfs restent intacts, la concentration de NfL demeure normale et la sensibilité cutanée des animaux reste inchangée. Autrement dit, Carba1 protège les neurones de la dégénérescence induite par le paclitaxel. Signe rassurant, Carba1 n’impacte pas la croissance tumorale.

Comme les neurones, les cellules cancéreuses consomment beaucoup d’énergie. Il était donc essentiel de vérifier que Carba1 n’avait pas d’effet pro-tumoral et qu’il ne diminuait pas l’efficacité du paclitaxel. Pour le savoir, nous avons administré Carba1 seul, ou en association avec une dose thérapeutique de paclitaxel, à des souris porteuses de tumeurs greffées. Les résultats sont clairs : Carba1 n’a provoqué aucun effet toxique, ni altéré la santé générale des animaux, ni stimulé la croissance des tumeurs. Il n’interfère pas non plus avec l’action anticancéreuse du paclitaxel.

Une nouvelle voie vers des traitements mieux tolérés

Cette découverte est particulièrement enthousiasmante, car elle combine deux effets rarement réunis :

renforcer l’efficacité des médicaments anticancéreux de la famille du paclitaxel (taxanes) en permettant d’en réduire la dose ;

préserver les nerfs et améliorer la qualité de vie des patients pendant et après le traitement.

Avant d’envisager un essai clinique chez l’humain, plusieurs étapes restent indispensables. Il faut d’abord confirmer la sécurité de Carba1 chez l’animal, déterminer la dose minimale efficace et la dose maximale tolérée. Enfin, il sera nécessaire de mettre au point une formulation adaptée à une administration chez l’humain.

Cette mission incombe désormais à la start-up Saxol, issue de cette recherche, dont je suis l’une des cofondatrices. Si ces étapes – qui devraient s’étendre sur cinq ans au moins, selon les défis techniques et les levées de fonds – se déroulent comme prévu, Carba1 pourrait devenir le premier traitement préventif contre la neuropathie induite par la chimiothérapie – une avancée majeure qui pourrait transformer la façon dont les patients vivent leur traitement anticancéreux.

Carba1 incarne une innovation à l’interface de la chimie, de la neurobiologie et de l’oncologie. En associant protection neuronale et renforcement de l’efficacité thérapeutique, cette petite molécule pourrait, à terme, réconcilier traitement du cancer et qualité de vie. Pour les millions de patients confrontés à la double épreuve du cancer et de la douleur neuropathique, elle représente un espoir concret et prometteur.

Laurence Lafanechère est cofondatrice et conseillère scientifique de la Société SAXOL. Pour mener ses recherches elle a reçu des financements de : Société d’Accélération de Transfert de Technologies Linksium Maturation grant CM210005, (L.L) Prématuration CNRS (LL) Ligue contre le Cancer Allier et Isère (LL, C.T, D.B.) Ruban Rose (LL)