03.12.2025 à 16:54

Quand des robots invisibles influencent nos choix et nos opinions

Texte intégral (2583 mots)

À chaque fois que nous cliquons sur une étoile pour évaluer un restaurant, que nous laissons un commentaire sur un site marchand ou que nous « likons » une vidéo, nous déposons une trace numérique. Individuellement, cela peut sembler insignifiant, un simple petit signe de préférence, une micro-opinion parmi tant d’autres. Mais collectivement, ces traces forment un vaste paysage social, un nuage de signaux visibles et persistants, qui influence profondément nos comportements.

Ces indices diffus, agrégés par des plateformes et amplifiés par des algorithmes, fonctionnent comme une mémoire partagée. Ils nous disent ce qui est populaire, digne de confiance ou au contraire suspect. Le phénomène est si puissant que les biologistes et les physiciens l’ont rapproché d’un mécanisme bien connu dans le monde animal : la stigmergie. Ce concept introduit à la fin des années 1950 par l’entomologiste Pierre-Paul Grassé pour expliquer la construction collective du nid chez les termites, décrit la coordination indirecte entre les individus grâce aux traces que ceux-ci laissent dans l’environnement. Chez les insectes sociaux, une boulette de terre imprégnée de phéromone de construction et déposée à un endroit attire d’autres ouvrières qui viendront ajouter la leur, entraînant la formation d’un pilier puis d’un dôme.

Dans le monde numérique, un commentaire enthousiaste, une série d’évaluations cinq étoiles ou la viralité d’un hashtag jouent un rôle similaire : ils incitent d’autres personnes à adopter un comportement convergent. Ainsi, sans qu’il y ait besoin d’un chef d’orchestre, des milliers d’actions individuelles peuvent se combiner pour produire un comportement collectif cohérent. Mais ce mécanisme fascinant comporte un revers. Car si la stigmergie favorise la coopération et l’intelligence collective, elle ouvre aussi la porte à la manipulation et à la tromperie. Que se passe-t-il lorsque certains individus, ou des programmes automatiques, déposent des traces biaisées ou mensongères ?

Les travaux que nous avons réalisés au Centre de recherches sur la cognition animale, en collaboration avec le Laboratoire de physique théorique et l’École d’économie à Toulouse nous plongent au cœur de cette question à la croisée de l’éthologie, de l’économie comportementale et de la science des systèmes complexes. Nos études expérimentales ont révélé comment, dans des environnements numériques contrôlés, les humains exploitent, détournent ou subissent l’influence de ces traces. Elles montrent, de manière saisissante, que même de simples robots logiciels, dépourvus de toute sophistication, peuvent réorienter en profondeur la dynamique de coopération d’un groupe humain.

Quand la coopération devient fragile face à la compétition

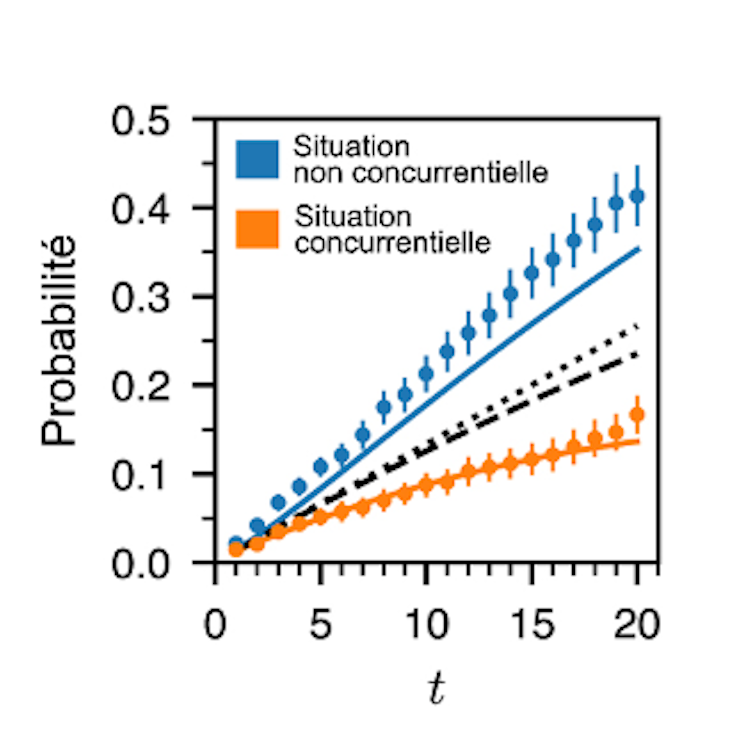

La première série d’expériences, publiée en 2023, avait pour but d’examiner dans quelles conditions la stigmergie favorise ou non la coopération entre humains. Pour cela, nous avons conçu une expérience dans laquelle des groupes de cinq participants étaient invités à explorer une même grille de 225 cases numériques, chacune contenant une valeur cachée comprise entre 0 et 99 réparties aléatoirement. Leur objectif était de trouver les cases aux plus fortes valeurs.

Chaque fois qu’un joueur découvrait une case, il devait lui attribuer une note sur cinq étoiles, exactement comme on le fait pour un produit en ligne. Après que tous les sujets aient ouvert et noté les cases, chacune des cases des tableaux explorés par chaque groupe initialement de couleur blanche, adoptait différentes tonalités de rouge dont l’intensité dépendait du pourcentage d’étoiles ayant été déposées dans la case par tous les sujets au cours des itérations précédentes. Ces traces de couleurs étaient visibles par tous les membres du groupe et constituaient ainsi une mémoire collective de leurs actions passées. L’expérience s’achevait au bout de vingt itérations et la somme des valeurs des cases visitées par chaque sujet au cours de toutes les itérations déterminait le score de celui-ci.

Or, deux règles de jeu différentes étaient proposées. Dans la version non compétitive, le score cumulé des joueurs au terme d’une série de dix expériences n’affectait pas le montant de leur rémunération en fin d’expérience qui était identique pour tous, chaque participant gagnant 10 euros. Dans la version compétitive, en revanche, chaque point comptait car le gain final (entre 10 euros et 20 euros) dépendait de la somme des valeurs découvertes qui déterminait le classement des joueurs. Ces derniers étaient donc mis en concurrence pour obtenir la meilleure récompense.

Les résultats ont montré que dans la condition sans compétition, les individus avaient tendance à noter les cases de manière proportionnelle à leur valeur, offrant aux autres une information fidèle et donc utile. La coopération émergeait spontanément. En exploitant les traces laissées par les uns et les autres, le groupe parvenait à identifier collectivement les meilleures cases, bien au-delà de ce qu’un individu isolé aurait pu espérer. Mais dès que la compétition entrait en jeu, tout changeait. Beaucoup de participants se mettaient à tricher subtilement, ils visitaient des cases de forte valeur mais leur attribuaient une mauvaise note, afin de ne pas attirer l’attention des autres. D’autres adoptaient des stratégies neutres, attribuant des notes aléatoires ou uniformes pour brouiller les pistes. Ainsi la mémoire collective devenait peu fiable, et la coopération s’effritait.

L’analyse fine des comportements permit d’identifier trois profils distincts : les collaborateurs, qui partagent honnêtement l’information ; les neutres, qui laissent des signaux ambigus ; et les trompeurs, qui induisent délibérément les autres en erreur. Dans un contexte compétitif, la proportion de trompeurs explose. Ce basculement montre que la coopération humaine fondée sur les traces est hautement contextuelle. Elle peut surgir naturellement lorsqu’il n’y a rien à perdre à partager, mais elle s’évapore dès que l’intérêt individuel pousse à garder pour soi ou à induire les autres en erreur. Cette ambivalence se retrouve dans de nombreux environnements en ligne, où les évaluations sincères cohabitent avec les commentaires mensongers, les faux avis ou le spam organisé.

Quand des robots sociaux s’invitent dans la partie

La deuxième étude, réalisée en 2022 et aujourd’hui en cours de publication, pousse l’expérience encore plus loin en introduisant de nouveaux acteurs : de simples bots programmés (un bot est une application logicielle automatisée qui exécute des tâches répétitives sur un réseau). Dans cette expérience nous avons repris le même dispositif de la grille à explorer et du système d’évaluation, mais cette fois-ci, chaque participant humain jouait avec quatre « partenaires » qui n’étaient pas des humains, même si les joueurs l’ignoraient. Ces partenaires étaient des bots adoptant des comportements prédéfinis. Certains collaboraient en notant fidèlement les cases, d’autres trichaient systématiquement, d’autres encore restaient neutres, et enfin un dernier type cherchait à optimiser la performance collective. L’idée était de tester si la présence de ces agents artificiels, pourtant rudimentaires pouvait influencer la stratégie des humains dans une situation compétitive.

Les résultats furent spectaculaires. Dans les groupes où les bots se montraient coopératifs, les humains réussissaient mieux, ils découvraient davantage de cases de grande valeur et obtenaient de meilleurs scores. Mais ce climat de confiance favorisait aussi l’émergence de comportements opportunistes ; ainsi certains participants se mettaient à tricher davantage, profitant de la fiabilité des traces laissées par les bots. À l’inverse, dans les groupes saturés de bots trompeurs, les participants s’adaptaient en devenant plus coopératifs ou neutres, comme s’ils tentaient de préserver un minimum de signal exploitable dans un océan de bruit.

L’influence des bots était si forte que la seule composition du groupe (quatre bots coopératifs, ou trois trompeurs et un coopérateur, etc.) suffisait à prédire les performances globales. Plus étonnant encore, lorsqu’on comparait les performances de cinq humains jouant ensemble à celles de groupes mixtes humains-bots, les groupes intégrant certains bots conçus pour optimiser la performance collective s’en sortaient beaucoup mieux que les groupes purement humains. Dans ces situations, la présence des bots incitait les participants à adopter un profil de collaborateur alors même qu’ils étaient en compétition.

Entre intelligence collective et risques de manipulation

Ces expériences, bien qu’effectuées en laboratoire avec des grilles de nombres, résonnent fortement avec notre quotidien numérique saturé de traces et de signaux automatiques. À la lumière des conclusions, on peut s’interroger pour savoir à quel point nos choix collectifs sont déjà façonnés par des agents invisibles. Ces expériences montrent que la stigmergie, ce mécanisme de coordination indirecte, fonctionne aussi chez nous humains, et pas seulement chez les termites ou les fourmis. Elles révèlent aussi sa fragilité. La coopération née des traces est toujours menacée par la tentation de la tromperie, amplifiée par la compétition ou la présence d’agents biaisés. Dans un monde où les plateformes en ligne reposent massivement sur les systèmes d’évaluation, de notation et de recommandation, ces résultats invitent à une réflexion urgente. Car derrière chaque note et chaque commentaire peuvent se cacher non seulement des stratégies humaines égoïstes, mais aussi des bots capables de biaiser l’opinion collective.

Cependant il ne s’agit pas uniquement de dénoncer les manipulations malveillantes, des faux avis pour booster un produit, des campagnes de désinformation orchestrées par des armées de bots, mais aussi de réfléchir aux usages potentiellement prosociaux de ces mêmes agents. Comme le montrent également nos expériences, des bots bien conçus peuvent au contraire favoriser la coopération, stabiliser les dynamiques collectives et même améliorer la performance d’un groupe. Encore faut-il savoir les intégrer de façon transparente et éthique, en évitant qu’ils ne deviennent des instruments de tromperie.

Ces travaux rappellent que nous vivons désormais dans des écosystèmes hybrides, où humains et agents artificiels cohabitent et interagissent sans cesse à travers les traces numériques. Comprendre comment ces interactions façonnent notre intelligence collective est un défi majeur pour la recherche interdisciplinaire. Mais c’est aussi un enjeu citoyen, car de la manière dont nous régulerons, concevrons et utiliserons ces traces et ces bots dépendra la qualité de nos coopérations futures et peut-être même la santé de nos démocraties numériques.

Cet article a été proposé en partenariat avec le colloque « Les propagations, un nouveau paradigme pour les sciences sociales ? » (à Cerisy (Manche), qui s’est tenu du 25 juillet au 31 juillet 2025).

Guy Théraulaz ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

02.12.2025 à 13:12

Quand l’IA fait n’importe quoi, le cas du gratte-ciel et du trombone à coulisse

Texte intégral (2490 mots)

Une expérience relativement simple consistant à demander à une intelligence artificielle générative de comparer deux objets de tailles très différentes permet de réfléchir aux limites de ces technologies.

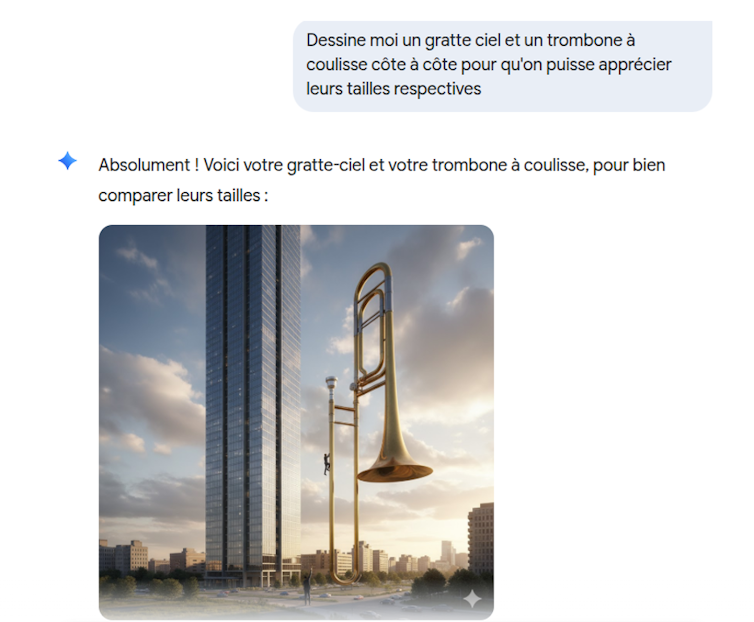

Les intelligence artificielle (IA) génératives font désormais partie de notre quotidien. Elles sont perçues comme des « intelligences », mais reposent en fait fondamentalement sur des statistiques. Les résultats de ces IA dépendent des exemples sur lesquels elles ont été entraînées. Dès qu’on s’éloigne du domaine d’apprentissage, on peut constater qu’elles n’ont pas grand-chose d’intelligent. Une question simple comme « Dessine-moi un gratte-ciel et un trombone à coulisse côte à côte pour qu’on puisse apprécier leurs tailles respectives » vous donnera quelque chose comme ça (cette image a été générée par Gemini) :

L’exemple provient du modèle de Google, Gemini, mais le début de l’ère des IA génératives remonte au lancement de ChatGPT en novembre 2022 et ne date que d’il y a trois ans. C’est une technologie qui a changé le monde et qui n’a pas de précédent dans son taux d’adoption. Actuellement ce sont 800 millions d’utilisateurs, selon OpenAI, qui chaque semaine, utilisent cette IA pour diverses tâches. On notera que le nombre de requêtes diminue fortement pendant les vacances scolaires. Même s’il est difficile d’avoir des chiffres précis, cela montre à quel point l’utilisation des IA est devenue courante. À peu près un étudiant sur deux utilise régulièrement des IA.

Les IA : des technologies indispensables ou des gadgets ?

Trois ans, c’est à la fois long et court. C’est long dans un domaine où les technologies évoluent en permanence, et court en termes sociétaux. Même si on commence à mieux comprendre comment utiliser ces IA, leur place dans la société n’est pas encore quelque chose d’assuré. De même la représentation mentale qu’ont ces IA dans la culture populaire n’est pas établie. Nous en sommes encore à une alternance entre des positions extrêmes : les IA vont devenir plus intelligentes que les humains ou, inversement, ce ne sont que des technologies tape-à-l’œil qui ne servent à rien.

En effet, un nouvel appel à faire une pause dans les recherches liées aux IA a été publié sur fond de peur liée à une superintelligence artificielle. De l’autre côté sont promis monts et merveilles, par exemple un essai récent propose de ne plus faire d’études, car l’enseignement supérieur serait devenu inutile à cause de ces IA.

Difficile de sortir de leurs domaines d’apprentissage

Depuis que les IA génératives sont disponibles, je mène cette expérience récurrente de demander de produire un dessin représentant deux objets très différents et de voir le résultat. Mon but par ce genre de prompt (requête) est de voir comment le modèle se comporte quand il doit gérer des questions qui sortent de son domaine d’apprentissage. Typiquement cela ressemble à un prompt du type « Dessine-moi une banane et un porte-avions côte à côte pour qu’on se rende compte de la différence de taille entre les deux objets ». Ce prompt en utilisant Mistral donne le résultat suivant :

À ce jour je n’ai jamais trouvé un modèle qui donne un résultat censé. L’image donnée en illustration ci-dessus (ou en tête de l’article) est parfaite pour comprendre comment fonctionnent ce type d’IA et quelles sont ses limites. Le fait qu’il s’agisse d’une image est intéressant, car cela rend palpables des limites qui seraient moins facilement discernables dans un long texte.

Ce qui frappe est le manque de crédibilité dans le résultat. Même un enfant de 5 ans voit que c’est n’importe quoi. C’est d’autant plus choquant qu’avec la même IA il est tout à fait possible d’avoir de longues conversations complexes sans pour autant qu’on ait l’impression d’avoir affaire à une machine stupide. D’ailleurs ce même type d’IA peut tout à fait réussir l’examen du barreau ou répondre avec une meilleure précision que des professionnels sur l’interprétation de résultats médicaux (typiquement, repérer des tumeurs sur des radiographies).

D’où vient l’erreur ?

La première chose à remarquer est qu’il est difficile de savoir à quoi on est confronté exactement. Si les composants théoriques de ces IA sont connus dans la réalité, un projet comme celui de Gemini (mais cela s’applique aussi aux autres modèles que sont ChatGPT, Grok, Mistral, Claude, etc.) est bien plus compliqué qu’un simple LLM couplé à un modèle de diffusion.

Un LLM est une IA qui a été entraînée sur des masses énormes de textes et qui produit une représentation statistique de ces derniers. En gros, la machine est entraînée à deviner le mot qui fera le plus de sens, en termes statistiques, à la suite d’autres mots (votre prompt).

Les modèles de diffusion qui sont utilisés pour engendrer des images fonctionnent sur un principe différent. Le processus de diffusion est basé sur des notions provenant de la thermodynamique : on prend une image (ou un son) et on ajoute du bruit aléatoire (la neige sur un écran) jusqu’à ce que l’image disparaisse, puis ensuite on fait apprendre à un réseau de neurones à inverser ce processus en lui présentant ces images dans le sens inverse du rajout de bruit. Cet aspect aléatoire explique pourquoi avec le même prompt le modèle va générer des images différentes.

Un autre point à considérer est que ces modèles sont en constante évolution, ce qui explique que le même prompt ne donnera pas le même résultat d’un jour à l’autre. De nombreuses modifications sont introduites à la main pour gérer des cas particuliers en fonction du retour des utilisateurs, par exemple.

À l’image des physiciens, je vais donc simplifier le problème et considérer que nous avons affaire à un modèle de diffusion. Ces modèles sont entraînés sur des paires images-textes. Donc on peut penser que les modèles de Gemini et de Mistral ont été entraînés sur des dizaines (des centaines ?) de milliers de photos et d’images de gratte-ciel (ou de porte-avions) d’un côté, et sur une grande masse d’exemples de trombone à coulisse (ou de bananes) de l’autre. Typiquement des photos où le trombone à coulisse est en gros plan. Il est très peu probable que, dans le matériel d’apprentissage, ces deux objets soient représentés ensemble. Donc le modèle n’a en fait aucune idée des dimensions relatives de ces deux objets.

Pas de « compréhension » dans les modèles

Les exemples illustrent à quel point les modèles n’ont pas de représentation interne du monde. Le « pour bien comparer leurs tailles » montre qu’il n’y a aucune compréhension de ce qui est écrit par les machines. En fait les modèles n’ont pas de représentation interne de ce que « comparer » signifie qui vienne d’ailleurs que des textes dans lesquels ce terme a été employé. Ainsi toute comparaison entre des concepts qui ne sont pas dans le matériel d’apprentissage sera du même genre que les illustrations données en exemple. Ce sera moins visible mais tout aussi ridicule. Par exemple, cette interaction avec Gemini « Considérez cette question simple : “Le jour où les États-Unis ont été établis est-il dans une année bissextile ou une année normale ?”. »

Lorsqu’il a été invoqué avec le préfixe CoT (Chain of Thought, une évolution récente des LLMs dont le but est de décomposer une question complexe en une suite de sous-questions plus simples), le modèle de langage moderne Gemini a répondu : « Les États-Unis ont été établis en 1776. 1776 est divisible par 4, mais ce n’est pas une année séculaire (de cent ans), c’est donc une année bissextile. Par conséquent, le jour où les États-Unis ont été établis était dans une année normale. »

On voit bien que le modèle déroule la règle des années bissextiles correctement, donnant par là même une bonne illustration de la technique CoT, mais il conclut de manière erronée à la dernière étape ! Ces modèles n’ont en effet pas de représentation logique du monde, mais seulement une approche statistique qui crée en permanence ce type de glitchs qui peuvent paraître surprenants.

Cette prise de conscience est d’autant plus salutaire qu’aujourd’hui, les IA écrivent à peu près autant d’articles publiés sur Internet que les humains. Ne vous étonnez donc pas d’être étonné par la lecture de certains articles.

Frédéric Prost ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

01.12.2025 à 15:24

Le premier zoo virtuel d’Europe peut-il éveiller les consciences sur le bien-être animal ?

Texte intégral (2504 mots)

De plus en plus décriés, les zoos jouent pourtant un rôle dans la sensibilisation du public à la sauvegarde des espèces sauvages. À Bruxelles, le premier zoo en réalité virtuelle aurait-il trouvé la formule gagnante ?

Inauguré à Bruxelles en septembre 2025 et ouvert au public jusqu’au 30 décembre 2025, le Zoo du futur, premier zoo européen 100 % virtuel promet l’émerveillement d’un zoo, mais sans cages. Imaginé par l’association de protection animale Gaia, en collaboration avec le studio d’expériences immersives Reality Matters, le Zoo du futur propose au public de repenser la relation entre humains et animaux en lui permettant d’admirer une pléiade d’animaux en liberté dans des environnements naturels reconstitués numériquement.

Deux technologies immersives rendent possible la découverte de ces univers numériques : la réalité virtuelle (VR) via des casques afin d’observer les animaux ainsi que la réalité augmentée via une application mobile pour interagir avec des modules pédagogiques (quiz, informations sur les animaux). L’ambition du projet est double : et si la VR ne servait pas seulement à divertir mais aussi à éduquer afin d’encourager des comportements plus responsables ?

Ayant travaillé sur les effets de la VR sur les consommateurs, le Zoo du futur constitue donc un terrain d’observation privilégié pour comprendre comment les technologies immersives modifient les pratiques touristiques et culturelles. Dans le cadre de ces recherches, je me suis entretenu avec plusieurs acteurs de cette initiative.

Renouveler l’expérience du public

Ces technologies immersives impactent plusieurs dimensions dans le vécu du visiteur. La première correspond à la métaversification de l’expérience, c’est-à-dire que le digital agrémente désormais les lieux marchands, culturels et touristiques réels. Dans le cas du zoo bruxellois, trois univers thématiques en VR offrent une expérience immersive aux visiteurs : la savane, la banquise et la jungle.

La seconde dimension correspond à l’aspect multisensoriel offert par les nouvelles technologies, qui, à l’instar d’une expérience réelle, stimulent plusieurs, voire tous les sens. Le Zoo du futur combine sons d’ambiance, diffusion d’odeurs et interaction virtuelle qui impliquent les mouvements du visiteur « pour essayer d’avoir l’immersion la plus aboutie possible », comme l’indique Sébastien de Jonge, le directeur des opérations de Gaia que j’ai pu interroger au cours de mes recherches. Lorsque le visiteur s’équipe du casque VR, il voit subitement un éléphant qui s’approche, ses yeux qui plongent dans les siens, sa trompe qui s’élève. Il essaye de toucher l’animal, persuadé de sentir sa présence. L’illusion sensorielle est palpable et l’émotion réelle.

La troisième dimension correspond à l’empowerment du consommateur, c’est-à-dire la capacité à agir activement avec son corps et à interagir avec les objets de l’environnement virtuel. En permettant de s’immerger à la première personne dans des environnements virtuels aux graphismes très réalistes, la VR séduit le public qui s’attend désormais à être davantage acteur de son expérience que de simplement avoir à écouter une histoire.

Pour Andy Van den Broeck, fondateur de Reality Matters, la VR est complémentaire à l’expérience réelle, voire magnifiée. Il souligne que « dans un zoo réel, vous ne pouvez pas vous approcher aussi près des animaux pour les observer, ou vous déplacer librement et interagir dans ces grands espaces naturels ». De plus, le zoo virtuel enrichit l’expérience avec de la réalité augmentée afin d’offrir une interaction ludique et éducative avec les animaux.

Provoquer l’empathie pour des animaux, même virtuels

Ces dimensions concourent à stimuler un sentiment d’incarnation, c’est-à-dire à l’illusion d’être le personnage virtuel. L’une des forces de la VR réside dans sa capacité à faire vivre une expérience d’incarnation dans laquelle on n’observe pas seulement, mais où l’on réfléchit et réagit émotionnellement d’une façon semblable que lors d’une expérience réelle (Leveau et Camus, 2023).

L’apprentissage par la pratique est une des forces de la VR. L’implication active favorise la mémorisation et l’acquisition des compétences grâce à une compréhension plus concrète et une meilleure appropriation de la situation que la simple lecture d’un document, par exemple. La pyramide de l’apprentissage établi par le chercheur en éducation américain Edgar Dale confirme qu’on apprend mieux lorsqu’on est acteur de la situation d’apprentissage. Un individu retiendrait selon lui seulement 10 % de ce qu’il lit, contre 90 % de ce qu’il dit et fait.

Les technologies immersives développent également l’empathie. Alors que, dans un zoo classique, on contemple des animaux réels, mais privés de liberté, le zoo virtuel exhibe des animaux numériques dans leur habitat naturel. À ce jour, « les visiteurs réfléchissent en termes de protection des espèces, pas d’individus », insiste Sébastien de Jonge. Le zoo virtuel invite à donc renverser le regard en valorisant l’animal comme un être vivant singulier et en proposant une alternative concrète et positive, tout en questionnant les conditions de vie des animaux dans les zoos traditionnels, sans pour autant attaquer leurs méthodes frontalement.

On constate que la gamification interactive associée à la VR, telle que les quiz interactifs sur l’espace vital d’un éléphant, déclenche une prise de conscience et des changements de comportements concrets. Selon Sébastien de Jonge, la réaction du public quant au bien-être des animaux à l’issue de l’expérience virtuelle en témoigne en provoquant des questionnements sur les alternatives à faire valoir. Ainsi, plonger les visiteurs dans des environnements naturels reconstitués en VR suscite une réflexion sur la captivité animale tout en préservant la dimension pédagogique des zoos. Cette approche, en phase avec les attentes des associations de défense animale, invite aussi chacun à repenser son rapport au vivant et à adopter des choix de consommation plus responsables.

Tirer parti des envies contradictoires des consommateurs

C’est précisément le basculement de spectateur passif à acteur impliqué qui confère un rôle inédit dans la sensibilisation éthique et environnementale. L’expérience en VR permet non seulement d’apprendre en interagissant de manière plus directe, mais aussi d’interroger nos modes de consommation et de loisirs. En proposant une alternative plus responsable dans les activités de récréations et de loisirs, la VR agit sur les comportements de manière vertueuse.

À cet effet, la VR contribue à des pratiques marketing plus éthiques en se substituant ponctuellement comme une alternative durable au voyage physique ou en contribuant à un tourisme plus inclusif auprès de certains publics (seniors, PMR, etc.). Pour le zoo, la VR contribue à donner l’illusion d’une expérience réelle sans nuire aux écosystèmes. Gaia défend ce modèle : « Le Zoo du futur, pour nous, c’est une campagne comme une autre », confie Sébastien de Jonge. Les tarifs volontairement bas, à 12 € l’entrée, ne sont pas rentables et confirment cette logique.

Mais qu’en est-il réellement du côté des consommateurs ? Dans un sondage réalisé auprès de 100 personnes, en France, en septembre 2025, 83,4 % déclarent préférer visiter un zoo réel plutôt qu’un zoo virtuel. Pourtant, plus de 98 % d’entre elles déclarent être sensibles au bien-être et aux conditions de vie des animaux en captivité. Ce paradoxe s’observe d’une part à travers le succès commercial des plus grands zoos en Europe, dont la fréquentation dépasse annuellement le million de visiteurs, comme au zoo de Barcelone, d’autre part à travers la multiplication de fermetures de delphinariums (Marineland en France en 2025 ou encore le dernier delphinarium en Belgique, Boudewijn Seapark, dont la fermeture administrative est actée pour 2037).

Inciter le changement de comportements

Enfin, 95 % des personnes interrogées nous ont confié être prêtes à adapter leurs comportements de consommation pour mieux respecter le bien-être des animaux en privilégiant un zoo virtuel plutôt qu’un zoo réel. Ainsi, nous espérons, comme Sébastien de Jonge, que cette fiction-réalité puisse « simplement allumer une lumière dans l’esprit du public » et conduire les zoos à se réinventer pour concilier bien-être animal avec viabilité économique. En cas de succès, le projet temporaire pourrait devenir permanent et esquisser pour les zoos un business model inédit.

Néanmoins, il ne faut pas oublier que ces technologies génèrent une pollution numérique et que la VR est réputée inciter le visiteur à se rendre dans la réalité sur le lieu qu’il a virtuellement exploré. Un tel dispositif risque donc de s’avérer contre-productif, à l’opposé des ambitions affichées par l’association, malgré la vocation première du projet de conjuguer émerveillement, pédagogie et respect du bien-être animal. Avec son zoo virtuel, Gaia démontre cependant le potentiel de la VR au-delà du simple divertissement : la technologie ouvre la voie à des pratiques plus soutenables et à un modèle économique écocentrique, fondé sur la valeur intrinsèque du vivant.

Pierre-Henry Leveau ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.