12.01.2026 à 15:54

La bulle de l’IA n’a rien de nouveau : Karl Marx en a expliqué les mécanismes, il y a près de 150 ans

Texte intégral (2462 mots)

L’explosion des investissements dans l’intelligence artificielle révèle, comme l’avait décrit Marx, d’une difficulté structurelle du capitalisme à absorber ses propres excédents, au prix d’une financiarisation accrue et de fragilités économiques croissantes.

Lorsque Sam Altman, patron d’OpenAI, a déclaré plus tôt cette année à des journalistes à San Francisco que le secteur de l’intelligence artificielle (IA) était en train de former une bulle, le marché technologique états-unien a réagi presque instantanément. Combinée au fait que 95 % des projets pilotes en IA échouent, sa remarque a été perçue par les traders comme un signal d’alerte plus large. Même si Altman visait spécifiquement les start-ups non cotées plutôt que les grands groupes en Bourse, certains semblent y avoir vu une évaluation de l’ensemble du secteur.

Le milliardaire de la tech Peter Thiel (NDT : un proche de Donald Trump) a par exemple vendu ses actions Nvidia, tandis que l’investisseur américain Michael Burry – rendu célèbre par The Big Short – a parié des millions de dollars sur une baisse de la valeur de ce fabricant de puces mais également de l’éditeur américain de logiciels d’analyse data Palantir.

À lire aussi : Pourquoi la hausse du prix des mémoires vives informatiques est une menace pour l’économie européenne

Au fond, le propos d’Altman ne met pas seulement en lumière la fragilité de certaines sociétés, mais une tendance plus profonde qu’avait anticipée Karl Marx : le problème du capital excédentaire, qui ne parvient plus à trouver de débouchés rentables dans la production.

La théorie marxiste des crises

L’avenir de l’IA n’est pas en cause. Comme Internet après l’éclatement de la bulle de 2001, la technologie est appelée à durer. Ce qui pose question, en revanche, c’est la destination du capital une fois que les actions liées à l’IA ne fourniront plus les rendements spéculatifs promis ces dernières années.

Cette interrogation nous ramène directement à l’analyse marxienne des crises liées à la suraccumulation. Marx soutenait qu’une économie devient instable lorsque la masse de capital accumulé ne peut plus être réinvestie de manière rentable.

Les investissements technologiques masquent la faiblesse économique

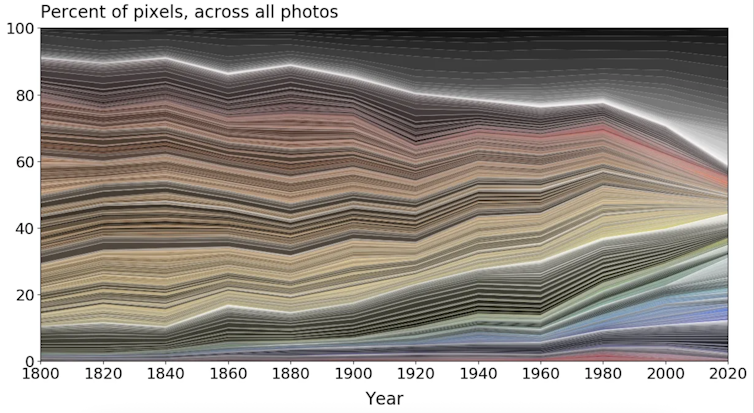

Des années de taux d’intérêt bas et de liquidités abondantes durant la pandémie ont gonflé les bilans des entreprises. Une large part de ces liquidités s’est dirigée vers le secteur technologique, en se concentrant sur ce que l’on appelle les « Sept Magnifiques » – Amazon, Alphabet, Meta, Apple, Microsoft, Nvidia et Tesla. Sans ces entreprises, la performance des marchés serait négative.

Cela ne traduit pas un véritable dynamisme technologique ; c’est le signe d’un capital concentré dans une poignée d’actifs surévalués, fonctionnant comme de l’« argent jeté dans la circulation sans base matérielle dans la production », qui circule sans ancrage dans l’activité économique réelle.

La conséquence est qu’une part moindre de l’investissement atteint l’« économie réelle », ce qui alimente la stagnation économique et la crise du coût de la vie – deux phénomènes largement masqués par l’indicateur du PIB.

Comment l’IA est devenue le dernier palliatif

Le géographe de l’économie David Harvey prolonge l’intuition de Marx avec la notion de « spatio-temporal fix », qu’on pourrait traduire par « correctif spatio-temporel », qui désigne la manière dont le capital résout provisoirement la stagnation en repoussant l’investissement dans le temps ou en s’étendant vers de nouveaux territoires.

La suraccumulation produit des excédents de travail, de capacités productives et de capital financier, qui ne peuvent être absorbés sans pertes. Ces excédents sont alors redirigés vers des projets de long terme, ce qui repousse les crises vers de nouveaux espaces et ouvre de nouvelles possibilités d’extraction.

Le boom de l’IA fonctionne à la fois comme un correctif temporel et un correctif spatial. Sur le plan temporel, il offre aux investisseurs des droits sur une rentabilité future qui pourrait ne jamais se matérialiser – ce que Marx appelait le « capital fictif ». Il s’agit d’une richesse qui apparaît dans les bilans alors qu’elle repose peu sur l’économie réelle, ancrée dans la production de biens.

Sur le plan spatial, l’extension des centres de données, des sites de fabrication de puces et des zones d’extraction minière nécessite des investissements matériels considérables. Ces projets absorbent du capital tout en dépendant de nouveaux territoires, de nouveaux marchés du travail et de nouvelles frontières de ressources. Mais comme le suggère l’aveu de Sam Altman, et alors que les mesures protectionnistes du président américain Donald Trump compliquent le commerce mondial, ces débouchés atteignent leurs limites.

Le coût du capital spéculatif

Les conséquences de la suraccumulation dépassent largement le seul monde des entreprises et des investisseurs. Elles se vivent socialement, et non de manière abstraite. Marx expliquait qu’une surproduction de capital correspond à une surproduction des moyens de production et des biens de première nécessité qui ne peuvent être utilisés aux taux d’exploitation existants.

Autrement dit, l’affaiblissement du pouvoir d’achat – ironiquement accéléré par l’essor de l’IA – empêche le capital de se valoriser au rythme auquel il est produit. Lorsque la rentabilité recule, l’économie résout ce déséquilibre en détruisant les moyens de subsistance des travailleurs et des ménages dont les retraites sont liées aux marchés financiers.

L’histoire offre des exemples frappants. L’éclatement de la bulle Internet a ruiné de petits investisseurs et concentré le pouvoir entre les mains des entreprises survivantes. La crise financière de 2008 a chassé des millions de personnes de leur logement tandis que les institutions financières étaient sauvées. Aujourd’hui, de grands gestionnaires d’actifs se couvrent déjà contre de possibles turbulences. Vanguard, par exemple, a opéré un net déplacement vers les obligations.

La spéculation comme moteur de la croissance

La bulle de l’IA est avant tout le symptôme de pressions structurelles, plus que le simple produit d’une dynamique technologique. Au début du XXᵉ siècle, l’économiste marxiste Rosa Luxemburg s’interrogeait déjà sur l’origine de la demande sans cesse croissante nécessaire à la reproduction élargie du capital.

Sa réponse fait écho à celles de Marx et de Harvey : lorsque les débouchés productifs se raréfient, le capital se déplace soit vers l’extérieur, soit vers la spéculation. Les États-Unis optent de plus en plus pour cette seconde voie. Les dépenses des entreprises dans les infrastructures d’IA contribuent désormais davantage à la croissance du PIB que la consommation des ménages, une inversion sans précédent qui montre à quel point la croissance actuelle repose sur l’investissement spéculatif plutôt que sur l’expansion productive.

Cette dynamique tire vers le bas le taux de profit et, lorsque le flux spéculatif s’inversera, la contraction suivra.

Les droits de douane resserrent l’étau sur le capital

L’inflation financière s’est accentuée à mesure que les soupapes traditionnelles permettant au capital de s’orienter vers de nouveaux marchés physiques ou géographiques se sont refermées.

Les droits de douane, les contrôles à l’exportation sur les semi-conducteurs et les mesures commerciales de rétorsion ont réduit l’espace mondial disponible pour les relocalisations. Comme le capital ne peut plus facilement échapper aux pressions structurelles de l’économie intérieure, il se tourne de plus en plus vers des outils financiers qui repoussent les pertes en refinançant la dette ou en gonflant les prix des actifs – des mécanismes qui accroissent finalement la fragilité lorsque l’heure des comptes arrive.

Le président de la Réserve fédérale des États-Unis Jerome Powell s’est dit favorable à d’éventuelles baisses des taux d’intérêt, signe d’un retour vers le crédit bon marché. En rendant l’emprunt moins coûteux, ces baisses permettent au capital de masquer ses pertes et d’alimenter de nouveaux cycles spéculatifs.

Marx a formulé cette logique dans son analyse du capital porteur d’intérêt, où la finance crée des droits sur une production future « au-delà de ce qui peut être réalisé sous forme de marchandises ». Il en résulte que les ménages sont poussés à s’endetter au-delà de ce qu’ils peuvent réellement supporter, échangeant ainsi une crise de stagnation contre une crise du crédit à la consommation.

Bulles et risques sociaux

Si la bulle de l’IA éclate alors que les gouvernements disposent de peu de marges pour redéployer les investissements à l’international et que l’économie repose sur un crédit de plus en plus fragile, les conséquences pourraient être lourdes.

Le capital ne disparaîtra pas mais se concentrera davantage dans les marchés obligataires et les instruments de crédit, gonflés par une banque centrale américaine désireuse de baisser les taux d’intérêt. Cela n’évite pas la crise ; cela en déplace simplement le coût vers le bas de l’échelle sociale.

Les bulles ne sont pas des accidents mais des mécanismes récurrents d’absorption du capital excédentaire. Si le protectionnisme de Trump continue de fermer les débouchés spatiaux et que les correctifs temporels reposent sur un endettement toujours plus risqué, le système s’oriente vers un cycle d’inflation des actifs, d’effondrement, puis de nouvelle intervention de l’État.

L’IA survivra, mais la bulle spéculative qui l’entoure est le symptôme d’un problème structurel plus profond – dont le coût, une fois pleinement révélé, pèsera avant tout sur les classes populaires.

Elliot Goodell Ugalde ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

12.01.2026 à 15:53

La Terre du Milieu de Tolkien, un lieu imaginaire pour repenser notre rapport à la nature

Texte intégral (2841 mots)

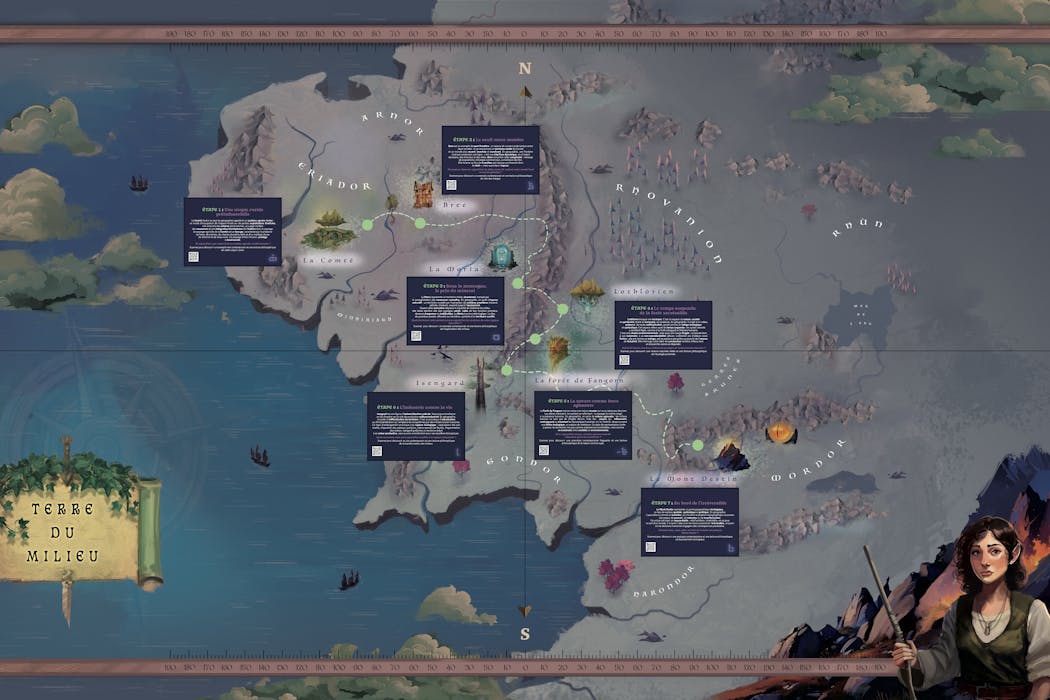

L’écrivain anglais J. R. R. Tolkien (1892-1973) était un cartographe de l’imaginaire. Dans le Seigneur des anneaux (1954-1955), il invente un monde dans lequel la frontière entre humanité et animalité est floue. Ses cartes de la Terre du Milieu construisent la cohérence spatiale et la densité narrative de la quête de la Communauté de l’anneau. Montagnes, forêts, rivières y constituent tantôt des épreuves spatiales, tantôt des espaces protecteurs ou de refuge. La géographie y structure le récit et façonne la fiction.

Les mondes imaginaires sont performatifs. Ils se nourrissent du réel dans une projection fictionnelle tout en l’interrogeant. Le Seigneur des anneaux n’y fait pas exception, nous invitant à réfléchir à nos liens avec la nature, à reconnaître sa valeur intrinsèque et à dépasser une conception dualiste opposant nature et culture, ne lui accordant qu’une valeur d’usage ou de ressource, à nous engager dans une éthique environnementale.

En suivant la Communauté, métissée, sur les chemins, parfois de traverse, les menant vers le mont Destin, nous sommes confrontés à différentes manières d’habiter et de transformer la nature : utopies rurales, zones industrieuses, refuges écologiques et lieux symboliques où des choix engagent l’avenir du monde. La fiction devient un outil pour questionner le réel, interroger nos pratiques et réfléchir aux enjeux environnementaux contemporains dans une ère désormais anthropocénique.

Habiter (avec) le monde : utopies rurales et résistance

La Comté repose sur un système agraire vivrier de polycultures fondé sur de petites exploitations familiales où le tabac réputé n’est que peu exporté. Les Hobbits vivent en autarcie et habitent littéralement une nature jardinée, dans des terriers. Le bocage, les prairies forment un maillage qui limite l’érosion et protège la biodiversité et organisent un territoire où nature et société coexistent harmonieusement. Cet idéal préindustriel s’éteint peu à peu dans le monde occidental moderne où une agriculture intensive et centralisée s’est imposée pour devenir norme sur un territoire remembré.

La forêt de Fangorn, elle, représente une nature qui résiste à la manière d’une zone à défendre (ZAD). Les Ents, gestionnaires du peuplement forestier, incarnent des arbres doués de parole, capables de révolte. Ils refusent la domination humaine fermant les sentiers d’accès avant de s’engager dans une guerre contre l’industrialisation menée par Saroumane en Isengard. Le chantier stoppé de l’autoroute A69 témoigne de la façon dont la nature peut parfois aujourd’hui par elle-même poser des limites aux projets d’aménagement voulus par l’humain.

La Lothlórien, enfin, symbolise une écotopie, un espace préservé du temps et des pressions humaines, où nature, société et spiritualité vivent en harmonie. La réserve intégrale de la forêt de la Massane, les forêts « sacrées » d’Afrique de l’Ouest ou celles du nord de la Grèce (massif du Pindes) font écho à cet idéal. Pensées comme des écosystèmes dont les dynamiques naturelles sont respectées et où l’intervention humaine contrôlée se fait discrète, elles permettent d’observer et de suivre les espèces, la régénération spontanée des habitats et leur résilience. Mais à l’image de la Lothlórien, un tel système de gestion reste spatialement rare, fragile. Il nécessite de construire la nature comme bien commun dont l’accès et l’usage sont acceptés par les communautés qui cohabitent avec ces espaces forestiers.

Ces trois types de territoires montrent qu’habiter le monde n’est pas simplement occuper, encore moins s’approprier, un espace de nature mais engager un dialogue avec lui, considérer qu’il a une valeur par lui-même, juste parce qu’il existe, et pas uniquement en tant que ressource. Il s’agit alors de cohabiter dans des interactions où chaque existant prend soin de l’autre.

Exploiter une nature ressource : de l’artificialisation à la destruction

La transformation des espaces de nature, comme le montre Tolkien, peut aussi répondre à une logique d’exploitation intensive, la nature offrant des ressources permettant d’asseoir la domination des humains sur la nature comme sur d’autres humains. Il ne s’agit plus d’envisager une cohabitation être humain/nature mais d’asservir la nature par la technique.

Isengard, le territoire de Saroumane au sud des monts Brumeux, contrôlé par la tour d’Orthanc, incarne la transformation radicale du milieu par et pour l’industrie ; une industrie dont la production d’Orques hybrides, sorte de transhumanisme appliqué à la sauvagerie, vise à renforcer le pouvoir de Saroumane et construire son armée pour prendre le contrôle d’autres territoires. La forêt est rasée, les fleuves détournés, le paysage mécanisé, dans l’unique but d’alimenter l’industrie. Les champs d’exploitation des schistes bitumineux en Amérique du Nord montrent à quel point l’exploitation de la nature peut détruire des paysages, polluer une nature qui devient impropre et dont les fonctions et services écosystémiques sont détruits).

La Moria, ancien royaume florissant du peuple Nain, est l’exemple de l’issue létale de la surexploitation d’une ressource naturelle. Si le mithril, minerai rare de très grande valeur a construit la puissance du royaume Nain, son exploitation sans cesse plus intense, vidant les profondeurs de la terre, va conduire à l’effondrement de la civilisation et à l’abandon de la Moria. Ce territoire minier en déshérence fait écho aux paysages des régions du Donbass par exemple, qui conservent aujourd’hui encore les traces visibles de décennies d’extraction charbonnière : galeries effondrées, sols instables et villes partiellement abandonnées.

Lieux de rupture et enjeux planétaires

On trouve enfin chez Tolkien une mise en scène d’espaces qui représentent des lieux de bascule pour l’intrigue et l’avenir du monde, en l’occurrence la Terre du Milieu.

Le « bourg-pont » de Bree, zone frontière matérialisée par une large rivière, marque la limite entre l’univers encore protégé, presque fermé, de la Comté et les territoires marchands de l’est, ouverts et instables. Mais Bree est aussi un carrefour dynamique, lieu d’échanges où circulent et se rencontrent des personnes, des biens et des récits. Un carrefour et une frontière où toutefois la tension et la surveillance de toutes les mobilités sont fortes.

Lieu de transition, symbolisant à la fois ouverture et fermeture territoriales, Bree est un point de bascule dans le récit où convergent et se confrontent des personnages clés de l’intrigue (les Hobbits, Aragorn, les cavaliers noirs de Sauron), les figures du Bien et du Mal autour desquelles vont se jouer l’avenir de la Terre du Milieu. Comme Bree, Calais est un point de friction entre un espace fermé (les frontières britanniques) et un espace ouvert où s’entremêlent société locale, logiques nationales et transnationales, mais où les circulations sont de plus en plus contrôlées.

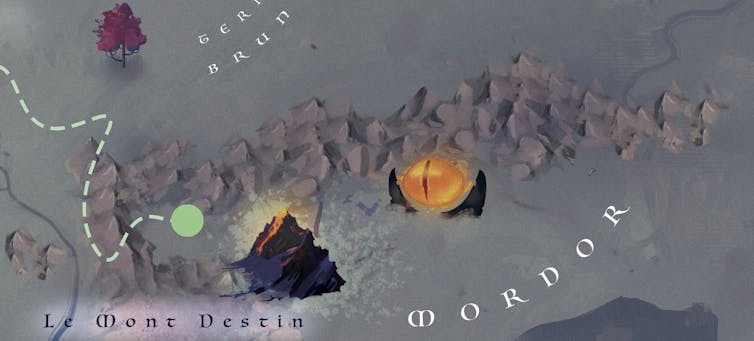

Enfin, la montagne du Destin, volcan actif, incarne le lieu de rupture ultime, celui où le choix d’un individu, garder l’anneau pour lui seul dans un désir de pouvoir total ou accepter de le détruire, a des conséquences majeures pour toute la Terre du Milieu. Certains espaces jouent un rôle similaire sur notre terre. La fonte du permafrost sibérien ou de l’inlandsis antarctique pourrait libérer d’immenses quantités de carbone pour l’un, d’eau douce pour l’autre, accélérant le dérèglement climatique et la submersion de terres habitées.

Ces lieux où des actions localisées peuvent déclencher des effets systémiques globaux, au-delà de tout contrôle, concentrent ainsi des enjeux critiques, écologiques, géopolitiques ou symboliques.

La fiction constitue un puissant vecteur de réflexion quant à notre responsabilité collective dans la gestion de la nature, quant à nos choix éthiques et politiques dans la manière d’habiter la Terre en tant que bien commun et ainsi éviter d’atteindre un point de bascule qui sera celui d’un non-retour.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

12.01.2026 à 12:02

Le microcrédit, un outil financier qui peut coûter cher aux femmes

Texte intégral (1352 mots)

Grâce au microcrédit, les femmes gagnent une plus grande indépendance financière et un pouvoir décisionnel dans leur activité professionnelle. Corollaires à ce progrès : le surendettement, les violences conjugales et… le suicide. Quelles sont les solutions pour limiter ces effets délétères ?

Cinquante ans après le lancement du microcrédit au Bangladesh, les femmes représentent aujourd’hui 80 % des bénéficiaires, mais en profitent-elles réellement ?

Pression de groupe pouvant entraîner des suicides, spirale de surendettement ou encore manque de contrôle des femmes sur l’utilisation des prêts… autant de dérives qui peuvent accroître la vulnérabilité des emprunteuses.

Dans un état de l’art que nous avons publié récemment, nous regardons l’impact réel du microcrédit sur les femmes. Le résultat n’est pas totalement en leur faveur.

Notre état de l’art s’appuie sur des travaux menés principalement dans des pays en développement, incluant l’Asie du Sud, l’Océanie et l’Afrique subsaharienne.

La pression des pairs

Comment fonctionne le prêt solidaire, outil le plus utilisé en microfinance ?

De petits groupes, composés de cinq à dix individus, empruntent ensemble. Si l’un des membres manque une échéance, les autres doivent avancer son dû. La pression des pairs assure le remboursement du prêt, mais elle déplace la charge sociale sur le groupe.

Cette pression peut être plus ou moins bien supportée. En Andhra Pradesh, un État de l’Inde, le cumul de dettes et des méthodes de recouvrement oppressives ont entraîné une vague de suicides, causant près de 80 morts en 2010. Malgré les mesures de régulation mises en place par les gouvernements et les institutions du secteur, des cas de suicides continuent d’être signalés. Il demeure difficile d’estimer régulièrement le nombre de décès liés au microcrédit, faute de données.

Un surendettement à la clé

Le manque d’accompagnement et d’éducation financière des emprunteurs et emprunteuses peuvent eux mener à l’échec de l’emprunt. Force est de constater que beaucoup de microcrédits financent de petites activités sur des marchés déjà saturés, où la probabilité de dégager un profit est faible.

Concrètement, il s’agit souvent d’activités à faible barrière à l’entrée mais très concurrentielles : petit commerce (vente de nourriture, fruits et légumes, vêtements), kiosques et revente sur marché, petite restauration, couture, etc. Sur des marchés locaux où de nombreuses personnes proposent des produits et des services similaires, la demande est rapidement « partagée ». Les marges sont faibles et les revenus restent volatils, ce qui limite la capacité à rembourser.

Face à cette situation, l’emprunteuse peut devoir contracter un nouveau prêt, l’exposant à un risque de surendettement.

Il peut s’agir d’un renouvellement, ou top-up, auprès de la même institution, d’un second microcrédit auprès d’une autre institution, ou d’un prêt informel (tontine, famille ou autre prêteur particulier). Ces prêts sont souvent de petits montants mais à remboursements fréquents. Leur coût peut être élevé, une fois les intérêts inclus. Le surendettement survient souvent lorsque le nouveau prêt sert à rembourser le précédent plutôt qu’à financer une activité rentable.

Qui décide de l’usage du prêt ?

Si, comme mentionné préalablement, la majorité des microcrédits sont accordés aux femmes, ces dernières n’ont pas forcément la maîtrise de l’argent obtenu qui revient à un parent ou un conjoint. Cela s’explique par les rapports de pouvoir au sein du ménage et des normes sociales, qui font de l’homme le décisionnaire principal du couple, surtout lorsqu’il s’agit d’argent.

Ce décalage entre celle qui paie et celui qui décide peut générer des tensions au sein du ménage. Dans certains contextes, l’accès au microcrédit peut même aller jusqu’à engendrer une hausse de la violence conjugale. Par exemple, à partir d’un échantillon national au Bangladesh, soit 4 163 femmes mariées, les chercheurs Nadine Shaanta Murshid, Ayse Akincigil et Allison Zippay concluent qu’avoir un microcrédit pour les femmes avec un meilleur statut économique est associé à une probabilité de 9 % de plus de subir de la violence domestique.

Prêter autrement ?

Pour limiter ces effets, des solutions existent.

Passer de la garantie de groupe à la responsabilité individuelle réduit la pression des pairs sans hausse des défauts. Au lieu qu’un « groupe solidaire » de 5 à 10 femmes soit collectivement responsable, chaque emprunteuse signe un contrat individuel et n’est responsable que de sa propre échéance. Pourquoi cela peut fonctionner ? Parce que la pression sociale du groupe peut pousser à rembourser même quand le prêt n’est pas rentable.

Proposer des microformations très pratiques en « règles de pouce », comme une formation d’une heure et demie maximum sur les bases de la gestion financière, peut contribuer à rendre les investissements profitables et limiter le risque de surendettement. Elles peuvent porter sur des gestes très concrets de gestion : séparer l’argent du ménage et celui de l’activité, tenir un mini-carnet quotidien des entrées et des sorties ou apprendre à calculer simplement des coûts, des prix et des marges pour identifier ce qui est réellement rentable.

Gérer l’emprunt directement sur les comptes personnels des emprunteuses, notamment via les comptes mobile money, donne aux femmes une autonomie financière effective. Elles reçoivent, paient et épargnent elles-mêmes, tout en réduisant le risque d’appropriation des fonds par un homologue masculin. Le prêt est versé sur le wallet mobile de l’emprunteuse, puis les remboursements se font depuis ce même compte ; cela rend plus difficile la « capture » immédiate en liquide par le conjoint et crée une traçabilité/contrôle directe des flux (réception, paiements fournisseurs, remboursement).

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

12.01.2026 à 12:02

À quoi servent les groupements d’employeurs ?

Texte intégral (1673 mots)

Quarante ans après leur naissance, les groupements d’employeurs restent relativement discrets. Pourtant, cette forme juridique originale peut être un puissant levier, notamment pour les (très) petites et moyennes entreprises, en leur donnant les moyens de recruter un salarié en commun. Revue de détail des services proposés par cet outil.

Les groupements d’employeurs ont été institués en France en 1985 afin de permettre aux petites et moyennes entreprises de se regrouper pour recruter de la main-d’œuvre. Malgré leur intérêt, ces structures souffrent d’un manque de reconnaissance car leurs vertus restent mal connues.

Constitués sous forme associative ou, plus rarement, sous le statut de société coopérative, les groupements d’employeurs (GE) permettent aux entreprises d’un même territoire de procéder à des embauches mutualisées. Les GE assurent le rôle d’employeur de salariés, dont le temps de travail est réparti le plus souvent entre deux ou trois entreprises adhérentes. Ils offrent ainsi une souplesse de fonctionnement à ces adhérents, qui disposent de compétences auxquelles ils n’auraient pas eu accès individuellement. Ils permettent aussi aux salariés de réaliser des missions diversifiées tout en bénéficiant d’un emploi à temps plein. Et à l’échelle des territoires, ils constituent un outil pour préserver des emplois et soutenir le dynamisme économique local.

Des structures peu visibles

35 ans après leur apparition, les GE restent cependant méconnus et insuffisamment utilisés. Alors que le tissu économique français est essentiellement constitué de TPE et de PME, les 5 000 GE environ que compte notre pays (dont 900 hors secteur agricole) ne représentent que 55 000 salariés (25 000 hors secteur agricole), selon les estimations réalisées par la DARES en 2021 et par le ministère de l’Agriculture en 2023.

Parmi les raisons avancées pour expliquer ce manque de popularité, le Conseil économique, social et environnemental (Cese) mentionne la pluralité des usages qui sont faits de ces structures, qui rend leur rôle peu lisible. Nous avons donc mené une recherche afin de les mettre en évidence.

S’adapter aux cycles d’activité

En premier lieu, les GE offrent à leurs adhérents la possibilité d’ajuster leurs recrutements aux cycles d’activité. Il s’agit là du rôle qui a présidé à leur création en 1985 : l’objectif était alors d’offrir un cadre légal aux pratiques, jusqu’alors informelles, de partage de personnel entre exploitants agricoles faisant face à un accroissement saisonnier de travail. De nos jours, ce type de recours aux GE s’est étendu à tout type d’entreprise dont l’activité est affectée par la saisonnalité, et en particulier à celles du secteur agroalimentaire.

À lire aussi : Qu’est-ce qu’un « bon employeur » ? Une approche par la notion d’« employeurabilité »

Les GE sont ainsi présents dans toutes les régions, avec des spécificités liées aux caractéristiques des territoires. À titre d’exemple, le GE “Côte Sud Emploi”, qui a été créé par et pour l’industrie agroalimentaire dans le département des Landes, a ainsi engagé des réflexions sur les complémentarités sectorielles en se positionnant également sur le thermalisme.

Mutualiser les compétences

L’usage des GE s’est progressivement étendu, puisqu’ils sont par la suite devenus une modalité stable de mutualisation des compétences. Ils permettent en effet aux PME qui en sont membres de bénéficier quelques jours par semaine de professionnels de fonctions support indispensables à la bonne conduite de leurs activités – marketing, communication, gestion des ressources humaines, hygiène et sécurité, etc.

L’intérêt pour les entreprises est ici de pouvoir bénéficier de compétences sur la durée, auxquelles elles n’auraient pas eu accès à titre individuel. Et les salariés apprécient eux aussi ce mode de recours aux GE, dans la mesure où ils peuvent ainsi acquérir de manière simultanée des expériences professionnelles diversifiées tout en bénéficiant d’un emploi stable.

Les emplois partagés proposés par le GE Mayage localisé dans le département de la Mayenne sont une bonne illustration de cette mutualisation de compétences. Le dirigeant d’une des entreprises adhérentes témoigne ainsi :

« Il y a trois ans, je cherchais à embaucher une personne pour la communication interne et externe de l’entreprise mais correspondant au volume d’une PME. Et Mayage a trouvé la personne qui, trois ans plus tard, est toujours au sein de l’entreprise. J’ai tous les avantages de la prestation sans avoir le salarié à ma charge puisque c’est Mayage qui s’occupe de tout. »

Accompagner la croissance

Un autre usage des GE est également apparu ces dernières années : leur rôle en matière d’accompagnement de la croissance. La croissance des entreprises nécessite en effet la structuration progressive de leur organisation, au travers de la mise en place de fonctions supports auxquelles les GE permettent d’accéder de manière facilitée.

Contrairement à la logique de mutualisation des compétences de long terme évoquée précédemment, il s’agit ici pour les entreprises adhérentes, dont l’activité est en plein essor, d’expérimenter momentanément le recours à des fonctions support à temps partagé, avant d’en disposer à temps plein en interne si leur croissance se poursuit. Les salariés peuvent quant à eux prendre leurs marques dans les entreprises d’accueil avant de les intégrer à temps plein. La TPE-PME bénéficie de la sorte d’un accompagnement à la croissance selon un principe de turn-over positif tel qu’il est qualifié au sein du réseau des GE. Biosupport, un GE francilien, souligne ainsi qu’« une dizaine de salariés passés au GE ont été au final embauchés par une entreprise adhérente ».

Pour les GE, les conséquences de ce rôle sont ambivalentes, dans la mesure où l’intégration à temps plein implique une diminution du maillage d’emplois. Si le turn-over positif devait être trop important, cela pourrait donc les mettre en difficulté économique. Mais, sur le temps long, cela traduit aussi la capacité des GE à créer des emplois sur le territoire.

Gérer la flexibilité

Si, historiquement, les GE ont été conçus pour accompagner des variations saisonnières d’activité, il s’avère qu’ils accompagnent désormais toutes les variations d’activité, à la hausse comme à la baisse. Les GE représentent ainsi une modalité de gestion de la flexibilité qui fait concurrence aux agences d’intérim.

Dans un contexte économique qui apparaît à l’heure actuelle plus tendu, certains GE font ainsi valoir auprès des dirigeants cette capacité à partager les risques. Le GE permet de gérer une crise en embauchant par exemple le salarié que l’entreprise est contrainte de licencier. Et dès la reprise d’activité, l’entreprise pourra à nouveau bénéficier de la compétence à temps plein. A l’automne 2025, le GE Hélys localisé à Rennes, présentait ainsi son offre aux dirigeants d’entreprise dont la situation économique est délicate :

« Nous pouvons permettre à une entreprise de se séparer administrativement d’un salarié, tout en continuant à bénéficier de ses compétences quelques jours par semaine en l’intégrant dans notre GE. Votre salarié devient le nôtre durant cette période de turbulence. Nous lui proposons un CDI. Nous complétons ensuite son temps de travail auprès d’autres adhérents pour lui permettre de conserver son niveau de vie. […] Et quand la tempête passe, vous pouvez réintégrer votre collaborateur. Vous savez tous le gain de temps et d’argent que cela représente versus le recrutement d’un nouveau profil. »

Vers une reconnaissance des GE ?

Au total, il s’avère que les usages des GE sont multiples, non mutuellement exclusifs, et vont bien au-delà de leur vocation originelle. En les clarifiant, nous espérons permettre aux GE, tout comme aux institutions qui les accompagnent, de communiquer plus précisément sur les services qu’ils proposent, et contribuer ainsi à accroître leur visibilité. À l’heure où les entreprises cherchent à concilier flexibilité et stabilité de l’emploi, les GE constituent une réponse originale encore trop méconnue.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

12.01.2026 à 12:01

Rihanna, Selena Gomez, Kylie Jenner : pourquoi la beauté est le nouvel eldorado des stars

Texte intégral (2033 mots)

Rihanna, Selena Gomez ou Kylie Jenner, ces dernières années les marques dans le secteur des cosmétiques créées ou co-fondées par des stars se sont multipliées. Mais pourquoi cet engouement particulier pour la beauté ?

Fenty Beauty, LolaVie, Blake Brown, Rare Beauty, Kylie Cosmetics, Rhode Skin ou Goop Beauty sont des marques de beauté et de soins capillaires qui ont toutes un point commun : celui d’avoir été lancées par une célébrité, comme Rihanna, Jennifer Aniston, Blake Lively, Selena Gomez, Kylie Jenner, Hailey Rhode Bieber et Gwyneth Paltrow.

Le personal branding, cette stratégie qui transforme le « moi » en image de marque unique que l’on peut valoriser sur la scène médiatique notamment, est d’autant plus pertinente dans le secteur des cosmétiques.

Alors pourquoi un tel engouement dans ce secteur et de ses consommateurs ?

Effet lipstick

Le marché des cosmétiques aurait générer en 2025 un chiffre d’affaires de 677 milliards de dollars, soit 574 milliards d’euros.

L’intérêt des célébrités pour la beauté n’est pas seulement une question d’image, il est également dicté par une logique économique. Les stars ont rapidement compris qu’en lançant leur propre marque, leur notoriété permettrait de réduire la lenteur de ce processus et d’amorcer une monétisation rapide de leur entreprise. La célébrité agit comme un puissant catalyseur marketing.

Historiquement, le secteur des cosmétiques est résilient aux crises, ce que les chercheurs nomment « effet lipstick ». Ce dernier explique comment les consommateurs, en période de crises économiques, réduisent les dépenses importantes, telles que l’achat de voiture ou les voyages, pour s’offrir des produits de luxe abordables, comme un rouge à lèvres.

Cette stabilité du marché de la beauté garantit un revenu sûr pour les marques de stars. Il offre des marges brutes élevées et peut encore croître de 100 milliards selon le patron de L’Oréal, Nicolas Hieronimus.

Le coût de production étant faible par rapport au prix de vente, et l’absence des contraintes logistiques, comme les collections de saisons, permettent un faible coût d’entrée et une gestion des stocks simplifiée.

Transférer les attributs positifs de la star

La célébrité qui endosse une marque est définie comme un individu jouissant d’une forte reconnaissance publique qui appose son image sur une marque par le biais d’un contrat publicitaire. Cette approche vise à transférer les attributs positifs de la star vers la marque, facilitant l’identification du message par le consommateur.

Depuis une dizaine d’années, ce qu’on appelle le self-branding for entrepreneurial prend une nouvelle ampleur avec l’avènement des réseaux sociaux. La célébrité devient cheffe d’entreprise et créée sa propre marque. La star n’est plus une simple ambassadrice : elle devient actionnaire, co-fondatrice ou propriétaire d’une marque.

C’est le cas de la comédienne Jennifer Aniston avec sa marque de soins capillaires LolaVie. L’actrice ne se contente pas de poser pour sa marque mais partage elle-même des vidéos de shooting sur les réseaux sociaux. Elle se met en scène en utilisant les produits et va jusqu’à poster des vidéos d’elle coiffant sa meilleure amie, l’actrice Courtney Cox, ou encore son petit ami Jim Curtis.

Jennifer Aniston fait preuve d’authenticité en exposant son intimité et en prenant à contre-pied l’image distante et éloignée de la réalité que peut avoir une célébrité. Elle renforce cette idée en utilisant l’humour dans son spot publicitaire « No Gimmicks » (« Pas d’artifices »).

Contre la beauté toxique

Le succès des marques de beauté fondées par des célébrités s’explique par la disruption stratégique mise en place. Des marques, comme Fenty Beauty, ont été pionnières en prouvant que l’inclusion ethnique avec plus de 40 teintes de fonds de teint proposées n’était pas un simple geste éthique mais une stratégie économique gagnante. « Fenty Beauty est une marque à 360 degrés qui s’adresse autant à une Coréenne qu’à une Irlandaise ou à une Afro-Américaine », décrypte Lionel Durand, patron de l’entreprise Black Up.

Dans la foulée, la marque Rare Beauty a élargi cette notion à l’inclusion émotionnelle, utilisant l’authenticité du discours de sa fondatrice concernant la santé mentale pour rejeter les normes de beauté toxiques. Selena Gomez n’ayant jamais caché sa bipolarité a choisi pour sa marque le slogan « Love Your Rare » (« Aimez votre rareté ») et a créé sa fondation Rare Impact Fund consacrée à cette thématique. Elle capitalise sur une communauté fidèle et engagée, là où d’autres marques valorisent essentiellement la perfection en termes de beauté.

Ces stars utilisent leurs réseaux sociaux comme laboratoires narratifs où elles construisent la crédibilité de leur marque à travers des récits personnels simples, de travail et de passion. Les produits de beauté ont un avantage : ils sont désirables et mobilisent l’attention surtout s’ils sont mis en avant par une célébrité.

Les vidéos Instagram ou TikTok à l’ère du marketing de contenu permettent aux célébrités d’échanger et d’atteindre rapidement leur public. Leurs produits deviennent une extension d’elles-mêmes, des objets identitaires au même titre que la mode ou la musique. La marque bio Goop, de Gwyneth Paltrow, est une ode à son lifestyle. Sur la plateforme TikTok, elle vend ses créations comme des produits skincare, de maquillage ou une ligne de vêtements. L’actrice a développé un empire autour de la mouvance New Age.

Marqueur social

Les marques des célébrités deviennent un marqueur social, une manière de prolonger l’univers de la star dans le quotidien des consommateurs. En 2025, on assiste à la continuité de cette tendance. L’année aura été marquée par des extensions de gammes pour Rhode et Rare Beauty, mais aussi par de nouveaux lancements de marques comme les parfums de Bella Hadid, Orebella, ou la gamme de soins Dua, de Dua Lipa.

Le succès de la marque continue de reposer sur la capacité de la célébrité-entrepreneure à projeter une authenticité perçue et une implication réelle. En face, se trouve un consommateur certes sensible aux réseaux sociaux, mais qui peut s’avérer résistant à certaines manœuvres marketing.

Si la célébrité paraît opportuniste ou déconnectée du produit, la légitimité s’effondre. Tel fut le cas pour Meghan Markle au moment du lancement de sa marque lifestyle, As Ever, de produits alimentaires, bougies et vins. Les critiques ont fusé, l’accusant de peu de professionnalisme, de capitaliser uniquement sur sa notoriété et sur son statut de duchesse de Sussex.

Des marques à durée limitée ?

Les produits de beauté ne sont qu’un exemple de la diversification entrepreneuriale des célébrités. Nombreuses sont les stars qui se tournent vers des marchés où le capital image est essentiel et où le taux de renouvellement des produits est élevé.

C’est le cas du secteur de l’alcool qui offre une marge élevée et une connexion directe avec les fans. L’actrice Cameron Diaz a co-fondé une marque de vin bio et vegan qu’elle a nommé Avaline. Le rappeur Jay Z possède sa maison de champagne, Armand de Brignac.

Le phénomène de la célébrité-entrepreneure révèle une nouvelle dynamique, celle de la marque personnelle. Dès lors, la question qui se pose n’est plus la performance initiale mais la vision stratégique à long terme. Cette hyper-accélération du succès, rendue possible essentiellement par la notoriété, leur permet-elle de devenir des marques à part entière, et non de simples prolongements de la célébrité ?

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

12.01.2026 à 12:01

Faut-il, comme EDF, interdire toute consommation d’alcool dans le monde professionnel ?

Texte intégral (1833 mots)

EDF a indiqué interdire la consommation d’alcool sur le lieu de travail et dans les repas d’affaires. Cette décision est-elle compatible avec la liberté individuelle ? Peut-elle ou doit-elle s’appliquer dans d’autres entreprises, notamment au nom de la lutte contre les addictions et de la garantie de la sécurité du personnel ?

Dès ce mois de janvier, les salariés d’EDF n’ont plus le droit de consommer d’alcool au travail ni lors d’événements organisés par leur employeur à l’extérieur.

Cette mesure, encadrée par l’article R4228-20 du Code du travail, questionne l’équilibre entre prévention des risques (addictions, comportements inappropriés, accidents du travail), libertés individuelles et préservation des rites qui constituent la culture d’entreprise.

Cette décision très médiatisée intervient dans un contexte où la prévention des risques professionnels et des accidents du travail est au centre du débat public.

Cette décision s’inscrit dans un cadre réglementaire existant et une jurisprudence constante. Cette décision n’a donc rien de bien surprenant.

Protéger la santé et la sécurité

L’organisation d’événements festifs ponctue la vie de l’entreprise. Ces moments supposés conviviaux à l’initiative de l’employeur, du comité social et économique (CSE) ou de certains salariés, contribuent à produire une meilleure cohésion des équipes et au maintien de la culture d’entreprise.

Parfois, l’alcool s’invite dans ces temps collectifs, à l’intersection de la vie professionnelle et personnelle… Il ne suffit pas que la réunion ait lieu en dehors de l’entreprise pour exonérer l’employeur de toute responsabilité. S’il en est à l’initiative, celle-ci reste sous sa responsabilité. La consommation d’alcool sur le lieu de travail comporte cependant de nombreux risques et, à ce titre, est très fortement encadrée en France.

Ainsi, l’article R4228-20 du Code du travail précise qu’« aucune boisson alcoolisée autre que le vin, la bière, le cidre et le poiré n’est autorisée sur le lieu de travail ». Si la consommation de boissons alcoolisées est susceptible de porter atteinte à la sécurité et à la santé physique et mentale des travailleurs, l’employeur, en application de l’article L. 4121-1 du Code du travail doit en restreindre l’usage. Cet article dispose que « l’employeur prend les mesures nécessaires pour assurer la sécurité et protéger la santé physique et mentale des travailleurs ».

L’employeur est soumis non pas à une obligation de résultat mais à une obligation de moyens renforcés (Cour de cassation, chambre sociale, 25 novembre 2015, no 14-24.444, Air France).

Règlement intérieur ou note de service ?

L’employeur peut aussi le prévoir dans le règlement intérieur – obligatoire dans les entreprises d’au moins 50 salariés. En effet, ce document fixe les règles de la vie en entreprise et notamment celles relatives à la discipline, la nature et l’échelle des sanctions. À défaut, l’employeur peut l’indiquer par l’intermédiaire d’une note de service reprenant les mesures prises pour protéger la santé et la sécurité des travailleurs et de prévenir tout risque d’accident.

Ces mesures, qui peuvent notamment prendre la forme d’une limitation voire d’une interdiction de consommation d’alcool, doivent être proportionnées au but recherché. Ainsi, l’employeur, en vertu de son pouvoir de direction, peut donc purement et simplement interdire la consommation d’alcool au sein de l’entreprise en invoquant cette obligation de sécurité. Cela lui permet de répondre à l’obligation de moyens renforcés.

Une sanction pouvant aller jusqu’au licenciement peut alors être prononcée à l’encontre des collaborateurs en cas de non-respect, si elle prévue dans le règlement intérieur.

À titre d’exemple, une clause d’un règlement intérieur précise :

« L’introduction, la distribution et/ou la consommation de toute boisson alcoolisée sur le lieu de travail (bureaux, chantiers…) sont interdites, à l’exception des dispositions prévues par l’article R. 4228-20 du Code du travail et uniquement lors des repas en dehors du temps de travail. Cette consommation devra l’être dans des quantités raisonnables de manière à ne pas altérer les capacités à occuper son emploi et/ou à être en mesure de conduire un véhicule, notamment pour regagner son domicile. L’introduction, la distribution et la consommation de produits stupéfiants dans les locaux de travail sont en outre strictement interdits. »

Le danger des pratiques addictives

Par ailleurs, l’employeur – qui est tenu d’identifier et de répertorier les risques dans le document unique d’évaluation des risques professionnels (DUERP) – doit tenir compte des pratiques potentiellement addictives (consommation d’alcool mais aussi de drogues). En effet, les pratiques addictives concernent de nombreux salariés, quels que soient le secteur d’activité ou la catégorie socioprofessionnelle.

Ces consommations, occasionnelles ou répétées, comportent des risques pour la santé et la sécurité des salariés. Il est donc nécessaire d’inscrire le risque lié aux pratiques addictives dans ce document unique (article R. 4121-1 du Code du travail).

Ce document est tenu à la disposition des salariés, des anciens salariés, des membres du comité social et économique, du médecin du travail, de l’agent de contrôle de l’inspection du travail et des agents des Carsat (article R4121-4 du Code du travail).

Interdire en préservant les libertés individuelles

En cas de consommation abusive d’alcool, le salarié pourrait avoir un accident dans l’entreprise ou en rentrant chez lui après un repas d’entreprise par exemple. L’employeur engagerait alors sa responsabilité dans le cadre de l’obligation de sécurité et pourrait être condamné. On pense par exemple à un accident automobile pour un commercial. De son côté, le salarié pourrait également être reconnu responsable.

Ainsi, le 10 avril 2024 (RG no 21/06884), la Cour d’appel de Rennes a statué sur la réalité d’un accident du travail dont l’origine était la consommation d’alcool par un salarié au temps et au lieu du travail. Un chauffeur alcoolisé chargeait un engin de chantier qui a basculé sur lui ; accident des suites duquel il est malheureusement décédé. À noter que les restrictions relatives à l’alcool sont par ailleurs souvent accompagnées de restrictions relatives aux stupéfiants.

Comment contrôler ?

Ainsi, le cadre légal dont relèvent les conduites addictives en entreprise est complexe, car il doit concilier l’obligation de sécurité avec le respect des droits fondamentaux de l’employé (article L.1121-1 du Code du travail).

L’employeur peut ainsi recourir au contrôle de l’alcoolémie sous réserve du respect de certaines dispositions. Le contrôle par éthylotest ne doit pas être systématique. Il doit être justifié par des raisons de sécurité et ne doit concerner que les salariés dont les fonctions sont de nature à exposer les personnes ou les biens à un danger. Ainsi, la liste des postes pour lesquels un dépistage est possible doit être prévue dans le réglement intérieur.

La restriction doit cependant être proportionnée au but recherché et doit permettre de protéger les intérêts légitimes de l’entreprise. Par exemple, dans un entrepôt où travaillent des caristes (conducteurs de petits véhicules de manutention), il est légitime d’interdire complètement l’alcool, dont la consommation pourrait altérer les réflexes des salariés et produire des accidents. L’usage de substances psychoactives sur le lieu de travail, ou avant la prise de poste, augmente le risque d’accidents du travail, d’erreurs humaines et de comportements inadaptés, notamment dans les secteurs nécessitant de la vigilance ou la manipulation de machines.

Dégradation du climat social

Les conduites addictives peuvent également dégrader le climat social en entreprise. Elles peuvent générer des tensions entre collègues, créer des situations de conflit ou d’incompréhension, et altérer la cohésion des équipes, impacter négativement la productivité et la qualité du travail, augmenter l’absentéisme et les retards, causer des soucis de santé et de gestion des aptitudes.

Au-delà de la dimension juridique liée aux risques humains et de contentieux, la consommation d’alcool ou de drogues est également un enjeu managérial. En effet, la stigmatisation des personnes concernées et le tabou entourant la consommation de substances addictives peuvent freiner la détection et la prise en charge des situations à risques, conduisant à une marginalisation des salariés concernés. Les managers et les services RH doivent apprendre à détecter les signaux faibles. Le recours à la médecine du travail est également indispensable. Information et formations sont importantes dans une stratégie de prévention.

Caroline Diard ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

11.01.2026 à 15:44

L’avenir de l’impression 3D passera par les matériaux

Texte intégral (2079 mots)

Qu’il s’agisse de pièces de fusée, d’automobile, de pont ou même d’aliments, la fabrication additive (FA) redéfinit complètement le champ des possibles dans de très nombreux domaines d’activités. Elle offre des perspectives prometteuses en matière de matériaux, mais elle pose également des défis techniques, économiques et environnementaux qui nécessitent une maturation et une adaptation des procédés en lien avec les matériaux utilisés.

Plus connu sous la dénomination « impression 3D », ce procédé met en œuvre des polymères (plastiques) ou des alliages métalliques pour fabriquer des objets du quotidien. Les imprimantes 3D polymères sont accessibles au grand public pour quelques centaines d’euros. Elles permettent notamment de fabriquer des pièces prototypes (d’où le nom prototypage rapide), des coques de téléphone, des pièces de rechange, des prothèses, des bijoux, des jouets, des objets de décorations ou des maquettes. En ce qui concerne les métaux, les machines d’impression sont beaucoup plus chères (quelques centaines de milliers d’euros). On trouve des applications telles que des implants médicaux, des pièces aérospatiales/automobiles, de l’outillage industriel, des bijoux de luxe. On peut également trouver ce principe de fabrication dans le domaine du BTP avec des « imprimantes » qui mettent en œuvre du béton pour fabriquer des maisons, des bâtiments ou tout type de structure en génie civil.

Mais, comme toute nouveauté, le procédé suscite autant d’espoir qu’il ne réserve de surprises (bonnes ou mauvaises) à celles et ceux qui souhaitent utiliser ce nouveau moyen de fabrication.

D’un point de vue technique, l’impression 3D consiste, couche après couche, à durcir (polymériser) une résine liquide ou à venir déposer de la matière (plastique ou métallique) de manière précise et contrôlée (en ajustant les paramètres tels que la température, la vitesse d’impression, le taux de remplissage, l’orientation de l’objet) pour répondre à certaines contraintes de géométrie, poids, optimisation des propriétés mécaniques ou physiques.

La microstructure d’une pièce imprimée en 3D (polymère ou métal) désigne l’organisation interne de sa matière à une échelle microscopique, influencée par le procédé d’impression. La complexité de la géométrie, les dimensions, le prix vont conditionner le choix de la technologie d’impression et des matériaux associés.

Une révolution dans de nombreux domaines industriels

Qu’elle soit alternative ou complémentaire des techniques conventionnelles par enlèvement de matière ou par déformation, la FA révolutionne de nombreux domaines industriels. De la réalisation de pièces monolithiques (en une seule étape de fabrication, sans assemblage) à forte valeur ajoutée à la fonctionnalisation (conférer à la pièce certaines propriétés locales en changeant les paramètres d’impression au besoin), en passant par le prototypage rapide (valider la conception d’une pièce prototype de manière itérative), les possibilités sont multiples. On peut citer notamment des prothèses de hanche en titane adaptées à l’anatomie de chaque patient, des injecteurs de fusée à géométrie complexe et fabriquées en une seule pièce, des moules optimisés avec canaux de refroidissement sur mesure, des bijoux en métaux précieux avec des designs impossibles à obtenir avec des moyens d’usinage conventionnels.

La chaîne de valeurs de la FA – qui définit l’ensemble des étapes de réalisation d’une pièce de l’approvisionnement en matière première, à la conception, aux conditions de mise en œuvre, à la fabrication, au coût énergétique, à la reprise d’usinage, aux opérations de parachèvement, à la qualification de la santé matière, à la caractérisation des propriétés physiques, au recyclage – est cependant plus complexe et potentiellement plus onéreuse. La technicité, oui, mais pas à n’importe quel prix ! Outre les moyens de fabrication spécifiques sur lesquels elle repose, elle nécessite des règles de conception fondamentalement différentes car elle impose de nouvelles contraintes techniques. De la Conception Assistée par Ordinateur, au choix matériau, au programme machine et à l’industrialisation, il faut ainsi redéfinir complètement la manière de penser du cahier des charges à la maintenance des produits issus de la FA.

Des enjeux majeurs pour les matériaux

Un des points fondamentaux du développement de ces nouveaux procédés réside dans la compréhension du lien entre les paramètres de fabrication des pièces (temps d’impression, puissance du laser, vitesse de déplacement de la tête d’impression, dimensions, environnement de travail – sous atmosphère contrôlée ou non), leur santé matière (présence de porosités ou de défauts parfois liés à un manque de fusion/gazéification locaux de la matière) et leurs propriétés physiques (conductivité thermique ou électrique, propriétés mécaniques, densité). Autrement dit, il est nécessaire de fiabiliser les procédés et optimiser les propriétés finales de la pièce en étant capable de contrôler des paramètres de fabrication, lesquels vont beaucoup dépendre des matériaux mis en œuvre. Ainsi, la FA présente des enjeux majeurs pour les matériaux, qu’ils soient techniques, économiques ou environnementaux.

Tout d’abord, les procédés de FA nécessitent de développer, en amont, des matériaux adaptés (filaments, poudres) aux spécificités des procédés (fusion laser, dépôt de matière fondue, alimentation en matière des têtes d’impression), lesquels vont imposer des contraintes en termes de prix, toxicité et recyclabilité. En effet, les poudres métalliques ou polymères spécifiques (de type thermoplastique) dédiées à la fabrication additive restent souvent plus coûteuses que les matériaux conventionnels, d’un facteur 10 environ.

Néanmoins, malgré le coût plus élevé des matériaux et des procédés, l’impression 3D réduit les déchets (pas de copeaux comme en usinage), permet de fabriquer des pièces dont la géométrie est optimisée (allègement des structures) et élimine le besoin de moules coûteux pour les petites séries, ce qui peut compenser l’écart de coût pour des pièces à forte valeur ajoutée. Ainsi, la réduction des coûts est un enjeu clé pour une adoption plus large. De plus, l’approvisionnement en matière première peut être limité, ce qui ralentit le développement des applications industrielles.

La FA permet également de faire de l’hybridation en associant différents types de matériaux lors de l’impression (en utilisant plusieurs têtes d’impression) afin d’obtenir des pièces composites dont les propriétés mécaniques, électriques ou thermiques sont spécifiques. Par exemple, dans l’industrie aérospatiale ou l’automobile, l’impression 3D de pièces comme des moules d’injection ou des échangeurs thermiques avec des canaux de refroidissement complexes intégrés – lesquels sont impossibles à réaliser par usinage classique – permettent d’optimiser la dissipation thermique, améliorant l’efficacité et la longévité de la pièce.

Les procédés de FA permettent également d’imprimer des structures arborescentes (bio-mimétisme) obtenues via des outils d’optimisation topologique qui est une méthode de conception avancée qui utilise des algorithmes pour déterminer la forme optimale d’une structure en fonction de contraintes spécifiques, telles que la résistance, le poids, ou la distribution des efforts. La spécificité de l’impression 3D réside aussi dans la possibilité de produire des structures complexes de type treillis ou architecturées pour fonctionnaliser le matériau (propriétés mécaniques sur mesure, réduction de la masse, diminution des coûts de fabrication, isolation thermique, acoustique, absorption des chocs ou des vibrations).

Fusion de matière

Quand les pièces sont imprimées, il existe – selon le procédé de fabrication – des opérations dites de parachèvement qui consistent à finaliser les pièces. Cela inclut l’usinage des supports de conformage (qui sont comme des échafaudages qui supportent la pièce lors de la fabrication couche par couche), la reprise d’usinage des surfaces (ou polissage) pour améliorer l’état de surface (quand cela est possible) en raison de la rugosité importante des pièces brutes. On peut également réaliser des traitements thermiques pour homogénéiser la microstructure (pièces métalliques) ou de compression à chaud pour limiter le taux de porosités (un des inconvénients majeurs de l’impression 3D). Ces opérations sont fondamentales, car la rugosité de surface et le taux de porosités sont les caractéristiques les plus critiques du point de vue du comportement mécanique. Par ailleurs, quand il s’agit de procédés à base de poudres, il est nécessaire de dépoudrer les pièces pour évacuer le surplus de matière, lequel peut nuire au fonctionnement en service de la pièce ainsi fabriquée.

Par nature, la majorité des procédés de FA impliquent la fusion de matière (plastique ou métallique), ce qui va se traduire par des échauffements localisés et des différences de température très importants au sein de la pièce. Ces gradients thermiques vont conditionner la microstructure, la présence de contraintes internes (en lien avec la microstructure), la santé (présence de défauts), l’anisotropie (les propriétés ne sont pas les mêmes dans toutes les directions) et l’hétérogénéité (les propriétés ne sont pas les mêmes en tout point) des pièces. La fiabilité des pièces imprimées va donc beaucoup dépendre de ces caractéristiques.

En amont, il est alors important d’étudier les interactions entre procédés-microstructure et propriétés mécaniques pour différents types de matériaux. C’est l’objet de nos travaux de recherche menés à l’INSA Rouen Normandie. Pour les polymères, l’impression 3D par dépôt de filament fondu (FFF) présente une porosité intrinsèque qui réduit la résistance à la rupture. En utilisant des procédés tels que le laser shock peening (LSP), un traitement mécanique in situ appliqué à certaines couches pendant l’impression, on peut alors faire de la fonctionnalisation en réduisant localement la porosité et en créant des barrières ralentissant la propagation des fissures, améliorant ainsi la ténacité des matériaux (la résistance à la fissuration du matériau). De manière similaire, pour les alliages métalliques obtenus par Fusion sur Lit de Poudre, en jouant sur les paramètres de fabrication (puissance et vitesse de déplacement du laser notamment), il est possible d’ajuster localement les propriétés du matériau pour moduler sa ténacité ou sa capacité à se déformer plastiquement.*

Aussi, il est nécessaire de caractériser précisément – en aval de la fabrication – les propriétés (thermiques, électriques, mécaniques) des pièces en accord avec les normes de certification propres aux différents domaines d’activité (médical, aéronautique, aérospatiale, automobile, agro-alimentaire).

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

11.01.2026 à 15:42

Groenland : rester avec les Inuit polaires

Texte intégral (2848 mots)

En juin 1951, l’explorateur Jean Malaurie voit surgir de la toundra une immense base militaire américaine, bâtie dans le secret le plus total. Ce choc marque pour lui le début d’un basculement irréversible pour les sociétés inuit. Aujourd’hui, alors que le Groenland redevient un enjeu stratégique mondial, l’histoire semble se répéter. Rester avec les Inuit polaires, c’est refuser de parler de territoires en oubliant ceux qui les habitent.

Le 16 juin 1951, l’explorateur français Jean Malaurie progresse en traîneaux à chiens sur la côte nord-ouest du Groenland. Il est parti seul, sur un coup de tête, avec un maigre pécule du CNRS, officiellement pour travailler sur les paysages périglaciaires. En réalité, cette rencontre avec des peuples dont la relation au monde était d’une autre nature allait forger un destin singulier.

Ce jour-là, après de longs mois d’isolement parmi les Inuit, au moment critique du dégel, Malaurie avance avec quelques chasseurs. Il est épuisé, sale, amaigri. L’un des Inuit lui touche l’épaule : « Takou, regarde » Un épais nuage jaune monte au ciel. À la longue-vue, Malaurie croit d’abord à un mirage : « une cité de hangars et de tentes, de tôles et d’aluminium, éblouissante au soleil dans la fumée et la poussière […] Il y a trois mois, la vallée était calme et vide d’hommes. J’avais planté ma tente, un jour clair de l’été dernier, dans une toundra fleurie et virginale. »

Le souffle de cette ville nouvelle, écrira-t-il, « ne nous lâchera plus ». Les excavatrices tentaculaires raclent la terre, les camions vomissent les gravats à la mer, les avions virevoltent. Malaurie est projeté de l’âge de pierre à l’âge de l’atome. Il vient de découvrir la base secrète américaine de Thulé, nom de code Operation Blue Jay. L’un des projets de construction militaire les plus massifs et les plus rapides de l’histoire des États-Unis.

Sous ce nom anodin se cache une logistique pharaonique. Les États-Unis redoutent une attaque nucléaire soviétique par la route polaire. En un seul été, quelque 120 navires et 12 000 hommes sont mobilisés dans une baie qui n’avait connu jusque-là que le glissement silencieux des kayaks. Le Groenland ne comptait alors qu’environ 23 000 habitants. En 104 jours, sur un sol gelé en permanence, surgit une cité technologique capable d’accueillir les bombardiers géants B-36, porteurs d’ogives nucléaires. À plus de 1 200 kilomètres au nord du cercle polaire, dans un secret presque total, les États-Unis font surgir l’une des plus grandes bases militaires jamais construites hors de leur territoire continental. Un accord de défense est signé avec le Danemark au printemps 1951, mais l’Operation Blue Jay est déjà engagée : la décision américaine a été prise dès 1950.

L’annexion de l’univers Inuit

Malaurie comprend aussitôt que la démesure de l’opération signe, de fait, une annexion de l’univers Inuit. Un monde fondé sur la vitesse, la machine, l’accumulation vient de pénétrer brutalement, aveuglément, un espace réglé par la tradition, le cycle, la chasse et l’attente.

Le geai bleu est un oiseau bruyant, agressif, extrêmement territorial. La base de Thulé se situe à mi-chemin entre Washington et Moscou par la route polaire. À l’heure des missiles hypersoniques intercontinentaux, hier soviétiques, aujourd’hui russes, c’est cette même géographie qui fonde encore l’argument du « besoin impérieux » invoqué par Donald Trump dans son désir d’annexion du Groenland.

Le résultat immédiat le plus tragique de l’Opération Blue Jay ne fut pas militaire, mais humain. En 1953, pour sécuriser le périmètre de la base et de ses radars, les autorités décidèrent de déplacer l’ensemble de la population inughuit locale vers Qaanaaq, à une centaine de kilomètres plus au nord. Le déplacement fut rapide, contraint, sans consultation, brisant le lien organique entre ce peuple et ses territoires de chasse ancestraux. Un “peuple racine” déraciné pour faire place à une piste d’aviation.

C’est sur ce moment de bascule foudroyante que Malaurie situe l’effondrement des sociétés traditionnelles inuit, où la chasse n’est pas une technique de survie mais un principe organisateur du monde social. L’univers inuit est une économie du sens, faite de relations, de gestes et de transmissions, qui donnent à chacun reconnaissance, rôle et place. Cette cohérence intime, qui fait la force de ces sociétés, les rend aussi extrêmement vulnérables lorsqu’un système extérieur en détruit soudainement les fondements territoriaux et symboliques.

Conséquences de l’effondrement des structures traditionnelles

Aujourd’hui, la société groenlandaise est largement sédentarisée et urbanisée. Plus du tiers des 56 500 habitants vit à Nuuk, la capitale, et la quasi-totalité de la population réside désormais dans des villes et localités côtières sédentarisées. L’habitat reflète cette transition brutale. Dans les grandes villes, une part importante de la population occupe des immeubles collectifs en béton, construits pour beaucoup dans les années 1960 et 1970, souvent vétustes et suroccupées. L’économie repose largement sur une pêche industrielle tournée vers l’exportation. La chasse et la pêche de subsistance persistent. Fusils modernes, GPS, motoneiges, connexions satellitaires accompagnent désormais les gestes anciens. La chasse demeure un repère identitaire, mais elle ne structure plus ni l’économie ni la transmission.

Les conséquences humaines de cette rupture sont massives. Le Groenland présente aujourd’hui l’un des taux de suicide les plus élevés au monde, en particulier chez les jeunes hommes inuit. Les indicateurs sociaux contemporains du Groenland - taux de suicide, alcoolisme, violences intrafamiliales – sont largement documentés. De nombreux travaux les relient à la rapidité des transformations sociales, à la sédentarisation et à la rupture des transmissions traditionnelles.

Revenons à Thulé. L’immense projet secret engagé au début des années 1950 n’avait rien de provisoire. Radars, pistes, tours radio, hôpital : Thulé devient une ville stratégique totale. Pour Malaurie, l’homme du harpon est condamné. Non par une faute morale, mais par une collision de systèmes. Il met en garde contre une européanisation qui ne serait qu’une civilisation de tôle émaillée, matériellement confortable, humainement appauvrie. Le danger n’est pas dans l’irruption de la modernité, mais dans l’avènement, sans transition, d’une modernité sans intériorité, opérant sur des terres habitées comme si elles étaient vierges, répétant, à cinq siècles d’écart, l’histoire coloniale des Amériques.

Espaces et contaminations radioactives

Le 21 janvier 1968, cette logique atteint un point de non-retour. Un bombardier B-52G de l’US Air Force, engagé dans une mission permanente d’alerte nucléaire du dispositif Chrome Dome, s’écrase sur la banquise à une dizaine de kilomètres de Thulé. Il transporte quatre bombes thermonucléaires. Les explosifs conventionnels des bombes nucléaires, destinés à amorcer la réaction, détonnent à l’impact. Il n’y a pas d’explosion nucléaire, mais la déflagration disperse sur une vaste zone du plutonium, de l’uranium, de l’americium et du tritium.

Dans les jours qui suivent, Washington et Copenhague lancent Project Crested Ice, une vaste opération de récupération et de décontamination avant la fonte printanière. Environ 1 500 travailleurs danois sont mobilisés pour racler la glace et collecter la neige contaminée. Plusieurs décennies plus tard, nombre d’entre eux engageront des procédures judiciaires, affirmant avoir travaillé sans information ni protection adéquates. Ces contentieux se prolongeront jusqu’en 2018-2019, débouchant sur des indemnisations politiques limitées, sans reconnaissance juridique de responsabilité. Aucune enquête épidémiologique exhaustive ne sera jamais menée auprès des populations inuit locales.

Aujourd’hui rebaptisée Pituffik Space Base, l’ancienne base de Thulé est l’un des nœuds stratégiques majeurs du dispositif militaire américain. Intégrée à la US Space Force, elle joue un rôle central dans l’alerte antimissile et la surveillance spatiale en Arctique, sous un régime de sécurité maximale. Elle n’est pas un vestige de la guerre froide, mais un pivot actif de la géopolitique contemporaine.

Dans Les Derniers Rois de Thulé, Malaurie montre que les peuples racine n’ont jamais de place possible au cœur des considérations stratégiques occidentales. Face aux grandes manœuvres du monde, l’existence des Inuit y devient aussi périphérique que celle des phoques ou des papillons.

Les déclarations de Donald Trump ne font pas surgir un monde nouveau. Elles visent à généraliser au Groenland un système en place depuis soixante-quinze ans. Mais la position d’un homme ne saurait nous exonérer de nos responsabilités collectives. Entendre aujourd’hui que le Groenland « appartient » au Danemark et dépend de l’OTAN, sans même évoquer les Inuit, revient à répéter un vieux geste colonial : concevoir les territoires en y effaçant ceux qui l’habitent.

Les Inuit demeurent invisibles et inaudibles. Nos sociétés continuent de se représenter comme des adultes face à des populations indigènes infantilisées. Leur savoir, leurs valeurs, leurs manières sont relégués au rang de variables secondaires. La différence n’entre pas dans les catégories à partir desquelles nos sociétés savent agir.

À la suite de Jean Malaurie, mes recherches abordent l’humain par ses marges. Qu’il s’agisse des sociétés de chasseurs-cueilleurs ou de ce qu’il reste de Néandertal, lorsqu’on le déshabille de nos projections, l’Autre demeure toujours l’angle mort de notre regard. Nous ne savons pas voir comment s’effondrent des mondes entiers lorsque la différence cesse d’être pensable.

Malaurie concluait son premier chapitre sur Thulé par ces mots :

« Rien n’aura été prévu pour imaginer l’avenir avec hauteur. »

Il faut redouter par-dessus tout non la disparition brutale d’un peuple, mais sa relégation silencieuse, et radicale, dans un monde qui parle de lui sans jamais le regarder ni l’entendre.

Ludovic Slimak ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

11.01.2026 à 15:41

Quand les IA cadrent l’information et façonnent notre vision du monde

Texte intégral (1938 mots)

Les grands modèles de langage façonnent notre perception de l’information, au-delà de l’exactitude ou inexactitude des faits présentés. Dans cette optique, comprendre et corriger les biais de l’intelligence artificielle est crucial pour préserver une information fiable et équilibrée.

La décision de Meta de mettre fin à son programme de fact-checking aux États-Unis a suscité une vague de critiques dans les milieux de la technologie et des médias (NDT : En France, le programme est maintenu). En jeu, les conséquences d’une pareille décision en termes de confiance et de fiabilité du paysage informationnel numérique, en particulier lorsque des plates-formes guidées par le seul profit sont en grande partie laissées à elles-mêmes pour se réguler.

Ce que ce débat a largement négligé, toutefois, c’est qu’aujourd’hui les grands modèles de langage d’intelligence artificielle (IA) sont de plus en plus utilisés pour rédiger des résumés d’actualité, des titres et des contenus qui captent votre attention bien avant que les mécanismes traditionnels de modération des contenus puissent intervenir.

Le problème ne se limite pas à des cas évidents de désinformation ou de contenus préjudiciables qui passeraient entre les mailles du filet en l’absence de modération. Ce qui se joue dans l’ombre, c’est comment des informations factuellement justes peuvent être sélectionnées, présentées et valorisées de façon à orienter la perception du public.

En générant les informations que les chatbots et assistants virtuels présentent à leurs utilisateurs, les grands modèles de langage (LLM) influencent progressivement la manière dont les individus se forgent une opinion. Ces modèles sont désormais également intégrés aux sites d’information, aux plates-formes de réseaux sociaux et aux services de recherche, devenant ainsi la principale porte d’accès à l’information.

Des études montrent que ces grands modèles de langage font bien plus que simplement transmettre de l’information. Leurs réponses peuvent mettre subtilement en avant certains points de vue tout en en minimisant d’autres, souvent à l’insu des utilisateurs.

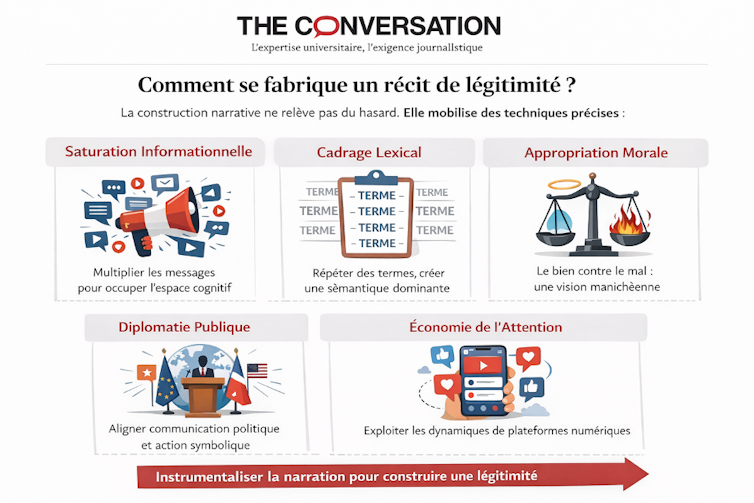

Biais de communication

Mon collègue, l’informaticien Stefan Schmid, et moi-même, chercheur en droit et politiques des technologies, montrons dans un article à paraître dans la revue Communications of the ACM que les grands modèles de langage présentent un biais de communication. Nous constatons qu’ils peuvent avoir tendance à mettre en avant certaines perspectives tout en en omettant ou en atténuant d’autres. Un tel biais est susceptible d’influencer la manière dont les utilisateurs pensent ou ressentent les choses, indépendamment du fait que l’information présentée soit vraie ou fausse.

Les recherches empiriques menées ces dernières années ont permis de constituer des jeux de données de référence qui mettent en relation les productions des modèles avec les positions des partis avant et pendant les élections. Elles révèlent des variations dans la manière dont les grands modèles de langage actuels traitent ces contenus publics. Le simple choix de la persona (l’identité fictive implicitement assignée au modèle) ou du contexte dans la requête suffit à faire glisser subtilement les modèles actuels vers certaines positions, sans que la justesse factuelle des informations soit remise en cause.

Ces glissements révèlent l’émergence d’une forme de pilotage fondée sur la persona : la tendance d’un modèle à aligner son ton et ses priorités sur ce qu’il perçoit comme les attentes de l’utilisateur. Ainsi, lorsqu’un utilisateur se présente comme militant écologiste et un autre comme chef d’entreprise, un modèle peut répondre à une même question sur une nouvelle loi climatique en mettant l’accent sur des préoccupations différentes, tout en restant factuellement exact dans les deux cas. Les critiques pourront par exemple porter, pour l’un, sur le fait que la loi n’aille pas assez loin dans la promotion des bénéfices environnementaux, et pour l’autre, sur les contraintes réglementaires et les coûts de mise en conformité qu’elle impose.

Un tel alignement peut facilement être interprété comme une forme de flatterie. Ce phénomène est appelé « sycophancy » (NDT : Si en français, le sycophante est un délateur, en anglais il désigne un flatteur fourbe), les modèles disant en pratique aux utilisateurs ce qu’ils ont envie d’entendre. Mais si la « sycophancy » est un symptôme de l’interaction entre l’utilisateur et le modèle, le biais de communication est plus profond encore. Il reflète des déséquilibres dans la conception et le développement de ces systèmes, dans les jeux de données dont ils sont issus et dans les incitations qui orientent leur perfectionnement. Lorsqu’une poignée de développeurs dominent le marché des grands modèles de langage et que leurs systèmes présentent systématiquement certains points de vue sous un jour plus favorable que d’autres, de légères différences de comportement peuvent se transformer, à grande échelle, en distorsions significatives de la communication publique.

Ce que la régulation peut – et ne peut pas – faire

Les sociétés contemporaines s’appuient de plus en plus sur les grands modèles de langage comme interface principale entre les individus et l’information. Partout dans le monde, les gouvernements ont lancé des politiques pour répondre aux préoccupations liées aux biais de l’IA. L’Union européenne, par exemple, avec l’AI Act et le règlement européen sur les services numériques, cherche à imposer davantage de transparence et de responsabilité. Mais aucun de ces textes n’est conçu pour traiter la question plus subtile du biais de communication dans les réponses produites par l’IA.

Les partisans de la régulation de l’IA invoquent souvent l’objectif d’une IA neutre, mais une neutralité véritable est le plus souvent hors d’atteinte. Les systèmes d’IA reflètent les biais inscrits dans leurs données, leur entraînement et leur conception, et les tentatives pour réguler ces biais aboutissent fréquemment à remplacer une forme de biais par une autre.

Et le biais de communication ne se limite pas à l’exactitude : il concerne la production et le cadrage des contenus. Imaginons que l’on interroge un système d’IA sur un texte législatif controversé. La réponse du modèle est façonnée non seulement par les faits, mais aussi par la manière dont ces faits sont présentés, par les sources mises en avant, ainsi que par le ton et le point de vue adoptés.

Cela signifie que la racine du problème des biais ne réside pas seulement dans la correction de données d’entraînement biaisées ou de sorties déséquilibrées, mais aussi dans les structures de marché qui orientent la conception des technologies. Lorsque seuls quelques grands modèles de langage (LLM) contrôlent l’accès à l’information, le risque de biais de communication s’accroît. Une atténuation efficace des biais suppose donc de préserver la concurrence, de renforcer la responsabilité portée par les utilisateurs et tout en restant ouvert aux différentes conceptions et offres de LLM du côté du régulateur.