ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

30.09.2025 à 17:00

Et si votre prochain collègue était un agent IA ?

Texte intégral (2243 mots)

Les agents d’IA sont capables d’effectuer différentes tâches de façon plus ou moins autonome. À mesure qu’ils sont intégrés à nos outils et à nos échanges personnels et professionnels, c’est toute la société qui doit décider ce qu’elle souhaite déléguer… et ce qu’elle préfère préserver.

En arrivant au bureau, un mail vous attend. Votre client voulait une mise à jour sur sa commande. Mais un agent IA a déjà consulté les données de livraison et envoyé un message de suivi. Vous n’avez rien eu à faire.

Ce n’est pas de la science-fiction. Les agents IA sont sur le point de transformer en profondeur nos façons de travailler. L’entreprise américaine de conseil Gartner estime que 15 % des décisions professionnelles quotidiennes seront prises par des agents IA d’ici 2028, et 33 % des entreprises utiliseront des agents IA (contre 1 % en 2024). Ces agents ne sont pas de simples assistants mais des entités capables d’agir, décider et parfois collaborer entre elles. Leur émergence pose des questions fondamentales sur le rôle des humains au travail.

Que sont les agents IA ?

Un agent IA est un logiciel (semi)-autonome qui utilise des techniques d’intelligence artificielle pour percevoir, prendre des décisions, accomplir des tâches et atteindre des objectifs prédéterminés, dans des environnements physiques ou numériques. Un agent IA peut agir pour le compte d’un utilisateur ou d’un autre système, par exemple un autre agent logiciel, en concevant son processus de travail et utilisant les outils disponibles.

Certains agents suivent une logique strictement scriptée, tandis que d’autres sont dotés d’une plus grande autonomie : ils déterminent eux-mêmes le bon moment pour agir en fonction du contexte, des objectifs et des informations disponibles. C’est cette autonomie qui caractérise l’« IA agentique ». Cette forme particulièrement autonome d’agent IA, qui ouvre de nouvelles possibilités mais soulève également des enjeux inédits en matière de conception, de contrôle et d’usage. Tous les agents IA ne forment pas une IA agentique, bien que la tendance aille en ce sens.

Par exemple, un « agent IA agentique » pourrait envoyer de lui-même un message aux clients de manière proactive si un message de retard du fournisseur est arrivé. Dans le contexte européen, une telle autonomie n’est pas interdite, mais elle relève des obligations de supervision humaine et de transparence imposées par l’AI Act (2024). Dans ce cadre, supervision ne signifie pas validation systématique de chaque action, mais capacité à tracer, contrôler et reprendre la main à tout moment.

Le marché mondial des agents IA, agentiques ou non, devrait représenter 47,1 milliards de dollars en 2030, 1,896 milliard de dollars en France en 2030.

Les agents IA s’appuient sur différentes briques d’intelligence artificielle : compréhension de requêtes, recherche d’informations, planification, action dans les systèmes, génération de texte. Parmi ces briques, les grands modèles de langage (LLM) jouent un rôle central, mais sont désormais utilisés par les agents IA de manière autonome, sans intervention humaine.

Les agents IA : vers une hyper automatisation du travail ?

Les agents IA fonctionnent en continu, sans fatigue ni pause. Ils permettent aux organisations d’étendre considérablement leur capacité d’action. À ce titre, ils incarnent la promesse d’une productivité accrue et d’une réduction des coûts.

À lire aussi : Les robots collaboratifs, des collègues de travail comme les autres ?

Mais cette automatisation radicale réactive des craintes anciennes : déqualification, dilution des responsabilités, dépendance technologique, perte de contrôle. Ainsi, 75 % des citoyens français pensent que l’IA détruira plus d’emplois qu’elle n’en créera, et 63 % refusent aujourd’hui de se former à ces outils selon le Labo Société Numérique 2024. Aux États-Unis, seuls 23 % des adultes pensent que l’IA améliorera leur façon de travailler, contre 73 % des experts de l’IA.

La rupture est donc aussi sociale que technologique.

Les agents d’IA permettront-ils d’innover davantage ?

Automatiser les processus peut figer une manière de faire, plutôt que d’innover. Selon Erik Brynjolfsson, le véritable potentiel de l’IA réside dans son pouvoir d’augmenter les capacités humaines pour faire de nouvelles choses, pas de les remplacer.

Ainsi, plutôt que de remplacer les humains, les agents IA pourraient élargir leur champ d’action créatif, en leur suggérant des idées nouvelles, en automatisant l’exploration de variantes ou en testant rapidement des pistes qu’un humain seul n’aurait pas le temps d’examiner… par exemple pour ouvrir la voie à des avancées majeures, notamment dans le domaine de la biomédecine.

Mais pour cela, il faut qu’ils soient dignes de confiance. Le fait que 93 % des employés de bureau doutent encore de la fiabilité des résultats produits par l’IA ne relève pas seulement d’un problème d’adoption : cette méfiance renvoie à des failles concrètes des systèmes actuels, qu’il s’agisse d’erreurs, de biais, ou d’un manque de traçabilité et d’explicabilité.

Quelle responsabilité pour les agents d’IA ?

Face à des systèmes capables d’agir de manière autonome tout en faisant des erreurs, qu’il s’agisse de biais, de décisions inadaptées ou d’hallucinations, une question demeure : qui est responsable du résultat ?

Les agents, par nature, ne peuvent ressentir ni assumer la responsabilité de leurs actes. Pourtant, leur rôle peut rester invisible aux yeux des utilisateurs : les employés peuvent ignorer qu’un agent a pris une décision à leur place, ou se retrouver démunis face à un raisonnement biaisé qu’ils ne comprennent pas. Un autre risque tient à l’imprécision des consignes données par l’utilisateur, ou à la manière dont l’agent les comprend. Une interprétation erronée peut amener ce dernier à sélectionner un outil inadéquat ou à en faire un usage détourné, avec des effets indésirables. Ce type de dérive est parfois qualifié d’ « hallucination d’appel de fonction ». Enfin, une étude publiée dans Nature montre que les agents IA sont plus enclins que les humains à suivre des instructions manifestement non éthiques, ce qui demande la mise en place de garde-fous prohibitifs. Lorsque les agents travaillent en mode agentique, en toute autonomie et auto-orchestration, ces questions ont d’autant plus de poids.

Ce sont donc les organisations qui doivent prendre l’initiative de mettre en place des mécanismes de gouvernance robustes, pour assurer à la fois la conformité éthique des usages et le bien-être des salariés exposés à ces systèmes. Les actions des agents IA peuvent aussi des conséquences imprévues, dont les organisations restent responsables, ce qui impose de se doter d’un cadre de gouvernance adéquat. Cela suppose des actions concrètes : une gouvernance robuste de l’IA dans l’entreprise, un niveau suffisant de transparence, et des cadres réglementaires établis.

En pratique, il est essentiel de définir explicitement les responsabilités respectives des humains et des machines, et de former les employés — notamment à la littératie algorithmique — pour leur permettre d’agir en connaissance de cause. Il faut également permettre une collaboration contradictoire, avec un agent IA qui interroge et affine les recommandations de l’agent humain.

D’un point de vue technique, le recours à des audits indépendants et la mise en place de dispositifs d’alerte en cas de dysfonctionnement constituent des garanties indispensables pour un contrôle pertinent des agents IA.

Collaborer… sans humains ? Les limites d’un avenir de systèmes multiagents

Certaines entreprises envisagent de faire collaborer plusieurs agents IA spécialisés pour atteindre des objectifs communs : ce sont les systèmes multiagents. Par exemple, des agents IA pourraient travailler ensemble pour suivre votre réclamation client sur votre dernière commande en ligne, faire des recommandations, remonter la solution, et ajuster votre facture.

Pour y arriver, il reviendra à l’entreprise de bien orchestrer la collaboration entre les agents IA. Elle peut créer un réseau centralisé, avec un serveur qui contrôle les actions et informations des agents et qui peut prendre la main sur le système ; ou alternativement, un réseau décentralisé où les agents IA contrôlent leurs interactions entre eux. Outre les risques d’échec de coordination, l’organisation peut être confrontée à des conflits informationnels entre agents IA et des collusions, et des risques de sécurité.

Plus l’autonomie des agents est élevée, plus il devient essentiel de maintenir une forme de contrôle sur les tâches accomplies. Le règlement européen sur l’intelligence artificielle insiste sur l’importance qu’un humain dans la boucle puisse intervenir pour corriger, interrompre ou valider les actions de l’IA.

Mais le marché de l’agentique propose une autre solution. Des agents gardiens qui peuvent surveiller, guider, et intervenir dans le comportement des autres agents lorsque nécessaire. Ces agents-gardiens, ou contremaîtres, représenteraient 10 à 15 % du marché de l’IA agentique.

Faut-il alors imaginer un futur où les humains deviendraient les contrôleurs des contrôleurs ? Or, ce rôle de supervision sans implication directe dans l’action est loin d’être satisfaisant : il est souvent associé à une baisse de l’engagement et de l’épanouissement professionnel. Pire encore, plus nous déléguons les tâches formatrices à des systèmes automatisés, plus il devient difficile pour les humains d’intervenir efficacement lorsque l’IA échoue, faute d’entraînement ou de compréhension fine de la tâche.

La prochaine fois que vous engagerez une nouvelle tâche… prenez un instant pour vous demander : est-ce vous qui l’accomplirez encore d’ici peu, ou un agent IA à votre place ? Et surtout, en quoi cela changerait-il le sens que vous tirerez de votre travail ? À mesure que les agents IA s’installent dans nos outils et nos échanges, c’est toute la société qui doit décider de ce qu’elle souhaite déléguer… et de ce qu’elle préfère préserver.

Cet article est publié dans le cadre de la Fête de la science (qui a lieu du 3 au 13 octobre 2025), dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « Intelligence(s) ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Stéphanie Gauttier ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

29.09.2025 à 16:52

Katherine Johnson : la mathématicienne qui a envoyé des astronautes dans l’espace

Texte intégral (2800 mots)

Si l’on a retenu les noms des premiers astronautes à faire quelques pas sur la Lune, ceux des femmes qui ont rendu possible cette prouesse sont longtemps restés dans l’oubli. Parmi elles, Katherine Johnson, qui faisait partie de ces « ordinateurs humains », de brillantes mathématiciennes dont le travail, peu reconnu à l’époque, fut pourtant essentiel pour calculer les trajectoires des missions spatiales de la Nasa.

Dans l’ombre des fusées qui perçaient le ciel et des astronautes qui marchaient sur la Lune se cachait une femme à l’esprit plus rapide qu’un ordinateur. Katherine Johnson, mathématicienne de génie, a calculé les trajectoires qui ont permis à l’Amérique de conquérir l’espace. Avant d’écrire l’histoire de la Nasa, elle a dû affronter celle de son pays : une Amérique ségrégationniste où être femme noire signifiait lutter chaque jour pour prouver que le génie n’a ni couleur ni genre.

« Les filles sont capables de faire exactement les mêmes choses que les hommes. Parfois, elles ont même plus d’imagination qu’eux. » — Katherine Johnson

Une jeunesse brillante dans l’Amérique ségrégationniste

Katherine Coleman naît le 26 août 1918 à White Sulphur Springs, en Virginie-Occidentale. Fille d’un bûcheron et d’une institutrice, elle grandit dans une Amérique profondément marquée par les lois Jim Crow. Très tôt, son génie pour les chiffres saute aux yeux et lui vaut de sauter plusieurs classes à l’école. Malheureusement, à cette époque, le comté où elle habite ne propose pas d’éducation aux enfants noirs au-delà de l’âge de 9 ou 10 ans. Son père, déterminé à offrir à sa fille l’instruction qu’elle mérite malgré la ségrégation, déménage une partie de l’année pour qu’elle puisse suivre des cours de qualité à l’institut de West Virginia State College.

À 15 ans, elle y débute ses études supérieures et rencontre le mathématicien William Schieffelin Claytor, l’un des premiers Afro-Américains à obtenir un doctorat en mathématiques. Il la prend sous son aile et l’encourage à viser plus haut que ce que la société lui permet. En 1937, à 18 ans, elle sort diplômée avec les plus grands honneurs en mathématiques et en français.

Cette même année, elle épouse le physicien et mathématicien James Francis Goble, avec qui elle aura trois filles. Elle débute sa carrière comme enseignante, l’un des rares débouchés pour une femme noire diplômée en mathématiques à l’époque. Sa vie semble tracée : enseignement, foyer, et un génie cantonné aux salles de classe.

Ses débuts comme « ordinateur humain »

En 1953, le National Advisory Committee for Aeronautics (Naca), ancêtre de la Nasa, ouvre un département de calcul réservé aux femmes afro-américaines : le West Area Computing Unit, dirigé par une compatriote de Virginie-Occidentale, Dorothy Vaughan. Johnson postule et y est engagée comme « ordinateur humain » – littéralement un cerveau destiné à faire, à la main, ce que les ordinateurs électroniques commencent tout juste à accomplir. Avec son mari et ses filles, elle déménage à Newport News, en Virginie, pour rejoindre ce nouveau poste.

Dans cet univers, les femmes calculent, les hommes valident. Plus grave encore : Katherine Johnson et ses collègues noires travaillent dans une aile séparée du bâtiment, mangent dans une cantine à part et doivent parcourir plusieurs centaines de mètres pour trouver des toilettes qui leur sont réservées.

Pendant ce temps, son mari James tombe gravement malade. Elle continue pourtant son travail avec la même rigueur. Il décède en 1956, la laissant seule avec leurs trois filles.

Des calculs qui envoient des hommes dans l’espace

En 1958, la Naca devient la Nasa et supprime officiellement la ségrégation dans ses bureaux. Katherine est intégrée à l’équipe du Space Task Group, la cellule chargée du tout premier programme spatial habité des États-Unis : Mercury. Son talent va alors se révéler décisif.

Elle calcule à la main la trajectoire du vol suborbital d’Alan Shepard, en 1961, le premier Américain envoyé dans l’espace. Mais c’est surtout lors du vol orbital de John Glenn, en 1962, qu’elle entre définitivement dans l’histoire. Glenn sait que les nouveaux ordinateurs électroniques sont sujets aux pannes et dysfonctionnements : une erreur de virgule et c’est un astronaute perdu dans l’infini. Avant de décoller, il lance alors cette phrase restée célèbre, en parlant de Katherine Johnson :

« Faites vérifier les calculs par la fille. Si elle dit que c’est bon, je suis prêt à y aller. »

Katherine Johnson vérifie les équations ligne par ligne, à la main. Le calcul est correct : Glenn décolle et revient sain et sauf. Le vol est un succès et marque un tournant dans la compétition entre les États-Unis et l’Union soviétique dans la conquête spatiale.

Viser la Lune

Durant ces années intenses, Katherine se remarie avec le colonel James Johnson, qui soutiendra sa carrière et l’aidera à élever ses filles. La course à l’espace s’intensifie, et Katherine Johnson continue de mettre son génie au service des missions Gemini et Apollo.

Pour Apollo 11, elle calcule la trajectoire qui permet aux astronautes de quitter la Lune, de rejoindre le module de commande en orbite et de revenir sur Terre en entrant dans l’atmosphère avec une précision absolue – un exploit mathématique qui ne laisse aucune place à l’approximation. Elle publie aussi plusieurs articles scientifiques en son nom, chose très rare pour une femme noire à l’époque.

Une reconnaissance tardive

Il aura fallu attendre plusieurs décennies pour que l’Amérique mesure l’ampleur de ses contributions. En 2015, à 97 ans, Katherine Johnson reçoit la médaille présidentielle de la Liberté des mains de Barack Obama.

« Katherine G. Johnson a refusé d’être limitée par les attentes qu’avait la société à l’égard de son genre et de sa race, tout en repoussant les frontières de ce que l’humanité peut atteindre », déclare la Maison Blanche.

L’année suivante, le livre puis le film les Figures de l’ombre (Hidden Figures) font connaître au grand public l’histoire de Katherine Jonhson et de ses collègues Mary Jackson et Dorothy Vaughan. Pour des millions de jeunes filles, surtout issues des minorités, elle devient un modèle : celui d’une femme qui prouve que le génie n’a ni couleur, ni sexe, ni frontières.

Katherine Johnson s’éteint le 24 février 2020, à 101 ans, laissant derrière elle un héritage scientifique et humain colossal. En 2016, la Nasa rebaptise l’un de ses bâtiments le Katherine-G.-Johnson Computational Research Facility, comme symbole de réparation morale. Sa vie nous rappelle que le progrès scientifique n’est pas seulement affaire de technologie, mais aussi de courage, de dignité et d’équité.

Coralie Thieulin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

28.09.2025 à 10:31

Protéger les cultures sans pesticides grâce au langage olfactif des plantes

Texte intégral (1370 mots)

Découvrez comment les plantes utilisent les odeurs pour se défendre contre les insectes nuisibles et comment les scientifiques cherchent à exploiter ces messages invisibles pour développer de nouvelles méthodes de protection des cultures plus respectueuses de l’environnement.

Bienvenue dans la jungle des odeurs où les plantes ne sont pas aussi innocentes qu’elles en ont l’air ! Quand certaines plantes sont attaquées par un prédateur, elles peuvent lancer un appel à l’aide olfactif. C’est le cas du maïs qui, lorsqu’il est attaqué par les chenilles de la légionnaire d’automne, un papillon causant des dégâts majeurs partout dans le monde, va produire des odeurs attractives pour un prédateur de la chenille : la guêpe Chelonus insularis. Ce petit insecte vient alors prêter main-forte aux plantes en détruisant les envahisseurs. Par exemple, l’alpha-copaène, odeur boisée utilisée en parfumerie, est un composé odorant clé de cette guerre olfactive.

Les plantes sont de vraies pros de la défense olfactive ! En plus d’appeler à l’aide les ennemis naturels des herbivores, elles ont d’autres tours dans leur sac. Certaines émettent des odeurs répulsives pour éloigner les insectes nuisibles, comme des odeurs de défense qui disent : « N’approchez pas, je suis toxique ! » D’autres produisent des composés qui attirent les pollinisateurs, comme des odeurs de séduction qui disent : « Viens ici ! J’ai du nectar pour toi. » Les plantes peuvent même communiquer avec leurs voisines pour les avertir d’un danger imminent, comme un téléphone olfactif qui dit : « Attention, les insectes arrivent, préparez vos défenses ! »

Les plantes sont de vraies stratèges de la guerre olfactive, et cela sent bon pour la recherche. Concrètement, comment les scientifiques travaillent-ils à exploiter ces messages invisibles pour développer de nouvelles méthodes de protection des cultures ?

Les pouvoirs olfactifs des plantes

Comme beaucoup d’êtres vivants, les plantes produisent des composés organiques volatils (COV). Les COV sont des molécules qui s’évaporent facilement et sont libérées dans l’air, jouant un rôle clé dans la communication et la défense des plantes. Lorsque ces COV peuvent être perçus par des insectes, d’autres animaux ou même d’autres plantes, et influencent leurs comportements et interactions, on parle alors de composés sémio-chimiques. Et parmi ces composés sémio-chimiques, vous en connaissez peut-être une catégorie qu’on appelle les phéromones, très utilisés par les insectes. C’est un type de composé agissant comme un messager entre individus de la même espèce, permettant par exemple la reconnaissance d’un partenaire sexuel, agissant comme signal d’agrégation, d’alarme, ou encore de cohésion sociale. Les signaux des plantes sont nommés « kairomones » ou « allomones », selon le bénéfice produit : les premiers sont utiles au receveur de l’information, les seconds à l’émetteur. Comprendre ces interactions chimiques peut nous aider à développer de nouvelles stratégies de gestion des populations d’insectes, plus ciblées et plus respectueuses de l’environnement que les méthodes conventionnelles à base d’insecticides de synthèse.

Des signaux olfactifs pour protéger les cultures

Et c’est ici que la recherche en écologie chimique entre en jeu. C’est la science qui étudie les interactions chimiques entre les organismes vivants et leur environnement.

Les scientifiques de ce domaine étudient ces interactions pour comprendre comment les plantes utilisent les COV pour influencer leur environnement. En analysant les odeurs émises par les plantes, ils peuvent identifier les molécules clés qui agissent sur le comportement des insectes. Les chercheurs développent ainsi des méthodes pour reproduire et amplifier les signaux chimiques des plantes, visant à tromper les insectes nuisibles.

Les pièges olfactifs à base d’odeurs attractives que vous avez peut-être dans votre jardin, ou les répulsifs que vous utilisez pour repousser moustiques, guêpes, frelons sont justement inspirés de la recherche en écologie chimique. Vous avez peut-être déjà tenté de vous débarrasser des mites alimentaires dans votre cuisine en utilisant des plaques de glue parfumées à la phéromone sexuelle de ce petit papillon dont les larves s’invitent dans nos farines, riz, pâtes ou fruits secs.

La recherche d’odeurs efficaces n’est cependant pas une mince affaire, vu l’immensité des signaux chimiques émis par les plantes. Une approche complémentaire que nous développons, appelée écologie chimique inverse, en permet un raccourci. Cette nouvelle approche se concentre sur le système de détection des insectes, et en particulier sur leurs « capteurs olfactifs », également appelés récepteurs olfactifs, qui se trouvent sur leurs organes sensoriels.

En comprenant comment ces récepteurs fonctionnent, nous pouvons précisément identifier ce qu’ils sont capables de détecter dans le vaste univers des COV de plantes, et des odeurs en général. Prenons pour exemple la noctuelle du coton qui, comme son nom ne l’indique pas, attaque en réalité une grande variété de cultures principalement dans le sud du Bassin méditerranéen et en Afrique, et représente aujourd’hui une menace invasive en France. L’étude d’un de ses récepteurs olfactifs nous a permis d’identifier de nouveaux attractifs insoupçonnés.

Cette compréhension fine permet de développer de nouvelles molécules capables de perturber de façon ciblée le fonctionnement naturel des récepteurs olfactifs clés et d’élargir le spectre de sémio-chimiques efficaces, sans perturber les insectes voisins. L’écologie chimique inverse permet ainsi d’accélérer le développement de méthodes de protection des cultures ciblées et plus respectueuses de l’environnement, tout en réduisant les impacts non intentionnels sur les autres espèces.

Nos projets de recherche exploitent ces connaissances à des fins appliquées en agriculture. Le projet Ardeco, par exemple, vise à développer une infrastructure nationale distribuée en écologie chimique pour anticiper le retrait de substances phytosanitaires et promouvoir des techniques alternatives pour la protection des cultures. Par ailleurs, le projet Invoria, cherche à percer les mystères des récepteurs olfactifs des insectes en utilisant une approche innovante mêlant intelligence artificielle et expérimentation haut débit. Les retombées attendues sont importantes pour la protection des cultures, mais aussi pour la santé humaine et animale, la pollinisation et la bioconservation.

En exploitant le pouvoir des odeurs, les scientifiques participent au développement d’alternatives prometteuses aux pesticides chimiques, contribuant ainsi à une agriculture plus durable et à la préservation de la biodiversité.

Sébastien Fiorucci a reçu des financements de l’ANR (ANR-16-CE21-0002 et ANR-25-CE20-2183), du CNRS (programme MITI 80|Prime), du Ministère de l’Agriculture et FranceAgriMer dans le cadre du Plan d’Action Stratégique PARSADA (PAEDP0924005531), et du programme "recherche à risque" EXPLOR'AE (ANR-24-RRII-0003), confié à INRAE par le Ministère de la Recherche et de l'enseignement supérieur et financé par France 2030.

Emmanuelle Jacquin-Joly a reçu des financements de l’ANR (ANR-20-CE20-003), du CNRS (programme MITI 80|Prime), du Ministère de l’Agriculture et FranceAgriMer dans le cadre du Plan d’Action Stratégique PARSADA (PAEDP0924005531), et du programme "recherche à risque" EXPLOR'AE (ANR-24-RRII-0003), confié à INRAE par le Ministère de la Recherche et de l'enseignement supérieur et financé par France 2030.

24.09.2025 à 16:45

ChatGPT : la proposition d’OpenAI pour éviter les hallucinations pourrait tuer son propre chatbot

Texte intégral (1704 mots)

Parce que les classements comparatifs d’IA pénalisent les modèles qui préfèrent ne pas répondre plutôt que de piocher une réponse au hasard, les hallucinations perdurent, estime OpenAI dans son dernier article de recherche. Mais la solution que propose le géant de l’intelligence artificielle pourrait conduire à sa propre perte.

Dans un article récent, des chercheurs d’OpenAI expliquent pourquoi ChatGPT et d’autres grands modèles de langage peuvent inventer des choses – un phénomène connu dans le monde de l’intelligence artificielle sous le nom d’« hallucination ». Ils révèlent aussi pourquoi ce problème pourrait être impossible à résoudre, du moins pour le grand public.

L’article en question propose l’explication mathématique la plus rigoureuse à ce jour sur les raisons pour lesquelles ces modèles énoncent des contre-vérités avec assurance. Il montre qu’il ne s’agit pas simplement d’un effet secondaire malheureux de la façon dont les IA sont actuellement entraînées, mais d’un phénomène mathématiquement inévitable. Le problème s’explique en partie par des erreurs dans les données sous-jacentes utilisées pour entraîner les IA. Mais grâce à une analyse mathématique de la façon dont les systèmes d’IA apprennent, les chercheurs prouvent que même avec des données d’entraînement parfaites, le problème persiste.

La façon dont les modèles de langage répondent aux requêtes – en prédisant un mot à la fois dans une phrase, sur la base de probabilités – produit naturellement des erreurs. Des chercheurs ont d’ailleurs montré que le taux d’erreur total pour générer des phrases est au moins deux fois plus élevé que le taux d’erreur que la même IA aurait sur une simple question fermée par oui ou non, car les erreurs peuvent s’accumuler au fil des prédictions successives. Autrement dit, les taux d’hallucination sont fondamentalement liés à la capacité des systèmes d’IA à distinguer les réponses valides des réponses invalides. Comme ce problème de classification est intrinsèquement difficile dans de nombreux domaines de connaissance, les hallucinations deviennent inévitables.

Il s’avère également que moins un modèle rencontre un fait durant son entraînement, plus il est susceptible d’halluciner lorsqu’on l’interroge à ce sujet. Pour les dates de naissance, par exemple, les auteurs démontrent que si 20 % de ces dates n’apparaissent qu’une seule fois dans les données d’entraînement, on doit s’attendre à ce que les modèles de base se trompent sur au moins 20 % des questions portant sur les anniversaires. Et effectivement, interrogé sur la date de naissance d’Adam Kalai (un des auteurs de l’article), DeepSeek-V3 a donné avec assurance trois dates différentes et toutes fausses lors de tentatives séparées : « 03-07 », « 15-06 » et « 01-01 ». La date correcte se situe en automne, donc aucune de ces réponses n’était même proche de la réalité.

Le piège de l’évaluation

Ce qui est plus troublant, c’est l’analyse de l’article sur les raisons pour lesquelles les hallucinations persistent malgré les efforts « post-training » (comme l’apprentissage par renforcement à partir de rétroaction humaine). Les auteurs ont examiné dix grands comparatifs d’IA, y compris ceux utilisés par Google, OpenAI, ainsi que les meilleurs classements qui évaluent les modèles d’IA. Leur travail a révélé que neuf de ces benchmarks utilisent des systèmes de notation binaires qui attribuent zéro point aux IA exprimant une incertitude.

Cela engendre ce que les auteurs appellent une « épidémie » où l’incertitude et le refus de répondre sont pénalisés. Lorsqu’un système d’IA dit « je ne sais pas », il reçoit le même score que s’il fournissait une information complètement fausse. La stratégie optimale dans ce type d’évaluation devient alors évidente : toujours deviner.

Et les chercheurs le prouvent mathématiquement. Avec cette évaluation binaire, quelles que soient les chances qu’une réponse particulière soit correcte, le score attendu en se contentant de deviner dépasse toujours celui d’une IA qui s’abstient lorsqu’elle ne sait pas.

La solution qui ferait tout exploser

La solution proposée par OpenAI consiste à ce que l’IA évalue la confiance qu’il attribue à sa réponse avant de la fournir, et que les comparatifs l’évaluent en fonction de cela. L’IA pourrait alors recevoir une consigne, par exemple : « Réponds seulement si tu es confiant à plus de 75 %, puisque les erreurs sont pénalisées de 3 points tandis que les bonnes réponses rapportent 1 point. »

Le cadre mathématique adopté par les chercheurs d’OpenAI montre que, avec des seuils de confiance appropriés, les systèmes d’IA exprimeraient naturellement de l’incertitude plutôt que de deviner. Cela permettrait donc de réduire les hallucinations.

Le problème réside dans l’impact que cela aurait sur l’expérience utilisateur. Imaginez les conséquences si ChatGPT commençait à répondre « je ne sais pas » à 30 % des requêtes – une estimation plutôt prudente fondée sur l’analyse que fait l’article de l’incertitude factuelle dans les données d’entraînement. Les utilisateurs, habitués à recevoir des réponses assurées à presque toutes leurs questions, abandonneraient probablement rapidement un tel système.

J’ai déjà rencontré ce genre de problème dans un autre domaine de ma vie. Je participe à un projet de surveillance de la qualité de l’air à Salt Lake City, dans l’Utah. Lorsque le système signale des incertitudes concernant les mesures pendant des conditions météorologiques défavorables ou lors du calibrage de l’équipement, l’engagement des utilisateurs est moindre comparé aux affichages donnant des mesures sûres – même lorsque ces mesures « sûres » se révèlent inexactes lors de la validation.

La question économique liée au calcul

Il ne serait pas difficile de réduire les hallucinations en s’appuyant sur les conclusions de l’article. Des méthodes pour quantifier l’incertitude existent depuis des décennies et pourraient être utilisées pour fournir des estimations fiables de l’incertitude et guider une IA vers des choix plus judicieux. Mais même si l’on pouvait surmonter le problème de l’aversion des utilisateurs pour cette incertitude, un obstacle encore plus important se poserait : le coût des calculs. Les modèles de langage « conscients de l’incertitude » nécessitent beaucoup plus de puissance de calcul que les approches actuelles, car ils doivent évaluer plusieurs réponses possibles et estimer les niveaux de confiance. Pour un système traitant des millions de requêtes chaque jour, cela se traduit par des coûts opérationnels considérablement plus élevés.

Des approches plus sophistiquées, comme l’apprentissage actif, où les systèmes d’IA posent des questions de clarification pour réduire l’incertitude, peuvent améliorer la précision mais augmentent encore les besoins en calcul. Ces méthodes fonctionnent bien dans des domaines spécialisés comme la conception de puces, où des réponses erronées coûtent des millions de dollars et justifient un calcul intensif. Pour des applications grand public, où les utilisateurs attendent des réponses instantanées, l’aspect économique devient prohibitif.

La donne change radicalement pour les systèmes d’IA qui gèrent des opérations commerciales critiques ou des infrastructures économiques. Lorsque des agents d’IA prennent en charge la logistique de la chaîne d’approvisionnement, le trading financier ou le diagnostic médical, le coût des hallucinations dépasse largement celui de rendre les modèles capables de décider lorsqu’ils sont trop incertains. Dans ces domaines, les solutions proposées par l’article deviennent économiquement viables – et même nécessaires. Ces agents d’IA « incertains » coûteront simplement plus cher.

Une incitation structurelle à l’hallucination

Cependant, les applications grand public dominent toujours les priorités de développement de l’IA. Les utilisateurs veulent des systèmes qui fournissent des réponses assurées à n’importe quelle question. Les benchmarks d’évaluation récompensent les systèmes qui devinent plutôt que ceux qui expriment de l’incertitude. Les coûts de calcul favorisent les réponses rapides et confiantes plutôt que les réponses lentes et incertaines.

La baisse des coûts énergétiques par token et les avancées dans les architectures de puces pourraient éventuellement rendre plus abordable le fait que les IA décident si elles sont suffisamment sûres pour répondre à une question. Mais la quantité de calcul resterait relativement élevée, comparée à celle requise pour deviner aujourd’hui. En résumé, l’article d’OpenAI met involontairement en lumière une vérité inconfortable : les incitations économiques qui orientent le développement de l’IA grand public restent fondamentalement incompatibles avec la réduction des hallucinations. Tant que ces incitations ne changeront pas, les hallucinations persisteront.

Wei Xing ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

23.09.2025 à 16:15

Peaux artificielles : comment reproduire la complexité de la peau humaine… jusqu’à son interaction avec le parfum

Texte intégral (1921 mots)

Pourquoi un parfum ne tient-il pas de la même façon sur toutes les peaux ? Pourquoi certaines crèmes collent-elles davantage sur certains types de peau ? Ces différences, chacun les remarque, mais on ne les comprend pas encore très bien.

Depuis une dizaine d’années, nous travaillons à percer les mystères de la peau, et de la manière dont elle interagit avec les produits dermatologiques, les cosmétiques et les parfums en développant une réplique de peau humaine, sans cellule mais riche d’informations physico-chimiques.

Comprendre la peau avant de la reproduire

La peau est bien plus qu’un simple revêtement. Elle est un tissu complexe, à la fois barrière, capteur et interface chimique. Sa surface varie selon les individus : celle d’un bébé joufflu est moins rugueuse et plus hydratée que celle d’une personne âgée. Ces différences influencent non seulement la sensation mécanique au toucher et l’apparence mais aussi la répartition du sébum et donc la chimie de sa surface. Avec toutes ses propriétés qui s’entremêlent, ces phénomènes sont difficiles à modéliser.

Or, pour imiter la peau de manière crédible, il faut d’abord la caractériser précisément.

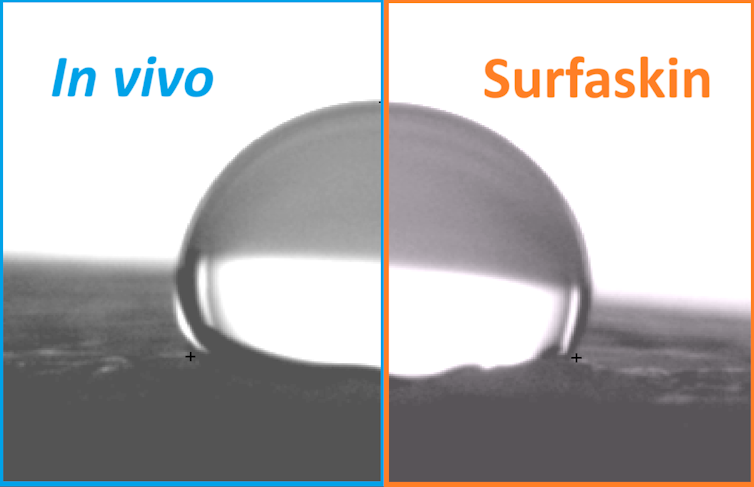

Notre équipe réalise chaque année des campagnes de mesures in vivo sur plusieurs centaines de volontaires. Nous analysons des paramètres comme la rugosité, la couleur, la composition lipidique (le gras) ou encore la mouillabilité (comment une goutte d’eau s’étale sur la peau).

Ces données, traitées statistiquement, permettent d’établir une « cartographie » des surfaces cutanées humaines et d’en quantifier la variabilité d’une personne à l’autre.

Les peaux artificielles

Les peaux artificielles ne sont pas nouvelles. On utilise depuis les années 1930 des modèles dits « biologiques » en dermatologie, comme des explants de peau humaine (petits morceaux de peau humaine prélevée lors d’une chirurgie et maintenue vivante en laboratoire), des peaux reconstruites à partir de cultures cellulaires, ou encore des peaux animales (notamment celle du porc, la plus proche de la peau humaine).

Plus récemment, depuis les années 2000, des peaux dites « électroniques » ou e-skins ont vu le jour, capables de capter diverses données pour des applications en robotique ou en médecine. Il s’agit de matériaux polymères souples, souvent sous forme de patch, qui collent sur la peau comme une seconde peau. Elles contiennent de minuscules capteurs capables de mesurer la pression, la température, ou des substances comme le glucose ou l’alcool dans la sueur, pour contrôler, reproduire ou ajuster ce qui se passe dans le corps.

Néanmoins, ces solutions biologiques et électroniques présentent souvent des limites : les peaux reconstruites sont coûteuses et peu reproductibles, les explants de peaux fragiles, de durée d’utilisation limitée et soumis à une variabilité biologique, et les peaux animales soulèvent des contraintes éthiques. De plus, un certain nombre d’entre elles, comme les peaux reconstruites et électroniques, ne reflètent pas fidèlement la chimie de surface de la peau humaine.

À lire aussi : Cosmétiques : le « Made in France » en pleine lumière

Notre modèle synthétique : SURFASKIN

À partir de cette base de données, nous avons conçu un modèle de peau artificielle non biologique, développé initialement dans le cadre du projet FUI URBASKIN. Contrairement aux peaux cellulaires ou biologiques utilisées en laboratoire, SURFASKIN est une surface polymérique, stable dans le temps, peu coûteuse, facilement reproductible.

Notre peau artificielle synthétique est également exempte de cellules vivantes. En effet, elle ne vise pas à reproduire les fonctions biologiques de la peau, mais ses propriétés de surface, celles qui conditionnent la manière dont la peau interagit avec son environnement en reproduisant fidèlement le microrelief de l’épiderme, ainsi que la composition et la pigmentation de sa surface.

Ce modèle a d’abord été pensé pour simuler l’exposition de la peau à des polluants atmosphériques, comme les particules urbaines ou la fumée de cigarette, afin de comprendre leur capacité à y pénétrer et à altérer ses propriétés. Avec des mesures combinées (in vivo, explants, SURFASKIN), nous avons démontré que les polluants désorganisent la structure lipidique et provoquent des phénomènes d’oxydation, tandis que certains produits dermocosmétiques peuvent ralentir ces effets de manière ciblée pour renforcer la fonction barrière de l’épiderme.

Très vite, notre modèle a trouvé d’autres applications, notamment en cosmétique et dermatologie. Ainsi, SURFASKIN permet d’évaluer l’étalement de crèmes hydratantes, la couvrance des maquillages, ou encore la résistance à l’eau des protections solaires, avec un haut degré de représentativité. Ainsi, en appliquant une crème teintée sur la peau ou sur SURFASKIN, le film résiduel conserve les mêmes propriétés, tant en épaisseur qu’en composition, ce qui reproduit fidèlement des caractéristiques, comme le toucher collant ou le pouvoir couvrant.

SURFASKIN s’inscrit dans la tendance des peaux artificielles, tout en comblant un vide : celui d’un modèle robuste, passif, mais suffisamment précis pour simuler les interactions de surface. Il ne remplace pas les tests biologiques, mais les complète, en offrant un outil éthique et reproductible pour la recherche et le développement de cosmétiques et de produits dermatologiques.

Malgré ses atouts, SURFASKIN présente encore des limites, laissant la voie ouverte à de futurs développements pour mieux comprendre le rôle du microbiote cutané, par exemple, reproduire la pénétration des substances au sein de la peau, étudier les interactions biologiques avec les cellules, ou même intégrer des capteurs miniaturisés capables de mesurer d’autres paramètres, comme la pression lors de l’application d’un produit.

Le cas du parfum : vers une parfumerie personnalisée ?

Un nouveau champ d’application émerge aujourd’hui : la parfumerie. Il est bien connu des parfumeurs qu’un parfum « ne tient pas » de la même façon selon les personnes, c’est-à-dire qu’il n’adhère et ne s’évapore pas de la même façon selon les types de peau.

Ce phénomène, souvent attribué à la « magie du corps », repose en réalité sur des facteurs physico-chimiques : le pH, la présence de sébum, la température, la rugosité de la peau influencent la diffusion et la rémanence des molécules odorantes.

Avec SURFASKIN, nous développons désormais des répliques de peau reproduisant ces variations, pour tester de manière rigoureuse l’adhérence et l’évaporation des parfums. C’est une avancée inédite : si l’industrie du luxe explore la question des parfums sur mesure depuis longtemps, elle reste peu documentée scientifiquement, surtout quand il s’agit d’une personnalisation en fonction du type de peau.

À terme, ces travaux pourraient donc ouvrir la voie à des parfums personnalisés, conçus non plus uniquement pour une image ou une émotion, mais pour les propriétés chimiques individuelles de chacun.

Une technologie au service de la recherche et de l’industrie

En collaboration avec Normandie Valorisation, nos travaux visent à faciliter le transfert de cette innovation vers les acteurs industriels de la cosmétique et de la parfumerie. La France, leader mondial dans ces secteurs, dispose d’un écosystème favorable à ce type de développement, à l’interface entre science académique et innovation appliquée.

SURFASKIN illustre une nouvelle manière de faire de la recherche : en créant des outils concrets, fiables, éthiques, et utiles pour comprendre des phénomènes du quotidien. Sous les apparences simples d’une crème ou d’un parfum, c’est tout un monde physico-chimique que l’on commence à explorer.

Céline Picard participera à une table ronde sur le thème « À fleur de peau : chimie, biologie et équilibre », vendredi 26 septembre, dans le cadre de l’événement scientifique Sur les épaules des géants qui se tient du 25 au 27 septembre au Havre (Seine-Maritime).

Géraldine Savary a reçu des financements pour des recherches doctorale de l'Université Le Havre Normandie, La Région Normandie, l'Agence Nationale de la Recherche.

Céline Picard a reçu des financements de L'Université Le Havre Normandie, de Normandie Université, de Le Havre Seine Métropole, de la Région Normandie, de l'Agence Nationale pour la Recherche et de l'Europe pour des projets de recherche dont des projets de recherches doctorales