16.12.2025 à 10:02

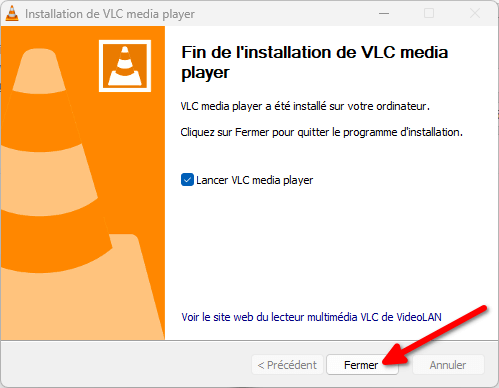

Publiez vos vidéos avec PeerTube sur mobile !

Framasoft

Texte intégral (4948 mots)

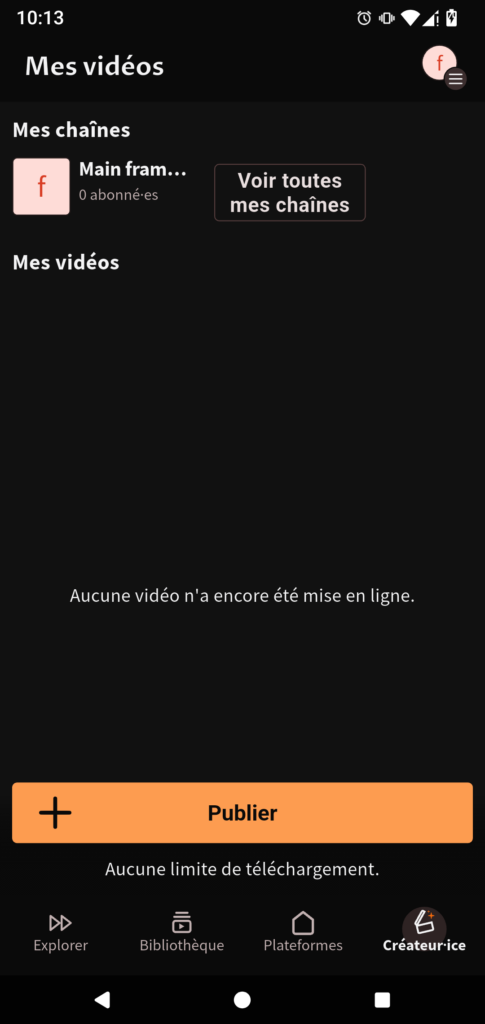

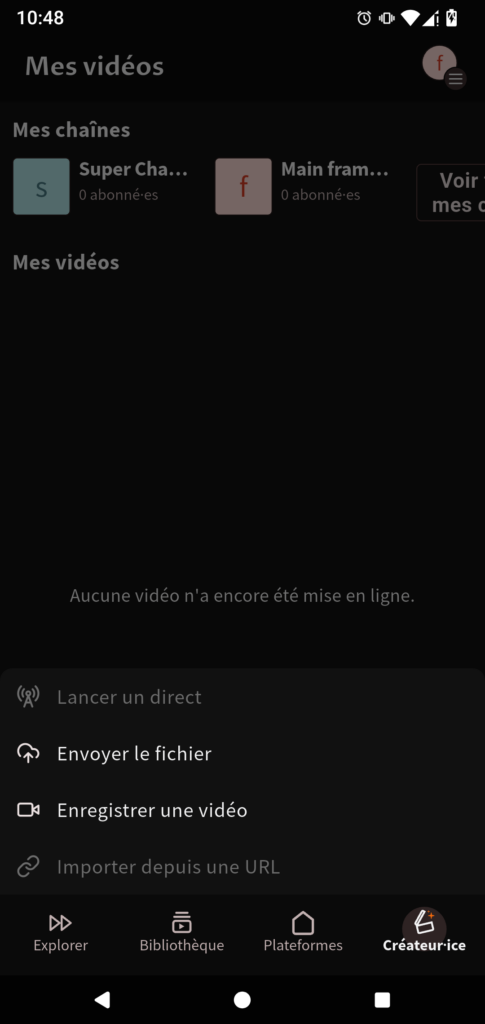

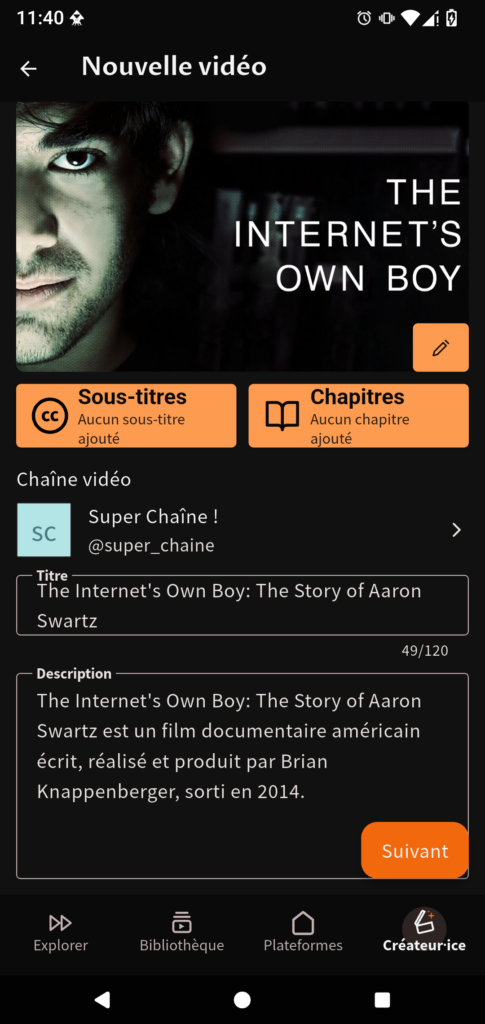

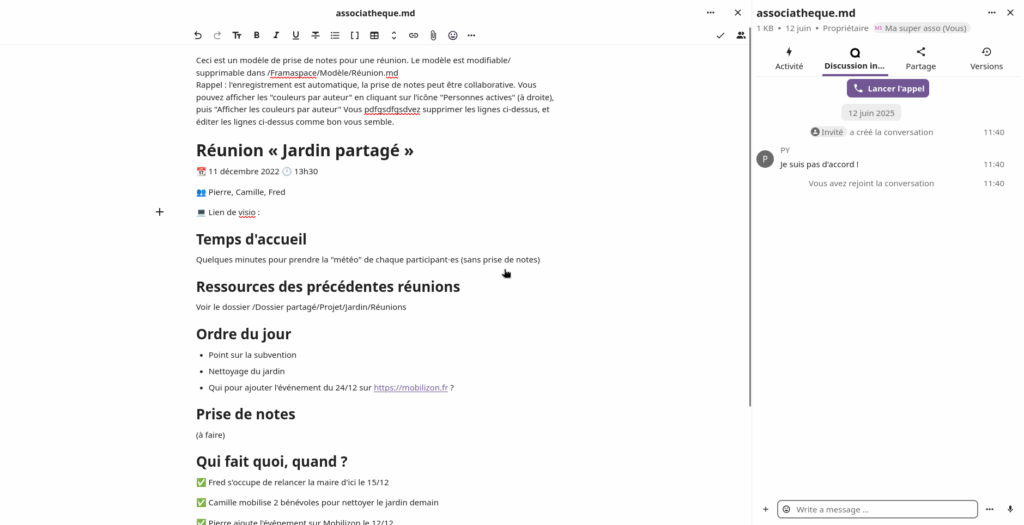

Publiez vos vidéos où que vous soyez

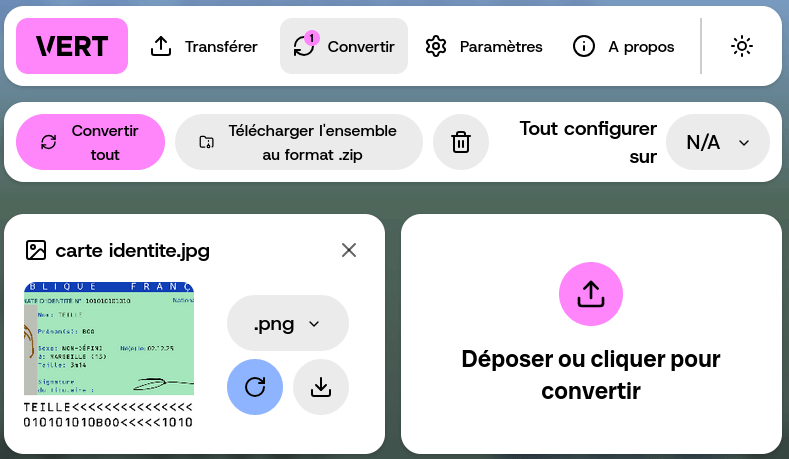

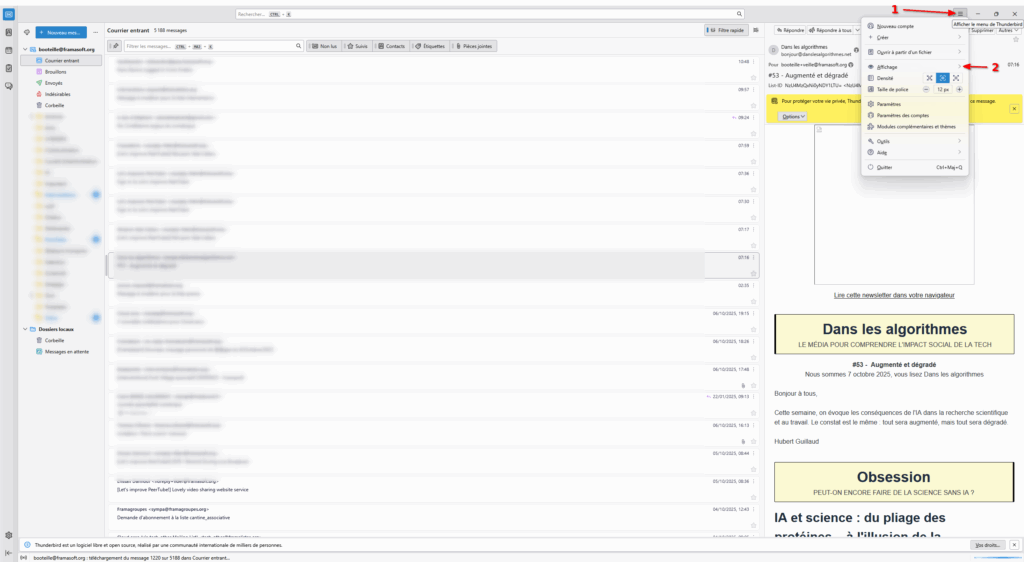

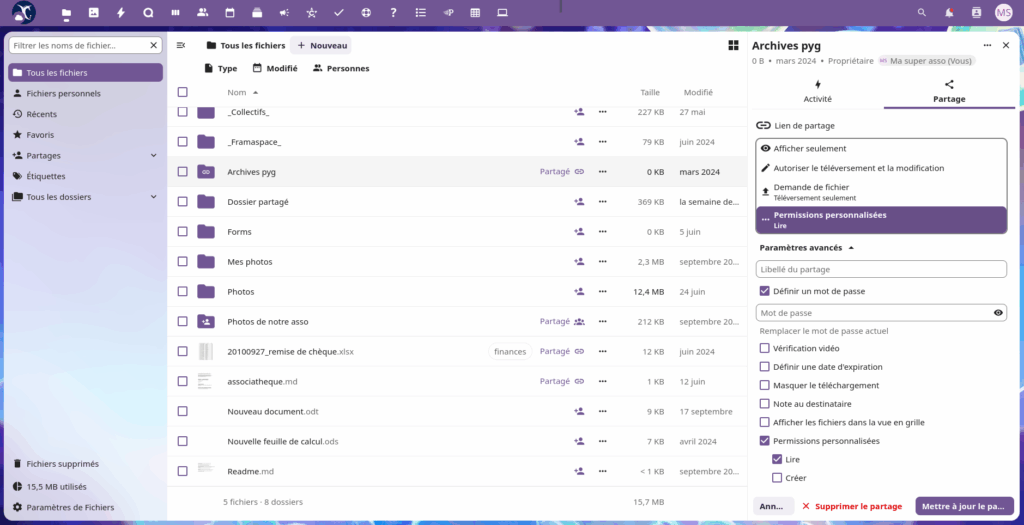

L’affichage du menu pour publier une vidéo. Seules les options « Envoyer le fichier » et « Enregistrer une vidéo » sont disponibles pour le moment.

Télécharger l’application Soutenir Framasoft

Télécharger l’application Soutenir Framasoft

Télécharger l’application Soutenir Framasoft

Construisons la robustesse de PeerTube et Framasoft

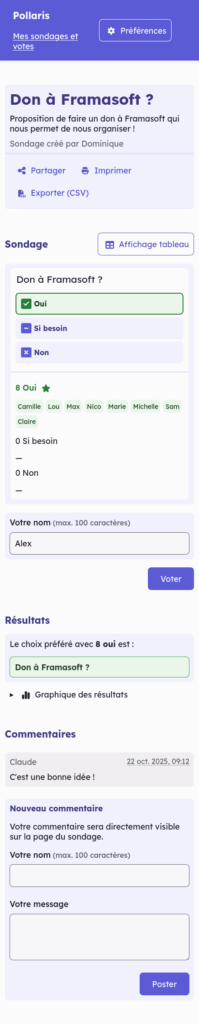

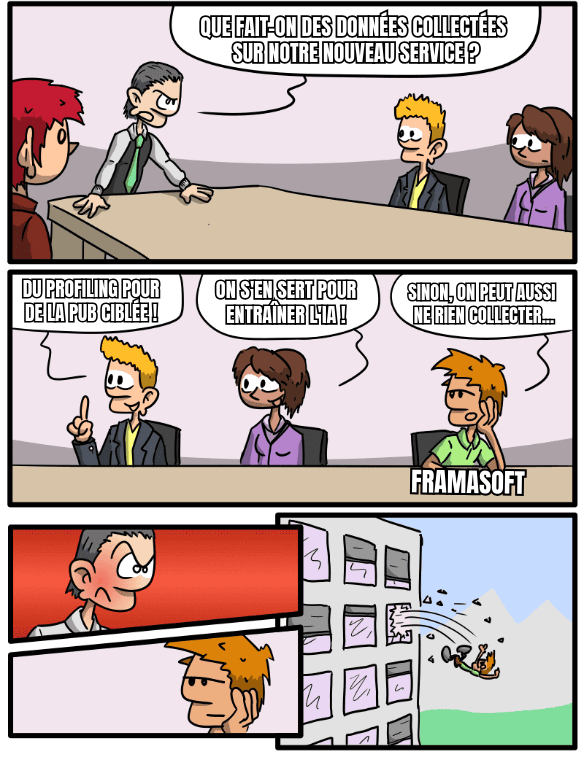

Framasoft (et donc PeerTube) est financé par vos dons !

En soutenant notre modèle basé sur la solidarité, vous permettez non seulement à PeerTube un avenir serein, loin des logiques marchandes, mais aussi à Framasoft de fournir, gratuitement, 23 services alternatifs à ceux des géants du numérique à plus de 2 millions d’utilisateurices !

Pour y parvenir, nous avons besoin de récolter 250 000 € d’ici la fin de l’année.

Grâce à plus de 3000 personnes, nous avons déjà récolté près de 150 000 € ! 🥳

Contribuez à renforcer la robustesse de Framasoft en nous faisant un don (défiscalisé à 66 % pour les contribuables français·es) et en partageant le mot avec vos proches !

Ensemble, prouvons qu’il est possible de construire un numérique non-marchand, accessible à toustes !

Télécharger l’application Soutenir Framasoft

Les illustrations ont été conçue par David Revoy et sont sous licence CC-BY 4.0.

15.12.2025 à 07:42

Khrys’presso du lundi 15 décembre 2025

Khrys

Texte intégral (9837 mots)

Comme chaque lundi, un coup d’œil dans le rétroviseur pour découvrir les informations que vous avez peut-être ratées la semaine dernière.

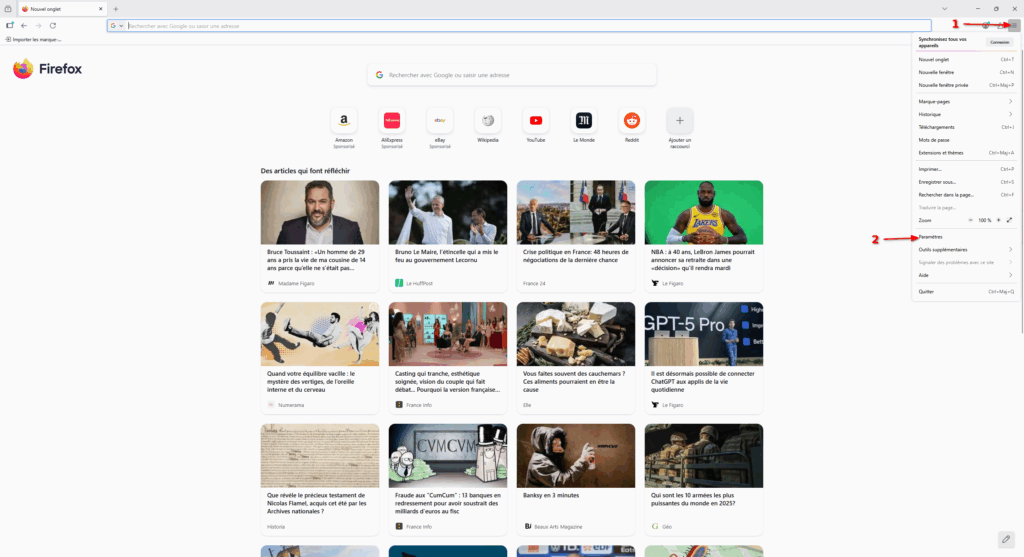

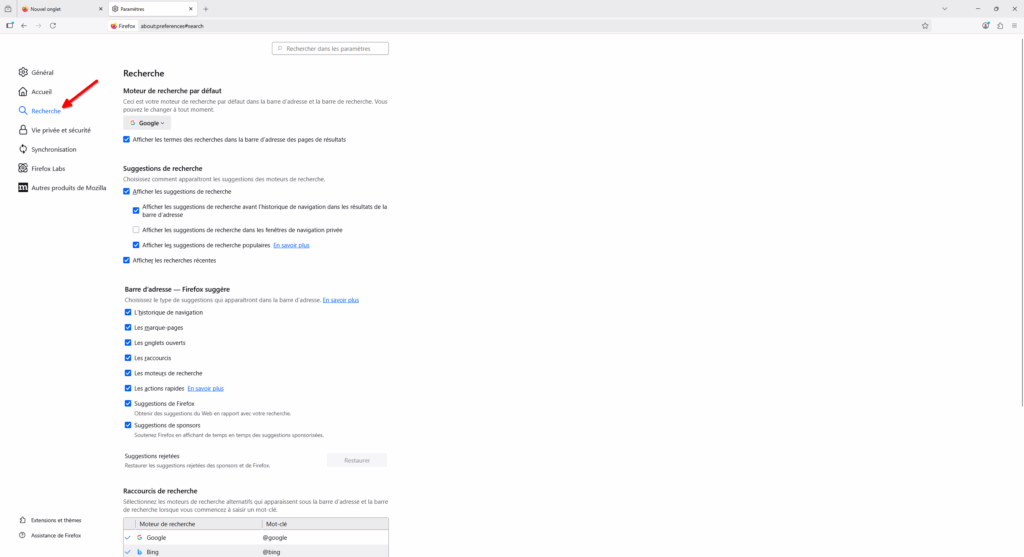

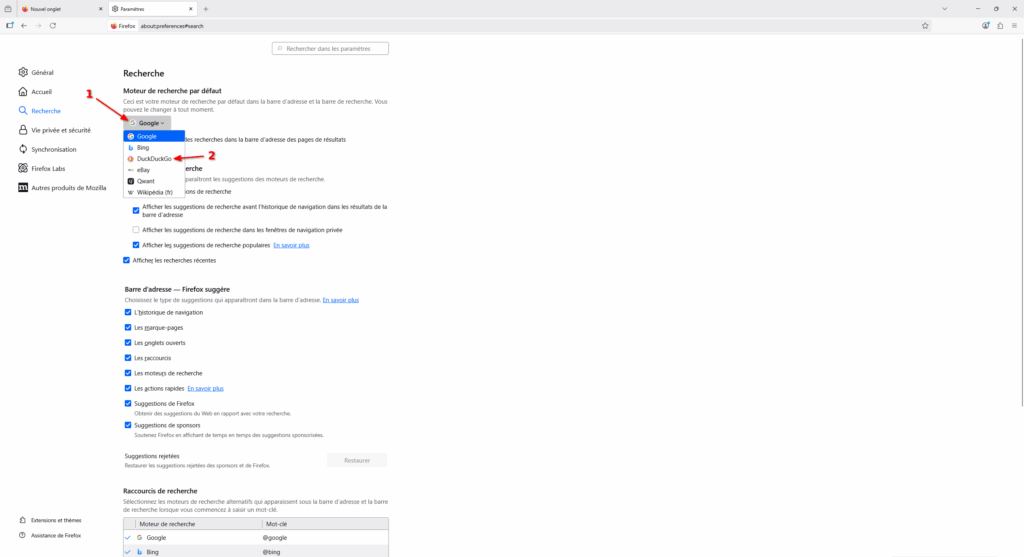

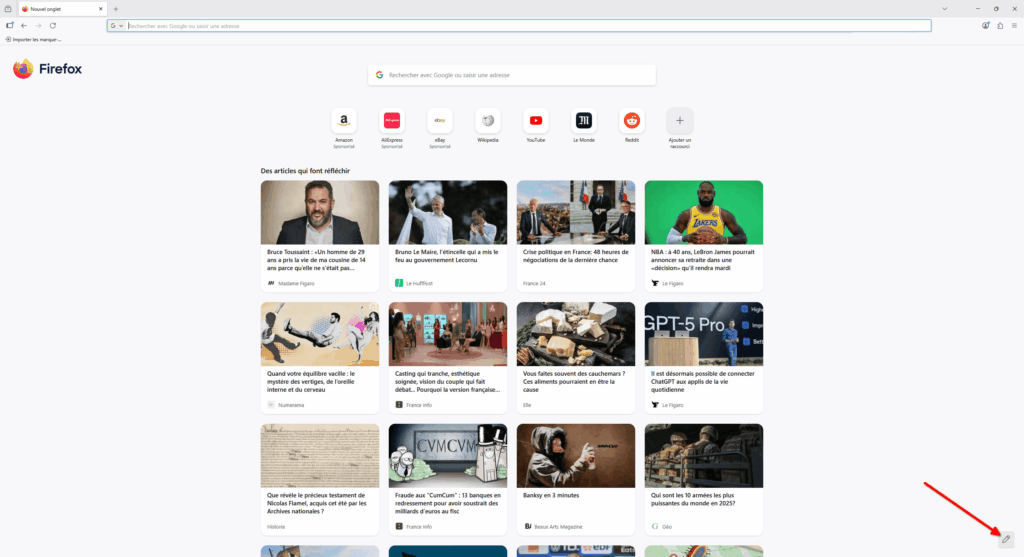

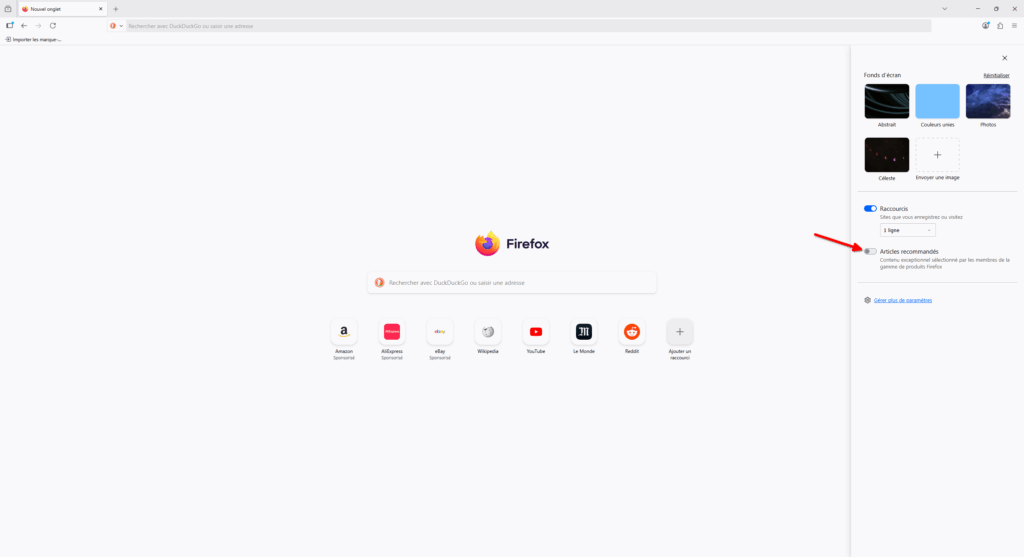

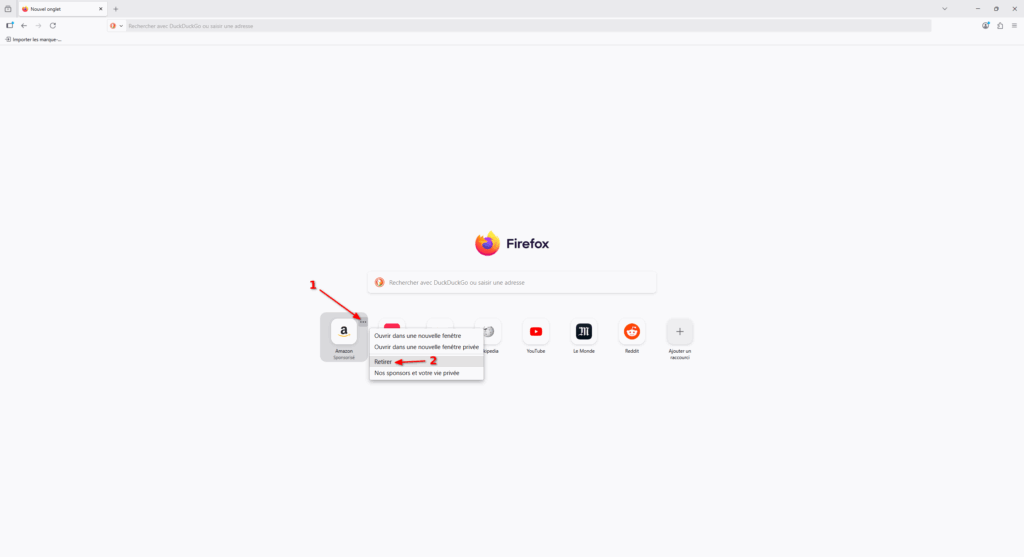

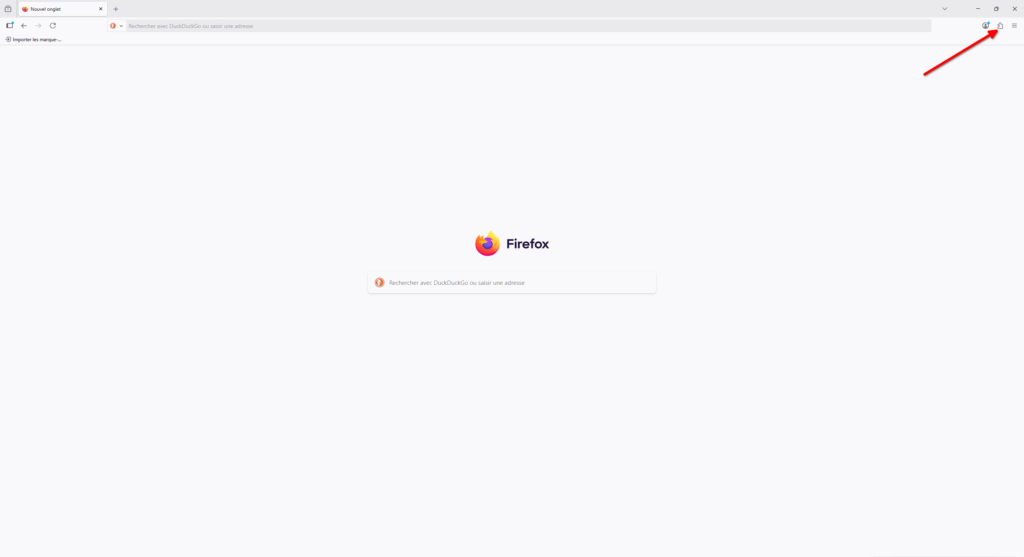

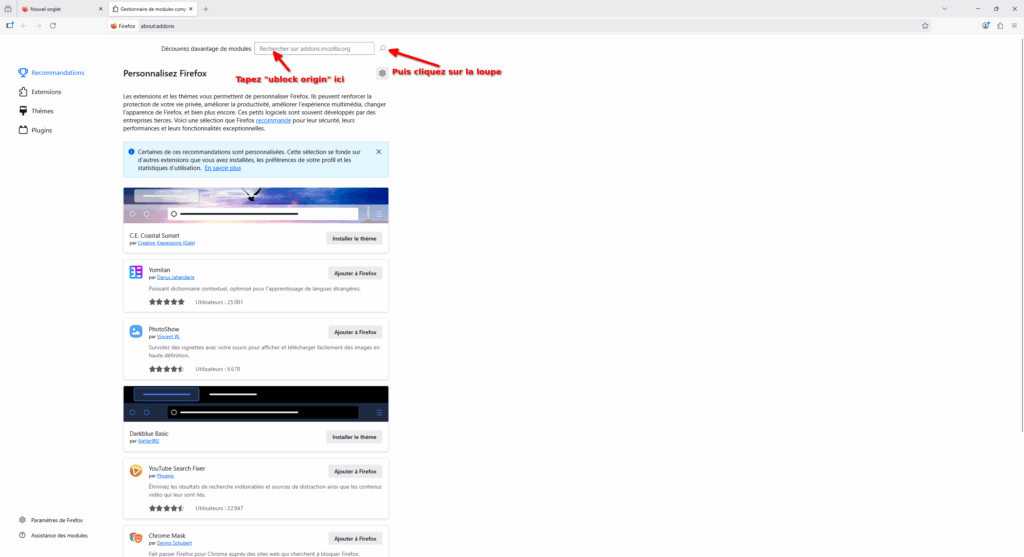

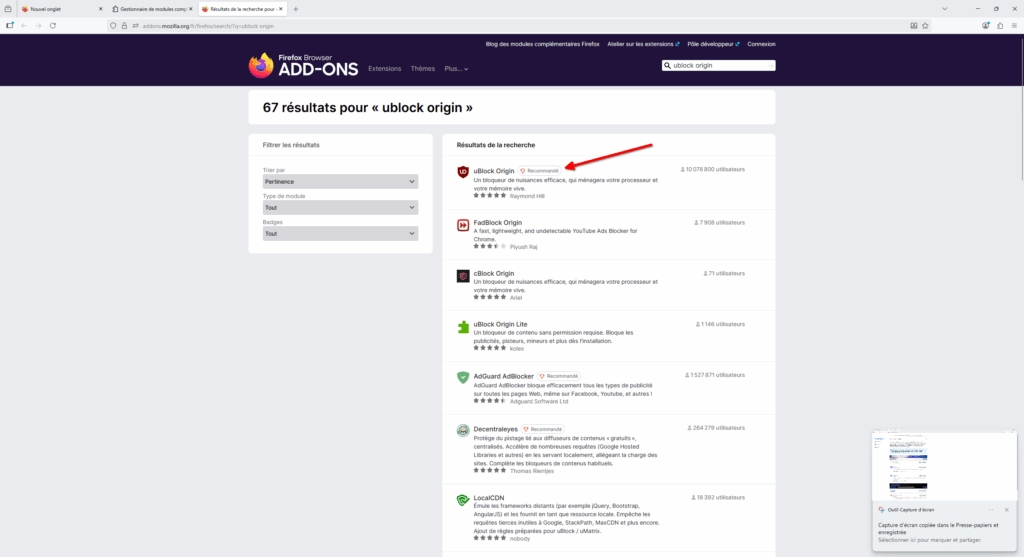

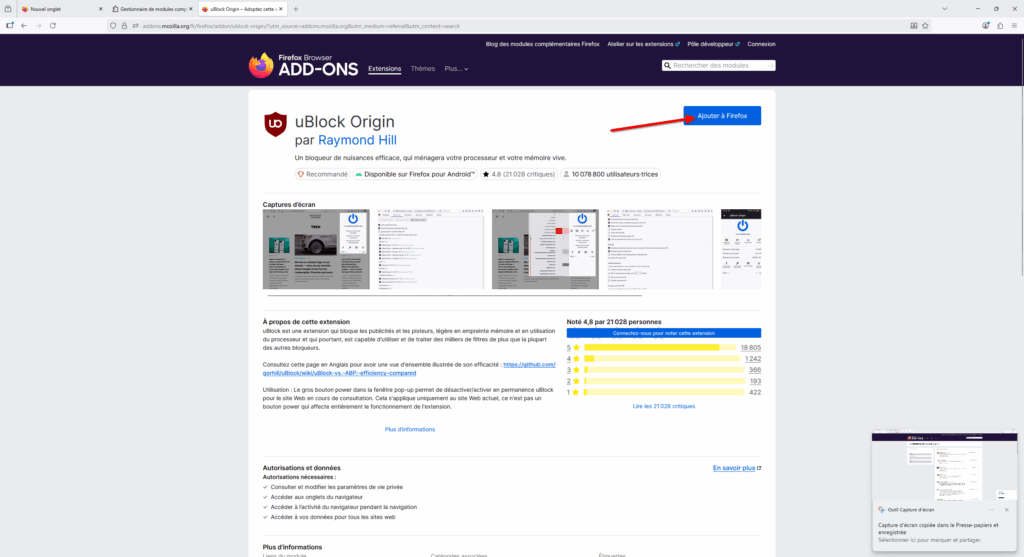

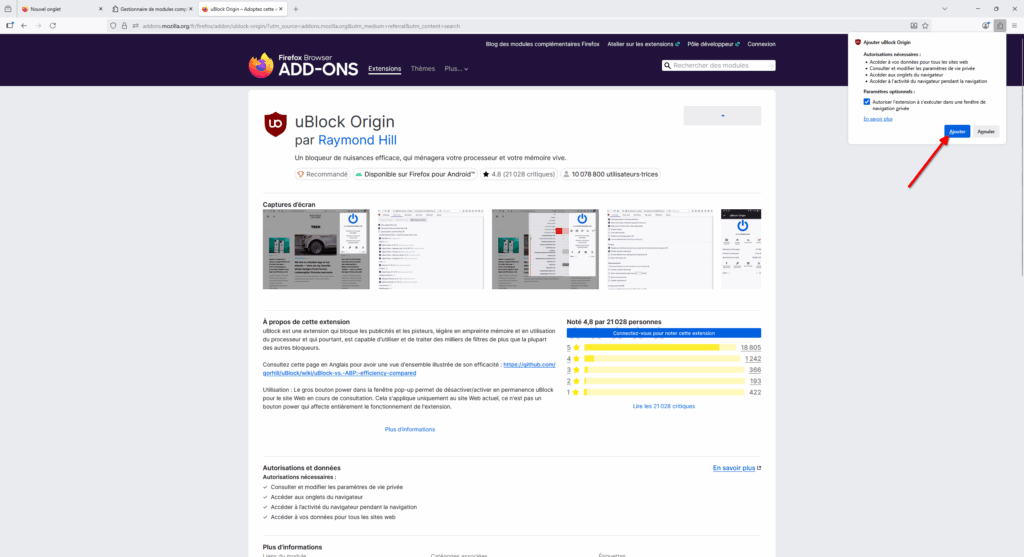

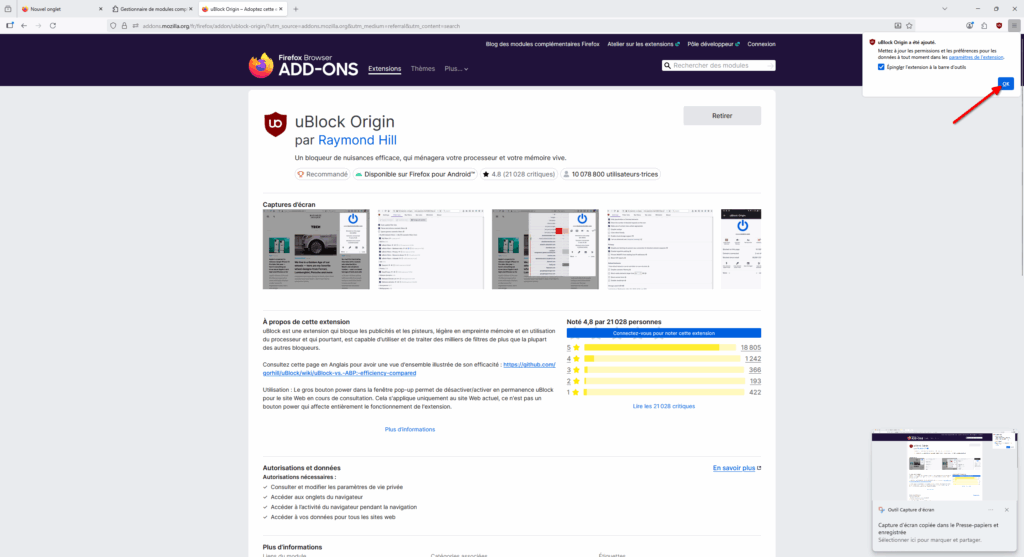

Tous les liens listés ci-dessous sont a priori accessibles librement. Si ce n’est pas le cas, pensez à activer votre bloqueur de javascript favori ou à passer en “mode lecture” (Firefox) ;-)

Brave New World

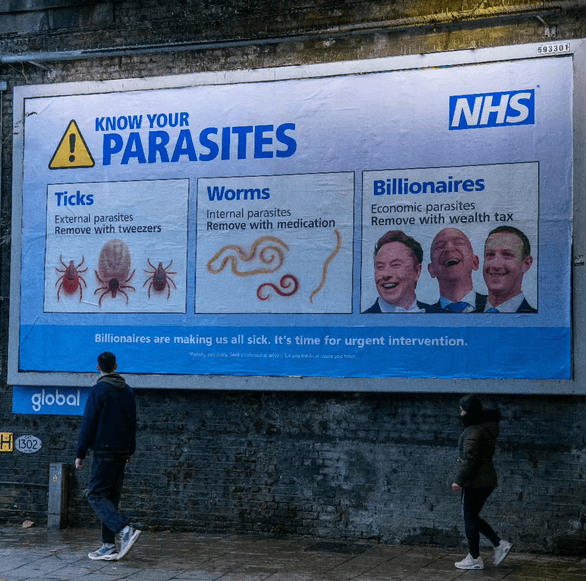

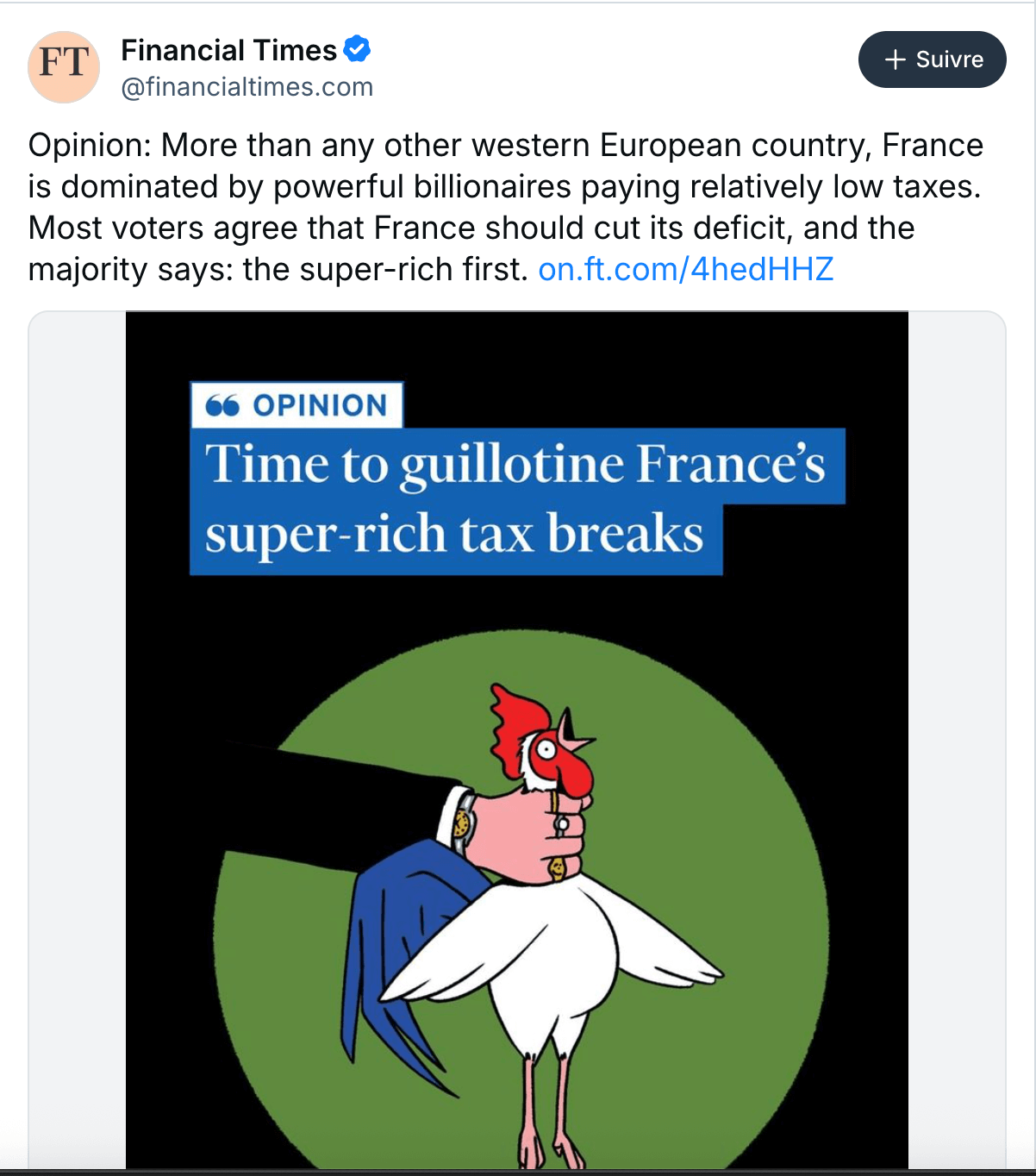

- Il n’y a jamais eu autant de milliardaires qu’en 2025, ne vous inquiétez pas pour eux (slate.fr)

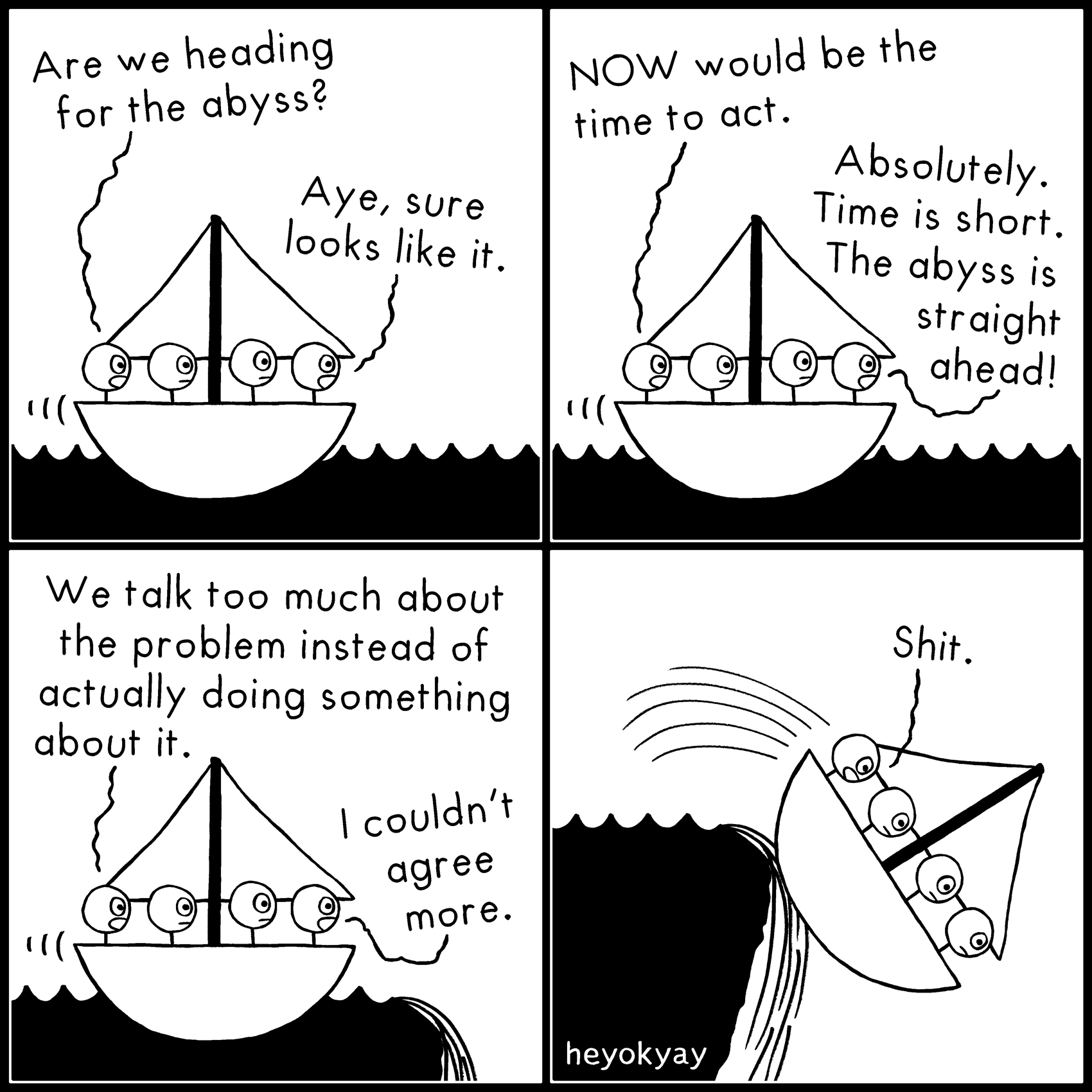

- Justice climatique : le droit impuissant face à l’inaction des États (reporterre.net)

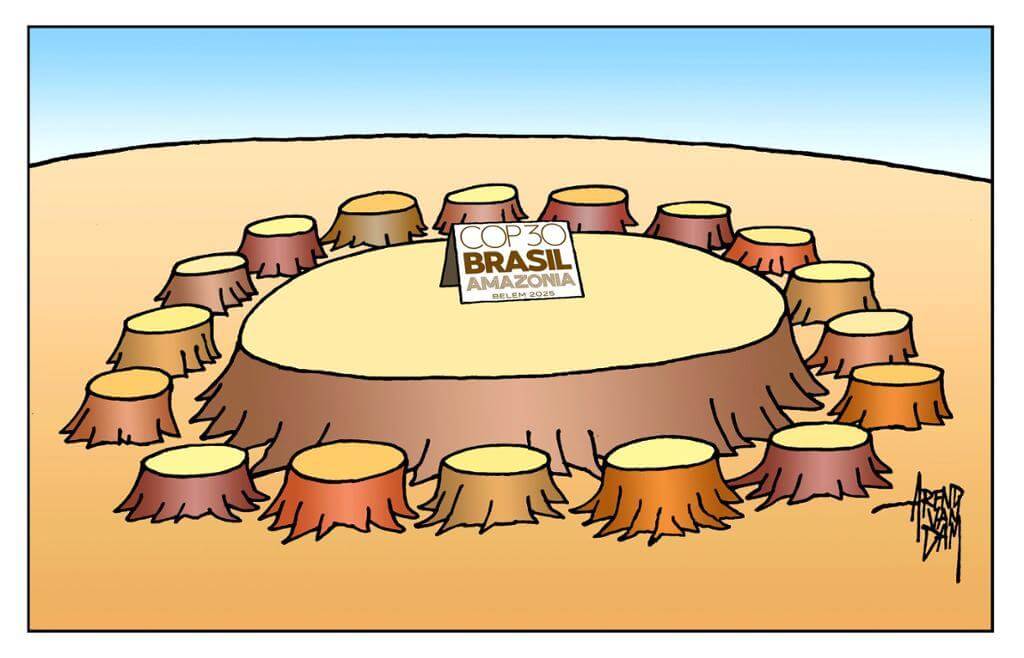

- Accord de Paris : dix ans plus tard, que reste-t-il du traité ? (reporterre.net)

- Australie : au moins onze morts après une fusillade en pleine fête juive sur une plage de Sydney (france24.com)

La police australienne demande au public d’éviter le secteur de la célèbre plage Bondi, à Sydney, où une fusillade a fait au moins 12 morts. Des centaines de personnes s’étaient rassemblées pour célébrer la fête juive de Hanoukka. L’un des tireurs présumés a été tué, le second a été blessé.

- L’Australie interdit les réseaux sociaux aux moins de 16 ans : un modèle bientôt suivi par d’autres pays ? (theconversation.com)

- Les Japonais·es en faveur du mariage pour toustes, à contre-courant de leur gouvernement (ouest-france.fr)

- The Data Breach That Hit Two-Thirds of a Country (yro.slashdot.org)

Online retailer Coupang, often called South Korea’s Amazon, is dealing with the fallout from a breach that exposed the personal information of more than 33 million accounts – roughly two-thirds of the country’s population – after a former contractor allegedly used credentials that remained active months after his departure to access customer data through the company’s overseas servers.

- Comment Shenzhen est devenu l’atelier du monde (multinationales.org)

En 1980, en guise de premier acte de sa réouverture économique, la Chine inaugure la zone économique spéciale de Shenzhen, destinée à attirer les multinationales du monde entier. La ville deviendra la capitale de la mondialisation dans les années 1990, avec son côté obscur en termes d’exploitation des travailleurs, et le berceau de multinationales chinoises comme Huawei et BYD.

- New mapping reveals hidden mining boom in Laos that threatens the Mekong (news.mongabay.com)

Satellite analysis has identified 517 suspected riverbank mines in Laos, many likely illegal, with clusters along key Mekong tributaries, raising fears of widespread, unmonitored contamination.

- All of Russia’s Porsches Were Bricked By a Mysterious Satellite Outage (autoblog.com)

Hundreds of Porsches across Russia went dark due to factory security systems going offline, leading to speculation whether the failure was intentional.

- Nucléaire : le réacteur accidenté de Tchernobyl n’est plus confiné (reporterre.net) – voir aussi Chernobyl radiation shield has stopped working after Russian drone strikes, UN warns (politico.eu)

- « Zone démilitarisée » dans l’est de l’Ukraine, accord de paix avant Noël… Washington s’impatiente, Zelensky tente de peser sur les négociations (humanite.fr)

- They Droned Back (digitaldigging.org) Young journalists expose Russian-linked vessels circling off the Dutch and German coast

- Syrie. De la libération à la libéralisation (orientxxi.info)

Il y a un an, le 8 décembre 2024, le président syrien Bachar Al-Assad tombait, laissant place à une administration dirigée par Ahmed Al-Charaa. Malgré les incertitudes en termes de stabilité, une libéralisation est à l’œuvre. Elle bénéficie avant tout à la Turquie et aux monarchies du Golfe. De son côté, en l’absence de reconstruction concrète, la population n’a que peu de perspectives économiques.

- Les États-Unis et l’Arabie saoudite bloquent une publication phare de l’ONU sur l’environnement (reporterre.net)

- Le géant français de la banane mis en demeure au Cameroun (reporterre.net)

La Compagnie fruitière, géant français de la banane, fait l’objet d’une mise en demeure pour des atteintes présumées aux droits humains et à l’environnement dans sa filiale camerounaise des Plantations du Haut-Penja.

- Benin’s December 7 failed coup : Fact-checking online mis and disinformation (ghanafact.com)

The coup of December 7, 2025, in Benin failed, but conversations online during and after the incident showed a mix of anti-democratic rhetoric and the spread of false and harmful content. GhanaFact analyses the recirculation of old images and videos, misuse of AI and how official disclaimers helped control misinformation.

- « Tout ce qui se trouve dans l’eau va mourir » : en Algérie, les déchets de la production d’huile d’olive polluent les fleuves (reporterre.net)

- Italie : 500 000 personnes défilent contre le budget Giorgia Meloni (humanite.fr)

Un demi-million de personnes ont défilé dans les rues italiennes d’après la confédération syndicale, la CGIL pour s’opposer au projet budgétaire 2026. La coalition d’extrême droite dirigée par Giorgia Meloni a présenté des coupes drastiques avec 18 milliards de dépenses alors que les salaires stagnent et les prix ne cessent d’augmenter.

- Des pesticides autorisés de manière illimitée en Europe : 2300 scientifiques alertent (basta.media)

La Commission européenne va présenter le 16 décembre un projet de règlement visant à autoriser des pesticides de manière illimitée, contre un examen aujourd’hui tous les dix ou quinze ans. 2300 scientifiques alertent dans cette lettre ouverte.

- Parmi les dix pays les plus indépendants en matière d’énergie, sept sont européens (legrandcontinent.eu)

l’Islande est le pays le plus indépendant et le plus résilient sur le plan énergétique, près de 90 % de sa consommation provenant d’énergies renouvelables. Le pays est suivi par la Norvège, la Suisse et la Suède, qui présentent également une faible dépendance vis-à-vis des combustibles fossiles — et sont ainsi parmi les moins exposés à des risques de pannes d’électricité majeures.

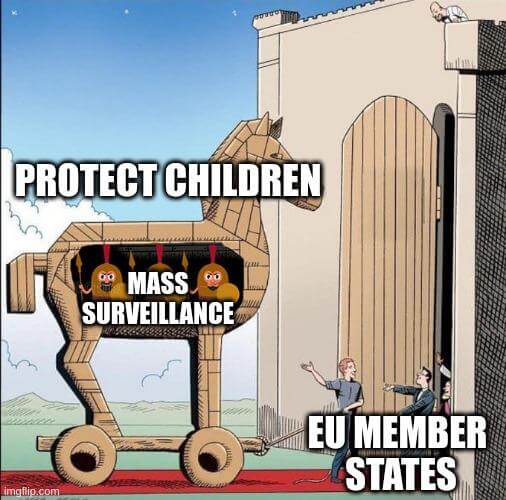

- After Years of Controversy, the EU’s Chat Control Nears Its Final Hurdle : What to Know (eff.org)

- Le marché européen représente environ un quart des revenus mondiaux des Big Tech (legrandcontinent.eu)

- Elon Musk’s X bans European Commission from making ads after €120m fine (bbc.com)

X has blocked the European Commission from making adverts on its platform – a move which comes a few days after it fined Elon Musk’s site €120m (£105m) over its blue tick badges.

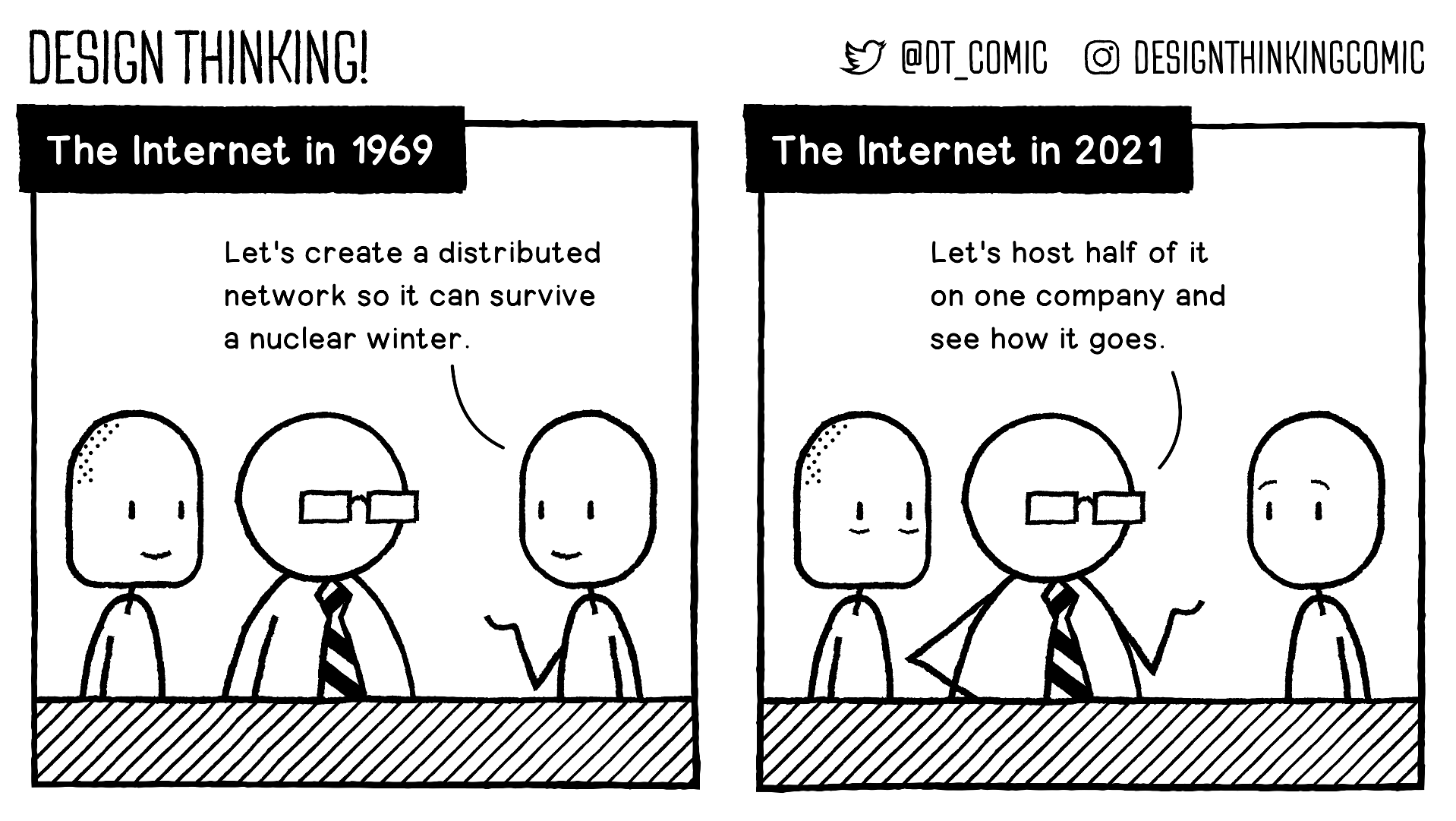

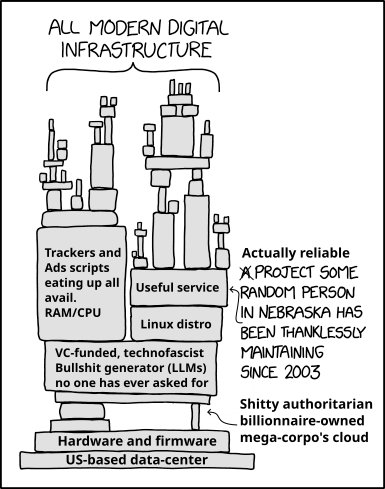

Voir aussi The world needs social sovereignty (blog.joinmastodon.org)

Elon Musk’s X platform has blocked the European Commission from making advertisements, presumably in response to the €120 million fine for its misleading verification system and overall lack of transparency. We’re grateful to Elon Musk for proving once again why the world needs to log off corporate-owned, centrally-controlled social media platforms and log on to a better way of being online. The world needs an open social web through the fediverse and Mastodon.

- Les États-Unis de Trump actent leur divorce avec l’Europe (politis.fr)

- Donald Trump is pursuing regime change – in Europe (theguardian.com)

- L’administration Trump veut que les touristes exemptés de visas, dont les Français, fournissent l’historique de leurs réseaux sociaux. (lemonde.fr)

- Axon Tests Face Recognition on Body-Worn Cameras (eff.org)

- Kilmar Abrego Garcia, symbole de la chasse aux migrants de Donald Trump, libéré par la justice (humanite.fr)

Kilmar Abrego Garcia, un Salvadorien expulsé par erreur par l’administration du locataire de la Maison Blanche puis ramené aux États-Unis après des mois de guérilla judiciaire et de nouveau enfermé, a été relâché jeudi 11 décembre sur décision de justice.

- Palantir CEO Says Making War Crimes Constitutional Would Be Good for Business (gizmodo.com)

- “Domestic Terrorism” : Leaked DOJ Memo Targets “Anti-Americanism, Anti-Capitalism, Anti-Christianity” (democracynow.org)

- FBI Leader Crumbles During Basic Questions About Threat of “Antifa” (newrepublic.com)

Well, this sure sounds like a confession that antifa’s designation as a domestic terror group was based on nothing.

- Font Wars : Times New Roman vs. Calibri in U.S. Diplomacy (devdiscourse.com)

The U.S. State Department has reverted to using Times New Roman in official communications, reversing the previous administration’s choice of Calibri, which was promoted for accessibility. This decision aligns with conservative views rejecting diversity, equity, and inclusion initiatives as wasteful and contrary to merit-based principles.

- RFK Jr.’s health department is using religious freedom to strip transgender people of health care (advocate.com)

- Trump admin sues school for religious discrimination for punishing Christians who harassed trans kid (lgbtqnation.com)

- American Men Are Flocking To Get Breast Reduction Surgery—And Everyone’s Making The Same Powerful Point (comicsands.com)

it is celebrated when cisgender men pursue this surgery, but condemned when transgender people seek the same outcome.

- Over 250 people quarantined in South Carolina as measles outbreak rages (arstechnica.com)

16 cases are linked to a church, which followed exposures at four schools last week.

- Entre le Venezuela et les États-Unis, la situation ne fait qu’empirer (portail.basta.media)

Sous prétexte de lutte contre le narcotrafic, les États-Unis font depuis plusieurs semaines monter les tensions avec le Venezuela. Les médias indépendants internationaux se penchent sur cette confrontation hautement explosive.

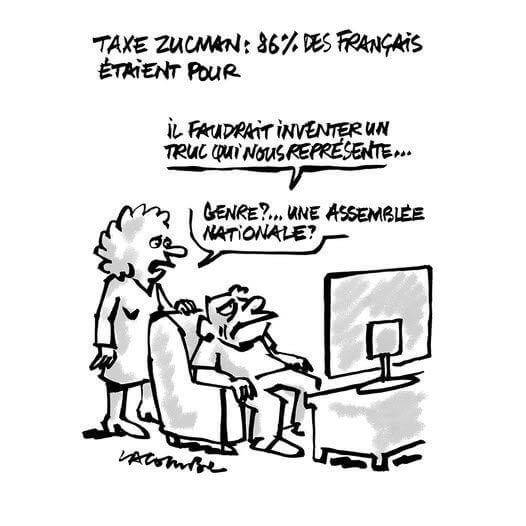

- Le Brésil supprime l’impôt sur le revenu pour les classes moyennes et augmente en contrepartie la fiscalité des plus riches (bfmtv.com)

Les députés brésiliens ont validé la mesure phare du président Lula visant à exonérer les classes moyennes d’impôt sur le revenu. Elle sera financée par une hausse du taux d’impôt des plus riches qui sera multiplié par quatre.

- Au Chili aussi, on cherche à sortir l’agriculture des pesticides (basta.media)

Au Chili, l’agriculture est tournée vers l’exportation et la consommation de pesticides. Des mouvements agricoles et citoyens tentent d’inverser la tendance, alors que l’homme d’extrême droite José Antonio Kast pourrait devenir le prochain président.

- Perturbateurs endrocriniens : 12 substances au cœur d’une étude XXL (politis.fr)

- Scientists Thought Parkinson’s Was in Our Genes. It Might Be in the Water (wired.com)

Since the 1990s, the number of Americans with chronic disease has ballooned to more than 75 percent of adults, per the CDC. Autism, insulin resistance, and autoimmune diagnoses have reached epidemic proportions. The incidence of cancer in people under the age of 50 has hit an all-time high. If Parkinson’s disease is—as Ray Dorsey believes—a pandemic that’s being caused by our environment, it’s probably not the only one

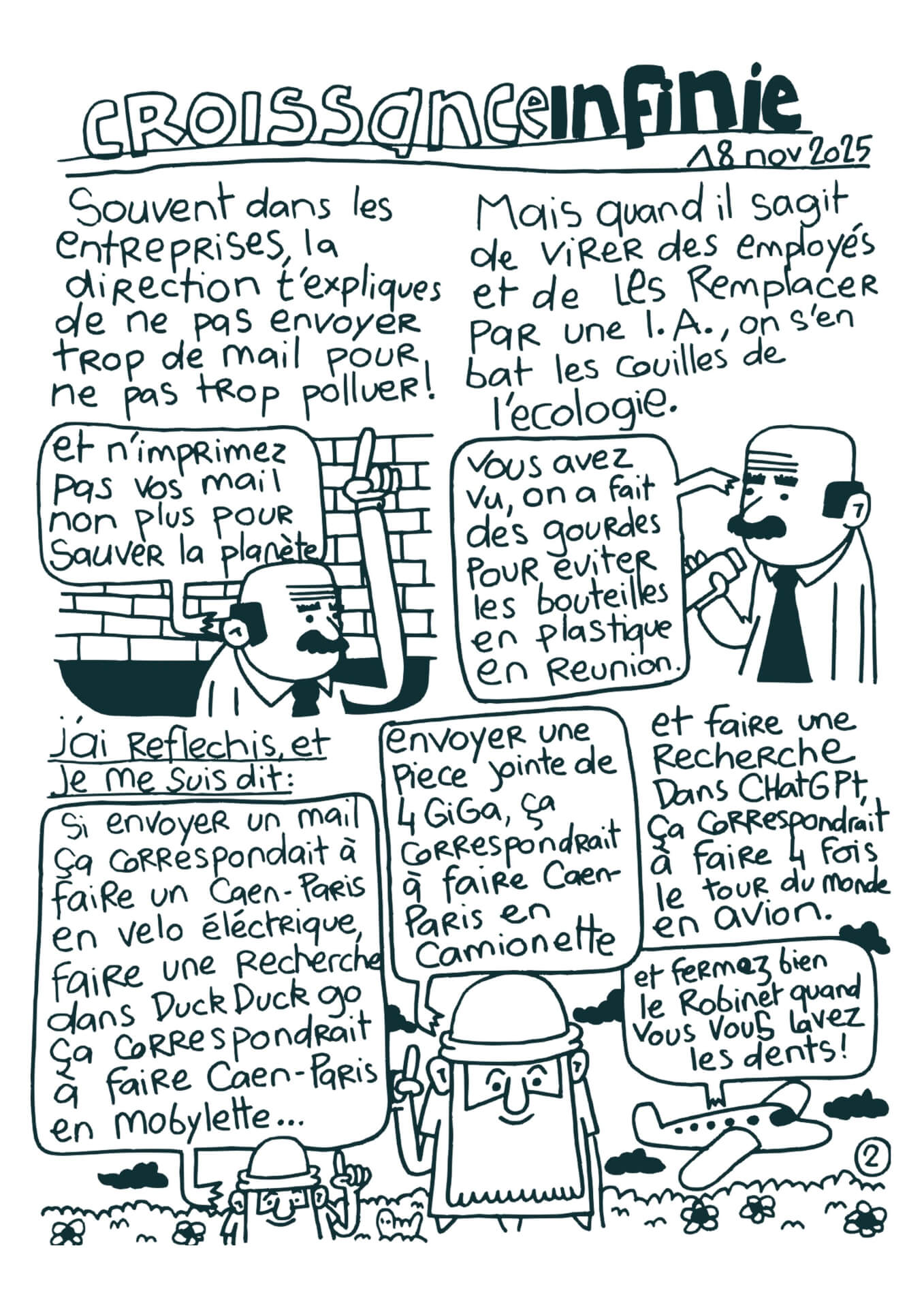

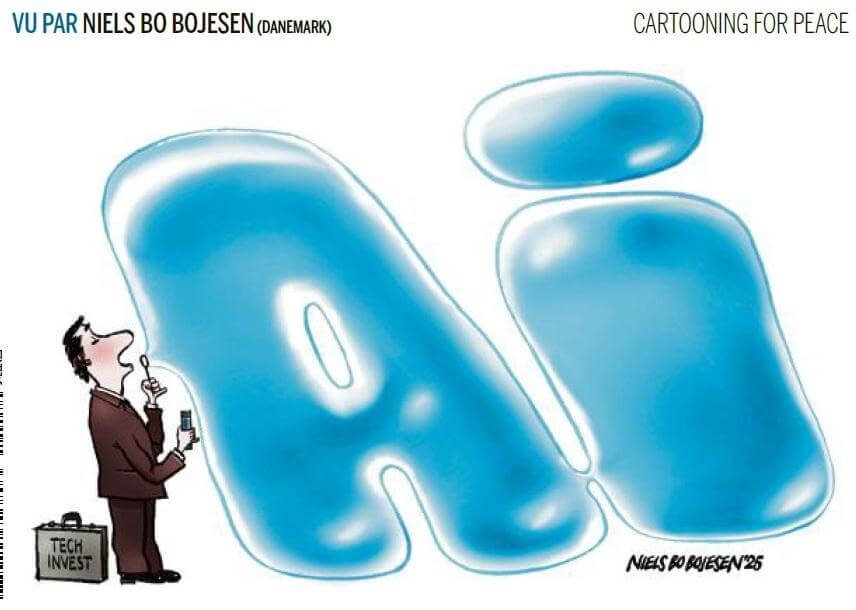

Spécial IA

- La Chine mise sur l’explosion de la bulle IA aux États-Unis — comprendre le plan Yifu Lin (legrandcontinent.eu)

- Cheap and powerful AI campaigns target voters in India (restofworld.org)

The Bihar state election was awash with voice clones and synthetic videos that reached voters easily and spread misinformation.

- VPNs, ‘old man’ masks, and AI : The holes in the social media ban and their fixes (abc.net.au)

Leading facial age estimation tools were easily fooled by a $22 “old man” mask, a Guy Fawkes mask, and other cheap party costumes, researchers have found.

- En Angleterre, des dizaines de trains mis à l’arrêt à cause d’un hoax généré par IA (clubic.com)

- Un virus sur ChatGPT ! Des milliers de Mac déjà infectés (mac4ever.com)

- LA Unified School District forces unfiltered AI on kids (pivottoai.libsyn.com)

- Kindle’s New Gen AI-Powered “Ask This Book” Feature Raises Rights Concerns (writerbeware.blog)

Ask This Book is, in effect, “an in-book chatbot. You ask any question about the book, and a generative AI process provides you answers.”

- Deep learning sur des photos d’enfants autistes : des articles scientifiques rétractés (next.ink)

Plusieurs recherches incluant l’entrainement de réseaux de neurones font l’objet d’une attention particulière […] En cause l’utilisation d’une base de données de photos posant des problèmes éthiques concernant le consentement des enfants ayant des troubles autistiques concernés. L’éditeur Springer Nature est en train de rétracter des dizaines d’articles scientifiques.

- OpenAI Staffer Quits, Alleging Company’s Economic Research Is Drifting Into AI Advocacy (wired.com)

OpenAI has allegedly become more guarded about publishing research that highlights the potentially negative impact that AI could have on the economy

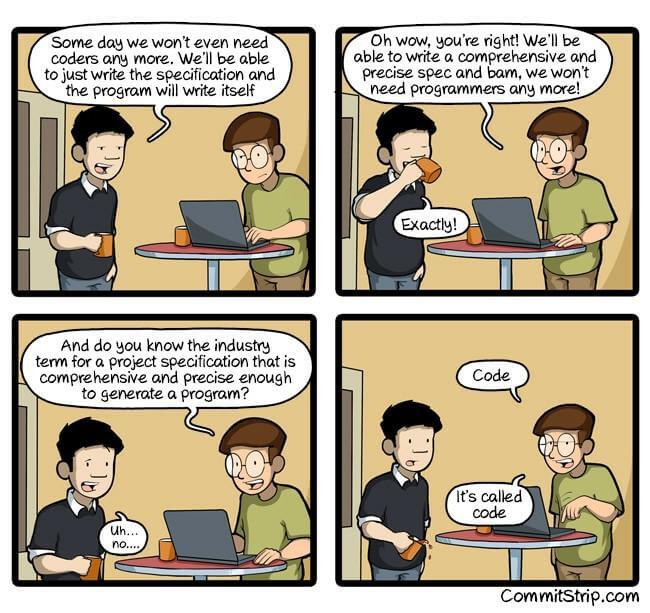

- “Everyone is so panicked” : Entry-level tech workers describe the AI-fueled jobpocalypse (restofworld.org)

Engineering graduates face shrinking opportunities and rising pressure to upskill beyond their curriculum. […] Students at engineering colleges in India, China, Dubai, and Kenya are facing a “jobpocalypse” as artificial intelligence replaces humans in entry-level roles. Tasks once assigned to fresh graduates, such as debugging, testing, and routine software maintenance, are now increasingly automated.

- The Emotional Labor Behind AI Intimacy (data-workers.org)

My name is Michael Geoffrey Asia, and I wrote this testimony to tell the story of workers like me who found ourselves trapped in the hidden corners of the AI industry, where human emotion becomes data.

- Donald Trump signe un décret pour limiter les lois contre l’IA (huffingtonpost.fr)

Alors que la plupart des pays cherchent à réguler les pouvoirs de l’IA, le président américain, lui, agit à contre-courant, lui donnant toujours plus de libertés.

Voir aussi Fact Sheet : President Donald J. Trump Ensures a National Policy Framework for Artificial Intelligence (whitehouse.gov)

- Le magazine Time a désigné les “architectes de l’IA” comme les personnalités de l’année (france24.com)

Le magazine américain Time a révélé, jeudi, les personnalités de l’année 2025. Les “architectes” de l’intelligence artificielle (IA) ont été désignés, parmi lesquels le patron d’Open AI Sam Altman, celui de Nvidia Jensen Huang ou celui de xAI Elon Musk.

- OpenAI joins the Linux Foundation’s new Agentic AI Foundation and the open-source world sees smoke and mirrors (nerds.xyz)

- Mozilla’s Betrayal of Open Source : Google’s Gemini AI is Overwriting Volunteer Work on Support Mozilla (quippd.com)

Mozilla’s translation bot on Support Mozilla (that is currently overwriting user contributions is based on the closed source, copyright infringing LLM, Google Gemini. This is in spite of Mozilla claiming that they are at the forefront of open source AI, and belies their exhortations to choose to build open source AI and data sets.

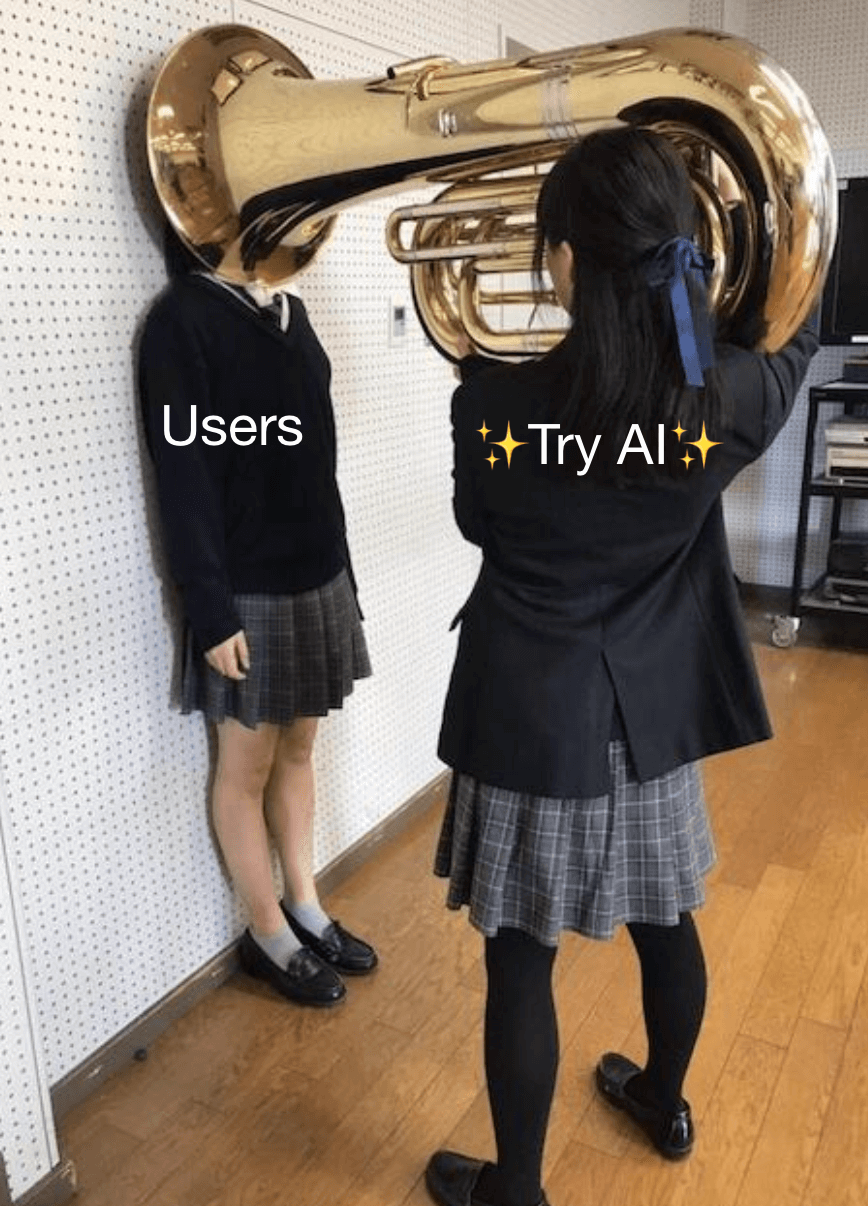

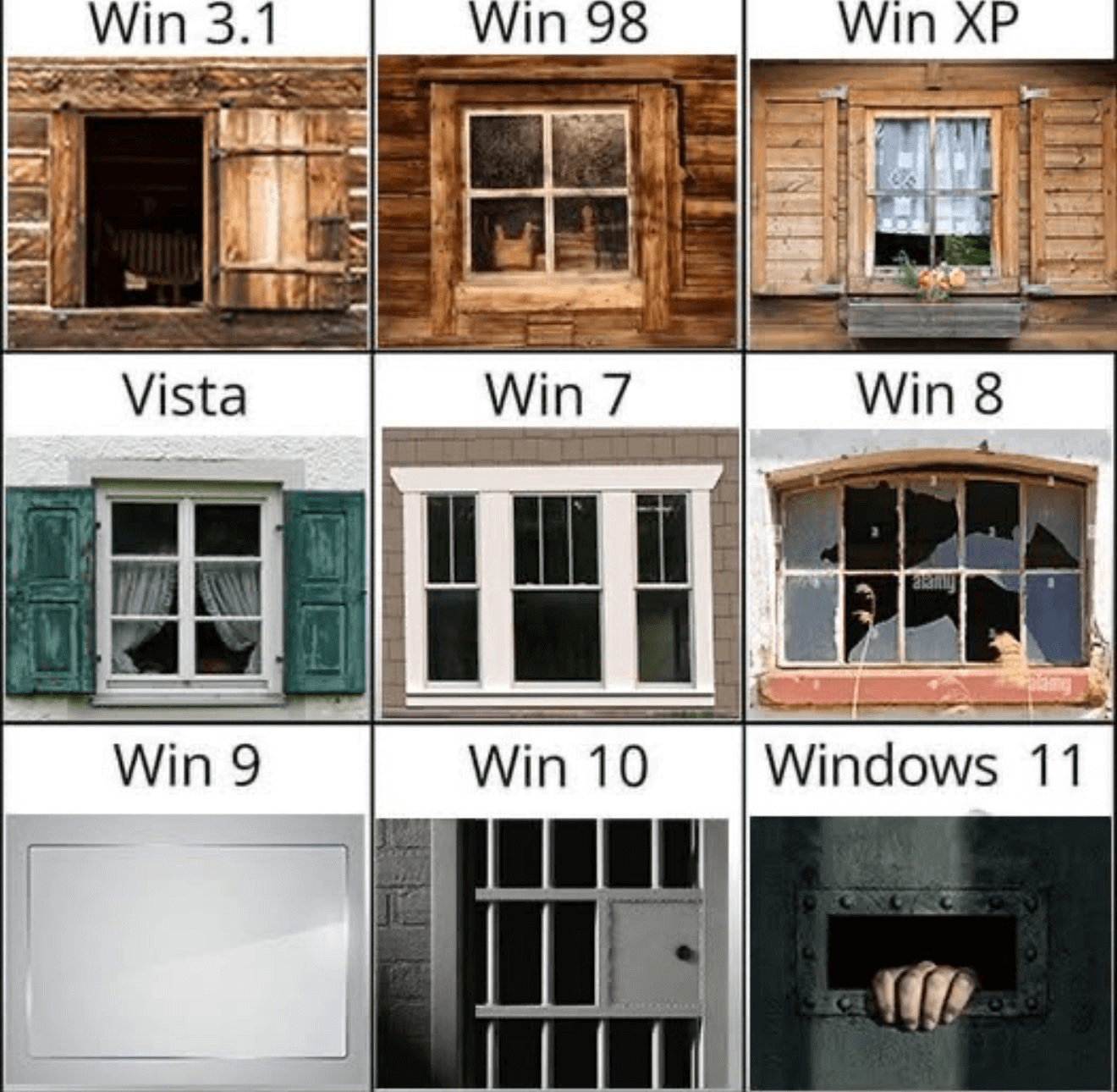

- Vast Number of Windows Users Refusing to Upgrade After Microsoft’s Embrace of AI Slop (futurism.com)

the tech giant’s controversial attempts to shoehorn AI into every aspect of the software appear to have turned off a staggering number of users from upgrading. While it’s to be expected at this point that not everybody will have jumped at the opportunity to update their machine’s operating system, the sheer scale of that refusal is staggering.

- Animation vs intelligence artificielle : la pub “100 % française” qui cartonne à l’international (france24.com)

Une publicité de plus de deux minutes, réalisée par un studio d’animation français pour les fêtes de Noël, est devenue virale avec plus de 20 millions de vues mercredi. “Une centaine de personnes” a travaillé pendant un an sur cette production, un choix artistique largement salué, alors que de grandes marques misent sur l’intelligence artificielle pour leurs spots.

- Conseil de l’intelligence artificielle et du numérique : quelles priorités pour 2026 ? (agora.gouv.fr)

Alors que le CIANum est en train de définir son programme de travail pour l’année à venir, cette consultation vise à recueillir vos priorités et préoccupations sur le numérique et l’intelligence artificielle, afin de guider ses travaux.

- Policy on the use of Generative Artificial Intelligence for NLnet-funded projects (nlnet.nl)

Spécial Palestine et Israël

- Israel’s biggest defence company suspended by NATO amid corruption probe (ftm.eu)

- « La surveillance des Palestinien·nes en Europe est très répandue » (politis.fr)

En Europe, les Palestiniens sont de plus en plus ciblés par les surveillances numériques ou les fermetures de comptes bancaires. Layla Kattermann, responsable de la veille pour l’European Legal Support Center, revient sur ce standard européen de surveillance.

- Vente d’armes à Israël : l’État stoppe les livraisons de composants pour drones fabriqués par l’entreprise Sermat (disclose.ng)

- L’ENS de Lyon mise en demeure pour rompre ses partenariats avec les universités israéliennes complices du génocide (rebellyon.info)

L’ENS de Lyon est partenaire de plusieurs universités israéliennes complices du génocide : Urgence Palestine Lyon, l’association NIDAL et plusieurs syndicats et collectifs étudiants de l’ENS lancent une action en justice.

- Condamné à un an de prison avec sursis en première instance, le responsable de la CGT du Nord de retour au tribunal pour contester la criminalisation du soutien à la Palestine (humanite.fr)

- La fabrique d’un boycott : comment Israël a perdu le charbon colombien (terrestres.org)

Cet article est la version française et enrichie de « The Making of a Coal Boycott. Inside the campaign to break the toxic relationship between Colombian mining and Israeli militarism », une enquête parue dans la revue Jewish Currents en octobre 2025.

- Eurovision winner Nemo to return trophy in protest of Israel (bbc.com)

The 26-year-old Swiss singer said there was a “clear conflict” between Israel’s involvement in the competition and the ideals of “unity, inclusion and dignity” the contest says it stands for.

Spécial femmes dans le monde

- Narges Mohammadi, la prix Nobel de la paix 2023, a été violemment arrêtée en Iran (huffingtonpost.fr)

La journaliste iranienne de 53 ans est en opposition avec le régime des mollahs et elle a déjà passé de nombreuses années en prison pour des délits d’opinion.

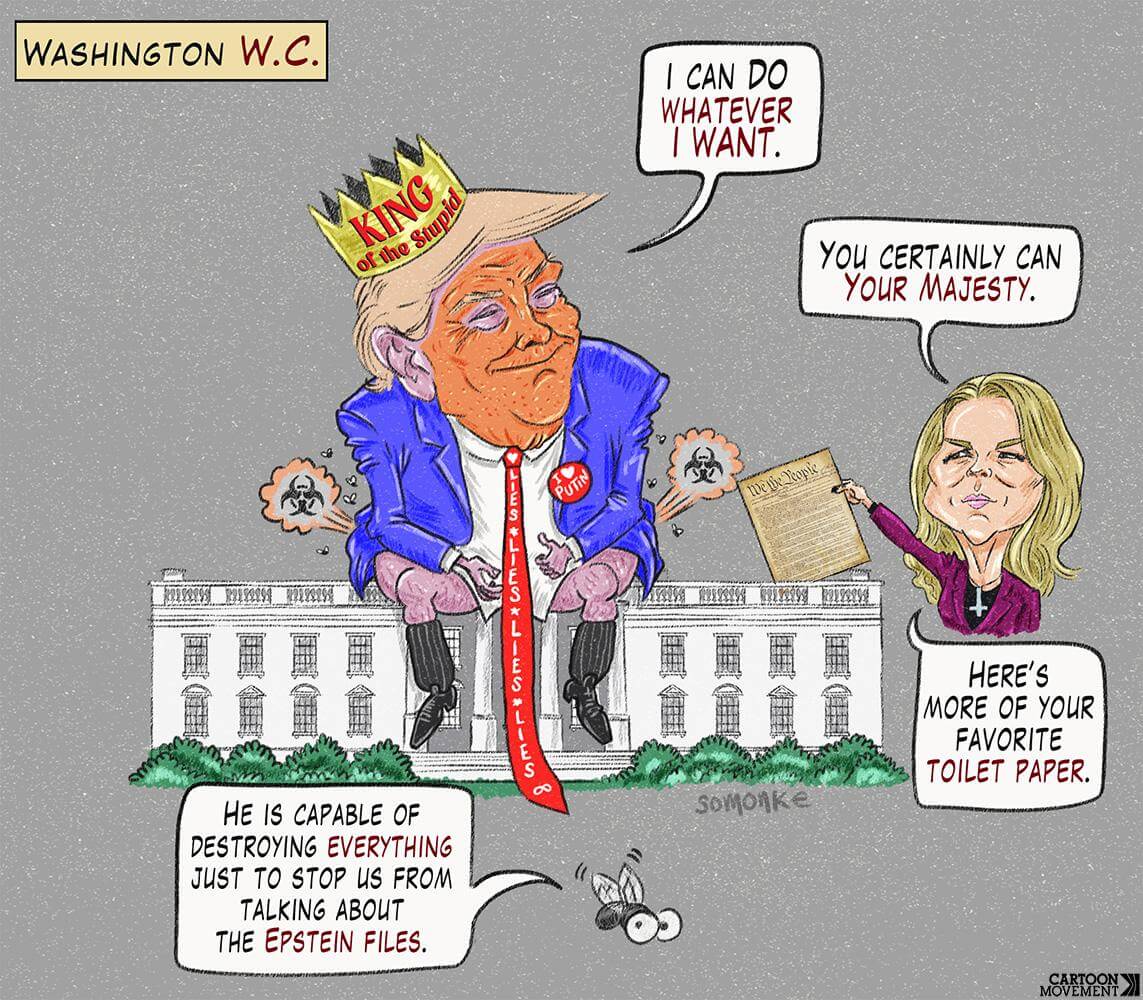

- Dans le dossier Epstein, ce « préservatif Trump » ne va pas arranger le cas du président américain (huffingtonpost.fr)

Parmi ces 19 clichés, l’un montre un bol rempli de préservatifs fantaisistes avec une caricature du visage de Donald Trump. Il est inscrit juste au-dessus sur un écriteau : « préservatif Trump, 4,50 dollars ». Et chaque préservatif porte une image du visage du président américain avec le texte : « je suis ÉNOOOORME ! »

- How boys get sucked into the manosphere (stories.theconversation.com)

- On a revu la série “Drôles de dames”… et c’est un carnage (telerama.fr)

Notre journaliste s’est replongée avec appréhension dans la série de son enfance, disponible sur la plateforme de l’INA. Mise en scène sexiste, dialogues paternalistes et intrigues taillées pour ces messieurs : le verdict n’est pas bon.Non sans blague.

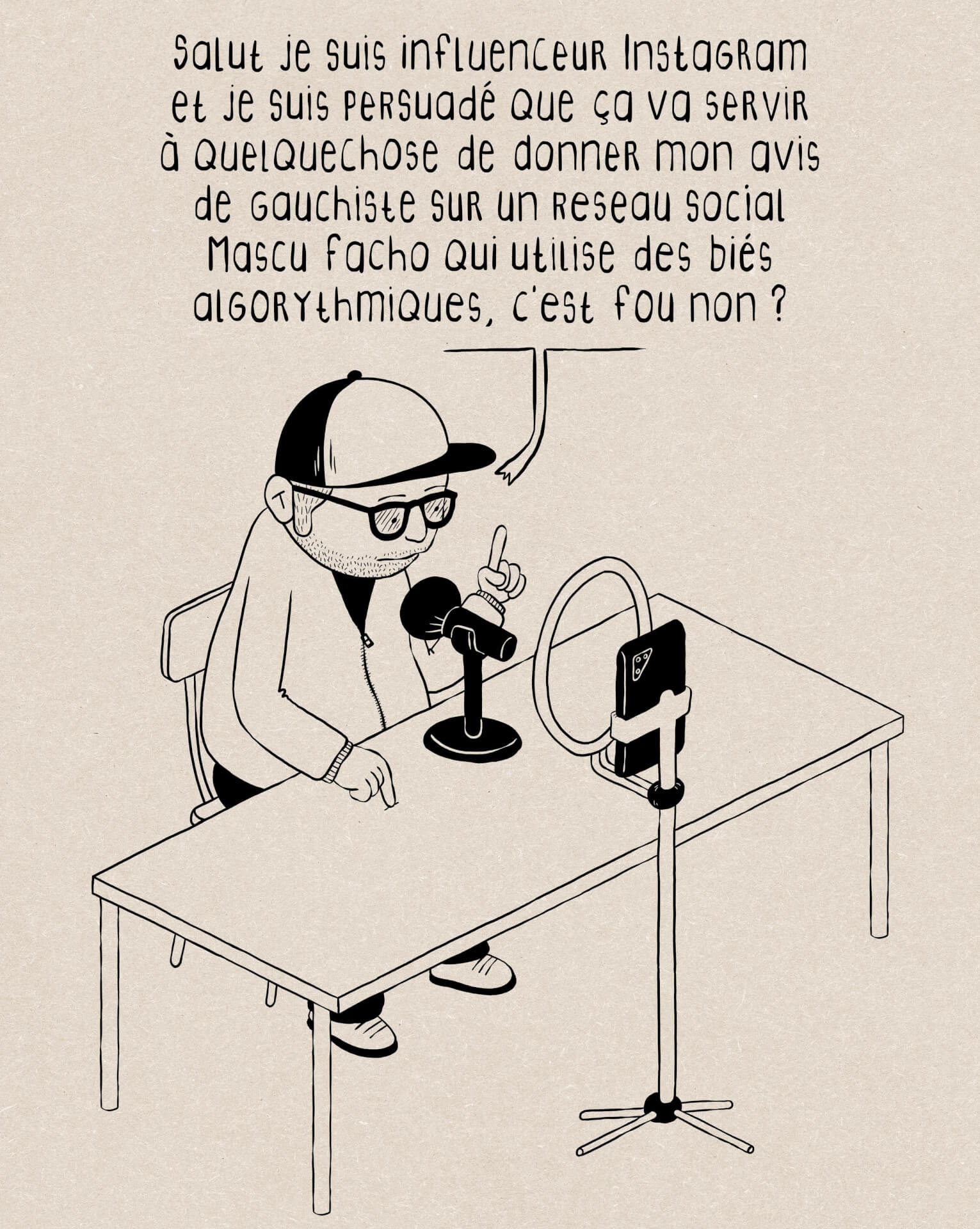

- L’invisibilisation des associations féministes sur Meta n’est pas un bug : c’est un choix politique (nouvelobs.com)

- Une moustache, un prénom masculin… et la visibilité explose sur LinkedIn ! (lesnouvellesnews.fr)

- ‘The patriarchy runs deep’ : women still getting a raw deal in the workplace as equality remains a dream (theguardian.com)

Women work longer and per hour earn a third of what men are paid, in figures that have changed little in 35 years, UN report shows

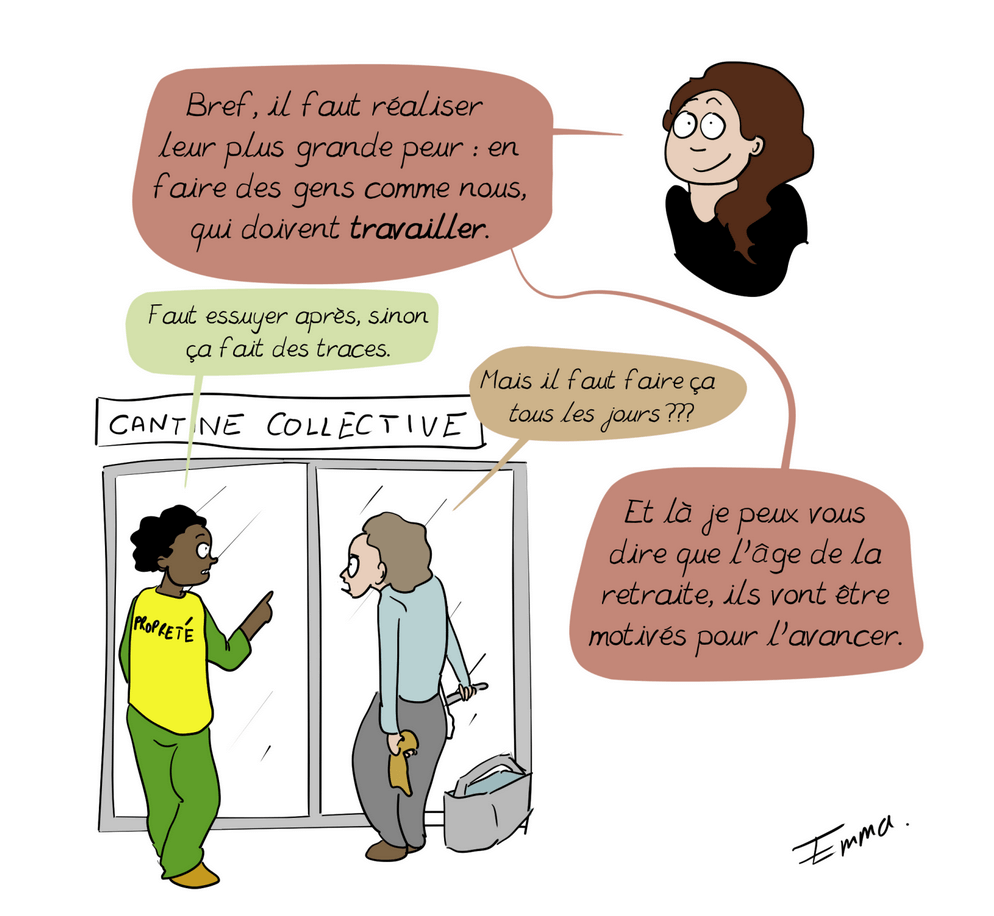

- Les femmes assument une grande partie des tâches domestiques, non rémunérées : Bogota a décidé de les aider (slate.fr)

Depuis 2020, la capitale colombienne a mis en place 25 centres pour épauler et soulager les personnes qui effectuent un travail invisible et gratuit, souvent sans s’en rendre compte. Des programmes d’aide à domicile ainsi que des formations sont également proposés.

- Lili Reinhart diagnostiquée de l’endométriose après des années d’errance : « je suis contente d’avoir écouté mon corps » (huffingtonpost.fr)

L’actrice de « Riverdale » a obtenu un diagnostic après des années d’errance médicale et d’avis contradictoires.

- Et si la masturbation pouvait réduire les effets indésirables de la ménopause ? (theconversation.com)

Une étude récente relayée dans le monde entier suggère que la masturbation pourrait atténuer certains symptômes désagréables chez les femmes en périménopause ou ménopause. Si cette attention médiatique peut surprendre, c’est sans doute parce que la masturbation reste peu évoquée, surtout chez les femmes plus âgées, et apparaît ici comme une stratégie inédite–voire audacieuse–de soulagement.

Spécial France

- Adoption du budget de la Sécurité sociale pour 2026 (projetarcadie.com) – voir aussi Les 8 mesures phares du budget de la Sécu 2026 (rapportsdeforce.fr)

- Le ministère de l’Intérieur victime d’une « attaque informatique » visant « un certain nombre de fichiers » (huffingtonpost.fr)

- Un bug informatique menace de bloquer le RER A et huit lignes de métro en 2038 (leparisien.fr)

Le tribunal administratif de Paris a condamné, jeudi 13 novembre, Alstom à réparer un défaut logiciel grave affectant le RER A, huit lignes de métro et six lignes de tramway. Sans correction, ces rames s’arrêteront le 19 janvier 2038.

- Les nouveaux dangers de la rue pour les malvoyants : “Je n’ai plus de plaisir à aller en ville. Je trouve qu’il y a de plus en plus d’obstacles” (france3-regions.franceinfo.fr)

- Paris-Tarbes, Paris-Berlin, Marseille-Rome… où en est le train de nuit en France ? (vert.eco)

Entre le retour du Paris-Berlin, la fin prématurée du Paris-Vienne et le renouvellement des lignes nationales, difficile de s’y retrouver lorsque l’on souhaite voyager en train de nuit.

- Nucléaire : la justice met un coup d’arrêt au projet de deux EPR2 au Bugey (reporterre.net)

Le tribunal a estimé que l’impact écologique n’avait pas été suffisamment pris en compte, notamment la présence de nombreuses espèces protégées et la proximité de la zone Natura 2000 de l’Isle Crémieux.

- Dermatose nodulaire contagieuse : l’abattage est « la seule solution » selon la ministre de l’Agriculture, la Confédération paysanne appelle à « des blocages partout en France » (humanite.fr)

- Le fermage, ce statut qui protège les paysan·nes des abus des propriétaires terriens (basta.media)

Limiter les pouvoirs absolus de la propriété privée, c’est possible en France pour les terres agricoles grâce au « fermage », un outil juridique mis en place il y a 80 ans, à la Libération.

Spécial femmes en France

- Endométriose : un appel à volontaires des personnes menstruées entre 18 et 45 ans, atteintes ou non d’endométriose, en région parisienne. (politis.fr)

- La Maison de Marthe et Marie, en croisade contre l’avortement (revueladeferlante.fr)

Sous couvert de « colocations solidaires », cette association fait du prosélytisme contre l’avortement. Financée par la galaxie catholique ultraconservatrice – dont le milliardaire d’extrême droite Pierre-Édouard Stérin – elle bénéficie aussi de fonds publics, à l’instar de ceux de la mairie de Paris, qui l’a subventionnée à hauteur de 700 000 euros pour la réhabilitation d’un monastère.

- Mêmes droits pour TOUTES les femmes vivant sur le territoire français ! (politis.fr)

Une tribune du Réseau des associations de femmes des quartiers populaires appelle à une loi-cadre intégrale protégeant toutes les femmes des violences sexistes et sexuelles […] nous constatons que les femmes étrangères en France vivent une quadruple peine

- Réouverture des maisons closes : Quand le RN sort le tapis rouge aux « pulsions sexuelles » des hommes à l’ère #metoo (humanite.fr)

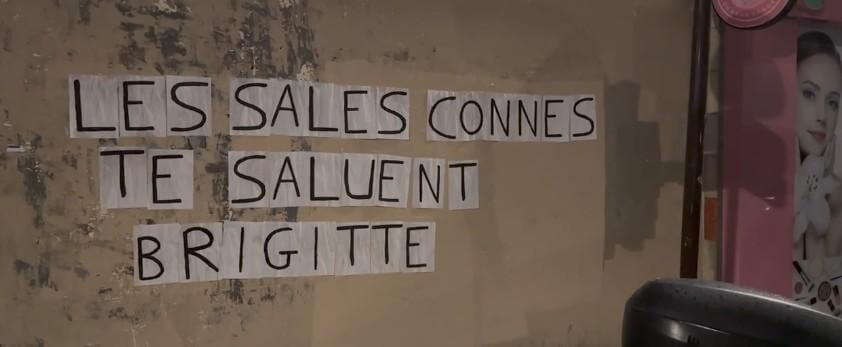

- Brigitte Macron qualifie de « sales connes » des militantes qui ont interrompu un spectacle d’Ary Abittan (huffingtonpost.fr)

La Première dame a été filmée dans les coulisses des Folies Bergère à Paris, à la rencontre de l’humoriste dont le spectacle avait été perturbé la veille.

Voir aussi “S’il y a les sales connes, on va les foutre dehors !” : Brigitte Macron s’emporte contre des militantes féministes qui ont interrompu un spectacle d’Ary Abittan (franceinfo.fr)

Samedi soir, quatre militantes du collectif #NousToutes, portant des masques à l’effigie de l’acteur avec la mention “violeur”, ont interrompu son spectacle dans la salle parisienne des Folies Bergère, scandant “Abittan violeur”.

Et Brigitte Macron se savait filmée au spectacle d’Ary Abittan, l’agence de Mimi Marchand déplore une bourde (huffingtonpost.fr)

D’après Bestimage, agence dirigée par la reine des paparazzi, la vidéo dans laquelle la première dame insulte des militantes de « sales connes » a été diffusée par erreur.

- « Sales connes » : ce que révèle l’antiféminisme ordinaire de Brigitte Macron (frustrationmagazine.fr)

- #salesconnes devient le slogan de ces féministes après les propos de Brigitte Macron (huffingtonpost.fr)

La première dame avait qualifié de « sales connes » des militantes du collectif #NousToutes qui avaient interrompu samedi un spectacle d’Ary Abittan, accusé de viol.

Voir aussi “Sales connes” devient un cri de ralliement féministe qui répond à Brigitte Macron (france3-regions.franceinfo.fr)

- « Blessée » par Brigitte Macron, la femme qui accuse Ary Abittan parle pour la première fois (huffingtonpost.fr)

« Entendre aujourd’hui des paroles blessantes prononcées par la Première dame, censée œuvrer pour la cause des femmes, me fait me sentir abandonnée et amplifie un traumatisme avec lequel je dois vivre chaque jour »

- Brigitte Macron visée par une plainte après ses propos sur les « sales connes » (huffingtonpost.fr)

L’association des Tricoteuses hystériques a annoncé porter plainte contre la femme du président après son insulte envers des militantes féministes.

- Brigitte Macron et les « sales connes » : Ary Abittan a-t-il été reconnu « non-coupable », comme l’affirme Julien Odoul ? (lessurligneurs.eu)

l’humoriste n’a pas été acquitté : il a bénéficié d’un non-lieu. Autrement dit, il reste présumé innocent, mais la justice ne s’est jamais prononcée sur son innocence ou sur sa culpabilité.

- Le « sales connes » qui cache la forêt (politis.fr)

L’insulte surmédiatisée de Brigitte Macron envers des militantes féministes doit nous indigner… Sans nous faire perdre de vue la stratégie d’inversion de la culpabilité mise en place par Ary Abittan.

- Le comédien Philippe Caubère mis en examen pour « proxénétisme » (huffingtonpost.fr)

Déjà concerné par des mises en examen pour « agression sexuelle », « viol » et « corruption de mineure », l’acteur français est désormais ciblé pour des faits de prostitution.

Spécial médias et pouvoir

- Appel aux ministres de la Justice et de l’Intérieur : respectez la liberté de la presse, renforcez le secret des sources (acrimed.org)

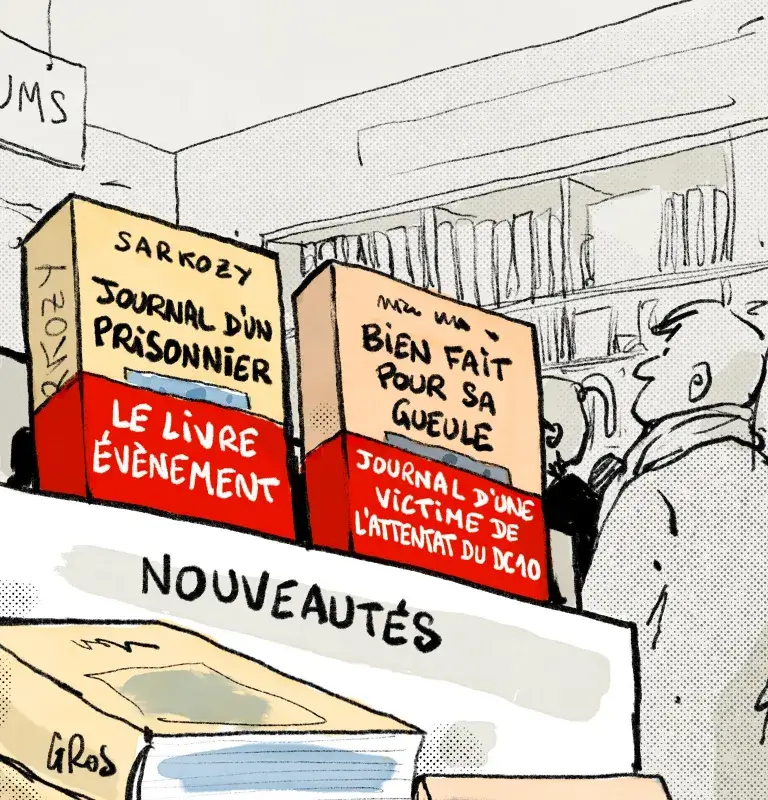

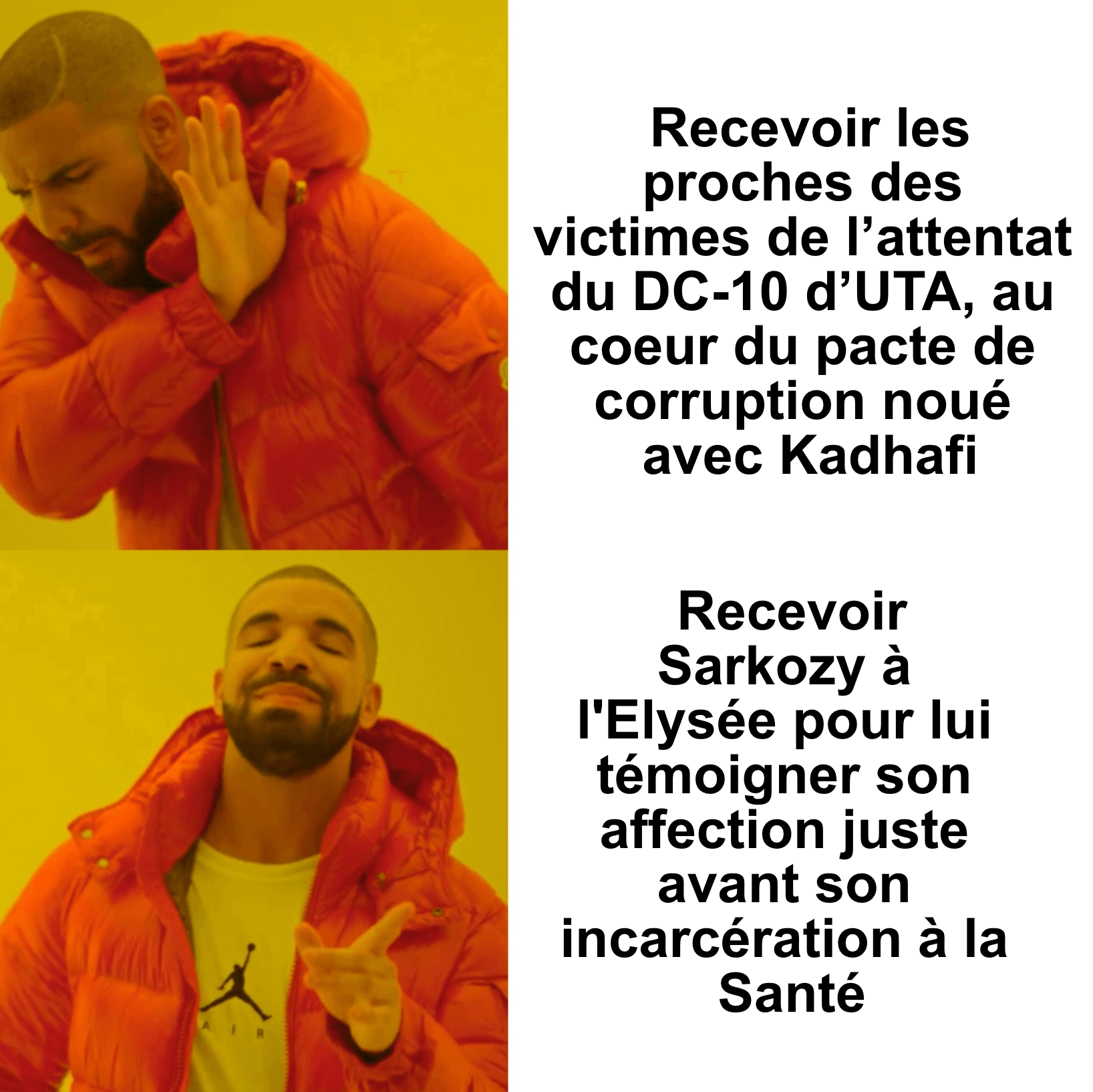

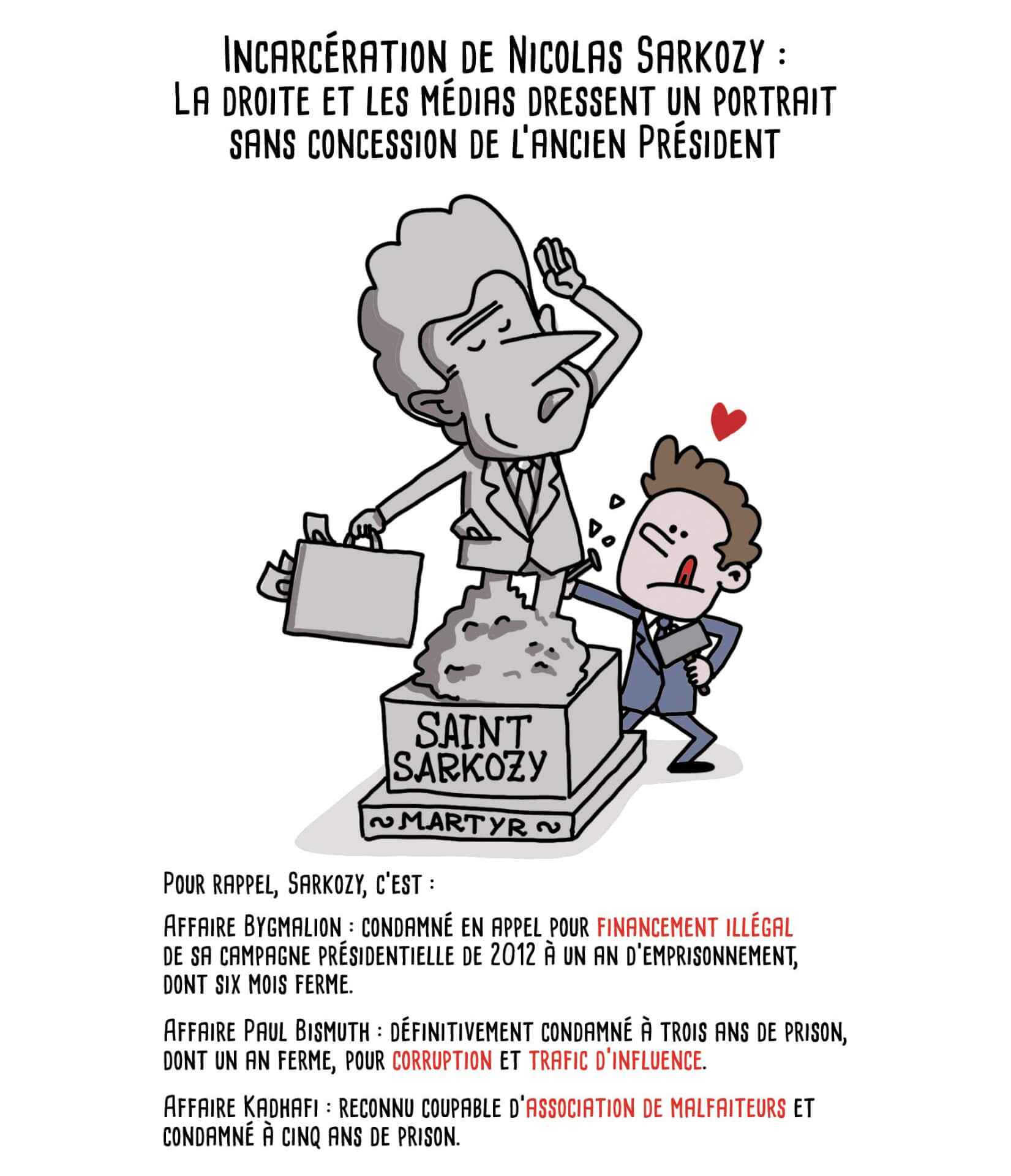

- Entre-soi et connivence : Sarkozy remercie ses soutiens médiatiques (acrimed.org)

Dans le petit monde politico-médiatique, il est une pratique que nul n’ignore : le renvoi d’ascenseur. Dans son livre commis au cours de sa brève détention, Nicolas Sarkozy salue ses plus fidèles soutiens médiatiques.

- Après des propos controversés de Nathalie Saint-Cricq, l’Arcom saisie par LFI et la Grande mosquée de Paris (huffingtonpost.fr)

LFI a annoncé à son tour saisir l’Arcom après que l’éditorialiste a fait un rapprochement entre l’antisémitisme et « la quête du vote musulman » sur « franceinfo ».

- Immigration et école : les relais médiatiques d’un think tank d’extrême droite (acrimed.org)

- Bad buzz, clashs et invités d’extrême droite : Le Crayon, les Cyril Hanouna du web ? (streetpress.com)

- Gros studio, locaux communs, flop… Sur YouTube, les fafs se professionnalisent (streetpress.com)

- Surproduction et concentration dans l’édition : la « bibliodiversité » en danger (journal-labreche.fr)

En 2024, les éditeurs ont publié 65 000 nouveaux titres, soit 12 000 de plus qu’en 2004. Une surproduction qui n’amène pas plus de diversité. Au contraire, la course aux ventes pousse à l’uniformisation et la concentration des éditeurs dans de grands groupes sature le marché. Jusqu’à mettre en péril la pluralité ?

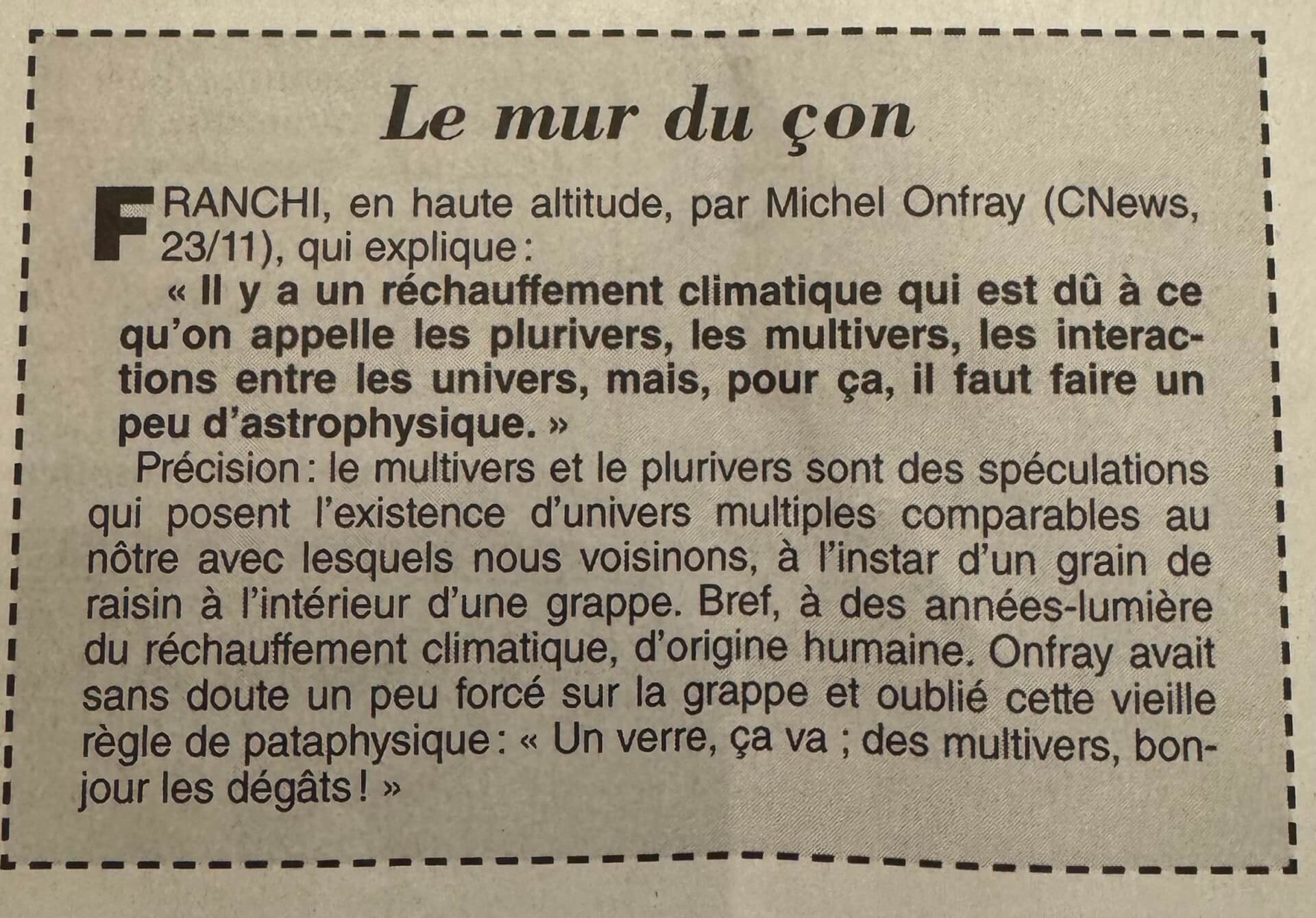

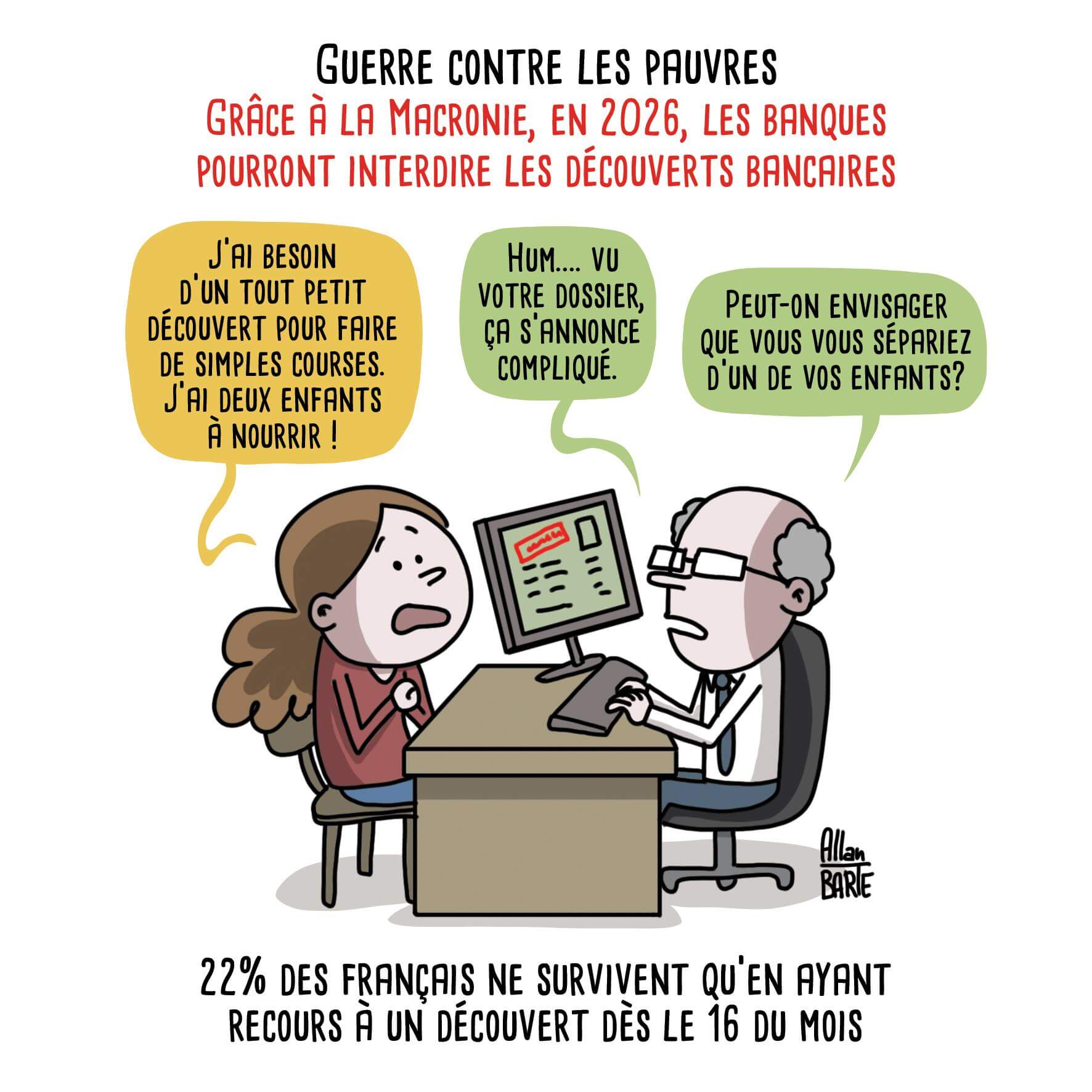

Spécial emmerdeurs irresponsables gérant comme des pieds (et à la néolibérale)

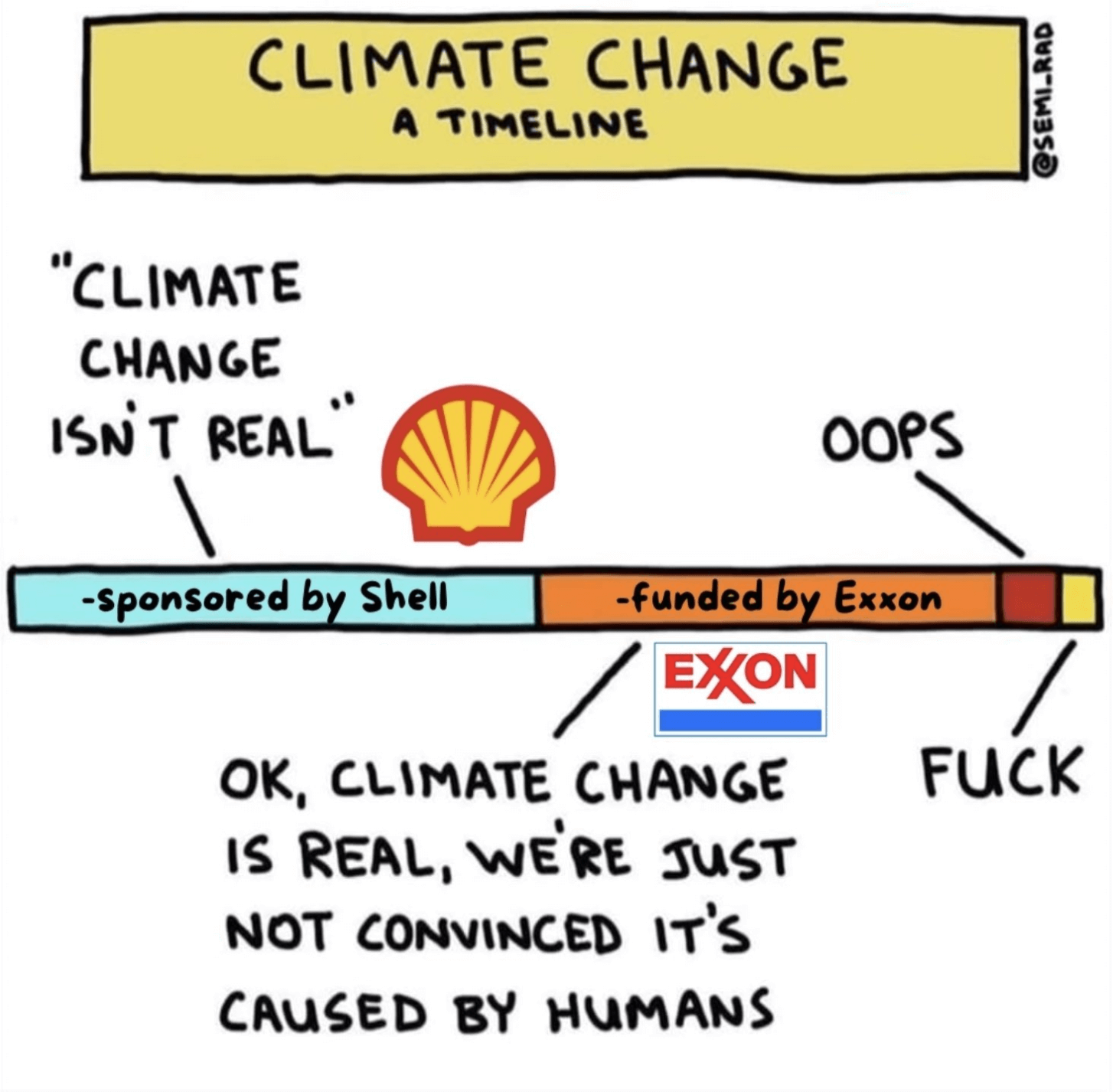

- Dix ans après l’accord de Paris, peu de progrès et beaucoup de questions pour le CAC 40 (multinationales.org)

À l’occasion du dixième anniversaire de l’Accord de Paris sur le climat, l’Observatoire des multinationales dresse le bilan des progrès accomplis – ou non – par les groupes du CAC 40 en matière de réduction de leurs émissions de gaz à effet de serre. Le chemin semble encore très long…

- Une nouvelle loi va-t-elle bientôt privatiser les barrages… ou les sauver ? (telerama.fr)

Une nouvelle loi devrait arriver bientôt à l’Assemblée nationale pour modifier le statut des barrages. Défendue par l’intersyndicale d’EDF, elle est critiquée en interne par des experts du secteur hydraulique. L’enjeu : leur éventuelle privatisation.

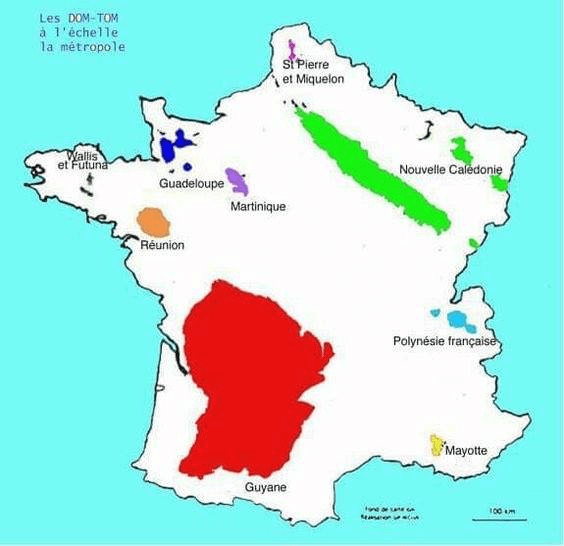

- Grandir à Mayotte : UNICEF alerte sur un territoire où l’enfance vacille après Chido (parallelesud.com)

Un an après le passage du cyclone Chido […] Mayotte peine encore à se relever. L’archipel, déjà fragilisé par la pauvreté, l’insécurité et des infrastructures sous-dimensionnées, a connu l’une des pires crises humanitaires de son histoire récente […] les enfants mahorais, qui représentent un habitant sur deux, sont les premières victimes d’un cumul de crises sans précédent.

- Evars : contre la désinformation, des députés sensibilisés à l’éducation à la sexualité (basta.media)

L’éducation à la vie affective, relationnelle et à la sexualité (Evars) est prévue dans la loi depuis 2001. Pourtant, ce n’est toujours pas appliqué. Alors, contre les préjugés, des associations tentent de former les parlementaires.

- Police : la gabegie du logiciel Scribe (politis.fr) – voir aussi Police : Le coût des défaillances d’un logiciel de rédaction de procès-verbaux estimé à 257 millions d’euros (20minutes.fr)

La Cour des comptes décrit un projet « au contenu mal défini », « des irrégularités comptables significatives » et conclut à un « préjudice financier significatif »

Spécial recul des droits et libertés, violences policières, montée de l’extrême-droite…

- Extrême droite : Alexandre Allégret-Pilot, le député de la vulgarité et du clash permanent (blast-info.fr)

Élu député du Gard en 2024, le ciottiste Alexandre Allégret-Pilot multiplie invectives, provocations et affabulations, parfois teintées de misogynie et de virilisme.

- D’abord interdit, un festival antifa finalement autorisé à Villeurbanne (liberation.fr)

Plusieurs soirées avaient été ciblées par un arrêté pour des risques de « troubles à l’ordre public » mais le tribunal administratif annulé cette décision, jeudi 11 novembre. […] L’interdiction de la préfecture était survenue après la diffusion de messages antipolice samedi soir à Lyon lors de la Fête des lumières, revendiqués localement par le mouvement écologiste des Soulèvements de la Terre, et au sujet desquels la préfète a saisi la justice. Le public avait pu lire sur la façade du musée des Beaux-Arts des messages lumineux qui disaient notamment « La police blesse et tue », « Non à l’Etat policier », « La violence policière est partout » ou encore « Sainte-Soline, ni oubli, ni pardon » et « On dégage le RN ».

- Un CRS tire deux balles en pleine rue à Nantes : encore un mensonge policier (contre-attaque.net)

La presse assurait que le CRS défendait sa vie face à un motard qui lui fonçait dessus, une vidéo prouve l’inverse.

- A69 : quand un commando nocturne de chefs d’entreprise et d’élus voulait intimider des anti-autoroute (reporterre.net)

cinq chefs d’entreprise, dont deux élus, un sous-traitant du concessionnaire et un de leurs camarades de rugby, tous favorables à l’A69, sont convoqués devant le tribunal correctionnel de Castres le 7 avril 2026 pour des faits de « dégradations en réunion », « divulgation d’informations personnelles » et « association de malfaiteurs en vue de la préparation d’un délit ».

Voir aussi « Ce soir, prévoyez frontale et cagoule » : dans les rouages du commando pro-A69 (reporterre.net)

- Réaction à l’acte de vandalisme contre le siège national de la LPO par la coordination rurale (faunesauvage.fr)

Tags injurieux, dépôt de pneus ou de ballots de paille surmontés d’une tête de sanglier décapitée : nous dénonçons fermement des pratiques d’intimidation inacceptables et indignes. Si cette colère est compréhensible, elle se trompe d’adversaires. Les véritables responsables des difficultés des agriculteurs ne sont pas les associations de protection de la nature. Nous partageons la même exigence de préserver des sols vivants et une biodiversité indispensable à la production alimentaire ainsi qu’à la santé des écosystèmes.

- JO 2030 : Reporterre empêché d’organiser une conférence dans les Hautes-Alpes (reporterre.net)

Reporterre a été empêché par la mairie de Villar-Saint-Pancrace, dans la vallée de Briançon, d’y organiser une conférence sur les Jeux olympiques 2030. L’événement a dû être déplacé dans une autre ville des Hautes-Alpes.

- 6 ans, malade, à la rue : le juge condamne, l’OFII remet pourtant la famille à la rue (blogs.mediapart.fr)

- Au tribunal, les personnes aux troubles psy sont enfermées malgré l’obligation de soin (streetpress.com)

Spécial résistances

- Contre-fête des Lumières, pas de lumières pour l’extrême-droite (rebellyon.info)

Samedi 6 décembre au soir, une petite perturbation a pu être observée place des Terreaux à la fin de l’attraction prévue pour la fête des Lumières. Quand vient le moment d’indiquer la sortie de la place, un certain nombre de messages sont projetés à distance sur les grands murs du Musée des Beaux-arts.

- Des militants écologistes repeignent la place de l’Étoile en orange (reporterre.net)

Vendredi 12 décembre en fin de matinée, des militants des ONG Greenpeace, Action non-violente COP21 et Action Justice Climat ont repeint en orange les pavés de la place de l’Étoile, où se dresse l’Arc de Triomphe, au bout des Champs Élysées, à Paris. Une action symbolique visant à dénoncer le manque d’actions ambitieuses sur le climat, depuis les 10 ans de l’Accord de Paris, signé le 11 décembre 2015.

- Résister syndicalement à l’imposition des IA dans nos métiers (snes.edu)

L’année scolaire 2024-2025 a vu se déployer l’offensive du ministère pour introduire les IA dans l’Éducation nationale. La publication d’un « cadre d’usage des IA dans l’Éducation » s’apparente de fait à un plan de développement. D’autant que dans les nombreuses formations proposées ou imposées aux collègues ne sont quasiment jamais mis en avant les recommandations officielles appelant à renoncer aux IA

- Grève dans le champagne LVMH : « On ne s’interdit pas un mouvement plus ample » (rapportsdeforce.fr)

- “Des chiffres et des lettres” : virés par France 3, les ex-présentateurs gagnent aux prud’hommes (telerama.fr)

Bertrand Renard et Arielle Boulin-Prat, licenciés après quarante-sept et trente-six ans de CDD, réclamaient que leurs contrats soient requalifiés en CDI. Les prud’hommes ont tranché en leur faveur.

Spécial outils de résistance

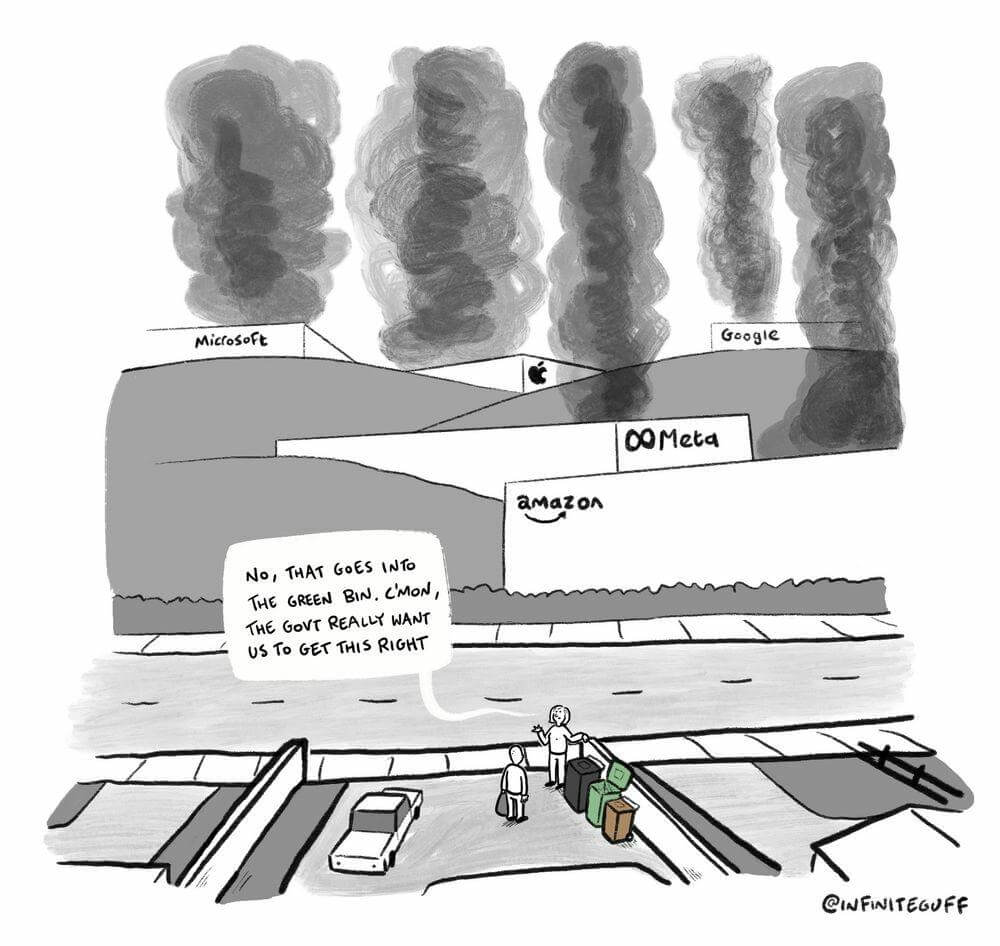

Spécial GAFAM et cie

- How Google Maps quietly allocates survival across London’s restaurants – and how I built a dashboard to see through it (laurenleek.substack.com)

I wanted a dinner recommendation and got a research agenda instead. Using 13000+ restaurants, I rebuild its ratings with machine learning and map how algorithmic visibility actually distributes power.

- Google unveils plans to try again with smart glasses in 2026 (bbc.co.uk)

- Meta accused of banning LGBTQ+ accounts in one of its “biggest waves of censorship” ever (lgbtqnation.com)

Meta – the parent company of Instagram, Facebook, Threads, and WhatsApp – has reportedly disabled or shadow-banned the accounts of more than 50 abortion providers, queer organizations, and reproductive healthcare organizations around the world over the past few months.

- Plusieurs associations féministes s’insurgent de leur invisibilisation par Meta (next.ink)

- 20 Years of Digital Life, Gone in an Instant, thanks to Apple (hey.paris)

- Les autorités suisses recommandent d’éviter les applications SaaS, y compris Microsoft 365 (channelnews.fr)

L’autorité responsable de la protection des données en Suisse, Privatim, a publié le 18 novembre 2025 une résolution appelant les organismes publics suisses à éviter d’utiliser les solutions SaaS des hyperscalers internationaux tels que Microsoft, Google ou Amazon, pour des raisons de sécurité.

- L’ascension de Linux : le géant Windows est-il vraiment en danger ? (generation-nt.com)

Longtemps cantonné à une niche d’experts, Linux connaît une croissance spectaculaire sur les PC de bureau. Sa part de marché a triplé en quatre ans, largement alimentée par des utilisateurs fuyant un Windows jugé trop contraignant. Entre la fin du support de Windows 10 et l’essor du gaming, l’OS libre est devenu une alternative crédible pour des millions de personnes.

Les autres lectures de la semaine

- The Authoritarian Stack (authoritarian-stack.info)

How Tech Billionaires Are Building a Post-Democratic America — And Why Europe Is Next

- « Quand une démocratie est malade, le fascisme vient à son chevet » (lareleveetlapeste.fr)

- À l’opposé du fascisme (inventif.fr)

- Pathologiser les révoltes (histoirescrepues.fr)

La drapétomanie n’est pas un fait médical : c’est une invention politique. Elle traduit la peur des propriétaires esclavagistes de voir leurs esclaves se révolter, et leur volonté de rationaliser l’esclavage sous couvert de science. En nommant la fuite « folie », on efface le sens politique de l’acte : la recherche de liberté. L’esclave qui s’échappe n’est plus un sujet résistant, mais un « malade » qu’il faut soigner ou punir.

- L’histoire de Heinz, ou pourquoi le ketchup est si sucré (multinationales.org)

Derrière le ketchup tel qu’on le connaît aujourd’hui, il y a un homme d’affaires de Pittsburgh, fils d’immigrés allemands, pionnier de l’industrie agroalimentaire : Henry Heinz.

- How Frank Gehry (RIP) and the Guggenheim Museum Bilbao Changed Architecture (openculture.com)

- John Brinkley, le médecin charlatan qui rendait les hommes chèvres (littéralement) (slate.fr)

Promettant de « rendre leur virilité » à ses patients impuissants, ce faux docteur et véritable escroc américain leur “greffait” des testicules de bouc, au début du XXe siècle, dans le Kansas.

- L’ADN du Moyen Âge (laviedesidees.fr)

La génétique s’invite dans les débats sur le haut Moyen Âge : en articulant données biologiques, archéologiques et historiques, elle renouvelle l’étude des migrations et des identités, loin des modèles raciaux et des récits figés d’origine des peuples européens.

- Dans l’Italie du XVIIIe siècle, les femmes s’insurgeaient contre le harcèlement sexiste et sexuel subi dans les confessionnaux (theconversation.com)

Blagues obscènes, questions intrusives, gestes déplacés : les archives inquisitoriales du Vatican montrent que le harcèlement sexuel au confessionnal était une réalité pour de nombreuses femmes dans l’Italie du XVIIIᵉ siècle – et que certaines ont osé le signaler.

- Dans le Haut-Karabagh défiguré, la quête d’un papillon au nom du père (revue21.fr)

- “The Matilda Effect” : How Pioneering Women Scientists Have Been Written Out of Science History (openculture.com)

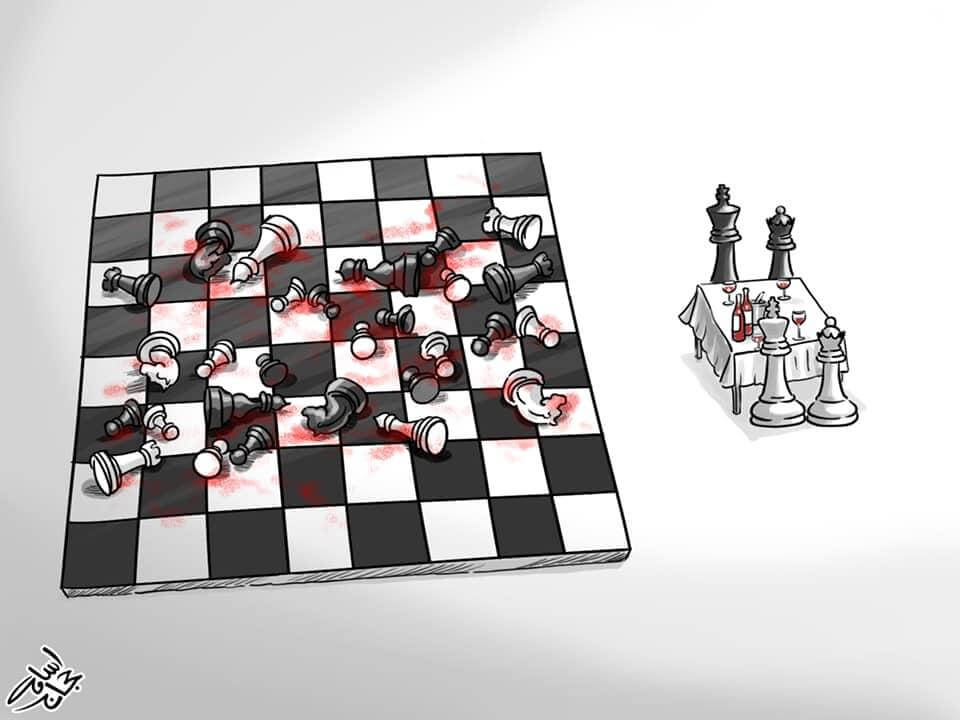

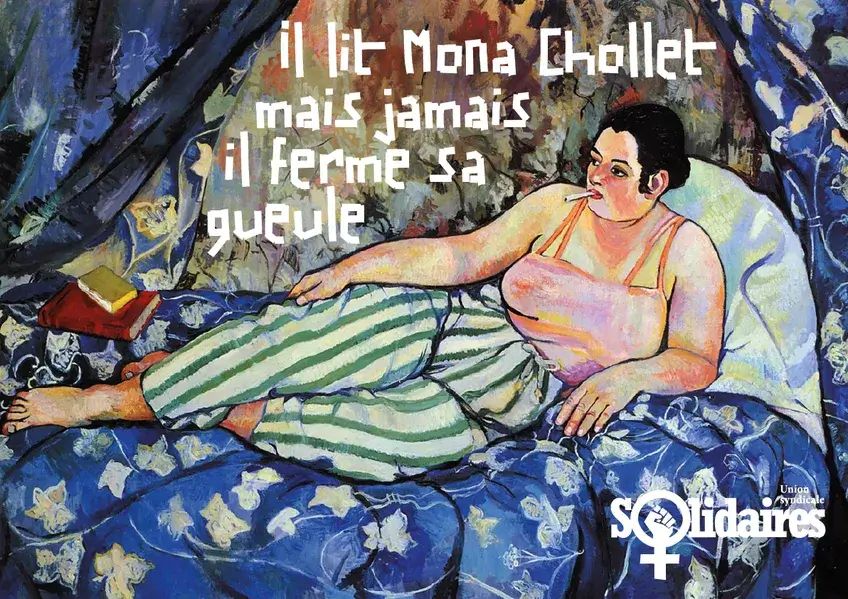

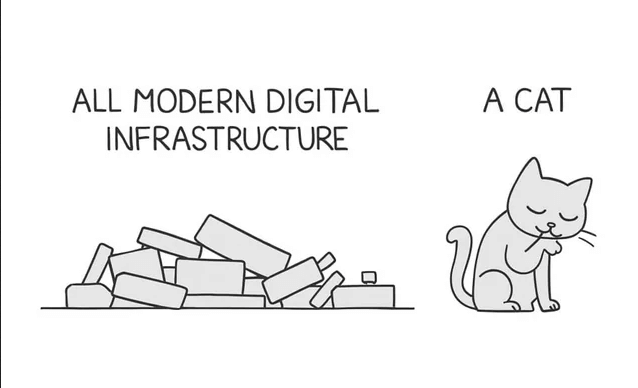

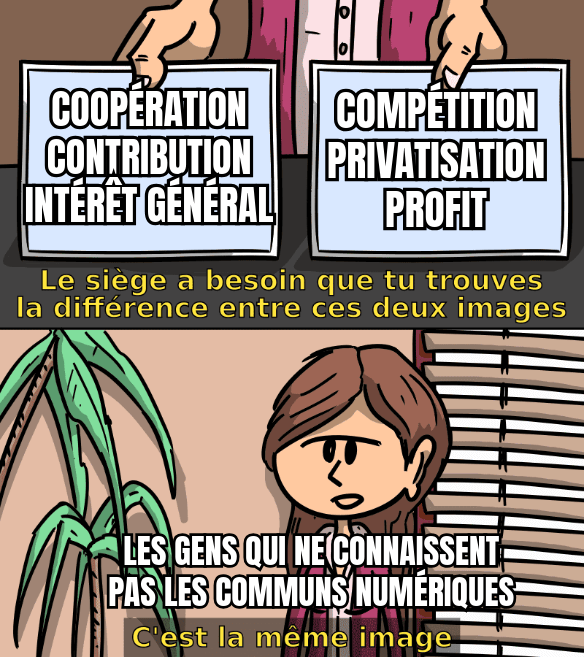

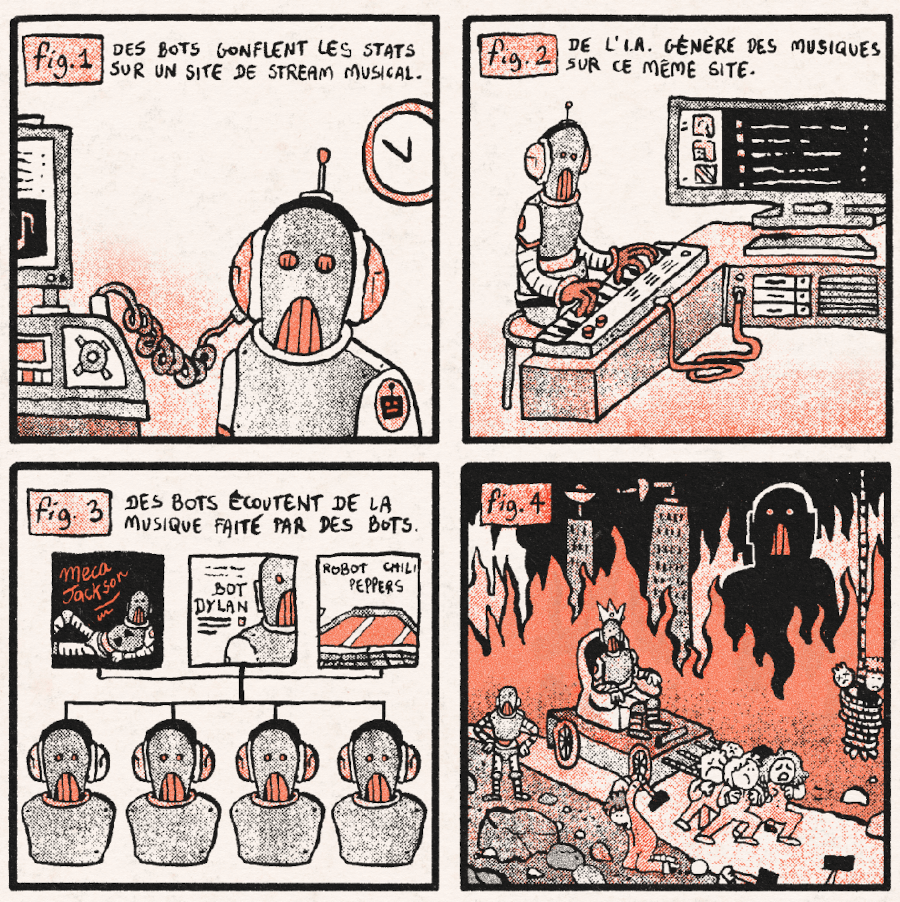

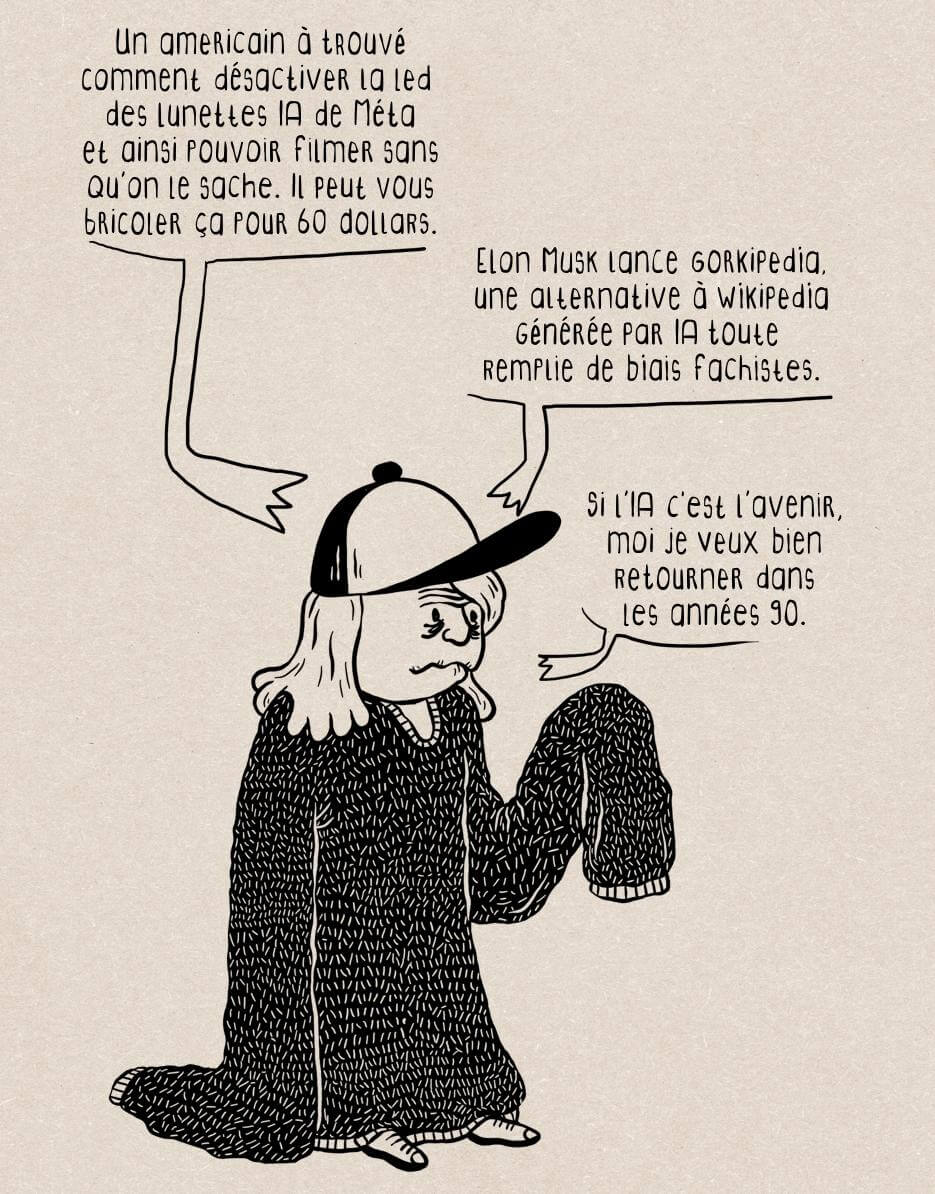

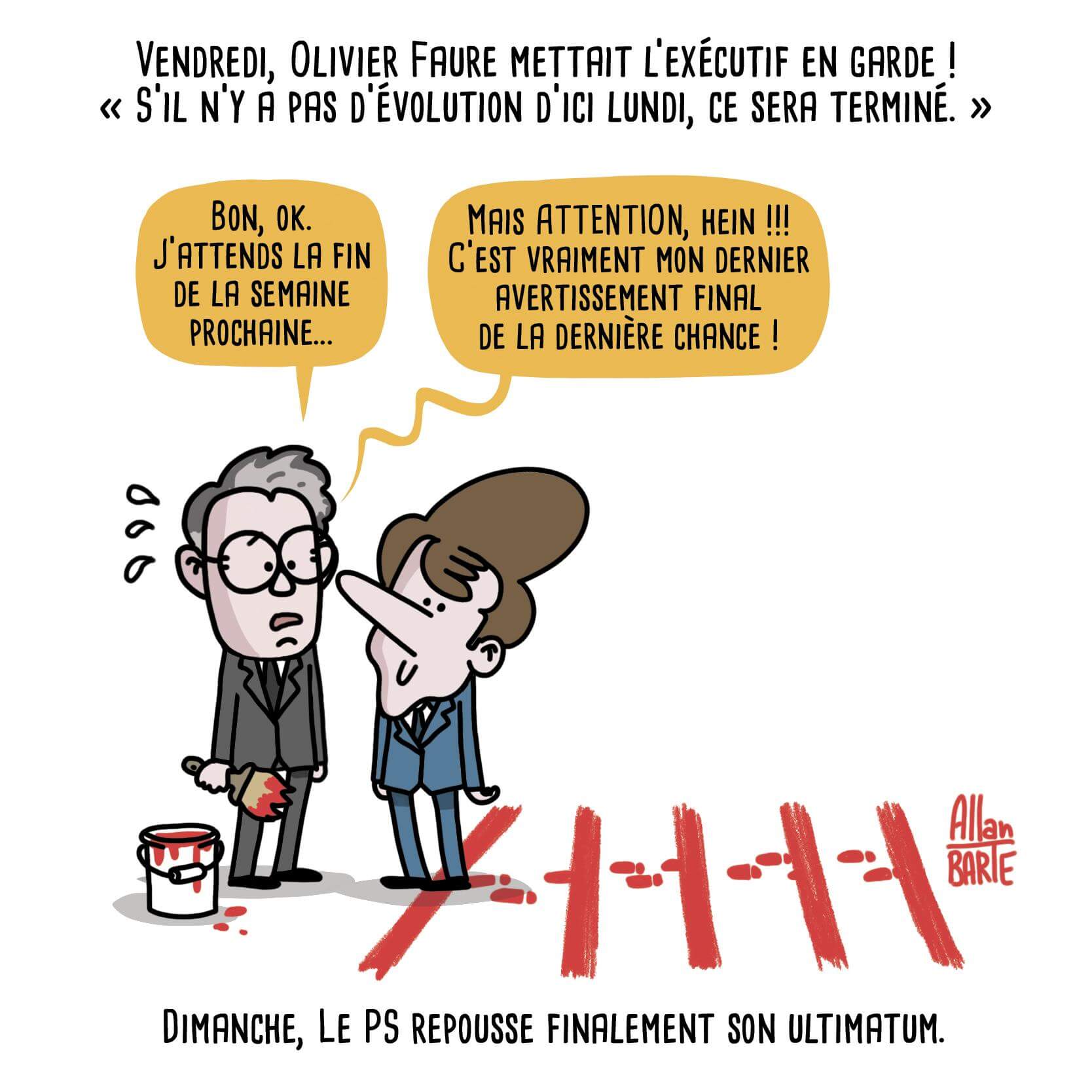

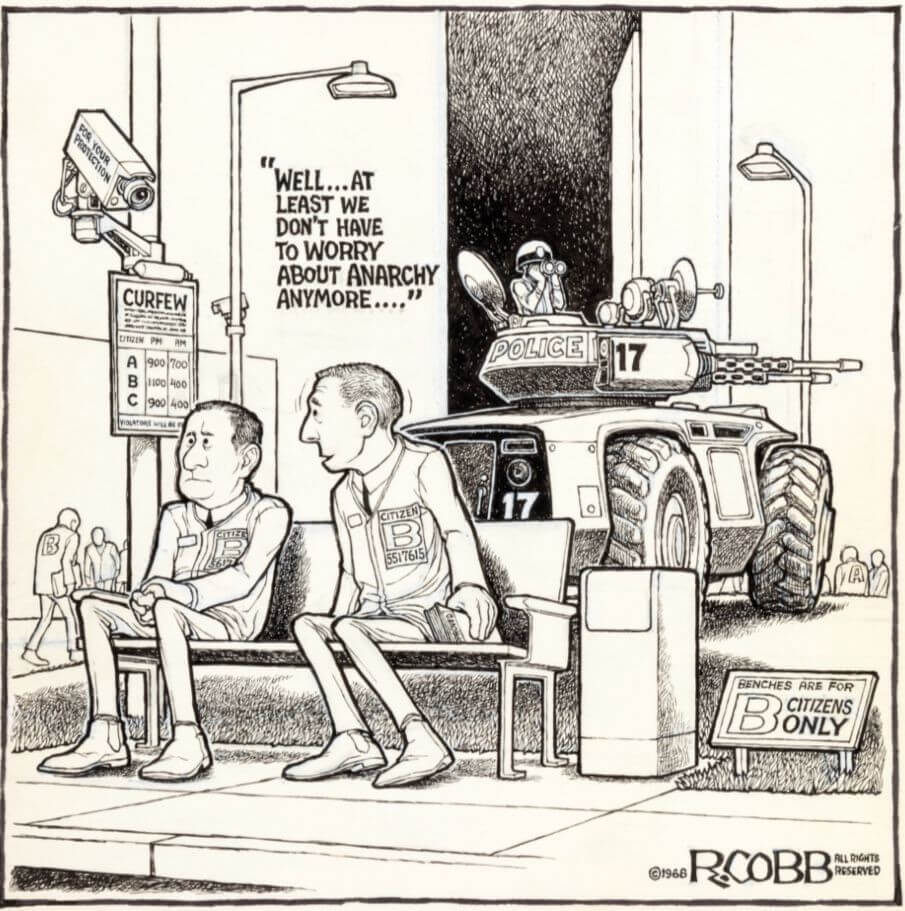

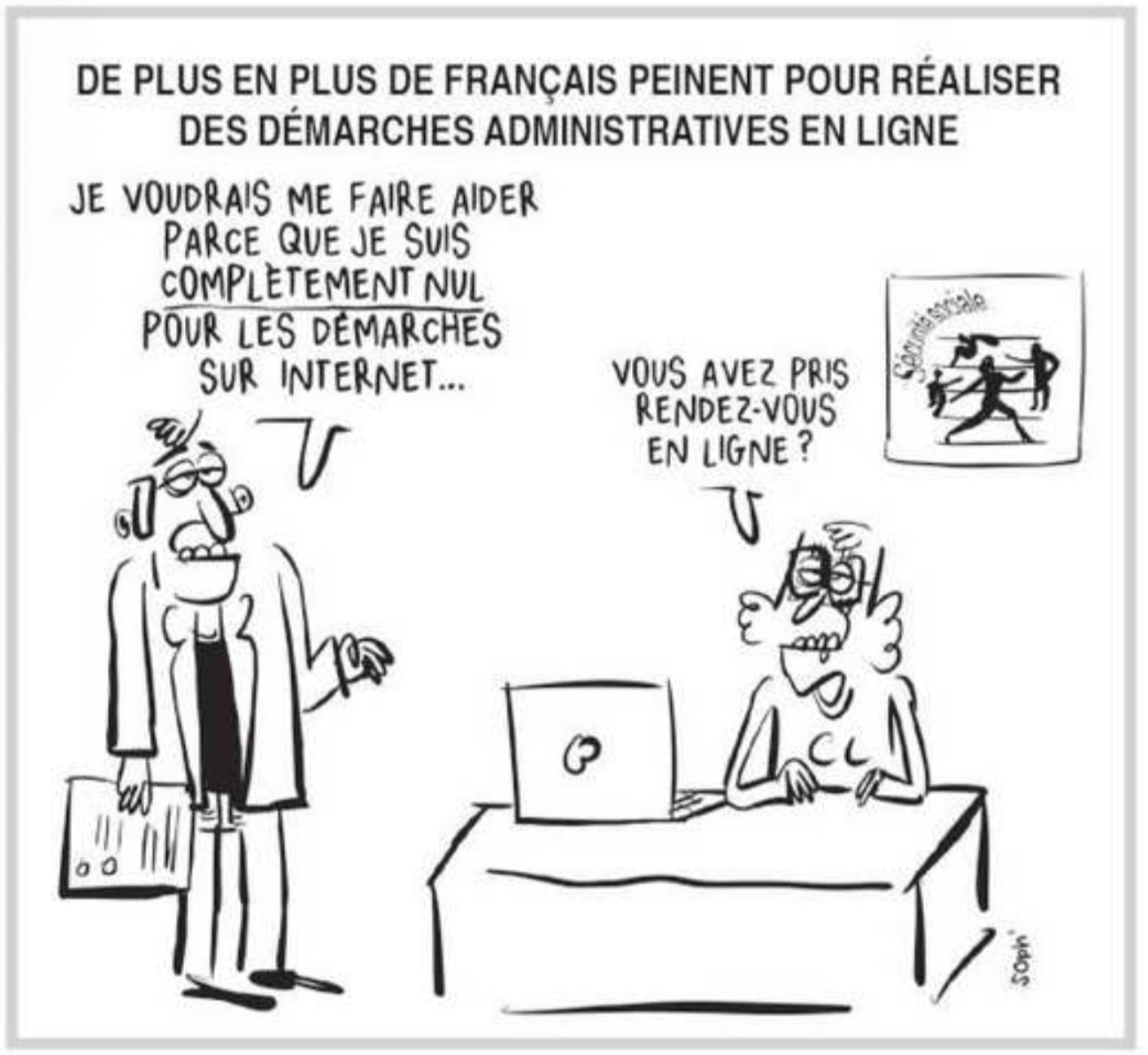

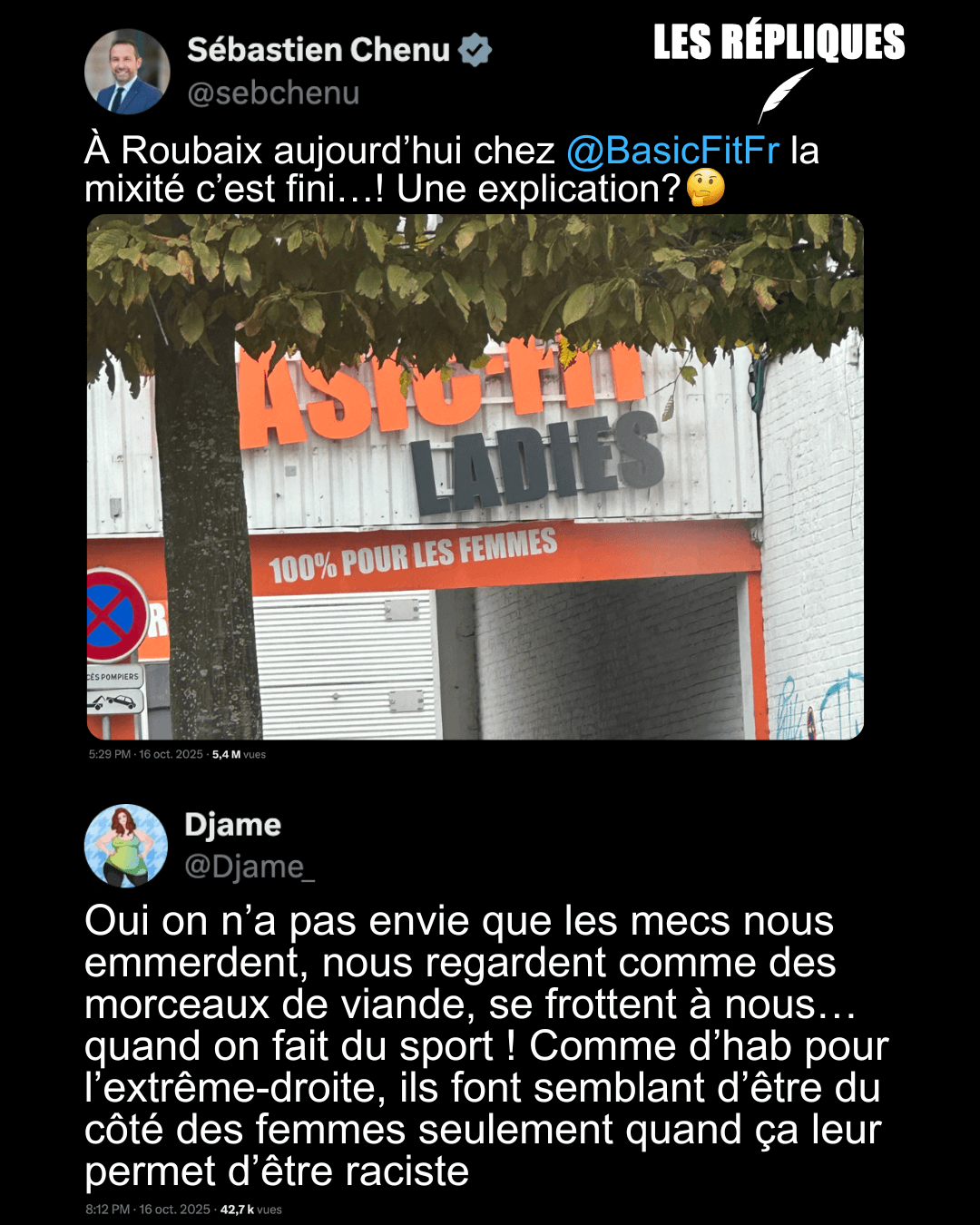

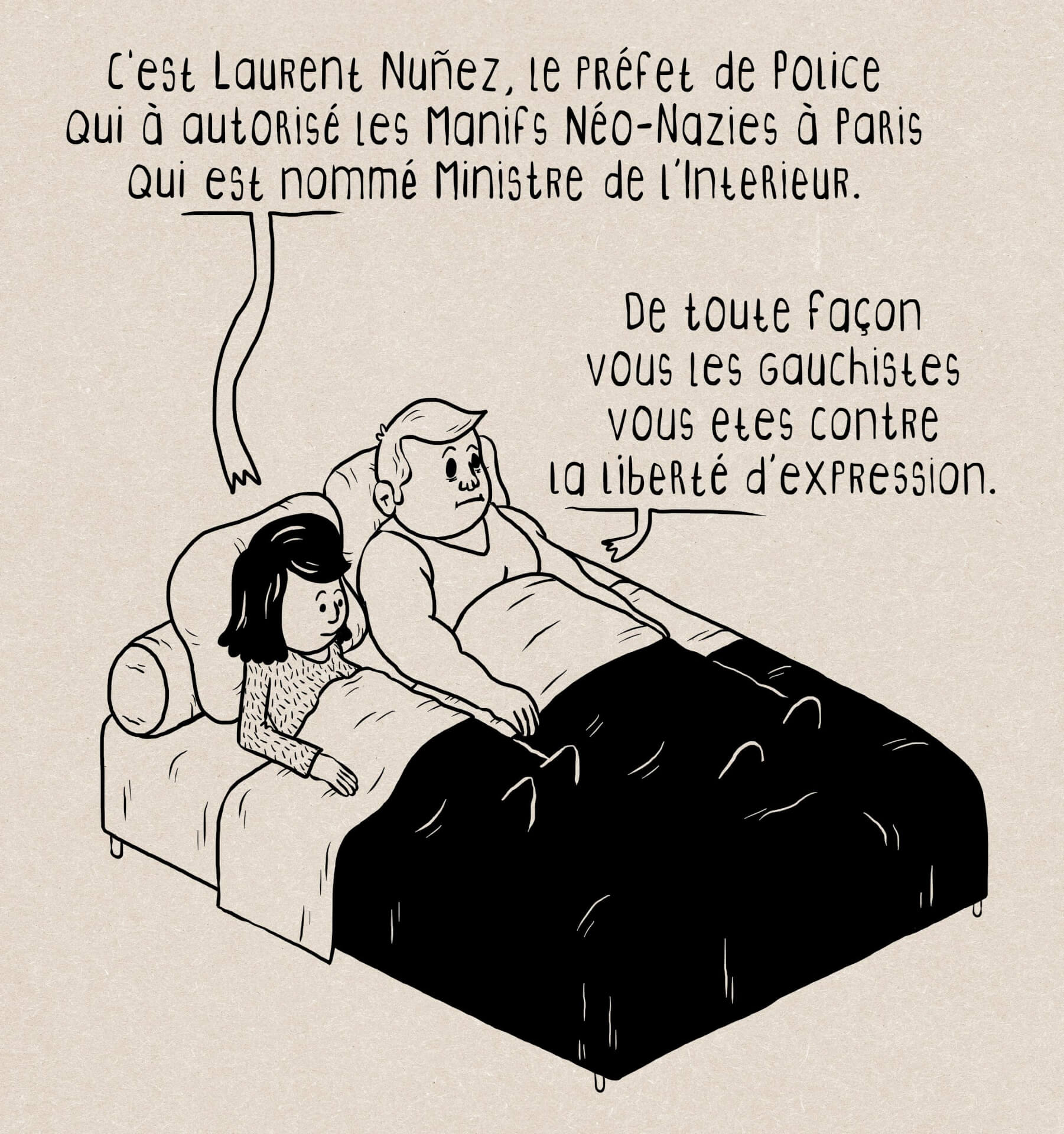

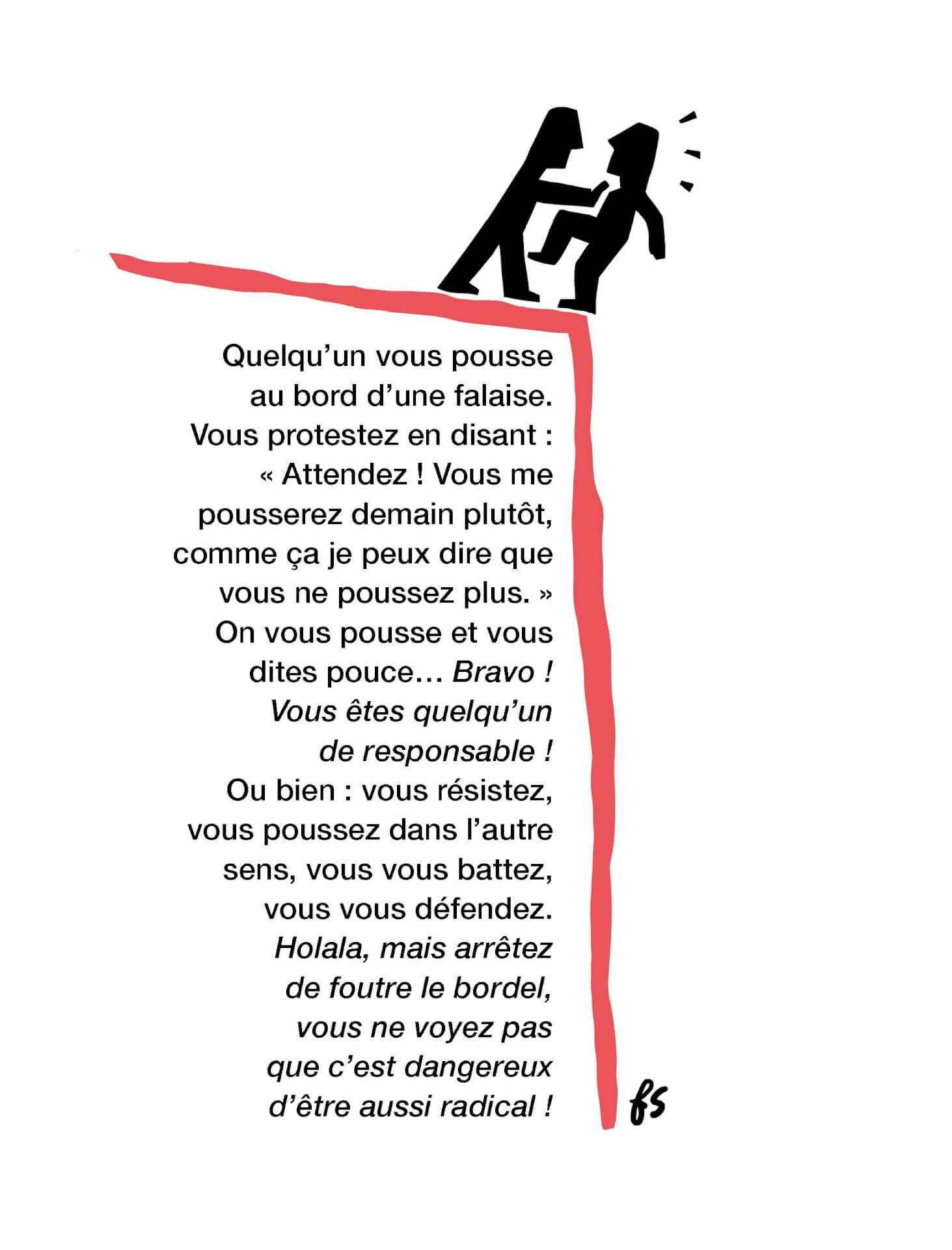

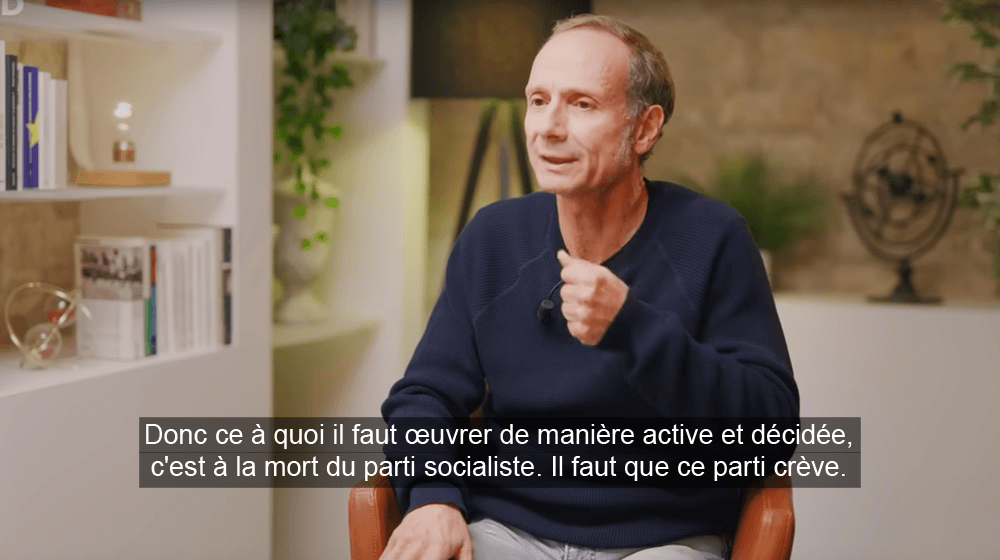

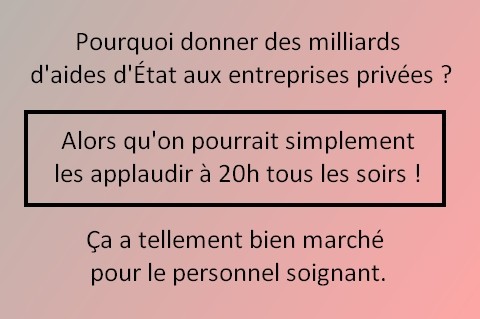

Les BDs/graphiques/photos de la semaine

- Sales connes

- Héros

- Service

- Tableau périodique

- Couleurs

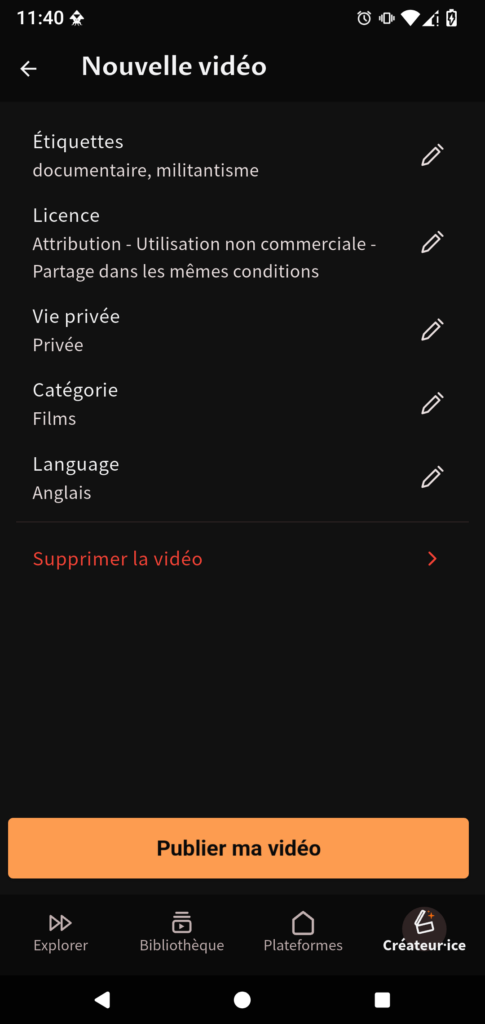

- Flights

- Incredible

- Dom-Tom

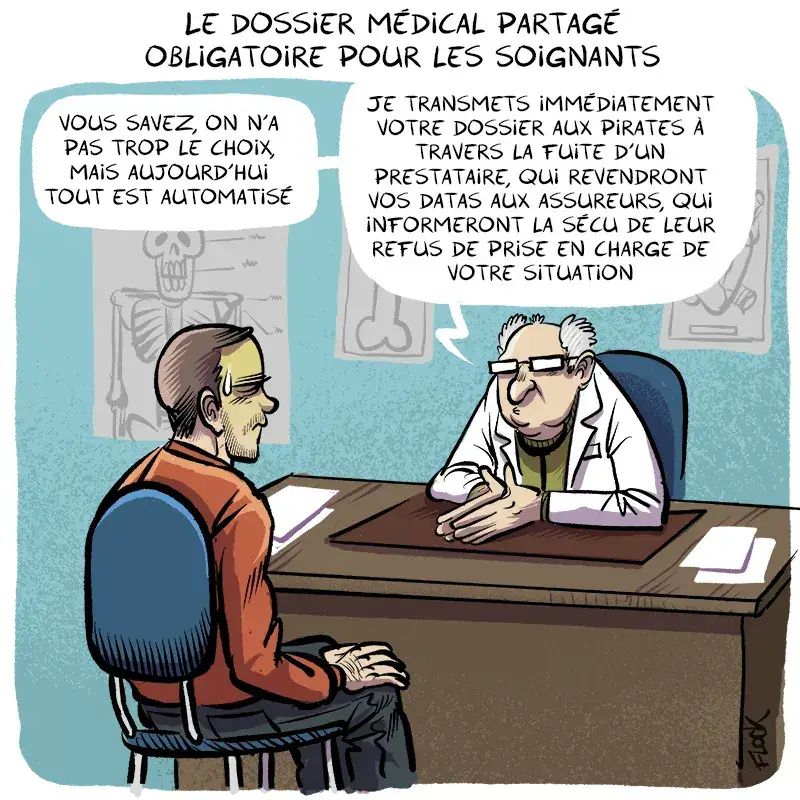

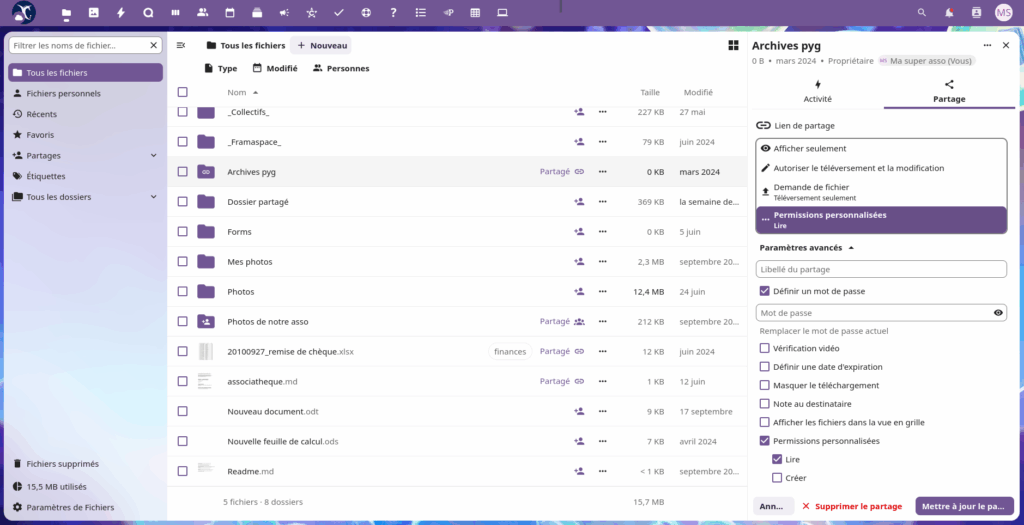

- Dossier partagé

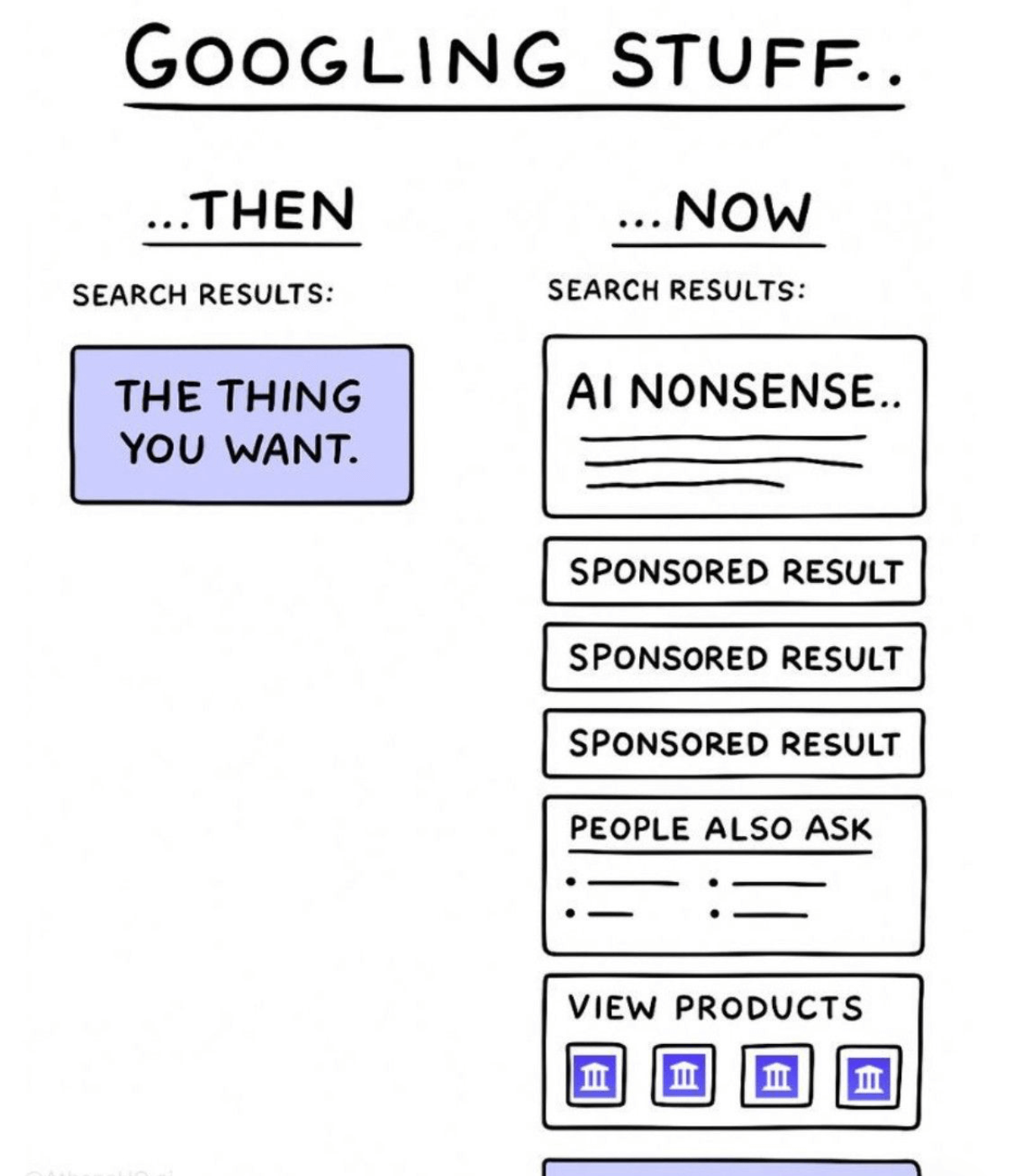

- Data

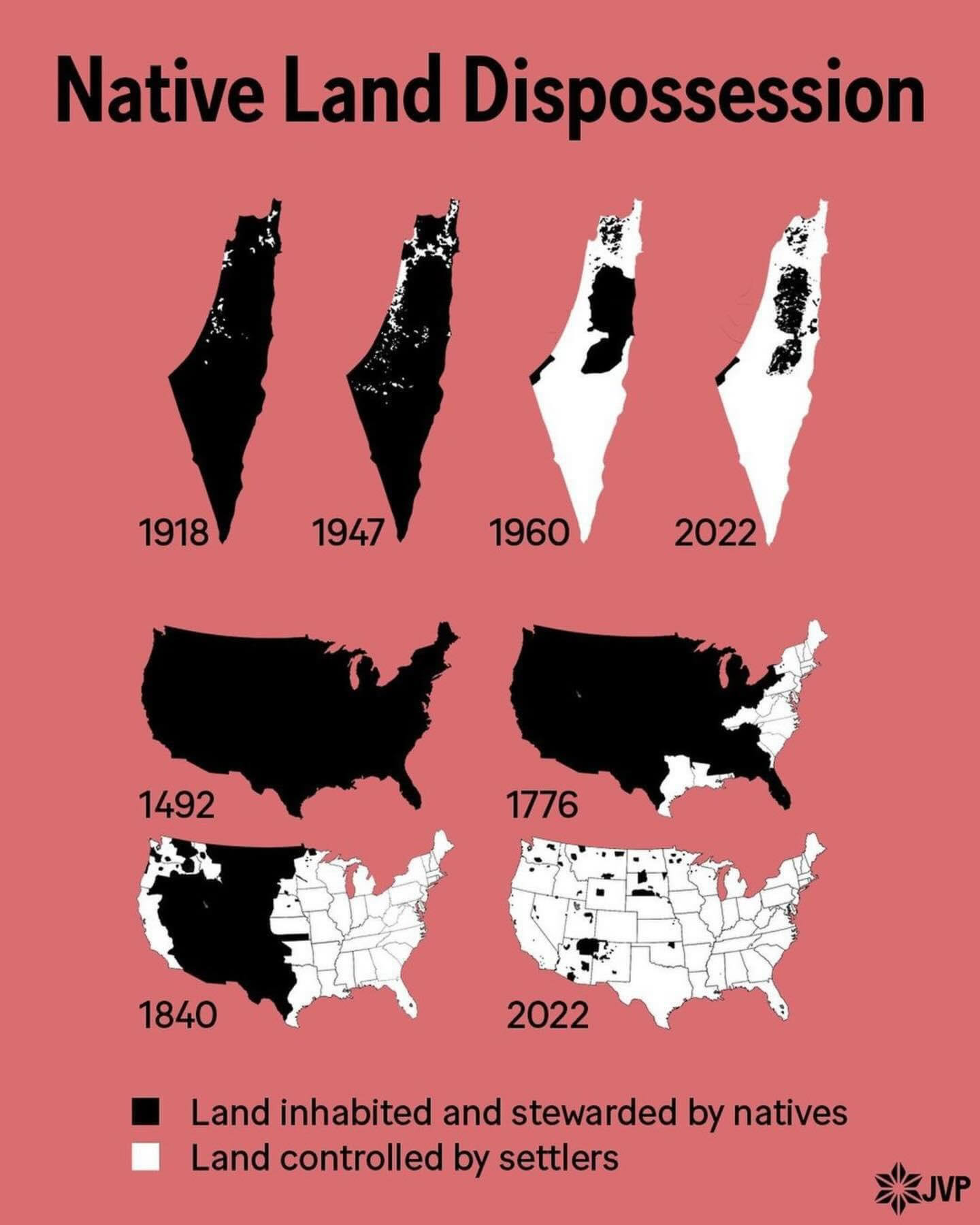

- Evolution

- Person of the year

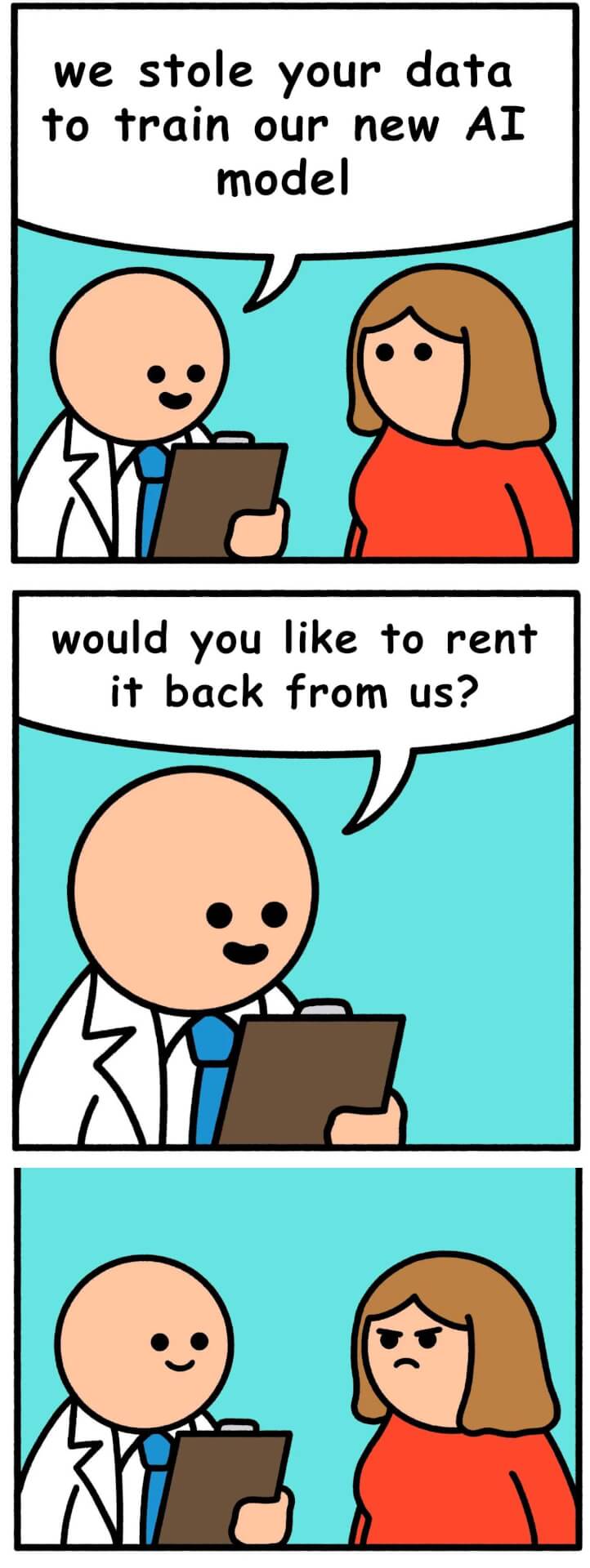

- Mozilla

- Mental health

Les vidéos/podcasts de la semaine

- Saison VI • Episode 4 • Brésil : La COP30 est une mascarade (audioblog.arteradio.com)

- Comment gagner la bataille culturelle ? Le cas Mamdani (humanite.fr)

- Colonisation, voile, police, immigration… le programme d’Édouard Philippe (humanite.fr)

Le top 5 des pires questions de Jean-Michel Apathie et des pires réponses d’Édouard Philippe dans l’émission “objectif 2027” sur LCI.

- Louis Sarkozy chez Kaamelott (tube.fdn.fr)

- Université : quand les femmes forçaient ses portes (radiofrance.fr)

Conquérir l’Université, ce fut une double bataille dont les pionnières vont avoir ici toute leur place. D’abord celle des étudiantes forçant peu à peu les portes des amphithéâtres sous le regard étonné, inquiet ou goguenard de leurs camarades masculins et imposant leur talent et leur détermination pour arracher des diplômes longtemps interdits ou hors de portée. Mais aussi la lutte des femmes pour l’accession aux fonctions d’enseignement, à tous les niveaux, et non pas seulement subalternes.

Les trucs chouettes de la semaine

- 1,2 million d’utilisateurices : la France réussit le plus gros déploiement open source de l’histoire (goodtech.info)

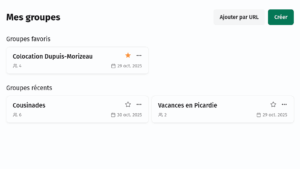

- PeerTube v8 : gérez vos vidéos en équipe ! (framablog.org)

Nous avons le plaisir de vous annoncer la sortie de la version 8 de PeerTube ! Dans cette version, parmi d’autres nouveautés, vous trouverez un nouveau design pour le lecteur vidéo, une amélioration de l’expérience pour importer des vidéos et la possibilité de partager la gestion d’une chaîne avec d’autres comptes.

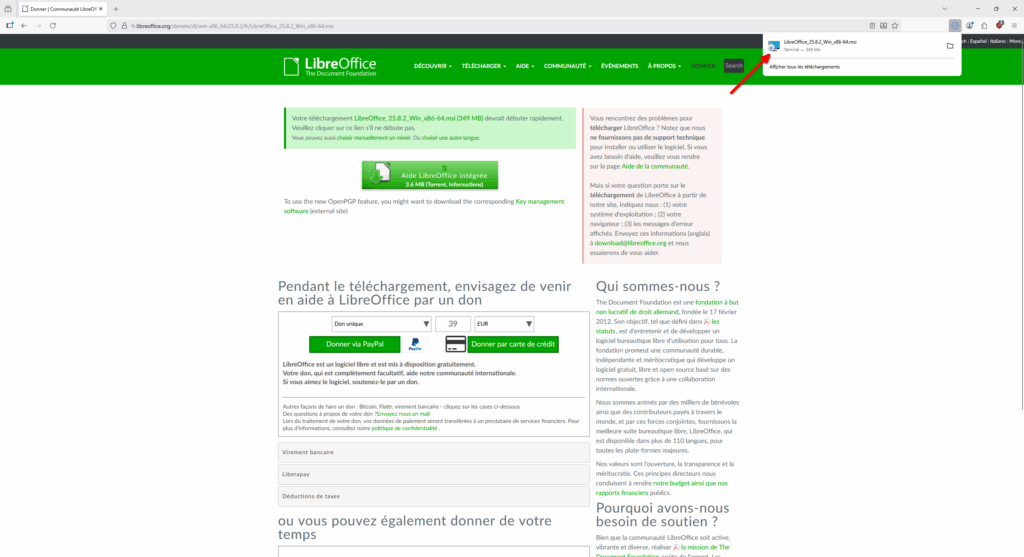

- Hurray ! This German State Decides to Save €15 Million Each Year By Kicking Out Microsoft for Open Source (itsfoss.com)

Schleswig-Holstein’s migration to LibreOffice reaches 80 % completion, with a one-time €9 million investment on cards for 2026.

- Groundbreaking monolingual Irish dictionary launched (rte.ie)

A groundbreaking new monolingual dictionary by Foras na Gaeilge that provides people with a new way to understand, use and learn the Irish language, without relying on dictionaries in English or in other languages, has gone live.

- L’incroyable sens de l’orientation des pigeons enfin expliqué (humanite.fr)

Une étude confirme l’hypothèse ancienne selon laquelle le sens de l’orientation de ces oiseaux est logé dans leur oreille interne.

Retrouvez les revues de web précédentes dans la catégorie Libre Veille du Framablog.

Les articles, commentaires et autres images qui composent ces « Khrys’presso » n’engagent que moi (Khrys).

09.12.2025 à 10:08

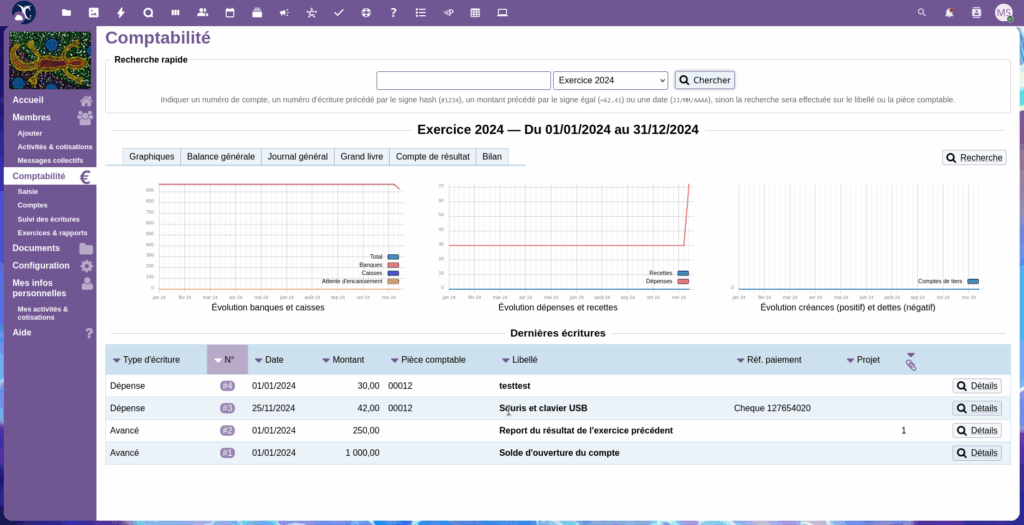

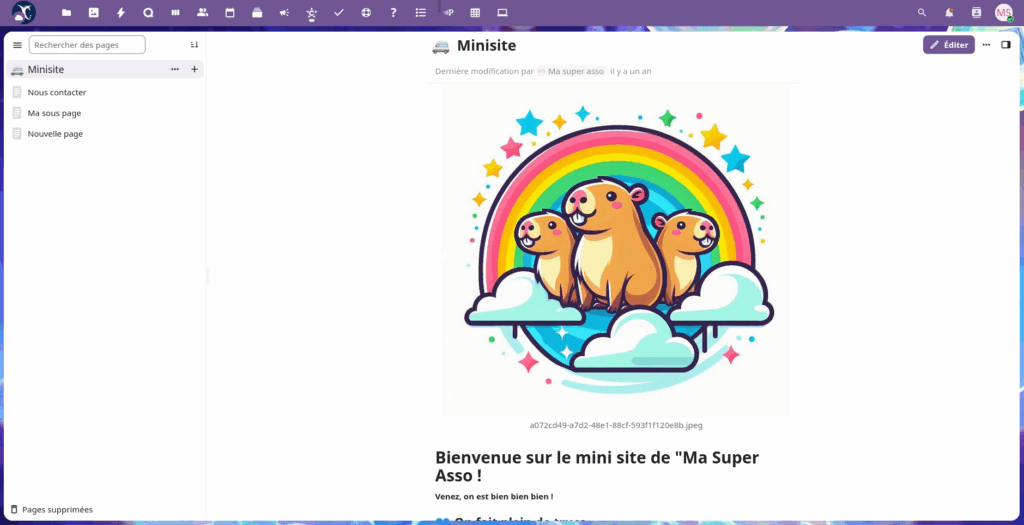

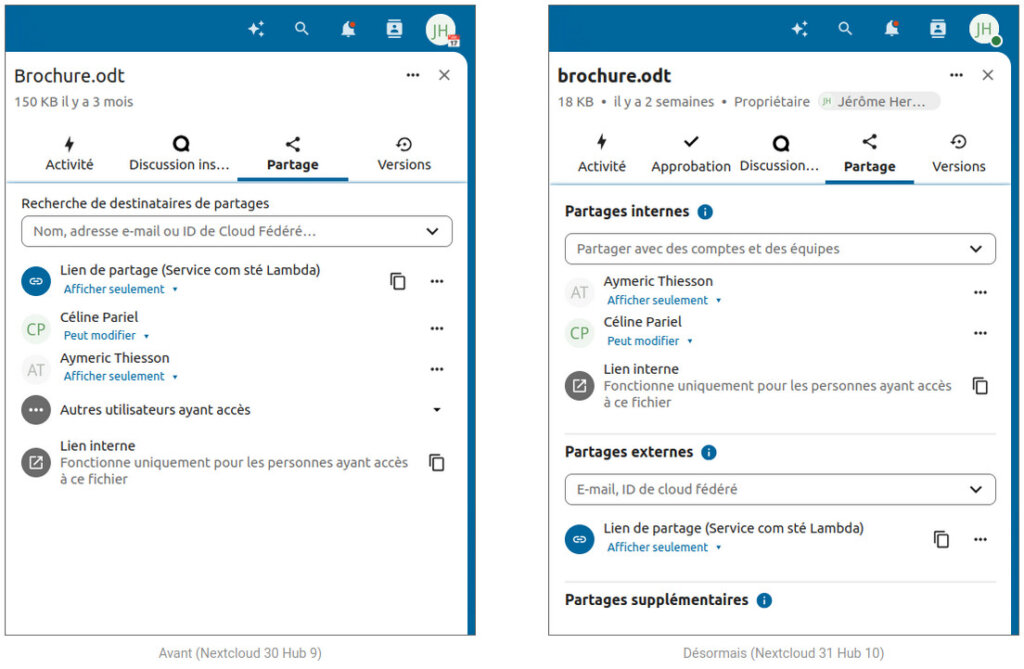

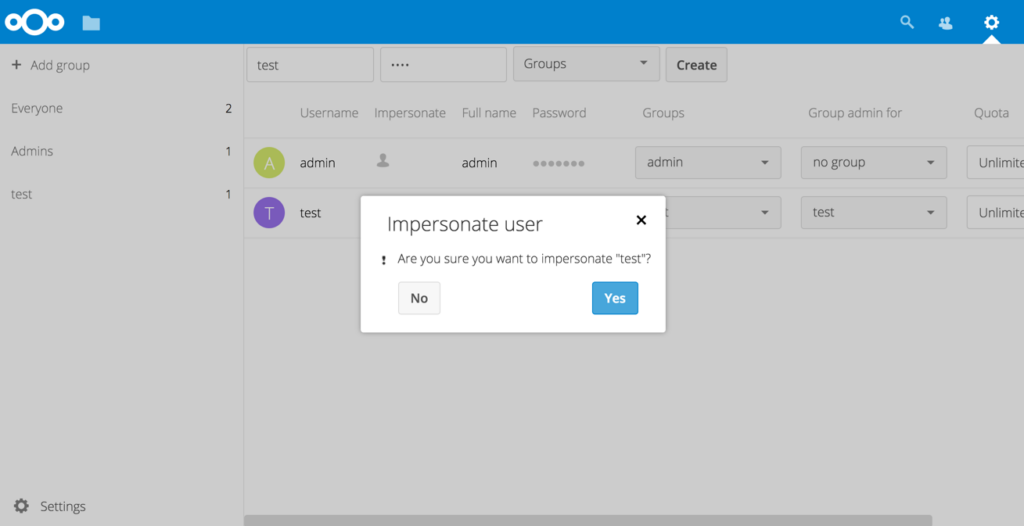

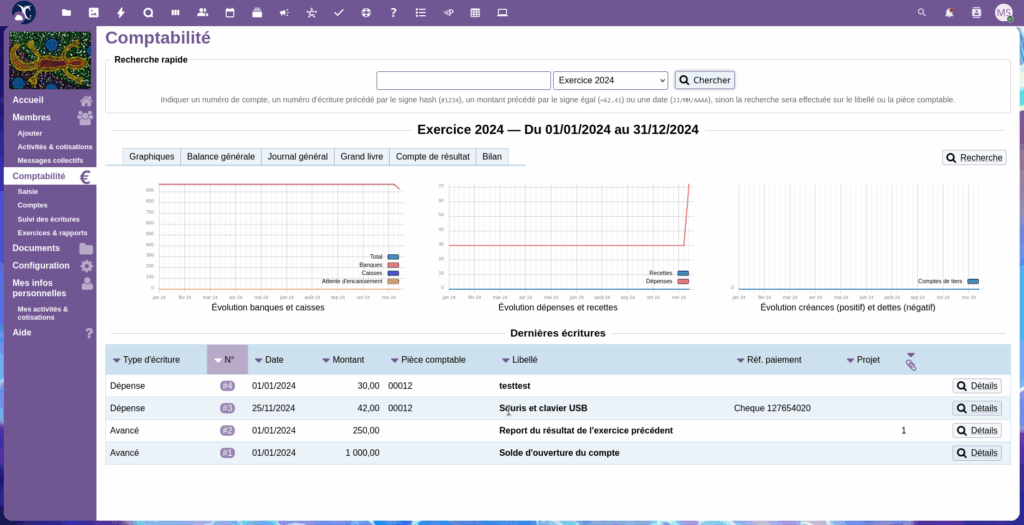

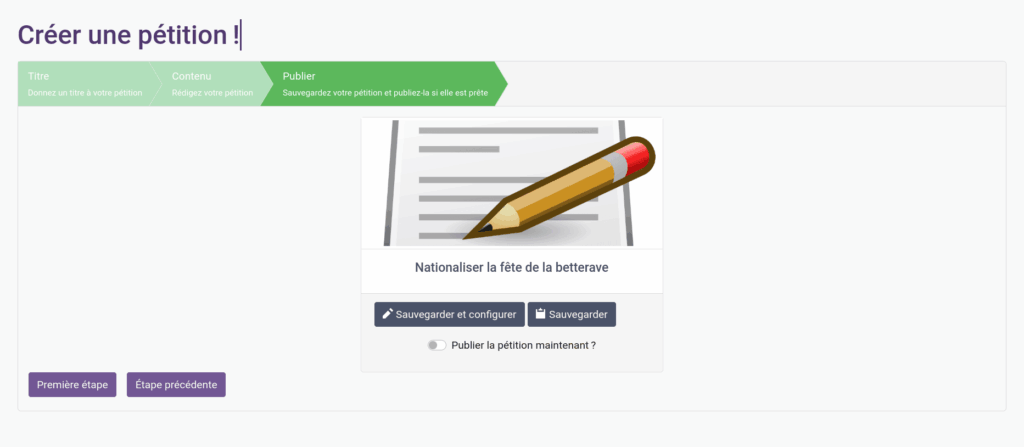

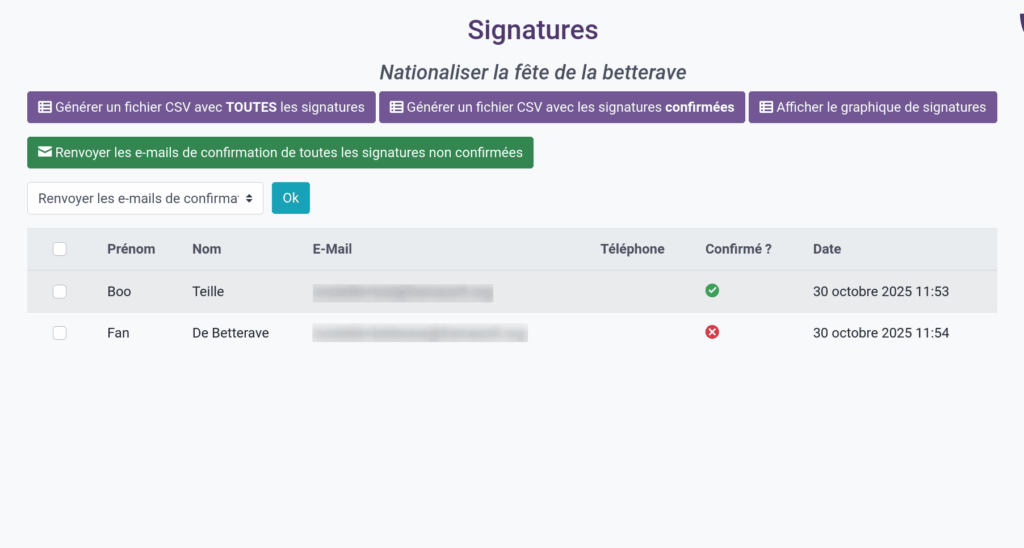

PeerTube v8 : manage your videos with your team !

Framasoft

Texte intégral (3333 mots)

We’re thrilled to announce the release of PeerTube v8 !

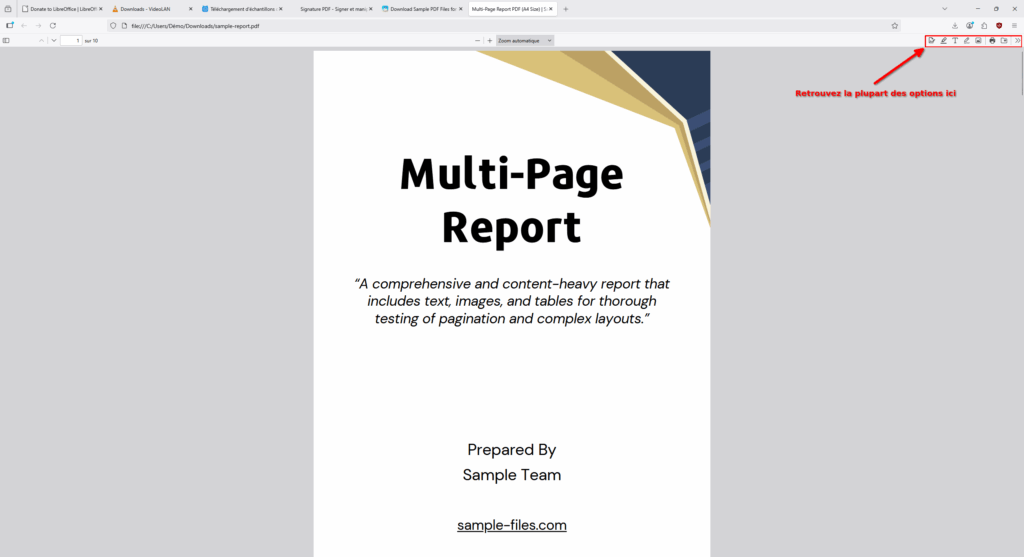

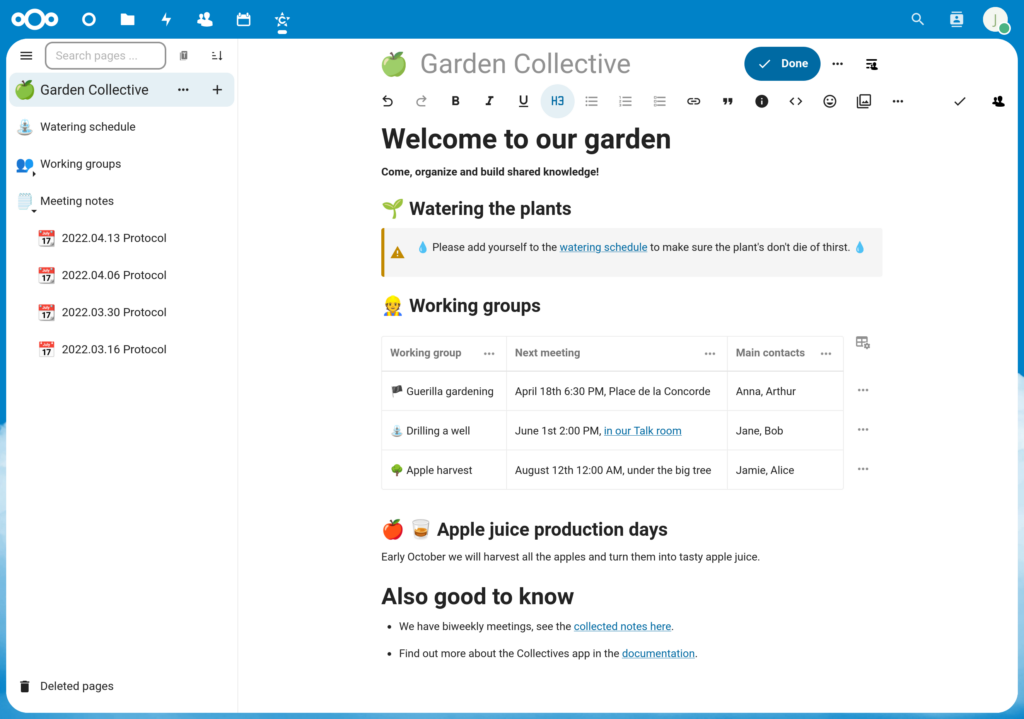

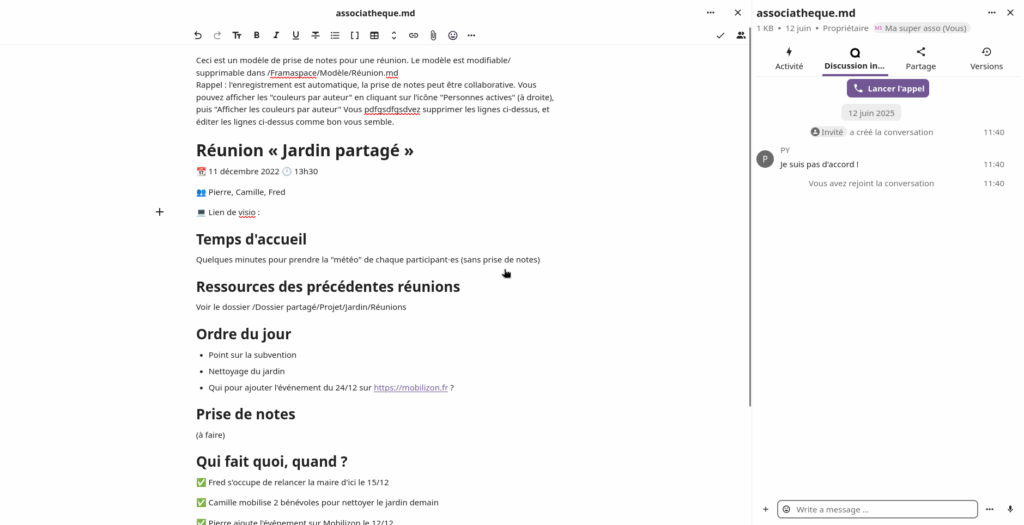

This version features a redesigned video player, an improved experience for importing videos and the ability to share channel management with other accounts !

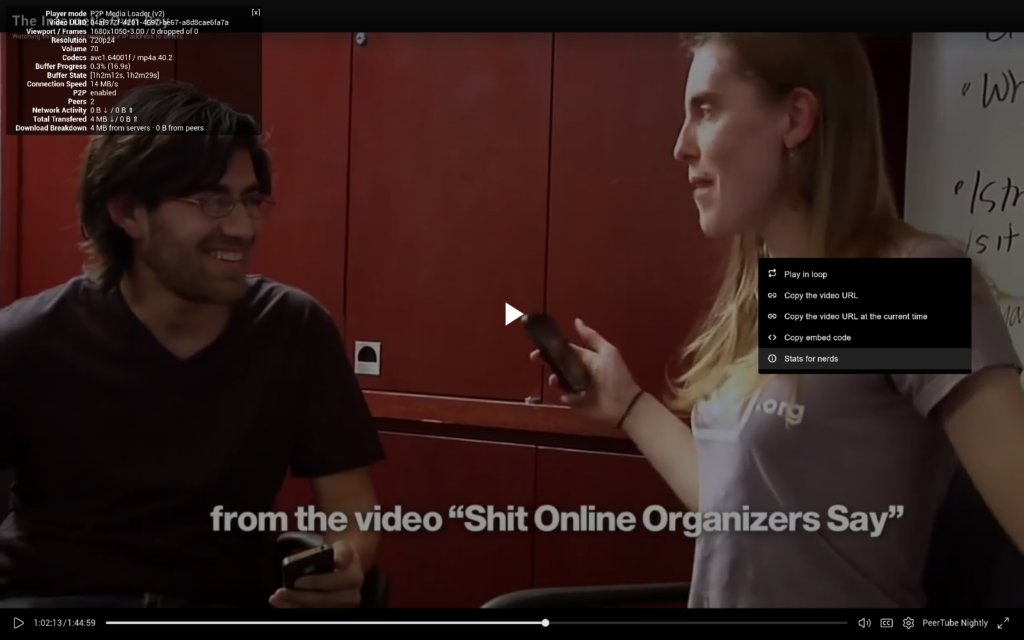

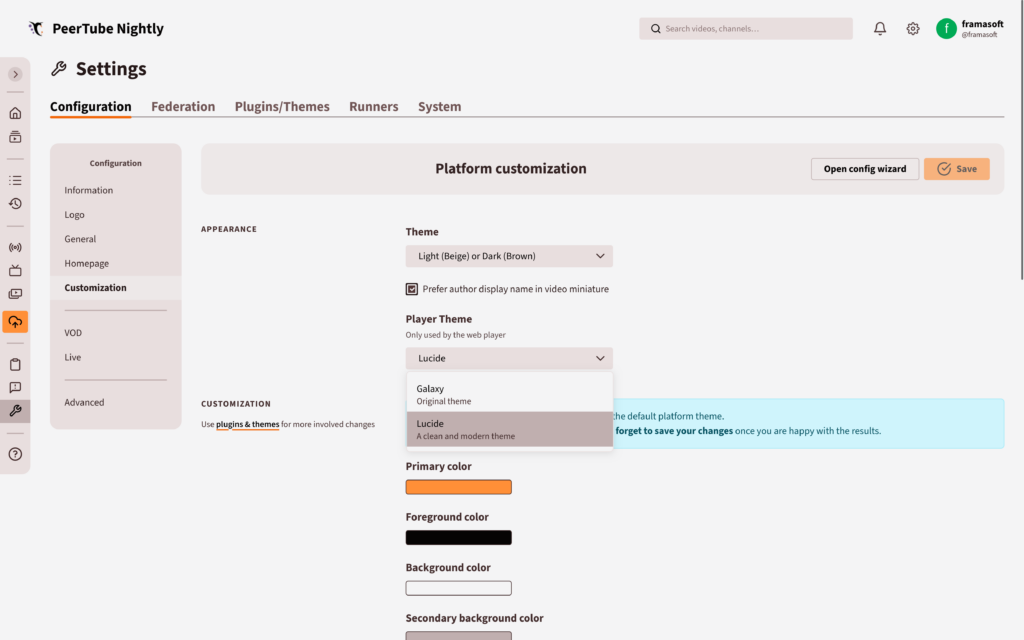

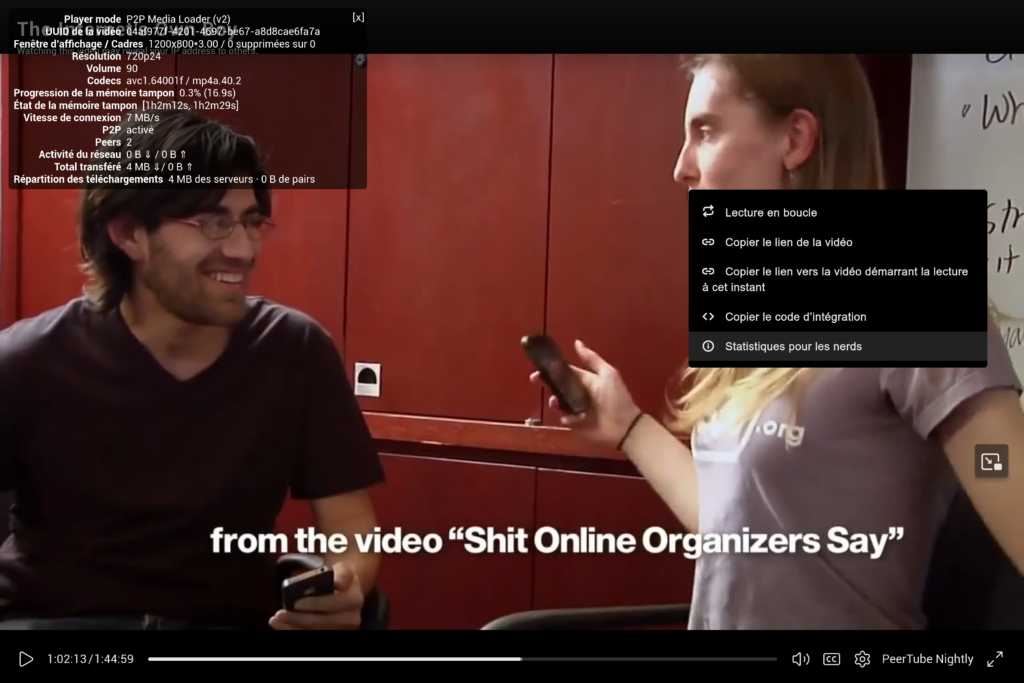

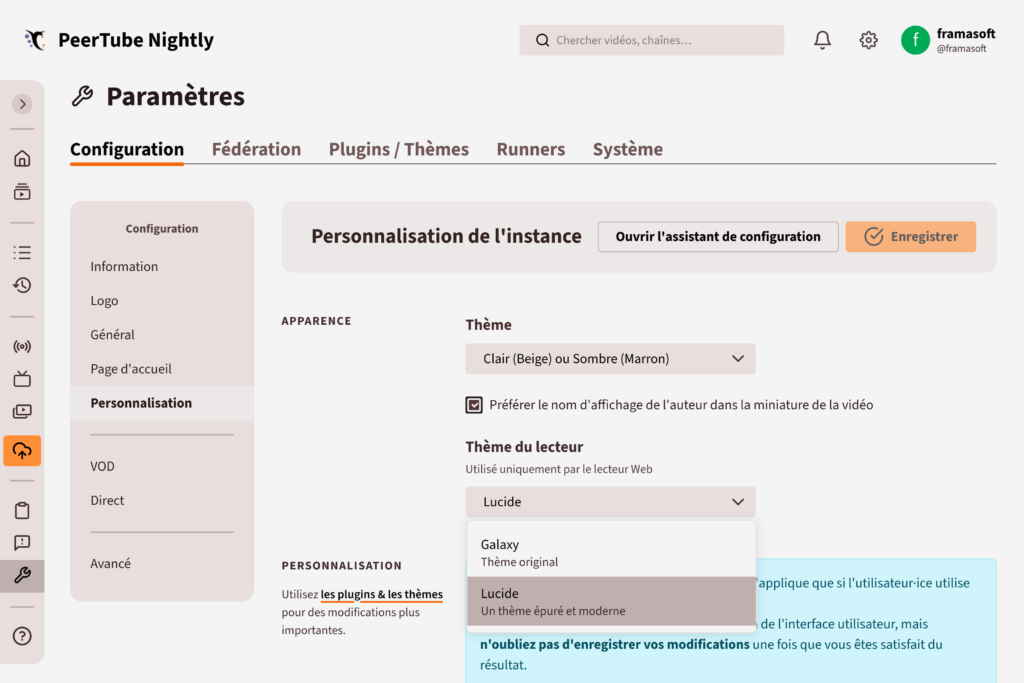

This new theme is named Lucide, in reference to the new icons used. It has been designed to be cleaner in order to better highlight the content.

Instead of bold, imposing icons, we opted for a more discreet style with finer lines on the buttons.

We also reworked the volume adjustment button to hide the volume state by default.

Finally, we moved the peer-to-peer information to the « Stats for nerds » menu, which is accessible by right-clicking on the player.

These few improvements breathe new life into PeerTube, giving it a more modern and professional look. They accomplish this by limiting the displayed information to what is strictly necessary. , as they say !

If you prefer the old theme, don’t worry, it’s still available ! You can choose the player theme at the platform, channel, or video level.

These changes are in line with all the design improvements we’ve made this year. With each update, PeerTube becomes more customizable, allowing you to create a video platform that reflects your personality !

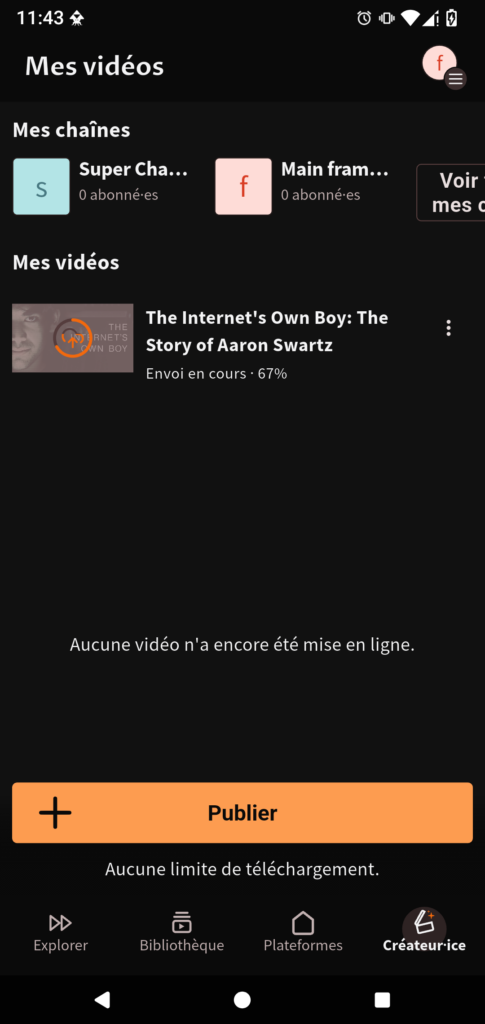

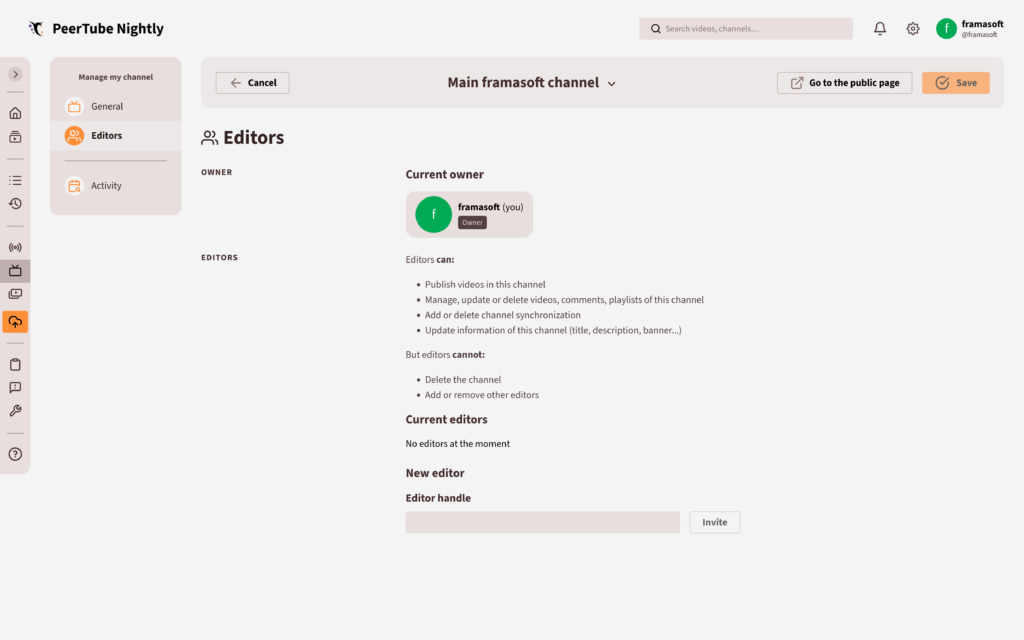

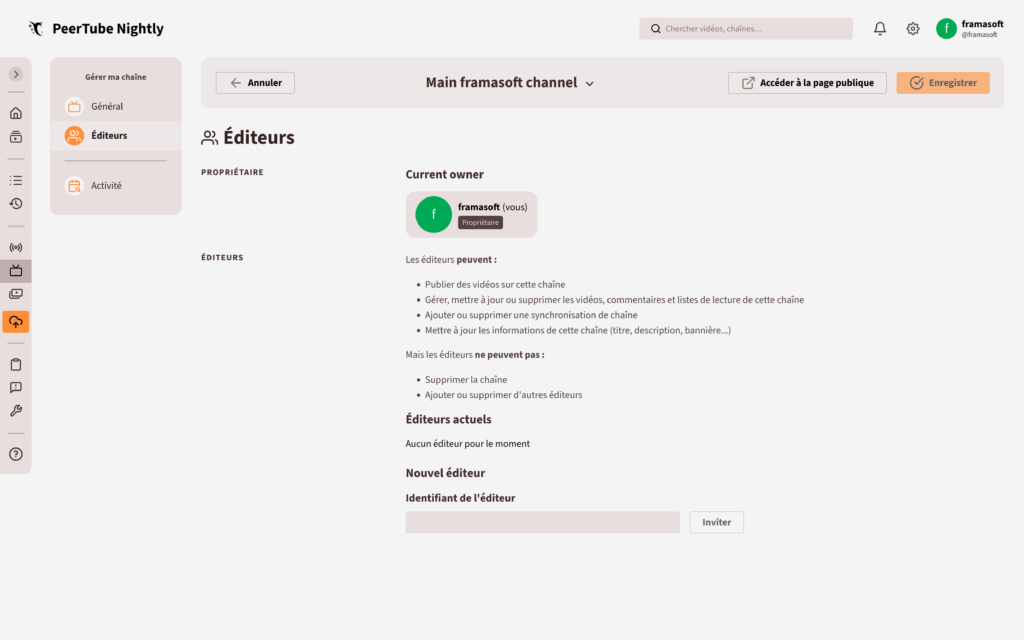

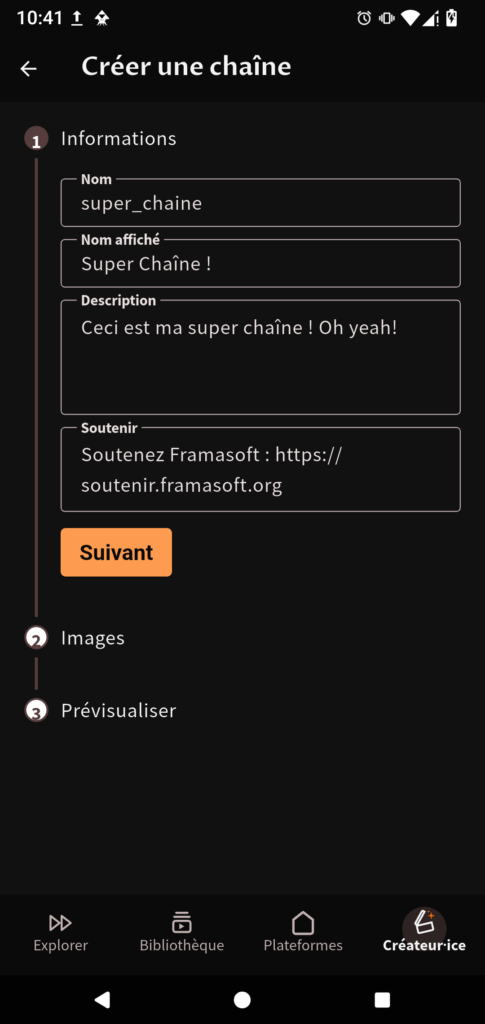

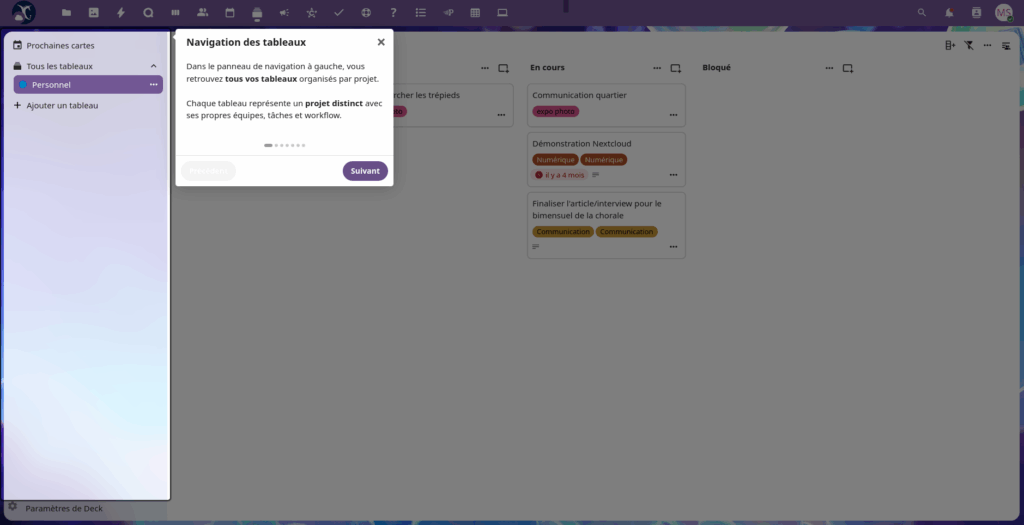

Manage your channels as a team

Since PeerTube,’s inception, many have asked us to add the ability to collaboratively manage a channel. This is, by the way, one of the most requested feature on our platform dedicated to idea suggestions !

Although use cases can very, it is often a critical need for organizations where several people are responsible for uploading new videos.

We are therefore delighted to announce that the collaborative channel management is now possible with PeerTube !

Thanks to this new feature you can now designate other members of your platform as editors.

Thus, a channel editor will be able to publish new videos, update or delete videos, playlists and comments, as well as add or delete synchronizations and update channel information !

Please note that editors cannot add or remove other editors, or delete the channel.

Of course, as with each new major version, many other improvements have been made.

Some are invisible to the general public, such as ilfarpro’s contribution, which adds the ability to generate storyboards (you know, the thumbnails that display the different images from a video when you hover over the progress bar) through a remote runner instead of the PeerTube server.

Others, however, are much more visible !

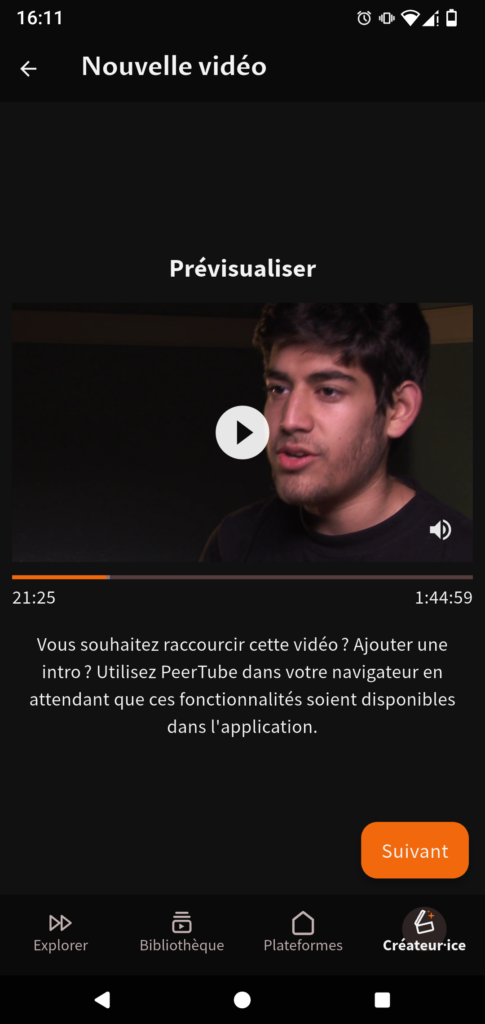

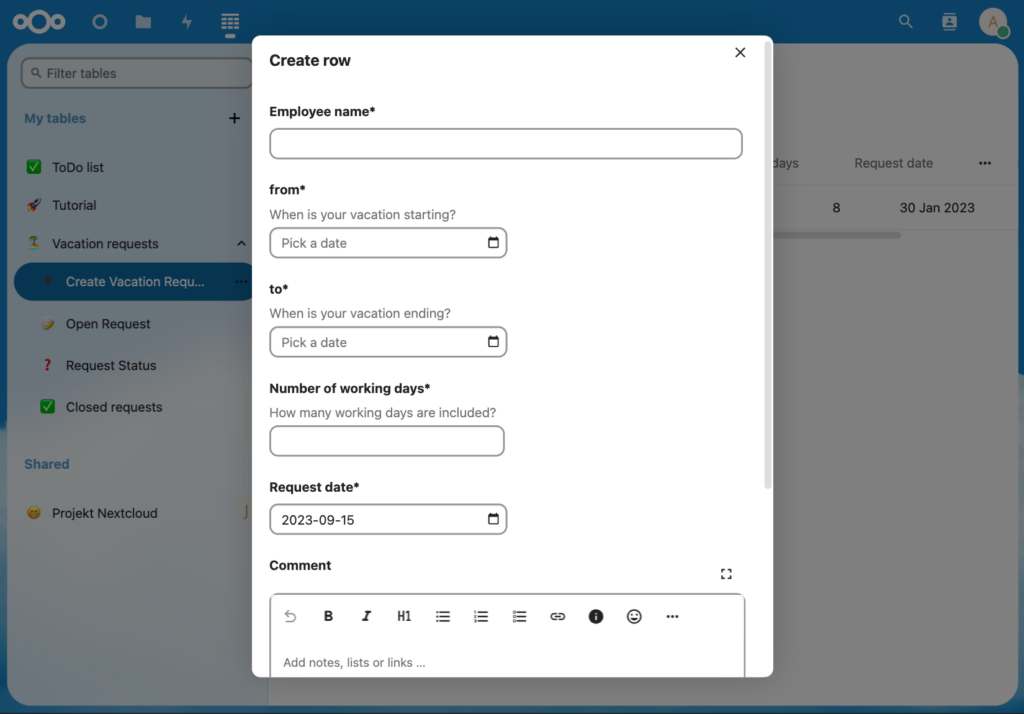

For example, this is the case with the improvements made to the system for importing videos and channels from other platforms.

It is now possible to manually rerun a failed import. Also, in the case of a channel synchronization, PeerTube will try to run again a failed import after some time (at the next verification for synchronization, which interval, being 1h by default, is configurable by the platform’s admin).

Finally, information about the status of a video import is now available in the video management page.

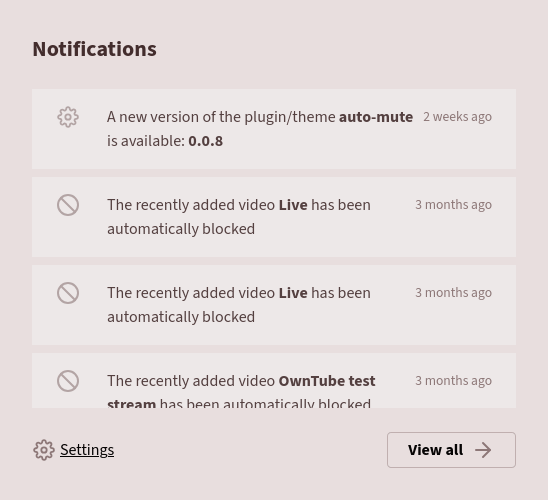

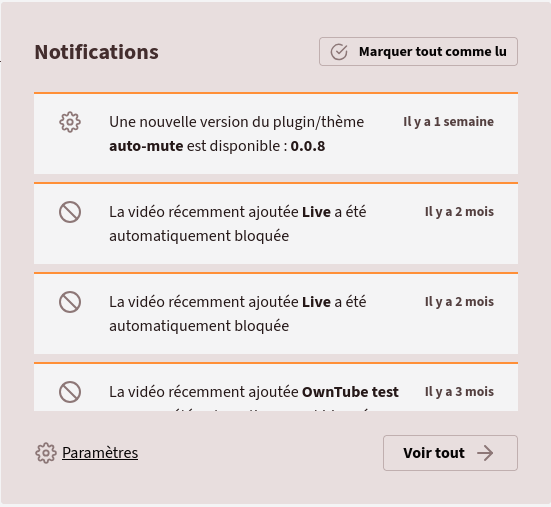

Another new improvement is that we have redesigned the appearance of notifications to better match PeerTube’s overall theme !

A complete list of all changes made in this version is available in the dedicated changelog.

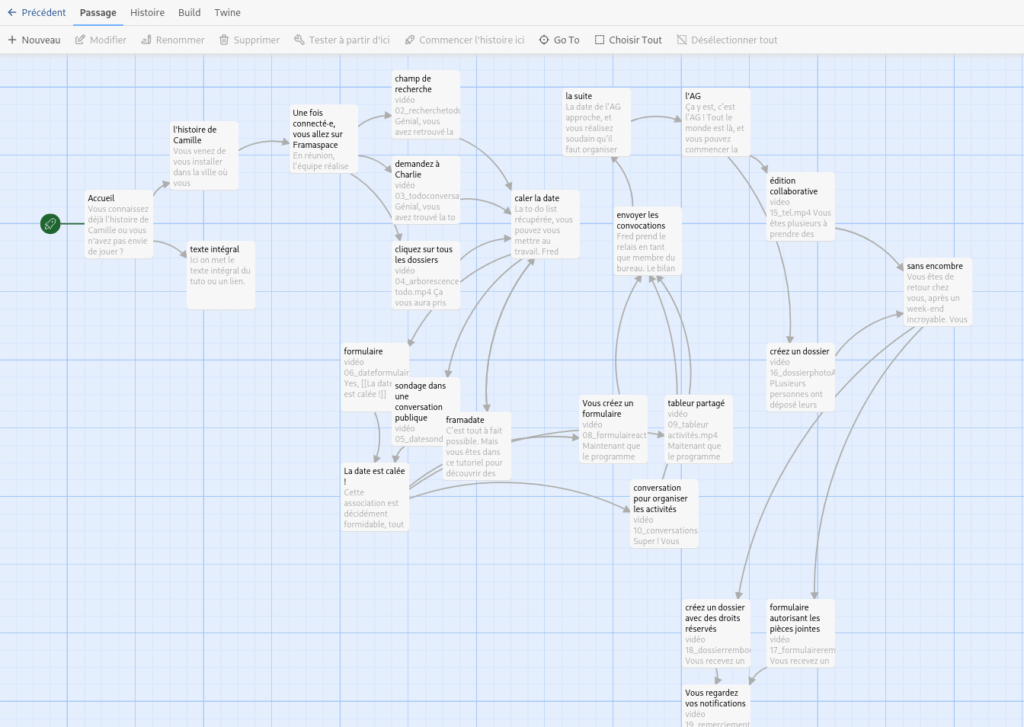

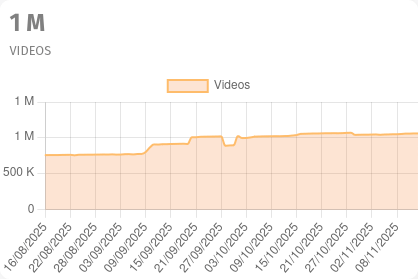

The year 2025 was marked by numerous advancements for the PeerTube project as a whole.

In total, we will have released four versions of PeerTube, all of which adhere to the guiding principle of making PeerTube easier for organizations to use.

Indeed, thanks to an NLnet grant, we were able to incorporate important features for this type of audience into the updates.

Keeping this in mind, we improved PeerTube’s design this year and made it easier to customize. Previous versions included the ability to translate PeerTube emails, a redesigned the « About » and « Video Management » pages, and an improved interface for easier batch batch action management (e.g. deleting videos) !

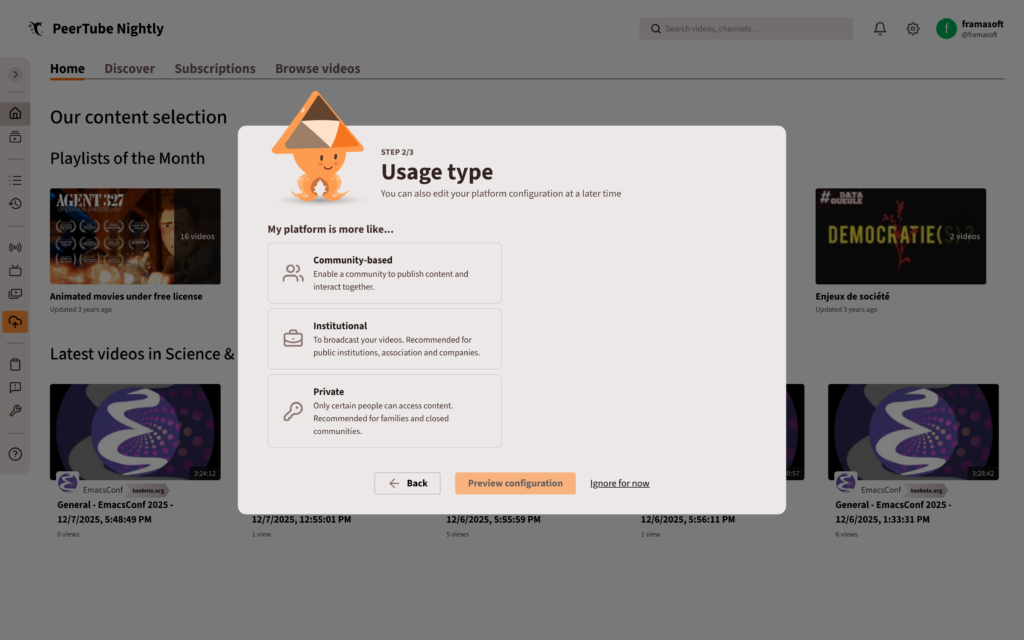

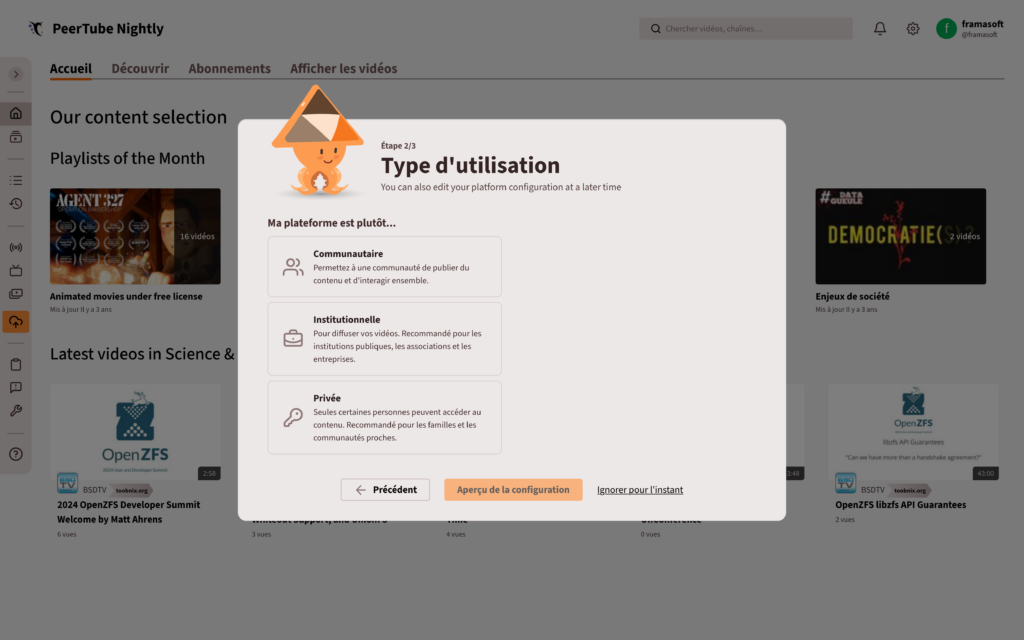

We also added — and this was the big feature in version 7.3 ! — a configuration wizard to help admins set up their platform according to their profile (institution, community, or individual).

Among other major improvements this year, we can also mention a new moderation tool that allows you to monitor certain words, making it much easier to track comments on your videos or platform !

Finally, thanks to a previous NLnet grant, but also because it was important to us : we completely redesigned the management of sensitive content.

We have long known that people’s sensitivity to a subject varies greatly and that the old system was too simplistic to truly meet the needs of video creators and their audiences.

That’s why we collaborated with La Coopérative des Internets to design system that is more complex (but not more complicated) yet more true to reality !

Institutional recognition and adoption

This recognition reinforces our confidence in the choices (both technical and political) we have made to ensure that PeerTube is a project that serves everyone.

When platforms like YouTube seem to continue to enshittify daily, more and more organizations (particularly medias outlets and institutions) are contacting us to make PeerTube their backup or even primary solution for hosting their videos.

We’re really proud to see that PeerTube truly meets the needs of all these organizations allowing them to create a video platform that they control and that respects their viewers.

First, regarding the mobile app, we aim to finalize the features promised during the crowdfunding campaign , including background video playback, live streaming, and TV apps.

If all goes well, background video playback should be available in early 2026 !

Regarding the PeerTube project as a whole, we would like to improve the experience for newcomers by reducing the effort required to find their first PeerTube platform !

The project is still in the planning stages and we still have a lot of work before it can happen. However, our ambitions could have a serious impact on the PeerTube ecosystem and we can’t wait to get started !

Early next year, we will publish the PeerTube project’s traditional roadmap. There, you will find more details about our vision for PeerTube in 2026. We are shaping this vision based on your ideas, so please feel free to share your suggestions on our dedicated platform !

To keep up with all our news (roadmap announcements, new projects, upcoming updates, etc.), you can subscribe to our social media channels and our newsletter.

PeerTube is developed by Framasoft, a french non-profit association raising awareness about digital issues. Framasoft is currently running a fundraising campaign to finance the year 2026.

At the time of writing, there are just over three weeks left to reach our goal of €250,000. However, we have only raised 24 % of this target so far.

So if you appreciate PeerTube and would like to support its development, please consider making a donation (66 % tax deductible for French residents) and help build a bright future for PeerTube !

The illustrations were created by David Revoy and are licensed under CC-BY 4.0.

09.12.2025 à 09:00

PeerTube v8 : gérez vos vidéos en équipe !

Framasoft

Texte intégral (4340 mots)

Pour la première fois depuis le développement de PeerTube, nous avons réalisé un nouveau thème pour le lecteur vidéo !

Gérez vos chaînes en équipe

Les illustrations ont été réalisées par David Revoy et sont sous licence CC-BY 4.0.

08.12.2025 à 07:42

Khrys’presso du lundi 8 décembre 2025

Khrys

Texte intégral (8444 mots)

Comme chaque lundi, un coup d’œil dans le rétroviseur pour découvrir les informations que vous avez peut-être ratées la semaine dernière.

Tous les liens listés ci-dessous sont a priori accessibles librement. Si ce n’est pas le cas, pensez à activer votre bloqueur de javascript favori ou à passer en “mode lecture” (Firefox) ;-)

Brave New World

- In Myanmar, illicit rare-earth mining is taking a heavy toll (arstechnica.com)

Uncontrolled mining in areas of Myanmar ruled by powerful ethnic armies has boomed.

- India orders smartphone makers to preload state-owned cyber safety app (reuters.com)

- « Tout brûler jusqu’à la Manche » : face à l’Occident, la diplomatie russe appelle au sang (legrandcontinent.eu)

- The missile meant to strike fear in Russia’s enemies fails once again (arstechnica.com)

A Russian intercontinental ballistic missile (ICBM) fired from an underground silo on the country’s southern steppe Friday on a scheduled test to deliver a dummy warhead to a remote impact zone nearly 4,000 miles away. The missile didn’t even make it 4,000 feet.

- La Norvège taxe les ultra-riches, et ça marche ! (lareleveetlapeste.fr)

En 2023, 654 947 citoyen·nes étaient concerné·es par cette taxe, soit 12 % de la population. Elle a rapporté 2,5 milliards d’euros cette année-là.

- Une victoire « historique » : la Norvège repousse de 4 ans l’exploitation de ses fonds marins (reporterre.net)

- « Ils ont détruit notre mer » : en Syrie, les trous béants laissés par la guerre (reporterre.net)

En Syrie, la guerre n’a pas seulement frappé les villes et les bâtiments : elle a aussi ravagé la mer Méditerranée. Fonds marins appauvris, poissons rares… Les pêcheurs locaux se battent pour leur survie.

- Le Niger annonce vouloir porter plainte contre le géant français du nucléaire Orano (rfi.fr)

Dans un nouvel épisode dans les tensions entre le Niger et Orano, Niamey a annoncé mardi 2 décembre son intention de porter plainte contre le groupe français. Le ministre nigérien de la Justice a expliqué lors d’une conférence de presse que des éléments radioactifs ont été découverts à Madaoulela, dans le nord du pays. Le Niger et Orano s’opposent déjà depuis plusieurs mois autour de l’uranium de la Somaïr, nationalisée en juin dernier.

- « On jette les agriculteurices dans les bras de grands groupes internationaux » : l’Union européenne en passe d’autoriser la propagation de « nouveaux OGM » (humanite.fr)

- À Budapest, vivre sans toit, c’est défier la loi (alterechos.be)

Restriction des hébergements d’urgence, suppression des aides au logement, interdiction de dormir dehors… En Hongrie, plus de 5.000 personnes vivent dans la rue chaque soir. Face à cet abandon du gouvernement, l’association des avocats de rue « Utcajogász » combat cette injustice en leur offrant une assistance juridique en matière de logement.

- En Allemagne, une mobilisation massive contre l’extrême droite (politis.fr)

Près de 50 000 personnes venue de tout le pays se sont rassemblées ce week-end à Gießen pour empêcher le parti d’extrême droite Alternative für Deutschland (AfD) de reformer sa faction jeune, auto-dissoute huit mois plus tôt.

- Game Over pour Cryptomixer – Europol débranche violemment la machine à laver préférée des cybercriminels (gigawatts.fr)

- EU “Chat Control” Twist : Commissioner Sides with Parliament Over Governments (patrick-breyer.de)

While EU member state governments continue to push for mass scanning of private messages (at the discretion of providers), mandatory age verification for all users, and effective bans on communication apps for under-17s, the Parliament enters negotiations with a clear alternative model : Mandatory but targeted surveillance only where reasonable suspicion exists and with a judicial warrant, alongside a firm rejection of mandatory age checks and app lockouts for teenagers.

- UK pushes ahead with facial recognition expansion despite civil liberties backlash (theregister.com)

Plan would create statutory powers for police use of biometrics, prompting warnings of mass surveillance

- UK is running out of water – but data centres refuse to say how much they use (inews.co.uk)

- Le bipartisme c’est terminé : comment la vague populiste d’extrême droite balaye les « démocraties’’ occidentales (slate.fr)

Des États-Unis à la France en passant par l’Allemagne et les Pays-Bas, les partis d’extrême droite atteignent des niveaux historiques. Leur influence grandissante met sous pression les démocraties libérales, fragilisées par des crises institutionnelles à répétition.

- Second Texas university system to restrict race and gender course content (statesman.com)

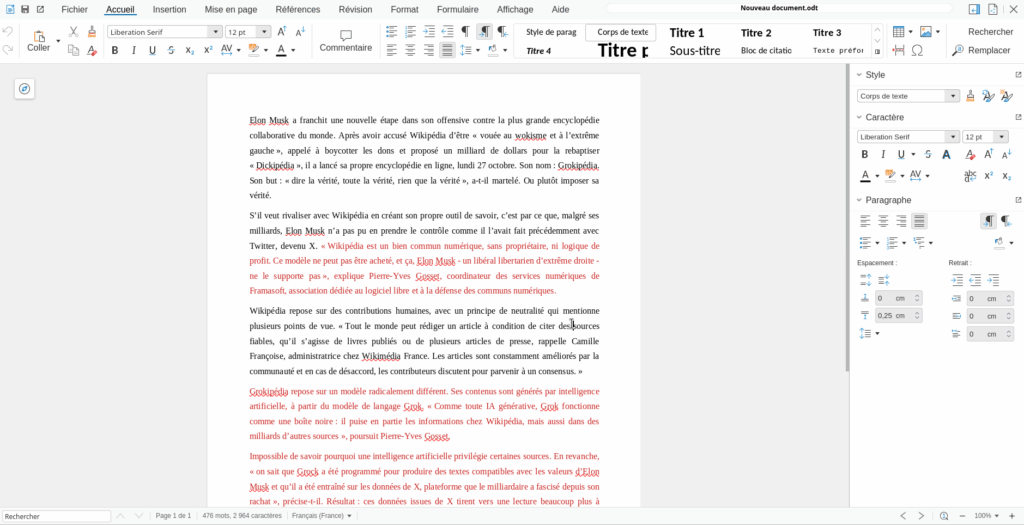

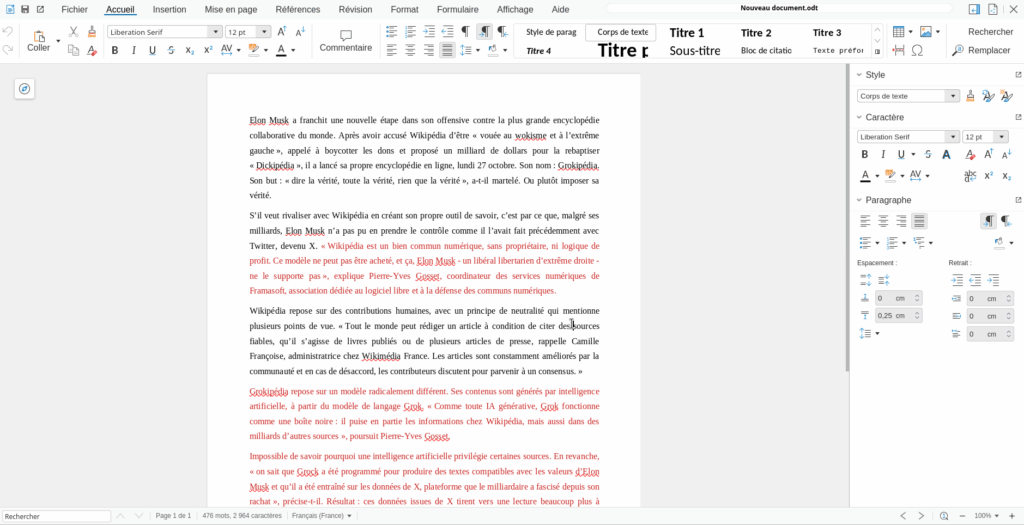

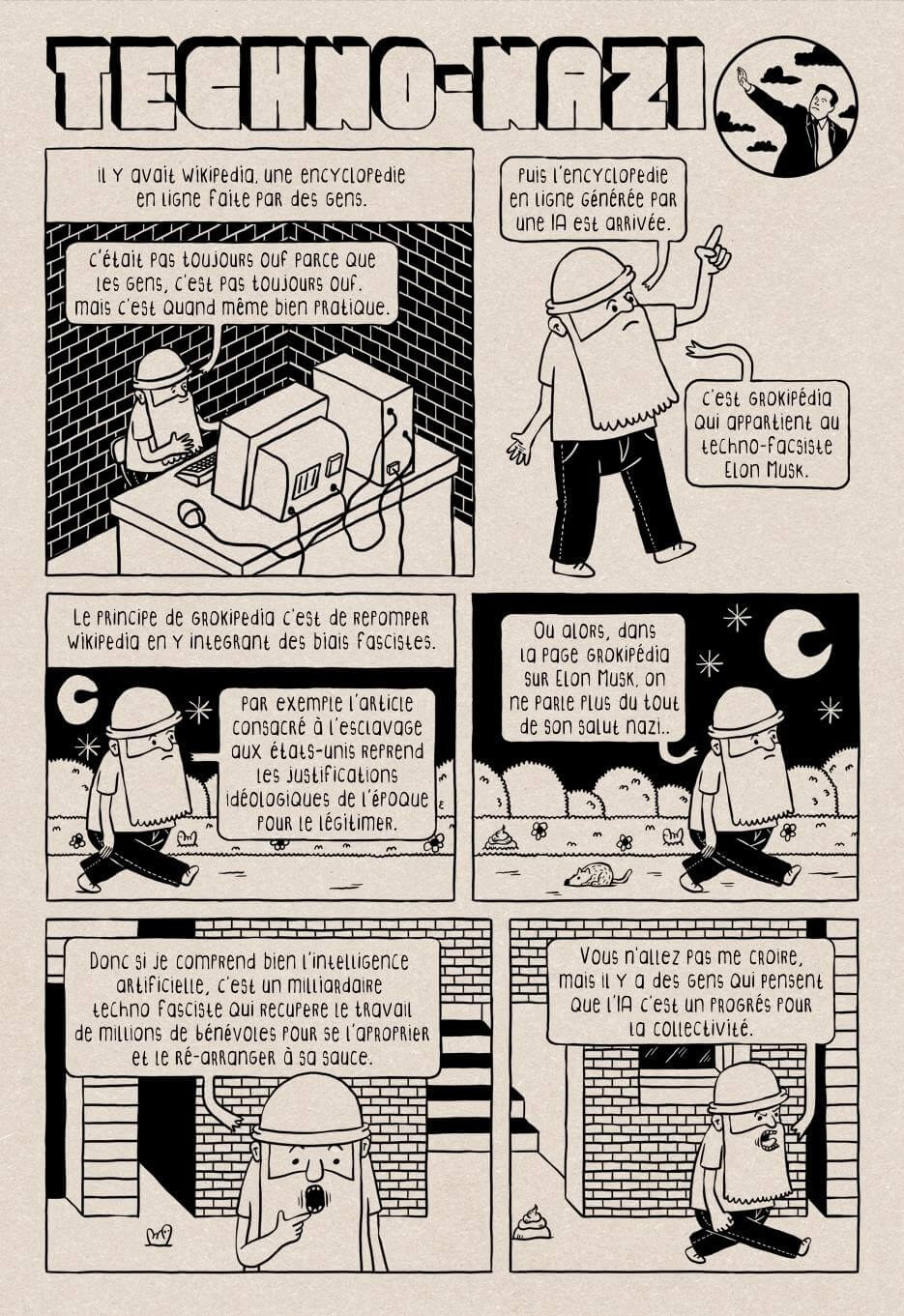

- Grokipedia – Le monument de la connaissance rêvé par Elon Musk n’est qu’un immense naufrage numérique (gigawatts.fr)

- McDonald’s sales are slumping because people can’t afford fast-food (cbsnews.com)

- Coca-Cola, Nestlé… San Francisco poursuit 10 géants de la malbouffe (reporterre.net)

San Francisco, au nom de l’État de Californie, a engagé le 2 décembre une procédure judiciaire inédite contre dix géants de l’alimentation ultratransformée, parmi lesquels Coca-Cola, Nestlé et PepsiCo, les accusant d’avoir provoqué une « crise de santé publique ».

- Luigi Mangione est de retour devant la justice (huffingtonpost.fr)

Le jeune homme de 27 ans est attendu pour une audition préliminaire au tribunal de New York, il est poursuivi pour leur meurtre du PDG d’une compagnie d’assurances[…]L’objectif de ses avocats est clair : empêcher les procureurs d’utiliser certaines preuves que les procureurs disent accablantes pour l’Américain de 27 ans, qui a plaidé non coupable.

- Cette plainte du « New York Times » n’arrange pas le Pentagone déjà dans la tourmente (huffingtonpost.fr)

Le New York Times a annoncé ce jeudi 4 décembre avoir lancé une action en justice contre le Pentagone, pour avoir mis en œuvre une série de mesures restrictives à l’égard de la presse qu’il juge contraires à la Constitution.

- What Chicago’s fight against ICE can teach us all about how to resist oppression (theguardian.com)

Hannah Arendt discussed the term Gleichschaltung, roughly translatable as “coordination” or “synchronisation”. It came from the Nazi justice minister Franz Gürtner to mean, broadly, that all political, social, cultural and civic institutions had to fall in line with the totalitarian state. Such a thing can only be achieved with the complicity of everyone : the minute-by-minute decisions of people who will do anything, personally or professionally, to stay with the majority. […] only about 15 % of people resisted nazism. It wasn’t because they were fervent supporters, or even, at the outset, because they were scared, but because that’s where the herd was. […] Don’t wait until your government is so racist that it’s lifting people off ladders while they are trying to work, or seizing kids as they are trying to get to school, before you protest. Every time you hear aggressive xenophobia and racist insinuation from those in power and check in with how it polled before you say it’s disgusting, you are building the herd that will suffocate opposition when it matters.

- Colombia bans all new oil and mining projects in its Amazon (news.mongabay.com)

- The Rise of Chile’s Hard Right (jacobin.com)

The first round of voting in Chile’s general election in November saw the shocking rise of the far right and the collapse of the country’s new left. It’s a crushing but not total defeat for the movement helmed by President Gabriel Boric.

- Glyphosate : une étude favorable à l’herbicide enfin désavouée et dépubliée (reporterre.net)

Vingt-cinq ans après sa publication, l’étude a pourtant largement été citée par les défenseurs de l’herbicide le plus vendu au monde. « Cet article a eu une influence considérable sur les décisions réglementaires concernant le glyphosate et le Roundup pendant des décennies »

- Satellite megaconstellations will threaten space-based astronomy (nature.com)

- Le spyware d’État Predator peut maintenant exploiter l’affichage des pubs mobiles pour vous infecter sans clic (clubic.com)

- Les revenus des grandes entreprises de l’armement ont atteint leurs niveaux les plus élevés en 2024 (legrandcontinent.eu)

Spécial IA

- L’IA générative, « instrument de précision » pour la censure et la répression en Chine (next.ink)

- In comedy of errors, men accused of wiping gov databases turned to an AI tool (arstechnica.com)

Two sibling contractors convicted a decade ago for hacking into US State Department systems have once again been charged, this time for a comically hamfisted attempt to steal and destroy government records just minutes after being fired from their contractor jobs. Despite their brazen attempt to steal and destroy information from multiple government agencies, the men lacked knowledge of the database commands needed to cover up their alleged crimes. So they allegedly did what many amateurs do : turned to an AI chat tool.

- “Je suis horrifié” : l’IA de Google efface l’intégralité du disque D d’un utilisateur, le désastre du “vibe coding” (clubic.com)

- Syntax hacking : Researchers discover sentence structure can bypass AI safety rules (arstechnica.com)

Researchers from MIT, Northeastern University, and Meta recently released a paper suggesting that large language models (LLMs) similar to those that power ChatGPT may sometimes prioritize sentence structure over meaning when answering questions.

- Quand l’IA fait n’importe quoi, le cas du gratte-ciel et du trombone à coulisse (theconversation.com)

- ‘End-to-end encrypted’ smart toilet camera is not actually end-to-end encrypted (techcrunch.com)

The security researcher also pointed out that given Kohler can access customers’ data on its servers, it’s possible Kohler is using customers’ bowl pictures to train AI.

- OpenAI desperate to avoid explaining why it deleted pirated book datasets (arstechnica.com)

OpenAI may soon be forced to explain why it deleted a pair of controversial datasets composed of pirated books, and the stakes could not be higher.At the heart of a class-action lawsuit from authors alleging that ChatGPT was illegally trained on their works, OpenAI’s decision to delete the datasets could end up being a deciding factor that gives the authors the win.

Voir aussi OpenAI loses fight to keep ChatGPT logs secret in copyright case (reuters.com)

- OpenAI declares ‘code red’ as Google catches up in AI race (theverge.com)

Google’s own ‘code red’ response to ChatGPT has started paying off.

- Google’s toying with nonsense AI-made headlines on articles in the Discover feed (pcgamer.com)

With the power of AI, data centres the size of a kolkhoz can now write clickbait instead of underpaid journalists at struggling websites.

- Une start-up de 8 employés publie 3 000 podcasts par semaine, générés par IA (next.ink)

- AI is Destroying the University and Learning Itself (currentaffairs.org)

Students use AI to write papers, professors use AI to grade them, degrees become meaningless, and tech companies make fortunes. Welcome to the death of higher education.

- The hidden Kenyan workers training China’s AI models (restofworld.org)

An unemployment crisis has created fertile ground for companies to step in with opaque systems built on WhatsApp groups, middlemen, and bargain-basement wages.

- The Reverse Centaur’s Guide to Criticizing AI (pluralistic.net)

RIP

- Frank Gehry, architecte visionnaire et maître du déconstructivisme, est mort (france24.com)

L’architecte américano-canadien Frank Gehry, l’un des rares de sa profession à s’être hissé au rang de superstar à travers la planète, est mort vendredi à l’âge de 96 ans.

Spécial Palestine et Israël

- Le huitième front (monde-diplomatique.fr)

Israël a perdu les faveurs de l’opinion publique américaine (lire « Même les Américains se lassent d’Israël »). Conscient du péril, le premier ministre Benyamin Netanyahou a annoncé l’ouverture d’un « huitième front », la « bataille pour la vérité », afin de reconquérir les cœurs et les esprits […] Il a chargé la société Clock Tower X d’inonder les réseaux sociaux américains de contenus « calibrés pour la génération Z ». Cette agence doit également créer une myriade de pages Internet destinées à orienter les réponses de ChatGPT ou Grok. Des influenceurs, rémunérés jusqu’à 7 000 dollars par publication, complètent l’opération. Mais il faut aussi faire disparaître ce que les gens ne doivent plus voir. Tout est alors affaire d’algorithme. Concernant X, M. Netanyahou ne s’inquiète pas (« Elon [Musk] est un ami, nous allons lui parler »). Le problème viendrait surtout de TikTok.

- Marwan Barghouti : 200 célébrités demandent la libération du “Mandela palestinien” (france24.com)

Musicien·nes, acteurices, écrivain·es… plus de 200 célébrités ont signé mercredi une lettre ouverte pour soutenir la campagne de libération de Marwan Barghouti. Emprisonné depuis plus de 20 ans en Israël, cette figure du Fatah est considéré par beaucoup comme le possible dirigeant d’un futur État palestinien.

- Contre Benjamin Netanyahu, ces Israéliens manifestent à Tel Aviv avec des bananes (huffingtonpost.fr)

Le Premier ministre d’Israël a officiellement demandé une grâce présidentielle dans son procès pour corruption. Ses opposants dénoncent une « république bananière ».

- Eurovision : quatre pays se retirent face au maintien d’Israël, la France se félicite d’avoir « contribué à empêcher un boycott » (humanite.fr)

- La Via Campesina condamne fermement les attaques contre son organisation membre en Palestine et dénonce les arrestations arbitraires (viacampesina.org)

- La tech israélienne de l’eau accueillie en catimini dans le sud de la France (reporterre.net)

La goutte de trop. La rencontre organisée le 3 décembre entre des entreprises israéliennes de l’eau et des acteurs français du secteur ne passe pas. Dans une lettre ouverte au président de la région Provence-Alpes-Côte d’Azur, Renaud Muselier, une quinzaine de collectifs et associations engagés sur l’eau et le soutien à la Palestine demandent l’annulation de l’événement.

Spécial femmes dans le monde

- LinkedIn favoriserait les profils masculins (humanite.fr)

Plusieurs utilisatrices ont commencé, le mois dernier, à […] mettre à jour leur présentation et leurs publications en les masculinisant. Résultat : une audience et des interactions qui grimpent. L’une a vu sa visibilité augmenter de 244 %, d’autres ont constaté la montée en flèche des mentions j’aime, des commentaires et des partages. Les posts d’une journaliste de l’AFP ont enregistré des milliers de clics supplémentaires.

- Only three out of ten ambassadors from European Union countries are women (civio.es)

Finland is the only EU country with a female majority while at the other extreme, in Italy and Czechia, men dominate the diplomatic corps.

- Terreur, viols, meurtres… Le quotidien épouvantable des femmes qui migrent du Soudan vers le Soudan du Sud (theconversation.com)

- 6 décembre : voici pourquoi le Canada doit reconnaître le crime de féminicide (theconversation.com)

Cela fait 36 ans que le massacre de 14 jeunes femmes a eu lieu à l’École Polytechnique de Montréal. Un homme les a abattues parce qu’elles étaient des femmes.Qualifié d’acte « violent de misogynie » par le gouvernement fédéral, ce massacre n’a pourtant jamais été officiellement qualifié de féminicide au Canada, malgré sa reconnaissance mondiale.

- Woman Hailed as Hero for Smashing Man’s Meta Smart Glasses on Subway (futurism.com)

Spécial France

- France Télécom : condamné dans l’affaire des suicides, l’ancien patron Didier Lombard perd sa Légion d’honneur. (sudouest.fr)

- Piratage informatique : les données de 1,6 million de personnes “susceptibles d’être divulguées”, selon France Travail et l’Union nationale des missions locales (franceinfo.fr)

- Le CNRS s’émancipe du Web of Science (cnrs.fr)

À partir du 1er janvier 2026, le CNRS coupera l’accès à l’une des plus importantes bases bibliométriques commerciales : le Web of Science de Clarivate Analytics, ainsi que les Core Collection et Journal Citation Reports.

- Retraites, année blanche, congé maladie… La soirée qui a re-refaçonné le budget de la Sécu (huffingtonpost.fr)

Les député·es ont notamment rétabli la suspension de la réforme des retraites, annulée par les sénateurices quelques jours plus tôt.

- 1297 personnes sont mortes au travail en 2024 (basta.media)

L’Assurance maladie vient de publier les chiffres annuels des décès liés au travail. En 2024, 1297 personnes ont perdu la vie en raison de leur activité professionnelle. Un chiffre record. Les plus âgé·es sont plus touché·es.

- Remboursement des fauteuils roulants : promesse tenue (politis.fr)

Depuis le 1er décembre, la Sécurité sociale rembourse la totalité du coût du fauteuil roulant pour les personnes en situation de handicap. Une bonne nouvelle pour les 1,1 million de personnes qui utilisent un fauteuil roulant en France, et les 150 000 qui en achètent chaque année.

- À l’Assemblée, Mélenchon nie tout lien entre LFI et les islamistes et se fait professeur de laïcité (humanite.fr)

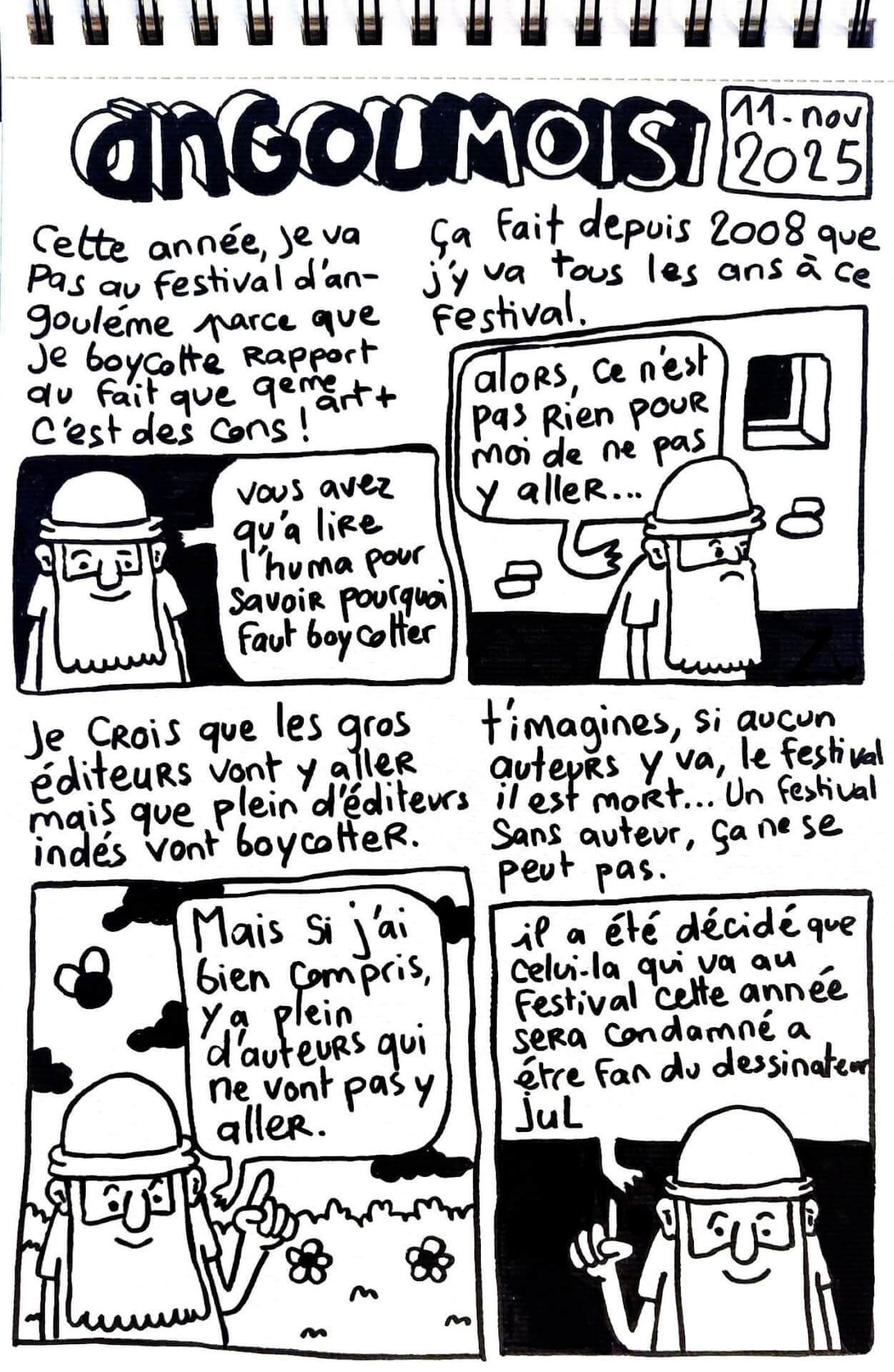

- L’édition 2026 du festival de BD d’Angoulême est officiellement annulée (france24.com)

L’édition 2026 du Festival international de BD d’Angoulême, qui devait se tenir fin janvier mais était plombée par le boycott des auteurices et la défection des éditeurices, est officiellement “annulée”, a affirmé lundi à l’AFP un des avocats de la société organisatrice 9e Art+.

- Bercy met de l’huile dans les rouages de l’implantation de datacenters en France (next.ink)

Build, baby, build

- La SNCF s’obstine à contourner le centre de la France (reporterre.net)

Avec sa nouvelle liaison Ouigo via l’Île-de-France, la SNCF prive une fois de plus le Massif central de connexion ferroviaire directe. Élus et associations réclament le retour d’une ligne traversant le centre de la France.

- Assurance habitation : le climat fait flamber les primes et fragilise les assurés, alerte l’UFC-Que Choisir (franceinfo.fr)

- L’eau minérale naturelle de Perrier est à nouveau inconsommable… (franceinfo.fr)

- Le plus petit des PFAS est omniprésent dans l’eau, confirme l’Anses (reporterre.net)

- La France a exporté 6 620 tonnes de pesticides interdits en 2024 (reporterre.net)

En 2024, la France a exporté 6 620 tonnes de pesticides interdits sur son territoire en raison de leur dangerosité pour la santé et l’environnement, révèle l’ONG suisse Public Eye dans une carte interactive publiée le 1er décembre.

La carte (publiceye.ch)

- Ce vigneron lutte contre les inondations grâce à l’agriculture bio sans labour (basta.media)

« Aujourd’hui, les agriculteurs nourrissent la plante et non pas le sol, alors que, quand vous nourrissez le sol, il y a suffisamment d’éléments à disposition des racines des plantes pour leur développement. Comme dans une forêt, vous avez des arbres qui fabriquent des tonnes de bois et pourtant il n’y a jamais eu besoin d’engrais chimiques ! »

- LGBTQIA+ : les agressions en forte progression depuis huit ans (stup.media)

- Éducation à la sexualité : l’État condamné pour 24 ans de manquements (politis.fr)

En France, l’éducation à la vie affective et sexuelle est inscrite dans la loi depuis 2001, organisée en trois séances par année scolaire. Dans la pratique, c’est loin d’être le cas. Face à ce manquement, le Planning familial, Sidaction et SOS Homophobie ont saisi la justice il y a deux ans et ont obtenu gain de cause le 2 décembre.

Spécial femmes en France

- Santé sexuelle : Sidaction s’alarme de la montée en puissance des discours masculinistes auprès des jeunes (publicsenat.fr)

31 % des 16-34 ans « se sentent plus puissants » quand ils ne portent pas de préservatif, 32 % pensent que les femmes doivent respecter leur refus d’en porter et 16 % voient dans ce mode de contraception « un signe de faiblesse ». Quant à la pratique répréhensible du « stealthing » (ndlr : retirer son préservatif sans prévenir son ou sa partenaire), 34 % des jeunes hommes adhérant aux théories masculinistes disent la cautionner. Et globalement, un homme sur dix (11 %), et un jeune de 25-34 ans sur cinq (18 %), déclarent comprendre ce retrait s’ils estiment que le préservatif a été imposé.

Voir aussi “C’est banalisé de le faire sans se protéger” : comment les lycéens sont incités “sur les réseaux sociaux” à des pratiques sexuelles risquées (franceinfo.fr)

- À Marseille, l’affaire de la femme tabassée par la police connaît un tournant, sept ans après les faits (huffingtonpost.fr)

Un policier a été mis en examen pour « violences aggravées » dans ce dossier longtemps ralenti par la culture du silence au sein des forces de l’ordre.

- Les réseaux français d’Epstein se découvrent (portail.basta.media)

- “En France, on peut faire 240 victimes et vivre sa vie tranquillement” : le calvaire de Sylvie, victime de soumission chimique par un haut fonctionnaire (france3-regions.franceinfo.fr)

Plus de 240 femmes accusent Christian Nègre, un haut fonctionnaire du ministère de la Culture, de les avoir droguées à leur insu lors d’entretiens d’embauche.

Spécial médias et pouvoir

- Face à Sophie Binet, Benjamin Duhamel se fait avocat de Bernard Arnault (acrimed.org)

Mardi 2 décembre, la secrétaire générale de la CGT, Sophie Binet est l’invitée de 8h20 sur France Inter, pour la première fois depuis la rentrée. L’occasion d’entendre les revendications des travailleurs ? Ou, pour les deux intervieweurs, de se faire les porte-voix du grand patronat.

- Le 20h de Salamé : l’info en mode zapping (acrimed.org)

- Bardella, l’œuf et la peur (politis.fr)

En quelques jours, le président du RN a été aspergé de farine et a reçu un œuf. Pour certains commentateurs, nous serions entrés dans une ère de chaos où la démocratie vacille au rythme des projectiles de supermarché. Ce qui devrait plutôt les inquiéter est la violence d’une parole politique qui fragilise les minorités, les élus et l’État de droit.

- Qui a peur de CNews ? (politis.fr)

Face à un média clairement d’extrême droite, la frilosité de l’Arcom, le « gendarme de l’audiovisuel », intrigue et inquiète.

- « Complément d’enquête » sanctionné, CNews favorisée : quand l’Arcom sacrifie l’audiovisuel public au profit de l’extrême droite (humanite.fr)

Par deux fois, l’émission « Complément d’enquête » s’est vue réprimander ces derniers mois par le régulateur des médias malgré un travail d’investigation de taille. En pleine commission sur l’audiovisuel public, ces décisions de l’Arcom interrogent : brimer une telle offre journalistique, sans motif sérieux, donne des gages à l’extrême droite

- Pierre-Édouard Stérin entre au capital de Valeurs Actuelles et place déjà ses gens de confiance (humanite.fr)

Spécial emmerdeurs irresponsables gérant comme des pieds (et à la néolibérale)

- Emmanuel s’en va-t-en-guerre (blogs.mediapart.fr)

- Sur le budget de la Sécu, la Macronie rejoue la carte du catastrophisme surjoué (huffingtonpost.fr)

Comme l’an passé, une partie des troupes du président de la République alerte sur les risques de la non-adoption du texte avant le 31 décembre, quitte à exagérer.

- Le Conseil d’État enterre le droit de grève à Radio France (humanite.fr)

Le Conseil d’État vient de rejeter le recours des représentants du personnel et des syndicats contre un texte qui vise à limiter cette liberté fondamentale.

Spécial recul des droits et libertés, violences policières, montée de l’extrême-droite…

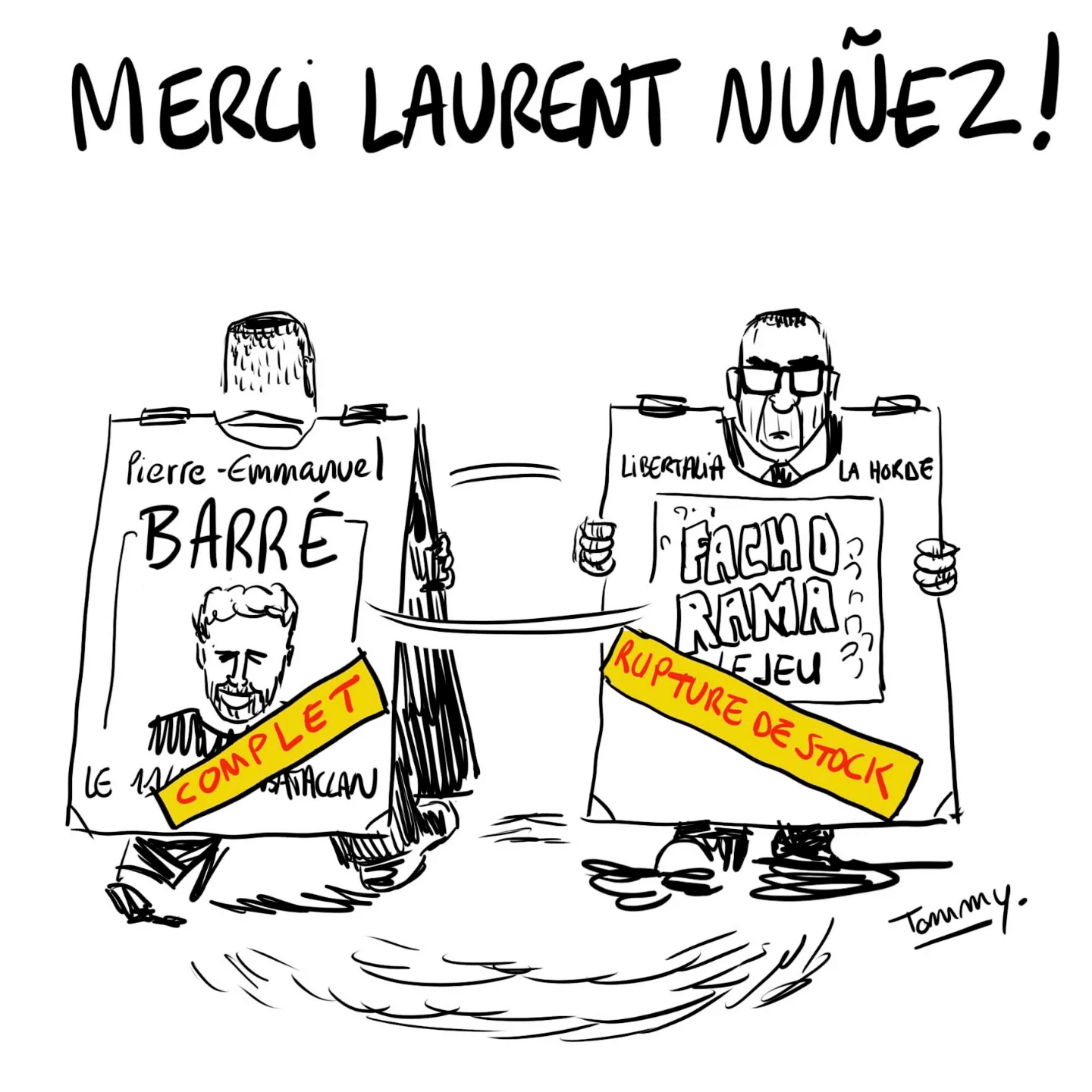

- Fâché contre « Fachorama », le ministre de l’Intérieur porte plainte contre l’éditeur du jeu (huffingtonpost.fr)

Libertalia a dévoilé un nouveau jeu de sept familles en association avec le collectif antifasciste La Horde.

- Sophie Binet annonce sa mise en examen après avoir comparé des grands patrons menaçant de délocaliser à des “rats” qui “quittent le navire” (franceinfo.fr)

Fin janvier, elle avait réagi aux propos du patron du groupe LVMH, Bernard Arnault, qui estimait que le projet de surtaxe du gouvernement “poussait à la délocalisation”, en estimant que “ses propos sont à l’image du comportement des grands patrons aujourd’hui qui coulent le pays”, qui “n’en ont plus rien à faire de la France (…). Moi, j’ai envie de dire : les rats quittent le navire.”

- Loi Duplomb : un médecin convoqué à la gendarmerie pour un post Facebook, après la plainte d’une députée RN (reporterre.net)

Le 3 décembre, un médecin généraliste de Charente a été convoqué à la gendarmerie d’Angoulême en audition libre. Son tort ? Avoir dénoncé sur les réseaux sociaux « l’obscurantisme » de Caroline Colombier, députée Rassemblement national, en plein débat sur la loi Duplomb cet été.

- Menacé·es de prison pour l’organisation de manifestations à Sainte-Soline (basta.media)

Des porte-parole des Soulèvements de la terre, Bassines non merci, Solidaires et CGT comparaissent en appel ce 3 décembre. Des peines de prison avait été prononcées en première instance. Depuis, la bassine en cause a été déclarée illégale.

- Sur le plateau de Millevaches : des militant·es écolos sous surveillance (journal-labreche.fr)

- Gaz lacrymo et LBD pour avoir refusé d’abattre leurs vaches vaccinées contre la dermatose (basta.media)

175 gendarmes ont été déployés sur une ferme du Doubs où des agriculteurs et voisins s’étaient rassemblés pour empêcher l’abattage de 82 vaches. Une seule était atteinte de dermatose nodulaire contagieuse. L’enjeu pour l’État : préserver l’export.« On est traités pire que des terroristes juste parce qu’on veut défendre nos vaches. »

- Chronique du système policier : le taser, une arme dangereuse qui tue régulièrement, hooliganisme policier, racisme… (ricochets.cc)

- Des librairies indépendantes menacées et vandalisées (politis.fr)

Depuis plusieurs mois, des librairies indépendantes – à Paris comme en région – subissent vandalisme, menaces et cyberharcèlement […] par des « groupuscules ou individus se réclamant d’idéologies extrémistes », « motivés par le seul fait que certains livres sont vendus, présentés ou débattus avec leurs auteurs en librairie ».