ACCÈS LIBRE

23.09.2025 à 09:00

Sarah qui ? Ça raccroche !

Frédéric Urbain

Texte intégral (1615 mots)

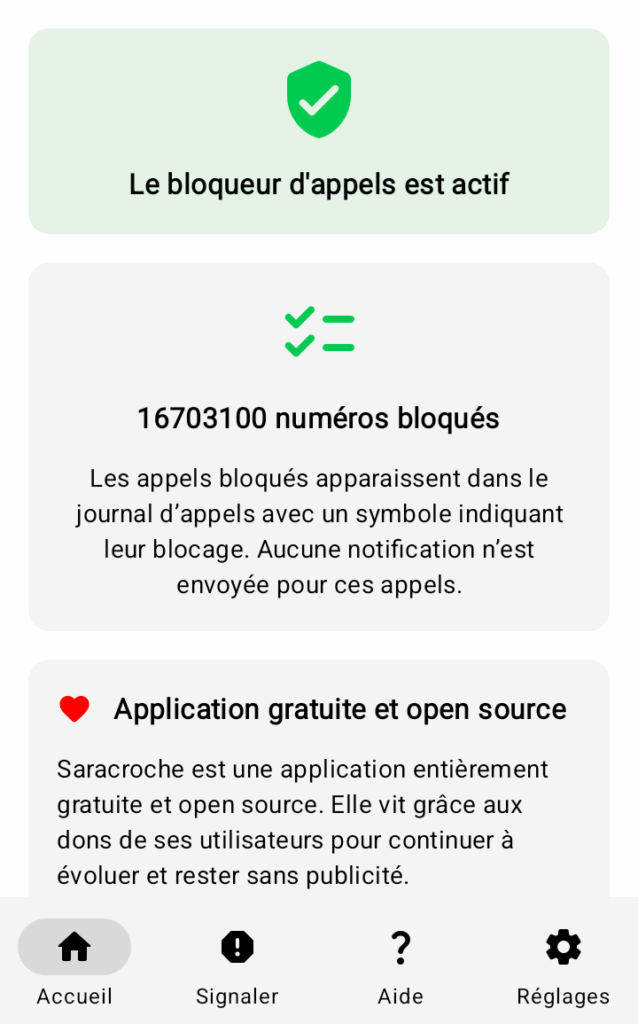

Marre des appels indésirables ? Un développeur français vous propose de bloquer plus de 16 millions de numéros sur iOS et Android.

Salut Camille !

Peux-tu nous dire qui tu es ?

Je m’appelle Camille Bouvat, je suis développeur depuis bientôt 18 ans et freelance depuis 13 ans, spécialisé dans le PHP avec Laravel. Je travaille avec différents types de clients, petites et grandes entreprises. J’aime diversifier mes compétences avec de l’administration système, de l’UX/UI, de l’accessibilité et aussi dernièrement du développement mobile natif. J’ai eu beaucoup d’expériences différentes que ce soit en entreprise, en tant qu’indépendant et entrepreneur ou même en tant que formateur.

Pour bloquer les appels indésirables, nous avons l’habitude de recommander Yet Another Spam Blocker (voir sur Framalibre ou chez Grisebouille), qui est sous licence AGPL et plutôt efficace. Pourquoi avoir créé une autre application de ton côté ?

Étant utilisateur iOS, cette application n’est pas disponible sur cette plateforme et je ne connaissais pas cette application. J’ai cherché simplement sur l’App Store et j’ai trouvé quelques applications que j’ai testées et utilisées. Mais souvent soit elle était payante, soit gratuite mais avec une liste de blocage assez limité ou encore une interface pas très intuitive.

Donc un dimanche après-midi, je me suis dit « tiens, code un prototype pour bloquer les appels », vers 20h j’avais le prototype fonctionnel. Après quelques peaufinements, je publie l’application sur l’App Store le lundi suivant. Puis, j’ai voulu pousser le bouchon plus loin en allant chercher des informations dans les données open-data de l’ARCEP, pour commencer à bloquer tous les préfixes des opérateurs sources de SPAM. La majorité des applications ne bloque que 12,5 millions de numéros qui correspondent aux numéros dédié au démarchage.

Actuellement, Saracroche bloque plus de 16 millions de numéros et et la liste va encore grossir au fur et à mesure des signalements faits dans l’application.

Je voulais aussi une application qui respecte au maximum la vie privée, en demandant le minimum de permissions, et qui limite au maximum les échanges avec un serveur.

T’as l’air d’un bon gars sur ta photo de profil, qu’est-ce qui t’a pris de t’agacer comme ça ?

Merci ☺️, mais comme tout le monde, je reçois des appels indésirables à titre personnel et encore plus quand on est indépendant. Donc je me suis lancé dans ce projet et c’était un défi pour moi, étant développeur web et pas mobile. J’ai voulu faire du natif avec Swift et Swift UI, pour faire une application légère et performante.

Au départ, je ne voulais faire l’application que pour iPhone mais j’ai reçu beaucoup de demandes pour la porter sur Android, ce que j’ai finit par faire au début du mois d’août. Cela m’a pris un peu plus de deux jours et demi de travail, tout en sachant que l’application Android est écrite dans un autre langage (Kotlin et Jetpack Compose). Après la publication le 15 août, elle a rencontré un succès assez rapide, avec déjà 5 000 installations.

Il y a très peu de paramètres, dans Saracroche. C’est limite frustrant pour des geeks. Il n’y a rien à ajouter ?

Mon but aussi est de proposer une application simple, pour le plus grand nombre avec peu de réglages en apparence. Je souhaite rajouter des fonctionnalités plus avancées, mais elles ne seront pas accessibles directement.

Je veux une UX réussie pour le plus grand nombre d’entre nous pas uniquement pour les geeks, car les appels et SMS indésirables sont un fléau et tout le monde doit pouvoir un moyen de s’en protéger. Proposer une interface de qualité par expérience, c’est du travail. Quand on est développeur, on a tendance à mettre toutes les fonctionnalités au même niveau mais il faut savoir hiérarchiser, avoir une vraie réflexion sur l’interface, se poser les bonnes questions, et se montrer empathique sur les besoins premiers des utilisateurs.

Ce que je souhaiterais rajouter :

- Une liste participative qui permettra de bloquer ou indiquer les appels indésirables de façon plus réactive.

- Bloquer les SMS.

- Proposer différentes listes avancés.

- L’adapter à l’étranger.

- Des options avancées (j’ai reçu des mails et tickets sur GitHub)

- Peut-être une version pour entreprise qui pourrait m’aider à rendre viable le projet sur long terme.

Il y a des choses que je vais pouvoir faire sur Android que je ne pourrais pas proposer sur iOS. Les deux plateformes sont très différentes sur leur gestion d’appels et SMS.

Je souhaite collaborer avec le service 33700. Je les ai contactés, mais malheureusement, je n’ai encore reçu aucune réponse.

L’app est disponible directement dans les magasins d’applications, pour iOS et Android, c’est bien ça ?

Oui, elle est disponible sur les plus gros stores. Elle est aussi disponible pour ceux sur Android via Obtainium et un jour sur F-Droid. Cela demande de faire une build reproductible. Je me suis penché dessus, mais cela va demander du temps.

Est-ce que tu as besoin d’un coup de main ? Pour traduire, soutenir, tester, c’est le moment de demander, on a un petit lectorat de libristes.

J’aurais besoin d’aide pour tester. Par exemple, en ce moment, je travaille sur une version iOS qui se met à jour en arrière-plan et iOS a un certain nombre de limitations, donc je souhaiterais avoir des retours sur le fonctionnement.

J’ai toujours besoin des signalements pour faire grossir la base de données et améliorer le blocage.

L’application est jeune, elle n’a que 5 mois sur iOS et même pas 1 mois sur Android, donc il y a encore beaucoup de travail, ne serait-ce que pour la traduire, rajouter des fonctionnalités… je n’en suis qu’au début !

Tu as prévu de développer d’autres applis d’utilité publique, ou bien ?

J’ai plusieurs idées, une application de recette couplée avec la base de données du Ciqual de l’ANSES pour aider à manger plus équilibré, moins de viande, et avoir le décompte des macronutriments. Une application pour aider les associations à gérer leurs membres avec un accent particulier sur l’expérience utilisateur.

J’ai toujours des idées, voire trop ! Mais Saracroche m’a donné encore plus envie de créer et d’être un contributeur open source.

Pour aller plus loin

Nous vous invitons à tester Saracroche, une app encore jeune, et à nous faire des retours dans les commentaires ou directement auprès de Camille via son site.

Saracroche n’a pas encore de notice dans Framalibre, notre annuaire de logiciels libres contributifs, je dis ça je dis rien.

22.09.2025 à 07:42

Khrys’presso du lundi 22 septembre 2025

Khrys

Texte intégral (10200 mots)

Comme chaque lundi, un coup d’œil dans le rétroviseur pour découvrir les informations que vous avez peut-être ratées la semaine dernière.

Tous les liens listés ci-dessous sont a priori accessibles librement. Si ce n’est pas le cas, pensez à activer votre bloqueur de javascript favori ou à passer en “mode lecture” (Firefox) ;-)

Brave New World

- TikTok : les États-Unis et la Chine s’entendent sur « un cadre pour un accord » (lemonde.fr)

- Là où la jeunesse fait vaciller le vieux monde (basta.media)

Dans plusieurs pays d’Asie, les jeunes se soulèvent. Après la révolution au Bangladesh l’an dernier, des mouvements ont lieu au Népal et en Indonésie. Des médias indépendants du monde entier s’intéressent à ces mobilisations.

- Israel killed 31 journalists in Yemen strike, press freedom group says (washingtonpost.com)

Last week’s attack was “the deadliest strike on journalists in the Middle East” documented by the Committee to Protect Journalists.

- When Africa’s internet breaks, this ship answers the call (restofworld.org)

Undersea internet cables are critical in today’s hyperconnected world. The crew of the Léon Thévenin maintains one stretch of this global network.

- COP30 : la trajectoire climatique européenne s’embourbe, la faute à la France qui trouble le jeu (humanite.fr)

À moins de deux mois du prochain sommet onusien sur le climat, les États membres de l’Union européenne sont incapables de se mettre d’accord sur un objectif clair de décarbonation, au risque de mettre en péril l’accord de Paris. Une situation provoquée par la France, qui cherche à remodeler l’objectif climatique 2040 de l’UE à sa guise.

- « L’Espagne compte aujourd’hui, 2,3 millions d’emplois de plus qu’avant la pandémie » : comment le gouvernement de gauche a redressé l’économie nationale (humanite.fr)

La nouvelle politique économique – fondée sur une importante expansion keynésienne, des augmentations salariales pour compenser l’inflation et la mise en place de nouveaux programmes de revenus minimums pour réduire les inégalités – a jeté les bases d’une croissance assez remarquable.

- Scammers using QR code stickers on parking meters to get at people’s bank accounts (nltimes.nl)

Paying with your smartphone has become commonplace, and scammers are finding new ways to exploit this. A new method on the rise in the Netherlands is sticking QR codes on parking meters, taking users to a spoofed website of the popular parking app EasyPark, where they have to enter their bank or credit card information.

- ProtectNotSurveil coalition raises alarm about EU’s Frontex expansion plans (edri.org)

The European Commission is set to reform Frontex’s mandate again in 2026. Frontex is the European Border and Coast Guard agency. […] the ProtectNotSurveil coalition highlights how reckless the expansion of Frontex’s surveillance capacities would be and how the Commission’s foreseen plans go in the opposite direction of what migrants and affected communities are calling for.

- Massive Attack Turns Concert Into Facial Recognition Surveillance Experiment (gadgetreview.com)

During their latest tour stop, Massive Attack shocked fans by integrating facial recognition into the show itself. Live video feeds captured audience faces, processing them through recognition software and projecting the results as part of the visual experience. […] This stunt aligns with the band’s decades-long critique of surveillance culture and digital control systems.

- Le logiciel, talon d’Achille du numérique « responsable » vaudois (https-vd.ch)

Le Conseil d’État vaudois a récemment répondu à une interpellation sur la durée de vie des équipements numériques utilisés par l’administration cantonale. Si cette réponse témoigne d’une volonté réelle de limiter l’empreinte environnementale du numérique public, elle laisse apparaître un angle mort préoccupant : le rôle central du logiciel dans l’obsolescence. […] Cette absence de critères empêche toute transition vers des systèmes d’exploitation libres, qui pourraient prolonger de plusieurs années la vie utile d’un appareil, et faciliter sa réutilisation par des tiers.

- Why Europe’s new tech laws have the world on edge (edri.org)

Trump and the global far-right are trying to discredit Europe’s tech laws with misinformation and political pressure, fearing that these regulations might disrupt their ability to undermine democracy. If Europe wants to safeguard its democracy and its credibility as a global regulatory leader in tech, the European Commission needs to enforce these laws swiftly and decisively.

- L’Irlande nomme une ancienne lobbyiste de Meta en tant que commissaire de sa CNIL (next.ink)

- Ballons JD Vance, sosies… Les manifestant·es anti Trump à Londres n’ont pas manqué de créativité (huffingtonpost.fr)

- Four arrested after photo of Trump and Jeffrey Epstein projected onto Windsor Castle (independent.co.uk)

- Channel 4 to mark Trump’s UK visit with ‘longest uninterrupted reel of untruths’ (theguardian.com)

More than 100 of Donald Trump’s inaccurate statements are to be dissected by Channel 4 to coincide with his state visit, in what it described as “the longest uninterrupted reel of untruths, falsehoods and distortions ever broadcast on television”.

- 170 milliards de dollars de pertes en six décennies : le coût du blocus étasunien pour Cuba (humanite.fr)

Lors de la présentation de son rapport annuel, le ministre des Affaires étrangères de l’île a fustigé une hausse de près de 50 % des dommages et préjudices subis par La Havane.

Voir aussi Cuba : comment Donald Trump a intensifié le blocus contre l’île (humanite.fr)

Avec leur politique « criminelle et inhumaine » de blocus visant Cuba basée sur « la misère, la faim et le désespoir », les États-Unis seraient responsables d’« une violation massive et systématique des droits humains », selon un dernier rapport diffusé par La Havane.

- Trump announces skilled worker visas will now cost $100,000 (theverge.com)

- Jimmy Kimmel viré, un signal de plus de l’effondrement de la liberté d’expression aux États-Unis (telerama.fr)

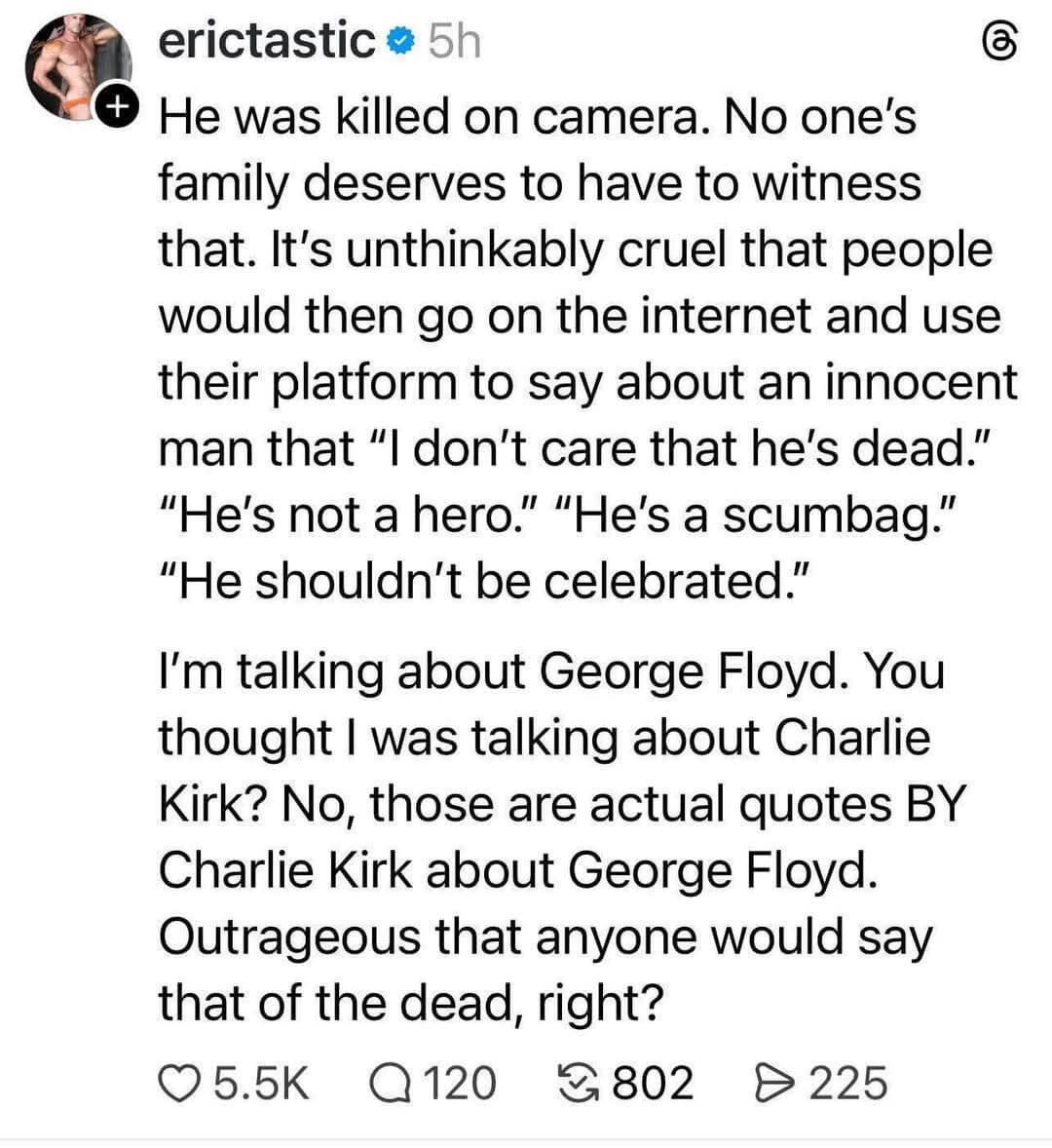

La star des talk-shows américains a été suspendue d’antenne par ABC après avoir critiqué la récupération de la mort de l’influenceur Charlie Kirk par le camp trumpiste. Après la fin du “Late Show” de Stephen Colbert, qui sera le prochain sur la liste ?

- The Scary Truth Behind Stephen Colbert’s Cancellation and Jimmy Kimmel’s Silencing (collider.com)

With Paramount, who owns CBS, wanting to merge with Skydance (which is led by Trump ally David Ellison), and the Federal Trade Commission (led by Trump appointee Brendan Carr) needing to sign off on the merger, many wondered if this would lead to Colbert, also a frequent critic of the former reality star-turned-President during his entire 10-year stint leading The Late Show, being fired.

- Donald Trump se dit « attaché à la liberté d’expression »… mais juge « illégal » que trop de médias le critiquent (huffingtonpost.fr)

Le président américain était interrogé sur l’éviction de Jimmy Kimmel sous la pression de son administration. Il a donné une définition très personnelle du « free speech ».

- Le Pentagone veut imposer aux journalistes son autorisation avant la publication d’une information (lemonde.fr)

Dans un message envoyé aux médias, le département de la défense américain menace de révoquer les accès au Pentagone si les correspondants ne se plient pas à cette règle.

- Aux États-Unis, le Sénat instaure une journée nationale de commémoration de Charlie Kirk (franceinfo.fr)

- DOJ Quietly Deletes Study on Politics of Domestic Terrorists (newrepublic.com)

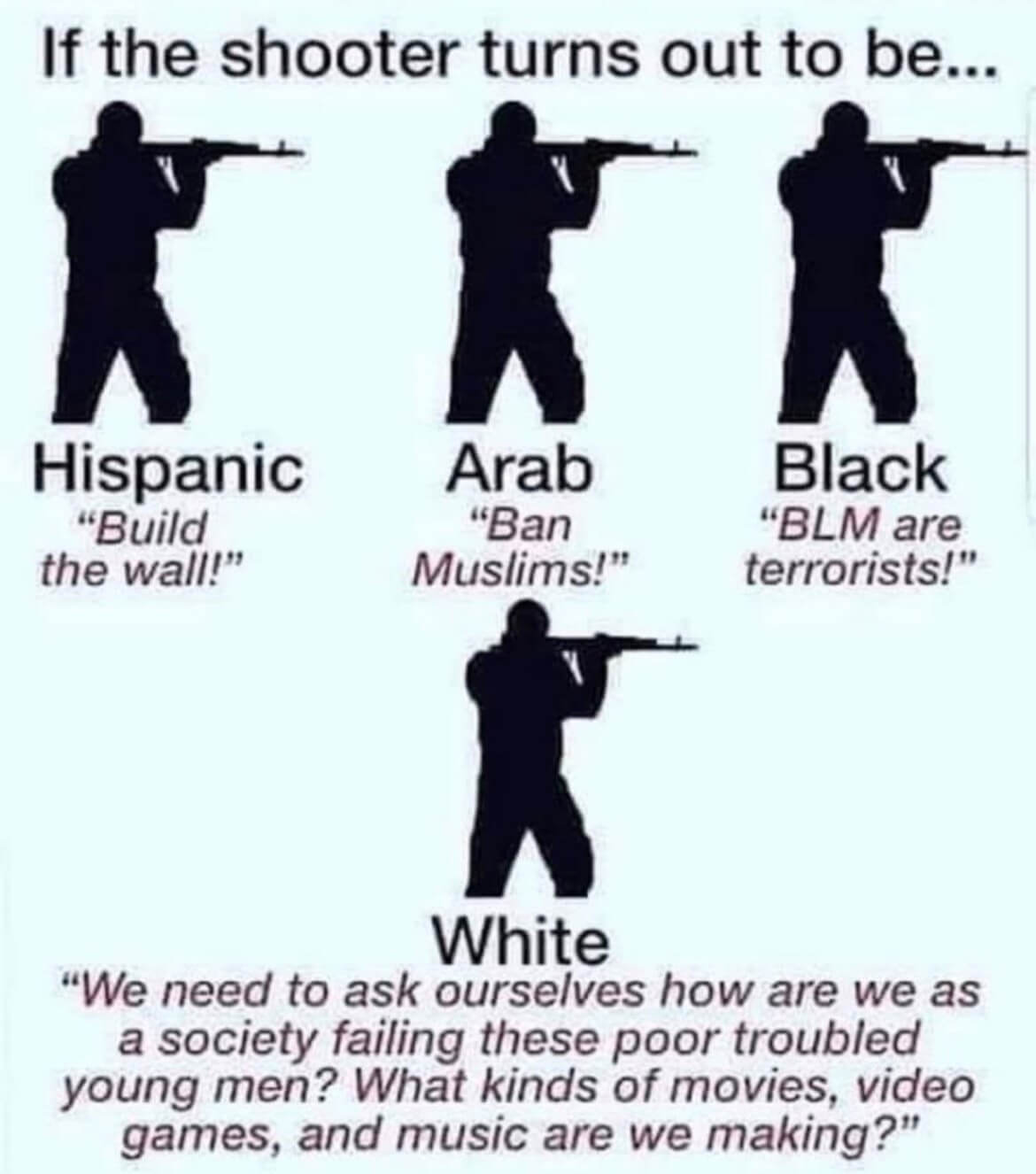

Trump’s Justice Department deleted a study from its website stating that right-wing violence “continues to outpace all other types of terrorism and domestic violent extremism” in the United States. This comes as the Trump administration and Republicans generally blame political violence solely on the left.

- Les purges menées par l’administration Trump et le mouvement MAGA après l’assassinat de Charlie Kirk : un premier bilan (legrandcontinent.eu)

- U.S. Press Freedom in Sharp Decline as Economic Pressures and Political Attacks Mount (mediabiasfactcheck.com)

The United States has fallen to 57th place in the 2025 RSF World Press Freedom Index, its lowest ranking in recent history, reflecting a deepening crisis for journalism in the country. Press freedom in the U.S. now faces unprecedented challenges—not only from political pressure but also from economic collapse within the media industry.

- Aux États-Unis, la police de l’immigration jette une candidate démocrate au sol… et est félicitée sur Fox News (huffingtonpost.fr)

Laura Ingraham, une présentatrice vedette de la chaîne, a salué le travail des agents de l’ICE après que l’un d’eux a poussé violemment la démocrate Kat Abughazaleh.

- Le président américain a désigné le mouvement « Antifa » comme organisation terroriste. (huffingtonpost.fr)

- After cuts to food stamps, Trump administration ends government’s annual report on hunger in America (mainichi.jp)

- RFK Jr.’s anti-vaccine panel realizes it has no idea what it’s doing, skips vote (arstechnica.com)

- Samsung brings ads to US fridges (theverge.com)

Samsung’s ‘screens everywhere’ initiative is morphing into ads everywhere.

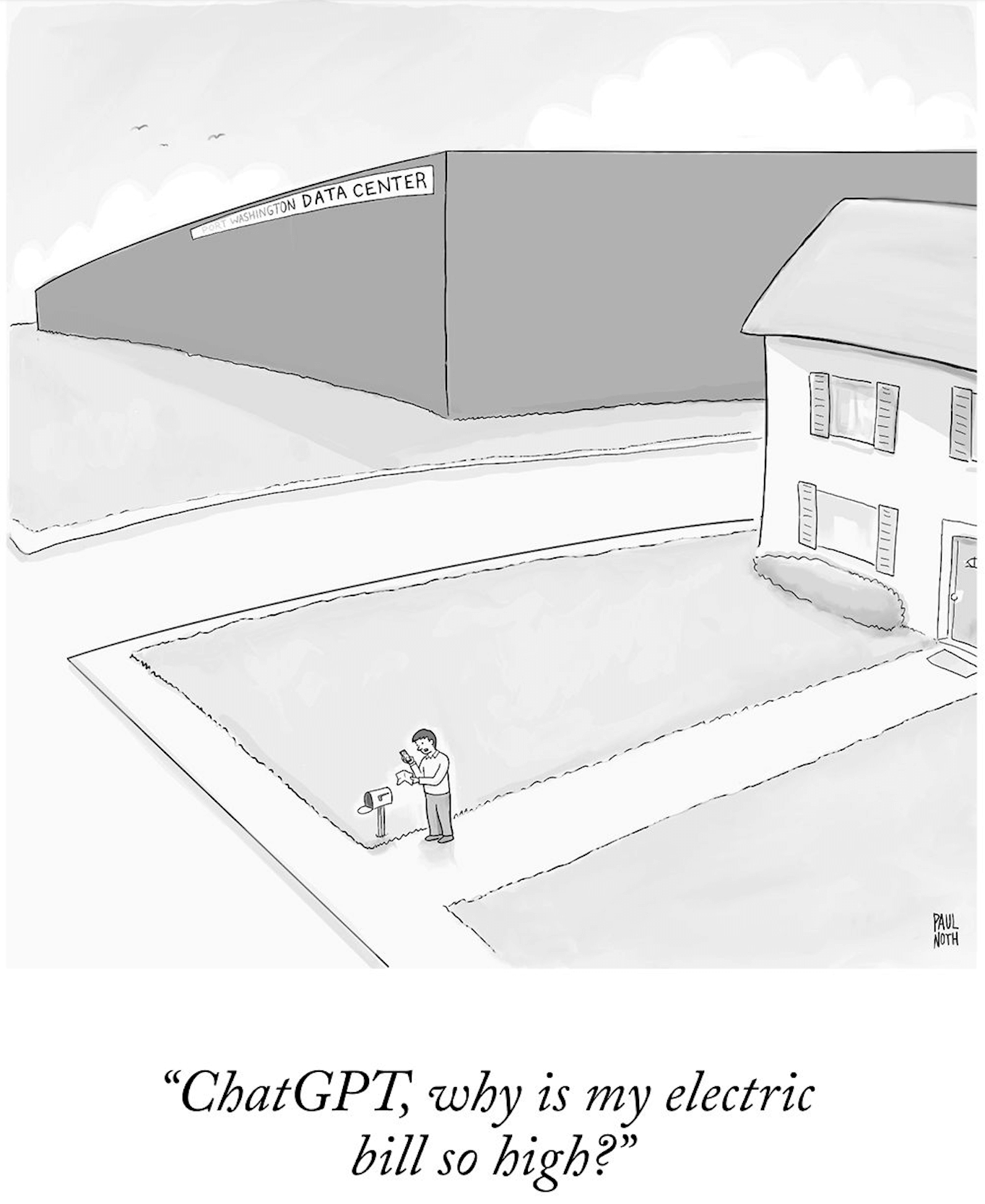

- Countries are struggling to meet the rising energy demands of data centers (restofworld.org)

Mexico’s lagging energy grid is forcing companies, including Microsoft, to use generators.

- Après la condamnation de Bolsonaro, le Brésil face aux forces réactionnaires (politis.fr)

L’ex-président a écopé de 27 ans de prison pour tentative de coup d’État. Un jugement historique pour le pays. Il ne met cependant pas fin aux assauts de l’extrême droite, qui compte notamment sur Trump pour sauver leur leader.

- « Un cas de racisme environnemental » : à l’approche de la COP30 à Belém, une favéla lutte pour accéder à l’eau potable (vert.eco)

- Chili : la Patagonie asphyxiée par ses saumons (politis.fr)

Le Chili est le deuxième producteur de ce poisson d’élevage au monde, après la Norvège, et la société civile exige une régulation de cette industrie jugée « écocidaire ». En juillet, l’ONG Oceana a alerté sur les risques pour l’environnement et l’humain que représente l’usage massif d’antibiotiques.

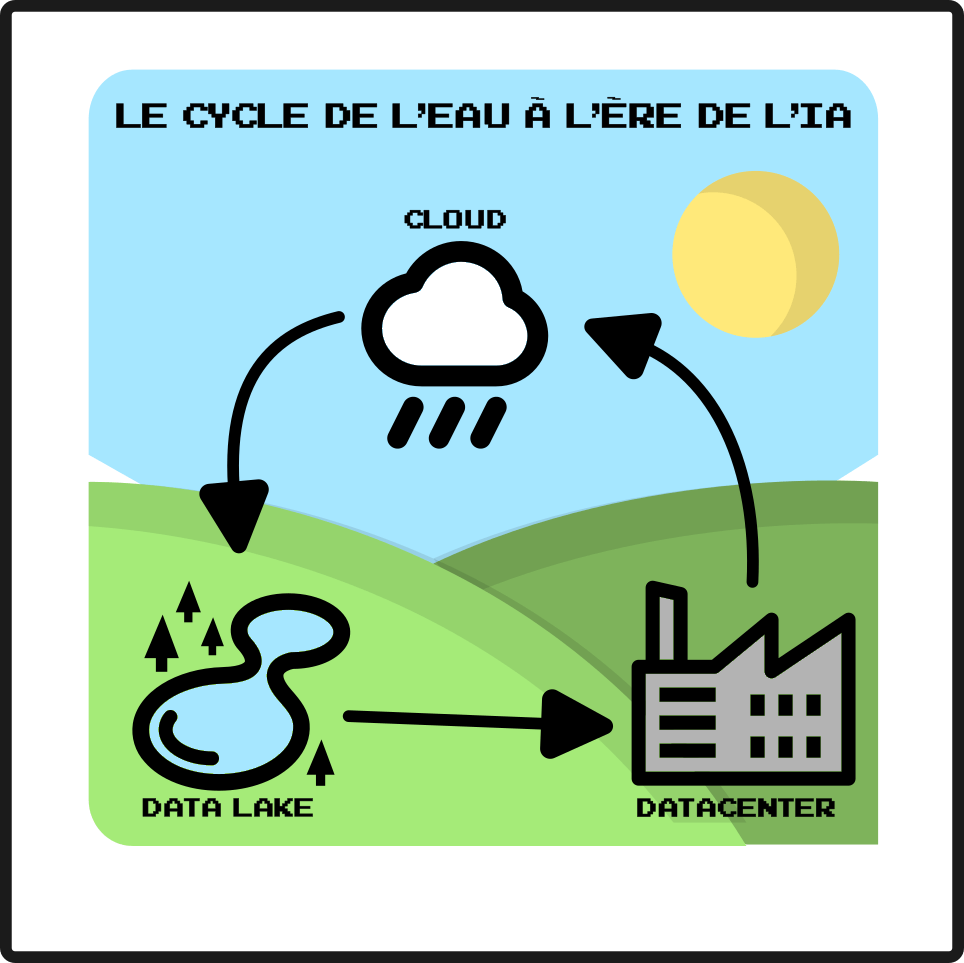

Spécial IA

- China’s DeepSeek says its hit AI model cost just $294,000 to train (reuters.com)

- DeepSeek AI’s code quality depends on who it’s for (and China’s opinion of them) (techspot.com)

- ChatGPT consomme autant d’énergie qu’une ville entière pendant trois jours (science-et-vie.com)

- Mark Zuckerberg n’a pas pu cacher son désarroi devant la présentation erratique de ses lunettes IA (huffingtonpost.fr) – voir aussi Quand l’IA ne veut pas (gros fail de Zuckerberg) (tube.fdn.fr)

- Microsoft, Nvidia, other tech giants plan over $40 billion of new AI investments in UK (cnbc.com)

- Microsoft is filling Teams with AI agents (theverge.com)

Dedicated Copilot agents will join meetings and answer questions in channels.

- Google stuffs Chrome full of AI features whether you like it or not (theregister.com)

- ChatGPT Will Guess Your Age and Might Require ID For Age Verification (yro.slashdot.org)

- OpenAI says models are programmed to make stuff up instead of admitting ignorance (go.theregister.com)

- Librarians Are Being Asked to Find AI-Hallucinated Books (404media.co)

patrons are growing more trusting of their preferred generative AI tool or product, and the veracity of the outputs they receive. […] librarians report being treated like robots over library reference chat, and patrons getting defensive over the veracity of recommendations they’ve received from an AI-powered chatbot. Essentially, like more people trust their preferred LLM over their human librarian.

- Science journalists find ChatGPT is bad at summarizing scientific papers (arstechnica.com)

LLM “tended to sacrifice accuracy for simplicity” when writing news briefs.

- Un rapport sur l’éducation appelant à une utilisation éthique de l’IA contient plus de 15 sources fictives (developpez.com)

- AI medical tools found to downplay symptoms of women, ethnic minorities (arstechnica.com)

Bias-reflecting LLMs lead to inferior medical advice for female, Black, and Asian patients.

- Épinglée pour la diffusion d’un visuel jugé raciste, la police nationale du Doubs le retire en catimini (lechni.info)

Une dame blanche, âgée, chic mais modeste, devant un distributeur, le regard perdu et qui semble supplier tout témoin de l’aider face à un danger imminent qu’elle ressent mais ne perçoit pas ; à un pas derrière elle, dans l’ombre, la fixant tel un charognard sur sa proie, surgit un homme, plus grand, jeune, cheveux crépus, le teint légèrement halé, portant un sweat à capuche. Cette scène n’est pas issue du dernier blockbuster identitaire, mais des réseaux sociaux de la « Police Nationale du Doubs ». Souhaitant alerter sur les dangers du « vol par ruse », l’institution n’a pas hésité à avoir recours à l’intelligence artificielle pour générer une iconographie qu’elle jugeait appropriée.

- Massive Attack remove music from Spotify to protest against CEO Daniel Ek’s investment in AI military (theguardian.com)

The band cited a ‘moral and ethical burden’ placed on artists by revenue from their work ultimately funding lethal technologies

- The Organic Academic Pledge (organicacademic.online)

We, the undersigned, pledge to never use generative AI for any part of our academic research.

- The Useful Idiots of AI Doomsaying (theatlantic.com)

Those who predict that superintelligence will destroy humanity serve the same interests as those who believe that it will solve all of our problems.

- Large Language Muddle (nplusonemag.com)

- Against the protection of stocking frames. (ethanmarcotte.com)

I think it’s long past time I start discussing “artificial intelligence” (“AI”) as a failed technology. Specifically, that large language models (LLMs) have repeatedly and consistently failed to demonstrate value to anyone other than their investors and shareholders. The technology is a failure, and I’d like to invite you to join me in treating it as such.

- About AI and Unlikelihood (superrr.net)

AI systems can by design only learn from the past – a past which is shaped by structures of colonialism, white supremacy and patriarchy. If AI is a machine of the past, then it is our craft to dream up futures not yet imagined. Artificial intelligence cannot, by design, do this ; what we need is the joy, wisdom and solidarity of real, messy, creative people.

Spécial Palestine et Israël

- Israeli tanks push into major Gaza City residential area (bbc.co.uk)

- The frantic race to protect historic treasures from Israeli bombs (bbc.co.uk)

- Ces Israélien·nes manifestent à la frontière avec Gaza pour dénoncer leur « pays qui tue tant de gens » (huffingtonpost.fr)

Des militant·es israélien·nes ont manifesté à la frontière avec la bande de Gaza alors que l’armée israélienne a prévenu qu’elle allait frapper Gaza-ville avec « une force sans précédent ».

- Israël, Eric Cantona prend position (football.fr)

« Quatre jours après le début de la guerre en Ukraine, la Fifa et l’UEFA ont suspendu la Russie. Nous en sommes maintenant à 716 jours de ce qu’Amnesty International a qualifié de génocide. Et pourtant, Israël continue d’être autorisé à participer. Pourquoi ces doubles standards ? »

- Aux Emmy Awards, Javier Bardem lance « Free Palestine » vêtu d’un keffieh (huffingtonpost.fr)

L’acteur espagnol a dénoncé « le génocide à Gaza » lors de la 77e édition des « Oscars de la télévision américaine » à Los Angeles.

- Massive Attack interdit la diffusion de sa musique en Israël et claque la porte de Spotify (liberation.fr)

Le légendaire groupe britannique a annoncé rejoindre l’initiative No Music for Genocide et bloque sa diffusion sur le territoire hébreu.

- “Pas de musique pour le génocide” : plus de 400 artistes et labels ne sont plus écoutables en Israël (telerama.fr)

Plusieurs centaines d’artistes internationaux dont Massive Attack, Fontaines D.C., Kneecap… ont rejoint le collectif No Music for Genocide, et appellent au boycott culturel de l’État hébreu.

- Comment les accusations de génocide à Gaza visant Israël ont pris une nouvelle dimension (huffingtonpost.fr)

Alors que les accusations de génocide à Gaza se multiplient ces derniers mois, une commission d’enquête de l’ONU a pour la première fois elle aussi qualifié la situation dans l’enclave palestinienne de génocide.

- Reconnaissance de la Palestine : le très politique revirement d’Emmanuel Macron (politis.fr)

Face à l’opinion publique et au génocide en cours à Gaza, le président se résout à prendre cette décision symbolique. À rebours de ses propres positions et de celles de ses ministres successifs.

- Drapeaux palestiniens sur les mairies : Retailleau veut les interdire, mais que dit vraiment la loi (huffingtonpost.fr) – voir aussi Drapeaux palestiniens : la nouvelle charge de Bruno Retailleau contre la solidarité avec Gaza (humanite.fr)

Le ministère de l’Intérieur a demandé aux préfets, dans un télégramme consulté vendredi 19 septembre par l’AFP, de s’opposer à la pose de drapeaux palestiniens sur des mairies et autres édifices publics lundi 22 septembre. Même le jour de la reconnaissance officielle par Emmanuel Macron de l’État de Palestine, la solidarité avec son peuple victime d’un génocide doit être interdite aux yeux de Bruno Retailleau.

- Marine Le Pen, Bruno Retailleau… En France, les derniers soutiens « inconditionnels » à Israël (humanite.fr)

De Marine Le Pen à Bruno Retailleau en passant par quelques élus macronistes, plusieurs responsables politiques continuent de fermer les yeux sur le génocide à Gaza et s’opposent fermement à la reconnaissance par la France d’un État palestinien.

- Depuis Gaza et Ramallah : « Macron parle de deux États tout en continuant d’armer Israël » (politis.fr)

La reconnaissance de leur État est un combat pour les Palestiniens depuis 77 ans. Lundi 22 septembre, à la tribune de l’ONU, la France, suivie par 17 autres pays dont le Royaume-Uni, va enfin franchir le pas.

- Nouveau veto américain pour protéger Israël, colère des 14 autres membres du Conseil de sécurité (france24.com)

- L’Espagne va coopérer activement avec la justice internationale pour enquêter sur des « violations des droits humains à Gaza » (humanite.fr)

La justice espagnole va collaborer avec la Cour internationale de justice et la Cour pénale internationale pour enquêter sur les crimes de guerre commis par Israël dans l’enclave palestinienne.

- Le Royaume-Uni, le Canada et l’Australie reconnaissent officiellement l’État de Palestine (huffingtonpost.fr)

Ces annonces interviennent à la veille d’un sommet important à New York, coprésidé par la France et l’Arabie saoudite, au sujet de l’avenir de la solution à deux États.

Spécial femmes dans le monde

- Tribune féministe internationale pour le boycott du Forum mondial des femmes pour la paix (contretemps.eu)

Les 19 et 20 septembre, un « Forum mondial des femmes pour la paix » se tenait à Essaouira (Maroc). En instrumentalisant le féminisme, il met sur le même plan la résistance palestinienne et l’armée coloniale, soit colonisé et colonisateur, participant ce faisant à normaliser l’État colonial d’Israël.

- Early dropoff in girls’ school sports linked to new gender confirmation forms (edmontonjournal.com)

‘Girls are taking a hard hit, while nothing is happening with the boys’

- ‘The New Age of Sexism’ explores how misogyny is replicated in AI and emerging tech (pbs.org)

- Marlène, millionnaire en quête de justice (radiofrance.fr)

Marlène Engelhorn a grandi dans une famille multimillionnaire à Vienne, en Autriche. Elle apprend à dissimuler le patrimoine que possède sa famille. Quand elle apprend qu’elle va hériter de plusieurs dizaines de millions d’euros, elle décide de redistribuer cet héritage via une assemblée citoyenne.

Spécial France

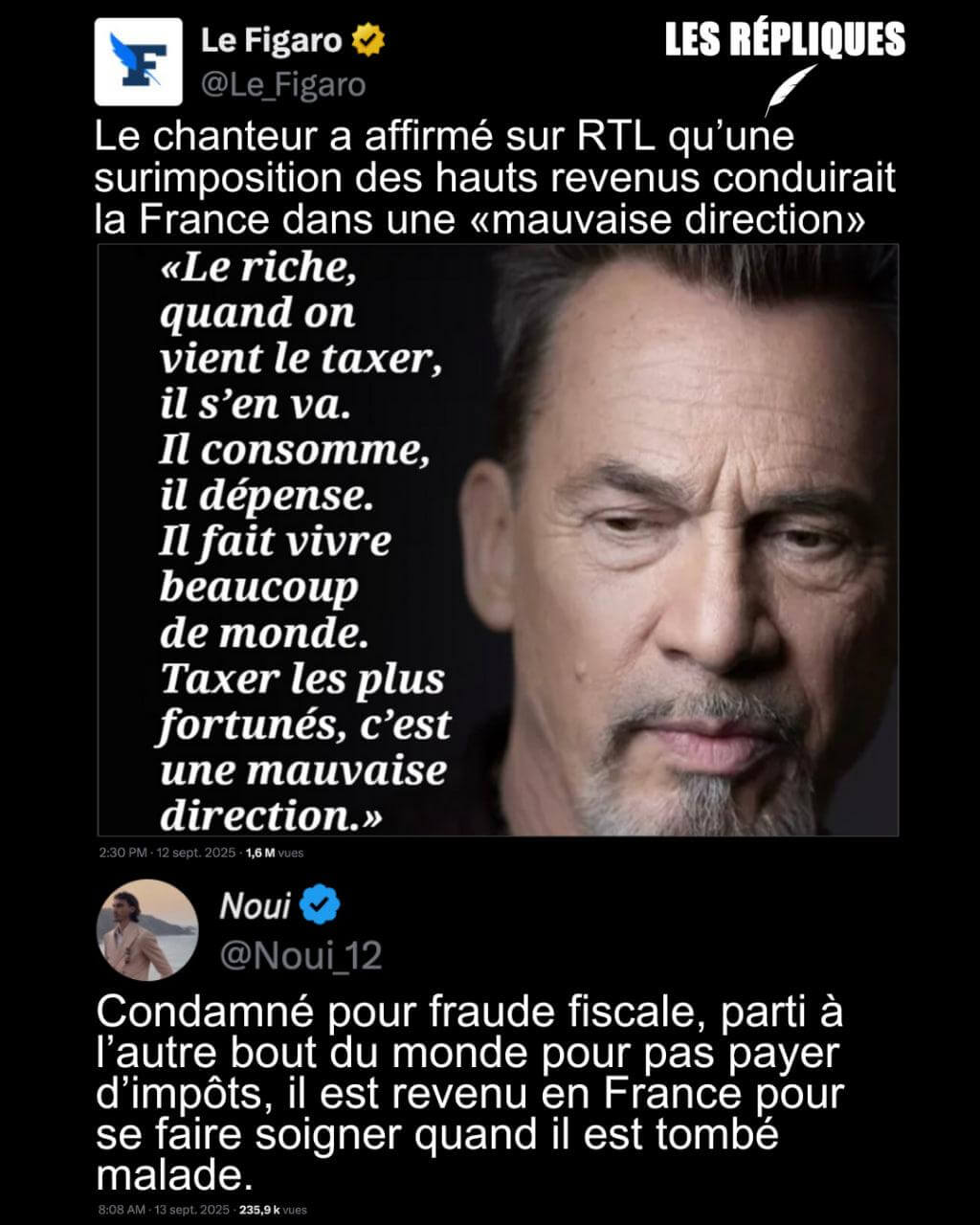

- Le gouverneur de la Banque de France favorable à des mesures sur les hauts patrimoines (lemonde.fr)

François Villeroy de Galhau en appelle […] à résoudre d’urgence un problème budgétaire « aggravé » par la crise politique. « On ne peut plus attendre, a-t-il déclaré, déplorant les querelles politiciennes ».« Pour citer un exemple, des mesures antioptimisation fiscale sur les hauts patrimoines seraient justifiées » afin que l’effort de redressement soit « ressenti comme juste »

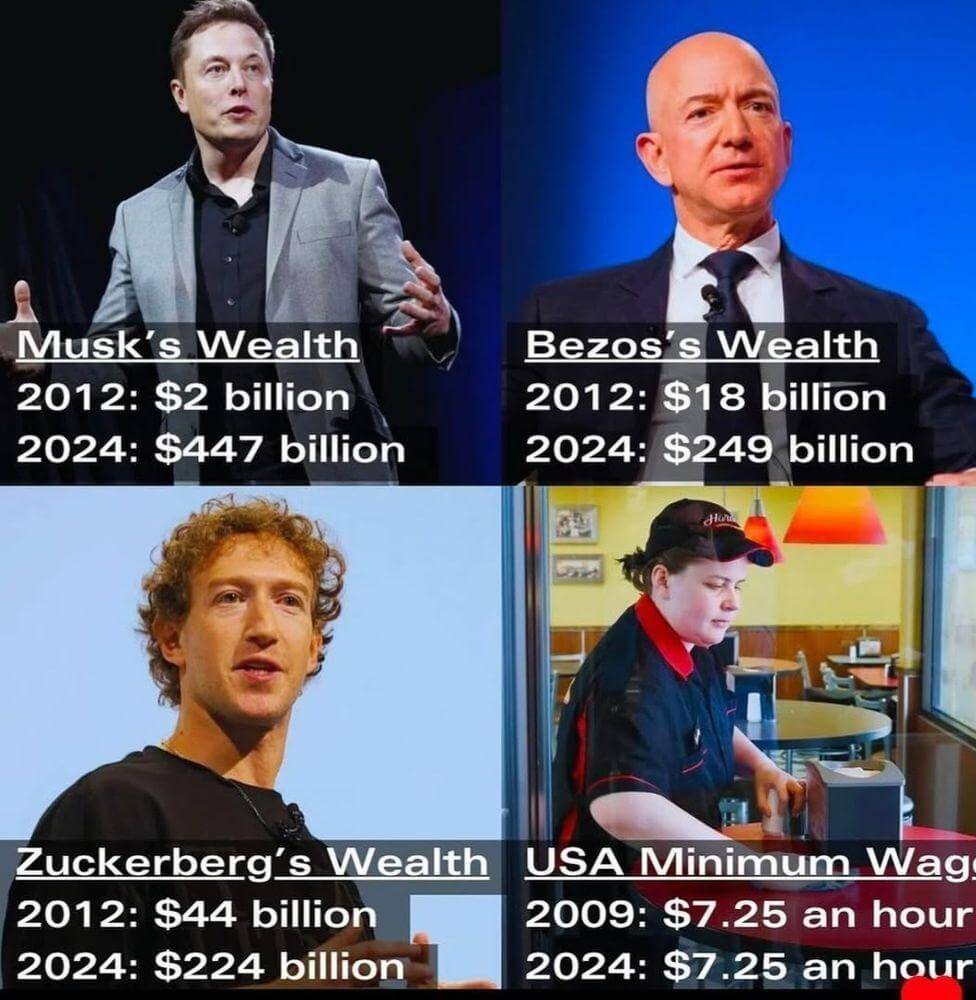

- Thomas Piketty : « Le combat pour la taxation des plus riches ne fait que commencer » (politis.fr)

- Taxe Zucman : panique à bord au Medef (politis.fr)

Alors que la taxe qui vise à taxer les patrimoines des ultra-riches, s’impose dans le débat public, le patronat monte de plus en plus violemment au front pour s’indigner de cette proposition. Signe d’une panique croissante.

- Stérin, visé par une enquête après son refus de comparaître devant les députés (projetarcadie.com)

- Pour Bernard Arnault, Gabriel Zucman est un « militant d’extrême gauche » qui vise « la destruction de l’économie libérale » (liberation.fr)

Chez ceux que sa taxe horrifie, certains disent qu’il invoque les sept plaies d’Egypte, d’autres que son pangolin domestique serait à l’origine du Covid-19, et certains prétendent même qu’il est l’architecte de l’Etoile de la mort. Gabriel Zucman est, aux yeux de Bernard Arnault, rien de moins qu’un « militant d’extrême gauche » dont l’objectif est « la destruction de l’économie libérale »

- Les tours de Notre-Dame de Paris rouvrent au public (france24.com)

Les tours de Notre-Dame de Paris seront de nouveau accessibles au public à partir de samedi dans le cadre des journées du patrimoine. Suspendu après l’incendie du 15 avril 2019, le parcours de la visite des tours a été totalement réorganisé et repensé avec à la clé l’une des plus belles vues de la capitale.

- Marche blanche pour rendre visibles les quatre victimes de meurtres homophobes retrouvées dans la Seine (humanite.fr)

Des centaines de personnes se sont réunies à Choisy-le-Roi (Val-de-Marne), ce 19 septembre, à l’appel de l’association Stop Homophobie, pour une marche blanche en hommage aux quatre victimes retrouvées dans la Seine le 13 août.

- La quasi-totalité de l’autorité environnementale d’Île-de-France démissionne (reporterre.net)

- Polytechnique, une école d’État sous emprise (multinationales.org)

Organes de gouvernance, chaires, partenariats, start-ups, associations d’élèves et d’anciens élèves… La place croissante des grandes entreprises à tous les niveaux de l’École polytechnique et leur influence sur le contenu de la recherche et de l’enseignement posent question dans un contexte d’urgence climatique.

- Cocktails et petits fours : quand Total, Nestlé et Danone financent les soirées étudiantes d’AgroParisTech (reporterre.net)

- PestiRiv : résultats de l’étude nationale sur l’exposition aux pesticides des riverains de zones viticoles (anses.fr)

Les résultats de l’étude montrent que les riverains des zones viticoles sont plus exposés aux produits phytopharmaceutiques appliqués sur ces cultures que les personnes éloignées de toute culture. Ces expositions sont par ailleurs plus importantes en période de traitement.

Voir aussi “Cette agriculture tue les gens” : l’étude PestiRiv révèle ses résultats, les riverains des vignes surexposés aux pesticides (france3-regions.franceinfo.fr)

Ce lundi 15 septembre étaient publiés les résultats très attendus de l’étude PestiRiv, portant sur l’exposition aux pesticides des populations situées à proximité des zones viticoles. Sans surprise, les riverains y sont fortement imprégnés de produits phytosanitaires et pose ainsi des questions de santé publique.

- A69 : des travaux assourdissants 18 heures par jour (reporterre.net)

Explosions, poussières… Depuis la reprise du chantier de l’A69, les riverains du tracé sont accablés par les nuisances. Le concessionnaire met les bouchées doubles pour combler son retard avant une audience décisive au tribunal.

- Le projet touristique porté par Tony Parker dans le Vercors est rejeté au motif des incertitudes sur l’impact environnemental (lemonde.fr)

Spécial femmes en France

- L’austérité budgétaire est sexiste (solidaires.org)

- Le cyberharcèlement frappe de plus en plus tôt et surtout les femmes (politis.fr)

Insultes, menaces, humiliations… Les études révèlent l’ampleur du cyberharcèlement en France qui débute dès l’école primaire et dont les conséquences psychologiques peuvent être dramatiques, allant jusqu’au suicide.

- « Pour lutter contre les cyberviolences, il faut combattre le sexisme hors-ligne » (politis.fr)

Comment lutter contre les violences sexistes en ligne ? Présidente du Collectif féministe contre le cyberharcèlement, Laure Salmona esquisse plusieurs pistes.

- Typhaine D : quand la justice décortique la violence masculine en ligne (politis.fr)

Neuf hommes ont été jugés, ce 17 septembre, par la 17e chambre du tribunal correctionnel de Paris, après une vague de cyberharcèlement subie par l’artiste Typhaine D. […] Qui aurait pu penser que l’écriture inclusive pouvait mener au tribunal ? Sûrement pas l’artiste Typhaine D. « Au bucher ! Sorcière ! », « Il faut la piquer », « Je déboiterai bien une bonne féministe », « Sale pute de Femen, le seul mot féminin que tu dois connaitre c’est ‘cuisine’ » (sic)… Des messages comme ceux-là, Typhaine D en a reçu des milliers en juillet 2022, après avoir participé à une émission du Crayon.

- Après le suicide de Caroline Grandjean, sa veuve Christine porte plainte contre l’Éducation nationale (huffingtonpost.fr)

Victime de harcèlement homophobe répété, l’institutrice à bout s’était donné la mort après avoir répertorié tout ce qu’elle subissait dans son village du Cantal.

- 83 % des affaires de violences sexuelles classées sans suite : le Conseil de l’Europe alarmé par l’impunité en France (nouvelobs.com)

- Après le féminicide d’Inès Mecellem à Poitiers, Gérald Darmanin a saisi l’Inspection générale de la justice (huffingtonpost.fr)

« Toute la lumière doit être faite sur cette horrible affaire », a déclaré le ministre de l’Intérieur, alors que la victime avait déposé plusieurs plaintes contre son ex-compagnon.

- Plaidoyer pour une médiatisation féministe pour contrer la propagande christofasciste (blogs.mediapart.fr)

Spécial médias et pouvoir

- Charlie Kirk et Charlie Hebdo : émoi à France Culture après un billet “du malaise et de la confusion” (telerama.fr)

Dans ce billet initialement titré « Je suis Charlie Kirk » et diffusé le 12 septembre, Guillaume Erner estimait qu’« il y a (vait) désormais au moins deux Charlie : le “Je suis Charlie” de Charlie Hebdo et puis “Je suis Charlie” de Charlie Kirk ».

- Delphine Ernotte monte au créneau contre CNews : “Qu’ils assument d’être une chaîne d’extrême droite !” (telerama.fr)

Dans un entretien au “Monde” ce jeudi 18 septembre, la présidente de France Télévisions défend vigoureusement l’audiovisuel public contre les offensives répétées des médias de l’empire Bolloré.

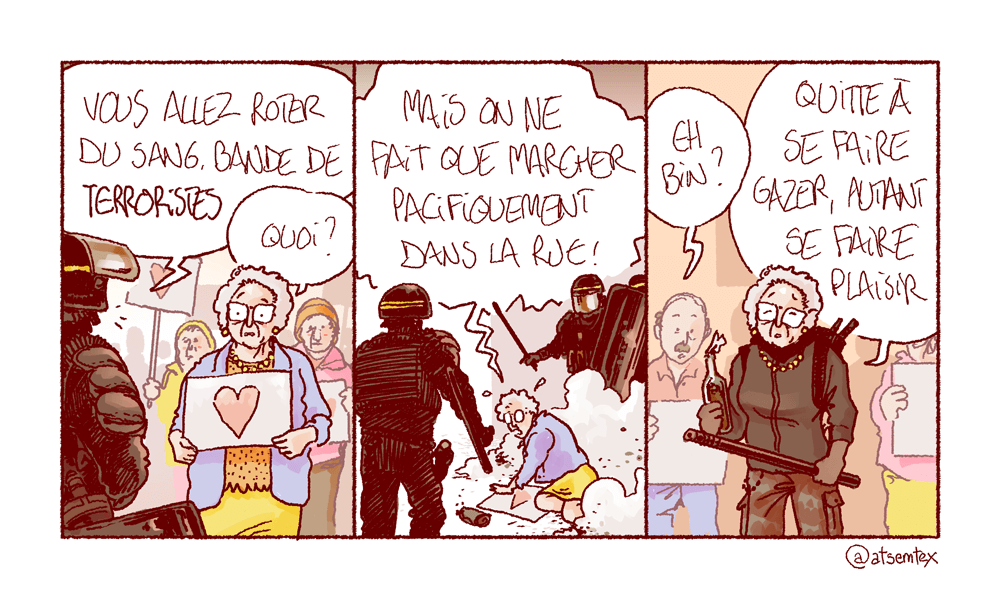

- « Bloquons tout » : un journalisme sous escorte policière (acrimed.org)

L’angle sécuritaire a largement dominé le traitement médiatique du mouvement social « Bloquons-tout », organisé partout en France le 10 septembre. Défilé de policiers sur les plateaux télé, focalisation sur les « violences », décompte en direct sur les chaînes d’information en continu du nombre d’interpellations : retour sur un cas d’école de journalisme de préfecture.

- « Bloquons tout » du 10 septembre sur CNews : haine, désinformation et carton d’audience (politis.fr)

Le 10 septembre, comme d’habitude, le moindre feu de poubelle a tenu en haleine tous les éditorialistes de chaînes d’info. Sur l’extrême droitière CNews, les grévistes n’étaient plus des Français·es lambda aux revendications légitimes, mais des gauchistes-LFIstes « palestinistes ».

- Pourquoi on ne voit que des gens aisés à la télé (frustrationmagazine.fr)

ce n’est pas seulement quand il s’agit d’information : en fait, tous les programmes télévisés sur-représentent les catégories aisées et diplômés. Et c’est… de pire en pire, nous confirme le rapport annuel de l’Arcom (ex-CSA)

- Prétention à l’objectivité du journalisme français : ça suffit ! (frustrationmagazine.fr)

Le journalisme français s’est bâti sur ce mythe : celui d’une objectivité quasi scientifique. Le journaliste, dit-on, « relate les faits », sans parti pris. Cette fiction, héritée de l’universalisme républicain, est brandie comme un étendard de professionnalisme. Mais comme l’ont montré par exemple les sociologues Pierre Bourdieu et Patrick Champagne, cette neutralité est un masque. Les journalistes politiques évoluent dans les mêmes cercles que les élus, fréquentent les mêmes grandes écoles, partagent les mêmes habitus bourgeois et parisiens. Ce n’est pas de l’objectivité : c’est un point de vue situé, celui d’une classe sociale dominante qui a réussi à imposer son regard comme « neutre ».

Spécial emmerdeurs irresponsables gérant comme des pieds (et à la néolibérale)

- La main dans le sac. Sébastien Lecornu n’est pas diplômé d’un master de droit, contrairement à ce qu’il prétendait (liberation.fr)

« Mediapart » révèle ce vendredi 19 septembre que le Premier ministre a « manipulé la réalité » en se présentant comme titulaire d’un diplôme qu’il n’a jamais obtenu.

Voir aussi Sébastien Lecornu : Le Premier ministre reconnaît ne pas avoir fini le cursus mentionné sur son CV (20minutes.fr)

Le journal [Mediapart] rappelle que ce genre de mensonge a poussé à la démission Noelia Núñez, députée espagnole. Elle avait assuré être diplômée en droit, en administration publique et en philologie anglaise avant d’admettre avoir entamé des études sans jamais les avoir finies. « Un diplôme en droit n’est pas indispensable pour représenter les citoyens ; l’honnêteté l’est », affirmait un édito d’El Pais, cité par le journal d’investigation français.

- “Mission État efficace” : Sébastien Lecornu nomme deux fonctionnaires chargés de supprimer des structures publiques (franceinfo.fr)

- Sébastien Lecornu supprime la délégation en charge du SNU en attendant « la création prochaine » d’un « service militaire volontaire » (liberation.fr)

Le nouveau Premier ministre a annoncé vendredi 19 septembre, qu’il entendait supprimer, au nom d’un Etat « efficace », plusieurs structures et délégations interministérielles, dont celle en charge du service national universel (SNU).

- Brevet 2026 : “les 2011 on est vraiment maudits”, les élèves de collège perdus face à la réforme qui les touche (france3-regions.franceinfo.fr)

Les collégiens multiplient les messages d’incompréhension et d’inquiétude face aux changements du diplôme national du brevet. Entre nouvelle notation, poids renforcé des épreuves finales et épreuves de mathématiques sans calculatrice, la réforme fait réagir aussi bien les élèves que les parents.

- Qui est Thierry Breton, le patron le plus incompétent de France ? (frustrationmagazine.fr)

- Pourquoi la Cour des comptes s’oppose à la gratuité des trams, métros et bus (lefigaro.fr)

- Inaction écologique : même la Cour des comptes tacle l’État (reporterre.net)

Spécial recul des droits et libertés, violences policières, montée de l’extrême-droite…

- De la dette publique à la lutte contre la démocratie : une stratégie néolibérale (politis.fr)

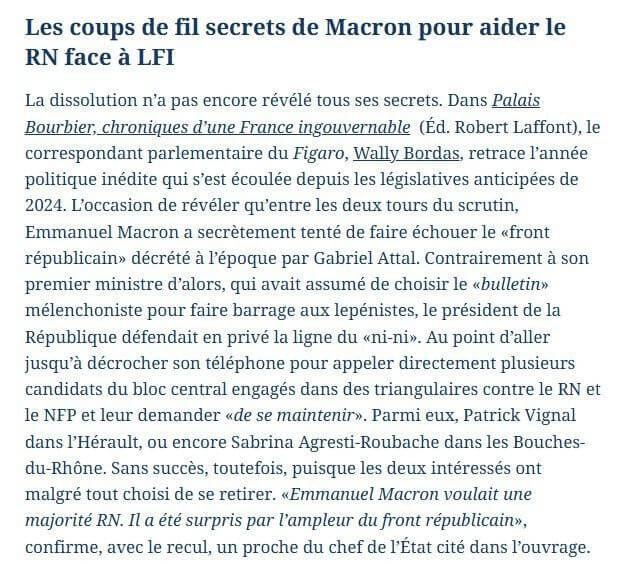

Pour les néolibéraux – qu’ils soient globalistes comme Emmanuel Macron ou nationalistes comme le RN –, la démocratie comme régime fondé sur le principe d’égalité doit être nécessairement limitée.

- Une étude d’ampleur sur l’islamophobie révèle l’angoisse des musulman·es en France (politis.fr)

Mené par l’Ifop et la Grande mosquée de Paris, ce travail montre l’étendue du racisme subi par les musulman·es en France au quotidien, au travail, dans l’Éducation, par les forces de l’ordre ou dans les services publics.

- Éric Zemmour définitivement condamné pour des propos racistes en 2019 (franceinfo.fr) – voir aussi Racisme : Éric Zemmour condamné pour la deuxième fois en deux semaines (humanite.fr)

La cour de cassation a rejeté, mardi, le pourvoi d’Éric Zemmour qui est donc définitivement condamné pour provocation à la haine raciale et injure à caractère raciste. En cause, des propos tenus en 2019 à la Convention de la droite.

- Un journaliste blessé dans une manif à Lyon, ses collègues de France TV mettent en cause les « forces de l’ordre » (huffingtonpost.fr)

Deux policiers ont par ailleurs été blessés, dont l’un a « perdu une dent » à la suite d’un jet de projectile, selon la préfecture.

- À Marseille, une enquête ouverte après la vidéo d’une femme violentée par la police le 18 septembre (huffingtonpost.fr)

- 10 septembre : taser et coups de pied servis par la Brav dans un restaurant parisien (streetpress.com)

Le 10 septembre, au soir du mouvement « Bloquons tout », des policiers ont débarqué dans l’enseigne « Chez Papa » dans le 19e arrondissement de Paris. Six personnes témoignent de la violence de leur intervention, où des coups de taser ont été donnés.« C’était en mode Gestapo, ça frappait à gauche et à droite des gens, aléatoirement »

- Grève du 18 septembre : qu’est-ce que le Centaure, le véhicule blindé de la gendarmerie déployé pour faire face aux manifestations ? (franceinfo.fr)

Spécial résistances

- Sous les lacrymos, une soif de justice sociale (politis.fr)

Alors que ce 18 septembre marque la seconde étape d’un mouvement social qui grossit, le pouvoir politique comme économique pèse de tout son poids pour tenter d’éteindre une colère qui ne demande qu’à le déborder.

- Politis en direct des manifestations (politis.fr)

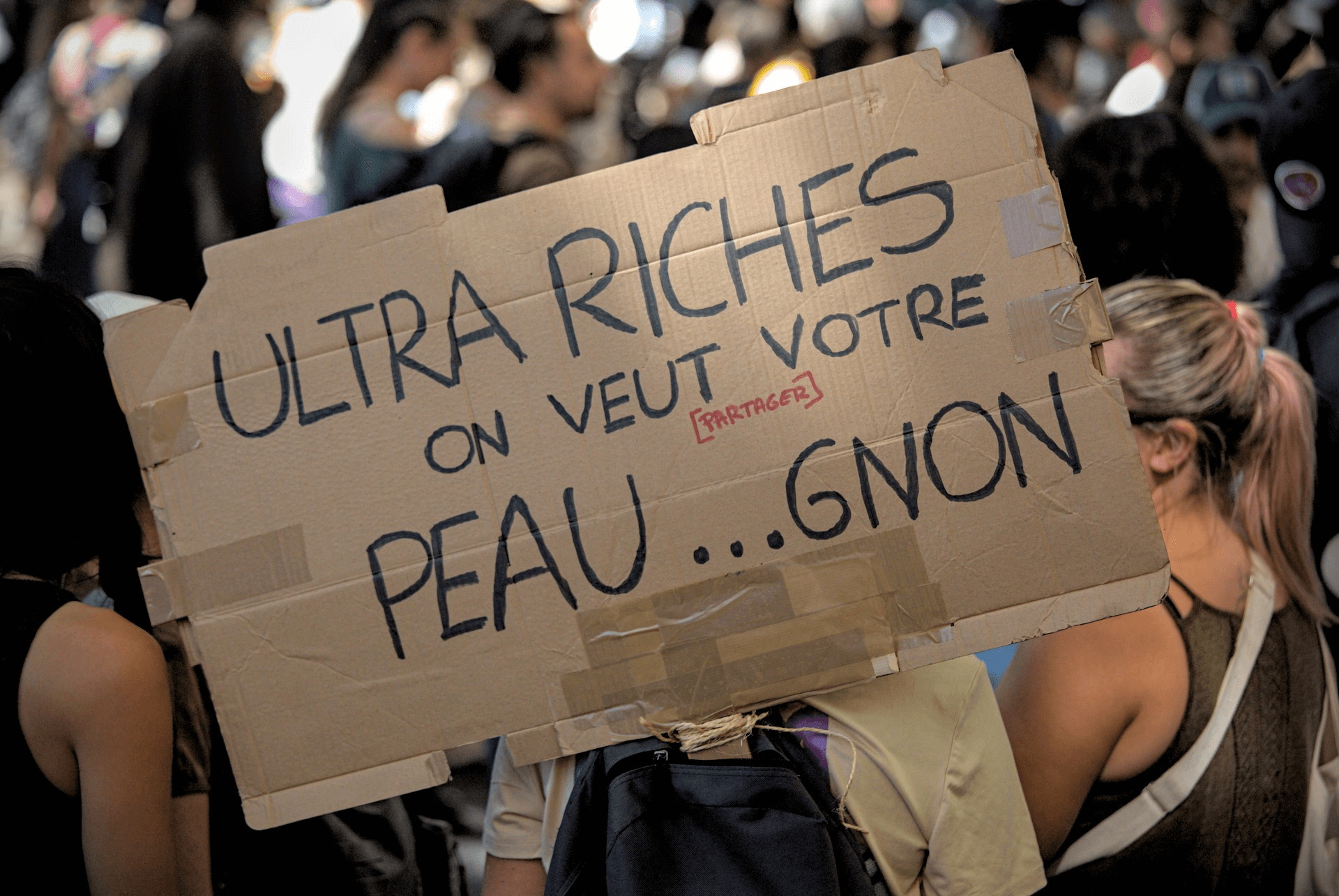

1 million de manifestant·es, selon la CGT. Tous les signaux étaient au vert, ce matin, pour une journée de mobilisation massivement suivie. Les promesses ont été tenues. Et le message envoyé à Emmanuel Macron, explicite : la fin de sa politique et du monde d’ultrariches dont elle sert les intérêts. Quelle sera la suite ?

- Pour la manifestation du 18 septembre, des cheminots en grève envahissent le ministère de l’Économie (huffingtonpost.fr)

L’action s’est tenue après une Assemblée générale organisée à la Gare de Lyon, située à quelques minutes.

- “Bloquons Tout” : c’est quoi “l’opération canard” qui a semé le bazar sur les boulevards à Toulouse ? (actu.fr)

“Opération canard”. C’est le nom de code d’une action menée ce samedi 13 septembre 2025 à Toulouse, dans le cadre du mouvement “Bloquons tout”. Et cela a semé une belle pagaille.[…]Le principe de ladite opération ? « Marcher à l’infini sur les passages piétons pour bloquer de fait la circulation »

- « Opération canard », « cortège vélorutionnaire » : c’est quoi ces actions vues aux mobilisations du 10 et du 18 septembre ? (leparisien.fr)

Des actions non violentes ont eu lieu lors des mobilisations du 10 et 18 septembre. Elles consistaient principalement à ralentir la circulation dans plusieurs villes françaises.

- « Ni ultimatum, ni pause » : organisons des AGs partout pour préparer la suite ! Billet d’Anasse Kazib (revolutionpermanente.fr)

Le mouvement doit se poursuivre et se doter d’un véritable plan de bataille pour faire tomber Lecornu et Macron.

- 24 septembre : l’intersyndicale lance un ultimatum au Premier ministre (rapportsdeforce.fr) – voir aussi Sébastien Lecornu répond à l’ultimatum des syndicats et leur propose une date de rencontre à Matignon (huffingtonpost.fr)

Le Premier ministre, arrivé en poste depuis peu, est attendu au tournant par l’intersyndicale, qui le menace d’une « nouvelle journée de grève ».

- Grêver est une joie pure ! (rogueesr.fr)

- À Bure, « la manif du futur » dénonce le projet Cigéo d’enfouissement de déchets nucléaires (huffingtonpost.fr)

Des centaines de personnes ont manifesté dans la Meuse, sous haute surveillance policière, contre le projet Cigéo d’enfouissement des déchets nucléaires hautement radioactifs.

Spécial outils de résistance

- Signer les pétitions : Pour une fiscalité juste : soutenons la taxe Zucman ! (petitions.assemblee-nationale.fr) et Pour une contribution équitable des ultra-riches et des grandes entreprises au financement des services publics (petitions.assemblee-nationale.fr)

- Imposition des ultrariches : au secours, les riches vont partir ! (basta.media)

Les gouvernements successifs agitent la peur de l’exil des ultra-riches pour ne pas trop les imposer. En s’appuyant sur des études, l’organisation Attac montre que les départs sont peu nombreux et défend une réforme de l’imposition des plus fortunés.

- 3 applis pour le 18 septembre et après (laquadrature.net)

- Vous avez été victime ou témoin de violences policières ? Partagez-nous votre témoignage (soscisurvey.de)

Ce questionnaire ANONYME et confidentiel a pour objectif de recenser les violences policières perpétrées pendant les journées de mobilisation. Il s’agit d’une initiative citoyenne menée par un collectif formé lors du mouvement “Bloquons tout”.

Spécial GAFAM et cie

- La taxe sur le numérique dans les clous de la Constitution (zdnet.fr)

La taxe GAFA française agace les États-Unis de Trump, mais aussi l’Européen Axel Springer qui l’attaquait devant le Conseil constitutionnel via sa filiale Digital Classifieds France. Le recours est écarté par les Sages.

- Google Secretly Handed ICE Data About Pro-Palestine Student Activist (theintercept.com)

Google handed over Gmail account information to ICE before notifying the student or giving him an opportunity to challenge the subpoena.

- This Microsoft Entra ID Vulnerability Could Have Been Catastrophic (wired.com)

A pair of flaws in Microsoft’s Entra ID identity and access management system could have allowed an attacker to gain access to virtually all Azure customer accounts.

- Boycott Microsoft (bdsmovement.net)

Microsoft is perhaps the most complicit tech company in Israel’s illegal apartheid regime and ongoing genocide against 2.3 million Palestinians in Gaza. Microsoft’s complicity in Israel’s apartheid and genocide is well documented, exposing its strong ties to the Israeli military, its collaboration with Israeli government ministries, and its involvement in the Israeli prison system, which is notorious for systematic torture and abuse of Palestinians. Microsoft knowingly provides Israel with technology, including artificial intelligence (AI), that is deployed to facilitate grave human rights violations, war crimes, crimes against humanity (including apartheid), as well as genocide.

- Un ancien fonctionnaire devient lobbyiste pour TikTok (projetarcadie.com)

Les autres lectures de la semaine

- Qui est responsable si un bot enregistre une réunion sans consentement ? (frenchweb.fr)

- « Les sciences sociales se sont construites comme un système de pouvoir ». Entretien avec Sonia Dayan-Herzbrun (contretemps.eu)

- 1st vs. 118th : On Gender Equality, Japan and Iceland Took Different Roads (unseen-japan.com)

Earlier this year, Japan’s Emperor Naruhito asked Iceland’s president why Iceland leads the world in gender equality. The question highlighted a striking contrast between the two nations. Iceland has held the top spot in the Global Gender Gap Report for years, while Japan ranks near the bottom.

- Depuis les soulèvements Indonésiens (lundi.am)

- L’incroyable histoire de la révolution haïtienne (frustrationmagazine.fr)

Alors qu’une guerre génocidaire à Gaza fait rage, et qu’en France un mouvement populaire renoue avec des aspirations révolutionnaires, certaines histoires trouvent un écho particulier. C’est le cas de la révolution haïtienne (1791-1804), la première révolution d’esclaves à avoir abouti, et qui, pour se faire, a tenu en respect, pendant plus de dix ans, des ennemis bien supérieurs en nombre et en armements

- Les chimpanzés consomment l’équivalent d’une « pinte de bière » par jour dans la nature, révèle une étude (huffingtonpost.fr)

- Ces livres qui brisent le « silence nucléaire » (reporterre.net)

RIP

- Robert Redford, icône du cinéma américain, est mort à 89 ans (france24.com)

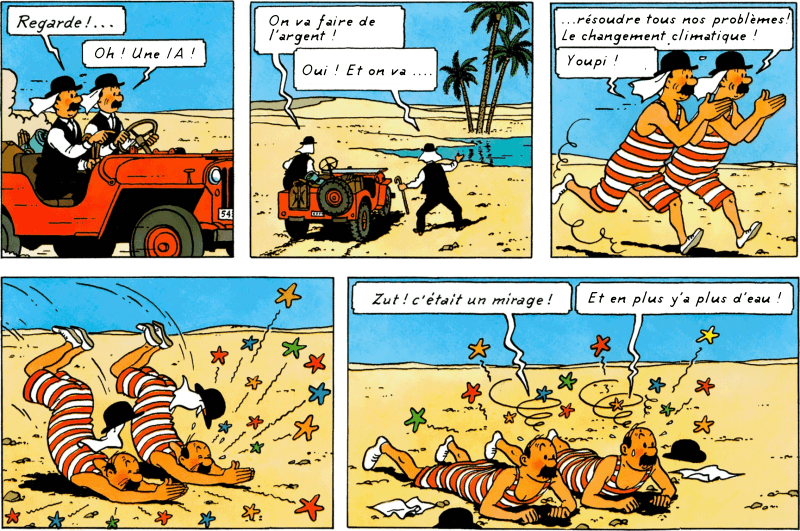

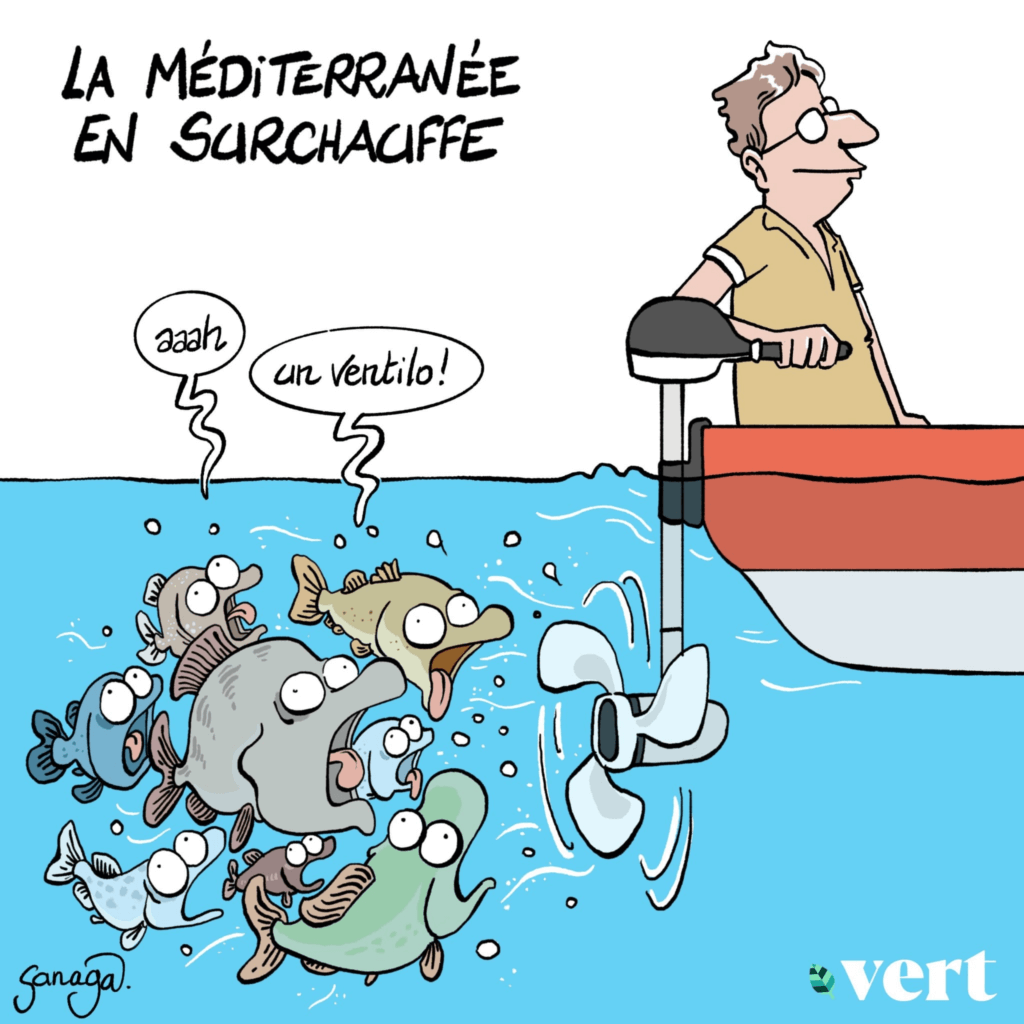

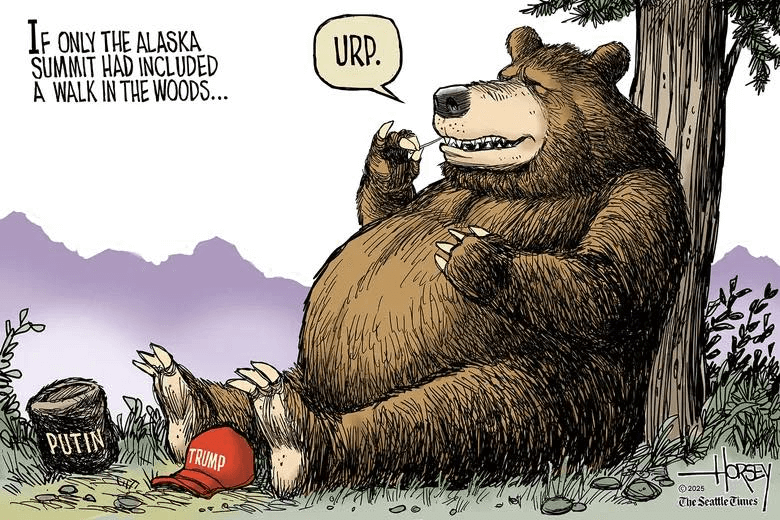

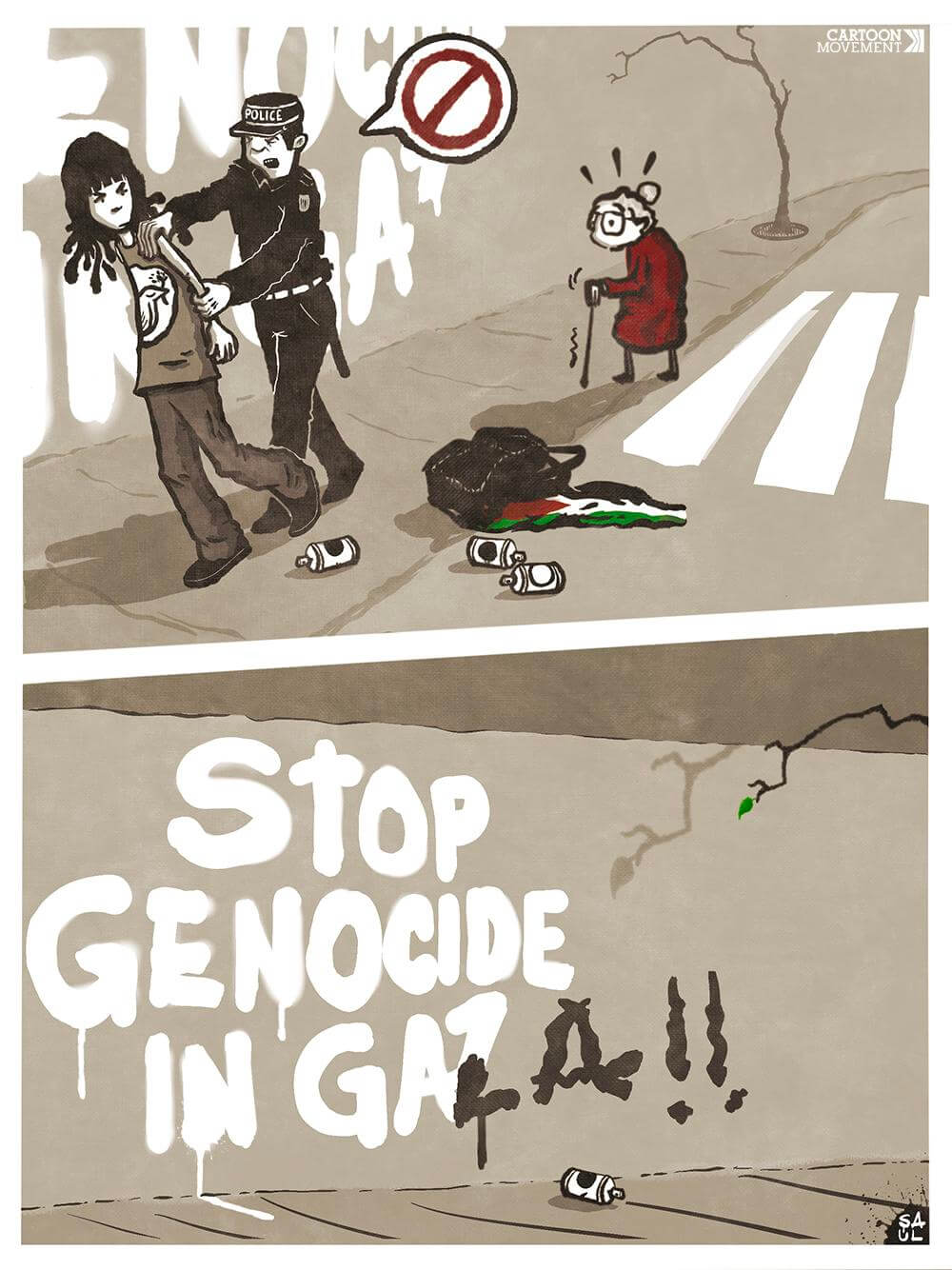

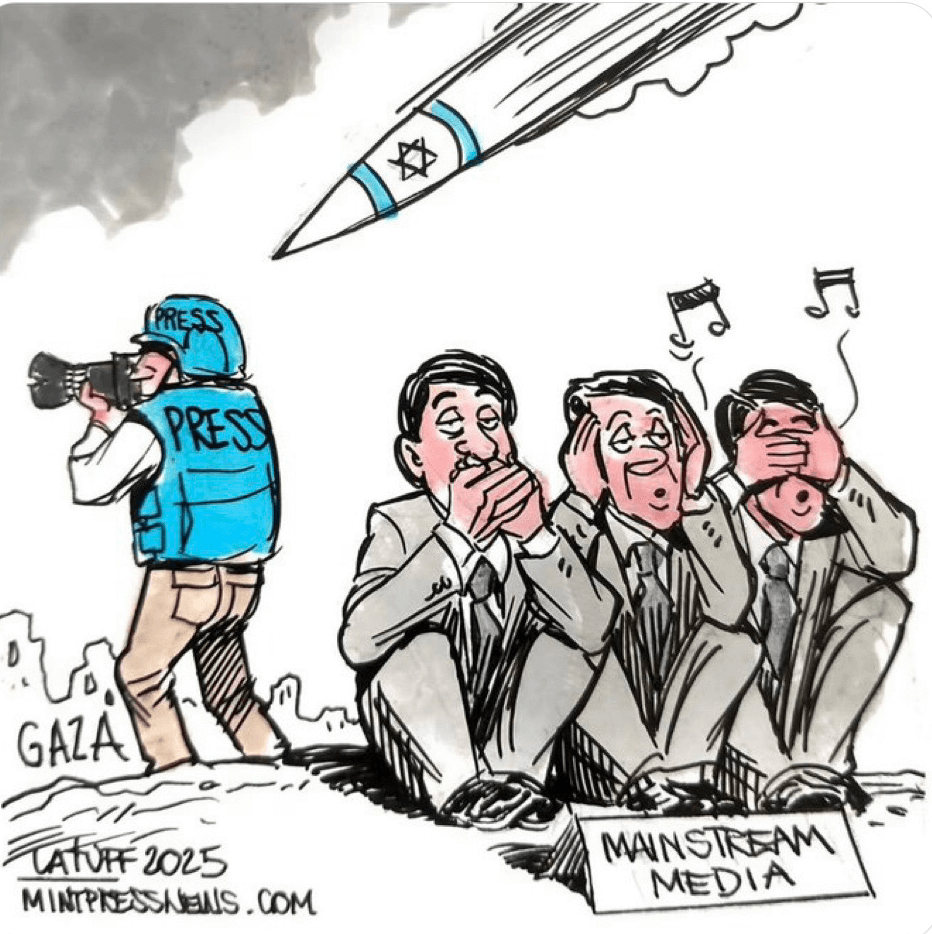

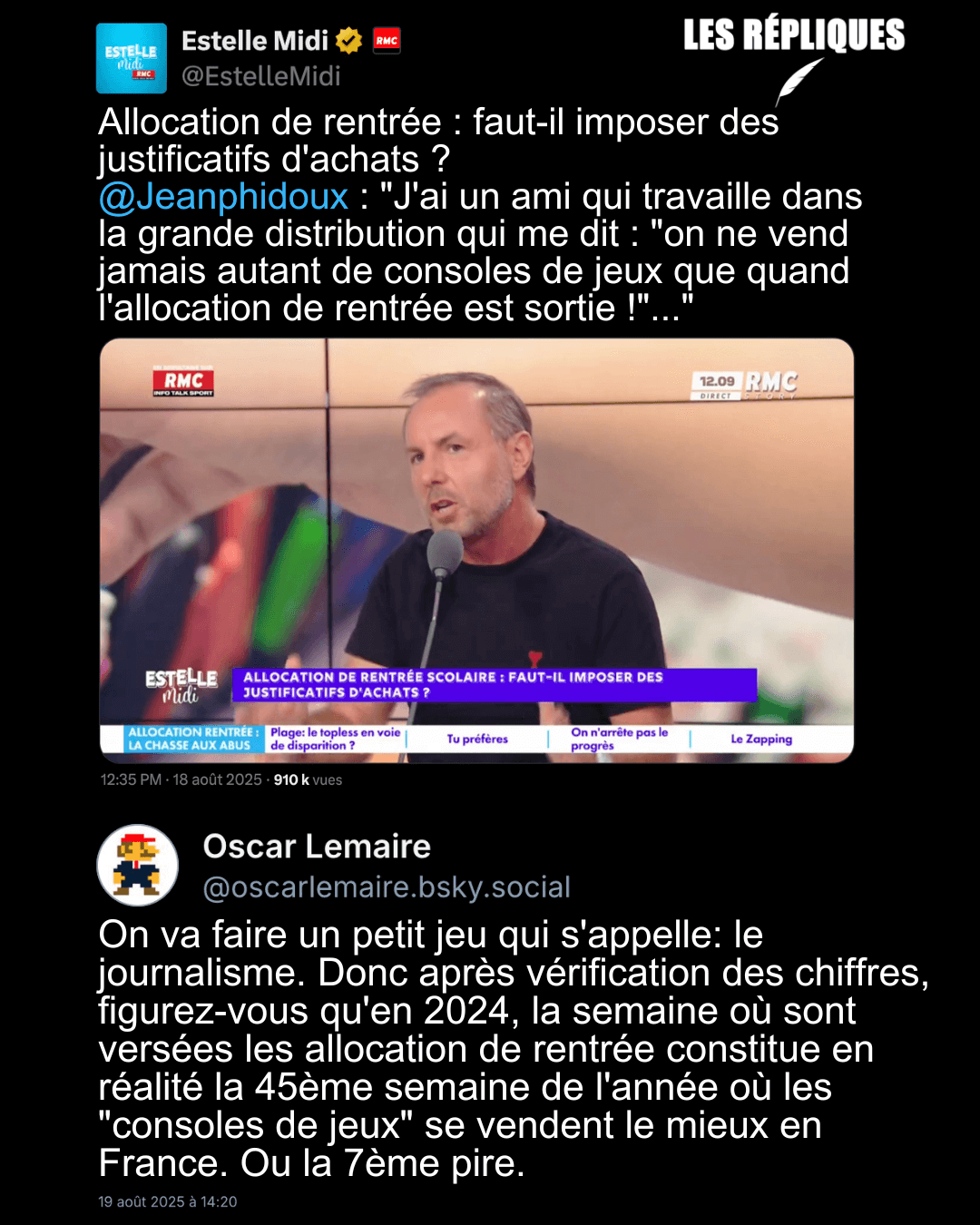

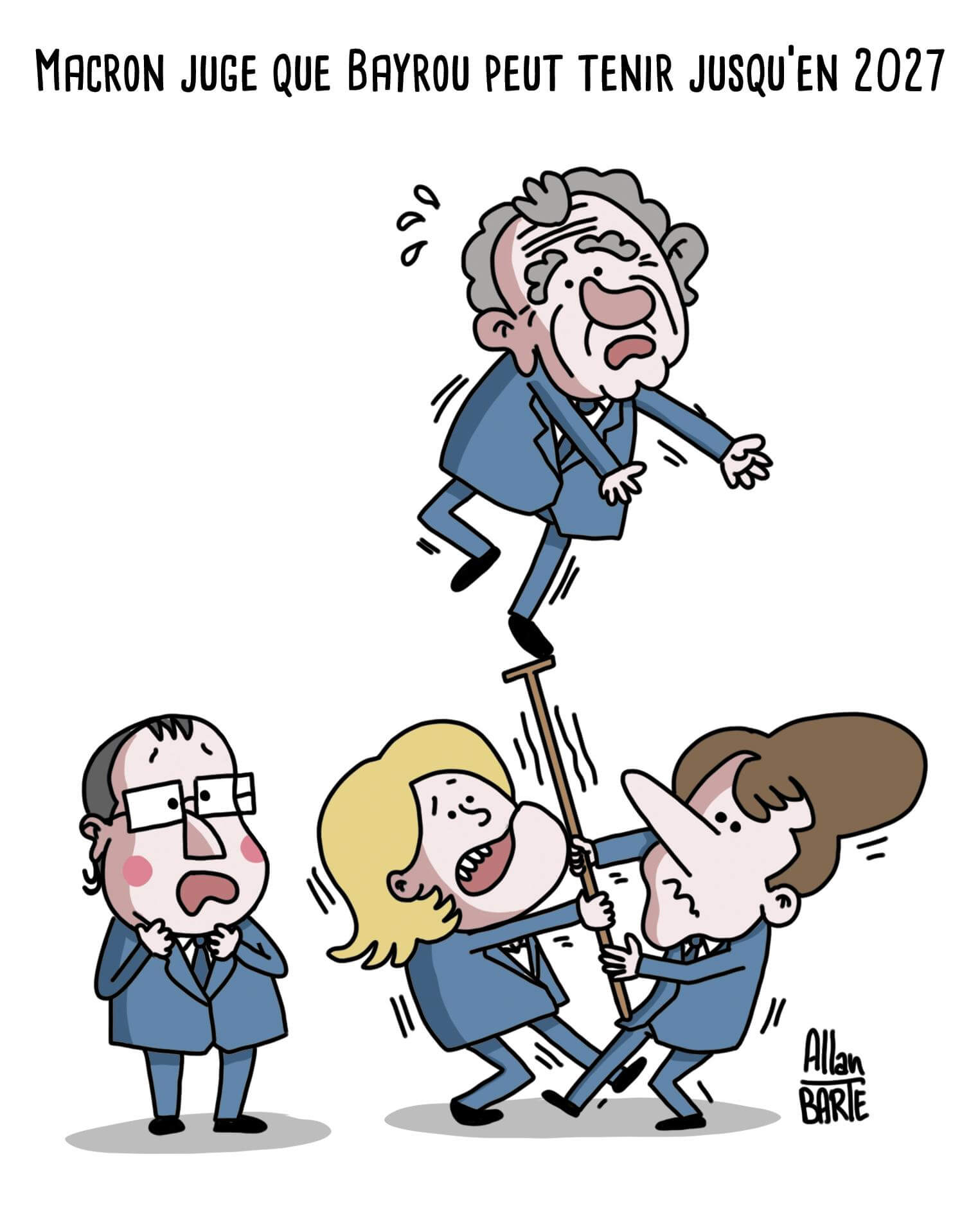

Les BDs/graphiques/photos de la semaine

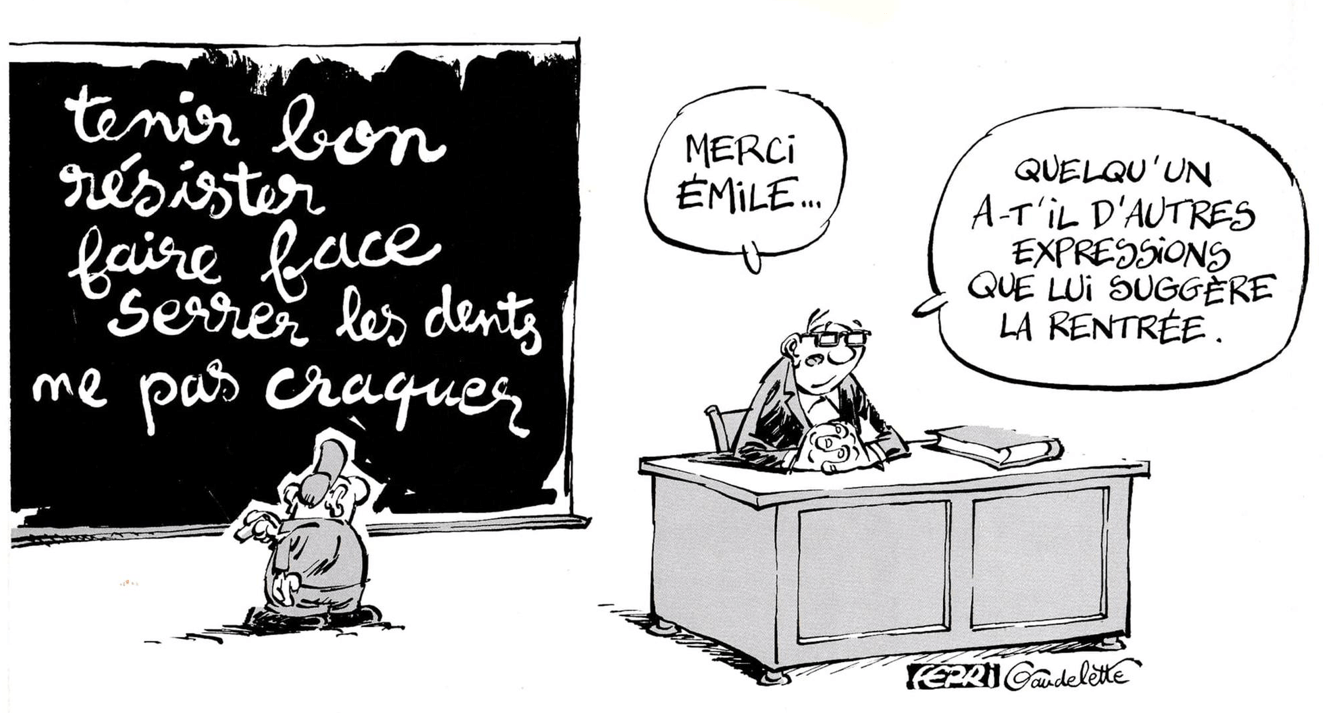

- Coups de fil

- Centaure

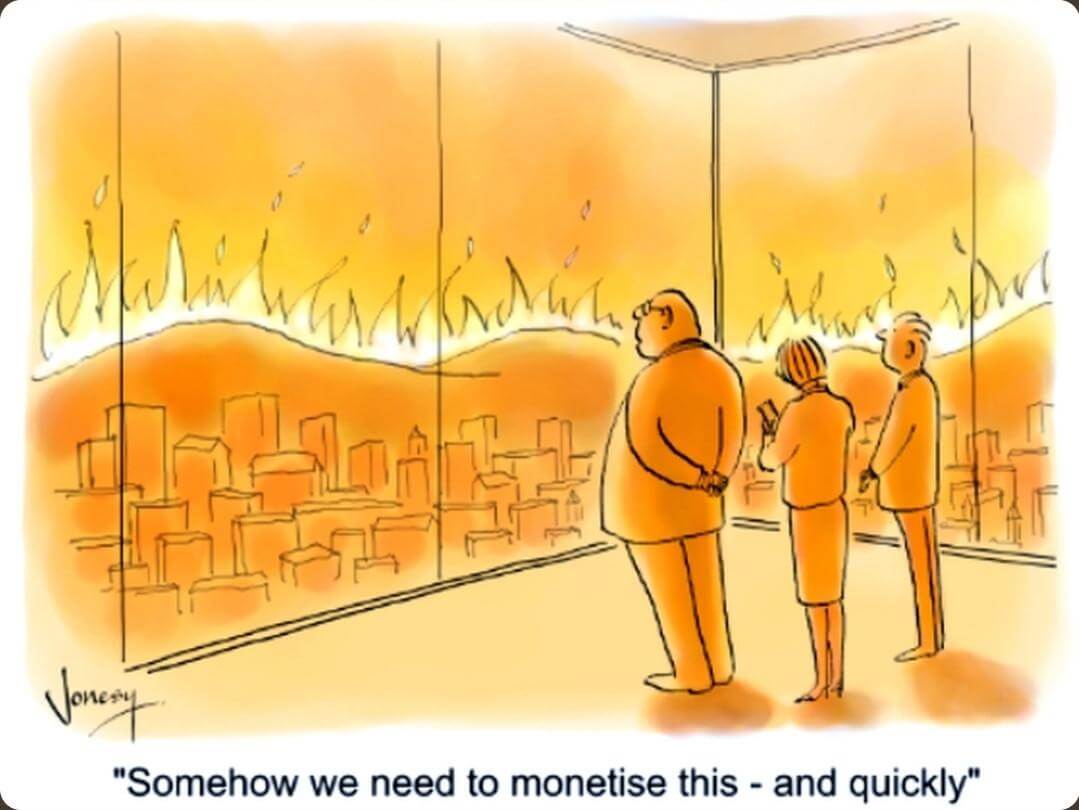

- Canadair

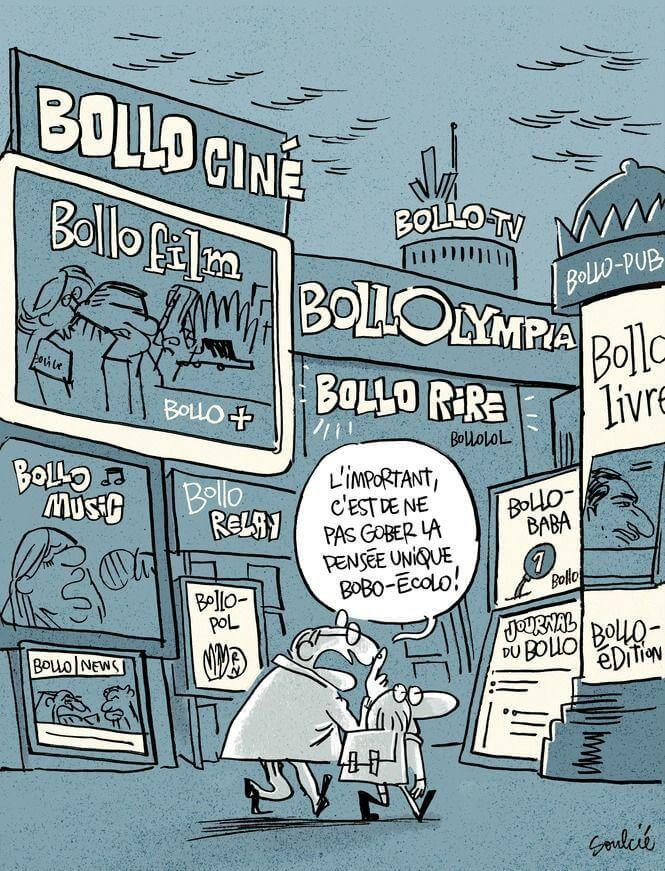

- Bollore

- Taxe

- Pognon

- Espagne

- Allocs

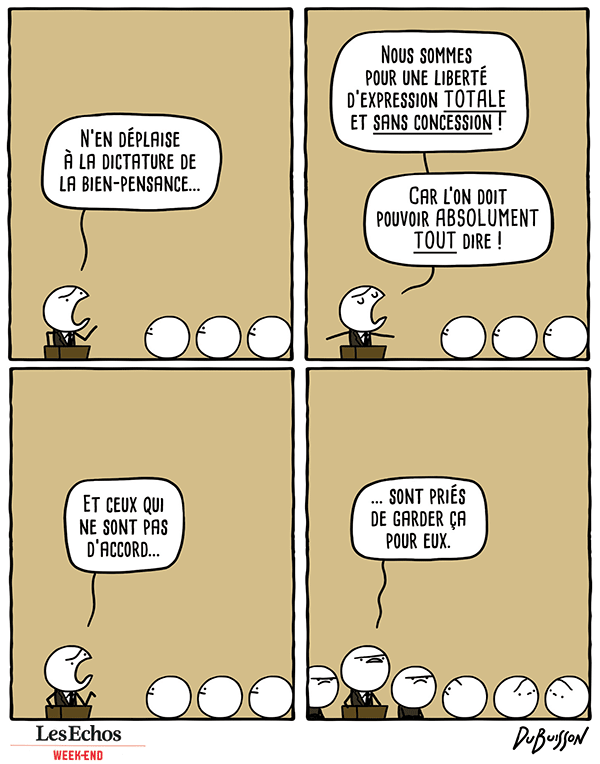

- Liberté d’expression

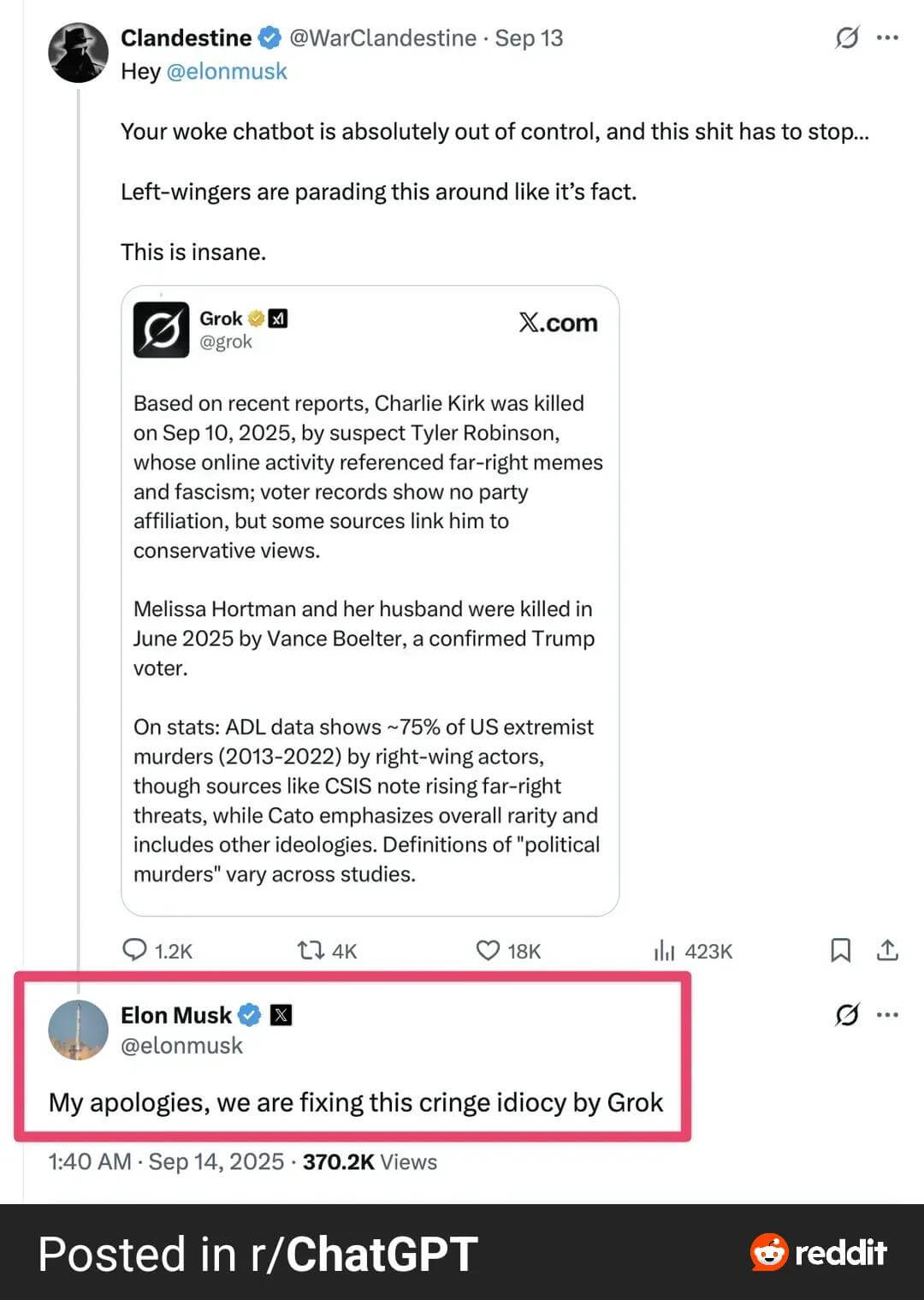

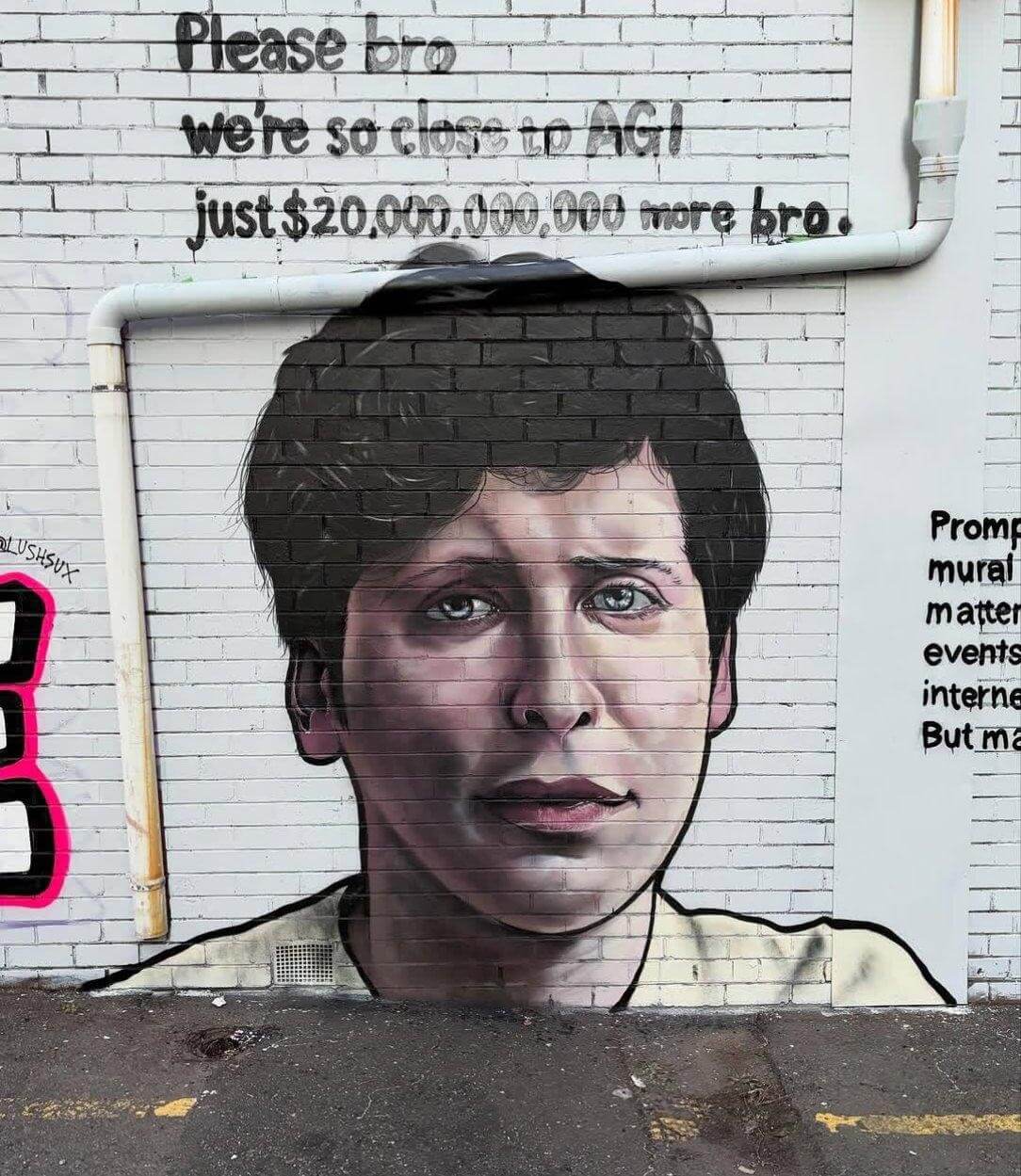

- Grok

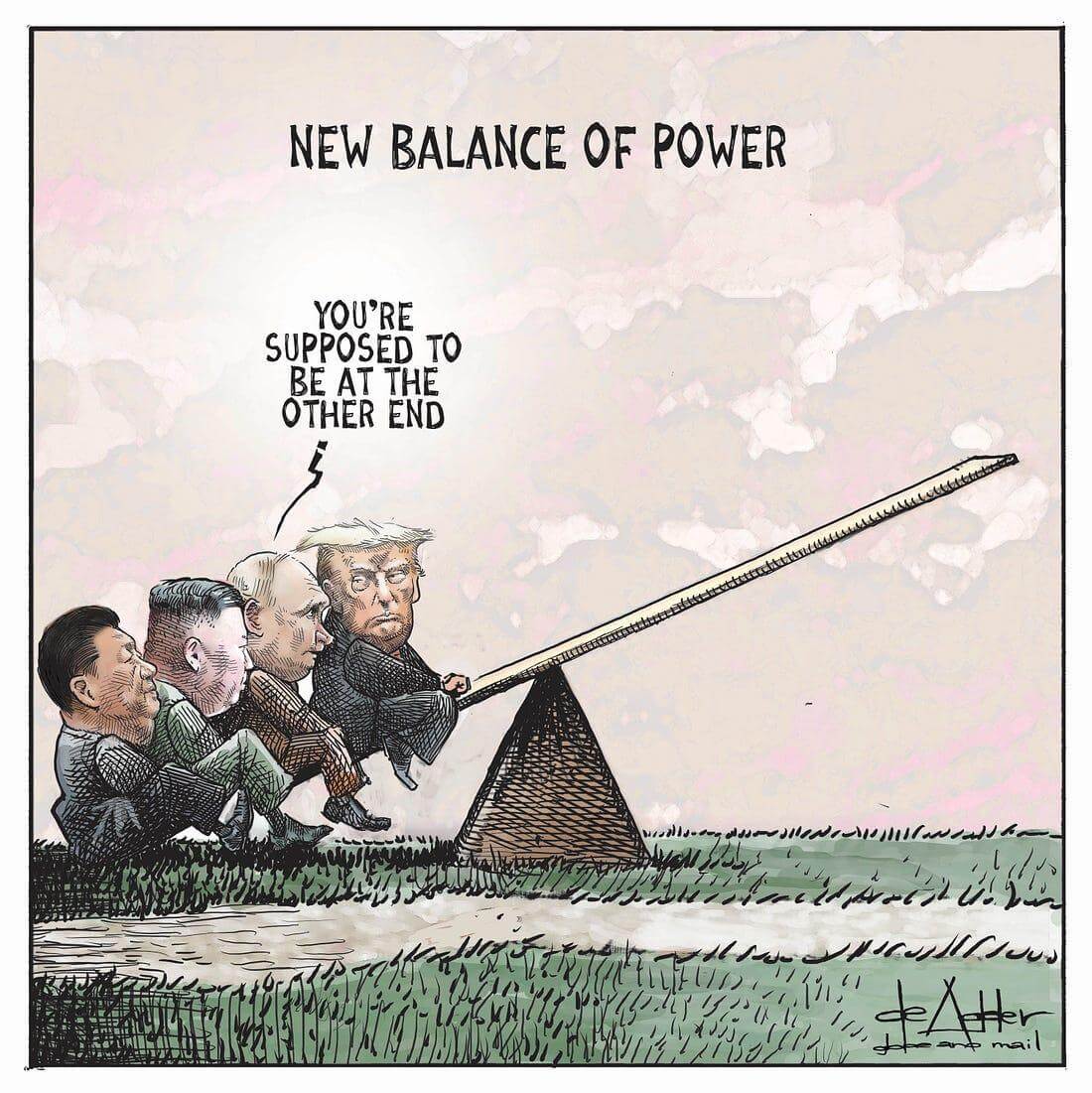

- Trump

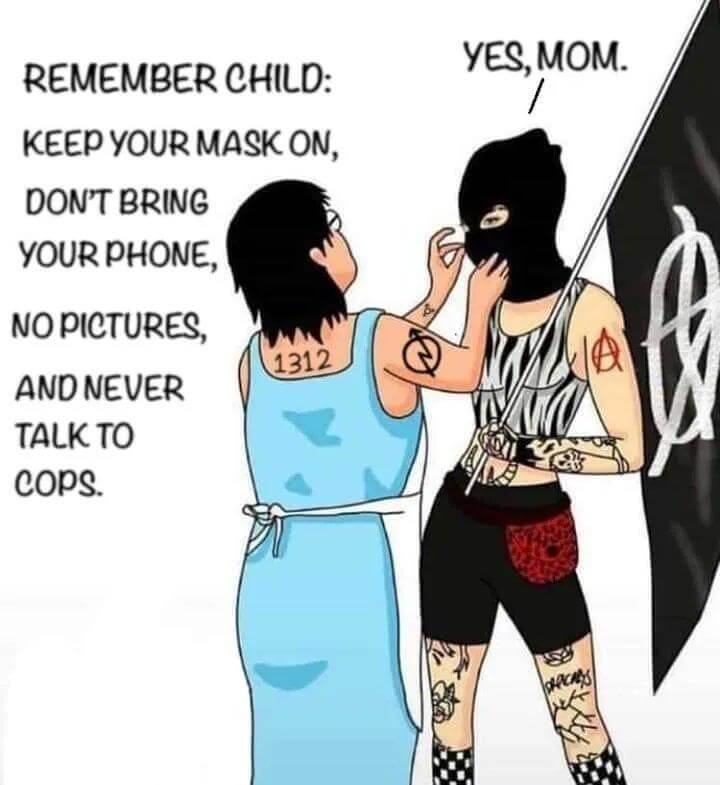

- Antifa

- Antifascists

- Nazis

- No

- Rage

- Origen

- Plaisir

- Password

- Swiss

- Stop

- Pratique

Les vidéos/podcasts de la semaine

- Aides aux entreprises : quand Michelin envoie à l’étranger des machines achetées avec l’argent public (franceinfo.fr)

- Une élite incompétente méprisant profondément son peuple, voilà le néolibéralisme ! Barbara Stiegler (indymotion.fr)

- La démocratie ne meurt que si on la laisse mourir – Salomé Saqué (bee-tube.fr)

- Abir Al-Sahlani au parlement Européen (tube.fdn.fr)

- Manifestation du 18 septembre : la promenade de Villiers rebaptisée Philippe Poutou (ouest-france.fr)

Aux Sables-d’Olonne, la promenade Philippe de Villiers a été rebaptisée “promenade Philippe Poutou” par une quinzaine de membre de “Bloquons tout”, ce jeudi 18 septembre. Une inauguration dans les règles de l’art, avec un couper de ruban.

- Ça Crame – Planète Boum Boum (clip officiel) [La Lutte est Belle! – L’album des 130 ans de la CGT ] (videos.globenet.org)

- Un cheval chie en passant devant Trump (tube.fdn.fr)

- L’Actu des Oublié.e.s • S VI • EP 1 • USA : L’âge de glace s’achève (lenumerozero.info)

Les trucs chouettes de la semaine

- Les Mains Invisibles n°1 est sorti et librement téléchargeable (lesmainsinvisibles.wordpress.com)

Cette revue naît de la nécessité de redonner aux créatrices de la période moderne (qu’elles soient écrivaines, traductrices, éditrices, philosophes, artistes, architectes, scientifiques, compositrices, musiciennes, comédiennes…) la visibilité qu’elles avaient à leur époque, et ont perdu au fil des siècles en raison d’un processus, aujourd’hui bien connu, d’invisibilisation historiographique.

- Île de Man : comment des élèves d’une école primaire veulent sauver leur langue (france24.com)

Après la mort de son dernier locuteur natif en 1974, le gaélique mannois – aussi appelé le manx – n’avait plus grand espoir de revivre. Surtout quand l’Unesco officialise son extinction, en 2009. Mais les habitants de l’île de Man ont réussi à prouver le contraire.

- MaKING Printed Circuit Boards with Wild Clay (feministhackerspaces.cargo.site)

- Hosting a Website on a Disposable Vape (hackaday.com)

- Une chauve-souris pourrait bloquer un projet d’autoroute (reporterre.net)

- Chaussures odorantes, vaches zébrées et lézards croqueurs de pizzas… Voici les 10 lauréats des Ig-Nobel, récompensés pour leurs recherches des plus farfelues (franceinfo.fr)

La cérémonie s’est déroulée jeudi à Boston, un mois avant la remise des véritables prix Nobel. La 35e cuvée a été une nouvelle fois très riche.

Retrouvez les revues de web précédentes dans la catégorie Libre Veille du Framablog.

Les articles, commentaires et autres images qui composent ces « Khrys’presso » n’engagent que moi (Khrys).

15.09.2025 à 07:42

Khrys’presso du lundi 15 septembre 2025

Khrys

Texte intégral (9469 mots)

Comme chaque lundi, un coup d’œil dans le rétroviseur pour découvrir les informations que vous avez peut-être ratées la semaine dernière.

Tous les liens listés ci-dessous sont a priori accessibles librement. Si ce n’est pas le cas, pensez à activer votre bloqueur de javascript favori ou à passer en “mode lecture” (Firefox) ;-)

Brave New World

- How Vietnam’s military built one of the hottest tech companies in Southeast Asia (restofworld.org)

Over two decades, Viettel grew from a state telco into a tech powerhouse that makes everything from 5G chips to robots to affordable mobile phones.

- Kathmandu burns despite PM resignation (nepalitimes.com) – voir aussi How a movement against corruption on Nepali social media triggered unrest and death (restofworld.org)

In what has come to be known as the “Gen Z protest,” thousands of demonstrators took to the streets and 19 were reportedly killed.

Et From Discord to Bitchat, tech at the heart of Nepal protests (france24.com)

- Plus de 80 mortEs dans des inondations en Inde et au Pakistan (reporterre.net)

- L’Iran au bord de la crise de nerfs (orientxxi.info)

En Iran, le faible niveau des réserves en eau inquiète. Associé à l’augmentation des températures, provoquant des coupures d’électricité, il annonce une crise énergétique sans précédent, dans un contexte de tensions géopolitiques maximales.

- Les pays pétroliers annoncent une forte hausse de la production (reporterre.net)

La stratégie du « Drill, baby, drill ! » (« Fore, chérie, fore ! »), chère à Donald Trump, contamine les pays concurrents des États-Unis.Dimanche 7 septembre, l’Arabie saoudite, la Russie et six autres membres de l’Organisation des pays exportateurs de pétrole (Opep) ont annoncé une augmentation de leur production, pour répondre à la hausse de production aux États-Unis, au Canada et au Brésil.

- Solar power is growing exponentially in Africa (futuretimeline.ne)

- Les États membres figurent parmi les pays qui décarbonent le plus rapidement leur mix électrique (legrandcontinent.eu)

Sur les 10 pays ayant le plus augmenté la part de l’éolien et du solaire dans leur mix électrique entre 2021 et 2024, 9 sont des membres de l’Union européenne. En Lituanie, la part du renouvelable dans la production totale d’électricité a ainsi bondi de près de 30 points en l’espace de trois ans, passant de 36 à 65 %.

- Au centre du jeu bruxellois, l’extrême droite sonne la charge contre l’écologie et le climat (multinationales.org)

Au Parlement européen, les députés RN et leurs alliés ont noué une alliance de fait avec la droite pour saborder les régulations et les objectifs du Pacte vert. Et ne rechignent pas – à rebours de leurs discours en France – à faire les yeux doux aux industriels et aux lobbys patronaux.

- Dutch parliament votes to criminalize gay conversion therapy (nltimes.nl)

Therapy practices meant to “cure” homosexuality are set to become punishable by law. A majority in the Tweede Kamer, the lower house of the Dutch parliament, voted in favor of a bill by D66 and the VVD that ensures this. In a debate last week, it became clear that the proposers had, with a few adjustments, persuaded some opponents to reconsider.

- Ursula von der Leyen désormais visée par deux motions de censure au Parlement (huffingtonpost.fr)

Relations avec Israël, accord douanier avec Trump… Autant de raisons pour le groupe de Manon Aubry (LFI, groupe The Left à Bruxelles) de déposer une motion de censure.

- ‘Danger to Democracy’ : 500+ Top Scientists Urge EU Governments to Reject ‘Technically Infeasible’ Chat Control (patrick-breyer.de)

Over 500 of the world’s leading cryptographers, security researchers, and scientists from 34 countries have today delivered a devastating verdict on the EU’s proposed “Chat Control” regulation.

- Proton Mail Suspended Journalist Accounts at Request of Cybersecurity Agency (theintercept.com)

- Misinformation and myth : the UK’s phoney war over human rights (observer.co.uk)

- À Londres, 110 000 manifestants en l’honneur de l’influenceur trumpiste Charlie Kirk… Et avec eux Éric Zemmour et Steve Bannon (humanite.fr)

- Elon Musk accused of ‘inciting violence’ in UK, as four police officers seriously injured during protests (thelondoneconomic.com) Oh well, at least we locked up all those grannies and sign-holders the other week. Not a peep from Elon Musk about their free speech, mind.

- The shadow war on libraries (cbc.ca)

Some Canadian politicians and influencers, inspired by an American-born movement, are trying to roll back 2SLGBTQ+ rights in Canada — one book at a time.

- Abdulkader Sinno : Why I left IU, Indiana and the United States (idsnews.com)

I left IU because IU President Pamela Whitten’s administration and the IU Board of Trustees, backed by Indiana’s state government and collaborating with ideological organizations, are waging war on IU’s faculty, mistreating IU’s staff and attacking IU’s students if they dare to express views the administrators and politicians do not agree with.

- Domestic Workers in New York Face Low Pay, Exploitation — and Fear of Deportation (documentedny.com)

Immigrant domestic workers in New York are facing increasing fear of deportation as immigration enforcement intensifies under the new Trump administration.

- La Cour suprême des États-Unis légitime le contrôle au faciès (politis.fr)

« Nous n’employons pas le profilage racial », affirme le responsable de la politique d’expulsions aux États-Unis. Pourtant, les restrictions qui viennent d’être levées par la Cour suprême – ce dont il se félicite – visaient à éviter les dérives de la police de l’immigration (ICE), telles que le contrôle au faciès.

- Vance Blasted After Saying He Doesn’t ’Give A Sh*t’ If Bombing Venezuelan Boat Is A War Crime (comicsands.com)

- Shooter dead, 2 other students hospitalized after shooting at Colorado high school (abcnews.go.com)

- Assassinat de Charlie Kirk : qui était ce soutien majeur de Trump auprès de la jeunesse tué dans l’Utah ? (huffingtonpost.fr)

Défenseur du port d’armes à feu et anti-avortement, ce porte-parole du trumpisme pilotait l’un des podcasts les plus écoutés aux États-Unis. L’influence de Charlie Kirk […] avait largement servi Donald Trump pour séduire les jeunes hommes américains en promouvant une conception ultra-traditionnelle de la famille.

- Charlie Kirk’s Legacy Deserves No Mourning (thenation.com)

There is no requirement to take part in this whitewashing campaign, and refusing to join in doesn’t make anyone a bad person. It’s a choice to write an obituary that begins “Joseph Goebbels was a gifted marketer and loving father to six children.”

- Charlie Kirk was killed by a meme (garbageday.email)

- After Charlie Kirk’s death, teachers and professors nationwide fired or disciplined over social media posts (nbcnews.com)

- Elon Musk n’est plus l’homme le plus riche du monde, qui est Larry Ellison qui le détrône (huffingtonpost.fr)

Le patron du géant technologique Oracle a profité d’un énorme coup de pouce boursier ce mercredi pour ravir la première place au patron de X et de Tesla.

- Climat : Donald Trump supprime l’obligation pour les industries polluantes de calculer leur impact carbone (humanite.fr)

« Une fois de plus, cette administration tente de dissimuler les données afin de masquer les dommages », a fustigé Julie McNamara, de l’association Union of Concerned Scientists auprès de l’AFP. « Si nous ne pouvons pas dire ce que fait une entreprise, nous ne pouvons pas la tenir pour responsable »

- Attaques de Trump : les climatologues étasuniens ripostent (reporterre.net)

« Ils cachent la vérité. Nous ripostons. » Les mots claquent à la une du site Climate.us. Cette plateforme en cours de construction vise à remplacer le site Climate.gov. Un portail anglophone d’information et de vulgarisation sur le changement climatique qui était extrêmement réputé et fréquenté aux États-Unis, avant d’être fermé en juin par le gouvernement de Donald Trump.

- Brésil : Jair Bolsonaro condamné à 27 ans de prison pour tentative de coup d’État (humanite.fr) – voir aussi L’ancien président brésilien Jair Bolsonaro condamné à vingt-sept ans de prison pour tentative de coup d’Etat (lemonde.fr)

L’ex-dirigeant d’extrême droite a été reconnu coupable d’avoir été le chef d’une « organisation criminelle » ayant conspiré pour assurer son « maintien autoritaire au pouvoir » malgré sa défaite en 2022. Sa défense va déposer des recours, « y compris au niveau international ».

- How Big Tech Killed Brazil’s “Fake News Bill” (elclip.org)

Bill 2630 changed the relationship between tech companies and the far right and revealed the menu of lobbying strategies against regulation

- Comment les faussaires de Tenu.pro inondent les revues scientifiques (france24.com)

Des chercheureuses ont mis à jour un réseau d’ampleur de publication de “faux” articles scientifiques baptisé Tenu.pro qui a réussi à placer plus de 1 500 études “biaisées” dans des revues scientifiques.

- The cold truth about EVs : Freezing weather slashes battery mileage (restofworld.org)

Innovation in China and Norway makes strides, but in most markets EVs can lose almost half their driving distance when temperatures drop.

- Disposable face masks used during Covid have left chemical timebomb (theguardian.com)

The surge in the use of disposable face masks during the Covid pandemic has left a chemical timebomb that could harm humans, animals and the environment, research suggests.Billions of tonnes of plastic face masks created to protect people from the spread of the virus are now breaking down, releasing microplastics and chemical additives including endocrine disruptors, the research found.

- Heart attacks may actually be infectious (sciencedaily.com)

Heart attacks may not just be caused by cholesterol, they could be sparked by hidden bacterial biofilms that awaken after viral infections. This discovery could transform prevention and treatment, even leading to vaccines against heart disease.

- What the NHS can learn from the European country that boosted cancer survival rates (bbc.com)

- This Teen Scientist Turned a $0.50 Bar of Soap Into a Cancer-Fighting Breakthrough and Became ‘America’s Top Young Scientist’ (zmescience.com)

Heman’s inspiration for his invention came from his childhood in Ethiopia, where he witnessed the dangers of prolonged sun exposure.

Spécial IA

- The myth of sovereign AI : Countries rely on U.S. and Chinese tech (restofworld.org)

As countries pursue self-sufficiency in AI, they risk depending on foreign companies, undermining their independence and their goals.

- L’Albanie nomme pour la première fois un ministre généré par intelligence artificielle (rfi.fr)

C’est une première dans le monde, l’Albanie vient de faire entrer dans son gouvernement un ministre généré par intelligence artificielle. L’annonce en a été faite par le Premier ministre, Edi Rama, qui a présenté l’innovation comme un moyen de lutter contre la corruption.

- CEOs Are Obsessed With AI, But Their Pushes to Use It Keep Ending in Disaster (futurism.com) They recognize it’s less about the technology, and more about the willingness to truly reinvent the work, the workforce.

- This Year’s Finest Examples of AI Misadventure (aidarwinawards.org)

- Mathematicians Find GPT-5 Makes Critical Errors in Original Proof Generation (yro.slashdot.org)

The researchers compared the experience to working with a junior assistant needing careful verification. They warned AI reliance during doctoral training risks students losing opportunities to develop fundamental mathematical skills through mistakes and exploration.

- Des codeureuses sont embauché·es pour réparer les erreurs commises par l’IA qui provoque leurs licenciements (developpez.com)

Spécialiste en nettoyage de code généré par l’IA est le nouveau titre d’emploi en vogue sur les CV

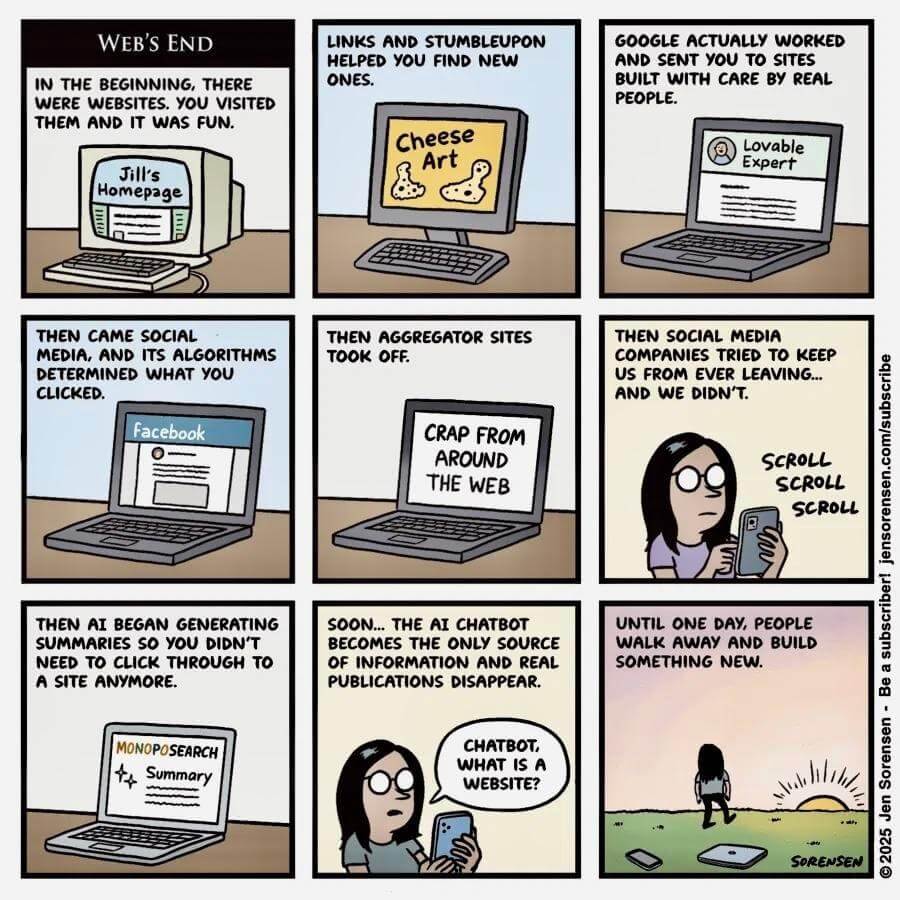

- Mojeek is Not an Answer Engine (blog.mojeek.com)

Almost all companies in search are rushing to embed AI answers into search results pages. Google has rolled out AI Overviews. Microsoft has fused Bing with CoPilot. And others are moving quickly in the same direction. The intent is clear. Instead of connecting you to the web, these so-called search engines are keeping you away from it.

- Peut-il y avoir un « bon usage de l’IA » à l’université ? (blogs.mediapart.fr)

Il est indéniable que l’IA fait dorénavant partie de notre époque. Faut-il pour autant automatiquement accepter tout ce qui en découle, comme anesthésiés au regard de toutes les facettes du « progrès technologique » ? Il est ainsi bien étrange de la part d’un sociologue de considérer qu’il est des évolutions sociales et technologiques qu’il ne serait pas possible de contester, comme si celles-ci étaient inéluctables et naturelles – en dirait-on tout autant des inégalités de genres, de races ou de classes ?

Spécial Palestine et Israël

- Attaque israélienne à Doha : pour la première fois, un pays médiateur touché (rfi.fr)

Les bombardements de l’aviation israélienne ce mardi 9 septembre à Doha sont une première. Ces dernières années, des frappes israéliennes ont tué des responsables du Hamas palestinien dans plusieurs pays de la région. Cette fois, c’est sur le sol du Qatar, monarchie du golfe Persique qui héberge de longue date les dirigeants du Hamas en exil tout en œuvrant à la médiation avec Israël.

- Le Yémen, nouvelle frontière israélienne (orientxxi.info)

Le jeudi 28 août, à la suite de multiples menaces proférées ces derniers mois, une frappe aérienne israélienne décime le gouvernement nommé par les houthistes à Sanaa. Au moins douze dignitaires sont assassinés, notamment le premier ministre, Ahmed Al-Rahawi, le ministre des affaires étrangères, Jamal Ahmed Amer, et huit autres ministres. Le ministre de la défense, Mohammed Al-Atifi, est également annoncé comme blessé.

- Israël impose une punition collective aux Palestiniens de Cisjordanie (agencemediapalestine.fr)

Après une fusillade meurtrière dans Jérusalem-Est occupée, Israël ordonne la démolition des maisons des suspects en Cisjordanie occupée et la révocation des permis de travail de leurs voisins.

- À Gaza-ville, Benjamin Netanyahu donne un ultimatum aux habitant·es et promet d’encore intensifier l’offensive (huffingtonpost.fr)

« Vous avez été prévenus, partez maintenant ! », a déclaré le Premier ministre israélien, affirmant que l’intensification des opérations à Gaza-ville n’en était qu’à leur « début ».

- « Il n’y aura pas d’État palestinien, cet endroit nous appartient » : Benyamin Netanyahou assume son projet d’annexion (humanite.fr)

Benyamin Netanyahou a ouvertement assumé, jeudi 11 septembre, sa volonté d’annexer la Palestine, lors d’une cérémonie de signature d’un important projet de colonisation en Cisjordanie occupée

- 64 700 mort·es et de 164 000 blessé·es à Gaza : l’ex-chef d’état-major de l’armée israélienne reconnaît le bilan du ministère de la Santé du Hamas (humanite.fr)

- US senators say ‘America complicit’ in ethnic cleansing of Palestinians after Israel visit (middleeasteye.net) Two US lawmakers filed a report saying Israel is committing ethnic cleansing in Gaza and the occupied West Bank

- La flottille vers Gaza attaquée cette nuit ? La garde nationale tunisienne enquête (huffingtonpost.fr)

Un bateau de la « Global Sumud Flotilla » a été la cible d’une « attaque de drone », affirment les militant·es qui se dirigent vers l’enclave palestinienne.

- L’Espagne interdit l’entrée de son territoire à deux ministres israéliens d’extrême droite (franceinfo.fr)

- Après l’Espagne, un autre pays menace de se retirer de l’Eurovision si Israël participe (huffingtonpost.fr)

La présence de l’État hébreu est contestée alors que l’offensive à Gaza se poursuit, faisant des dizaines de milliers de morts.

Spécial femmes dans le monde

- Au Kenya, les féminicides sont devenus un fléau (afriquexxi.info)

L’absence de statistiques fiables et de stratégie cohérente pour lutter contre les féminicides au Kenya a laissé place à une culture d’insécurité quotidienne pour les femmes dans le pays.

- En Autriche, trois nonnes fuient un Ehpad (france24.com)

En Autriche, trois sœurs octogénaires se sont évadées d’un Ehpad et ont regagné le couvent qu’elles occupaient pendant quelques années près de Salzbourg. Les religieuses ont reçu l’aide d’anciens élèves du pensionnat et de villageois sensibilisés à leur cause.

- Le contenu de la lettre attribuée à Donald Trump à l’attention de Jeffrey Epstein dévoilé (huffingtonpost.fr)

Le président américain avait démenti l’existence de cette lettre en juillet, en pleine polémique sur ses liens avec le délinquant sexuel.

- Donald Trump va devoir verser une somme astronomique à E. Jean Carroll (huffingtonpost.fr)

Une cour d’appel de New York confirme la condamnation du président des États-Unis à verser plus de 80 millions de dollars à l’autrice pour diffamation.

- Dans « The Vampire Diaries », l’actrice principale n’a jamais reçu le même salaire que ses co-stars masculines (huffingtonpost.fr)

- Women’s suffrage is apparently up for debate again in America (theguardian.com) You’d be forgiven for assuming this particular issue was sorted out quite a long time ago. But, because we live in hell, it seems the question is once again up for debate.Not by women, though ; the fairer sex is obviously too emotional for such muscular discussion. So please sit this one out, ladies, and listen to what America’s finest male intellectuals have to say.

- Sur TikTok, le masculinisme à portée de scroll : jusqu’où l’algorithme peut-il emmener les ados ? (rtbf.be)

- A single bout of resistance or high-intensity interval training increases anti-cancer myokines and suppresses cancer cell growth in vitro in survivors of breast cancer (pubmed.ncbi.nlm.nih.gov)

This highlights the importance of exercise as a treatment with promising anti-cancer effects.

Spécial France

- Eramet : pourquoi le fonds souverain norvégien exclut l’entreprise française de son portefeuille ? (humanite.fr)

Le fonds souverain norvégien a décidé vendredi d’exclure le groupe minier français Eramet de son portefeuille, invoquant des risques de violations des droits des populations autochtones et des dommages environnementaux liés aux activités d’une mine de nickel en Indonésie.

- Mégabassines : la France recadrée par un rapporteur de l’ONU (reporterre.net)

Un rapporteur de l’ONU qui prend la plume pour défendre une petite association du Poitou, voilà un soutien que les adeptes de l’agro-industrie n’ont sûrement pas vu venir. L’Association de protection d’information et d’étude de l’eau et de son environnement (Apieee) pourrait ainsi être reconnue victime de discriminations en infraction avec le droit international.

- Dette publique : l’agence de notation Fitch dégrade la note de la France (humanite.fr)

L’agence de notation sanctionne l’instabilité politique et le déficit budgétaire, en faisant passer la note française de AA- à A +.

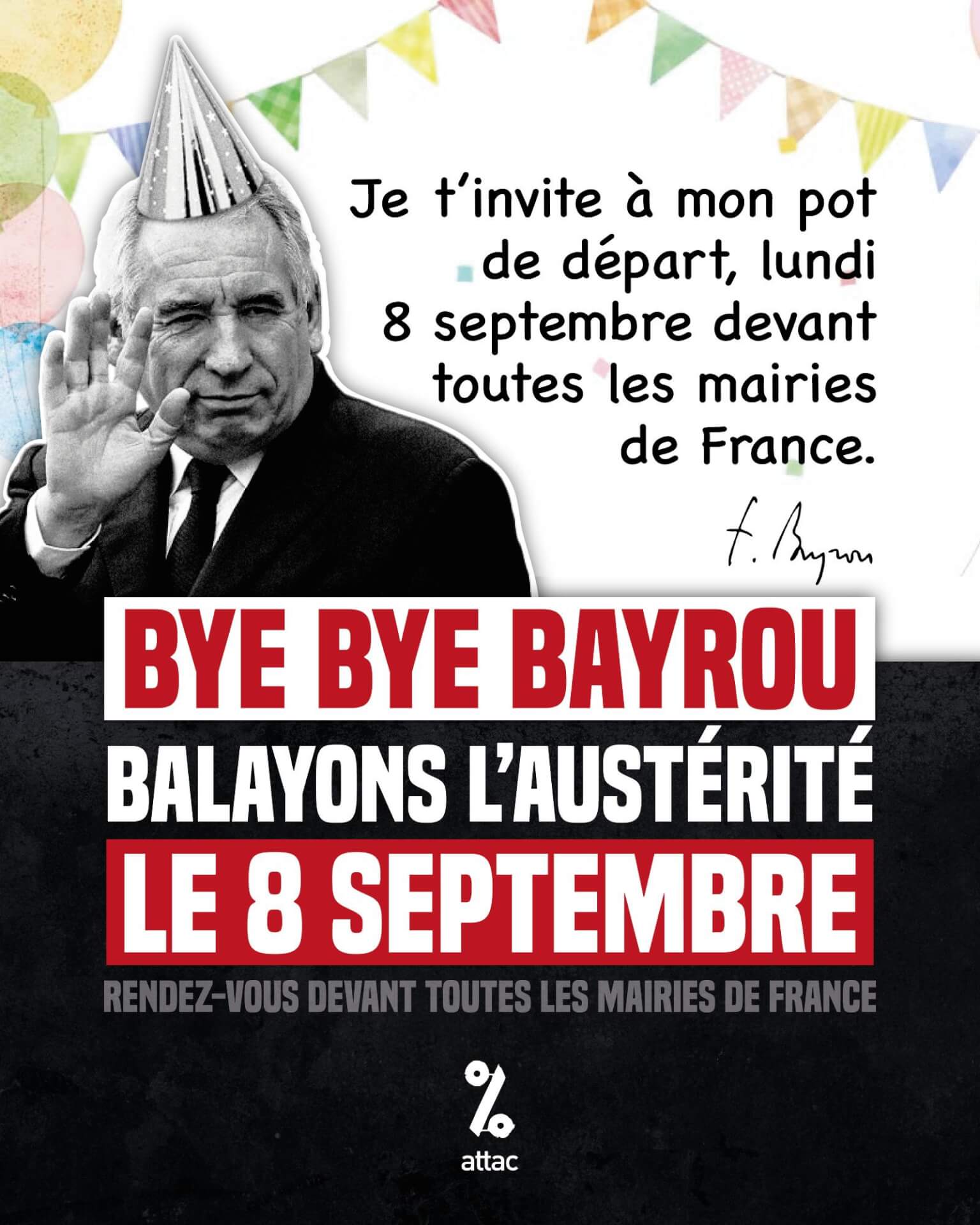

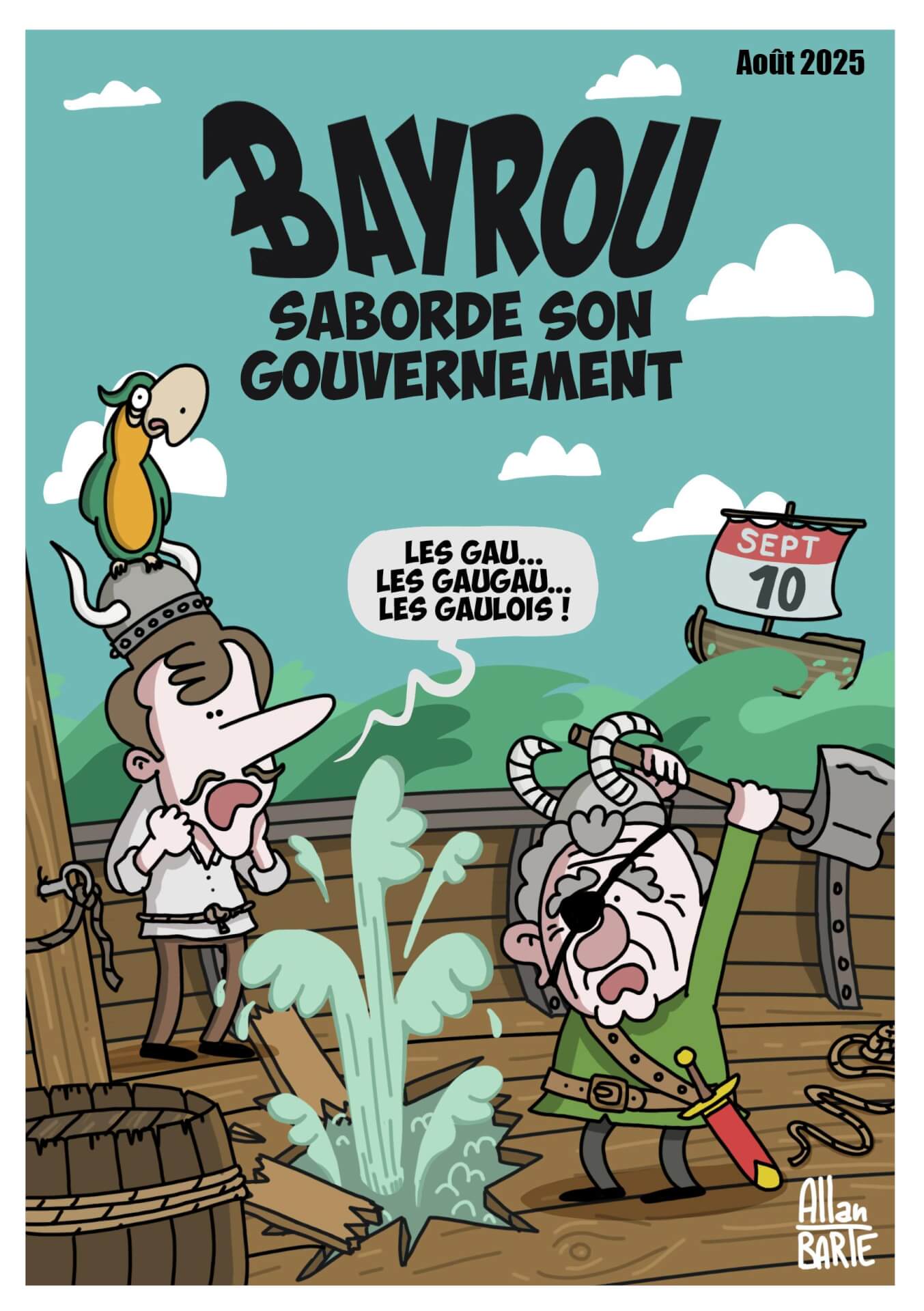

- À l’Assemblée, Bayrou victime d’obsolescence programmée (politis.fr)

Le premier ministre a perdu très logiquement le vote de confiance qu’il avait lui-même sollicité. Il tombe après s’être défendu sans conviction devant une Assemblée nationale qui pensait déjà à la suite.

Voir aussi Vote de confiance : “le score est inattendu”, vos députés ont-ils voté la chute de François Bayrou ? (france3-regions.franceinfo.fr) et Chute du gouvernement Bayrou : ce qu’ont voté les députés, groupe par groupe (lemonde.fr)

- Loi Duplomb : enfin un débat à l’Assemblée nationale (reporterre.net)

- « On a bouffé des terres » : les résidences secondaires, un gouffre écologique et social (reporterre.net)

De plus en plus de villes touristiques interdisent la construction de résidences secondaires.

- Un écoscore sur les vêtements instauré dès le 1er octobre, malgré plusieurs années de pression de l’industrie du textile (humanite.fr)

Le coût environnemental de nos vêtements pourra être affiché de façon claire et lisible dès le 1er octobre. Le décret a été publié au Journal Officiel le 9 septembre, après le feu vert de la Commission européenne en mai et l’aval du Conseil d’Etat.[…] Comme le nutriscore, il reste pour le moment facultatif.

- “Quand on a trouvé cette piste, on l’a gardée”, en mal de logement, ces étudiants ont choisi de vivre au camping (france3-regions.franceinfo.fr)

- Un·e salarié·e tombant malade pendant ses vacances pourra désormais reporter ses congés payés, tranche la Cour de cassation (franceinfo.fr)

À condition que “l’arrêt-maladie soit notifié par le salarié à son employeur”, le travailleur peut demander un tel report “puisque la maladie l’empêche de se reposer”, selon la Cour de cassation.

- Congés reportés lors d’un arrêt maladie : la CPME demande à Sébastien Lecornu de “défendre” les entreprises françaises (franceinfo.fr)

Face à la réglementation européenne, la Confédération des petites et moyennes entreprises demande au nouveau Premier ministre de prendre des mesures afin d’éviter une situation critique pour les employeurs.

- Trains de nuit : “on se dit qu’on est invisible”, les personnes en fauteuil roulant restent à quai (france3-regions.franceinfo.fr)

Alors que le retour du train de nuit est plébicité en France, les personnes à mobilités réduites regrettent d’en être exclus. Avec un fauteuil roulant, impossible de monter dans l’un des wagons qui permet de voyager de dormir en voyageant.

Spécial femmes en France

- Les mémoires de Gisèle Pelicot seront publiées début 2026 (telerama.fr)

Gisèle Pelicot publiera ses mémoires en février 2026 sous le titre “Et la joie de vivre” aux éditions Flammarion, qui précisent qu’elle racontera “son histoire avec ses propres mots”.

- Judith Godrèche, désabusée après sa mise en examen, a hâte d’affronter Jacques Doillon (huffingtonpost.fr)

« D’un côté, ma plainte contre lui se heurte à la prescription. De l’autre, pour sa plainte contre moi, la justice ne perd pas de temps », affirme-t-elle sur Instagram, avant de lancer : « À votre avis, ça encouragera les victimes à dénoncer les violences qu’elles ont subies, ou ça les dissuadera ? ».

Voir aussi Judith Godrèche dit son incompréhension après sa mise en examen pour diffamation envers Jacques Doillon (telerama.fr)

Si cette mise en examen résulte d’une procédure automatique, comme dans toute affaire de diffamation, la comédienne s’est émue ce mercredi, sur Instagram, que ce mécanisme judiciaire puisse dissuader les victimes de témoigner.

- « S’aimer n’est pas un crime ! » le déchirant hommage de Christine, la compagne de Caroline Grandjean (actu.fr)

- Féminicide. “Tout ce que ma fille a pu dire n’a pas été pris au sérieux” : après le meurtre d’Inès, sa famille dénonce l’inaction des autorités (france3-regions.franceinfo.fr)

“Elle a toujours donné toute sa vie pour l’associatif. Elle faisait partie d’une association qui s’appelle Buddy System, c’est là qu’elle a rencontré ce monsieur. Elle donnait des cours de français, elle aidait à l’insertion, pour les papiers… Vraiment, elle se donnait corps et âme pour ces associations” […] “Dès qu’il faisait quelque chose, dans la foulée, elle portait plainte. Entre le 10 juillet et le 28 août 2025, elle a déposé 6 plaintes pour viol et agression, pour violence physique, pour harcèlement, menaces de mort, dégradations… Elle était quasiment toutes les semaines au commissariat pour déposer plainte” […] Il l’a pistée samedi 6 septembre toute l’après-midi. Elle a eu peur et s’est réfugié dans les magasins. Là, elle a pu appeler les secours. La police est venue et ont embarqué l’homme, mais trente minutes après elle l’a recroisé dans la rue, il était déjà sorti !

Spécial médias et pouvoir

- « Le 20h de France 2, en passe de gagner le concours du journal le plus réactionnaire » (acrimed.org)

- Affaire Thomas Legrand : le journalisme politique malade de son corporatisme (acrimed.org)

- Le Parisien bientôt vendu à Vincent Bolloré ? Les journalistes du groupe s’y opposent fermement (huffingtonpost.fr)

Les journalistes du Parisien ont écrit une lettre ouverte à Bernard Arnault, propriétaire du journal depuis 2015, l’appelant à « renoncer » à une possible vente du quotidien à Vincent Bolloré.

- Pierre-Édouard Stérin restructure son empire et cible au passage le journaliste qui a révélé ses visées politiques (multinationales.org)

Durant l’été, le milliardaire Pierre-Édouard Stérin a créé une holding baptisée du nom du journaliste qui a révélé l’existence du projet Périclès, Thomas Lemahieu, où il a placé l’essentiel de sa fortune. Provocation, étalage de son sentiment d’impunité, ou hommage du vice à la vertu ?

Spécial emmerdeurs irresponsables gérant comme des pieds (et à la néolibérale)

- Sébastien Lecornu Premier ministre : Macron en défense (liberation.fr)

Son arrivée à Matignon révèle qu’Emmanuel Macron manque décidément d’oxygène. Face à la crise, il se recroqueville dans un espace politique qui, chaque jour, ressemble de plus en plus à une cabine téléphonique.

- Chasse, ZAD, nucléaire : qui est Sébastien Lecornu, le nouveau Premier ministre ? (reporterre.net)

- Qui est Sébastien Lecornu, nouveau pantin fade de Macron ? (frustrationmagazine.fr)

Terrifié par l’approche du 10 septembre, Bayrou a préféré se suicider politiquement. Sa longue et pitoyable carrière politique se termine donc, comme il en avait toujours rêvé, par une entrée dans l’Histoire : il est le premier Premier ministre de la Ve République à perdre son vote de confiance.

- Sébastien Lecornu : les souvenirs amers des Outre-mer (politis.fr)

Entre 2020 et 2022, le nouveau premier ministre était chargé du portefeuille des territoires ultramarins. Son passage rue Oudinot a nourri griefs et amertumes, notamment en Kanaky-Nouvelle-Calédonie.

- Le gouvernement bloque au dernier moment un plan pour réduire la consommation de viande des Français (lavoixdunord.fr)

La Stratégie nationale pour l’alimentation a été bloquée par les services du Premier ministre juste avant le vote de confiance de ce lundi. Sa publication était pourtant prête, après des mois de négociations.

- Juste avant de partir, François Bayrou a enchaîné les décisions anti-écologiques (reporterre.net)

- Avec la chute de François Bayrou, tous ces dossiers législatifs qui vont tomber à l’eau (huffingtonpost.fr)

Même sans dissolution de l’Assemblée nationale, la chute du gouvernement Bayrou a des conséquences sur certains textes législatifs, sur le plan calendaire mais pas uniquement.

- Indemnité, garde du corps, chauffeur… ces avantages que vont conserver Bayrou et ses ministres (ledauphine.com)

Spécial recul des droits et libertés, violences policières, montée de l’extrême-droite…

- « Pour Macron, les manifestations ne sont plus une expression de la démocratie » (politis.fr)

- Chute de Bayrou : « Un épisode de plus dans la dérive antidémocratique du macronisme » (reporterre.net)

- Laurent Mauduit : « Entre les patrons et l’extrême droite, ce ne sont plus des passerelles, mais de la porosité » (alternatives-economiques.fr)

- Après la chute de Bayrou, les plans du Rassemblement national (streetpress.com)

- Les images impressionnantes d’un immeuble en feu au cœur de Paris pendant le 10-septembre (huffingtonpost.fr)

Des manifestants ont scandé « bravo la police ! », selon des images filmées par l’AFP, et ont accusé les forces de l’ordre d’avoir lancé une grenade de gaz lacrymogène en direction du restaurant après une charge policière.

- « J’ai le droit de prendre un café ! » : Danielle Simonnet expulsée d’un café par la Brav-M (huffingtonpost.fr)

La députée du NFP Danielle Simonnet a été sortie d’un café ce mercredi 10 septembre à Paris, après s’y être réfugiée dans le cadre des mobilisations.