11.02.2026 à 16:27

La cinéaste Chloé Zhao, portraitiste de l’intimité du deuil

Joanne Vrignaud, Doctorante en cinéma américain à UPN, Université Paris Nanterre

Texte intégral (2660 mots)

Le dernier film de Chloé Zhao, Hamnet, est déjà un succès critique et populaire. Quatre ans après le succès mitigé de son film de commande les Éternels, la réalisatrice oscarisée revient avec une adaptation de l’œuvre de la romancière et journaliste britannique Maggie O’Farrell. Un drame qui met en lumière un thème central dans son cinéma : l’intimité du deuil.

Chloé Zhao s’est fait connaître dès ses débuts dans l’industrie en se formant sous l’égide de réalisateurs et d’acteurs engagés, comme Spike Lee ou Forrest Whittaker. Alors que les médias s’emparent de la question de l’alcoolisme dans les réserves amérindiennes, la Sino-Américaine part en 2015 filmer les riders (ces hommes qui pratiquent le rodéo) des nations lakotas du Dakota du Sud et en tire son premier long-métrage, Les chansons que mes frères m’ont apprises.

On y suit deux jeunes membres du clan des Oglalas dont la mort brusque du père entraîne une réflexion sur leur présence dans la réserve de Pine Ridge. Leur gestion différente du deuil, l’un par les questionnements sur la masculinité, l’autre par l’apprentissage culturel, se rejoint dans leur relation commune à la nature et devient le fil conducteur de l’histoire et, incidemment, de toutes les autres que Zhao développera.

Une esthétique intime fondée sur le lien avec la nature

En effet, dans Les chansons…, Johnny (17 ans) et Jashaun Winters (10 ans) sont sans cesse ramenés aux conséquences de la perte de leur père (un rider alcoolique), des difficultés économiques à l’opportunité de se tourner vers de nouveaux mentors, tout aussi violents et traumatisés par la vie dans une réserve. Si elle ne quitte jamais le domaine du réalisme social, la caméra s’attache aux moments de vulnérabilité : un premier baiser, un lever de soleil, un combat de boxe. L’ancrage des protagonistes dans la réserve est un cheminement émotionnel fait de plans rapprochés nous invitant à nous projeter dans leur univers mental. Les scènes sont douces, le son feutré, les plans longs : les dialogues laconiques dans la nature forment déjà la patte caractéristique (fortement inspirée par le réalisateur Terrence Malick) de l’esthétique de la réalisatrice.

Le film fait parler de lui au festival du cinéma indépendant de Sundance (Wyoming), et lui permet de réaliser son second film en 2017, The Rider. À nouveau, Zhao dézoome lentement sur l’expression endeuillée du jeune rider Brady Blackburn, interdit de monter à cause d’une terrible chute de rodéo, pour l’inscrire dans son environnement. Loin de l’esthétique épique des westerns traditionnels où selon l’historien Armando José Pratts, les cowboys, ranchers et bandits s’approprient les terres d’abord par le regard, puis par la force, ce cowboy sioux ne domine pas le sublime paysage qui l’entoure, laissant ses fantasmes de masculinité de cowboy dans le sillage de sa dernière course sur le dos de Gus. C’est là la théorie de l’intime de Zhao : se concentrer sur les regards plutôt que sur l’objet de ceux-ci et inscrire les personnages dans des environnements qui reflètent l’abondance de leur paysage intérieur.

Pouvoir thérapeuthique des grands espaces

Nomadland (oscarisé en 2021) s’inscrit dans des thèmes similaires (perte, questionnement identitaire, critique du capitalisme). Après avoir perdu son mari et son travail, Fern devient nomade pour fuir son passé. L’intime, comme toujours chez Zhao, se crée dans les dialogues minimes, une bande-son légère et des moments d’humanité poétisée. Zhao filme encore l’Ouest américain et le pouvoir thérapeutique des grands espaces sur Fern, en contraste avec son dénuement isolant dans le monde du travail. Quittant les tensions raciales et idéologiques du western, elle utilise les codes du road movie pour dramatiser le paysage (grands panoramas, lumières rasantes) au travers du regard de Fern, qui se fait camérawoman, utilisant des cailloux percés pour observer la même réserve de Pine Ridge. C’est par cet apprentissage de la vision artistique que Fern parvient à recréer du lien dans un système capitaliste et individualiste qui déchire l’Amérique profonde et à se remettre de son deuil. L’étape finale de son développement est le regard caméra soulagé de Fern quand on lui indique la sortie d’un labyrinthe naturel : l’intime se noue aussi par la relation à la spectatrice.

Zhao pose ainsi les fondements de son esthétique intimiste, qui lui sera reprochée dans le cadre épique d’un film Marvel comme les Éternels (2021). Les plans rapprochés et les longues séquences à l’épaule où les personnages baignent dans des lumières rasantes (les fameuses golden hours) reflètent le cheminement émotionnel des personnages. Il s’agit de lenteur, de gros plans, voire de très gros plans, sur des personnages sensibles, marginalisés et souvent ignorés par les films hollywoodiens, dont la tradition cinématographique peine encore à séparer la figure de l’autochtone de l’Indien des westerns ou à centrer des personnages féminins marginalisés.

« Hamnet », un monde naturel où seul l’intime survit

Avec Hamnet (2026), la relecture du mythe shakespearien se fait à l’aune de la perte, annoncée dans une myriade de symboles : l’oiseau de proie, un gouffre mystérieux, l’inondation, les scènes d’accouchement anxiogènes. La forêt forme l’épicentre de la vie et de la mort dont émergent les femmes de la lignée d’Agnes : c’est là qu’elle accouche, qu’elle rencontre puis perd son oiseau. Surtout, les boutures de la clairière, symbole de vie et de renaissance, sont replantées dans le jardin de la maisonnette, reconstituées sur la scène du Théâtre du Globe et dans les tapisseries des coulisses de l’au-delà où attend Hamnet.

La dichotomie stéréotypée entre Agnes, femme de la forêt, et William, génie littéraire, s’inscrit dans le cinéma de Zhao : alors que William se construit par le verbe (contre son père, en jouant avec ses enfants, sur scène), Agnes, comme Jashaun et Fern, est caractérisée par la mise en scène de son regard sur le monde naturel. L’art et la nature s’emmêlent à l’image du couple, comme dans les costumes en treille et paille des enfants jouant Macbeth.

Le pathos du film ne fait pas non plus l’unanimité auprès de la critique. En effet, Zhao ne laisse aucune distance s’établir entre les personnages et les spectatrices et spectateurs : le film foisonne sensoriellement, souligne les textures, capture les micro-expressions, remplit l’espace sonore de bruits de fonds discrets qui rendent les rares silences insoutenables.

Alors que le film commence sur des plans pied ou panoramiques, la caméra de Zhao se rapproche progressivement des visages à mesure qu’approche la disparition de l’enfant, jusqu’à finir sur les gros plans à l’épaule qui caractérisent l’agonie du fils et le cri de sa mère.

La caméra, suivant les dynamiques de l’intime propre au cinéma de Zhao, semble également représenter une puissance de vie et de mort : un très gros plan vacillant sur l’œil de William symbolise ses tendances suicidaires sur le quai, un regard caméra terrifié de Hamnet brise le quatrième mur quand il prend la place de sa sœur dans le lit de mort. Le regard spectateur, si intime dans Nomadland, se fait celui de la Faucheuse : nous, public presque voyeur, annonçons la scène finale ou l’acteur fantomatique d’Hamlet transcende la frontière de la mort et des planches en prenant la main d’Agnes.

Comme Jashaun, Fern ou Brady, Agnes redécouvre ses émotions au travers de la confrontation avec l’art et le toucher. En serrant la chair du pouce, Agnes perçoit les paysages secrets de ceux qu’elle aime, et c’est par la perte de ce contact que le couple se déchire dans le deuil de leur enfant. C’est donc également par ce toucher qu’Agnes rend universel le deuil de ce fils-personnage conjuré par les mots de son mari : une fois que les parents s’accordent sur la forme du deuil et que la mère a pu recréer de l’intime individuel avec les fantômes sur scène, les autres spectateurs se joignent à l’expérience de cette perte.

Joanne Vrignaud ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.02.2026 à 16:46

Le mystère de la « Dame à l’éventail », éclairé par une photo de Jeanne Duval

Maria C. Scott, Associate Professor of French Literature and Thought, University of Exeter

Texte intégral (1729 mots)

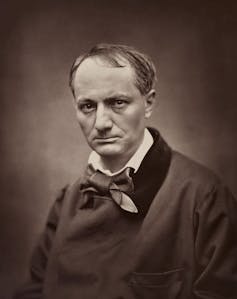

On sait très peu de choses au sujet de la comédienne haïtienne Jeanne Duval (1818-1868), compagne de Charles Baudelaire peinte par Manet, qui continue de fasciner les spécialistes de la littérature, de la peinture et du féminisme.

En mai 2025, je suis tombée sur une photographie extraordinaire sur le site Wikipedia anglais consacré à Jeanne Duval. Duval, originaire d’Haïti, était la maîtresse et muse de longue date, supposée n’avoir jamais été photographiée, du poète français Charles Baudelaire.

Le portrait, représentant une femme assise vêtue d’habits bourgeois raffinés, avait été publié sur Wikipédia par une étudiante de l’historienne de l’art Justine De Young. De Young évoque ce portrait comme un exemple d’auto-mise en scène dans son dernier ouvrage, The Art of Parisian Chic. Imprimée sur une petite carte (il s’agit d’un portrait-carte de visite, en vogue à l’époque) et datée du 18 août 1862, l’image a été découverte dans les archives françaises par une autre chercheuse, comme je l’ai mentionné dans un récent article publié par le Times Litterary Supplement, et documentée en ligne par elle en 2021.

Une photo redécouverte

Jeanne Duval fascine de nombreuses chercheuses et chercheurs experts du féminisme et du postcolonialisme, en partie parce que l’on sait très peu de choses précises à son sujet. Intriguée, je me suis rendue moi-même aux archives à l’été 2025, juste pour voir la photo. Là, j’ai remarqué une deuxième photo au format carte de visite à côté de la première. Elle portait le même nom, « Jeanne », la même date, et provenait du même studio de photographie, l’atelier Nadar. Les deux cartes avaient été inscrites au registre du dépôt légal sous la mention « idem ».

À lire aussi : Les femmes censurées des « Fleurs du mal »

Cette deuxième Jeanne se tient debout, dans une pose inhabituellement rigide pour une photographie de ce type. Elle porte une robe de soirée à épaules dénudées et ses cheveux tombent en cascade dans son dos, retenus sur le front par un simple bandeau.

Une inspiration pour Manet ?

Une version numérique haute résolution de cette image a révélé de fortes ressemblances avec le modèle de la première photographie, similitudes qui n’étaient pas immédiatement apparentes sur les petites cartes. Les deux photos révèlent une implantation capillaire similaire, une même imperfection sur le front et une bague au même doigt. Il était clair que si la première photographie représentait Duval, celle-ci aussi.

Cependant, le crucifix porté en pendentif sur une chaîne courte et les grandes boucles d’oreilles m’ont semblé particulièrement intéressants. Des bijoux très similaires sont en effet portés par le modèle dans le portrait d’Édouard Manet intitulé Dame à l’éventail (1862), également connu sous le nom de la Maîtresse de Baudelaire allongée. Ce dernier titre avait été inscrit au dos du tableau à un moment donné, soit pendant, soit avant l’inventaire posthume de l’atelier de l’artiste.

La pose maladroite et l’expression faciale impénétrable du modèle ont souvent été interprétées comme faisant référence aux difficultés et à la maladie que Duval endurait à l’époque. Elle se trouvait dans une situation financière désastreuse et souffrait d’une paralysie du côté droit depuis un accident vasculaire cérébral survenu en 1859. Cependant, l’identification du modèle de Manet comme étant Duval est parfois contestée par les chercheurs, pour plusieurs raisons.

Le portrait sur carte de « Jeanne » debout, réalisé la même année que le portrait à l’huile et son étude à l’aquarelle, présente des traits, une expression et des ombres très similaires. Les historiens de l’art Griselda Pollock et Therese Dolan ont émis l’hypothèse que Manet s’était inspiré d’une photographie ou d’une carte de visite de Duval pour réaliser Dame à l’éventail. Les liens entre la photographie de Jeanne debout et les portraits à l’huile et à l’aquarelle de Manet semblent confirmer que Duval est le sujet des deux peintures (aquarelle et huile) et des deux photographies.

Pourquoi ces photographies ont-elles été prises ?

Duval posait-elle donc pour Manet dans ces photographies ? Il convient de noter que Manet, Félix Nadar (le propriétaire du studio de photographie) et Baudelaire étaient tous des amis proches, et que Duval s’était séparée du poète, apparemment de manière définitive, en 1861.

Duval a peut-être proposé de poser, ou a été invitée à poser pour les photographies de Nadar (et indirectement pour Manet, qui travaillait souvent à partir de photographies) en échange d’argent. Nous savons qu’elle avait approché au moins un autre ami de Baudelaire en 1862 pour essayer de lui vendre les biens du poète. Le fait qu’elle tienne une cravache sur la photographie avec le crucifix vient étayer l’hypothèse de la monétisation. Peut-être espérait-elle, ou espéraient-ils, que le portrait sur carte de la muse sadique/angélique du recueil de poèmes de Baudelaire les Fleurs du mal (1857) aurait une valeur marchande.

Il est également possible que Baudelaire ait commandé des portraits de son ancienne maîtresse à des fins personnelles. Malgré sa colère et son ressentiment envers Duval après leur séparation, ses lettres et ses croquis témoignent de sa loyauté et de son affection persistantes.

Ou peut-être Duval souhaitait-elle rétablir la vérité sur qui elle était. Peut-être voulait-elle que le monde sache qu’elle n’était en fait pas la muse diabolique et sexualisée au centre du volume de poésie scandaleux de Baudelaire, mais plutôt quelqu’un qui s’habillait avec des vêtements élégants et respectables (probablement empruntés) comme on le voit sur la première photographie.

Peut-être que le crucifix et la bague visible à l’annulaire des deux photos avaient également pour but de témoigner de ses valeurs morales. Cependant, certains détails de la deuxième image, notamment la cravache, les épaules nues et les grandes boucles d’oreilles, suggèrent que sa volonté n’était pas de se donner une image « respectable ».

Il est probable que les portraits-cartes de visite, s’ils représentent bien Jeanne Duval, aient été motivées par des raisons financières, qu’elles aient été son idée ou celle de Nadar, Manet ou Baudelaire. Il est également possible que la mise en scène de soi ait fait partie de son objectif, mais si tel est le cas, le message qu’elle voulait faire passer n’est pas clair.

Des chercheurs français ont récemment découvert que Duval était morte dans un hospice six ans seulement après la réalisation de ces portraits. Jusqu’alors, personne ne semblait savoir ce qu’elle était devenue. Ces photographies témoignent, du moins à mes yeux, de la résistance de Duval à se laisser cataloguer et de sa dignité tranquille.

Maria C. Scott publiera prochainement un article universitaire sur ce sujet dans la revue French Studies.

09.02.2026 à 23:08

En Mésopotamie, le rôle très important des personnes trans

Chaya Kasif, PhD Candidate; Assyriologist, Macquarie University

Texte intégral (2998 mots)

Loin d’être marginalisées, certaines personnes de genre atypique jouaient un rôle central dans le culte, la politique et l’armée en Mésopotamie, montrant une forme ancienne de reconnaissance sociale.

Aujourd’hui, les personnes trans font face à une politisation de leur vie et à la diabolisation par des politiciens, certains médias et une partie de la société. Mais dans quelques-unes des premières civilisations de l’histoire, ces personnes étaient reconnues et comprises de manière totalement différente.

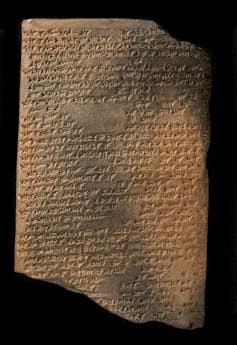

Dès 4 500 ans avant notre ère, en Mésopotamie dans le Proche-Orient ancien par exemple, des rôles sociaux importants, avec des titres professionnels majeurs, étaient dévolus aux personnes de genre atypique. Notamment les serviteurs cultuels de la grande divinité Ištar, appelés assinnu, et les hauts courtisans royaux appelés ša rēši. Des preuves antiques montrent que ces personnes occupaient des positions de pouvoir en raison de leur ambiguïté de genre, et non malgré elle.

La Mésopotamie

La Mésopotamie est une région qui correspond aujourd’hui principalement à l’Irak et à des régions de la Syrie, de la Turquie et de l’Iran. Faisant partie du Croissant fertile, le mot « Mésopotamie » vient du grec et signifie littéralement « terre entre deux fleuves », l’Euphrate et le Tigre.

Pendant des milliers d’années, plusieurs grands groupes culturels y ont vécu. Parmi eux, les Sumériens, puis plus tard les groupes sémitiques appelés Akkadiens, Assyriens et Babyloniens.

Les Sumériens ont inventé l’écriture en traçant des coins sur des tablettes d’argile. L’écriture, appelée cunéiforme, a été créée pour transcrire la langue sumérienne, mais les civilisations suivantes l’ont utilisée pour écrire leurs propres dialectes de l’akkadien, la plus ancienne langue sémitique.

Qui étaient les assinnu ?

Les assinnu étaient les serviteurs religieux de la grande déesse mésopotamienne de l’amour et de la guerre, Ištar.

Reine des cieux, Ištar a précédé Aphrodite et Vénus.

Connue des Sumériens sous le nom d’Inanna, cette déesse guerrière détenait le pouvoir politique ultime et conférait leur légitimité aux rois. Elle veillait également sur l’amour, la sexualité et la fertilité. Dans le mythe de son voyage aux Enfers, sa mort entraîne la fin de toute reproduction sur Terre. Pour les Mésopotamiens, Ištar était l’une des plus grandes divinités du panthéon. L’entretien de son culte officiel garantissait la survie de l’humanité.

Ses serviteurs, les assinnu, avaient la responsabilité de la satisfaire et de s’occuper d’elle par le biais de rituels religieux et de l’entretien de son temple. Le titre même d’assinnu est un mot akkadien lié à des termes signifiant « féminin », « homme-femme » ainsi que « héros » et « prêtresse ».

Leur fluidité de genre leur venait directement d’Ištar. Dans un hymne sumérien, la déesse est décrite comme ayant le pouvoir de :

transformer un homme en femme et une femme en homme,

changer l’un en l’autre,

habiller les femmes avec des vêtements d’hommes,

habiller les hommes avec des vêtements de femmes,

mettre des fuseaux dans les mains des hommes,

et donner des armes aux femmes.

Les assinnu ont d’abord été considérés par une partie des historiens comme un type de travailleur·se religieux·se sexuel·le. Une conception qui repose sur des hypothèses anciennes concernant les groupes transgenres et qui n’est pas fortement étayé par les preuves.

Le titre est aussi souvent traduit par « eunuque », bien qu’il n’existe aucune preuve claire qu’il se soit agi d’hommes castrés. Si le titre est principalement masculin, il existe des preuves d’assinnu féminines. En réalité, divers textes montrent une résistance à la binarité de genre.

Leur importance religieuse leur attribuait des pouvoirs magiques et de guérison. Une incantation dit :

Que ton assinnu se tienne à mes côtés et retire ma maladie. Qu’il fasse sortir par la fenêtre la maladie qui m’a saisi.

Un présage néo-assyrien indique également que des relations sexuelles avec un assinnu pouvaient procurer des avantages personnels :

Si un homme s’approche d’un « assinnu » pour avoir des relations sexuelles, les interdits à son égard seront assouplis.

En tant que dévots d’Ištar, ils exerçaient également une forte influence politique. Un almanach néo-babylonien indique :

le [roi] doit toucher la tête d’un « assinnu », il vaincra son ennemi

et son pays obéira à ses ordres.

Ayant vu leur genre transformé par Ištar elle-même, les assinnu pouvaient marcher entre le divin et le mortel tout en veillant au bien-être des dieux et de l’humanité.

Qui étaient les « ša rēši » ?

Généralement décrits comme des eunuques, les ša rēši étaient des serviteurs du roi. Les « eunuques » de cour ont été recensés dans de nombreuses cultures au fil de l’histoire. Cependant, le terme n’existait pas en Mésopotamie, et les ša rēši avaient leur propre titre distinct.

Le terme akkadien ša rēši signifie littéralement « un de la tête » et désigne les courtisans les plus proches du roi. Leurs fonctions au palais étaient variées, et ils pouvaient occuper plusieurs postes de haut rang simultanément.

Les preuves de leur ambiguïté de genre sont à la fois textuelles et visuelles. Plusieurs textes les décrivent comme infertiles, comme une incantation qui dit :

Comme un « ša rēši » qui n’engendre pas, que ton sperme se dessèche !

Les ša rēši sont toujours représentés imberbes, en contraste avec un autre type de courtisan appelé ša ziqnī (« celui qui a une barbe »), qui avait des descendants. Dans les cultures mésopotamiennes, la barbe symbolisait la virilité ; un homme imberbe allait donc directement à l’encontre de la norme. Pourtant, des bas-reliefs montrent que les ša rēši portaient les mêmes vêtements que les autres hommes royaux, leur permettant ainsi d’afficher leur autorité aux côtés des autres élites masculines.

L’une de leurs fonctions principales était de superviser les quartiers des femmes dans le palais – un lieu à accès très restreint – où le seul homme autorisé à entrer était le roi lui-même.

Étant si étroitement liés au roi, ils pouvaient non seulement occuper des fonctions martiales comme gardes et conducteurs de char, mais aussi commander leurs propres armées. Après leurs victoires, les ša rēši se voyaient attribuer des biens et la gouvernance de territoires nouvellement conquis, comme en témoigne l’inscription royale en pierre que l’un d’eux s’est fait ériger.

Grâce à leur fluidité de genre, les ša rēši pouvaient transcender non seulement les limites de l’espace genré, mais aussi celles séparant le souverain de ses sujets.

La fluidité de genre comme outil de pouvoir

Alors que les premiers historiens considéraient ces figures comme des « eunuques » ou des « travailleur·ses religieux·ses sexuel·les », les preuves montrent que c’est parce qu’ils vivaient en dehors de la binarité de genre que ces groupes pouvaient occuper des rôles puissants dans la société mésopotamienne.

Reconnaître aujourd’hui l’importance des personnes trans et de genre divers dans nos communautés, est, en quelque sorte, une continuité du respect accordé à ces figures anciennes.

Chaya Kasif ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

09.02.2026 à 23:07

Au Moyen Âge, les femmes prenaient (aussi) la plume

Justine Audebrand, Chercheuse associée au Laboratoire de médiévistique occidentale de Paris (UMR 8589), post-doctorante à l'Institut Historique Allemand, Université Paris 1 Panthéon-Sorbonne

Texte intégral (2056 mots)

Au Moyen Âge, l’alphabétisation se décline en une palette de situations : savoir lire ne signifie pas qu’on est capable de composer un texte. Seule une petite élite maîtrise l’écriture. Mais dans cette élite, il y a des femmes. Qui étaient-elles ? Et dans quels types d’écrits se sont-elles illustrées ?

Le Moyen Âge apparaît souvent comme une période sombre pour les femmes : cloîtrées dans d’obscurs monastères ou soumises à leur mari, elles auraient été tenues écartées du pouvoir et de toute forme de culture écrite.

Ce cliché, comme beaucoup d’autres, sur les prétendus temps obscurs, apparaît à la Renaissance et se développe dans l’esprit des Lumières. Or, durant les six siècles qui suivent la fin de l’Empire romain, la condition féminine est très éloignée de cet imaginaire collectif. Dans les sphères du pouvoir ou du savoir, certaines femmes tiennent alors une place éminente, qui n’est pas tout à fait la même que ce que l’on verra entre les XIIᵉ et XVᵉ siècles.

Le Moyen Âge est une longue période et de nombreuses reconfigurations politiques, économiques ou religieuses changent et affectent la condition des femmes : celles de la fin de la période sont plus connues car nous possédons davantage de sources, mais celles du début ont parfois accès à des ressources économiques ou culturelles inattendues.

Les femmes ont aussi pris part à la culture de leur temps, c’est que montrent les recherches mises en avant dans la Vie des femmes au Moyen Âge. Une autre histoire VIᵉ-XIᵉ siècle (Perrin, 2026). À une époque où l’alphabétisation était faible, c’est parfois par les femmes que se transmettait la maîtrise de la lecture et de l’écriture.

Apprendre à écrire

Pour écrire, il faut bien sûr avoir appris le geste technique qui consiste à tracer des lettres sur du parchemin. Aujourd’hui, lecture et écriture s’apprennent ensemble mais, au Moyen Âge, beaucoup de personnes savent lire sans pour autant être capables d’écrire, si ce n’est leur nom.

L’alphabétisation médiévale se pense d’ailleurs comme un spectre : il y a un monde de pratiques entre savoir lire et être capable de composer un texte complexe en latin. De ce fait, la maîtrise complète de l’écriture est réservée à une petite élite, laïque ou ecclésiastique, et de plus en plus à des professionnels de l’écrit comme les notaires qui gagnent en importance à partir du XIIᵉ siècle. Par ailleurs, les laïcs les plus susceptibles d’avoir appris à lire et à écrire disposent aussi de secrétaires : au début du Moyen Âge par exemple, les aristocrates n’écrivent pas eux-mêmes leurs lettres mais les dictent à des secrétaires, voire ne leur donnent que quelques indications.

Les femmes ne sont pas exclues de ces logiques, bien au contraire. Dans l’aristocratie laïque de la première moitié du Moyen Âge, il n’est pas rare qu’elles reçoivent une éducation poussée.

La raison en est simple : elles sont bien souvent elles-mêmes en charge de l’éducation de leurs enfants. La reine Mathilde, épouse du roi de Germanie Henri Ier (919-936), sait par exemple lire et écrire, ce qui n’est pas le cas de son royal époux et, dans la famille ottonienne (du nom de leur fils, le roi puis empereur Otton Ier), ce sont souvent les femmes qui sont les plus lettrées.

Copistes et autrices

Ce n’est pourtant pas chez les laïcs mais au sein des monastères féminins que l’on trouve le plus de femmes qui savent écrire. L’acte le plus courant est la copie de manuscrits : avant l’invention de l’imprimerie, c’est cet inlassable travail qui permet la diffusion des œuvres.

On estime qu’environ 1 % des manuscrits médiévaux ont été copiés par des femmes. Cela peut paraître infime, mais il faut avoir en tête que l’immense majorité des manuscrits ne sont pas signés par leurs copistes et qu’on ne peut donc en réalité que rarement connaître le genre du ou de la copiste. Le travail des moniales est en tout cas loin d’être déconsidéré : à la fin du VIIIᵉ siècle, les nonnes de Chelles sont les principales pourvoyeuses en copies d’Augustin d’Hippone, un des pères de l’Église les plus lus au Moyen Âge. Elles reçoivent notamment des commandes des évêques de Cologne et de Wurtzbourg.

Il est donc logique que ce soit aussi dans les monastères que l’on trouve le plus d’autrices, c’est-à-dire de femmes qui ne se contentent pas de copier des œuvres et en composent de nouvelles. Aucun genre littéraire ne leur est interdit : elles écrivent de l’hagiographie – la vie de saints, hommes et femmes –, des textes annalistiques, des traités, de la poésie et même du théâtre.

La dramaturge et poétesse Hrotsvita, qui vit au monastère de Gandersheim (en Saxe) autour de 960, est ainsi considérée comme la « première poétesse allemande » même si elle écrit, comme la plupart de ses contemporains, en latin.

Une écriture « féminine » ?

Ces textes de femmes ont été étudiés de diverses manières par les historiens, d’abord avec un brin de suspicion : quand les œuvres de Hrotsvita ont été redécouvertes au XIXᵉ siècle, d’éminents savants ont douté de leur attribution et ont cherché, en vain, à affirmer que la moniale n’avait jamais existé, ou jamais écrit…

Et ce n’est que dans les années 1980 que les spécialistes du Moyen Âge ont véritablement commencé à s’intéresser aux écrits des femmes médiévales d’avant Christine de Pizan. Ces travaux sont marqués par l’idée que l’écriture des hommes serait différente de celle des femmes. Il ne s’agit pas de l’écriture manuscrite, paléographique, puisque la différenciation genrée n’apparaît qu’au XVIIIᵉ siècle, mais du style.

Les femmes, même au Moyen Âge, parleraient plus facilement de leurs émotions et de leur famille. C’est sans doute vrai dans certains textes mais, en réalité, les textes écrits par des femmes montrent plus de similitudes que de différence avec ceux des hommes. Cela est dû, en partie, au poids des modèles anciens dans l’écriture médiévale : quand la moniale Baudonivie écrit la vie de la sainte reine Radegonde vers 600, elle a en tête le modèle par excellence qu’est la Vie de saint Martin, tout comme son contemporain Venance Fortunat qui consacre aussi un texte à la sainte.

Pour autant, en particulier à partir des XIIᵉ et XIIIᵉ siècles, il semble que l’écriture des femmes soit de plus en plus contrainte et que cela les cantonne parfois à certains types d’écrits. La grande réforme de l’Église connue sous le nom de réforme grégorienne cherche à mieux encadrer les pratiques des fidèles et à redéfinir le lien des femmes au sacré. Le développement des universités – réservées aux clercs et donc aux hommes – exclut aussi les femmes de tout un pan du savoir.

C’est dans ce cadre que fleurissent les femmes mystiques, dont les écrits vantent une proximité particulière avec la divinité. Mais là encore, la réalité est complexe : les visions de ces femmes sont souvent mises par écrit par leur confesseur ou un homme qui peut retravailler la matière transmise par la mystique. Même Hildegarde de Bingen, grande savante et abbesse du XIIᵉ siècle, a recours à un secrétaire. Au Moyen Âge, l’idée d’un auteur ou d’une autrice unique fonctionne rarement, et l’écrit des femmes comme celui des hommes fait souvent appel à une multitude d’intervenants ou intervenantes.

Justine Audebrand ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

09.02.2026 à 15:59

La statue de la Liberté (1886-2026) : un anniversaire sous tension

Laurence Nardon, responsable du programme Amériques, IFRI (Institut français des relations internationales)

Texte intégral (1305 mots)

Cet article est publié en partenariat avec France Inter. Retrouvez Laurence Nardon, spécialiste de la politique américaine, dans le podcast « L’épopée de Lady Liberty », qui relate l’histoire épique de la statue de la Liberté, une idée française devenue le symbole de l’Amérique. Au fil des dix épisodes de ce poscast, Philippe Collin propose un long voyage dans le temps, un récit mouvementé à travers une amitié transatlantique autour de valeurs à défendre.

L’année 2026 marque les 140 ans de l’inauguration de la statue de la Liberté à New York, le 28 octobre 1886. Cette figure majestueuse, installée sur une île à l’embouchure de l’Hudson, est l’un des monuments préférés des New-Yorkais et des touristes, accueillant quatre millions de visiteurs par an. Au cours du temps, elle a su symboliser tour à tour la libération des esclaves et le triomphe de la république à l’issue de la guerre de Sécession (1861-1865), l’accueil des immigrants et le progrès social dans les années 1930, la lutte du « monde libre » et des démocraties libérales contre le totalitarisme pendant la guerre froide, ou encore la résilience de la ville après les attentats du 11-Septembre…

Cadeau de la France aux États-Unis, Lady Liberty incarne aussi le lien entre ces deux pays. Sa construction est imaginée en 1865 par un groupe d’amis français sous la houlette du professeur de droit Édouard de Laboulaye et du sculpteur Auguste Bartholdi, qui souhaitent célébrer la démocratie libérale américaine au lendemain de la guerre de Sécession. Leur projet exprime plus largement leur adhésion aux valeurs des Lumières et, implicitement, une critique du régime impérial de Napoléon III. Il mettra plus de vingt ans à se réaliser. Grâce à la vente de produits dérivés et aux dons du grand public des deux côtés de l’Atlantique, la statue elle-même est financée par la France, son socle par les Américains.

Une amitié franco-américaine compromise par le populisme trumpiste

La commémoration de son inauguration aurait pu donner lieu cette année à une célébration conjointe de l’amitié franco-américaine, d’autant plus qu’une autre date anniversaire se profile en 2026, celle de la Déclaration d’indépendance. Proclamée le 4 juillet 1776, cette dernière aura cette année 250 ans. On sait que la France a été le premier allié déclaré des rebelles nord-américains, dépêchant Lafayette, Rochambeau et l’amiral de Grasse à la tête de 10 000 hommes pour aider les révolutionnaires dans leur combat pour l’indépendance. On aurait donc pu imaginer dans les mois qui viennent des discours, des fleurs et des embrassades sincères devant la tombe de Lafayette au cimetière de Picpus et devant celle de Bartholdi au cimetière du Montparnasse.

Hélas, les relations entre Paris et Washington se sont dégradées depuis le retour au pouvoir de Donald Trump en janvier 2025. À vrai dire, l’hostilité de la Maison-Blanche ne concerne pas seulement la France, mais toute l’Europe. Les hausses de droits de douane, les désaccords sur le soutien à l’Ukraine et le projet d’achat du Groenland refusé par le Danemark ne sont que les manifestations concrètes d’une remise en cause beaucoup plus fondamentale : la contestation idéologique du modèle libéral hérité des Lumières par le camp populiste MAGA (Make America Great Again) autour du président Trump. À Munich en février 2025, le vice-président J. D. Vance a ainsi dénoncé le « déclin civilisationnel » du Vieux Continent via le « wokisme » et l’immigration, laissant stupéfait le parterre d’Européens auquel il s’adressait.

Affirmer l’espoir de jours meilleurs

Dans ce contexte, les Européens n’ont désormais plus d’autre choix que de se penser seuls. C’est un choc pour certains de nos voisins : ceux qui sont très proches culturellement des États-Unis, comme la Grande-Bretagne, ou ceux qui se perçoivent comme particulièrement vulnérables vis-à-vis de la Russie, tels que la Pologne ou les pays baltes. Ces derniers avaient compris les avancées russes, de l’annexion de la Crimée en 2014 à l’invasion de l’Ukraine en 2022, comme la preuve qu’il fallait absolument maintenir la protection américaine, impliquant un alignement politique et stratégique, l’achat d’armements américains, etc. Le fait que les États-Unis de Trump soient devenus une puissance menaçante pour le Vieux Continent conduit ces mêmes pays européens à modifier en profondeur leur approche sécuritaire.

Cette rupture est sans doute plus facile à penser pour la France, qui a été historiquement habituée aux frictions avec Washington – c’est pour garantir son indépendance qu’elle a, avant même le retour de de Gaulle au pouvoir en 1958, lancé son propre programme de bombe nucléaire. La situation actuelle entraîne en tout cas des propositions inédites. Ainsi, le premier ministre canadien a proposé, lors du sommet de Davos de janvier 2026, que les puissances moyennes s’unissent pour tenir tête aux grandes puissances inamicales ou devenues inamicales. Si l’on considère qu’une telle alliance existe déjà avec l’Union européenne, cette dernière doit désormais avancer résolument dans la voie de la puissance géopolitique.

Mais sans doute faut-il aussi garder à l’esprit que le populisme trumpiste ne sera qu’un moment, peut-être un cycle, de l’histoire des États-Unis. La société civile américaine a connu deux cent cinquante ans de pratique démocratique ininterrompue et compte dans ses rangs une majorité de personnes « décentes ». Ces dernières auront du mal à accepter un glissement durable vers l’illibéralisme et l’agressivité internationale. Tocqueville ajoute encore que les Américains sont finalement peu intéressés par les passions politiques, tendant à se retirer tôt ou tard dans leur sphère privée.

Dès lors, les symboles conservent toute leur importance. Célébrer cette année la statue de la Liberté et les valeurs qu’elle incarne, c’est aussi affirmer l’espoir de jours meilleurs pour les États-Unis comme pour leurs alliés.

Laurence Nardon ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

07.02.2026 à 14:01

« Hamnet » ou le roman d’une femme puissante

Armelle Parey, Professeur de littératures de langue anglaise, Université de Caen Normandie

Texte intégral (1425 mots)

La sortie du film Hamnet de Chloé Zhao et son grand succès critique sont l’occasion de revenir au roman éponyme, publié par la romancière britannique Maggie O’Farrell en 2020, et à la façon dont ce récit met en lumière des personnages en marge de l’histoire littéraire, en particulier l’épouse de Shakespeare, Agnes (dite Anne) Hathaway.

Ce qui frappe probablement le plus sur l’affiche du film Hamnet, outre sa très belle photographie, est ce titre qui ne manque pas d’interpeller le passant ou la passante par sa quasi-homophonie avec Hamlet, l’un des plus célèbres titres et personnages de William Shakespeare. L’affiche, qui représente un couple, nous promet d’ailleurs « L’histoire méconnue qui a inspiré le plus grand chef-d’œuvre de Shakespeare ». En effet, Hamnet est le prénom du fils du dramaturge et le film comme le roman développent la thèse selon laquelle c’est à ce garçon décédé à l’âge de 11 ans pour des raisons inconnues que l’on devrait indirectement Hamlet et, probablement, la Nuit des rois.

Si le point d’orgue du roman est la mort d’Hamnet qui intervient à la moitié du volume et à ses effets sur sa famille, la véritable protagoniste est la mère de l’enfant et épouse de Shakespeare, généralement connue sous le nom d’Anne Hathaway. Dans le scénario du film co-écrit par O’Farrell, comme dans l’adaptation théâtrale proposée par Lolita Chakrabarti en 2023, le propos est quelque peu infléchi pour donner une part plus importante au personnage du dramaturge qui reste en retrait, jamais nommé, dans le roman. Dans Hamnet, Anne Hathaway est Agnes, son nom de naissance, O’Farrell signalant ainsi dès le début que son récit se détache des portraits négatifs et infondés dressés jusqu’au XXe siècle dans des biographies et des romans qui représentaient cette femme dont l’on ne sait pourtant presque rien en prédatrice âgée et ignare. Après une étude exhaustive de ce que l’on sait d’Anne, Katherine West Scheil, professeure de littérature anglaise, a montré la variété des récits faits sur la conjointe de Shakespeare au fil des siècles en fonction des évolutions culturelles, jusqu’à des romances récentes qui font d’elle une influence majeure dans la production shakespearienne.

Un récit alternatif et vraisemblable

Tout en restant dans les limites du vraisemblable, O’Farrell élabore dans Hamnet un récit alternatif plus juste envers cette femme, rappelant qu’elle était en fait un bon parti pour les Shakespeare endettés auprès de la famille Hathaway. O’Farrell cite parmi ses sources la féministe Germaine Greer qui revient sur les interprétations négatives des biographes qui attribuent par exemple les années passées par Shakespeare loin de sa famille au désir d’être éloigné de sa femme, négligeant le fait qu’il prend le soin de l’installer dans la plus grande maison des environs… Greer suggère que cette séparation peut très bien avoir été une décision conjointe puisque Anne n’a pas dénoncé son époux pour avoir déserté le domicile conjugal comme cela aurait été possible. O’Farrell va plus loin en montrant que c’est Agnes qui organise le départ de son mari pour Londres, lui permettant ainsi d’écrire, consciente qu’il étouffe à Stratford dans l’atelier d’un père violent, gantier de son état.

« Le romancier est l’interprète du mystère », dit l’historienne et essayiste Mona Ozouf. C’est en effet le propre du roman en général que de combler les blancs de l’histoire, d’imaginer ce que ce que l’on ne sait pas. O’Farrell utilise la liberté permise par la fiction pour questionner la mémoire officielle qui s’est cristallisée autour du personnage de la femme de Shakespeare et envisager des alternatives.

Lorsqu’elle apparaît de loin au jeune précepteur pour la première fois dans le roman, Agnes est prise pour un garçon, signe d’un caractère transgressif et en dehors des normes souligné tout au long du roman à tel point qu’on la dit folle ou fille d’une sorcière. L’Agnes imaginée par O’Farrell est bien une femme puissante. Certes illettrée, elle est dotée d’une connaissance du monde de la nature qui lui permet de fabriquer des remèdes pour soigner les autres doublé d’un don de prémonition. Inventive et pragmatique, elle sait qu’une grossesse est le moyen de forcer les 2 familles à accepter leur union.

Une évocation féministe du passé

Cette mise au premier plan d’un personnage très secondaire de l’histoire littéraire ne se fait pas aux dépens du poète et dramaturge. Désigné par ses différents rôles dans la vie ordinaire (précepteur de latin, père, mari, etc.) le personnage de Shakespeare est en marge du roman qui explore dans sa deuxième partie la douleur de la mère. Le roman (comme le film) culmine cependant avec la représentation finale d’Hamlet qui permet la réconciliation d’un couple séparé par la perte de leur enfant lorsque Agnes succombe à « l’alchimie » ou illusion théâtrale grâce à laquelle elle retrouve son fils sur scène. Hamnet contextualise l’écriture d’Hamlet et interprète la pièce comme un hommage certain, bien qu’indirect, au fils disparu ; le roman célèbre également le pouvoir de l’art à rendre compte de l’expérience humaine et à offrir du réconfort. Enfin, à travers la réaction finale d’Agnes à la représentation de la pièce, le lecteur est convaincu du talent artistique supérieur de Shakespeare et de son génie des mots.

Quand elle imagine ces histoires de vies ordinaires négligées ou déformées, O’Farrell sauve Hamnet de l’invisibilité et Anne Hathaway de son assujettissement à des rôles négatifs ou improbables. En outre, en se concentrant sur Agnes et les activités quotidiennes des femmes, O’Farrell souligne également l’absence de traces écrites de l’expérience domestique. Dans une certaine mesure, son évocation féministe du passé complète les archives historiques en réinsérant les activités domestiques d’Agnes et des autres personnages féminins dans le récit.

En comblant les lacunes de la mémoire et en soulignant l’impact d’une figure mineure comme Hamnet Shakespeare, en réparant les dommages indûment causés à la réputation d’Agnes Shakespeare, en donnant vie et voix aux invisibles ou personnages perçus comme mineurs, Hamnet s’inscrit dans la lignée du roman historique contemporain et du roman biographique qui réorientent la mémoire culturelle.

Armelle Parey ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

05.02.2026 à 16:31

Parlez-vous l’« algospeak » ? Les dessous d’une néologie particulière

Anne Gensane, Chercheuse en sciences du langage, Université d'Artois

Texte intégral (1657 mots)

Aujourd’hui, les contenus en ligne sont massivement surveillés par des algorithmes chargés de filtrer ce qui est jugé sensible ou contraire aux règles des plateformes (propos injurieux ou insultes). Pour continuer à s’exprimer malgré ces restrictions, les internautes ont développé ce que l’on appelle désormais l’« algospeak ». Mais exprimer quoi ? Comment ? Pourquoi ? Et à quel prix ?

Le mot « algospeak » est formé des termes anglais algo, troncation d’« algorithme », et speak, « parler ». À ce jour, il reste cependant un néologisme non référencé dans les dictionnaires généralistes les plus connus. Il désigne un ensemble de pratiques linguistiques consistant à modifier volontairement la forme ou le sens des mots afin d’évoquer des sujets considérés comme problématiques par les plateformes en échappant à la détection automatisée. Du point de vue de la néologie (analyse de la (re)création des mots), on parle de « néologismes de forme » (modifications graphiques, substitutions phonétiques…) et de « néosémies » (glissements ou détournements de sens).

L’objectif de l’algospeak est double. Il s’agit, d’une part, d’éviter des sanctions telles que la suppression du contenu ou même du compte ; d’autre part, de rester compréhensible par les autres utilisateurs. Il ne s’agit pas seulement d’inventer de nouveaux mots, mais de négocier en permanence avec des systèmes de contrôle automatisés.

Comment parler « algo » ?

Les travaux anglophones consacrés à l’algospeak sont relativement nombreux. Nous pouvons notamment trouver des recensements de termes observés. En revanche, les études francophones restent lapidaires ; c’est pourquoi la constitution de corpus spécifiques représente aujourd’hui un enjeu majeur pour la recherche en néologie (et en argotologie contemporaine). Nous recherchons activement des informateurs pour nous aider à finaliser une typologie.

Concrètement, comment contourne-t-on un filtre lexical en français ?

Un émoji (🍆) peut se substituer à un mot, une graphie peut être altérée en remplaçant des lettres par des chiffres (la « v10lence »), ou en lui incorporant des points entre chaque lettre (le s.u.i.c.i.d·e), des astérisques peuvent remplacer des lettres (le v***) voire peuvent être finalement supprimées : il est possible de nommer avec une seule lettre (le V). Des périphrases et des métaphores peuvent permettre, également, d’évoquer indirectement certaines réalités. Nous pourrions ajouter que dans les contenus audiovisuels, un bip sonore peut masquer un terme problématique (comme une image peut être brièvement floutée afin de préserver la visibilité d’une vidéo).

La compréhension de ces messages suppose une compétence interprétative particulière. Le destinataire doit être capable d’assembler différents indices et de reconnaître des conventions implicites. L’algospeak repose ainsi sur une forme de connivence linguistique, où la compréhension n’est jamais totalement garantie.

Argot et « algo »

À bien des égards, l’algospeak peut sembler familier : il n’est pas sans rappeler des formes connues de création ou d’innovation linguistique. Il fait par exemple penser aux formes scripturales du célèbre « langage SMS » d’antan…

Mais surtout, il présente des affinités avec les pratiques argotiques néologiques qui reposent elles aussi sur le détournement du sens et de la forme des mots afin de permettre une communication entre initiés. Dans ces deux cas, il s’agit d’une néologie fonctionnelle : le langage est transformé pour répondre à une contrainte précise.

Cependant, il nous faut nommer ici au moins deux différences majeures qui distinguent l’algospeak de l’argot « classique ». D’abord, l’argot est de tradition orale, au contraire de l’algospeak. Ensuite, la contrainte n’est plus principalement sociale, mais algorithmique. Là où l’argot visait souvent à se distinguer d’un groupe dominant ou à exclure en tout cas certains interlocuteurs humains, l’algospeak cherche avant tout à devenir invisible pour des systèmes d’intelligence artificielle.

Les locuteurs ne cherchent pas nécessairement à marquer une identité collective forte, mais à rendre leurs propos indétectables par des dispositifs dont les règles sont changeantes et rarement explicitées. Il s’agit de dire autrement ce qui ne peut plus être dit directement.

Un caractère éphémère ?

L’algospeak est, par définition, un langage éphémère. Dès qu’une expression est repérée par un filtre automatique, il perd sa valeur stratégique et doit être remplacé. On peut ainsi parler d’une véritable obsolescence programmée du langage, où l’éphémère constitue une propriété centrale. Ce n’est pas autant le cas pour les pratiques argotiques bien qu’elles soient tout à fait labiles : la vitesse du changement n’est pas tout à fait la même.

Pour autant, toutes les créations de l’algospeak ne disparaissent pas aussitôt. Certaines parviennent à se stabiliser et à dépasser leur fonction initiale de contournement. Elles peuvent être reprises dans d’autres contextes, parfois à l’oral, parfois dans des usages argotiques plus classiques. Le terme « tana » qui désigne, pour l’insulter, une jeune femme qui est jugée trop visible (vraisemblablement la forme tronquée du nom de la série Hannah Montana, diffusée entre 2006 et 2011, ou d'Ana Montana, mannequin reconnue dans les années 2010), par exemple, illustre cette circulation entre sphères numériques et pratiques langagières plus larges. Il devient aussi difficile de déterminer l’origine exacte d’un mot : est-il né pour déjouer un algorithme, ou appartenait-il déjà à des usages préexistants ?

Cette porosité montre que l’algospeak ne constitue pas un phénomène isolé. Il pourrait témoigner d’une évolution plus générale du lexique, marquée par l’effacement progressif des frontières entre langage numérique et parlers ordinaires.

Des enjeux éthiques

L’algospeak repose sur un savoir-faire collectif, construit et transmis au sein de communautés d’internautes. Il s’appuie sur l’expérience : on apprend, au moyen d’essais et d’erreurs, ce qui risque d’être modéré et comment reformuler ce qu’il vaut mieux éviter de dire explicitement. Ces pratiques mobilisent ainsi de nouvelles compétences liées à l’anticipation de la modération algorithmique.

Mais cette adaptation n’est pas sans conséquences. Modifier les mots pour éviter la censure peut en atténuer la force symbolique. Remplacer un terme explicite par un émoji ou une périphrase permet de rester visible, mais peut aussi rendre certaines réalités moins lisibles voire les banaliser. L’algospeak apparaît dès lors comme une solution ambivalente : il ouvre des espaces d’expression tout en transformant profondément la manière dont les choses sont nommées et perçues.

S’il s’agissait surtout, au départ, de modérer le contenu pour lutter contre une « désinformation » au sujet de la pandémie causée par le coronavirus, le problème est désormais déplacé.

L’algospeak met en lumière des enjeux centraux liés aux rapports entre langage, intelligence artificielle et… pouvoir. Il illustre la capacité d’adaptation des locuteurs face à des systèmes de contrôle invisibles et omniprésents, mais cette créativité linguistique n’est pas sans ambiguïté : si elle permet de préserver une libre expression dans un espace public, elle a le pouvoir de transformer la manière de nommer le réel qui dérange. Or, comme l’ont montré par exemple les (socio)linguistes, nommer le réel n’est jamais un acte neutre : c’est déjà exercer un pouvoir symbolique sur lui.

L’algospeak pose dès lors une question éthique centrale : comment continuer à s’exprimer librement, dans une volonté de prévention par exemple, dans un environnement de plus en plus surveillé, tout en restant compréhensible et sans perdre l’impact symbolique des mots ? À travers ces détours linguistiques se joue peut-être, discrètement mais à terme, une redéfinition assez profonde de notre manière de dire le monde.

Anne Gensane ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

04.02.2026 à 16:13

Protéger les biens culturels face aux pillages et aux trafics : ce que révèle l’exemple de la Chine

Elsa Valle, Doctorante, Institut catholique de Paris (ICP)

Texte intégral (2075 mots)

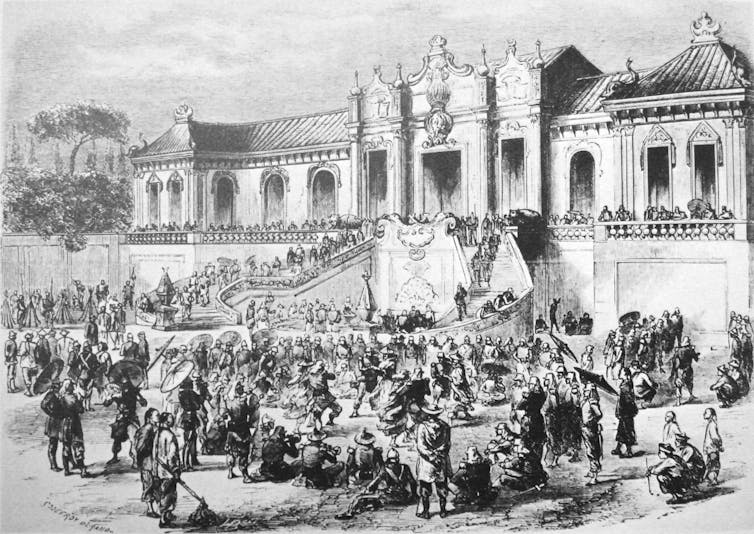

Civilisation millénaire à la richesse culturelle exceptionnelle, la Chine a produit d’innombrables œuvres d’art de grande valeur. Une bonne partie de ce patrimoine a été, au cours des siècles, vendue illégalement ou tout simplement pillée. Ce phénomène se poursuit à ce jour, malgré les efforts des autorités chinoises et de la communauté internationale.

« Si un objet est détruit, c’est un objet de moins. Si un État est anéanti, il peut se relever. Mais la perte de la culture est irrémédiable. »

Ce message, publié en 1933 par l’autorité centrale du Kuomintang (qui est à la tête de la République de Chine de 1928 à 1949), rappelle que, dans les périodes de crise, protéger le patrimoine ne se limite pas à la conservation matérielle : il s’agit aussi de préserver la mémoire d’une civilisation et la continuité de son histoire. À cette date, le Kuomintang prit une décision forte, qui ne fit d’ailleurs pas l’unanimité : déplacer les collections du Musée du Palais, créé en 1925 et installé dans la Cité interdite à Pékin, plus au sud, à Shanghai, afin de les protéger de l’invasion japonaise.

L’historienne Tsai-Yun Chan a qualifié, dans un article, cet épisode de « longue marche » des collections impériales constituées par 51 empereurs pendant près de neuf siècles. Cette « longue marche » souligne la fragilité du patrimoine en temps de guerre et sa vulnérabilité face aux convoitises.

Aujourd’hui, nous pouvons admirer, dans les vitrines des musées occidentaux ou dans les catalogues de ventes, des bronzes rituels, des sculptures funéraires, ou encore des vases impériaux. Ces objets chinois suscitent un intérêt à la fois scientifique, esthétique et marchand. Pourtant, derrière ces œuvres peuvent se dissimuler des trajectoires complexes, marquées par des conflits, des pillages et des circulations contraintes dans des contextes d’instabilité politique.

Depuis le XIXe siècle, une part du patrimoine chinois a quitté son territoire d’origine, alimentant collections privées et institutions publiques à travers le monde. Cette dispersion, antérieure à l’émergence du droit international du patrimoine, complique aujourd’hui les débats sur la légitimité des détentions et les politiques de protection des biens culturels.

L’exemple chinois apparaît ainsi comme un paradigme : il éclaire non seulement les enjeux du trafic illicite et les limites des mécanismes juridiques et diplomatiques, mais révèle aussi la valeur symbolique et émotionnelle que revêt le patrimoine pour une nation.

Quand des trésors chinois ont quitté la Chine : la circulation des biens culturels avant le droit international

La présence aujourd’hui d’œuvres d’art chinoises dans les collections occidentales s’explique par une histoire longue, parfois marquée par des épisodes de violence. Vient à l’esprit l’événement emblématique du sac du Palais d’Été en 1860, pendant la deuxième guerre de l’opium : des milliers d’objets impériaux furent alors pillés par les troupes britanniques et françaises puis dispersés, intégrant collections privées et musées, tel le « musée chinois » de l’impératrice Eugénie au château de Fontainebleau.

Au début du XXe siècle, cette dynamique s’amplifie dans un contexte d’instabilité politique chronique en Chine. Missions archéologiques, explorations scientifiques, fouilles plus ou moins contrôlées et achats sur place contribuent à la sortie massive d’objets.

Dès 1910, au retour d’une de ses missions, le sinologue français Paul Pelliot fait don de plusieurs objets chinois anciens au musée du Louvre. Dans les années 1920 et 1930, de nombreux artefacts arrivent en Occident, contribuant à la constitution des grandes collections d’art chinois ancien. Par exemple, l’archéologue et conservateur américain Carl Withing Bishop dirige deux expéditions en Chine, une première entre 1923 et 1927 puis une deuxième entre 1929 et 1934. Au cours de ces deux expéditions, il achète de nombreux objets qui vont enrichir les collections de la Freer Gallery à Washington.

Ces circulations ne relèvent pas toujours du pillage au sens strict, mais elles s’opèrent néanmoins dans un cadre juridique quasi inexistant, bien avant l’adoption des grandes conventions internationales de protection du patrimoine. Ce vide juridique historique pèse aujourd’hui sur les débats concernant la provenance et la protection des œuvres.

Un trafic illicite toujours actif

Le trafic d’antiquités chinoises demeure une réalité contemporaine, alimentée par la demande du marché international et par la vulnérabilité persistante de nombreux sites archéologiques. En Chine, malgré un cadre législatif national renforcé, les fouilles clandestines et les pillages continuent d’affecter des zones rurales et des sites difficilement surveillés. Selon l’Unesco, 1,6 million d’objets chinois seraient aujourd’hui dispersés à travers le monde.

Le Conseil international des musées (ICOM) créé en 1946, qui a pour but de promouvoir et de protéger le patrimoine culturel et naturel, a ainsi établi en 2010 une « liste rouge » des biens culturels de la Chine susceptibles de faire l’objet de transactions illicites sur le marché international des antiquités. Cette liste vise à aider musées, marchands, collectionneurs, officiers des douanes et de police, à identifier les objets potentiellement pillés et exportés illégalement de Chine.

Le cas chinois illustre donc les limites des dispositifs actuels de contrôle face à un trafic mondialisé et structuré.

Les limites du droit international du patrimoine

La lutte contre le trafic illicite et les demandes de restitution reposent aujourd’hui en grande partie sur le droit international du patrimoine, dont la pierre angulaire est la convention de l’Unesco de 1970. Celle-ci vise à prévenir l’importation, l’exportation et le transfert de propriété illicites des biens culturels. Toutefois, ce cadre juridique présente une limite majeure : son principe de non-rétroactivité. Les œuvres sorties de leur pays d’origine avant l’entrée en vigueur de la convention ne peuvent, en règle générale, être revendiquées sur cette base.

La Convention Unidroit de 1995 renforce ce dispositif en harmonisant les règles de droit privé relatives au commerce international de l’art. Elle permet notamment un traitement uniforme des demandes de restitution devant les juridictions nationales des États signataires.

La Chine a ratifié ces deux textes internationaux, ce qui s’explique sans doute par la recrudescence du trafic illicite des biens culturels sur le territoire chinois dans les années 1990. Il y a eu d’ailleurs une volonté politique de s’inspirer de ces instruments juridiques internationaux en ce qui concerne la législation chinoise sur la protection du patrimoine culturel.

Repenser la protection du patrimoine : les enseignements du cas chinois

Le cas chinois met en lumière les tensions qui traversent aujourd’hui la lutte contre le trafic illicite des œuvres d’art et les politiques de protection du patrimoine. Il révèle l’écart entre des cadres juridiques conçus pour répondre aux trafics contemporains et des collections constituées dans des contextes historiques marqués par la guerre, la domination et l’inégalité des rapports de force. Cette dissociation entre légalité et légitimité constitue l’un des principaux défis pour les acteurs du patrimoine.

Face à ces limites, la recherche de provenance, la coopération internationale et le dialogue entre historiens, archéologues, juristes et spécialistes des relations internationales apparaissent comme des leviers essentiels. Ensemble, ils permettent de mieux documenter les trajectoires des objets et de replacer la circulation de ceux-ci dans des contextes historiques, politiques et culturels plus larges.

Au-delà de ces outils traditionnels, la Chine adopte des pratiques visant à garantir une justice pour les sociétés d’origine des biens culturels, en s’impliquant dans la résolution internationale de conflits relatifs aux objets, en négociant le rapatriement de pièces dispersées comme les deux volumes du manuscrit de soie de Zidanku conservés au musée national des Arts asiatiques de Washington et restitués à la Chine en mai 2025, et en concluant des accords bilatéraux avec plus de vingt pays pour renforcer la lutte contre le pillage et l’exportation illégale d’objets culturels. Ces démarches, qui ne relèvent pas toutes du cadre juridique des restitutions internationales, s’inscrivent dans une dynamique plus large : la Chine formule des revendications explicites concernant certains biens culturels, les enjeux patrimoniaux participant d’une affirmation accrue de sa place sur la scène internationale.

Ces évolutions montrent que la protection du patrimoine ne relève plus seulement de la conservation matérielle ou du respect des cadres juridiques, mais implique une approche globale capable d’articuler histoire, droit, circulation des œuvres et enjeux contemporains du marché de l’art.

Elsa Valle ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

04.02.2026 à 16:09

Dissonance patrimoniale, réparation mémorielle : la « Table de désorientation », un contre-monument décolonial à Nancy

Gaëlle Crenn, Maîtresse de conférences en Sc. de l'Info-Com, Centre de Recherche sur les Médiations (CREM), Université de Lorraine

Texte intégral (1832 mots)

À Nancy, en Meurthe-et-Moselle, a été dévoilée, le 6 novembre 2025, face à la statue du sergent Blandan, la Table de désorientation, œuvre de Dorothée-Myriam Kellou, qui, selon l’inscription visible sur le socle, « interroge le passé colonial de l’Algérie et de la France, évoque ses blessures et appelle à la réparation ». Par les conditions de sa genèse, par les caractéristiques de son implantation, mais aussi par la singularité de sa grammaire stylistique, la Table de désorientation inaugure une politique mémorielle originale.

Ce monument est le résultat d’un processus de patrimonialisation « par le bas », produit d’initiatives convergentes de divers acteurs locaux : un projet pédagogique au lycée Jeanne-d’Arc, lancé par le professeur Étienne Augris, touché par le mouvement Black Lives Matter ; l’histoire personnelle de la famille Kellou, dont le père, le réalisateur Malek Kellou, a découvert la statue durant son enfance à Boufarik (près de Blida en Algérie), puis, devenu résidant à Nancy (Meurthe-et-Moselle), l’y a redécouverte. Cette histoire trouve un écho dans la démarche des musées de la ville, qui souhaitent explorer les enjeux mémoriels liés à la colonisation.

À lire aussi : Ce que les statues coloniales dans l’espace public racontent de la France

En 2022, l’exposition « Sur les traces du sergent Blandan », inaugure le programme « Récits décoloniaux » au musée des Beaux-Arts de Nancy. Le projet se concrétise ultimement avec une commande publique d’œuvre à la fille du réalisateur, Dorothée-Myriam Kellou. L’œuvre mêle « Histoire » et « histoire », politique coloniale et récit familial intime. Elle naît de la transmission d’une histoire traumatique d’abord tue, puis déliée, après un temps d’anamnèse, dans un geste de transmission filiale.

Installée à quelques mètres de la statue, l’œuvre est un miroir circulaire, dressé à la verticale, qui porte en inscription un texte poétique de l’autrice, débutant par une interpellation du sergent : « Qui es-tu ? » Le texte, inscrit en français et en arabe – les deux écritures se déployant en miroir l’une de l’autre, vise à interpeller le spectateur qui découvre en passant son reflet dans la surface miroitante.

À lire aussi : Ce que les statues coloniales dans l’espace public racontent de la France

Un contre-monument dissonant

Le reflet perturbe la perception habituelle et permet de replacer le monument Blandan dans le périmètre de notre attention, invitant à la réflexion sur le sens que peut prendre aujourd’hui cet emblème de la statuaire figurative de l’époque coloniale.

Après son rapatriement forcé en 1963, suite à l’indépendance algérienne, et après un temps de purgatoire dans une caserne, la statue est réinstallée en 1990 sur le terre-plein d’un carrefour près de la caserne qui porte son nom. Elle est ensuite déplacée de quelques mètres et repositionnée, pour prendre place face aux nouveaux bâtiments d’ARTEM, un complexe universitaire novateur.

La présence imposante de la statue n’empêche cependant pas un relatif oubli de cette figure. C’est pourquoi,« devant la statue du sergent Blandan qui a perdu son sens historique pour la plupart des passants, mais qui exerce toujours son influx mémoriel, se dresse un appel en miroir » (texte du socle).

L’œuvre redonne visibilité au monument initial, mais en le recontextualisant, en ouvrant des « réinterprétations de l’histoire coloniale », en proposant des « contrepoints » au récit, plutôt que des répliques (discours de Dorothée-Myriam Kellou lors du dévoilement).

On peut soutenir que l’espace physique entre les monuments fait naître un nouvel espace discursif qui permet d’initier un dialogue sur les multiples significations de la statue. Ce dialogue se nourrit d’un jeu d’opposition : entre l’« Histoire » officielle et l’« histoire » familiale qu’elle vient percuter, entre les mémoires des exploits militaires et les mémoires des descendants de familles algériennes immigrées. Le contre-monument institue un espace de discussion sur le sens des héritages coloniaux ouverts à des interprétations divergentes, voire contradictoires.L’ espace inter-monumental produit de plus une mise en tension de la géographie mémorielle de la ville. Il résonne avec l’inauguration récente d’une esplanade du nom de François Borella, membre du PSU (Parti socialiste unifié), victime de l’Organisation de l’armée secrète (OAS), geste qui veut affirmer l’attachement de la ville aux valeurs républicaines.

Avec ce contre-monument, « une trace ajoutée à une trace » (carton d’invitation), s’ouvre « un espace de relation et de réflexion critique sur les conséquences contemporaines de la colonisation » (ibid.).

Par ce geste, la Ville de Nancy déploie ce que l’on peut appeler une politique de la dissonance patrimoniale. Alors que le patrimoine est habituellement pensé comme le résultat d’un consensus sur les legs du passé que l’on souhaite conserver, le terme prend ici une signification plus complexe, qui incorpore les dissensions et les disputes qui le colorent.

En phase avec les nouvelles expressions citoyennes de revendication mémorielle, le rôle de la statuaire publique s’en trouve modifié : moins au service de l’imposition et de l’affirmation de valeurs que de leur mise en débat et de leur diffraction dans l’espace public.

Un anti-monument de réparation mémorielle

Au-delà de son rôle de contre-monument, on peut également considérer la Table comme un anti-monument, au sens que l’artiste Jochen Gerz, ainsi que ses commentateurs et commentatrices ont pu donner à ce terme.

Selon Gerz, un anti-monument est une proposition qui, par sa grammaire plastique et stylistique, remet en cause les fonctions habituellement remplies par les monuments – affirmer des valeurs, représenter (des héros, des victimes ou des allégories) –, au profit d’une ouverture à la réflexion et à la multiplication des significations possibles. La Table de désorientation possède cette forme d’humilité et d’ouverture aux interprétations favorisant une mise en suspens des valeurs. Comme le dit encore Mathieu Klein dans son discours, l’œuvre « ne nous impose rien, elle invite à penser ».

Le trait le plus marquant de la Table est la modestie de sa taille. Dressée et légèrement inclinée vers l’arrière, elle mesure 1,59 mètre – ce qui était très exactement la taille du sergent. Sa rondeur et sa petitesse sont en tant que telles une remise en question de la monumentalité de la statue voisine, qui culmine sur son énorme socle à presque 4 mètres de hauteur. À l’impression de lourdeur et d’opacité donnée par l’ensemble massif de pierre et de bronze, qui héroïse le combattant colonial, encapsule les valeurs guerrières et rappelle la politique de conquête impérialiste, s’oppose la clarté et la légèreté de la Table. Ses miroitements conduisent les passant·es à se questionner, sans préjuger de leurs interprétations : elle renvoie les sujets à leur propre réflexion (aux sens propre et figuré).

Alors que l’attitude du sergent, les mentions sur le socle, ses bas-reliefs de bronze et sa plaque commémorative concourent tous à affirmer la valorisation du guerrier héroïque mort pour la colonisation, la Table invite à mettre en question ces valeurs et à rouvrir un questionnement sur celles que nous (l’ensemble de la communauté) souhaitons voir célébrées aujourd’hui dans l’espace public. Ainsi, l’œuvre contribue à la mise en débat des héritages de la colonisation et à la réflexion sur la place des descendants et des minorités. À l’égard des anciennes voix silenciées, elle opère une forme de réparation mémorielle.

Quelle orientation des publics ?

Une difficulté cependant peut naître dans l’appropriation du nouveau monument par le public. En effet, le texte gravé sur le miroir, avec son lettrage subtil, s’avère très difficile à déchiffrer. Lors de la cérémonie de dévoilement, les premiers spectateurs et spectatrices ne ménagent pourtant pas leurs efforts, se rapprochant au maximum de la surface miroitante, reculant et variant les angles de vue. La mairie a prévu un programme de médiations pour accompagner la découverte de la nouvelle œuvre publique dans son contexte. Celles-ci s’avèreront sans doute utiles pour que le public ne souffre pas d’une « désorientation » excessive.

Peut-être même l’adjonction d’un panneau permanent sera-t-elle à envisager afin de lui livrer des appuis interprétatifs pour faire sens de l’œuvre et de l’espace intermonumental qu’elle génère. Cela serait sans doute profitable pour qu’il saisisse toute la richesse de ce nouveau monument, à la fois populaire par sa genèse, dissonant dans son principe, contre- et anti-monumental dans ses effets.

Gaëlle Crenn a été membre de la liste des Verts lors des élections municipales de Nancy en 2020.

03.02.2026 à 17:14

Addicts à nos écrans : et si tout avait commencé avec la télé en couleurs ?

Jean-Michel Bettembourg, Enseignant, Métiers du multimédia et de l'Internet, Université de Tours

Texte intégral (1882 mots)

Octobre 1967, le premier programme en couleurs est diffusé sur la deuxième chaîne de l’ORTF (aujourd’hui, France 2). Pourtant, la démocratisation de la télévision couleur a pris de nombreuses années, pour s’imposer à la fin des années 1980 dans quasiment tous les foyers de France, créant une forme de séduction qui se poursuit peut-être aujourd’hui à travers l’addiction aux écrans.

Le 1er octobre 1967, dans quelques salons français, le monde bascule avec l’avènement de la télévision en couleurs : une révolution médiatique, mais aussi politique, sociale et culturelle.

Cette première diffusion a lieu sur la deuxième chaîne de l’Office de radiodiffusion-télévision française (ORTF). Mais la télévision en couleurs, au début, n’est pas à la portée de tous. Pour la grande majorité des Français, elle reste un rêve inaccessible. Il y a, d’un côté, une ambition nationale immense pour promouvoir cette vitrine de la modernité et, de l’autre, une réalité sociale qui reste encore largement en noir et blanc.

La décision, très politique, vient d’en haut. La couleur n’était pas qu’une question d’esthétique, et le choix même de la technologie, le fameux procédé Sécam, est une affaire d’État. Plus qu’une décision purement technique, le choix d’un standard de télé est en réalité une affaire de souveraineté nationale.

Pour comprendre ce qui se joue, il faut se replacer dans le contexte de l’époque. Dans la période gaullienne, le maître mot, c’est l’indépendance nationale sur tous les fronts : militaire, diplomatique, mais aussi technologique.

Un standard très politique

Pour le général de Gaulle et son gouvernement, imposer un standard français, le Sécam, est un acte politique aussi fort que de développer le nucléaire civil ou plus tard de lancer le programme Concorde. La France fait alors face à deux géants : d’un côté le standard américain, le NTSC, qui existe déjà depuis 1953, et le PAL, développé par l’Allemagne de l’Ouest. Choisir le Sécam, c’est refuser de s’aligner, de devenir dépendant d’une technologie étrangère.

L’État investit. Des millions de francs de l’époque sont investis pour moderniser les infrastructures, pour former des milliers de techniciens et pour faire de la deuxième chaîne une vitrine de cette modernité à la française. Sécam signifie « Séquentiel couleur à mémoire », un système basé sur une sorte de minimémoire tampon avant l’heure, qui garantit une transmission sur de longues distances et des couleurs stables qui ne bavent pas.

Le pari est audacieux, car si la France opte ainsi pour un système plus robuste, cela l’isole en revanche du reste de l’Occident. Le prix à payer pour cette exception culturelle et technologique est double. Tout d’abord, le coût pour le consommateur : les circuits Sécam étaient beaucoup plus complexes et donc un poste TV français coûtait entre 20 et 30 % plus cher qu’un poste PAL, sans compter les problèmes d’incompatibilité à l’international. L’exportation des programmes français est acrobatique : il faut tout transcoder, ce qui est coûteux et entraîne une perte de qualité. Et ce coût, justement, nous amène directement à la réalité sociale de ce fameux 1er octobre 1967.

Fracture sociale

D’un côté, on avait cette vitrine nationale incroyable et, de l’autre, la réalité des salons français. Le moment clé, c’est l’allocution du ministre de l’information Georges Gorse qui, ce 1er octobre 1967, lance un sobre mais historique « Et voici la couleur… ». Mais c’est une image d’Épinal qui cache la fracture.

Le prix des télévisions nouvelle génération est exorbitant. Un poste couleur coûte au minimum 5 000 francs (soit l’équivalent de 7 544 euros, de nos jours). Pour donner un ordre de grandeur, le smic de l’époque est d’environ 400 francs par mois … 5 000 francs, c’est donc plus d’un an de smic, le prix d’une voiture !

La démocratisation a été extrêmement lente. En 1968, seuls 2 % des foyers environ étaient équipés, et pour atteindre environ 90 %, il faudra attendre jusqu’en… 1990 ! La télévision couleur est donc immédiatement devenue un marqueur social. Une grande partie de la population voyait cette promesse de modernité à l’écran, mais ne pouvait pas y toucher. La première chaîne, TF1, est restée en noir et blanc jusqu’en 1976.

Cette « double diffusion » a accentué la fracture sociale, mais en même temps, elle a aussi permis une transition en douceur. Le noir et blanc n’a pas disparu du jour au lendemain. Et une fois ce premier choc encaissé, la révolution s’est mise en marche.

La couleur a amplifié de manière exponentielle le rôle de la télé comme créatrice d’une culture populaire commune. Les émissions de variétés, les feuilletons, les jeux et surtout le sport, tout devenait infiniment plus spectaculaire. L’attrait visuel était décuplé. Lentement, la télévision est devenue le pivot qui structure les soirées familiales et synchronise les rythmes de vie. Et en coulisses, c’était une vraie révolution industrielle. L’audiovisuel s’est professionnalisé à une vitesse folle. Les budgets de production ont explosé.

Cela a créé des besoins énormes et fait émerger de tout nouveaux métiers, les étalonneurs, par exemple, ces experts qui ajustent la colorimétrie en postproduction. Et bien sûr, il a fallu former des légions de techniciens spécialisés sur la maintenance des caméras et des télés Sécam pour répondre à la demande. Dans ce contexte, l’ORTF et ses partenaires industriels, comme Thomson, ont développé des programmes ambitieux de formation des techniciens, impliquant écoles internes et stages croisés.

Le succès industriel est retentissant. L’impact économique a été à la hauteur de l’investissement politique initial. L’État misait sur la recherche et le développement. Thomson est devenu un leader européen de la production de tubes cathodiques couleur, générant des dizaines de milliers d’emplois directs dans ses usines. C’est une filière entière de la fabrication des composants à la maintenance chez le particulier qui est née.

Et puis il y a eu le succès à l’exportation du système. Malgré son incompatibilité, le Sécam a été vendu à une vingtaine de pays, notamment l’URSS.

La place des écrans dans nos vies

Mais en filigrane, on sentait déjà poindre des questions qui nous sont très familières aujourd’hui, sur la place des écrans dans nos vies. C’est peut-être l’héritage le plus durable de la télévision en couleurs. La puissance de séduction des images colorées a immédiatement renforcé les craintes sur la passivité du spectateur. On commence à parler de « consommation d’images », d’une « perte de distance critique ».

Le débat sur le temps d’écran n’est pas né avec les smartphones, mais bien à ce moment-là, quand l’image est devenue si attractive, si immersive, qu’elle pouvait littéralement « capturer » le spectateur. La télé couleur, avec ses rendez-vous, installait une logique de captation du temps.

Et avec l’arrivée des premières mesures d’audience précises à la fin des années 1960, certains observateurs parlaient déjà d’une forme d’addiction aux écrans. La couleur a ancré durablement la télévision au cœur des industries culturelles, avec le meilleur des créations audacieuses et le moins bon, des divertissements certes très populaires mais de plus en plus standardisés.

L’arrivée de la couleur, c’était la promesse de voir enfin le monde « en vrai » depuis son salon. Cette quête de réalisme spectaculaire, de plus vrai que nature, ne s’est jamais démentie depuis, de la HD à la 4K, 6K et au-delà. On peut alors se demander si cette promesse initiale vendue sur un écran de luxe ne contenait pas déjà en germe notre rapport actuel à nos écrans personnels ultraportables, où la frontière entre le réel et sa représentation est devenue une question centrale.

Jean-Michel Bettembourg ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

02.02.2026 à 16:21

Femme, artiste et entrepreneure : relever le défi