25.11.2025 à 15:45

Jean Baudrillard, le philosophe qui a prédit l’intelligence artificielle, trente ans avant ChatGPT

Bran Nicol, Professor of English, University of Surrey

Emmanuelle Fantin, Maîtresse de conférences en sciences de l'information et de la communication, Sorbonne Université

Texte intégral (1492 mots)

Visionnaire de la culture numérique, Jean Baudrillard pensait l’intelligence artificielle comme une prothèse mentale capable d’exorciser notre humanité, et un renoncement à notre liberté.

Certains penseurs semblent si précis dans leur compréhension du lieu vers lequel la société et la technique nous emportent qu’ils sont affublés du titre de « prophète ». C’est le cas de J. G. Ballard, Octavia E. Butler, ou encore Donna Haraway.

L’un des membres les plus importants de ce club est le penseur Jean Baudrillard (1929-2007) – bien que sa réputation se soit amoindrie depuis une vingtaine d’années, il est désormais vaguement associé à l’époque révolue où les théoriciens français tels que Roland Barthes et Jacques Derrida régnaient en maîtres.

Lorsque nous l’avons relu pour écrire la nouvelle biographie qui lui est consacrée, nous nous sommes toutefois souvenus à quel point ses prédictions sur la technologie contemporaine et ses effets se révélaient prémonitoires. Sa compréhension de la culture numérique et de l’intelligence artificielle (IA) s’avère particulièrement clairvoyante – d’autant que ses écrits l’ont présentée plus de trente ans avant le lancement de ChatGPT.

Un contexte de préhistoire numérique

Il faut bien se figurer que les technologies de communication de pointe des années 1980 nous paraissent désormais totalement obsolètes : Baudrillard écrit alors que l’entourent des répondeurs téléphoniques, des fax, et bien sûr, le Minitel, prélude médiatique franco-français au réseau Internet. Son génie résidait dans une aptitude à entrevoir au sein de ces dispositifs relativement rudimentaires une projection des usages probables de la technologie dans le futur.

À la fin des années 1970, il avait déjà commencé à développer une théorie originale de l’information et de la communication. Celle-ci s’est encore déployée à partir de la publication de Simulacres et Simulation en 1981 (l’ouvrage qui a influencé les sœurs Wachowski dans l’écriture du film Matrix, sorti en 1999).

Dès 1986, le philosophe observait :

« Aujourd’hui, plus de scène ni de miroir, mais un écran et un réseau. »

Il prédit alors l’usage généralisé du smartphone, en imaginant que chacun d’entre nous serait aux commandes d’une machine qui nous tiendrait isolés « en position de parfaite souveraineté », comme un « cosmonaute dans sa bulle ». Ces réflexions lui ont permis d’élaborer son concept le plus célèbre : la théorie d’après laquelle nous serions entrés dans l’ère de « l’hyperréalité ».

Dans les années 1990, Baudrillard a porté son attention sur les effets de l’IA, d’une manière qui nous aide à la fois à mieux comprendre son essor tentaculaire dans le monde contemporain et à mieux concevoir la disparition progressive de la réalité, disparition à laquelle nous faisons face chaque jour avec un peu plus d’acuité.

Les lecteurs avertis de Baudrillard n’ont probablement pas été surpris par l’émergence de l’actrice virtuelle Tilly Norwood, générée par IA. Il s’agit d’une étape tout à fait logique dans le développement des simulations et autres deepfake, qui semble conforme à sa vision du monde hyperréel.

« Le spectacle de la pensée »

Baudrillard envisageait l’IA comme une prothèse, un équivalent mental des membres artificiels, des valves cardiaques, des lentilles de contact ou encore des opérations de chirurgie esthétique. Son rôle serait de nous aider à mieux réfléchir, voire à réfléchir à notre place, ainsi que le conceptualisent ses ouvrages la Transparence du mal (1990) ou le Crime parfait (1995).

Mais il était convaincu qu’au fond, tout cela ne nous permettrait en réalité uniquement de vivre « le spectacle de la pensée », plutôt que nous engager vers la pensée elle-même. Autrement dit, cela signifie que nous pourrions alors repousser indéfiniment l’action de réfléchir. Et d’après Baudrillard, la conséquence était limpide : s’immerger dans l’IA équivaudrait à renoncer à notre liberté.

Voilà pourquoi Baudrillard pensait que la culture numérique précipiterait la « disparition » des êtres humains. Bien entendu, il ne parlait pas de disparition au sens littéral, ni ne supposait que nous serions un jour réduits à la servitude comme dans Matrix. Il envisageait plutôt cette externalisation de notre intelligence au sein de machines comme une manière « d’exorciser » notre humanité.

En définitive, il comprenait toutefois que le danger qui consiste à sacrifier notre humanité au profit d’une machine ne proviendrait pas de la technologie elle-même, mais bien que la manière dont nous nous lions à elle. Et de fait, nous nous reposons désormais prodigieusement sur de vastes modèles linguistiques comme ChatGPT. Nous les sollicitons pour prendre des décisions à notre place, comme si l’interface était un oracle ou bien notre conseiller personnel.

Ce type de dépendance peut mener aux pires conséquences, comme celles de tomber amoureux d’une IA, de développer des psychoses induites par l’IA, ou encore, d’être guidé dans son suicide par un chatbot.

Bien entendu, les représentations anthropomorphiques des chatbots, le choix de prénoms comme Claude ou encore le fait de les désigner comme des « compagnons » n’aide pas. Mais Baudrillard avait pressenti que le problème ne provenait pas de la technologie elle-même, mais plutôt de notre désir de lui céder la réalité.

Le fait de tomber amoureux d’une IA ou de s’en remettre à sa décision est un problème humain, non pas un problème propre à la machine. Encore que, le résultat demeure plus ou moins le même. Le comportement de plus en plus étrange de Grok – porté par Elon Musk – s’explique simplement par son accès en temps réels aux informations (opinions, assertions arbitraires, complots) qui circulent sur X, plateforme dans laquelle il est intégré.

« Suis-je un être humain ou une machine ? »

De la même manière que les êtres humains sont façonnés par leur interaction avec l’IA, l’IA est dressée par ses utilisateurs. D’après Baudrillard, les progrès technologiques des années 1990 rendaient déjà impossible la réponse à la question « Suis-je un être humain ou une machine ? »

Il semblait confiant malgré tout, puisqu’il pensait que la distinction entre l’homme et la machine demeurerait indéfectible. L’IA ne pourrait jamais prendre plaisir à ses propres opérations à la manière dont les humains apprécient leur propre humanité, par exemple en expérimentant l’amour, la musique ou le sport. Mais cette prédiction pourrait bien être contredite par Tilly Norwood qui a déclaré dans le post Facebook qui la révélait au public :

« Je suis peut-être générée par une IA, mais je ressens des émotions bien réelles. »

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

24.11.2025 à 16:33

« Le discours monotone du dictateur » ou comment Franco a construit un autoritarisme sans charisme

Susana Ridao Rodrigo, Profesora catedrática en el Área de Lengua Española (UAL), Universidad de Almería

Texte intégral (1486 mots)

On associe volontiers les dictateurs aux discours tonitruants et exaltés d’un Hitler ou d’un Mussolini et à une mise en scène exubérante pensée pour galvaniser les foules. Franco, lui, a fait exactement l’inverse : les prises de parole de l’homme qui a verrouillé l’Espagne pendant près de quarante ans se distinguaient par une élocution froide et monotone et un style volontairement très austère.

Francisco Franco (1892-1975) a été le chef de l’État espagnol de la fin de la guerre civile (1936-1939) jusqu’à sa mort. Le régime franquiste a instauré une dictature autoritaire, qui a supprimé les libertés politiques et a établi un contrôle strict sur la société. Pendant près de quarante ans, son leadership a profondément marqué la vie politique, économique et culturelle de l’Espagne, dont l’empreinte durable a souvent fait et fait encore l’objet de controverses.

Mais d’un point de vue communicationnel, peut-on dire que Franco était un grand orateur ?

Cela dépend de la façon dont on définit « grand orateur ». Si l’on entend par éloquence la capacité à émouvoir, persuader ou mobiliser par la parole – comme savaient le faire Churchill ou de Gaulle –, Franco n’était pas un grand orateur. Cependant, si l’on analyse sa communication du point de vue de l’efficacité politique et symbolique, son style remplissait une fonction spécifique : il transmettait une impression d’autorité, de distance et de contrôle.

Son éloquence ne visait pas à séduire le public, mais à légitimer le pouvoir et à renforcer une image de stabilité hiérarchique. En ce sens, Franco a développé un type de communication que l’on pourrait qualifier de « discours de commandement », caractérisé par une faible expressivité et une rigidité formelle, mais qui cadrait avec la culture politique autoritaire du franquisme.

Sur le plan verbal, Franco s’appuyait sur un registre archaïque et protocolaire. Son lexique était limité, avec une abondance de formules rituelles (« tous espagnols », « glorieuse armée », « grâce à Dieu ») qui fonctionnaient davantage comme des marqueurs idéologiques que comme des éléments informatifs.

Du point de vue de l’analyse du discours, sa syntaxe tendait à une subordination excessive, ce qui générait des phrases longues, monotones et peu dynamiques. On observe également une préférence pour le mode passif et les constructions impersonnelles, qui diluent la responsabilité de l’émetteur : « il a été décidé », « il est jugé opportun », « il a été nécessaire ».

Ce choix verbal n’est pas neutre ; il constitue un mécanisme de dépersonnalisation du pouvoir, dans lequel la figure du leader est présentée comme l’incarnation de l’État, et non comme un individu qui prend des décisions. Ainsi, sur le plan verbal, Franco communique davantage en tant qu’institution qu’en tant que personne.

Communication paraverbale : voix, rythme et intonation

C’est un aspect caractéristique de sa communication. Franco avait une intonation monotone, avec peu de variations mélodiques. D’un point de vue prosodique, on pourrait dire que son discours présentait un schéma descendant constant : il commençait une phrase avec une certaine énergie et l’atténuait vers la fin, ce qui donnait une impression de lenteur et d’autorité immuable.

Le rythme était lent, presque liturgique, avec de nombreux silences. Cette lenteur n’était pas fortuite : dans le contexte politique de la dictature, elle contribuait à la ritualisation du discours. La parole du caudillo ne devait pas être spontanée, mais solennelle, presque sacrée.

Son timbre nasal et son articulation fermée rendaient difficile l’expressivité émotionnelle, mais renforçaient la distance. Ce manque de chaleur vocale servait la fonction propagandiste. Le leader n’était pas un orateur charismatique, mais une figure d’autorité, une voix qui émanait du pouvoir lui-même. En substance, sa voix construisait une « éthique du commandement » : rigide, froide et contrôlée.

Contrôle émotionnel

Sa communication non verbale était extrêmement contrôlée. Franco évitait les gestes amples, les déplacements ou les expressions faciales marquées. Il privilégiait une kinésique minimale, c’est-à-dire un langage corporel réduit au strict nécessaire.

Lorsqu’il s’exprimait en public, il adoptait une posture rigide, les bras collés au corps ou appuyés sur le pupitre, sans mouvements superflus. Ce contrôle corporel renforçait l’idée de discipline militaire et de maîtrise émotionnelle, deux valeurs essentielles dans sa représentation du leadership.

Son regard avait tendance à être fixe, sans chercher le contact visuel direct avec l’auditoire. Cela pourrait être interprété comme un manque de communication du point de vue actuel, mais dans le contexte d’un régime autoritaire, cela consistait à instaurer une distance symbolique : le leader ne s’abaissait pas au niveau de ses auditeurs. Même ses vêtements – l’uniforme, le béret ou l’insigne – faisaient partie de sa communication non verbale, car il s’agissait d’éléments qui transmettaient l’idée de la permanence, de la continuité et de la légitimité historique.

Charisme sobre d’après-guerre

Le charisme n’est pas un attribut absolu, mais une construction sociale. Franco ne jouait pas sur une forme de charisme émotionnel, comme Hitler ou Mussolini, mais il avait un charisme bureaucratique et paternaliste. Son pouvoir découlait de la redéfinition du silence et de l’austérité, car dans un pays dévasté par la guerre, son style sobre était interprété comme synonyme d’ordre et de prévisibilité. Son « anti-charisme » finit donc par être, d’une certaine manière, une forme de charisme adaptée au contexte espagnol de l’après-guerre.

Du point de vue de la théorie de la communication, quel impact ce style avait-il sur la réception du message ? Le discours de Franco s’inscrivait dans ce que l’on pourrait appeler un modèle unidirectionnel de communication politique. Il n’y avait pas de rétroaction : le récepteur ne pouvait ni répondre ni remettre en question. L’objectif n’était donc pas de persuader, mais d’imposer un sens.

En appliquant là théorie de la communication du linguiste Roman Jakobson, on constate que les discours solennels de Franco, la froideur de son ton, visaient à forcer l’obéissance de l’auditoire en empêchant toute forme d’esprit critique et en bloquant l’expression des émotions.

Anachronique devant la caméra

Au fil du temps, son art oratoire n’a évolué qu’en apparence. Dans les années 1950 et 1960, avec l’ouverture du régime, on perçoit une légère tentative de modernisation rhétorique, tout particulièrement dans les discours institutionnels diffusés à la télévision. Cependant, les changements étaient superficiels : Franco usait de la même prosodie monotone et du même langage rituel. En réalité, le média télévisuel accentuait sa rigidité. Face aux nouveaux dirigeants européens qui profitaient de la caméra pour s’humaniser, Franco apparaissait anachronique.

L’exemple de Franco démontre que l’efficacité communicative ne dépend pas toujours du charisme ou de l’éloquence, mais plutôt de la cohérence entre le style personnel et le contexte politique. Son art oratoire fonctionnait parce qu’il était en accord avec un système fermé, hiérarchique et ritualisé. Dans l’enseignement de la communication, son exemple sert à illustrer comment les niveaux verbal, paraverbal et non verbal construisent un même récit idéologique. Dans son cas, tous convergent vers un seul message : le pouvoir ne dialogue pas, il dicte.

Aujourd’hui, dans les démocraties médiatiques, ce modèle serait impensable ; néanmoins, son étude aide à comprendre comment le langage façonne les structures du pouvoir, et comment le silence, lorsqu’il est institutionnalisé, peut devenir une forme de communication politique efficace.

Susana Ridao Rodrigo ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

23.11.2025 à 14:55

Comment l’IA peut nous aider à dresser le portrait de la population parisienne d’il y a 100 ans

Sandra Brée, Chargée de recherche CNRS - LARHRA, Centre national de la recherche scientifique (CNRS)

Texte intégral (2309 mots)

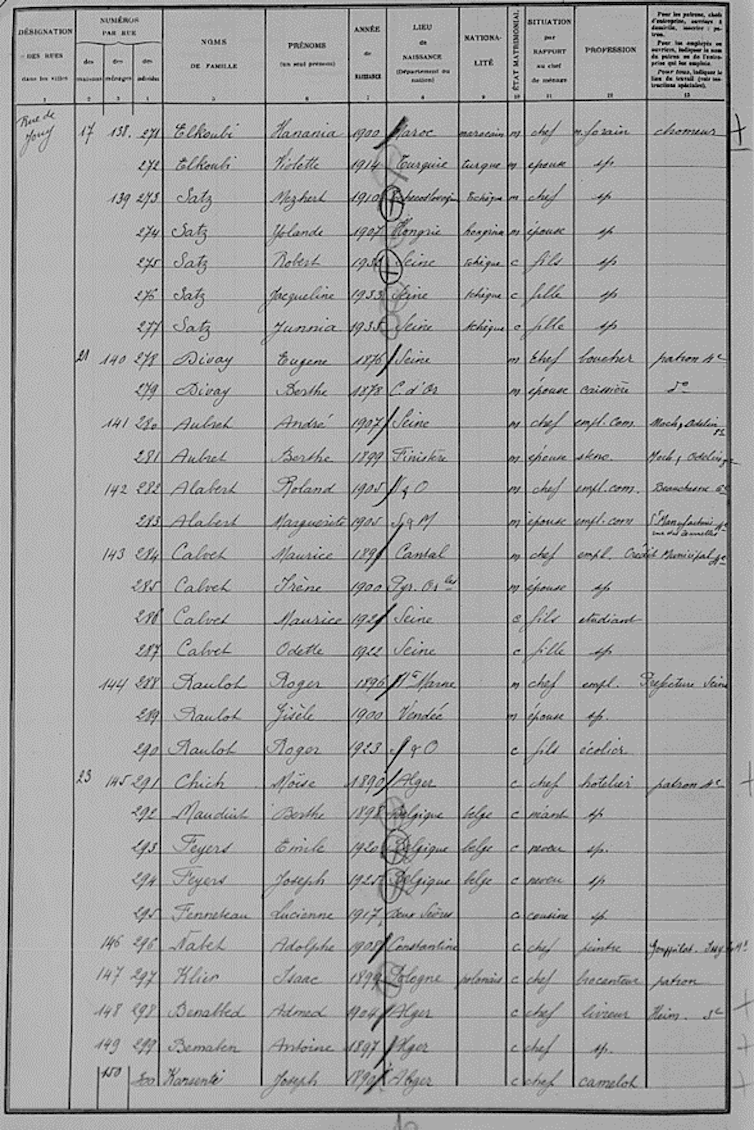

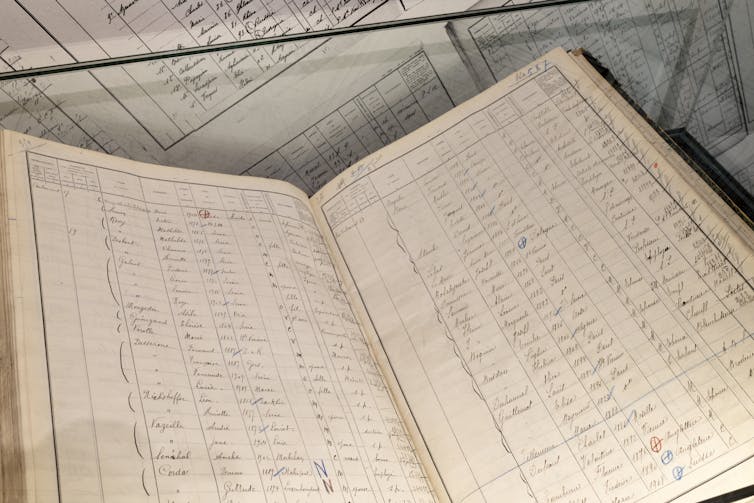

L’exposition « Les gens de Paris, 1926-1936. Dans le miroir des recensements de population », qui se tient actuellement, et jusqu’au 8 février 2026, au musée Carnavalet-Histoire de Paris, s’appuie sur les recensements de la population parisienne de 1926, de 1931 et de 1936, et contribue à renouveler le regard sur le peuple de la capitale dans l’entre-deux-guerres.

En France, des opérations de recensement sont organisées dès 1801, mais ce n’est qu’à partir de 1836 que des instructions spécifiques sont fournies pour procéder de manière uniforme dans toutes les communes du pays. Le recensement de la population est alors organisé tous les cinq ans, les années se terminant en 1 et en 6, jusqu’en 1946, à l’exception de celui de 1871 qui est reporté à l’année suivante en raison de la guerre franco-prussienne, et de ceux de 1916 et de 1941 qui ne sont pas organisés à cause des deux guerres mondiales.

Des données précieuses sur la population parisienne

Le premier but des recensements de la population est de connaître la taille des populations des communes pour l’application d’un certain nombre de lois. Ils permettent également de recueillir des informations sur l’ensemble des individus résidant dans le pays à un instant t pour en connaître la structure. Ces statistiques sont dressées à partir des bulletins individuels et/ou (selon les années) des feuilles de ménage (les feuilles de ménages récapitulent les individus vivant dans le même ménage et leurs liens au chef de ménage) remplies par les individus et publiées dans des publications spécifiques intitulées « résultats statistiques du recensement de la population ».

En plus de ces statistiques, les maires doivent également dresser une liste nominative de la population de leur commune. Mais Paris avait obtenu le droit de ne pas dresser ces listes. C’est le chef du bureau de la statistique parisienne, M. Lambert, qui décide de revenir sur cette exception dès 1926. Les listes nominatives de 1926, de 1931 et de 1936 sont donc les seules, avec celle de 1946, à exister pour la population parisienne.

Si Paris avait obtenu le droit de ne pas dresser ces listes, c’est en raison du coût d’une telle opération pour une population si vaste. La population parisienne compte, en effet, déjà près de 1,7 million d’habitants en 1861, un million de plus en 1901 et atteint son pic en 1921 avec 2,9 millions d’individus. Les données contenues dans ces listes sont particulièrement intéressantes, car elles permettent d’affiner considérablement les statistiques dressées pendant l’entre-deux-guerres.

Une base de données conçue grâce à l’IA

Ces listes, conservées aux Archives de Paris et numérisées puis mises en ligne depuis une dizaine d’années, ont déjà intéressé des chercheurs qui se sont appuyés dessus, par exemple, pour comprendre l’évolution d’une rue ou d’un quartier, mais elles n’avaient jamais été utilisées dans leur ensemble en raison du volume qui rend impossible leur dépouillement pour un chercheur isolé. Voulant également travailler à partir de ces listes – au départ, pour travailler sur la structure des ménages et notamment sur les divorcés –, j’avais moi aussi débuté le dépouillement à la main de certains quartiers.

La rencontre avec les informaticiens du Laboratoire d’informatique, de traitement de l’information et des systèmes (LITIS), Thierry Paquet, Thomas Constum, Pierrick Tranouez et Nicolas Kempf, spécialistes de l’intelligence artificielle, a changé la donne puisque nous avons entrepris de créer une base de données à partir de l’ensemble des listes nominatives de la population parisienne de 1926, de 1931 et de 1936 dans le cadre du projet POPP. Les 50 000 images, qui avaient déjà été numérisées par les Archives de Paris, ont été traitées par les outils d’apprentissage profond et de reconnaissance optique des caractères développés au LITIS pour créer une première base de données.

Les erreurs de cette première base « brute » étaient déjà très faibles, mais nous avons ensuite, avec l’équipe de sciences humaines et sociales – composée de Victor Gay (École d’économie de Toulouse, Université Toulouse Capitole), Marion Leturcq (Ined), Yoann Doignon (CNRS, Idées), Baptiste Coulmont (ENS Paris-Saclay), Mariia Buidze (CNRS, Progedo), Jean-Luc Pinol (ENS Lyon, Larhra) –, tout de même essayé de corriger au maximum les erreurs de lecture de la machine ou les décalages de colonnes. Ces corrections ont été effectuées de manière automatique, c’est-à-dire qu’elles ont été écrites dans un script informatique permettant leur reproductibilité. Ainsi, nous avons par exemple modifié les professions apparaissant comme « benne » en « bonne » ou bien les « fnène » en « frère ».

Adapter la base à l’analyse statistique

Il a ensuite fallu adapter la base à l’analyse statistique. Les listes nominatives n’avaient, en effet, pas pour vocation d’être utilisées pour des traitements statistiques puisque ces derniers avaient été établis directement à partir des bulletins individuels et des feuilles de ménage. Or, l’analyse statistique requiert que les mots signalant la même entité soient inscrits de la même façon. Cette difficulté est exacerbée dans le cas des listes nominatives : les agents avaient peu de place pour écrire, car les colonnes sont étroites. Ils utilisaient donc des abréviations, notamment pour les mots les plus longs comme les départements de naissance ou les professions.

Nous avons dû par conséquent uniformiser la manière d’écrire l’ensemble des professions, des départements ou des pays de naissance, des situations dans le ménage et des prénoms. Pour ce faire, nous nous sommes appuyés sur différents dictionnaires, c’est-à-dire des listes de mots correspondant à la variable traitée provenant de recherches antérieures ou d’autres bases de données. Ainsi, pour corriger les prénoms, Baptiste Coulmont, qui a travaillé sur cette partie de la base a utilisé les bases Insee des prénoms et des personnes décédées. Marion Leturcq et Victor Gay ont, par ailleurs, utilisé les listes des départements français, des colonies et des pays étrangers, tels qu’ils étaient appelés pendant l’entre-deux-guerres, ou encore la nomenclature des professions utilisées par la Statistique générale de la France (SGF).

Enfin, nous avons créé des variables qui manquaient pour l’analyse statistique que nous souhaitions mener, comme la variable « sexe » qui n’existe pas dans les listes nominatives (alors que le renseignement apparaît dans les fiches individuelles), ou encore délimiter les ménages afin d’en comprendre la composition. Ce travail de correction et d’adaptation de la base est encore en cours, car nous travaillons actuellement à l’ajout d’une nomenclature des professions – afin de permettre une analyse par groupes professionnels –, ou encore à la création du système d’information géographique (SIG) de la base pour réaliser la géolocalisation de chaque immeuble dans la ville.

Retrouver des ancêtres

La base POPP ainsi créée a déjà été utilisée à différentes fins. Une partie de la base (comprenant les noms de famille – qui, eux, n’ont pas été corrigés –, les prénoms et les adresses) a été reversée aux Archives de Paris pour permettre la recherche nominative dans les images numérisées des listes nominatives. Ce nouvel outil mis en place au début du mois d’octobre 2025 – et également proposé en consultation au sein de l’exposition « Les gens de Paris, 1926-1936. Dans le miroir des recensements de population » – a déjà permis à de nombreuses personnes de retrouver leurs ancêtres.

Il nous a également été possible de fournir les premiers résultats tirés de la base POPP (confrontés aux résultats statistiques des recensements publiés) pour dresser des données de cadrage apparaissant sous forme d’infographies dans l’exposition (créées par Clara Dealberto et Jules Grandin). Ces résultats apparaissent également avec une perspective plus comparative dans une publication intitulée « Paris il y a 100 ans : une population plus nombreuse qu’aujourd’hui et déjà originaire d’ailleurs » (Ined, septembre 2025).

L’heure est maintenant à l’exploitation scientifique de la base POPP par l’équipe du projet dont le but est de dresser le portrait de la population parisienne à partir des données disponibles dans les listes nominatives des recensements de la population, en explorant les structures par sexe et âge, profession, état matrimonial, origine, ou encore la composition des ménages des différents quartiers de la ville.

L’autrice remercie les deux autres commissaires de l’exposition « Les gens de Paris, 1926-1936. Dans le miroir des recensements de population » Valérie Guillaume, directrice du musée Carnavalet – Histoire de Paris, et Hélène Ducaté, chargée de mission scientifique au musée Carnavalet – Histoire de Paris et les Archives de Paris.

Sandra Brée a reçu des financements du CollEx-Persée, de Progedo, de l'humathèque du Campus-Condorcet et du CNRS.

20.11.2025 à 16:15

« Les Dents de la mer » : genèse d’une bande originale mythique

Jared Bahir Browsh, Assistant Teaching Professor of Critical Sports Studies, University of Colorado Boulder

Texte intégral (2972 mots)

La séquence de deux notes légendaires, qui fait monter la tension dans « les Dents de la mer », géniale trouvaille du compositeur John Williams, trouve son origine dans la musique classique du début du XXᵉ siècle, mais aussi chez Mickey Mouse et chez Hitchcock.

Depuis les Dents de la mer, deux petites notes qui se suivent et se répètent – mi, fa, mi, fa – sont devenues synonymes de tension, et suscitent dans l’imaginaire collectif la terreur primitive d’être traqué par un prédateur, en l’occurrence un requin sanguinaire.

Il y a cinquante ans, le film à succès de Steven Spielberg – accompagné de sa bande originale composée par John Williams – a convaincu des générations de nageurs de réfléchir à deux fois avant de se jeter à l’eau.

En tant que spécialiste de l’histoire des médias et de la culture populaire, j’ai décidé d’approfondir la question de la longévité de cette séquence de deux notes et j’ai découvert qu’elle était l’héritage direct de la musique classique du XIXe siècle, mais qu’elle a aussi des liens avec Mickey Mouse et le cinéma d’Alfred Hitchcock.

Le premier blockbuster estival de l’histoire

En 1964, le pêcheur Frank Mundus tue un grand requin blanc de deux tonnes au large de Long Island au nord-est des États-Unis.

Après avoir entendu cette histoire, le journaliste indépendant Peter Benchley se met à écrire un roman qui raconte comment trois hommes tentent de capturer un requin mangeur d’hommes, en s’inspirant de Mundus pour créer le personnage de Quint. La maison d’édition Doubleday signe un contrat avec Benchley et, en 1973, les producteurs d’Universal Studios, Richard D. Zanuck et David Brown, achètent les droits cinématographiques du roman avant même sa publication. Spielberg, alors âgé de 26 ans, est engagé pour réaliser le film.

Exploitant les peurs à la fois fantasmées et réelles liées aux grands requins blancs – notamment une série tristement célèbre d’attaques de requins le long de la côte du New Jersey en 1916 –, le roman de Benchley publié en 1974, devient un best-seller. Le livre a joué un rôle clé dans la campagne marketing d’Universal, qui a débuté plusieurs mois avant la sortie du film.

À partir de l’automne 1974, Zanuck, Brown et Benchley participent à plusieurs émissions de radio et de télévision afin de promouvoir simultanément la sortie de l’édition de poche du roman et celle à venir du film. La campagne marketing comprend également une campagne publicitaire nationale à la télévision qui met en avant le thème à deux notes du compositeur émergent John Williams. Le film devait sortir en été, une période qui, à l’époque, était réservée aux films dont les critiques n’étaient pas très élogieuses.

À l’époque, les films étaient généralement distribués petit à petit, après avoir fait l’objet de critiques locales. Cependant, la décision d’Universal de sortir le film dans des centaines de salles à travers le pays, le 20 juin 1975, a généré d’énormes profits, déclenchant une série de quatorze semaines en tête du box-office américain.

Beaucoup considèrent les Dents de la mer comme le premier véritable blockbuster estival. Le film a propulsé Spielberg vers la célébrité et marqué le début d’une longue collaboration entre le réalisateur et Williams, qui allait remporter le deuxième plus grand nombre de nominations aux Oscars de l’histoire, avec 54 nominations, derrière Walt Disney et ses 59 nominations.

Le cœur battant du film

Bien qu’elle soit aujourd’hui considérée comme l’une des plus grandes musiques de l’histoire du cinéma, lorsque Williams a proposé son thème à deux notes, Spielberg a d’abord pensé qu’il s’agissait d’une blague.

Mais Williams s’était inspiré de compositeurs des XIXe et XXe siècles, notamment Claude Debussy (1862-1918), Igor Stravinsky (1882-1971) et surtout de la Symphonie n° 9 (1893), d’Antonin Dvorak (1841-1904), dite Symphonie du Nouveau Monde. Dans le thème des Dents de la mer, on peut entendre des échos de la fin de la symphonie de Dvorak, et reconnaître l’emprunt à une autre œuvre musicale, Pierre et le Loup (1936), de Sergueï Prokofiev.

Pierre et le Loup et la bande originale des Dents de la mer sont deux excellents exemples de leitmotivs, c’est-à-dire de morceaux de musique qui représentent un lieu ou un personnage.

Le rythme variable de l’ostinato – un motif musical qui se répète – suscite des émotions et une peur de plus en plus intenses. Ce thème est devenu fondamental lorsque Spielberg et son équipe technique ont dû faire face à des problèmes techniques avec les requins pneumatiques. En raison de ces problèmes, le requin n’apparaît qu’à la 81ᵉ minute du film qui en compte 124. Mais sa présence se fait sentir à travers le thème musical de Williams qui, selon certains experts musicaux, évoque les battements du cœur du requin.

Des sons pour manipuler les émotions

Williams doit également remercier Disney d’avoir révolutionné la musique axée sur les personnages dans les films. Les deux hommes ne partagent pas seulement une vitrine remplie de trophées. Ils ont également compris comment la musique peut intensifier les émotions et amplifier l’action.

Bien que sa carrière ait débuté à l’époque du cinéma muet, Disney est devenu un titan du cinéma, puis des médias, en tirant parti du son pour créer l’une des plus grandes stars de l’histoire des médias, Mickey Mouse.

Lorsque Disney vit le Chanteur de jazz en 1927, il comprit que le son serait l’avenir du cinéma.

Le 18 novembre 1928, Steamboat Willie fut présenté en avant-première au Colony Theater d’Universal à New York. Il s’agissait du premier film d’animation de Disney à intégrer un son synchronisé avec les images.

Contrairement aux précédentes tentatives d’introduction du son dans les films en utilisant des tourne-disques ou en faisant jouer des musiciens en direct dans la salle, Disney a utilisé une technologie qui permettait d’enregistrer le son directement sur la bobine de film. Ce n’était pas le premier film d’animation avec son synchronisé, mais il s’agissait d’une amélioration technique par rapport aux tentatives précédentes, et Steamboat Willie est devenu un succès international, lançant la carrière de Mickey et celle de Disney.

L’utilisation de la musique ou du son pour accompagner le rythme des personnages à l’écran fut baptisée « mickeymousing ».

En 1933, King Kong utilisait habilement le mickeymousing dans un film d’action réelle, avec une musique calquée sur les états d’âme du gorille géant. Par exemple, dans une scène, Kong emporte Ann Darrow, interprétée par l’actrice Fay Wray. Le compositeur Max Steiner utilise des tonalités plus légères pour traduire la curiosité de Kong lorsqu’il tient Ann, suivies de tonalités plus rapides et inquiétantes lorsque Ann s’échappe et que Kong la poursuit. Ce faisant, Steiner encourage les spectateurs à la fois à craindre et à s’identifier à la bête tout au long du film, les aidant ainsi à suspendre leur incrédulité et à entrer dans un monde fantastique.

Le mickeymousing a perdu de sa popularité après la Seconde Guerre mondiale. De nombreux cinéastes le considéraient comme enfantin et trop simpliste pour une industrie cinématographique en pleine évolution et en plein essor.

Les vertus du minimalisme

Malgré ces critiques, cette technique a tout de même été utilisée pour accompagner certaines scènes emblématiques, avec, par exemple, les violons frénétiques qui accompagne la scène de la douche dans Psychose (1960), d’Alfred Hitchcock, dans laquelle Marion Crane se fait poignarder.

Spielberg idolâtrait Hitchcock. Le jeune Spielberg a même été expulsé des studios Universal après s’y être faufilé pour assister au tournage du Rideau déchiré, en 1966.

Bien qu’Hitchcock et Spielberg ne se soient jamais rencontrés, les Dents de la mer sont sous l’influence d’Hitchcock, le « maître du suspense ». C’est peut-être pour cette raison que Spielberg a finalement surmonté ses doutes quant à l’utilisation d’un élément aussi simple pour représenter la tension dans un thriller.

L’utilisation du motif à deux notes a ainsi permis à Spielberg de surmonter les problèmes de production rencontrés lors de la réalisation du premier long métrage tourné en mer. Le dysfonctionnement du requin animatronique a contraint Spielberg à exploiter le thème minimaliste de Williams pour suggérer la présence inquiétante du requin, malgré les apparitions limitées de la star prédatrice.

Au cours de sa carrière légendaire, Williams a utilisé un motif sonore similaire pour certains personnages de Star Wars. Chaque fois que Dark Vador apparaissait, la « Marche impériale » était jouée pour mieux souligner la présence du chef du côté obscur.

Alors que les budgets des films avoisinent désormais un demi-milliard de dollars (plus de 434 millions d’euros), le thème des Dents de la mer – comme la façon dont ces deux notes suscitent la tension – nous rappelle que dans le cinéma, parfois, le minimalisme peut faire des merveilles.

Jared Bahir Browsh ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

19.11.2025 à 16:24

Les marques et savoir-faire culturels français : des atouts convoités à l’étranger

Cécile Anger, Docteur en droit des marques culturelles, Université Paris 1 Panthéon-Sorbonne

Texte intégral (2985 mots)

Le patrimoine culturel, les musées et monuments jouent un rôle prépondérant dans les motivations des touristes qui visitent la France. Mais ce patrimoine est aussi, dans sa dimension immatérielle, un vecteur d’expertise valorisée au-delà de nos frontières.

Première destination touristique mondiale, la France a attiré 100 millions de visiteurs internationaux en 2024.

L’intérêt porté aux musées et monuments, dans leur composante matérielle – en tant que lieux qui se visitent – se mesure aussi dans leur composante immatérielle. L’apport du patrimoine culturel à l’économie se traduit par l’accueil de touristes se rendant en France, mais aussi à travers l’exportation des institutions culturelles hors des frontières françaises.

C’est précisément en raison de son patrimoine culturel que la France est arrivée en tête du classement annuel Soft Power 30 en 2017 et en 2019.

De nombreux rapports publics ont investi cette question, percevant les musées ou monuments comme détenteurs d’actifs immatériels susceptibles d’être valorisés à l’international.

Le tournant de l’économie de l’immatériel

Dès 2006, les auteurs du rapport remis à Bercy sur l’économie de l’immatériel écrivaient : « Aujourd’hui, la véritable richesse n’est pas concrète, elle est abstraite. » Au capital matériel a succédé le capital immatériel, le capital des talents, de la connaissance et du savoir. Ce rapport invitait les acteurs français à miser davantage sur leur capital intangible, gisement devenu stratégique pour rester compétitif. Identifiant trois atouts immatériels culturels – le nom des établissements culturels, leur image et leur expertise –, Maurice Lévy et Jean-Pierre Jouyet recommandaient d’engager une transition vers leur valorisation.

Un rapport spécifique a ainsi été commandé en 2014 par le ministère de la culture au haut fonctionnaire Jean Musitelli, « La valorisation de l’expertise patrimoniale à l’international ». En 2019, la Cour des comptes se penchait sur la valorisation internationale de l’ingénierie et des marques culturelles.

Plus récemment, en 2023, le Sénat a publié un rapport d’information réalisé par les parlementaires Else Joseph et Catherine Morin-Desailly sur l’expertise patrimoniale internationale française, faisant état d’un savoir-faire complet, ancien et reconnu, la qualité scientifique de l’expertise française étant établie « sur l’ensemble du champ patrimonial ».

L’expertise culturelle française : un vivier de métiers hautement qualifiés

La notion d’expertise renvoie à des connaissances ou compétences qui ne sont juridiquement pas protégées par brevet et qui permettent la création de produits ou services. L’expertise peut faire l’objet d’une transmission dans le cadre d’une transaction, son transfert se matérialisant par des missions de conseil ou de formation.

Les musées regorgent d’une variété de métiers et savoir-faire liés aux activités exercées par les professionnels y travaillant. Véritable « conservatoire de talents », ils détiennent une expertise technique particulièrement qualifiée et recherchée.

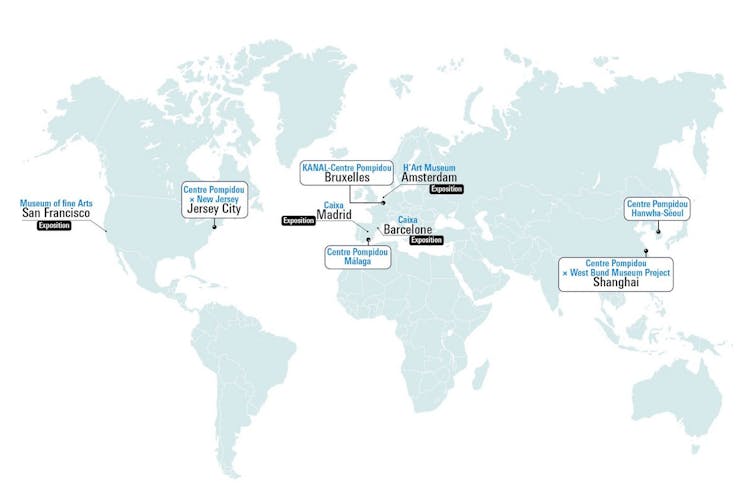

Constitué en interne en 2014, le département Louvre conseil a la charge de valoriser l’expertise des équipes du musée. Cette expertise porte sur les collections, les publics mais aussi sur le management. La brochure présentant l’ingénierie patrimoniale du Centre Pompidou énumère la liste des prestations possibles dans la création et la gestion d’espaces culturels : conseil en muséographie, en médiation… mais aussi accompagnement sur le plan administratif.

Les savoir-faire patrimoniaux français ont bénéficié d’une large couverture médiatique lors du chantier de restauration de Notre-Dame. Les sénatrices à l’origine du rapport précité jugeaient judicieux de profiter de la grande visibilité du chantier – servant ainsi de vitrine des métiers d’art français – pour « valoriser l’ensemble des savoir-faire qui ont collaboré à cette entreprise (archéologues, artisans d’art, architectes, maîtres d’ouvrage, restaurateurs, facteurs d’instruments…) ».

Une expertise recherchée en majorité par les pays émergents

Les pays émergents sont les principaux demandeurs de cette expertise, le patrimoine étant perçu comme un levier d’attractivité et suscitant ainsi un intérêt croissant. Faute de compétences suffisantes pour construire, agencer et gérer des musées, ils font appel à des institutions disposant de cette expérience. Les pays du Moyen-Orient, d’Asie et d’Afrique constituent « les marchés les plus prometteurs » sur ce plan.

Le rapport du Sénat considère que la France possède de sérieux atouts pour prendre part à ce marché :

« Il est clair que la réputation de ses savoir-faire et la renommée de certains de ses établissements au niveau mondial, qu’il s’agisse du Louvre, du château de Versailles ou du Mont Saint-Michel, contribuent à asseoir sa position sur le plan international. »

Une combinaison gagnante : l’apport de marque et d’ingénierie

Les grands accords internationaux s’accompagnent fréquemment d’un élément complémentaire à l’expertise : la marque des institutions culturelles.

Le Louvre Abou Dhabi incarne cette pluralité. Signé en 2007 entre la France et les Émirats arabes unis, l’accord prévoyait la création d’un musée constitué avec l’expertise des équipes muséales françaises et portant le nom du Louvre. Plusieurs volets composent cet accord : l’accompagnement en ingénierie, le prêt d’œuvres des collections françaises (plusieurs musées étant parties prenantes) ainsi que le prêt du nom du Louvre à travers un contrat de licence de marque.

Il en va de même dans l’expérience du Centre Pompidou, qui valorise tant ses savoir-faire que sa marque, celle-ci étant apposée sur le devant des nouveaux musées, dont les façades s’ornent ainsi du sceau de l’institution française. Présent sur tous les continents, il a collaboré en Europe avec la ville de Malaga (Espagne) et la Fondation bruxelloise Kanal. En Asie, il s’est associé avec la société d’aménagement West Bund pour accompagner la création d’un musée à Shanghai (Chine). Son action se mesure aussi en Amérique du Sud (Brésil) et dans les pays du Golfe (Arabie saoudite).

On notera cependant que la valorisation de la marque, a fortiori dans un contexte international, n’a de sens que pour des institutions notoires. Si l’expertise des musées français peut relever tant d’institutions nationales que de structures territoriales, le rayonnement de la marque semble limité aux grands musées, qualifiés par certains auteurs, dont l’économiste Bruno S. Frey, de « superstar » en raison de leur statut et de leur aura.

Une économie fondée sur l’excellence française ?

L’affirmation constante de la nécessité de valoriser l’expertise et les marques culturelles peut être vue comme l’application de la théorie de l’avantage comparatif développée par l’économiste britannique David Ricardo au XIXe siècle. Selon cette théorie, « chaque nation a intérêt à se spécialiser dans la production où elle possède l’avantage le plus élevé comparativement aux autres ». Aussi s’agit-il de « concentrer ses efforts à l’export sur des secteurs où le pays possède de réels avantages comparatifs ».

Il convient toutefois de nuancer ce postulat, car si la France possède assurément des marques fortes et une expertise patrimoniale reconnue, elle n’est pas la seule à en disposer ni à les proposer sur la scène internationale, ce marché étant concurrentiel et, au demeurant, occupé par d’autres États « également bien positionnés », notamment le Royaume-Uni, l’Allemagne ou l’Italie.

Les marques muséales américaines s’exportent également. D’aucuns auront en tête l’exemple très connu du Guggenheim, à l’origine même du concept de « marque muséale », au sens de « brand » et de « trademark », c’est-à-dire un outil de développement économique et d’expansion internationale. Le Guggenheim de Bilbao (Espagne) en témoigne : la fondation new-yorkaise a cédé le droit d’usage de son nom et perçu, en échange, 20 millions de dollars (17,2 millions d'euros) de royalties pour l’usage de sa marque.

Le Museum of Modern Art de New York (MoMA) valorise aussi son nom et son expertise. Il a, par exemple, exporté son concept de boutique de design hors des frontières américaines, avec l’implantation de deux MoMA Design Stores au Japon, à Tokyo et à Kyoto.

Des outils de diversification des ressources propres

On rappellera qu’historiquement, les musées apportaient leur savoir-faire dans une logique, non pas de valorisation mais de solidarité avec d’autres pays. C’est le cas des chantiers de fouilles archéologiques relevant avant tout d’une logique de coopération. La valorisation économique des savoir-faire est un phénomène nouveau, dont l’émergence s’explique par une demande croissante d’ingénierie culturelle émanant de certains pays mais aussi par le contexte budgétaire.

Ce désir de valorisation ne saurait être appréhendé indépendamment du contexte économique contemporain. Il s’agit également de favoriser le développement de ressources propres, venant abonder les budgets, de plus en plus tendus, des institutions culturelles. Les subsides publics n’étant pas mirifiques, les musées doivent répondre à l’impérieuse nécessité de diversifier leurs sources de financement.

Le Centre Pompidou perçoit entre 14 millions et 16 millions d’euros par an au titre de ses partenariats internationaux. S’agissant de l’exemple emblématique du Louvre Abou Dhabi, le montant total de l’accord s’élève à 1 milliard d’euros, la valorisation de la marque « Louvre » représentant 400 millions d’euros.

Ces redevances de licence de marque et d’ingénierie culturelle viennent compléter les ressources propres des établissements, rejoignant ainsi d’autres recettes, parmi lesquelles le mécénat, la location d’espaces, la vente de produits en boutique…

Des partenariats adaptés au contexte local

Face au constat d’un intérêt marqué de la part de pays émergents auprès de musées européens et états-uniens pour construire une offre culturelle, se pose la question de la construction de cette offre et de la confrontation de regards différents.

Ainsi que le relève la juriste Marie Maunand :

« Le développement des échanges internationaux dans le domaine patrimonial induit une dynamique de transfert d’expertise des pays du Nord – pays développés à économie de marché – vers des pays dits du Sud – qui sont soit émergents soit moins avancés – qui pourrait contribuer à la diffusion d’un modèle culturel unique. »

La diversité doit être au cœur de ces accords afin d’éviter toute forme de standardisation. Une approche pragmatique adaptée au contexte local, propre à celui qui est demandeur de l’expertise, s’avère primordiale.

Un transfert de savoir-faire suppose une transmission d’informations ou de compétences. En dépit de la nature commerciale de ces partenariats, il ne saurait s’agir d’un discours simplement descendant de la part de l’expert ou du « sachant » vers son partenaire, mais bien d’un échange favorisant la rencontre de points de vue variés. Dans ce sens, Émilie Girard, présidente d’ICOM France observe un « changement de paradigme et de posture dans le mode de construction d’une expertise plus tournée vers le dialogue ».

Mentionnant la mise en œuvre du partenariat avec les Émiriens, Laurence des Cars, présidente-directrice générale du Louvre, évoque la question de la médiation et de l’explication des œuvres, et, dans le cadre de cet échange entre la France et les Émirats arabes unis, de « l’altérité culturelle » et des manières permettant aux différents publics de partager des œuvres d’art en l’absence de références culturelles ou religieuses communes.

En 2015, le rapport livré par Jean Musitelli cité par Marie Maunand relevait :

« La valorisation dans le contexte de la mondialisation doit […] concourir à la diversification des expressions culturelles […] en se montrant attentif aux attentes et aux besoins des partenaires et en ajustant l’offre aux réalités et traditions locales, [avec] […] des alternatives au modèle standard tel qu’il est véhiculé par la globalisation. »

C’est aussi un rôle que souhaitent allouer à l’expertise française les autrices du rapport de la mission sénatoriale d’information.

Si sa valorisation procède pour partie d’une démarche économique, elle est aussi le reflet d’enjeux diplomatiques, dont l’objectif est de renforcer le rayonnement et l’influence de la France sur la scène internationale. Else Joseph, sénatrice des Ardennes, notait ainsi :

« Ces dernières années, combien l’influence de la France est, si ce n’est en recul, du moins de plus en plus contestée et fragilisée. C’est particulièrement vrai dans les instances internationales en matière culturelle, à l’instar de l’Unesco, où les pays occidentaux se voient régulièrement reprocher une attitude néocoloniale. »

En vue d’y apporter une réponse, la parlementaire suggérait de « tirer parti de la solide expertise de la France dans le domaine patrimonial pour maintenir notre capacité d’influence ».

En ce sens, l’expertise et les marques culturelles sont assurément une incarnation du soft power de la France, qu’il importe autant de valoriser que de préserver.

Cécile Anger a soutenu sa thèse de doctorat en 2024 à l'Université Paris 1 Panthéon-Sorbonne. Elle est depuis jeune docteure associée à l'Ecole de Droit de la Sorbonne. Son domaine de recherche porte sur les marques culturelles ainsi que la protection et la valorisation de l'image des œuvres d'art, musées et monuments. Elle a commencé sa carrière au musée de Cluny, puis occupé le poste de Cheffe du service marque et mécénat au Domaine national de Chambord avant de rejoindre l'équipe de l'Établissement public du Mont Saint-Michel.

19.11.2025 à 11:52

Pourquoi publier une « nouvelle » histoire de France en 2025

Éric Anceau, Professeur d'histoire contemporaine, Université de Lorraine

Texte intégral (2153 mots)

La connaissance du passé évolue au fil des recherches. Du big data à l’archéologie préventive, la palette d’outils à disposition de l’historien s’enrichit. Et on s’intéresse aujourd’hui à des sujets longtemps restés sous silence, comme l’environnement ou le genre. Regard sur cette nouvelle approche de l’histoire.

L’histoire de France est un inépuisable sujet de discussion pour les personnalités politiques de tous bords, les médias, les Français et les étrangers qui observent les querelles qui agitent notre pays autour de son passé avec un mélange d’admiration, d’amusement et d’agacement. Les représentations qui en ont été proposées lors de la cérémonie des Jeux olympiques de Paris, à l’été 2024, ont ainsi fait couler beaucoup d’encre.

De fait, la connaissance du passé progresse au fil des recherches. Le contexte de naguère n’est plus celui d’aujourd’hui et les interprétations de l’histoire s’entrechoquent. On ne peut ainsi pas parler du passé colonial de la France en 2025 comme on le faisait au « temps béni des colonies », pour reprendre le titre de la chanson ironique et critique, en 1976, de Michel Sardou, Pierre Delanoë et Jacques Revaux – pour ne donner que cet exemple.

C’est pourquoi nous avons entrepris avec une centaine de spécialistes une Nouvelle Histoire de France. Publiée en octobre 2025 aux éditions Passés composés, cette somme de 340 éclairages, des Francs à la crise actuelle de la Ve République, de Vercingétorix à Simone Veil, tient compte des renouvellements de la discipline. Explications.

Une histoire trop longtemps tiraillée entre roman national et déconstruction

Non seulement la France a été au cœur de la plupart des principaux événements qui ont scandé l’histoire mondiale des derniers siècles, mais elle a également été en proie à des clivages politiques, religieux et idéologiques majeurs : les catholiques face aux protestants, les républicains contre les monarchistes ou encore la droite face à la gauche.

Ce passé, long, riche et tumultueux, n’a cessé d’être instrumentalisé. À partir du XIXe siècle, et plus particulièrement de la IIIe République, a dominé un « roman national » qui présentait la France sans nuances, puissante et rayonnante, et faisait de tous ces affrontements un préalable douloureux mais nécessaire à un avenir radieux.

À partir des années 1970, cette histoire a commencé à être déconstruite par le postmodernisme soucieux de rompre avec la modernité née pendant les Lumières, de libérer la pensée et de délivrer l’individu du passé pour l’inscrire pleinement dans le présent, en fustigeant les grands récits historiques.

Cette approche a été salutaire car elle a fait réfléchir, a remis en cause de fausses évidences et a fait progresser notre connaissance. Ainsi, pour reprendre le cas de l’histoire coloniale, Edward Saïd (1935-2003) a-t-il souligné, dans l’Orientalisme. L’Orient créé par l’Occident (1978, 1980 pour l’édition française), ce que le regard occidental porté sur l’Orient et sur les colonisés avait pu avoir de biaisé, voire de méprisant, même s’il a pu pécher lui-même par réductionnisme et caricature pour défendre sa thèse.

Et certains déconstructeurs en sont venus à noircir systématiquement l’histoire de France, comme le fit par exemple Claude Ribbe avec son Crime de Napoléon (2005) comparant l’esclavage et la traite négrière à la Shoah et Napoléon à Hitler.

Cependant, d’autres ont rapidement profité de ces derniers excès pour proposer de nouveau un roman national qui a pu prendre un tour essentialiste. Il existe pourtant et évidemment une voie entre la fierté aveugle des uns et la passion destructrice des autres.

Un troisième moment historiographique

De la fin des années 2000 au milieu de la décennie suivante, trois grandes entreprises collectives ont contribué à explorer une autre voie, à distance des interprétations partisanes.

À partir de 2009, Joël Cornette a ainsi dirigé, pour l’éditeur Belin, une Histoire de France en plus de dix volumes et 10 000 pages, faisant la part belle aux sources et aux illustrations. Claude Gauvard a pris peu après la tête d’une Histoire personnelle de la France en six volumes aux Presses universitaires de France, avant que Patrick Boucheron et un autre collectif ne publient, en 2017, aux éditions du Seuil, une Histoire mondiale de la France autour d’événements destinés à faire réfléchir.

Ces trois histoires proposaient un récit chronologique et s’appuyaient sur des spécialistes reconnus pour essayer de recentrer un pendule de l’histoire qui avait sans nul doute trop oscillé. Il nous est cependant apparu qu’il y avait nécessité de proposer un autre projet de grande ampleur, une Nouvelle Histoire de France. Nous avons emprunté cette même voie médiane, en rassemblant d’ailleurs plusieurs des autrices et auteurs qui avaient participé aux entreprises précédentes, mais en procédant aussi différemment, sous forme encyclopédique et chronologico-thématique.

Pierre Nora (1931-2025) qui avait dirigé une somme pionnière au milieu des années 1980, les Lieux de mémoire, nous disait au début du processus éditorial, en 2023, que le temps était sans doute venu d’ouvrir un troisième moment historiographique, celui d’une histoire soustraite à la fausse modernité qui conduit à ne lire le passé qu’avec des schémas actuels de pensée, celui d’une histoire renonçant au nouveau mantra qui rend l’Occident coupable de tous les maux et qui pare le reste du monde de toutes les vertus par un excès symétrique à celui par lequel le premier s’est longtemps pris pour le phare de la planète renvoyant le second à sa supposée arriération, celui enfin d’une histoire extraite du cadre étroit de notre hexagone pour montrer ce que la France doit au monde mais aussi ce qu’elle lui a apporté, dans un incessant mouvement de circulation à double sens, à la fois humain, matériel et immatériel.

De nouveaux sujets et des méthodes nouvelles

Avec cette Nouvelle Histoire de France, il s’agit de renoncer aux effets de mode, d’accorder toute leur place aux incontournables – les personnalités, les faits marquants, les œuvres majeures – sans omettre aucun des renouvellements majeurs de ces dernières années. La discipline a évolué en effet tant dans les objets (histoire impériale et coloniale, histoire des voix oubliées et des marges négligées, histoire du genre et des femmes, histoire environnementale…), que dans les méthodes (archéologie préventive, prosopographie, approche par le bas, jeu sur les échelles, big data…).

Parmi les nouveaux sujets historiques, l’environnement est très certainement l’un de ceux qui ont pris le plus de place dans la recherche en raison de la dégradation accélérée de la planète due au double processus de marchandisation du monde

– porté par un imaginaire économique de croissance infinie – et d’artificialisation de la planète – reposant sur un imaginaire technoscientifique prométhéen – qui se développe depuis la fin du XVIIIe siècle. En mettant en avant ces alertes précoces et les alternatives proposées dans le passé, l’histoire environnementale est porteuse de sens pour l’avenir et c’est pourquoi nous voulions lui accorder une grande place en confiant à Charles-François Mathis, son chef de file en France, le soin de l’aborder.

Quant aux méthodes nouvelles à disposition de l’historien, il nous faut dire un mot, là encore à titre d’exemple, de l’archéologie préventive. Celle-ci a commencé à se développer en France à partir des années 1970, avec l’ambition de préserver et d’étudier les éléments significatifs du patrimoine archéologique français menacés par les travaux d’aménagement et les projets immobiliers. Elle a permis de mieux comprendre l’héritage gaulois de la France et ses limites. Et qui mieux que Dominique Garcia, grand spécialiste de la Gaule préromaine et directeur de l’Institut national de la recherche archéologique préventive (Inrap) pour traiter le chapitre « Gaulois » de notre ouvrage ?

En outre, l’histoire n’est pas une discipline isolée mais elle s’enrichit du dialogue avec les autres sciences humaines et sociales et c’est dans cet esprit que nous avons aussi fait appel à 17 auteurs et autrices de 14 autres disciplines, habitués à travailler en profondeur historique : le géographe Jean-Robert Pitte, le spécialiste de la littérature française Robert Kopp, l’historienne de l’art Anne Pingeot, le philosophe Marcel Gauchet… Tous ont accepté de mettre leur savoir à la portée du plus grand nombre au prix d’un effort de synthèse et de vulgarisation.

C’est à ce prix que cette histoire en 100 chapitres, 340 éclairages et 1 100 pages se veut renouvelée et tout à la fois érudite et vivante, encyclopédique et ludique, dépassionnée… mais passionnante !

Éric Anceau a dirigé la « Nouvelle histoire de France » publiée aux éditions Passés composés.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview