28.01.2026 à 12:00

Jusqu’au XIXᵉ siècle, les sociétés islamiques ont célébré l’amour homoérotique dans leur littérature. Que s’est-il passé ensuite ?

Texte intégral (1992 mots)

De Rûmî à Hafez, l’amour homoérotique a nourri l’imaginaire spirituel islamique. Son effacement brutal, au tournant des XIXᵉ et XXᵉ siècles, révèle l’impact profond des valeurs victoriennes importées en terres d’islam.

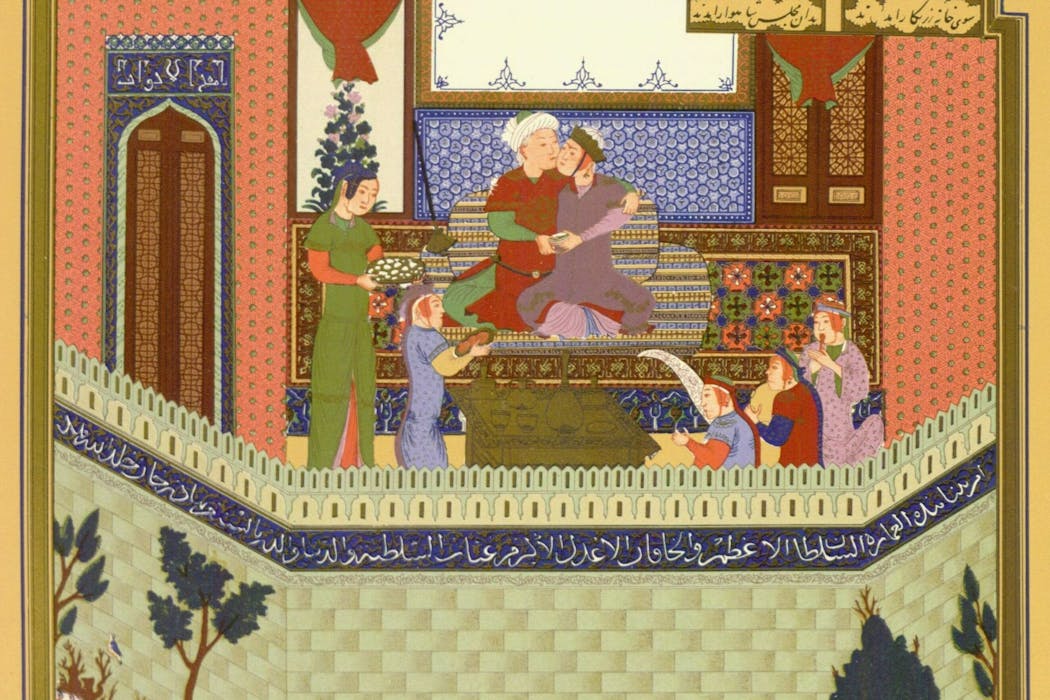

Pendant des siècles, la littérature issue des régions islamiques, en particulier d’Iran, a célébré l’amour homoérotique masculin comme un symbole de beauté, de mysticisme et de désir spirituel. Ces attitudes étaient particulièrement marquées durant l’âge d’or de l’islam, du milieu du VIIIᵉ siècle au milieu du XIIIᵉ siècle.

Mais cette tradition littéraire a progressivement disparu à la fin du XIXᵉ et au début du XXᵉ siècle, sous l’influence des valeurs occidentales et de la colonisation.

Le droit islamique et la licence poétique

Les attitudes à l’égard de l’homosexualité dans les sociétés islamiques anciennes étaient complexes. D’un point de vue théologique, l’homosexualité a commencé à être désapprouvée au VIIe siècle, dès la révélation du Coran au prophète de l’islam, Mohammed.

Cependant, la diversité des attitudes et des interprétations religieuses laissait place à une certaine marge de manœuvre. Les sociétés islamiques médiévales des classes supérieures acceptaient souvent ou toléraient les relations homosexuelles. La littérature classique d’Égypte, de Turquie, d’Iran et de Syrie suggère que toute interdiction de l’homosexualité était fréquemment appliquée avec clémence.

Même dans les cas où le droit islamique condamnait l’homosexualité, les juristes autorisaient les expressions poétiques de l’amour entre hommes, en soulignant le caractère fictif du vers. La composition de poésie homoérotique permettait ainsi à l’imagination littéraire de s’épanouir dans des limites morales.

Les littératures classiques arabe, turque et persane de l’époque faisaient une place à une poésie homoérotique célébrant l’amour sensuel entre hommes. Cette tradition a été portée par des poètes tels que l’Arabe Abû Nuwâs, les maîtres persans Saadi, Hafez et Rûmî, ainsi que les poètes turcs Bâkî et Nedîm, qui, tous, célébraient la beauté et l’attrait de l’aimé masculin.

Dans la poésie persane, les pronoms masculins pouvaient être utilisés pour décrire aussi bien des aimés masculins que féminins. Cette ambiguïté linguistique contribuait à légitimer davantage encore l’homoérotisme littéraire.

Une forme de désir mystique

Dans le soufisme – une forme de croyance et de pratique mystiques de l’islam apparue durant l’âge d’or de l’islam –, les thèmes de l’amour entre hommes étaient souvent utilisés comme symbole de transformation spirituelle. Comme le professeur d’histoire et d’études religieuses Shahzad Bashir le montre, les récits soufis présentent le corps masculin comme le principal vecteur de la beauté divine.

Dans le soufisme, l’autorité religieuse se transmet par la proximité physique entre un guide spirituel, ou cheikh (Pir Murshid), et son disciple (Murid).

La relation entre le cheikh et le disciple mettait en scène le paradigme de l’amant et de l’aimé, fondamental dans la pédagogie soufie : les disciples s’approchaient de leurs guides avec le même désir, le même abandon et la même vulnérabilité extatique que celle exprimée dans la poésie amoureuse persane.

La littérature suggère que les communautés soufies se sont structurées autour d’une forme d’affection homoérotique, utilisant la beauté et le désir comme métaphores pour accéder à la réalité cachée.

Ainsi, le maître saint devenait le reflet de la radiance divine, et l’élan du disciple signifiait l’ascension de l’âme. Dans ce cadre, l’amour masculin incarné devenait un vecteur d’anéantissement spirituel et de renaissance sur la voie soufie.

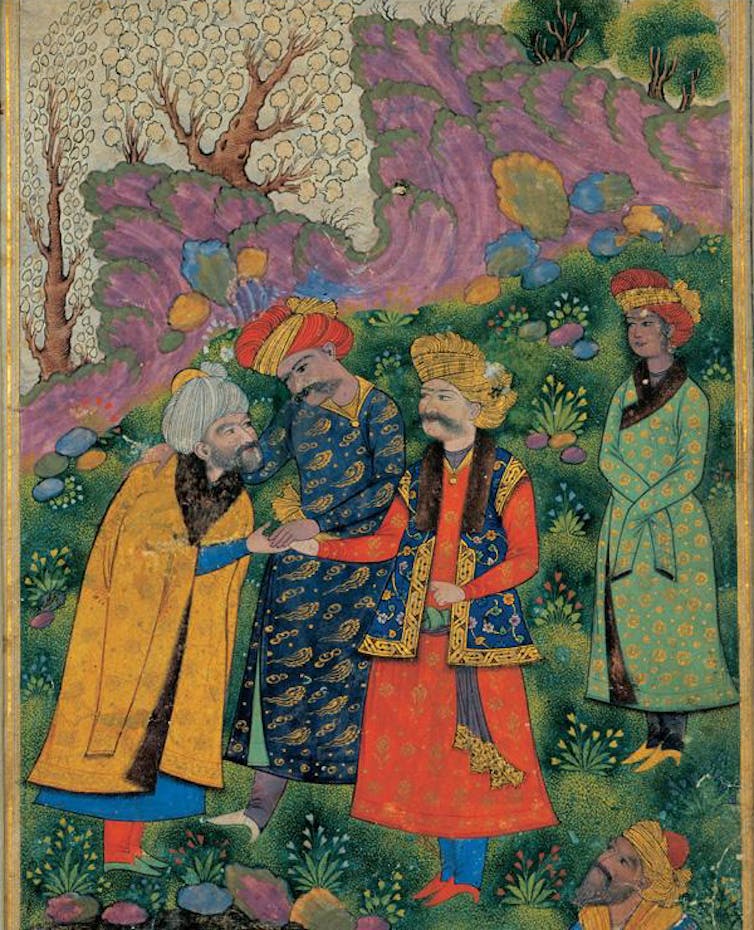

L’amour légendaire entre le sultan Mahmud de Ghazni et son esclave masculin Ayaz en offre un exemple parfait. Submergé par la vision de la beauté d’Ayaz nu dans un bain, le sultan Mahmud confesse :

Alors que je n’avais vu que ton visage, j’ignorais tout de tes membres. À présent, je les vois tous, et mon âme brûle de cent feux. Je ne sais lequel aimer davantage.

Dans d’autres récits, Ayaz se propose volontairement de mourir de la main de Mahmud, symbolisant la transformation spirituelle par l’anéantissement de l’ego.

La relation entre Rûmî et Shams de Tabriz, deux soufis persans du XIIIe siècle, constitue un autre exemple d’amour mystique entre hommes.

Dans un récit rapporté par leurs disciples, les deux hommes se retrouvent après une longue période de transformation spirituelle, s’embrassent, puis tombent aux pieds l’un de l’autre.

La poésie de Rûmî brouille la frontière entre dévotion spirituelle et attirance érotique, tandis que Shams remet en cause l’idée d’une pureté idéalisée :

Pourquoi regarder le reflet de la lune dans un bol d’eau, quand on peut regarder la chose elle-même dans le ciel ?

Les thèmes homoérotiques étaient si courants dans la poésie persane classique que des critiques iraniens ont affirmé :

La littérature lyrique persane est fondamentalement une littérature homosexuelle.

L’essor des valeurs occidentales

À la fin du XIXe siècle, écrire de la poésie célébrant la beauté et le désir masculins est devenu tabou, non pas tant en raison d’injonctions religieuses que sous l’effet des influences occidentales.

Les puissances coloniales britannique et française ont importé une morale victorienne, l’hétéronormativité et des lois antisodomie dans des pays comme l’Iran, la Turquie et l’Égypte. Sous leur influence, les traditions homoérotiques de la littérature persane ont été stigmatisées.

Le colonialisme a amplifié ce basculement, en présentant l’homoérotisme comme « contre nature ». Ce mouvement a été encore renforcé par l’application stricte des lois islamiques, ainsi que par des agendas nationalistes et moralistes.

Des publications influentes telles que Molla Nasreddin (publiée de 1906 à 1933) ont introduit des normes occidentales et tourné en dérision le désir entre personnes de même sexe, en l’assimilant à la pédophilie.

Les modernisateurs nationalistes iraniens ont mené des campagnes visant à purger les textes homoérotiques, les présentant comme des vestiges d’un passé « pré-moderne ». Même des poètes classiques tels que Saadi et Hafez ont été requalifiés ou censurés dans les histoires littéraires iraniennes à partir de 1935.

Un millénaire de libertinage poétique a alors cédé la place au silence, et la censure a effacé l’amour masculin de la mémoire littéraire.

Morteza Hajizadeh ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

27.01.2026 à 16:21

La psychanalyse peut-elle nous aider à comprendre la série « Pluribus » ?

Texte intégral (2094 mots)

Thriller psychologique teinté de comédie noire, la série Pluribus explore la perte de l’individualité. Sous ses airs d’utopie, le monde sans conflit mis en scène par Vince Gilligan devient terrifiant, car il efface tout ce qui fait le propre de l’humain : le manque, la colère et le libre arbitre.

Attention, si vous n’avez pas vu la première saison de Pluribus, cet article en divulgâche l’intrigue.

Pluribus fait l’unanimité tant du côté des spectateurs que de la critique. Il y est question d’une thématique classique en science-fiction : une entité extraterrestre transforme la population mondiale en une conscience unique (on peut penser à Terre et Fondation, d’Asimov, à l’Invasion des profanateurs de sépultures, de Don Siegel et même à un épisode de la série d’animation Rick et Morty).

Précisons d’emblée le point de départ du récit : un virus d’origine extraterrestre se propage sur Terre, mais, contrairement aux pandémies habituelles, il rend les gens parfaitement heureux, calmes et connectés à une sorte de conscience collective harmonieuse. Carol Sturka (jouée par Rhea Seehorn), une romancière cynique et névrosée, découvre qu’elle est l’une des rares personnes immunisées. Elle se retrouve alors dans la position paradoxale de devoir « sauver l’humanité du bonheur ».

Certes, le psychanalyste Jacques Lacan explique qu’il y a une forme de « goujaterie » à vouloir psychologiser les personnages d’une fiction, et a fortiori leur auteur. Mais il reste possible de proposer une « interprétation ». C’est ce que nous allons essayer de faire ici, à partir de trois questions que la série nous pose en filigrane.

Être moi, qu’est-ce que ça veut dire ?

« Soyez vous-même, les autres sont déjà pris. » Cette citation (probablement fausse) d’Oscar Wilde pose avec humour la question d’une individualité qui nous est finalement imposée par la condition humaine. Pluribus nous place dans un cas où cette individualité n’est non seulement plus une obligation, mais une exception.

La série nous montre deux catégories d’individu, ceux qui ont été contaminés et forment maintenant une conscience collective unique (appelons-les « eux ») ; et les 11 personnages immunisés, qui sont restés eux-mêmes, groupe auquel appartient l’héroïne de la série, Carol, autrice désabusée de romances de science-fiction à succès.

Tout au long de la série, le groupe majoritaire prétend que sa situation nouvelle est bien meilleure que celle d’avant. Si le souvenir spécifique d’un individu reste conservé (un personnage peut raconter qui il était avant), sa personnalité est détruite, pour rejoindre la personnalité unique et bienveillante de la conscience collective.

Le philosophe Paul Ricœur déduit de la psychanalyse freudienne que l’inconscient est le vrai lieu de la subjectivité. C’est-à-dire que l’inconscient n’est pas le négatif de la conscience ou un fourre-tout de ce qui n’est pas conscient, mais le lieu originel où se forme l’identité. Ce qui fait que je suis moi et pas un autre, ça n’est pas ma personnalité, mais bien mon inconscient. Si l’on suit ce précepte, il ne peut y avoir de subjectivité sans inconscient et nous devons donc nous demander si le groupe « eux » a un inconscient pour comprendre ce que signifie de rejoindre la conscience collective.

Il semble évident que, pour le groupe contaminé, il n’y a pas d’inconscient individuel, qui serait propre à chaque individu. Mais existe-t-il chez « eux » un inconscient collectif, comme il existe une conscience collective ?

Si l’on retrouve bien l’expression d’émotions, telles que la joie (omniprésente ad nauseam) et la peur, ou même l’expression de besoins biologiques, y compris l’impératif de contaminer l’autre, il n’y a rien dans le comportement du groupe contaminé qui fasse penser à du désir, par exemple. C’est-à-dire qu’il n’y a jamais chez « eux » l’expression d’un manque. Or, notre subjectivité découle du fait que nous sommes des sujets divisés par le langage, c’est-à-dire que le fait de parler nous permet de mettre à distance le monde en le symbolisant. Mais du fait de cette distance, il reste un manque impossible à combler : nous ne sommes pas fusionnés avec le monde, quelque chose reste extérieur à nous.

On peut supposer que cette entité n’habite pas sa langue comme nous habitons la nôtre. Les mots, pour « eux », sont juste l’outil technique d’une expression alors que, pour nous, ils structurent le rapport au monde.

Devenir « eux », ça n’est pas juste se diluer dans un grand tout ou recevoir toute l’humanité en soi, c’est passer d’un rapport au monde structuré par un manque absolu à la possibilité d’être un tout sans extérieur à soi-même. Nous sommes tout, donc nous ne sommes plus.

Aimer, qu’est-ce que ça veut dire ?

Au fil des épisodes, Carol – qui perd sa compagne au cours du premier épisode – se lie à Zosia, une femme qui appartient au groupe contaminé, et finit par développer une relation amoureuse avec elle. Mais est-ce réellement de l’amour ? Lacan nous dit dans une phrase célèbre que « l’amour, c’est donner ce qu’on n’a pas à quelqu’un qui n’en veut pas ».

Essayons de comprendre cette phrase.

« L’amour, c’est donner ce qu’on n’a pas » : ce que veut dire Lacan, c’est que l’amour, ça n’est pas offrir des fleurs ou un objet, c’est d’abord et avant tout offrir un manque. C’est présenter à l’autre son incomplétude et donc lui laisser une place puisque nous ne sommes pas comblés.

« À quelqu’un qui n’en veut pas » : nous présentons notre incomplétude, certes, nous laissons à l’autre une place, certes, mais ce manque que nous lui offrons ne répond pas à son manque à lui. Pour la psychanalyse, l’amour, ça n’est pas combler le désir de l’autre mais tisser avec l’autre le lien du manque.

Dans Pluribus, le manque de Carol est largement mis en scène au travers de sa souffrance et de sa misanthropie. Nous pouvons le voir à travers la façon dont elle vit son deuil mais aussi dans son impossibilité à assumer publiquement sa sexualité. « Eux » semblent l’accepter telle qu’elle est et vouloir combler son manque. Pour autant, est-ce vraiment de l’amour ?

Si l’on reste attaché à la théorie lacanienne, « eux » doivent avoir un manque fondamental à offrir. Or, si nous pouvons en avoir l’illusion en même temps que Carol, nous nous rendons compte en définitive que le manque qu’ils mettent en avant (Carol n’est pas fusionnée) n’est pas un manque au sens d’un sujet divisé par le langage, car ce manque-là ne peut jamais être comblé. Nous pourrions considérer leur manque comme fondamental si après avoir fusionné tout l’univers, ils se rendaient compte que ça ne suffisait pas à les satisfaire.

Si « eux » ne ressentent pas de manque au sens du manque fondamental que ressent Carol, alors l’amour que Carol pense ressentir est un malentendu. Et l’on retombe sur la phrase de Lacan citée plus haut. Carol donne ce qu’elle n’a pas, c’est-à-dire son manque, à quelqu’un qu’elle ne pense pas pouvoir satisfaire. L’erreur de Carol porte sur ce dernier point : le don de Carol pourrait tout à fait les satisfaire ! Mais ça n’est donc pas de l’amour au sens où l’entend Lacan.

Qu’est-ce que le bien ?

Dans la série, « eux » incarnent une forme de bienveillance poussée à son extrême (ils préfèrent mourir de faim que de tuer), mais ne comprennent pas en quoi manger des cadavres humains reconditionnés en brique de lait représente une violence symbolique insupportable pour Carol. De leur point de vue, ils incarnent une morale universelle dans un monde où toute forme de violence aurait disparu.

Une morale tellement universelle qu’elle peut se passer du consentement des gens. C’est ainsi qu’ils envahissent la Terre sans préavis et n’ont aucun scrupule à contraindre Carol à devenir l’une des leurs, mais « pour son bien ».

Lacan aborde cette question d’une morale universelle dans un texte classique intitulé « « Kant avec Sade ». Il y commente le propos de Kant qui cherche à concevoir une morale parfaite, c’est-à-dire reposant sur une pure logique dénuée de tout sentiment subjectif. Lacan souligne que cette morale sans désir va à l’encontre de celui qui la porte et constitue donc une forme de masochisme. Lacan explique qu’une loi universelle, en niant le sujet qui la porte, devient son persécuteur, sous forme d’une injonction impossible à satisfaire. C’est ce que l’on voit dans la série quand la morale incite les contaminés à se laisser mourir de faim.

Dans ce même texte, Lacan explique que la morale de Sade est l’application logique des principes kantiens. Chez Sade, le bourreau doit aussi agir sans sentiment, en ne visant que la jouissance de sa toute-puissance, ce qui est tout à fait compatible avec la structure d’une morale kantienne.

Donc Kant pose les principes d’une loi pour elle-même, toute-puissante et sans sujet ; et Sade met concrètement en application ce principe en proposant une doctrine où la toute-puissance du bourreau est une fin en soi.

On retrouve la même logique dans la morale du groupe fusionné. Leur souverain bien repose sur une fusion totale et ils sont, comme le dit un personnage, poussés par cet impératif biologique. Aucun désir ni sujet n’intervient ici, si ce n’est une morale universelle qui s’impose comme seul discours de vérité.

Finalement, Lacan proposera dans le le Séminaire, Livre VII une « éthique du désir » pouvant se substituer à la morale universelle. L’idée n’est alors plus de chercher le bien de tous, mais d’être fidèle à son désir, quitte à en assumer la tragédie. Cela rejoint la dernière scène de la première saison de la série où Carol, fidèle à sa volonté de ne pas fusionner, préfère apparemment déclencher une guerre nucléaire. Allant au bout de son désir, elle assume les conséquences tragiques de son choix.

Maxime Parola ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

26.01.2026 à 16:30

« Les Sept Cadrans » : la série Netflix transforme le huis clos campagnard d’Agatha Christie en une réflexion sur la guerre

Texte intégral (1426 mots)

Netflix revisite les Sept Cadrans en déplaçant le regard : l’intrigue policière devient un prisme pour interroger la guerre, l’ordre social et l’impensé impérial de la Grande-Bretagne des années 1920. Une relecture ambitieuse qui montre combien Agatha Christie reste une autrice de son temps – et du nôtre.

Nous sommes en 1925 et l’action se déroule à Chimneys, la demeure aristocratique anglaise de la famille Caterham. Mais Lady Caterham (Helena Bonham Carter), désargentée, a été contrainte de la louer à l’industriel Sir Oswald Coote (Mark Lewis Jones).

À l’intérieur, la réception bat son plein. Misanthrope et réduite au rôle de simple invitée chez elle, Lady Caterham glisse à sa fille, Lady Eileen « Bundle » Brent (Mia McKenna Bruce), que l’assemblée réunit « l’industrie, l’aristocratie et la diplomatie (le Foreign Office).

Les Sept Cadrans, d’Agatha Christie, publié en 1929, est aujourd’hui adapté en une minisérie Netflix de trois épisodes, écrite par Chris Chibnall et réalisée par Chris Sweeney. Cette nouvelle version s’appuie sur l’énigme des sept cadrans non seulement pour divertir, mais aussi pour interroger le monde politique et impérial que les romans de Christie laissent souvent en arrière-plan.

Au cours de la réception, de jeunes fonctionnaires du Foreign Office jouent un tour à l’un de leurs collègues en disposant huit réveils dans sa chambre, programmés pour sonner à 11 h 15 le lendemain matin. La raison ? Leur camarade est réputé pour faire la grasse matinée.

Lorsqu’un des réveils disparaît, avant d’être retrouvé par Bundle sur la pelouse, tandis que les sept autres sont soigneusement disposés sur la cheminée de la chambre, la jeune femme est perplexe. Et puis on découvre un mort – évidemment.

Malgré l’idée que la victime aurait été fragilisée par le stress lié à son travail – écho contemporain à la hausse rapide des troubles de santé mentale chez les jeunes hommes –, Bundle rejette la thèse du suicide. Sa certitude se renforce lorsqu’elle tombe plus tard sur un autre jeune homme mort, dont les derniers mots sont « sept cadrans ». Mais à quoi fait-il réellement référence ? Bundle entend bien le découvrir.

En suivant une silhouette qu’elle ne parvient pas à identifier, elle se retrouve à Scotland Yard, face à l’inspecteur Battle (Martin Freeman, habitué des enquêtes pour avoir incarné Watson dans la série Sherlock de la BBC). Bundle fait écho à Irene Adler, héroïne d’Arthur Conan Doyle dans Un scandale en Bohême (1891). Dans la nouvelle, Adler suit Holmes déguisé jusqu’à Baker Street et devient la seule personne à avoir jamais réussi à le déjouer.

À l’image d’Adler, l’intrépide Bundle s’impose comme une figure féministe avant l’heure. McKenna Bruce est remarquable, habitant le rôle avec une assurance éclatante. Dans le roman de Christie, Bundle est incapable de tenir en place. Dans la série, elle saute par la fenêtre d’un étage de Chimneys pour échapper à une demande en mariage formulée par un député ennuyeux et plus âgé, George Lomax (Alex Macqueen), et atterrit dans le jardin, où Kettle examine des indices. Son choix est fait.

Ce que Netflix ajoute à l’œuvre originale de Christie

La série adopte une forme de thriller plus directe que dans le roman de Christie. Dans l’introduction à l’édition anglaise de 2026 de référence, dotée d’une nouvelle couverture et d’un nouveau design signés Netflix, Val McDermid avance que Christie évolue sur le terrain du pastiche de thriller, en détournant les thrillers virils à la John Buchan qui dominaient les années 1910 et 1920. Elle se rapproche aussi de Jane Austen par son regard ironique sur l’aristocratie, les nouveaux riches et les jeunes hommes et femmes désœuvrés.

La série fait écho à la critique des structures sociales rigides des années 1920, dont Agatha Christie est coutumière. Lady Caterham, incarnée par Helena Bonham Carter, remarque que Lady Coote ne devrait pas remercier les domestiques ; Sir Oswald Coote affirme, lui, que la distinction sociale peut s’acheter. Mais la série va plus loin encore. Christie évitait toute référence directe à la Première Guerre mondiale, écrivant dans la décennie qui a suivi sa fin. Pendant le conflit, elle avait travaillé à la distribution de médicaments pour le Voluntary Aid Detachment de la Croix-Rouge britannique à Torquay, où elle a acquis sa connaissance des poisons. À l’inverse, dans la série, la guerre est pleinement intégrée à l’intrigue.

Bundle a perdu son frère pendant le conflit, et le lien qui l’unit aux jeunes hommes du Foreign Office est une camaraderie forgée par la guerre. Ce sont, d’une certaine manière, des survivants. La vie, dit-elle, est « bien trop courte ». Son frère disparu, Tommy, servait aux côtés de Gerry Wade (Corey Mylchreest), du Foreign Office, qui a rapatrié son corps.

Au point culminant de la série, Lady Caterham, interprétée avec une force saisissante par Helena Bonham Carter, décrit la guerre comme un « abattoir », dénué de toute « gloire ». À la manière de Miss Havisham, elle vit recluse dans une maison où un seau recueille l’eau qui goutte d’un toit qui fuit et où le valet n’est même plus payé. Et, comme le découvre Bundle – conformément aux codes du thriller – personne n’est réellement ce qu’il paraît être.

Mais la dénonciation la plus glaçante des empires européens et des structures sociales qui les soutiennent est portée par le Dr Cyril Matip (Nyasha Hatendi), brillant inventeur camerounais que Lomax tente d’attirer au service de la Grande-Bretagne en l’invitant dans sa demeure de campagne.

Lorsque Lomax organise une chasse au faisan pour divertir son invité, Matip refuse d’y prendre part : il a vu ce que les armes peuvent faire. Pendant ce temps, le regard de Bundle s’attarde sur un faisan abattu dans l’herbe. À table, Matip décrit les ravages de la guerre et la défiance qu’elle a fait naître chez lui à l’égard des Européens. Il a vu comment « des Africains ont combattu d’autres Africains pour des Européens blancs ».

En hommage à l’œuvre la plus célèbre de Christie, le Crime de l’Orient-Express, le dénouement se joue à bord d’un train. Mais tout n’est pas encore terminé. Le dernier secret – celui des Sept Cadrans – reste à révéler. Les Sept Cadrans d’Agatha Christie actualise l’œuvre de l’autrice, et le fait avec brio.

Catherine Wynne ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

25.01.2026 à 18:15

Qu’est-ce qui remplit les salles de concerts ? La nostalgie, pardi !

Texte intégral (2053 mots)

Sur les scènes françaises, les tournées « best of » ou les « tribute bands » occupent le terrain, remplissent les salles et structurent un véritable marché de la « nostalgie live ». Portés par une demande de réconfort émotionnel et de communion mémorielle, ces spectacles du passé remixés au présent interrogent. Comment comprendre un tel engouement pour ces pastiches et jusqu’où cette économie de la copie peut-elle prospérer sans trop étouffer la création ?

Une semaine ordinaire en France permet d’aller voir « One Night of Queen » (le plus célèbre tribute band de Queen) le 20 janvier à Paris, « Covertramp » (hommage à Supertramp), le 24 janvier à Reims et « Cloudbusting » (tribute à Kate Bush) le même jour à Paris. D’autres préféreront « Génération Céline » (Céline Dion) à Aix-en-Provence, le 21 janvier, « Balavoine, ma bataille » à Nantes (23 janvier) ou « Soul Cages Trio » (un hommage jazzy à Sting), le 28 janvier à Paris. Il y en a pour tous les goûts ! Le défilé de ces groupes qui rendent hommage à un artiste est ininterrompu sur les scènes françaises et les salles ne désemplissent pas.

Notre recherche sur cette tendance nostalgique du spectacle vivant a conduit à distinguer trois registres différents, tout aussi couronnés de succès.

D’abord, les tournées « best of » où les artistes rejouent leur propre catalogue : les Rolling Stones (tournée Sixty, 2022) enchaînent 14 concerts en Europe devant plus de 750 000 spectateurs pour environ 120 millions de dollars (102,2 millions d’euros) de revenus, complétés par un merchandising intensif qui donne lieu, en moyenne, à deux achats à 40 euros par spectateur. La célébration d’albums iconiques renforce le mécanisme à l’image de U2 et de son LP emblématique The Joshua Tree avec ses 2,7 millions de spectateurs sur une cinquantaine de dates. En France, les chiffres illustrent la robustesse et le caractère massif de cette demande, qu’incarne par exemple Étienne Daho porté par ses 50 concerts pour environ 300 000 billets vendus. Dans cet ensemble, on peut inclure des groupes qui persévèrent à jouer leur catalogue et à se produire sur scène, alors même qu’aucun des membres fondateurs n’est encore présent, à l’instar de Dr Feelgood !

Ensuite, les concerts de reprises réalisés par des artistes déjà identifiés, qui utilisent des standards pour élargir l’audience et sécuriser la billetterie. L’exemple central est la tournée associée à l’album Imposteur de Julien Doré daté de 2024, fondée sur des reprises et présentée comme un succès majeur correspondant à plus de 500 000 billets sur environ 60 dates, dont la majorité vendue avant le lancement.

Poussée à son paroxysme, cette logique mène des artistes à s’approprier non pas quelques chansons, mais tout le répertoire d’un autre, plus connu et suffisamment fédérateur pour remplir des salles. C’est le cas de la chanteuse américaine minimaliste Cat Power qui, en 2022, a sorti un album reprenant un concert entier de Bob Dylan, celui de 1966 à Manchester. Elle ne se contente pas de chanter ses chansons : elle recrée l’ambiance, l’ordre des morceaux, l’intensité de l’époque. C’est une façon de rendre hommage, mais aussi d’augmenter sensiblement son audience personnelle, alors que la carrière de Cat Power connaissait un creux. Le succès est tel que la chanteuse a élargi le répertoire, en se focalisant toujours sur le Dylan première période et les titres qu’il refuse obstinément de jouer sur scène.

Enfin, il apparaît que le phénomène le plus structurant est celui des « groupes hommage » (tribute bands), qui reproduisent le répertoire

– et souvent l’esthétique – d’un groupe mythique. Il met en lumière la professionnalisation des artistes via des tourneurs spécialisés. En France, une entreprise, comme Richard Walter Productions, revendique à elle seule environ 700 000 entrées payantes en 2025 aux hommages à plusieurs artistes ou groupes qualifiés souvent de « mythiques », tels que Queen, ABBA, Pink Floyd, Genesis, etc. Sur ce segment spécifique des tribute bands, le marché mondial était évalué en 2018 entre 500 millions et 750 millions de dollars (soit entre 425 millions et 638,9 millions d’euros) et reste en forte croissance.

Alors que les tournées best of sont appelées à disparaître avec la mise à la retraite inévitable des groupes phares de la fin du XXᵉ siècle et qu’un artiste qui ne fait que des reprises risque d’y perdre son identité, les tribute bands constituent la tendance majeure de l’expression de la nostalgie sur scène.

Une salle, deux ambiances : un atout majeur pour tous les artistes

Le public qui se rend aux concerts de simili-Queen ou de faux Beatles correspond à deux catégories de consommateurs, aux logiques d’achat assez différentes. La première est constituée de fans « historiques », plus âgés et plus aisés, recherchant l’authenticité (musicale, visuelle, narrative) et dépensant davantage en produits dérivés. Les tribute bands qui s’adressent à cette frange fanatique du public font dans le haut de gamme, avec des shows à la qualité musicale très travaillée, aux costumes, décors et effets visuels reproduisant scrupuleusement les spectacles connus des adeptes présents dans la salle.

La seconde est plus orientée « grand public ». Elle est attirée par la dimension festive et intergénérationnelle, et par des prix plus accessibles : des tribute bands proposent des billets autour de 30–40 €, quand certains concerts de stars atteignent des niveaux nettement supérieurs. C’est le cas pour U2 (autour de 300 euros, contre 30 euros pour son cover band 4U2) comme ce le fut pour Beyoncé au Stade de France… avec des places à plus de 600 euros !

L’inflation du prix des places de concert alimente mécaniquement la demande de substituts crédibles. Cela s’est avéré flagrant lors de la reformation du groupe Oasis : le manque de billets et la spéculation à la hausse des enchères (officielles ou non) ont entraîné un report du public vers des groupes comme Definitely Oasis, à moins de 20 livres sterling (23 euros environ) l’entrée.

Si les tarifs des tribute bands augmentent d’environ 15 % lorsque l’artiste original est décédé, il y a aussi des effets d’entraînement avec les artistes toujours en activité : quand l’original repart en tournée, la promotion bénéficie indirectement aux copies tandis que la rareté et la concentration des dates dans les grandes villes laissent des territoires entiers accessibles aux tribute bands, sans cannibaliser frontalement les tournées des stars dont ils s’inspirent.

La nostalgie musicale, un réconfort émotionnel attesté

Pourquoi cette tristesse douce-amère qui se mêle à la quête d’expériences révolues est-elle tant recherchée par les fans qui communient lors de shows passéistes ? L’explication n’est pas seulement économique.

La nostalgie est un mécanisme de réconfort émotionnel, de réduction du stress et de renforcement du sentiment d’appartenance, particulièrement recherché en périodes d’incertitude (crises sanitaires, géopolitiques, climatiques). Ces résultats scientifiques qui attestent des effets positifs du sentiment de nostalgie montrent aussi que la musique s’avère justement le meilleur moyen de générer ces réactions analgésiques et apaisantes.

En outre, le concert nostalgique fonctionne comme une « communion mémorielle » : on y revit une époque, on y transmet (parents/enfants), et l’on y partage une identité culturelle. Cet aspect positif de la nostalgie n’a pas échappé au marketing, qui s’en est largement emparé : packaging rétro, rééditions, retours de marques et d’objets…

La lassitude peut-elle gagner le public ?

Cette exploitation intensive de la nostalgie live n’est pas sans risque. D’une part, si les tribute bands se calquent sur les logiques inflationnistes des concerts originaux, le public acceptera-t-il de payer très cher pour une copie, même (presque) parfaite ? C’est loin d’être acquis et pourtant c’est le mouvement constaté par les professionnels. D’autre part, la saturation est de plus en plus probable. Les gains potentiels attirent de nouveaux entrants, au risque d’une baisse de qualité et d’une fatigue du public. Sans compter qu’une industrie trop centrée sur l’hommage peut freiner la création et la rupture, alors même que la musique est aussi un laboratoire d’innovation.

À l’heure où le numéro 1 des ventes d’album en Angleterre est Wish You Were Here des Pink Floyd, sorti en septembre 1975, la nostalgie musicale live en tant que spectacle vivant innovant apparaît comme un marché robuste, structuré et technologiquement dopé (notamment par les hologrammes et par l’intelligence artificielle). Il est tiré par une demande de réconfort et par des modèles économiques efficaces fondés sur une billetterie et un merchandising habile. Toutefois, sa durabilité dépendra de sa capacité à éviter l’inflation mimétique, la saturation qualitative et le basculement vers une « nostalgie de substitution » qui étoufferait l’émergence des nouveautés.

À moins que le « mashup 100 % live » vienne au contraire réinventer la nostalgie et la marier avec le présent comme le proposent des groupes, comme Analog Society dont le succès récent est tout à fait rafraîchissant.

Pour cette recherche, Joan Le Goff a bénéficié d'un financement du Centre national de la musique.

Marc Bidan a reçu, pour cette recherche, un financement en provenance du centre national de la musique (CNM Lab)

Pour cette recherche, Sylvie Michel a bénéficié d'un financement en provenance du Centre national de la musique.

22.01.2026 à 17:24

Quand les morts quittent les cimetières : nouvelles pratiques funéraires en pleine nature

Texte intégral (2049 mots)

À bas bruit et hors de portée du marché du funéraire se développent des pratiques qui déplacent les morts et leur mémoire à l’extérieur des cimetières dans des espaces bien réels, au plus près des valeurs et des façons de vivre dont témoignaient les défunts de leur vivant.

Lorsque les espaces et les pratiques funéraires sont évoquées dans les médias ou dans le débat public français, c’est souvent aux approches des fêtes de la Toussaint, pour relater des évolutions en cours dans la gestion des funérailles et des cimetières, et pour mettre en lumière des services, objets, techniques ou technologies dites innovantes. Il était ces dernières années beaucoup question de l’écologisation des lieux et techniques funéraires (cimetière écologique, humusation/terramation, décarbonation des produits funéraires) et de la digitalisation du recueillement et de la mémoire (deadbots, gestion post-mortem des volontés et des données numériques, cimetières et mémoriaux virtuels, télétransmission des cérémonies). Mais discrètement, d’autres pratiques voient le jour.

Avec la crémation devenue majoritaire dans de nombreux territoires français, la dispersion des cendres dite « en pleine nature » se révèle très importante dans les souhaits et de plus en plus dans les faits. Pourtant, beaucoup méconnaissent le cadre légal et pratique de son application. Cet article dévoile les premiers éléments d’une enquête en cours sur ces pratiques discrètes qui témoignent d’une émancipation créative face à la tradition contraignante de la tombe et du cimetière.

Des cimetières de moins en moins fréquentés

Le cimetière paroissial du Moyen Âge qui plaçait la communauté des morts au plus près de l’église et de ses reliques, dans la promesse de son salut et de sa résurrection, était un espace multifonctionnel et central de la vie et de la ville.

Le cimetière de la modernité matérialiste et hygiéniste est déplacé dans les faubourgs, puis dans les périphéries de la ville et se marginalise petit à petit des fonctions urbaines. Il devient, comme le dit Foucault, « l’autre ville, où chaque famille possède sa noire demeure », puis s’efface dans l’étalement urbain du XXᵉ siècle.

À l’intérieur des murs d’enceinte qui deviennent souvent de simples clôtures, les aménagements pour gagner de la place se rationalisent, le mobilier d’un marché funéraire en voie d’industrialisation et de mondialisation se standardisent. Les morts y sont rangés pour des durées de concessions écourtées au fil des décennies, sous la pression d’une mortalité en hausse (génération des baby-boomers) et de la saturation de nombreux cimetières urbains.

Dans les enquêtes régulières sur « Les Français et les obsèques » du Centre de recherche pour l’étude et l’observation des conditions de vie (Credoc), les Français montrent peu d’affection envers leurs cimetières qu’ils jugent trop souvent démesurés, froids et impersonnels. Alors qu’ils étaient encore 50 % en 2005, seulement un tiers des Français de plus de 40 ans continuent vingt ans plus tard à les fréquenter systématiquement à la Toussaint. Pour les Français de moins de 40 ans, ils sont encore moins souvent des lieux de sens et d’attachement.

Cette désaffection des cimetières, pour beaucoup synonymes d’enfermement tant matériel que mental, explique en partie l’essor de la crémation et de la dispersion des cendres. Les dimensions économiques et écologiques de ces options funéraires viennent renforcer cette tendance et s’exprime par la volonté de ne pas être un poids pour ses descendants (coût et soin des tombes) et/ou pour la planète (bilan carbone important de l’inhumation avec caveau et/ou monuments), et illustre la proposition de garder l’espace pour les vivants et le vivant.

La crémation gagne du terrain

La crémation était répandue en Europe avant sa christianisation et a même été conservée marginalement en périodes médiévales dans certaines cultures d’Europe du Nord. Elle se pratiquait sur des bûchers à foyer ouvert. Sa pratique, telle que nous la connaissons aujourd’hui en foyer fermé, a été rendue possible par la technique et l’essor du four industriel au XIXᵉ siècle, et par la plaidoirie des crématistes depuis la Révolution française jusqu’à la fin du XXᵉ siècle où la pratique va définitivement s’instituer.

Si les fragments calcinés étaient conservés communément dans des urnes, c’est avec l’apparition d’une autre technique industrielle dans le crématorium que la dispersion a pu être imaginée : la crémulation, c’est-à-dire la pulvérisation des fragments sortant du four, permettant d’obtenir une matière plus fine et moins volumineuse. Cette matière aseptisée par le feu et homogénéisée par le crémulateur peut alors rejoindre d’autres destinations que les urnes et le cimetière.

En 1976, un nouveau texte de loi insiste sur le fait que les cendres doivent être pulvérisées afin que des ossements ne puissent y subsister, effaçant ainsi ce qu’il restait de la forme d’un corps. Cette nouvelle matérialité peut alors se fondre discrètement dans nos lieux familiers, les morts se retrouvent inscrits dans nos paysages privilégiés, et leur souvenir cohabiter avec les activités récréatives et contemplatives qui prennent place dans les espaces naturels non aménagés.

Dispersions, disséminations

Alors que de nombreux Français pensent cette pratique interdite, son cadre légal et la notion de « pleine nature » ont été précisés en 2008 et en 2009. Ce cadre relativement souple permet de disperser les cendres en de nombreux espaces publics (sauf sur la voie publique) à distance des habitations et zones aménagées (parcs naturels, forêts, rivières, mers éloignées des côtes), plus difficilement dans des espaces privés avec la contrainte d’obtenir l’accord du propriétaire d’un droit d’accès perpétuel, ce qui peut poser des difficultés au moment des ventes de biens.

La « pleine nature » correspond aujourd’hui à une proportion d’un quart à un tiers des destinations des cendres des défunts crématisés. À travers un appel à témoignages anonymes en ligne ouvert dans le cadre d’une recherche en cours depuis 2023, une cinquantaine de micro-récits de dispersion ont été rassemblés et constituent un premier corpus pour appréhender ces pratiques discrètes et peu documentées. Ces récits inédits révèlent l’émergence de nouvelles manières de rendre hommage aux défunts et de donner du sens à la mort et à la vie dans des mondes contemporains en crise.

Le milieu du funéraire et de l’accompagnement du deuil se montre réservé face à cette pratique donnant lieu à des sépultures labiles en proie aux éléments, sans traces tangibles identifiant les défunts et sans garantie de se transmettre au fil des générations, parfois difficilement accessibles, isolant ces morts des autres morts.

Faisant écho de craintes parfois avérées de rendre les deuils plus difficiles, les professionnels doivent pourtant reconnaître que malgré ces nouvelles contraintes et en en connaissant les impacts, une grande majorité de ceux qui ont opté pour la dispersion des cendres de leurs proches reconduiraient le choix de la dispersion. Celui-ci procure en effet pour beaucoup le sentiment de satisfaction d’une promesse tenue, car ces destinations en pleine nature sont le souhait des vivants et se déroulent par là même souvent sans conflit au sein de l’entourage des défunts, dans une ambiance de sérénité, d’un chagrin joyeux, dans les plis de paysages et de territoires intimes aux défunts et à leurs proches.

De manière assez naturelle découlent de ces gestes et territoires de dispersion des prises pour imaginer des suites, des revisites, des retrouvailles sous forme de balades discrètement ritualisées, de pique-niques et baignades mémorielles, des façons de reconfigurer et d’entretenir les liens avec les défunts dans ces territoires familiers.

La diversité des lieux, des configurations sensibles et des éléments en jeu dans les dispersions renouvelle les possibles en termes de gestes et d’actes d’hommage envers les défunts, lors de la dispersion comme après, imbriquant la mémoire du mort dans des souvenirs de moments de vie partagés.

Les mises en gestes de la dispersion partiellement décrites dans les témoignages et rejouées dans le collectif de chercheurs pour en révéler des parts implicites montrent aussi des moments de flottement, des maladresses, des surprises et des improvisations qui se dénouent souvent avec des rires. Ce sont autant de marges dans lesquelles peuvent s’engouffrer des marques de la singularité des personnes en jeu, manœuvrer avec audace les acteurs pour s’approprier ces moments importants et en faire des lieux d’individuation, un premier pas actif sur le chemin du deuil.

Avec la dispersion des cendres, le lieu de nos morts n'est plus l'espace autre, l’autre ville des noires demeures, mais l‘espace même qui accueille nos moments de vie, là où nos beaux souvenirs avec eux font gage d’éternité. La suite de l’enquête permettra d’affiner les contours et les potentialités de ces pratiques.

Cet article est publié dans le cadre de la série « Regards croisés : culture, recherche et société », publiée avec le soutien de la Direction générale de la démocratie culturelle, des enseignements et de la recherche du Ministère de la culture.

Pascaline Thiollière ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

21.01.2026 à 16:15

« Une bataille après l’autre » et « The Mastermind » : quand le cinéma révèle les échecs de la gauche aux États-Unis

Texte intégral (1622 mots)

Explorant les failles et la défaite de la gauche américaine, les films Une bataille après l’autre, de Paul Thomas Anderson, et The Mastermind, de Kelly Reichardt, sont sortis en 2025, tandis que Donald Trump faisait un retour en force. Chacun à leur manière, ils invitent les membres et les partisans du parti démocrate comme les activistes de la gauche radicale à faire leur introspection.

La victoire de Donald Trump en novembre 2024 a provoqué une profonde remise en question dans les forces de gauche de la politique états-unienne. Après avoir échoué, les dirigeants du Parti démocrate ont passé l’essentiel de l’année 2025 à panser leurs plaies, tandis que Trump lançait ce que ses opposants considèrent comme une attaque frontale contre la démocratie américaine.

La nouvelle année a commencé par de nouveaux scandales, tant sur le plan intérieur qu’extérieur, l’administration Trump agissant avec une impunité de plus en plus effrayante.

À lire aussi : Le raid de Donald Trump sur le Venezuela laisse présager un nouveau partage du monde entre les grandes puissances

Combinée à la poursuite de la montée du populisme de droite et de l’autoritarisme dans le monde entier, la version « 2.0 » de Trump est vécue comme une crise existentielle pour la gauche.

Le pays a déjà connu une telle situation. Les mouvements de protestation de gauche des années 1960 aux États-Unis ont contribué à d’importants changements législatifs – en particulier dans le domaine des droits civiques –, mais ils ont souvent été caricaturés comme étant « antipatriotiques », notamment s’agissant de la guerre du Vietnam. Le sentiment que le pays se désagrégeait sous l’action de jeunes radicaux violents a conduit la « majorité silencieuse » conservatrice à offrir la victoire électorale à Richard Nixon en 1968.

Depuis lors, la gauche institutionnelle étasunienne s’est détournée de l’idéalisme des années 1960 et a plutôt proposé des changements progressifs et limités. Mais cette stratégie ne s’est sans doute pas révélée très efficace au cours du dernier demi-siècle.

Dans le contexte d’une nouvelle défaite et d’un énième cycle d’introspection, il semble donc approprié que deux films portant sur les échecs de la politique révolutionnaire de gauche des années 1960 et 1970 émergent presque simultanément avec le retour en force de Trump.

Explorer l’activisme de gauche

Bien que très différents par leur style et leur ton, Une bataille après l’autre (2025), de Paul Thomas Anderson, et The Mastermind (2025), de Kelly Reichardt, critiquent ce qu’ils présentent comme l’insuffisance stratégique et l’autosatisfaction de l’activisme de gauche, tout en explorant son coût personnel.

Une bataille après l’autre met en scène l’ancien révolutionnaire Pat Calhoun, alias Bob, (Leonardo DiCaprio) qui tente de sauver sa fille Willa (Chase Infiniti) des griffes d’un colonel suprémaciste blanc, qui a tout d’un psychopathe, Lockjaw (Sean Penn). Bien que Bob ait autrefois résisté aux politiques d’immigration cruelles et racistes du gouvernement fédéral à travers une série de raids audacieux contre des centres de détention, la paternité et une consommation excessive de cannabis ont émoussé son ardeur révolutionnaire.

Au lieu de cela, Bob est désormais un bouffon quelque peu incompétent. Le film exploite à des fins comiques ses tentatives chaotiques pour communiquer avec la « French 75 », l’armée révolutionnaire dont il faisait autrefois partie, inspirée de groupes révolutionnaires réels des années 1960 et 1970, comme les Weathermen.

Déambulant en peignoir, il a oublié tous les codes et les conventions nécessaires pour évoluer dans cet univers. Des mots de passe aux pronoms, Bob est en décalage avec son époque.

Cependant, le film se permet aussi de se moquer du moralisme de la gauche. Alors que Bob devient de plus en plus agressif faute d’obtenir des informations sur un point de rendez-vous crucial, le radical à qui il parle au téléphone l’informe que le langage qu’il emploie nuit à son bien-être. Si Bob manque de compétences pour soutenir la révolution, ceux qui la dirigent sont trop fragiles pour en mener une à bien.

À l’inverse, The Mastermind suit J. B. Mooney (Josh O’Connor) dans ses tentatives d’échapper aux autorités après avoir orchestré le vol de quatre œuvres d’art dans un musée de banlieue. Mari, père et fils d’un juge, Mooney est privilégié, sans direction, désorganisé, égoïste et, semble-t-il, indifférent à l’impact de la guerre du Vietnam alors que le conflit fait rage autour de lui.

Sa désorganisation est évidente dès le moment où il réalise que l’école de ses enfants est fermée pour une journée de formation des enseignants, le jour du casse. Son privilège apparaît clairement lorsqu’il lui suffit de mentionner le nom de son père lors de son premier interrogatoire par la police pour qu’on le laisse tranquille.

Même ses tentatives de convaincre sa femme, Terri (Alana Haim), qu’il a agi pour elle et pour leurs enfants sont maladroites, puisqu’il finit par admettre qu’il l’a aussi fait pour lui-même.

Alors qu’il est en fuite, Mooney semble ignorer ce qui se passe réellement autour de lui, des jeunes hommes noirs qui discutent de leur déploiement imminent au Vietnam, aux bulletins d’information relatant la réalité de la guerre. Sans rien dévoiler, Mooney ne peut finalement échapper aux conséquences de la guerre du Vietnam sur la société américaine.

Des moments révélateurs dans les deux films suggèrent également l’engagement vacillant envers la révolution de la part de ses anciens adeptes. Dans The Mastermind, Mooney se cache chez Fred (John Magaro) et Maude (Gaby Hoffmann), un couple avec lequel il a fréquenté l’école d’art. Malgré son passé militant, Maude refuse de l’héberger plus d’une nuit par crainte d’attirer l’attention des autorités. Dans Une bataille après l’autre, la volonté de Bob de prendre des risques pour sa sécurité et sa liberté diminue lorsqu’il devient parent et il est, de manière assez problématique, prompt à juger la mère de Willa, Perfidia (Teyana Taylor), qui continue à agir à ses risques et périls.

Le cinéma politique des années 1970

Les deux films rappellent inévitablement les œuvres tout aussi politiques produites par le cinéma états-unien à la fin des années 1960 et au début des années 1970, telles que Cinq pièces faciles (1970), Macadam à deux voies (1971) et Chinatown (1974). Au cœur du contrecoup nixonien face au radicalisme des années 1960, ces films adoptent un ton de résignation défaitiste, mettant en scène des protagonistes sans direction et des fins malheureuses.

La conclusion de The Mastermind ressemble à celle de ces films des années 1970. Le film s’achève sur des policiers présents lors d’une manifestation contre la guerre du Vietnam, se félicitant mutuellement après avoir arrêté un nouveau groupe de manifestants et de les avoir envoyés en prison.

Bien qu’Une bataille après l’autre soit beaucoup plus pétillant dans son style, la politique révolutionnaire de gauche y apparaît aussi comme une impasse. Des victoires à plus petite échelle restent possibles : Sergio (Benicio del Toro) continue de se battre pour les immigrés sans papiers, et Willa s’enfuit pour rejoindre une manifestation Black Lives Matter à la fin du film.

Mais en regardant ces deux films depuis la perspective d’une nouvelle année où l’administration Trump menace de provoquer de nouveaux bouleversements violents, tant au plan national qu’international, je repense à la lamentation mélancolique de Captain America (Peter Fonda) vers la fin du classique de la contre-culture Easy Rider (1969) :

« On a tout gâché. »

Gregory Frame ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

20.01.2026 à 15:04

Agatha Christie : la reine du crime était aussi la reine du châtiment

Texte intégral (1767 mots)

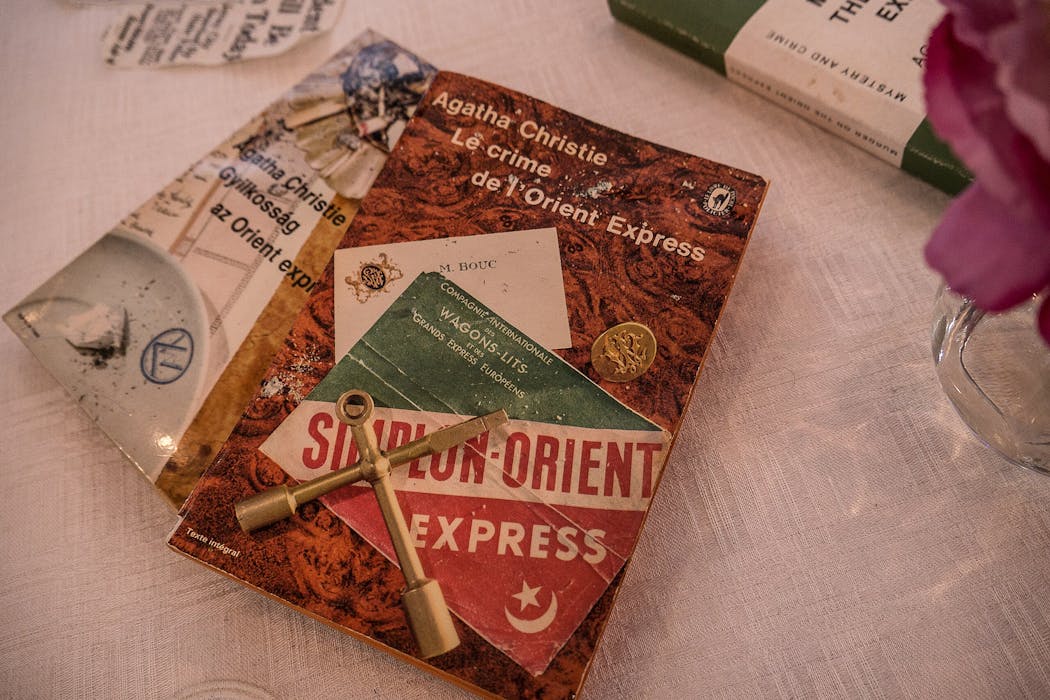

Agatha Christie, souvent surnommée la reine du crime, demeure l’autrice de fiction la plus vendue au monde : plus de 2 milliards d’exemplaires de ses livres ont été écoulés depuis leur première publication. Ses intrigues captivantes – de Ils étaient dix au Crime de l’Orient-Express – ont été traduites dans plus de 100 langues, plaçant Christie non seulement au sommet du genre policier mais aussi parmi les auteurs les plus lus de tous les temps. Mais l’habileté littéraire dissimule un autre aspect de son œuvre et de sa personnalité : Agatha Christie était aussi, dans ses fictions, la reine de la répression.

Pourquoi (re)lire Agatha Christie ? Pour prendre conscience du fonds idéologique de son œuvre. Pour saisir ce qui peut échapper à la (première) lecture, le lecteur étant implacablement pris et entraîné par la mécanique de l’intrigue policière, tournant les pages vers la résolution finale tant attendue. Les énigmes policières, qui pourraient sembler n’être que des constructions abstraites suspendues dans le vide, des casse-têtes brillants mais sans enjeux concrets, des jeux pour divertir l’esprit, portent, en leur sein ou dans le décor fictionnel dans lequel elles s’inscrivent, un discours sur la société. Lire le Meurtre de Roger Ackroyd pour la prouesse littéraire, oui, bien sûr, il le faut. Mais le relire aussi pour y percevoir « l’arrière-fable », selon une expression du philosophe Michel Foucault, et décrypter les messages ainsi adressés au lecteur, à son insu souvent.

Les romans policiers à énigme ne sont donc pas des produits littéraires jetables, dont la relecture serait du temps perdu. Bien au contraire : délivré de l’emprise de l’intrigue, le lecteur y gagne une nouvelle intelligence du texte. Il peut prendre le temps de discerner certains fils dans la trame policière qui disent quelque chose de la philosophie ou de la politique de l’auteur.

Alors, relisez Agatha Christie. Les rééditions infinies de ses textes vous y encouragent. Relisez-la en usant d’une clé de lecture tout à fait efficace pour avoir accès à sa vision du monde : les représentations de la justice pénale. Tous ces romans et nouvelles sont, en effet, porteurs d’une philosophie répressive singulière. Une philosophie répressive, c’est-à-dire une manière de concevoir les fonctions sociales de la peine.

Trois modèles de justice pénale

Il est plusieurs conceptions possibles de la sanction pénale, qui peuvent d’ailleurs coexister. La peine peut tout d’abord être la réponse violente à l’infraction, le prix à payer par le criminel pour le crime qu’il a commis – le prix du sang. Il s’agit alors de justice rétributive : l’harmonie du monde est rétablie dès lors que le mal infligé à la victime est compensé par le mal subi par l’auteur du crime. La peine peut ensuite être un moyen d’empêcher un nouveau passage à l’acte, de dissuader les potentiels récidivistes. La justice pénale est, dans ce cas, utilitariste et elle se fonde sur l’idée que les individus peuvent être corrigés, améliorés. Enfin, la peine peut perdre son nom et devenir une « mesure » de justice restaurative : l’État est laissé de côté, l’objectif est dès lors de permettre à l’auteur et à la victime de l’infraction de trouver ensemble, par le dialogue, une issue satisfaisante à leur conflit.

Qu’en est-il chez Agatha Christie ? Dans son œuvre, la justice pénale est résolument rétributive. Elle est même, par certains de ses aspects, réactionnaire. Ne vous fiez pas trop aux aimables photographies présentant la romancière dans son bureau en inoffensive grand-mère. Tous ses récits à énigme enseignent que la justice humaine est inefficace, que les procédures légales tournent à vide, que les procès ne permettent pas d’aboutir à la vérité. Ce sont des agents d’une justice supérieure, surnaturelle, qui triomphent chez elle : le silencieux et mélancolique Harley Quinn, l’avocat des morts, messager de l’au-delà. Mais aussi Hercule Poirot – personnage à la vanité assumée et délicieusement comique, méthodique jusqu’à l’obsession, qui se prend pour Dieu le Père et qui finira sa carrière en assassin. Enfin Miss Marple, à l’apparence bienveillante, mais redoutablement lucide et plus perfide qu’il n’y paraît, incarnation de la déesse grecque de la vengeance Némésis. Némésis et non Thémis, la déesse de la justice.

Némésis l’implacable

Pour Agatha Christie, la vengeance est une forme de justice, et c’en est la forme la plus efficace. En effet, selon elle, le meurtre appelle la mort du meurtrier. Pas de place pour le pardon, ni pour la correction des comportements. Non, elle est très claire, elle l’écrit noir sur blanc dans son Autobiographie : les criminels doivent soit être exécutés, soit accepter d’être des cobayes pour la science, « la marque de Caïn enfin effacée de leur front ». Elle écrit ceci non pas en 1930 mais en 1977.

Toutes les morts se valent d’ailleurs. Que le criminel se suicide, qu’il succombe lors d’un accident ou qu’il soit exécuté sur le gibet, toutes ces issues sont satisfaisantes pour l’écrivain, dès lors que le prix du sang est payé.

Notre sensibilité européenne actuelle sera peut-être heurtée, mais l’évidence s’impose : Agatha Christie défend la peine de mort, c’est la seule peine qui lui semble juste. Il est d’ailleurs intéressant de relever qu’à chaque réforme adoptée en Angleterre en faveur de l’abolition de la peine capitale, Agatha Christie a fait connaître sa désapprobation dans ses récits de fiction. Relisez le Train de 16 h 50, relisez le Crime d’Halloween. Dès 1930, elle faisait dire à Miss Marple :

« Les scrupules humanitaristes modernes à propos de la peine capitale m’exaspèrent. »

Rétablir l’ordre du monde

Le monde littéraire d’Agatha Christie est un monde ordonné, un monde harmonieux, une bibliothèque où chaque ouvrage est à sa place. Le cadavre qui y surgit doit être évacué, les taches de sang effacées, la vérité dévoilée et le meurtrier châtié. Et peu importe le temps qui passe : la prescription de l’action publique n’existe pas dans l’œuvre d’Agatha Christie (elle n’existait pas non plus en droit anglais à l’époque où elle écrivait). Némésis possède une mémoire d’éléphant. C’est pourquoi Hercule Poirot peut enquêter seize ans après les faits dans Cinq petits cochons. Idem pour Miss Marple qui intervient dix-huit ans après l’affaire, dans la Dernière Énigme.

Réordonner le monde dérangé par le meurtre passe aussi par un moyen plus doux : le mariage. Innombrables sont les romans d’Agatha Christie dans lesquels l’intrigue policière se double d’une intrigue amoureuse trouvant son dénouement dans un mariage ou dans un projet de mariage. Hercule Poirot n’est pas qu’un détective, c’est aussi un entremetteur, un facilitateur de fiançailles. Or, réunir des amants, c’est, de fait, rétablir l’ordre du monde : l’infraction a sectionné le lien social, le mariage le retisse. Si, comme dans les contes de fées, le héros se marie à la fin d’un roman d’Agatha Christie, ce n’est pas par goût frivole du happy end, mais c’est encore pour traduire une philosophie pénale qui a été distillée dans l’esprit de millions de lecteurs, en sourdine.

Relire Agatha Christie, c’est finalement se donner les moyens de prendre conscience qu’un texte littéraire – même un texte relevant de la littérature populaire – est porteur d’un discours philosophique, social ou politique. Relire Agatha Christie, c’est également comprendre qu’il est possible d’aimer un auteur, sans nécessairement adhérer aux valeurs qu’il diffuse.

Nicolas Bareït ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Time [Fr]

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- L'Autre Quotidien

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- Gauche.Media

- CETRI

- ESSF

- Inprecor

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview