13.02.2026 à 10:09

Comment Bad Bunny a porté l’activisme sur la scène du Super Bowl

Belinda Zakrzewska, Assistant Professor of Marketing, University of Birmingham

Flavia Cardoso, Associate Professor in Business and Economics

Jannsen Santana, Assistant Professor in Marketing, TBS Education

Texte intégral (1466 mots)

Le show de mi-temps du Super Bowl signé Bad Bunny n’a pas seulement battu des records d’audience. À travers une mise en scène chargée de symboles, le rappeur portoricain a transformé un spectacle grand public en manifeste culturel, articulant mémoire coloniale, identité et activisme.

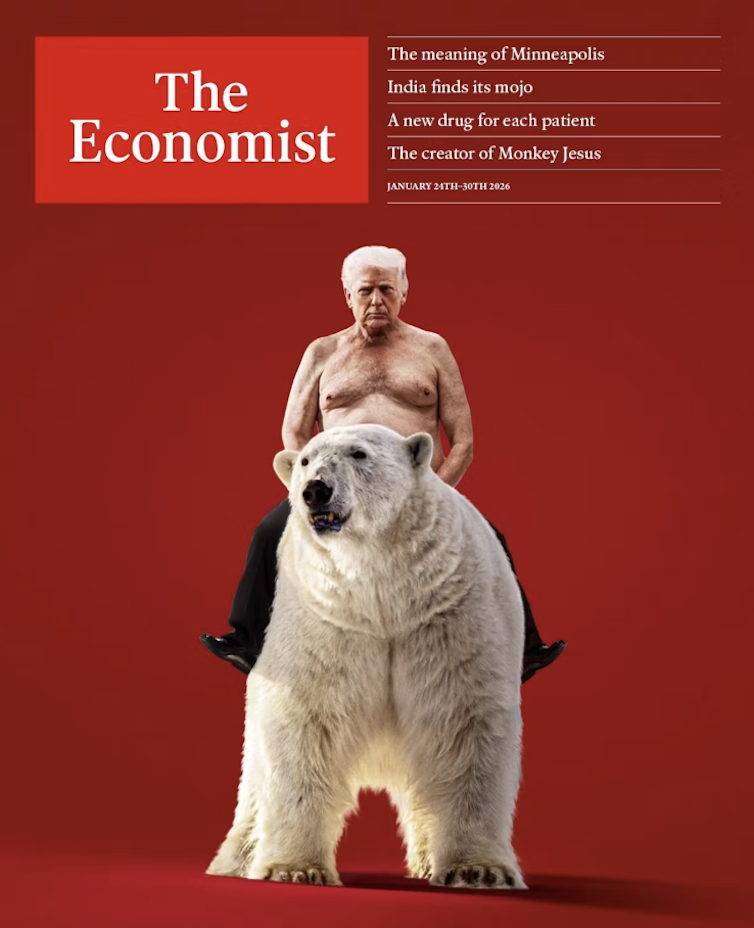

Après plusieurs jours de controverse – au cours desquels Donald Trump s’était plaint du choix des artistes, avait déclaré qu’il n’assisterait pas à l’événement, et qu’une programmation alternative « 100 % américaine » serait mise en avant –, le rappeur portoricain Bad Bunny est monté sur scène lors du très attendu spectacle de mi-temps du Super Bowl, dimanche 8 février.

Les attentes étaient élevées, comme en témoigne le nombre inédit de téléspectateurs. Le show de Bad Bunny a généré plus de 135,4 millions de vues, surpassant les 133,5 millions de Kendrick Lamar en 2025 et les 133,4 millions de Michael Jackson en 1993.

À lire aussi : Bad Bunny is the latest product of political rage — how pop culture became the front line of American politics

Les médias ont principalement présenté l’événement comme une célébration de la diversité, suscitant en retour une réaction hostile chez les partisans de Donald Trump et certains commentateurs conservateurs. Les critiques visaient Bad Bunny non seulement pour son opposition ouverte à l’administration Trump, mais aussi au motif qu’il ne serait « pas un artiste américain » (comprendre : « états-unien »), malgré le fait que Porto Rico est un territoire des États-Unis. Sa performance a montré comment l’authenticité peut se construire à travers un activisme anticolonial.

Si l’authenticité est souvent vue comme quelque chose de réel, vrai ou sincère, elle repose en réalité sur une qualité relationnelle qui peut être liée au comportement d’une personne de trois façons : par la connexion aux personnes ou aux lieux ; par la conformité aux conventions ou leur remise en cause ; et par la cohérence entre le message et les actions. Lors de la mi-temps du Super Bowl, Bad Bunny a incarné ces trois dimensions.

L’authenticité comme connexion

L’authenticité s’est manifestée notamment par la présence de canne à sucre sur scène, une culture qui a façonné les économies coloniales des Caraïbes. Les plantations appartenaient aux colonisateurs et reposaient sur l’exploitation violente des peuples autochtones et des Africains réduits en esclavage. En mettant la canne à sucre au centre du décor, la performance a rappelé les fondements de la richesse coloniale et a réhabilité un symbole d’oppression en tant que vérité historique plutôt que comme mémoire idéalisée.

La présence de l’icône portoricaine Ricky Martin a renforcé ce sentiment de connexion lorsqu’il a interprété Lo Que Le Pasó A Hawaii, de Bad Bunny. Par ses paroles, la chanson met en garde les Portoricains contre la perte de leur identité culturelle face aux pressions d’assimilation à l’influence états-unienne. La performance de Martin a souligné ce message, en présentant la préservation culturelle comme une forme essentielle de résistance anticoloniale.

Lady Gaga a ajouté une dimension symbolique forte. Sa robe bleu clair renvoyait à la version originale de 1895 du drapeau portoricain, avant que sa teinte ne soit assombrie pour s’aligner sur celle du drapeau des États-Unis. Elle portait un hibiscus rouge – emblème national de fierté et de résistance – ainsi que des fleurs blanches, évoquant ensemble les couleurs du drapeau. Elle incarnait ainsi le respect, la participation et la solidarité plutôt que la séparation ou l’effacement.

L’authenticité comme conformité

Les artistes naviguent souvent entre conformité et transgression, et Bad Bunny a parfaitement maîtrisé cet équilibre. En tant qu’artiste portoricain évoluant dans une industrie qui pousse souvent à abandonner ses origines, il a au contraire créé un espace culturel hybride : un spectacle de mi-temps du Super Bowl en espagnol. Il a ainsi agi au sein du système tout en remettant en cause l’idée que l’anglais doive dominer et que les figures grand public doivent correspondre à un modèle culturel étroit.

L’artiste a également bousculé le récit dominant qui réduit l’« Amérique » aux États-Unis, en reconnaissant l’ensemble du continent américain. Après avoir déclaré « God Bless America », il a énuméré tous les pays du continent, du sud au nord.

En citant les pays, Bad Bunny a inversé la hiérarchie géopolitique traditionnelle. Ce geste évoquait l’œuvre América Invertida de l’artiste uruguayen Joaquín Torres-García et son idée selon laquelle « le Sud est notre Nord », remettant en cause l’idée que la légitimité culturelle ou politique doive venir du « Nord ».

L’authenticité comme cohérence

Enfin, la cohérence s’est manifestée par des clins d’œil à l’activisme de longue date de Bad Bunny. L’explosion d’un lampadaire avant l’interprétation d’El Apagón renvoyait directement à son clip de 2022, qui prend la forme d’un documentaire dénonçant la négligence des infrastructures et la privatisation de l’électricité par des entreprises états-uniennes. Ce moment reliait le divertissement aux réalités coloniales vécues à Porto Rico.

La brève apparition d’El Sapo Concho, mascotte de son dernier album, a ajouté une autre dimension symbolique. Presque disparu en raison des perturbations écologiques liées à l’exploitation coloniale des ressources, ce crapaud portoricain est devenu un symbole de survie face aux dommages structurels. Sa présence dans le show rappelait que l’impact du colonialisme est autant environnemental que culturel.

De la même façon, lorsque Bad Bunny a remis un Grammy à une version plus jeune de lui-même, il renforce son message : « Si je suis ici, c’est parce que j’ai toujours cru en moi. » Dans un contexte où les populations issues de nations colonisées font face à la discrimination et à la marginalisation, beaucoup ont vu la culture des colonisateurs comme un moyen d’ascension sociale. Son geste a ainsi réaffirmé la confiance en soi comme un acte de résistance.

« This is America »

À la fin du spectacle, un panneau lumineux affichait « The only thing more powerful than hate is love » (La seule chose plus puissante que la haine, c’est l’amour). Bad Bunny tenait alors un ballon de football portant l’inscription : « Together, We Are America. » (Ensemble, nous sommes l’Amérique.)

Cette image proposait un idéal panaméricain fondé sur la solidarité plutôt que sur la domination. À travers des symboles de résilience collective, l’artiste présentait ainsi l’authenticité comme une forme d’activisme anticolonial ancrée dans l’amour, la mémoire et la communauté.

Ces choix visuels étaient intentionnels et s’inscrivaient dans des années de prises de position publique, de musique et d’engagement. Chaque élément renforçait un récit cohérent de résistance, démontrant que l’authenticité n’est pas seulement une performance, mais le résultat d’un activisme anticolonial constant.

En imbriquant histoire, symbolismes et convictions personnelles à chaque instant de sa performance, Bad Bunny a démontré que l’art peut devenir un vecteur d’action politique et culturelle, fondé sur l’amour, la tolérance et l’inclusion.

Flavia Cardoso a reçu des financements du gouvernement chilien (Fondecyt) et de la Fondation Luksic.

Belinda Zakrzewska et Jannsen Santana ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.

13.02.2026 à 09:23

Inondations : l’aménagement du territoire est-il responsable ?

Luc Aquilina, Professeur en sciences de l’environnement, Université de Rennes 1 - Université de Rennes

Pierre Brigode, Maître de conférences en hydrologie, École normale supérieure de Rennes

Texte intégral (2282 mots)

Les inondations qui touchent le Sud-Ouest de la France provoquées par la tempête Nils pourraient alimenter à nouveau le débat sur le rôle l’aménagement du territoire dans la survenue de ces événements. Les inondations sont pourtant des phénomènes complexes et le rôle des aménagements reste difficile à estimer.

Depuis plusieurs années, l’Europe est frappée par des inondations majeures aux bilans humains terribles : 243 morts en juillet 2021 en Allemagne, en Belgique, au Luxembourg et aux Pays-Bas, 17 morts en mai 2023 en Italie du Nord, 27 morts en septembre 2024 lors de la tempête Boris en Europe Centrale, de l’Allemagne à la Roumanie, et 237 morts en octobre 2024 dans le sud de Valence. Plus près de nous, les inondations de la Vilaine de ce mois de janvier 2026 et celles de l’année dernière ont ravivé pour les habitants le spectre des inondations du passé.

Ces évènements frappent les esprits et font la une des médias, surtout s’ils se déroulent en Europe. Très vite, des causes liées à l’aménagement du territoire sont invoquées. En Espagne, l’extrême droite a condamné les écologistes qui ont prôné l’arasement des barrages. Vérification faite, il ne s’est agi que de la suppression de « barrières » peu élevées et le lien avec les barrages n’est pas attesté. En Bretagne, à l’inverse, suite à la crue de la Vilaine début 2025 et à l’inondation de plusieurs quartiers de Rennes et de Redon, plusieurs coupables ont été rapidement désignés dans les médias. Le changement climatique d’abord, puis le remembrement des territoires ruraux et le drainage des parcelles agricoles qui ont accompagné la révolution verte des années 1960 et 1970 ont été pointés du doigt.

Les scientifiques de l’eau soulignent le rôle des aménagements passés sur les sécheresses et les tensions autour de la ressource en eau. Pour autant, l’attribution des causes à des événements exceptionnels comme les crues intenses s’avère difficile. Faut-il chercher un seul coupable, ou bien plusieurs ? Changement climatique et modification des usages des sols contribuent à la genèse des inondations, mais leurs implications respectives dans ces évènements varient selon le type d’inondation ainsi qu’au cours du temps.

Il est difficile de déterminer les causes des crues

Isoler la part de responsabilité du changement climatique dans la survenue d’un événement climatique extrême est ce qu’on appelle un processus d’attribution. La science de l’attribution, relativement récente, est nécessaire pour quantifier les impacts du changement climatique dans des processus complexes et variables. Un exemple récent est l’étude menée suite aux pluies torrentielles d’octobre 2024 en Espagne, qui a montré que ce type d’épisode pluvieux présente jusqu’à 15 % de précipitations supplémentaires par rapport à un climat sans réchauffement. En d’autres termes, environ une goutte d’eau sur six tombée lors de cet épisode peut être imputée au changement climatique.

Si l’attribution des pluies est aujourd’hui de mieux en mieux maîtrisée, celle des crues reste moins bien déterminée. On confond souvent l’attribution de la pluie et celle de la crue, alors qu’elles ne sont pas équivalentes. Entre le moment où la pluie tombe et celui où la rivière déborde, il se passe beaucoup de choses au niveau du bassin versant : selon le degré d’humidité et la nature du sol et du sous-sol ou bien la manière dont il a été aménagé, il peut agir comme tampon ou accélérer les flux d’eau. Deux bassins versants différents auront des réponses également différentes pour un même volume de pluie, et un même volume de pluie tombant sur un même bassin versant peut avoir des conséquences très différentes selon le moment de l’année. La survenue d’une crue dépend donc de la combinaison de deux dés : la pluie qui tombe sur le bassin versant et la capacité de ce bassin à l’absorber.

Le changement climatique et les aménagements perturbent l’absorption des sols

Les études d’attribution des pluies montrent avec certitude que le réchauffement climatique — et donc les activités humaines qui en sont la cause — intensifient les pluies fortes et les rendent de plus en plus fréquentes. Si nos futurs étés seront plus secs, les hivers seront eux plus humides, notamment dans le nord de la France. Qu’en est-il du deuxième dé, la capacité d’absorption des bassins versants ? Le changement climatique l’affecte également, en modifiant l’humidité des sols au fil des saisons. Mais cette capacité dépend aussi largement des transformations opérées par certaines activités humaines.

C’est le cas par exemple des barrages, conçus pour stocker l’eau lors des saisons humides et qui ont la capacité de tamponner la puissance des crues. Mais d’autres phénomènes sont impliqués, comme l’urbanisation, qui imperméabilise les sols en remplaçant champs et prairies par du béton et de l’asphalte. Ces surfaces imperméables réduisent fortement l’infiltration et favorisent le ruissellement. Même si l’urbanisation reste marginale à l’échelle des grands bassins versants, elle peut jouer un rôle majeur localement, notamment en zones périurbaines, où les petits cours d’eau sont souvent canalisés ou recouverts.

Les aménagements agricoles comptent également. Le remembrement, qui a fait disparaître des milliers de haies et fossés au profit de grandes parcelles plus facilement exploitables pour des machines agricoles, a profondément modifié la circulation de l’eau. En parallèle, d’autres transformations ont réduit la capacité du paysage à retenir l’eau lors des pluies fortes, comme la pose de drains en profondeur dans les sols agricoles qui vise à évacuer l’excédent d’eau des terres trop humides durant l’hiver. La création de digues et de canaux pour limiter l’expansion des rivières, le creusement des cours d’eau et la rectification de leurs berges les ont recalibrées pour les rendre linéaires. Ces différents aménagements ont des effets importants. Ils modifient le cycle de l’eau continental en accélérant globalement les flux vers la mer. Les niveaux des nappes ont déjà été affectés par ces modifications. Dans les vastes marais du Cotentin, nous avons montré que le niveau moyen des nappes a chuté d’environ un mètre depuis 1950, alors que les aménagements des siècles précédents avaient déjà diminué ces niveaux. Le changement climatique va renforcer cette diminution des niveaux de nappe au moins sur une grande partie du territoire hexagonal.

D’un bassin à l’autre, des effets différents

Ces facteurs jouent différemment selon la surface des bassins versants et leur localisation : l’urbanisation a un effet très fort sur les crues des petits bassins versants côtiers de la Côte d’Azur, qui ont une surface inférieure à 10 km2, mais un effet moindre sur le bassin versant de la Vilaine, qui compte 1 400 km2 à Rennes après la confluence avec l’Ille. À l’inverse, les pratiques agricoles ont un effet plus important sur les crues du bassin de la Vilaine que sur ceux de la Côte d’Azur.

Aujourd’hui, il est difficile de quantifier précisément la part relative de ces facteurs dans l’occurrence des crues observées. En amont des cours d’eau, certaines transformations peuvent ralentir la propagation des crues en augmentant des capacités de stockage locales, par exemple dans les sols, les zones humides ou les plaines inondables, tandis qu’en aval, l’accélération des flux et leur addition tendent à dominer. Chacun des aménagements décrits influence la manière dont un bassin versant absorbe ou accélère l’eau, mais l’addition de leurs effets crée une interaction complexe dont nous ne savons pas précisément faire le bilan.

Lors d’événements exceptionnels comme la crue de Valence, ce sont avant tout les volumes de pluie qui déclenchent la crue et ses conséquences, le changement climatique pouvant intensifier ces précipitations. Les aménagements du territoire influencent de manière secondaire la façon dont l’eau s’écoule et se concentre dans les bassins versants. Il n’en reste pas moins que ces deux effets jouent un rôle de plus en plus important dans les événements de moindre ampleur, dont les impacts sont néanmoins importants et dont l’occurrence a déjà augmenté et va encore s’accentuer dans le futur. Pour deux degrés de réchauffement, l’intensité des crues décennales (d’une ampleur observée en moyenne une fois tous les 10 ans) augmentera potentiellement de 10 à 40 % dans l’Hexagone, et celle des crues centennales (observées en moyenne une fois tous les siècles) de plus de 40 %.

Une vie en catastrophes ?

Ces événements ont provoqué des prises de position politique virulentes. Certains, en particulier à droite de l’échiquier politique, ont remis en question les politiques récentes de restauration de l’état naturel des cours d’eau, de protection des zones humides et de destruction des barrages. Elles ont conduit à des appels à la suppression de l’Office français de la biodiversité lors des manifestations agricoles, proposition reprise par le sénateur Laurent Duplomb devant le Sénat le 24 janvier 2024.

Les aménagements les plus récents, défendus par de nombreuses structures territoriales, visent à redonner au cycle de l’eau, et en particulier aux rivières, des espaces plus larges et à recréer ou protéger des zones humides. Tous ces aménagements conduisent à ralentir les flux et donc luttent contre les inondations, tout en préservant la biodiversité à laquelle notre santé est liée. Les zones humides sont par exemple les meilleurs ennemis des moustiques tigres, en permettant le développement de leurs prédateurs. Bien qu’ils exigent de concéder des terres agricoles aux milieux naturels, ces aménagements nourrissent les nappes qui restent le meilleur réservoir pour le stockage de l’eau des saisons humides.

Remettre en question les politiques de recalibration des cours d’eau, de remembrement et de drainage, tout comme l’imperméabilisation des zones urbaines, est une nécessité imposée par l’adaptation au changement climatique. Il s’agit de limiter ou éviter les tensions entre les besoins des activités humaines et les besoins des écosystèmes qui pourraient en faire les frais. Les inondations catastrophiques ne sont qu’en partie liées aux aménagements et ne peuvent pas justifier à elles seules les politiques de retour à l’état naturel des cours d’eau, qui sont en revanche une réponse aux sécheresses estivales à venir. Pour autant, ces inondations majeures sont là pour nous alerter sur les effets du changement climatique. Les étés vont devenir plus secs et les ressources vont manquer, mais les événements extrêmes vont également se multiplier. Une vie en catastrophes nous attend si nous ne transformons pas nos modes de consommation et de production. Tel est le message porté par les inondations. Sera-t-il mieux entendu que les appels des hydrologues ?

Luc Aquilina est co-titulaire de la chaire Eaux et territoires de la fondation de l’Université de Rennes qui reçoit des fonds d’Eau du Bassin Rennais, Rennes Métropole et du Syndicat Mixte Eau 50.

Pierre Brigode a reçu des financements de l'Université de Rennes, du Centre national de la recherche scientifique et de l'Agence nationale de la recherche.

12.02.2026 à 16:15

Manger ou ne pas manger d’huîtres ?

François Lévêque, Professeur d’économie, Mines Paris - PSL

Texte intégral (2337 mots)

L’huître est clivante : elle séduit les amateurs gourmets et dégoûte ses détracteurs. Mets de fête, longtemps réservées aux mois en « r », les huîtres ont échappé à leur destin depuis que l’humain s’est mêlé de leur génétique. Aliment naturel, ce mollusque est réputé pour être sain, si l’on survit à ce qui pourrait être le plus grand des dangers : ouvrir sa coquille.

Noël est passé, la consommation d’huîtres a chuté. La France se retrouve coupée en deux : les amateurs qui en mangent toute l’année et les mangeurs occasionnels qui rejoignent alors les rangs de celles et ceux qui n’en avalent jamais. La France du littoral contre celle de l’intérieur.

Examinons sérieusement, mais dans la bonne humeur, cette fracture française trop ignorée dans notre monde, pourtant si friand d’oppositions binaires. Quel que soit votre camp, renforcez ou questionnez vos comportements en découvrant les causes de ce fossé séparant les Français.

Deux positions bien tranchées

Traçons tout d’abord le profil des uns et des autres. Si vous ne consommez pas d’huîtres, sachez que vous êtes loin d’être seuls. Un tiers de la population française n’en mange jamais. Vous en avez peut-être goûté un jour mais vous n’aimez pas cela. Ou même pas essayé, rebuté par l’idée d’ingérer un animal ou par conviction religieuse. Souvent, vous craignez aussi que les huîtres ne conviennent pas à toute la famille.

Si vous êtes un consommateur occasionnel, vous en avez mangé à Noël ou au Nouvel An ; éventuellement aussi lors d’autres repas festifs. Vous formez le plus grand bataillon des consommateurs d’huîtres. Vous les achetez au supermarché et vous manquez d’expertise pour les choisir. Vous n’aimez pas trop les ouvrir.

À lire aussi : Huîtres et algues : partenaires pour le meilleur et pour le pire dans un océan en mutation

Enfin, si vous êtes un consommateur régulier, comme 20 % des Français, vous habitez le plus souvent près de la mer et en consommez toute l’année. Vous achetez vos huîtres auprès d’un ostréiculteur ou d’un écailler du marché. Vous savez faire la différence entre les huîtres numéro 2, 3 ou 4, les fines et les spéciales. Vous éprouvez même un certain plaisir et de la fierté à les ouvrir.

De La Fontaine à Maupassant

Trouvez-vous les huîtres délicieuses ? Comme Maupassant qui décrit les huîtres d’un souper dans Bel-Ami (1885) « mignonnes et grasses, semblables à de petites oreilles enfermées en des coquilles et fondant entre le palais et la langue ainsi que les bonbons salés ». Ou bien dégoûtantes, comme ce personnage d’une nouvelle de Tchekhov, un enfant pauvre de Moscou, forcé à manger des huîtres. Il les découvre « hideuses, aux yeux brillants et à la peau visqueuse ».

Il est vrai que ce coquillage se mange vivant. À ma connaissance, c’est le seul animal ainsi ingurgité sous nos latitudes. Piquez de la pointe de votre couteau le bord d’une huître, elle se rétractera à moins qu’elle se soit endormie sous la glace. Âmes sensibles, s’abstenir. Ou manger les huîtres cuites – il y a pléthore de recettes. Renonciation aussi des végétariens, au moins tant que la chair d’huître végétale n’a été inventée, à partir d’algues par exemple.

Dans les enquêtes, l’aspect cru et vivant ainsi que le mauvais goût et l’odeur sont invoqués en premier par les non-consommateurs. À l’inverse, les mangeurs d’huîtres soulignent leurs qualités gustatives et leur parfum iodé.

Naturelle peut-être, mais plus très sauvage

L’huître fait partie des fruits de mer, d’où le côté naturel que les consommateurs lui associent spontanément. Mais, contrairement à la coquille Saint-Jacques ou à la crevette grise, elle a quitté son caractère sauvage. Bel-Ami mangeait des huîtres plates cueillies sur l’estran et les compères qui, chez Boileau et La Fontaine, se disputent une huître qu’avalera finalement un troisième larron l’ont trouvée sur une plage. La découverte d’une huître sur l’estran suggère qu’une exploitation ostréicole n’est sans doute pas loin. Surexploitée au dix-neuvième siècle, l’huître plate sauvage, native de nos côtes, a quasiment disparu.

Si l’huître est un fruit de mer, elle est le produit de l’aquaculture. Une aquaculture que l’on serait néanmoins tenté de qualifier de douce, de quasi-naturelle, puisque l’huître, contrairement au saumon, croît sans aliments industriels ni médicaments vétérinaires.

Tout dépend cependant si l’huître est née en écloserie ou en mer ainsi que de son nombre de chromosomes. Reproduite en mer, elle aura vécu sa vie larvaire au gré des courants et des vagues avant de se fixer aux collecteurs posés par les ostréiculteurs. Aux branchages, pierres, coquilles et tuiles d’autrefois, les naissains sont désormais captés dans des assemblages de coupelles ou de tubes en PVC, plus rarement en plastique biosourcé. Née à terre entre quatre murs, elle aura connu un début de vie en milieu contrôlé, vie qu’elle poursuivra un temps en nurserie dans des bacs alimentés en eau de mer avant de découvrir enfin la vie marine.

La vérité est dans les chromosomes

L’essor des écloseries a été favorisé par l’invention de l’huître triploïde, rencontre d’un gamète à 10 chromosomes et d’un autre qui en compte 20. Souvenez-vous de vos cours de biologie ou d’éducation sexuelle : les gamètes n’embarquent qu’une moitié des chromosomes de chacun de leurs parents. L’huître triploïde est donc issue du mariage d’une huître diploïde normale (deux fois 10 chromosomes) et d’une huître tétraploïde (quatre fois 10 chromosomes) fabriquée en laboratoire. Évidemment, cela fait peur et renforce le camp des non-consommateurs. L’huître serait devenue un être transgénique, un OVM (organisme vivant modifié) !

Mais soyons rassurés. On dispose d’un temps de recul suffisamment long pour établir solidement l’absence de contamination des zones de captage naturel des huîtres normales. Manger des huîtres triploïdes n’entraîne pas non plus de risques pour la santé humaine. L’Agence nationale de sécurité sanitaire (Anses) a tranché la question. En outre, l’élevage de l’huître diploïde est majoritaire. Il couvre les trois quarts de la production ostréicole.

Diploïde ou triploïde ?

Il est vrai que l’origine diploïde ou triploïde des huîtres est rarement communiquée aux consommateurs. Il n’y a pas d’obligation légale en la matière. Pas de signes faciles à déceler non plus. En revanche, si vos huîtres consommées l’été ne contiennent pas de laitance, il s’agit à coup sûr de triploïdes. Ces huîtres étant stériles, elles ne produisent pas cette substance blanchâtre visqueuse principalement composée de gamètes. C’est d’ailleurs ce qui explique l’intérêt commercial et économique de la triploïde. Pas de reproduction, pas de laitance qui rebute les consommateurs et cantonne la consommation aux mois de l’année en « r ». L’huître triploïde peut se consommer toute l’année. Par ailleurs, sans dépense d’énergie de l’animal pour se reproduire, le cycle d’élevage peut être ramené à deux ans au lieu de trois.

Quant au goût différent entre les huîtres modifiées et celles non modifiées, la question reste ouverte. La composition chimique présente bien quelques différences objectives. Mais il n’est pas évident d’en saisir les effets sur le plan olfactif et gustatif. Le seul test à l’aveugle dont j’ai connaissance n’est pas convaincant faute d’un protocole scientifique digne de ce nom.

Blessures et intoxications

Pompant plusieurs litres d’eau chaque heure pour se nourrir de plancton, l’huître est tributaire de la qualité de l’eau qu’elle filtre. Microalgues toxiques, virus et bactéries sont ses ennemies mais aussi les nôtres quand nous les dégustons. Un risque d’intoxication entraînant diarrhées, nausées et vomissements est bien réel. La France dispose cependant d’un réseau efficace de surveillance sanitaire et d’alerte pour le réduire à de faibles proportions. Les autorités n’hésitent pas à interdire la commercialisation des huîtres s’il le faut. Ainsi, en décembre 2023, les huîtres du bassin d’Arcachon ont raté les repas de fêtes.

Le vrai danger est plutôt de se blesser en ouvrant les huîtres ! Les Français semblent d’ailleurs ne pas s’y tromper comme le suggèrent leurs réponses aux sondages. Ils sont 87 % à avoir confiance dans la production d’huîtres en France ; les craintes sanitaires sont peu évoquées alors que la très grande majorité des sondés reconnaissent l’existence de ce risque.

Ainsi, la mention de ces craintes vient très loin derrière les images négatives ayant trait au dégoût, que ce soit pour les Français dans leur ensemble ou pour les non-consommateurs. Pour ces derniers, la difficulté à ouvrir les huîtres est citée juste après la crainte de tomber malade comme raison justifiant le choix de ne pas en consommer. Dans une autre enquête portant sur un plus faible échantillon, elle est même placée devant.

L’huître innocentée faute de preuves

Ce faisceau de présomptions n’apporte pas la preuve que l’ouverture des huîtres est bien objectivement le plus grand danger. Il faudrait pouvoir comparer le nombre de personnes intoxiquées à celui d’ouvreurs d’huîtres blessés. Des données manquantes dans les deux cas. En outre, déclarer que les huîtres sont difficiles à ouvrir ne signifie pas forcément que l’on s’est entaillé la peau de la main en tentant l’opération.

L’ouverture des huîtres est en tout cas un frein à leur consommation. Pour la faciliter, de nombreuses méthodes, plus ingénieuses et cocasses les unes que les autres, ont été inventées. Citons le fil à couper l’huître consistant à passer un cordon en inox dans l’huître en la faisant bâiller dans une eau saturée en sel. Refermée, il suffira ensuite à la maison de tirer ce fil pour provoquer l’ouverture. Ou encore le cachet de cire alimentaire fermant un trou percé exprès, laissant plus facilement entrer la pointe du couteau. Ou enfin, l’ouv-huître, un outillage ad-hoc, créé par un ostréiculteur de Pontivy, Michel Lannay. Il a remporté le concours Lépine et a même été couronné au concours mondial des inventeurs. Sa prestation vidéo vaut le détour.

Vous n’allez sans doute pas modifier votre habitude alimentaire à l’issue de cette lecture. J’espère qu’elle vous aura seulement rendu plus tolérant à l’égard de ceux qui ne font pas comme vous. Que mangeurs et non-mangeurs d’huîtres puissent partager la même table, les uns dégustant leurs mollusques marins, et les autres une autre entrée qu’ils trouveront délicieuse.

François Lévêque ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

12.02.2026 à 16:13

Fabriquer de l’oxygène avec le sol lunaire : le futur de l’exploration spatiale ?

Jack Robinot, Doctorant en sciences de l'ingénieur, Centre national de la recherche scientifique (CNRS)

Alexis Paillet, Chargé de projet vaisseaux spatiaux, Centre national d’études spatiales (CNES)

Stéphane Abanades, Directeur de Recherche, Centre national de la recherche scientifique (CNRS)

Sylvain Rodat, Chimiste, Centre national de la recherche scientifique (CNRS)

Texte intégral (3232 mots)

Alors que les projets de retour sur la Lune se multiplient, et cette fois-ci pour s’y implanter durablement, comment respirer sur un astre sans atmosphère ? La réponse se trouve peut-être dans la poussière qui recouvre notre satellite.

Une nouvelle course à la Lune se dessine entre les États-Unis et la Chine. Contrairement à il y a cinquante ans, il n’est plus seulement question d’alunir et de repartir, mais bien d’établir une base qui autorise une présence durable et des séjours prolongés à la surface de notre satellite naturel. L’objectif est désormais de se servir de la Lune comme d’un bac à sable pour tester les technologies qui nous permettront de voyager plus loin, notamment vers Mars.

L’une de ces technologies clés est l’in-situ resource utilization (ISRU), c’est-à-dire l’exploitation des ressources disponibles sur place afin de produire les consommables nécessaires aux activités humaines : oxygène, eau, carburants pour les fusées ou matériaux de construction. En produisant directement sur la Lune ce qui est indispensable à la vie et aux opérations, il sera possible de réduire significativement la masse de cargaison à expédier depuis la Terre, réduisant ainsi les coûts logistiques et financiers de l’exploration spatiale. Plutôt que d’importer ces ressources depuis la Terre, il s’agit d’apprendre à vivre sur la Lune.

Décomposer la poussière lunaire pour en extraire de l’oxygène

À l’aube de ce retour durable de l’être humain sur la Lune, l’ISRU s’impose donc comme un pivot stratégique. L’un des défis majeurs est de produire de l’oxygène à partir du régolithe, la couche de sol qui recouvre la Lune, principalement formée de petits fragments de roches et de poussières. La composition du régolithe est complexe. Celui-ci est essentiellement constitué de plusieurs minéraux (plagioclase, pyroxène, olivine) eux-mêmes constitués d’un mélange d’oxydes métalliques, des composés chimiques qui associent de l’oxygène à un autre élément comme du silicium, du fer ou du calcium.

Environ 40 à 45 % de la masse du régolithe est donc composée d’oxygène, ce qui en fait l’élément le plus abondant à la surface de la Lune. L’oxygène est omniprésent, mais il n’existe pas sous forme gazeuse comme dans l’atmosphère terrestre. Pour libérer l’oxygène, il faut briser les liaisons chimiques qui l’attachent aux autres éléments dans les oxydes du sol lunaire.

Une des méthodes envisagées est la pyrolyse, un type de réaction chimique qui permet de décomposer des matériaux grâce à de hautes températures, afin de produire des composés volatils. Appliquée au régolithe, il est possible de le chauffer jusqu’à ce que les oxydes métalliques se vaporisent et se décomposent en oxygène et en métaux.

Sur la Lune, l’énergie thermique serait fournie grâce à la concentration solaire, un procédé qui consiste à utiliser des miroirs ou des lentilles pour focaliser la lumière du Soleil vers une petite zone. Les rayons se rassemblent alors en un faisceau et convergent en un point focal où l’énergie est fortement concentrée, permettant d’atteindre des températures de plusieurs milliers de degrés. Cette méthode prévoit également d’exploiter le vide lunaire, un environnement qui favorise les réactions libérant du gaz. Cela permettra de diminuer la quantité d’énergie nécessaire à la réaction.

Le four solaire, une méthode efficace et peu coûteuse

La Lune a un environnement particulièrement favorable à la pyrolyse solaire. Dépourvue d’atmosphère, la pression à sa surface est extrêmement faible, de l’ordre de 10⁻15 bar. L’absence d’atmosphère offre un second avantage : le rayonnement solaire ne peut pas être absorbé par celle-ci ni bloqué par des nuages. Cela permet d’obtenir des flux solaires concentrés plus élevés que sur Terre. De plus, certaines zones géographiques à son pôle Sud sont exposées à la lumière du Soleil jusqu’à 90 % du temps. Ainsi, en combinant le vide lunaire avec des systèmes de concentration solaire, on peut concevoir un procédé relativement simple, robuste et potentiellement efficace pour extraire de l’oxygène du régolithe.

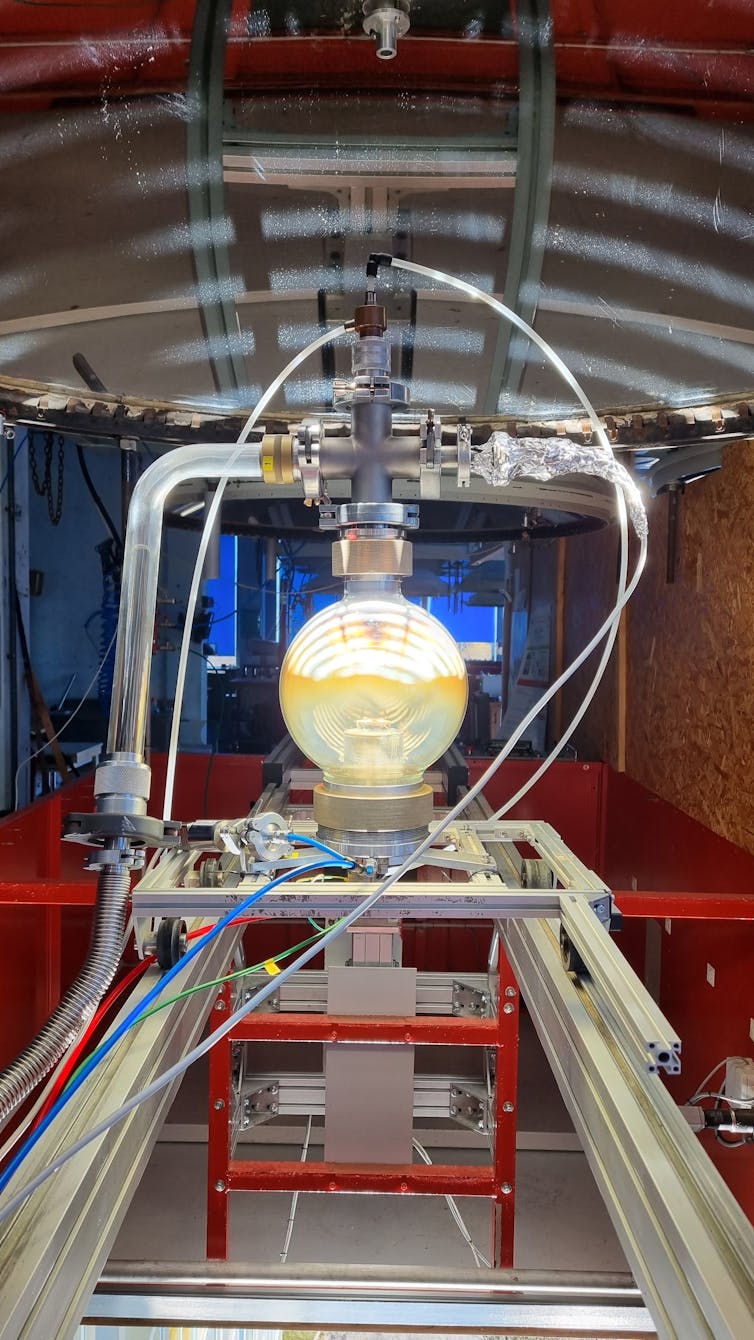

Au sein du laboratoire Procédés, matériaux, énergie solaire (Promes-CNRS), spécialisé dans les technologies de concentration solaire, nous travaillons à la validation du concept de base de la pyrolyse qui pourra à l’avenir être déployé sur la Lune. Implanté sur le site du grand four solaire d’Odeillo (Pyrénées-Orientales) en Occitanie, le laboratoire dispose d’infrastructures expérimentales uniques au monde vouées à l’étude des procédés hautes températures. Parmi ces équipements figurent notamment des paraboles de deux mètres de diamètre permettant de concentrer 10 000 fois les rayons solaires sur une tache d’environ 2 cm de diamètre et d’atteindre des températures de plus de 3 000 °C.

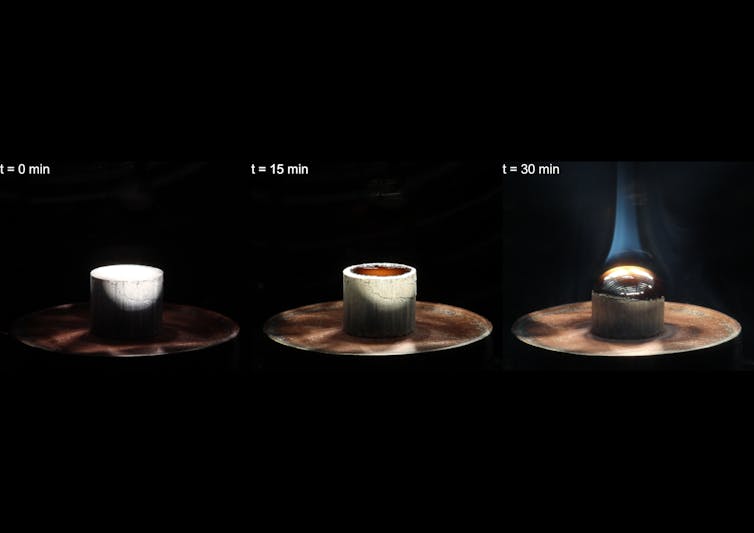

Cette énergie alimente le réacteur de pyrolyse, une enceinte sous vide conçue pour exposer des échantillons de matériaux qui simulent le régolithe lunaire au flux solaire concentré. Les pastilles de simulant sont placées sur un support en cuivre refroidi, tandis qu’une parabole focalise la lumière du Soleil à l’intérieur du réacteur pour assurer leur chauffage. Une pompe à vide maintient une pression d’environ 10 millibars. Une cellule électrochimique permet de déterminer en continu la concentration d’oxygène dans le réacteur.

L’échantillon est ensuite progressivement chauffé et commence à fondre aux alentours de 1 200 °C. Le régolithe atteint par la suite des températures d’environ 2 000 °C. Dans ces conditions, les oxydes présents dans l’échantillon commencent à se vaporiser et se dissocient pour libérer de l’oxygène.

D’autres produits en plus de l’oxygène

Lors des premiers essais, 35 mg d’oxygène ont été extraits à partir d’une pastille de 3,38 g, soit environ 1 % de la masse totale. Cela correspond à 2,5 % de l’oxygène contenu dans le simulant de régolithe. Une fois l’expérience achevée, une bille de verre est obtenue à la place de la pastille de régolithe. La fraction de régolithe qui s’est vaporisée lors de l’expérience se condense sur les parois froides du réacteur sous la forme de composés minéraux. Ces espèces sont collectées afin de les caractériser ensuite et de déterminer leur composition chimique.

Après pyrolyse, la bille de verre formée présente une composition chimique différente de celle du simulant de régolithe initial. Les oxydes volatils, qui se sont échappés lors du processus, y sont moins concentrés, à l’inverse des oxydes non volatils. Les espèces les plus volatiles ont été retrouvées dans les dépôts collectés sur les parois du réacteur, où elles se sont condensées lors de la pyrolyse.

Cette observation suggère qu’il serait aussi possible d’utiliser la pyrolyse comme une méthode pour séparer les oxydes dans le régolithe selon le principe de la distillation. Ces coproduits pourraient être exploités pour la fabrication de structures, d’outils ou de matériaux de construction directement sur la Lune, renforçant ainsi l’autonomie des futures missions lunaires.

Passer de la preuve de concept aux conditions réelles

Ces premiers essais ont permis de déterminer un rendement, mais celui-ci reste faible. Les prochaines étapes de développement viseront à réduire la pression à l’intérieur du réacteur, afin de se rapprocher des conditions lunaires. Une pression réduite devrait permettre de diminuer les températures mises en jeu lors de la pyrolyse, afin de vaporiser intégralement l’échantillon et d’augmenter le rendement.

Par la suite, il sera également pertinent de tester différents types de régolithes, ainsi que les minéraux et oxydes individuels qui les composent, afin de mieux comprendre la chimie des réactions. Le réacteur de pyrolyse se devra de fonctionner en continu afin d’exploiter au mieux le jour lunaire. Le procédé peut encore être optimisé. Un contrôle plus précis de la température permettrait de mieux maîtriser les réactions et d’améliorer leur rendement. Une collecte plus efficace des gaz produits viserait à limiter les pertes d’oxygène. Nous espérons également réduire les pertes thermiques en utilisant un creuset et en l’isolant. Enfin, une meilleure condensation des sous-produits permettrait d’identifier et de valoriser les matériaux formés lors de la pyrolyse en plus de l’oxygène.

L’ensemble du système (réacteur, miroirs et dispositifs de concentration solaire) devra en outre être robuste et fiable, capable de résister aux conditions extrêmes de l’environnement lunaire : poussière abrasive, radiations, fortes variations thermiques… Enfin, l’oxygène généré devra être stocké, purifié pour le séparer d’autres éléments qui peuvent être présents dans le gaz et utilisé. Il faut aussi penser à la logistique d’alimentation du réacteur en régolithe, qu’il s’agisse de son extraction, de son transport ou de son utilisation après traitement.

La pyrolyse solaire sous vide est une méthode particulièrement bien adaptée aux conditions lunaires. Elle tire parti du vide naturel de la Lune, demande peu de ressources importées et utilise l’énergie solaire, abondante sur un satellite sans atmosphère. Les tests à Odeillo ont déjà prouvé la faisabilité du concept, mais les rendements doivent encore être améliorés et les défis techniques restent considérables. En produisant localement de l’oxygène et des matériaux, le procédé soutiendrait les futures bases lunaires et réduirait leur dépendance vis-à-vis de la Terre.

Jack Robinot a reçu des financements du CNES et de la région Occitanie.

Sylvain Rodat a reçu des financements de la région Occitanie et un support matériel de l'ESA (Agence spatial européenne) qui a fourni le simulant de régolithe.

Alexis Paillet et Stéphane Abanades ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.

12.02.2026 à 16:12

Barbie, figure d’émancipation féminine ?

Sophie Renault, Professeur des Universités en Sciences de Gestion et du Management, Université d’Orléans

Texte intégral (1781 mots)

Longtemps critiquée pour enfermer les fillettes dans des carcans stéréotypés, Barbie s’affirme désormais comme un symbole de l’émancipation féminine. Effectivement, Mattel a entièrement révisé sa stratégie : diversité des origines, des hobbies et professions, représentation des handicaps… Mais Barbie est-elle pour autant devenue un levier d’émancipation ou présente-t-elle un féminisme compatible avec les ambitions commerciales ?

Créée en 1959, Barbie apparaît comme une innovation majeure dans l’univers du jouet. À une époque où les poupées proposées aux fillettes sont essentiellement des bébés à pouponner, Barbie incarne une femme adulte, indépendante, dotée d’une maison, d’une voiture et susceptible d’épouser une pluralité de métiers. Elle ouvre ainsi un espace de projection inédit, permettant aux enfants d’imaginer des trajectoires féminines affranchies du seul horizon domestique. Cette promesse d’autonomie s’accompagne toutefois de critiques. La silhouette de Barbie, aux proportions irréalistes, devient un symbole de la pression exercée sur les corps féminins. Comme l’indique Bazzano dans son ouvrage intitulé la Femme parfaite : histoire de Barbie :

« Si Barbie, au lieu de ses quelque trente centimètres, mesurait un mètre soixante-quinze, ses mensurations poitrine-taille-hanches seraient : 95-53-83. »

Selon l’auteure, il s’agit de proportions peu crédibles avec un buste trop court, une poitrine trop forte, sur une taille trop fine, avec des hanches trop étroites, sur des jambes trop longues se terminant par des pieds trop cambrés. De nombreuses recherches montrent que l’exposition répétée à cet idéal corporel contribue à l’intériorisation de normes de beauté susceptibles d’affecter l’image corporelle dès le plus jeune âge.

L’univers esthétique de la poupée, centré sur la mode, la consommation et une féminité très codifiée, renforce cette critique. Barbie représente une femme indépendante, certes, mais tenue de rester belle, mince et désirable.

Représenter pour rendre possible

Afin de répondre aux transformations sociétales et de mieux coller à la diversité du réel, Mattel a engagé une évolution progressive de la poupée. Comme le signifie Rogers dans son ouvrage intitulé Barbie Culture, bien que Barbie ait des amies racisées depuis les années 1960 et qu’elle ait elle-même été commercialisée en version afro-américaine, asiatique et hispanique, elle demeurait dans l’esprit collectif blonde, blanche et élancée.

L’introduction de la gamme Barbie Fashionistas en 2009 constitue une étape décisive. Mattel élargit la gamme des carnations, de types de cheveux et coiffures, tout en mettant l’accent sur une diversité des styles, hobbies et professions. Il faut attendre 2016 pour que la marque franchisse une étape supplémentaire en introduisant des morphologies alternatives en termes de taille et corpulence engageant ainsi une remise en question plus directe de l’idéal corporel historiquement associé à la poupée.

Barbie incarne également une diversité de carrières, avec un message clair : « You can be anything » (« Tu peux être qui tu veux »). Sur le plan symbolique, cette logique se fonde sur un principe qui postule que tout ce qui est visible devient susceptible d’être pensé. Les jouets jouent un rôle actif dans la socialisation genrée et la formation des aspirations. Évidemment, une poupée astronaute, paléontologue, médecin ou rock-star n’évoque pas les mêmes rêves qu’une poupée confinée au milieu domestique. Ici, l’émancipation se manifeste par le jeu, la redondance et la normalisation de figures féminines qui ont été longtemps mises en marge. Ainsi, Barbie permet aux enfants d’explorer une variété de scénarios professionnels. Pourtant, cette influence sur le réel reste complexe.

L’étude menée par Sherman et Zurbriggen a montré que les fillettes qui jouaient à Barbie, même dans sa version docteur avec blouse blanche, otoscope et stéthoscope, indiquaient qu’elles avaient moins d’options de carrière futures que les garçons. En revanche, celles qui jouaient avec Monsieur Patate signalaient une différence moins importante entre leurs propres carrières futures possibles et celles des garçons, suggérant que la sexualisation de la poupée pèse plus lourd que son uniforme.

Présentée comme célibataire, malgré l’omniprésence de Ken, son éternel prétendant relégué au second plan, Barbie met en scène une indépendance qui passe aussi par ce qu’elle possède. Les objets qui l’entourent participent à la construction d’une image de femme libre et ambitieuse. L’empowerment se transforme alors en promesse individualisée, esthétisée et compatible avec les logiques de consommation de masse, plutôt qu’en un processus collectif de transformation sociale. Par ailleurs, malgré les efforts de diversification, certaines normes persistent. Même lorsqu’elle est scientifique ou pilote d’avion, Barbie reste conforme aux standards de désirabilité dominants. Son évolution demeure ainsi régie par les normes du marché. Il s’agit in fine de provoquer l’acte d’achat.

La représentation du handicap : entre reconnaissance et simplification

Parmi les avancées les plus notables figure la récente représentation du handicap dans l’univers de Barbie. Mattel a en effet déployé des poupées en fauteuil roulant, dotées de prothèses de jambe, touchées par le vitiligo, l’alopécie, la cécité ou bien encore la trisomie 21. Élaborées en partenariat avec des personnes concernées ou spécialistes (professionnels de santé, associations…), ces poupées ont le plus souvent été saluées pour leur aptitude à représenter des vérités longtemps négligées dans le monde du jouet. Elles permettent aux enfants concernés de se reconnaître et aux autres d’intégrer la différence comme une composante ordinaire du monde social. Le jeu devient alors un espace de familiarisation et de déstigmatisation.

La commercialisation, en 2025, d’une Barbie atteinte de diabète de type 1, équipée d’un capteur de glucose et d’une pompe à insuline, marque une étape importante dans la politique inclusive de la marque. Ce lancement ouvre un nouveau chapitre en déplaçant la question de la représentation vers le terrain des handicaps dits « invisibles », longtemps absents de l’univers du jouet. Dans cette mouvance, une Barbie autiste est commercialisée depuis janvier 2026. Ici aussi, la représentation s’opère principalement par l’utilisation d’accessoires. La Barbie est en effet équipée d’un casque antibruit, d’un hand-spinner et d’une tablette de communication. Ces évolutions posent alors la question de la capacité du jouet à offrir un véritable espace d’identification, sans réduire le handicap à une série de signes ou d’objets immédiatement reconnaissables.

Barbie, miroir de nos contradictions

À mesure que l’inclusion devient un argument central du discours de marque, une tension se dessine entre reconnaissance symbolique et logique commerciale, au risque de relever d’une forme d’habillage éthique. Dans cette perspective, l’inclusion est envisagée comme une stratégie de marque, consolidant la crédibilité de Barbie sans remettre en question les hiérarchies esthétiques et commerciales qui structurent son succès.

Barbie cristallise certaines des contradictions contemporaines : la reconnaissance d’une diversité plus visible s’accompagne d’une vigilance face à une stratégie marketing bien maîtrisée. Cette ambivalence a été mise en évidence par le film Barbie (2023) qui oscille entre satire populaire et analyse métaféministe. Le film met en effet en exergue les paradoxes d’un féminisme soutenu par une icône commerciale.

En définitive, Barbie ne génère pas l’empowerment, elle le soutient, le reformule et parfois le simplifie. Elle exprime, dans le langage accessible du jouet, des problématiques complexes. La trajectoire de Barbie illustre que l’émancipation dépend des conditions socio-économiques et culturelles qui peuvent transformer ces représentations en expériences concrètes.

Sophie Renault ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

12.02.2026 à 16:12

Élections municipales : quelle place pour les femmes, les minorités et les classes populaires ? Enquête en Seine-Saint-Denis

Violette Arnoulet, Urbaniste et maître de conférences en sociologie à l'université Paris Dauphine - PSL, Université Paris Dauphine – PSL

Claudette Lafaye, Maitresse de conférence en sociologie, Université Paris 8 – Vincennes Saint-Denis

Texte intégral (2351 mots)

Dans certains départements français, dont la Seine-Saint-Denis, les mandats municipaux se sont largement ouverts aux femmes et aux personnes appartenant à une minorité visible. Mais cette évolution masque une reconfiguration du « plafond de verre », entre discriminations, exclusion des classes populaires et limitation à des postes stéréotypés.

À quelques semaines des élections municipales de mars 2026 se repose la question de la faible représentativité du personnel politique français. Dans les conseils municipaux comme à l’Assemblée nationale, la professionnalisation des élu·e·s s’accompagne de la quasi-disparition des classes populaires et du maintien d’assemblées majoritairement blanches et le plus souvent présidées par des hommes. En 2025, 21 % seulement des maires étaient des femmes et 9 % déclaraient une profession d’employé ou d’ouvrier.

Qu’en est-il en Seine-Saint-Denis, département marqué par l’histoire de la « banlieue rouge », la présence des classes populaires et d’une immigration ancienne ? Les listes candidates et les conseils municipaux sont-ils, dans ce département comme ailleurs, de plus en plus éloignés de la population qu’ils représentent ?

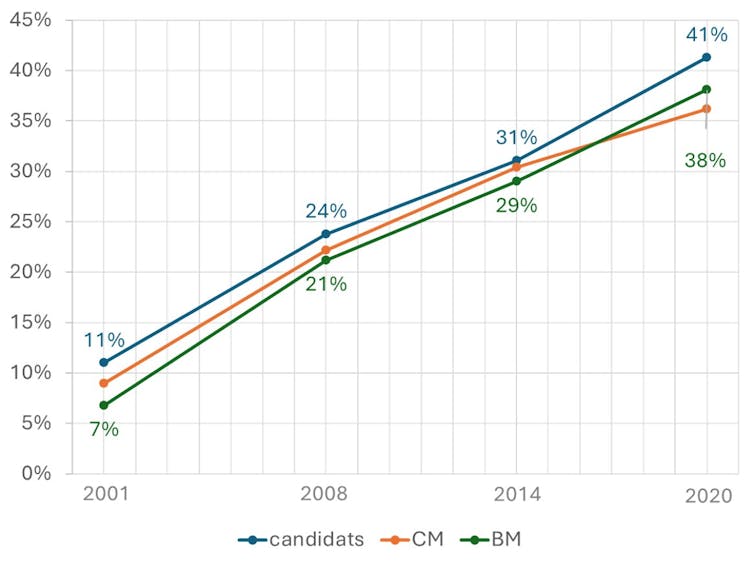

Pour nourrir ces réflexions, nous partageons les premiers résultats d’une enquête sur les 40 communes de ce département, menée par une équipe des universités Paris Nanterre, Paris 8 et Paris Dauphine. Cette recherche documente les évolutions des candidats et candidates aux élections municipales et celles des membres des conseils municipaux de 2001 à 2020, au prisme de la classe sociale, du genre et de l’assignation raciale. Elle analyse notamment la place en politique des personnes renvoyées à un statut social inférieur, sur la base de leur origine supposée, de leur apparence ou de leur nom. On désigne ici ces personnes comme « racisées » ou « minorités visibles ».

Une percée des femmes et des minorités racisées dans les conseils municipaux

Depuis les élections municipales de 2001, l’évolution du personnel politique en Seine-Saint-Denis suit les tendances nationales. Si l’implantation du Parti communiste français (PCF) a longtemps favorisé l’élection de conseillers municipaux et de maires ouvriers, la présence des classes populaires dans les assemblées municipales est désormais résiduelle : seuls 11 % des personnes élues en 2020 sont employées ou ouvrières, alors que ces catégories représentent 53 % de la population active du département. Comme dans le reste des communes urbaines, les conseils municipaux de Seine-Saint-Denis sont plus accessibles aux cadres (42 % des personnes élues en 2020, pour 21 % de la population active du département). Ces dynamiques sont encore plus vraies pour le mandat de maire : 25 maires sur 40 sont des cadres en 2020.

Du côté du genre, les lois sur la parité en politique ont renforcé la présence des femmes. En 2020, elles représentaient 48 % des personnes élues du département. Leur part reste néanmoins inférieure à 50 %, signe que les têtes de liste sont, ici comme ailleurs, plus souvent des hommes. Cette féminisation s’accompagne, par ailleurs, d’une forte sélection sociale des femmes élues qui, comme les hommes, sont très souvent des cadres (40 % des élues).

Dans ce contexte, c’est une évolution moins commentée qui a retenu notre attention. Depuis 2001, la présence de personnes appartenant aux minorités visibles se renforce dans les conseils municipaux du département. Les élections de 2008 qui suivent les révoltes urbaines de 2005 marquent un tournant : la part des personnes racisées double sur les listes candidates et augmente fortement dans les conseils municipaux. Elle triple même au sein des bureaux municipaux (composés d’un·e maire et de ses adjoint·es) qui concentrent la réalité du pouvoir communal.

En 2020, les personnes racisées représentent désormais plus du tiers (36,2 %) des membres des conseils municipaux, améliorant ainsi la représentation politique de la population du département.

Comme pour les femmes, cette ouverture bénéficie surtout aux classes moyennes et supérieures : 5 des 7 maires racisés élus en 2020 sont des cadres ou des chefs d’entreprise, et aucun n’est ouvrier ou employé. Néanmoins, beaucoup d’élu·es racisé·es sont des enfants ou des petits enfants d’immigré·es de milieu populaire qui ont connu une ascension sociale. Au sein des conseils municipaux, cette trajectoire les distingue des autres élu·e·s, de même que leur jeunesse (19 % ont moins de 30 ans en 2020).

Figure : La part des personnes racisées parmi les candidat·es aux élections municipales, les élu·es des conseils municipaux et des bureaux municipaux est en progression constante depuis les élections de 2008

Dans les communes de Seine-Saint-Denis, représentation des classes populaires et diversité de genre ou ethnoraciale ne vont ainsi pas de pair. Au contraire, l’entrée de femmes et de personnes racisées dans les conseils municipaux s’accommode du renforcement de la sélection sociale, aboutissant à l’invisibilisation des classes populaires. Peut-on pour autant conclure de cette avancée relative que le racisme et le sexisme auraient disparu en politique ?

Le « plafond de verre » n’a pas disparu, il s’est reconfiguré

Premier constat, les femmes et les personnes racisées continuent à faire face à des obstacles dans l’accès aux responsabilités. C’est pour le mandat de maire que le « plafond de verre » résiste le mieux, en particulier pour les femmes. Dans les 40 communes du département, seules 5 femmes sont élues maires en 2020, sans amélioration vis-à-vis des scrutins précédents.

Pour les personnes racisées, ce plafond de verre, longtemps impénétrable, commence à se fissurer. En 2014, Stains est la première ville de Seine-Saint-Denis à élire un descendant de l’immigration algérienne en la personne d’Azzedine Taïbi. En 2020, c’est le cas de six autres communes, ce qui porte à sept le nombre de maires racisés. Deux femmes racisées accèdent également à cette fonction en cours de mandat en 2016 et 2022, à la faveur de la démission du maire en place. La première n’est pas reconduite aux élections suivantes et la seconde a depuis rétrocédé sa place à son prédécesseur.

Au-delà des limitations imposées à leurs ambitions, les personnes racisées comme les femmes font face à des inégalités dans la répartition des rôles au sein des conseils municipaux, qui tendent à reconduire des stéréotypes genrés ou racialisés. Ainsi, les femmes sont souvent en charge des affaires sociales, de l’enfance ou des familles, et les personnes racisées se voient confier la lutte contre les discriminations ou la jeunesse, surtout en début de carrière.

Cette situation est in fine particulièrement défavorable pour les femmes racisées, largement évincées des délégations clés – finances de la commune, urbanisme et aménagement – généralement confiées aux premiers adjoints ou adjointes du maire. Dans ce contexte, elles sont nombreuses à exprimer en entretien le sentiment d’être considérées comme des « décorations » ou des « cautions féminines ».

Un engagement politique marqué par l’expérience des inégalités

Second constat, les limitations imposées aux ambitions des femmes et des personnes racisées ne sont que l’un des aspects des discriminations rencontrées par ces dernières en politique. Si l’importance du sexisme est désormais connue, le racisme exerce aussi une influence sur les parcours en politique. Il peut nourrir un désir de s’engager comme freiner l’accès à la candidature et favoriser l’usure au cours du mandat.

Les personnes racisées témoignent d’abord souvent du rôle joué par l’expérience des discriminations dans leur politisation et leur désir d’engagement. Certaines ont fait de l’amélioration de la représentation des habitants et habitantes des quartiers populaires un enjeu de campagne, en s’engageant sur des listes citoyennes, portées par des militantes et militants associatifs. On a pu voir ce type de liste dans des villes comme Aubervilliers ou le Blanc-Mesnil, aux élections de 2008, 2014 et 2020.

D’autres, plus nombreuses, ont été renvoyées à leurs origines supposées ou à leur appartenance à une minorité visible au cours de leur mandat, parfois de façon positive. À Gagny, par exemple, l’élection du maire Rolin Cranoly en 2019 a été saluée par la presse antillaise, conduisant cet édile à prendre conscience du caractère symbolique de son parcours. Le plus souvent cependant, ces assignations relèvent du racisme ordinaire, comme en témoigne en entretien une adjointe d’une commune de gauche :

« Ah, c’est subtil, c’est très subtil. Au début, on doute en disant : “C’est pas possible.” On écorche votre nom, puis on vous demande de le répéter ; quand vous dites une phrase, on vous demande de la répéter deux ou trois fois ; on vient vous demander si vous faites le ramadan. »

Enfin, certains sont la cible d’attaques virulentes, comme Azzedine Taïbi, maire de Stains depuis 2014 : des militants d’extrême droite ont cherché à s’introduire dans la mairie après la dénonciation publique par l’édile d’injures racistes et de menaces de mort proférées à son encontre.

À l’approche des élections municipales de mars 2026, des initiatives s’emparent de ces questions. Les militants et militantes de l’Assemblée des quartiers ont obtenu l’ouverture de certaines listes de gauche à des candidatures issues des quartiers populaires. Le collectif Démocratiser la politique défend quant à lui l’institution d’une parité sociale en politique pour remédier à l’exclusion des classes populaires.

Ces enjeux sont particulièrement vifs en Seine-Saint-Denis, où de nombreuses villes verront s’affronter des listes menées par des femmes et des personnes racisées. Alors que pour les classes populaires, le défi est plus que jamais celui de l’accès à la représentation politique locale, les femmes et les personnes racisées sont désormais face à la tâche difficile de politiser l’expérience du plafond de verre et des discriminations, pour transformer le jeu politique local.

Cet article s’appuie sur une recherche conduite par Marie-Hélène Bacqué, Jeanne Demoulin, Claudette Lafaye, Hélène Haztfeld, Violette Arnoulet et Yasmina Dris. Elle a donné lieu à l’écriture d’un livre : Élus des banlieues populaires, « La vie des idées », Presses universitaires de France, 2026.

J'ai travaillé 6 ans pour l'établissement public territorial Plaine Commune de 2014 à 2019 en tant qu'urbaniste. J'étais chargée de mission au sein de la direction de la rénovation urbaine sur les projets de Stains. J'ai ensuite consacré ma thèse (soutenue en 2023) à la commune de Stains.

Claudette Lafaye ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

12.02.2026 à 16:11

Chine-Inde : le face-à-face des géants

Emmanuel Lincot, Spécialiste de l'histoire politique et culturelle de la Chine contemporaine, Institut catholique de Paris (ICP)

Texte intégral (3347 mots)

Les relations entre la Chine et l’Inde s’inscrivent dans une longue histoire politique et culturelle. Bouddhisme, colonisation occidentale puis décolonisation et héritages de la guerre froide : les deux géants asiatiques partagent un immense passé commun. Dans son ouvrage Chine-Inde. La guerre des mondes, Emmanuel Lincot, sinologue, professeur à l’Institut catholique de Paris et directeur Asie de l’Iris, revient sur les rivalités et les interdépendances sino-indiennes. Extrait.

Prolégomènes

En guise de préambule général à cette étude très générale concernant les relations entre la Chine et l’Inde, il est primordial de restaurer la place occupée par l’imaginaire dans l’histoire culturelle de ces deux pays, car lui seul expliquerait la puissante attirance qui s’est exercée entre eux, à l’origine de leur porosité même. Cette attirance correspond à une épistémè. Elle s’ouvre sur près d’un millénaire, depuis l’introduction du bouddhisme en Chine sous les Han de l’Est (IIe siècle de notre ère), par l’intermédiaire tout d’abord des missionnaires et marchands kouchans, jusqu’aux invasions islamiques ghaznévides et la destruction hautement symbolique de ce lieu d’études bouddhistes que fut Nalanda dans la province du Bihar vers 1200.

Cette longue période est marquée par toute une série d’échanges, dans le domaine de la pensée et de l’esthétique notamment. C’est ce que retient l’historiographie la plus courante, sous la forme de prodigieux inventaires dont on retiendra ceux réalisés à l’initiative du gouvernement indien, fruit d’une collaboration académique sino-indienne remarquable éditée il y a dix ans, et si le bouddhisme dans ces échanges finit par être marginalisé, c’est qu’en Inde même il entrait dans une phase irréversible de déclin par rapport à l’hindouisme tandis que le néoconfucianisme en Chine, sous la dynastie Song, dans ses formes les plus réactionnaires, se muait en une politique de rejet vis-à-vis de cette religion d’origine étrangère.

En apparence tout au moins, car ce bouddhisme première manière qui avait emprunté ses thèses sur la vacuité des choses attribuées au grand penseur Nagarjuna (IIe siècle de notre ère), se voit transformé dans son contact avec la Chine par la puissance d’une toute autre tradition, l’herméneutique tibétaine. Celle-ci, jusqu’au début du XXe siècle, nourrit à la Cour sino-mandchou de Pékin tout un ordonnancement qui allie à la fois le rite au mythe. Ce dernier tient lieu d’explication, de fabulation, de facteur de mobilisation, mais aussi de mode discursif permettant d’élaborer toute une variante de représentations, politiques notamment.

Lorsque Xi Jinping convoque la mémoire bouddhiste de son pays à Xi’an (2015) ou que Narendra Modi lui rendant la pareille s’attache à commémorer la figure de Bodhidharma à Mahabalipuram (2019), chacun souligne des analogies structurelles, sans se préoccuper des différences historiques, ce qui relève bel et bien d’une préoccupation avant tout idéologique. Ce qui vaut pour les périodes anciennes vaut pour les périodes les plus récentes. Ainsi, et pour s’en tenir à un événement de la seconde moitié du XXe siècle important dans l’histoire des relations internationales, Bandung est l’un des grands mythes continuant à nourrir les imaginaires politiques à la fois indien et chinois. Cette conférence qui vit en 1955 New Dehli et Pékin défier l’Occident, au nom des intérêts du Tiers Monde, demeure l’une des grandes références idéologiques que le Sud Global a cœur encore aujourd’hui à cultiver.

C’est que ces deux États ont une histoire commune et douloureuse vis-à-vis de l’Occident. Elle est liée au déploiement des voies de communication et partant, des échanges les plus divers. Échanges suivant le cheminement des convoyages de l’opium à partir de la seconde moitié du XIXe siècle, dans une trajectoire géographiquement parallèle à celle des imprimés, lesquels sont symptomatiques d’une accélération de l’histoire. En définitive, cette accélération de l’histoire n’est pas autre chose qu’une accélération de la médiation. Transnationale, cette histoire voit le jour avec le capitalisme international et la colonisation des espaces indien et chinois que l’Europe marchande convoite. Elle bouleverse les représentations traditionnelles chinoise et indienne du monde. Respectivement marquées par un rapport centre/périphérie que traduisent les spéculations indiennes sur le symbole du mandala ou pour la Chine par un marquage identitaire fort et que personnifie la Grande Muraille, ces représentations volent en éclat lorsqu’au XIXe siècle les Européens s’imposent avec des normes, une supériorité technique et un calendrier que ne maîtrisent ni les Indiens ni les Chinois.

Ce qui change aussi c’est une culture impériale vernaculaire que remettent en cause les Européens. C’est vrai, côté chinois, avec les Guerres de l’Opium ou du côté indien dès la prise de New Dehli (1857) et la délégitimation des dynasties régnantes (Qing et Moghole). Désormais, les décisions pour l’Inde et la Chine se prennent à Londres et à Paris. Les puissances conquérantes morcellent de leur emprise territoriale des régions entières. Encore à ce jour, l’Inde et la Chine n’ont de cesse que de vouloir les réintégrer dans leur propre espace de sécurité ou, à défaut, d’en chasser définitivement toute présence étrangère qui viendrait à s’y exercer.

La reconfiguration des espaces stratégiques n’est pas le seul héritage des transformations liées à l’entrée brutale de l’Inde et de la Chine dans l’ère moderne. L’exemple de l’islam indien, sous la colonisation britannique, et ses ramifications jusqu’en Chine à travers la présence de communautés basées à Hongkong ou celui, beaucoup plus récent, galvanisant les mouvements contestataires de la Milk Tea Alliance depuis les marges des mondes indien et chinois, sont en cela des plus probants.

Mais l’évocation de ces faits ne saurait faire oublier que cette histoire partagée se bâtit sur des omissions sélectives. Si c’est particulièrement vrai pour la Chine eu égard à l’histoire du « siècle de la honte » (bai nian guo chi), autrement dit le XIXe siècle dans son rapport conflictuel aux puissances européennes, cela l’est davantage pour l’épisode traumatisant que représentent les ratées du maoïsme, et que le régime entend faire disparaître d’un trait. Cette amnésie peut être identifiée, également en Inde, comme une source possible de pratiques discriminatoires à l’encontre du passé moghol et musulman en l’espèce ici. Dans les faits, cette discrimination commence très tôt avec une référence forte à l’hindutva. Son terreau idéologique né dans le contexte colonial britannique du début du XXe siècle sera le fil directeur, on le sait, de toute l’extrême droite hindouiste.

Atavisme géographique et héritages de la guerre froide

Cette radicalité n’est évidemment pas la seule que l’on observe. La perception de l’espace stratégique de chacun de ces pays change tout autant. Ainsi, jusqu’au XIXe siècle la menace existentielle pour l’empire chinois se situe dans les régions du Nord et de l’Ouest, régions associées dans les mémoires collectives, au danger du monde barbare. Elles redeviendront prioritaires et stratégiques à l’issue du schisme sino-soviétique, dans les années soixante, alors que Mao Zedong craignait par-dessus tout une invasion par les troupes de Moscou depuis la Mongolie et la Sibérie et ce, après un intermède d’un siècle qui avait été marqué par le dépeçage de l’empire à l’instigation des puissances européenne et japonaise, c’est-à-dire sur son flanc Est.

Comparativement, pour l’Inde et à la suite de l’effondrement de l’URSS en 1991, ce schéma s’inverse. Pour New Dehli, le danger provient en effet beaucoup moins de la mer et du littoral que du grand Nord et de ses régions limitrophes qui l’opposent à la Chine et au Pakistan. La guerre froide aura toutefois laissé de part et d’autre des préjugés et des appréhensions tenances qui échappent à ces considérations géographiques, qu’il s’agisse de la relation établie par Pékin ou New Dehli vis-à-vis de Washington et de Moscou. Pour des raisons historiques, une grande partie de l’armée indienne doute de la fiabilité américaine à son endroit.

Des incartades voire de spectaculaires revirements de la Maison Blanche, elle a été ébranlée par trois fois. La première, lorsque les Américains se sont engagés en 1954 à apporter une assistance militaire au Pakistan, qui, en contrepartie, a participé au système d’alliances occidentales (Organisation du traité de l’Asie du Sud-Est (OTASE), puis pacte de Bagdad). La deuxième, lorsque les Américains ont soutenu les Pakistanais contre les sécessionnistes du Bangladesh en 1971 ; ces derniers bénéficiant en revanche de l’aide des Indiens et de leur partenaire soviétique. La troisième enfin, est liée à la question tibétaine. Depuis 1959, le Dalaï-lama s’est réfugié à Dharamsala dans le Nord de l’Inde et la CIA conduit des commandos tibétains depuis le territoire indien contre des intérêts chinois.

Lorsque Richard Nixon rencontre son homologue Mao Zedong en 1972, Tibétains et Indiens assistent impuissants au lâchage de ces hommes. Malgré les critiques proférées par Pékin contre Washington et Moscou, la Chine, elle, reste à la fois pragmatique et prudente vis-à-vis des États-Unis. D’une part en raison d’une antériorité de liens sino-américains profonds qui remontent à la seconde guerre mondiale alors que Washington soutenait les Chinois dans leur effort de guerre contre les Japonais avec l’envoi notamment des premières escadrilles de volontaires américains commandés par le Général Chenault, les Flying Tigers.

À ce précédent s’ajoute la collaboration discrète dans les années quatre-vingt entre la CIA et les services chinois afin de renseigner les Moudjahidines afghans en lutte contre les Soviétiques. L’idylle sino-américaine est ternie par les massacres des étudiants à Tiananmen en 1989. Washington impose un embargo sur la vente d’armes à Pékin. Il est encore en vigueur aujourd’hui. Dans le même temps, Washington semble donner des signes d’encouragement en faveur de la démocratisation de Taïwan, île avec laquelle les Américains ont signé le très important Taïwan Relations Act. Avec Moscou, l’Inde entretient des relations privilégiées dès son indépendance et la relation militaire au sein de leur partenariat stratégique occupe une place de premier rang.

Depuis l’instauration du régime en 1949, l’État-Parti chinois s’est quant à lui à la fois inspiré de l’URSS défunte ou s’y est référée comme repoussoir. Ainsi, se confondant avec les structures de l’État, le Parti fonctionne sur un mode stalinien. Dans ses choix de développement, y compris dans la volonté de se doter de l’arme nucléaire à partir de 1964, Moscou est le modèle vers lequel les premières générations de communistes et stratèges chinois se tournent. Quitte à devoir renoncer, comme dut s’y plier Mao Zedong, à l’usage de la guérilla au profit d’une modernisation de l’Armée Populaire de Libération et ce, en suivant des modalités plus conventionnelles, c’est-à-dire en optant pour un programme de nucléarisation qu’appelait de ses vœux le Maréchal Peng Dehuai.

Notons que cet usage de la guérilla d’inspiration chinoise a fait bien des émules en Inde même avec le développement d’une mouvance, les Naxalites. Dès les années soixante, elle a recours à une lutte armée de nature asymétrique, et revendique pleinement sa filiation idéologique avec le maoïsme chinois en vue d’instaurer une démocratie directe et défendre les intérêts des paysans. Si cette mouvance s’essouffle aujourd’hui, elle ne constitue pas moins, dans ses modalités profondes, une opposition structurée au modèle de la démocratie représentative et le modèle d’une utopie rurale vivace quoi que malmenée par les bouleversements en Inde liés au développement du capitalisme, la privatisation de l’économie à partir des années quatre-vingt dix et l’explosion des cultures urbaines.

Sur le plan international, que ce soit en Inde ou en Chine, la chute du Mur de Berlin en 1989 puis la chute, trois ans plus tard, de l’URSS est de toutes les mémoires. C’est sur ses cendres (dont la décomposition est à l’origine de l’indépendance de quinze États) qu’Evguenij Primakov, alors ministre des Affaires étrangères de la toute jeune fédération de Russie, devient l’ardent avocat de la multipolarité, en tant qu’alternative à l’hégémonie mondiale exercée par les États-Unis. Ce choix demeure une constante pour Moscou. Cette volonté russe s’est parfois plus clairement exprimée sur la nécessité de constituer un axe « Moscou-Pékin-Delhi ». Véritable serpent de mer, cette idée de « trilatéralisme » n’a pas toujours fait l’unanimité. Ainsi, Pékin a longtemps fait prévaloir le principe de « coexistence pacifique » (heping gongchu, une expression empruntée par Mao Zedong aux Soviétiques) avant d’employer, beaucoup plus tard, celle d’« ascension pacifique » (heping jueqi) sous la présidence (2003-2013) de Hu Jintao, comme doctrine caractérisant ses choix de politique étrangère.

Quelles perspectives ?

Alors que la Chine et l’Inde s’apprêtent en cette fin de XXe siècle à souscrire aux règles de la mondialisation, et à poursuivre le développement de voies alternatives à l’Occident, chacune cherche à consolider sa présence sur ses marges. La Look East Policy pour l’Inde et la volonté pour la Chine de sanctuariser ses intérêts dans le Sud de la mer de Chine en sont la parfaite illustration. Bien que la Russie fasse figure de matrice référentielle à ces velléités de coopération trilatérale, la rivalité systémique qui oppose pour l’heure la Chine à l’Inde augure mal d’une structure pérenne commune aux trois États.

Toutefois, chacun de leurs dirigeants se projette déjà dans une ère post-américaine pour définir leur rôle dans les relations internationales. On en veut pour preuve leur rencontre fortement médiatisée lors du sommet de l’Organisation de Coopération de Shanghai à Tianjin en août 2025. Cette projection leur sera d’autant plus aisée que les axes de leur politique étrangère, sur bien des aspects convergent, et sont même parfois très proches.

Si leur attachement à la défense de leurs intérêts et à leur souveraineté est un premier point commun, leur souhait d’accompagner la mondialisation pour gagner en influence sur la scène internationale en est un autre. Cette idée d’une trilitéralité entre les trois États sera encouragée par Vladimir Poutine et trouvera des échos favorables auprès de Pékin. Tandis que la Chine y verra le moyen de contrer l’unipolarité américaine qu’elle commencera ouvertement à contester, l’Inde se verra chaque année davantage acculée à des choix cornéliens dans le choix de ses priorités de partenariat tout en gardant un avantage, celui d’être ramenée au centre de toutes les attentions. La signature des accords de libre-échange entre l’Inde et l’Union européenne en janvier 2026 confirme cette observation et montre le souhait de l’Inde à privilégier un nouvel équilibre avec ses partenaires européens.

Et pour cause, les faits sont têtus : partageant avec la Chine 3800 kilomètres de frontière commune avec la Chine, New Dehli et Pékin n’ont toujours pas su apaiser leurs litiges frontaliers. Ils s’ajoutent à ceux qui opposent au Cachemire l’Inde au Pakistan, de nouveau entrés en guerre pour une brève période en avril 2025. Pour Pékin, ce foyer de crise constitue avec son prolongement himalayen, « une nouvelle frontière ». Alors que la Chine a réglé la plupart de ses contentieux frontaliers, l’Himalaya est la dernière région de sa périphérie où ses frontières ne sont pas stabilisées. Cette instabilité est liée à une problématique plus profonde, celle que pose l’intégration de deux régions situées sur ses confins. Elles se heurtent aux paradigmes historiques et culturels proprement chinois. Ce sont les provinces du Tibet et du Xinjiang. Elles comptent encore aujourd’hui parmi les régions les plus déshéritées du pays.

Rappelons que chacune est d’autant plus importante, qu’elle ouvre respectivement vers le subcontinent indien et l’Asie centrale. Se comprend d’autant mieux le fait que les questions ouïgoure et tibétaine soient moins traitées par les analystes indiens sous l’angle des droits de l’Homme, comme le font leurs homologues occidentaux, que sécuritaires. Le seul Tibet représente 13 % du territoire chinois. La province est en contact avec l’Inde, le Bhoutan, le Népal, le Myanmar et le Pakistan, sa position en surplomb, ses ressources minières et en eau offrent à Pékin un ascendant considérable par rapport à New Dehli. Le développement du grand Ouest programmé dès la fin des années quatre-vingt-dix par le gouvernement central confère au Tibet une place particulière en tant que province frontalière mais aussi dans les moyens alloués en vue de son essor sur le plan économique. C’est cette région du monde qui verra sans doute de prochaines déflagrations.

Emmanuel Lincot ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

12.02.2026 à 16:10

Croissance rapide de la population en Afrique de l’Ouest : les quatre défis que la région doit relever

Serge Rabier, Chargé de recherche Population et Genre, Agence Française de Développement (AFD)

Texte intégral (2506 mots)

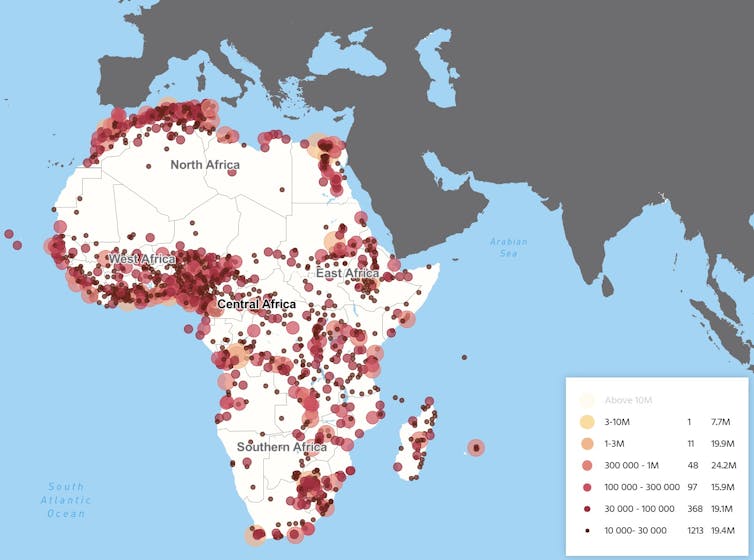

L’Afrique de l’Ouest fait face à une expansion démographique accélérée : près de la moitié de la population est âgée de moins de 20 ans. Les défis – insertion sur le marché du travail, transformations urbaines et, à plus long terme, accroissement sensible du nombre des personnes âgées – que pose ce phénomène sont nombreux. S’ils sont relevés, la jeunesse pourra être un véritable moteur pour le développement de la région.

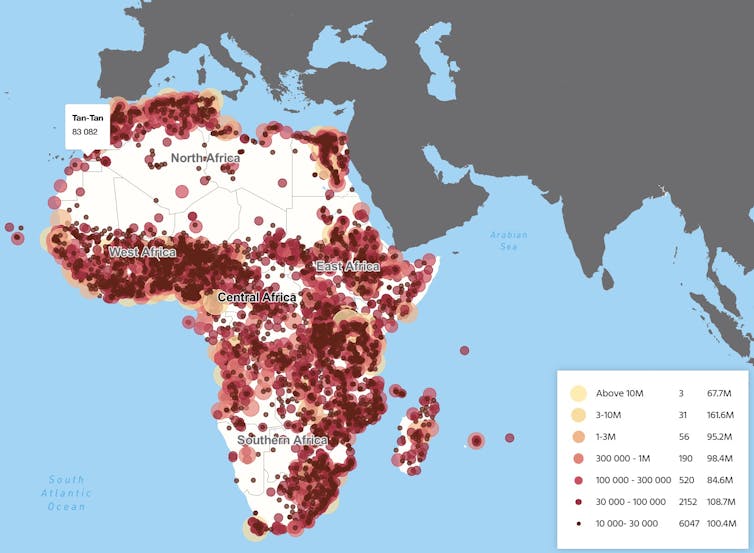

D’ici à 2050, le continent africain devrait compter plus de 2,4 milliards d’habitants, soit presque un milliard de plus qu’aujourd’hui. Cette dynamique est marquée en Afrique subsaharienne et tout particulièrement en Afrique de l’Ouest et centrale (AOC), dont environ 33 % de la population se situe dans la tranche d’âge 10-24 ans en 2025.

L’expansion démographique s’accompagne de transformations économiques, sociales et territoriales majeures : urbanisation rapide et non planifiée, migrations accrues, profondes inégalités de revenus ou d’accès aux services essentiels comme la santé ou l’éducation… Cette expansion peut représenter, pour l’Afrique de l’Ouest, non pas un handicap mais, au contraire, une opportunité de développement à saisir. Mais pour cela, quatre défis devront être relevés.

Défi nunéro 1 : accompagner la transition démographique