12.12.2025 à 13:09

Le sort de Warner Bros suspendu au duel Netflix–Paramount

Julien Jourdan, Professeur, HEC Paris Business School

Texte intégral (1496 mots)

Ce pourrait être un épisode d’une série américaine sur le monde des affaires. Qui, de Paramount ou de Netflix, mettra la main sur la Warner Bros ? Les deux projets n’ont pas les mêmes motivations. Surtout, l’un et l’autre devront faire avec le droit de la concurrence aux États-Unis, mais aussi en Europe, mondialisation oblige. Résumé des premiers épisodes, si vous avez manqué le début…

La nouvelle a frappé Hollywood de stupeur. Le 4 décembre dernier, Netflix annonçait l’acquisition des studios Warner Bros. (WB) pour 83 milliards de dollars, coiffant au poteau le favori Paramount. La situation s’est depuis compliquée : le patron de Paramount, David Ellison, a surenchéri avec une offre hostile à 108 milliards de dollars pour l’ensemble du groupe WB Discovery, incluant les studios ainsi qu’un bouquet – en déclin – de chaînes de télévision, dont la célèbre chaîne d’information CNN.

L’issue de cette bataille est incertaine à l’heure actuelle. Les deux opérations sont de nature différente. Un achat par Paramount impliquerait une triple fusion entre deux studios, deux plates-formes de streaming – Paramount+ (79 millions d’abonnés) et HBO+ (128 millions d’abonnés) – et deux bouquets de chaînes de télévision (dont CNN et CBS). Ce serait une fusion horizontale entre des acteurs en concurrence directe sur leurs marchés. L’impact social pourrait être très lourd : l’opération prévoit 6 milliards de dollars de synergies, en grande partie via la suppression de postes en doublon.

À lire aussi : Netflix, une machine à standardiser les histoires ?

Si Netflix mettait la main sur WB, ce serait principalement pour acquérir le vaste catalogue de WB et de HBO, les chaînes du câble étant exclues de l’offre du géant du streaming. Les synergies anticipées, de l’ordre de 3 milliards, concerneraient les dépenses technologiques pour les deux tiers et seraient constituées, pour le reste, d’économies sur les achats de droits de diffusion. Netflix pourrait ainsi librement diffuser Game of Thrones ou Harry Potter auprès de ses 302 millions d’abonnés dans le monde. Ce serait une fusion verticale combinant un producteur de contenus, WB, et un diffuseur, Netflix, qui éliminerait au passage un concurrent notable, HBO+.

Des précédents coûteux

Ce type d’opération pourrait rendre nerveux quiconque se rappelle l’histoire des fusions de Warner Bros. Déjà en 2001, le mariage de WB et d’AOL célébrait l’alliance du contenu et des « tuyaux » – pour utiliser les termes alors en vogue. L’affaire s’était terminée de piteuse manière par le spin-off d’AOL et l’une des plus grosses dépréciations d’actifs de l’histoire – de l’ordre de 100 milliards de dollars. Quinze ans plus tard, AT&T retentait l’aventure. L’union fut de courte durée. En 2021, le géant des télécoms se séparait de WB, qui se voyait désormais associé au groupe de télévision Discovery, sous la direction de David Zaslav, aujourd’hui à la manœuvre.

Pourquoi ce qui a échoué dans le passé marcherait-il aujourd’hui ? À dire vrai, la position stratégique de Netflix n’a rien à voir avec celle d’AOL et d’AT&T. Les fusions verticales précédentes n’ont jamais produit les synergies annoncées pour une simple raison : disposer de contenu en propre n’a jamais permis de vendre plus d’abonnements au téléphone ou à Internet. Dans les deux cas, le château de cartes, vendu par les dirigeants, et leurs banquiers, s’est rapidement effondré.

Un catalogue sans pareil

Une fusion de Netflix avec WB délivrerait en revanche des bénéfices très concrets : le géant du streaming ajouterait à son catalogue des produits premium – films WB et séries HBO – dont il est à ce jour largement dépourvu. L’opération permettrait de combiner l’une des bibliothèques de contenus les plus riches et les plus prestigieuses avec le média de diffusion mondiale le plus puissant qui ait jamais existé. L’ensemble pourrait en outre attirer les meilleurs talents, qui restent à ce jour largement inaccessibles à Netflix.

En pratique, certains contenus, comme la série Friends, pourraient être inclus dans l’offre de base pour la rendre plus attractive et recruter de nouveaux abonnés. D’autres films et séries pourraient être accessibles via une ou plusieurs options payantes, sur le modèle de ce que fait déjà Amazon Prime, augmentant ainsi le panier moyen de l’abonné.

Le rapprochement de deux stars du divertissement ferait à coup sûr pâlir l’offre de leurs concurrents, dont Disney mais aussi… Paramount. Et c’est là que le bât blesse. Les autorités de la concurrence, aux États-Unis et en Europe, approuveront-elles la formation d’un tel champion mondial ? Si la fusion est confirmée, les procédures en recours ne tarderont pas à arriver.

CNN dans le viseur

C’est l’argument avancé par David Ellison, le patron de Paramount, qui agite le chiffon rouge de l’antitrust pour convaincre les actionnaires de WBD : que restera-t-il du studio si la fusion avec Netflix est rejetée après deux ans de procédures ? Ted Sarandos, le co-PDG de Netflix, pourrait lui retourner la pareille, car une fusion horizontale avec Paramount ne manquerait pas d’éveiller, elle aussi, des inquiétudes – d’autant plus qu’elle serait largement financée par des capitaux étrangers venant du Golfe.

Le fils de Larry Ellison, deuxième fortune mondiale, réputé proche du président américain, s’est assuré le soutien financier du gendre de ce dernier, Jared Kushner. Si Donald Trump se soucie probablement assez peu du marché du streaming, il pourrait être sensible au sort réservé à la chaîne CNN, une de ses bêtes noires. En cas de victoire de Paramount, CNN pourrait être combinée avec CBS et sa ligne éditoriale revue pour apaiser le locataire de la Maison-Blanche. Du côté du vendeur, David Zaslav laisse les enchères monter. Il pourrait empocher une fortune – on parle de plus de 425 millions de dollars.

À cette heure, le sort de WB est entre les mains de cette poignée d’hommes. Des milliers d’emplois à Los Angeles, et ailleurs, sont en jeu. Une fusion WB/Netflix pourrait par ailleurs accélérer la chute de l’exploitation des films en salles, dans un contexte d’extrême fragilité : le nombre de tickets vendus dans les cinémas en Amérique du Nord a chuté de 40 % depuis 2019. Netflix pourrait choisir de diffuser directement sur sa plateforme certains films de WB, qui représente environ un quart du marché domestique du cinéma. Pour les films qui conserveraient une sortie en salle, la fenêtre d’exclusivité réservée aux exploitants pourrait se réduire à quelques semaines, fragilisant un peu plus leur économie. Hollywood retient son souffle.

Julien Jourdan ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

12.12.2025 à 13:08

Le smic protège-t-il encore de la pauvreté ?

Hugo Spring-Ragain, Doctorant en économie / économie mathématique, Centre d'études diplomatiques et stratégiques (CEDS)

Texte intégral (1866 mots)

Vendredi 12 décembre 2025, le Groupe d’experts sur le smic publie un rapport sur l’impact du salaire minimum sur l’économie française. Son impact sur la pauvreté n’est cependant pas univoque. Le smic ne suffit pas à expliquer les trajectoires personnelles de plus en plus diverses. Le revenu disponible qui prend en compte les aides perçues et les dépenses contraintes est un critère plus juste.

La question revient cette année encore avec le rapport du Groupe d’experts du smic publié ce vendredi 12 décembre : le salaire minimum protège-t-il encore réellement de la pauvreté ? Pourtant, comme l’ont rappelé l’Insee et l’Institut des politiques publiques (IPP) dans plusieurs travaux plus ou moins récents, le salaire brut, seul, ne détermine pas la pauvreté. Ce qui importe, c’est le niveau de vie, c’est-à-dire le revenu disponible après transferts sociaux de toutes sortes (qui s’ajoutent), impôts et charges contraintes (qui se soustraient). Dans un contexte de renchérissement du logement (13 % d’augmentation de l’indice de référence des loyers, IRL) et d’hétérogénéité croissante des situations familiales, la question ne doit plus être posée en termes uniquement macroéconomiques.

La littérature académique reprend ce constat. Antony B. Atkinson souligne que la pauvreté ne renvoie pas simplement à un « manque de salaire », mais à un insuffisant accès aux ressources globales ; Patrick Moyes rappelle que la structure familiale modifie profondément le niveau de vie relatif. Quant à France Stratégie et l’Insee, après sa publication faisant l’état des lieux de la pauvreté en France, ils documentent la montée de ce qu’on appelle la pauvreté laborieuse, c’est-à-dire le fait de travailler sans pour autant dépasser les seuils de pauvreté et sans possibilité de profiter de l’ascenseur social.

À lire aussi : La pauvreté de masse : symptôme d’une crise de la cohésion sociale

Un amortisseur d’inflation ?

Notre premier graphique compare l’évolution du smic, des salaires et des prix depuis 2013. On y observe très nettement que le salaire minimum a servi d’amortisseur pendant la séquence inflationniste récente : ses revalorisations automatiques l’ont fait progresser aussi vite, souvent plus vite, que l’indice des prix à la consommation.

Figure 1 – Évolution du smic, du salaire mensuel de base (SMB), du salaire horaire de base des ouvriers et des employés (SHBOE) et de l’indice des prix à la consommation (IPC) hors Tabac – Sources : Dares, Insee, Rapport GES 2025 – Graphique de l’auteur.

Ce mouvement contraste avec celui des salaires moyens, dont la progression a été plus lente. Comme le soulignent plusieurs analyses de France Stratégie et de l’Organisation de coopération et de développement économiques (OCDE), cela a eu pour effet de resserrer la hiérarchie salariale, une situation déjà documentée lors de précédentes périodes de rattrapage du smic.

L’influence du temps de travail

Mais ce constat ne dit rien d’une dimension pourtant déterminante : l’accès au temps plein car une partie des salariés au smic n’y est pas à temps complet. Comme l’ont montré plusieurs travaux de l’Insee et de la direction de l’animation de la recherche, des études et des statistiques (Dares, ministère du travail), une proportion importante de travailleurs rémunérés au salaire minimum occupe des emplois à temps partiel, et souvent non par choix mais parce qu’aucun temps plein n’est disponible. C’est ce que les économistes appellent le temps partiel contraint.

Ce temps partiel modifie radicalement l’interprétation du smic : on parle d’un salaire minimum horaire, mais, concrètement, les ressources mensuelles ne reflètent pas ce taux. Un salaire minimum versé sur 80 % d’un temps plein ou sur des horaires discontinus conduit mécaniquement à un revenu inférieur et donc à une exposition accrue à la pauvreté.

Mais si l’on s’en tenait à cette comparaison, on pourrait conclure que le smic protège pleinement les salariés les plus modestes. Or, c’est précisément ici que la question se complexifie. Car la pauvreté ne dépend pas du seul salaire : elle dépend du revenu disponible et donc de l’ensemble des ressources du ménage. C’est ce que montrent les travaux sur la pauvreté laborieuse, un phénomène en hausse en France selon l’Observatoire des inégalités, environ une personne en situation de pauvreté sur trois occupe un emploi mais les charges familiales, le coût du logement ou l’absence de second revenu maintiennent le ménage sous les seuils de pauvreté.

Du smic au revenu disponible

Pour comprendre la capacité réelle du smic à protéger de la pauvreté, il faut observer ce qu’il devient une fois transformé en revenu disponible grâce aux données de l’Insee et de la Dares, c’est-à-dire le revenu après impôts, aides et charges incompressibles.

Le graphique suivant juxtapose trois situations familiales : une personne seule, un parent isolé avec un enfant et un couple avec un enfant dont les deux adultes perçoivent le smic.

Figure 2 – Revenu disponible et seuils de pauvreté selon trois profils de ménages rémunérés au smic Sources : Dares, Insee, Rapport GES 2025 – Graphique de l’auteur.

Dans le premier panneau, on observe qu’une personne seule rémunérée au smic dispose d’un revenu disponible supérieur au seuil de pauvreté à 60 % du revenu médian. La prime d’activité joue un rôle important, mais c’est surtout l’absence de charge familiale et de coûts fixes élevés qui explique ce résultat.

Ce profil correspond à la représentation classique du smic comme filet de sécurité individuel. Comme le confirment les données de l’Insee et les travaux de France Stratégie, la pauvreté laborieuse y est encore relativement limitée. Cependant, même seul, un actif au smic pourrait avoir des dépenses contraintes extrêmement élevées dans des zones à forte demande locative.

La pauvreté laborieuse

Le deuxième panneau raconte une histoire totalement différente. Le parent isolé, même à temps plein au smic se situe clairement en dessous du seuil de pauvreté, plus grave encore, son revenu disponible ne compense plus le salaire net via les transferts. C’est ici que la notion de pauvreté laborieuse prend tout son sens. Malgré un emploi et malgré les compléments de revenu, le ménage reste dans une situation de fragilité structurelle.

Selon l’Insee, les familles monoparentales sont aujourd’hui le groupe le plus exposé à la pauvreté et notamment à la privation matérielle et sociale, non parce qu’elles travaillent moins, mais parce qu’elles cumulent un revenu unique, des charges plus élevées et une moindre capacité d’ajustement.

Dans le troisième panneau, un couple avec un enfant et deux smic vit lui aussi en dessous de la ligne de pauvreté. Ce résultat laisse penser que la composition familiale, même accompagnée de deux smic crée une pauvreté structurelle sur les bas revenus ; aussi le graphique montre-t-il que la marge est finalement assez limitée. Une partie du gain salarial disparaît en raison de la baisse des aides et de l’entrée dans l’impôt, un phénomène bien documenté par l’IPP et par le rapport Bozio-Wasmer dans leurs travaux sur les « taux marginaux implicites ». Dans les zones de loyers élevés, un choc de dépense ou une hausse de charges peut faire basculer ces ménages vers une situation beaucoup plus précaire.

Situations contrastées

Une conclusion s’impose : le smic protège encore une partie des salariés contre la pauvreté, mais ce résultat est loin d’être uniforme. Il protège l’individu à plein temps et sans enfant, mais ne suffit plus à assurer un niveau de vie décent lorsque le salaire doit couvrir seul les charges d’un foyer, notamment dans les configurations monoparentales. Cette asymétrie est au cœur de la montée de la pauvreté laborieuse observée par l’Insee et documentée par l’Institut des politiques publiques.

Ces résultats rappellent que la pauvreté n’est plus seulement un phénomène d’exclusion du marché du travail. Elle touche des travailleurs insérés, qualifiés et en contrat stable, mais dont le salaire minimum, appliqué sur un volume horaire insuffisant ou absorbé par des dépenses contraintes, ne permet plus un niveau de vie supérieur aux seuils de pauvreté. Le smic se révèle alors davantage un plancher salarial individuel qu’un instrument de garantie sociale familiale.

À l’heure où la question du pouvoir d’achat occupe une place centrale et où la revalorisation du smic reste l’un des outils majeurs d’ajustement, ces conclusions invitent à réorienter le débat. Ce n’est pas seulement le niveau du smic qu’il faut interroger, mais sa capacité à constituer un revenu de référence pour des configurations familiales et territoriales très hétérogènes. Autrement dit, le smic joue encore sa fonction de stabilisateur individuel, mais il n’est plus suffisant seul pour protéger durablement certains ménages.

La question devient alors moins « De combien augmenter le smic ? » que « Comment garantir que le revenu disponible issu d’un emploi au smic permette effectivement d’éviter la pauvreté ? ».

Hugo Spring-Ragain ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

11.12.2025 à 16:16

L’internationale trumpiste : la Stratégie de sécurité nationale 2025 comme manifeste idéologique

Jérôme Viala-Gaudefroy, Spécialiste de la politique américaine, Sciences Po

Texte intégral (2420 mots)

L’administration Trump vient de rendre publique sa Stratégie de sécurité nationale. Charge virulente contre l’Europe, affirmation de l’exceptionnalisme des États-Unis, présentation du président actuel en héros affrontant au nom de son pays des périls mortels pour la civilisation occidentale : bien plus qu’un simple ensemble de grandes lignes, il s’agit d’une véritable proclamation idéologique.

La Stratégie de sécurité nationale (National Security Strategy, NSS) est normalement un document technocratique, non contraignant juridiquement, que chaque président des États-Unis doit, durant son mandat, adresser au Congrès pour guider la politique étrangère du pays.

La version publiée par l’administration Trump en 2025 (ici en français) ressemble pourtant moins à un texte d’État qu’à un manifeste idéologique MAGA (Make America Great Again) qui s’adresse tout autant à sa base qu’au reste du monde, à commencer par les alliés européens de Washington, accusés de trahir la « vraie » démocratie. Pour la première fois, et contrairement à la NSS du premier mandat Trump publiée en 2017, la sécurité nationale y est définie presque exclusivement à partir des obsessions trumpistes : immigration, guerre culturelle, nationalisme.

Les trois principales articulations du texte

La NSS 2025 rompt complètement avec la tradition libérale de la démocratie constitutionnelle (respect des droits fondamentaux, primauté de l’État de droit, pluralisme) et avec sa traduction internationale — la promotion de la démocratie dans le cadre d’un ordre multilatéral fondé sur des règles. Elle réécrit l’histoire depuis la fin de la guerre froide, construit un ennemi composite (immigration, élites « globalistes », Europe) et détourne le vocabulaire de la liberté et de la démocratie au service d’un exceptionnalisme ethno-populiste.

Ce document présente une grande narration en trois actes.

Acte I : La trahison des élites.

C’est le récit de l’échec des politiques menées par les États-Unis depuis 1991, imputées à l’hubris d’élites qui auraient voulu l’hégémonie globale. Elles auraient mené des « guerres sans fin », mis en place un « prétendu libre-échange » et soumis le pays à des institutions supranationales, au prix de l’industrie américaine, de la classe moyenne, de la souveraineté nationale et de la cohésion culturelle. Ce premier acte souligne enfin l’incapacité à renouveler un récit national crédible après la fin de la guerre froide : c’est sur ce vide narratif que Trump construit son propre récit.

Acte II : Le déclin.

Le déclin des États-Unis tel que vu par l’administration Trump est à la fois économique, moral, géopolitique et démographique. Il se manifeste par la désindustrialisation, les guerres ratées, ou encore par la crise des frontières avec le Mexique. Il fait écho au « carnage américain » que l’actuel président avait dénoncé lors de son premier discours d’investiture, en 2017. L’ennemi est ici décrit comme à la fois intérieur et extérieur : l’immigration, présentée comme une « invasion » liée aux cartels, mais aussi les institutions internationales et les élites de politique étrangère, américaines comme européennes. Tous sont intégrés dans un même schéma conflictuel, celui d’une guerre globale que l’administration Trump serait prête à mener contre ceux qui menaceraient souveraineté, culture et prospérité américaines.

Acte III : Le sauveur.

La NSS présente le locataire de la Maison Blanche comme un leader providentiel, comme le « président de la Paix » qui corrige la trahison des élites. Trump y apparaît comme un « redresseur », héros (ou anti-héros) qui aurait, en moins d’un an, « réglé huit conflits violents ». Il incarnerait une nation retrouvée, prête à connaître un « nouvel âge d’or ». On retrouve ici un schéma narratif typiquement américain, issu de la tradition religieuse de la jérémiade : un prêche qui commence par dénoncer les fautes et la décadence, puis propose un retour aux sources pour « sauver » la communauté. L’historien Sacvan Bercovitch a montré que ce type de récit est au cœur du mythe national américain. Un texte qui devrait être techno-bureaucratique se transforme ainsi en récit de chute et de rédemption.

L’exceptionnalisme américain à la sauce Trump

À y regarder de près, la NSS 2025 foisonne de tropes propres aux grands mythes américains. Il s’agit de « mythifier » la rupture avec des décennies de politique étrangère en présentant la politique conduite par l’administration Trump comme un retour aux origines.

Le texte invoque Dieu et les « droits naturels » comme fondement de la souveraineté, de la liberté, de la famille traditionnelle, voire de la fermeture des frontières. Il convoque la Déclaration d’indépendance et les « pères fondateurs des États-Unis » pour justifier un non-interventionnisme sélectif. Il se réclame aussi de « l’esprit pionnier de l’Amérique » pour expliquer la « domination économique constante » et la « supériorité militaire » de Washington.

Si le mot exceptionalism n’apparaît pas (pas plus que la formule « indispensable nation »), la NSS 2025 est saturée de formulations reprenant l’idée d’une nation unique dans le monde : hyper-superlatifs sur la puissance économique et militaire, rôle central de l’Amérique comme pilier de l’ordre monétaire, technologique et stratégique. Il s’agit d’abord d’un exceptionnalisme de puissance : le texte détaille longuement la domination économique, énergétique, militaire et financière des États-Unis, puis en déduit leur supériorité morale. Si l’Amérique est « la plus grande nation de l’histoire » et « le berceau de la liberté », c’est d’abord parce qu’elle est la plus forte. La vertu n’est plus une exigence qui pourrait limiter l’usage de la puissance ; elle est au contraire validée par cette puissance.

Dans ce schéma, les élites — y compris européennes — qui affaiblissent la capacité américaine en matière d’énergie, d’industrie ou de frontières ne commettent pas seulement une erreur stratégique, mais une faute morale. Ce n’est plus l’exceptionnalisme libéral classique de la diffusion de la démocratie, mais une forme d’exceptionnalisme moral souverainiste : l’Amérique se pense comme principale gardienne de la « vraie » liberté, contre ses adversaires mais aussi contre certains de ses alliés.

Là où les stratégies précédentes mettaient en avant la défense d’un « ordre international libéral », la NSS 2025 décrit surtout un pays victime, exploité par ses alliés, corseté par des institutions hostiles : l’exceptionnalisme devient le récit d’une surpuissance assiégée plutôt que d’une démocratie exemplaire. Derrière cette exaltation de la « grandeur » américaine, la NSS 2025 ressemble davantage à un plan d’affaires, conçu pour servir les intérêts des grandes industries — et, au passage, ceux de Trump lui-même. Ici, ce n’est pas le profit qui se conforme à la morale, c’est la morale qui se met au service du profit.

Une vision très particulière de la doctrine Monroe

De même, le texte propose une version mythifiée de la doctrine Monroe (1823) en se présentant comme un « retour » à la vocation historique des États-Unis : protéger l’hémisphère occidental des ingérences extérieures. Mais ce recours au passé sert à construire une nouvelle doctrine, celui d’un « corollaire Trump » — en écho au « corollaire Roosevelt » : l’Amérique n’y défend plus seulement l’indépendance politique de ses voisins, elle transforme la région en chasse gardée géo-économique et migratoire, prolongement direct de sa frontière sud et vitrine de sa puissance industrielle.

À lire aussi : États-Unis/Venezuela : la guerre ou le deal ?

Sous couvert de renouer avec Monroe, le texte légitime une version trumpiste du leadership régional, où le contrôle des flux (capitaux, infrastructures, populations) devient le cœur de la mission américaine. Là encore, le projet quasi impérialiste de Trump est présenté comme l’extension logique d’une tradition américaine, plutôt que comme une rupture.

La NSS 2025 assume au contraire une ingérence politique explicite en Europe, promettant de s’opposer aux « restrictions antidémocratiques » imposées par les élites européennes (qu’il s’agisse, selon Washington, de régulations visant les plates-formes américaines de réseaux sociaux, de limitations de la liberté d’expression ou de contraintes pesant sur les partis souverainistes) et de peser sur leurs choix énergétiques, migratoires ou sécuritaires. Autrement dit, Washington invoque Monroe pour sanctuariser son hémisphère, tout en s’arrogeant le droit d’intervenir dans la vie politique et normative européenne — ce qui revient à revendiquer pour soi ce que la doctrine refuse aux autres.

Dans la NSS 2025, l’Europe est omniprésente — citée une cinquantaine de fois, soit deux fois plus que la Chine et cinq fois plus que la Russie —, décrite comme le théâtre central d’une crise à la fois politique, démographique et civilisationnelle. Le texte oppose systématiquement les « élites » européennes à leurs peuples, accusant les premières d’imposer, par la régulation, l’intégration européenne et l’ouverture migratoire, une forme d’« effacement civilisationnel » qui reprend, sans le dire, la logique du « grand remplacement » de Renaud Camus, théorie complotiste d’extrême droite largement documentée.

À lire aussi : L’Europe vue par J. D. Vance : un continent à la dérive que seul un virage vers l’extrême droite pourrait sauver

L’administration Trump s’y arroge un droit d’ingérence idéologique inédit : elle promet de défendre les « vraies » libertés des citoyens européens contre Bruxelles, les cours et les gouvernements, tout en soutenant implicitement les partis d’extrême droite ethno-nationalistes qui se posent en porte-voix de peuples trahis. L’Union européenne est dépeinte comme une machine normative étouffante, dont les règles climatiques, économiques ou sociétales affaibliraient la souveraineté des nations et leur vitalité démographique. Ce faisant, le sens même des mots « démocratie » et « liberté » est inversé : ce ne sont plus les institutions libérales et les traités qui garantissent ces valeurs, mais leur contestation au nom d’un peuple soi-disant homogène et menacé, que Washington prétend désormais protéger jusque sur le sol européen.

La Russie, quant à elle, apparaît moins comme ennemi existentiel que comme puissance perturbatrice dont la guerre en Ukraine accélère surtout le déclin européen. La NSS 2025 insiste sur la nécessité d’une cessation rapide des hostilités et de la mise en place d’un nouvel équilibre stratégique, afin de favoriser les affaires. La Chine est le seul véritable rival systémique, surtout économique et technologique. La rivalité militaire (Taïwan, mer de Chine) est bien présente, mais toujours pensée à partir de l’enjeu clé : empêcher Pékin de transformer sa puissance industrielle en hégémonie régionale et globale.

Le Moyen-Orient n’est plus central : grâce à l’indépendance énergétique, Washington cherche à transférer la charge de la sécurité à ses alliés régionaux, en se réservant un rôle de faiseur de deals face à un Iran affaibli. L’Afrique, enfin, est envisagée comme un terrain de reconquête géo-économique face à la Chine, où l’on privilégie les partenariats commerciaux et énergétiques avec quelques États jugés « fiables », plutôt qu’une politique d’aide ou d’interventions lourdes.

Un texte qui ne fait pas consensus

Malgré la cohérence apparente et le ton très péremptoire de cette doctrine, le camp MAGA reste traversé de fortes divisions sur la politique étrangère, entre isolationnistes « America First » hostiles à toute projection de puissance coûteuse et faucons qui veulent continuer à utiliser la supériorité militaire américaine pour imposer des rapports de force favorables.

Surtout, les sondages (ici, ici, ou ici) montrent que, si une partie de l’électorat républicain adhère à la rhétorique de fermeté (frontières, Chine, rejet des élites), l’opinion américaine dans son ensemble demeure majoritairement attachée à la démocratie libérale, aux contre-pouvoirs et aux alliances traditionnelles. Les Américains souhaitent moins de guerres sans fin, mais ils ne plébiscitent ni un repli illibéral ni une remise en cause frontale des institutions qui structurent l’ordre international depuis 1945.

Jérôme Viala-Gaudefroy ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

11.12.2025 à 15:57

Le cash recule, mais reste solidement ancré dans les portefeuilles des Français

Timothée Waxin, Responsable du département Finance, Data & Performance, Pôle Léonard de Vinci

Texte intégral (1491 mots)

Le cash recule mais ne disparaît pas. Face à l’essor fulgurant des paiements numériques et aux ambitions européennes d’un euro digital, les espèces résistent, portées par la recherche de confidentialité, de contrôle et de résilience. À l’heure du tout dématérialisé, les Français n’ont pas encore remisé pièces et billets.

Le cash, c’est-à-dire l’argent liquide, tangible et immédiatement disponible, est très ancien, bien antérieur au mot lui-même. Les premières pièces de monnaie remontent à 600 avant notre ère environ en Lydie (actuelle Turquie). Les billets de banque remplacent progressivement les pièces à partir du XVIIe siècle.

Plus de 2 600 ans après son apparition, la monnaie fiduciaire (pièces et billets), par opposition à la monnaie scripturale (virements, cartes, paiements mobiles…), est-elle condamnée à disparaître ?

Un moindre usage des espèces au profit des paiements dématérialisés

L’usage des espèces recule progressivement en France au profit de la carte bancaire et des paiements mobiles. La quatrième enquête de la Banque centrale européenne (BCE) sur les habitudes de paiement des consommateurs en zone euro, publiée en décembre 2024, montre en effet que les paiements par carte représentent désormais 48 % des transactions, contre 43 % pour les paiements en espèces.

Pour la première fois, la carte dépasse donc le cash dans l’Hexagone – une situation qui contraste avec celle de l’ensemble de la zone euro, où les espèces demeurent le moyen de paiement le plus utilisé aux points de vente.

Répartition des moyens de paiement aux points de vente, en France et en zone euro (en % du nombre de transactions)

Cette évolution s’inscrit dans une tendance de long terme, nourrie par un environnement propice à l’innovation et à la numérisation des services financiers.

L’écosystème français des paiements, porté par un tissu dynamique de fintech, propose une offre diversifiée de solutions scripturales qui séduit un nombre croissant de consommateurs. L’essor du paiement sans contact accompagne ce mouvement. Apparue en 2012 avec un plafond initial de 20 euros, relevé successivement à 30 puis 50 euros, cette fonctionnalité concerne aujourd’hui près de sept paiements sur dix réalisés au point de vente. Le développement de la technologie dite « PIN online », permettant de dépasser ce seuil après saisie d’un code sur le terminal de paiement, devrait encore accélérer cette adoption. Parallèlement, la croissance du commerce en ligne a profondément transformé les usages.

Un quart des paiements en France s’effectue désormais sur Internet, une évolution largement stimulée par la crise sanitaire, qui a ancré durablement les réflexes numériques des consommateurs. Les paiements mobiles et les virements instantanés connaissent eux aussi une progression rapide, soutenue par l’émergence de solutions innovantes comme Wero, service européen de paiement instantané proposé par les banques de cinq pays européens.

Cette transition vers le numérique soulève des enjeux majeurs

Cette dynamique devrait se poursuivre à mesure que l’écosystème des paiements continue d’évoluer. De nouveaux acteurs – prestataires techniques, grandes entreprises technologiques, fintech spécialisées – renforcent leur présence dans la chaîne de valeur des paiements.

Dans ce contexte d’initiatives privées et de dématérialisation accrue, les banques centrales cherchent à préserver leur rôle dans les paiements. L’Eurosystème prépare ainsi l’émission d’un euro numérique, destiné à compléter les espèces et les moyens de paiement existants. Son déploiement pourrait intervenir à l’horizon 2027 ou 2028, malgré des interrogations persistantes sur sa complexité d’usage et sa valeur ajoutée perçue par le grand public.

De leur côté, les paiements en stablecoins progressent également, portés par des cas d’usage concrets dans le commerce numérique, les transferts de fonds et les paiements internationaux : ils s’intègrent de plus en plus à l’économie réelle et ne relèvent plus uniquement de la spéculation.

Toutefois, cette transition vers le numérique soulève des enjeux majeurs de souveraineté. Comme le souligne François Villeroy de Galhau, gouverneur de la Banque de France, dans sa Lettre au président de la République, d’avril 2025, 72 % des paiements par carte en zone euro au second semestre 2023 reposaient sur des réseaux internationaux. Christine Lagarde, présidente de la BCE, alerte également sur la dépendance de l’Europe à des infrastructures non européennes – Visa, Mastercard, PayPal, Alipay – issues pour la plupart des États-Unis ou de Chine.

Les infrastructures de cartes nationales, comme Carte bleue (CB) en France, s’érodent en Europe : seuls neuf demeurent actives dans l’Union européenne, tandis que treize pays de la zone euro dépendent entièrement d’acteurs internationaux. Cette dépendance accroît la vulnérabilité de l’Europe face à d’éventuelles restrictions d’accès aux systèmes de paiement. Dans un récent rapport de la Fondation Concorde, nous préconisons le développement de solutions européennes et le co-badging sur les cartes pour renforcer l’autonomie financière du continent.

Le numérique séduit, le cash rassure

Malgré cette dématérialisation rapide des paiements, les Français restent profondément attachés aux espèces. L’enquête de la BCE souligne en effet que 60 % d’entre eux jugent important de conserver la possibilité de payer en liquide. L’anonymat et la protection de la vie privée (d’ailleurs, crainte souvent émise à l’égard du projet d’euro numérique de la BCE), le règlement immédiat et la maîtrise des dépenses figurent parmi les avantages les plus fréquemment cités.

L’accès au cash demeure par ailleurs très satisfaisant : 94 % des commerçants acceptent encore les espèces, et la quasi-totalité de la population (99,9 %) vit à moins de quinze minutes de trajet par la route d’un site équipé d’au moins un distributeur automatique de billets (DAB) ou d’un point d’accès privatif chez un commerçant. Bien que le nombre de DAB ait reculé (42 578 DAB fin 2024, contre 52 697 en 2018), 91 % des Français estiment que l’accès au liquide reste « facile » ou « très facile » – l’un des meilleurs scores de la zone euro.

Assez paradoxalement, la Banque centrale européenne elle-même invite dans une note « Gardez votre calme et conservez de l’argent liquide : leçons sur le rôle unique de la monnaie physique à travers quatre crises », parue en septembre dernier, à ne pas tourner totalement le dos au cash. En cas de crise majeure – panne électrique, cyberattaque ou pandémie –, elle recommande de garder entre 70 et 100 euros en liquide par personne pour les dépenses essentielles. Un conseil révélateur : si le cash décline dans nos portefeuilles, il reste une valeur refuge, un symbole de sécurité et d’autonomie. Autrement dit, la France avance vers les paiements du futur… sans tout à fait lâcher ses pièces et ses billets.

Entre la carte et les espèces, les Français se montrent ainsi ambivalents. Ils adoptent avec enthousiasme les technologies sans contact, les paiements mobiles et les virements instantanés, tout en conservant dans leurs portefeuilles un peu de cash « au cas où ». Le futur du paiement s’écrira sans doute à deux vitesses : numérique par choix, mais liquide par prudence.

Timothée Waxin est administrateur et vice-président du conseil scientifique de la Fondation Concorde.

11.12.2025 à 15:57

Comment Paris est passé de capitale de la vie brève à championne de la longévité

Florian Bonnet, Démographe et économiste, spécialiste des inégalités territoriales, Ined (Institut national d'études démographiques)

Catalina Torres, Maîtresse de conférence, Universidad de la República, Montevideo, Uruguay - chercheure associée, unité « Mortalité, santé, épidémiologie », Ined (Institut national d'études démographiques)

France Meslé, Démographe, Ined (Institut national d'études démographiques)

Texte intégral (4249 mots)

Longtemps marquée par une mortalité élevée, la population de Paris accusait à la fin du XIXᵉ siècle un lourd retard d’espérance de vie par rapport à celles des autres régions de France. Un siècle plus tard, la ville est devenue l’un des territoires où l’on vit le plus longtemps au monde. Comment expliquer ce renversement spectaculaire ? Une plongée dans les archives de la capitale permet de retracer les causes de cette transformation, entre recul des maladies infectieuses, progrès de l’hygiène publique et forte baisse des inégalités sociales face à la mort.

Combien de temps peut-on espérer vivre ? Derrière cette question d’apparence simple se cache un des indicateurs les plus brûlants pour appréhender le développement socio-économique d’un pays. Car l’espérance de vie à la naissance ne mesure pas seulement la durée moyenne de la vie ; elle résume à elle seule l’état sanitaire, les conditions de vie ainsi que les inégalités sociales au sein d’une population.

En 2024, la France figurait parmi les pays les plus longévifs au monde (autrement dit, l’un des pays où l’on vit le plus longtemps). L’espérance de vie y était de 80 ans pour les hommes et de 85 ans et 7 mois pour les femmes, selon l’Insee. Derrière ces moyennes nationales se cachent toutefois des disparités territoriales notables.

À Paris, par exemple, l’espérance de vie atteignait 82 ans pour les hommes et 86 ans et 8 mois pour les femmes – soit un avantage de 1 à 2 ans par rapport à la moyenne nationale selon le sexe. Mais cela n’a pas toujours été le cas. Retour sur cent cinquante ans d’évolutions.

Une espérance de vie longtemps inférieure à la moyenne française

Paris n’a pas toujours été un havre de longévité. Il y a cent cinquante ans, la vie moyenne des habitants de la capitale était nettement plus courte. Un petit Parisien ayant soufflé sa première bougie en 1872 pouvait espérer vivre encore 43 ans et 6 mois. Une petite Parisienne, 44 ans et dix mois.

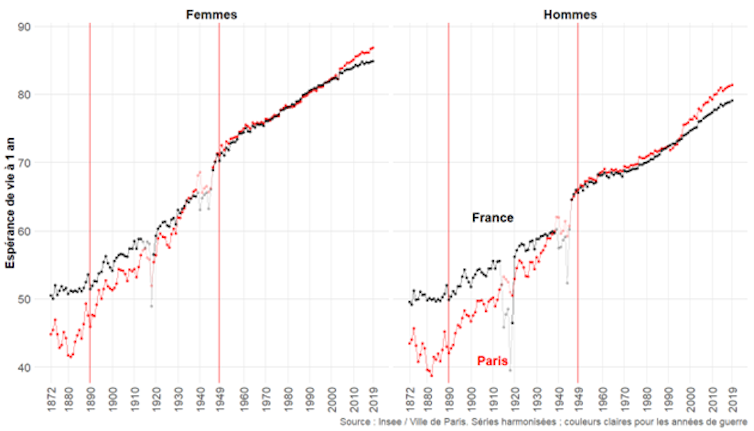

C’est ce que révèle la figure ci-dessous, qui retrace l’évolution de l’espérance de vie à un an entre 1872 et 2019 pour la France entière (en noir) et pour la capitale (en rouge). Cet indicateur, qui exclut la mortalité infantile (très élevée et mal mesurée à Paris à l’époque), permet de mieux suivre les changements structurels de la longévité en France sur le long terme.

On constate que, dans la capitale, l’espérance de vie est longtemps restée inférieure à celle du reste du pays. Ce n’est qu’au début des années 1990 (pour les femmes) et des années 2000 (pour les hommes) qu’elle a dépassé celle de l’ensemble des Français.

À la fin du XIXe siècle, l’écart en défaveur des habitants de la capitale atteignait dix ans pour les hommes et huit ans pour les femmes. Cette situation, commune de par le monde, est connue dans la littérature sous le nom de pénalité urbaine. On l’explique entre autres par une densité de population élevée favorisant la propagation des maladies infectieuses et un accès difficile à une eau potable de qualité.

Dans une étude récemment publiée dans la revue Population and Development Review, nous avons cherché à mieux comprendre comment Paris est passé de la capitale de la vie brève à l’un des territoires dans le monde où les habitants peuvent espérer vivre le plus longtemps.

Une base de données inédite pour remonter le fil de la longévité parisienne

Pour cela, nous avons collecté un ensemble inédit de données sur les causes de décès entre 1890 et 1949 à Paris, seule ville de France pour laquelle ces données ont été produites à cette époque, grâce aux travaux fondateurs des statisticiens Louis-Adolphe et (son fils) Jacques Bertillon.

Cette tâche est pendant très longtemps restée impossible, car, même si les données requises existaient, elles restaient dispersées dans les archives de la Ville et leurs coûts de numérisation étaient élevés. De plus, les statistiques de mortalité par cause étaient difficiles à exploiter, en raison de changements répétés de classification médicale. Nous avons pu récemment lever ces écueils grâce à des innovations de collecte et de méthode statistique.

En pratique, nous sommes allés photographier de nombreux livres renseignant le nombre de décès par âge, sexe et cause pour l’ensemble de la ville de Paris sur près de 60 ans. Puis nous avons extrait cette information (bien souvent à la main) afin qu’elle soit utilisable par nos logiciels statistiques. Pour approfondir nos analyses, nous avons également collecté ces données par quartier – les 80 actuels – pour certaines maladies infectieuses, afin de mieux saisir la transformation des inégalités sociales et spatiales face à la mort durant cette période.

Cette collecte minutieuse de dizaines de milliers de données a permis de constituer une nouvelle base désormais librement accessible à la communauté scientifique. Elle offre la possibilité d’analyser de manière inédite les mécanismes à l’origine de l’amélioration spectaculaire de la longévité à Paris durant la première moitié du XXᵉ siècle, une période où la population de la capitale a fortement augmenté pour atteindre près de trois millions d’habitants, notamment en raison de l’arrivée massive de jeunes migrants venus des campagnes françaises lors de l’exode rural.

Un gain important dû au recul des maladies infectieuses

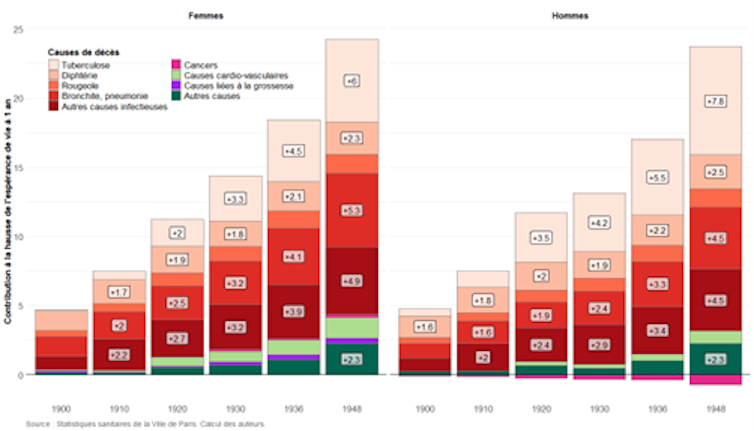

Entre 1890 et 1950, l’espérance de vie à 1 an a bondi de près de vingt-cinq ans à Paris. À quoi un tel progrès est-il dû ? Si l’on décompose cette formidable hausse par grandes causes de décès, pour les hommes comme pour les femmes, on constate que les maladies infectieuses dominaient largement la mortalité parisienne à la Belle Époque. C’était en particulier le cas de la tuberculose, la diphtérie, la rougeole, la bronchite et la pneumonie. Nous avons également isolé les cancers, les maladies cardio-vasculaires et, pour les femmes, les causes liées à la grossesse.

Le résultat est sans appel : la disparition progressive des maladies infectieuses explique à elle seule près de 80 % des gains de longévité observés dans la capitale. Sur les 25 années d’espérance de vie gagnées, 20 sont dues au recul de ces infections.

La lutte contre la tuberculose, maladie infectieuse provoquée par la bactérie Mycobacterium tuberculosis, a été le principal moteur de ce progrès. Longtemps première cause de décès à Paris, le déclin rapide de cette maladie après la Première Guerre mondiale représente près de huit ans d’espérance de vie gagnés pour les hommes et six ans pour les femmes. Les infections respiratoires (bronchites et pneumonies), très répandues à l’époque, ont quant à elles permis un gain supplémentaire de cinq ans. Des avancées sur plusieurs fronts (transformations économiques et sociales, progrès en santé publique, efforts collectifs de lutte contre la tuberculose et améliorations nutritionnelles) ont pu contribuer à la baisse de la mortalité liée à ces maladies.

La diphtérie, particulièrement meurtrière chez les enfants au XIXᵉ siècle, a également reculé spectaculairement durant les années 1890, ce qui a permis un gain d’espérance de vie d’environ deux ans et six mois. La baisse de la mortalité due à cette cause aurait été impulsée par l’introduction réussie du sérum antidiphtérique – l’un des premiers traitements efficaces contre les maladies infectieuses.

En revanche, les maladies cardio-vasculaires et les cancers n’ont joué qu’un rôle mineur avant 1950. Leurs effets apparaissent plus tardivement, et s’opposent même parfois à la progression générale : les cancers, notamment chez les hommes, ont légèrement freiné la hausse de l’espérance de vie. Quant aux causes liées à la grossesse, leur impact est resté limité.

Cette formidable hausse de l’espérance de vie s’est poursuivie au-delà de notre période d’étude, mais à un rythme moins soutenu. L’augmentation a été d’un peu moins de vingt ans entre 1950 et 2019.

Au début du XXᵉ siècle, de féroces inégalités sociales face à la mort

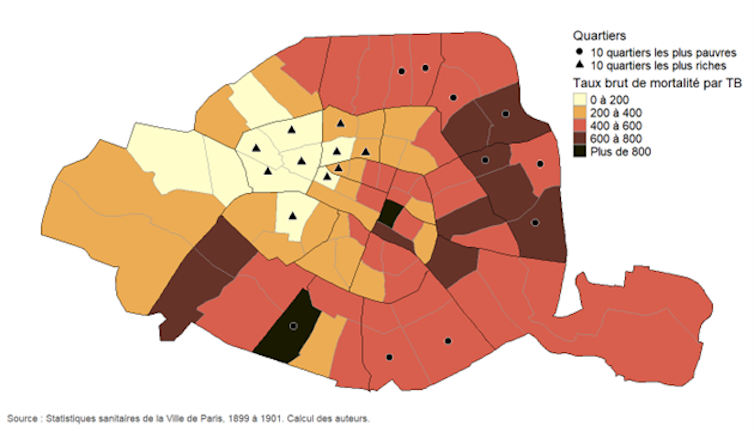

Nous l’avons vu, la lutte contre la tuberculose a été l’un des principaux moteurs des progrès spectaculaires de l’espérance de vie à Paris entre 1890 et 1950. Grâce aux séries des statistiques de décès par cause que nous avons reconstituées pour les 80 quartiers de la capitale, nous avons cherché à mieux comprendre les ressorts de cette maladie en dressant une véritable géographie sociale.

Pour chaque quartier, nous avons calculé un taux de mortalité « brut »

– c’est-à-dire le rapport entre le nombre de décès dus à la tuberculose et la population totale du quartier, pour 100 000 habitants. Nous avons ainsi pu produire une carte afin de visualiser cette mortalité spécifique, aux alentours de l’année 1900.

On constate que les écarts de mortalité étaient considérables au sein de la capitale en 1900. Les valeurs les plus élevées, souvent supérieures à 400 décès pour 100 000 habitants, se concentraient dans l’est et le sud de Paris. Les trois quartiers où les valeurs étaient les plus élevées sont Saint-Merri (près de 900), Plaisance (850) et Belleville (un peu moins de 800). À l’inverse, les quartiers de l’Ouest parisien affichaient des taux bien plus faibles, et des valeurs minimales proches de 100 dans les quartiers des Champs-Élysées, de l’Europe et de la Chaussée-d’Antin.

Ces différences spatiales reflètent directement les inégalités sociales de l’époque. En nous fondant sur les statistiques de loyers du début du XXᵉ siècle, nous avons estimé quels étaient les dix quartiers les plus riches (matérialisés sur la figure par des triangles noirs) ainsi que les dix plus pauvres (cercles noirs). On constate que la nette fracture sociale entre le Paris aisé du centre-ouest et le Paris populaire des marges orientales se superpose clairement à la carte de la mortalité par tuberculose.

Une situation qui s’équilibre seulement après la Seconde Guerre mondiale

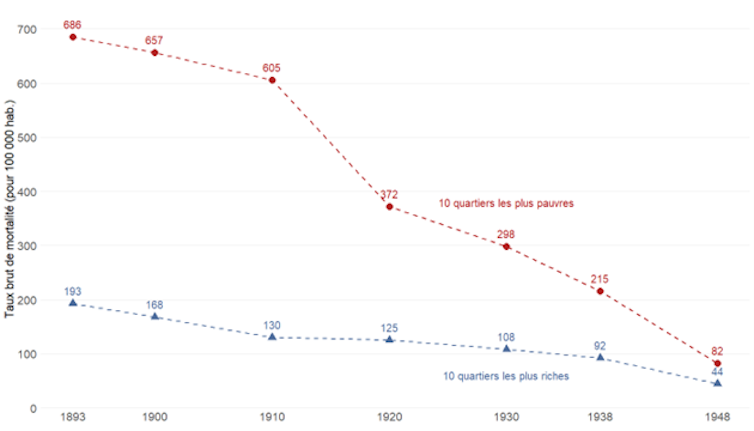

Si l’on se penche sur l’évolution de ces écarts entre la fin du XIXᵉ siècle et 1950, on constate que les quartiers les plus pauvres affichaient à la fin du XIXᵉ siècle des taux de mortalité par tuberculose supérieurs à 600, trois fois et demie supérieurs à ceux des quartiers les plus riches.

L’écart s’est encore creusé jusqu’à la veille de la Première Guerre mondiale, sous l’effet d’une baisse de la mortalité plus forte dans les quartiers riches que dans les quartiers pauvres. Ainsi en 1910, les taux de mortalité par tuberculose étaient encore quatre fois et demie plus élevés dans les quartiers populaires que dans les quartiers riches.

Durant l’entre-deux-guerres, les écarts se sont resserrés. L’éradication progressive des maladies infectieuses a permis les progrès considérables d’espérance de vie observés de la Belle Époque à la fin de la Seconde Guerre mondiale. La mortalité a chuté très rapidement dans les quartiers les plus défavorisés. À la fin des années 1930, elle n’y était plus que deux fois supérieure à celle des quartiers riches.

Après la Seconde Guerre mondiale, les taux sont enfin passés sous les 100 décès pour 100 000 habitants dans les quartiers pauvres. Un seuil que le quartier des Champs-Élysées avait déjà atteint cinquante ans plus tôt…

Quelles leçons pour l’histoire ?

Le rythme de cette transformation – dont la lutte contre la tuberculose a été l’un des moteurs – fut exceptionnel. Ce sont près de six mois d’espérance de vie qui ont été gagnés chaque année sur la période allant des débuts de la Belle Époque à la fin de la Seconde Guerre mondiale. Les déterminants de cette forte baisse de la mortalité sont encore débattus, toutefois on peut les regrouper en trois catégories.

La première concerne les investissements dans les infrastructures sanitaires. La connexion progressive des logements aux réseaux d’assainissement aurait contribué à la réduction de la mortalité causée par les maladies infectieuses transmises par l’eau.

Par ailleurs, la mise en place au tournant du XXᵉ siècle du « casier sanitaire » aurait contribué à la baisse de la mortalité des maladies infectieuses transmises par l’air – notamment la tuberculose –, en permettant l’enregistrement des informations liées à la salubrité des logements : présence d’égouts, d’alimentation en eau, recensement du nombre de pièces sur courette, du nombre de cabinets d’aisances communs ou privatifs, du nombre d’habitants et de logements par étage, liste des interventions effectuées sur la maison (désinfections, rapport de la commission des logements insalubres, maladies contagieuses enregistrées), compte-rendu d’enquête sanitaire (relevant la nature du sol, le système de vidange, l’état des chutes, les ventilations), etc.

La seconde catégorie de déterminants qui ont pu faire augmenter l’espérance de vie tient aux innovations médicales : le vaccin BCG contre la tuberculose (mis au point en 1921) ou le vaccin antidiphtérique (mis au point en 1923) ont, entre autres, modifié le paysage sanitaire.

Enfin, la troisième et dernière catégorie relève des transformations économiques et sociales. La première moitié du XXᵉ siècle a connu une croissance économique soutenue, une amélioration des conditions de vie et une diminution marquée des inégalités de revenus.

L’amélioration du réseau de transport a par ailleurs facilité l’approvisionnement alimentaire depuis les campagnes, contribuant à une meilleure nutrition. Notre étude semble montrer, enfin, que les antibiotiques, découverts plus tardivement, n’ont joué qu’un rôle marginal avant 1950.

Comprendre les dynamiques sanitaires contemporaines

Nos recherches sur le sujet ne sont pas terminées. Nous continuons à accumuler de nouvelles données pour analyser l’évolution de l’espérance de vie et de la mortalité par cause dans chacun des 20 arrondissements et des 80 quartiers de la capitale afin d’analyser plus en détail cette période de cent cinquante ans. Nous pourrons ainsi progressivement lever le voile sur l’ensemble des raisons qui font de Paris cette championne de la longévité que l’on connaît aujourd’hui.

Ces recherches, bien que centrées sur des phénomènes historiques, conservent une importance majeure pour l’analyse des dynamiques sanitaires contemporaines. Elles documentent la manière dont les maladies chroniques ont progressivement commencé à façonner l’évolution de l’espérance de vie, rôle qui structure aujourd’hui les transformations de la longévité.

Elles démontrent également que les disparités de mortalité selon les conditions socio-économiques, désormais bien établies dans la littérature actuelle, étaient déjà présentes dans le Paris de la fin du XIXᵉ siècle.

Surtout, nos analyses examinent un cas concret montrant que, malgré l’ampleur initiale des inégalités socio-économiques de mortalité, celles-ci se sont fortement réduites lorsque les groupes les plus défavorisés ont pu bénéficier d’un accès élargi aux améliorations sanitaires, sociales et environnementales.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

11.12.2025 à 15:56

Entretenir le mythe du Père Noël, une affaire de milieu social ?

Géraldine Bois, Maitresse de conférences en sociologie, Université de Lorraine

Charlotte Moquet, Post-doctorante au CRESPPA-CSU, Ingénieure de recherche au CNRS - Docteure en sociologie de l'Université de Poitiers, Université de Poitiers

Texte intégral (2199 mots)

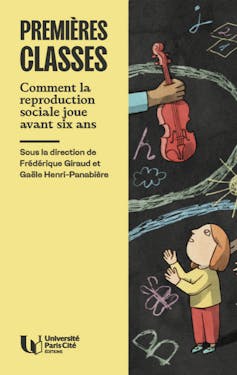

Dès la grande section de maternelle, des inégalités s’immiscent au sein du quotidien des enfants. Publié sous la direction des chercheuses Frédérique Giraud et Gaële Henri-Panabière, l’ouvrage Premières classes. Comment la reproduction sociale joue avant six ans met en lumière les mécanismes précoces qui sous-tendent leur transmission d’une génération à l’autre, à partir d’une enquête de terrain menée à la fois en famille et en classe.

Dans le premier chapitre, les sociologues Géraldine Bois et Charlotte Moquet s’arrêtent sur les conceptions de l’enfance qui animent les parents. Comment celles-ci orientent-elles leurs pratiques éducatives ? Dans l’extrait ci-dessous, elles nous montrent comment leur attitude vis-à-vis des croyances enfantines, comme le Père Noël et la petite souris, varient selon les milieux sociaux.

On se représente souvent l’enfance comme l’âge de l’innocence, un âge où les enfants doivent pouvoir rêver et s’émerveiller à l’abri des soucis des adultes. De fait, tous les parents que nous avons rencontrés adhèrent à cette conception de l’enfance, à des degrés divers. Ils s’efforcent de tenir leur enfant à distance de certaines de leurs discussions (soucis professionnels, conflits familiaux, etc.) et regrettent de ne pas toujours y parvenir : « On essaye de pas le faire, mais bon quelquefois ça arrive […]. On oublie qu’il y a les petites oreilles des enfants à côté. » (Mme Moreau, pharmacienne en couple avec un ingénieur, classes supérieures)

Ils tentent tout particulièrement de le protéger des événements violents de l’actualité (attentats, guerres, etc.), en contrôlant son accès à ces informations et en évitant d’en parler devant lui. « Je me dis qu’elle a bien le temps de voir l’horreur de la société dans laquelle on vit », « Ils sont encore jeunes, ils ont encore le temps de voir beaucoup de misère », déclarent par exemple les parents interrogés.

Cette tendance à la préservation du monde de l’enfance est cependant plus ou moins marquée selon leurs appartenances sociales : certains parents, plus souvent de classes populaires, s’efforcent de maintenir leur enfant dans ce monde, quand d’autres, plus souvent de classes moyennes et supérieures, l’encouragent plutôt à le questionner.

Sur ce point, les attitudes parentales vis-à-vis des croyances enfantines que sont le Père Noël et la petite souris sont révélatrices. Certains parents entretiennent ces croyances afin de sauvegarder une « magie », un « imaginaire » et une « innocence » qu’ils estiment propres à l’enfance. Mme Chanteau (assistante sociale, classes moyennes), qui « essaye de trouver des réponses qui [lui] semblent les moins farfelues » pour limiter les doutes de sa fille Annabelle, explique : « Je trouve qu’elle est petite et j’ai envie de la conforter encore dans cet imaginaire. » Dans ces familles, la prise de conscience de la réalité à propos de ces croyances est donc remise à plus tard, comme l’exprime le père de Bastien Perret (ouvrier en couple avec une infirmière, classes populaires) : « De toute façon, après, il le saura par l’école, parce que plus il va grandir [moins il y croira]. »

Les récits des pratiques familiales témoignent de stratégies pour retarder le plus possible leur disparition. Ainsi, les parents de Bastien ont demandé à ses cousins plus âgés de ne pas lui révéler la vérité sur l’existence du Père Noël. D’autres parents échafaudent de véritables mises en scène qu’ils racontent avec beaucoup d’enthousiasme : faire disparaître dans la nuit des gâteaux destinés au Père Noël, créer une diversion pour disposer à l’insu des enfants les cadeaux sous le sapin, faire croire que le Père Noël passe en diffusant le son de son traîneau, etc.

Si ces attitudes de préservation des croyances enfantines se rencontrent dans des familles de milieux sociaux variés, elles sont nettement plus présentes dans les classes populaires et concernent la quasi-totalité des familles de ce milieu social. En outre, les quelques familles de classes moyennes et supérieures également concernées se caractérisent souvent par des origines populaires du côté des parents. Cette particularité permet de souligner que, si la façon dont les parents pensent l’enfance et agissent à l’égard de leur enfant a des effets sur son éducation, ces représentations et pratiques des parents sont elles-mêmes le fruit d’une socialisation antérieure, notamment familiale. Autrement dit, les représentations et pratiques des parents sont les produits de ce qu’ils ont appris dans leur propre environnement familial.

D’autres parents, au contraire, ne tiennent pas spécialement à ce que leur enfant continue de croire au Père Noël ou la petite souris. On rencontre cette distance vis-à-vis des croyances enfantines uniquement dans les familles de classes moyennes et supérieures, et dans la très grande majorité des familles de ces milieux sociaux. S’avouant parfois mal à l’aise avec « les mensonges » qu’implique l’entretien de ces croyances, les parents adoptent ici une attitude qui consiste à laisser leur enfant croire si celui-ci en a envie, sans l’y encourager pour autant. Sans dire explicitement la vérité à leur enfant, ces parents se montrent intéressés par les doutes qu’il exprime et voient positivement le fait qu’il ne soit pas totalement dupe ou naïf. En effet, dans ces familles, les croyances enfantines sont avant tout traitées comme un terrain d’exercice du raisonnement logique.

Comme l’explique Mme Tardieu (responsable de communication dans une grande entreprise en couple avec un ingénieur d’affaires, classes supérieures), « on est sur des sujets où justement on veut que [nos enfants] réfléchissent un petit peu ». Les parents évitent donc d’apporter à leur enfant des réponses définitives. Ils encouragent plutôt ses questionnements en lui demandant ce qu’il en pense ou ce qu’il souhaite lui-même croire : « Je lui dis : “Mais qu’est-ce que tu as envie de croire ? Est-ce que tu as envie de croire que le [Père Noël] existe ?” Et dans ces cas-là, elle réfléchit. […] On lui dit : “C’est comme tu veux. Il y en a qui croient, il y en a qui ne croient pas. C’est comme croire en Dieu. Il y en a qui croient, il y en a qui ne croient pas. Après si tu as des questions on répond, mais on ne va pas te faire ton idée.” […] On reste un peu évasifs. » (mère de Lisa Chapuis, au foyer, en couple avec un architecte, classes moyennes)

À lire aussi : Pourquoi les enfants croient-ils (ou pas) au Père Noël ?

Les enfants de classes moyennes et supérieures sont ici familiarisés à des manières de raisonner (questionner, réfléchir par soi-même) qui sont de nos jours particulièrement valorisées à l’École et peuvent de ce fait contribuer à leur procurer certains bénéfices scolaires. L’extrait d’entretien précédent montre bien que les rapports parentaux aux croyances enfantines peuvent s’inscrire dans une tendance plus générale à l’encouragement de l’esprit critique sur différents sujets.

De la même manière, les plaisanteries sur le Père Noël sont l’un des biais par lesquels les mères de Rebecca Santoli (l’une est professeure de français ; l’autre est en situation de reconversion professionnelle et exerce des petits boulots en intérim) habituent leur fille à un regard critique sur les stratégies commerciales et les inégalités de genre : « Moi je lui ai dit que le Père Noël il a le beau rôle et que c’était la Mère Noël qui faisait tout le taf [rires]. Et puis qu’il est habillé en Coca-Cola là… »

Ces mères font partie des rares parents de l’enquête – appartenant essentiellement aux fractions cultivées des classes moyennes et supérieures – à tenir régulièrement des discussions politiques entre adultes devant leur enfant. Elles amènent aussi Rebecca à des réunions militantes mêlant adultes et enfants. À propos de ce qui pourrait inquiéter leur fille, elles ont par ailleurs une attitude ambivalente qui manifeste leur tendance à vouloir solliciter son questionnement. Concernant les événements de l’actualité, elles disent avoir le souci de « l’épargner » mais aussi l’« envie de répondre à ses questions ». Elles doutent également de la pertinence de sa prise de conscience des difficultés financières de l’une d’entre elles, partagées entre le sentiment qu’elle est « un peu jeune » pour « se faire du souci » à ce sujet et la volonté de la « confronter à la réalité ».

À lire aussi : Ce que les enfants pensent vraiment du père Noël

À côté de certains parents de classes moyennes ou supérieures comme ceux de Rebecca, qui ont les moyens de décider ce à quoi ils exposent leur enfant, les parents les plus précarisés des classes populaires habituent eux aussi, mais par la force des choses, leur enfant à certaines réalités. Si Ashan accompagne sa mère, Mme Kumari (sans emploi, antérieurement infirmière au Sri Lanka) qui l’élève seule, aux réunions du comité de soutien des familles sans logement, c’est ainsi par nécessité (faute de moyen de garde aux horaires de ces réunions et parce que la famille est contrainte de vivre dans un foyer de sans-abri), contrairement aux mères de Rebecca lorsqu’elles vont avec leur fille à des réunions militantes.

D’ailleurs, Ashan tend à jouer à l’écart durant ces réunions sans visiblement écouter ce que disent les adultes, quand Rebecca est encouragée à y participer, à y prendre la parole. Contrairement à Rebecca, Ashan retire donc vraisemblablement peu de bénéfices scolaires de sa présence à ces réunions. Plus généralement, Ashan, mais aussi Libertad Anaradu (dont le père enchaîne des contrats précaires en tant qu’employé municipal et la mère est sans emploi), Balkis Bouzid (dont les parents sont sans activité professionnelle) et Flavia Kombate (dont la mère, qui l’élève seule, est auxiliaire de vie à mi-temps) sont, de fait, confrontés aux problèmes de leurs parents, ceux-ci n’ayant pas la possibilité de leur épargner certaines expériences (manque d’argent, expulsions, absence de logement stable, etc.). Ils n’ont pas non plus toujours les moyens d’entretenir les croyances de leur enfant. Par exemple, Mme Kombate dit à Flavia que le Père Noël n’existe pas et, l’année de l’enquête, elle lui explique qu’elle ne lui achètera pas de cadeaux à Noël puisqu’elle lui en a déjà offerts plus tôt dans l’année.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview