15.12.2025 à 16:26

Incertitudes politiques et débats bioéthiques : les enjeux à venir en 2026

Katia Andreetti, Anthropologue Ph.D en science politique / Chercheure associée CERSA - Paris II, Université Paris-Panthéon-Assas

Texte intégral (1867 mots)

Dans un paysage politique recomposé, le Comité consultatif national d’éthique (CCNE) prépare le lancement des États généraux de la bioéthique 2026, avec un calendrier avancé pour précéder le « temps politicien » et un maillage territorial renforcé, notamment pour intégrer davantage les outre-mer. Un moment particulier où vont s’entrelacer enjeux scientifiques, attentes citoyennes et recomposition des équilibres démocratiques.

Dans un contexte institutionnel instable, les futurs États généraux de la bioéthique de 2026 se préparent en coulisses, comme le prévoit l’article 41 de la loi relative à la bioéthique de 2021.

Lors d’un entretien que nous a accordé en juillet 2025, le professeur Jean-François Delfraissy, président du Comité consultatif national d’éthique (CCNE), nous précisait les grandes orientations retenues par les membres du CCNE pour les futurs États généraux : numérique et santé, santé et environnement, examens génétiques et médecine génomique, dons et transplantations, neurosciences, cellules souches et organoïdes, procréation et embryologie, sobriété en médecine, prévention santé dans les outre-mer.

Jean-François Delfraissy a exprimé

« [sa] volonté de structurer davantage les discussions autour des domaines où l’innovation technologique avance le plus vite, notamment en sciences fondamentales ».

Cette analyse s’appuie également sur nos travaux de recherche consacrés à la bioéthique et aux politiques publiques de santé.

Précéder « le temps politicien, avant 2027 »

En vertu de la loi de bioéthique de 2021, cette consultation citoyenne doit précéder la prochaine loi de bioéthique ou survenir dans un délai de cinq ans à compter de la précédente promulgation. Ainsi, entre la rapidité des innovations et les délais des calendriers politiques et juridiques, les dissonances temporelles sont intrinsèques au temps de la bioéthique. Or, celui-ci exige un autre rythme : celui de l’analyse et de la concertation.

L’Office parlementaire d’évaluation des choix scientifiques et technologiques (OPECST), qui réunit les deux chambres du Parlement, a déjà engagé des échanges préparatoires pour faire un premier bilan de la loi de bioéthique de 2021, en amont de l’ouverture officielle des États généraux. Jean-François Delfraissy et Philippe Berta, auditionné en qualité d’ancien rapporteur de la loi bioéthique 2021, nous l’ont confirmé.

Alors qu’une majorité parlementaire absolue prévalait à cette époque, la dissolution de l’Assemblée nationale en 2024 a entraîné une profonde recomposition de l’échiquier politique. À l’aube des élections municipales de 2026, des présidentielles de 2027 et des législatives anticipées qui devraient s’ensuivre, l’avenir de la loi relative à la bioéthique s’annonce retardé à 2028.

Procréation, neurosciences, vieillissement démographique, volet santé-environnement…

Parmi les questions qui s’annoncent saillantes pour 2026, nous pouvons retenir : la procréation post mortem, les avancées rapides de la génomique et des cellules souches, la xénogreffe, les organoïdes, les neurosciences, mais aussi la santé reproductive ou encore le vieillissement démographique.

À lire aussi : Assistance médicale à la procréation (AMP ou PMA) : les incohérences de la loi actuelle

Ces enjeux, identifiés par le CCNE, interrogent la capacité de nos politiques de santé à concilier innovation scientifique, équité sanitaire et solidarité intergénérationnelle.

Nous avons abordé ces thématiques dans notre contribution à l’ouvrage collectif Idées reçues sur l’infertilité (2024), au chapitre « Les pouvoirs publics commencent à s’emparer du sujet ».

Concernant le volet santé-environnement, s’inscrire dans une perspective de One Health, c’est-à-dire de santé globale, suppose de redéfinir le prisme intellectuel et politique qui lui est propre afin de dépasser « l’anthropocentrisme de la bioéthique ». Cette réflexion prolonge les travaux fondateurs d’Aldo Leopold (Almanach d’un comté des sables, 1995) et de Van Rensselaer Potter (Global Bioethics, 1988), précurseur d’une éthique élargie au vivant.

Les crises sanitaires récentes, notamment les zoonoses (ces maladies infectieuses transmissibles à l’humain par l’animal et inversement, ndlr), rappellent que la santé humaine ne peut être pensée isolément de celle des autres espèces et des écosystèmes qui les relient.

La méthode du CCNE : Des consultations citoyennes, au cœur des territoires

Créé en 1983, le CCNE est une instance consultative indépendante chargée d’éclairer les enjeux éthiques issus des progrès biomédicaux et technologiques. Elle veille au respect des libertés, de la dignité humaine et de la protection des plus vulnérables.

Chef d’orchestre de ce moment de démocratie sanitaire et scientifique, le Comité consultatif a perfectionné sa méthode : calendrier anticipé, maillage territorial élargi, formation renforcée.

Grâce aux espaces de réflexion éthiques régionaux (Erer), « Nous avons préparé cela avec beaucoup plus de temps que ce qu’on avait fait qu’à l’époque », souligne Jean-François Delfraissy.

De janvier à avril 2026, environ 300 débats en région seront déployés sur l’ensemble du territoire, y compris dans les outre-mer, assure le président du CCNE :

« Je me suis déplacé à La Réunion et je vais me rendre aux Antilles, pour mener une série de grands débats. Pour la première fois, le CCNE compte parmi ses membres un représentant de l’outre-mer, réanimateur exerçant en Martinique ».

Jean-François Delfraissy le rappelle :

« Il n’y a qu’un tiers de médecins et de scientifiques ; les deux autres tiers sont des juristes, des philosophes et des représentants des citoyens. Nous faisons monter le niveau des membres avec une série de présentations d’experts issus de champs scientifiques. Nous avons commencé cette « formation » de nos membres, par exemple avec Alain Fischer sur les thérapies géniques ou sur les neurosciences ».

Près de 200 auditions seront menées par les membres de l’instance avec le concours inédit du Conseil économique, social et environnemental (CESE). « Nous allons faire un comité citoyen plus fort », affirme le président du CCNE.

Un premier rendu (Bilan des États généraux) sera disponible au début de l’été 2026, puis l’avis du CCNE sera publié à l’automne. Ce grand moment démocratique précède la révision de la loi qui n’aura lieu qu’en 2028 ou 2029, à condition que le futur gouvernement décide de l’inscrire à son agenda politique.

Science, société, politique : temporalités dissonantes

Les États généraux se sont imposés comme de véritables biorituels institutionnalisés. Très attendus par les citoyens, ils ont gagné en solidité, transparence et légitimité.

Suivie de près à l’international, « la bioéthique à la française » est un processus tripartite qui s’articule entre science, société et politique. Ce modèle fait figure d’exception : il exige du collectif, du temps, de la pédagogie et un certain degré de maturité démocratique. Ainsi, consolider la culture scientifique en santé des citoyens et des élus, renforce la démocratie dans son ensemble. Dès lors, les États généraux ne peuvent être réduits à une simple phase consultative. Ils incarnent un espace de recomposition du contrat social sanitaire.

Cette démarche s’inscrit dans la continuité d’une démocratie en santé qui, en France, s’affirme comme un espace d’intermédiation entre la société civile, les institutions et les acteurs de santé. Cette conception, développée par Didier Tabuteau, prolonge la reconnaissance du patient-citoyen dont le statut s’est mué, passant de celui de patient à celui d’acteur du débat public ».

L’innovation biomédicale ouvre de nouvelles perspectives thérapeutiques, sociétales et sociales. Toutefois, elle soulève aussi d’inédites réflexions éthiques, à l’heure où nos systèmes de santé peinent à en absorber les coûts, à résorber les inégalités, tandis que l’intelligence artificielle va plus vite que notre capacité collective à définir ses contours.

Une traduction législative incertaine

Si les États généraux se veulent inclusifs et ouverts, leur traduction législative reste incertaine.

le professeur Delfraissy avertit :

« La loi ne viendra pas avant 2028, mais la science avance très vite, on risque une dissociation. »

Ainsi, ce décalage entre les temporalités de l’innovation, du débat public, du temps institutionnel et juridique, démontre que les dissonances temporelles sont intrinsèques à la bioéthique, constituant également l’un des angles morts du processus bioéthique français.

Reste une incertitude : que deviendront ces délibérations dans la future arène parlementaire ? C’est là, sans doute, que se jouera l’équilibre entre science, citoyens et démocratie.

Le professeur Jean-François Delfraissy, président du Conseil consultatif national d’éthique, a relu et validé l’article.

Le professeur Jean-François Delfraissy fut membre du jury de thèse de Katia Andreetti et elle a interagi avec lui lorsqu’elle travaillait en tant que collaboratrice parlementaire. Cette fonction passée l’a conduite à travailler en lien avec l’OPECST.

15.12.2025 à 16:24

Rythmes scolaires : des pauses actives pour repenser les journées de classe et lutter contre la sédentarité

Sylvain Wagnon, Professeur des universités en sciences de l'éducation, Faculté d'éducation, Université de Montpellier

Rémi Richard, Maître de Conférences en sociologie du sport et du handicap, Université de Montpellier

Sihame Chkair, Docteure et chercheure en économie de la santé et en sciences de l'éducation, Université de Montpellier

Texte intégral (1750 mots)

Le rapport de la Convention citoyenne sur les temps de l’enfant publié en cette fin d’année 2025 rappelle que les rythmes scolaires actuels ne sont pas bien en phase avec les besoins des enfants. Proposer régulièrement à ces derniers des pauses actives ne serait-il pas un levier prometteur pour réinventer les journées de classe ?

Rendu public le 22 novembre 2025, le rapport de la Convention citoyenne sur les temps de l’enfant a rappelé que l’organisation de la journée scolaire française reste peu adaptée aux rythmes biologiques et cognitifs des élèves.

Il appelle à une réforme d’ampleur des rythmes scolaires, invitant à repenser non seulement les horaires, mais aussi la manière dont se répartissent attention, repos, mouvement et apprentissages. Dans cette perspective, proposer aux élèves des pauses actives (c’est-à-dire de courtes périodes d’exercices physiques, échauffements ou encore relaxation au fil de la journée) ne serait-il pas un levier particulièrement prometteur ?

Augmenter l’activité physique des enfants, une urgence de santé publique

En 2024 en France, seuls 33 % des filles et 51 % des garçons de 6 à 17 ans atteignent les recommandations de l’Organisation mondiale de la santé (OMS) : au moins 60 minutes d’activité physique quotidienne d’intensité modérée à soutenue. Parallèlement, entre la classe et les transports, les repas et les temps d’écran, ils restent de longues heures sédentaires.

Cette réalité interroge particulièrement l’école : comment maintenir l’attention d’élèves contraints à rester immobiles de longues heures ? Comment prévenir les troubles de l’attention, fatigue ou anxiété. Des questions d’autant plus urgentes du fait que le système scolaire français fait partie de ceux qui enregistrent le plus grand nombre d’heures de classe données aux enfants durant toute leur scolarité,

Une précision avant de poursuivre : attention à ne pas confondre sédentarité et manque d’activité physique.

La sédentarité correspond au temps passé, assis ou allongé éveillé, avec une dépense énergétique très faible. On peut donc être physiquement actif selon les recommandations de l’OMS (par exemple courir trois fois par semaine), tout en étant très sédentaire si l’on reste assis plus de huit heures par jour. À l’inverse, l’inactivité physique signifie ne pas atteindre les seuils d’activité physique recommandés (au moins 150 minutes hebdomadaires d’intensité modérée).

Ces deux dimensions interagissent mais ne se confondent pas, comme le rappelle le Guide des connaissances sur l’activité physique et la sédentarité publié par la Haute Autorité de Santé en 2022.

Relativement récente en santé publique, cette distinction ne s’est imposée qu’au cours des années 2000, lorsque les grandes enquêtes ont montré que les risques liés à la sédentarité (diabète, maladies cardiovasculaires, certains cancers) existaient indépendamment du manque d’activité physique.

Les pauses actives : bouger quelques minutes ensemble

La pause active désigne un court moment de 5 à 15 minutes de mobilisation physique, intégrée directement dans le temps d’apprentissage ou de travail. Elle se déroule en quatre phases : échauffement, exercice cardio ou moteur, activité de coordination ou d’équilibre, retour au calme par étirements ou respiration.

Elle ne nécessite ni salle dédiée ni matériel particulier. Son efficacité repose sur la régularité : plusieurs fois par jour, entre deux séquences de travail ou d’apprentissage. Si les formes peuvent varier selon les contextes et les âges, il convient de ne pas les confondre avec les temps de recréation, de motricité ou d’éducation physique.

Depuis, de nombreuses études ont confirmé que l’activité physique stimule la plasticité cérébrale et la mémoire. Des études en psychologie cognitive démontrent que quelques minutes de mouvement suffisent à relancer l’attention soutenue et la concentration. La santé publique établit que rompre la sédentarité réduit le stress et prévient les troubles musculosquelettiques.

À l’école : apprendre mieux en bougeant

Depuis une dizaine d’années, les études et les expériences menées au Québec dans la cadre du projet À mon école, on s’active soulignent l’importance de ce type d’activités. En France le ministère de l’éducation nationale français a fait le choix des activités physiques quotidiennes (APQ) pour que chaque élève du premier degré bénéficie d’au moins 30 minutes d’activité physique quotidienne à l’école primaire. Cette mesure lancée, à la rentrée 2022, par le gouvernement, n’est appliquée que par 42 % des écoles primaires, selon un rapport sénatorial de septembre 2024.

Ce dispositif contribue à limiter le manque d’activité physique, mais ne réduit pas nécessairement la sédentarité. Les recommandations françaises actualisées en 2016 distinguent clairement ces deux dimensions : les bénéfices d’une pratique régulière d’activité physique ne compensent pas toujours les effets délétères du temps passé assis. Pour être efficaces, les politiques éducatives doivent donc agir à la fois sur l’augmentation du volume d’activité et sur la réduction des périodes prolongées d’immobilité. La mission flash sur l’activité physique et sportive et la prévention de l’obésité en milieu scolaire d’avril 2025 a réaffirmé l’urgence d’une politique éducative généralisée.

Dans ce contexte, les pauses actives sont présentées comme un moyen complémentaire : elles doivent améliorer la concentration et la mémorisation, réduisent l’agitation pour faciliter la gestion des comportements et le climat scolaire.

Les pauses actives ne peuvent être des activités isolées du reste des apprentissages, elles sont partie prenante d’une éducation intégrale, qui prend en compte non seulement la tête (l’intellect), mais aussi le corps (mouvement, coordination) et le cœur (gestion des émotions). Une vision théorisée par le pédagogue libertaire Paul Robin au milieu du XIXe siècle et qui pourrait être reprise par l’école publique laïque.

Une révolution dans notre rapport au temps

Comme le précise le rapport de la convention citoyenne sur les temps de l’enfant de novembre 2025, les journées des élèves doivent être repensées dans leur globalité, en rééquilibrant sollicitations intellectuelles, besoins physiques et temps de repos.

Intégrer les pauses actives dans les routines quotidiennes ne relève pas d’un gadget, mais d’une transformation profonde de nos manières de travailler et d’apprendre. Elles réintroduisent le rythme, la respiration et le mouvement comme conditions de toute activité intellectuelle. Une question déjà bien étudiée à l’université ou dans le monde professionnel où les pauses actives se développent.

À lire aussi : Bouger pour mieux apprendre : Comment lutter contre la sédentarité à l’école

Avec les pauses destinées au silence, à la rêverie ou au repos, elles dessinent une véritable écologie du temps, plus respectueuse des besoins humains.

Ces pauses actives à l’école constituent une première étape. Aller plus loin impliquerait d’intégrer le mouvement au cœur même des apprentissages, par exemple grâce au mobilier actif ou encore à des démarches pédagogiques qui associent marche et apprentissage.

La lutte contre la sédentarité pourrait alors devenir l’occasion de repenser plus largement nos modalités éducatives, en valorisant une approche où l’attention, le corps et le savoir évoluent dans l’ensemble des espaces scolaires. Promouvoir ces pratiques, c’est faire le choix d’une société qui prévient plutôt qu’une société qui tente de réparer et qui cultive l’attention plutôt que de l’épuiser.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

15.12.2025 à 16:14

Et si la nature brillait plus que ce que nous voyons ? À la découverte de la vie fluo

Romain Garrouste, Chercheur à l’Institut de systématique, évolution, biodiversité (ISYEB), Muséum national d’histoire naturelle (MNHN)

Bernd Schöllhorn, Professor, Université Paris Cité

Serge Berthier, Professeur, Institut des Nanosciences de Paris, Sorbonne Université

Texte intégral (3128 mots)

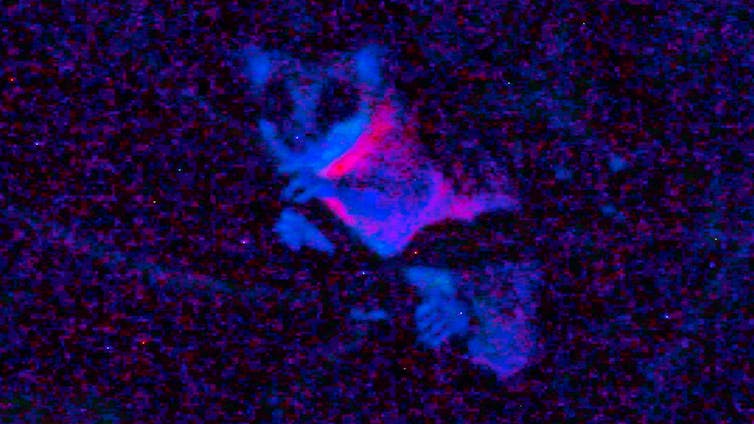

Le parcours nocturne Lumières de la nature, proposé par le Jardin des plantes de Paris jusqu’au 16 janvier 2026, a été inspiré d’études menées en Guyane. Derrière cette exposition, on trouve notamment trois chercheurs qui ont inspecté la forêt amazonienne, armés de lampes UV. Ils nous livrent ici les secrets de la fluorescence naturelle, le plus souvent invisible pour les humains mais omniprésente dans le vivant.

Dans la pénombre de la forêt guyanaise, en début de nuit, nos lampes UV éclairent une forme mouvante dans les arbres, mauve, presque rose et assez intense. C’est un mammifère marsupial, un Marmosa, qui nous révèle un phénomène physique longtemps passé inaperçu dans le vivant… Non loin de là, sur un tronc à hauteur d’homme, une grosse grenouille arboricole montre elle une intense couleur bleu-vert, alors que sa peau est brun-vert en lumière normale, presque mimétique des troncs où elle se déplace.

Ce phénomène physique s’appelle la fluorescence, un type de photoluminescence qui se manifeste dans la nature, au sein d’une étonnante diversité d’organismes : lichens, plantes, champignons, insectes, araignées, scorpions, reptiles, poissons, oiseaux et même… mammifères. Dans ce contexte on parle de la « fluorescence naturelle » qui implique l’absorption d’un rayonnement du spectre lumineux

– l’ultraviolet (UV), le visible ou l’infrarouge (IR) – suivie de l’émission spontanée (à l’échelle de la nanoseconde) d’une lumière moins énergétique, souvent visible, mais pas uniquement.

Longtemps considérée comme une curiosité, la fluorescence naturelle se révèle plus répandue et intrigante qu’on ne l’imaginait. Elle intéresse de plus en plus la recherche, notamment dans le cadre d’applications technologiques ou biomédicales (par exemple des nouveaux marqueurs cellulaires pour la recherche). Les chercheuses et chercheurs l’étudient davantage dans la nature, une nouvelle exploration du vivant étant permise par des instruments portatifs de mesures (photo-spectromètres) et d’émissions (torches LED UV). Notre équipe de recherche se spécialise depuis plusieurs années sur l’exploration des fluorescences du vivant. Nous revenons d’une mission scientifique en Guyane dans le but d’appréhender ce phénomène dans la forêt amazonienne, et plus spécialement dans les biotopes autour de la station de recherche des Nouragues

À lire aussi : Ces champignons qui brillent dans la nuit : la bioluminescence fongique décryptée

Un éclat discret mais omniprésent

La fluorescence naturelle, à ne pas confondre avec la bioluminescence, repose sur la capacité de certaines molécules, les fluorophores, à absorber un photon d’énergie élevée (par exemple dans l’UV) et à en réémettre un autre, d’énergie moindre (dans le visible ou l’IR). La vie, à toutes ses échelles, en est imprégnée. On trouve quelquefois le terme d’autofluorescence pour bien insister sur le fait qu’il ne s’agit pas de fluorescence de composés artificiels. C’est le cas également de nombreux minéraux, comme la fluorite (CaF2), qui a donné son nom au phénomène de fluorescence du fait de sa fluorescence spectaculaire aux UV.

La fluorescence des plantes est connue depuis longtemps, notamment à travers celle de la chlorophylle : lorsqu’elle absorbe la lumière, une partie de l’énergie non utilisée pour la photosynthèse est réémise sous forme de fluorescence rouge. Ce signal est si caractéristique qu’il sert à mesurer à distance la vitalité de la végétation, y compris depuis les satellites. Mais la chlorophylle n’est pas seule à briller. D’autres composés végétaux, comme les flavonoïdes, les anthocyanes ou les ptérines, peuvent émettre une fluorescence bleue ou verte lorsqu’ils sont excités par la lumière ultraviolette.

Plus largement, des études récentes ont révélé que la fluorescence existe dans presque tous les grands groupes du vivant.

À quoi sert la fluorescence ?

Chez certains animaux, elle pourrait jouer un rôle avant tout dans la protection contre les UV, mais aussi dans la communication visuelle telle que la reconnaissance entre congénères (comme chez l’araignée Cosmophasis umbratica, les perruches australiennes ou encore une grenouille arboricole), ou dans l’avertissement, et même le camouflage. Cela peut sembler contre-intuitif de se camoufler en étant « fluo » mais il ne faut pas oublier que d’autres organismes n’ont pas la même vision que les humains.

La fluorescence de certaines fleurs, à la lumière du jour souvent cachée aux yeux humains mais perceptible pour les insectes pollinisateurs, pourrait jouer un rôle attractif. Pour la plupart des autres organismes fluorescents, nous ignorons si cette propriété possède une fonction biologique ou s’il ne s’agit pas simplement d’un effet optique sans conséquence pour l’animal ou la plante. La frontière reste floue si l’on ne possède pas les clés pour déchiffrer les phénomènes. Encore faut-il les voir…

Chez les mammifères : quand les marsupiaux s’y mettent

La découverte a surpris la communauté scientifique : des mammifères fluorescents, vraiment ? Depuis 2020, plusieurs études ont montré que des marsupiaux – notamment les opossums américains (Didelphis spp.), mais aussi des espèces australiennes comme le planeur à sucre (Petaurus breviceps) ou phalanger, émettent une fluorescence rose ou bleutée sous lumière ultraviolette.

En Guyane, comme nous l’avons observé, des petits opossums sont également fluo, comme les Marmosa.

Des travaux récents ont élargi le constat : plus de 125 espèces de mammifères présentent un certain degré de fluorescence. Celle-ci se manifeste surtout sur les zones claires ou peu pigmentées : pelage blanc, moustaches, griffes, dents ou piquants. Sur le terrain, nous avons souvent observé des rats fluorescents dans la nature (Rattus spp.) que ce soit en Europe, en Asie ou en Guyane.

Chez les insectes, des signaux souvent cachés

Les insectes offrent une extraordinaire diversité de structures fluorescentes. Les ailes de certaines libellules et cigales contiennent de la résiline, une protéine élastique qui émet une lumière bleue sous UV. L’un des plus spectaculaires reste les nids de guêpes asiatiques (Polistes sp.), que nous avons observés au Vietnam qui battent des records de fluorescence induite par l’UV avec un rendement quantique (le rapport entre le nombre de photons émis et absorbés) exceptionnellement élevé jusqu’à 36 % (champion des matériaux biologiques terrestre à ce jour).

Les élytres des coléoptères, quant à eux, peuvent renfermer des pigments fluorescents enchâssés dans des micro ou nanostructures photoniques, capables d’amplifier, de restreindre ou de diriger la lumière émise. Chez le scarabée Hoplia coerulea, par exemple, ces structures créent une fluorescence directionnelle d’un bleu métallique saisissant. Quelques exemples ont été étudiés mais certainement beaucoup d’autres restent à découvrir.

En Amazonie, chez le Morpho sulkowskyi, un papillon iridescent et spectaculaire, la fluorescence fait aussi partie des signaux renvoyés par les ailes colorées.

Une lumière sur l’évolution… et sur la recherche

Cette redécouverte de la fluorescence naturelle dans autant de groupes vivants change notre regard sur la biodiversité et nous incite à mieux la comprendre. L’anthropomorphisme nous a conduits à croire que nous vivions dans un monde visible universel alors que c’est loin d’être le cas, par exemple, notre totale non-perception des UV qui pourtant imprègnent une grande partie du monde animal, des insectes aux poissons (la plupart des requins sont fluorescents !), et déterminent un grand nombre d’interactions écologiques, comme la pollinisation et les relations proie-prédateur, ou modifie notre perception du mimétisme (que voient réellement les prédateurs ?).

Pour comprendre ces phénomènes, la chimie et la physique doivent s’associer à la biologie qui peine seule à élucider les mécanismes, et qui peut les ignorer ou les minimiser.

Ne négligeons pas les applications potentielles (par fois bio-inspirées) qui peuvent découler de la meilleure connaissance et de la compréhension des systèmes naturels. La fluorescence est déjà au cœur de nombreuses applications scientifiques : microscopie de fluorescence, imagerie médicale, biologie cellulaire. Aujourd’hui, la GFP (protéine fluorescente verte), trouvée dans une méduse, est l’un des outils les plus largement utilisés en biologie moléculaire, et sa découverte a été récompensée par un prix Nobel en 2008. La découverte de nouvelles molécules fluorescentes performantes pourrait améliorer les outils de diagnostics médicaux et ouvrir la voie à des dispositifs photoniques inédits, capables d’améliorer l’efficacité des panneaux solaires, par exemple.

Le monde vivant n’est pas seulement coloré, il recèle aussi un « spectre caché » de lumières invisibles à l’œil humain. Pour le comprendre, il nous faut l’appréhender et revoir notre perception du monde, ainsi que de nombreuses certitudes. C’est ce qui fait la beauté de la science face à la merveilleuse complexité de la nature. Et si le monde était encore plus beau que ce que l’on croyait ?

Pour en savoir plus, vous pouvez visiter l’exposition « En voie d’illumination : les lumières de la nature » jusqu’au 18 janvier 2026 au Jardin des plantes (Paris), où vous verrez une reconstitution de la forêt tropicale d’Amérique du Sud, avec sa bioluminescence et sa fluorescence.

Romain Garrouste a reçu des financements de MNHN, CNRS, Sorbonne Université, National Geographic, MRAE, MTE, Labex BCDiv, Labex CEBA, WWF

Bernd SCHÖLLHORN a reçu des financements du CNRS (MITI et OVNI) et de l'Université Paris Cité (IDEX et laboratoire ITODYS)

Serge Berthier a reçu des financements de ANR, CNRS, Sorbonne Université.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview