04.12.2025 à 13:03

L’« effet Lazare », ou quand certains êtres vivants ressurgissent après des millions d’années

Violaine Nicolas Colin, Maitre de conférence en systématique et phylogéographie, Muséum national d’histoire naturelle (MNHN)

Texte intégral (2257 mots)

Nommé d’après la figure biblique revenue d’entre les morts, l’« effet Lazare » désigne un phénomène bien plus fréquent qu’on ne le pense : la réapparition de certains groupes d’organismes que l’on croyait éteints.

Tout le monde connaît Lazare, ce personnage du Nouveau Testament que Jésus aurait ramené à la vie. C’est de cette image symbolique qu’est né le terme d’« effet Lazare », utilisé aujourd’hui dans différents domaines de la biologie.

En paléontologie et en phylogénie (l’étude des relations évolutives entre les organismes), il désigne un phénomène fascinant : celui de groupes d’organismes – espèces, genres ou familles – qui semblent avoir disparu pendant des millions d’années si l’on se fie à l’ensemble des fossiles découverts à ce jour, avant de réapparaître comme par miracle.

Le concept a été introduit dans les années 1980 par les scientifiques états-uniens Karl Flessa et David Jablonski, puis affiné par la suite. Toutefois, les scientifiques ne sont pas toujours d’accord sur la manière de le définir : certains, comme Jablonski, y voient une simple absence temporaire dans les archives fossiles pendant un intervalle de temps donné, d’autres le réservent aux retours spectaculaires après les grandes crises d’extinction massive.

Pourquoi ces « résurrections » apparentes ?

L’effet Lazare demeure de fait étroitement lié à la qualité du registre fossile, c’est-à-dire à l’ensemble des fossiles découverts à ce jour, qui n’offre qu’une image partielle du passé de la vie. La fossilisation est un processus rare et sélectif : certains organismes se fossilisent mieux (par exemple, ceux dotés de coquilles ou d’os) et certains milieux (comme les fonds marins) favorisent la conservation des restes biologiques. De plus, les roches peuvent être détruites, transformées ou tout simplement jamais explorées. Résultat : de larges pans de l’histoire du vivant nous échappent encore.

L’absence d’un taxon (unité de genre, de famille ou d’espèce) dans le registre fossile pendant des millions d’années peut donc avoir deux explications :

une cause « stratigraphique », autrement dit un trou dans les archives. Le taxon a bien survécu, mais nous n’en avons conservé aucune trace ;

une cause « biologique » signifiant qu’il s’agit d’un véritable événement évolutif.

Plusieurs scénarios peuvent alors expliquer cette disparition apparente :

→ Le taxon a pu trouver refuge dans des zones isolées, de petite taille ou mal explorées. Après une longue période d’isolement dans ces refuges, le taxon a ensuite envahi de nouveau son territoire originel et est réapparu dans le registre fossile.

→ Il a pu subsister à très faible densité, en dessous du seuil nécessaire pour laisser des traces fossiles. En dessous de ce seuil, la population reste viable, mais nous n’avons tout simplement aucune trace de son existence. Malheureusement, ce seuil varie selon les environnements et les taxons, et il est quasiment impossible à quantifier.

La distinction entre les alternatives stratigraphique et biologique est souvent difficile. L’intensité des fouilles, la qualité de l’identification des fossiles et le niveau taxonomique (espèce, genre, famille…) jouent tous un rôle crucial dans l’interprétation de ces cas. Il faut aussi noter que l’interprétation de l’effet Lazare est une procédure asymétrique, car l’alternative biologique n’est privilégiée que lorsque l’alternative stratigraphique ne peut être documentée. Par conséquent, les techniques analytiques évaluant l’exhaustivité des archives fossiles sont essentielles pour comprendre la signification des taxons Lazare.

Quand la vie joue à cache-cache : quelques exemples

Une chose reste elle certaine, les exemples de taxons Lazare sont bien moins rares qu’on pourrait le penser.

Les lézards iguanidés, par exemple, étaient très répandus et diversifiés en Europe durant l’Éocène (de -56 millions à -33,9 millions d’années). On pensait qu’ils avaient totalement disparu du continent après la transition Éocène-Oligocène. Pourtant, la découverte, en 2012, de spécimens du genre Geiseltaliellus dans le sud de la France a montré qu’ils avaient survécu quelque temps en faible abondance avant de s’éteindre définitivement, probablement à la fin de l’Oligocène, il y a 23 millions d’années.

Autre cas remarquable : le gastéropode du genre Calyptraphorus. Longtemps considéré comme disparu à la fin de l’Éocène, il a refait surface au Pliocène (de -5,3 millions à -2,6 millions d’années) dans des gisements des Philippines (Asie du Sud-Est), prolongeant son existence fossile d’environ 30 millions d’années ! Cette longévité cachée suggère qu’il aurait survécu discrètement dans des zones refuges du Pacifique tropical.

La redécouverte d’espèces vivantes appartenant à des groupes que l’on pensait éteints constitue une expression rare et spectaculaire de l’effet Lazare. Parmi les exemples les plus emblématiques on peut par exemple citer, le cœlacanthe, véritable icône de l’effet Lazare. Ce poisson, que l’on croyait éteint depuis 66 millions d’années, a été redécouvert vivant en 1938 au large de l’Afrique du Sud (Afrique australe).

Un autre cas remarquable est celui de Laonastes, un petit rongeur découvert en 2005 au Laos, en Asie du Sud-Est, sur les étals d’un marché local de viande sauvage. Au départ, les chercheurs pensaient avoir affaire à une nouvelle famille de rongeurs, qu’ils ont appelée Laonastidæ.

Cette classification reposait sur des analyses génétiques basées sur un nombre limité de gènes et sur la comparaison de sa morphologie avec celle d’espèces actuelles. Mais un véritable bouleversement scientifique est survenu lorsque les scientifiques ont intégré des fossiles dans leurs analyses morphologiques. En comparant en détail le crâne, la mandibule, les dents et le squelette de Laonastes avec des rongeurs fossiles et actuels, ils ont découvert qu’il appartenait en réalité à la famille des Diatomyidæ, que l’on croyait éteinte depuis plus de 11 millions d’années.

Ces analyses ont également révélé que les plus proches parents actuels de cette famille sont les goundis Ctenodactylus gundi. Des études génétiques plus poussées sur les espèces actuelles ont ensuite confirmé ce lien de parenté entre Laonastes et les goundis, et révélé que ces deux lignées auraient divergé il y a environ 44 millions d’années. Laonastes représente donc un exemple frappant de taxon Lazare.

Pourquoi ces découvertes sont-elles si importantes ?

Les taxons Lazare sont ainsi bien plus que des curiosités de la nature. Ils offrent aux scientifiques des clés uniques pour comprendre l’évolution du vivant, la résilience des espèces face aux crises et surtout les limites du registre fossile.

En phylogénie, leur réapparition peut modifier notre compréhension des liens de parenté entre les espèces, des dates de divergence et d’extinction ou encore de la vitesse d’évolution morphologique.

En paléontologie, ils rappellent à quel point le registre fossile est biaisé et incomplet, et combien il faut être prudent avant de déclarer une espèce « disparue ».

Enfin, les taxons Lazare montrent que la vie ne disparaît pas toujours là où on le croit. Parfois, elle se retire simplement dans l’ombre pour ressurgir des millions d’années plus tard, comme un témoin silencieux de la longue histoire de l’évolution.

Parce que dans les usages de nomenclature biologique, seuls les noms de rangs générique et infra-générique (genre, espèce, sous-espèce) se composent en italique, tandis que les noms de familles et au-dessus (famille, sous-famille, ordre, etc.) se composent en romain. Ainsi, Laonastidæ a parfois été perçu comme un nom de genre par confusion et mis en italique à tort, alors que Diatomyidæ est un nom de famille correctement laissé en romain.

Violaine Nicolas Colin a reçu des financements de l'ANR.

03.12.2025 à 16:52

Mal-être au champ : pourquoi les agriculteurs sont-ils plus à risque de suicide ?

Virginie Le Bris Fontier, enseignante chercheuse en sociologie, Université Bretagne Sud (UBS)

Texte intégral (2266 mots)

Les agriculteurs, en particulier les hommes de moins de 64 ans, sont beaucoup plus à risque de suicide que la population générale. Comment expliquer ce phénomène ? Les raisons sont multiples : aucune, à elle seule, n’explique tout. Les pressions économiques jouent un rôle, tout comme le manque d’accès aux soins de santé mentale et une certaine construction du métier au masculin, qui rend encore plus compliqué le fait d’appeler à l’aide.

Derrière les images bucoliques, la réalité du monde agricole reste souvent rude, et parfois tragique. En France, un agriculteur se suicide tous les deux jours. En 2016, 529 exploitants affiliés à la Mutualité sociale agricole (MSA, le régime de protection sociale des agriculteurs) ont mis fin à leurs jours, un chiffre que les spécialistes considèrent comme sous-évalué.

Pourquoi ces hommes et ces femmes, qui nourrissent la société, sont-ils et elles si vulnérables face au risque de suicide ? Les difficultés économiques jouent un rôle, mais n’expliquent pas, à elles seules, un phénomène aussi massif et durable dans le temps : en 2015, la MSA dénombrait 604 suicides parmi ses bénéficiaires, tandis Santé publique France dénombrait près de 300 suicides entre 2010 et 2011.

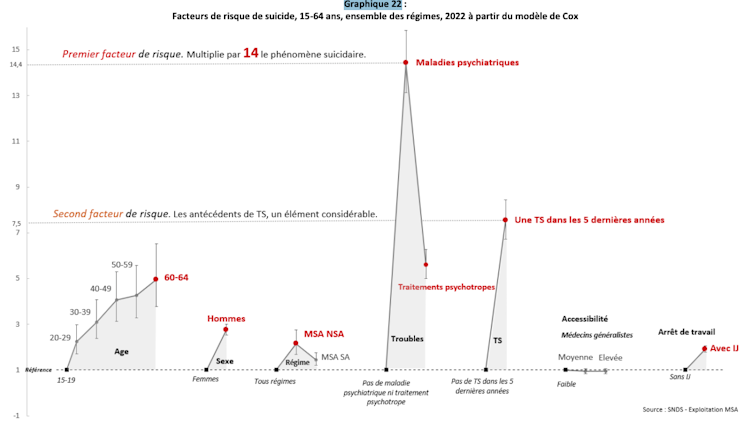

Dans tous les cas, les agriculteurs âgés de 15 ans à 64 ans ont environ 46 % plus de risques de se suicider que les autres catégories socioprofessionnelles, selon le rapport 2025 de la MSA. Le suicide agricole révèle donc des mécanismes sociaux profonds.

Le suicide agricole, un fait social

Depuis Émile Durkheim (1897), le suicide est compris comme un fait social. Il ne dépend pas seulement de la psychologie individuelle, mais aussi de l’intégration et de la cohésion sociale.

Autrefois concentrés dans les villes, les suicides touchent désormais le monde rural, fragilisé par les transformations du travail agricole, la solitude et l’insuffisance des formes actuelles de solidarités.

Le rapport 2026 de la MSA montre que ce sont les non-salariés agricoles (par exemple, les chefs d’exploitation) qui présentent le surrisque de suicide le plus élevé. Ce surrisque, d’environ 56,7 %, est supérieur à la fois à celui des salariés agricoles (40 %) et à celui de la population générale.

Il touche plus particulièrement les hommes entre 45 ans et 54 ans et les plus de 65 ans, avec des disparités régionales marquées. Les taux de suicide supérieurs à la moyenne nationale se concentrent particulièrement dans les territoires ruraux et semi-ruraux de la France. La MSA identifie plusieurs territoires particulièrement à risque, dont la Bretagne et plus largement l’Armorique, la Dordogne et le Lot-et-Garonne, le Poitou, la Mayenne, l’Orne et la Sarthe, le Limousin, ainsi que les Charentes.

Les facteurs de risque incluent l’âge, le sexe (les hommes étant près de trois fois plus exposés que les femmes), les maladies psychiatriques et un antécédent de tentative de suicide dans les cinq années précédant le passage à l’acte.

Le suicide agricole est donc un symptôme de souffrance d’origine sociale. Le suicide agricole doit être compris non seulement comme une souffrance individuelle, mais aussi comme un phénomène façonné par des facteurs collectifs et structurels. Les régularités observées dans l’exposition au surrisque (âge, sexe, lieu de résidence, secteur d’activité, etc.) montrent qu’il s’agit d’un fait social, dont les causes sont avant tout sociales et contextuelles.

Elle ne peut être soulagée uniquement par une aide psychologique. L’analyse des parcours de soins montre qu’un profil majoritaire, qui représente plus des trois quarts des suicides, correspond à des personnes ayant peu recours aux soins dans l’année précédant leur décès. Si les territoires ruraux apparaissent davantage exposés selon la grille de densité de l’Insee, les statistiques révèlent ici qu’il n’existe aucun lien direct entre l’accessibilité aux soins primaires et le suicide.

Ainsi, le surrisque observé dans les zones rurales ne semble pas lié à la densité ou à l’accès aux soins, mais renvoie plutôt à d’autres déterminants sociaux. Agir sur les conditions qui produisent la souffrance est indispensable.

À lire aussi : Pourquoi tant de suicides chez les agriculteurs ?

Une conjonction de causes qui augmente le risque suicidaire

Réduire le suicide des agriculteurs à la crise économique serait une erreur. Crises du lait, de la vache folle ou hausse des coûts peuvent déclencher des passages à l’acte, mais ne constituent pas des causes uniques. Le sociologue Nicolas Deffontaines a montré que chaque situation combine des facteurs économiques, sociaux, symboliques et biographiques.

Chaque parcours est singulier. Certains vivent l’effondrement économique comme une perte d’identité. D’autres subissent la pression familiale ou le regard du voisinage. Les transformations du métier, la dépendance aux marchés mondiaux, la bureaucratisation et la précarisation bouleversent profondément les équilibres de vie. Le suicide agricole n’est pas conjoncturel : c’est un phénomène structurel, révélateur d’un système en mutation et d’une identité professionnelle en souffrance.

Entre 2018 et 2021, la Bretagne a expérimenté un dispositif de reconversion pour les agriculteurs en difficulté. Les témoignages des reconvertis mettent en lumière que perdre son activité, c’est perdre une expertise, un rôle social et un sens à sa vie quotidienne. La reconversion implique une recomposition identitaire difficile, comparable à un deuil : deuil d’une histoire, d’un statut, d’une vocation, parfois même d’un projet de vie. C’est une question que j’explore dans un article à paraître en décembre 2025 dans la revue Paysans et Société, 2025/6, n° 414.

À lire aussi : Ce que la crise agricole révèle des contradictions entre objectifs socio-écologiques et compétitivité

Un métier encore souvent construit au masculin

Le monde agricole reste profondément marqué par une construction genrée du métier. L’homme producteur, fort et silencieux, symbolise le « bon agriculteur ». Courage physique, endurance et dévouement total à l’exploitation définissent ce modèle.

Il relève de la masculinité hégémonique au sens de Raewyn Connell, qui valorise force, maîtrise de soi et distance face à la souffrance. La division sexuée du travail et la transmission patrimoniale renforcent cette identité masculine.

Ces représentations influencent directement la santé mentale des agriculteurs : demander de l’aide, se reposer ou reconnaître sa détresse peuvent être perçus comme une faiblesse ou une atteinte à l’honneur professionnel. La valorisation de l’autonomie, héritée de l’indépendance paysanne, peut ainsi conduire à un déni de vulnérabilité. Les normes de genre produisent une exposition différenciée à la souffrance et au risque suicidaire. Comprendre cette dimension genrée est essentiel pour toute politique de prévention.

Le suicide agricole est donc multifactoriel et ne se comprend qu’en articulant les dimensions économiques, sociales, culturelles et genrées du métier. Il révèle moins des fragilités individuelles que les tensions d’un système professionnel et symbolique en crise.

À lire aussi : Crise agricole : quels défis pour demain ?

Comment prévenir le mal-être agricole ?

Les politiques de prévention actuelles reposent sur plusieurs axes :

la sensibilisation et la formation des agriculteurs et des professionnels pour détecter la détresse ;

l’accès à l’aide psychologique, via des lignes d’écoute (Agri’écoute, numéro de téléphone unique à disposition es assurés MSA en grande détresse, joignable 24 heures sur 24, sept jours sur sept), des consultations et des accompagnements spécifiques ;

la prévention collective, avec réseaux d’entraide, groupes de parole et soutien local pour réduire l’isolement.

Le programme de Prévention du mal-être agricole (PMEA) de la MSA vise à structurer et coordonner ces actions. Il intervient dès les premiers signes de difficulté et mobilise acteurs agricoles, partenaires institutionnels et professionnels de santé.

Les « sentinelles », bénévoles ou professionnels de proximité issus du monde rural, jouent un rôle crucial dans le dispositif. Ce sont eux qui repèrent les signes de détresse, écoutent et orientent les agriculteurs vers les bonnes structures. Leur proximité avec le terrain permet d’intervenir avant la rupture. Cette approche humaine, fondée sur la solidarité et ancrée dans le territoire, constitue un pilier de la santé mentale en milieu agricole.

Mais pour que ces actions soient pleinement efficaces, il est essentiel de prendre en compte les expériences (dont les difficultés) vécues par ces sentinelles, qui ne doivent pas nécessairement être des actifs du secteur agricole. Il peut également s’agir de retraités agricoles ou d’autres acteurs ruraux non agricoles, par exemple maires et secrétaires de commune, ambulanciers, vétérinaires, etc. Il faut ainsi répondre à leur besoin de formation et de soutien. Entre 2023 et 2024, le nombre de sentinelles a augmenté de 29 %.

Une telle approche systémique, organisée autour d’un véritable écosystème de prévention du mal-être agricole (réunissant un réseau d’acteurs de proximité, de professionnels de santé, d’institutions et politiques publiques), constitue une piste majeure pour construire une stratégie de santé mentale en milieu agricole, capable de répondre aux vulnérabilités individuelles tout en agissant sur les facteurs sociaux et collectifs.

À lire aussi : Comprendre le malaise des agriculteurs

Virginie Le Bris Fontier ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

02.12.2025 à 15:58

La transition agroécologique peut-elle vraiment justifier le soutien politique à la méthanisation ?

Renaud Metereau, Socio-Economie Ecologique , Université Paris Cité

Texte intégral (2462 mots)

La méthanisation agricole se développe en France portée par deux promesses politiques : celle de contribuer à la transition énergétique en produisant du biométhane, d’une part, et celle de participer à la transition agroécologique en faisant évoluer les systèmes agricoles, d’autre part. Mais cette seconde promesse peut-elle vraiment être tenue ?

Le projet en date de programmation pluriannuelle de l’énergie (PPE 3) formule, comme les précédentes, pour la méthanisation un double objectif : promouvoir de concert la transition énergétique et la transition agroécologique.

Pour l’heure, ces promesses servent à justifier une dépense publique d’un milliard d’euros par an pour le rachat du biométhane produit. Sans elle, la filière ne se développerait pas de la même manière, ni quantitativement, ni qualitativement. Les objectifs de production énergétique du projet de PPE sont à la fois très ambitieux (multipliés par quatre entre 2023 et 2030, jusqu’à sept d’ici 2035, selon les scénarios), et annoncés compatibles avec l’agroécologie – voire comme un levier en faveur de son développement.

L’argument d’une convergence entre méthanisation et agroécologie est notamment fondé sur la réduction attendue des pertes d’azote permise par sa meilleure maîtrise et le développement de cultures intermédiaires à vocation énergétique (Cive) s’intercalant entre deux cultures d’hiver (on parle de « Cive d’été », typiquement du maïs) ou juste avant une culture d’été (Cive couvrant le sol en hiver, typiquement un seigle récolté en vert).

Cette allégation agroécologique d’ensemble a pourtant de quoi surprendre, car le développement de la biométahisation a tous les attributs d’une agriculture industrielle.

Face à ces visions contradictoires, nous nous proposons d’évaluer la manière dont cette promesse est remplie. Nous continuons une discussion déjà engagée ici, en adoptant une perspective agroécologique plus large.

À lire aussi : La méthanisation est-elle vraiment un levier pour l’agroécologie ?

L’agroécologie, un changement systémique

Revenons d’abord sur le terme « agroécologie », largement repris et transformé dans différents espaces politiques.

Face aux multiples réappropriations, rappelons qu’elle désigne à la fois :

un ensemble de pratiques productives liées entre elles et non un catalogue de pratiques dans lequel on pourrait piocher isolément ;

un mouvement social à l’avant-garde de la transformation socioécologique des systèmes agroalimentaires ;

et une science transdisciplinaire.

Cette notion a donc une histoire fondée sur des développements scientifiques. Depuis les années 1980, ces derniers insistent sur son caractère systémique. Il ne s’agit pas seulement de promouvoir une agriculture plus vertueuse selon un critère donné, par exemple la seule réalisation d’économies en énergie ou fertilisants.

L’enjeu est de penser l’agroécosystème comme un ensemble intégré, en s’appuyant sur l’analyse et la compréhension de ses propriétés et de ses fonctionnalités pour concevoir des systèmes productifs réellement soutenables des points de vue écologique et social.

Dans les discours qui promeuvent la méthanisation, trois grands éléments sont présentés comme des leviers de transition agroécologique :

les économies en fertilisants azotés achetés qui sont permises par l’usage de digestats, coproduits du processus de méthanisation riches en azote ;

la diversification des cultures via l’introduction de Cive ;

et l’autonomie renforcée des agriculteur pratiquant la méthanisation, sans que cette autonomie soit précisée, nous y reviendrons.

Ces trois points relèvent en effet d’une démarche agroécologique dans leur acception générique. Ils font toutefois ici l’objet d’une requalification qui en altère fondamentalement la signification.

Des économies d’azote en trompe-l’œil

Commençons par les économies d’engrais azotés souvent mises en avant, procédant de l’épandage des digestats. Il faut d’abord considérer que la méthanisation agricole ne crée pas d’azote ex nihilo. Dans les digestats, celui-ci provient très majoritairement en amont des engrais de synthèse, des déjections animales et, marginalement, des légumineuses.

Ces « économies » d’engrais azotés pour fertiliser les cultures en aval du processus de méthanisation relèvent donc d’un transfert d’azote entre une exploitation tierce et l’unité de méthanisation, via la biomasse contenant de l’azote « incorporé ».

À lire aussi : Comment l’agriculture industrielle bouleverse le cycle de l’azote et compromet l’habitabilité de la terre

Lorsque la source d’azote du digestat est d’origine végétale, cela veut dire qu’on a introduit sur le territoire des cultures spécifiques (les Cive), ce qui signifie une intensification de la production de biomasse puisqu’on produit deux fois plus sur la même surface. Dans ce cas, ce qui est économisé en aval sur le plan économique provient en fait d’une intensification de la production agricole en amont.

Enfin, lorsque la méthanisation est fondée sur la valorisation des déjections animales, la logique est en principe plus propice à une circularité des flux. Pour autant, les contraintes de collecte et de stockage à une échelle suffisante pour alimenter une unité de méthanisation ne sont majoritairement pas compatibles avec des modalités d’élevage agroécologique.

Une diversification sans intérêt écologique

Par ailleurs, la diversification promise via l’introduction des Cive concerne des cultures à rotation courte (seigle, avoine, méteil, maïs).

Pour autant, ces cultures – souvent du maïs – n’ont pas nécessairement d’intérêt écologique fort en elles-mêmes. C’est d’autant moins si elles sont irriguées et fertilisées, comme c’est souvent le cas.

Le risque est que les objectifs de production énergétique affichés ne conduisent à la multiplication et à l’agrandissement des unités de méthanisation, qui vont en retour augmenter la demande de Cive.

Sur ce point, la requalification consiste à passer d’un principe agroécologique de maximisation de la biodiversité et de préservation des services rendus par les écosystèmes, à une simple diversification des cultures intensives.

Une autonomie illusoire

Quant à l’autonomie telle qu’elle est entendue ici, elle découle du complément de revenu par l’agrométhaniseur (voire d’un glissement vers un revenu principal tiré pour les « énergiculteurs ») permis par des tarifs de rachat globalement avantageux. Le raisonnement étant qu’un agrométhaniseur doté d’un revenu plus élevé peut plus facilement mettre en œuvre des pratiques agroécologiques que s’il a le couteau sous la gorge.

Mais le revenu issu de la méthanisation n’induit pas en lui-même l’adoption de systèmes agroécologiques et cet objectif pourrait être mieux atteint par un meilleur ciblage des aides. Le milliard d’euros par an pour le tarif de rachat est à comparer à environ 170 millions d’euros annuels pour l’ensemble des mesures agri-environnementales de la PAC, notoirement sous-dotées.

« L’autonomie » financière tirée de la méthanisation a tout autant de chances de pousser à une maximisation de la production énergétique sous forte contrainte technico-économique pour rembourser les investissements : davantage de maïs irrigué, de déjections concentrées dans des bâtiments. Au risque de renforcer la pression sur les agroécosystèmes et produire des effets opposés à l’autonomie technique et décisionnelle qui est celle de l’agroécologie.

Finalement, l’agrométhaniseur se retrouve dépendant, tout comme l’agriculteur conventionnel, de prestataires techniques et financiers. Son approvisionnement en biomasse devient crucial et induit une pression sur l’ensemble des filières territoriales, qui deviendra critique en cas de rareté les mauvaises années

De nombreux angles morts

La promesse agroécologique de la méthanisation reste toutefois muette sur des points pourtant cruciaux : les paysages, la biodiversité, la sobriété absolue en intrants ; c’est-à-dire, le fait de ne plus dépendre d’intrants azotés de synthèse, à ne pas confondre avec une optimisation de leur usage.

Sur un registre plus sociopolitique, l’autonomie paysanne et décisionnelle des agriculteurs et plus largement, la transformation industrielle des modes de développement auxquels la méthanisation participe, ne sont pas pris en compte.

Pourtant : pas d’agroécologie sans écologie du paysage, sans substitution des intrants de synthèse par des solutions fondées sur la nature, sans végétation semi-naturelle et des animaux extensifs jouant un rôle écologique, sans autonomie financière et technologique des paysans, sans remise en cause des rapports socioécologiques de production.

À lire aussi : Au nom du paysage ? Éoliennes, méthaniseurs… pourquoi les projets renouvelables divisent

Ce qui est absent de la politique actuelle de développement de la méthanisation est fondamentalement l’approche holistique qui caractérise pleinement l’agroécologie. Cette dernière ne peut se résumer à un catalogue de pratiques mises en avant, mais à une démarche globale articulant l’autonomie décisionnelle à une autonomie technique fondée sur une sobriété matérielle d’ensemble et un respect des cycles biologiques et biogéochimiques à l’échelle territoriale.

À lire aussi : Comment l’agriculture industrielle bouleverse le cycle de l’azote et compromet l’habitabilité de la terre

Une nécessaire réorientation politique

Est-ce à dire que la méthanisation est incompatible avec l’agroécologie ? En principe, non, et des exemples dans des pays en développement montrent qu’à petite échelle, elle peut pleinement contribuer à un projet agroécologique, lorsqu’elle valorise une fraction réduite de déchets au service d’une véritable autonomie paysanne low-tech.

Mais le passage à l’échelle, tel qu’envisagé en France et porté par le cadre politique d’ensemble, contredit les fondamentaux de l’agroécologie. Ce n’est pas une question de bonnes ou mauvaises pratiques, c’est une question politique de développement d’une filière à grande échelle, qui induit des rapports de production auxquels l’agroécologie, telle qu’elle se déploie historiquement dans les mouvements paysans à travers le monde, veut précisément proposer des alternatives.

S’il doit y avoir une rencontre entre la méthanisation et l’agroécologie, c’est via des projets opportunistes, économes, à petite échelle, qui prennent en compte le fonctionnement de l’ensemble des agroécosystèmes, n’induisant aucune production supplémentaire dédiée et au service d’usages locaux. Faire l’impasse sur la biodiversité, les paysages et la sobriété, c’est hypothéquer l’avenir. Viser beaucoup trop grand, c’est risquer la faillite d’ensemble de l’ensemble de l’agriculture. Continuer la politique du chiffre agrégeant les TWh, c’est sélectionner davantage des exploitations déterritorialisées, qui ne répondent pas aux enjeux socioécologiques auxquels nous devons faire face.

Et à ceux qui considèrent qu’il faudrait alors peut-être sacrifier l’agroécologie à la souveraineté énergétique, nous répondrons qu’il faut commencer par le commencement : la sobriété énergétique, trop souvent marginalisée par les discours de politique de l’offre. La biomasse industrielle est sans doute une chimère à laquelle il est dangereux de s’accrocher, fût-elle autoproclamée « durable ».

Xavier Poux, agronome et consultant pour le cabinet d'études, de conseils et de recherche dans le domaine des politiques environnementales AScA, expert pour l'IDDRI, a co-écrit cet article

Renaud Metereau a reçu des financements de IdEx Université Paris Cité, ANR-18-IDEX- 0001 (Centre des Politiques de la Terre - projet MethaTransferts)

30.11.2025 à 20:34

Les forêts du Grand-Est au cinéma : un territoire qui s’enracine à l’écran

Delphine Le Nozach, Maître de conférences en Sciences de l'information et de la communication, Université de Lorraine

Violaine Appel, Enseignant-chercheur en sciences de l'information et de la communication, Université de Lorraine, Université de Lorraine

Texte intégral (2031 mots)

Le Grand-Est est l’une des régions les plus boisées de France, avec plus de 30 % de sa surface couverte par des forêts. Au cinéma, il offre une forêt multiple : espace de travail, de mémoire, d’émotions et d’imaginaire.

Peu filmées mais profondément singulières, les forêts du Grand-Est deviennent à l’écran des lieux où se croisent réalités industrielles, ancrages identitaires et puissances narratives. À travers elles, les films révèlent autant un territoire qu’une manière sensible de le regarder.

Dans cette étude (issue des résultats du projet Matercine), nous analysons la manière dont les longs métrages tournés dans cette région investissent les forêts, qu’il s’agisse de témoigner des usages liés au travail du bois, de mobiliser des paysages rares et méconnus pour leur force esthétique, ou encore d’exprimer le lien intime qu’entretiennent certains réalisateurs avec ces lieux. L’ensemble de ces approches permet de comprendre comment la forêt du Grand-Est, bien au-delà du simple décor, devient au cinéma un espace identitaire et narratif essentiel.

La dualité des représentations des forêts du Grand-Est au cinéma

Comme dans d’autres régions françaises, les réalisateurs montrent souvent la forêt comme un espace de travail, lié à l’exploitation du bois. Mais ces usages productifs n’épuisent pas les façons de la représenter : nombre de réalisateurs choisissent ces forêts pour leur valeur esthétique, leur caractère méconnu ou pour l’attachement personnel qu’ils entretiennent à ces territoires.

La forêt du Grand-Est est en effet un espace multifonctionnel où s’entremêlent nature, industrie et culture. Elle structure les activités humaines (coupe du bois, schlittage – la schlitte est un traîneau qui servait, dans les Vosges et en Forêt-Noire, à descendre le bois des montagnes, conduit par un homme sur une voie faite de rondins – transport des grumes, sciage, construction et papeterie) qui façonnent l’économie régionale comme l’imaginaire collectif. Le cinéma reprend cette diversité et l’inscrit au cœur de ses récits. Les Grandes Gueules (Enrico, 1965) en offre un exemple emblématique : tourné dans une véritable scierie vosgienne, le film témoigne des pratiques forestières d’une époque – travail du bois, énergie hydraulique, transport traditionnel. Nos patriotes (Le Bomin, 2017) valorise quant à lui un schlittage filmé avec réalisme, rendu possible grâce à l’implication de spécialistes locaux.

Dans le Mangeur d’âmes (Bustillo, Maury, 2024), scierie et grumes deviennent des éléments dramatiques : décor authentique, matière visuelle dense et espace de tension pour les scènes d’action. L’usage industriel du bois apparaît aussi dans le Torrent (Le Ny, 2022), tourné au sein d’une entreprise vosgienne réelle, ou dans le Couperet (Costa-Gavras, 2005), où une papeterie vosgienne accueille l’intrigue, articulant territoire local et discours social universel.

Plus-value culturelle

Au-delà de ces dimensions productives, les forêts du Grand-Est possèdent une singularité paysagère qui attire des réalisateurs en quête de décors rares. Elles offrent des espaces peu filmés, marqués par des reliefs, des lacs glaciaires, des espaces boisés denses, qui constituent des territoires non substituables. Filmer ces forêts revient alors à révéler un paysage méconnu, à donner à voir un territoire encore invisibilisé. Cette démarche confère une valeur ajoutée au film, mais aussi au lieu : comme l’énonce la géographe Maria Gravari-Barbas, le regard cinématographique peut créer une plus-value culturelle pour des sites auparavant invisibles.

Certains cinéastes revendiquent cette volonté de découverte. Anne Le Ny, réalisatrice du film le Torrent (2022), souligne ainsi l’atmosphère unique des Vosges, qui lui a donné le sentiment d’être « pionnière ». Dans Perdrix (2019), Erwan Le Duc filme longuement les forêts et le lac des Corbeaux, affirmant un territoire « de cinéma » encore peu exploré.

« J’ai trouvé qu’il y avait une atmosphère très particulière dans les Vosges. D’abord, je suis tombée sur des décors magnifiques qui collaient très bien au scénario avec un mystère particulier et puis le plaisir aussi de tourner dans une région qui n’a pas tellement été filmée. On se sent un petit peu pionnière et c’est très excitant. » (Anne Le Ny, interviewée par Sarah Coton, Fun Radio, novembre 2022)

Cette proximité peut être encore plus intime. De nombreux réalisateurs tournent dans des lieux qu’ils connaissent, où ils ont grandi ou qu’ils associent à leur histoire personnelle. Leur rapport au territoire relève ainsi d’un territoire vécu, chargé de mémoire, d’expériences et de relations sociales. La forêt devient alors le support d’une identité, un espace où se superposent réalité et fiction. C’est le cas d’Erwan Le Duc dans Perdrix (2019) ou de Valérie Donzelli pour Main dans la main (2011), qui revendiquent leur attachement aux paysages lorrains de leur enfance.

La forêt, un territoire d’ombres…

Entre clair-obscur, sous-bois inquiétants et clairières lumineuses, les forêts du Grand-Est permettent aux réalisateurs de traduire aussi bien la peur, le mystère ou la clandestinité que la sérénité, l’éveil ou l’accomplissement. Par leur capacité à refléter les états intérieurs des personnages, ces forêts deviennent de véritables outils esthétiques et narratifs, révélant la singularité du territoire.

Une première tonalité, sombre et dramatique, irrigue le cinéma fantastique, policier, de guerre ou d’horreur. La forêt y apparaît comme un espace d’isolement et de menace, qui mêle naturalisme et surnaturel : silhouettes mouvantes, bruits étouffés, climat hostile, jeux d’ombres. Cette atmosphère immersive renforce la tension psychologique, les peurs profondes et le sentiment d’incertitude. La Région accompagne cette dimension à travers le label « Frissons en Grand-Est », premier fonds consacré aux films de genre, soutenu par le Centre national du cinéma et de l'image animée (CNC) et structuré autour de festivals phares, tels que ceux de Gérardmer, de Strasbourg, ou encore Reims Polar et War on Screen. Cette dynamique contribue à positionner le Grand-Est comme terre de frissons, où les paysages forestiers deviennent les complices naturels d’une esthétique noire.

La forêt s’expose dans les récits de guerre, en particulier autour de la thématique de la clandestinité. Lieu de refuge pour les maquisards, elle abrite déplacements secrets, identités dissimulées et tensions de la survie. Dans Nos patriotes (Le Bomin, 2017), la Place d’une autre (Georges, 2021) ou encore Nos résistances (Cogitore, 2011), les réalisateurs choisissent les Vosges ou l’Alsace afin d’ancrer leurs récits dans un territoire historique réel, renforçant le réalisme des actions clandestines. Ces forêts incarnent alors autant une protection qu’une transformation intime, où les personnages quittent leur vie civile pour entrer dans une existence parallèle faite de solidarité et de résistance.

La criminalité trouve aussi dans ces espaces naturels un terrain narratif fertile. Qu’il s’agisse d’un crime intime, comme dans le Torrent (Le Ny, 2022), d’une tension familiale violente, comme dans la Fin du silence (Erzard, 2011), ou d’une atmosphère de légende sombre et de disparitions inexpliquées, comme dans le Mangeur d’âmes (Bustillo, Maury, 2024), la forêt agit comme un personnage à part entière : elle dissimule, révèle, dérègle, structure. Ses reliefs, son climat, son obscurité ou son immensité renforcent la dramaturgie et nourrissent une topographie émotionnelle du secret, du mensonge ou de la menace.

Enfin, la forêt du Grand-Est au cinéma apparaît comme un refuge temporaire et fragile, offrant aux personnages un espace isolé pour se protéger et se reposer. Dans Survivre avec les loups (Belmont, 2007), elle joue ce rôle de protection, tandis que dans Baise-moi (Despentes, 2000), la forêt finale symbolise un havre éphémère pour les deux protagonistes, un moment de calme et de sérénité avant la tragédie, où même la mort semble suspendue par la nature.

… et de lumières

Ces forêts se déploient également comme des espaces lumineux, poétiques et pacifiés. Dans la Dormeuse Duval (Sanchez, 2017), Main dans la main (Donzelli, 2012) ou la Bonne Épouse (Provost, 2020), elles deviennent des territoires d’apaisement, des lieux de beauté et de contemplation qui contrastent avec l’agitation urbaine. Elles éveillent les sens – comme dans les Parfums (Magne, 2019), où la forêt alsacienne est appréhendée par l’olfaction – et accompagnent des récits d’apprentissage, d’amitié ou d’amour. La forêt y assume alors des fonctions symboliques complémentaires : le départ (fuite du quotidien), le passage (transformation, éveil du désir, émancipation) et l’arrivée (réconciliation, apaisement, accomplissement).

Le départ se manifeste comme un besoin de fuir le quotidien ou la contrainte sociale : dans Leurs enfants après eux (signé des frères Boukherma, 2024), les adolescents quittent la grisaille ouvrière pour s’échapper dans les bois, tandis que dans Tous les soleils (Claudel, 2011), le héros rejoint un refuge forestier pour se libérer des pressions familiales et retrouver un peu de silence.

Le passage correspond à l’expérience de transformation et d’émancipation : dans Petite Nature (Theis, 2021), Johnny traverse la forêt pour se rapprocher du monde adulte et s’affirmer, et dans Mon chat et moi… (Maidatchevsky, 2023), Rroû retrouve son instinct et sa liberté en explorant les sous-bois.

Enfin, l’arrivée symbolise l’accomplissement et l’apaisement : dans Perdrix (Le Duc, 2019), Pierre et Juliette atteignent la rive du lac après leurs aventures forestières, exprimant leur amour en toute liberté, et dans Jules et Jim (Truffaut, 1962), les balades en forêt incarnent des instants de joie et de plénitude avant la tragédie. À travers ces récits, la forêt se révèle un espace initiatique, miroir des émotions et catalyseur de la transformation intérieure.

Ainsi les forêts du Grand-Est se révèlent-t-elles un espace filmique pluriel. Elles traversent les récits en incarnant une territorialité cinématographique, où les liens entre les personnages et leur environnement façonnent la narration. À travers elles, le territoire se donne à voir et à ressentir, agissant comme un lieu d’émotions et de symboles, capable d’exprimer les ombres comme les lumières. Cette polysémie participe à la force cinématographique du Grand-Est, dont la richesse narrative repose précisément sur cette capacité à conjuguer frisson, mémoire, liberté et poésie, révélant un territoire à la fois concret et sensible.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

30.11.2025 à 09:38

Peut-on rendre la forêt « nourricière » ? La proposition du jardin-forêt

Jacques Tassin, Chercheur en écologie forestière (HDR), spécialiste des rapports Homme / Nature, Cirad

Michon Geneviève, Institut de recherche pour le développement (IRD)

Texte intégral (2270 mots)

Issu des régions tropicales, le jardin-forêt est un modèle d’agroforesterie qui séduit de plus en plus en Europe pour prendre le contrepied d’un modèle agricole à bout de souffle. Il semble peu envisageable qu’il se substitue à l’agriculture productiviste dominante, mais il ouvre des pistes inspirantes pour promouvoir des pratiques plus respectueuses du vivant.

Les analyses se multiplient aujourd'hui pour dénoncer les externalités négatives (pollution, changement climatique, crise de la biodiversité…) induites par le paradigme économique actuel. Le modèle agricole dominant, en particulier, est pointé du doigt.

En effet, les systèmes agroalimentaires dominants s'avèrent coûteux à bien des égards. Ils substituent à des processus naturels répondant à des fonctions écologiques précieuses des intrants à fort impact environnemental (engrais par exemple), ils uniformisent les modes de culture, ils mettent à disposition du consommateur une alimentation d'une qualité nutritive questionnable, et enfin ils dévitalisent les tissus sociaux ruraux.

À rebours de cette logique productiviste, d'autres formes d'agriculture, parfois très anciennes, suscitent dès lors un regain d'intérêt. C'est le cas du modèle jardin-forêt, qui se développe peu à peu en Europe. Il est une transposition géographique en milieux tempérés de l'agroforesterie des tropiques humides, notamment indonésiennes.

Là-bas, l'agriculture vivrière et une partie de l'agriculture commerciale des petits planteurs sont conduites en pérennisant le modèle forestier traditionnel – fruits, légumes, noix, tubercules, plantes médicinales, matériaux, bois de feu ou de construction y sont produits au sein d'écosystèmes arborés multi-étagés, diversifiés et denses.

Structurés autour des arbres et de leur diversité, les jardins-forêts partagent avec les forêts naturelles des caractéristiques de robustesse, de résilience et de productivité. Multipliant les externalités positives (c'est-à-dire, des effets positifs tant d'ordre écologiques qu'économiques), ce modèle millénaire nourricier représente une voie inspirante qui vaudrait d'être davantage connue et considérée sous nos latitudes.

Il est fondé sur la polyvalence des forêts. Les jardins-forêts montrent que les arbres et les systèmes forestiers, dont les capacités de production, de régulation, de facilitation et de symbiose sont mésestimées, peuvent être bien plus productifs que nous le croyons.

À lire aussi : Pour des forêts à croissance rapide, favorisez les arbres à croissance lente

Des « forêts comestibles » aux antipodes des monocultures

Aussi surnommés « forêts comestibles », les jardins-forêts se caractérisent par une forte densité d'arbres, d'arbustes, mais aussi de lianes et d'herbacées, tous de lumière et d'ombre, et tous d'intérêt alimentaire.

Ils sont donc multifonctionnels. En témoignent par exemple :

leur productivité à l'hectare,

l'agencement spatial de leurs éléments constitutifs,

leur composition très diversifiée en termes d'espèces,

la richesse des mutualismes entre espèces,

Leur performance leur dynamisme et leur robustesse en tant que système de production alimentaire.

Ils sont à l'opposé des monocultures, qui sont spatialement et génétiquement homogènes. Celles-ci sont fondées sur la culture d'une seule variété, et souffrent dès lors une vulnérabilité maximale aux aléas. En jardin-forêt, les invasions d'insectes ravageurs ou les dégâts d'intempéries, pour ne citer que ces exemples, sont réduits en raison d'une importante hétérogénéité structurale et d'une faible exposition aux aléas. Des caractéristiques précieuses dans le contexte de dérèglement climatique.

Ces systèmes nourriciers sont aujourd'hui une réalité éprouvée, y compris en Europe. Aux Pays-Bas par exemple, des jardins-forêts à vocation agricole affirmée existent depuis quinze ans, financés par la politique agricole commune.

À lire aussi : Incendies, sécheresses, ravageurs : les forêts victimes de la monoculture

Une production agricole à hauteur d'humain

Un autre point fort de cette alternative agricole est son échelle à hauteur humaine. En effet, le jardin-forêt envisage le parcellaire cultivé, dans ses dimensions spatiales comme dans les pratiques dont il fait l'objet, autour de la mesure étalon de la personne qui en prend soin.

Les recours à l'observation et au soin, de même que l'accumulation patiente de connaissances pratiques, y sont largement promus. Ils permettent une réactivité accrue et plus adaptée aux aléas, environnementaux mais aussi économiques.

Le « jardinier-forestier » est dès lors convié à se pencher sur son terrain à différentes échelles : du contrôle de la qualité des tissus mycorhiziens (c'est-à-dire, les champignons agissant en symbiose avec les racines) du sol jusqu'à la surveillance de la complémentarité permanente des strates de végétation.

La diversité ne se joue pas qu'à l'échelle d'une forêt comestible, mais aussi à l'échelle d'un territoire. A l'image du bocage, un réseau de jardins-forêts divers est pourvoyeur de services écosystémiques complets. Ils peuvent également s'insérer dans le tissu agricole et compenser une partie des impacts environnementaux néfastes induits par le modèle agricole dominant.

Un seul espace, des productions multiples

Par essence, le jardin-forêt offre une large diversité alimentaire. Pour rappel, seules 30 à 60 espèces végétales tout au plus assurent la base de notre alimentation occidentale, dont quelques espèces seulement de céréales. Une partie de cette alimentation est importée (avocats, ananas ou bananes), alors que 7 000 espèces alimentaires sont cultivables en climat tempéré, sans renfort technique particulier. Le modèle du jardin-forêt s'avère apte à les valoriser.

Les « forêts comestibles » sont en effet des espaces de multiproduction où sur une même parcelle peuvent se déployer quatre types de produits différents :

Les aliments « forestibles » dans lesquels ont peut inclure fruits, noix et graines, ressources tuberculeuses amidonnées ou riches en inuline, légumes, feuilles, feuillages, fleurs, champignons, épices, sirop de sève, viande sauvage ou domestique en cas de petit élevage, ou encore produits de la ruche (miel, pollen, propolis) ;

les biomatériaux (bois de construction, bambou, osier, gommes, cires, résines, liants, latex, papier, tinctoriales) ;

les ressources médicinales provenant de tous les étages végétaux de la forêt comestible ;

et enfin les combustibles (bois énergie, copeaux, fagots).

À lire aussi : Pharma, cosmétique… et si les déchets végétaux aidaient à développer l’économie circulaire ?

Une porte vers d'autres imaginaires

Les jardins-forêts ne se limitent pas à la seule production de biens alimentaires et de services environnementaux. Ils offrent également des ressources immatérielles dont nous avions fini par croire qu'elles ne pouvaient être compatibles avec une agriculture performante.

En effet, ces espaces créent aussi les conditions pour d'autres imaginaires. Ils sont le support d'activités diverses (artisanales, éducatives, thérapeutiques, culturelles) favorables au mieux-être. Ces services immatériels peuvent concourir à transformer les zones rurales en espaces plus désirables et plus habitables, voire à les reterritorialiser. La psychologie atteste en outre des bienfaits des arbres sur le bien-être humain.

En France, les jardins-forêts recouvrent environ 2 000 hectares. Peu connus du grand public, des institutions et des pouvoirs publics, ils se heurtent à une vision encore archaïque de la forêt, vue comme aux antipodes de la civilisation, et à une réticence à valoriser des ressources alimentaires parfois rattachées dans les imaginaires aux périodes de famine.

Il leur est également reproché d'inviter à un relâchement des pratiques conventionnelles de contrôle du vivant habituellement exercées en agriculture (taille, fertilisation, contrôle direct des ravageurs…), auxquelles est ici préférée, pour des raisons de durabilité et d'efficience économique, une philosophie de l'accompagnement et de l'amplification des processus écologiques naturels.

S'ils n'ont pas vocation à supplanter les autres systèmes agricoles en place, ils ont toutefois le potentiel de redynamiser et resocialiser les campagnes. De quoi développer de nouvelles activités rurales exigeantes mais porteuses de sens et pourvoyeuses de bien-être. C'est précisément là une demande sociale et une exigence environnementale de plus en plus pressantes.

Fondateur de l’association Forêt gourmande, Fabrice Desjours a contribué à la rédaction de cet article.

Michon Geneviève a reçu des financements de ANR, UE.

Jacques Tassin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

27.11.2025 à 17:07

« Dévendeurs » contre commerçants : comment sortir du dilemme des politiques de soutien à l’économie circulaire ?

Amal Jrad, Chercheuse, Université de Strasbourg

Karine Bouvier, Chercheuse, Université de Strasbourg

Texte intégral (2037 mots)

Malgré le succès grandissant du Black Friday, qui se tient ce vendredi 28 novembre et qui vient renforcer la surconsommation à travers des promotions généralisées, les modes de consommation changent peu à peu à l’aune des enjeux écologiques. Mais les politiques publiques peinent souvent à trouver l’équilibre entre soutien à l’économie circulaire et protection des intérêts commerciaux traditionnels. Comment sortir de ce dilemme ?

En novembre 2023, à la veille du Black Friday, l’Agence de la transition écologique (Ademe) lançait une campagne de communication introduisant le concept de « dévendeur ». Concrètement, plusieurs vidéos mettaient en scène un vendeur qui encourageaient un client en quête de conseils sur le modèle à acquérir, à plutôt réparer son bien au lieu d’acheter un nouveau produit neuf.

Sur les réseaux sociaux, l’initiative a déclenché une vive polémique et a divisé autant les professionnels que le gouvernement. Au-delà de la controverse, cette situation illustre un défi majeur de notre époque : comment concilier la transition vers l’économie circulaire avec les intérêts économiques traditionnels ?

Pour trouver des réponses, l’Observatoire des futurs de l’EM Strasboug (Université de Strasbourg) a réalisé une étude sur la thématique industrie et économie circulaire à l’horizon 2035. Cette étude s’appuie sur des ateliers participatifs réunissant chercheurs, praticiens et acteurs institutionnels tels qu’Eurométropole, l’Ademe, Initiatives durables, et Grand Est Développement). Nous en livrons quelques résultats.

À lire aussi : Sobriété versus surconsommation : pourquoi les « dévendeurs » de l’Ademe sont polémiques

Un dilemme au cœur des politiques publiques

À l’échelle européenne, l’engagement pour l’économie circulaire s’est considérablement renforcé depuis le lancement du Pacte vert en 2019. Cette volonté s’est traduite par des plans d’action successifs, notamment en mars 2020, ciblant des secteurs spécifiques comme le textile, les plastiques et la construction. La Commission européenne a également proposé en 2022 des mesures pour accélérer cette transition, avec un accent particulier mis sur la durabilité des produits et la responsabilisation des consommateurs.

En France, cette dynamique européenne s’est accompagnée d’initiatives nationales ambitieuses. La loi anti-gaspillage pour une économie circulaire (dite loi Agec) adoptée en 2020 promeut en particulier l’économie de la fonctionnalité et du service via le réemploi et la réparation. Selon une étude de l’Institut national de l’économie circulaire (Inec) et d’Opeo publiée en 2021, 81 % des industriels français interrogés perçoivent l’économie circulaire comme une opportunité.

Pour plus de 85 % d’entre eux, elle permettrait non seulement de développer de nouveaux marchés et de réaliser des économies, mais aussi de relever les défis environnementaux actuels. Cependant, ces orientations se heurtent à un modèle économique encore largement basé sur la vente en volume.

À lire aussi : Consommation sobre : un défi culturel autant qu'économique

Des consommateurs de plus en plus conscients

L’évolution des comportements d’achat témoigne d’ailleurs d’une prise de conscience croissante chez les consommateurs. Les convictions personnelles liées à l’éthique et l’environnement pèsent de plus en plus sur les choix individuels et les consommateurs privilégient désormais le « Made in France » et les produits issus de l’économie circulaire.

Une enquête menée en France par OpinionWay en 2024 montrait ainsi que 42 % des personnes interrogées se disaient prêtes à dépenser plus d’argent pour avoir des produits vestimentaires plus respectueux de l’environnement et socialement responsables.

D’après une étude d’Ipsos, deux vacanciers européens sur trois se déclaraient prêts à modifier leur mode de transport durant l’été 2023 pour réduire leur impact carbone.

À lire aussi : Surconsommation de vêtements : pourquoi la garde-robe des Français déborde

Un soutien public en quête d’équilibre

Face à ces évolutions, les politiques publiques tentent de trouver un équilibre délicat. L’Union européenne (UE) déploie des financements importants pour soutenir cette transition. Le programme Horizon Europe (2021-2027) offre ainsi un budget de 95,5 milliards d’euros, dont une partie significative est destinée à la recherche et l’innovation en économie circulaire.

Toutefois, ces mécanismes de financement européens souffrent de plusieurs lacunes que nous avons identifiées à partir des entretiens d’experts réalisés dans le cadre de l’étude :

- une communication limitée autour des programmes,

- un soutien insuffisant aux entreprises déjà engagées dans la circularité,

- et des budgets parfois davantage orientés vers les études que vers l’accompagnement concret des transformations.

Au niveau national, de nombreuses mesures ont été mises en place, parmi lesquelles :

- le fonds d’économie circulaire de l’Ademe, renouvelé annuellement,

- les programmes d’investissement d’avenir successifs, dont le dernier (PIA 5) dispose d’un budget de 54 milliards d’euros,

- ou le plan France 2030, qui a déjà engagé 21 milliards d’euros avec plus de 1 000 projets répondant à l’objectif « mieux produire ».

Ces dispositifs ne parviennent toutefois pas toujours à répondre aux besoins de l’ensemble des acteurs. Les petites entreprises, en particulier, peinent souvent à accéder aux informations et aux financements, alors même qu’elles sont en général plus avancées dans leurs pratiques circulaires.

C’est plutôt au niveau local qu’émergent les solutions innovantes les plus prometteuses : l’Eurométropole de Strasbourg, par exemple, déploie des actions concrètes : création de réseaux d’acteurs autour de l’économie circulaire, soutien aux structures d’insertion dans le domaine du recyclage, développement de l’écologie industrielle territoriale et promotion du réemploi dans le secteur du bâtiment et travaux publics (BTP).

Ces initiatives montrent qu’il est possible de créer des synergies entre différents acteurs économiques autour de l’économie circulaire.

À lire aussi : Économie circulaire : les consommateurs, acteurs oubliés de la réglementation européenne

Quatre futurs possibles pour réinventer le commerce

Mais la controverse des « dévendeurs » a révélé un besoin plus profond de repenser nos modèles économiques. Comment les politiques de soutien pourraient-elles évoluer face à ce dilemme entre promotion de la sobriété et maintien de l’activité commerciale ? Quatre scénarios se dessinent à l’horizon 2035, chacun proposant une approche différente de création de valeur.

Dans un premier scénario, les politiques de soutien resteraient ambivalentes, tentant de satisfaire à la fois les commerçants traditionnels et les acteurs de l’économie circulaire. Cette approche conduirait à des mesures parfois contradictoires : d’un côté, des subventions pour la modernisation des commerces, de l’autre, des campagnes promouvant la sobriété. Les grandes enseignes s’adapteraient en créant des « coins réparation », mais sans remise en cause fondamentale de leur modèle. Les petits commerces, pris entre deux logiques, peineraient à trouver leur place. Le risque est d’aboutir à un soutien fragmenté et inefficace.

Le deuxième scénario miserait sur l’innovation pour réconcilier vente et durabilité. Les commerces deviendraient des « hubs circulaires » où la technologie (IA, blockchain) optimiserait la réparation et la revente. Le métier de vendeur évoluerait vers un rôle de « conseiller en usage durable », proposant la solution la plus pertinente : réparation, achat neuf ou reconditionné. Un modèle prometteur, mais qui risque d’exclure les petits commerces faute de moyens d’investissement.

Dans une troisième configuration, les politiques se territorialiseraient fortement, avec des aides adaptées aux besoins locaux. Les commerces deviendraient des lieux hybrides de vente, réparation et échange. L’économie de la fonctionnalité s’y développerait naturellement, privilégiant l’usage plutôt que la propriété. Les « dévendeurs » s’intégreraient dans ce maillage territorial, même si cette approche pourrait créer des disparités entre régions.

Face à l’urgence climatique, le dernier scénario verrait l’État imposer une transformation radicale et un tantinet autoritaire. Des quotas de réparation et de réemploi seraient imposés aux commerces. La fonction de « dévendeur » deviendrait obligatoire dans les grandes surfaces. Parmi les mesures concrètes, l’Institut national de l’économie circulaire propose déjà une TVA à 5,5 % sur les opérations de réparation et des taux réduits pour les produits reconditionnés et écoconçus.

Dépasser l’opposition entre vendeurs et « dévendeurs »

La résolution du dilemme entre « dévendeurs » et commerçants passera sans doute par une combinaison de ces approches. Les politiques de soutien devront préserver la viabilité économique du commerce tout en accélérant la transition vers la sobriété. Ce qui implique la création de nouveaux métiers autour de la réparation et du réemploi, l’innovation dans les services plutôt que dans la production de biens, un accompagnement fort des pouvoirs publics et une transformation de notre rapport à la consommation.

En définitive, l’enjeu n’est plus tant d’opposer commerce traditionnel et économie circulaire que de réinventer nos modes de production et de consommation. Le concept de « dévendeur » n’est peut-être qu’une première étape vers cette nécessaire mutation de notre économie, qui requiert des politiques de soutien plus inclusives, capables d’accompagner tous les acteurs dans cette transition.

L’article s’appuie sur des entretiens réalisés avec Christophe Barel (chef de projet senior à l’Ademe, le 30 janvier 2024) ; Carmen Colle (entrepreneuse dans le secteur du textile et militante pour un entrepreneuriat responsable, social et solidaire, 14 décembre 2024) ; Pia Imbs (présidente de l’Eurométropole de Strasbourg, 19 décembre 2024) ; Anne Sander (députée européenne, questeur du Parlement européen, 9 février 2024) et Maryline Wilhelm (conseillère déléguée à l’économie circulaire, sociale et solidaire, Ville de Schiltigheim, 19 janvier 2024).

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

27.11.2025 à 17:06

La dinde, histoire d’une domestication

Aurélie Manin, Chargée de recherche en Archéologie, Archéozoologie et Paléogénomique, Centre national de la recherche scientifique (CNRS)

Texte intégral (2581 mots)

La dinde constitue un mets de choix sur les tables des fêtes d’Europe et d’Amérique du Nord, que ce soit pour Thanksgiving ou Noël. Son origine et les péripéties qui l’ont menée jusque dans nos cuisines sont toutefois peu connues du grand public.

La période des festivités de fin d’année semble tout indiquée pour revenir sur l’histoire naturelle et culturelle de cet oiseau de basse-cour, qui a fait l’objet d’un ouvrage collectif sorti en juin 2025 aux éditions scientifiques du Muséum national d’histoire naturelle.

La dinde ou le dindon commun, selon que l’on parle de la femelle ou du mâle, appartiennent à l’espèce Meleagris gallopavo que l’on retrouve encore à l’état sauvage sur l’essentiel du territoire des États-Unis, dans le sud du Canada et le nord du Mexique. Les sociétés américaines ont longtemps interagi avec ces oiseaux, essentiellement à travers la chasse. Le plus ancien kit de tatouage retrouvé en contexte archéologique, au Tennessee (États-Unis), daté d’entre 3500 et 1500 ans avant notre ère, était constitué d’os de dindon appointés. Mais ce n’est ni dans cette région ni à cette époque que la domestication du dindon a commencé, c’est-à-dire que le dindon et les humains sont entrés dans une relation de proximité mutualiste conduisant aux oiseaux de basse-cour que l’on connaît aujourd’hui [figure 1].

Une première domestication en Amérique centrale

Jusqu’au début de notre ère, les indices archéologiques d’un rapprochement entre dindons et humains sont, de fait, ténus. C’est en Amérique centrale, au Guatemala, que l’on retrouve la plus ancienne preuve de la gestion et de la manipulation des dindons. Dans cette région tropicale, on ne trouve pas de dindon commun sauvage mais son proche cousin, le dindon ocellé [figure 2]. Or sur le site d’El Mirador, quelques os de dindon commun ont été retrouvés, datés entre 300 avant notre ère et le tout début de notre ère – une identification confirmée par la génétique.

L’analyse des isotopes du strontium contenus dans ces os, spécifiques de l’environnement dans lequel un animal a vécu, ont quant à eux montré que les oiseaux avaient été élevés dans l’environnement local. Il s’agit de la trace la plus ancienne de translocation de l’espèce, son déplacement dans une région dans laquelle elle ne vivrait pas naturellement. Or un tel déplacement, sur des milliers de kilomètres et vers un environnement très différent, nécessite une connaissance fine du dindon et de ses besoins ainsi que des compétences zootechniques certaines. C’est donc l’aboutissement de plusieurs générations d’interactions et de rapprochement dans la région où le dindon commun se trouve naturellement, probablement sur la côte du golfe du Mexique ou dans le centre du Mexique, près de l’actuelle ville de Mexico. Au fil du temps, le nombre de restes de dindon augmente dans les sites archéologiques jusqu’à l’arrivée des Européens au XVIe siècle.

Dans le sud-ouest des États-Unis, à la convergence de l’Utah, du Colorado, du Nouveau-Mexique et de l’Arizona, on sait que les dindons étaient déjà présents il y a environ 10 000 ans, au début de la période holocène mais ils sont particulièrement rares dans les sites archéologiques.

Ce n’est qu’entre le début et 200 de notre ère qu’on voit leurs ossements apparaître régulièrement dans les sites archéologiques, bien qu’en faible proportion. Les traces les plus abondantes de leur présence sont leurs crottes (que l’on appelle coprolithes une fois fossilisées, dans le registre archéologique) retrouvées en particulier dans des structures en briques de terre crue complétées de branches qui servaient probablement à maintenir les dindons en captivité.

Des oiseaux convoités pour leurs plumes

Ces oiseaux appartiennent à une lignée génétique différente de celle des dindons sauvages locaux et l’analyse des isotopes du carbone contenu dans leurs os indique qu’ils ont consommé de grandes quantités de maïs. Ce sont donc des oiseaux captifs, certainement domestiques, mais on retrouve rarement leurs os dans ce que les archéologues étudient le plus, les poubelles des maisons. Ils n’auraient donc pas été mangés, ou assez rarement par rapport aux efforts mis en place pour les garder sur les sites. Les plumes d’oiseaux étaient néanmoins importantes pour ces populations et on retrouve notamment des fragments de plumes de dindon incluses dans le tissage d’une couverture en fibre en yucca. Une seule couverture aurait nécessité plus de 11 000 plumes, soit cinq à dix oiseaux selon la taille des plumes sélectionnées. Les oiseaux maintenus en captivité auraient ainsi pu être plumés régulièrement pour fournir cette matière première.

Au fil du temps, l’usage de dindons domestiques s’étend entre cette région du sud-ouest des États-Unis, le Mexique et l’Amérique centrale, mais les dindons sauvages restent bien présents dans l’environnement. Dans l’est des États-Unis, en revanche, si les restes osseux de dindons peuvent être abondants sur les sites archéologiques, il s’agit d’oiseaux sauvages chassés. C’est une mosaïque d’usage du dindon que les Européens ont ainsi rencontré à leur arrivée sur le continent américain [figure 3].

Poules d’Inde

C’est lors du quatrième voyage de Christophe Colomb en Amérique, alors qu’il explore les côtes de l’actuel Honduras, que l’on trouve ce qui peut être la première rencontre entre des Européens et des dindons, en 1502. On ne sait pas exactement comment leur réputation atteint l’Europe, probablement à travers les premières villes européennes construites dans les Antilles, mais en 1511 une lettre est envoyée par la couronne d’Espagne au trésorier en chef des Indes (les Antilles) demandant à ce que chaque bateau revenant vers la péninsule rapporte des « poules d’Inde » (d’où la contraction « dinde » apparue au XVIIe siècle en français), mâle et femelle, en vue de leur élevage.

En 1520, l’évêque d’Hispaniola (île englobant aujourd’hui Haïti et la République dominicaine) offre à Lorenzo Pucci, cardinal à Rome, un couple de dindons.

L’ouvrage publié au Muséum national d’histoire naturelle montre la multiplication des témoignages de la présence du dindon dans l’entourage de l’aristocratie européenne au cours du XVIe siècle. En France, en 1534, on trouve des dindons à Alençon, en Normandie, dans le château de Marguerite d’Angoulême, sœur de François Ier et reine de Navarre.

C’est aussi en 1534 qu’une amusante histoire se déroule en Estonie, où l’évêque de Tartu envoie un dindon en présent au duc Glinski – dindon qu’il avait précédemment reçu d’Allemagne. Mais l’oiseau exotique se répand aussi progressivement dans les basses-cours et sa consommation se généralise.

Entre le XVIe et le XVIIe siècle, il accompagne de nombreuses missions maritimes commerciales, atteignant même le Japon et revenant en Amérique – depuis l’Europe – dans les établissements coloniaux. Il semble toutefois être longtemps resté réservé aux repas de fêtes, et ce n’est qu’au cours du XXe siècle, avec l’essor de l’industrie agroalimentaire et la sélection de races de plus en plus lourdes, que sa viande entre dans la production de nombreux produits transformés. Finalement, l’animal complet, rôti et dressé sur une table à l’occasion de Thanksgiving ou de Noël, conserve la trace de cette longue histoire.

Aurélie Manin a reçu des financements des Actions Marie Sklodowska-Curie pour réaliser ce travail.

27.11.2025 à 11:51

Le climat est-il vraiment seul responsable de l’augmentation du degré d’alcool des vins ?

Léo Mariani, Anthropologue, Maître de conférence Habilité à diriger des recherches, Muséum national d’histoire naturelle (MNHN)

Texte intégral (3408 mots)

La précocité des vendanges que l’on observe depuis quelques années a été favorisée par le changement climatique. Mais la hausse du degré d’alcool dans les vins est aussi le fruit d’une longue tradition qui emprunte à l’histoire, au contexte social et aux progrès techniques, et qui a façonné la définition moderne des appellations d’origine protégée. Autrement dit, le réchauffement du climat et celui des vins, entraîné par lui, ne font qu’exacerber un phénomène ancien. C’est l’occasion d’interroger tout un modèle vitivinicole.

Dans l’actualité du changement climatique, la vitiviniculture a beaucoup occupé les médias à l’été 2025. En Alsace, les vendanges ont débuté un 19 août. Ce record local traduit une tendance de fond : avec le réchauffement des températures, la maturité des raisins est plus précoce et leur sucrosité plus importante. Cela a pour effet de bouleverser les calendriers et d’augmenter le taux d’alcool des vins.

La précocité n’est pas un mal en soi. Le millésime 2025 a pu être ainsi qualifié de « très joli » et de « vraiment apte à la garde » par le président d’une association de viticulteurs alsaciens. Ce qui est problématique en revanche, c’est l’augmentation du degré d’alcool : elle est néfaste pour la santé et contredit l’orientation actuelle du marché, plutôt demandeur de vins légers et fruités. Autrement dit, le public réclame des vins « à boire » et non « à garder », alors que la hausse des températures favorise plutôt les seconds.

Il faudrait préciser pourtant que l’augmentation des niveaux d’alcool dans les vins n’est pas nouvelle. Elle est même décorrélée du changement climatique :

« Les vins se sont réchauffés bien avant le climat »,

me souffle un jour un ami vigneron. Autrement dit, l’augmentation du degré d’alcool dans les vins a suivi un mouvement tendanciel plus profond au cours de l’histoire, dont on va voir qu’il traduit une certaine façon de définir la « qualité du vin ».

Se pose donc la question de savoir qui a « réchauffé » qui le premier ? Le climat en portant à maturité des grappes de raisins plus sucrées ? ou le savoir-faire des viticulteurs, qui a favorisé des vins plus propices à la conservation – et donc plus alcoolisés ? Postulons que le climat ne fait aujourd’hui qu’exacerber un problème qu’il n’a pas créé le premier. En lui faisant porter seul la responsabilité de la hausse de l’alcool dans les vins, on s’empêche de bien définir ce problème.

De plus, on inverse alors le sens des responsabilités : la vitiviniculture, en tant qu’activité agricole émettrice de gaz à effet de serre, participe à l’augmentation des températures – et cela bien avant que le changement climatique ne l’affecte en retour.

À lire aussi : Vin et changement climatique, 8 000 ans d’adaptation

Quand la définition des AOP fait grimper les degrés

Disons-le sans détour, l’instauration des appellations d’origine protégée AOP constitue un moment objectif de la hausse des taux d’alcool dans les vins. Dans certaines appellations du sud-est de la France, où j’ai enquêté, elle est parfois associée à des écarts vertigineux de deux degrés en trois à dix ans.

Il faut dire que les cahiers des charges des AOP comportent un « titre alcoométrique volumique naturel minimum » plus élevé que celui des autres vins : l’alcool est perçu comme un témoin de qualité.

Mais il n’est que le résultat visible d’une organisation beaucoup plus générale : si les AOP « réchauffent » les vins, souvent d’ailleurs bien au-delà des minima imposés par les AOP, c’est parce qu’elles promeuvent un ensemble de pratiques agronomiques et techniques qui font augmenter mécaniquement les niveaux d’alcool.

C’est ce paradigme, qui est associé à l’idée de « vin de garde », dont nous allons expliciter l’origine.

Les « vins de garde » se généralisent sous l’influence de l’État, de la bourgeoisie et de l’industrie

Contrairement à une idée répandue, le modèle incarné par les AOP n’est pas représentatif de l’histoire vitivinicole française en général.

Les « vins de garde » n’ont rien d’un canon immuable. Longtemps, la conservation des vins n’a intéressé que certaines élites. C’est l’alignement progressif, en France, des intérêts de l’une d’elles en particulier, la bourgeoisie bordelaise du XIXe siècle, de ceux de l’État et de ceux de l’industrie chimique et pharmaceutique, qui est à l’origine de la vitiviniculture dont nous héritons aujourd’hui.

L’histoire se précipite au milieu du XIXe siècle : Napoléon III signe alors un traité de libre-échange avec l’Angleterre, grande consommatrice de vins, et veut en rationaliser la production. Dans la foulée, son gouvernement sollicite deux scientifiques.

Au premier, Jules Guyot, il commande une enquête sur l’état de la viticulture dans le pays. Au second, Louis Pasteur, il confie un objectif œnologique, car l’exportation intensive de vins ne demande pas seulement que l’on gère plus efficacement la production. Elle exige aussi une plus grande maîtrise de la conservation, qui offre encore trop peu de garanties à l’époque. Pasteur répondra en inventant la pasteurisation, une méthode qui n’a jamais convaincu en œnologie.

À lire aussi : Louis Pasteur : l’empreinte toujours d’actualité d’un révolutionnaire en blouse

Sur le principe, la pasteurisation anticipe toutefois les grandes évolutions techniques du domaine, en particulier le développement du dioxyde de soufre liquide par l’industrie chimique et pharmaceutique de la fin du XIXe siècle. Le dioxyde de soufre (SO2) est un puissant conservateur, un antiseptique et un stabilisant.

Il va permettre un bond en avant dans la rationalisation de l’industrie et de l’économie du vin au XXe siècle (les fameux sulfites ajoutés pour faciliter la conservation), au côté d’autres innovations techniques, comme le développement des levures chimiques. En cela, il va être aidé par la bourgeoisie française, notamment bordelaise, qui investit alors dans la vigne pour asseoir sa légitimité. C’est ce groupe social qui va le plus bénéficier de la situation, tout en contribuant à la définir. Désormais, le vin peut être stocké.

Cela facilite le développement d’une économie capitaliste rationnelle, incarnée par le modèle des « vins de garde » et des AOP ainsi que par celui des AOC et des « crus ».

Ce qu’il faut pour faire un vin de garde

Bien sûr ce n’est pas, en soi, le fait de pouvoir garder les vins plus longtemps qui a fait augmenter les taux d’alcool. Mais l’horizon esthétique que cette capacité a dessiné.

Un vin qui se garde, c’est en effet un vin qui contient plus de tanins, car ceux-ci facilitent l’épreuve du temps. Or pour obtenir plus de tanins, il faut reculer les vendanges et donc augmenter les niveaux d’alcool, qui participent d’ailleurs aussi à une meilleure conservation.

Ensuite, la garde d’un vin dépend du contenant dans lequel il est élevé. En l’espèce, c’est le chêne, un bois tanique qui a été généralisé (déterminant jusqu’à la plantation des forêts françaises). Il donne aujourd’hui les arômes de vanille aux vins de consommation courante et le « toasté » plus raffiné de leurs cousins haut de gamme.

La garde d’un vin dépend également des choix d’encépagement. En l’espèce, les considérations relatives à la qualité des tanins et/ou à la couleur des jus de raisin ont souvent prévalu sur la prise en compte de la phénologie des cépages (c’est-à-dire, les dates clés où surviennent les événements périodiques du cycle de vie de la vigne).

Ceci a pu favoriser des techniques de sélection mal adaptées aux conditions climatiques et des variétés qui produisent trop d’alcool lorsqu’elles sont plantées hors de leur région d’origine, par exemple la syrah dans les Côtes du Rhône septentrionales.

En effet, la vigne de syrah résiste très bien à la chaleur et les raisins produisent une très belle couleur, raison pour laquelle ils ont été plantés dans le sud. Mais le résultat est de plus en plus sucré, tanique et coloré : la syrah peut alors écraser les autres cépages dans l’assemblage des côtes-du-rhône.

On pourrait évoquer enfin, et parmi beaucoup d’autres pratiques techniques, les vendanges « en vert », qui consiste à éclaircir la vigne pour éviter une maturation partielle du raisin et s’assurer que la vigne ait davantage d’énergie pour achever celle des grappes restant sur pied. Ceci permet d’augmenter la concentration en arômes (et la finesse des vins de garde), mais aussi celle du sucre dans les raisins (et donc d’alcool dans le produit final).

C’est tout un monde qui s’est donc organisé pour produire des vins de garde, des vins charpentés et taillés pour durer qui ne peuvent donc pas être légers et fruités, comme semblent pourtant le demander les consommateurs contemporains.

« Sans sulfites », un nouveau modèle de vins « à boire »

Ce monde, qui tend à réchauffer les vins et le climat en même temps, n’est pas représentatif de l’histoire vitivinicole française dans son ensemble. Il résulte de la généralisation d’un certain type de rapport économique et esthétique aux vins et à l’environnement.

C’est ce monde dans son entier que le réchauffement climatique devrait donc questionner lorsqu’il oblige, comme aujourd’hui, à ramasser les raisins de plus en plus tôt… Plutôt que l’un ou l’autre de ces aspects seulement.

Comme pistes de réflexion en ce sens, je propose de puiser l’inspiration dans l’univers émergent des vins « sans soufre » (ou sans sulfites) : des vins qui, n’étant plus faits pour être conservés, contiennent moins d’alcool. Ces vins sont de surcroît associés à beaucoup d’inventivité technique tout en étant écologiquement moins délétères, notamment parce qu’ils mobilisent une infrastructure technique bien plus modeste et qu’ils insufflent un esprit d’adaptation plus que de surenchère.