ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

06.10.2025 à 16:26

Nicolas Sarkozy condamné à une incarcération sans attendre son appel : pourquoi cette « exécution provisoire » est banale

Vincent Sizaire, Maître de conférence associé, membre du centre de droit pénal et de criminologie, Université Paris Nanterre – Alliance Paris Lumières

Texte intégral (1748 mots)

De nombreuses critiques ont été formulées à l’encontre du jugement condamnant Nicolas Sarkozy à une incarcération « avec mandat de dépôt à effet différé assorti d’une exécution provisoire », c’est-à-dire sans attendre l’issue de sa procédure d’appel. Cette exécution provisoire de la peine d’emprisonnement est pourtant banale. En 2022, 55 % des peines d’emprisonnement ferme prononcées par le tribunal correctionnel ont ainsi été mises à exécution immédiatement. En revanche, on peut considérer que les règles encadrant l’exécution provisoire en matière répressive posent question du point de vue de l’État de droit.

Parmi les polémiques relatives à la condamnation de l’ancien chef de l’État, le 25 septembre dernier, l’exécution provisoire de la peine d’emprisonnement (le fait qu’elle soit appliquée même en cas d’appel) qui lui a été infligée figure en très bonne place. Comme la plupart des commentaires à l’emporte-pièce qui saturent l’espace médiatique depuis le prononcé du jugement, ces critiques viennent généralement nourrir la thèse, sinon du complot, du moins de « l’acharnement judiciaire » plus ou moins idéologique dont serait victime l’ancien locataire de l’Élysée. Elles se distinguent néanmoins des autres en ce qu’elles ne s’appuient pas sur des spéculations plus ou moins délirantes sur le contenu d’un dossier que, par hypothèse, aucune des personnes extérieures à la procédure ne connaît, mais sur une réalité juridique et humaine indéniable : Nicolas Sarkozy va devoir exécuter sa peine sans attendre la décision de la Cour d’appel. Une réalité qui peut fort légitimement choquer toute personne un tant soit peu attachée à la présomption d’innocence et au droit au recours, favorisant ainsi la réception de la théorie d’une vengeance judiciaire, théorie qui permet d’occulter une opposition beaucoup plus profonde à l’idée même d’égalité devant la loi.

Pour en finir avec ce mythe, il est donc nécessaire d’apporter un éclairage particulier sur la question de l’exécution provisoire en montrant que, si son régime et son application sont porteuses de réelles difficultés d’un point de vue démocratique, ces difficultés sont loin de concerner spécifiquement les classes dirigeantes.

Ce que dit la loi de l’exécution provisoire

En premier lieu, rappelons que, contrairement à ce que laissent entendre les contempteurs les plus acharnés du prétendu « gouvernement des juges », la possibilité d’assortir un jugement de l’exécution provisoire est bien prévue par la loi et n’a pas été inventée pour les besoins de la cause par le tribunal correctionnel. Depuis le droit romain, notre ordre juridique a toujours ménagé la faculté, pour les juridictions, de rendre leur décision immédiatement exécutoire dans les hypothèses où le retard pris dans sa mise en application serait de nature à compromettre durablement les droits des justiciables, en particulier dans les situations d’urgence. C’est pourquoi, par exemple, les ordonnances de référé, qui visent à prévenir un dommage imminent (suspension de travaux dangereux, d’un licenciement abusif, injonction à exécuter un contrat affectant la pérennité d’une entreprise) sont, depuis le Code de procédure civile de 1806, exécutoires par provision.

En matière pénale, la question se pose cependant de façon différente en ce sens que l’exécution provisoire porte atteinte non seulement au droit au recours contre une décision de justice, mais également à la présomption d’innocence. Or, ces deux principes sont protégés tant par la Constitution – le Conseil constitutionnel les ayant respectivement consacrés en 1981 et en 1996 – que par la Convention européenne de sauvegarde des droits de l’homme et des libertés fondamentales. Ce qui ne signifie pas que ces garanties soient absolues, mais que le législateur ne peut y porter atteinte que de façon exceptionnelle, en fixant des critères précis et en veillant à ce que l’atteinte demeure nécessaire et proportionnée. C’est ainsi, par exemple, que la détention provisoire – ordonnée avant toute déclaration de culpabilité et avant même la phase d’audience – ne peut être prononcée que s’il est démontré qu’elle constitue l’unique moyen de sécuriser les investigations (éviter la destruction de preuves, des concertations entre auteurs) ou de s’assurer de la mise à disposition de la personne mise en examen (éviter le risque de fuite, de renouvellement des faits).

Or aucune garantie de cette nature n’est prévue par la loi quand l’exécution provisoire est prononcée par une juridiction pénale lorsqu’elle prononce une sanction à l’égard d’une personne. Le Code de procédure pénale ne fixe aucun critère pour déclarer immédiatement exécutoire telle ou telle sanction, qu’il s’agisse d’une peine d’amende, de probation ou d’emprisonnement, se bornant à exiger du tribunal qu’il motive spécifiquement sa décision sur ce point. C’est ce qu’a fait le tribunal dans la condamnation de Nicolas Sarkozy, en considérant que l’exécution provisoire s’imposait en raison de la particulière gravité des faits. La seule exception concerne le mandat de dépôt prononcé à l’audience (c’est-à-dire l’incarcération immédiate du condamné) assortissant une peine de prison inférieure à un an, dont le prononcé est subordonné aux mêmes conditions que la détention provisoire. En outre, alors qu’en matière civile, la personne peut toujours demander au premier président de la Cour d’appel de suspendre l’exécution provisoire du jugement de première instance, la loi pénale ne prévoit aucune possibilité similaire, la personne condamnée devant subir sa peine nonobstant l’exercice du recours. Ainsi, il est vrai de dire que les règles encadrant aujourd’hui le prononcé de l’exécution provisoire en matière répressive, en ce qu’elles ne garantissent pas suffisamment le caractère nécessaire et proportionné de cette mesure, posent question du point de vue des exigences de l’État de droit démocratique. Pour y remédier, il faudrait que la loi fixe de façon précise et limitative les conditions pour prononcer l’exécution provisoire, par exemple en prévoyant qu’elle n’est possible que si l’on peut légitimement craindre que la personne cherche à se soustraire à sa sanction.

Un recours massif lors des comparutions immédiates

En revanche, il est complètement faux d’affirmer que cette pratique ne concernerait que les membres de la classe politicienne. Le cadre juridique particulièrement permissif que nous venons d’évoquer favorise au contraire la généralisation du recours à l’exécution provisoire en matière pénale.

En 2022, 55 % des peines d’emprisonnement ferme prononcées par le tribunal correctionnel ont ainsi été mises à exécution immédiatement – ce taux monte à 87 % pour les personnes poursuivies en comparution immédiate. En d’autres termes, loin de constituer une mesure exceptionnelle qui trahirait une démarche vindicative ou un abus de pouvoir de la part des magistrats, l’exécution provisoire qui assortit la condamnation de l’ancien chef de l’État – comme celle de la présidente du Rassemblement national (RN) – constitue une mesure particulièrement commune, pour ne pas dire tristement banale.

C’est ainsi que, dans un communiqué du 27 septembre dernier, l’association des avocats pénalistes

« se réjouit de constater que politiques et médias prennent enfin conscience des difficultés posées par l’infraction d’association de malfaiteurs et par la contradiction inhérente à l’exécution provisoire d’une décision frappée d’appel »

(en ce qu’elle oblige le condamné à purger sa peine sans attendre l’issue du recours), mais

« rappelle cependant que ces modalités sont appliquées tous les jours à des centaines de justiciables sous l’œil courroucé des éditorialistes et gouvernants qui fustigeaient jusqu’alors une justice laxiste ».

Il s’agit là d’une autre vertu de l’exigence d’égalité juridique lorsqu’elle pleinement et véritablement appliquée. Plus les membres des classes dirigeantes et, en particulier, celles et ceux qui contribuent directement ou indirectement à l’écriture de la loi, auront conscience qu’elle peut potentiellement s’appliquer à leur personne, plus l’on peut espérer qu’ils se montrent sensibles, d’une façon générale, au respect des droits de la défense. Une raison supplémentaire de sanctionner, à sa juste mesure, la délinquance des puissants.

Vincent Sizaire ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

06.10.2025 à 16:24

Accès au logement : la couleur de peau plus discriminante que le nom

Élisabeth Tovar, Maîtresse de conférences en sciences économiques, Université Paris Nanterre – Alliance Paris Lumières

Laetitia Tuffery, Maîtresse de conférences en économie, Université de Nîmes

Marie-Noëlle Lefebvre, Enseignante-Chercheuse en sciences économiques, Université Paris-Panthéon-Assas

Mathieu Bunel, Maître de conférences en Économie, Université Bourgogne Europe

Texte intégral (1290 mots)

Locataire noir ou blanc : qui l’agent immobilier préférera-t-il ? Notre expérience révèle les ressorts méconnus de la discrimination dans la location de logements.

Chercher un logement peut vite tourner au parcours du combattant, surtout quand on s’appelle Mohamed ou Aïssata. En France, en 2017, 14 % des personnes ayant cherché un logement au cours des cinq années précédentes disaient avoir subi des discriminations, selon la dernière enquête sur la question, menée par le défenseur des droits.

Mais comment ces discriminations fonctionnent-elles concrètement ? Qu’est-ce qui pèse le plus : la couleur de peau, le nom, le salaire, ou encore les préjugés du propriétaire ?

Pour le découvrir, nous avons mené une expérience inédite avec 723 étudiants d’une école immobilière, confrontés à des dossiers de locataires fictifs. Les résultats bousculent plusieurs idées reçues.

Un appartement, trois candidats

Imaginez : vous êtes agent immobilier et devez évaluer trois candidats pour un appartement de trois pièces. Trois candidats se présentent :

Éric Pagant, un informaticien blanc, 3 400 euros nets mensuels ;

Mohamed Diop, un ambulancier en intérim noir, 1 800 euros nets mensuels ;

Kévin Cassin, un enseignant fonctionnaire blanc, célibataire, 1 845 euros nets mensuels.

Vous devez noter chaque candidat en le notant de 1 à 4, selon, d’une part, le degré de satisfaction de votre client, le propriétaire, en cas de location au candidat et, d’autre part, votre intention d’organiser une visite de l’appartement avec le candidat.

Dans notre expérience, nous avons fait varier les éléments des profils des candidats : parfois, c’est Mohamed Diop, un homme noir, qui est informaticien, parfois, il a un nom français (Philippe Rousseau), parfois, sa photo n’apparaît pas, parfois le propriétaire exprime des préférences discriminatoires… Ce protocole nous a permis de mesurer l’effet réel de chacune de ces caractéristiques sur les notes obtenues par les candidats.

La couleur de peau compte plus que le nom

Contrairement à ce qu’on pourrait penser, avoir un nom à consonance étrangère pénalise moins qu’être visiblement Noir sur une photo. Quand Mohamed Diop concourt sans photo, avec seulement son nom africain, son handicap face à Éric Pagant, le candidat blanc, est de 0,6 point sur 4. Mais quand sa photo révèle sa couleur de peau, même avec un nom français l’écart grimpe à 1,7 point !

Cette découverte est importante, car la plupart des études scientifiques sur la discrimination se basent sur les noms, pas sur les photos. Elles sous-estiment peut-être la réalité vécue par les personnes racisées qui se présentent physiquement aux visites.

Protection relative du statut social

Certes, avoir un bon salaire protège un peu les candidats noirs contre la discrimination. Nos répondants accordent une importance particulière au revenu des futurs locataires : indépendamment de leur couleur de peau, les informaticiens ont un avantage de 1,55 point (sur 4) par rapport aux ambulanciers. Cela veut dire qu’un candidat noir informaticien sera mieux noté que tous les candidats ambulanciers, Blancs comme Noirs.

C’est troublant : au sein des candidats aisés, la pénalité subie par les Noirs par rapport aux Blancs est plus forte (-0,32 point) qu’entre candidats modestes (-0,22 point), comme si certains répondants avaient du mal à accepter qu’une personne noire puisse être à égalité avec une personne blanche ayant un statut social élevé.

Propriétaires discriminants

L’expérience révèle aussi que les agents immobiliers amplifient les préjugés de leurs clients.

Quand le propriétaire ne manifeste aucune préférence ethnique, la discrimination disparaît complètement entre candidats blancs et noirs (-0,048 point sur 4). C’est une bonne nouvelle : les futurs professionnels de l’immobilier que nous avons testés ne montrent pas de racisme personnel.

Mais dès que le propriétaire exprime sa réticence à louer « à des gens issus de minorités ethniques », l’écart entre les candidats noirs et blancs se creuse (-0,48 point pour les candidats noirs) – même si une telle demande est tout à fait illégale ! C’est une illustration du mécanisme de « client-based discrimination », bien connu en théorie économique.

Effet de minorité

Dernier élément marquant : un candidat noir est moins bien noté (avec une pénalité de -0,34 point) quand il concourt contre deux candidats blancs (comme dans la première ligne de la figure ci-dessous) que quand il fait face à d’autres candidats noirs (comme dans la deuxième ligne de la figure ci-dessous). À l’inverse, être Blanc face à des candidats noirs ne procure aucun avantage particulier.

Ce résultat montre l’existence d’un « effet de minorité » jouant en défaveur des personnes racisées qui chercheraient à se loger hors de quartier ségrégé.

« Premier arrivé, premier servi »

Ces résultats pointent vers des solutions concrètes.

Plutôt que de miser uniquement sur la formation des professionnels, il faudrait s’attaquer aux préjugés des propriétaires et limiter leur influence, en protégeant les professionnels des attentes de leurs clients. Pour cela, certaines villes états-uniennes, comme Seattle et Portland, ont adopté le principe du « premier arrivé, premier servi » pour empêcher la sélection discriminatoire.

Sans aller jusque-là, l’anonymisation des dossiers de location ou l’obligation de motiver les refus, avec signature du propriétaire, pourraient être des pistes à explorer.

Une autre piste pourrait être l’utilisation systématique de mémentos listant les points d’attention pour louer sans discriminer, comme ceux qui sont proposés, en France, par le défenseur des droits à l’attention des propriétaires et des professionnels de l’immobilier.

Quoi qu’il en soit, ces leviers d’action ne sont pas coûteux à mettre en place, mais cela nécessite l’implication de tous les acteurs du secteur.

Élisabeth Tovar a reçu des financements de l'Agence Nationale de la Recherche.

Mathieu Bunel est membre de la Fédération de recherche Tepp Théories et évaluations des politiques publiques.

Laetitia Tuffery et Marie-Noëlle Lefebvre ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.

05.10.2025 à 16:22

CNews contre les médias publics : une mise à mort du journalisme ?

Alexandre Joux, Professeur en Sciences de l’information et de la communication, Aix-Marseille Université (AMU)

Texte intégral (2106 mots)

Le conflit entre les médias du groupe Bolloré et le service public de l’audiovisuel interroge les fondements mêmes du journalisme et d’une « information impartiale ». Aux États-Unis, la montée en puissance de Fox News face à CNN dans les années 2000 avait consacré une culture de médias d’opinon et affaibli la culture journalistique. La France suivra-t-elle le même chemin ?

La vidéo montrant les journalistes de France Inter et de France Télévisions Thomas Legrand et Patrick Cohen en rendez-vous avec des cadres du Parti socialiste (PS) est à l’origine d’une confrontation inédite entre porte-paroles de CNews et d’Europe 1, et les représentants de l’audiovisuel public. Le 16 septembre 2025, Delphine Ernotte, présidente de France Télévisions, a qualifié CNews de « chaîne d’extrême droite ». Pascal Praud, animateur vedette de la chaîne, a immédiatement réagi en soulignant la politisation de l’audiovisuel public à gauche.

Cette séquence interroge les fondements mêmes du journalisme et des médias d’information. Un « journalisme honnête » ou objectif est-il possible ? Les médias sont-ils au contraire condamnés à exprimer des opinions portées par des lignes politiques ? Cette séquence peut être interprétée à l’aune du « moment Fox News » qui a transformé le paysage médiatique américain dans les années 2000.

Le moment Fox News aux États-Unis

Dès 1949, aux États-Unis, les médias audiovisuels, la radio puis la télévision, sont soumis à un devoir de pluralisme interne imposé par l’autorité qui les régule, la Federal Communications Commission (FCC). Les mass media étant suspectés d’exercer une grande influence sur leurs publics, la fairness doctrine (la « doctrine de l’impartialité », en français) limite les possibilités de les mettre au service d’une cause, en exigeant une couverture « fair and balanced » (« juste et équilibrée ») sur les sujets controversés.

La distribution de bouquets de chaînes par le câble, puis par le satellite, en permettant une plus grande diversité de l’offre de chaînes d’information, conduira à l’abrogation de la fairness doctrine en 1987. C’est dans ce contexte que naît Fox News, en 1996.

Dans les années 2000, Fox News va dénoncer un biais libéral dans les médias se revendiquant « fair », notamment CNN. Pour Fox News, ces médias seraient en fait de gauche, mais ils ne l’avouent pas et revendiquent une information impartiale pour mieux faire avancer leur agenda politique. Du point de vue de Fox News, le pluralisme obligatoire à l’antenne de 1949 à 1987 n’a jamais vraiment existé : l’objectivité, c’est les faits, leur interprétation est toujours politique. Le pluralisme va exister désormais, mais autrement : avec la suppression de la fairness doctrine, il est possible de faire du journalisme d’opinion à la télévision.

Fox News souhaite alors « rééquilibrer » le paysage audiovisuel américain en proposant une chaîne d’information très à droite. La chaîne conçoit l’équilibre des points de vue au niveau du paysage médiatique global. C’est ce que nous connaissons en France sous le nom de « pluralisme externe », comme dans la presse par exemple, où des titres aux colorations politiques différentes permettent de couvrir la totalité du spectre des opinions politiques.

Dans les années 2000, Fox News va supplanter CNN et devenir la première chaîne d’information aux États-Unis. Son ton critique, ultraconservateur, va fédérer des audiences très engagées et lui assurer de confortables revenus publicitaires, qui inciteront les autres chaînes à l’imiter. Le niveau de critique va globalement monter, CNN devenir de plus en plus prodémocrate (la chaîne est connue pour son opposition à Trump) quand Fox News deviendra la porte-parole de Trump avant qu’il ne soit élu une première fois en 2016.

La polarisation des médias aux États-Unis se superpose finalement à la polarisation idéologique de la société, au point de rendre le journalisme impossible : la confusion s’est opérée entre ligne éditoriale et exigence journalistique. Les lignes éditoriales marquées des médias d’information finissent par conduire les rédactions à se désintéresser de pans entiers du réel, pour ne retenir que les faits, les propos qui semblent répondre à leur lecture du monde et aux attentes de leurs audiences.

Cnews, Fox News, même combat ?

Finalement, Fox News a lancé aux États-Unis le débat que la polémique CNews/audiovisuel public incarne actuellement. Les médias qui se disent impartiaux seraient en fait de gauche ; les idées de la droite conservatrice seraient sous-représentées dans les médias et un rééquilibrage nécessaire.

Reste que la France, contrairement aux États-Unis, a encore, une « fairness doctrine » : pour les chaînes qui disposent d’une fréquence, l’Arcom impose de « faire respecter l’expression pluraliste des courants de pensée et d’opinion à la télévision ». Mais cette exigence est-elle respectée ? On peut en douter, en suivant la décision du Conseil d’État du 13 février 2024 qui a constaté un manquement de l’Arcom relatif au pluralisme interne de certaines chaînes, à la suite d’une plainte de RSF relative à Cnews. Le Conseil d’État a finalement considéré que le pluralisme ne se réduisait pas au temps de parole des politiques à la télévision, et qu’il fallait également considérer les opinions des chroniqueurs et des invités. À l’avenir, cette nouvelle grille d’analyse pourrait permettre de qualifier CNews, et d’autres, de chaînes d’opinion – mais également nous amener à comprendre que notre situation se rapproche de celle des États-Unis.

Réflexions sur le journalisme impartial et ses limites

Le débat initié par Fox News ou par CNews nous amène plus fondamentalement à réfléchir à la possibilité d’un journalisme impartial.

Rappelons que de nombreuses études universitaires des années 1970-1980 ont amené à une réflexion critique concernant les pratiques journalistiques. Ces études ont montré que les rédactions et leurs journalistes ne sont pas vraiment autonomes, qu’ils ont des routines, des « prêts-à-penser », des manières de faire qui leur empêchent souvent de traiter correctement des choses. C’est encore à cette époque que la recherche va questionner de nouveau le rôle des médias dans la fabrique de l’ordre du jour politique, à travers la notion d’agenda setting, c’est-à-dire le processus par lequel certains sujets s’imposent dans les médias et surtout la manière d’en parler.

Mais ces études avaient pour ambition d’améliorer le journalisme en documentant ses limites pour que les rédactions, ensuite, apprennent à se prémunir de leurs propres travers. Il ne s’agissait pas de discréditer l’objectif d’impartialité, mais de dire que le journalisme supposait une vigilance permanente par rapport aux préjugés, aux sources, aux intentions non avouées, aux contextes, etc.

Au-delà de la pratique journalistique et de ses exigences, cette réflexion conduit à distinguer la ligne éditoriale des médias et la manière de traiter les sujets.

L’incarnation de la ligne éditoriale relève de ce que l’on nomme en journalisme le « gate keeping », à savoir le choix des sujets qui seront portés à la connaissance du public parmi tous les faits et déclarations. Ce gate keeping n’est pas sans défauts, l’évaluation de ce qu’est une information importante (newsworthiness, dans le journalisme anglosaxon) est toujours discutable. Ces faits sont ensuite abordés d’une certaine manière, par des accroches, par des angles. C’est le cadrage de l’information (framing) qui n’est pas neutre non plus. Mais cela relève de la liberté éditoriale, qui est garantie aux États-Unis comme en France.

En revanche, une fois un sujet sélectionné, son traitement doit respecter des exigences toutes journalistiques, en se forçant à entendre aussi les lectures de la réalité portées par ceux avec qui l’on n’est pas spontanément d’accord, en donnant finalement la priorité à une exigence de présentation des faits et de leur contexte qui soit la plus complète possible et la plus rationnelle possible – c’est globalement ce que recouvre l’idéal d’objectivité journalistique.

Quand, à l’inverse, les opinions l’emportent, quand les faits sont cadrés à outrance sans prendre en considération la complexité des situations auxquelles ils renvoient, alors il ne s’agit plus d’information ni non plus de journalisme. Ces distinctions permettent de poser le débat non pas au niveau des opinions (chaîne d’extrême droite, audiovisuel public de gauche), mais des exigences journalistiques. Aux citoyens de s’en saisir ensuite pour organiser autrement leur consommation de programmes dits d’information.

Alexandre Joux ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

02.10.2025 à 17:08

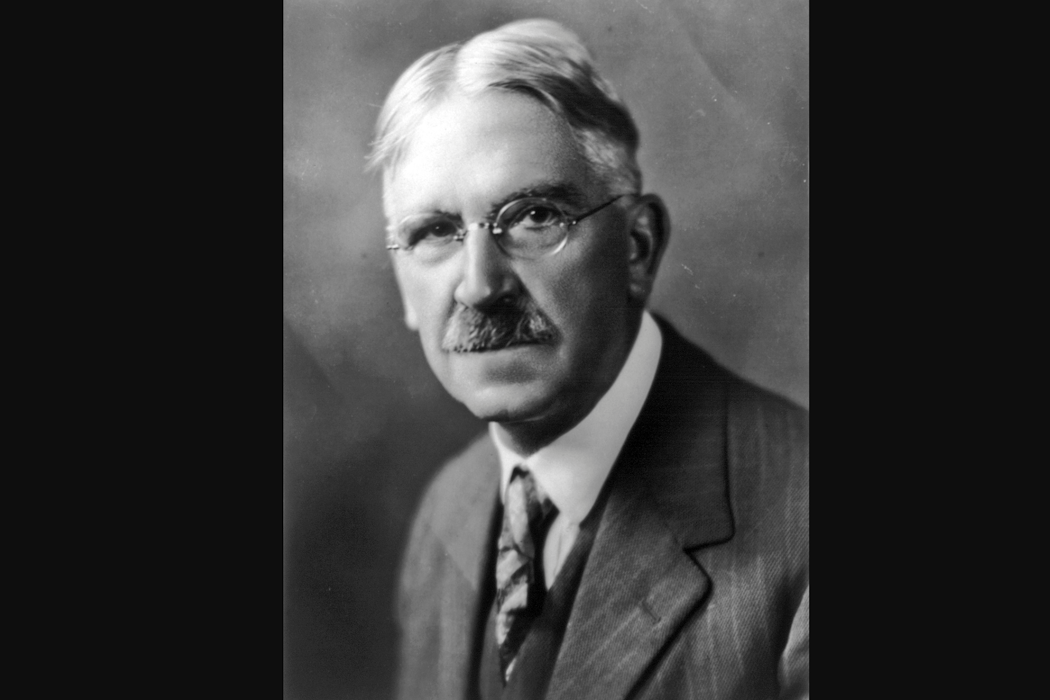

Avec John Dewey, penser la démocratie comme « enquête » collective

Patrick Savidan, Professeur de science politique, Université Paris-Panthéon-Assas

Texte intégral (2323 mots)

Notre démocratie est en crise, comment la réinventer ? Que nous enseignent ceux qui, au cours des âges, furent ses concepteurs ? Suite de notre série consacrée aux philosophes et à la démocratie avec l’Américain John Dewey (1859-1952). En plaçant l’idée d’« enquête » au cœur de la vie publique démocratique et en éliminant l’idée de « vérité absolue », il propose un modèle coopératif, orienté vers la recherche commune de solutions et admettant sa propre faillibilité.

John Dewey (1859-1952) est à la fois l’un des fondateurs du pragmatisme américain – aux côtés de Charles Sanders Peirce et William James – et le grand artisan d’une pédagogie nouvelle, active et expérimentale. Dès la fondation, en 1896, de son école expérimentale à Chicago, il s’est imposé comme l’une des figures majeures de la vie intellectuelle américaine.

Dans The Public and its Problems (1927), Dewey regrettait que « le nouvel âge des relations humaines ne dispose d’aucun mécanisme politique digne de lui ». Ce diagnostic, formulé il y a près d’un siècle, conserve aujourd’hui une résonance troublante. Les démocraties contemporaines, confrontées à des mutations techniques, sociales et économiques d’une ampleur inédite peinent à en saisir les dynamiques profondes et à y répondre de manière appropriée.

À la crise ancienne de la représentation est, en effet, venue s’associer une crise inédite de l’espace public. Tandis que la défiance envers les élus se généralise, les conditions mêmes du débat public se trouvent radicalement transformées par la révolution numérique.

Si les promesses initiales étaient immenses – savoir collaboratif avec Wikipédia, inclusion financière par le paiement mobile, accès élargi aux soins via la télémédecine, démocratisation culturelle et accélération scientifique –, les désillusions n’en sont que plus saisissantes : manipulation de l’opinion à grande échelle, instrumentalisation des réseaux sociaux par les régimes autoritaires, prolifération des récits complotistes et des infox, démultipliées par le recours à l’intelligence artificielle.

Face à ces symptômes, il serait réducteur d’évoquer une « crise de la vérité ». Ce qui vacille, ce ne sont pas tant les vérités elles-mêmes que les procédures et les médiations permettant leur élaboration collective. La vérité, loin d’avoir disparu, est menacée par des pratiques déréglées de la certitude et du doute, qui minent les conditions d’une délibération démocratique féconde.

C’est dans ce contexte que la pensée politique de John Dewey, et plus particulièrement sa conception expérimentale de la démocratie, mérite d’être réinterrogée. En plaçant l’idée d’« enquête » au cœur de la vie publique, en substituant à la notion de « vérité absolue » celle d’« assertibilité garantie », il propose un modèle coopératif, orienté vers la recherche commune de solutions et admettant sa propre faillibilité.

Une telle approche, attentive aux conditions concrètes de la connaissance partagée, offre aujourd’hui une piste féconde pour affronter les pathologies de l’espace public.

Connaître est agir

Dewey propose une réflexion forte, avertie des tentations dogmatiques de l’être humain, autrement dit, de sa propension à se ruer sur toutes les certitudes susceptibles de l’apaiser face aux périls, réels ou imaginés, qui le guettent. En ce sens, son pragmatisme est un formidable remède contre tout dogmatisme. C’est un appel à toujours remettre sur le métier la recherche du savoir, et non un quelconque congé donné au savoir.

Sa perspective est profondément marquée par un naturalisme inspiré de certaines des dimensions de l’œuvre de Darwin. Dewey envisage le développement de la connaissance en tant que processus humain d’adaptation aux conditions qui l’environnent, processus dont l’objectif est la restructuration active de ces conditions. La pensée n’est plus, comme pour la tradition, un processus dont la vigueur tient à la distance qu’elle met entre elle et le monde, mais elle se conçoit comme le produit d’une interaction entre un organisme et son environnement.

Dewey a appliqué cette conception de la connaissance à la notion d’enquête. C’est ce qui explique l’intensité de son rapport au réel. Il ne s’agit pas de s’inventer de faux problèmes, mais de partir d’une difficulté qui bloque le progrès et de trouver un moyen satisfaisant de la surmonter.

Politique de l’enquête

Dans ce contexte, Dewey distingue trois étapes. L’enquête débute par l’expérience d’une situation problématique, c’est-à-dire une situation qui met en échec nos manières habituelles d’agir et de réagir. C’est en réponse à cette inadaptation que la pensée se met en mouvement et vient nourrir le processus.

La deuxième étape consiste à isoler les données qui définissent les paramètres en vertu desquels la restructuration de la situation initiale va pouvoir s’engager. La troisième étape consiste en un moment de réflexion qui correspond à l’intégration des éléments cognitifs du processus de l’enquête (idées, présuppositions, théories, etc.) à titre d’hypothèses susceptibles d’expliquer la formation de la situation initiale. Le test ultime du résultat de l’enquête n’est nul autre que l’action elle-même. Si la restructuration de la situation antérieure permet de libérer l’activité, alors les éléments cognitifs peuvent être tenus pour « vrais » à titre provisoire.

Cette approche vaut, selon Dewey, aussi bien pour les enquêtes engagées pour résoudre des problèmes de la vie ordinaire que pour des enquêtes scientifiques. La différence entre les deux ne tient qu’au degré de précision plus grand qui peut être requis pour pratiquer les niveaux de contrôle plus élevés qu’appellent des problèmes scientifiques.

L’enquête placée au cœur de cette forme de vie qu’est la démocratie est ainsi ancrée dans une exigence forte d’objectivité. La « dissolution des repères de la certitude » qui caractérise, comme l’écrivait Claude Lefort, la logique démocratique, est ici déjà assumée non comme un obstacle, mais bien comme une condition de la vie démocratique et des formes de coopération qu’elle appelle. La communauté citoyenne constate un problème. Elle s’efforce de le résoudre. C’est l’horizon même de toute coopération.

Ouverture à la diversité des savoirs

Il en résulte que le savoir ne saurait être la chasse gardée de savants retranchés dans un langage hyperformalisé, détaché des pratiques concrètes et des réalités vécues.

La figure du spectateur, si prégnante dans certaines théories de la connaissance (et si caractéristique des illusions dont se berce le technocrate), trahit pour Dewey un désir de domination : en excluant les non-initiés du champ du savoir, elle opère une disqualification implicite des formes d’intelligence issues de la pratique. Ce dispositif, pour lui, n’est pas seulement épistémologique : il est politique. Il fonctionne comme une justification implicite d’un ordre social inégal, dans lequel le monopole de la connaissance devient l’outil d’un pouvoir de classe. Renverser cette hiérarchie des savoirs, c’est ainsi remettre en cause les mécanismes mêmes d’une organisation économique et légale qui permet à une minorité de s’arroger le contrôle de la connaissance, en la mettant au service d’intérêts privés, plutôt que de l’orienter vers un usage partagé et démocratique.

Dewey défend une répartition plus équitable des éléments de compréhension liés aux activités sociales et au travail. Ce rééquilibrage doit rendre possible une participation plus large, plus libre, à l’usage et aux bénéfices du savoir, mais il impose aussi aux croyances ordinaires de se mettre à l’épreuve du réel, en entrant dans le processus de l’enquête et en acceptant ses exigences.

En repartant des pratiques concrètes, des problèmes réels, Dewey donne consistance à une théorie de la connaissance fondée sur la coopération, la réflexivité et la capacité d’invention collective qui, pour lui, doit figurer au cœur de toute démocratie digne de ce nom.

Démocratie et connaissances

La société humaine, telle que l’envisage Dewey, n’est pas une simple juxtaposition d’individus, mais une forme d’association fondée sur l’action conjointe, et sur la conscience, partagée, des effets que cette action produit. C’est en reconnaissant la contribution spécifique de chacun que peut émerger un intérêt commun, entendu comme la préoccupation collective pour l’action et pour l’efficacité des coopérations engagées.

Mais cet intérêt commun reste vulnérable. Lorsqu’un mode d’organisation économique exerce un pouvoir oppressif sans contrepartie, ou lorsque les institutions deviennent sourdes aux dynamiques sociales, l’équilibre se rompt. Dans de telles situations, le défi n’est évidemment pas d’ajuster les individus à l’ordre existant, mais de repenser les formes mêmes de l’association.

Selon cette perspective, les concepts, les théories et les propositions politiques sont appréhendés comme des instruments d’enquête, soumis à la vérification, à l’observation, à la révision. Cela signifie, par exemple, que les politiques publiques doivent être considérées comme des hypothèses de travail, susceptibles d’ajustements constants selon les effets qu’elles produisent. Ce n’est qu’à ces conditions que les sciences sociales pourront contribuer au déploiement d’un dispositif de connaissance apte à guider l’action démocratique.

La démocratie, ainsi comprise, tire sa force de sa capacité à organiser la discussion publique autour des besoins vécus, des déséquilibres ressentis, des tensions expérimentées. Elle repose sur la possibilité pour chacun de s’exprimer, de tester ses croyances, d’évaluer les savoirs produits par d’autres et de juger de leur pertinence face aux problèmes communs. La disponibilité de la connaissance, sa maniabilité dans l’espace public, constitue dès lors un enjeu démocratique fondamental.

À rebours de toute philosophie relativiste, Dewey montre que la « vérité » dont une démocratie peut se nourrir, doit s’élaborer dans le cadre d’une enquête ouverte, partagée, ancrée dans l’expérience.

« Aucune faculté innée de l’esprit, écrit-il dans « le Public et ses problèmes », ne peut pallier l’absence de faits. Tant que le secret, le préjugé, la partialité, les faux rapports et la propagande ne seront pas remplacés par l’enquête et la publicité, nous n’aurons aucun moyen de savoir combien l’intelligence existante des masses pourrait être apte au jugement de politique sociale. »

Une enquête démocratique ne peut s’accommoder d’un public fantôme ni d’un espace public fragmenté, polarisé, déconnecté des pratiques réelles et des problèmes concrets. Elle exige que la société prenne une part active à sa propre compréhension, qu’elle se découvre elle-même par la confrontation aux obstacles qui entravent sa capacité à se constituer en tant que public. C’est en partant des déséquilibres tels que cette collectivité les expérimente que peut s’élaborer une conscience commune minimale et s’armer notre capacité à les surmonter.

Ainsi, la connaissance, dont le public est à la fois le moteur et la finalité, peut être dite véritablement démocratique. Elle ne cherche pas à imposer une vérité depuis les hauteurs d’un savoir institué, mais fait advenir une intelligence collective, capable d’inventer les formes d’une association toujours à réajuster. À l’heure où les pathologies de l’espace public se nourrissent de la disqualification de la parole profane, des effets délétères de la fragmentation algorithmique et de la confiscation de l’autorité cognitive, la pensée de Dewey trace ainsi une voie précieuse : celle d’une démocratie de l’enquête, ouverte, inclusive, rigoureuse, résolument orientée vers l’émancipation et la répartition équitable des libertés d’agir individuelles.

Patrick Savidan ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

01.10.2025 à 16:29

Urbaniser sans artificialiser : le potentiel caché du sous-sol

Jean-Philippe Antoni, Professeur de géographie et d'urbanisme, Université Bourgogne Europe

Texte intégral (2153 mots)

La loi « visant à faciliter la mise en œuvre des objectifs de lutte contre l’artificialisation des sols et à renforcer l’accompagnement des élus locaux » (2003) entend limiter l’artificialisation des sols d’ici 2050. Pour concilier développement urbain et sobriété foncière, l’urbanisme souterrain apparaît comme une solution intéressante. Il permet de préserver les terres agricoles et les paysages tout en intégrant infrastructures, commerces ou transports sous la surface.

Dans le cadre d’un aménagement durable lié à la lutte contre le changement climatique, la loi dite « Zéro artificialisation nette » (ZAN), adoptée en 2023, suscite de nombreux débats. Pour atteindre une sobriété foncière devenue nécessaire face à l’ampleur de l’étalement urbain, elle prévoit la fin probable de toute artificialisation d’ici 2050, c’est-à-dire l’interdiction de construire sans compensation sur des espaces qui ne sont pas déjà bâtis. La loi ZAN est de ce fait perçue par certains comme une atteinte historique à la propriété privée, mais également comme un frein à l’autonomie des communes, dont le développement économique et résidentiel serait mis sous cloche. Pour s’y préparer, de nombreux projets envisagent une requalification et une densification du bâti existant, mais rares sont ceux qui proposent de mieux exploiter le sous-sol. Or, l’urbanisme souterrain est une solution déjà ancienne dont les expériences récentes confirment l’efficacité, en particulier dans les zones les plus peuplées.

L’utilisation des sous-sols est souvent mal connue du grand public pour une raison simple qui constitue aussi son principal avantage : son invisibilité. C’est généralement seulement lors des travaux de voirie que l’on découvre dans le sous-sol un foisonnement technique très divers qui regroupe autant des réseaux d’eau, de communication et d’énergie, que des caves ou des espaces de stockage, voire des équipements de transports. La majorité, sans intérêt esthétique, y ont été enfouis pour y être cachés ou pour dégager un espace équivalent à leur volume, laissant la place en surface à des espaces ouverts ou végétalisés. Cette idée a fait l’objet de plusieurs approches théoriques qui ont montré son intérêt pour les villes d’aujourd’hui.

Un nouveau rôle pour le sous-sol

Au début du XXe siècle, l’urbaniste Eugène Hénard est parmi les premiers à imaginer des rues à étages multiples pour rationaliser l’usage du sol et rendre la ville plus salubre. Son idée repose sur le constat qu’au fil du temps, l’accumulation anarchique des réseaux dans les égouts de Paris a rendu leur fonctionnement difficile à gérer et empêche, par sa complication, toute possibilité d’évolution. Il propose alors de réserver systématiquement un espace en sous-sol pour les équipements nécessaires. Les rues seraient comme « dupliquées » : circulation des personnes et des véhicules légers en surface, réseaux techniques et transport lourd en souterrain. Cette proposition préfigure l’urbanisme de dalle, tel qu’il a par exemple été mis en œuvre dans les années 1960 à Barbican Estate (Londres) ou à la Défense (Paris), un quartier d’affaires dont l’aménagement devrait bientôt s’étendre en sous-sol.

Au milieu du XXe siècle, l’architecte Édouard Utudjian (1905-1975) a proposé une théorie de l’urbanisme souterrain plus complète, partant du principe que « les rues seront toujours trop étroites, les distances trop grandes, les constructions trop entassées, les fumées trop nombreuses ». Reste alors le sous-sol, qui apparaît selon lui comme « l’une des chances de demain ». Il y voit en effet plusieurs avantages, notamment la préservation des espaces verts en surface, le doublement des voies de circulation sans croisement, ou la protection du vent et des incendies. Il n’est évidemment pas question « d’enterrer l’habitat humain, mais seulement certains organes de la ville qui encombrent la surface de leur masse inerte », dans lesquels l’homme ne vivra que périodiquement.

La ville souterraine de Montréal (Québec, Canada) concrétise aujourd’hui cette idée. Avec plus de 30 km de galeries souterraines piétonnières reliant près de 2 000 commerces et restaurants éclairés par des puits de lumière au milieu d’œuvres d’art et d’architecture remarquables, elle protège les habitants des intempéries hivernales. La lutte contre le froid et la chaleur est en effet un argument majeur pour justifier les constructions souterraines. Le climat est souvent l’une des premières motivations pour un enfouissement qui réduit les variations de température, à Montréal comme à Abou Dabi, où, pour limiter le recours à la climatisation, la ville laboratoire de Masdar City intègre des galeries et des équipements souterrains, avec à terme, un système de transport individuel et automatique innovant en sous-sol.

Ensuite, c’est la lutte contre la congestion qui justifie les projets souterrains. Le sous-sol permet d’organiser les flux de circulation, de réduire le trafic en surface, et donc la congestion qu’il génère, en augmentant le nombre de voies et en les séparant pour plus de sécurité. Bien connu dans les grandes métropoles, l’efficacité du métro réside dans l’enfouissement de tunnels en ligne droite et en site propre, qui permettent d’éviter l’encombrement et la circulation des rues pour un transport urbain parmi les plus rapides et les plus sûrs au monde.

Enfin, c’est la pénurie d’espace et la préservation des paysages qui invitent à enterrer certains bâtiments ou certaines infrastructures. Cette translation vers le sous-sol libère d’autant l’occupation du sol à l’air libre et ne laisse visible que le patrimoine architectural ou paysager qui doit être mis en valeur. À Naoshima au Japon, le musée de Chichū a par exemple été conçu en souterrain pour faciliter les jeux de lumière mettant l’art en valeur, mais aussi pour conserver une vue sur le paysage de collines environnant, faisant de la qualité du site naturel un atout revendiqué du projet.

Stratégies de sobriété souterraine

Le sous-sol apparaît donc comme une solution possible pour concilier développement urbain et sobriété foncière. La question reste de savoir ce qui pourrait être enterré, et à quelle profondeur, pour que l’ensemble reste viable et vivable. Les propositions déjà anciennes de l’aménageur québécois Daniel J. Boivin y répondent partiellement en découpant le sous-sol en trois strates selon leur accessibilité.

La première, « immédiatement sous nos pieds », est épaisse d’une dizaine de mètres et contient déjà des câbles et des conduites diverses. Elle pourrait aussi accueillir de nombreuses activités commerciales qui nécessitent peu de lumière naturelle directe (supermarchés, discothèques, cinémas, restaurants). Jusqu’à 200 mètres, la deuxième strate pourrait contenir des éléments d’industrie légère, des voies de transport et de stationnement, des entrepôts, des centres de recherche, des studios d’enregistrement ou des installations de chauffage urbain. Enfin, les grandes profondeurs (en dessous de 200 mètres) pourraient être réservées aux équipements lourds comme les centrales électriques, le stockage des déchets industriels, ou les réservoirs d’eau et d’énergie.

Par ailleurs, l’urbanisme souterrain se connecte sans difficulté majeure au système de transport urbain pour y apporter une valeur ajoutée. À Tokyo, par exemple, le développement des galeries marchandes souterraines s’est appuyé sur le métro pour capter sa clientèle, ce qui a permis de compenser directement le prix de l’investissement en sous-sol par un bénéfice commercial augmenté. On retrouve donc ici une idée bien connue des urbanistes d’aujourd’hui : le transit-oriented development (TOD). Théorisé par l’architecte américain Peter Caltorpe, le TOD vise à créer des quartiers accessibles autour des pôles de transport (gares ou stations métro/tramway) avec une haute densité bâtie, une grande mixité fonctionnelle et une déambulation piétonnière qui pourraient être largement favorisées par des projets souterrains.

La question est de savoir à quels coûts de tels projets sont envisageables. Si le montant des investissements nécessaires ne peut être estimé qu’au cas par cas, il est structurellement bien plus important que pour une construction classique. On ne peut donc envisager sa rentabilité que dans le long terme, dans le cadre de partenariats avec les acteurs publics, fondés sur une volonté politique durable de sobriété foncière. Les enjeux sont importants, notamment dans les périphéries des grandes villes sujettes à l’étalement urbain. En enfouissant autant que possible l’architecture sans fenêtres caractéristique des zones commerciales périurbaines, un urbanisme souterrain aurait l’avantage de ne plus consommer d’espaces agricoles et de ne plus nuire aux paysages des entrées de villes qui, plutôt que d’offrir une véritable vitrine aux agglomérations, sont souvent décriées pour leur hétérogénéité et leur manque d’harmonie.

Dans un contexte culturel où le monde souterrain a longtemps été associé à la peur ou à la science-fiction, il reste également à savoir comment de tels projets peuvent être perçus en termes d’ambiance et de confort. Mais c’est d’ores et déjà une question que les usagers du métro ne se posent plus vraiment, et les projets existants montrent par leur fréquentation que le sous-sol peut être exploité à son avantage dans des espaces valorisés par l’éclairage indirect. Il est fort probable que l’acceptabilité de projets de plus grande échelle réside dans un traitement architectural réussi, qui organise avec harmonie la transition entre la surface et le sous-sol. Urbaniser en souterrain n’est donc pas seulement un enjeu pour l’environnement et pour le le climat. C’est aussi un défi pour les architectes de demain.

Jean-Philippe Antoni a reçu des financements de l'Agence de la transition écologique (ADEME) et de l'Agence nationale de la recherche (ANR).

30.09.2025 à 16:59

La guerre cognitive, sans bombes ni balles : une zone grise juridique et stratégique

David Gisselsson Nord, Professor, Division of Clinical Genetics, Faculty of Medicine, Lund University

Alberto Rinaldi, Postdoctoral Researcher in Human Rights and Humanitarian Law, Lund University

Texte intégral (1871 mots)

On parle de « guerre cognitive » lorsque de fausses informations sont utilisées pour déstabiliser des populations. La Russie – entres autres – l’utilise massivement. Pourtant, cette forme d’action hostile, qui se renforce, n’est pas encadrée par le droit de la guerre. Quelle réponse envisager ?

Imaginez : vous réveillez en écoutant la nouvelle qu’une souche mortelle de grippe est apparue dans votre ville. Les autorités sanitaires minimisent la situation, mais les réseaux sociaux sont inondés d’affirmations contradictoires de la part d’« experts médicaux » débattant de son origine et de sa gravité.

Les hôpitaux sont débordés de patients présentant des symptômes grippaux, empêchant d’autres patients d’accéder aux soins, ce qui conduit à des décès. Il apparaît peu à peu qu’un adversaire étranger a orchestré cette panique en diffusant de fausses informations – comme le fait que la souche aurait un taux de mortalité très élevé. Pourtant, malgré les pertes humaines, aucune règle légale ne qualifie cette situation comme un acte de guerre.

Voici ce qu’on appelle guerre cognitive, ou « cog war » en abrégé, lorsque le domaine cognitif est utilisé sur les champs de bataille ou dans des attaques hostiles en dehors des conflits déclarés.

Un exemple classique de guerre cognitive est appelé « contrôle réflexif » – un art que la Russie a perfectionné depuis des décennies. Il s’agit de façonner les perceptions d’un adversaire à son propre avantage sans qu’il ne se rende compte qu’il a été manipulé.

Dans le cadre du conflit en Ukraine, cela inclut des récits sur des revendications historiques de la Russie sur des territoires ukrainiens ou la représentation de l’Occident comme moralement corrompu.

La guerre cognitive vise à prendre l’avantage sur un adversaire en ciblant les attitudes et comportements au niveau individuel, collectif ou de toute la population. Elle est conçue pour modifier les perceptions de la réalité, faisant de « la manipulation de la cognition humaine » un domaine crucial de la guerre. C’est donc une arme dans une bataille géopolitique qui se joue par interactions entre les esprits plutôt qu’entre les corps.

Parce qu’elle peut être menée sans les dommages physiques régulés par les lois de la guerre actuellement en vigueur, la guerre cognitive évolue dans un vide juridique. Cela ne signifie pas qu’elle ne peut pas conduire à de la violence sur la base de fausses informations, ou provoquer des blessures et des décès par effets secondaires.

Bataille des esprits, corps blessés

L’idée que la guerre est avant tout une confrontation mentale, où la manipulation cognitive est centrale, remonte au stratège Sun Tzu (Ve siècle avant notre ère), auteur de l’Art de la guerre. Aujourd’hui, le domaine numérique est l’arène principale de ce type d’opérations.

La révolution numérique permet un contenu de plus en plus personnalisé, exploitant les biais repérés à travers notre empreinte numérique : c’est ce qu’on appelle le « micro-ciblage ». L’intelligence artificielle peut même nous proposer du contenu ciblé sans prendre une seule photo ou sans enregistrer une vidéo. Il suffit d’une requête bien formulée par une IA pour soutenir un récit et des objectifs définis par des acteurs malveillants, tout en trompant discrètement le public.

Ces campagnes de désinformation s’étendent de plus en plus au domaine physique du corps humain. Dans la guerre en Ukraine, on observe encore des récits de guerre cognitive, comme des accusations selon lesquelles les autorités ukrainiennes auraient dissimulé ou provoqué des épidémies de choléra. D’autres allégations sur des laboratoires d’armes biologiques soutenus par les États-Unis ont également été utilisées comme justifications fallacieuses pour l’invasion à grande échelle par la Russie.

Pendant la pandémie de Covid-19, de fausses informations ont causé des décès, certaines personnes refusant les mesures de protection ou ayant recours à des remèdes dangereux pour se soigner. Certains récits liés à la pandémie s’inscrivaient dans une lutte géopolitique. Tandis que les États-Unis menaient des opérations d’information secrètes, des acteurs étatiques russes et chinois coordonnaient des campagnes utilisant des avatars générés par IA et du micro-ciblage pour influencer l’opinion au niveau des communautés et des individus.

La capacité de micro-ciblage pourrait évoluer rapidement grâce à des méthodes de couplage cerveau-machine permettront de collecter des données sur les schémas cognitifs. Ces interfaces entre les machines et le cerveau humain vont de simples électrodes posées sur le cuir chevelu à des casques de réalité virtuelle avec stimulation sensorielle immersive.

Le programme Next-Generation Nonsurgical Neurotechnology (dit, N3) de l’agence chargée de la recherche et du développement de nouvelles technologies à usage militaire aux États-Unis (la DARPA) illustre la façon dont ces dispositifs pourraient « lire» et « écrire » en plusieurs endroits du cerveau simultanément. Cependant, ces outils pourraient également être piratés ou alimentés par des données corrompues dans le cadre de futures stratégies de manipulation de l'information ou de perturbation psychologique. Relier directement le cerveau au monde numérique de cette manière effacera la frontière entre le corps humain et le domaine de l'information de manière inédite.

Un vide juridique

Les lois traditionnelles de la guerre considèrent l’usage de la force physique – bombes et balles – comme le principal sujet de préoccupation, laissant la guerre cognitive dans une zone grise. La manipulation psychologique est-elle une « attaque armée » justifiant la légitime défense au titre de la Charte des Nations unies ? À ce jour, il n’existe aucune réponse claire. Un acteur étatique pourrait potentiellement utiliser de la désinformation sanitaire pour provoquer des pertes massives dans un autre pays sans déclarer la guerre.

Des lacunes similaires existent même lorsque la guerre traditionnelle est déjà en cours. Dans ce contexte, la guerre cognitive brouille la ligne entre la tromperie militaire autorisée (ruses de guerre) et la perfidie interdite.

Imaginez un programme de vaccination humanitaire collectant secrètement de l’ADN, utilisé ensuite par des forces militaires pour cartographier des réseaux d’insurgés fondés sur des clans. Cette exploitation de données médicales constituerait une perfidie au regard du droit humanitaire — mais seulement si l’on considère que de telles tactiques comme parties intégrantes de la guerre.

Vers une réglementation

Que faire pour nous protéger de cette nouvelle réalité ? Tout d’abord, nous devons repenser la notion de « menace » dans les conflits modernes. La Charte des Nations unies interdit déjà les « menaces de recours à la force » contre d’autres États, mais cela nous enferme dans une conception physique de la menace.

Quand une puissance étrangère inonde vos médias de fausses alertes sanitaires pour semer la panique, cela ne menace-t-il pas votre pays tout autant qu’un blocus militaire ?

Cette problématique a été reconnue dès 2017 par les groupes d’experts à l’origine du Manuel de Tallinn sur la cyberguerre (Règle 70), mais nos normes juridiques n’ont pas suivi.

Ensuite, il faut reconnaître que le préjudice psychologique est un vrai préjudice. Lorsqu’on pense aux blessures de guerre, on imagine des blessures physiques. Pourtant, le stress post-traumatique est reconnu depuis longtemps comme une blessure de guerre légitime — alors pourquoi pas les effets mentaux des opérations cognitives ciblées ?

Finalement, les lois traditionnelles de la guerre pourraient ne pas suffire — il faudrait se tourner vers les règles relatives aux droits humains pour trouver des solutions. Ceux-ci incluent déjà des protections de la liberté de pensée et de la liberté d’opinion mais aussi des interdictions contre la propagande de guerre. Ces dernières pourraient servir de protection des civils contre les attaques cognitives. Les États ont l’obligation de faire respecter ces droits à l’intérieur comme à l’extérieur de leurs frontières.

L’utilisation de tactiques et de technologies de plus en plus sophistiquées pour manipuler la pensée et les émotions constitue l’une des menaces actuelles les plus insidieuses contre la liberté humaine. Ce n’est qu’en adaptant nos cadres juridiques à ce défi que nous pourrons renforcer la résilience de nos sociétés en permettant aux générations futures de faire face aux crises et conflits de demain.

David Gisselsson Nord bénéficie d'un financement du Conseil suédois de la recherche, de la Société suédoise du cancer et de la Fondation suédoise contre le cancer chez les enfants. Il a également reçu une bourse de voyage du ministère américain de la Défense.

Alberto Rinaldi a reçu un financement de la chaire invitée Raoul Wallenberg en droits de l'homme et droit humanitaire et du Conseil suédois de la recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Lava

- La revue des médias

- Le Grand Continent

- Le Diplo

- Le Nouvel Obs

- Lundi Matin

- Mouais

- Multitudes

- Politis

- Regards

- Smolny

- Socialter

- The Conversation

- UPMagazine

- Usbek & Rica

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- Contretemps

- A Contretemps

- Alter-éditions

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- Philo Mag

- Terrestres

- Vie des Idées

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview

- Fiabilité 3/5

- Slate

- Ulyces

- Fiabilité 1/5

- Contre-Attaque

- Issues

- Korii

- Positivr

- Regain