ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

02.10.2025 à 17:08

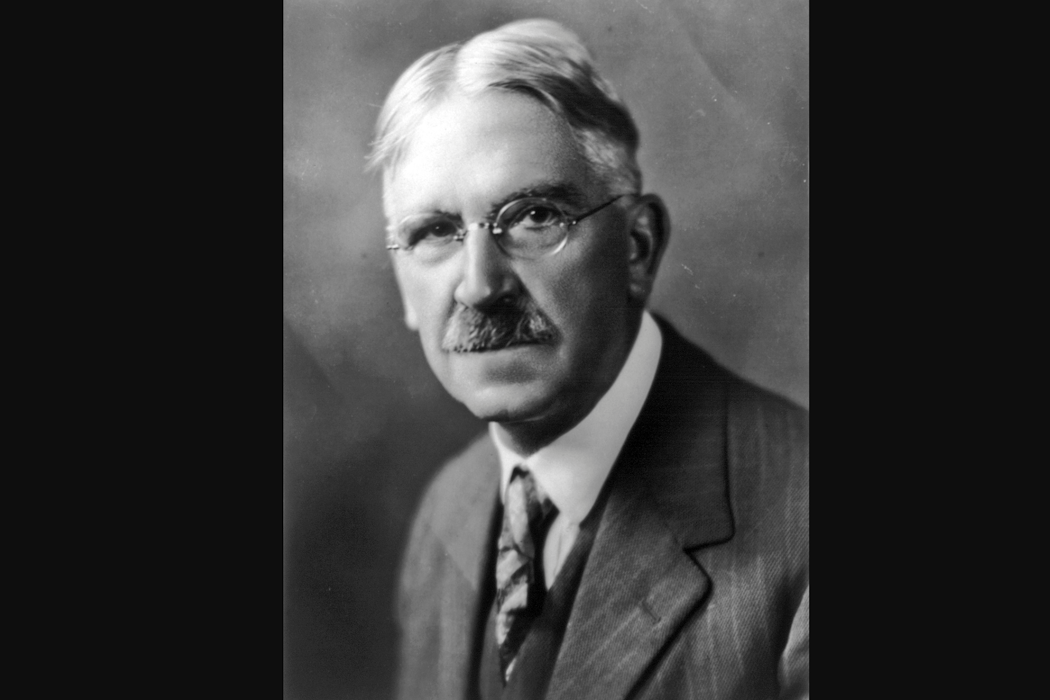

Avec John Dewey, penser la démocratie comme « enquête » collective

Patrick Savidan, Professeur de science politique, Université Paris-Panthéon-Assas

Texte intégral (2323 mots)

Notre démocratie est en crise, comment la réinventer ? Que nous enseignent ceux qui, au cours des âges, furent ses concepteurs ? Suite de notre série consacrée aux philosophes et à la démocratie avec l’Américain John Dewey (1859-1952). En plaçant l’idée d’« enquête » au cœur de la vie publique démocratique et en éliminant l’idée de « vérité absolue », il propose un modèle coopératif, orienté vers la recherche commune de solutions et admettant sa propre faillibilité.

John Dewey (1859-1952) est à la fois l’un des fondateurs du pragmatisme américain – aux côtés de Charles Sanders Peirce et William James – et le grand artisan d’une pédagogie nouvelle, active et expérimentale. Dès la fondation, en 1896, de son école expérimentale à Chicago, il s’est imposé comme l’une des figures majeures de la vie intellectuelle américaine.

Dans The Public and its Problems (1927), Dewey regrettait que « le nouvel âge des relations humaines ne dispose d’aucun mécanisme politique digne de lui ». Ce diagnostic, formulé il y a près d’un siècle, conserve aujourd’hui une résonance troublante. Les démocraties contemporaines, confrontées à des mutations techniques, sociales et économiques d’une ampleur inédite peinent à en saisir les dynamiques profondes et à y répondre de manière appropriée.

À la crise ancienne de la représentation est, en effet, venue s’associer une crise inédite de l’espace public. Tandis que la défiance envers les élus se généralise, les conditions mêmes du débat public se trouvent radicalement transformées par la révolution numérique.

Si les promesses initiales étaient immenses – savoir collaboratif avec Wikipédia, inclusion financière par le paiement mobile, accès élargi aux soins via la télémédecine, démocratisation culturelle et accélération scientifique –, les désillusions n’en sont que plus saisissantes : manipulation de l’opinion à grande échelle, instrumentalisation des réseaux sociaux par les régimes autoritaires, prolifération des récits complotistes et des infox, démultipliées par le recours à l’intelligence artificielle.

Face à ces symptômes, il serait réducteur d’évoquer une « crise de la vérité ». Ce qui vacille, ce ne sont pas tant les vérités elles-mêmes que les procédures et les médiations permettant leur élaboration collective. La vérité, loin d’avoir disparu, est menacée par des pratiques déréglées de la certitude et du doute, qui minent les conditions d’une délibération démocratique féconde.

C’est dans ce contexte que la pensée politique de John Dewey, et plus particulièrement sa conception expérimentale de la démocratie, mérite d’être réinterrogée. En plaçant l’idée d’« enquête » au cœur de la vie publique, en substituant à la notion de « vérité absolue » celle d’« assertibilité garantie », il propose un modèle coopératif, orienté vers la recherche commune de solutions et admettant sa propre faillibilité.

Une telle approche, attentive aux conditions concrètes de la connaissance partagée, offre aujourd’hui une piste féconde pour affronter les pathologies de l’espace public.

Connaître est agir

Dewey propose une réflexion forte, avertie des tentations dogmatiques de l’être humain, autrement dit, de sa propension à se ruer sur toutes les certitudes susceptibles de l’apaiser face aux périls, réels ou imaginés, qui le guettent. En ce sens, son pragmatisme est un formidable remède contre tout dogmatisme. C’est un appel à toujours remettre sur le métier la recherche du savoir, et non un quelconque congé donné au savoir.

Sa perspective est profondément marquée par un naturalisme inspiré de certaines des dimensions de l’œuvre de Darwin. Dewey envisage le développement de la connaissance en tant que processus humain d’adaptation aux conditions qui l’environnent, processus dont l’objectif est la restructuration active de ces conditions. La pensée n’est plus, comme pour la tradition, un processus dont la vigueur tient à la distance qu’elle met entre elle et le monde, mais elle se conçoit comme le produit d’une interaction entre un organisme et son environnement.

Dewey a appliqué cette conception de la connaissance à la notion d’enquête. C’est ce qui explique l’intensité de son rapport au réel. Il ne s’agit pas de s’inventer de faux problèmes, mais de partir d’une difficulté qui bloque le progrès et de trouver un moyen satisfaisant de la surmonter.

Politique de l’enquête

Dans ce contexte, Dewey distingue trois étapes. L’enquête débute par l’expérience d’une situation problématique, c’est-à-dire une situation qui met en échec nos manières habituelles d’agir et de réagir. C’est en réponse à cette inadaptation que la pensée se met en mouvement et vient nourrir le processus.

La deuxième étape consiste à isoler les données qui définissent les paramètres en vertu desquels la restructuration de la situation initiale va pouvoir s’engager. La troisième étape consiste en un moment de réflexion qui correspond à l’intégration des éléments cognitifs du processus de l’enquête (idées, présuppositions, théories, etc.) à titre d’hypothèses susceptibles d’expliquer la formation de la situation initiale. Le test ultime du résultat de l’enquête n’est nul autre que l’action elle-même. Si la restructuration de la situation antérieure permet de libérer l’activité, alors les éléments cognitifs peuvent être tenus pour « vrais » à titre provisoire.

Cette approche vaut, selon Dewey, aussi bien pour les enquêtes engagées pour résoudre des problèmes de la vie ordinaire que pour des enquêtes scientifiques. La différence entre les deux ne tient qu’au degré de précision plus grand qui peut être requis pour pratiquer les niveaux de contrôle plus élevés qu’appellent des problèmes scientifiques.

L’enquête placée au cœur de cette forme de vie qu’est la démocratie est ainsi ancrée dans une exigence forte d’objectivité. La « dissolution des repères de la certitude » qui caractérise, comme l’écrivait Claude Lefort, la logique démocratique, est ici déjà assumée non comme un obstacle, mais bien comme une condition de la vie démocratique et des formes de coopération qu’elle appelle. La communauté citoyenne constate un problème. Elle s’efforce de le résoudre. C’est l’horizon même de toute coopération.

Ouverture à la diversité des savoirs

Il en résulte que le savoir ne saurait être la chasse gardée de savants retranchés dans un langage hyperformalisé, détaché des pratiques concrètes et des réalités vécues.

La figure du spectateur, si prégnante dans certaines théories de la connaissance (et si caractéristique des illusions dont se berce le technocrate), trahit pour Dewey un désir de domination : en excluant les non-initiés du champ du savoir, elle opère une disqualification implicite des formes d’intelligence issues de la pratique. Ce dispositif, pour lui, n’est pas seulement épistémologique : il est politique. Il fonctionne comme une justification implicite d’un ordre social inégal, dans lequel le monopole de la connaissance devient l’outil d’un pouvoir de classe. Renverser cette hiérarchie des savoirs, c’est ainsi remettre en cause les mécanismes mêmes d’une organisation économique et légale qui permet à une minorité de s’arroger le contrôle de la connaissance, en la mettant au service d’intérêts privés, plutôt que de l’orienter vers un usage partagé et démocratique.

Dewey défend une répartition plus équitable des éléments de compréhension liés aux activités sociales et au travail. Ce rééquilibrage doit rendre possible une participation plus large, plus libre, à l’usage et aux bénéfices du savoir, mais il impose aussi aux croyances ordinaires de se mettre à l’épreuve du réel, en entrant dans le processus de l’enquête et en acceptant ses exigences.

En repartant des pratiques concrètes, des problèmes réels, Dewey donne consistance à une théorie de la connaissance fondée sur la coopération, la réflexivité et la capacité d’invention collective qui, pour lui, doit figurer au cœur de toute démocratie digne de ce nom.

Démocratie et connaissances

La société humaine, telle que l’envisage Dewey, n’est pas une simple juxtaposition d’individus, mais une forme d’association fondée sur l’action conjointe, et sur la conscience, partagée, des effets que cette action produit. C’est en reconnaissant la contribution spécifique de chacun que peut émerger un intérêt commun, entendu comme la préoccupation collective pour l’action et pour l’efficacité des coopérations engagées.

Mais cet intérêt commun reste vulnérable. Lorsqu’un mode d’organisation économique exerce un pouvoir oppressif sans contrepartie, ou lorsque les institutions deviennent sourdes aux dynamiques sociales, l’équilibre se rompt. Dans de telles situations, le défi n’est évidemment pas d’ajuster les individus à l’ordre existant, mais de repenser les formes mêmes de l’association.

Selon cette perspective, les concepts, les théories et les propositions politiques sont appréhendés comme des instruments d’enquête, soumis à la vérification, à l’observation, à la révision. Cela signifie, par exemple, que les politiques publiques doivent être considérées comme des hypothèses de travail, susceptibles d’ajustements constants selon les effets qu’elles produisent. Ce n’est qu’à ces conditions que les sciences sociales pourront contribuer au déploiement d’un dispositif de connaissance apte à guider l’action démocratique.

La démocratie, ainsi comprise, tire sa force de sa capacité à organiser la discussion publique autour des besoins vécus, des déséquilibres ressentis, des tensions expérimentées. Elle repose sur la possibilité pour chacun de s’exprimer, de tester ses croyances, d’évaluer les savoirs produits par d’autres et de juger de leur pertinence face aux problèmes communs. La disponibilité de la connaissance, sa maniabilité dans l’espace public, constitue dès lors un enjeu démocratique fondamental.

À rebours de toute philosophie relativiste, Dewey montre que la « vérité » dont une démocratie peut se nourrir, doit s’élaborer dans le cadre d’une enquête ouverte, partagée, ancrée dans l’expérience.

« Aucune faculté innée de l’esprit, écrit-il dans « le Public et ses problèmes », ne peut pallier l’absence de faits. Tant que le secret, le préjugé, la partialité, les faux rapports et la propagande ne seront pas remplacés par l’enquête et la publicité, nous n’aurons aucun moyen de savoir combien l’intelligence existante des masses pourrait être apte au jugement de politique sociale. »

Une enquête démocratique ne peut s’accommoder d’un public fantôme ni d’un espace public fragmenté, polarisé, déconnecté des pratiques réelles et des problèmes concrets. Elle exige que la société prenne une part active à sa propre compréhension, qu’elle se découvre elle-même par la confrontation aux obstacles qui entravent sa capacité à se constituer en tant que public. C’est en partant des déséquilibres tels que cette collectivité les expérimente que peut s’élaborer une conscience commune minimale et s’armer notre capacité à les surmonter.

Ainsi, la connaissance, dont le public est à la fois le moteur et la finalité, peut être dite véritablement démocratique. Elle ne cherche pas à imposer une vérité depuis les hauteurs d’un savoir institué, mais fait advenir une intelligence collective, capable d’inventer les formes d’une association toujours à réajuster. À l’heure où les pathologies de l’espace public se nourrissent de la disqualification de la parole profane, des effets délétères de la fragmentation algorithmique et de la confiscation de l’autorité cognitive, la pensée de Dewey trace ainsi une voie précieuse : celle d’une démocratie de l’enquête, ouverte, inclusive, rigoureuse, résolument orientée vers l’émancipation et la répartition équitable des libertés d’agir individuelles.

Patrick Savidan ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

01.10.2025 à 16:29

Urbaniser sans artificialiser : le potentiel caché du sous-sol

Jean-Philippe Antoni, Professeur de géographie et d'urbanisme, Université Bourgogne Europe

Texte intégral (2153 mots)

La loi « visant à faciliter la mise en œuvre des objectifs de lutte contre l’artificialisation des sols et à renforcer l’accompagnement des élus locaux » (2003) entend limiter l’artificialisation des sols d’ici 2050. Pour concilier développement urbain et sobriété foncière, l’urbanisme souterrain apparaît comme une solution intéressante. Il permet de préserver les terres agricoles et les paysages tout en intégrant infrastructures, commerces ou transports sous la surface.

Dans le cadre d’un aménagement durable lié à la lutte contre le changement climatique, la loi dite « Zéro artificialisation nette » (ZAN), adoptée en 2023, suscite de nombreux débats. Pour atteindre une sobriété foncière devenue nécessaire face à l’ampleur de l’étalement urbain, elle prévoit la fin probable de toute artificialisation d’ici 2050, c’est-à-dire l’interdiction de construire sans compensation sur des espaces qui ne sont pas déjà bâtis. La loi ZAN est de ce fait perçue par certains comme une atteinte historique à la propriété privée, mais également comme un frein à l’autonomie des communes, dont le développement économique et résidentiel serait mis sous cloche. Pour s’y préparer, de nombreux projets envisagent une requalification et une densification du bâti existant, mais rares sont ceux qui proposent de mieux exploiter le sous-sol. Or, l’urbanisme souterrain est une solution déjà ancienne dont les expériences récentes confirment l’efficacité, en particulier dans les zones les plus peuplées.

L’utilisation des sous-sols est souvent mal connue du grand public pour une raison simple qui constitue aussi son principal avantage : son invisibilité. C’est généralement seulement lors des travaux de voirie que l’on découvre dans le sous-sol un foisonnement technique très divers qui regroupe autant des réseaux d’eau, de communication et d’énergie, que des caves ou des espaces de stockage, voire des équipements de transports. La majorité, sans intérêt esthétique, y ont été enfouis pour y être cachés ou pour dégager un espace équivalent à leur volume, laissant la place en surface à des espaces ouverts ou végétalisés. Cette idée a fait l’objet de plusieurs approches théoriques qui ont montré son intérêt pour les villes d’aujourd’hui.

Un nouveau rôle pour le sous-sol

Au début du XXe siècle, l’urbaniste Eugène Hénard est parmi les premiers à imaginer des rues à étages multiples pour rationaliser l’usage du sol et rendre la ville plus salubre. Son idée repose sur le constat qu’au fil du temps, l’accumulation anarchique des réseaux dans les égouts de Paris a rendu leur fonctionnement difficile à gérer et empêche, par sa complication, toute possibilité d’évolution. Il propose alors de réserver systématiquement un espace en sous-sol pour les équipements nécessaires. Les rues seraient comme « dupliquées » : circulation des personnes et des véhicules légers en surface, réseaux techniques et transport lourd en souterrain. Cette proposition préfigure l’urbanisme de dalle, tel qu’il a par exemple été mis en œuvre dans les années 1960 à Barbican Estate (Londres) ou à la Défense (Paris), un quartier d’affaires dont l’aménagement devrait bientôt s’étendre en sous-sol.

Au milieu du XXe siècle, l’architecte Édouard Utudjian (1905-1975) a proposé une théorie de l’urbanisme souterrain plus complète, partant du principe que « les rues seront toujours trop étroites, les distances trop grandes, les constructions trop entassées, les fumées trop nombreuses ». Reste alors le sous-sol, qui apparaît selon lui comme « l’une des chances de demain ». Il y voit en effet plusieurs avantages, notamment la préservation des espaces verts en surface, le doublement des voies de circulation sans croisement, ou la protection du vent et des incendies. Il n’est évidemment pas question « d’enterrer l’habitat humain, mais seulement certains organes de la ville qui encombrent la surface de leur masse inerte », dans lesquels l’homme ne vivra que périodiquement.

La ville souterraine de Montréal (Québec, Canada) concrétise aujourd’hui cette idée. Avec plus de 30 km de galeries souterraines piétonnières reliant près de 2 000 commerces et restaurants éclairés par des puits de lumière au milieu d’œuvres d’art et d’architecture remarquables, elle protège les habitants des intempéries hivernales. La lutte contre le froid et la chaleur est en effet un argument majeur pour justifier les constructions souterraines. Le climat est souvent l’une des premières motivations pour un enfouissement qui réduit les variations de température, à Montréal comme à Abou Dabi, où, pour limiter le recours à la climatisation, la ville laboratoire de Masdar City intègre des galeries et des équipements souterrains, avec à terme, un système de transport individuel et automatique innovant en sous-sol.

Ensuite, c’est la lutte contre la congestion qui justifie les projets souterrains. Le sous-sol permet d’organiser les flux de circulation, de réduire le trafic en surface, et donc la congestion qu’il génère, en augmentant le nombre de voies et en les séparant pour plus de sécurité. Bien connu dans les grandes métropoles, l’efficacité du métro réside dans l’enfouissement de tunnels en ligne droite et en site propre, qui permettent d’éviter l’encombrement et la circulation des rues pour un transport urbain parmi les plus rapides et les plus sûrs au monde.

Enfin, c’est la pénurie d’espace et la préservation des paysages qui invitent à enterrer certains bâtiments ou certaines infrastructures. Cette translation vers le sous-sol libère d’autant l’occupation du sol à l’air libre et ne laisse visible que le patrimoine architectural ou paysager qui doit être mis en valeur. À Naoshima au Japon, le musée de Chichū a par exemple été conçu en souterrain pour faciliter les jeux de lumière mettant l’art en valeur, mais aussi pour conserver une vue sur le paysage de collines environnant, faisant de la qualité du site naturel un atout revendiqué du projet.

Stratégies de sobriété souterraine

Le sous-sol apparaît donc comme une solution possible pour concilier développement urbain et sobriété foncière. La question reste de savoir ce qui pourrait être enterré, et à quelle profondeur, pour que l’ensemble reste viable et vivable. Les propositions déjà anciennes de l’aménageur québécois Daniel J. Boivin y répondent partiellement en découpant le sous-sol en trois strates selon leur accessibilité.

La première, « immédiatement sous nos pieds », est épaisse d’une dizaine de mètres et contient déjà des câbles et des conduites diverses. Elle pourrait aussi accueillir de nombreuses activités commerciales qui nécessitent peu de lumière naturelle directe (supermarchés, discothèques, cinémas, restaurants). Jusqu’à 200 mètres, la deuxième strate pourrait contenir des éléments d’industrie légère, des voies de transport et de stationnement, des entrepôts, des centres de recherche, des studios d’enregistrement ou des installations de chauffage urbain. Enfin, les grandes profondeurs (en dessous de 200 mètres) pourraient être réservées aux équipements lourds comme les centrales électriques, le stockage des déchets industriels, ou les réservoirs d’eau et d’énergie.

Par ailleurs, l’urbanisme souterrain se connecte sans difficulté majeure au système de transport urbain pour y apporter une valeur ajoutée. À Tokyo, par exemple, le développement des galeries marchandes souterraines s’est appuyé sur le métro pour capter sa clientèle, ce qui a permis de compenser directement le prix de l’investissement en sous-sol par un bénéfice commercial augmenté. On retrouve donc ici une idée bien connue des urbanistes d’aujourd’hui : le transit-oriented development (TOD). Théorisé par l’architecte américain Peter Caltorpe, le TOD vise à créer des quartiers accessibles autour des pôles de transport (gares ou stations métro/tramway) avec une haute densité bâtie, une grande mixité fonctionnelle et une déambulation piétonnière qui pourraient être largement favorisées par des projets souterrains.

La question est de savoir à quels coûts de tels projets sont envisageables. Si le montant des investissements nécessaires ne peut être estimé qu’au cas par cas, il est structurellement bien plus important que pour une construction classique. On ne peut donc envisager sa rentabilité que dans le long terme, dans le cadre de partenariats avec les acteurs publics, fondés sur une volonté politique durable de sobriété foncière. Les enjeux sont importants, notamment dans les périphéries des grandes villes sujettes à l’étalement urbain. En enfouissant autant que possible l’architecture sans fenêtres caractéristique des zones commerciales périurbaines, un urbanisme souterrain aurait l’avantage de ne plus consommer d’espaces agricoles et de ne plus nuire aux paysages des entrées de villes qui, plutôt que d’offrir une véritable vitrine aux agglomérations, sont souvent décriées pour leur hétérogénéité et leur manque d’harmonie.

Dans un contexte culturel où le monde souterrain a longtemps été associé à la peur ou à la science-fiction, il reste également à savoir comment de tels projets peuvent être perçus en termes d’ambiance et de confort. Mais c’est d’ores et déjà une question que les usagers du métro ne se posent plus vraiment, et les projets existants montrent par leur fréquentation que le sous-sol peut être exploité à son avantage dans des espaces valorisés par l’éclairage indirect. Il est fort probable que l’acceptabilité de projets de plus grande échelle réside dans un traitement architectural réussi, qui organise avec harmonie la transition entre la surface et le sous-sol. Urbaniser en souterrain n’est donc pas seulement un enjeu pour l’environnement et pour le le climat. C’est aussi un défi pour les architectes de demain.

Jean-Philippe Antoni a reçu des financements de l'Agence de la transition écologique (ADEME) et de l'Agence nationale de la recherche (ANR).

30.09.2025 à 16:59

La guerre cognitive, sans bombes ni balles : une zone grise juridique et stratégique

David Gisselsson Nord, Professor, Division of Clinical Genetics, Faculty of Medicine, Lund University

Alberto Rinaldi, Postdoctoral Researcher in Human Rights and Humanitarian Law, Lund University

Texte intégral (1871 mots)

On parle de « guerre cognitive » lorsque de fausses informations sont utilisées pour déstabiliser des populations. La Russie – entres autres – l’utilise massivement. Pourtant, cette forme d’action hostile, qui se renforce, n’est pas encadrée par le droit de la guerre. Quelle réponse envisager ?

Imaginez : vous réveillez en écoutant la nouvelle qu’une souche mortelle de grippe est apparue dans votre ville. Les autorités sanitaires minimisent la situation, mais les réseaux sociaux sont inondés d’affirmations contradictoires de la part d’« experts médicaux » débattant de son origine et de sa gravité.

Les hôpitaux sont débordés de patients présentant des symptômes grippaux, empêchant d’autres patients d’accéder aux soins, ce qui conduit à des décès. Il apparaît peu à peu qu’un adversaire étranger a orchestré cette panique en diffusant de fausses informations – comme le fait que la souche aurait un taux de mortalité très élevé. Pourtant, malgré les pertes humaines, aucune règle légale ne qualifie cette situation comme un acte de guerre.

Voici ce qu’on appelle guerre cognitive, ou « cog war » en abrégé, lorsque le domaine cognitif est utilisé sur les champs de bataille ou dans des attaques hostiles en dehors des conflits déclarés.

Un exemple classique de guerre cognitive est appelé « contrôle réflexif » – un art que la Russie a perfectionné depuis des décennies. Il s’agit de façonner les perceptions d’un adversaire à son propre avantage sans qu’il ne se rende compte qu’il a été manipulé.

Dans le cadre du conflit en Ukraine, cela inclut des récits sur des revendications historiques de la Russie sur des territoires ukrainiens ou la représentation de l’Occident comme moralement corrompu.

La guerre cognitive vise à prendre l’avantage sur un adversaire en ciblant les attitudes et comportements au niveau individuel, collectif ou de toute la population. Elle est conçue pour modifier les perceptions de la réalité, faisant de « la manipulation de la cognition humaine » un domaine crucial de la guerre. C’est donc une arme dans une bataille géopolitique qui se joue par interactions entre les esprits plutôt qu’entre les corps.

Parce qu’elle peut être menée sans les dommages physiques régulés par les lois de la guerre actuellement en vigueur, la guerre cognitive évolue dans un vide juridique. Cela ne signifie pas qu’elle ne peut pas conduire à de la violence sur la base de fausses informations, ou provoquer des blessures et des décès par effets secondaires.

Bataille des esprits, corps blessés

L’idée que la guerre est avant tout une confrontation mentale, où la manipulation cognitive est centrale, remonte au stratège Sun Tzu (Ve siècle avant notre ère), auteur de l’Art de la guerre. Aujourd’hui, le domaine numérique est l’arène principale de ce type d’opérations.

La révolution numérique permet un contenu de plus en plus personnalisé, exploitant les biais repérés à travers notre empreinte numérique : c’est ce qu’on appelle le « micro-ciblage ». L’intelligence artificielle peut même nous proposer du contenu ciblé sans prendre une seule photo ou sans enregistrer une vidéo. Il suffit d’une requête bien formulée par une IA pour soutenir un récit et des objectifs définis par des acteurs malveillants, tout en trompant discrètement le public.

Ces campagnes de désinformation s’étendent de plus en plus au domaine physique du corps humain. Dans la guerre en Ukraine, on observe encore des récits de guerre cognitive, comme des accusations selon lesquelles les autorités ukrainiennes auraient dissimulé ou provoqué des épidémies de choléra. D’autres allégations sur des laboratoires d’armes biologiques soutenus par les États-Unis ont également été utilisées comme justifications fallacieuses pour l’invasion à grande échelle par la Russie.

Pendant la pandémie de Covid-19, de fausses informations ont causé des décès, certaines personnes refusant les mesures de protection ou ayant recours à des remèdes dangereux pour se soigner. Certains récits liés à la pandémie s’inscrivaient dans une lutte géopolitique. Tandis que les États-Unis menaient des opérations d’information secrètes, des acteurs étatiques russes et chinois coordonnaient des campagnes utilisant des avatars générés par IA et du micro-ciblage pour influencer l’opinion au niveau des communautés et des individus.

La capacité de micro-ciblage pourrait évoluer rapidement grâce à des méthodes de couplage cerveau-machine permettront de collecter des données sur les schémas cognitifs. Ces interfaces entre les machines et le cerveau humain vont de simples électrodes posées sur le cuir chevelu à des casques de réalité virtuelle avec stimulation sensorielle immersive.

Le programme Next-Generation Nonsurgical Neurotechnology (dit, N3) de l’agence chargée de la recherche et du développement de nouvelles technologies à usage militaire aux États-Unis (la DARPA) illustre la façon dont ces dispositifs pourraient « lire» et « écrire » en plusieurs endroits du cerveau simultanément. Cependant, ces outils pourraient également être piratés ou alimentés par des données corrompues dans le cadre de futures stratégies de manipulation de l'information ou de perturbation psychologique. Relier directement le cerveau au monde numérique de cette manière effacera la frontière entre le corps humain et le domaine de l'information de manière inédite.

Un vide juridique

Les lois traditionnelles de la guerre considèrent l’usage de la force physique – bombes et balles – comme le principal sujet de préoccupation, laissant la guerre cognitive dans une zone grise. La manipulation psychologique est-elle une « attaque armée » justifiant la légitime défense au titre de la Charte des Nations unies ? À ce jour, il n’existe aucune réponse claire. Un acteur étatique pourrait potentiellement utiliser de la désinformation sanitaire pour provoquer des pertes massives dans un autre pays sans déclarer la guerre.

Des lacunes similaires existent même lorsque la guerre traditionnelle est déjà en cours. Dans ce contexte, la guerre cognitive brouille la ligne entre la tromperie militaire autorisée (ruses de guerre) et la perfidie interdite.

Imaginez un programme de vaccination humanitaire collectant secrètement de l’ADN, utilisé ensuite par des forces militaires pour cartographier des réseaux d’insurgés fondés sur des clans. Cette exploitation de données médicales constituerait une perfidie au regard du droit humanitaire — mais seulement si l’on considère que de telles tactiques comme parties intégrantes de la guerre.

Vers une réglementation

Que faire pour nous protéger de cette nouvelle réalité ? Tout d’abord, nous devons repenser la notion de « menace » dans les conflits modernes. La Charte des Nations unies interdit déjà les « menaces de recours à la force » contre d’autres États, mais cela nous enferme dans une conception physique de la menace.

Quand une puissance étrangère inonde vos médias de fausses alertes sanitaires pour semer la panique, cela ne menace-t-il pas votre pays tout autant qu’un blocus militaire ?

Cette problématique a été reconnue dès 2017 par les groupes d’experts à l’origine du Manuel de Tallinn sur la cyberguerre (Règle 70), mais nos normes juridiques n’ont pas suivi.

Ensuite, il faut reconnaître que le préjudice psychologique est un vrai préjudice. Lorsqu’on pense aux blessures de guerre, on imagine des blessures physiques. Pourtant, le stress post-traumatique est reconnu depuis longtemps comme une blessure de guerre légitime — alors pourquoi pas les effets mentaux des opérations cognitives ciblées ?

Finalement, les lois traditionnelles de la guerre pourraient ne pas suffire — il faudrait se tourner vers les règles relatives aux droits humains pour trouver des solutions. Ceux-ci incluent déjà des protections de la liberté de pensée et de la liberté d’opinion mais aussi des interdictions contre la propagande de guerre. Ces dernières pourraient servir de protection des civils contre les attaques cognitives. Les États ont l’obligation de faire respecter ces droits à l’intérieur comme à l’extérieur de leurs frontières.

L’utilisation de tactiques et de technologies de plus en plus sophistiquées pour manipuler la pensée et les émotions constitue l’une des menaces actuelles les plus insidieuses contre la liberté humaine. Ce n’est qu’en adaptant nos cadres juridiques à ce défi que nous pourrons renforcer la résilience de nos sociétés en permettant aux générations futures de faire face aux crises et conflits de demain.

David Gisselsson Nord bénéficie d'un financement du Conseil suédois de la recherche, de la Société suédoise du cancer et de la Fondation suédoise contre le cancer chez les enfants. Il a également reçu une bourse de voyage du ministère américain de la Défense.

Alberto Rinaldi a reçu un financement de la chaire invitée Raoul Wallenberg en droits de l'homme et droit humanitaire et du Conseil suédois de la recherche.

29.09.2025 à 16:34

Comment les juges tracent la ligne entre critique d’une religion et stigmatisation des fidèles

Anna Arzoumanov, Maitresse de conférences en langue et littérature françaises, Sorbonne Université

Texte intégral (2173 mots)

Certaines critiques de la religion relèvent-elles de la liberté d’expression ou basculent-elles dans la stigmatisation des croyants ? En France, la frontière est juridiquement ténue. Dans les prétoires, les juges tranchent, au cas par cas, loin des slogans et des polémiques médiatiques.

Les mots et discours qui circulent dans l’espace public sont régulièrement au cœur de controverses autour des limites de la liberté d’expression. Ils soulèvent des interrogations récurrentes sur les droits des individus, figures publiques ou anonymes, à tenir certains propos. Parmi les sujets les plus sensibles figurent les discours critiques à l’égard des religions.

Si certains les considèrent comme l’expression légitime d’une opinion ou d’un désaccord avec une doctrine, d’autres y voient une forme de stigmatisation insidieuse visant les croyants eux-mêmes. Ainsi, ce qui relève pour les uns d’un simple rejet intellectuel d’une croyance peut apparaître, pour les autres, comme une attaque implicite contre ceux qui y adhèrent. Ces divergences reflètent des clivages idéologiques profonds, qui alimentent la virulence des débats dans l’espace public.

Sans prétendre trancher ce débat, il faut souligner que ces tensions se jouent également dans les salles d’audience. Comment les juges français tracent-ils la ligne entre la critique d’une religion et la stigmatisation de ses fidèles ? La justice reconnaît-elle que cette frontière peut parfois s’estomper, que la critique peut glisser vers la stigmatisation ?

Offense ou préjudice ? Une distinction juridique essentielle

En France, la liberté d’expression repose sur la loi du 29 juillet 1881, qui garantit une parole libre dans l’espace public tout en posant des limites : diffamation, injure, provocation à la haine ou apologie de crimes sont ainsi sanctionnées. Longtemps concentré à la 17e chambre du tribunal judiciaire de Paris, ce contentieux s’est largement diffusé sur le territoire français avec les réseaux sociaux, impliquant désormais des anonymes autant que des figures publiques.

Pour les juges, la méthode reste constante : identifier la cible des propos, puis en apprécier le sens selon le contexte. Ce cadre juridique repose sur une distinction essentielle : on ne punit pas une opinion, mais un discours portant atteinte à des personnes. Cela rejoint l’opposition formulée par le philosophe français Ruwen Ogien (1947-2017) entre offense, dirigée contre des idées ou des croyances, et préjudice, qui touche des individus ou des groupes identifiables.

Ainsi, critiquer une religion, même de manière virulente, relève de la liberté d’expression, alors que viser explicitement ses fidèles en excède les limites. Les tribunaux font la différence entre des propos sur « l’islam » ou sur « le catholicisme », qui désignent des dogmes religieux, et ceux visant « les musulmans » ou « les catholiques », assimilables à des attaques contre des personnes. Cette ligne de séparation permet d’expliquer certaines décisions judiciaires : Michel Houellebecq, par exemple, a été relaxé en 2002 après avoir qualifié l’islam de « religion la plus con », la justice estimant qu’il s’en prenait au dogme, non aux croyants.

Le blasphème n’est plus un délit en France depuis 1881

Cette distinction opérée entre croyance et croyants s’explique par le fait que, depuis 1881, le blasphème n’est plus un délit en France. La critique de figures ou de symboles religieux est donc légalement permise, même si elle choque. Mais cela n’empêche pas certains groupes de considérer ces critiques comme des atteintes aux croyants eux-mêmes. À intervalles réguliers, des associations saisissent les tribunaux pour tenter de faire reconnaître qu’une offense dirigée contre une religion constitue en réalité un préjudice infligé à ceux qui la pratiquent. La sociologue Jeanne Favret-Saada a bien analysé ce phénomène dans les Sensibilités religieuses blessées. Christianismes, blasphèmes et cinéma. 1965-1988 (2017), en montrant comment, dans certaines procédures, ces associations tentent de transformer une offense symbolique en une atteinte personnelle devant la justice.

La plupart des actions en justice liées à des offenses religieuses sont portées par des associations chrétiennes, notamment catholiques. En première ligne, l’Alliance générale contre le racisme et pour le respect de l’identité française et chrétienne (Agrif), qui multiplie les procédures pour dénoncer ce qu’elle considère comme de la christianophobie. Pour elle, critiquer un dogme ou un symbole religieux revient à attaquer les croyants eux-mêmes. Dès 2010, le chercheur Jean Boulègue (1936-2011) relevait déjà que 90 % de ces affaires étaient engagées par des chrétiens, avec l’intention de faire reconnaître juridiquement l’offense comme un préjudice réel.

Des associations musulmanes ont tenté d’emprunter la même voie, notamment lors des procès contre Michel Houellebecq, en 2002, ou contre Charlie Hebdo après la publication des caricatures de Mahomet, en 2007. Mais la justice a tranché systématiquement en faveur d’une relaxe, les juges estimant que la critique visait la religion, non les musulmans en tant que groupe. Une position réaffirmée régulièrement : tant que le discours cible le dogme et non les fidèles, elle reste protégée par la liberté d’expression. En 2006, la Cour de cassation a même annulé une condamnation contre une publicité pastichant la Cène, rappelant qu’un symbole religieux peut être détourné sans que cela constitue une injure.

Si le principe juridique semble clair, son application se heurte à certains discours qui le mettent à mal. Dès lors que le discours s’éloigne du sens littéral, par des procédés comme la métonymie ou la personnification, l’identification de la cible devient plus complexe. C’est dans ces zones grises que se joue aujourd’hui la frontière entre critique légitime d’une croyance et discours stigmatisant des croyants.

Quand le discours prend des détours : la métonymie et la personnification à l’épreuve du droit

Le sens littéral des mots ne suffit pas toujours à identifier leur cible. Le contexte, le ton, l’intention, et certaines figures de style peuvent en modifier la portée.

Parmi elles, la métonymie désigne un objet par un autre auquel il est lié : dire « boire un verre », c’est évoquer le contenu, non le contenant. Dans le vers de Paul Éluard, « Paris a froid, Paris a faim », Paris désigne les habitants, non la ville elle-même. Ce glissement, bien connu des linguistes, peut devenir source d’ambiguïté en justice, où l’interprétation précise des propos est cruciale. La métonymie permet de suggérer sans nommer, de contourner les interdits sans les enfreindre explicitement. Dans les prétoires, elle pose la question suivante : où s’arrête la critique d’une idée ou d’un dogme, et où commence l’attaque d’un groupe de personnes ?

Un premier exemple éclaire ces enjeux. Un arrêt de la Cour de cassation du 16 mars 2021 portait sur un tract diffusé après l’attentat de Magnanville (Yvelines), où figuraient les slogans « Islam assassin » et « Islam dehors », associés à un poignard ensanglanté. La question posée aux juges : ces slogans visaient-ils la religion ou, métonymiquement, ses fidèles ? Le tract, en attribuant à l’islam des intentions humaines (volonté de soumettre, violence), recourait à la personnification, ce qui ouvre la voie à une désignation implicite des musulmans.

Le tribunal correctionnel a vu dans ce procédé une attaque indirecte contre les pratiquants, renforcée par d’autres expressions stigmatisantes caractéristiques du discours raciste (« grand remplacement », « invasion »). La cour d’appel, au contraire, a opté pour une lecture littérale, jugeant que l’absence de mention explicite d’un groupe empêchait de qualifier les propos d’incitation à la haine. La Cour de cassation a cassé cette décision, rappelant qu’on ne peut faire abstraction du discours figuré ni de ses effets implicites. Ce cas oppose donc deux lectures : l’une, contextuelle et figurale, attentive aux procédés stylistiques ; l’autre, strictement littérale, limitée au sens des mots en dehors de leur usage en contexte.

Une autre affaire, liée à des propos tenus en 2013 à Belfort (Territoire de Belfort), met en lumière un autre aspect de cette frontière floue entre critique de la religion et stigmatisation des croyants. La même personne que celle du tract y déclare : « Oui je suis islamophobe, et alors ? La haine de l’islam, j’en suis fière. L’islam est une saloperie […], c’est un danger pour la France. » Contrairement au tract, ici la religion est explicitement visée, sans glissement apparent vers les fidèles. La prévenue assume une hostilité envers une religion, et non envers ceux qui la pratiquent. Elle est condamnée en première instance par des juges qui acceptent d’y voir un glissement entre haine de la religion et haine des croyants, mais relaxée en appel : les juges reconnaissent la violence du propos, mais estiment qu’il relève d’une opinion sur une religion, sans intention manifeste de stigmatiser un groupe. Ce raisonnement interroge. Peut-on vraiment dissocier des formules comme « haine de l’islam » ou « l’islam est un danger » de toute portée sociale sur les croyants ? Revendiquer son islamophobie comme l’affirmation d’une haine à l’égard d’une croyance peut à l’inverse être vu comme une manière de contourner l’interdit de la haine envers les personnes, sous couvert de critiquer une abstraction.

Ces deux affaires illustrent les limites d’une approche strictement littérale. Si les propos ne franchissent pas toujours le seuil de l’incitation légale, ils révèlent combien la frontière entre critique du dogme et attaque des croyants peut être instable, et parfois exploitée pour rester dans la légalité.

L’affaire Houellebecq, évoquée plus haut, en offre une nouvelle illustration. Dans une interview, l’écrivain affirme : « La religion la plus con, c’est quand même l’islam. » La justice y voit une critique de la religion en tant que telle, et non une attaque contre ses fidèles. Pourtant, lorsqu’il poursuit en déclarant : « L’islam naît avec la volonté de soumettre le monde […]. C’est une religion belliqueuse, intolérante, qui rend les gens malheureux », le discours glisse vers une personnification du dogme. Ce procédé ouvre la voie à une lecture métonymique, susceptible d’assimiler croyance et croyants. Là encore, l’interprétation littérale masque les effets de glissement potentiels du propos et l’ambiguïté de leur cible.

Les exemples étudiés montrent que la justice française s’efforce de maintenir une distinction délicate entre la critique du dogme et l’attaque dirigée contre les croyants eux-mêmes. Toutefois, cette frontière demeure instable, car elle peut facilement être contournée. Les mots, en contexte, peuvent glisser insidieusement de l’abstraction théologique à la stigmatisation implicite d’un groupe de fidèles. Ce glissement, souvent permis par les ressources mêmes du langage – métonymie, personnification, implicite – exige des juges une lecture fine et contextualisée des discours, attentive non seulement à leur contenu littéral, mais aussi à leurs effets, leurs sous-entendus, et à l’intention qui les anime.

Si la liberté de critiquer les religions constitue un principe fondamental en droit français, elle ne saurait servir de paravent à des propos qui, sous des apparences abstraites, ciblent en réalité un groupe identifiable. La langue, par sa richesse et sa souplesse, permet précisément ces déplacements de sens : les ignorer serait faire preuve d’un dangereux aveuglement.

Anna Arzoumanov est l’autrice de Juger les mots. Liberté d’expression, justice et langue, éditions Actes Sud, « La compagnie des langues », avril 2025.

Arzoumanov Anna a reçu des financements de l'ANR et du CNRS pour des projets de recherche sur la liberté d'expression.

29.09.2025 à 12:33

Le recours à l’intérim dans le travail social : opportunité ou fatalité ?

Laura Beton-Athmani, Attachée de Recherche IRTS PACA Corse - Chercheure associée LEST, Aix-Marseille Université (AMU)

Texte intégral (1611 mots)

Quelles réalités recouvre l’emploi intérimaire dans le secteur médico-social en 2025 ? Une recherche exploratoire auprès de professionnels permet de dresser un premier panorama du phénomène.

Depuis plusieurs années, l’emploi intérimaire émerge dans un secteur où on ne l’attendait pas. Pire ! Où on le redoutait : le secteur social et médico-social. Au cœur d’un paradoxe fort, entre accompagnement de longue durée et travail par essence temporaire.

Faisant grincer des dents, ce phénomène mérite un intérêt particulier : donner à voir la complexité de celui-ci, et surtout des individus qui sont au cœur de ce dilemme « éthique ».

Et si ce qui s’apparente initialement à un désengagement était finalement une forme de réappropriation d’un métier souffrant d’un manque d’attractivité ? D’une marge de manœuvre dans l’exercice de ses fonctions ? Finalement, prendre soin de soi pour « durer » auprès de ceux qui en ont besoin ?

La crise du travail social ne date pas d’hier

La crise que connaît le travail social n’est pas nouvelle. Dès la fin des années 1990, des auteurs témoignent du malaise des travailleurs sociaux, engendré par une déstructuration de ce champ professionnel. Le sociologue Marcel Jaeger souligne en 2013 cette double impuissance, symbolisée par le manque de moyens et la perte de sens.

Le contexte actuel exacerbe cette crise : difficultés de recrutement, diminution de candidats au sein des instituts de formation, nouveaux profils de stagiaires, abandon de certains déçus par les conditions de travail, complexité des situations des personnes accompagnées, contraintes financières et procédurales, obligation de résultat, bas salaires, libéralisation du travail social, etc.

Émergence de l’emploi intérimaire

L’emploi intérimaire interroge une large frange des travailleurs sociaux et des personnels en poste d’encadrement dans le secteur. Mon intérêt pour ce phénomène émergé d’échanges réguliers avec des étudiants en certificat d’aptitude aux fonctions de directeur d’établissement ou de service d’intervention sociale (CAFDES) au sein de l’Institut Régional du Travail social (IRTS) Paca Corse.

À ce jour, peu d’études scientifiques évoquent ce phénomène, si ce n’est les travaux de Charlène Charles en protection de l’enfance. Ses résultats mettent en avant la « contrainte » du recours à l’intérim pour des professionnels précaires. Ils répondent principalement à des situations « d’urgence sociale », des missions de « contention sociale », souvent sollicités pour faire fonction de « renfort éducatif », pour des situations de « crises ».

Jusqu’alors, l’intérim a été justifié dans le secteur de la protection de l’enfance du fait de l’accroissement de situations complexes chez les jeunes de l’Aide Sociale à l’Enfance, nommés « les incasables ». Il touche d’autres champs, comme le handicap ou encore la lutte contre l’exclusion, champs enquêtés dans notre recherche.

Point juridique à ce sujet

Afin d’encadrer le recours à l’intérim, la loi Valletoux est promulguée le 27 décembre 2023. En application du décret du 24 juin 2024, elle fixe une durée minimale d’exercice préalable de deux ans pour certains professionnels avant leur mise à disposition d’un établissement ou service social ou médico-social par une entreprise de travail temporaire.

Rebondissement le 6 juin dernier. Le Conseil d’État annule cette mesure pour les professionnels expérimentés, eux aussi touchés par cette mesure.

Manque d’attractivité des métiers

Mais alors quelles réalités revêtent le recours à l’intérim en travail social en 2025 ? Notre recherche exploratoire auprès de deux organisations du secteur médico-social permet de dresser un premier portrait du phénomène.

À lire aussi : Agents d’entretien : la crise sanitaire révèle l'absurdité des stratégies d'externalisation

Elle permet de confirmer le manque d’attractivité des métiers ou la souffrance des professionnels du secteur face à des conditions de travail difficiles. Quelques lignes de notre carnet de chercheur font état d’un acte de violence d’un résident auprès d’une professionnelle :

Le 30 janvier 2025, arrivée à 09 heures 15. Je croise C., la [cheffe de service], et H., une [aide-soignante], dans les couloirs. H. a une poche de glace sur la joue. Elle vient de se faire frapper par un résident. Elle propose l’achat d’un sac de frappe pour les résidents. C’était le cas dans un ancien établissement où elle a travaillé.

Intérim contraint et choisi

Au-delà, le recours à l’intérim met en lumière un rapport de force inversé, désormais entre les mains des individus et non plus des organisations. Il entraîne un recours presque inévitable à l’intérim afin d’assurer la survie des établissements concernés, notamment sur des périodes dites « de tensions ». Force est donc de constater le glissement d’un intérim « contraint » à un intérim « choisi » pour les professionnels du secteur.

« Les agences non lucratives, ça fait partie de leur mission d’amener les intérimaires à l’emploi. Les agences non lucratives, c’est une perte de capital humain », rappelle un directeur d’une association.

La digitalisation des agences d’intérim facilite la mise en contact avec les intérimaires, ainsi que la présence de nouvelles agences d’intérim dites coopératives. Certaines d’entre elles ont justement vu le jour grâce à un travail interassociatif, les organisations du secteur souhaitant retrouver une forme de contrôle sur les embauches de ces professionnels.

Période d’essai du CDI

Du côté des organisations, l’usage de l’intérim peut paraître ambigu. Pour l’une des organisations enquêtées, l’intérim est clairement affiché comme une « période d’essai » du CDI. Cela permet aux managers de proposer des CDI à des intérimaires dont les compétences ont été reconnues.

« Oui, c’est une source d’embauche importante. Ça a été un moyen de permettre, en fait, de remplacer une période d’essai, on va dire comme ça, avec des conditions, pour être honnête, plus avantageuses et pour la personne en intérim, et plus souples pour nous » relève un directeur associatif.

Pour les organisations, les motivations exposées résident principalement dans le fait que les « intérimaires repérés » jouent un rôle de facilitateur. Le recours à l’intérim facilite une partie du travail administratif, notamment lorsque l’agence d’intérim s’occupe des plannings des intérimaires et des roulements.

Ce type d’intérimaires repérés sont porteurs d’une histoire, de connaissances d’un dispositif. De facto, ils facilitent la prise de poste de professionnels permanents, notamment de leur supérieur hiérarchique.

« Pour ne rien vous cacher, ça m’arrangeait aussi puisque c’était toujours les mêmes intérimaires. Elles maîtrisaient mieux le dispositif que moi. Et si je suis honnête, c’est elles qui m’ont plus formée quand je suis arrivée » souligne une cheffe de service éducatif.

Se confronter à la réalité du travail

Du côté des intérimaires, l’intérim est utilisé pour choisir l’établissement d’exercice, afin d’éprouver les conditions réelles de travail face à l’image et la notoriété d’un établissement ou d’une association.

Les intérimaires témoignent de plusieurs motivations à recourir à ce statut : moins de stress, plus de liberté, des avantages financiers et une meilleure conciliation vie privée/vie professionnelle.

« J’ai des parents vieillissants dont je suis seule à m’occuper. Et comme je disais à la [cheffe de service] : je ne pourrais pas accompagner les résidents ici comme j’ai toujours fait […] Et ne pas m’occuper des miens, ce n’est pas possible. »

Laura Beton-Athmani est vice-présidente de l'association MJF - Jane Pannier.

27.09.2025 à 11:20

Les prémices de l’État de droit au Moyen Âge : quand la loi s’impose au roi

Yves Sassier, professeur émérite, Sorbonne Université

Texte intégral (2196 mots)

L’histoire intellectuelle et politique du XIIᵉ au XIVᵉ siècle est essentielle pour comprendre la transformation des royautés féodales européennes en États modernes et les prémices des idéaux démocratiques. À cette époque, la redécouverte du droit romain et de la philosophie d’Aristote produisent de passionnants débats sur les rapports du pouvoir et de la loi.

Après l’effacement de l’unité impériale romaine au profit de royautés plurielles (Ve siècle), les penseurs (presque tous membres du clergé) intègrent certaines réflexions des antiques sur les finalités de la loi. Il s’agit d’œuvrer en vue de l’utilité commune et d’éviter tout abus de pouvoir du prince. Ils héritent également de la pensée juridique du Bas Empire chrétien, selon laquelle la loi doit s’efforcer d’orienter l’action des princes vers une réalisation spirituelle. Le bon prince doit légiférer pour Dieu et se soumettre lui-même aux lois qu’il impose à ses sujets. Pourtant, la persistance des vieilles pratiques germaniques – vengeance privée et autorégulation sociale des conflits – débouche, vers la fin du IXe siècle carolingien, sur un profond affaiblissement des royautés comme de leur capacité à « faire loi ».

Mettre en œuvre ce qui est utile à tous

Le XIIe siècle marque un renversement de tendance. La conjoncture économique, démographique et sociale est très favorable aux détenteurs des plus florissantes cités, aux premiers rangs desquels figurent les rois. L’essor de la production et du commerce à distance profite aux princes. Il profite aussi à ceux qui, appartenant au monde clérical des cités, traversent l’Europe pour s’instruire, puis entrent au service des souverains comme conseillers. La démarche intellectuelle de cette élite pensante témoigne d’une lente prise de conscience de la complexité croissante du corps social. Et de la naissance, en son sein d’une forte exigence de sûreté juridique, de liberté et d’identité communautaire.

La réflexion sur le pouvoir, s’inspirant notamment des œuvres de Cicéron, s’oriente ainsi progressivement vers l’idée d’une nature sociale de l’être humain. On réfléchit aussi sur la justice et sur la règle de droit et l’on insiste sur le but ultime de cette justice : mettre en œuvre ce qui est utile à tous et, par-delà, assurer le bien-être matériel et spirituel de la communauté en son entier.

Absolutisme princier versus « certaine science » de la communauté politique

Cette époque est également marquée par la redécouverte de l’immense œuvre juridique de l’empereur romain d’Orient Justinien (VIe siècle). Cet événement considérable suscite la naissance d’une étude textuelle, très tôt mise à profit par les entourages princiers à travers toute la chrétienté occidentale. Dans ce cercle étroit, le débat est lancé entre tenants d’un « absolutisme » princier et partisans d’une capacité propre de toute communauté à émettre ses propres règles.

Les premiers s’appuient sur certains passages de l’œuvre justinienne qui mettent l’accent sur la relation du prince à la loi, notamment deux aphorismes en provenance d’un jurisconsulte romain du IIIe siècle, Ulpien. « Ce qui a plu au prince à la vigueur de la loi ». Ce passage est suivi d’une explication affirmant que par la « lex regia » (loi d’investiture de l’empereur), le peuple romain transmet au prince tout son imperium (pouvoir de commandement) et toute sa potestas (puissance). Et puis :« Le prince est délié des lois », une sentence contraire au modèle du gouvernant soumis à la loi diffusé par la pensée chrétienne du haut Moyen Âge. Tout prince peut alors se prévaloir de ces textes pour affirmer sa pleine capacité à émettre la règle de droit ou à s’affranchir de celle-ci. De telles thèses circulent dès le XIIe siècle dans les entourages royaux.

Cependant, les savants qui glosent le droit romain ont aussi trouvé chez Justinien tel texte par lequel le prince déclare soumettre son autorité à celle du droit et sa propre personne aux lois. Ou tel autre plaidant en faveur d’une fonction législative revenant au peuple, voire d’un droit du peuple d’abroger la loi ou d’y déroger.

La théorie de la supériorité de la coutume générale d’un peuple sur la loi du prince, comme celle de la « certaine science » d’une communauté locale la rendant apte à déroger, en pleine conscience, à la règle générale, est un autre apport de ce XIIe siècle. Tout comme la réflexion, plus mesurée, de certains romanistes sur la nécessité, pour une communauté locale s’affranchissant d’une règle, d’agir avec sagesse et de se donner de nouvelles règles conformes à la raison. Ces exigences correctrices de la théorie première ouvrent la voie à la confirmation d’une capacité de suppression de la « mauvaise » coutume par le prince agissant lui aussi en vertu de sa propre « certaine science »

Aristote redécouvert

Jusqu’aux années 1250, c’est principalement dans le sillage de ces acquis que se situe la pensée juridico-politique. La réflexion très neuve sur le pouvoir normatif du prince est désormais un élément essentiel. Le XIIIe siècle est bien celui d’une montée en puissance des législations royales dans nombre de pays européens où semblent dans un premier temps prévaloir les aphorismes d’Ulpien.

La redécouverte, autour des années 1240-1260, de l’_Éthique à Nicomaque et de la Politique_ d’Aristote accélère l’évolution de la réflexion sur l’instrument du pouvoir que redevient la loi. La doctrine naturaliste d’Aristote (l’homme, voué à s’intégrer à une communauté, est par nature un « animal politique ») n’a pas pour conséquence immédiate une complète autonomie du politique vis-à-vis du théologique. Aux yeux des plus aristotéliciens des penseurs du temps, l’homme demeure un être voué à l’obéissance aux commandements divins. La vertu de charité qui lui est assignée implique cet amour du bien commun, vertu première du citoyen.

Il reste cependant que découvrir Aristote permet un remarquable enrichissement de la réflexion sur la communauté. Ici aussi le débat est vif entre juristes et théologiens-philosophes et débouche sur des visions contradictoires des droits de la multitude. Certains considèrent cette dernière comme ayant pleine capacité juridique à consentir aux actes du prince. D’autres persistent à la présenter comme l’équivalent juridique d’un mineur sous protection, son tuteur qu’est le prince disposant d’une plénitude de puissance.

Partager la confection de la loi avec le peuple ?

Si l’exigence du bien commun devient plus que jamais l’objet d’un discours rationnel, sa mise en œuvre, néanmoins, peut adopter deux voies bien différentes. La première s’appuie sur la lecture absolutiste de Justinien : elle insiste sur l’idéal du prince vertueux œuvrant au service de son peuple, apte à légiférer seul, mais en s’appuyant sur de sages conseillers ; apte aussi à ne jamais abuser d’une puissance qui ne connaît cependant d’autre frein que sa propre conscience.

La seconde est assurément nouvelle dans le contexte médiéval de cette fin du XIIIe siècle : mettre en œuvre les possibles alternatives qu’offrent deux éléments essentiels de la réflexion d’Aristote. L’un concerne les variantes qui peuvent modifier en profondeur chacun des trois régimes purs) que sont la monarchie, l’aristocratie et la démocratie ; l’autre porte sur sa préférence pour un régime privilégiant un droit de participation active aux affaires publiques accordé à une partie de la population, représentative d’un « juste milieu » social et garante d’un « juste milieu » éthique. Il s’agit ici d’empêcher toute dérive tyrannique provenant tant d’un monarque ou d’une oligarchie que d’un peuple sans vertu.

Le XIVe siècle verra ainsi croître les théories prônant le recours, par le monarque, au dialogue voire au partage de la confection de la loi avec son peuple. Certaines de ces théories iront même jusqu’à afficher l’idée d’une sorte de souveraineté de principe du peuple en matière législative (Marsile de Padoue, Nicole Oresme).

En cette fin de Moyen Âge, la pensée politique, progressivement mise à portée d’une élite plus large, s’est ainsi orientée vers certaines thèses qui préfigurent le « constitutionnalisme » moderne et aussi, à certains égards, vers ce que la doctrine politique occidentale appelle de nos jours « l’État de droit ». Il est cependant vrai que certaines conditions de cet État de droit (séparation des pouvoirs législatif, exécutif et judiciaire, pleine souveraineté de tout un peuple liée à une pleine égalité de droit de ses membres) ne seront guère acquises à la fin du XVe siècle.

La réflexion sur le politique, on le sait, s’orientera aussi vers l’autre thèse développée dès le XIIe siècle, celle de la toute-puissance d’un prince « absous des lois ». Elle débouchera au tournant des XVIe et XVIIe siècles sur des parenthèses absolutistes parfois courtes et vouées à l’échec comme dans l’Angleterre des Stuarts, parfois plus longues comme dans la France des Bourbons.

Yves Sassier est l’auteur du Prince et la loi en Occident. VIe siècle av. J.-C.-début XVe siècle, Presses universitaires de France, juin 2025.

Yves Sassier ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Lava

- La revue des médias

- Le Grand Continent

- Le Diplo

- Le Nouvel Obs

- Lundi Matin

- Mouais

- Multitudes

- Politis

- Regards

- Smolny

- Socialter

- The Conversation

- UPMagazine

- Usbek & Rica

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- Contretemps

- A Contretemps

- Alter-éditions

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- Philo Mag

- Terrestres

- Vie des Idées

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview

- Fiabilité 3/5

- Slate

- Ulyces

- Fiabilité 1/5

- Contre-Attaque

- Issues

- Korii

- Positivr

- Regain