ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

23.09.2025 à 16:15

Peaux artificielles : comment reproduire la complexité de la peau humaine… jusqu’à son interaction avec le parfum

Géraldine Savary, Enseignant-chercheur en analyse sensorielle dans le domaine des arômes, parfums et cosmétiques, Université Le Havre Normandie

Céline Picard, Professeure des universités en chimie organique et macromoléculaire, Université Le Havre Normandie

Texte intégral (1919 mots)

Pourquoi un parfum ne tient-il pas de la même façon sur toutes les peaux ? Pourquoi certaines crèmes collent-elles davantage sur certains types de peau ? Ces différences, chacun les remarque, mais on ne les comprend pas encore très bien.

Depuis une dizaine d’années, nous travaillons à percer les mystères de la peau, et de la manière dont elle interagit avec les produits dermatologiques, les cosmétiques et les parfums en développant une réplique de peau humaine, sans cellule mais riche d’informations physico-chimiques.

Comprendre la peau avant de la reproduire

La peau est bien plus qu’un simple revêtement. Elle est un tissu complexe, à la fois barrière, capteur et interface chimique. Sa surface varie selon les individus : celle d’un bébé joufflu est moins rugueuse et plus hydratée que celle d’une personne âgée. Ces différences influencent non seulement la sensation mécanique au toucher et l’apparence mais aussi la répartition du sébum et donc la chimie de sa surface. Avec toutes ses propriétés qui s’entremêlent, ces phénomènes sont difficiles à modéliser.

Or, pour imiter la peau de manière crédible, il faut d’abord la caractériser précisément.

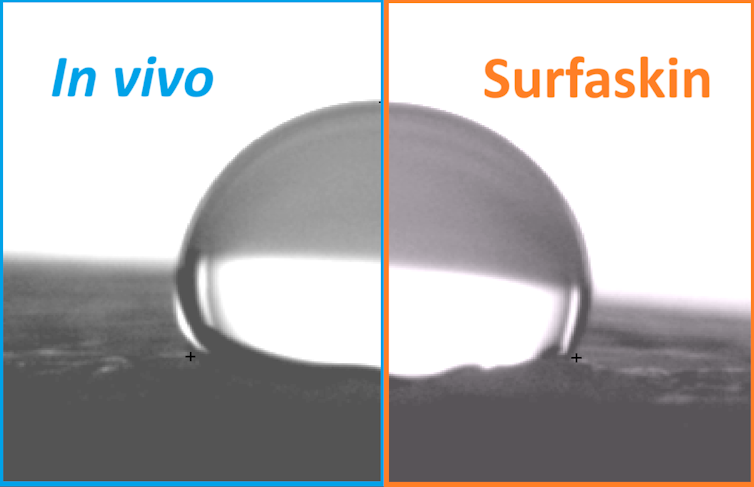

Notre équipe réalise chaque année des campagnes de mesures in vivo sur plusieurs centaines de volontaires. Nous analysons des paramètres comme la rugosité, la couleur, la composition lipidique (le gras) ou encore la mouillabilité (comment une goutte d’eau s’étale sur la peau).

Ces données, traitées statistiquement, permettent d’établir une « cartographie » des surfaces cutanées humaines et d’en quantifier la variabilité d’une personne à l’autre.

Les peaux artificielles

Les peaux artificielles ne sont pas nouvelles. On utilise depuis les années 1930 des modèles dits « biologiques » en dermatologie, comme des explants de peau humaine (petits morceaux de peau humaine prélevée lors d’une chirurgie et maintenue vivante en laboratoire), des peaux reconstruites à partir de cultures cellulaires, ou encore des peaux animales (notamment celle du porc, la plus proche de la peau humaine).

Plus récemment, depuis les années 2000, des peaux dites « électroniques » ou e-skins ont vu le jour, capables de capter diverses données pour des applications en robotique ou en médecine. Il s’agit de matériaux polymères souples, souvent sous forme de patch, qui collent sur la peau comme une seconde peau. Elles contiennent de minuscules capteurs capables de mesurer la pression, la température, ou des substances comme le glucose ou l’alcool dans la sueur, pour contrôler, reproduire ou ajuster ce qui se passe dans le corps.

Néanmoins, ces solutions biologiques et électroniques présentent souvent des limites : les peaux reconstruites sont coûteuses et peu reproductibles, les explants de peaux fragiles, de durée d’utilisation limitée et soumis à une variabilité biologique, et les peaux animales soulèvent des contraintes éthiques. De plus, un certain nombre d’entre elles, comme les peaux reconstruites et électroniques, ne reflètent pas fidèlement la chimie de surface de la peau humaine.

À lire aussi : Cosmétiques : le « Made in France » en pleine lumière

Notre modèle synthétique : SURFASKIN

À partir de cette base de données, nous avons conçu un modèle de peau artificielle non biologique, développé initialement dans le cadre du projet FUI URBASKIN. Contrairement aux peaux cellulaires ou biologiques utilisées en laboratoire, SURFASKIN est une surface polymérique, stable dans le temps, peu coûteuse, facilement reproductible.

Notre peau artificielle synthétique est également exempte de cellules vivantes. En effet, elle ne vise pas à reproduire les fonctions biologiques de la peau, mais ses propriétés de surface, celles qui conditionnent la manière dont la peau interagit avec son environnement en reproduisant fidèlement le microrelief de l’épiderme, ainsi que la composition et la pigmentation de sa surface.

Ce modèle a d’abord été pensé pour simuler l’exposition de la peau à des polluants atmosphériques, comme les particules urbaines ou la fumée de cigarette, afin de comprendre leur capacité à y pénétrer et à altérer ses propriétés. Avec des mesures combinées (in vivo, explants, SURFASKIN), nous avons démontré que les polluants désorganisent la structure lipidique et provoquent des phénomènes d’oxydation, tandis que certains produits dermocosmétiques peuvent ralentir ces effets de manière ciblée pour renforcer la fonction barrière de l’épiderme.

Très vite, notre modèle a trouvé d’autres applications, notamment en cosmétique et dermatologie. Ainsi, SURFASKIN permet d’évaluer l’étalement de crèmes hydratantes, la couvrance des maquillages, ou encore la résistance à l’eau des protections solaires, avec un haut degré de représentativité. Ainsi, en appliquant une crème teintée sur la peau ou sur SURFASKIN, le film résiduel conserve les mêmes propriétés, tant en épaisseur qu’en composition, ce qui reproduit fidèlement des caractéristiques, comme le toucher collant ou le pouvoir couvrant.

SURFASKIN s’inscrit dans la tendance des peaux artificielles, tout en comblant un vide : celui d’un modèle robuste, passif, mais suffisamment précis pour simuler les interactions de surface. Il ne remplace pas les tests biologiques, mais les complète, en offrant un outil éthique et reproductible pour la recherche et le développement de cosmétiques et de produits dermatologiques.

Malgré ses atouts, SURFASKIN présente encore des limites, laissant la voie ouverte à de futurs développements pour mieux comprendre le rôle du microbiote cutané, par exemple, reproduire la pénétration des substances au sein de la peau, étudier les interactions biologiques avec les cellules, ou même intégrer des capteurs miniaturisés capables de mesurer d’autres paramètres, comme la pression lors de l’application d’un produit.

Le cas du parfum : vers une parfumerie personnalisée ?

Un nouveau champ d’application émerge aujourd’hui : la parfumerie. Il est bien connu des parfumeurs qu’un parfum « ne tient pas » de la même façon selon les personnes, c’est-à-dire qu’il n’adhère et ne s’évapore pas de la même façon selon les types de peau.

Ce phénomène, souvent attribué à la « magie du corps », repose en réalité sur des facteurs physico-chimiques : le pH, la présence de sébum, la température, la rugosité de la peau influencent la diffusion et la rémanence des molécules odorantes.

Avec SURFASKIN, nous développons désormais des répliques de peau reproduisant ces variations, pour tester de manière rigoureuse l’adhérence et l’évaporation des parfums. C’est une avancée inédite : si l’industrie du luxe explore la question des parfums sur mesure depuis longtemps, elle reste peu documentée scientifiquement, surtout quand il s’agit d’une personnalisation en fonction du type de peau.

À terme, ces travaux pourraient donc ouvrir la voie à des parfums personnalisés, conçus non plus uniquement pour une image ou une émotion, mais pour les propriétés chimiques individuelles de chacun.

Une technologie au service de la recherche et de l’industrie

En collaboration avec Normandie Valorisation, nos travaux visent à faciliter le transfert de cette innovation vers les acteurs industriels de la cosmétique et de la parfumerie. La France, leader mondial dans ces secteurs, dispose d’un écosystème favorable à ce type de développement, à l’interface entre science académique et innovation appliquée.

SURFASKIN illustre une nouvelle manière de faire de la recherche : en créant des outils concrets, fiables, éthiques, et utiles pour comprendre des phénomènes du quotidien. Sous les apparences simples d’une crème ou d’un parfum, c’est tout un monde physico-chimique que l’on commence à explorer.

Céline Picard participera à une table ronde sur le thème « À fleur de peau : chimie, biologie et équilibre », vendredi 26 septembre, dans le cadre de l’événement scientifique Sur les épaules des géants qui se tient du 25 au 27 septembre au Havre (Seine-Maritime).

Géraldine Savary a reçu des financements pour des recherches doctorale de l'Université Le Havre Normandie, La Région Normandie, l'Agence Nationale de la Recherche.

Céline Picard a reçu des financements de L'Université Le Havre Normandie, de Normandie Université, de Le Havre Seine Métropole, de la Région Normandie, de l'Agence Nationale pour la Recherche et de l'Europe pour des projets de recherche dont des projets de recherches doctorales

19.09.2025 à 12:01

Ce qu’avoir un chat fait à votre cerveau (et au sien)

Laura Elin Pigott, Senior Lecturer in Neurosciences and Neurorehabilitation, Course Leader in the College of Health and Life Sciences, London South Bank University

Texte intégral (1907 mots)

Caresser un chat, l’entendre ronronner n’a rien d’anodin : derrière ces instants se cache une réaction chimique qui renforce la confiance et diminue le stress, autant chez l’humain que chez l’animal.

Les chats ont beau avoir la réputation d’être indépendants, des recherches récentes suggèrent que nous partageons avec eux un lien unique, alimenté par la chimie du cerveau.

Au cœur du processus se trouve l’ocytocine, fréquemment désignée comme l’« hormone de l’amour ». Cette même substance neurochimique est libérée lorsqu’une mère berce son bébé ou lorsque des amis s’étreignent ; elle a un effet bénéfique sur la confiance et l’affection. Et aujourd’hui, des recherches indiquent qu’elle joue également un rôle important dans la relation entre les chats et les humains.

L’ocytocine est au cœur des liens sociaux, c’est-à-dire de la capacité d’entrer en contact avec les autres et de leur faire confiance, ainsi que de la régulation du stress, et ce tant chez les animaux que chez les humains. Une expérience menée en 2005 a montré qu’elle rendait des volontaires humains nettement plus enclins à faire confiance aux autres dans des opérations boursières fictives.

Cette hormone a aussi des effets apaisants, chez les humains comme chez les animaux : elle réduit le cortisol, l’hormone du stress, et active le système nerveux parasympathique — celui du repos et de la digestion — pour aider le corps à se détendre.

Les scientifiques savent depuis longtemps que les interactions amicales entre les chiens et leurs propriétaires déclenchent la libération d’ocytocine, créant une véritable boucle de rétroaction affective. Mais chez les chats, ce phénomène restait moins étudié.

Moins démonstratifs que les chiens, les chats expriment leur affection de façon plus subtile. Pourtant, leurs propriétaires décrivent souvent les mêmes bénéfices : chaleur, réconfort, baisse du stress. Les recherches confirment peu à peu ces témoignages. Ainsi des chercheurs japonais ont montré en 2021 que de brèves séances de caresses avec un chat augmentaient le taux d’ocytocine chez de nombreux propriétaires.

Dans le cadre de cette étude, des femmes passaient quelques minutes à interagir avec leur chat pendant que les scientifiques mesuraient leurs niveaux hormonaux. Résultat : le contact amical (caresser, parler doucement) entraînait une hausse d’ocytocine dans la salive.

Beaucoup trouvent apaisant de caresser un chat qui ronronne, et ce n’est pas qu’une question de douceur du pelage. Le simple fait de caresser un chat — ou même d’entendre son ronronnement — stimule la production de cette hormone dans le cerveau. Une étude de 2002 a montré que ce pic d’ocytocine, déclenché par le contact, contribue à réduire le cortisol, ce qui peut ensuite faire baisser la tension artérielle, et même la douleur.

Quand l’ocytocine circule-t-elle entre les chats et les humains ?

Les chercheurs commencent à identifier les moments précis qui déclenchent cette hormone de l’attachement dans la relation humain-chat. Le contact physique doux semble être le facteur principal.

Une étude publiée en février 2025 montre que lorsque les propriétaires caressent, câlinent ou bercent leurs chats de manière détendue, leur taux d’ocytocine a tendance à augmenter, tout comme celui des félins, à condition cependant que l’interaction ne soit pas forcée.

Les chercheurs ont surveillé le taux d’ocytocine chez les chats pendant 15 minutes de jeu et de câlins à la maison avec leur propriétaire. Quand les chats étaient à l’initiative du contact, par exemple en s’asseyant sur les genoux ou en donnant des petits coups de tête, ils présentaient une hausse significative d’ocytocine. Plus ils passaient de temps auprès de leur humain, plus l’augmentation était marquée.

Qu’en est-il des félins moins câlins ? La même étude a noté des schémas différents chez les chats ayant des styles d’attachement plus anxieux ou distants. Les chats dits « évitants », qui gardent leurs distances, ne présentaient aucun changement significatif de leur taux d’ocytocine, tandis que les chats anxieux (toujours en quête de leur maître, mais vite submergé) avaient un taux d’ocytocine élevé dès le départ.

Chez ces derniers, comme chez les chats évitants, les câlins imposés faisaient baisser le niveau d’ocytocine. Autrement dit : quand l’interaction respecte le rythme du chat, le lien s’approfondit ; quand elle est forcée, l’hormone de l’attachement diminue.

Les humains pourraient en tirer une leçon : la clé pour créer un lien fort avec un chat est de comprendre son mode de communication.

Contrairement aux chiens, les chats ne s’appuient pas sur un contact visuel prolongé pour créer des liens. Ils utilisent des signaux plus subtils, comme le clignement lent des yeux — un « sourire félin » qui exprime sécurité et confiance.

Le ronronnement joue aussi un rôle central. Son grondement grave est associé non seulement à l’autoguérison chez le chat, mais aussi à des effets apaisants chez les humains. L’écouter peut réduire la fréquence cardiaque et la tension artérielle et l’ocytocine contribue à ces bienfaits.

Ainsi, la compagnie d’un chat — renforcée par toutes ces petites poussées d’ocytocine issues des interactions — peut agir comme un véritable bouclier contre le stress, l’anxiété et parfois même la dépression, offrant un réconfort proche dans certains cas de celui d’un soutien humain.

Les chats sont-ils moins affectueux que les chiens ?

Les études montrent en effet que l’ocytocine est généralement plus fortement libérée dans les interactions homme-chien. Dans une expérience célèbre menée en 2016, des scientifiques ont mesuré l’ocytocine chez des animaux de compagnie et leurs propriétaires avant et après dix minutes de jeu. Les chiens ont montré une augmentation moyenne de 57 % après avoir joué, contre environ 12 % chez les chats.

Chez l’humain aussi, l’ocytocine grimpe davantage quand les interactions sociales sont fortes. Des études montrent que le contact avec un être cher produit des réponses plus fortes en ocytocine que le contact avec des étrangers. Cela explique pourquoi l’accueil enthousiaste d’un chien peut ressembler à l’émotion ressentie face à un enfant ou un partenaire.

Les chiens, animaux de meute domestiqués pour vivre aux côtés des humains, sont quasiment programmés pour rechercher le contact visuel avec nous, nos caresses et notre approbation — autant de comportements qui stimulent l’ocytocine des deux côtés. Les chats, eux, descendent de chasseurs solitaires et n’ont pas développé les mêmes signaux sociaux démonstratifs. Ils libèrent donc de l’ocytocine plus rarement, souvent seulement quand ils se sentent en sécurité.

La confiance d’un chat ne s’acquiert pas automatiquement, elle se mérite. Mais une fois acquise, elle est renforcée par la même molécule qui unit parents, partenaires et amis humains.

Ainsi, la prochaine fois que votre chat clignera doucement des yeux depuis le canapé ou se pelotera en ronronnant sur vos genoux, souvenez-vous : il ne se passe pas seulement quelque chose de tendre. Dans vos deux cerveaux, l’ocytocine circule, renforçant la confiance et apaisant le stress. Les chats, à leur manière, ont trouvé comment activer en nous la chimie de l’amour.

Laura Elin Pigott ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

18.09.2025 à 16:11

Selon le sport pratiqué, les athlètes n’auraient pas la même probabilité de donner naissance à une fille ou à un garçon

Favier François, Enseignant Chercheur en STAPS, Université de Montpellier

Florian Britto, Chercheur, Université Paris Cité

Grégoire Millet, Professeur en physiologie environnementale et physiologie de l'exercice, Université de Lausanne

Texte intégral (1962 mots)

Une récente étude vient de mesurer que, chez les sportifs de haut niveau, leur discipline peut influencer sur la probabilité de donner naissance plutôt à une fille qu’à un garçon. Quelles pourraient-être les hypothèses pour expliquer cette « étrangeté » ?

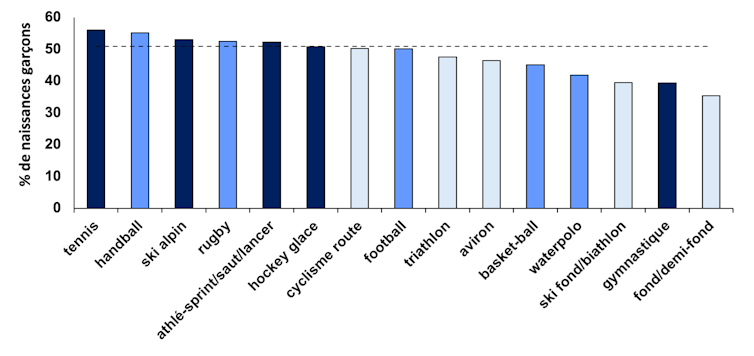

Les chercheurs en sciences du sport ont parfois de drôles de conversations : il y a environ un an, nous discutions de l’influence de la discipline sportive sur le sexe des enfants de sportifs. Ça parait incongru de prime abord, mais il se disait que les sportifs d’endurance avaient plus de filles… En discutant et en prenant en exemple nos connaissances, ou d’illustres athlètes, cette rumeur semblait se confirmer. Mais aucun travail scientifique solide n’avait été fait : nous avons donc mené l’enquête ! Et oui, nos analyses portant sur près de 3 000 naissances confirment cette idée : un athlète de haut niveau en triathlon ou ski de fond a moins de probabilité d’avoir un garçon qu’un professionnel en sports collectifs ou en tennis.

Comment en sommes-nous arrivés à ces conclusions ? D’abord il faut trouver les données. Et pour cela, nous avons utilisé les informations fournies par les sportifs eux-mêmes via les réseaux sociaux, les sites de magazines spécialisés, de journaux, les fiches Wikipédia ou directement par questionnaire. Commence alors un long et fastidieux travail de collecte auprès de sportifs professionnels ou avec des sélections en équipe nationale. On note l’âge des sportifs, leur discipline sportive, les dates de leur carrière et bien sûr l’année de naissance et le sexe de leur progéniture. On sait que dans la population générale, il y a entre 1.03 à 1.05 garçons pour 1 fille, et ce résultat est très stable à travers le monde et le temps. Nous avons comparé les résultats chez nos sportifs avec ces valeurs et également les disciplines entre elles pour savoir si nous pouvions identifier des critères associés aux naissances de filles ou de garçons.

Près de 3 000 naissances analysées

Résultat : 2 995 naissances entre 1981 et 2024 issues de sportifs de plus de 80 pays et de 45 disciplines sportives différentes ont été analysées, dont un peu moins de 20 % de sportives (ce ratio étant dû principalement à la disponibilité des données qui découlent notamment d’une plus grande mise en avant médiatique des sportifs par rapport aux sportives). Premier enseignement, chez nos sportifs on observe 0.98 naissance garçon pour 1 naissance fille, soit moins que chez les non-sportifs. Nous sommes sur la bonne voie. Pour voir si la discipline sportive influence le sexe des enfants, on classe les sports en fonction du pourcentage de naissances de garçons observées dans chaque sport et on constate qu’il y a des écarts très importants (56 % à 35 % de naissances masculines) entre le tennis, le handball et le ski d’un côté (avec beaucoup de garçons), et le ski de fond/biathlon, la gymnastique ou la course de fond et demi-fond de l’autre.

En observant ces résultats, on note que cela se complique un peu, car la gymnastique ou le water-polo, qui ne sont pas vraiment considérés comme des sports d’endurance, semblent aussi influencer le sexe de la progéniture des athlètes vers une augmentation des naissances de filles. En revanche, on voit apparaître un autre élément : les sportives mettent au monde significativement moins de garçons que les sportifs (0.85 garçon pour 1 fille, contre 1.02 pour 1 chez les hommes).

Pour y voir plus clair, on regroupe les différentes disciplines au sein de quatre catégories : endurance (cyclisme, ski de fond…), puissance (ski de descente, sauts et lancers…), mixte (sports collectifs) et précision (tir, golf…). On ajoute les critères : sexe de l’athlète et date de la naissance par rapport à la carrière du sportif (pendant ou après sa carrière). On réalise ensuite une analyse par arbre de classification. Cela revient à séparer l’échantillon en sous-groupes distincts avec les critères spécifiés, si ces derniers ont un pouvoir prédictif sur le sexe de la progéniture.

En réalisant cette analyse statistique, on peut conclure que c’est bien la discipline sportive qui pèse le plus, les sportifs pratiquant les sports d’endurance ou de précision engendrant significativement plus de naissances de filles et moins de naissances de garçons que les deux autres (mixte et puissance). Puis, au sein du sous-groupe de sportifs qui pratiquent l’endurance ou les sports de précision, le sexe du sportif lui-même est un prédicteur du sexe de sa progéniture : les sportives de ce sous-groupe engendrent 0.7 garçon pour 1 fille contre 0.91 chez les messieurs.

Enfin, dernier effet, au sein des sportives d’endurance et de précision, le fait d’avoir un enfant pendant ou après sa carrière a une grosse incidence puisque la probabilité est de seulement 0.58 garçon pour 1 fille quand la naissance survient pendant la carrière contre 0.81 après la carrière.

Finalement, le sous-groupe pour lequel l’effet de la pratique sportive à haut niveau est le plus marqué est celui constitué par les sportives qui pratiquent un sport d’endurance ou de précision et qui ont un enfant pendant leur carrière. Chez elles, la probabilité d’avoir une fille ou un garçon est de 63 % vs. 37 %, alors que c’est environ 49 vs. 51 % dans la population mondiale.

Quelles sont les hypothèses ?

Comment expliquer une telle différence ? À ce stade, on ne peut émettre que des hypothèses.

Une des causes pourrait être liée au profil hormonal des parents au moment de la conception. En effet, de hauts niveaux de testostérone ou d’œstrogènes favoriseraient les naissances masculines, à l’inverse de la progestérone ou du cortisol. Or le rapport testostérone/cortisol a été proposé en sport comme marqueur de surentraînement.

Une autre cause physiologique pourrait être la dépense énergétique liée à l’activité physique. En effet, le développement au stade embryonnaire est plus coûteux en énergie pour les fœtus mâles que pour les fœtus femelles.

Le nombre d’heures passées à s’entraîner ainsi que l’intensité des entraînements modifierait le statut hormonal et/ou l’état énergétique de l’organisme avant la conception, ce qui pourrait influencer le sexe de la progéniture des sportifs.

En accord avec cette hypothèse, il a été montré sur un échantillon de footballeurs chiliens que ceux qui s’entraînaient le plus avaient plus de filles que les autres. Même constat chez les animaux : les souris femelles gestantes qui courent le plus font moins de souriceaux mâles. Le nombre d’heures d’entraînement hebdomadaire expliquerait aussi le faible nombre de garçons chez les gymnastes et les poloïstes, deux sports avec un volume d’entraînement important. Mais les aspects psycho-sociologiques pourraient aussi contribuer à influencer le sexe des enfants de sportifs. Par exemple, une bonne situation financière serait associée à une augmentation des naissances masculines dans la population générale.

Les différences de revenus entre les disciplines sportives, entre les hommes et les femmes, ou l’incertitude liée à l’après-carrière pourraient donc contribuer aux variations observées. La liste des autres paramètres susceptibles d’influencer le sexe des enfants de sportifs est longue (profil du partenaire, utilisation possible de certaines substances pharmacologiques, bilan alimentaire/énergétique, situation politique du pays, etc.). De nouvelles études standardisées seront donc nécessaires pour élucider ces observations. D’un point de vue des hypothèses physiologiques, il serait intéressant de comparer le profil hormonal, la dépense énergétique et le volume d’entraînement des athlètes parents de petits garçons avec ceux parents de petites filles. Des études plus poussées sur la qualité du sperme des athlètes masculins et l’adaptation du tractus génital des athlètes féminines en réponse à leur pratique seraient aussi très intéressantes. Enfin, il serait aussi pertinent de mesurer l’impact d’un meilleur aménagement socio-économique de la carrière des sportives sur le sexe de leur progéniture.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

17.09.2025 à 16:29

Pourquoi tout le monde n’a pas le sens de l’orientation

Atlas Thébault Guiochon, Ingénieur·e en neurosciences cognitives et Enseignant·e, Université Lumière Lyon 2

Texte intégral (1610 mots)

Vous êtes plutôt du genre à vous repérer partout dès la première fois, ou à encore sortir le GPS après plusieurs années dans le même quartier ? Ah ! le fameux « sens de l’orientation » ! On entend souvent que les femmes en manqueraient, tandis que les hommes posséderaient « un GPS intégré ». Mais la réalité est beaucoup plus subtile… Alors, d’où vient ce « sens de l’orientation », et pourquoi diffère-t-il tant d’une personne à l’autre ?

Vous marchez dans la rue à la recherche de l’adresse que votre amie vous a donnée… mais qu’est-ce qui se passe dans votre cerveau à ce moment-là ? La navigation spatiale mobilise un véritable orchestre de nombreuses fonctions cognitives.

D’un côté, des processus dits de « haut niveau » : localiser son corps dans l’espace, se représenter mentalement un environnement, utiliser sa mémoire, planifier un itinéraire ou encore maintenir un objectif. De l’autre, des processus plus automatiques prennent le relais : avancer, ralentir, tourner… sans même y penser.

En réalité, le « sens de l’orientation » n’est pas une capacité unique, mais un ensemble de tâches coordonnées, réparties entre différentes zones du cerveau, qui travaillent de concert pour que vous arriviez à bon port.

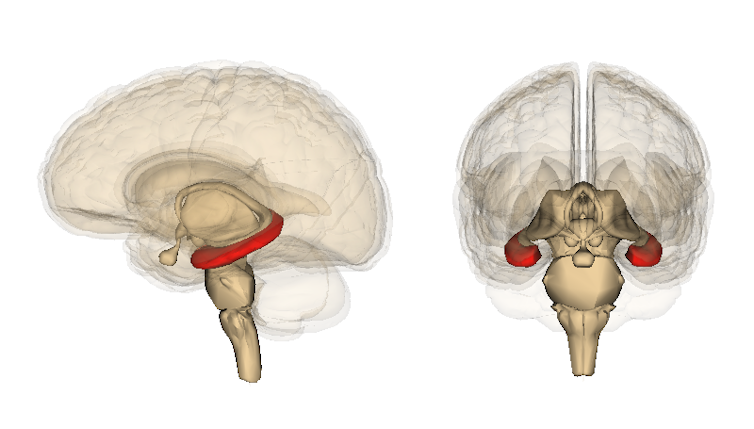

Le cerveau cartographe

S’il existe bien une structure cérébrale particulièrement impliquée, c’est l’hippocampe. Cette structure jumelle, une par hémisphère, possède une forme allongée qui rappelle le poisson dont elle tire son nom.

Son rôle dans la navigation spatiale est souvent illustré par une étude devenue emblématique.

L’équipe de recherche s’intéressait à la plasticité cérébrale, cette capacité du cerveau à se réorganiser et à adapter ses connexions en fonction des apprentissages. Elle a alors remarqué que la partie postérieure de l’hippocampe des conducteurs et conductrices de taxi à Londres était plus développée que celle de personnes n’ayant pas à mémoriser le plan complexe de la ville et qui n’y naviguent pas au quotidien. Preuve, s’il en fallait, que notre cerveau s’adapte selon les expériences.

Le sens de l’orientation n’est pas inné

C’est une des questions qu’a voulu explorer Antoine Coutrot au sein d’une équipe internationale, en développant Sea Hero Quest, un jeu mobile conçu pour évaluer nos capacités de navigation. Le jeu a permis de collecter les données de plus de 2,5 millions de personnes à travers le monde, du jamais vu à cette échelle pour le domaine.

Les participant·e·s ne partageaient pas seulement leurs performances dans le jeu, mais fournissaient également des informations démographiques (âge, genre, niveau d’éducation, etc.), la ville dans laquelle iels avaient grandi, ou encore leurs habitudes de sommeil.

Alors, les hommes ont-ils vraiment « un GPS dans la tête » ? Pas tout à fait.

Les données révèlent bien une différence moyenne entre les sexes, mais cette différence est loin d’être universelle : elle varie en fonction du pays, et tend à disparaître dans ceux où l’égalité de genre est la plus forte. En Norvège ou en Finlande, l’écart est quasi nul, contrairement au Liban ou à l’Iran. Ce ne serait donc pas le sexe, mais les inégalités sociales et les stéréotypes culturels qui peuvent, à force, affecter la confiance des personnes en leur capacité à se repérer, et donc leurs performances réelles.

L’âge joue aussi un rôle : durant l’enfance, nous développons très tôt les compétences nécessaires à l’orientation et à la navigation spatiales. Après 60 ans, les capacités visuospatiales déclinent, tout comme le sens de l’orientation, qui repose, comme on l’a vu, sur de nombreuses fonctions cognitives.

À lire aussi : Proprioception et équilibre : notre « sixième sens » varie d’un individu à l’autre

… mais façonné par l’environnement

L’endroit dans lequel on grandit semble également impliqué. Celles et ceux qui ont grandi dans de petits villages sont souvent plus à l’aise dans de grands espaces. À l’inverse, les citadin·e·s, habitué·e·s à tout avoir à quelques pas, se repèrent mieux dans les environnements denses et complexes.

La forme même de la ville, et plus précisément son niveau d’organisation (que l’on appelle parfois « entropie »), influence également nos capacités d’orientation. Certaines villes très organisées, aux rues bien alignées, comme de nombreuses villes états-uniennes, présentent une entropie faible. D’autres, comme Paris, Prague ou Rome, plus « désorganisées » à première vue, possèdent une entropie plus élevée. Et ce sont justement les personnes ayant grandi dans ces villes à forte entropie qui semblent développer un meilleur sens de l’orientation.

Même l’âge auquel on apprend à conduire peut jouer. Les adolescent·e·s qui prennent le volant avant 18 ans semblent mieux se repérer que celles et ceux qui s’y mettent plus tard. Une exposition plus précoce à la navigation en autonomie sans aide extérieure (adulte, GPS…) pourrait donc renforcer ces compétences.

En somme, ce qu’on appelle le sens de l’orientation n’est pas prédéfini. Il se construit au fil des expériences, de l’environnement, et des apprentissages.

Atlas Thébault Guiochon ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

17.09.2025 à 13:36

« Tout le monde est potentiellement la cible des cybercriminels », conversation avec Jean-Yves Marion

Jean-Yves Marion, Professeur d'informatique, Université de Lorraine

Texte intégral (4221 mots)

Vous avez peut-être déjà été victime d’un virus informatique. Le terme date de 1984 et on le doit à Fred Cohen, un chercheur américain. Pourtant, la notion de virus est intrinsèquement liée à celle même de l’informatique, dès ses origines, avec les travaux d’Alan Turing dans les années 1930 et, par la suite, avec les programmes autoréplicants. Aujourd’hui, ce terme n’est plus vraiment utilisé, on parlera plutôt de logiciels malveillants. Jean-Yves Marion est responsable du projet DefMal du programme de recherche PEPR France 2030 Cybersécurité qui porte sur la lutte contre ce qu’on appelle aussi les « malwares ».

Il répond aux questions de Benoît Tonson, chef de rubrique Sciences et technologies à « The Conversation France », pour nous faire pénétrer les secrets des cybercriminels et comprendre comment ils arrivent à pénétrer des systèmes informatiques et à escroquer leurs victimes.

The Conversation : Comment vous êtes-vous intéressé au monde des logiciels malveillants ?

Jean-Yves Marion : J’ai fait une thèse à l’Université Paris 7 en 1992 (aujourd’hui, Paris Cité) sur un sujet d’informatique fondamental de logique et de complexité algorithmique. C’était assez éloigné de la cybersécurité, ce qui m’intéressait quand j’étais jeune, c’était de comprendre les limites de ce qui est calculable par ordinateur quand les ressources sont bornées.

Plus tard, on pourrait dire que j’ai fait une « crise de la quarantaine » mais version chercheur. J’ai eu envie de changement et de sujets plus appliqués, plus en prise avec les enjeux de société. J’avais besoin de sortir de la théorie pure. J’ai passé ce cap en 2004. Et j’ai commencé à m’intéresser à ce que l’on appelait, encore à l’époque, les virus ; en gros, des programmes capables de se reproduire, de se dupliquer. Dans le mot « virus », il y a toujours eu le côté malveillant, mais ce qui m’intéressait, c’était le côté théorique de la reproduction de programme.

Finalement, je me suis passionné pour le sujet. J’étais déjà au Loria (Laboratoire lorrain de recherche en informatique et ses applications) que j’ai dirigé à partir de 2012 pendant onze ans. J’ai commencé à étudier les virus et à travailler avec de vrais programmes malveillants. D’ailleurs, la direction du laboratoire de l’époque s’était inquiétée, je pense à juste titre, de nos activités. Elle avait peur qu’à force d’exécuter des programmes malveillants sur nos ordinateurs pour comprendre comment ils fonctionnaient, ils puissent passer sur le réseau national de télécommunications pour la technologie, l’enseignement et la recherche (Renater) et qu’on soit bannis de la recherche publique à vie ! J’exagère, bien sûr, mais on a tout de même eu l’idée de construire une plateforme de recherche qu’on appelle maintenant le laboratoire de haute sécurité (LHS) et qui est un lieu qui se trouve au sous-sol de notre bâtiment. Il permet d’analyser les virus en toute sécurité, car il a son propre réseau qui n’est connecté à aucun autre. Les travaux ont continué et ont pris petit à petit de l’ampleur, notamment en termes de financement de la recherche.

Aujourd’hui on n’utilise plus le terme de « virus », on parle plutôt de programmes « malveillants » (malware en anglais). On va également parler de « rançongiciels », d’infostealers (« voleurs d’information »), des logiciels créés dans le but de pénétrer les systèmes d’information et d’y voler des informations sensibles ; de « bots espions »… Il existe également des stalkerwares, des logiciels installés sur un smartphone par exemple, qui permettent de suivre l’activité de ce dernier et suivre à la trace les déplacements d’une personne.

Parlons plus en détail des « rançongiciels » : qu’est-ce que c’est ?

J.-Y. M. : Un « rançongiciel », c’est un programme malveillant qui va s’infiltrer à l’insu de la victime et dont l’objectif est soit d’exfiltrer des données, soit de les chiffrer de manière à demander une rançon, soit de faire les deux. On parle souvent des attaques avec chiffrement de données, car elles peuvent bloquer une organisation entière et empêcher le travail d’une entreprise ou d’une organisation publique. Il ne faut pas pour autant négliger la simple, si je peux dire, exfiltration qui est également beaucoup utilisée avec un levier de pression et un discours assez simple de la part de l’attaquant : « On a des informations personnelles, si tu ne payes pas, on divulgue. » La victime peut être une personne ou une entreprise ou un organisme comme un hôpital, une université, une administration, par exemple.

Les cibles sont donc multiples…

J.-Y. M. : Je pense que le premier élément à bien comprendre, c’est que la plupart des attaques sont extrêmement opportunistes, cela signifie que tout le monde est potentiellement une cible.

Les grosses entreprises peuvent être particulièrement visées parce que l’on peut espérer extorquer des rançons beaucoup plus grosses et gagner beaucoup plus d’argent que si l’on s’attaquait à une PME. C’est plus difficile et également plus risqué dans le sens où la police va très probablement intervenir.

L’exemple d’école, c’est l’attaque, en 2021, sur l’entreprise américaine Colonial Pipeline qui opère un réseau d’oléoducs à partir du Texas vers le sud-est des États-Unis. Il s’agissait de la plus grande cyberattaque contre une infrastructure pétrolière de l’histoire des États-Unis menée par le groupe DarkSide. L’entreprise avait payé une rançon de 75 bitcoins, soit à l'époque environ 4 millions de dollars. Somme en partie retrouvée par les autorités américaines. DarkSide a ensuite déclaré cesser toutes ses opérations sous les pressions américaines.

Plus généralement, les cibles dépendent des politiques des groupes de cybercriminels : certains vont se spécialiser dans des cibles visibles à gros revenus et d’autres vont plutôt attaquer des « petits poissons » à petit revenu.

Vous parlez de groupes, or, dans l’imaginaire collectif, le pirate informatique est plutôt seul dans sa cave, qu’en est-il dans la réalité ?

J.-Y. M. : C’est rarement une personne seule qui va mener une attaque. En général, ce sont des groupes. C’est un modèle que la police appelle « ransomware as a service ». Ces groupes offrent un service clé en main pour mener une attaque par rançongiciel. On parle plus généralement de « malware as a service » voire de « crime as a service ».

Il ne faut pas imaginer une organisation qui ressemblerait à une entreprise classique. Ce sont des groupes assez diffus, dont les membres ne se connaissent pas forcément de manière physique et qui vont offrir différents services qui peuvent être séparés :

uniquement l’accès initial à un ordinateur spécifique ;

acheter un rançongiciel ;

avoir un accès à des services de négociation qui vont faciliter la négociation de la rançon.

Il est également possible de s’offrir des services de stockage de données, car si une attaque a pour but d’exfiltrer de grosses quantités de données, il faut pouvoir les stocker et montrer à sa cible qu’on a réellement ces données. À ce propos, certains groupes utilisent ce qu’ils appellent des « murs de la honte » où ils vont afficher sur des sites des informations confidentielles d’une entreprise, par exemple, sur le dark web.

En bas de l’échelle, on trouve ce que l’on appelle des « affiliés », ce sont les petites mains. On parle même d’« ubérisation de la cybercriminalité ». Ce sont eux qui vont lancer les attaques en utilisant les services du groupe. Si l’attaque réussit et que la cible paye, la rançon est partagée entre le groupe et les affiliés.

Si on va à l’autre bout de l’échelle, on connaît quelques leaders comme celui de Conti, un groupe de pirates basé en Russie. Ce dernier est connu sous les pseudonymes de Stern ou Demon, et agit comme un PDG. Des travaux universitaires ont même montré son modèle de management. Il semble qu’il fasse du micromanagement, où il tente de régler tous les problèmes entre ses « employés » et de contrôler toutes les tâches qu’ils effectuent sans très grande anticipation.

Maintenant que l’on connaît mieux l’écosystème criminel, expliquez-nous comment, techniquement, on peut entrer dans un système ?

J.-Y. M. : On peut diviser ça en grandes étapes.

La première, c’est la plus diffuse, c’est la reconnaissance de la cible. Essayer d’avoir la meilleure connaissance possible des victimes potentielles, tenter de savoir s’il y a des vulnérabilités, donc des endroits où l’on pourrait attaquer. Un autre aspect est de bien connaître les revenus de la cible pour, in fine, adapter la rançon.

Une fois ce travail réalisé, il faut réussir à obtenir un premier accès dans le réseau. C’est souvent la partie la plus complexe et elle est faite, généralement par une personne physique derrière son ordinateur. Pas besoin d’être nombreux pour cette étape. Ce qui fonctionne le mieux, c’est l’ingénierie sociale. On va chercher à manipuler une personne pour obtenir une information en exploitant sa confiance, son ignorance ou sa crédulité.

Prenons un exemple, avec votre cas, imaginons que l’on cherche à infiltrer le réseau de The Conversation et que l’attaquant vous connaisse. Il sait que vous êtes journaliste scientifique et toujours à l’affût d’un bon sujet à traiter. Il va donc vous envoyer un mail qui va vous dire : « Regardez, je viens de publier un excellent article scientifique dans une grande revue, je pense que cela ferait un très bon sujet pour votre média, cliquez ici pour en prendre connaissance. »

À ce moment-là, vous cliquez et vous arrivez sur un site qu’il contrôle et qui va vous forcer à télécharger un logiciel malveillant. Ce type de technique peut fonctionner sur énormément de personnes à condition de connaître le bon moyen de pression.

Dans le cas que l’on vient de prendre, il s’agissait d’une attaque bien ciblée. On peut aussi prendre le cas inverse et envoyer un très grand nombre d’emails sans ciblage.

Le cas classique est ce mail, que vous avez peut-être déjà reçu, venant soi-disant de la police et qui vous indique que vous avez commis une infraction et que vous devez payer une amende. Le gros problème, c’est que c’est devenu plus facile de rédiger des mails sans faute d’orthographe ni de grammaire grâce aux outils d’IA. Détecter le vrai du faux est de plus en plus complexe.

Donc la meilleure manière est de s’attaquer à un humain ?

J.-Y. M. : Oui, ça marche bien, mais il y a d’autres manières d’attaquer. L’autre grand vecteur, c’est ce qu’on appelle les vulnérabilités : tous les bugs, donc les erreurs, que vont faire une application ou un système d’exploitation. On peut exploiter les bugs de Windows mais aussi les bugs d’applications comme Firefox, Safari ou Chrome. Trouver une vulnérabilité, c’est vraiment le Graal pour un attaquant parce que cela va être relativement silencieux, personne ne peut s’en rendre compte tout de suite. À la différence d’une personne piégée qui pourrait se rendre compte de la supercherie.

Concrètement, une vulnérabilité qu’est-ce que c’est et comment l’exploiter ?

J.-Y. M. : Une vulnérabilité, c’est un bug – je pense que tout le monde en a entendu parler. Un bug, c’est quand une application va faire une erreur ou avoir un comportement anormal.

Alors, comment ça marche ? L’idée est que l’attaquant va envoyer une donnée à un programme. Et, à cause de cette donnée, le programme va commettre une erreur. Il va interpréter cette donnée comme une donnée à exécuter. Et là, évidemment, l’attaquant contrôle ce qui est exécuté. L’exploitation de vulnérabilité est une illustration de la dualité donnée/programme qui est constitutive et au cœur de l’informatique, dès ses origines.

J’aimerais également citer une autre grande manière d’attaquer : une « attaque supply chain », en français « attaque de la chaîne d’approvisionnement , appelée aussi « attaque de tiers ». C’est une attaque absolument redoutable. Pour comprendre, il faut savoir que les programmes, aujourd’hui, sont extrêmement complexes. Une application d’une entreprise particulière va utiliser beaucoup de programmes tiers. Donc il est possible de réaliser des attaques indirectes.

Je reprends votre cas, imaginons que quelqu’un qui vous connaisse cherche à vous attaquer, il sait que vous êtes journaliste, il se dit que vous utilisez probablement Word, il peut donc étudier les dépendances de cette application à d’autres programmes et voir si ces derniers ont des failles. S’il arrive à installer une backdoor (une porte dérobée est une fonctionnalité inconnue de l’utilisateur légitime, qui donne un accès secret au logiciel) chez un fournisseur de Word pour y installer un logiciel malveillant, alors, à la prochaine mise à jour que vous allez effectuer, ce dernier arrivera dans votre logiciel et, donc, dans votre ordinateur.

La grande attaque de ce type que l’on peut donner en exemple est celle menée par Clop, un groupe russophone qui s’est attaqué à MoveIt, un logiciel de transfert de fichiers sécurisé. Ils ont compromis ce logiciel-là directement chez le fournisseur. Donc tous les clients, quand ils ont mis à jour leur logiciel, ont téléchargé les malwares. Il y a eu des dizaines de millions de victimes dans cette affaire. Si des criminels réussissent un coup pareil, c’est le véritable jackpot, ils peuvent partir vivre aux Bahamas… ou en prison.

Et une fois que l’attaquant est entré dans un ordinateur, que fait-il ?

J.-Y. M. : Une fois que l’on est dedans, on passe au début de l’attaque. On va essayer de ne pas être visible, donc de désactiver les systèmes de défense et de multiplier les backdoors, les points d’accès. Car, si l’un est repéré, on pourra en utiliser un autre. Typiquement, si un attaquant a piraté votre ordinateur, il peut créer un nouvel utilisateur. Il va ensuite créer une connexion sécurisée entre son ordinateur et le vôtre. Il a accès à l’ordinateur, et peut donc y installer les logiciels qu’il veut.

Ensuite, il va explorer et voir, si votre machine est connectée à un réseau d’entreprise et donc s’il peut se déployer et aller chercher des informations sensibles par exemple. Cela peut être la liste de tous vos clients, des résultats financiers, des documents de travail, dans le but de faire de l’exfiltration. S’il peut se déployer, l’attaque devient globale. Ici, on parle vraiment d’une personne qui explore le réseau en toute discrétion pendant des jours, des semaines voire des mois. Les données sont exfiltrées au compte-gouttes, car les systèmes de défense sont capables de détecter de gros flux de données et de comprendre qu’il y a une attaque.

Si l’idée du cybercriminel est plutôt de faire une attaque par chiffrement, qui va empêcher l’entreprise d’accéder à ses données, il doit éliminer les sauvegardes. Une fois que c’est fait, le chiffrement de toutes les données peut être lancé et la demande de rançon va être envoyée.

Et que se passe-t-il après cette demande ?

J.-Y. M. : Le groupe va contacter la cible en lui expliquant qu’il vient d’être attaqué et va lui demander de se connecter à un portefeuille numérique (wallet) pour payer ce qu’on lui demande, en général, en bitcoins. Souvent, à ce moment-là, une négociation va démarrer. Une hotline est, parfois, mise en place par les pirates pour communiquer. Les groupes organisés ont des services voués à cette opération.

L’attaquant tente de vendre la clé de déchiffrement – c’est la rançon –, ou bien menace de diffuser des données volées. Il y a d’ailleurs énormément de transcriptions d’échanges en ligne.

D’après les recherches que j’ai pu effectuer, il y aurait environ 60 % des gens qui paient, mais c’est très compliqué d’avoir les vrais chiffres.

La première chose à faire est de déclarer à la gendarmerie ou à la police la cyberattaque subie. En parallèle, il y a aujourd’hui dans chaque région des centres qui ont été mis en place d’aide aux victimes. Ainsi, il y a des choses à faire au moment de la négociation : demander au pirate de décrypter une partie des données, juste pour montrer qu’il est capable de le faire, parce qu’on a déjà vu des cas où les attaquants ne sont pas, disons, très professionnels et ils sont incapables de déchiffrer les données.

Il faut également s’assurer que si l’attaquant s’est servi d’une backdoor, il n’en a pas laissé une autre pour une future attaque. Cela s’est déjà vu et c’est au service informatique, lorsqu’il va tout réinstaller, de vérifier cela. Ensuite, si des données ont été exfiltrées, vous ne pouvez jamais savoir ce que va en faire l’attaquant. Les mots de passe qui sont exfiltrés peuvent être utilisés pour commettre une nouvelle cyberattaque, vous pouvez faire confiance à un cybercriminel pour cela. Personnellement, j’ai lu suffisamment de livres policiers pour ne pas avoir envie de faire confiance à un bandit.

On a finalement vu toute la chaîne de l’attaque, mais quel est votre rôle en tant qu’universitaire et responsable du projet DefMal du PEPR cybersécurité dans cet écosystème ?

J.-Y. M. : Il y a deux volets qui ont l’air d’être séparés, mais vous allez vite comprendre qu’ils s’articulent très facilement.

Il y a un volet que l’on pourrait qualifier de très informatique, qui consiste à construire des défenses : des systèmes de rétro-ingénierie et de détection. L’objectif est, par exemple, de déterminer si un programme est potentiellement malveillant.

Plusieurs approches sont explorées. L’une d’elles consiste à utiliser des méthodes d’apprentissage à partir d’exemples de malware et de goodware. Cela suppose d’être capable d’extraire, à partir du binaire, des caractéristiques précisant la sémantique du programme analysé. Pour cela, nous combinons des approches mêlant méthodes formelles, heuristiques et analyses dynamiques dans un sandbox (bac à sable, un environnement de test).

Une difficulté majeure est que les programmes sont protégés contre ces analyses par des techniques d’obfuscation qui visent à rendre leur fonctionnement délibérément difficile à comprendre.

L’un des enjeux scientifiques est donc de pouvoir dire ce que fait un programme, autrement dit, d’en retrouver la sémantique. Les questions soulevées par la défense contre les logiciels malveillants – par exemple, expliquer le comportement d’un programme – exigent une recherche fondamentale pour obtenir de réels progrès.

Au passage, on a un petit volet offensif. C’est-à-dire qu’on essaie aussi de construire des attaques, ce qui me paraît important parce que je pense qu’on ne peut bien concevoir une défense qu’à condition de savoir mener une attaque. Ces attaques nous servent également à évaluer les défenses.

Pour vous donner un exemple, je peux vous parler d’un travail en cours. C’est un système qui prend un programme normal, tout à fait bénin, et qui prend un programme malveillant, et qui va transformer le programme malveillant pour le faire ressembler au programme bénin ciblé afin de lui faire passer les défenses qui s’appuient sur l’IA.

J’ai donc parlé de la partie informatique, mais il y aussi tout le volet sur l’étude de l’écosystème actuel qui m’intéresse particulièrement, qui est un travail passionnant et interdisciplinaire. Comment les groupes sont-ils organisés, quel est le système économique, comment les groupes font-ils pour blanchir l’argent, quel type de management ? Une autre grande question que l’on se pose, c’est celle de savoir comment les cybercriminels vont s’approprier l’IA. Comment anticiper les prochains modes opératoires ?

On va aussi aller explorer le dark web pour récupérer des discussions entre criminels pour mieux comprendre leurs interactions.

Vous arrive-t-il d’aider la police sur des enquêtes en particulier ?

J.-Y. M. : On ne nous sollicite jamais sur des attaques concrètes. Une enquête doit être faite dans un cadre légal très strict.

Nous entretenons de bonnes relations avec tout l’environnement de lutte contre les cybercriminels (police, gendarmerie, armée, justice…). Ils suivent nos travaux, peuvent nous poser des questions scientifiques. On a des intérêts communs puisqu’une partie de nos travaux de recherche, c’est de comprendre l’écosystème de la cybercriminalité.

Je vous donne un exemple : sur le dark web, un forum qui permettait d’échanger des logiciels malveillants a été bloqué. Nous en tant que chercheurs, on va essayer de comprendre l’impact réel de cette action, car, d’ici plusieurs mois, il y aura sans doute un nouveau forum. Les relations entre les groupes cybercriminels et les services de certains États font partie aussi de nos questions actuelles.

Une autre question scientifique à laquelle on peut répondre, c’est lorsque l’on découvre un nouveau logiciel, savoir à quoi on peut le comparer, à quelle famille. Cela ne nous donnera pas le nom du développeur mais on pourra le rapprocher de tel ou tel groupe.

On commence également à travailler sur le blanchiment d’argent.

Pour aller plus loin, vous pouvez lire l’article de Jean-Yves Marion, « Ransomware : Extortion Is My Business », publié dans la revue Communications of the ACM.

Jean-Yves Marion a reçu des financements de l'ANR et de l'Europe. Il travaille détient des parts dans CyberDetect et Cyber4care.

17.09.2025 à 12:42

À quand une fusée réutilisable en Europe ?

Elisa Cliquet Moreno, Chef de projet réutilisation, Centre national d’études spatiales (CNES)

Texte intégral (2357 mots)

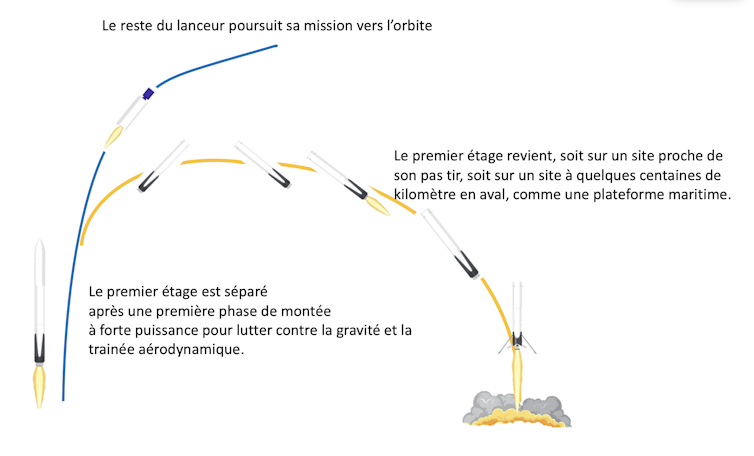

Une nouvelle course à l’espace est en cours. Depuis 2013, SpaceX, le principal concurrent d’Ariane, est capable de récupérer et réutiliser le premier étage de sa fusée Falcon 9 et travaille à rendre sa super fusée, Starship, entièrement réutilisable.

De nombreux acteurs cherchent à acquérir cette technologie, qui permet de réduire les coûts et d’améliorer la versatilité et la flexibilité d’un système de lancement. En effet, alors qu’un lanceur ou une fusée est constituée de plusieurs étages, le premier – le plus puissant pour lutter contre la gravité et la traînée aérodynamique – est aussi le plus cher. Le récupérer et le remettre en état peut être moins cher que d’en fabriquer un neuf à chaque lancement.

La réutilisation est un indéniable atout de compétitivité à l’heure où la concurrence mondiale augmente dans le domaine des lanceurs.

Le Centre national d’études spatiales (Cnes) a, depuis 2015, mis en place une feuille de route articulée autour de plusieurs prototypes de démonstration. Ceux-ci visent à maîtriser les différentes briques technologiques et les nouvelles « phases de vie » des lanceurs liées à la réutilisation : il faut pouvoir guider la phase de retour, atterrir verticalement, puis « remettre en sécurité » l’étage récupéré avec des robots, c’est-à-dire vidanger les fluides sous pression qu’il contient encore pour permettre l’accès à des opérateurs dans des conditions de sécurité optimales.

Après des essais au sol réussis en France en 2024, c’est un prototype d’étage à bas coût et réutilisable qui a rejoint au début de cet été son pas de tir à Kiruna, en Suède.

Première étape : développer un moteur versatile, capable de fournir de petites comme de grandes poussées

La première brique fondamentale est de disposer d’un moteur réallumable et dont la poussée peut s’adapter en cours du vol pour permettre à la fois un décollage « à fond », pour faire décoller le lanceur plein, mais également permettre un atterrissage tout en douceur du premier étage quasiment vide : il faut pour cela un moteur capable de fonctionner sur une large plage de poussée.

À lire aussi : Ariane 6 et les nouveaux lanceurs spatiaux, ou comment fabriquer une fusée aujourd'hui

Le démonstrateur (ou prototype) Prometheus a donc naturellement fait l’objet de la première démonstration, lancée sous l’impulsion du Cnes dès 2015. Fonctionnant à l’oxygène liquide et au biométhane liquide (plus propre et mieux adapté à la réutilisation que le kérosène ou l’hydrogène), capable de fournir une poussée allant de 30 à 110 % de son point de fonctionnement de référence à 1 000 kilonewtons, il est le précurseur d’une nouvelle génération de moteurs réutilisables à bas coût.

Grâce à l’impression 3D, il est composé de 50 % de pièce en moins qu’un moteur conventionnel. Le but est que Prometheus soit réutilisable au minimum 5 fois (le nombre de réutilisations pour assurer l’intérêt économique de la récupération est une variable qui dépend de chaque système de lancement).

Testé avec succès courant 2024 chez ArianeGroup à Vernon, dans l’Eure, le premier exemplaire de Prometheus a été monté sur le premier prototype européen d’étage réutilisable à oxygène et méthane liquides, Themis 1 (ou, T1H).

Themis 1 (T1H), les premiers tests à échelle 1 d’un démonstrateur d’étage bas coût et réutilisable en Europe

Ce démonstrateur n’est pas un lanceur complet mais juste un premier étage. Il a quitté le site d’ArianeGroup en France, le 12 juin dernier, pour rejoindre le pas de tir suédois. Là, Themis T1H doit d’abord subir des essais combinés avec ses robots de remise en sécurité avant de réaliser un « hop » de quelques dizaines de mètres.

T1H, qui mesure plus de 30 mètres de haut pour environ 30 tonnes, va permettre de valider les grands principes des opérations liées à la réutilisation à une échelle représentative d’un petit lanceur. Seront en particulier scrutées les phases d’atterrissage et de remise en sécurité.

Un autre prototype Themis, plus ambitieux, est en cours d’étude.

Callisto, un démonstrateur de premier étage réutilisable beaucoup plus ambitieux

Le démonstrateur Callisto, fruit d’une coopération entre le Cnes, les agences spatiales japonaise JAXA et allemande DLR, marque un saut en complexité. Ce démonstrateur de 13 mètres de haut, tout juste plus d’un mètre de diamètre et environ 4 tonnes au décollage, malgré son échelle réduite, porte toutes les fonctions et la complexité d’un futur premier étage de lanceur réutilisable.

Pour illustrer les défis technologiques à relever avec Callisto, citons par exemple la manœuvre de « retournement » parmi tant d’autres. Après une phase de montée comme une fusée normale, l’étage doit rapidement changer d’orientation pour revenir vers son pas de tir, ce qui « secoue » les ergols dans les réservoirs au point que, sans précaution particulière, le liquide se déplace, se mélange avec le gaz, se réchauffe, et pourrait ne plus alimenter le moteur qui doit pourtant être rallumé ensuite pour freiner l’étage.

Callisto est conçu pour voler dix fois, être capable de monter à plus de dix kilomètres d’altitude et effectuer une manœuvre complexe lui permettant de se retourner rapidement vers son pas d’atterrissage, situé juste à côté de son pas de tir sur l’ensemble de lancement multi-lanceurs (ELM Diamant) au Centre spatial guyanais, à Kourou. Les vols de Callisto permettront ainsi de valider de nouveaux algorithmes pour le GNC (Guidage Navigation Pilotage), une autre brique cruciale pour la réutilisation.

De nombreux éléments de Callisto sont déjà fabriqués et en cours d’essai, notamment les pieds, certaines structures clés, et des équipements avioniques. Les trois partenaires du programme contribuent de manière égalitaire à sa réalisation : la JAXA fournit par exemple le moteur, le DLR les pieds, et le Cnes réalise les études système et le segment sol.

Des essais à feu de l’ensemble propulsif sont prévus mi-2026 au centre d’essai de Noshiro au Japon avant l’envoi de Callisto au Centre spatial guyanais pour ses premiers essais au second semestre 2026.

Les vols de Callisto, qui commenceront par des petits « sauts » (hops) à basse altitude seront de plus en plus ambitieux : ils culmineront à plus de dix kilomètres d’altitude et franchiront Mach 1 (soit 1 235 km/h, environ).

Skyhopper : récupérer et faire re-voler un étage sur un lanceur opérationnel

La dernière étape de la feuille de route consistera à démontrer la récupération puis un second vol de l’étage récupéré, directement sur un mini lanceur opérationnel, lors d’un de ses vols commerciaux. C’est ArianeGroup & MaiaSpace qui ont été retenus pour mener à bien ce projet, baptisé Skyhopper, qui sera testé en Guyane.

Une fois la mission principale du premier étage achevée, celui-ci sera séparé du deuxième étage à une altitude d’environ 50 kilomètres : il effectuera alors une manœuvre de ré-orientation, déploiera ses gouvernes aérodynamiques, rallumera ses moteurs pour un boost de freinage.

S’en suivra une phase planée, pendant laquelle l’étage sera dirigé grâce à ses gouvernes aérodynamiques, puis un dernier rallumage du moteur, le déploiement des pieds et, enfin, l’atterrissage vertical sur une barge maritime située à quelques centaines de kilomètres des côtes guyanaises.

L’étage sera alors stabilisé et remis en sécurité de façon autonome par des robots puis la barge sera tractée jusqu’au port de Pariacabo à Kourou (Guyane). Une fois inspecté et remis en état, cet étage sera assemblé sur un autre lanceur qui décollera pour une nouvelle mission vers l’orbite achevant ainsi la démonstration avant la fin de la décennie.

À lire aussi : Adieu Ariane 5 ! Retour sur ses plus belles missions

Cette feuille de route, qui s’appuie à la fois sur des programmes de l’Agence spatiale européenne (ESA) (Prometheus et Themis ont été lancés par le Cnes, puis sont entrés dans le périmètre du programme « Future Launcher Preparatory » de l’ESA respectivement en 2016 et 2019) et des programmes nationaux (Skyhopper) ou dans une coopération multilatérale (Callisto), a bénéficié également d’un solide support de multiples activités de recherche et technologies menées au niveau national, permettant de valider en amont et à petite échelle des concepts peu matures comme l’impression 3D permettant ensuite d’optimiser la conception et la fabrication du moteur Prometheus.

La France et ses partenaires sont donc en ordre de bataille pour relever les défis de la réutilisation du premier étage d’un lanceur.

Elisa Cliquet Moreno est membre de l'Association Aéronautique et Astronautique de France (présidente de la commission transport spatial)

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Lava

- La revue des médias

- Le Grand Continent

- Le Diplo

- Le Nouvel Obs

- Lundi Matin

- Mouais

- Multitudes

- Politis

- Regards

- Smolny

- Socialter

- The Conversation

- UPMagazine

- Usbek & Rica

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- Contretemps

- A Contretemps

- Alter-éditions

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- Philo Mag

- Terrestres

- Vie des Idées

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview

- Fiabilité 3/5

- Slate

- Ulyces

- Fiabilité 1/5

- Contre-Attaque

- Issues

- Korii

- Positivr

- Regain