ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

08.10.2025 à 16:28

Comment recycler la chaleur perdue dans les usines ?

Alexis Giauque, Maitre de conférences en simulation numérique pour les énergies renouvelables, Centrale Lyon

Texte intégral (2368 mots)

Chaque année, l’industrie rejette une partie de la chaleur nécessaire à l’ensemble de ses procédés. Cette énergie perdue s’appelle « chaleur fatale ». Les solutions pour récupérer cette chaleur sont aujourd’hui encore trop limitées. De nouveaux dispositifs, utilisant des pompes à chaleurs et des fluides « supercritiques », sont en développement.

Fours de cimenterie, séchage du papier, agroalimentaire… les quantités de chaleur perdues aujourd’hui dans des procédés industriels sont significatives. Il faut bien évidemment tout mettre en œuvre pour les réduire en optimisant les procédés et en ajustant au plus proche la production à la demande. Mais aucun processus physique ne peut atteindre un rendement parfait, et si rien n’était fait pour récupérer cette chaleur résiduelle, l’équivalent de sept mégatonnes de pétrole serait brûlé pour rien, émettant aussi 28 mégatonnes de CO2, soit 6 % des émissions totales de CO2 en France.

Les méthodes de récupération de la chaleur perdue (ou fatale) visent aujourd’hui principalement des gisements à haute température (supérieure à 100 °C), ou nécessitent l’existence d’un réseau de chaleur à proximité (un ensemble de tuyaux capables d’amener la chaleur sur de courtes distances vers des logements ou des bâtiments publics par exemple).

Pour mieux valoriser cette chaleur générée dans les usines, qui représenterait au total un réservoir d’environ 110 térawattheures par an en France, d’autres solutions sont actuellement à l’étude.

La chaleur fatale : une énergie thermique émise par toutes les industries sous de nombreuses formes

Pour mieux comprendre les enjeux, prenons un exemple concret, celui d’une cimenterie. Une tonne de ciment nécessite 3 000 mégajoules de chaleur : seuls 40 % sont absorbés par les réactions chimiques entre l’argile et le calcaire, et une partie des 60 % restants peut être directement réutilisée pour préchauffer les matériaux. Mais on estime entre 300 et 1 000 mégajoules par tonne la chaleur perdue dans l’atmosphère. Sachant qu’une cimenterie peut produire environ 1 500 tonnes de ciment par jour, cela revient à brûler entre 12 et 37 tonnes d’essence par jour pour rien.

Ce problème est bien plus large que les cimenteries : on trouve l’agroalimentaire en tête, puis la chimie-plastique, la production de papier et de carton, la sidérurgie et la fabrication de matériaux non métalliques (ciment, verre, tuile ou brique). Tous domaines industriels confondus, les fours et séchoirs représentent 60 % de l’énergie consommée par l’industrie en France.

Point noir supplémentaire, une bonne part (60 %) de l’énergie utilisée dans l’industrie est obtenue par la combustion de matières fossiles, ce qui émet du CO2 dans l’atmosphère et explique pourquoi l’industrie est encore responsable d’environ 17 % des émissions de gaz à effet de serre de la France. L’objectif est de réduire ces émissions de 35 % d’ici 2030 et de 81 % d’ici 2050 par rapport à 2015.

À lire aussi : Avenir énergétique de la France : le texte du gouvernement est-il à la hauteur des enjeux ?

La chaleur fatale émise au cours d’un procédé industriel est d’autant plus simple à réutiliser ou à recycler que la température du flux thermique est élevée. Cela est si fondamental que les ingénieurs et chercheurs ont l’habitude de distinguer la chaleur fatale « basse température » ou « basse qualité », à moins de 100 °C (56 térawatts-heures par an) et celle dite « haute température » ou « haute qualité » au-delà de 100 °C (53 térawatts-heures par an).

Comment recycler la chaleur fatale ?

Heureusement, des solutions existent pour recycler la chaleur fatale.

L’idéal est d’intégrer le flux de chaleur fatale directement dans le processus industriel qui en est à l’origine : dans l’industrie du ciment par exemple, la chaleur en sortie du four peut être introduite dans le précalcinateur situé en bas de la tour de préchauffage, qui a pour fonction principale de « précuire » le cru avant son entrée dans le four.

Si la chaleur fatale est à température relativement faible (inférieure à 100 °C), elle peut être réutilisée directement sur le site industriel pour alimenter d’autres procédés ou pour chauffer les locaux — la proximité limite les pertes de chaleur dans les tuyaux. On peut aussi insérer cette chaleur dans un réseau urbain ou dans le réseau d’un autre industriel à proximité.

Autre option : produire de l’électricité à partir de la chaleur perdue, grâce à l’utilisation de cycles thermodynamiques de Rankine organiques. En pratique ceci fonctionne pour des sources de chaleur fatale à assez haute température (supérieure à 200 °C) car le rendement est limité : par exemple, dans le cas d’une température de sortie d’usine à 200 °C et d’un refroidissement à l’atmosphère (20 °C), le rendement maximal est de 38 %.

Enfin, on peut utiliser des pompes à chaleur pour remonter le niveau de température du flux de chaleur fatale, et permettre ainsi son exploitation directe au sein du processus industriel. Cette option est prometteuse car le gisement de chaleur fatale basse température représente 51 % du gisement global.

Les pompes à chaleur domestiques sont de mieux en mieux connues des particuliers, mais celles que nous devons utiliser et développer pour récupérer la chaleur fatale dans les usines sont plus difficiles à mettre en œuvre.

Les pompes à chaleur : une solution pour la valorisation du gisement « basse température » de chaleur fatale

Les pompes à chaleur (ou « PAC ») permettent de remonter la température selon un principe qui peut paraître paradoxal : il s’agit de prendre de la chaleur à la source froide pour la donner à la source chaude, s’opposant ainsi au sens naturel du transfert d’énergie.

Il faut forcer le transfert inverse en ajoutant du « travail » dans le cycle thermodynamique (le travail est en somme, une forme d’énergie, et c’est pour cela que les pompes à chaleur domestiques ont une prise électrique). Elles captent la plupart de l’énergie utilisée sous forme de calories (chaleur) et dépensent un peu d’électricité.

À lire aussi : La géothermie, plus écologique et économe que la climatisation classique pour rafraîchir

Le transfert depuis la source froide vers la source chaude se fait en quatre étapes principales, explicitées ci-dessous :

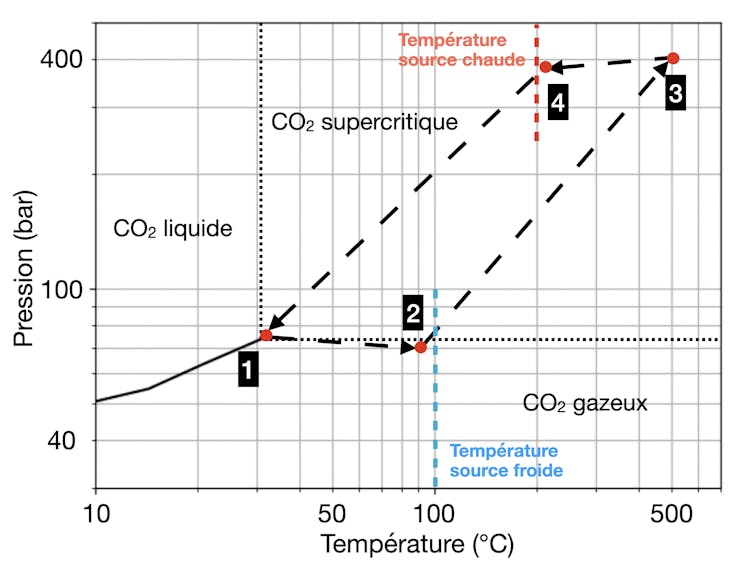

Dans notre cas, le fluide est du « CO2 supercritique » (le CO2, à haute température et haute pression, se comporte à la fois comme un liquide et comme un gaz : il peut diffuser à travers les solides comme un gaz et peut dissoudre des matériaux comme un liquide). La source froide, dont on souhaite extraire la chaleur, est le flux de chaleur fatale issu du procédé industriel (à Tfroide=100 °C) ; la « source » chaude, ou cible, quant à elle est à une température bien plus élevée (la cible dans notre projet est Tchaude=200 °C).

La seule dépense énergétique dans ce cycle est celle nécessaire à assurer le fonctionnement du compresseur permettant la circulation du fluide – dans notre cas, du CO2 supercritique – le point clé est que l’énergie dépensée est environ cinq fois plus faible que l’énergie transmise de la source froide à la source chaude.

On peut ainsi « upcycler » la chaleur, mais toute la chaleur ne peut pas être récupérée. Dans notre cycle par exemple, on rejette un flux de chaleur à une température légèrement supérieure à 30 °C. Il n’est cependant pas simple de quantifier la chaleur résiduelle parce qu’elle dépend de la température environnante : si on est en plein été et que la température de l’atmosphère est à 30 °C alors on a pour ainsi dire récupéré toute la chaleur car le flux de sortie est quasiment à l’équilibre avec l’atmosphère… en hiver, ce serait moins le cas.

Nos pompes à chaleur utilisent du CO2 dans le domaine supercritique car cela offre plusieurs avantages : par exemple, l’augmentation de la capacité calorifique améliore le transfert de chaleur lors de l’échange avec la source froide, la viscosité faible limite les pertes par frottement dans les turbomachines (compresseurs/turbines), et il n’y a pas de gouttes (interfaces liquide/gaz) qui risqueraient d’endommager les pièces métalliques dans les turbomachines.

La recherche scientifique au service de la décarbonation de l’industrie

Le cycle que nous venons de décrire (cycle Brayton inverse du CO2 supercritique) est au cœur du projet REVCO₂.

Mais notre collaboration cherche à ajouter à ce système de recyclage de la chaleur un système de stockage à haute température (T~600 °C), ce qui permettrait de générer de l’électricité à partir de cette chaleur de « haute qualité ».

Notre espoir est que les industriels pourront choisir, en fonction de leur besoin à chaque instant, soit de consommer un peu d’électricité pour obtenir de la chaleur utilisable dans leur procédé industriel, soit d’utiliser la chaleur stockée à 600 °C pour produire de l’électricité (la chaleur fatale seule ne le permettrait pas avec un rendement décent) et la revendre. Le prix de l’électricité à l’achat et à la revente sur le marché européen apparaît donc comme un nouveau paramètre pour la récupération de la chaleur fatale. Nos optimisations incluront donc une dimension économique, essentielle pour l’appropriation par les industriels de nouvelles solutions technologiques.

Pour produire un système optimisé, dans le projet REVCO2, nous mettrons en œuvre des expériences détaillées pour les échangeurs de chaleur et le système de stockage et des outils de simulation haute-fidélité qui reproduiront séparément le comportement de chacun des éléments du système complet (turbomachines, échangeurs et systèmes de stockage de chaleur). Grâce aux données collectées, un jumeau numérique du système complet sera réalisé et permettra de tester les stratégies d’utilisation optimale d’un point de vue technico-économique.

Le projet REVCO2 — Développement et optimisation d’un cycle de Brayton au CO₂ supercritique REVersible pour la récupération de chaleur fatale du PEPR (programme et équipements prioritaires de recherche) SPLEEN, soutenu par l’Agence nationale de la recherche (ANR) qui finance en France la recherche sur projets. L’ANR a pour mission de soutenir et de promouvoir le développement de recherches fondamentales et finalisées dans toutes les disciplines, et de renforcer le dialogue entre science et société. Pour en savoir plus, consultez le site de l’ANR.

Alexis Giauque a reçu des financements de l'ANR dans le cadre du projet PEPR-SPLEEN REVCO2 (2025-2030)

08.10.2025 à 16:27

L’électronique de puissance : méconnue mais omniprésente et source de toujours plus de déchets électroniques

Tanguy Phulpin, Maitre de Conférence, en gestion de l'énergie électrique, CentraleSupélec – Université Paris-Saclay

Florentin Salomez, Chargé de Recherche en électronique de puissance, Centre national de la recherche scientifique (CNRS)

Hugo Helbling, Maitre de Conférences en Génie Electrique, Université Claude Bernard Lyon 1

Jean-christophe Crebier, Directeur de recherche CNRS, Grenoble INP - UGA

Marina Labalette, Cheffe de projet, IRT Saint Exupéry

Murielle Fayolle-Lecocq, Ingénieure sur l'impact environnemental des composants de puissance, Commissariat à l’énergie atomique et aux énergies alternatives (CEA)

Pierre Lefranc, Maître de conférences en électronique de puissance, Grenoble INP - UGA

Texte intégral (2471 mots)

C’est l’une des clés de voûte invisibles – mais omniprésentes – de la transition énergétique : l’électronique de puissance, qui convertit l’électricité sous une forme exploitable par toute la diversité d’équipements électriques et électroniques. C’est elle qui permet de recharger son smartphone, d’allumer une pompe à chaleur, ou encore d’injecter l’électricité éolienne et solaire dans le réseau. Mais, avec la multiplicité des usages, nous faisons aujourd'hui face à des problèmes de soutenabilité. Quid de tous ces composants, difficiles à réparer, à réutiliser et à recycler ? Peut-on limiter les impacts environnementaux liés à la technologie et à nos besoins croissants en énergie ?

L’un des leviers de la transition énergétique et de la décarbonation de l’économie  est l’électrification de nos usages. Les véhicules électriques, par exemple, émettent pendant leur utilisation moins de polluants et de gaz à effet de serre (GES) que leurs équivalents à moteurs thermiques.

L’électricité n’est toutefois pas une source d’énergie en tant que telle, mais un vecteur d’énergie, comme l’énergie chimique contenue par les hydrocarbures, qui est libérée lors de leur combustion. Contrairement à celle-ci toutefois, il s’agit d’une forme d’énergie qu’on retrouve peu à l’état naturel (hormis peut-être lors des orages).

Un des enjeux clés est donc de produire l’électricité à partir de sources décarbonés : aujourd’hui encore, près de 60 % de l’électricité mondiale est produite à partir d’énergies fossiles. Mais ce n’est pas là le seul défi de la transition. Pour électrifier l’économie, il faut aussi déployer massivement les usages (par exemple la mobilité électrique) et renforcer la résilience du réseau électrique.

Ceci repose sur des technologies de pointe. Parmi ces technologies, l’électronique de puissance, qui permet de convertir l’électricité sous une forme exploitable par les différents appareils, joue un rôle clé qu’il convient de décrire, tant à travers son fonctionnement qu’à travers les enjeux énergétiques et écologiques qui lui sont associés.

L’électronique de puissance, maillon clé de la transition

L’électronique de puissance, mal et peu connue du grand public, est pourtant omniprésente dans notre quotidien. Il s’agit des dispositifs électroniques utilisés pour convertir l’énergie électrique, à tous les niveaux de la chaîne : par exemple sur les lignes électriques pour les changements de tension, pour le chargement des véhicules électriques, sans oublier les chargeurs de nos téléphones mobiles et ordinateurs portables.

Pour les chargeurs, l’électronique de puissance permet de transformer le courant alternatif (AC) du réseau électrique en courant électrique continu pour alimenter les batteries. Elle permet également la réalisation d'onduleurs pour l’opération inverse : la transformation de courant continu en courant alternatif.

Les applications des onduleurs sont très nombreuses : ils permettent d’intégrer les sources renouvelables (photovoltaïque, éolien…) sur le réseau électrique. Ils sont également essentiels au chargement des véhicules électriques, au fonctionnement des pompes à chaleur et des climatiseurs, des produits électroménagers tels que les réfrigérateurs, les machines à laver, etc.

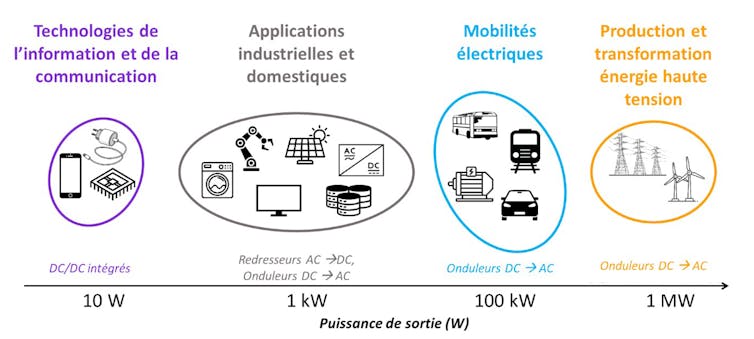

En réalité, la quasi-totalité des équipements électriques comprennent un, voire souvent plusieurs convertisseurs d’électronique de puissance, et cela à toutes gammes de puissances électriques :

pour les plus faibles puissances, de l’ordre de quelques dizaines de watts (W) pour charger un smartphone par exemple,

pour les puissances intermédiaires, de l’ordre de quelques dizaines de kW pour recharger un véhicule électrique ou injecter sur le réseau la production de panneaux solaires photovoltaïques,

jusqu’à celles de plusieurs mégawatts (MW), par exemple pour convertir en électricité l’énergie générée par une éolienne, ou pour alimenter les moteurs d’un TGV ou alimenter un data center.

La diversité des applications et des niveaux de puissance requis a conduit à développer une très grande diversité de produits d’électronique de puissance, optimisés pour chaque contexte.

Traditionnellement, ces enjeux de recherche et développement (R&D) concernent l’amélioration du rendement énergétique (pour limiter les pertes et augmenter les performances), l’augmentation de la densité de puissance (afin de réduire le poids et le volume des appareils), ou encore l’amélioration de leur fiabilité et de leur durée de vie. Mais avec l’explosion des usages électriques, l’électronique de puissance fait désormais face à des enjeux environnementaux et sociaux.

En effet, l’approvisionnement en matières premières critiques est sous le coup de tensions géopolitiques, tandis que leur extraction peut être source de pollutions et de dégradation des écosystèmes naturels.

Les efforts investis pour décarboner la société ne doivent néanmoins pas être considérés uniquement à travers les seules émissions de GES. Pour prévenir et limiter les transferts d’impacts (lorsque la diminution d’un impact environnemental sur une étape du cycle de vie d’un produit implique des effets négatifs sur un autre impact ou une autre étape), il faut tenir compte des autres indicateurs environnementaux, telles la disponibilité des ressources critiques ou encore la dégradation de la biodiversité.

À lire aussi : La flexibilité électrique, ou comment décaler nos usages pour optimiser la charge du réseau

Des matériaux difficiles à réparer et à recycler

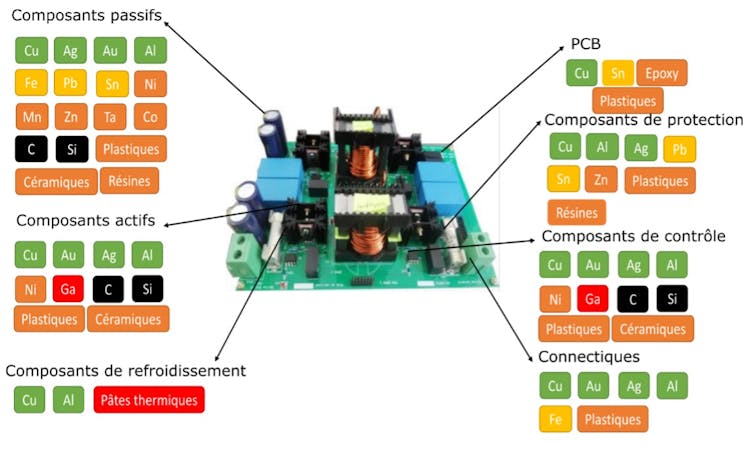

On l’a vu, l’électronique de puissance recoupe une large gamme d’applications et de puissances. De ce fait, elle est constituée d’une grande diversité de matériaux et de composants : on retrouve ainsi dans les composants constituants les convertisseurs de base plus de 70 matériaux différents.

Par exemple, du silicium pour les composants semi-conducteurs, des matériaux ferreux ou alliages à base de néodyme ou nickel pour les composants magnétiques, de l’aluminium ou tantale pour les condensateurs, des époxys ou polyamides non dégradables pour les circuits imprimés (PCB) ou encore des larges pièces en aluminium faisant office de radiateurs (pour évacuer de la chaleur produite par la conversion électrique). Certains de ces matériaux sont considérés comme des matériaux critiques et/ou stratégiques, associés à de forts enjeux environnementaux, économiques, sociaux voire géopolitiques.

Le problème tient aussi à leur recyclabilité : spécialisés pour un usage donné, les produits d’électronique de puissance peuvent être plus difficiles à réparer et souvent jetés en fin de vie. L’électronique de puissance contribue ainsi à l’augmentation de la quantité de déchets électroniques à gérer dans le monde, avec quelque 62 millions de tonnes atteintes en 2022. À l’heure actuelle, moins de 20 % sont collectés et traités.

La gestion des déchets issus de l’électronique de puissance, en fin de vie, constitue ainsi un problème qui se surajoute aux tensions d’approvisionnement en matières premières critiques et à l’impact environnemental de leur extraction. Pour les minimiser, il faut agir à toutes les étapes du cycle de vie, en particulier leur conception et leur fin de vie.

Rendre l’électronique de puissance plus soutenable

La communauté des experts techniques du domaine travaille ainsi à l’amélioration de la soutenabilité des équipements électroniques, et en particulier les convertisseurs.

En particulier, le groupe de travail Convertisseurs électroniques de puissance plus soutenables (CEPPS) du groupement de recherche Systèmes d’énergie électrique dans leurs dimensions sociétales (SEEDS) du CNRS, dont nous faisons partie, s’interroge sur les possibles transferts d’impacts d’une électrification massive sans repenser nos usages et nos besoins.

En effet, l’électrification engendre la production de toujours plus d’appareils électriques pour répondre à la croissance permanente des besoins énergétiques de notre société. Ce constat devrait nous inciter, en premier lieu, à modérer ces besoins en misant davantage sur la sobriété énergétique.

Une autre question, plus délicate pour cette industrie, tient à sa quête effrénée de la performance et de la miniaturisation. Ne faudrait-il pas plutôt changer les priorités de la conception ? Par exemple, en visant l'allongement de la durée de vie ou la mise en œuvre de pratiques plus circulaires, qui permettent notamment de favoriser le recyclage ? Ce dernier point peut passer par une amélioration de la réparabilité, de l'aptitude au désassemblage et par une homogénéisation des composants et des matériaux utilisés dans les appareils.

Les experts techniques en électronique de puissance que nous sommes le reconnaissent : notre communauté ne pourra résoudre tous les problèmes évoqués précédemment. C’est pourquoi nous pensons qu’il est important d’interroger les choix de société : modèles de consommation bien sûr, mais également des choix technologiques. Or, ces derniers sont réalisés par une seule partie des acteurs de la filière, alors qu’il faudrait inclure non seulement les ingénieurs, les fabricants et les législateurs, mais également les consommateurs, sans oublier d’adopter le regard des sciences humaines et sociales.

Cela implique aussi de mieux former le grand public aux systèmes énergétiques et notamment électriques. Celui-ci doit s’approprier pleinement tant leur fonctionnement scientifique et technique que les grands défis qui y sont associés.

À lire aussi : Comment rendre l’électronique plus soutenable ?

Jean-christophe Crebier a reçu des financements publics de l'ANR et de l'Europe en lien direct avec le sujet via les projets VIVAE, EECONE et ARCHIMEDES.

Pierre Lefranc a reçu des financements de l'ANR pour le projet VIVAE portant sur l'éco-conception en électronique de puissance.

Florentin Salomez, Hugo Helbling, Marina Labalette, Murielle Fayolle-Lecocq et Tanguy Phulpin ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.

07.10.2025 à 12:09

Dodo 2.0 : à quel point sommes-nous proches du retour de cet oiseau disparu ?

Timothy Hearn, Lecturer, University of Cambridge; Anglia Ruskin University

Texte intégral (1963 mots)

Peut-on vraiment faire revenir le dodo ? Colossal Biosciences s’en rapproche grâce à l’édition génétique, mais le projet se heurte à d’énormes défis scientifiques et écologiques.

La société américaine de biotechnologie Colossal Biosciences affirme être enfin parvenue à maintenir en vie, suffisamment longtemps en laboratoire, des cellules de pigeon pour pouvoir en modifier l’ADN – une étape cruciale vers son rêve de recréer le dodo.

L’entreprise a réussi à cultiver des « cellules germinales primordiales » – des cellules embryonnaires précoces – provenant de pigeons de Nicobar, les plus proches parents vivants du dodo, et à les faire vivre pendant plusieurs semaines d’affilée. C’est une avancée que les spécialistes de la génétique des oiseaux poursuivent depuis plus de dix ans. Mais la véritable valeur de cette percée réside dans son potentiel à protéger des espèces encore existantes.

Des recherches sur le poulet

Selon Colossal Biosciences, ces cellules, une fois modifiées, pourraient être introduites dans des embryons de poulets eux-mêmes édités génétiquement, transformant ces derniers en mères porteuses pour des oiseaux disparus depuis plus de trois siècles. Cette percée s’accompagne d’un calendrier audacieux. Ben Lamm, le directeur général de Colossal Biosciences, affirme que les premiers « néo-dodos » pourraient éclore d’ici cinq à sept ans.

Il évoque aussi un objectif à plus long terme : relâcher plusieurs milliers d’oiseaux sur des sites de l’île Maurice protégés de tout prédateur, là même où vivaient les dodos avant leur disparition. Cette promesse a contribué à faire grimper la valorisation de la start-up au-delà de dix milliards de dollars, selon le site de l’entreprise.

Presque tout ce que l’on sait sur l’édition génétique des oiseaux vient des recherches menées sur le poulet, dont les cellules germinales – à l’origine des spermatozoïdes et des ovules – se développent sans difficulté dans des cultures de laboratoire classiques. Les cellules de pigeon, elles, meurent généralement en quelques heures en dehors de leur organisme.

Colossal Biosciences affirme avoir testé plus de 300 combinaisons de facteurs de croissance – des substances qui stimulent la multiplication cellulaire – avant d’en trouver une réellement efficace. Ces cellules peuvent désormais être chargées de fragments d’ADN reconstitués et d’interrupteurs moléculaires contrôlant la forme du crâne, la taille des ailes et la masse corporelle.

Des zones manquantes

Si les modifications prennent, ces cellules altérées migreront vers les ovaires ou les testicules d’un embryon de poulet encore à un stade précoce de développement, de sorte que l’animal adulte pondra des œufs ou produira du sperme porteur du génome modifié.

Ce procédé pourrait donner naissance à un oiseau qui ressemble à un dodo, mais la génétique ne raconte qu’une partie de l’histoire. Le génome du dodo a été reconstitué à partir d’os et de plumes conservés dans des musées, et les zones manquantes ont été comblées avec de l’ADN de pigeon ordinaire.

Parce que l’espèce est éteinte et ne peut plus être étudiée, on ignore encore largement les gènes impliqués dans son comportement, son métabolisme ou ses défenses immunitaires. Reconstituer les régions connues de son ADN, lettre par lettre, nécessiterait des centaines de modifications distinctes. Le travail à accomplir serait d’une ampleur sans précédent, bien au-delà de tout ce qui a été tenté dans les programmes de sélection agricole ou de recherche biomédicale, même si Colossal Biosciences semble prête à investir massivement pour y parvenir.

Reste aussi la question du poulet porteur. Un œuf de poule pèse bien moins qu’un œuf de dodo. Dans les collections muséales, il n’existe qu’un seul œuf de dodo connu, d’une taille comparable à celle d’un œuf d’autruche. Même si un embryon parvenait à survivre aux premiers stades, il dépasserait rapidement la taille de la coquille et devrait éclore avant d’être complètement formé – comme un prématuré nécessitant des soins intensifs. Le poussin devrait donc recevoir une surveillance et des soins constants pour atteindre le poids historique du dodo, estimé entre 10 et 20 kilos.

« Remplacement fonctionnel »

Des poules « génétiquement réinitialisées », modifiées par édition du génome, ont déjà pondu avec succès des œufs appartenant à des races rares de poulets, démontrant que la gestation croisée par cellules germinales fonctionne en principe. Mais appliquer cette technique à une espèce disparue et de taille bien supérieure reste totalement inédit.

C’est pour ces raisons que de nombreux biologistes préfèrent parler de « remplacement fonctionnel » plutôt que de « désextinction ». Ce qui pourrait éclore serait un hybride : principalement un pigeon de Nicobar, enrichi de fragments d’ADN de dodo et incubé dans un œuf de poule. Mais parler de résurrection relève davantage du marketing que de la science.

Les promesses et la réalité

La tension entre promesse et réalité a marqué les précédents projets de Colossal Biosciences. Les loups sinistres (Aenocyon dirus) présentés en août 2025 se sont révélés être des clones de loups gris avec quelques modifications génétiques. Des experts en conservation ont averti que ce type d’annonces peut inciter la société à considérer l’extinction comme réversible, réduisant ainsi le sentiment d’urgence à protéger les espèces menacées.

Malgré tout, la percée réalisée sur les pigeons pourrait profiter aux espèces encore vivantes. Environ un oiseau sur huit est aujourd’hui menacé d’extinction, selon l’évaluation mondiale de 2022 de BirdLife International. La culture de cellules germinales offre un moyen de préserver la diversité génétique sans avoir à maintenir d’immenses populations captives, et éventuellement de réintroduire cette diversité dans la nature.

Si la technique s’avère sûre chez les pigeons, elle pourrait aider à sauver des oiseaux en danger critique, comme l’aigle des Philippines ou le perroquet à ventre orange d’Australie. La population sauvage de ce dernier ne compte plus qu’environ 70 individus et avait même chuté à seulement 16 en 2016.

Une porte-parole de Colossal Biosciences a déclaré que l’entreprise respecte ses jalons scientifiques, mais que l’obtention d’éléphants mères porteuses et de cellule-œuf appropriés pour leur projet de mammouth laineux « implique une logistique complexe échappant à notre contrôle direct » et que « nous accordons la priorité au bien-être animal, ce qui signifie que nous ne précipitons aucune étape cruciale ».

Elle a ajouté que, selon les recherches de l’entreprise, les travaux de désextinction accentuent au contraire l’urgence de protéger les espèces menacées. « L’important, c’est que nous ne remplaçons pas les efforts de conservation existants, nous y ajoutons de nouvelles ressources et renforçons l’implication du public », a-t-elle précisé.

Un dodo irrécupérable

« Notre travail apporte des financements entièrement nouveaux à la conservation, provenant de sources qui n’investissaient pas auparavant dans la protection de la biodiversité. Nous avons ainsi attiré plusieurs centaines de millions de dollars de capitaux privés qui n’auraient autrement pas été consacrés à des projets de conservation. De plus, les outils génétiques que nous développons pour la désextinction sont déjà utilisés aujourd’hui pour aider des espèces menacées. »

Pour qu’un retour d’oiseaux proches du dodo soit possible sur l’île Maurice, il faut d’abord qu’y soit réunies les conditions fondamentales pour leur conservation. Il sera nécessaire d’éradiquer les rats, qui s’attaquaient aux dodos, de contrôler les populations de singes et de restaurer la forêt. Ces actions demandent des financements et l’adhésion des populations locales, mais elles bénéficient immédiatement à la faune encore présente. Colossal Biosciences devra respecter son engagement envers une gestion écologique durable.

Mais, au sens strict, le dodo du XVIIe siècle est irrécupérable. Ce que le monde pourrait voir d’ici à 2030 n’est qu’une expérience vivante, illustrant les avancées de l’édition génétique. L’intérêt de cet oiseau ne résidera pas dans la convocation du passé mais dans sa capacité à aider les espèces actuelles à ne pas connaître le destin du dodo.

Timothy Hearn ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

06.10.2025 à 16:22

Pour sauver les pôles, les projets de géo-ingénierie sont voués à l’échec

Steven Chown, Director, Securing Antarctica's Environmental Future and Professor of Biological Sciences, Monash University

Texte intégral (2059 mots)

Alors que les pôles fondent à un rythme accéléré, certains chercheurs misent sur la géo-ingénierie pour ralentir la catastrophe : rideaux sous-marins, microbilles de verre ou fertilisation des océans. Mais une récente étude montre que ces solutions spectaculaires sont inefficaces, coûteuses et dangereuses – et qu’elles risquent surtout de détourner l’attention de l’urgence à réduire nos émissions de gaz à effet de serre.

Notre planète continue de se réchauffer en raison des émissions de gaz à effet de serre liées aux activités humaines. Les régions polaires sont particulièrement vulnérables à ce réchauffement. L’étendue de la banquise diminue déjà dans l’Arctique comme dans l’Antarctique. Les calottes glaciaires du Groenland et de l’Antarctique fondent, et des changements brutaux sont en cours dans les deux environnements polaires.

Ces changements ont de profondes conséquences pour nos sociétés, qu’il s’agisse de la montée du niveau de la mer, de l’évolution de la circulation océanique ou de la multiplication des phénomènes climatiques extrêmes. Ils entraînent aussi de lourdes conséquences pour les écosystèmes, notamment pour les ours polaires et les manchots empereurs, devenus des symboles des effets du changement climatique.

Le moyen le plus efficace pour atténuer ces changements et réduire le risque d’impacts généralisés est de diminuer les émissions de gaz à effet de serre. Pourtant, la décarbonation progresse lentement, et les projections actuelles indiquent une augmentation de la température d’environ 3 °C d’ici à 2100.

Aussi, certains scientifiques et ingénieurs, conscients des changements attendus et de l’importance des régions polaires pour la santé de la planète, ont-ils proposé de développer des approches technologiques, appelées géo-ingénierie, afin d’atténuer les effets sur l’Arctique et l’Antarctique.

Dans une étude publiée récemment dans Frontiers in Science, mes collègues et moi avons évalué cinq des concepts de géo-ingénierie les plus avancés envisagés pour les régions polaires. Nous en avons conclu qu’aucun d’entre eux ne devrait être utilisé dans les prochaines décennies. Ils sont extrêmement peu susceptibles d’atténuer les effets du réchauffement climatique dans les régions polaires et risquent de provoquer de graves conséquences indésirables.

Qu’est-ce que la géo-ingénierie polaire ?

La géo-ingénierie recouvre un large éventail d’idées visant à modifier délibérément, à grande échelle, le climat de la Terre. Les deux grandes catégories

consistent soit à retirer du dioxyde de carbone de l’atmosphère, soit à augmenter la quantité de lumière solaire renvoyée vers l’espace (une approche connue sous le nom de « modification du rayonnement solaire »).

Pour les régions polaires, les cinq concepts actuellement les plus avancés sont :

1. L’injection d’aérosols stratosphériques. Cette technique de modification du rayonnement solaire consiste à introduire dans la stratosphère de fines particules (comme le dioxyde de soufre ou le dioxyde de titane) afin de réfléchir la lumière du soleil vers l’espace. L’idée est ici d’appliquer ce principe spécifiquement aux pôles.

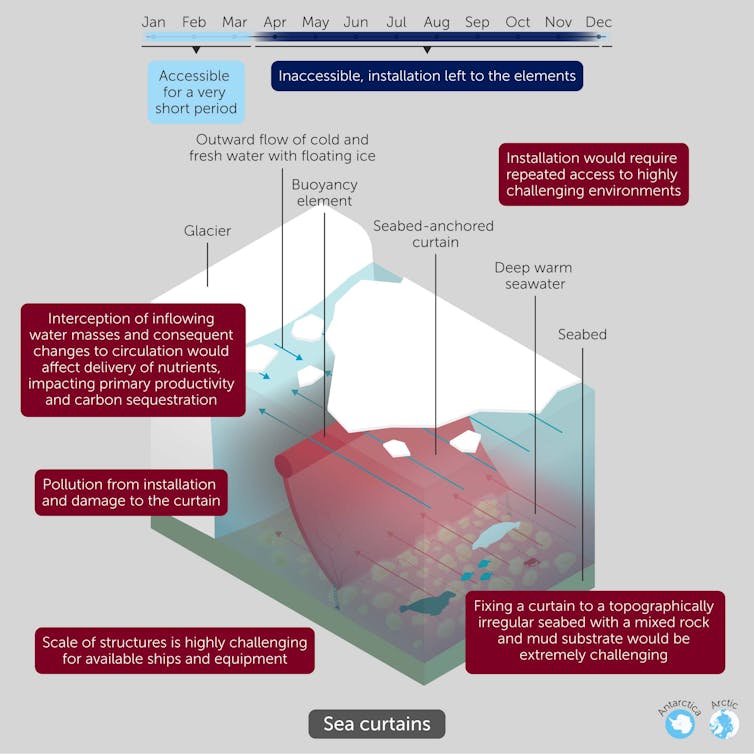

2. Les rideaux sous-marins. Ces structures flexibles et flottantes, ancrées au plancher océanique entre 700 et 1 000 m de profondeur et s’élevant sur 150 à 500 m, visent à empêcher l’eau chaude de l’océan d’atteindre et de faire fondre les plates-formes de glace (prolongements flottants qui ralentissent l’écoulement de la glace du Groenland et de l’Antarctique vers l’océan) ainsi que les lignes d’ancrage des calottes (là où se rencontrent terre, glace et océan).

3. Gestion de la banquise. Deux pistes sont explorées : d’une part, la dispersion de microbilles de verre sur la glace de mer arctique fraîche pour la rendre plus réfléchissante et prolonger sa durée de vie ; d’autre part, le pompage d’eau de mer à la surface de la banquise, où elle gèle pour l’épaissir, ou dans l’air pour produire de la neige, grâce à des pompes éoliennes.

4. Ralentir l’écoulement de la calotte glaciaire. Cette approche cible les « courants glaciaires » du Groenland et de l’Antarctique, de véritables rivières de glace s’écoulant rapidement vers la mer et contribuant à l’élévation du niveau marin. L’eau présente à leur base agit comme un lubrifiant. L’idée est de pomper cette eau afin d’accroître la friction et de ralentir leur progression. Le concept semble particulièrement pertinent pour l’Antarctique, où la fonte se joue davantage à la base de la calotte qu’à sa surface.

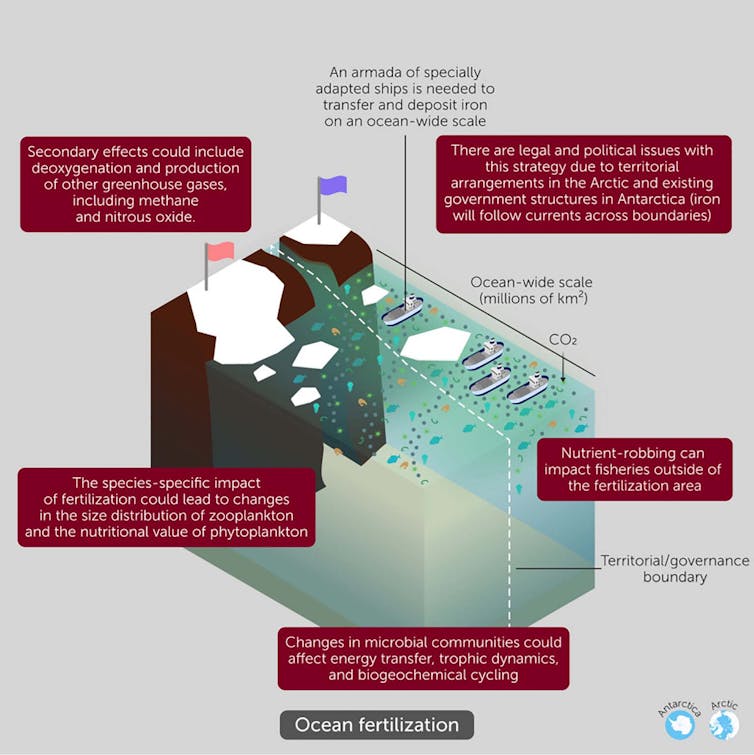

5. La fertilisation des océans. Elle consiste à ajouter des nutriments, comme du fer, dans les océans polaires afin de stimuler la croissance du phytoplancton. Ces organismes microscopiques absorbent le dioxyde de carbone atmosphérique, qui se retrouve stocké dans les profondeurs marines lorsqu’ils meurent et coulent.

Le risque des faux espoirs

Dans nos travaux, nous avons évalué chacun de ces concepts selon six critères : ampleur de la mise en œuvre, faisabilité, coûts financiers, efficacité, risques environnementaux et enjeux de gouvernance. Ce cadre fournit une méthode objective pour examiner les avantages et limites de chaque approche.

Aucun des projets de géo-ingénierie polaire ne s’est avéré viable dans les décennies à venir. Tous se heurtent à de multiples obstacles.

Ainsi, couvrir 10 % de l’océan Arctique de pompes destinées à projeter de l’eau de mer pour la geler exigerait l’installation d’un million de pompes par an sur dix ans. Les coûts estimés pour les rideaux marins (un milliard de dollars US par kilomètre) sous-estiment, de six à vingt-cinq fois, ceux de projets d’ampleur comparable dans des environnements plus simples, comme la barrière de la Tamise à Londres.

Un projet visant à répandre des microbilles de verre sur la glace a d’ailleurs été abandonné en raison des risques environnementaux. Et lors de leur dernière réunion, la majorité des Parties consultatives du Traité sur l’Antarctique ont réaffirmé leur opposition à toute expérimentation de géo-ingénierie dans la région.

Ces propositions nourrissent de faux espoirs face aux conséquences dramatiques du changement climatique, sans réduire rapidement les émissions de gaz à effet de serre. Elles risquent d’alimenter la complaisance face à l’urgence d’atteindre la neutralité carbone d’ici à 2050, voire d’être instrumentalisées par des acteurs puissants pour justifier la poursuite des émissions.

La crise climatique est une crise. Compte tenu du temps disponible, les efforts doivent se concentrer sur la décarbonation, dont les bénéfices peuvent être obtenus à court terme.

Steven Chown ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

02.10.2025 à 09:03

En 2030, la Nasa dira adieu à la station spatiale internationale et entrera dans l’ère des stations commerciales

John M. Horack, Professor of Mechanical and Aerospace Engineering, The Ohio State University

Texte intégral (2310 mots)

La Station spatiale internationale vit ses dernières années. En 2030, elle sera désorbitée. Vingt-cinq ans d’occupation continue laisseront alors place à une nouvelle ère, celle des stations spatiales commerciales.

Depuis novembre 2000, la Nasa et ses partenaires internationaux assurent sans interruption une présence humaine en orbite basse, avec toujours au moins un Américain à bord. Une continuité qui fêtera bientôt ses 25 ans.

Dans l’histoire de l’exploration spatiale, la Station spatiale internationale (ISS) apparaît sans doute comme l’une des plus grandes réalisations de l’humanité, un exemple éclatant de coopération dans l’espace entre les États-Unis, l’Europe, le Canada, le Japon et la Russie. Mais même les plus belles aventures ont une fin.

En 2030, la Station spatiale internationale sera désorbitée : elle sera dirigée vers une zone isolée du Pacifique.

Je suis ingénieur en aérospatiale et j’ai contribué à la conception de nombreux équipements et expériences pour l’ISS. Membre de la communauté spatiale depuis plus de trente ans, dont dix-sept au sein de la Nasa, il me sera difficile d’assister à la fin de cette aventure.

Depuis le lancement des premiers modules en 1998, la Station spatiale internationale a été le théâtre d’avancées scientifiques majeures dans des domaines tels que la science des matériaux, la biotechnologie, l’astronomie et l’astrophysique, les sciences de la Terre, la combustion et bien d’autres encore.

Les recherches menées par les astronautes à bord de la station et les expériences scientifiques installées sur sa structure extérieure ont donné lieu à de nombreuses publications dans des revues à comité de lecture. Certaines ont permis de mieux comprendre les orages, d’améliorer les procédés de cristallisation de médicaments essentiels contre le cancer, de préciser comment développer des rétines artificielles en apesanteur, d’explorer la production de fibres optiques ultrapures et d’expliquer comment séquencer l’ADN en orbite.

Au total, plus de 4 000 expériences ont été menées à bord de l’ISS, donnant lieu à plus de 4 400 publications scientifiques destinées à améliorer la vie sur Terre et à tracer la voie de futures activités d’exploration spatiale.

La station a démontré toute la valeur de la recherche conduite dans l’environnement unique des vols spatiaux – marqué par une très faible gravité, le vide, des cycles extrêmes de température et des radiations – pour faire progresser la compréhension d’une large gamme de processus physiques, chimiques et biologiques.

Maintenir une présence en orbite

Avec le retrait annoncé de la station, la Nasa et ses partenaires internationaux n’abandonnent pas pour autant leur avant-poste en orbite terrestre basse. Ils cherchent au contraire des alternatives pour continuer à exploiter le potentiel de ce laboratoire de recherche unique et prolonger la présence humaine ininterrompue maintenue depuis 25 ans à quelque 402 kilomètres au-dessus de la Terre.

En décembre 2021, la Nasa a annoncé trois contrats visant à soutenir le développement de stations spatiales privées et commerciales en orbite basse. Depuis plusieurs années, l’agence confie déjà le ravitaillement de l’ISS à des partenaires privés. Plus récemment, elle a adopté un dispositif similaire avec SpaceX et Boeing pour le transport d’astronautes à bord respectivement de la capsule Dragon et du vaisseau Starliner.

Fort de ces succès, la Nasa a investi plus de 400 millions de dollars pour stimuler le développement de stations spatiales commerciales, avec l’espoir de les voir opérationnelles avant la mise hors service de l’ISS.

L’aube des stations spatiales commerciales

En septembre 2025, la Nasa a publié un projet d’appel à propositions pour la phase 2 des partenariats concernant les stations spatiales commerciales. Les entreprises retenues recevront des financements pour réaliser les revues critiques de conception et démontrer le bon fonctionnement de stations capables d’accueillir quatre personnes en orbite pendant au moins trente jours.

La Nasa procédera ensuite à une validation et une certification formelles afin de garantir que ces stations répondent à ses normes de sécurité les plus strictes. Cela permettra ensuite à l’agence d’acheter des missions et des services à bord de ces stations sur une base commerciale – de la même manière qu’elle le fait déjà pour le transport de fret et d’équipages vers l’ISS. Reste à savoir quelles entreprises réussiront ce pari, et selon quel calendrier.

Pendant que ces stations verront le jour, les astronautes chinois continueront à vivre et à travailler à bord de leur station Tiangong, un complexe orbital habité en permanence par trois personnes, évoluant à environ 400 kilomètres au-dessus de la Terre. Si la continuité habitée de l’ISS venait à s’interrompre, la Chine et Tiangong prendraient ainsi le relais comme station spatiale habitée sans discontinuité la plus ancienne en activité. Tiangong est occupée depuis environ quatre ans.

En attendant, levons les yeux

Il faudra encore plusieurs années avant que les nouvelles stations spatiales commerciales n’encerclent la Terre à environ 28 000 kilomètres par heure et avant que l’ISS ne soit désorbitée en 2030.

D’ici là, il suffit de lever les yeux pour profiter du spectacle. Lors de ses passages, l’ISS apparaît la plupart des nuits comme un point bleu-blanc éclatant, souvent l’objet le plus brillant du ciel, traçant silencieusement une courbe gracieuse à travers la voûte étoilée. Nos ancêtres n’auraient sans doute jamais imaginé qu’un jour, l’un des objets les plus lumineux du ciel nocturne serait conçu par l’esprit humain et assemblé par la main de l’homme.

John M. Horack a reçu des financements de recherche externes de la NASA, de Voyager Technologies et d’autres organismes liés au domaine spatial, dans le cadre de son travail de professeur à l’Université d’État de l’Ohio.

01.10.2025 à 11:49

Comment débutent les cancers du sein ? Conversation avec la biochimiste Alexandra Van Keymeulen

Alexandra Van Keymeulen, Maître de recherche FNRS au Laboratoire des Cellules Souches et du Cancer, Université Libre de Bruxelles (ULB)

Texte intégral (3154 mots)

Alexandra Van Keymeulen est biochimiste et spécialiste du cancer du sein. Avec son équipe, elle explore les étapes extrêmement précoces dans le développement des tumeurs, bien avant que celles-ci ne soient détectables. Elle a reçu Elsa Couderc, cheffe de rubrique Science et Technologie, pour expliquer simplement ce qu’est un cancer, et les avancées de la recherche depuis qu’elle a débuté dans le domaine.

The Conversation France : Aujourd’hui, vous êtes une spécialiste reconnue sur l’origine du cancer du sein, mais vous n’avez pas commencé vos recherches par là.

Alexandra Van Keymeulen : J’ai fait ma thèse, en Belgique, sur la thyroïde. J’étudiais les mécanismes qui font que les cellules thyroïdiennes prennent la décision de se diviser. Comme les cellules ne sont pas immortelles, qu’elles vivent moins longtemps que nous, il y a sans arrêt des cellules qui meurent et, donc, des cellules qui se divisent pour donner naissance à de nouvelles cellules. Dans une thyroïde saine, les cellules prennent en permanence la décision de se diviser ou non pour donner naissance à la prochaine génération de cellules.

Je travaillais sur les thyroïdes saines, mais dans un groupe où d’autres personnes étudiaient le cancer de la thyroïde. En effet, les mécanismes de division cellulaire sont dérégulés dans le cas d’un cancer : les cellules se divisent de manière anarchique, sans contrôle. Elles forment une masse, un peu comme un mini-organe. Elles ne répondent plus aux signaux environnants qui leur indiquent de stopper leur croissance. La division cellulaire incontrôlée est la première étape pour former une tumeur.

Mais une tumeur bénigne n’est pas appelée « cancer ». Un cancer a aussi des caractéristiques invasives, c’est-à-dire que ces cellules migrent et envahissent les autres tissus.

Et justement, après ma thèse, je suis partie cinq années à San Francisco en postdoctorat. Là, j’ai travaillé sur la migration cellulaire. Je ne travaillais toujours pas sur des cellules cancéreuses, mais sur les mécanismes intrinsèques, au sein des cellules, qui font qu’elles se déplacent d’un organe à l’autre ; typiquement, ce sont les cellules du système immunitaire qui se déplacent pour aller au site de l’infection.

Ce sont ces mécanismes-là qui sont piratés par les cellules cancéreuses pour former des métastases. Les cellules cancéreuses migrent moins vite que des cellules du système immunitaire, mais elles arrivent à se déplacer.

Après avoir étudié la division cellulaire et la migration des cellules saines, vous êtes rentrée en Belgique pour étudier les cancers du sein ?

A. V. K. : Oui, je suis rentrée en même temps que Cédric Blanpain et j’ai rejoint l’équipe qu’il était en train de monter. Il est spécialiste du cancer de la peau. Très vite, j’ai décidé de travailler sur le sein, qui n’est pas si différent que ça de la peau, car ces deux organes sont composés de cellules épithéliales. Ils ont des caractéristiques communes et donc on peut utiliser les mêmes souris pour les projets qui ont trait au cancer de la peau ou au cancer du sein.

À ce stade, c’était nouveau pour vous comme organe d’étude ?

A. V. K. : Tout était nouveau ! Travailler sur le sein était nouveau, mais je n’avais jamais travaillé non plus avec des souris.

Et quelles étaient les grandes questions de la recherche sur le cancer du sein à l’époque ? Qu’est-ce que vous cherchiez à savoir, dans ce tout nouveau labo, en 2006 ?

A. V. K. : La grande question, c’était de savoir quelles cellules sont à l’origine des cancers du sein. Il y avait déjà à l’époque deux hypothèses. En vingt ans, on a répondu à certaines choses, mais ces deux hypothèses sont toujours là aujourd’hui. Pourquoi y a-t-il différents types de cancer du sein ? Est-ce parce que les patients ont eu différentes mutations génétiques ou parce que les mutations sont survenues dans différents types de cellules de la glande mammaire ? On pourrait avoir aussi une combinaison de ces deux explications.

En ce qui concerne les mutations, on avait déjà repéré que certaines mutations génétiques sont liées à certains types de cancers du sein chez l’humain : on dit que la mutation a un impact sur l’issue tumorale.

Pour explorer l’autre hypothèse – quelles sont les cellules à l’origine d’un cancer, il a d’abord fallu comprendre comment se renouvellent les cellules dans la glande mammaire. Est-ce que tous les types de cellules de la glande mammaire sont maintenus par un seul type de cellule souche, ou bien est-ce qu’à chaque type de cellule correspond une cellule souche ? On appelle ça la « hiérarchie cellulaire ».

Qu’est-ce qu’une cellule souche ?

- Une cellule souche adulte est une cellule capable, à la fois, de générer des cellules spécialisées d’un organe et de se régénérer dans l’organe pour une spécialisation ultérieure.

Comment étudiez-vous d’où viennent les cellules de la glande mammaire et comment elles se renouvellent tout au cours de la vie, pendant une grossesse, l’allaitement, etc. ?

A. V. K. : On a fait du « traçage de lignée » (lineage tracing, en anglais), qui est notre grande spécialité au laboratoire. Cette technique consiste à introduire un marqueur fluorescent dans une cellule. Comme ce marqueur fluorescent est dû à une mutation génétique, le marquage est irréversible : une fois que la cellule est fluorescente, elle va le rester toute sa vie. Et surtout, si elle se divise, toute sa progéniture va être fluorescente aussi… ce qui va nous permettre de suivre le devenir d’une cellule ! Si on a ciblé une cellule qui ne se divise plus, elle va être éliminée après quelques semaines et on n’aura plus de fluorescence. Par contre, si on a ciblé une cellule souche, on va voir qu’elle va donner naissance à de nouvelles cellules qui vont également être fluorescentes.

Avec cette technique, on a pu étudier comment les glandes mammaires sont maintenues au cours du temps et démontrer, en 2011, que ce sont différents types de cellules souches qui renouvellent la glande mammaire.

C’était vraiment un changement de paradigme, car on croyait à l’époque qu’en haut de la hiérarchie cellulaire de la glande mammaire, il y avait des cellules souches « multipotentes » (c’est-à-dire, capables de se différencier en plusieurs types de cellules). On sait aujourd’hui qu’il y a trois types de cellules souches dans la glande mammaire, qui se différencient chacune en un seul type de cellule.

Quels sont ces trois types de cellules dans le sein ?

A. V. K. : Les glandes mammaires contiennent un réseau de tuyaux reliés au mamelon, et qui vont produire le lait à l’intérieur du tube pour l’expulser.

Un premier type de cellules est celui des « cellules basales », aussi appelées myoépithéliales, qui ont des propriétés contractiles et vont se contracter au moment de l’allaitement pour expulser le lait.

Puis, à l’intérieur des tubes, se trouve la couche luminale, qui est composée de deux types de cellules : celles qui sont positives aux récepteurs aux œstrogènes et celles qui sont négatives aux récepteurs aux œstrogènes. Les positives vont sentir la présence des hormones et relayer les signaux hormonaux aux autres cellules, pour dire « Maintenant, on se divise tous ensemble ». Les négatives sécrètent du lait pendant l’allaitement.

Donc aux trois types de cellules dans le sein correspondent trois types de cellules souches « unipotentes ». Mais en ce qui concerne la formation de tumeurs cancéreuses : comment étudiez-vous une tumeur avant même qu’elle existe ? Vous avez une machine à remonter le temps ?

A. V. K. : Eh non ! Il faut prédisposer les souris aux tumeurs. Pour cela, on utilise des souris transgéniques, avec une mutation génétique dont on sait qu’elle est favorable à un cancer du sein. On insère la mutation soit dans les cellules luminales, soit dans les cellules basales. Et on a montré que le type de cancer développé n’est pas le même lorsque la mutation est introduite dans les cellules luminales ou basales.

Comment ça se passe en pratique ? Vous induisez une mutation génétique, mais vous ne pouvez pas être sûre que chaque souris va développer un cancer. Est-ce qu’il faut tuer la souris avant qu’elle développe un cancer, ou on peut faire des prélèvements ?

A. V. K. : Effectivement, toutes les souris prédisposées ne développent pas de cancers. Pour savoir comment ça évolue, nous palpons les souris – comme les palpations qui accompagnent les mammographies dans les examens pour les femmes. Il existe aussi des PET-scanners pour souris, mais mon laboratoire n’est pas équipé.

Si on palpe une tumeur, alors on tue la souris afin de prélever la tumeur et d’étudier le type de cancer qui a été provoqué par la mutation que nous avions induite. C’est comme cela que nous avons démontré, en 2015, qu’une même mutation n’a pas le même effet si elle est introduite sur une cellule basale ou sur une cellule luminale.

Ensuite on a développé un outil pour cibler les cellules luminales, qui sont divisées en deux types, comme on l’a vu : celles qui sont positives aux récepteurs aux œstrogènes et celles qui sont négatives aux récepteurs aux œstrogènes. C’est ce que nous avons publié en 2017. On s’est posé la même question que précédemment : est-ce qu’une même mutation génétique provoque des types de cancers différents ?

Ce sont des recherches qui sont encore en cours, mais, à nouveau, nos résultats semblent montrer que l’issue tumorale dépend de la cellule dans laquelle survient la première mutation.

Vous avez étudié plusieurs mutations connues pour favoriser les cancers du sein ?

A. V. K. : On connaît aujourd’hui des dizaines de mutations génétiques responsables de cancers du sein. Les étudier toutes va prendre du temps, d’autant que cette librairie de mutations est peut-être non exhaustive. Pour l’instant, nous avons étudié une seule mutation, qui est l’une des plus courantes dans le cancer du sein chez la femme.

À lire aussi : Cancer du sein : une nouvelle étude révèle un risque génétique chez les femmes africaines

Est-ce que vous interagissez avec les médecins, avec les patientes ?

A. V. K. : Avec les médecins, oui, bien sûr. On se retrouve aux conférences, et certains de mes collègues sont médecins à l’hôpital universitaire de l’Université libre de Bruxelles, juste à côté de notre laboratoire. Quand j’ai des résultats, je vais en discuter avec un spécialiste du cancer du sein chez l’humain pour essayer de trouver la pertinence pour des cancers chez l’humain.

Je fais aussi partie des experts scientifiques bénévoles pour la Fondation contre le cancer belge – ça fait partie des missions d’un chercheur à l’université que de prendre ce genre de rôle.

Les patientes, je les rencontre plutôt pour de la vulgarisation, avec la Fondation contre le cancer, qui organise tous les ans des visites de laboratoire. Il y a aussi le Télévie, un organisme inspiré du Téléthon, en Belgique francophone et au Luxembourg, où on côtoie des patients et des bénévoles lors d’événements. Ces organismes sont aussi des financeurs de nos recherches.

La prévention est un thème qui me tient à cœur, puisqu’un cancer du sein sur quatre pourrait être évité en éliminant le tabac, l’alcool, le surpoids et en faisant régulièrement de l’activité physique. En particulier, le fait que même une consommation légère d’alcool augmente le risque de cancer du sein est encore très méconnu du grand public, mais démontré scientifiquement.

À lire aussi : Pourquoi l’alcool augmente le risque de cancer, et ce, dès le premier verre

On entend beaucoup parler de certains cancers du sein qui sont liés à des prédispositions génétiques…

A. V. K. : En fait, il n’y a que 10 % des cancers du sein qui viennent de prédispositions génétiques, c’est-à-dire des mutations présentes depuis la naissance, comme c’est le cas d’Angelina Jolie.

La grande majorité des cancers provient de mutations génétiques qui ont lieu au cours de la vie, par exemple à cause de cassures de l’ADN qui sont liées à la consommation de tabac et d’alcool, et qui ont été mal ou pas réparées par l’organisme.

Or, plus un cancer est pris tôt, plus les chances de guérison sont grandes et plus le traitement sera léger. D’où l’intérêt de notre travail sur les étapes extrêmement précoces dans le développement d’une tumeur… mais aussi l’importance pour le patient de consulter dès l’apparition de symptômes.

Justement, vous disiez tout à l’heure que les grandes questions sur l’origine des cancers du sein, qui prévalaient au début de votre carrière, étaient toujours d’actualité aujourd’hui ?

A. V. K. : Tout à fait. Quand on introduit une mutation dans les souris, on doit attendre plusieurs mois – parfois six mois ou un an – avant d’observer l’apparition d’une tumeur. Mais on ne sait pas encore ce qui se passe dans la glande mammaire pendant ce temps-là.

C’est pour cela que je disais tout à l’heure que la question que nous nous posions il y a vingt ans demeure dans une certaine mesure : on cherche toujours ce qu’il se passe dans les cellules qui sont à l’origine du cancer.

En fait, on observe que la mutation change complètement le comportement de ces cellules. La structure extérieure macroscopique de la glande mammaire reste la même, mais, à l’intérieur, les cellules sont tout à fait reprogrammées. Elles deviennent beaucoup plus plastiques, multipotentes – c’est-à-dire qu’elles peuvent donner lieu aux autres types cellulaires.

L’idée serait d’avoir une « fenêtre de tir » thérapeutique entre la mutation et le développement d’une tumeur ?

A. V. K. : Tout à fait : si on comprend ce qui se passe pendant cette période-là, on pourrait imaginer des outils de diagnostic. Par exemple, pour les femmes qui sont prédisposées génétiquement, comme Angelina Jolie, plutôt que d’enlever les seins et les ovaires, on aimerait pouvoir les surveiller de près et, dès que l’on verrait apparaître certaines de ces étapes précoces, intervenir avec un traitement préventif pour inhiber le développement d’une tumeur cancéreuse.

À l’heure actuelle, ça reste hypothétique : nous sommes un laboratoire de recherche fondamentale. Aujourd’hui, on essaye de comprendre ce qui se passe entre l’introduction de la mutation et le début de la tumeur. Auparavant, on devait se contenter d’étudier les tumeurs elles-mêmes, car nous n’avions pas les outils pour étudier cette fenêtre de six mois – je précise que cette durée est évaluée chez les souris, pas chez les humains.

Pour mener à un cancer, il faut une mutation génétique dans une seule cellule, ou bien la même mutation dans plein de cellules différentes, une accumulation progressive ?

A. V. K. : Il faut plusieurs mutations dans une seule cellule – s’il ne fallait qu’une mutation dans une cellule, tout le monde aurait des cancers partout ! C’est une accumulation de probablement sept ou huit mutations bien spécifiques.

Mais quand une cellule est mutée, souvent ce qu’on observe, c’est que ces mutations donnent un avantage à ces cellules par rapport aux cellules avoisinantes. Des études récentes montrent par exemple des « taches » dans la peau des paupières, invisibles à l’œil nu. Ce sont des zones de la peau où toutes les cellules ont les mêmes mutations. Elles proviennent d’une seule et même cellule, qui s’est divisée, au détriment des cellules avoisinantes : en se divisant, les descendantes de la cellule mutée poussent les autres et propagent les mutations. C’est aussi vrai pour d’autres organes, notamment la glande mammaire.

Aujourd’hui, sur les étapes précoces des cancers du sein, nous cherchons donc à savoir comment les cellules à l’origine du cancer sont reprogrammées génétiquement et comment cela leur confère un avantage par rapport aux cellules saines. On explore ainsi petit à petit les grandes étapes qui mènent à une tumeur.

Alexandra Van Keymeulen est consultant scientifique de Cancer State Therapeutics. Ses recherches bénéficient du soutien financier du FNRS, Télévie, Fondation contre le Cancer et du Fonds Gaston Ithier.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Lava

- La revue des médias

- Le Grand Continent

- Le Diplo

- Le Nouvel Obs

- Lundi Matin

- Mouais

- Multitudes

- Politis

- Regards

- Smolny

- Socialter

- The Conversation

- UPMagazine

- Usbek & Rica

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- Contretemps

- A Contretemps

- Alter-éditions

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- Philo Mag

- Terrestres

- Vie des Idées

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview

- Fiabilité 3/5

- Slate

- Ulyces

- Fiabilité 1/5

- Contre-Attaque

- Issues

- Korii

- Positivr

- Regain