14.12.2025 à 17:59

Airbus : D’où vient la panne qui a conduit l’entreprise à immobiliser des milliers d’avions ?

David Monniaux, Chercheur en informatique, Centre national de la recherche scientifique (CNRS), Université Grenoble Alpes (UGA)

Texte intégral (2101 mots)

Fin octobre, Airbus demande aux compagnies aériennes de maintenir au sol 6 000 A320, à la suite d’un incident survenu en vol. L’entreprise l’explique par une mise à jour logicielle qui serait plus sensible aux rayonnements cosmiques. Si ce genre de problèmes existe, ils sont cependant détectés immédiatement en temps normal.

Le 30 octobre dernier, un vol de Cancún vers le New Jersey de la compagnie JetBlue a rapidement chuté en plein vol, avant que les pilotes puissent rétablir sa trajectoire, au bout de quelques secondes. Après un atterrissage en urgence en Floride, quelques passagers ont reçu des soins. À la suite de cet incident, Airbus a dû changer en urgence un logiciel de pilotage dans 6000 appareils de la famille A320. On a évoqué une « perturbation par une particule isolée » et le rôle des éruptions solaires. Qu’en est-il ?

Le palliatif proposé par Airbus est de faire revenir la version de certains logiciels de pilotage à une version antérieure. Sur les forums spécialisés, on spécule sur les causes techniques de ce dysfonctionnement, sur d’éventuelles fonctionnalités ajoutées entre ces deux versions, qui seraient insuffisamment protégées contre les effets que des rayonnements cosmiques peuvent avoir dans les composants informatiques. Il vaut mieux, toutefois, attendre le rapport officiel de l’enquête sur l’incident. En attendant, nous pouvons revenir sur l’explication invoquée et en quoi elle peut surprendre.

Les rayons cosmiques, ennemis de nos systèmes électroniques

La Terre est en permanence bombardée par des particules venant de l’espace – du Soleil ou de corps plus lointains. La plupart de ces particules sont déviées par le champ magnétique terrestre, une autre partie est absorbée ou transformée par l’atmosphère, mais certaines d’entre elles peuvent atteindre la surface terrestre. Elles forment une partie de la radioactivité naturelle, et sont plus abondantes en périodes d’éruption solaire.

Ces particules arrivant de l’espace ont des effets variés. Dans les régions polaires, moins protégées par le champ magnétique terrestre, elles provoquent de magnifiques aurores dans le ciel de nuit. On leur attribue également les flashes lumineux que les astronautes perçoivent dans leurs yeux. Comme il s’agit de rayonnements ionisants, les particules reçues peuvent avoir des effets sur la santé. Ainsi, Thomas Pesquet, en six mois de séjour dans la station spatiale internationale, a bien dépassé le quota annuel maximum d’exposition aux radiations permis pour un travailleur français.

Les particules issues de l’espace peuvent provoquer des dysfonctionnements dans les circuits électroniques. Par exemple, dans les années 1990, des composants électroniques de puissance, notamment conçus pour des trains, grillaient pour des raisons mystérieuses. Pour trier parmi les diverses hypothèses envisagées, on a essayé ces composants à la surface et dans une mine de sel, sous 140 mètres de roche : les problèmes ne se produisaient pas dans la mine ! Une fois le problème identifié, on a pu concevoir des composants et des modes d’utilisation beaucoup moins vulnérables.

Qu’est-ce qu’une perturbation par une particule isolée ?

Il est plus courant que, plutôt que de griller un composant, les particules modifient une donnée qui y est stockée. Les ordinateurs retiennent les informations sous forme de 0 et de 1, et une particule peut provoquer le basculement d’un 0 en 1 ou l’inverse, ce qu’on appelle une « perturbation par une particule isolée », ou single event upset en anglais.

En 2003, dans la commune belge de Schaerbeek, une liste a obtenu lors d’une élection un excès de précisément 4 096 voix, ce qui correspond exactement au basculement d’un 0 en 1 à l’intérieur d’un nombre écrit en binaire. Un tel basculement s’expliquerait par un single event upset.

Bien évidemment, et notamment pour les applications aérospatiales, particulièrement exposées, on a développé des parades. Certaines parades sont matérielles : par exemple, les mémoires vives peuvent être munies de codes correcteurs d’erreurs fondés sur du matériel spécifique pour coder et décoder très rapidement. C’est habituellement le cas de la mémoire vive des serveurs, les machines qui stockent des données dans les data centers, mais pas des ordinateurs de bureau ou des portables, du fait de leur coût. Ces codes permettent de corriger à coup sûr certaines erreurs et, dans d’autres cas, d’au moins signaler qu’il s’est passé quelque chose d’incorrect.

D’autres parades sont logicielles : procéder régulièrement à certaines vérifications, dupliquer des données à conserver sur de longues durées, éviter de garder trop longtemps des données dans des mémoires vulnérables, enregistrer certaines informations importantes d’une façon telle que le basculement d’un chiffre fournit une valeur absurde, donc détectable… Les possibilités sont nombreuses. Il y a par ailleurs des protocoles de test, y compris consistant à placer les circuits dans le faisceau d’un accélérateur de particules (grand instrument de sciences physiques).

Des commandes de vol électriques touchées par une panne

Voyons maintenant les implications pour l’aviation. La transmission des ordres des pilotes de ligne à leurs gouvernes, les parties mobiles de l’avion qui permettent de contrôler sa trajectoire, se faisait historiquement par des systèmes de câbles, de poulies ou de circuits hydrauliques assez compliqués. Il faut en plus assurer la redondance, c’est-à-dire prévoir plusieurs modes de transmission en cas de panne. Depuis les années 1980, les nouveaux modèles d’avions utilisent des commandes de vol électriques, c’est-à-dire que ces transmissions mécaniques sont remplacées par des câblages et des calculateurs électroniques.

Ces calculateurs diminuent la charge de pilotage (ils automatisent des actions que les pilotes devraient sinon faire manuellement) et augmentent ainsi la sécurité. Ils peuvent vérifier si les pilotes commandent une manœuvre qui sortirait l’avion du domaine des manœuvres qu’il peut faire en sécurité, et peuvent par exemple prévenir le décrochage. La panne qui a valu le rappel des avions Airbus concerne un calculateur appelé ELAC, qui commande les élévateurs et les ailerons, qui sont respectivement des gouvernes situées sur le stabilisateur arrière de l’avion et sur l’arrière du bout des ailes.

Les commandes de vol sont particulièrement sécurisées

Un point qui peut tout d’abord nous rassurer est que les problèmes de particules venues de l’espace se produisent plutôt à haute altitude, lorsqu’il y a moins d’atmosphère protectrice, alors que les étapes les plus dangereuses dans un vol sont plutôt le décollage et l’atterrissage. Ceci n’excuse cependant pas le dysfonctionnement constaté. Voyons un peu pourquoi ce problème n’aurait pas dû se produire.

Les calculateurs informatisés d’aviation civile sont classés, suivant les standards internationaux de l’aviation civile, en cinq niveaux de criticité, selon la sévérité des conséquences possibles d’un dysfonctionnement : du niveau A, où un dysfonctionnement peut provoquer une catastrophe aérienne, au niveau E, où il n’y aurait pas de conséquences pour la sécurité de l’aéronef. Les commandes de vol électriques sont du niveau A, elles sont donc soumises aux normes les plus sévères. On peut donc raisonnablement supposer que les commandes de vol des A320 sont équipées de mécanismes de détection et/ou de remédiation de dysfonctionnements, y compris dus aux radiations.

Sur les Airbus A330/A340, par exemple, il existe deux niveaux de commande de vol, primaires et secondaires. Il y a trois boîtiers de commandes primaires, et lorsqu’un boîtier a subi un problème, il est temporairement désactivé – ce n’est pas grave, car il en a deux autres pour le relayer. S’il y avait un problème générique sur les commandes primaires, on pourrait fonctionner avec les commandes secondaires, qui utilisent d’autres types de composants.

Chaque boîtier de commande de vol primaire consiste en deux calculateurs, l’un qui commande les gouvernes, l’autre qui surveille celui qui commande – ils doivent produire environ les mêmes résultats, sinon le système détecte que quelque chose ne va pas. Normalement, sur un tel système, en cas de dysfonctionnement d’un des calculateurs, le problème est rapidement détecté, le boîtier est désactivé, on passe sur un autre et une chute comme celle qui s’est passée en octobre est impossible.

Pourquoi les systèmes n’ont-ils pas détecté le problème ?

J’ai personnellement travaillé sur l’analyseur statique Astrée, un outil destiné à vérifier que des logiciels de contrôle ne se mettent jamais dans des situations d’erreur. Il a notamment été utilisé par Airbus sur ses commandes de vol électriques. J’ai eu l’occasion, au fil des années, d’apprécier le sérieux et la volonté de cette société de se doter d’approches à la pointe de l’état de l’art en matière de technologies logicielles, notamment de vérification formelle.

Plus récemment, j’ai également travaillé sur des contre-mesures à des erreurs de fonctionnement informatique provoquées volontairement à l’aide de rayonnements électromagnétiques. Il existe en effet la possibilité que des personnes induisent volontairement des pannes afin de les exploiter dans un but frauduleux, c’est donc nécessaire de travailler à prévenir ces tentatives pour des cartes à puce et d’autres équipements sécurisés.

L’hypothèse qu’il s’agisse bien d’une perturbation par une particule isolée reste plausible, mais il est surprenant qu’il ait fallu plusieurs secondes pour traiter le problème. Le système de sécurité du boîtier de commande affecté par l’irradiation aurait dû détecter l’incident, le boîtier touché aurait dû être automatiquement désactivé et l’avion basculé sur un autre, en secours. Il faut donc attendre d’autres éléments pour déterminer si c’est la bonne explication, et comment cela a pu alors se produire, ou si d’autres scénarios sont à envisager.

David Monniaux a reçu des financements de l'ANR (PEPR Cybersécurité). En tant que co-développeur de l'analyseur Astrée, il touche une prime d'intéressement à la valorisation de ce logiciel, donc à ses ventes.

10.12.2025 à 16:07

Dans les torrents, des insectes tissent de minuscules filets de pêche qui inspirent de nouveaux matériaux

Christophe Mori, Maitre de conférences, Université de Corse Pascal-Paoli

Texte intégral (1519 mots)

Au fond des torrents et des ruisseaux, de petites larves d’insecte construisent des filets pour attraper leur nourriture et font preuve d’une intelligence remarquable pour s’adapter au courant. Des comportements qui inspirent nos propres innovations techniques.

Imaginez-vous au bord d’un torrent, où l’eau surgit avec une force capable d’emporter des pierres. Au fond de ce tumulte, des larves de quelques millimètres, non seulement survivent, mais prospèrent en bâtissant des pièges ingénieux pour capturer leur nourriture. Sur leurs filets de soie de 2 à 3 cm de diamètre, on les voit s’affairer, le nettoyant régulièrement des petits morceaux de feuilles, de bois, des algues et des petits organismes qui s’y piègent.

Ces larves sont des hydropsychés, des insectes de l’ordre des trichoptères. Après avoir vécu sous la forme de larve dans une rivière pendant un à deux ans, ils s’envolent une fois leur forme adulte atteinte, durant laquelle il ressemble à un petit papillon de nuit. La fin de leur vie sera alors très courte, de 10 à 20 jours seulement.

Les hydropsychés, petits ingénieurs des ruisseaux

Les hydropsychés sont des insectes aquatiques ingénieux qui construisent ces tamis de soie pour filtrer passivement leur nourriture dans les eaux courantes. Cette capacité démontre une réelle intelligence comportementale, d’autant qu’ils savent s’ajuster aux flux de nutriments et qu’elles défendent leur territoire. Les larves tricotent des mailles fines (entre 1/50 e et 1/10 e de mm) adaptées à la vitesse du courant : plus il est fort, plus elles fabriquent un filet aux mailles serrées pour résister au courant ! Et lorsqu’il est obstrué ou endommagé, par exemple par des sédiments ou un courant trop fort, elles sont capables de le reconstruire ou le modifier. Il reste à comprendre le déclencheur précis de cette adaptation – est-ce purement génétique ou influencé par l’apprentissage individuel ?

Un si petit organisme, de seulement 1 à 2 cm de long, et qui possède un cerveau de 0,3 mm3 est non seulement capable de concevoir son filet avec une maille variable, de l’ancrer au substrat et de l’orienter face au courant. Mais il est sait aussi repousser ses congénères qui pourraient s’installer trop près et lui voler sa pêche ! Pour cela, les hydropsychés utilisent des ultrasons (d’une fréquence de 64 à 100 kHz, bien au-delà de ce que l’oreille humaine peut percevoir) pour indiquer leur présence à leurs voisins.

À la manière des cigales, les larves génèrent ces sons par stridulation, en frottant certaines parties de leur corps entre elles. Cette technique acoustique facilite leur navigation dans le tumulte sonore des eaux agitées, et est associée à des signaux chimiques tels que des phéromones qui facilitent l’identification et l’interaction sociale dans des milieux agités.

Des petites larves témoin de la qualité des eaux

Dans les communautés aquatiques, les hydropsychés coexistent avec d’autres espèces filtreuses, comme des larves de diptères, pour optimiser les ressources. Elles influencent la stabilité des cours d’eau en modulant les sédiments organiques et les différents flux nutritifs. Les organismes filtreurs sont de véritables nettoyeurs des rivières et des torrents, de petits ingénieurs qui améliorent la qualité des eaux. Ils sont déterminants dans l’architecture des écosystèmes d’eaux courantes, puisqu’ils constituent des proies pour les autres organismes, et sont donc à la base des chaînes alimentaires.

D’un point de vue morphologique, les branchies spécialisées des hydropsychés leur permettent d’extraire l’oxygène même dans des conditions tumultueuses ou déficientes. Cependant, ce sont aussi des organismes fragiles. Cela en fait de bons indicateurs biologiques qui servent aux scientifiques à évaluer la qualité de l’eau et les impacts de la pollution ou du changement climatique.

De plus, les hydropsyché inspirent le biomimétisme pour des technologies filtrantes durables, des colles aquatiques et la recherche médicale. Contrairement à la soie de ver à soie ou d’araignée, celle des hydropsychés est synthétisée sous l’eau, ce qui lui confère une résistance exceptionnelle à l’humidité, une haute élasticité et une biodégradabilité contrôlée. Ces caractéristiques en font un modèle idéal pour développer des biomatériaux innovants en médecine.

Quand l’hydropsyché inspire nos propres innovations

Dans ce monde aquatique en perpétuel mouvement, ces organismes démontrent que la survie dépend d’une vigilance constante et de l’adaptation face à l’instabilité. L’humanité peut s’inspirer de cette résilience et, plus spécifiquement, des stratégies de ces petits insectes aquatiques. La soie des larves d’hydropsychés intéresse la recherche, car elle adhère facilement aux surfaces immergées tout en restant flexible. Elle présente également une résistance mécanique jusqu’à plusieurs fois celle de l’acier à poids égal, n’induit pas de réactions immunitaires fortes et est biodégradable sans laisser de résidus toxiques.

En imitant la composition de la soie des larves d’hydropsyché, les scientifiques développent des colles synthétiques qui fonctionnent en milieu humide, comme dans le corps humain. Ces adhésifs pourraient révolutionner la chirurgie en permettant de refermer des tissus mous (comme le foie ou le cœur) sans points de suture, réduisant les risques d’infection et accélérant la guérison. Des prototypes sont déjà testés pour sceller des vaisseaux sanguins ou réparer des organes internes.

Le filet adaptable des hydropsychés inspire aussi des filtres intelligents qui ajustent leur porosité selon le débit d’eau et la taille des particules, et qui seraient utiles dans les usines de traitement des eaux et les stations d’épuration. Ce composé intéresse aussi les industries marines, pour créer des matériaux qui absorberaient l’énergie des vagues sans se briser, prolongeant la durée de vie des structures. Cela pourrait notamment être exploité par le secteur de l’énergie, pour les éoliennes marines ou les hydroliennes.

Les habitants des cours d’eau : un exemple à suivre

En nous inspirant de ce petit ingénieur, nous ouvrons des voies pour des avancées concrètes. Les solutions les plus élégantes et durables ne viennent pas toujours de laboratoires, mais souvent de la nature elle-même, où l’ingénieuse simplicité du vivant surpasse notre créativité. Et à l’instar des communautés d’organismes fluviaux qui se soutiennent mutuellement, les sociétés humaines doivent établir des réseaux solidaires pour affronter l’incertitude. La remarquable résilience de ces larves nous exhorte à repenser nos modes de vie, en mettant l’accent sur une adaptation préventive plutôt que sur une réaction tardive.

En fin de compte, les hydropsychés et les organismes aquatiques en général nous offrent un exemple à suivre : dans un environnement instable, la survie réside dans la diversité des adaptations et une réelle persévérance. Dans un monde en mutation, elle n’est pas innée, mais elle peut être cultivée. Ces organismes nous montrent que même dans l’agitation structurelle permanente, la vie persiste. En protégeant les écosystèmes fluviaux, nous préservons non seulement la biodiversité, mais aussi un trésor d’inspirations pour un avenir plus résilient et innovant.

Cet article est publié dans le cadre de la Fête de la science (qui a lieu du 3 au 13 octobre 2025), dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « Intelligence(s) ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Christophe Mori ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.12.2025 à 12:22

Ces pointes de flèches prouvent-elles la présence d’Homo Sapiens en Eurasie il y a 80 000 ans ?

Hugues Plisson, archéologue spécialisé en tracéologie (reconstitution de la fonction des outils préhistoriques par l'analyse de leurs usures), Université de Bordeaux

Andrey I. Krivoshapkin, Acting director, Russian Academy of Sciences

Texte intégral (3861 mots)

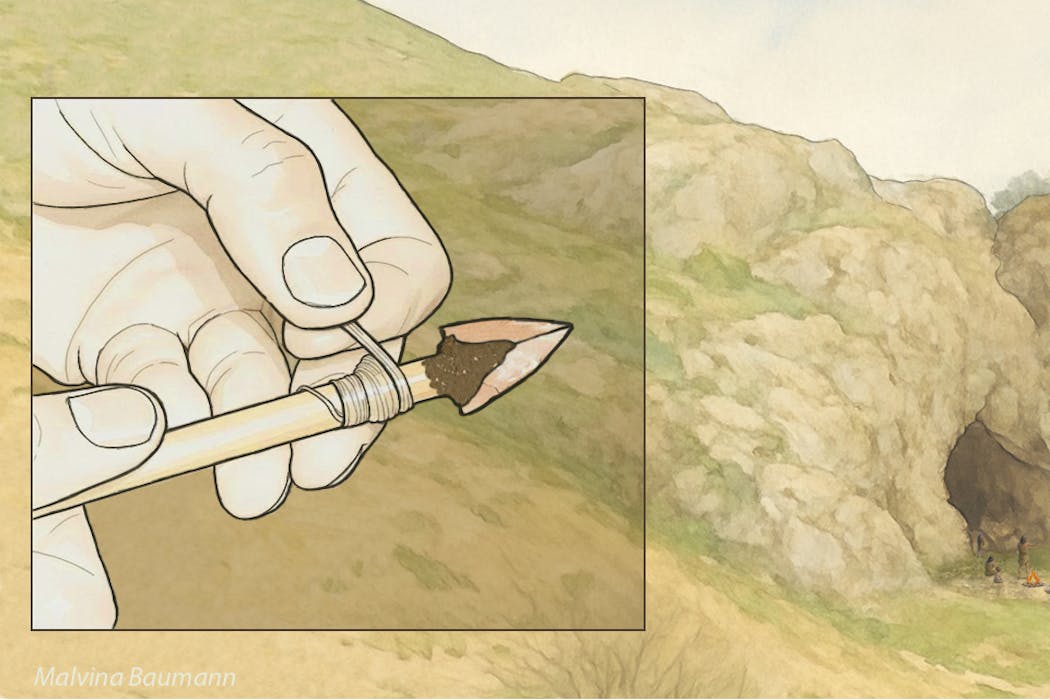

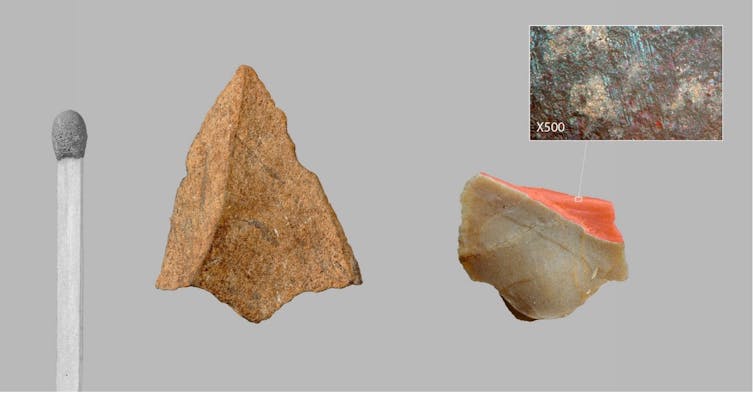

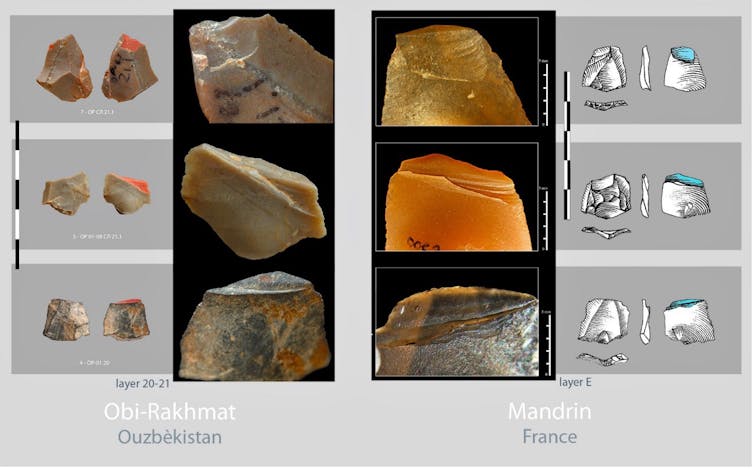

De minuscules pointes de projectile triangulaires ont été identifiées à partir de leurs fractures d’impact dans les plus anciennes couches d’occupation du site d’Obi-Rakhmat en Ouzbékistan, vieilles de 80 000 ans. Elles ont la dimension de pointes de flèches et sont identiques à celles découvertes dans une couche beaucoup plus récente d’un site de la vallée du Rhône, en France, à la toute fin du Paléolithique moyen, correspondant à une incursion d’Homo Sapiens en territoire néanderthalien il y a 54 000 ans. Cette nouvelle étude, publiée dans la revue « PLOS One », apporte un argument décisif pour la réécriture du scénario de l’arrivée d’Homo Sapiens en Europe.

Développés en Europe occidentale et plus particulièrement en France à partir de la seconde moitié du XIXe siècle, les cadres chrono-culturels et anthropologiques de la Préhistoire et les modèles évolutifs qu’ils inspirèrent furent d’abord linéaires et européocentrés : Cro-Magnon descendant de Néanderthal posait les fondements d’une supériorité civilisationnelle dont se prévalait alors cette partie du monde. Ce n’est qu’un siècle plus tard que sera mise en évidence l’origine africaine d’Homo Sapiens et des traits technologiques et sociaux structurants du Paléolithique supérieur occidental, de ~ 45 000 à 12 000 ans avant le présent (productions symboliques, réseaux à grande distance, outillages et armements lithiques et osseux diversifiés).

Les plus anciennes évidences de présence d’Homo Sapiens en Australie vers 65 000 ans précèdent de 10 millénaires celles de l’Europe dont les modalités du peuplement demeurent sujet de discussion. À ce jour, le calage chronologique des toutes premières occupations européennes du Paléolithique supérieur par rapport à celles de l’est du bassin méditerranéen, pourtant regardées comme les plus proches, demeure insatisfaisant. Soit les données sont issues de fouilles trop anciennes pour avoir été suffisamment précises, soit elles ne s’inscrivent pas dans la filiation directe supposée entre le Levant et l’Europe. Les racines mêmes du Paléolithique supérieur initial levantin, malgré la proximité africaine, sont incertaines. Une origine centre asiatique, a été suggérée par l’archéologue Ludovic Slimak en 2023.

Un site en Asie centrale

Corridor entre l’ouest et l’est du continent ou zone refuge, selon les phases climatiques, l’Asie centrale n’est encore documentée que par quelques sites paléolithiques, mais qui sont autant de références de l’histoire de la Préhistoire.

Parmi ceux-ci figure l’abri sous roche d’Obi-Rakhmat en Ouzbékistan découvert en 1962. Ce gisement livre sur 10 mètres de stratigraphie, entre 80 000 et 40 000 ans, une industrie lithique qui par certains traits s’inscrit clairement dans la continuité du Paléolithique moyen ancien du Levant mais par d’autres fut rapprochée du Paléolithique supérieur initial. Ce Paléolithique moyen ancien du Levant, associé dans le site de Misliya à de l’Homo Sapiens archaïque, disparut du Proche-Orient vers 100 000 ans. À Obi-Rakhmat, les restes crâniens d’un enfant trouvés dans une couche à ~ 70 000 ans, présentent des caractères regardés comme néanderthaliens et d’autres comme anatomiquement modernes, combinaison pouvant résulter d’une hybridation.

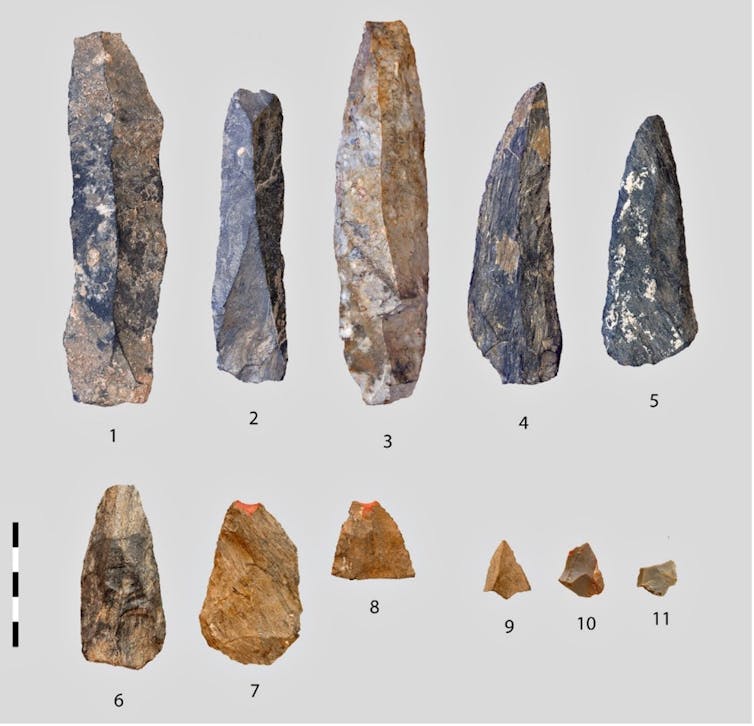

Lames massives mais pointes microlithiques

C’est dans ce contexte que notre équipe internationale, dirigée par Andrei I. Krivoshapkin, a identifié dans les couches les plus anciennes de minuscules pointes de projectiles triangulaires. Mesurant moins de 2 cm de large et ne pesant que quelques grammes, elles sont impropres par leurs dimensions et leur fragilité à avoir été montées sur des hampes de lances. Leur étroitesse correspond au diamètre (inférieur ou égal à 8 mm) des hampes documentées ethnographiquement sur tous les continents pour les flèches tirées à l’arc droit.

Question de balistique

Les armes perforantes projetées constituent des systèmes complexes dont les éléments ne sont pas interchangeables d’un type d’arme à l’autre, car répondant à des contraintes différentes en intensité et en nature.

L’importante force d’impact des lances tenues ou lancées à la main fait de la robustesse de l’arme un paramètre essentiel, aussi bien en termes d’efficacité que de survie du chasseur, la masse assurant à la fois cette robustesse, la force d’impact et la pénétration. À l’opposé, la pénétration des traits légers tirés à grande distance repose sur leur acuité, car l’énergie cinétique, beaucoup plus faible, procède là essentiellement de leur vitesse, laquelle, à la différence de la masse, décroit très rapidement sur la trajectoire et dans la cible. Cette vitesse ne pouvant être atteinte par la seule extension du bras humain, elle est obligatoirement tributaire de l’emploi d’un instrument de lancer. Les pointes de flèche et celles de lances ou de javelines ne sont donc pas conçues selon les mêmes critères et ne se montent pas sur les même hampes, les dimensions et le degré d’élasticité desquelles sont par ailleurs essentiels en terme balistique. Ainsi, comme en paléontologie où la forme d’une dent révèle le type d’alimentation et suggère le mode de locomotion, les caractéristiques d’une armature fournissent des indices sur le type d’arme dont elle est l’élément vulnérant.

Un armement propre à Sapiens ?

Le minuscule gabarit des pointes d’Obi-Rakhmat ne peut être regardé comme un choix par défaut, car non seulement la matière première lithique de bonne qualité dont on a tiré de grandes lames ne manque pas à proximité du site, mais l’inventaire des traces d’usage relevées à la loupe binoculaire et au microscope met en évidence au sein du même assemblage des pointes retouchées beaucoup plus robustes (15 à 20 fois plus lourdes et 3 à 4 fois plus épaisses) et du gabarit des têtes de lance ou de javeline.

En retournant à la bibliographie et à nos propres travaux sur des outillages du Paléolithique moyen, nous avons constaté que la présence dans un même ensemble d’armatures de divers types, pour partie microlithiques et produites à cette fin, n’était à ce jour connue que dans les sites à Homo Sapiens. Les plus anciennes occurrences documentées sont en Afrique du Sud dans les couches culturelles Pre-Still Bay (plus de 77 000 ans) et postérieures du gisement de Sibudu. Dans l’univers néanderthalien, les pointes lithiques endommagées par un usage en armature de projectile sont rares, elles sont de fort gabarit et ne se distinguent ni par leurs dimensions, leur facture ou leur type de celles employées à d’autres activités que la chasse, telles que la collecte de végétaux ou la boucherie. Cette distinction dans la conception des outillages et des armements prend valeur de marqueur anthropologique.

En raison de leurs dates respectives, de la distance entre l’Afrique du sud et l’Asie centrale (14 000 km) et de la différence de facture des armatures d’Obi-Rakhmat et de Sibudu (lithique brut de débitage vs lithique façonné ou retouché, osseux façonné), l’hypothèse de foyers d’invention indépendants est la plus vraisemblable.

Des piémonts du Tien Shan à la vallée du Rhône 25 000 plus tard

La seule forme d’armature miniature de projectile identique actuellement connue est beaucoup plus récente. Elle fut découverte par Laure Metz, sur le site de Mandrin, en vallée du Rhône en France, qui livra aussi une dent de lait d’Homo Sapiens déterminée par Clément Zanolli. L’ensemble est daté d’environ 54 000 ans, soit une dizaine de milliers d’années avant la disparition des Néanderthaliens locaux. La similitude des micro-pointes d’Obi-Rakhmat et de Mandrin, pourtant séparées par plus de 6 000 km et 25 millénaires, est telle que les unes et les autres pourraient être interchangées sans qu’aucun autre détail que la roche ne trahisse la substitution.

Des travaux récents publiés par Leonardo Vallini et Stéphane Mazières définissent le Plateau perse, à la périphérie nord-est duquel est situé Obi-Rakhmat, comme un concentrateur de population où les ancêtres de tous les non-Africains actuels vécurent entre les premières phases de l’expansion hors d’Afrique – donc bien avant le Paléolithique supérieur – et la colonisation plus large de l’Eurasie. Cet environnement riche en ressources pourrait avoir constitué une zone de refuge propice à une régénération démographique après le goulet d’étranglement génétique de la sortie d’Afrique, à l’interaction entre les groupes et par conséquent aux innovations techniques.

Mandrin et Obi-Rakhmat représentent probablement deux extrémités géographiques et temporelles d’une phase pionnière de peuplement telle qu’entrevue par Ludovic Slimak, marquée par ce que les typologues qualifiaient jadis de fossile directeur et qui ici recouvrirait la propagation d’une invention fondamentale propre à Homo Sapiens. Jusqu’à présent passées inaperçues parce que brutes de débitage, minuscules et fragmentaires, il est à parier que les micro-pointes de projectile dont les critères de reconnaissance sont maintenant posés commenceront à apparaître dans des sites intermédiaires entre l’Asie centrale et la Méditerranée occidentale.

Prémisses d’un nouveau scénario du peuplement occidental d’Homo Sapiens

Cette découverte est stimulante à plusieurs titres. Elle valide la cohérence de l’étude du site de Mandrin qui concluait à une brève incursion en territoire néanderthalien de Sapiens armés d’arcs, mais dont plusieurs éléments avaient été critiqués – ce qui est cependant le jeu scientifique habituel lorsqu’une proposition nouvelle s’écarte par trop des connaissances admises – et dont la dimension prédictive n’avait alors pas été considérée.

La similitude des micro-pointes de Mandrin et d’Obi-Rakhmat ne peut être une simple coïncidence. Elle ne porte pas seulement sur leur forme, mais aussi sur leur mode de fabrication, qui requière un réel savoir-faire comme en témoigne la préparation minutieuse de leur plan de frappe avant débitage, et sur leur fonctionnement. On pourra débattre de l’instrument approprié au tir de flèche armées de si minuscules armatures, l’arc étant en filigrane, ou si l’on préfère garder une certaine réserve ne parler que de tir instrumenté, mais cela contraste déjà avec ce que l’on connait des armes de chasse de Néanderthal et de leur conception.

L’autre aspect remarquable, encore peu habituel, est la convergence et la complémentarité de données provenant de la culture matérielle et de la mémoire de nos gènes, qui ne purent s’influencer au regard des dates d’étude et de publication respectives. Les deux conjuguées esquissent la réécriture du scénario de l’arrivée d’Homo Sapiens en Europe : on le pensait venu directement d’Afrique par le chemin le plus court, il y a 45 000 ans, et on le découvre implanté depuis fort longtemps au cœur du continent eurasiatique, bien avant qu’il n’en sorte en quête de nouveaux territoires.

Plisson Hugues a reçu des financements du CNRS et de l'université de Bordeaux

Andrey I. Krivoshapkin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview