06.01.2026 à 16:56

Quelle est la différence entre matière noire et antimatière ?

Dipangkar Dutta, Professor of Nuclear Physics, Mississippi State University

Texte intégral (2160 mots)

« Qu’est-ce que la matière noire et qu’est-ce que l’antimatière ? Sont-elles la même chose ou différentes ? » Cet article est issu de notre série pour les plus jeunes lecteurs, Curious Kids, et répond à la question de Namrata, 13 ans, Ghaziabad, Inde.

Imaginez un jeu vidéo d’aventure avec votre héros préféré comme personnage principal. Un autre personnage, son jumeau miroir, apparaît de temps en temps et fait exploser tout ce qu’il touche. Pour corser encore le tout, le jeu inclut une ruche mystérieuse peuplée de minions cachés à chaque coin, qui changent les règles du jeu sans jamais se montrer.

Si l’on considère ces personnages comme des types de matière, ce jeu vidéo représente en gros le fonctionnement de notre Univers.

Le héros est la matière ordinaire, c’est-à-dire tout ce que nous pouvons voir autour de nous. L’antimatière est le jumeau miroir explosif que les scientifiques arrivent à comprendre, mais plus difficilement à trouver. Et la matière noire représente les minions invisibles : elle est partout, mais nous ne pouvons pas la voir, et les scientifiques ignorent de quoi elle est faite.

Antimatière : le jumeau miroir

Toute la matière ordinaire autour de vous est constituée de blocs de base appelés atomes. Les atomes possèdent des particules chargées positivement appelées protons entourées de minuscules électrons chargés négativement.

On peut considérer l’antimatière comme le jumeau de la matière ordinaire, mais avec des charges opposées.

Toutes les particules, comme les protons et les électrons, ont des « frères et sœurs » d’antimatière. Les électrons ont des positrons, qui sont des anti-électrons, tandis que les protons ont des antiprotons. Les antiprotons et les positrons forment des atomes d’antimatière, ou anti-atomes. Ils ressemblent à des images miroirs, mais avec leurs charges électriques inversées. Quand la matière et l’antimatière se rencontrent, elles se détruisent mutuellement dans un éclair de lumière et d’énergie avant de disparaître.

Heureusement, l’antimatière est très rare dans notre Univers. Mais certains atomes de matière ordinaire, comme le potassium, peuvent se désintégrer et produire de l’antimatière. Par exemple, lorsque vous mangez une banane ou tout aliment riche en potassium, vous consommez de très petites quantités de ces atomes producteurs d’antimatière. Mais la quantité est trop faible pour avoir un effet sur votre santé.

L’antimatière a été découverte il y a presque cent ans. Aujourd’hui, les scientifiques peuvent créer, stocker et étudier l’antimatière en laboratoire. Ils en comprennent très bien les propriétés. Les médecins l’utilisent même pour les PET-Scan. Ils injectent de toutes petites quantités d’atomes producteurs d’antimatière dans le corps et, au fur et à mesure que ces atomes circulent, le scanner prend des images des éclairs de lumière produits par l’annihilation de l’antimatière et de la matière dans le corps. Ce processus permet aux médecins de voir ce qui se passe à l’intérieur du corps.

Les scientifiques ont également découvert qu’à la naissance de l’Univers, il y avait des quantités presque égales de matière et d’antimatière. Elles se sont rencontrées et annihilées. Heureusement, une très petite quantité de matière ordinaire a survécu pour former les étoiles, les planètes et nous tous.

Matière noire : les minions invisibles

La matière noire est beaucoup plus mystérieuse. Avez-vous déjà tourné très vite sur un tourniquet ? Si oui, vous savez combien il est difficile de rester dessus sans tomber, surtout si vous êtes seul sur le tourniquet.

Maintenant, imaginez qu’il y ait plein de minions invisibles sur ce tourniquet avec vous. Vous ne pouvez ni les voir ni les toucher, mais ils vous retiennent et vous empêchent de vous envoler quand il tourne à toute vitesse. Vous savez qu’ils sont là parce que le tourniquet est plus lourd et difficile à faire tourner qu’il n’y paraît. Les minions ne jouent pas et ne parlent à personne ; ils restent simplement là, ajoutant leur poids à l’ensemble.

Il y a environ cinquante ans, l’astronome Vera Rubin a découvert un mystère similaire dans les galaxies spirales. Elle a observé des galaxies en rotation, qui sont comme des tourniquets cosmiques, et a remarqué quelque chose d’étrange : les étoiles situées à l’extérieur de ces galaxies tournaient beaucoup plus vite qu’elles ne devraient. Elles auraient dû être projetées dans l’espace comme des étincelles d’un feu d’artifice. Mais ce n’était pas le cas.

C’était comme regarder des enfants tourner à une vitesse incroyable sur un tourniquet mais rester parfaitement en place.

La seule explication ? Il doit exister un océan de « choses » invisibles qui maintiennent tout en place grâce à leur gravité supplémentaire. Les scientifiques ont appelé cette matière mystérieuse « matière noire ».

Depuis, les astronomes ont observé des comportements étranges similaires dans tout l’Univers. Les galaxies au sein de grands amas se déplacent de manière inattendue. La lumière est plus courbée autour des galaxies qu’elle ne devrait l’être. Les galaxies restent bien plus solidaires que ce que la matière visible seule pourrait expliquer.

C’est comme si notre terrain de jeu cosmique avait des balançoires qui bougent toutes seules et des tape-culs qui basculent alors que personne n’est assis dessus.

La matière noire n’est pour l’instant qu’un nom provisoire, en attendant que les scientifiques découvrent ce que c’est réellement. Depuis cinquante ans, de nombreux chercheurs mènent des expériences pour détecter la matière noire ou la produire en laboratoire. Mais jusqu’à présent, ils sont restés bredouilles.

Nous ne savons pas ce qu’est la matière noire, mais elle est partout. Il pourrait s’agir de particules que les scientifiques n’ont pas encore découvertes ou de quelque chose de complètement inattendu. Mais les astronomes peuvent constater, en observant la vitesse de rotation des galaxies, qu’il y a environ cinq fois plus de matière noire que toute la matière ordinaire de l’Univers.

Dipangkar Dutta bénéficie d'un financement du ministère américain de l'Énergie et de la National Science Foundation.

05.01.2026 à 15:44

Une nouvelle étude met en lumière le rôle du climat dans la disparition de l’homme de Florès

Nick Scroxton, Research Fellow, Palaeoclimate, National University of Ireland Maynooth

Gerrit (Gert) van den Bergh, Researcher in Palaeontology, University of Wollongong

Michael Gagan, Honorary Professor, Palaeoclimate, University of Wollongong; The University of Queensland

Mika Rizki Puspaningrum, Researcher in Palaeontology, Bandung Institute of Technology, Institut Teknologi Bandung

Texte intégral (1980 mots)

L’analyse de stalagmites et de fossiles d’éléphants pygmées révèle comment le climat et la présence d’eau douce ont façonné la vie et la survie de l’homme de Florès.

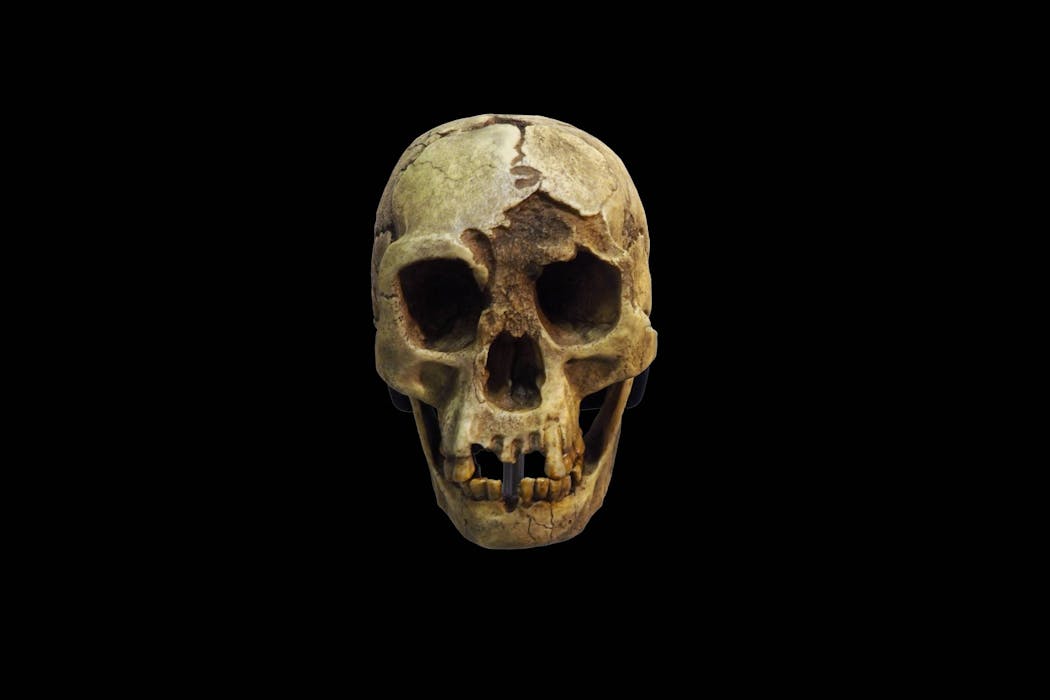

Il y a environ 50 000 ans, l’humanité a perdu l’un de ses derniers cousins hominines survivants, Homo floresiensis (ou homme de Florès, également connu sous le nom de « Hobbit » en raison de sa petite taille). La cause de sa disparition, après plus d’un million d’années passées sur l’île volcanique isolée de Florès, en Indonésie, demeure une énigme de longue date.

De nouvelles preuves suggèrent toutefois qu’une période de sécheresse extrême, commencée il y a environ 61 000 ans, pourrait avoir contribué à la disparition des hommes de Florès. Notre nouvelle étude, publiée le 8 décembre dans Communications Earth & Environment, révèle une histoire d’essor et d’effondrement écologique. Nous avons établi le relevé climatique le plus détaillé à ce jour du site où vivaient autrefois ces anciens hominines.

Une île aux grottes profondes

La découverte d’Homo floresiensis en 2003 a bouleversé notre conception de ce qui fait de nous des êtres humains. Ces hominines de petite taille et au cerveau réduit, qui ne mesuraient que 1,1 m, fabriquaient des outils en pierre. Contre toute attente, ils ont atteint l’île de Florès, apparemment sans disposer de technologie maritime.

Les ossements et outils en pierre d’H. floresiensis ont été retrouvés dans la grotte de Liang Bua, dissimulée dans une petite vallée des hauteurs de l’île. Ces vestiges datent d’une période comprise entre 190 000 et 50 000 ans.

Aujourd’hui, Florès connaît un climat de mousson, avec de fortes pluies pendant les étés humides (principalement de novembre à mars) et des précipitations plus légères durant les hivers plus secs (de mai à septembre). Cependant, durant la dernière période glaciaire, la quantité de pluie et le moment où elle tombait variaient considérablement.

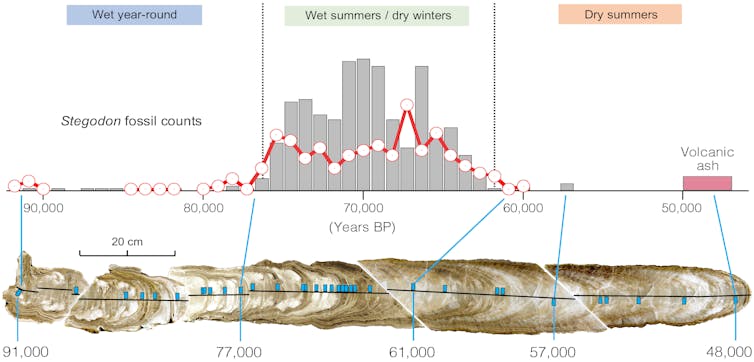

Pour comprendre à quoi ressemblaient ces pluies, notre équipe s’est tournée vers une grotte située à 700 mètres en amont de Liang Bua, appelée Liang Luar. Par pur hasard, au fond de cette grotte se trouvait une stalagmite qui s’est formée précisément pendant la période correspondant à la disparition d’H. floresiensis. En grandissant couche après couche grâce à l’eau qui goutte du plafond, sa composition chimique variable enregistre l’histoire d’un climat en mutation.

Les paléoclimatologues disposent de deux principaux outils géochimiques pour reconstituer à partir des stalagmites les précipitations passées. En observant une mesure spécifique de l’oxygène, appelée δ18O, ils peuvent identifier les variations d’intensité de la mousson. Parallèlement, le rapport entre le magnésium et le calcium permet d’estimer la quantité totale de précipitations.

Nous avons combiné ces deux types de mesures sur les mêmes échantillons, les avons précisément datés, puis avons reconstitué les niveaux de précipitations estivales, hivernales et annuelles. L’ensemble offre un aperçu inédit de la variabilité saisonnière du climat.

Nous avons identifié trois grandes phases climatiques. Entre 91 000 et 76 000 ans, le climat était plus humide qu’aujourd’hui tout au long de l’année. De 76 000 à 61 000 ans, la mousson est devenue très nettement saisonnière, avec des étés plus pluvieux et des hivers plus secs. Enfin, entre 61 000 et 47 000 ans, le climat s’est considérablement asséché durant l’été, à l’image de celui que connaît aujourd’hui le sud du Queensland en Australie.

Les « Hobbits » suivaient leurs proies

Nous disposions donc d’un relevé précis des grands changements climatiques, mais restait à savoir quelle en avait été la réponse écologique, s’il y en avait eu une. Il nous fallait établir une chronologie précise des fossiles d’H. floresiensis retrouvés à Liang Bua.

La solution est venue de manière inattendue grâce à notre analyse du δ18O contenu dans l’émail des dents fossilisées de Stegodon florensis insularis, un lointain parent pygmée disparu des éléphants modernes. Ces jeunes éléphants pygmées figuraient parmi les proies préférées des « Hobbits », comme le montrent les traces de découpe sur les os retrouvés à Liang Bua.

Fait remarquable, les variations du δ18O observées dans la stalagmite de Liang Luar correspondaient parfaitement à celles relevées dans les dents provenant de couches sédimentaires de plus en plus profondes à Liang Bua. Cette concordance nous a permis de dater avec précision les fossiles de Stegodon ainsi que les restes associés d’Homo floresiensis.

La chronologie ainsi affinée montre qu’environ 90 % des restes d’éléphants pygmées datent de la période comprise entre 76 000 et 61 000 ans, soit une période au climat fortement saisonnier, ni trop humide ni trop sec – une sorte de climat idéal. Ce contexte semble avoir offert des conditions favorables au pâturage des éléphants pygmées et à leur chasse par Homo floresiensis. Mais les deux espèces ont presque disparu lorsque le climat est devenu plus sec.

Le recul des précipitations, des éléphants pygmées et des « Hobbits » au même moment indique que la raréfaction des ressources a joué un rôle crucial dans ce qui ressemble à un abandon progressif de Liang Bua.

Avec l’assèchement du climat, la principale source d’eau en saison sèche, le petit fleuve Wae Racang, a peut-être diminué au point de ne plus suffire, privant les Stegodon d’eau douce. Les animaux ont alors pu migrer hors de la région, Homo floresiensis les suivant.

Un volcan impliqué ?

Les derniers restes fossiles de Stegodon et les outils en pierre de Liang Bua sont recouverts d’une épaisse couche de cendres volcaniques, datée d’environ 50 000 ans. On ne sait pas encore si une éruption volcanique à proximité a constitué « la goutte d’eau » dans le déclin des hommes de Florès de Liang Bua.

Les premières traces archéologiques attribuées à Homo sapiens se trouvent au-dessus de cette couche de cendres. Même s’il est impossible de savoir si Homo sapiens et Homo floresiensis se sont croisés, de nouvelles preuves archéologiques et génétiques indiquent que les Homo sapiens parcouraient déjà l’Indonésie, sautant d’île en île jusqu’au supercontinent de Sahul, il y a au moins 60 000 ans.

Si Homo floresiensis a été contraint par des pressions écologiques de quitter leur refuge pour se rapprocher de la côte, il est possible qu’ils aient croisé la route des humains modernes. Et si tel était le cas, la concurrence, les maladies, voire la prédation, auraient pu devenir des facteurs déterminants.

Quelle que soit la cause ultime, notre étude fournit un cadre pour de futures recherches sur l’extinction de l’emblématique Homo floresiensis dans le contexte de grands changements climatiques. Le rôle fondamental de la disponibilité en eau douce dans le déclin de l’un de nos cousins humains rappelle que l’histoire de l’humanité est une expérience fragile de survie, et que les variations des précipitations peuvent avoir des conséquences profondes.

Nick Scroxton a reçu des financements de de la Sustainable Energy Authority of Ireland et a réalisé ce travail tout en bénéficiant d’un financement de l’Australian Research Council.

Gerrit van den Bergh a reçu des financements de l’Australian Research Council.

Michael Gagan a reçu des financements de l’Australian Research Council.

Mika Rizki Puspaningrum ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

04.01.2026 à 14:03

Ce que révèle une vaste enquête citoyenne sur la qualité de l’eau en France

Nicolas Dietrich, Professeur des universités en génie des procédés, INSA Toulouse

Johanne Teychené, Maitre de conférences en génie des procédés, INSA Toulouse

Nathalie Clergerie, Ingénieure d'études INSA toulouse

Texte intégral (2453 mots)

En 2023, des milliers de citoyens ont pris part à un projet de recherche participative visant à cartographier la qualité de l’eau sur le territoire français. Une démarche qui en apprend beaucoup aux chercheurs et qui sensibilise les bénévoles.

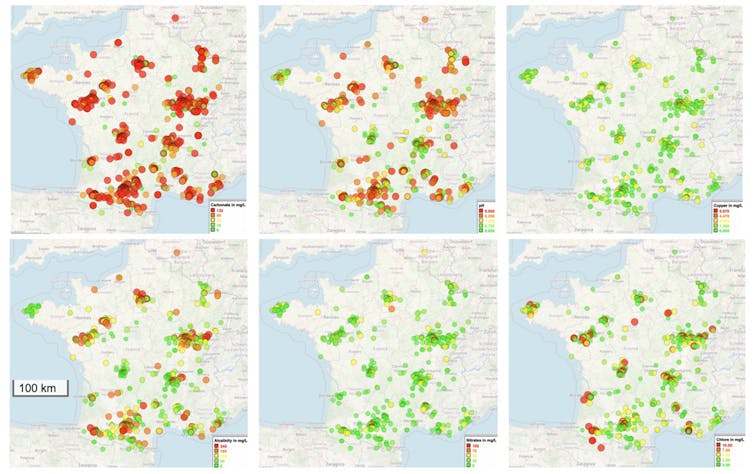

Le 29 septembre 2023, partout en France, des milliers de personnes ont endossé, le temps d’un week-end, la casquette du chercheur. Armés de leur smartphone, d’une bandelette colorée et d’une fiche d’instructions, ils se sont lancés dans une expérience collective inédite : mesurer la qualité des eaux de France dans les rivières, les fontaines, les lacs, les puits et les flaques. En quelques jours, près de 800 échantillons ont été collectés et plus de 20 000 données ont été mesurées.

Derrière ces chiffres impressionnants se cache une aventure humaine et scientifique : la Grande Synchr’Eau, une initiative massive de science participative récompensée par l’une des médailles de la médiation du CNRS en 2025 pour son originalité et son impact sur la société. Cette expérience participative inédite a permis de révéler la diversité chimique des eaux françaises.

Le principe est simple : tremper une bandelette dans l’eau, observer les pastilles se colorer, puis les comparer à une échelle. Ce geste, à la fois simple et ludique, cache en réalité des mesures précieuses : le pH (ou l’acidité), la concentration en nitrates issus des engrais, en chlore, ainsi qu’en métaux lourds tels que le cuivre ou le plomb. Pour beaucoup, l’expérience provoque un effet « waouh » : « On avait l’impression de jouer, mais en fait, on faisait de la vraie science », racontait une mère venue vivre l’expérience avec sa fille. C’est là toute la force de la science citoyenne : permettre à chacun de participer à la recherche, tout en produisant des données utiles aux scientifiques.

Une mosaïque de réalités locales

Les résultats, compilés par les équipes de l’INSA Toulouse et du Toulouse Biotechnology Institute, révèlent une France de l’eau pleine de contrastes. En Bretagne et dans le Massif central, l’eau est plus acide, en raison des sols granitiques et volcaniques, car ces roches contiennent peu de minéraux capables de « tamponner » l’acidité. L’eau de pluie, naturellement légèrement acide, n’est donc pas neutralisée en traversant ces terrains, contrairement aux régions calcaires où les roches relarguent du carbonate qui remonte le pH. Dans les plaines agricoles de la Beauce et de la Champagne, les nitrates dépassent parfois 100 mg/L, témoins directs de l’usage intensif des engrais.

En ville, d’autres signaux apparaissent : à Lyon, Toulouse ou Marseille, les citoyens ont détecté du cuivre jusqu’à 6 mg/L, un niveau trois fois supérieur à la limite de qualité de l’eau potable (2 mg/L), généralement lié à la corrosion des vieilles canalisations en cuivre. Dans certaines zones rurales, le chlore est quasi absent, alors qu’en Île-de-France ou dans le Rhône, la concentration atteint des niveaux dix fois supérieurs à ceux observés dans les campagnes du Massif central. Cela reste compatible avec les normes, mais reflète une désinfection beaucoup plus marquée des grands réseaux urbains, expliquant parfois les goûts d’eau chlorée rapportés par certains usagers.

Autrement dit, il n’existe pas une eau française, mais une mosaïque d’eaux locales, chacune portant la marque de son sol, de ses usages et de ses infrastructures.

Des flaques chlorées et des puits ferrugineux

Parmi les échantillons, certaines eaux sortent franchement du lot. Si, globalement, le pH reste dans des valeurs normales (entre 6 et 7,6), la diversité chimique surprend. Le chlore total, c’est-à-dire à la fois le chlore libre (désinfectant actif) et le chlore combiné (qui a déjà réagi avec d’autres substances), atteint parfois 10 mg/L, soit cinq fois la concentration d’une piscine publique.

Certaines flaques urbaines semblent avoir reçu un traitement sanitaire involontaire : ruissellement des trottoirs, résidus de produits ménagers, lessivage des surfaces. Bref, si l’eau des flaques n’est pas potable, certaines sont surprenamment bien désinfectées !

Certains puits battent tous les records de fer, avec des concentrations pouvant atteindre 25 mg/L, soit 500 fois la limite de potabilité. À ce stade, l’eau prend une teinte orangée et un goût métallique prononcé. Sur le millier de prélèvements effectués, 8,4 % des eaux ont été jugées brunes par les citoyens, un signe d’oxydation intense du fer dans les captages locaux. Ce phénomène, fréquent dans certaines zones rurales, n’est pas dangereux en soi, mais rend l’eau impropre à la consommation et peut entraîner des dépôts, des taches et un encrassement des installations domestiques. Il illustre la forte variabilité chimique des eaux locales et les enjeux propres aux puits non traités.

Autre découverte : l’ammonium, présent jusqu’à 40 mg/L dans certains échantillons. Ce composé, issu de la décomposition de la matière organique ou du ruissellement agricole, témoigne d’une activité biologique intense : en clair, une eau très vivante, mais pas forcément celle qu’on a envie de boire.

L’eau, miroir de nos modes de vie

Derrière les anecdotes et les chiffres, ces mesures citoyennes racontent une vérité simple : l’eau enregistre nos modes de vie. Elle circule, transporte et mémorise nos activités. Dans les villes, elle se charge de chlore, de cuivre et de résidus ménagers. Dans les campagnes, elle emporte du nitrate, de l’ammonium ou du fer. Et dans les zones naturelles, elle reste souvent plus équilibrée, mais jamais totalement vierge de l’empreinte humaine.

En plus des cartes, la Grande Synchr’Eau dessine une France curieuse et engagée. L’enquête menée auprès de 120 participants révèle une mobilisation intergénérationnelle : 22 % ont moins de 18 ans, 21 % sont entre 46 et 55 ans, et 45 classes de primaire et de collège ont participé à l’expérience. Les motivations sont variées : 54 % y voient une façon de protéger l’environnement, 43 % de contribuer à la recherche, 28 % pour apprendre et 25 % par curiosité. Autrement dit, mesurer devient un moyen de comprendre et d’agir.

Nourrir la recherche tout en sensibilisant les citoyens

Les effets de la démarche sur les volontaires sont marquants : 81 % des participants estiment que l’expérience a changé leur regard ou leurs comportements, et 82 % ont eu le sentiment de participer à la protection de l’environnement. Lorsqu’on leur demande les mots auxquels ils pensent pour qualifier l’eau, ceux qui reviennent le plus sont vie, vitale et précieuse, ce qui traduit un rapport sensible, presque affectif, à cette ressource commune.

Enfin, à la question « Qui doit agir pour préserver l’eau ? », 83 % citent l’État, 79 % les scientifiques, 71 % les associations et 54 %… eux-mêmes. La science n’est plus perçue comme un domaine réservé : elle devient un espace partagé, où la connaissance se construit à plusieurs et où chacun assume sa responsabilité sociétale.

Au final, peut-on boire l’eau des flaques d’eau ? Non, car elles contiennent parfois plus de chlore qu’une piscine. Mais on peut toujours les observer, les mesurer et les comparer. Ces expériences rappellent qu’il n’y a pas besoin d’un laboratoire pour faire de la science : un peu de curiosité, une bandelette colorée et l’envie de comprendre suffisent à faire émerger une connaissance collective. La Grande Synchr’Eau en est la preuve : la science peut jaillir de partout, même d’une simple flaque.

Nicolas Dietrich a reçu des financements dans le cadre du projet Grande Expérience Participative (2023), financé par l’initiative Nuit Européenne des Chercheur·e·s dans le cadre des Actions Marie Sklodowska-Curie. Un financement complémentaire a été obtenu dans le cadre du projet SMARTER, soutenu par le programme Horizon 2020 de l’Union européenne (Grant Agreement No. 772787)

Johanne Teychené et Nathalie Clergerie ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Time [Fr]

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- L'Autre Quotidien

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- AlterQuebec

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview