13.02.2026 à 12:41

Aux États-Unis, les vents du « backlash » climatique redoublent d’intensité

Texte intégral (2055 mots)

Le président Trump a annoncé l’abrogation de l’Endangerment Finding, un texte de l’Agence environnementale américaine (EPA) à la base de toutes les régulations fédérales concernant les émissions de gaz à effet de serre (GES) du pays. Après le retrait de l’accord de Paris et des institutions internationales traitant du climat, c’est un renforcement du backlash climatique qui souffle sur les États-Unis.

L’abrogation de l’Endangerment Finding (qu’on peut traduire par « constat de mise en danger »), annoncée depuis la Maison-Blanche, le 12 février 2026, marque un retour en arrière de près de vingt ans.

Ce texte de l’EPA réunit en effet les éléments scientifiques permettant l’application d’une décision de la Cour suprême des États-Unis datant de 2007, qui appelait l’Agence environnementale américaine (EPA) à inclure les six principaux gaz à effet de serre parmi les rejets atmosphériques qu’elle a mission de réguler.

Nouvelle illustration du backlash climatique de l’Amérique trumpienne, cette abrogation promet de multiples contentieux juridiques qui remonteront sans doute jusqu’à la Cour suprême, dont la décision de 2007 n’a pas été abrogée.

À lire aussi : La réélection de Donald Trump : quelles implications pour les politiques climatiques ?

Aux origines du « backlash »

Titre d’un livre de Susan Faludi paru en 1991, l’expression « backlash » a connu son heure de gloire aux États-Unis dans les années 1990. Elle désignait alors toute régression en matière de droits civiques, en particulier ceux des femmes et des minorités.

Le backlash est revenu en force en 2025, avec le démarrage du second mandat de Donald Trump. La guerre contre les droits civiques a repris avec une grande violence pour les migrants. Elle a été étendue à tout ce qui touche le changement climatique, autrement dit aux droits environnementaux, ainsi qu’à la science.

La guerre anti-climat a été déclarée le premier jour de la présidence. Le 20 janvier 2025, parmi les innombrables décrets signés par Donald Trump, figurait celui annonçant le retrait des États-Unis de l’accord de Paris sur le climat et un autre visant la relance des énergies fossiles.

En termes de politique extérieure, la dénonciation de l’accord de Paris a été complétée en janvier 2026 par le retrait des États-Unis de la convention-cadre des Nations unies sur le réchauffement climatique et du Groupe d’experts intergouvernemental sur l’évolution du climat (Giec). En se retirant de la convention-cadre, l’Amérique trumpienne s’est affranchie de toute obligation en matière climatique.

À lire aussi : La transition énergétique américaine à l’épreuve de Trump 2.0

Les sciences du climat en ligne de mire

Le retrait du Giec illustre un autre volet du backlash : la guerre déclarée contre les sciences du climat et toutes les institutions qui les hébergent.

Si les universités et les centres indépendants comme le World Resources Institute (WRI) ou le Berkeley Earth ont pu résister, trois grandes administrations fédérales ont été directement affectées : l’administration en charge de l’atmosphère et de l’océan (NOAA), les centres de recherche sur le climat de la NASA et l’agence environnementale (EPA), en charge de l’établissement de l’inventaire des émissions de gaz à effet de serre. Ces trois institutions produisent nombre de données et de modélisations utilisées par les scientifiques du monde entier.

Sur le plan de la politique intérieure, l’abrogation de l’Endangerment Finding ouvre la voie à la suppression de l’ensemble des régulations environnementales touchant le climat, notamment dans les transports et l’énergie. Elle a été préparée par la publication du rapport de juillet 2025 du Département de l’énergie, qui relativisait les impacts du réchauffement climatique, instillant le doute sur ses origines anthropiques et affirmant, dans son résumé pour décideurs, que « des politiques d’atténuation excessivement agressives pourraient s’avérer plus néfastes que bénéfiques ».

La question des preuves scientifiques était déjà au cœur de la décision d’avril 2007 de la Cour suprême des États-Unis, dite Massachusetts v. EPA, qui enjoignait à l’EPA d’intégrer les gaz à effet de serre (GES) parmi les polluants atmosphériques qu’elle avait en charge de réglementer. Ce faisant, la Cour a retourné, par une faible majorité (5 contre 4), la jurisprudence antérieure qui reposait sur les supposées incertitudes scientifiques quant au lien entre les émissions de GES et le changement climatique.

C’est à nouveau en contestant les diagnostics des sciences du climat que l’Amérique trumpienne tente de s’affranchir de toute responsabilité face au changement climatique. Cela ne va pas manquer de multiplier les contentieux judiciaires, qui risquent fort de remonter jusqu’à la Cour suprême, dont la décision de 2007 enjoignant à l’EPA de réguler les émissions de gaz à effet de serre n’a pas été abrogée.

Des conséquences déjà tangibles pour le climat

L’abrogation de l’Endangerment Finding vise à inscrire dans la durée la stratégie trumpienne. Celle-ci est guidée par le rétroviseur, avec la promesse de retrouver un paradis énergétique reposant sur une abondance d’énergie fossile livrée à bas coût à la population.

C’est au nom de cette chimère que les dispositifs de soutien aux énergies renouvelables et à l’électrification des usages ont été démantelés en moins d’un an. Cela a conduit les constructeurs américains à mettre un grand coup de frein sur la voiture électrique. Dans les énergies renouvelables, la filière éolienne a été particulièrement visée, avec le gel ou l’arrêt de la plupart des grands projets offshore déjà engagés, généralement portés par des entreprises européennes.

Simultanément, le secteur des énergies fossiles a été cajolé par la « grande et belle loi budgétaire » qui prévoit, entre autres, la cession de nouvelles concessions pétrolières dans le golfe du Mexique et sur les terres fédérales, des allègements fiscaux sur les forages, le report de la redevance sur le méthane, la réduction des redevances minières pour le charbon, l’extension de son extraction sur les terres fédérales et enfin des crédits d’impôt pour le « charbon métallique » utilisé dans les hauts-fourneaux.

Ce cocktail de mesures a contribué à la remontée, estimée à 2,4 %, des émissions de gaz à effet de serre du pays en 2025. La tendance à la baisse des émissions observée depuis 2005 risque ainsi d’être interrompue.

Le tête-à-queue américain peut-il faire dérailler les scénarios globaux de sortie des énergies fossiles ? En 2025, les États-Unis ont été à l’origine de 13 % des émissions mondiales de carbone fossile. Tout dépendra de la façon dont va réagir le reste du monde.

À lire aussi : « Drill, baby, drill » : face à l'obsession de Trump pour le pétrole, une mobilisation citoyenne verra-t-elle le jour ?

Face au « backlash » : accélération au Sud, hésitations en Europe

Dans le reste du monde, ce n’est pas le backlash, mais l’accélération de la transition énergétique qui prévaut.

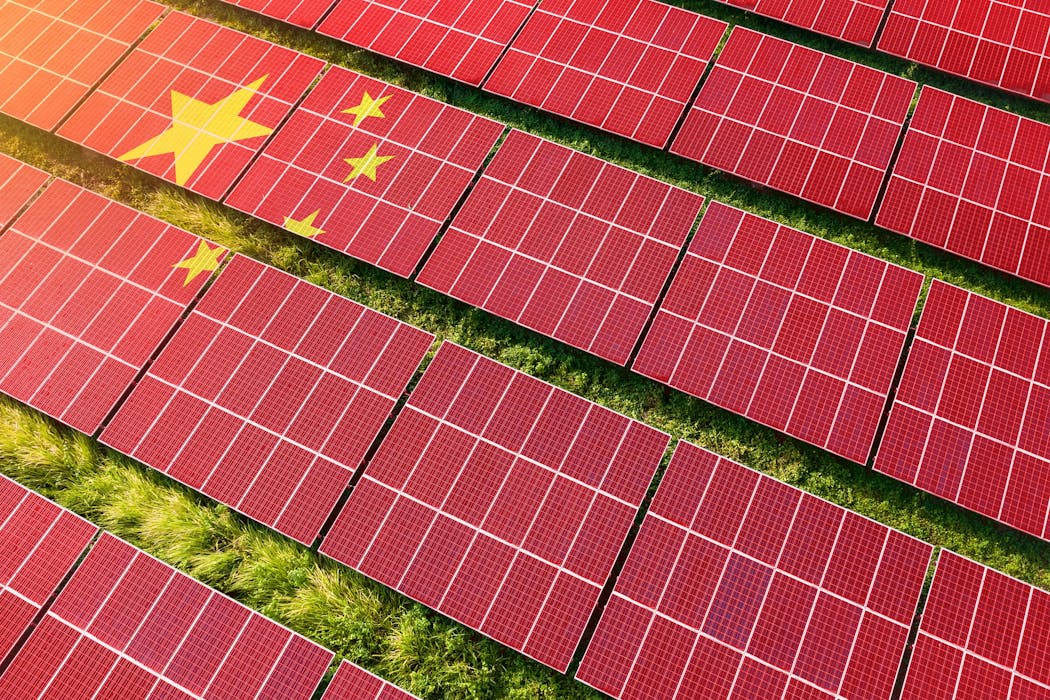

La Chine en est devenue l’acteur pivot. Grâce à un investissement sans pareil dans les énergies bas carbone, elle est en train de franchir son pic d’émission à 8 tonnes de CO2 par habitant, quand les États-Unis ont franchi le leur à 21 tonnes, et l’Europe à 11 tonnes. La question clé est désormais celle du rythme de la décrue après le pic.

Devenue le fournisseur dominant des biens d’équipement de la transition énergétique, la Chine a contré la fermeture du marché américain en redirigeant ses ventes vers le Sud global, qui accélère ses investissements dans l’économie bas carbone. L’agressivité trumpiste a même réussi à rapprocher la Chine de l’Inde.

L’accélération de la transition bas carbone est particulièrement forte en Asie. En 2025, l’Inde a stabilisé les émissions de son secteur électrique, grâce à la montée en régime du solaire. La même année, on a vendu, en proportion, plus de véhicules électriques au Viêt-nam ou en Thaïlande que dans l’Union européenne, et le Pakistan s’est couvert de panneaux photovoltaïques.

À lire aussi : La Chine, leader de la décarbonation des économies du Sud

Dans ce contexte, l’Europe s’enferme dans une position défensive face aux États-Unis, subissant les coups les uns après les autres. Les vents du backlash climatique trouvent même des relais au sein de l’Union européenne, où une partie de la classe politique cherche désormais à freiner, voire stopper, la transition bas carbone.

Cette attitude est contreproductive. Le vieux continent importe la grande majorité de son énergie fossile, et pourrait au contraire reconquérir une partie de sa souveraineté économique en accélérant sa transition énergétique. Cela contribuerait également à relever son taux d’investissement, car l’économie bas carbone est plus capitalistique que celle reposant sur l’énergie fossile.

L’Europe devrait, enfin, mobiliser toutes ses ressources scientifiques pour faire face aux attaques lancées contre les sciences du climat. Aux « faits alternatifs » que cherchent à imposer les « ingénieurs du chaos » – du nom de l’essai éponyme paru en 2019 – sur les réseaux sociaux, il est temps d’opposer avec détermination les faits scientifiques.

Christian de Perthuis ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

13.02.2026 à 09:23

Inondations : l’aménagement du territoire est-il responsable ?

Texte intégral (2284 mots)

Les inondations qui touchent le Sud-Ouest de la France provoquées par la tempête Nils pourraient alimenter à nouveau le débat sur le rôle l’aménagement du territoire dans la survenue de ces événements. Les inondations sont pourtant des phénomènes complexes et le rôle des aménagements reste difficile à estimer.

Depuis plusieurs années, l’Europe est frappée par des inondations majeures aux bilans humains terribles : 243 morts en juillet 2021 en Allemagne, en Belgique, au Luxembourg et aux Pays-Bas, 17 morts en mai 2023 en Italie du Nord, 27 morts en septembre 2024 lors de la tempête Boris en Europe Centrale, de l’Allemagne à la Roumanie, et 237 morts en octobre 2024 dans le sud de Valence. Plus près de nous, les inondations de la Vilaine de ce mois de janvier 2026 et celles de l’année dernière ont ravivé pour les habitants le spectre des inondations du passé.

Ces évènements frappent les esprits et font la une des médias, surtout s’ils se déroulent en Europe. Très vite, des causes liées à l’aménagement du territoire sont invoquées. En Espagne, l’extrême droite a condamné les écologistes qui ont prôné l’arasement des barrages. Vérification faite, il ne s’est agi que de la suppression de « barrières » peu élevées et le lien avec les barrages n’est pas attesté. En Bretagne, à l’inverse, suite à la crue de la Vilaine début 2025 et à l’inondation de plusieurs quartiers de Rennes et de Redon, plusieurs coupables ont été rapidement désignés dans les médias. Le changement climatique d’abord, puis le remembrement des territoires ruraux et le drainage des parcelles agricoles qui ont accompagné la révolution verte des années 1960 et 1970 ont été pointés du doigt.

Les scientifiques de l’eau soulignent le rôle des aménagements passés sur les sécheresses et les tensions autour de la ressource en eau. Pour autant, l’attribution des causes à des événements exceptionnels comme les crues intenses s’avère difficile. Faut-il chercher un seul coupable, ou bien plusieurs ? Changement climatique et modification des usages des sols contribuent à la genèse des inondations, mais leurs implications respectives dans ces évènements varient selon le type d’inondation ainsi qu’au cours du temps.

Il est difficile de déterminer les causes des crues

Isoler la part de responsabilité du changement climatique dans la survenue d’un événement climatique extrême est ce qu’on appelle un processus d’attribution. La science de l’attribution, relativement récente, est nécessaire pour quantifier les impacts du changement climatique dans des processus complexes et variables. Un exemple récent est l’étude menée suite aux pluies torrentielles d’octobre 2024 en Espagne, qui a montré que ce type d’épisode pluvieux présente jusqu’à 15 % de précipitations supplémentaires par rapport à un climat sans réchauffement. En d’autres termes, environ une goutte d’eau sur six tombée lors de cet épisode peut être imputée au changement climatique.

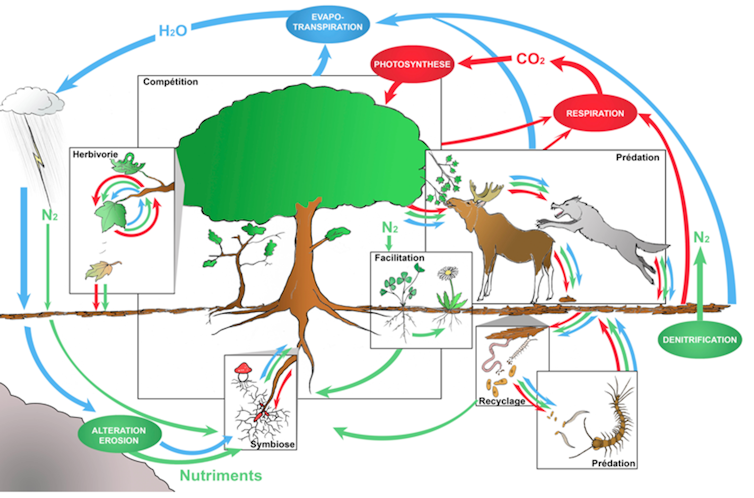

Si l’attribution des pluies est aujourd’hui de mieux en mieux maîtrisée, celle des crues reste moins bien déterminée. On confond souvent l’attribution de la pluie et celle de la crue, alors qu’elles ne sont pas équivalentes. Entre le moment où la pluie tombe et celui où la rivière déborde, il se passe beaucoup de choses au niveau du bassin versant : selon le degré d’humidité et la nature du sol et du sous-sol ou bien la manière dont il a été aménagé, il peut agir comme tampon ou accélérer les flux d’eau. Deux bassins versants différents auront des réponses également différentes pour un même volume de pluie, et un même volume de pluie tombant sur un même bassin versant peut avoir des conséquences très différentes selon le moment de l’année. La survenue d’une crue dépend donc de la combinaison de deux dés : la pluie qui tombe sur le bassin versant et la capacité de ce bassin à l’absorber.

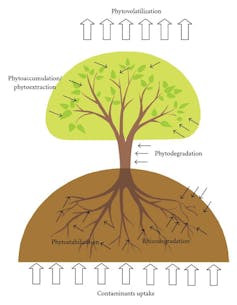

Le changement climatique et les aménagements perturbent l’absorption des sols

Les études d’attribution des pluies montrent avec certitude que le réchauffement climatique — et donc les activités humaines qui en sont la cause — intensifient les pluies fortes et les rendent de plus en plus fréquentes. Si nos futurs étés seront plus secs, les hivers seront eux plus humides, notamment dans le nord de la France. Qu’en est-il du deuxième dé, la capacité d’absorption des bassins versants ? Le changement climatique l’affecte également, en modifiant l’humidité des sols au fil des saisons. Mais cette capacité dépend aussi largement des transformations opérées par certaines activités humaines.

C’est le cas par exemple des barrages, conçus pour stocker l’eau lors des saisons humides et qui ont la capacité de tamponner la puissance des crues. Mais d’autres phénomènes sont impliqués, comme l’urbanisation, qui imperméabilise les sols en remplaçant champs et prairies par du béton et de l’asphalte. Ces surfaces imperméables réduisent fortement l’infiltration et favorisent le ruissellement. Même si l’urbanisation reste marginale à l’échelle des grands bassins versants, elle peut jouer un rôle majeur localement, notamment en zones périurbaines, où les petits cours d’eau sont souvent canalisés ou recouverts.

Les aménagements agricoles comptent également. Le remembrement, qui a fait disparaître des milliers de haies et fossés au profit de grandes parcelles plus facilement exploitables pour des machines agricoles, a profondément modifié la circulation de l’eau. En parallèle, d’autres transformations ont réduit la capacité du paysage à retenir l’eau lors des pluies fortes, comme la pose de drains en profondeur dans les sols agricoles qui vise à évacuer l’excédent d’eau des terres trop humides durant l’hiver. La création de digues et de canaux pour limiter l’expansion des rivières, le creusement des cours d’eau et la rectification de leurs berges les ont recalibrées pour les rendre linéaires. Ces différents aménagements ont des effets importants. Ils modifient le cycle de l’eau continental en accélérant globalement les flux vers la mer. Les niveaux des nappes ont déjà été affectés par ces modifications. Dans les vastes marais du Cotentin, nous avons montré que le niveau moyen des nappes a chuté d’environ un mètre depuis 1950, alors que les aménagements des siècles précédents avaient déjà diminué ces niveaux. Le changement climatique va renforcer cette diminution des niveaux de nappe au moins sur une grande partie du territoire hexagonal.

D’un bassin à l’autre, des effets différents

Ces facteurs jouent différemment selon la surface des bassins versants et leur localisation : l’urbanisation a un effet très fort sur les crues des petits bassins versants côtiers de la Côte d’Azur, qui ont une surface inférieure à 10 km2, mais un effet moindre sur le bassin versant de la Vilaine, qui compte 1 400 km2 à Rennes après la confluence avec l’Ille. À l’inverse, les pratiques agricoles ont un effet plus important sur les crues du bassin de la Vilaine que sur ceux de la Côte d’Azur.

Aujourd’hui, il est difficile de quantifier précisément la part relative de ces facteurs dans l’occurrence des crues observées. En amont des cours d’eau, certaines transformations peuvent ralentir la propagation des crues en augmentant des capacités de stockage locales, par exemple dans les sols, les zones humides ou les plaines inondables, tandis qu’en aval, l’accélération des flux et leur addition tendent à dominer. Chacun des aménagements décrits influence la manière dont un bassin versant absorbe ou accélère l’eau, mais l’addition de leurs effets crée une interaction complexe dont nous ne savons pas précisément faire le bilan.

Lors d’événements exceptionnels comme la crue de Valence, ce sont avant tout les volumes de pluie qui déclenchent la crue et ses conséquences, le changement climatique pouvant intensifier ces précipitations. Les aménagements du territoire influencent de manière secondaire la façon dont l’eau s’écoule et se concentre dans les bassins versants. Il n’en reste pas moins que ces deux effets jouent un rôle de plus en plus important dans les événements de moindre ampleur, dont les impacts sont néanmoins importants et dont l’occurrence a déjà augmenté et va encore s’accentuer dans le futur. Pour deux degrés de réchauffement, l’intensité des crues décennales (d’une ampleur observée en moyenne une fois tous les 10 ans) augmentera potentiellement de 10 à 40 % dans l’Hexagone, et celle des crues centennales (observées en moyenne une fois tous les siècles) de plus de 40 %.

Une vie en catastrophes ?

Ces événements ont provoqué des prises de position politique virulentes. Certains, en particulier à droite de l’échiquier politique, ont remis en question les politiques récentes de restauration de l’état naturel des cours d’eau, de protection des zones humides et de destruction des barrages. Elles ont conduit à des appels à la suppression de l’Office français de la biodiversité lors des manifestations agricoles, proposition reprise par le sénateur Laurent Duplomb devant le Sénat le 24 janvier 2024.

Les aménagements les plus récents, défendus par de nombreuses structures territoriales, visent à redonner au cycle de l’eau, et en particulier aux rivières, des espaces plus larges et à recréer ou protéger des zones humides. Tous ces aménagements conduisent à ralentir les flux et donc luttent contre les inondations, tout en préservant la biodiversité à laquelle notre santé est liée. Les zones humides sont par exemple les meilleurs ennemis des moustiques tigres, en permettant le développement de leurs prédateurs. Bien qu’ils exigent de concéder des terres agricoles aux milieux naturels, ces aménagements nourrissent les nappes qui restent le meilleur réservoir pour le stockage de l’eau des saisons humides.

Remettre en question les politiques de recalibration des cours d’eau, de remembrement et de drainage, tout comme l’imperméabilisation des zones urbaines, est une nécessité imposée par l’adaptation au changement climatique. Il s’agit de limiter ou éviter les tensions entre les besoins des activités humaines et les besoins des écosystèmes qui pourraient en faire les frais. Les inondations catastrophiques ne sont qu’en partie liées aux aménagements et ne peuvent pas justifier à elles seules les politiques de retour à l’état naturel des cours d’eau, qui sont en revanche une réponse aux sécheresses estivales à venir. Pour autant, ces inondations majeures sont là pour nous alerter sur les effets du changement climatique. Les étés vont devenir plus secs et les ressources vont manquer, mais les événements extrêmes vont également se multiplier. Une vie en catastrophes nous attend si nous ne transformons pas nos modes de consommation et de production. Tel est le message porté par les inondations. Sera-t-il mieux entendu que les appels des hydrologues ?

Luc Aquilina est co-titulaire de la chaire Eaux et territoires de la fondation de l’Université de Rennes qui reçoit des fonds d’Eau du Bassin Rennais, Rennes Métropole et du Syndicat Mixte Eau 50.

Pierre Brigode a reçu des financements de l'Université de Rennes, du Centre national de la recherche scientifique et de l'Agence nationale de la recherche.

12.02.2026 à 10:29

Les clauses environnementales des accords de libre-échange sont-elles efficaces ? L’exemple de la pêche

Texte intégral (1329 mots)

Une étude montre que les clauses environnementales contenues dans les accords de libre-échange sont ambivalentes : leur succès dépend, pour beaucoup, du contexte global et de la volonté politique à les mettre en œuvre. Le principal problème ? Elles ne contribuent pas vraiment à transformer les modèles et les pratiques qui nuisent le plus à l’environnement.

Les projecteurs sont actuellement braqués sur l’accord de libre-échange entre l’Union européenne et le Mercosur, signé le 17 janvier 2026 et déjà très contesté. Nombre de préoccupations portent sur les effets délétères qu’il pourrait avoir sur l’environnement.

Peut-on concilier commerce international et protection de l’environnement ? Cette question dépasse les forêts amazoniennes ou les bœufs brésiliens. Il touche aussi un bien commun trop souvent oublié : les océans et les pêcheries qui en dépendent.

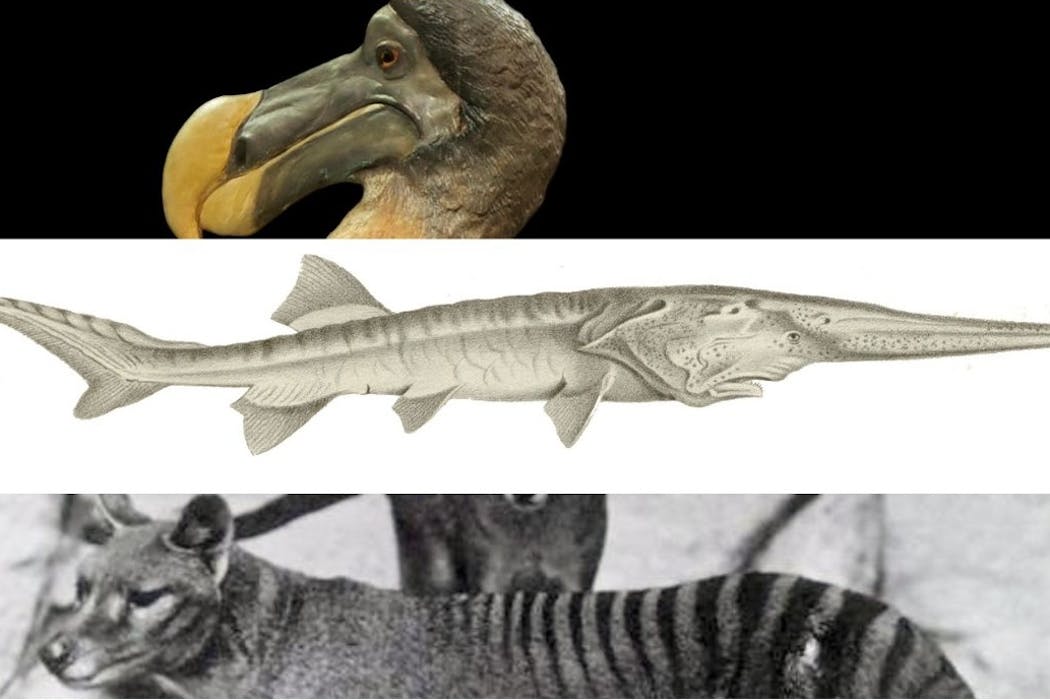

Les pêcheries sont, en effet, un pilier de la sécurité alimentaire mondiale. Elles nourrissent des milliards de personnes, font vivre des communautés entières dans les pays côtiers et assurent une part cruciale des exportations des pays du Sud global. Et pourtant, elles s’épuisent : selon l’Organisation des Nations unies pour l’alimentation et l’agriculture (FAO), à peine 65 % des stocks mondiaux de poissons sont exploités durablement, contre 90 % dans les années 1970.

Face à ce déclin, les gouvernements mobilisent un éventail de politiques : quotas, aires marines protégées, taxes, subventions… Mais un autre outil, plus discret, joue un rôle croissant : celui es accords commerciaux, qui incluent désormais des « clauses environnementales » censées limiter les effets néfastes du commerce sur la nature. Certaines portent directement sur les pêcheries. Mais sont-elles efficaces ?

Notre étude récente publiée dans la revue World Development analyse les conséquences économiques et écologiques de ces clauses, appliquées au secteur des pêcheries. En examinant plus de 700 accords commerciaux conclus depuis la Seconde Guerre mondiale, nous avons comparé ceux qui comportaient des clauses sur la pêche à ceux qui n’en prévoient pas.

Nous avons ainsi étudié leur effet sur le niveau trophique moyen des prises, c’est-à-dire la position des poissons pêchés dans la chaîne alimentaire. Si cet indicateur baisse, cela signifie que l’on pêche des espèces de plus en plus petites et basses dans la chaîne, et donc que les grands prédateurs marins disparaissent.

À lire aussi : Que sait-on sur les captures accidentelles de dauphins dans le golfe de Gascogne, et pourquoi est-il si difficile de les éviter ?

Un filet de sécurité, mais qui dépend du contexte national

Notre étude montre un résultat principal : les accords commerciaux sur la pêche détériorent la durabilité des ressources marines, mais l’inclusion de clauses environnementales atténue significativement cette dégradation. Ces clauses limitent les dégradations supplémentaires provoquées ou accentuées par la libéralisation des échanges.

En clair, ces dispositions environnementales jouent un rôle de filet de sécurité : elles empêchent la situation de se dégrade davantage, sans pour autant l’améliorer spectaculairement. Les effets positifs apparaissent lentement, entre cinq et neuf ans après la signature.

Ces résultats ont des implications au-delà des pêcheries. En effet, depuis une quinzaine d’années, les accords commerciaux ont intégré une multitude de clauses environnementales : sur les forêts, le climat, la pollution, la biodiversité… Toutefois, si ces dispositions ont parfois prouvé leur efficacité – pour réduire la déforestation ou les émissions polluantes, par exemple – leurs effets varient fortement selon les secteurs et les pays. Ils dépendent notamment largement de la qualité des institutions des pays signataires : les pays dotés d’une gouvernance solide en tirent bien plus de bénéfices écologiques.

Autrement dit, cela peut fonctionner, mais d’abord là où les États sont capables de les mettre en œuvre.

À lire aussi : Quel est le poids exact de la France dans la « déforestation importée » qui touche l’Amazonie ?

Un impact limité sur les pratiques de pêche

Notre étude souligne aussi le revers de la médaille, autrement dit l’ambivalence de ces politiques : elles peuvent atténuer les dégâts écologiques, mais pas nécessairement transformer les comportements économiques qui en sont à la source.

En effet, les améliorations écologiques observées, par rapport à un accord de libre-échange dépourvu de dispositions environnementales, ne sont pas tant liés à la transformation des pratiques de pêche – comme l’abandon du chalutage destructeur – qu’à la réduction forte des volumes pêchés et exportés.

Les clauses environnementales semblent donc d’abord agir comme des freins au commerce plutôt que comme des moteurs d’innovation durable. Elles freinent la pression commerciale, mais sans transformer le modèle de production vers davantage de soutenabilité.

Elles montrent surtout que la réussite de la transition écologique ne dépend pas uniquement des règles internationales, mais de la volonté politique et institutionnelle de les faire vivre par les États.

À lire aussi : À quelles conditions peut-on parler d’activités de pêche « durables » ?

Un enjeu de volonté politique

La question dépasse donc le commerce international : tout se joue dans la capacité des États à appliquer localement des engagements pris au niveau supranational. Une clause environnementale n’a d’effet que si la capacité des administrations à contrôler et sanctionner suit.

Sans investissement dans la mise en application et l’accompagnement des secteurs concernés, ces accords ne peuvent donc agir qu’à la marge. L’enjeu n’est donc pas d’ajouter des obligations dans les traités, mais de s’assurer qu’elles sont réellement mises en œuvre, seule condition pour changer les pratiques plutôt que simplement freiner le commerce.

Dans le débat sur l’accord UE–Mercosur, beaucoup craignent que l’environnement serve à nouveau de variable d’ajustement aux intérêts commerciaux. Nos recherches montrent qu’il n’y a pas de fatalité : si les clauses environnementales sont ambitieuses, assorties de mécanismes de suivi et appliquées par des États capables de les faire respecter, elles peuvent réellement protéger les ressources naturelles.

Basak Bayramoglu est membre de la Chaire Énergie et Prospérité, sous l'égide de La Fondation du Risque.

Clément Nedoncelle, Estelle Gozlan et Thibaut Tarabbia ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.

12.02.2026 à 10:29

Accord UE-Mercosur : quand la radiochronologie retrace l’histoire agricole de la Pampa en Amérique du Sud

Texte intégral (3093 mots)

Alors que l’accord UE-Mercosur suscite de vives inquiétudes chez les agriculteurs européens, il ne faut pas éluder ses conséquences environnementales potentielles en Amérique du Sud. Notre étude récente, qui s’appuie sur la datation radiométrique de sédiments, a permis de reconstituer une histoire des pollutions agricoles dans la Pampa uruguayenne. Or, en matière de pesticides, la terre n’oublie pas : on retrouve par exemple du DDT, pourtant interdit depuis des décennies, dans des prélèvements récents.

Alors que la récente signature de l’accord commercial entre l’Union européenne (UE) et le Mercosur fait encore débat, on a beaucoup parlé – à raison – de ses retombées pour les agriculteurs français et européens. On a, par contre, beaucoup moins évoqué les impacts que cet accord pourrait avoir sur l’environnement dans les pays du Mercosur (Argentine, Brésil, Paraguay et Uruguay).

L’Amérique du Sud est aujourd’hui devenue une puissance agricole mondiale, et l’un des premiers producteurs de soja dans le monde. La production de cette légumineuse est en effet passée de 297 000 tonnes en 1961 à 210 millions de tonnes en 2024, soit plus de la moitié de la production mondiale d’après les statistiques de l’Organisation des Nations unies pour l’alimentation et l’agriculture (FAO).

Cette expansion agricole se fait au détriment des espaces naturels. La région amazonienne retient souvent l’attention du grand public et des médias. Pourtant, il ne s’agit pas – loin s’en faut – du seul ensemble d’écosystèmes naturels (ou « biome ») à pâtir de l’expansion agricole. C’est également le cas de la Pampa, localisée entre le sud du Brésil, l’Uruguay et dans le nord-est de l’Argentine. Sa superficie dépasse les 1,2 million de kilomètres carrés (km²), soit plus de deux fois la superficie de la France hexagonale.

Ces vastes étendues de prairies naturelles constituent un vaste réservoir de biodiversité et un important puits de carbone. En 2023, une équipe de chercheurs brésiliens y avait identifié plus de 12 500 espèces différentes. L’accélération de la conversion de la Pampa en cultures, en prairies intensives et en plantations forestières commerciales au cours des dernières décennies menace ainsi les services fournis par ces écosystèmes.

Afin de reconstituer l’histoire agricole de ces écosystèmes depuis les 80 dernières années, nous avons collecté et analysé les sédiments qui se sont déposés au cours du temps dans le réservoir du barrage de Rincón del Bonete, sur le rio Negro, en étroite collaboration avec des chercheurs uruguayens.

Nous avons ensuite procédé à des analyses pour dater ces échantillons, en nous appuyant sur les traces de radionucléides à la fois naturels (qui retombent en continu avec les pluies) et artificiels (issus des essais nucléaires atmosphériques réalisés entre les années 1950 et les années 1970) qu’on y retrouve. Nous avons ainsi abouti à une remise en perspective historique inédite de l’histoire agricole de la région.

Des archives naturelles de l’histoire agricole

Ces sédiments jouent le rôle d’archives naturelles. En effet, chaque année, au fil des évènements pluvieux et des crues, les sédiments érodés à l’amont du rio Negro et transportés par la rivière se déposent dans le réservoir. Leur collecte et leur analyse permettent ainsi de reconstruire l’histoire des paysages de la région depuis l’inauguration du barrage hydroélectrique en 1945. C’est l’un des barrages l’un des plus anciens d’une telle ampleur en Amérique du Sud.

L’analyse de cette archive sédimentaire (intensité des flux sédimentaires, détection de pesticides…) a permis de reconstruire quatre grandes phrases de développement agricole dans la région :

De la fin de la Seconde Guerre mondiale à 1963 : une agriculture conventionnelle en continu, basée sur la mise en place de rotations annuelles, se développe. Ce système est associé, dans notre analyse, à des flux sédimentaires importants. Comprendre : une quantité importante de terres agricoles étaient alors lessivées par les pluies et transportées par le rio Negro.

De 1963 aux années 1990 : un système associant cultures et élevage se met en place. Il permet la réduction des flux sédimentaires. Cette période est caractérisée par la première détection de pesticides dans l’archive sédimentaire.

Des années 1990 au début des années 2000 : l’usage du semis direct, c’est-à-dire de cultures sans labour, commence à se répandre dans la région. Cette évolution est liée au développement de variétés de soja génétiquement modifiées, conçues pour être résistantes au glyphosate, qui pouvait ainsi être répandu pour détruire les adventices (les « mauvaises herbes ») sans endommager la culture principale.

Accompagnée d’une rotation entre polyculture et élevage, cette pratique semble avoir contribué à la réduction de l’érosion des sols, puisque cette période enregistre les plus faibles taux de sédimentation de la séquence. Cette période coïncide aussi avec d’importantes plantations d’arbres exotiques, principalement l’eucalyptus, utilisé pour produire de la pâte à papier.

À partir de 2007 : bien que le semis direct ait été adopté par la majorité des agriculteurs, les pratiques agricoles s’intensifient. La monoculture continue intensive ou une double récolte au cours de l’année (généralement une succession de soja et de céréales) est souvent de mise.

De nombreuses zones naturelles sont alors converties pour la culture du soja et la plantation d’eucalyptus. En conséquence, cette période enregistre les plus forts taux de sédimentation et les flux de pesticides les plus élevés depuis la fin de la Seconde Guerre mondiale.

Des traces récentes de pesticides interdits, comme le DDT

Parmi les pesticides retrouvés au sein des sédiments déposés récemment dans le barrage uruguayen, on retrouve notamment des substances interdites en Europe et aux États-Unis, telles que le Mirex – utilisé dans les plantations d’eucalyptus – ou le DDT.

Ce pesticide nocif à la fois pour l’humain et l’environnement, désormais interdit dans la quasi-totalité du monde, a été historiquement utilisé comme insecticide pour l’agriculture. Il fut également largement répandu à travers l’Amérique lors de grandes campagnes d’éradication des vecteurs du paludisme au sortir de la Seconde Guerre mondiale.

L’explication la plus probable derrière la réapparition du DDT serait une remobilisation des quantités de ce pesticide déjà présentes dans l’environnement. Cela pourrait faire suite à l’augmentation de l’érosion des sols cultivés depuis des décennies, ainsi qu’à la mise en culture et à l’érosion de nouvelles terres, faisant partie d’espaces naturels qui avaient été traités avec du DDT au milieu du siècle dernier.

À lire aussi : Pesticides et biodiversité, les liaisons dangereuses

Les essais nucléaires du siècle dernier, utiles pour la datation

Dans notre étude, nous avons combiné plusieurs analyses à haute résolution des sédiments accumulés par le barrage. L’analyse historique a été rendue possible grâce à la datation des couches successives de sédiments, réalisée à travers l’analyse de radionucléides à la fois naturels (qui retombent en continu avec les pluies) et artificiels (liés aux essais nucléaires atmosphériques réalisés entre les années 1950 et les années 1970).

Ces essais nucléaires, menés principalement par les États-Unis, l’Union soviétique et la France, sont en effet associés à des émissions de césium et de plutonium spécifiques, dont ils sont, en quelque sorte, la signature. De quoi aider à reconstruire l’âge des couches successives de la séquence sédimentaire.

Nous avons ensuite pu mettre en relation les propriétés des sédiments avec des données historiques, telles que les statistiques agricoles ou d’usage des sols, afin de proposer cette analyse historique de l’impact des changements paysagers.

Les impacts environnementaux à venir dans la Pampa

Les impacts environnementaux liés à la mise en culture de la Pampa sont déjà très nets, mais ce n’est malheureusement peut-être que le début.

À ce jour, seuls 20 % des prairies qui étaient encore en place en 1985 ont été transformées. Les prairies de la Pampa, qui recouvraient 83 % de la zone étudiée en 1985, ne représentaient plus que 60 % de la surface en 2022. Autant d’espaces où les activités agricoles et sylvicoles pourraient continuer à se développer.

Dans ce contexte, les accords commerciaux qui ont été conclus entre les pays du Mercosur et de l’Union européenne – mais aussi avec d’autres grandes puissances, telles que la Chine – auront un impact. Ils favoriseront les exportations et augmenteront la demande en produits tels que le soja et la pâte à papier. Ce faisant, ils risquent d’exacerber l’expansion et l’intensification agricole, ainsi que leurs impacts environnementaux.

L’approche développée, qui a donc permis de reconstruire une perspective historique inédite, pourrait être prolongée dans le temps pour suivre les impacts environnementaux à venir dans la région, en lien avec les évolutions réglementaires et commerciales en cours.

Amaury Bardelle a reçu des financements de l'Agence Nationale de la Recherche (ANR) dans le cadre du projet AVATAR (ANR-22-CE93-0001), du projet ClimatAmSud CELESTE et du CNRS (International Research Project - IRP - CELESTE Lab).

Anthony Foucher a reçu des financements de l'Agence Nationale de la Recherche (ANR) dans le cadre du projet AVATAR (ANR-22-CE93-0001), du projet ClimatAmSud CELESTE et du CNRS (International Research Project - IRP - CELESTE Lab).

Olivier Evrard a reçu des financements de l'Agence Nationale de la Recherche (ANR) dans le cadre du projet AVATAR (ANR-22-CE93-0001), du projet ClimatAmSud CELESTE et du CNRS (International Research Project - IRP - CELESTE Lab).

Pierre-Alexis Chaboche a reçu des financements de l'Agence Nationale de la Recherche (ANR) dans le cadre du projet AVATAR (ANR-22-CE93-0001), du projet ClimatAmSud CELESTE et du CNRS (International Research Project - IRP - CELESTE Lab).

Renaldo Gastineau a reçu des financements de l'Agence Nationale de la Recherche (ANR) dans le cadre du projet AVATAR (ANR-22-CE93-0001).

11.02.2026 à 16:28

Face au changement climatique, la Normandie plus vulnérable qu’elle ne le croit

Texte intégral (2388 mots)

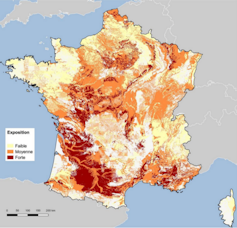

La Normandie, protégée par son climat océanique, s’est longtemps pensée à l’abri des bouleversements climatiques. Pourtant, les données scientifiques racontent une autre histoire : celle de risques nouveaux qui s’installent peu à peu. Comprendre et intégrer ces mécanismes est urgent pour aider le territoire à s’adapter

Alors que le sud de la France commence à s’inquiéter d’une éventuelle recomposition de son attractivité touristique et résidentielle avec un recul du ski hivernal et l’augmentation des canicules, la Normandie court un risque très différent : celui de se croire à l’abri.

Seuls 52 % des Normands disent en effet ressentir le dérèglement climatique dans leur quotidien, contre 71 % au niveau national. Ce sentiment de sécurité relative ressenti par une partie de la population normande face au changement climatique s’explique par un facteur géographique réel, associé à des biais psychologiques naturels.

Depuis toujours, les territoires délimités par la Manche sont ouverts aux flux atmosphériques d’ouest perturbés, qui ont conduit à la construction d’une réputation, pas toujours élogieuse – ni usurpée – de risques de pluie importants, y compris durant l’été.

Ce rideau de fumée météorologique mène naturellement à un fort décalage de perception du dérèglement climatique. Il entretient chez nous, les Normands, un biais d’optimisme irréaliste accentué. De ce fait, nous avons une tendance naturelle à nous considérer comme mieux protégés que les autres et, parfois paradoxalement, à l’abri.

Lors des deux épisodes caniculaires de l’été 2025, alors que les stations météo du sud de la France dépassaient 40 °C, la Normandie atteignait péniblement les 30 °C. Une température tout à fait accueillante pour les touristes ayant eu l’audace de choisir Deauville (Calvados) ou Dieppe (Seine-Maritime) comme destination estivale, mais beaucoup moins adaptée à nos écosystèmes normands.

En réalité, le changement climatique touche la Normandie, comme toutes les autres régions.

La Normandie, loin d’être épargnée

À Rouen (Seine-Maritime), la fréquence des jours de chaleurs à plus de 25 °C est passée de 14 jours par an en 1971 à 40 jours par an en 2023. Les huit années les plus chaudes depuis 1970 se sont toutes produites après 2014.

Pendant ce temps, sur nos côtes, les falaises reculent de 20 cm à 25 cm par an, parfois 40 cm dans certaines zones où nos constructions amplifient le phénomène. Ce recul n’est pas régulier, il se fait souvent au prix d’effondrements spectaculaires… et dangereux.

Cette mer qui monte peut aussi provoquer un phénomène de blocage de l’écoulement des eaux fluviales vers la mer, comme cela a été observé en mars 2020 quand les quais de Rouen se sont retrouvés inondés. La tempête Ciara avait alors provoqué une surcote au niveau de l’embouchure de la Seine.

D’ici la fin du siècle, ce phénomène va s’accentuer. Sur le littoral, la menace changerait d’échelle avec une élévation du niveau de la mer projetée entre 1,1 m et 1,8 m. Dans les terres, le réchauffement moyen de la Normandie pourrait atteindre plus de + 3 °C, augmentant radicalement le stress hydrique et les risques sanitaires.

Petit à petit, nous nous habituons à ces étés plus chauds, à ces hivers plus doux et à voir les bâtiments de nos villes les pieds dans l’eau. Mais si chaque événement semble acceptable, pris isolément, leur répétition et surtout leur combinaison changeront, dans un futur proche, la nature du risque sur le territoire normand.

Le risque n’est plus seulement ponctuel : il provoque un enchaînement de conséquences territoriales et sociales, souvent invisibles au moment de l’événement, mais persistantes dans le temps.

À lire aussi : « Renaturer » les villes, une voie prometteuse pour mieux s’adapter au changement climatique

Dans les angles morts des risques climatiques

L’équilibre et la dynamique d’un territoire découlent de multiples facteurs étroitement liés par des interactions complexes. La modification d’un seul élément, comme l’élévation des températures, entraîne des conséquences en chaîne sur l’ensemble des autres secteurs : eau, biodiversité, économie, santé, etc.

Or la complexité de ces interactions peut créer des angles morts, c’est-à-dire à des zones non visibles par les observations et les projections, et donc des procédures de prévention et d’adaptation inadéquates face aux risques qui menacent la Normandie.

Ce risque dépend de la combinaison d’un aléa climatique, comme une canicule ou de fortes pluies, du niveau d’exposition d’enjeux humains ou matériels et enfin de la vulnérabilité de ces enjeux. L’un des premiers leviers d’action, pour le diminuer, est d’abaisser le niveau de vulnérabilité : par exemple, construire une digue face à des habitations menacées ou d’engager des actions de renaturation dans une ville exposée aux canicules.

Mais ce faisant, un premier angle mort peut apparaître : en réduisant une vulnérabilité précise, nous pouvons en accroître d’autres. Une digue mal conçue va accélérer le recul du trait de côte à proximité de sa zone de protection. Une végétation urbaine inadaptée peut entraîner des risques sanitaires en diffusant des allergènes ou en abritant des insectes porteurs de maladies.

D’autres angles morts existent, comme la fragilisation d’un territoire entier ou l’existence de grands décalages temporels entre les temps politiques et les temps climatiques. Par exemple, des choix d’urbanisation (par exemple, constructions en bord de plage) ou d’artificialisation réalisés il y a plusieurs décennies n’expriment pleinement leurs effets que tardivement. Aujourd’hui, ils augmentent les risques d’inondation avec des épisodes pluvieux ou des tempêtes littorales devenus plus intenses.

Quitter l’approche en silo

L’angle mort qui permet à tous les autres d’exister, enfin, réside dans notre difficulté persistante à prendre en compte les liens qui existent entre les différents risques climatiques. Inondations, sécheresses, canicules, submersions, risques industriels ou sanitaires sont mesurés, analysés et combattus séparément. Cette vision en silo nous empêche de voir l’ensemble de leurs relations, et par là même les mécanismes de déclenchement, d’amplification ou de cascade, qui sont pourtant au cœur des crises climatiques actuelles et à venir.

À Rouen, par exemple, de fortes pluies associées aux grandes marées, à la montée des eaux et à une tempête à l’embouchure de la Seine pourront mener à des inondations, et notamment dans le secteur industriel de la rive gauche où se concentrent plusieurs usines Seveso.

L’aléa naturel entraîne alors des risques industriels qui peuvent conduire à des pollutions des captages ou des sols, des tensions sanitaires, et même sociales, avec l’arrêt de certaines activités professionnelles et l’évacuation de quartiers d’habitation.

Cette cécité culturelle court des chercheurs, évalués sur leur hyperspécialisation dans un domaine, aux opérateurs de l’État ou des collectivités au sein desquels l’action reste structurée par secteurs, compétences et dispositifs spécialisés. Une organisation qui favorise l’expertise, mais rend difficile une approche systémique pourtant indispensable.

Prendre en compte la société face aux changements

La création en 2019 du Giec normand, suivie des premiers rapports publiés en 2020, a permis d’établir un diagnostic scientifique sur l’évolution physique du territoire. Très vite, les limites d’une lecture classique des risques sont apparues : face aux interactions multiples entre activités humaines et équilibres environnementaux, les réponses ciblées ou sectorielles se sont révélées insuffisantes.

Avec le Giec normand, dont la seconde mouture de travaux a été publiée en 2023 et 2024, un cap a été franchi : l’analyse s’est élargie aux effets sociaux, juridiques et économiques du changement climatique.

Si plus de 80 % des Français reconnaissent l’origine humaine du réchauffement, les travaux en sciences humaines et sociales montrent que cette prise de conscience se traduit encore peu en actions concrètes. Ils mettent aussi en évidence des vulnérabilités socialement différenciées face aux aléas, comme la submersion marine.

Le droit, de son côté, précise les responsabilités croissantes des collectivités et l’économie commence à chiffrer le coût, souvent sous-estimé, de l’inaction.

Il ne s’agit plus seulement de comprendre les changements induits par le dérèglement climatique, mais aussi d’analyser la société face à ces transformations et face aux solutions d’adaptation qui se déploient.

Élaborer des scénarios pour l’avenir

Cependant, une étape majeure reste à franchir, sans doute la plus difficile : passer de la phase de diagnostic à une transformation opérationnelle des politiques publiques. Et si nous, citoyens, avons parfois tendance à reporter l’ensemble des responsabilités sur nos décideurs politiques, une part de ce travail nous revient également.

Pour penser système, il ne faut plus raisonner à l’aune d’événements isolés, mais en scénarios. Il s’agit, par exemple, de dépasser le raccourci « pluie = crue » pour déplier un enchaînement de conséquences possibles, de l’inondation à l’interruption de certains secteurs économiques, en passant par l’accident industriel et la saturation des services hospitaliers.

Cette lecture en scénarios implique aussi de revisiter les choix d’adaptation. Les décisions prises aujourd’hui en matière d’aménagement, de travail ou de formation engagent les territoires sur le long terme et produisent souvent leurs effets à distance, dans le temps comme dans l’espace. Sans une compréhension claire de ces enchaînements, le risque est de multiplier des réponses locales cohérentes prises isolément, mais inefficaces, voire contre-productives.

Agir à l’échelle des métropoles et des régions

À l’échelle de nos choix individuels, cela implique de sortir d’une logique de réponses immédiates et de réussir à relier nos décisions d’aujourd’hui aux effets qu’ils auront plus tard, peut-être dans longtemps, sur les systèmes dont nous faisons partie.

Mais les actions individuelles seront vaines sans une action collective pensée de manière globale. Ce rôle incombe aux institutions publiques, aux collectivités territoriales, aux acteurs associatifs mais aussi aux universités, qui produisent des connaissances, forment des acteurs et font dialoguer sciences, territoires et société.

Le territoire joue ici un rôle crucial et les échelons des métropoles et de la région apparaissent les plus pertinents : ils sont assez larges pour permettre des actions adaptées aux risques à venir, mais assez proches pour que chaque citoyen s’y sente concerné et impliqué.

Réduire les inégalités face aux risques

Une action territoriale structurée, appuyée sur les savoirs scientifiques et leur appropriation collective, est aussi un enjeu de justice, dans un contexte où tous les citoyens ne disposent pas des mêmes ressources pour s’informer, s’adapter ou agir. Elle permet de réduire ces inégalités d’exposition et de vulnérabilité face à des risques climatiques qui dépassent largement l’échelle des choix individuels.

La vision systémique prend alors tout son sens. Elle nous aide à relier les aléas, les risques en cascade qu’ils engendrent, leurs conséquences mais aussi les effets parfois contradictoires des solutions d’adaptation. Elle permet de regarder la société dans son ensemble et de construire des réponses justes et adaptées à la diversité des situations.

Julien Réveillon a reçu des financements de ANR France 2030 - ANR-23-EXES-0013.

11.02.2026 à 16:22

Des centaines de séismes ont été détectés à proximité du « glacier de l’apocalypse » en Antarctique

Texte intégral (1461 mots)

Grâce à l’utilisation de stations sismiques locales, des chercheurs ont identifié des centaines de séismes glaciaires au glacier de Thwaites, jusqu’ici passés inaperçus. Ils permettent de suivre l’activité d’une zone critique pour la stabilité antarctique.

Les séismes glaciaires sont un type particulier de tremblement de terre dans les régions froides et glacées. Découverts pour la première fois dans l’hémisphère Nord il y a plus de vingt ans, ils se produisent lorsque d’énormes blocs de glace tombent des glaciers dans la mer, générant des vibrations qui se propagent ensuite dans le sol sous le glacier et au-delà.

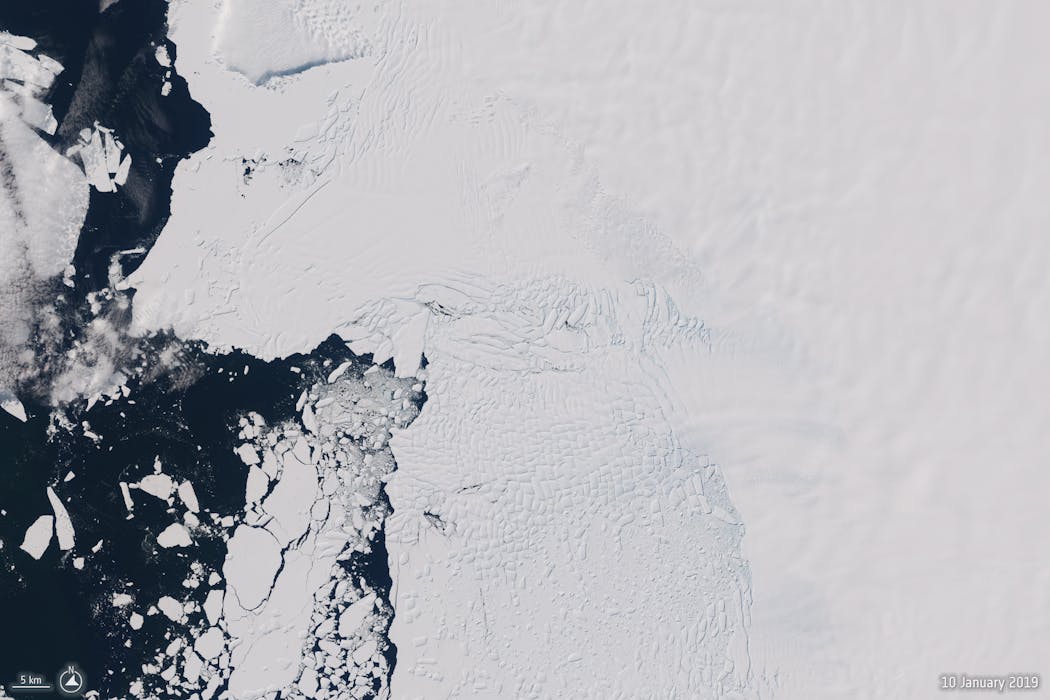

Jusqu’à présent, seuls très peu de ces séismes provoqués par la chute de blocs de glace avaient été détectés en Antarctique. Dans une nouvelle étude publiée dans Geophysical Research Letters, je présente des preuves de centaines d’occurrences en Antarctique entre 2010 et 2023, principalement à l’extrémité océanique du glacier Thwaites – le fameux « glacier de l’Apocalypse », qui pourrait provoquer une montée rapide du niveau de la mer en cas d’effondrement.

À lire aussi : Face à la fonte des glaces de l’Antarctique, le niveau de la mer n’augmente pas au même rythme partout

Une découverte récente

Un séisme glaciaire se produit lorsque de hauts icebergs effilés se détachent de l’extrémité d’un glacier et tombent dans l’océan.

Lorsque ces blocs basculent, ils heurtent violemment le glacier principal. Ce choc génère de fortes vibrations mécaniques du sol, ou ondes sismiques, qui se propagent sur des milliers de kilomètres depuis leur origine.

Ce qui rend les séismes glaciaires uniques, c’est qu’ils ne génèrent aucune onde sismique à haute fréquence. Et comme ces ondes sont essentielles pour détecter et localiser les sources sismiques classiques, comme les tremblements de terre, les volcans ou les explosions nucléaires, les séismes glaciaires n’ont été découverts que relativement récemment, alors que d’autres sources sismiques sont, elles, analysées quotidiennement depuis plusieurs décennies.

Variations saisonnières

La plupart des séismes glaciaires détectés jusqu’à présent ont été localisés près des extrémités des glaciers au Groenland, la plus grande calotte glaciaire de l’hémisphère nord.

Ils présentent des magnitudes relativement élevées, dont les plus importantes sont comparables à celles des séismes provoqués par les essais nucléaires menés par la Corée du Nord au cours des deux dernières décennies. Ces magnitudes assez importantes permettent de suivre ces séismes glaciaires avec un réseau sismique international, opérationnel en continu.

Les événements groenlandais sont saisonniers. Ils surviennent plus fréquemment à la fin de l’été. Ils sont également devenus plus fréquents au cours des dernières décennies. Ces tendances pourraient être liées à un réchauffement climatique plus rapide dans les régions polaires.

En Antarctique, des preuves difficiles à obtenir

Bien que l’Antarctique abrite la plus grande calotte glaciaire de la planète, les preuves directes de séismes glaciaires causés par le basculement d’icebergs (on parle de vêlage) sont difficiles à détecter.

La plupart des tentatives précédentes reposaient sur le réseau mondial de détecteurs sismiques – qui pourraient ne pas être suffisamment sensible si les séismes glaciaires antarctiques sont de magnitude beaucoup plus faible que ceux du Groenland.

Dans ma nouvelle étude, j’ai utilisé des stations sismiques situées en Antarctique. J’ai détecté ainsi plus de 360 événements sismiques glaciaires. La plupart ne figuraient pas dans les catalogues de séismes.

Ces événements sont situés dans deux zones, près des glaciers de Thwaites et de Pine Island. Ce sont les deux principales sources de la montée du niveau de la mer en provenance de l’Antarctique.

Les séismes du glacier de l’Apocalypse

Le glacier de Thwaites est parfois surnommé « glacier de l’Apocalypse », car, s’il venait à s’effondrer complètement, il ferait monter le niveau mondial des mers de 3 mètres – et parce qu’il est susceptible de se désintégrer rapidement.

Environ les deux tiers des événements que j’ai détectés – 245 sur 362 – se situaient près de l’extrémité du glacier en contact avec l’océan. La plupart sont probablement des séismes glaciaires causés par le basculement d’icebergs.

À la différence de ce qui se passe au Groenland, le principal facteur à l’origine de ces événements ne semble pas être la variation annuelle des températures de l’air.

La période la plus prolifique pour les séismes glaciaires à Thwaites, entre 2018 et 2020, coïncide plutôt avec une accélération de la progression de la langue glaciaire vers la mer. Cette accélération, confirmée de manière indépendante par des observations satellites, pourrait être liée aux conditions océaniques, mais leur effet est encore mal compris.

Ces nouveaux résultats suggèrent donc que l’état de l’océan peut avoir un impact à court terme sur la stabilité des glaciers qui terminent dans la mer. Cela mérite d’être étudié plus avant pour évaluer la contribution potentielle du glacier à la hausse future du niveau de la mer.

À lire aussi : Une nouvelle méthode pour évaluer l’élévation du niveau de la mer

Le deuxième plus grand groupe de séismes glaciaires antarctiques que j’ai observés se trouve près du glacier de Pine Island. Mais ces séismes étant situés à 60–80 kilomètres du rivage, il est peu probable qu’ils aient été provoqués par le basculement d’icebergs.

Ces événements demeurent énigmatiques et nécessitent des recherches complémentaires.

Perspectives pour la recherche sur les séismes glaciaires en Antarctique

La détection de séismes glaciaires liés au vêlage d’icebergs sur le glacier de Thwaites pourrait contribuer à avancer sur plusieurs questions scientifiques importantes. Parmi elles, figure l’interrogation fondamentale sur l’instabilité potentielle du glacier de Thwaites, en lien avec l’interaction entre océan, glace et substrat rocheux à l’endroit précis où il rejoint la mer.

Mieux comprendre ces mécanismes est essentiel pour réduire les grandes incertitudes sur les projections de montée du niveau de la mer au cours des prochains siècles.

Thanh-Son Pham a reçu des financements de l'Australian Research Council.

10.02.2026 à 16:49

Du plastique biodégradable pour pailler les sols agricoles : solution ou nouveau problème ?

Texte intégral (1857 mots)

Les films de paillage ont changé le quotidien de nombreux agriculteurs en facilitant la gestion des mauvaises herbes et de l’eau. Mais exposés au soleil, à l’humidité et au travail du sol, ces plastiques se fragmentent progressivement en micro et nanoplastiques qui s’accumulent dans les sols. Que deviennent ces particules invisibles ? Les plastiques biodégradables peuvent-ils réellement limiter cette pollution ?

En maraîchage et en arboriculture fruitière, les films plastiques de paillage sont devenus incontournables dans certains conditions de température, d’humidité et d’aération des sols. Posés à sa surface, ils empêchent les mauvaises herbes de se développer, conservent l’humidité et accélèrent le réchauffement du sol au printemps. Le résultat ? Des cultures plus productives et une moindre dépendance aux herbicides, notamment dans les sols en milieu tempéré soumis à un stress hydrique saisonnier.

Aujourd’hui, l’immense majorité des films de paillage – près de 90 % – sont fabriqués à partir de polyéthylène, un polymère dérivé du pétrole. Solide, bon marché et imperméable, ce matériau s’est imposé dans les champs. Mais il présente un inconvénient majeur : il ne se biodégrade pas et, une fois fragmenté, peut rester dans l’environnement pendant des siècles.

Une fois les cultures récoltées, ces films ne sont pas complètement retirés. Les fragments qui restent dans les sols se dégradent lentement sous l’effet du soleil, de l’humidité et du travail mécanique des terres. Ils se fragmentent progressivement en microplastiques (dont les dimensions vont de un micromètre à cinq millimètres), atteignant dans certaines exploitations plusieurs milliers de particules par kilogramme de sol. Avec le temps, ces fragments deviennent encore plus petits et forment ce que l’on nomme des nanoplastiques (dont la taille est inférieure à un micromètre).

Invisibles et pendant longtemps peu étudiées, ces particules soulèvent aujourd’hui de nombreuses questions. Comment se comportent-elles dans les sols agricoles ? Quels sont leurs effets potentiels sur l’environnement ? Surtout, les alternatives dites « biodégradables » constituent-elles réellement une solution pour limiter cette pollution ?

À lire aussi : Comment le plastique est devenu incontournable dans l’industrie agroalimentaire

L’agriculture européenne consomme 427 000 tonnes de plastique par an

Bien que les nano et microplastiques présents dans les sols agricoles aient des origines multiples, toutes les sources ne contribuent pas dans les mêmes proportions.

Parmi les apports externes figurent notamment les boues issues des stations d’épuration, parfois utilisées comme amendements organiques. Elles peuvent contenir jusqu’à près de 900 particules microplastiques par kilogramme de matière sèche. À l’échelle européenne, leur épandage représenterait chaque année l’introduction de 63 000 à 430 000 tonnes de microplastiques dans les sols agricoles.

Mais la contribution la plus importante se trouve souvent directement au champ. Les films plastiques de paillage constituent aujourd’hui la principale source de micro et nanoplastiques en agriculture. Chaque année, 427 000 tonnes de ces produits sont utilisées en Europe et 300 000 tonnes en Amérique du Nord. La Chine concentre, à elle seule, près de 30 % de la consommation mondiale, avec 2,6 millions de tonnes de films agricoles, dont 1,3 million de tonnes de films de paillage, soit environ les trois quarts de l’usage mondial.

À lire aussi : Peut-on se passer de plastique en agriculture ?

Des plastiques, du champ à l’assiette

Or, dans les sols agricoles, les nano et microplastiques ne se comportent pas comme de simples déchets inertes. Ils peuvent modifier les propriétés physiques, chimiques et biologiques des sols en affectant leur structure, leur porosité, leur capacité à retenir l’eau ou encore les cycles du carbone et de l’azote.

Ces particules peuvent aussi se fixer aux racines, freinant l’absorption de l’eau et la croissance des plantes. Certaines cultures, comme la laitue ou le blé, absorbent même des microplastiques depuis le sol, qui peuvent ensuite migrer vers les parties comestibles que nous mangeons.

Ce n’est pas tout : plus un fragment de plastique est petit, plus sa surface exposée au milieu environnant augmente par rapport à son volume. Or, les interactions entre le plastique et le sol se produisent principalement à sa surface. Ainsi, à quantité de plastique égale, les micro et surtout les nanoplastiques présentent une surface de contact beaucoup plus importante avec leur environnement que les fragments de plus grande taille.

Cette surface élevée les rend particulièrement réactifs : ils interagissent plus fortement avec les molécules présentes dans le sol. De nombreuses substances chimiques peuvent ainsi se fixer à la surface de ces particules, notamment des polluants organiques ou des métaux. En présence de pesticides, les plastiques peuvent alors se comporter comme de véritables « éponges chimiques », captant et concentrant localement des substances indésirables et potentiellement toxiques.

À lire aussi : Microplastiques, nanoplastiques : quels effets sur la santé ?

Plastique biodégradable ? Une promesse à nuancer

Pour répondre à cette problématique, des plastiques dits « biodégradables » ont été développés. Présentés comme une alternative aux films de plastique classiques, ils reposent sur un principe séduisant : après usage, ils seraient transformés par les microorganismes du sol en composés naturels, tels que l’eau et le dioxyde de carbone.

Mais cette promesse dépend fortement des conditions environnementales. En effet, la biodégradabilité est tributaire des conditions environnementales. Un plastique peut se dégrader rapidement dans une installation de compostage industriel, soumise à de fortes chaleurs, mais rester presque intact pendant longtemps dans un sol agricole plus frais.

C’est notamment le cas des polymères couramment utilisés dans les films de paillage biodégradables, comme le polybutylène adipate-co-téréphtalate (PBAT) ou le poly (butylène succinate) (PBS). Dans les conditions réelles des champs agricoles, leur dégradation peut rester incomplète.

Se pose alors la question de leur devenir à long terme et de leur capacité réelle à limiter l’accumulation de nano et microplastiques dans les sols.

Les vers de terre à la rescousse ?

Constatant ces échecs, des chercheurs s’attachent désormais à en comprendre les causes et à identifier les conditions environnementales et biologiques qui permettraient d’améliorer la dégradation de ces plastiques dans les sols agricoles. Il ne s’agit pas seulement de concevoir de nouveaux matériaux, mais aussi d’adapter les pratiques agricoles à leur présence dans les sols, en particulier dans les systèmes où l’usage des films de paillage est intensif.

Les scientifiques s’intéressent ainsi au rôle des amendements organiques, des biostimulants et des extraits microbiens, capables de modifier l’activité biologique des sols. Des études ont ainsi montré que le vermicompost – un compost produit par les vers de terre – peut fortement améliorer les performances de certains plastiques biodégradables en conditions agricoles. Cet effet s’expliquerait à la fois par l’apport de nutriments favorisant les microorganismes du sol et par la présence d’une flore microbienne spécifique, issue du tube digestif des vers de terre.

Pour mieux comprendre ces mécanismes, des expériences en laboratoire suivent la dégradation des plastiques à l’aide de systèmes respirométriques mesurant la transformation du carbone des plastiques en dioxyde de carbone par les microorganismes. Ces dispositifs permettent d’évaluer de manière quantitative dans quelles conditions cette dégradation est accélérée.

À lire aussi : Du slip troué aux sachets de thé, quelques indicateurs pour mesurer la santé des sols

Améliorer les plastiques et les pratiques

Si les plastiques dits biodégradables représentent une piste intéressante contre l’accumulation dans les sols de nano et de microplastiques, leur efficacité dépend étroitement des conditions réelles du milieu agricole et ils ne peuvent pas être considérés comme une solution systématique ou tenue pour acquise.

Les travaux de recherche montrent qu’améliorer leur biodégradation passe à la fois par une meilleure compréhension de l’interaction entre les matériaux, le fonctionnement biologique des sols et les pratiques culturales associées. Amendements organiques spécifiques, apports de souches exogènes et stimulation de l’activité microbienne autochtone constituent autant de leviers potentiels.

À terme, réduire la pollution plastique en agriculture nécessitera une approche globale, combinant innovation technologique, pratiques agronomiques adaptées et cadres réglementaires cohérents, afin de concilier performance agricole et protection durable des sols.

Jules Bellon a reçu des financements de la Région Normandie pour mener ses travaux de recherche.

Feriel Bacoup a reçu des financements de Région Normandie

Richard Gattin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

09.02.2026 à 16:00

La Chine, leader de la décarbonation des économies du Sud

Texte intégral (2039 mots)

Très engagée dans la décarbonation de son économie, la Chine est devenue la première, et la plus innovante, productrice mondiale d’énergies vertes. Cette position lui permet de conforter ses relations avec les pays du Sud, en répondant à leurs besoins tout en servant ses propres objectifs d’étendre son influence, d’écouler sa production et d’approfondir l’internationalisation de sa monnaie. L’objectif : être la première puissance mondiale en 2049.

L’image d’une alliance entre grands pays du Sud global lors de la rencontre Xi Jinping, Vladimir Poutine et Narendra Modi pendant la réunion de l’Organisation de coopération de Shanghai (OCS) à Tianjin en septembre 2025, est un message aux pays du monde occidental : il existe une alternative au multilatéralisme.

L’importante délégation chinoise à la COP 30 en novembre 2025, au Brésil, et l’organisation dans ce cadre, d’un évènement sur la coopération Sud-Sud relatif au climat, illustre l’un des principaux vecteurs de cette coopération. La Chine est devenue le premier investisseur mondial dans les énergies renouvelables.

Cette stratégie vise à servir l’ambition chinoise de devenir la première puissance économique mondiale en 2049. Elle doit notamment lui permettre de jouer un rôle majeur dans la définition des normes et des standards internationaux.

Une stratégie offensive pour concurrencer l’Occident

L’affaiblissement des économies occidentales lors de la crise financière de 2007 a été concomitante de la volonté des pays du Sud de monter en puissance dans la gouvernance mondiale.

La création des BRICS (Brésil, Russie, Inde, Chine et Afrique du Sud) en 2009 et le discours de Wen Jiabao, alors premier ministre de Hu Jintao, à Davos la même année, illustrent cette volonté d’être leader de ce mouvement. La Chine est progressivement passée d’une stratégie « profil bas » avec Deng Xiaoping à la stratégie offensive d’une économie innovante pouvant concurrencer les économies développées dans de nombreux secteurs.

À lire aussi : Qu’est-ce que la « civilisation écologique » que revendique le pouvoir chinois ?

À l’heure où les États-Unis se marginalisent dans la lutte contre le réchauffement climatique et où l’Europe souffre de ses désaccords, la Chine se positionne comme le fournisseur de technologies vertes aux pays du Sud et le défenseur de leurs intérêts. Elle peut leur permettre d’accélérer la décarbonation de leur économie à un coût assez faible, de bénéficier d’investissements qui créent des emplois et peuvent générer des transferts de technologie. Elle sert un double objectif :

offrir des débouchés pour écouler ses surproductions, poursuivre la montée en gamme de son industrie et renforcer sa position de leader dans les technologies vertes ;

accroître l’internationalisation de sa monnaie, pour limiter les dépendances à l’extraterritorialité du dollar.

Une demande croissante de technologie chinoise par les pays du Sud

Éoliennes, panneaux solaires, batteries, la Chine est le premier producteur d’énergies vertes dans le monde. C’est principalement par la technologie que la Chine envisage la décarbonation de l’économie. Par exemple, en matière de panneaux solaires, la Chine dispose de 80 % de la capacité de production mondiale à chaque stade de la chaîne de valeur. La domination est encore plus forte dans les batteries avec 85 % de maîtrise de la chaîne de valeur.

Elle dispose d’un quasi-monopole dans la technologie de traitement des terres rares qu’elle possède en grande quantité. Sa compétitivité en matière de transports décarbonés illustre les efforts faits dans ce domaine grâce aux différents plans, notamment Made in China 2025.

S’agissant des véhicules électriques, on retrouve la traditionnelle intégration des pays d’Asie et des entreprises chinoises – BYD, China’s Sunwoda Electric Company, China’s Zhejiang Geely Holding Group, etc. Ces dernières ont créé des usines de voitures électriques et de batteries en Thaïlande, au Vietnam, en Malaisie et en Indonésie. Les investissements de l’entreprise China’s Sunwoda Electronic Company et de Chery doivent permettre respectivement à la Thaïlande et au Vietnam de devenir des acteurs majeurs dans la chaîne de valeur des véhicules électriques.

À lire aussi : Le bond en avant de l’industrie automobile chinoise de 1953 à nos jours

Dans ce domaine, c’est tout un écosystème qui est proposé par Contemporary Amperex Technology Co. Limited (CATL), la plus grande usine chinoise de batteries, s’appuyant sur une joint-venture (coentreprise) sur le nickel avec l’Indonésie pour construire des capacités locales grâce à l’expertise chinoise.

Internationalisation de sa monnaie, le renminbi

Entre 2000 et 2023, la Chine a prêté 36,67 milliards d’euros aux pays africains pour développer l’accès à l’électricité sur le continent.

La construction de centrales hydroélectriques concentre 63 % des financements chinois de production d’électricité en Afrique entre 2020 et 2023, notamment en Zambie et en Angola. Les entreprises chinoises ont là aussi une position très dominante sur les chaînes de valeur de la transition énergétique, qu’il s’agisse des panneaux photovoltaïques ou des systèmes de stockage par batteries.

Sa compétitivité dans ce domaine lui permet de servir un autre objectif : l’internationalisation de sa monnaie. L’Arabie saoudite a accepté que le pétrole qu’elle vend à la Chine lui soit payé en renminbi (RMB) et attend en échange des investissements chinois dans les énergies renouvelables.

Obligations « pandas »

Grâce à des obligations libellées en renminbi, la Chine peut soutenir des projets dans les pays du Sud sur trois marchés : le marché obligataire panda onshore, le marché obligataire dim sum offshore et le marché obligataire offshore des zones de libre-échange (free-trade zones, FTZ), qui connaissent une forte croissance. Rappelons qu’une obligation est une dette émise par un État, une entreprise ou une collectivité locale sur un marché financier. Lorsqu’un étranger émet une dette sur un marché financier chinois, en renminbi, elle est qualifiée d’« obligation panda ». Lorsque ce titre de dette en renminbi est émis sur un marché étranger (off-shore), c’est une « obligation dim sum ».

En 2023, l’Égypte émet une obligation panda durable d’un montant de 3,5 milliards de renminbi (362 millions d’euros), avec le soutien de la Banque africaine de développement (BAD) et de la Banque asiatique d’investissement dans les infrastructures (BAII).

En 2024, c’est l’entreprise brésilienne de pâte à papier Suzano qui émet 1,2 milliard de renminbi (140 millions d’euros) en obligations vertes pandas, avec l’aide de la Banque de Chine. Ces fonds ont été affectés à des plantations d’eucalyptus qui séquestrent le carbone tout en protégeant les forêts indigènes.

Ces obligations panda sont particulièrement adaptées aux projets à grande échelle comme les fermes solaires et les stations d’épuration des eaux usées. La Chine accroît sa présence dans des financements en partie délaissés par les États-Unis, et qui sont de plus en plus souvent le fait de banques commerciales.

Elle fournit aussi des services de conseil. La Tunisie a fait appel à la Chine pour l’aider à lutter contre la pollution industrielle. Le gouvernement tunisien compte ainsi sur les capacités d’expertise chinoises pour éradiquer la pollution d’une usine de produits chimiques de Gabès (près de Sfax, au sud-est du pays) émettant des gaz toxiques entraînant des problèmes de santé pour les riverains, .

Objectif de leadership

Si la Chine participe activement à la décarbonation de l’économie, en servant un intérêt global, la lutte contre le réchauffement climatique, elle sert aussi son objectif de leadership. La domination des entreprises chinoises se renforce au fur et à mesure que les pays investissent dans les projets hydroélectriques, solaires, nucléaires notamment, comme en Afrique australe.

La Chine conforte son influence sur les pays du Sud en répondant à leur demande et en offrant une alternative à leurs relations avec les pays occidentaux, même si cela s’accompagne d’une certaine méfiance et de nombreuses tensions.

Mary-Françoise Renard ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

09.02.2026 à 15:56

Pourquoi participer à la « Fresque du climat » ne change pas durablement les comportements

Texte intégral (703 mots)

C’est un atelier pédagogique de sensibilisation au changement climatique qui jouit d’un succès grandissant. La « Fresque du climat » revendique avoir touché deux millions de personnes. Une étude inédite montre cependant que trois mois après y avoir pris part, la grande majorité des personnes n’ont pas tellement changé leur mode de vie.

C’est un dispositif qui gagne en popularité. Le principe est simple : d’abord, construire une fresque pour mieux comprendre le dérèglement climatique, son origine humaine et ses conséquences dramatiques (guerres, famines, maladies)… Puis présenter des clés pour réduire son empreinte carbone individuelle. Mais quel est l’impact réel de ces ateliers de la « Fresque du climat » ?

Pour le savoir, une étude a suivi 460 participants pendant trois mois et comparé l’évolution de leurs comportements à ceux d’un groupe qui n’y avait pas participé.

Ces résultats montrent qu’une minorité de 30 % seulement des participants a significativement modifié ses habitudes un mois plus tard. De plus, les efforts étaient concentrés dans le mois qui suivait l’atelier et disparaissaient ensuite.

Des émotions à l’action

Comment expliquer ces résultats ? Sans doute en partie par les émotions qui émergent lors de ces ateliers.

Les résultats de l'étude sont formels : les personnes les plus écoanxieuses étaient, avant même l’atelier, les plus engagées en faveur de l’environnement. Les participants qui ont ressenti un pic d’écoanxiété après l’atelier sont aussi ceux qui ont fait le plus d’efforts pour faire évoluer leurs habitudes.

Mais tout n’est pas si simple. Trois modalités d’animation de fin d’atelier ont été testées : la première insistant sur les risques ; la seconde sur les réussites et les progrès déjà accomplis ; et une troisième, qualifiée de « mixte », insistant sur les risques, puis sur les progrès.

Cette dernière était la plus efficace. Les efforts consentis par les participants des ateliers évoquant seulement les risques n’étaient pas, quant à eux, significativement différents de ceux du groupe n’ayant pas participé à l’atelier.

Des recherches montrent, de fait, que lorsque les gens ont le sentiment de perdre le contrôle d’une situation, ils ont tendance à fuir le problème, voire à nier son existence.

Inscrire le changement dans une dynamique collective

Après l’atelier, les participants sont retournés à leurs routines habituelles, souvent sans cadre pour soutenir leurs efforts. Or, la psychologie sociale montre que les changements durables sont plus probables lorsqu’ils s’inscrivent dans une dynamique collective.

Sans cet appui, les nouvelles résolutions perdent rapidement de leur attrait.

Des actions régulières, comme des ateliers de rappel, des objectifs collectifs ou des récompenses pour les progrès réalisés, pourraient donc consolider l’engagement en faveur de la transition écologique sur le long terme.

Le fait de sentir que nos actions s’intègrent à un objectif commun, que les efforts sont concédés à tous les niveaux et par tous, au sein d’un projet de société partagé qui fasse sens, est également primordial. Le poids de la norme sociale reste très puissant et si l’on sent que les autres agissent, il semblera logique d’agir également.

Cet article est la version courte de celui écrit par Hélène Jalin (Nantes Université) en mars 2025.

Service Environnement ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

08.02.2026 à 14:20

La guerre de l’énergie a déjà commencé en Ukraine : pourquoi l’Europe a tout intérêt à développer le stockage thermique

Texte intégral (2504 mots)

La guerre en Ukraine rappelle la vulnérabilité des infrastructures énergétiques, qui peuvent alors se muer en cibles militaires, pourtant proscrites en tant que telles par le droit des conflits armés : terminaux gaziers, centrales nucléaires, lignes à haute tension… Toutefois, des solutions existent pour rendre notre système énergétique plus résilient, par exemple celles fondées sur le stockage de chaleur plutôt que le simple transport d’électricité ou de gaz. Ce domaine demeure malheureusement, à l’heure actuelle, un impensé des politiques de transition énergétique.