04.02.2026 à 16:14

Pourrait-on faire fonctionner des data centers dans l’espace ?

Texte intégral (1700 mots)

Différents acteurs de la tech envisagent d’utiliser des satellites pour faire des calculs. En d’autres termes, il s’agit d’envoyer des data centers dans l’espace. Est-ce réaliste ? Un informaticien fait le point.

On parle de l’idée d’installer dans l’espace, en orbite, des data centers destinés à l’intelligence artificielle. Par exemple, en novembre 2025, Google annonçait son projet Suncatcher.

Quel crédit accorder à cette proposition ? Je vais d’abord expliquer les difficultés techniques qui font que cela semble très compliqué et coûteux pour un avantage peu clair, avant de formuler des hypothèses sur les raisons qui motivent ces annonces.

L’intelligence artificielle, c’est beaucoup de calcul

L’apprentissage automatique à grande échelle est au cœur des applications d’intelligences artificielles (IA) génératives (ChatGPT et consorts). Pour cela, il faut beaucoup de processeurs de calcul, qui consomment de l’électricité et rejettent sous forme de chaleur l’énergie ainsi consommée. Sur Terre, un grand data center de calculs d’intelligence artificielle peut consommer 100 mégawatts (MW) et au-delà ; on a même projeté la construction de data centers à 1 000 MW.

Dans l’espace, du point de vue technique, se posent alors quatre problèmes :

les composants électroniques sont irradiés par les rayons cosmiques, ce qui peut causer des pannes ;

il faut produire de l’électricité ;

il faut évacuer la chaleur produite ;

les installations ne sont pas aisément accessibles pour intervenir.

Les radiations perturbent les composants électroniques

Récemment, un Airbus A320 a fait une embardée dans le ciel, car son informatique de commande avait été touchée par des rayons cosmiques. En effet, dans l’espace et, dans une moindre mesure, en altitude (les avions de ligne volent à une dizaine de kilomètres d’altitude), l’électronique est soumise à un rude régime.

Les rayonnements cosmiques peuvent au pire détruire certains composants, au mieux perturber temporairement leur fonctionnement. Pour cette raison, les fournisseurs conçoivent pour équiper les engins spatiaux des processeurs spéciaux résistant aux rayonnements, par exemple le LEON et le NOEL-V, mais ceux-ci ont des performances de calcul modestes (par exemple, le NOEL-V, pourtant moderne, est environ dix fois plus lent qu’un seul cœur de mon ordinateur portable, qui en comporte 12). Si l’on utilise dans l’espace des composants destinés à des applications terrestres conventionnelles, les radiations peuvent provoquer des pannes qui nécessitent des redémarrages de chaque processeur, allant d’une fois toutes les quelques semaines à plusieurs fois par jour, suivant les conditions d’utilisation, d'autant plus fréquemment que le processeur est gravé finement (haute performance).

Produire suffisamment d’électricité

Les géants de la tech parlent actuellement de construire des data centers terrestres consommant de l’ordre de 1 000 MW. À titre de comparaison, les réacteurs de centrales nucléaires françaises ont des puissances électriques nominales (ce qu’elles peuvent produire à 100 % de leur puissance normale d’utilisation) entre 890 MW et 1 600 MW. En d’autres termes, un tel data center consommerait complètement la puissance d’un des petits réacteurs français.

Or, dans l’espace, pour produire de l’électricité, il faut utiliser des panneaux solaires ou des procédés plus exotiques et peu utilisés – microréacteur nucléaire ou générateur à radioéléments, ces derniers étant utilisés pour des sondes partant vers des régions éloignées du Soleil et où il serait donc difficile d’utiliser des panneaux solaires.

Aujourd’hui, les panneaux solaires de la Station spatiale internationale produisent environ 100 kilowatt (kW) de puissance, autrement dit 1 000 fois moins que ce que consomme un data center de 100 MW. Suivant l’orbite, il peut être nécessaire de gérer les périodes où le satellite passe dans l’ombre de la Terre avec des batteries (qui ont une durée de vie limitée), ou accepter que chaque satellite ne fonctionne qu’une partie du temps, ce qui pose d’autres problèmes.

Évacuer la chaleur

Il peut paraître surprenant, vu le froid de l’espace, qu’il soit difficile d’y évacuer de la chaleur. Sur Terre, nous évacuons la chaleur des data centers directement dans l’air, ou encore via des liquides pour ensuite restituer cette chaleur à l’air via une tour de refroidissement. Dans l’espace, il n’y a pas d’air à qui transférer de la chaleur, que ce soit par conduction ou par convection.

Ainsi, la seule façon d’évacuer de la chaleur dans l’espace est le rayonnement lumineux qu’émet tout objet. Quand un objet est très chaud, comme du fer chauffé à blanc, ce rayonnement est intense (et en lumière visible). En revanche, pour des objets tels qu’un ordinateur en fonctionnement ou un corps humain, ce rayonnement (en lumière infrarouge, invisible aux yeux humains mais visible à l’aide de caméras spéciales), est peu intense. Il faut donc de grandes surfaces de radiateurs pour disperser de la chaleur dans l’espace. Organiser l’évacuation de chaleur n’a rien d’évident dans un satellite…

Des problèmes très terre-à-terre

Venons-en à des problèmes plus pratiques. Quand on a un problème dans un data center sur Terre, on envoie un·e technicien·ne. Dans l’espace, cela impliquerait une mission spatiale. Certes, certaines tâches pourraient être accomplies par des robots, mais on est à des ordres de grandeur de complications par rapport à une maintenance dans un bâtiment terrestre. Or, les panneaux solaires et les autres composants ont une durée de vie limitée. Enfin, communiquer avec un satellite est plus compliqué et offre un moindre débit que d’installer un raccordement fibre optique dans une zone bien desservie sur Terre.

Bien entendu, il y aurait également la question de la masse considérable de matériel à transférer en orbite, celle du coût des lancements et de l’assemblage.

On peut également évoquer la pollution, pour l’observation astronomique, du ciel par le passage de constellations de satellites, ainsi que la pollution des orbites par les débris des satellites détruits.

En résumé, même s’il était éventuellement possible techniquement de faire des calculs d’intelligence artificielle dans un satellite en orbite (ou sur une base lunaire), cela serait à un coût considérable et au prix de grandes difficultés. Dans les propos de ceux qui annoncent des data centers spatiaux, on peine à trouver une bonne raison à tant de complications. Parmi certaines justifications avancées, celle d’échapper dans l’espace aux législations des États.

Pourquoi donc parler de mettre des data centers en orbite ?

La question intéressante, plutôt que de savoir s’il serait possible de faire un centre de calcul IA dans l’espace, est donc de savoir à qui cela profite de parler dans les médias de projets relevant plus de la science-fiction que du développement industriel réaliste. Il est bien entendu périlleux de prétendre identifier les objectifs derrière les actes de communication, mais nous pouvons fournir quelques hypothèses.

L’industrie spatiale états-unienne, notamment SpaceX, nourrit l’idée de l’espace comme dernière frontière, avec en ligne de mire l’installation sur Mars, voire la colonisation de cette planète – qu’importe qu’elle soit froide (- 63 °C en moyenne à l’équateur), à l’atmosphère très ténue, et sans protection contre le rayonnement cosmique, autrement dit très hostile à la vie.

L’industrie de l’intelligence artificielle, quant à elle, nourrit l’idée du dépassement du cerveau humain.

Ces deux industries ont un besoin intense de capitaux – par exemple, OpenAI a une dette de 96 milliards de dollars (81,2 milliards d’euros). Pour les attirer, elles ont besoin de récits qui font rêver. Toutes deux créent la « fear of missing out » (ou FOMO), la peur de passer à côté d’une évolution importante et de devenir obsolètes.

D’ailleurs, cette communication fonctionne. La preuve, j’ai rédigé cet article qui, même si c’est pour expliquer à quel point ces projets sont irréalistes, leur accorde une publicité supplémentaire…

David Monniaux ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

04.02.2026 à 11:26

Pourquoi les pénis humains sont-ils si grands ? Une nouvelle étude sur l’évolution révèle deux raisons principales

Texte intégral (2108 mots)

Comparés à ceux des autres grands singes, les pénis humains sont mystérieusement grands, ce qui suggère qu’ils pourraient servir de signal aux partenaires.

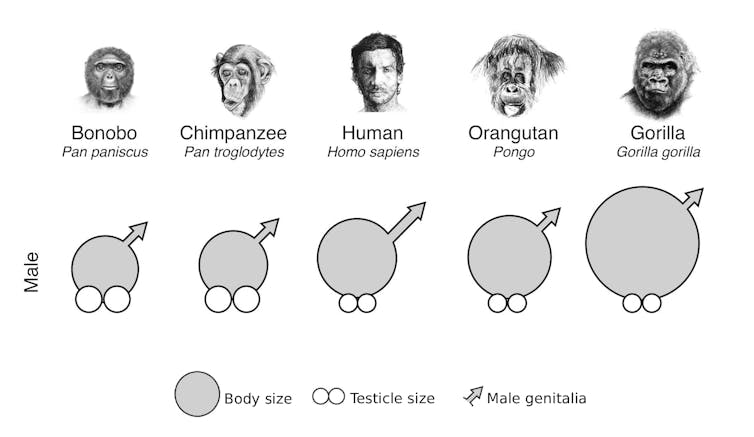

« La taille compte », c'est une phrase assez cliché, mais pour les biologistes de l’évolution, la taille du pénis humain constitue un véritable mystère. Comparé à celui d’autres grands singes, comme les chimpanzés et les gorilles, le pénis humain est plus long et plus épais que ce à quoi on pourrait s’attendre pour un primate de notre taille.

Si la fonction principale du pénis est simplement de transférer le sperme, pourquoi le pénis humain est-il si nettement plus grand que celui de nos plus proches parents ?

Notre nouvelle étude, publiée aujourd’hui dans PLOS Biology révèle qu’un pénis plus grand chez l’être humain remplit deux fonctions supplémentaires : attirer des partenaires et intimider les rivaux.

Pourquoi est-il si proéminent ?

Comprendre pourquoi le corps humain a cette apparence est une question centrale en biologie évolutive. Nous savons déjà que certaines caractéristiques physiques, comme une grande taille ou un torse en forme de V, augmentent l’attrait sexuel d’un homme

En revanche, on sait moins de choses sur l’effet d’un pénis plus grand. Les humains ont marché debout bien avant l’invention des vêtements, ce qui rendait le pénis très visible aux yeux des partenaires et des rivaux pendant une grande partie de notre évolution.

Cette proéminence aurait-elle favorisé la sélection d’une plus grande taille ?

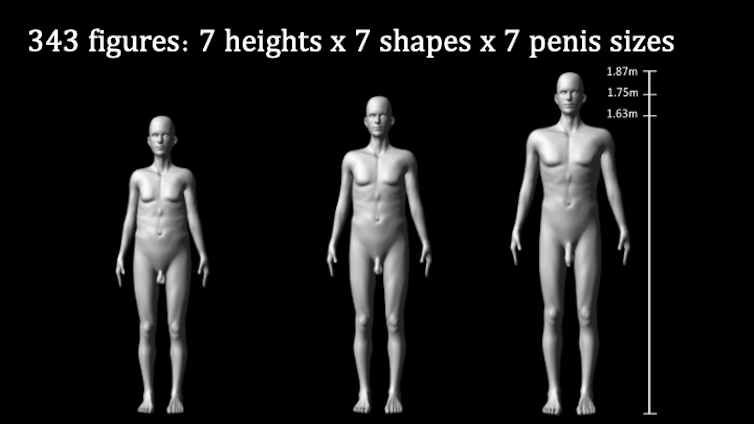

Il y a treize ans, dans une étude qui a fait date, nous avons présenté à des femmes des projections grandeur nature de 343 silhouettes masculines en 3D générées par ordinateur, anatomiquement réalistes, variant selon la taille, le rapport épaules-hanches (silhouette) et la taille du pénis.

Nous avons constaté que les femmes préfèrent généralement les hommes plus grands, avec des épaules plus larges et un pénis plus grand.

Cette étude a fait la une des médias du monde entier, mais elle ne racontait qu’une partie de l’histoire. Dans notre nouvelle étude, nous montrons que les hommes aussi prêtent attention à la taille du pénis.

Une double fonction ?

Chez de nombreuses espèces, les traits plus marqués chez les mâles, comme la crinière du lion ou les bois du cerf remplissent deux fonctions : attirer les femelles et signaler la capacité de combat aux autres mâles. Jusqu’à présent, nous ne savions pas si la taille du pénis humain pouvait elle aussi remplir une telle double fonction.

Dans cette nouvelle étude, nous avons confirmé notre conclusion précédente selon laquelle les femmes trouvent un pénis plus grand plus attirant. Nous avons ensuite cherché à déterminer si les hommes percevaient également un rival doté d’un pénis plus grand comme plus attirant pour les femmes et, pour la première fois, si les hommes considéraient un pénis plus grand comme le signe d’un adversaire plus dangereux en cas de confrontation physique.

Pour répondre à ces questions, nous avons montré à plus de 800 participants les 343 silhouettes variant en taille, en morphologie et en taille de pénis. Les participants ont observé et évalué un sous-ensemble de ces silhouettes, soit en personne sous forme de projections grandeur nature, soit en ligne sur leur propre ordinateur, tablette ou téléphone.

Nous avons demandé aux femmes d’évaluer l’attrait sexuel des personnages, et aux hommes de les évaluer en tant que rivaux potentiels, en indiquant dans quelle mesure chaque personnage leur semblait physiquement menaçant ou sexuellement compétitif.

Ce que nous avons découvert

Pour les femmes, un pénis plus grand, une stature plus élevée et un torse en forme de V augmentaient l’attrait d’un homme. Toutefois, cet effet présentait un rendement décroissant : au-delà d’un certain seuil, une augmentation supplémentaire de la taille du pénis ou de la taille corporelle n’apportait que des bénéfices marginaux.

La véritable révélation est cependant venue des hommes. Ceux-ci percevaient un pénis plus grand comme le signe d’un rival à la fois plus combatif et plus compétitif sur le plan sexuel. Les silhouettes plus grandes et au torse plus en V étaient évaluées de manière similaire.

Cependant, contrairement aux femmes, les hommes classaient systématiquement les individus présentant les traits les plus exagérés comme des concurrents sexuels plus redoutables, ce qui suggère qu’ils ont tendance à surestimer l’attrait de ces caractéristiques pour les femmes.

Nous avons été frappés par la cohérence de nos résultats. Les évaluations des différentes silhouettes ont conduit à des conclusions très similaires, que les participants aient vu les projections grandeur nature en personne ou les aient observées sur un écran plus petit en ligne.

Jugement instantané – avec des limites

Il est important de rappeler que le pénis humain a avant tout évolué pour le transfert du sperme. Néanmoins, nos résultats montrent qu’il fonctionne également comme un signal biologique.

Nous disposons désormais de preuves indiquant que l’évolution de la taille du pénis pourrait avoir été en partie guidée par les préférences sexuelles des femmes et par son rôle de signal de capacité physique entre hommes.

Il convient toutefois de noter que l’effet de la taille du pénis sur l’attractivité était quatre à sept fois plus important que son effet en tant que signal de capacité de combat. Cela suggère que l’augmentation de la taille du pénis chez l’homme a évolué davantage en réponse à son rôle d’ornement sexuel destiné à attirer les femmes qu’en tant que symbole de statut social pour les hommes, bien qu’il remplisse effectivement ces deux fonctions.

Fait intéressant, notre étude a également mis en évidence une particularité psychologique. Nous avons mesuré la rapidité avec laquelle les participants évaluaient les silhouettes. Ceux-ci étaient nettement plus rapides pour juger les silhouettes présentant un pénis plus petit, une taille plus réduite et un haut du corps moins en forme de V. Cette rapidité suggère que ces traits sont évalués inconsciemment, presque instantanément, comme moins attirants sexuellement ou moins menaçants physiquement.

Il existe bien sûr des limites à ce que révèle notre expérience. Nous avons fait varier la taille corporelle, la taille du pénis et la morphologie, mais dans la réalité, des caractéristiques telles que les traits du visage et la personnalité jouent également un rôle important dans la manière dont nous évaluons les autres. Il reste à déterminer comment ces facteurs interagissent entre eux.

Enfin, bien que nos conclusions soient valables pour des hommes et des femmes issus de différentes origines ethniques, nous reconnaissons que les normes culturelles de la masculinité varient à travers le monde et évoluent au fil du temps.

Upama Aich a reçu des financements de la Forrest Research Foundation pour travailler à l'Université d'Australie occidentale et a reçu une bourse de recherche de la Monash University pour mener cette étude.

MIchael Jennions ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

04.02.2026 à 11:26

Quand macaques et hippopotames se baignaient dans la Seine il y a 400 000 ans

Texte intégral (2495 mots)

S’il est aujourd’hui à nouveau possible de se baigner dans la Seine, pouvez-vous imaginer devoir faire attention aux hippopotames avant de plonger ? C’était bien ce que devaient faire nos ancêtres, il y a 400 000 ans. Une étude récente décrit un paysage insoupçonné.

À 15 km de Fontainebleau (Seine-et-Marne), le site de La Celle est connu depuis le XIXᵉ siècle. Il livre à cette époque quelques outils façonnés par des humains préhistoriques mais, surtout, une remarquable collection d’empreintes de végétaux et de coquilles de mollusques. Au cours de nouvelles études entamées en 2003, des restes d’hippopotame et de macaque y sont également découverts.

Notre équipe de recherche constituée d’une quinzaine de spécialistes de disciplines très variées a pu exploiter tout le potentiel de ce site pour reconstituer des conditions climatiques et environnementales particulièrement douces dans la vallée de la Seine, il y a environ 400 000 ans. Retour sur plus de vingt années de recherche dont nous avons récemment publié une synthèse.

Depuis 2,6 millions d’années, le climat de la Terre alterne entre périodes glaciaires et interglaciaires. Les périodes glaciaires sont des phases froides. Les glaciers y étaient bien plus étendus, aux pôles comme en montagne. Ces périodes durent en moyenne 80 000 ans. Les interglaciaires sont, au contraire, des phases chaudes. Elles ressemblent au climat actuel et sont plus courtes, environ 20 000 ans.

Le site de La Celle est daté par des méthodes diverses d’une de ces périodes interglaciaires survenue il y a environ 400 000 ans. Cet interglaciaire en particulier peut être considérée comme une période « modèle » pour comprendre l’évolution récente du climat, depuis une dizaine de milliers d’années, en dehors des effets du dérèglement climatique lié aux activités humaines.

La principale formation géologique observée à La Celle est ce que l’on appelle un tuf calcaire. C’est une roche sédimentaire qui se forme à l’émergence de certaines sources ou dans des cours d’eau peu profonds. Sa formation est favorisée par un climat tempéré et humide, justement typique des périodes interglaciaires. Les tufs sont des archives géologiques particulièrement intéressantes car ils fossilisent des informations riches et diversifiées sur les environnements et climats passés.

À La Celle, plusieurs milliers d’années ont été nécessaires à la formation de près de 15 mètres d’épaisseur de tuf. Dans certains niveaux les empreintes de feuilles d’arbres et de fruits sont conservées et renvoient l’image d’une végétation riche qui se développe sous des conditions plutôt chaudes : chêne, peuplier, saule… mais surtout buis, figuier et micocoulier. Au milieu du dépôt la présence d’ossements de macaque et d’hippopotame est aussi un indice de conditions climatiques clémentes.

Reconstruire les milieux du passé grâce aux escargots

Notre équipe a également étudié de petits fossiles particulièrement intéressants pour reconstituer en détail l’évolution de l’environnement : les coquilles de mollusques (escargots et limaces). Chaque escargot a des contraintes écologiques particulières et porte sur sa coquille des caractères distinctifs qui permettent même sur un petit morceau de reconnaître l’espèce à laquelle elle appartenait. Ainsi, la malacologie, discipline qui étudie ces fossiles de mollusques, permet de déduire à partir des assemblages d’escargots les milieux dans lesquels ils vivaient.

Dans le tuf de La Celle, les coquilles sont particulièrement bien conservées : plus de 42 000 individus ont été collectés, représentant 94 espèces de mollusques ! Elles sont par ailleurs présentes sur toute l’épaisseur du tuf ce qui permet de reconstituer des changements environnementaux sur plusieurs milliers d’années. La succession des faunes d’escargots de La Celle révèle trois étapes environnementales. À la base, une prairie marécageuse évolue vers une forêt de plus en plus dense. Celle-ci est contemporaine des silex taillés par les préhistoriques et des ossements de macaque et d’hippopotame. Dans la partie supérieure du dépôt, la forêt laisse place à une zone humide.

À La Celle les escargots de milieu forestier sont remarquables par leur diversité. Plusieurs espèces sont aujourd’hui éteintes où ne vivent plus que dans des contrées éloignées d’Europe centrale ou de la côte Atlantique sud. Elles constituent ce qui est nommée « la faune à Lyrodiscus » du nom d’un sous-genre d’escargot qui n’existe plus dans la faune moderne qu’aux îles Canaries. La faune à Lyrodiscus a été identifiée dans sept gisements de tuf répartis dans les vallées de la Seine, de la Somme et le sud de l’Angleterre, tous datés du même interglaciaire. Cependant, par son épaisseur exceptionnelle, le tuf de La Celle est le seul qui enregistre en détail l’émergence, le développement et la disparition de cette faune caractéristique d’une forêt tempérée et humide. La Celle sert de modèle pour positionner dans la succession forestière les séries plus courtes des autres gisements.

Des macaques et des hippopotames dans le nord de la « France »

Certaines caractéristiques chimiques du tuf lui-même renseignent sur les conditions de température et d’humidité au moment de sa formation : c’est l’étude géochimique. Ces analyses menées en parallèle de l’étude des mollusques montrent que l’optimum climatique, qui correspond aux conditions les plus chaudes et les plus humides enregistrées au cours de toute la séquence, intervient au même moment que le développement maximal de la forêt. Ces données géochimiques ont été comparées avec celles obtenues sur d’autres tufs du nord de la France datés de périodes interglaciaires plus récentes : le dernier interglaciaire, il y a environ 125 000 ans (enregistré à Caours dans la Somme) et l’interglaciaire actuel. Nous avons ainsi pu montrer que l’interglaciaire de La Celle, il y a 400 000 ans, avait été le plus chaud et le plus humide, ce qui explique, au moins en partie, la très grande richesse des faunes d’escargots, mais également la présence du macaque, de l’hippopotame et de plantes méridionales.

Par son épaisseur importante, rarement observée pour un tuf de cet âge, la diversité et la complémentarité des informations conservées, le tuf de La Celle peut maintenant être considéré comme une référence européenne pour la connaissance des changements environnementaux et climatiques au cours de la période interglaciaire survenue il y a 400 000 ans. De tels sites sont importants, car si les sédiments marins ou les couches de glace en Antarctique nous renseignent de façon spectaculaire sur les variations climatiques globales des dernières centaines de milliers d’années, il est plus complexe d’obtenir des enregistrements longs sur les séries des continents beaucoup plus soumises à l’érosion. Or, les macaques, les hippopotames… et les humains préhistoriques ne vivaient ni au fond des océans, ni au Pôle sud !

Si vous avez envie de voir à quoi ressemble ce tuf en vrai, bonne nouvelle : il est aménagé et accessible librement, alors venez le visiter !

Julie Dabkowski a reçu des financements de CNRS.

Nicole Limondin-Lozouet a reçu des financements de CNRS.

Pierre Louis Antoine a reçu des financements de CNRS

04.02.2026 à 11:26

Comment Sophie Adenot va étudier les effets de la gravité dans l’ISS

Texte intégral (1691 mots)

Pour comprendre l’effet de la gravité sur notre corps, il faut être capable de s’en soustraire, et la Station spatiale internationale est l’unique laboratoire où cela est possible sur des périodes prolongées. Sophie Adenot va pouvoir y mener différentes expériences pendant ses huit mois de mission.

Depuis plus de vingt ans, la Station spatiale internationale (ISS) est un laboratoire scientifique unique où l’absence de pesanteur met la physiologie humaine à l’épreuve. La station se déplace très vite autour de la Terre, elle est en chute libre permanente tout en restant en orbite terrestre, c’est cette configuration bien particulière qui fait que tout « flotte » à l’intérieur.

Nous parlerons plutôt d’état de micropesanteur, car il reste tout de même des accélérations minimes. Si l’astronaute dans l’ISS reste bien dans le champ de gravité de la Terre, les effets physiologiques de la gravité sur son organisme sont en revanche totalement supprimés. En conduisant des études biomédicales dans l’ISS, il s’agit non seulement de permettre à l’humain de s’adapter à un environnement extrême caractérisé par cette micropesanteur, mais aussi d’étudier le rôle de la gravité sur les grandes fonctions de notre organisme. Et comment comprendre le rôle de cette force omniprésente sur le vivant si ce n’est en étudiant la suppression de ses effets ?

Gravité et micropesanteur du niveau cellulaire jusqu’à l’organisme

Au niveau tissulaire, il existe des cellules spécialisées dont le rôle est de percevoir précisément la gravité. Ce sont par exemple les cellules ciliées du vestibule situé dans l’oreille interne chez l’humain. C’est l’organe dont la perturbation par l’absence de pesanteur contribue au mal de l’espace qui ressemble au mal de mer. La question de la faculté de graviception pour chacune de nos cellules se pose. Dans quelle mesure la force de gravité interagit-elle sur le cytosquelette, ce réseau de filaments protéiques à l’intérieur de la cellule qui lui donne sa forme et, plus généralement, sur les interactions moléculaires comme celle d’une enzyme avec son substrat ?

Au niveau de l’organisme, si la gravité n’existait pas, nul besoin d’un système cardiovasculaire aussi complexe avec ses mécanismes de protection permettant de maintenir une circulation normale au niveau du cerveau en position debout, cet organe a en effet besoin d’avoir un flux sanguin permanent et suffisant pour pouvoir fonctionner. Le tissu osseux serait inutile, au même titre que le tissu musculaire, puisqu’une partie importante du rôle de ces systèmes est de lutter contre la gravité. L’absence de pesanteur dans une station spatiale induit donc chez nos astronautes une sédentarité poussée avec toutes les conséquences médicales sur leur santé.

Déconditionnement à la gravité

La gravité a façonné le vivant depuis des millions d’années, et, de façon très surprenante, soustraire notre organisme de l’influence de cette force, même partiellement et après quelques jours seulement, conduit à une désadaptation à la gravité. C’est ce que nous appelons le déconditionnement. Ce syndrome comporte principalement un risque de syncope, une diminution de la capacité à effectuer un exercice physique, une amyotrophie, une fragilisation osseuse et des troubles métaboliques. De très nombreuses expériences sont ainsi conduites par les équipages dans l’ISS afin de comprendre l’impact de l’absence de pesanteur sur l’ensemble de nos grandes fonctions. À côté des expériences conduites dans un environnement spatial vrai, nous mettons aussi en place des études sur des analogues au sol par alitement (le sujet est rendu inactif dans un lit) ou par immersion sèche (le sujet flotte dans une grande baignoire au sec isolé par un film élastique). Il est aussi possible d’induire de courtes durées de micropesanteur (de l’ordre de trente secondes) en avion lors de vols paraboliques. Ces études, permettent de conduire des travaux sur un nombre de sujets plus importants et de valider des méthodes prophylactiques (appelées contre-mesures) afin de lutter contre ce déconditionnement, avant de les prescrire aux astronautes.

Le Centre national des études spatiales (CNES) est reconnu pour son soutien aux travaux de médecine et de physiologie spatiale ainsi que pour le développement d’outils spécifiques. Il s’appuie sur ses équipes d’ingénieurs qui ont une longue expérience dans le développement et la qualification de tels instruments biomédicaux. Il a lancé très tôt un programme dans le domaine cardiovasculaire. Citons le programme Physiolab, qui a été mis en œuvre lors de la mission Cassiopée (1996), à bord de la station Mir, par Claudie Haigneré, première astronaute française à être allée dans l’espace. Physiolab a permis une étude fine à l’échelle du battement cardiaque de la régulation cardiovasculaire. Suivre la fréquence cardiaque et la pression artérielle battement par battement permet de décrire et de comprendre la survenue des épisodes de syncope au retour sur terre. Plusieurs évolutions de ce système ont été utilisées depuis Physiolab, aboutissant aujourd’hui au programme « Physiotool ».

Le protocole Physiotool

Pour bien comprendre les effets d’un séjour dans l’espace sur le corps et surveiller de près le système cardiovasculaire des astronautes, il faut une approche intégrative qui permet de suivre non seulement les paramètres cardiovasculaires habituels, mais aussi des flux sanguins périphériques (cérébraux et musculaires), l’activation musculaire elle-même ainsi que les mouvements respiratoires.

C’est ce que permet Physiotool, développé et intégré par le CNES en combinant différents appareils biomédicaux utilisables en ambulatoire. Nous pourrons ainsi réaliser un suivi physiologique de l’astronaute au repos, lors de sessions d’exercices physiques, de stimulations cognitives ou sur de plus longues durées. Après des tests au sol, Physiotool sera utilisé en vol pour la première fois lors de la mission Epsilon.

Cet instrument développé par le CNES, en lien avec l’Agence spatiale européenne (ESA), permettra de réaliser un protocole scientifique porté conjointement par l’Université d’Angers et l’Université de Lorraine avec Benoît Bolmont. Physiotool a pour vocation de devenir un moniteur ambulatoire de la santé cardiovasculaire de l’astronaute !

Le protocole Echo-bones

La physiologie spatiale est une discipline qui favorise les études inter-systèmes. Nous souhaitons connaître dans quelle mesure les vaisseaux sanguins sont impliqués dans la fragilisation osseuse induit par l’absence de pesanteur. Le projet Echo-bones permet d’étudier à la fois la structure de l’os, mais aussi les flux vasculaires intra-osseux avec un échographe innovant.

Ce projet est particulièrement soutenu par le CNES et ouvre des perspectives en médecine pour mieux comprendre par exemple l’ostéoporose et l’arthrose. Ce protocole scientifique est porté en France par le CHU d’Angers, l’Université de Saint-Étienne (Laurence Vico) et aux Pays-Bas par l’Université de Delft (Guillaume Renaud qui est à l’origine du développement de cet échographe innovant). Dans le cadre de la mission Epsilon, des mesures en pré et post vols seront réalisées afin de quantifier les modifications osseuses induites par cette mission de longue durée.

Voici deux exemples d’études dont je suis l’investigateur principal et qui seront conduites à l’occasion de la mission Epsilon dont le décollage est prévu très prochainement. D’autres protocoles en médecine spatiale sont bien entendus mis en place avec le CNES dans le cadre de cette mission, comme Echo-Finder pour faciliter la réalisation, par un astronaute novice, en complète autonomie, d’une échographie afin d’étudier un ensemble d’organes (ce protocole est porté par l’Université de Caen). Ce système prépare les futures missions d’exploration lointaine (Lune, Mars). Et il y aura évidemment aussi tout le programme d’études scientifiques internationales réalisées régulièrement dans le domaine des sciences de la vie !

Et après ?

L’après-ISS se prépare activement (elle sera détruite en 2030), avec la programmation de futures stations spatiales, qu’elles soient privées ou issues de partenariats académiques, et qui ouvriront de nouveaux cadres pour la poursuite de nos études scientifiques et médicales. Parallèlement, des projets d’exploration spatiale se mettent en place, notamment avec les missions Artemis visant le retour très prochain sur la Lune.

Le suivi médical et physiologique des astronautes sera un point critique pour le succès de ces missions. Cette surveillance devra d’autant plus évoluer que de nouvelles problématiques médicales devront être prises en compte, comme l’exposition au régolithe (la poussière lunaire), l’augmentation des risques liés aux radiations cosmiques et l’éloignement de l’équipage dont les conséquences psychologiques doivent être anticipées.

Marc-Antoine Custaud a reçu des financements du CNES, de la région des Pays de la Loire et du CNRS. Il est président de l'ISGP, association scientifique à vocation académique (International Society for Gravitational Physiology)

04.02.2026 à 11:24

ISS : quelles expériences scientifiques va réaliser Sophie Adenot, la nouvelle astronaute française ?

Texte intégral (1687 mots)

Dans la Station spatiale internationale, les astronautes réalisent de nombreuses expériences scientifiques – c’est même le cœur de leur activité. Aujourd’hui, Rémi Canton, responsable au Centre national d’études spatiales de la préparation des expériences françaises à bord de l’ISS, nous parle des recherches scientifiques à bord.

The Conversation : Sophie Adenot, la nouvelle astronaute française, va partir un peu en avance par rapport à ce qui avait été prévu et devrait rester huit mois à bord d’ISS – ce qui est plus long que la plupart des missions ?

Rémi Canton : Oui, le départ de Sophie va peut-être être légèrement avancé à cause du retour anticipé de la mission précédente, en raison d’un problème de santé d’un des membres de l’équipage. La durée de sa mission en revanche n’est pas liée à des raisons scientifiques ou de santé, mais a été fixée par la Nasa qui souhaite réduire le nombre de lancements de rotation d’équipage pour réduire les coûts et prévoit donc que les missions à bord de l’ISS seront dorénavant plus longues.

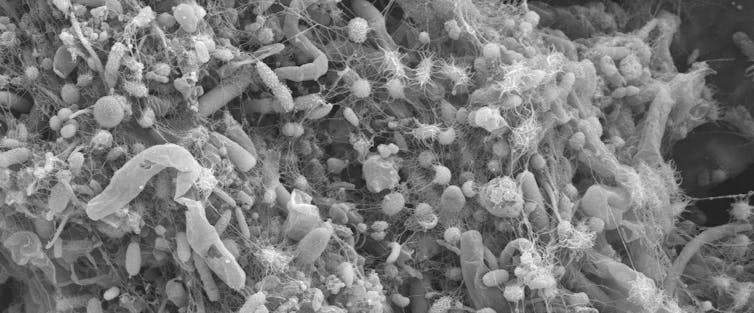

Outre les expériences de physiologie dont nous parle votre collègue Marc-Antoine Custaud dans un autre article, Sophie Adenot va travailler sur les contaminations par des microorganismes : bactéries, champignons, virus… Mais honnêtement, on n’imagine pas au premier abord une station spatiale comme un nid à microbes ! D’où viennent ces contaminations ?

R. C. : La biocontamination n’est évidemment pas une spécificité spatiale, et il n’y a pas de problème particulier identifié à bord, mais les enjeux dans un espace confiné sont importants. En premier lieu pour protéger la santé de l’équipage, mais aussi pour minimiser le temps d’entretien afin de maximiser le temps consacré aux expériences scientifiques.

Le matériel que l’on monte est bien sûr désinfecté pour éviter d’amener toute sorte de contamination dans l’ISS. Mais il peut y avoir des résidus et, avec l’équipage à bord, il y a forcément du vivant. Le corps humain contient en grand nombre tout un ensemble de bactéries, de microchampignons et autres microorganismes, que l’on appelle le microbiote. Et qui peut se propager à cause de postillons, par exemple.

Il faut donc en limiter la prolifération, dans cet environnement confiné et que l’on ne peut pas aérer !

Dans quel but étudier ces contaminations ?

R. C. : Il s’agit d’abord de protéger la santé des astronautes, mais aussi la durée de vie du matériel, qui peut être endommagé par la corrosion bactérienne. Il y a des endroits difficiles d’accès et donc compliqués à nettoyer : connectique, derrière des câbles ou des baies informatiques, par exemple.

La première étape est de caractériser les microorganismes présents dans l’ISS et qui sont responsables de la biocontamination. La deuxième étape est de trouver des matériaux et des traitements – physiques et non chimiques – de surface, c’est-à-dire des textures ou revêtements, qui ralentissent ou empêchent la prolifération des contaminants. Soit en les piégeant, soit en les repoussant pour les empêcher de s’accrocher et de proliférer derrière un biofilm protecteur. Cela se fait grâce à l’expérience Matiss-4, dernière itération d’une expérience commencée dès la mission Proxima de Thomas Pesquet en 2016. On étudie par exemple des surfaces hydrophiles et hydrophobes, des surfaces texturées avec des petits plots en silice qui font que c’est plus difficile de s’accrocher d’un point de vue microscopique.

À terme, on espère identifier les meilleurs matériaux et revêtements qui pourraient être utilisés pour les futures stations spatiales et bases lunaires, et qui répondent parfaitement à cette problématique.

À bord, Sophie Adenot n’analysera pas ces surfaces ?

R. C. : Non, Sophie accrochera ces porte-échantillons avec différents types de surfaces dans des endroits stratégiques de l’ISS, près des filtres et bouches d’aération par exemple. Ils seront exposés pendant plusieurs mois à l’environnement ISS avant d’être ramenés sur Terre bien après sa mission pour une analyse au sol par fluorescence X ou spectroscopie Raman, par les scientifiques.

En parallèle, elle utilisera un deuxième instrument, appelé MultISS, caméra multimodale et multispectrale, qui permettra de prendre des photos des surfaces dans différentes longueurs d’onde (ultraviolets notamment) pour évaluer la contamination des surfaces invisible à l’œil nu. Cela permettra d’identifier les zones qui nécessitent le plus d’attention.

Existe-t-il pour ces expériences un objectif de développement d’applications qui soient utiles sur Terre ?

R. C. : Le but du Cadmos, le service dont je m’occupe au CNES, est d’abord de répondre à des objectifs scientifiques pour améliorer la connaissance et la compréhension de phénomènes inobservables sur Terre : nous recevons des demandes de laboratoires de recherche qui veulent observer certains phénomènes physiques, biologiques ou physiologiques en impesanteur, car cela permet de s’affranchir des effets de la gravité, comme le poids, la convection thermique, la poussée d’Archimède, la sédimentation ou la pression hydrostatique. Ces chercheuses et chercheurs ne cherchent pas à aller dans l’espace ! Au contraire, pour eux c’est plus une contrainte qu’autre chose. Mais c’est le seul endroit où ils peuvent avoir accès à l’impesanteur sur de longues périodes, ce qui leur « ouvre les yeux » sur un univers invisible sur Terre.

Donc, pour répondre à votre question : les applications terrestres ne sont pas dans le cahier des charges initial, c’est le principe même de la recherche fondamentale, mais le fait est que l’on découvre ensuite une multitude d’applications terrestres possibles.

Par exemple, nous avons étudié les fluides supercritiques (des fluides sous très haute pression et très haute température) dans l’expérience DECLIC. Parmi les propriétés qui ont été découvertes : en présence d’un oxydant, l’eau supercritique dissout et oxyde les substances organiques sans dégager d’oxyde d’azote… En d’autres termes, il s’agit d’un procédé de combustion « propre », beaucoup moins polluante. Au niveau spatial, cela pourrait être très intéressant pour le traitement des déchets, par exemple, sur une base lunaire. C’est d’ailleurs ce procédé qu’utilise Matt Damon dans Seul sur Mars, avec notre expérience, pour traiter ses déchets organiques. Mais ce serait surtout une technologie très utile sur Terre, car bien moins polluante que les incinérateurs classiques. Peut-être avec un rendement moindre que dans l’ISS, car le fluide supercritique serait moins homogène qu’en impesanteur, mais ce serait une technologie issue de la recherche spatiale, et qui a d’ailleurs commencé à être déployée pour traiter les déchets de certaines usines pétrochimiques.

Au-delà des expériences scientifiques qui nous sont demandées par les chercheurs, nous travaillons aussi à la préparation des technologies nécessaires pour l’exploration habitée plus lointaine. Et même si c’est moins intuitif et que cela peut paraître paradoxal, beaucoup d’applications terrestres découlent de cette branche. Car il s’agit de répondre à des problématiques de gestion et de recyclage de l’eau, le stockage de l’énergie, le traitement des déchets ou l’autonomie en santé. Et en effet, un équipage dans une station ou sur une base spatiale doit utiliser au mieux des ressources limitées, comme nous sur Terre, à une autre échelle. L’environnement exigeant et très contraint du spatial nous force ainsi à trouver des solutions innovantes, et sert ainsi d’accélérateur de technologie. Nous avons par exemple développé des techniques pour faire de l’échographie à distance avec des sondes motorisées et pilotables à distance, qui sont utilisées aujourd’hui en télémédecine dans des déserts médicaux.

Nous parlions de prévention de biocontamination tout à l’heure : l’objectif initial était une application spatiale, mais au final l’application sera surtout terrestre, pour les milieux hospitaliers, les transports en commun (barres de métro…), les lieux publics (boutons d’ascenseur, poignées de porte…), afin d’éviter la propagation d’agents pathogènes.

En parlant de recherche fondamentale : en 2023, l’astronaute danois Andy Morgensen a fait une mousse au chocolat pour étudier la formation d’émulsions en micropesanteur. Est-ce que Sophie Adenot va tester une nouvelle recette ?

R. C. : Oui, mais plus pour le plaisir que pour la science, cette fois-ci ! Nous avons juste décidé d’intégrer un objectif supplémentaire par rapport à la mousse au chocolat : dans un scénario réaliste, il n’y aura ni cacaotier ni d’œufs sur une base lunaire… Sophie va réaliser ce coup-ci une recette incorporant des ingrédients que des astronautes pourraient un jour faire pousser sur une base spatiale. Au menu : houmous et caviar d’aubergine !

Rémi Canton ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

03.02.2026 à 15:26

Une nouvelle carte de la matière noire

Texte intégral (2168 mots)

Depuis plus d’un siècle, les astronomes n’ont cessé d’étudier les galaxies, découvrant peu à peu la diversité de leurs formes et de leurs propriétés. Grâce aux progrès de nos instruments d’observation, nous avons pu cartographier la position de millions de galaxies dans l’Univers proche. De vastes régions de l’Univers se révèlent très vides, traversées par d’immenses filaments qui relient des régions où les galaxies se regroupent. Sous l’effet de la gravité, les galaxies sont entraînées inexorablement les unes vers les autres pour façonner ces immenses structures, qui grandissent au fil des milliards d’années de temps cosmique qui s’écoule.

L’étude d’une de ces structures, l’amas de Coma, par Fritz Zwicky en 1933 a mis au jour un des aspects les plus mystérieux de notre compréhension de l’Univers : la majeure partie de la masse de Coma ne peut pas être expliquée par la présence de matière ordinaire.

Les études cosmologiques les plus modernes confirment que le gaz et les étoiles ne représentent qu’environ un sixième de la masse totale de l’Univers. Le reste ? Une matière invisible, baptisée matière noire par les physiciens. L’une des plus grandes énigmes de la physique moderne reste entière : de quoi cette matière noire est-elle faite ? Comme interagit-elle avec la matière ordinaire ? Comment sa présence impacte-t-elle la formation et l’évolution des galaxies ?

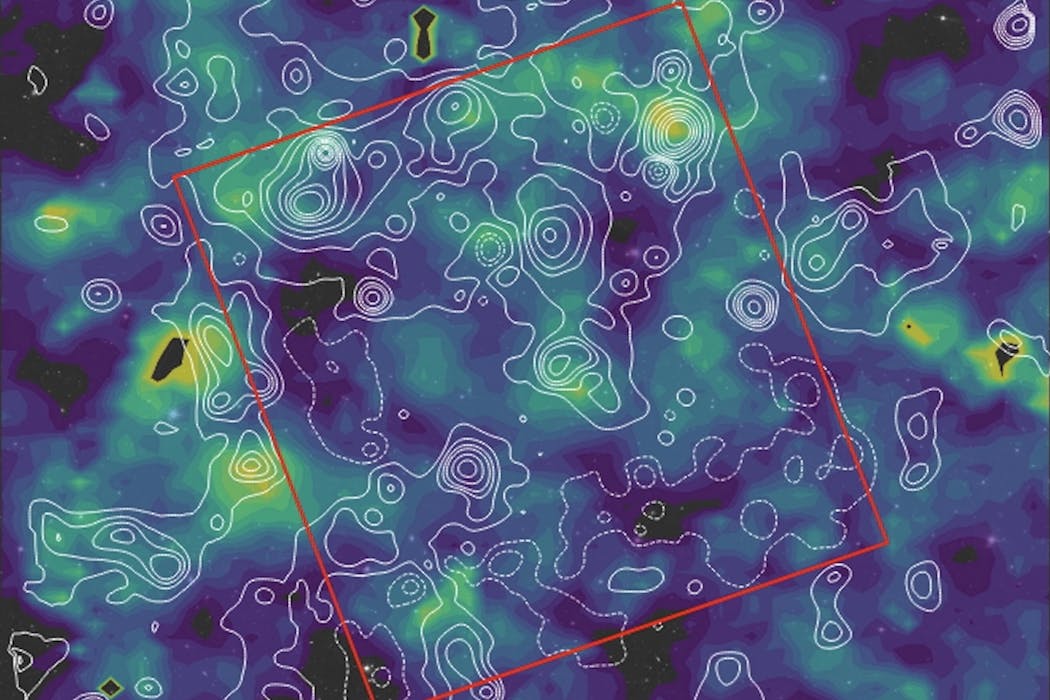

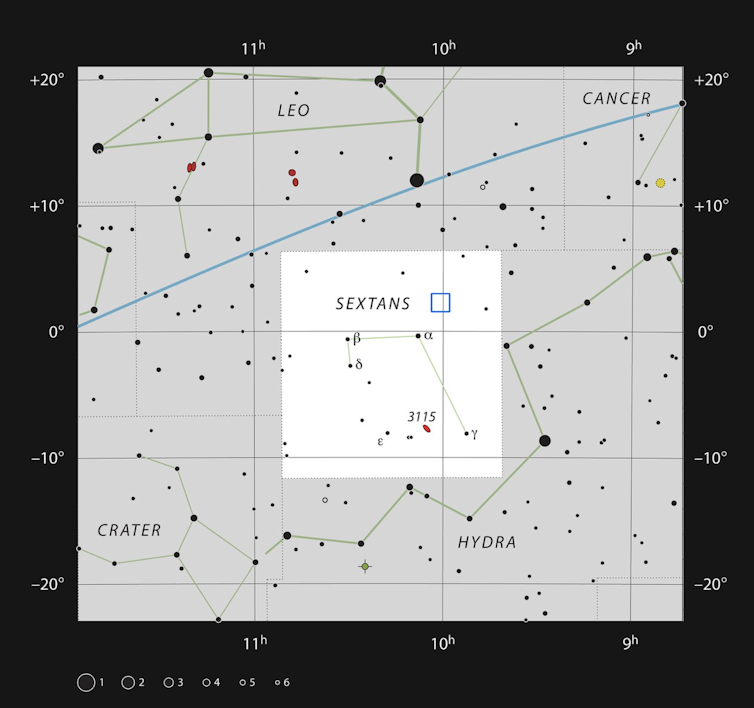

Dans notre étude publiée dans Nature Astronomy, et dirigée par Diana Scognamiglio du Jet Propulsion Laboratory de la Nasa, nous présentons une carte détaillée de la distribution de la matière noire. Bien que notre étude ne puisse pas répondre directement à la question fondamentale sur la nature de la matière noire, elle apporte un outil puissant pour relier la matière ordinaire et la matière noire, sur un intervalle de temps cosmique couvrant les deux tiers de l’âge de l’Univers.

Notre nouvelle carte montre en particulier que la matière noire et la matière visible évoluent conjointement.

Comment cette découverte a-t-elle pu être réalisée ?

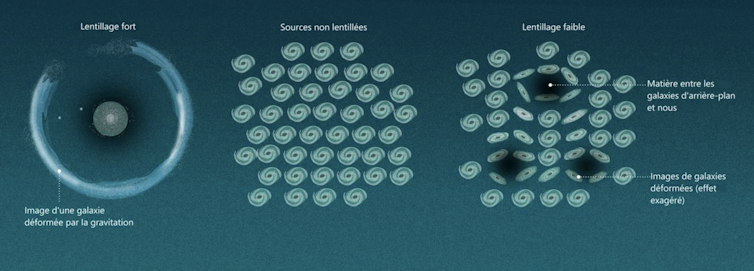

Dans cette étude, nous avons employé l’une des méthodes les plus puissantes pour révéler la présence de matière noire : le lentillage gravitationnel faible. La présence d’une grande structure de matière noire va entraîner une déformation de l’espace-temps. La lumière d’une galaxie qui se trouve en arrière-plan va être légèrement déviée en traversant la structure. La forme de cette galaxie d’arrière-plan va donc se trouver artificiellement étirée quand sa lumière atteindra nos télescopes.

La clé de notre méthode réside dans l’accumulation de données : en observant un grand nombre de galaxies dans une petite région du ciel, nous pouvons détecter une distorsion cohérente de la forme des galaxies d’arrière-plan et en déduire la masse de la structure en avant-plan.

Pour bâtir une carte de ces déformations de l’espace-temps, il est donc essentiel de mesurer la forme d’un grand nombre de galaxies.

Près de 255 heures d’observation sur le télescope spatial James-Webb ont permis de couvrir une zone beaucoup plus vaste que celles observées précédemment (environ la surface de trois pleines lunes), avec des détails sans précédent sur la forme des galaxies.

En analysant en détail 250 000 galaxies lointaines (distance, morphologie, masse), nous avons mesuré la densité de matière noire d’avant-plan et créé ainsi une carte de la matière noire dans cette région du ciel.

En effet, notre carte de lentille gravitationnelle faible retrace la distribution projetée de la matière totale, sombre et lumineuse, à travers les amas de galaxies, les filaments et les régions sous-denses. Les pics proéminents correspondent à des amas massifs.

En quoi cette recherche est-elle importante ?

Notre équipe étudie cette région du ciel, baptisée « COSMOS », depuis plus de vingt ans. En comparant cette nouvelle carte de matière noire avec les données accumulées sur les galaxies et le gaz chaud, nous voyons que la matière noire, le gaz chaud et les galaxies retracent souvent les mêmes structures.

En d’autres termes, cette carte nous montre que la matière noire et la matière visible évoluent conjointement.

De plus, COSMOS est aujourd’hui le champ de référence pour les études sur l’évolution des galaxies. Il fournit désormais un repère haute résolution à partir duquel les futures cartes de l’univers sombre pourront être calibrées et comparées.

Quelles sont les suites de ces recherches ?

La prochaine étape consiste à étendre cette cartographie à des volumes beaucoup plus importants de l’Univers à l’aide de missions telles que Euclid de l’Agence spatiale européenne (ESA) et le télescope spatial Nancy-Grace-Roman de la Nasa qui couvriront jusqu’à un tiers du ciel. Tous ces télescopes utilisent COSMOS comme point d’étalonnage.

Tout savoir en trois minutes sur des résultats récents de recherches commentés et contextualisés par les chercheuses et les chercheurs qui les ont menées, c’est le principe de nos « Research Briefs ». Un format à retrouver ici.

Le projet instruire l’émergence des galaxies massives et leur évolution — iMAGE est soutenu par l’Agence nationale de la recherche (ANR), qui finance en France la recherche sur projets. L’ANR a pour mission de soutenir et de promouvoir le développement de recherches fondamentales et finalisées dans toutes les disciplines, et de renforcer le dialogue entre science et société. Pour en savoir plus, consultez le site de l’ANR.

Olivier Ilbert a reçu des financements de l'ANR et du CNES (projet HST-COSMOS).

02.02.2026 à 14:41

Allumer la lumière pour éteindre la douleur chez les rongeurs

Texte intégral (1434 mots)

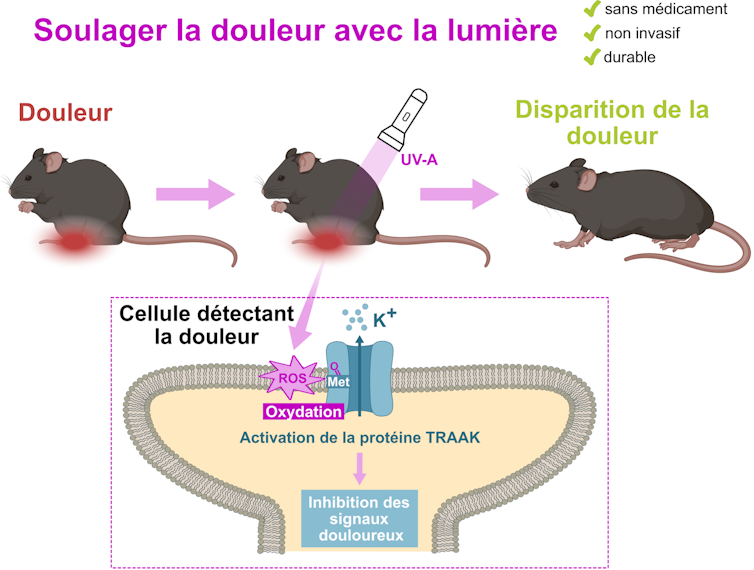

Allumer la lumière pour éteindre la douleur. Ce slogan résume bien notre découverte : une simple lumière dans l’UV-A supprime la douleur chez les rongeurs, sans aucun médicament et de manière plus efficace et durable que l’ibuprofène. Cette méthode, que nous avons appelée Light-Induced Analgesia, récemment publiée dans Nature Communications, le 26 janvier 2026, pourrait améliorer le bien-être animal et bouleverser les pratiques vétérinaires dans le cadre de l’expérimentation animale, mais aussi lors de la prise en charge des nouveaux animaux de compagnie, comme les hamsters, les chinchillas et même les tortues ou les boas.

Comment est née cette méthode antidouleur reposant sur la lumière ?

Comme Pasteur l’a dit, « le hasard ne favorise que les esprits préparés ». Effectivement, toute notre étude repose sur une observation inattendue que nous avons faite lors d’une expérience témoin : une protéine appelée TRAAK s’active (en d’autres mots, elle se met en marche), lorsqu’elle est éclairée avec de la lumière UV-A.

Aussi fortuite qu’elle puisse paraître, cette observation nous a souri puisque l’activité principale de notre laboratoire porte sur TRAAK et les protéines qui lui sont proches.

TRAAK est une protéine présente dans les récepteurs de la douleur et freine la transmission des messages douloureux vers le cerveau quand elle est dans son état actif. D’où notre idée : activer ces protéines des récepteurs de la douleur présents dans la peau avec de la lumière et ainsi inhiber les récepteurs de la douleur. Cela empêcherait alors les messages nerveux d’atteindre le cerveau, et induirait donc une analgésie.

Pour vérifier cela, nous avons illuminé les pattes de souris et avons testé leur sensibilité mécanique en déterminant la pression à appliquer pour déclencher leur réflexe de retrait de la patte. Cette procédure, couramment utilisée en expérimentation animale et humaine n’induit aucune douleur chez la souris puisque le réflexe est déclenché physiologiquement avant que la souris ne ressente la douleur. Nous avons ainsi pu montrer que, après le traitement à la lumière, il faut trois fois plus de force pour induire le retrait, ce qui veut dire que les pattes des souris deviennent trois fois moins sensibles, que ce soit sur des souris saines ou soumises à une douleur chronique pour une durée allant jusqu’à six heures. Nous avons même démontré que cet effet est plus efficace et durable que les antidouleurs utilisés couramment, comme l’ibuprofène ou la crème anesthésiante Emla (souvent utilisée lors de la vaccination).

Pourquoi cette découverte est-elle importante ?

Ce nouveau traitement est non invasif, peu coûteux et simple à mettre en place. De plus, l’analgésie induite par la lumière (LIA) ne requiert aucune injection ni traitement médicamenteux et permet de s’affranchir de tout effet secondaire ou d’interaction médicamenteuse. Ce dernier point en fait une véritable aubaine en expérimentation animale, en proposant une solution pour soulager la douleur sans avoir de répercussion sur les conclusions des expériences.

En effet, dans le cadre des expériences précliniques sur rongeurs, bien contrôler la douleur est essentiel, à la fois pour le bien-être des animaux et pour la fiabilité des résultats scientifiques. Une douleur mal prise en charge peut en effet modifier le fonctionnement de l’organisme et fausser les observations et conclusions de l’étude. Les solutions actuelles pour soulager la douleur reposent essentiellement sur des médicaments qui sont efficaces mais susceptibles d’induire des effets secondaires pouvant modifier les paramètres biologiques étudiés et ainsi fausser les résultats et conclusions de l’étude.

Au-delà du cadre de l’expérimentation animale, la LIA pourra être appliquée aux nouveaux animaux de compagnie pour une analgésie locale, rapide et robuste. Par exemple, un vétérinaire pourrait l’employer pour rendre plus supportable le nettoyage d’un abcès chez les hamsters.

Quelles sont les suites de cette étude ?

La LIA n’est pas applicable chez l’humain, une unique différence dans la séquence de TRAAK rend la lumière inefficace sur la version humaine de la protéine : la lumière n’aura donc aucun effet antidouleur.

Nous sommes tout de même très excités, car notre étude identifie TRAAK comme une cible prometteuse pour le développement de nouveaux traitements antidouleur, y compris chez l’humain (en l’activant d’une manière différente). Nous allons donc poursuivre nos travaux pour développer des molécules activant TRAAK et proposer une stratégie potentiellement plus efficace et plus ciblée que les antidouleurs disponibles actuellement sur le marché.

Enfin, même si nous avons déterminé le mécanisme moléculaire à l’origine de l’activation de TRAAK par la lumière, une question subsiste : pourquoi certaines espèces possèdent-elles une version activable à la lumière ? Cela joue-t-il un rôle physiologique, par exemple au niveau du rythme nocturne/diurne des espèces ou encore dans la vision ? Nous comptons bien trouver des explications en étudiant quelles espèces possèdent une protéine TRAAK sensible à la lumière et leurs caractéristiques écologiques.

Tout savoir en trois minutes sur des résultats récents de recherches commentés et contextualisés par les chercheuses et les chercheurs qui les ont menées, c’est le principe de nos « Research Briefs ». Un format à retrouver ici.

Marion Bied a reçu des financements de la Fondation pour la Recherche Médicale (FRM).

Guillaume Sandoz a reçu des financements de la Fondation pour la Recherche Médicale, l'Agence Nationale de la Recherche

01.02.2026 à 10:17

Une piste vers des stations de traitement d’eau plus sobres en énergie grâce aux bactéries… électriques

Texte intégral (2146 mots)

Le traitement des eaux usées est essentiel pour éviter la pollution de l’environnement et ses impacts potentiels sur la santé humaine. Différentes pistes existent pour rendre les stations d’épuration plus efficientes, et donc réduire le prix de l’eau.

En France, le coût du traitement de l’eau (ou « assainissement collectif ») représente 40 % de son prix de vente. Un ménage paie en moyenne 260 euros par an juste pour l’assainissement… dont plus de 35 euros directement imputable à la consommation d’énergie des stations d’épuration.

Au vu de la volatilité du prix de l’énergie, de nouvelles solutions émergent pour réduire drastiquement la consommation énergétique des stations de traitement. Des solutions qui utilisent des bactéries électriques !

Traitement de l’eau – comment ça marche ?

Les technologies d’épuration des eaux usées sont connues de longue date et très matures. Leur principe est relativement simple : il s’agit de soustraire (ou mieux, d’éliminer) les polluants de l’eau, du plus gros au plus petit. Dans ces étapes, celle dite d’aération est une étape clef… mais c’est également la principale consommatrice d’énergie !

Le processus commence en général par des grilles et tamis permettant de retirer la fraction solide volumineuse (branches, détritus, cailloux…) présente les eaux usées à l’entrée de la station.

Vient alors l’étape de séparation du sable (grosses particules) qui décante assez facilement au fond du bassin de traitement, et des huiles moins denses que l’eau, récupérées à la surface.

Les particules plus légères sont encore trop nombreuses et trop lentes à décanter au fond du bassin – certaines peuvent mettre des mois à décanter ! Des lamelles insérées en biais permettent de les rapprocher du fond du bassin, et de diminuer ainsi leur temps de décantation. Des produits chimiques sont également ajoutés (floculants) pour agréger les particules entre elles et les rendre plus lourdes. On parle de traitement primaire.

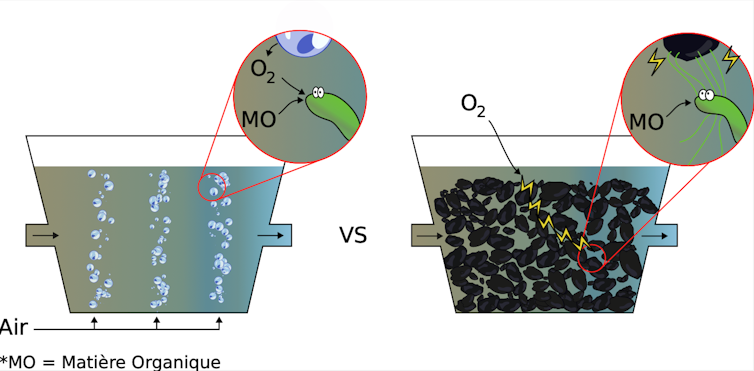

Ensuite, le bassin d’aération constitue le cœur de la station de traitement. Il s’agit tout simplement d’aérer l’eau en permanence pendant un certain temps grâce à des bulleurs au fond du bassin. Cette aération permet à des microorganismes de se développer et de décomposer toute la matière organique encore présente. Sans cette aération, les microorganismes efficaces ne se développent plus, l’eau croupit, et la matière organique se dégrade peu (pensez à l’eau des tourbières, ou simplement celle des flaques d’eau qui ne sont jamais remuées). L’aération est le principal poste de consommation de la station, responsable de 40 à 80 % de l’énergie utilisée. Cette énergie est nécessaire au fonctionnement des pompes et surpresseurs employés pour injecter de l’air en continu dans le bassin. On parle de traitement secondaire.

Dans la plupart des stations d’épuration existantes, à la suite du traitement biologique par aération, l’eau passe de nouveau dans un bassin de décantation (décantation secondaire ou clarificateur) pour faire sédimenter les milliards de bactéries mortes.

Enfin, l’eau est rejetée dans la nature.

Repenser le système grâce à d’autres microorganismes

Il existe donc un enjeu important dans le monde de l’assainissement : comment limiter la consommation d’énergie liée à l’aération, tout en traitant aussi bien les eaux usées et sans faire exploser les coûts ?

Car si l’aération fonctionne aussi bien, c’est parce qu’elle permet une oxygénation de l’eau, et que les microorganismes qui se développent dans les milieux oxygénés sont très efficaces pour dégrader la matière organique.

En effet, l’oxygène est un élément naturellement oxydant, c’est-à-dire qu’il est avide d’électrons. À l’inverse, la matière organique est riche en électrons du fait de son important nombre de liaisons Carbone. La présence d’oxygène facilite la rupture des liaisons Carbone, les électrons libérés étant transférés vers l’oxygène. Ce transfert est naturellement lent (heureusement, sinon, nous brûlerions instantanément), mais il est accéléré par la présence des bactéries, véritables usines de décomposition). C’est bien ce qui est souhaité dans cette étape : casser les chaînes de carbone jusqu’à obtenir des éléments simples, non assimilables par des bactéries pathogènes en aval dans les cours d’eau.

Si l’on décide de se passer d’aération, l’oxygène devient difficilement accessible, et la dégradation peu efficace. Sauf si on utilise des microorganismes un peu spéciaux.

Par exemple, à Villeurbanne (Rhône), une station d’épuration utilise des microorganismes capables de digérer les boues des stations d’épuration et de fabriquer du méthane, qui est injecté dans le réseau de gaz de ville.

Dans notre groupe de recherche, nous explorons une autre piste : celle des bactéries électriques !

Éviter l’aération grâce aux bactéries « électriques »

Dès le début des années 2000, les chercheurs ont redécouvert des bactéries « électriques ». Ces bactéries, telles des araignées dans le monde microscopique, ont la capacité de fabriquer des fils de taille nanométrique, qui ont la curieuse propriété d’être conducteurs électriques. Nul besoin d’oxygène en leur sein : il suffit de se connecter à un oxydant externe, qui peut être plus loin. Imaginez-vous être capable de respirer grâce à un fil dont un bout reste exposé à l’air libre, peu importe l’endroit dans lequel vous vous trouvez.

Pour en revenir au traitement de l’eau, voici l’idée : plutôt que d’amener l’oxygène aux bactéries par l’aération, les bactéries électriques présentes dans tout le bassin se connectent à un matériau conducteur présent sur toute la colonne d’eau et s’y développent. Ainsi, les bactéries sont connectées à l’oxygène de la surface. Pour cela, l’eau transite dans des structures en carbone conducteur appelées « biofiltres électro-actifs », sur lesquelles se développent les bactéries électriques. Plus besoin d’aérer : si un chemin électrique existe entre la bactérie et l’air ambiant, elle dégradera presque aussi bien la matière organique l’environnant.

L’avantage est considérable : une fois installé, le système est passif, nécessite un faible entretien, et régénérable à l’infini. Ces systèmes sont déjà proposés à la vente pour les petites stations de traitement, notamment par la start-up espagnole METfilter.

Cerise sur le gâteau : ces bactéries « électriques » existent spontanément dans l’environnement, elles n’ont pas à être artificiellement ajoutées au système et sont sélectionnées naturellement par la présence du matériau carboné.

Si cette piste nous semble prometteuse pour diminuer la facture d’électricité des stations d’épuration, ces bactéries ne dégradent pas tout : résidus de médicaments, PFAS, et autres substances résiduelles dans notre eau traversent encore les stations de traitement, et se retrouvent disséminées dans l’environnement. Les solutions techniques étant encore très énergivores, chaque économie d’énergie sur l’ensemble de la chaîne est un pas vers un traitement plus vertueux de nos eaux usées.

Le projet IRONTECH est soutenu par l’Agence nationale de la recherche (ANR) qui finance en France la recherche sur projets. L’ANR a pour mission de soutenir et de promouvoir le développement de recherches fondamentales et finalisées dans toutes les disciplines, et de renforcer le dialogue entre science et société. Pour en savoir plus, consultez le site de l’ANR.

Grégory Bataillou a travaillé comme Post-Doctorant sur le financement ANR appelé IRONTECH qui vise à utiliser du Fer et des bactéries actives pour dénitrifier les effluents agro-industriels.

29.01.2026 à 16:03

Quel type de télétravailleur êtes-vous ? Quand les maths éclairent votre profil

Texte intégral (1564 mots)

Chaque jour, sans même y penser, nous classons les choses : ranger les livres de la bibliothèque selon le genre, classer les e-mails… Mais comment classer des éléments quand on ne dispose pas d’une classification existante ? Les mathématiques peuvent répondre à ce type de questions. Ici, une illustration sur le télétravail.

Dans le cadre du télétravail, nous nous sommes posé la question de savoir si les télétravailleurs peuvent être regroupés en fonction de leur perception de l’autonomie et du contrôle organisationnel.

Ceci nous a permis de justifier mathématiquement que deux grandes classes de télétravailleurs existent, et que leur vision du télétravail diffère. Ceci peut permettre aux managers et aux services de ressources humaines d’adapter le management de chacun en fonction de son profil.

Classer, c’est mesurer la similarité

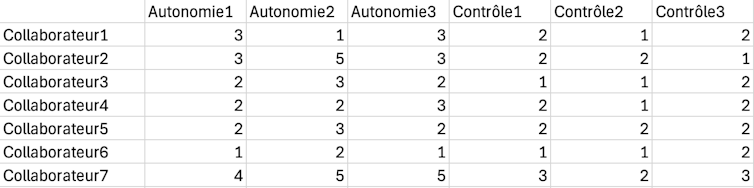

Nous avons considéré 159 télétravailleurs. Pour classer les individus, il faut d’abord mesurer à quel point ils se ressemblent. Pour cela on identifie des « profils type » à partir de l’évaluation de « construits », qui sont des ensembles de critères qui traitent le même sujet.

Dans notre étude, les construits principaux sont le contrôle et l’autonomie. On évalue ces deux construits grâce à plusieurs questions posées aux télétravailleurs, par exemple « J’ai l’impression d’être constamment surveillé·e par l’utilisation de la technologie à la maison ». Ceux-ci donnent leur réponse sur une échelle en 5 points (de 1-pas du tout d’accord à 5-tout à fait d’accord).

Ensuite, chaque télétravailleur est représenté par une ligne de données : ce sont les réponses du télétravailleur dans l’ordre des critères. Par exemple pour le collaborateur 1, on peut voir les réponses (3, 1, 3, 2…), voir figure.

Pour regrouper les télétravailleurs, il faut d’abord mesurer à quel point ils se ressemblent. Pour cela, on mesure la distance entre les profils (en utilisant des distances euclidiennes). Cette notion de distance est très importante, car c’est elle qui quantifie la similitude entre deux télétravailleurs. Plus deux profils sont proches, plus ils auront vocation à être dans la même classe.

Si on considère autant de classes que de personnes, la séparation est parfaite mais le résultat est sans intérêt. L’enjeu est donc double : avoir un nombre raisonnable de classes distinctes tel que, dans chaque classe, les individus soient suffisamment semblables.

À lire aussi : Maths au quotidien : pourquoi votre assurance vous propose un contrat avec franchise

Combien de classes choisir ?

Nous avons utilisé la méthode de classification ascendante hiérarchique, qui consiste à regrouper les individus les plus semblables possibles dans une même classe tandis que les classes restent dissemblables.

Plus précisément, au début, chaque télétravailleur est traité comme une classe et on essaie de regrouper deux ou plusieurs classes de manière appropriée pour former une nouvelle classe. On continue ainsi « jusqu’à obtenir la classe tout entière, c’est-à-dire l’échantillon total ». L’arbre aussi obtenu (dendrogramme) peut être coupé à différents niveaux.

Une question importante se pose alors : comment choisir le nombre de classes ? Il existe plusieurs méthodes. Par exemple, la méthode du coude : le point où la courbe (variance intra-classe en fonction du nombre de classes) « fait un coude » correspond au nombre de classes à retenir. Cela signifie que si « on ajoute une classe de plus, on gagne peu en précision ». Dans notre étude, le nombre de classes retenu est deux.

Afin d’améliorer notre classification, nous poursuivons avec une méthode de classification non hiérarchique (k-means) qui répartit à nouveau les télétravailleurs dans deux classes (mais ceux-ci sont légèrement différents) tout en minimisant la distance aux « centres » de classes (scores moyens des critères de chaque classe trouvés précédemment).

Nous découvrons alors deux classes de télétravailleurs mieux répartis : les « satellites-autonomes » et les « dépendants-contrôlés ».

La classification au service du manager

Une fois la classification trouvée, on s’intéresse alors à analyser les scores moyens par rapport aux autres construits du modèle, en l’occurrence l’expérience du télétravailleur. Les « satellites autonomes » ont une vision globalement plus positive de leur travail que les « dépendants contrôlés » et estiment que leurs conditions de travail se sont améliorées depuis la mise en place du télétravail.

Il existe bien sûr des limites à notre étude : il faudra en tester la robustesse, répéter l’analyse avec des sous-échantillons ou d’autres échantillons de télétravailleurs et encore tester plusieurs méthodes de classification. Une nouvelle enquête pourra montrer si le nombre ou la nature des classes que nous avons trouvées évolue. Mais il est important de noter que ce résultat (deux profils de télétravailleurs) est le fruit d’une démarche mathématique et statistique rigoureuse, qui complète les études antérieures qualitatives.

La classification est un outil bien connu en matière de gestion des ressources humaines. Par exemple, elle consiste à « peser » le poste et le positionner dans une grille prédéfinie en comparant son profil aux caractéristiques de quelques postes repères. Chaque convention collective dispose d’une grille de classification. C’est la loi du 23 décembre 1946 et les arrêtés Parodi-Croizat du 11 avril 1946 qui avaient ouvert la voie de la classification des ouvriers en sept échelons.

À l’aide des mathématiques, notre classification montre que le télétravail ne peut pas être géré comme un dispositif unique. Chaque profil correspond à des besoins et à des dynamiques organisationnelles spécifiques. Savoir qu’il existe deux profils majoritaires permet de proposer des actions différenciantes dans l’accompagnement des télétravailleurs.

Les mathématiques sont ici un outil au service du manager et aident à voir des structures invisibles dans un ensemble complexe de données. Il s’agit d’un outil d’aide à la décision.

Rien à déclarer

Caroline Diard et Niousha Shahidi ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.

29.01.2026 à 16:03

L’IA arrive dans le jugement olympique. Qu’est-ce qui pourrait (bien) se passer ?

Texte intégral (2007 mots)

Alors que le Comité international olympique (CIO) adopte le jugement assisté par l’intelligence artificielle, cette technologie promet une plus grande cohérence et une meilleure transparence. Pourtant, les résultats de la recherche suggèrent que la confiance, la légitimité et les valeurs culturelles comptent autant que la précision technique.

En 2024, le CIO a dévoilé son agenda olympique de l’intelligence artificielle (IA), positionnant celle-ci comme un pilier central des futurs Jeux olympiques. Cette vision a été renforcée lors du tout premier Forum olympique sur l’IA, organisé en novembre 2025, où athlètes, fédérations, partenaires technologiques et décideurs politiques ont discuté de la manière dont l’IA pourrait soutenir le jugement, la préparation des athlètes et l’expérience des fans.

Aux Jeux olympiques d’hiver de 2026 de Milan-Cortina qui démarrent vendredi 6 février, le CIO envisage d’utiliser l’IA pour soutenir le jugement en patinage artistique (épreuves individuelles et en couple, hommes et femmes), en aidant les juges à identifier précisément le nombre de rotations effectuées lors d’un saut.

Son utilisation s’étendra également à des disciplines, telles que le big air, le halfpipe et le saut à ski (des épreuves de ski et de snowboard où les athlètes enchaînent des sauts et figures aériennes), où des systèmes automatisés pourront mesurer la hauteur des sauts et les angles de décollage. À mesure que ces systèmes passent de l’expérimentation à un usage opérationnel, il devient essentiel d’examiner ce qui pourrait bien se passer… ou mal se passer.

Sports jugés et erreurs humaines

Dans les sports olympiques tels que la gymnastique et le patinage artistique, qui reposent sur des panels de juges humains, l’IA est de plus en plus présentée par les fédérations internationales et les instances sportives comme une solution aux problèmes de biais, d’incohérence et de manque de transparence. En effet, les juges doivent évaluer des mouvements complexes réalisés en une fraction de seconde, souvent depuis des angles de vue limités, et ce pendant plusieurs heures consécutives.

Les analyses post-compétition montrent que les erreurs involontaires et les divergences entre juges ne sont pas des exceptions. Cela s’est à nouveau matérialisé en 2024, lorsqu’une erreur de jugement impliquant la gymnaste américaine Jordan Chiles lors des Jeux olympiques de Paris a déclenché une vive polémique. En finale du sol, Chiles avait initialement reçu une note qui la plaçait à la quatrième place. Son entraîneur a alors introduit une réclamation, estimant qu’un élément technique n’avait pas été correctement pris en compte dans la note de difficulté. Après réexamen, la note a été augmentée de 0,1 point, permettant à Chiles d’accéder provisoirement à la médaille de bronze. Cette décision a toutefois été contestée par la délégation roumaine, qui a fait valoir que la réclamation américaine avait été déposée hors délai, dépassant de quatre secondes la fenêtre réglementaire d’une minute. L’épisode a mis en lumière la complexité des règles, la difficulté pour le public de suivre la logique des décisions, et la fragilité de la confiance accordée aux panels de juges humains.

Par ailleurs, des cas de fraude ont également été observés : on se souvient notamment du scandale de jugement en patinage artistique lors des Jeux olympiques d’hiver de Salt Lake City en 2002. À l’issue de l’épreuve en couple, des accusations ont révélé qu’une juge aurait favorisé un duo en échange d’un soutien promis dans une autre compétition, mettant au jour des pratiques d’échanges de votes au sein du panel de juges. C’est précisément en réponse à ce type d’incidents que des systèmes d’IA ont été développés, notamment par Fujitsu en collaboration avec la Fédération internationale de gymnastique.

Ce que l’IA peut (et ne peut pas) corriger dans le jugement

Nos recherches sur le jugement assisté par l’IA en gymnastique artistique montrent que la question ne se résume pas à savoir si les algorithmes sont plus précis que les humains. Les erreurs de jugement proviennent souvent des limites de la perception humaine, ainsi que de la vitesse et de la complexité des performances de haut niveau, ce qui rend l’IA attrayante. Cependant, notre étude impliquant juges, gymnastes, entraîneurs, fédérations, fournisseurs de technologies et fans met en lumière une série de tensions.

L’IA peut être trop exacte, évaluant les routines avec un niveau de précision qui dépasse ce que les corps humains peuvent réalistement exécuter. Par exemple, là où un juge humain apprécie visuellement si une position est correctement tenue, un système d’IA peut détecter qu’un angle de jambe ou de bras s’écarte de quelques degrés seulement de la position idéale, pénalisant une athlète pour une imperfection imperceptible à l’œil nu. Si l’IA est souvent présentée comme objective, de nouveaux biais peuvent émerger à travers la conception et la mise en œuvre des systèmes. Par exemple, un algorithme entraîné principalement sur des performances masculines ou sur des styles dominants peut pénaliser involontairement certaines morphologies. En outre, l’IA peine à prendre en compte l’expression artistique et les émotions, des éléments considérés comme centraux dans des sports tels que la gymnastique et le patinage artistique. Enfin, si l’IA promet une plus grande cohérence, son maintien exige une supervision humaine continue afin d’adapter les règles et les systèmes à l’évolution des disciplines.

Les sports d’action ont une autre logique

Nos recherches montrent que ces préoccupations sont encore plus marquées dans les sports d’action comme le snowboard et le ski freestyle. Beaucoup de ces disciplines ont été ajoutées au programme olympique afin de moderniser les Jeux et d’attirer un public plus jeune. Pourtant, des chercheurs avertissent que l’inclusion olympique peut accélérer la commercialisation et la standardisation, au détriment de la créativité et de l’identité de ces sports.

Un moment emblématique remonte à 2006, lorsque la snowboardeuse américaine Lindsey Jacobellis a perdu la médaille d’or olympique après avoir effectué un geste acrobatique consistant à saisir sa planche en plein saut en plein saut alors qu’elle menait la finale de snowboard cross. Ce geste, célébré dans la culture de son sport, a entraîné une chute qui lui a coûté la médaille d’or.

Les essais de jugement par IA aux X Games

Le jugement assisté par l’IA ajoute de nouvelles couches à cette tension. Des travaux antérieurs sur le halfpipe en snowboard avaient déjà montré comment les critères de jugement peuvent, avec le temps, remodeler subtilement les styles de performance. Contrairement à d’autres sports jugés, les sports d’action accordent une importance particulière au style et à la prise de risque, des éléments particulièrement difficiles à formaliser algorithmiquement.

Pourtant, l’IA a déjà été testée lors des X Games 2025, notamment pendant les compétitions de snowboard SuperPipe, une version de grande taille du halfpipe, avec des parois plus hautes permettant des sauts plus amples et plus techniques. Des caméras vidéo ont suivi les mouvements de chaque athlète, tandis que l’IA analysait les images afin de produire une note de performance indépendante. Ce système était testé en parallèle du jugement humain, les juges continuant à attribuer les résultats officiels et les médailles.

Cet essai n’a toutefois pas modifié les résultats officiels, et aucune comparaison publique n’a été communiquée quant à l’alignement entre les notes produites par l’IA et celles des juges humains. Néanmoins, les réactions ont été très contrastées : certains acteurs saluent une plus grande cohérence et transparence, tandis que d’autres ont averti que les systèmes d’IA ne sauraient pas quoi faire lorsqu’un athlète introduit une nouvelle figure – souvent très appréciée des juges humains et du public.

Au-delà du jugement : entraînement, performance et expérience des fans

L’influence de l’IA dépasse largement le seul cadre du jugement. À l’entraînement, le suivi des mouvements et l’analyse de la performance orientent de plus en plus le développement technique et la prévention des blessures, façonnant la manière dont les athlètes se préparent à la compétition. Parallèlement, l’IA transforme l’expérience des fans grâce à des ralentis enrichis, des visualisations biomécaniques et des explications en temps réel des performances.

Ces outils promettent davantage de transparence, mais ils cadrent aussi la manière dont les performances sont interprétées, avec davantage de « storytelling » autour de ce qui peut être mesuré, visualisé et comparé.

À quel prix ?

L’Agenda olympique de l’IA reflète l’ambition de rendre le sport plus juste, plus transparent et plus engageant. Toutefois, à mesure que l’IA s’intègre au jugement, à l’entraînement et à l’expérience des fans, elle joue aussi un rôle discret mais puissant dans la définition de ce qui constitue l’excellence. Si les juges d’élite sont progressivement remplacés ou marginalisés, les effets pourraient se répercuter à tous les niveaux : formation des juges, développement des athlètes et évolutions des sports eux-mêmes.

Le défi auquel sont confrontés les sports du programme olympique n’est donc pas seulement technologique ; il est institutionnel et culturel. Comment éviter que l’IA ne vide de leur substance les valeurs qui donnent à chaque sport son sens ?

Willem Standaert ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

28.01.2026 à 14:43

Des fossiles datés de 773 000 ans éclairent l’histoire de nos origines

Texte intégral (1024 mots)

Le site de la grotte aux Hominidés à Casablanca, sur la côte atlantique du Maroc, offre l’un des registres de restes humains les plus importants d’Afrique du Nord. Il est connu depuis 1969 et étudié par des missions scientifiques impliquant le Maroc et la France. Ce site éclaire une période cruciale de l’évolution humaine : celle de la divergence entre les lignées africaines qui donneront nos ancêtres directs, les Néandertaliens en Europe et les Dénisoviens en Asie.

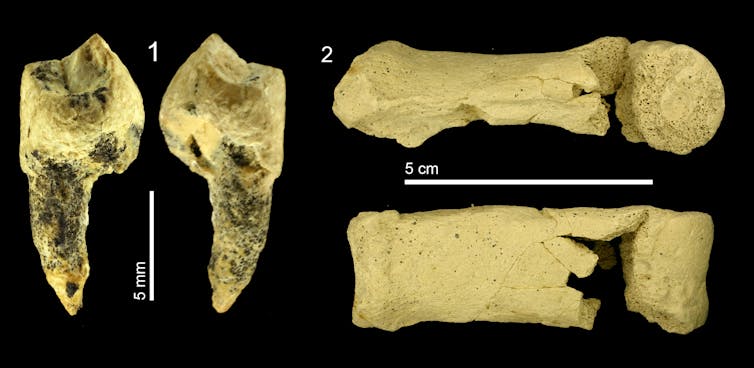

Une étude très récente publiée dans Nature décrit des fossiles d’hominines datés de 773 000 ans. Le groupe des hominines rassemble à toutes les espèces qui ont précédé la nôtre depuis la divergence de la lignée des chimpanzés. Ces fossiles (des vertèbres, des dents et des fragments de mâchoires) ont été découverts dans une carrière qui a fait l’objet de fouilles pendant de nombreuses années. Les découvertes les plus importantes et les plus spectaculaires ont eu lieu en 2008-2009. La raison pour laquelle ce matériel n’avait pas été révélé plus tôt à la communauté scientifique et au public est que nous n’avions pas de datation précise.

Comment cette découverte a-t-elle pu être réalisée ?

Grâce à l’étude du paléomagnétisme, nous avons finalement pu établir une datation très précise. Cette technique a été mise en œuvre par Serena Perini et Giovanni Muttoni de l’Université de Milan (Italie). Ces chercheurs s’intéressent à l’évolution du champ magnétique terrestre. Le pôle Nord magnétique se déplace au cours du temps, mais il y a aussi de très grandes variations : des inversions. À certaines époques, le champ devient instable et finit par se fixer dans une position inverse de la précédente. Ce phénomène laisse des traces dans les dépôts géologiques sur toute la planète.