14.02.2026 à 08:42

En ouvrant ChatGPT à la publicité, OpenAI expose l’IA à des dérives dangereuses

Texte intégral (2107 mots)

La question dépasse la technique. En ouvrant ChatGPT aux annonceurs, OpenAI pose un choix politique : l’IA doit-elle servir le public ou devenir un outil redoutable dans les mains des publicitaires ?

OpenAI a annoncé son intention d’introduire de la publicité dans ChatGPT aux États-Unis. Les annonces apparaîtront dans la version gratuite et pour les abonnés à l'offre Go (la moins chère), mais pas pour les abonnés Pro, Business ou Entreprise.

L’entreprise affirme que les publicités seront clairement séparées des réponses du chatbot et qu’elles n’influenceront pas les contenus générés. Elle s’est également engagée à ne pas vendre les conversations des utilisateurs, à permettre la désactivation des publicités personnalisées et à éviter toute publicité destinée aux moins de 18 ans ou portant sur des sujets sensibles tels que la santé et la politique.

Malgré ces engagements, la décision a suscité des inquiétudes chez une partie des utilisateurs. La question centrale est de savoir si ces garanties tiendront une fois que la publicité deviendra un pilier de son modèle économique.

Pourquoi la publicité dans l’IA était presque inévitable

Nous avons déjà vu ce scénario. Il y a quinze ans, les plateformes de réseaux sociaux peinaient à transformer leurs audiences massives en profits.

Le tournant est venu avec la publicité ciblée : adapter les annonces à ce que les utilisateurs recherchent, consultent et regardent. Ce modèle est devenu la principale source de revenus de Google et de Facebook, au point de remodeler leurs services pour maximiser l’engagement des utilisateurs.

Les plateformes d’intelligence artificielle (IA) grand-public sont extrêmement coûteuses pour leurs propriétaires. L’entraînement et le fonctionnement de modèles avancés exigent d’immenses centres de données, des puces spécialisées et un travail d’ingénierie continu. Malgré une croissance rapide du nombre d’utilisateurs, de nombreuses entreprises d’IA continuent d’opérer à perte. OpenAI prévoit à elle seule de « brûler » près de 100 milliards d’euros au cours des cinq prochaines années.

Seules quelques entreprises peuvent absorber de tels coûts. Pour la plupart des fournisseurs d’IA, trouver un modèle économique à grande échelle est urgent, et la publicité ciblée apparaît comme la réponse la plus évidente. Elle reste le moyen le plus fiable de rentabiliser de larges audiences.

Ce que l’histoire nous enseigne

OpenAI affirme qu’elle maintiendra une séparation claire entre les publicités et les réponses, et qu’elle protégera la vie privée des utilisateurs. Ces garanties peuvent sembler rassurantes, mais elles reposent pour l’instant sur des engagements vagues et susceptibles d’être réinterprétés.

L’entreprise indique ainsi qu’elle ne diffusera pas de publicités « à côté de sujets sensibles ou réglementés comme la santé, la santé mentale ou la politique », mais apporte peu de précisions sur ce qui est considéré comme « sensible », sur l’étendue de la notion de « santé » ou sur l’instance chargée de fixer ces limites.

La plupart des échanges avec une IA, dans la vie réelle, ne relèveront pas de ces catégories restreintes. À ce jour, OpenAI n’a donné aucune précision sur les types de publicités qui seront autorisés ou exclus. Si aucun garde-fou n’est posé sur le contenu des annonces, on peut aisément imaginer qu’un internaute demandant « comment décompresser après une journée stressante » se voie proposer des publicités pour la livraison d’alcool. Une requête sur des « idées de week-end sympa » pourrait faire surgir des promotions pour des sites de jeux d’argent.

Pourtant, ces produits sont associés à des effets néfastes reconnus sur la santé et la société. Placées à côté d’un conseil personnalisé, au moment précis où une décision se prend, ces publicités peuvent infléchir les comportements de façon discrète mais efficace, même en l’absence de toute question de santé explicitement formulée.

On avait vu fleurir des promesses comparables aux débuts des réseaux sociaux. Mais l’expérience montre que l’autorégulation s’érode face aux impératifs commerciaux, au profit des entreprises et au détriment des utilisateurs.

Les logiques publicitaires ont souvent mis à mal l’intérêt général. Le scandale Cambridge Analytica a révélé des données personnelles collectées à des fins commerciales pouvaient être réutilisées pour peser sur des scrutins. Les « Facebook Files » ont, eux, révélé que Meta était consciente des effets délétères de ses plateformes, notamment sur la santé mentale des adolescentes et adolescents, mais a tardé à engager des réformes susceptibles d’entamer ses revenus publicitaires.

Plus récemment, des investigations ont montré que Meta continue de tirer profit de publicités frauduleuses, malgré les alertes répétées sur leurs conséquences.

Pourquoi les chatbots changent la donne

Les chatbots ne sont pas un simple fil d’actualité de plus. Les utilisateurs s’en servent de manière intime et personnelle, pour demander des conseils, chercher un soutien émotionnel ou réfléchir en privé. Ces échanges sont perçus comme discrets, sans jugement, et incitent souvent à confier des choses que l’on ne dirait pas en public.

Cette relation de confiance renforce le pouvoir de persuasion, d’une manière que les réseaux sociaux ne permettent pas. On consulte un chatbot pour obtenir de l’aide ou prendre une décision. Même si les publicités sont formellement séparées des réponses, elles s’insèrent dans un espace privé et conversationnel, et non dans un flux public.

Cette relation de confiance décuple le pouvoir de persuasion, bien au-delà de ce que permettent les réseaux sociaux. On se tourne vers un chatbot pour demander conseil, trancher une décision, chercher un appui. Même officiellement dissociées des réponses, les publicités s’invitent alors dans un tête-à-tête numérique, au cœur d’un échange privé, et non dans le brouhaha d’un fil public.

Des messages placés aux côtés de recommandations personnalisées — qu’ils concernent des biens de consommation, des loisirs, les finances ou la politique — ont toutes les chances d’exercer une influence bien plus forte que les mêmes publicités aperçues au détour d’une navigation classique.

Alors qu’OpenAI présente ChatGPT comme un « super assistant » capable d’accompagner ses utilisateurs dans tous les domaines, des finances à la santé, la frontière entre conseil et incitation devient de plus en plus floue.

Pour les escrocs comme pour les régimes autoritaires, disposer d'un outil de propagande encore plus efficace serait particulièrement tentant. Et du côté des acteurs de l’IA, la perspective de revenus supplémentaires rendra toute complaisance d’autant plus difficile à écarter

Le problème de fond tient à un conflit d’intérêts structurel. Les modèles publicitaires récompensent les plateformes qui maximisent l’engagement, alors même que les contenus les plus susceptibles de capter durablement l’attention sont souvent trompeurs, émotionnellement chargés ou préjudiciables à la santé.

C’est pour cette raison que l’autorégulation des plateformes en ligne a, à maintes reprises, montré ses limites.

Existe-t-il une meilleure voie ?

Une piste serait de considérer l’IA comme une infrastructure publique numérique : des systèmes essentiels, conçus pour servir l’intérêt général plutôt que pour maximiser les recettes publicitaires.

Cela n’implique pas d’exclure les acteurs privés. Mais cela suppose l’existence d’au moins une option publique de haute qualité, placée sous contrôle démocratique — à l’image des médias audiovisuels publics qui coexistent avec les chaînes commerciales.

Des exemples émergent déjà. La Suisse a développé le système d’IA public Apertus via ses universités et son centre national de calcul intensif. Ce modèle est open source, conforme au droit européen sur l’IA et exempt de publicité.

L’Australie (NDT : la version originale de ce texte a été écrite pour un public australien) pourrait aller plus loin. En parallèle du développement de ses propres outils d’IA, les autorités pourraient imposer des règles claires aux acteurs commerciaux : obligation de transparence, interdiction des publicités nuisibles à la santé ou à caractère politique, et sanctions effectives — pouvant aller jusqu’à la suspension d’activité — en cas d’infractions graves.

La publicité n’a pas dévoyé les réseaux sociaux en un jour. Elle a progressivement déplacé les incitations, jusqu’à faire des atteintes à l’intérêt général un simple effet secondaire de la quête de rentabilité. L’introduire dans l’IA conversationnelle, c’est risquer de reproduire ce scénario — mais dans des systèmes auxquels les utilisateurs accordent une confiance bien plus profonde encore.

La question décisive n’est donc pas d’ordre technique, mais politique : l’IA doit-elle servir le public, ou les annonceurs et les investisseurs ?

Raffaele F Ciriello est membre bénévole et temporaire du groupe consultatif des parents auprès de l’eSafety Commissioner, où il conseille sur les réactions des parents et des jeunes face aux lois australiennes fixant un âge minimum pour l’usage des réseaux sociaux. Cet article s’appuie sur ses recherches menées à titre indépendant.

Kathryn Backholer est vice-présidente (politique) de la Public Health Association of Australia. Elle reçoit des financements du National Health and Medical Research Council, de l’Australian Research Council, de l’UNICEF, de la Ian Potter Foundation, de la National Heart Foundation, de VicHealth, de la Foundation for Alcohol Research and Education, de QUIT, de la .auDA Foundation ainsi que du Victorian Department of Justice and Community Safety pour des travaux portant sur les effets nocifs de la publicité en ligne sur la santé.

13.02.2026 à 09:23

Inondations : l’aménagement du territoire est-il responsable ?

Texte intégral (2284 mots)

Les inondations qui touchent le Sud-Ouest de la France provoquées par la tempête Nils pourraient alimenter à nouveau le débat sur le rôle l’aménagement du territoire dans la survenue de ces événements. Les inondations sont pourtant des phénomènes complexes et le rôle des aménagements reste difficile à estimer.

Depuis plusieurs années, l’Europe est frappée par des inondations majeures aux bilans humains terribles : 243 morts en juillet 2021 en Allemagne, en Belgique, au Luxembourg et aux Pays-Bas, 17 morts en mai 2023 en Italie du Nord, 27 morts en septembre 2024 lors de la tempête Boris en Europe Centrale, de l’Allemagne à la Roumanie, et 237 morts en octobre 2024 dans le sud de Valence. Plus près de nous, les inondations de la Vilaine de ce mois de janvier 2026 et celles de l’année dernière ont ravivé pour les habitants le spectre des inondations du passé.

Ces évènements frappent les esprits et font la une des médias, surtout s’ils se déroulent en Europe. Très vite, des causes liées à l’aménagement du territoire sont invoquées. En Espagne, l’extrême droite a condamné les écologistes qui ont prôné l’arasement des barrages. Vérification faite, il ne s’est agi que de la suppression de « barrières » peu élevées et le lien avec les barrages n’est pas attesté. En Bretagne, à l’inverse, suite à la crue de la Vilaine début 2025 et à l’inondation de plusieurs quartiers de Rennes et de Redon, plusieurs coupables ont été rapidement désignés dans les médias. Le changement climatique d’abord, puis le remembrement des territoires ruraux et le drainage des parcelles agricoles qui ont accompagné la révolution verte des années 1960 et 1970 ont été pointés du doigt.

Les scientifiques de l’eau soulignent le rôle des aménagements passés sur les sécheresses et les tensions autour de la ressource en eau. Pour autant, l’attribution des causes à des événements exceptionnels comme les crues intenses s’avère difficile. Faut-il chercher un seul coupable, ou bien plusieurs ? Changement climatique et modification des usages des sols contribuent à la genèse des inondations, mais leurs implications respectives dans ces évènements varient selon le type d’inondation ainsi qu’au cours du temps.

Il est difficile de déterminer les causes des crues

Isoler la part de responsabilité du changement climatique dans la survenue d’un événement climatique extrême est ce qu’on appelle un processus d’attribution. La science de l’attribution, relativement récente, est nécessaire pour quantifier les impacts du changement climatique dans des processus complexes et variables. Un exemple récent est l’étude menée suite aux pluies torrentielles d’octobre 2024 en Espagne, qui a montré que ce type d’épisode pluvieux présente jusqu’à 15 % de précipitations supplémentaires par rapport à un climat sans réchauffement. En d’autres termes, environ une goutte d’eau sur six tombée lors de cet épisode peut être imputée au changement climatique.

Si l’attribution des pluies est aujourd’hui de mieux en mieux maîtrisée, celle des crues reste moins bien déterminée. On confond souvent l’attribution de la pluie et celle de la crue, alors qu’elles ne sont pas équivalentes. Entre le moment où la pluie tombe et celui où la rivière déborde, il se passe beaucoup de choses au niveau du bassin versant : selon le degré d’humidité et la nature du sol et du sous-sol ou bien la manière dont il a été aménagé, il peut agir comme tampon ou accélérer les flux d’eau. Deux bassins versants différents auront des réponses également différentes pour un même volume de pluie, et un même volume de pluie tombant sur un même bassin versant peut avoir des conséquences très différentes selon le moment de l’année. La survenue d’une crue dépend donc de la combinaison de deux dés : la pluie qui tombe sur le bassin versant et la capacité de ce bassin à l’absorber.

Le changement climatique et les aménagements perturbent l’absorption des sols

Les études d’attribution des pluies montrent avec certitude que le réchauffement climatique — et donc les activités humaines qui en sont la cause — intensifient les pluies fortes et les rendent de plus en plus fréquentes. Si nos futurs étés seront plus secs, les hivers seront eux plus humides, notamment dans le nord de la France. Qu’en est-il du deuxième dé, la capacité d’absorption des bassins versants ? Le changement climatique l’affecte également, en modifiant l’humidité des sols au fil des saisons. Mais cette capacité dépend aussi largement des transformations opérées par certaines activités humaines.

C’est le cas par exemple des barrages, conçus pour stocker l’eau lors des saisons humides et qui ont la capacité de tamponner la puissance des crues. Mais d’autres phénomènes sont impliqués, comme l’urbanisation, qui imperméabilise les sols en remplaçant champs et prairies par du béton et de l’asphalte. Ces surfaces imperméables réduisent fortement l’infiltration et favorisent le ruissellement. Même si l’urbanisation reste marginale à l’échelle des grands bassins versants, elle peut jouer un rôle majeur localement, notamment en zones périurbaines, où les petits cours d’eau sont souvent canalisés ou recouverts.

Les aménagements agricoles comptent également. Le remembrement, qui a fait disparaître des milliers de haies et fossés au profit de grandes parcelles plus facilement exploitables pour des machines agricoles, a profondément modifié la circulation de l’eau. En parallèle, d’autres transformations ont réduit la capacité du paysage à retenir l’eau lors des pluies fortes, comme la pose de drains en profondeur dans les sols agricoles qui vise à évacuer l’excédent d’eau des terres trop humides durant l’hiver. La création de digues et de canaux pour limiter l’expansion des rivières, le creusement des cours d’eau et la rectification de leurs berges les ont recalibrées pour les rendre linéaires. Ces différents aménagements ont des effets importants. Ils modifient le cycle de l’eau continental en accélérant globalement les flux vers la mer. Les niveaux des nappes ont déjà été affectés par ces modifications. Dans les vastes marais du Cotentin, nous avons montré que le niveau moyen des nappes a chuté d’environ un mètre depuis 1950, alors que les aménagements des siècles précédents avaient déjà diminué ces niveaux. Le changement climatique va renforcer cette diminution des niveaux de nappe au moins sur une grande partie du territoire hexagonal.

D’un bassin à l’autre, des effets différents

Ces facteurs jouent différemment selon la surface des bassins versants et leur localisation : l’urbanisation a un effet très fort sur les crues des petits bassins versants côtiers de la Côte d’Azur, qui ont une surface inférieure à 10 km2, mais un effet moindre sur le bassin versant de la Vilaine, qui compte 1 400 km2 à Rennes après la confluence avec l’Ille. À l’inverse, les pratiques agricoles ont un effet plus important sur les crues du bassin de la Vilaine que sur ceux de la Côte d’Azur.

Aujourd’hui, il est difficile de quantifier précisément la part relative de ces facteurs dans l’occurrence des crues observées. En amont des cours d’eau, certaines transformations peuvent ralentir la propagation des crues en augmentant des capacités de stockage locales, par exemple dans les sols, les zones humides ou les plaines inondables, tandis qu’en aval, l’accélération des flux et leur addition tendent à dominer. Chacun des aménagements décrits influence la manière dont un bassin versant absorbe ou accélère l’eau, mais l’addition de leurs effets crée une interaction complexe dont nous ne savons pas précisément faire le bilan.

Lors d’événements exceptionnels comme la crue de Valence, ce sont avant tout les volumes de pluie qui déclenchent la crue et ses conséquences, le changement climatique pouvant intensifier ces précipitations. Les aménagements du territoire influencent de manière secondaire la façon dont l’eau s’écoule et se concentre dans les bassins versants. Il n’en reste pas moins que ces deux effets jouent un rôle de plus en plus important dans les événements de moindre ampleur, dont les impacts sont néanmoins importants et dont l’occurrence a déjà augmenté et va encore s’accentuer dans le futur. Pour deux degrés de réchauffement, l’intensité des crues décennales (d’une ampleur observée en moyenne une fois tous les 10 ans) augmentera potentiellement de 10 à 40 % dans l’Hexagone, et celle des crues centennales (observées en moyenne une fois tous les siècles) de plus de 40 %.

Une vie en catastrophes ?

Ces événements ont provoqué des prises de position politique virulentes. Certains, en particulier à droite de l’échiquier politique, ont remis en question les politiques récentes de restauration de l’état naturel des cours d’eau, de protection des zones humides et de destruction des barrages. Elles ont conduit à des appels à la suppression de l’Office français de la biodiversité lors des manifestations agricoles, proposition reprise par le sénateur Laurent Duplomb devant le Sénat le 24 janvier 2024.

Les aménagements les plus récents, défendus par de nombreuses structures territoriales, visent à redonner au cycle de l’eau, et en particulier aux rivières, des espaces plus larges et à recréer ou protéger des zones humides. Tous ces aménagements conduisent à ralentir les flux et donc luttent contre les inondations, tout en préservant la biodiversité à laquelle notre santé est liée. Les zones humides sont par exemple les meilleurs ennemis des moustiques tigres, en permettant le développement de leurs prédateurs. Bien qu’ils exigent de concéder des terres agricoles aux milieux naturels, ces aménagements nourrissent les nappes qui restent le meilleur réservoir pour le stockage de l’eau des saisons humides.

Remettre en question les politiques de recalibration des cours d’eau, de remembrement et de drainage, tout comme l’imperméabilisation des zones urbaines, est une nécessité imposée par l’adaptation au changement climatique. Il s’agit de limiter ou éviter les tensions entre les besoins des activités humaines et les besoins des écosystèmes qui pourraient en faire les frais. Les inondations catastrophiques ne sont qu’en partie liées aux aménagements et ne peuvent pas justifier à elles seules les politiques de retour à l’état naturel des cours d’eau, qui sont en revanche une réponse aux sécheresses estivales à venir. Pour autant, ces inondations majeures sont là pour nous alerter sur les effets du changement climatique. Les étés vont devenir plus secs et les ressources vont manquer, mais les événements extrêmes vont également se multiplier. Une vie en catastrophes nous attend si nous ne transformons pas nos modes de consommation et de production. Tel est le message porté par les inondations. Sera-t-il mieux entendu que les appels des hydrologues ?

Luc Aquilina est co-titulaire de la chaire Eaux et territoires de la fondation de l’Université de Rennes qui reçoit des fonds d’Eau du Bassin Rennais, Rennes Métropole et du Syndicat Mixte Eau 50.

Pierre Brigode a reçu des financements de l'Université de Rennes, du Centre national de la recherche scientifique et de l'Agence nationale de la recherche.

12.02.2026 à 16:13

Fabriquer de l’oxygène avec le sol lunaire : le futur de l’exploration spatiale ?

Texte intégral (3234 mots)

Alors que les projets de retour sur la Lune se multiplient, et cette fois-ci pour s’y implanter durablement, comment respirer sur un astre sans atmosphère ? La réponse se trouve peut-être dans la poussière qui recouvre notre satellite.

Une nouvelle course à la Lune se dessine entre les États-Unis et la Chine. Contrairement à il y a cinquante ans, il n’est plus seulement question d’alunir et de repartir, mais bien d’établir une base qui autorise une présence durable et des séjours prolongés à la surface de notre satellite naturel. L’objectif est désormais de se servir de la Lune comme d’un bac à sable pour tester les technologies qui nous permettront de voyager plus loin, notamment vers Mars.

L’une de ces technologies clés est l’in-situ resource utilization (ISRU), c’est-à-dire l’exploitation des ressources disponibles sur place afin de produire les consommables nécessaires aux activités humaines : oxygène, eau, carburants pour les fusées ou matériaux de construction. En produisant directement sur la Lune ce qui est indispensable à la vie et aux opérations, il sera possible de réduire significativement la masse de cargaison à expédier depuis la Terre, réduisant ainsi les coûts logistiques et financiers de l’exploration spatiale. Plutôt que d’importer ces ressources depuis la Terre, il s’agit d’apprendre à vivre sur la Lune.

Décomposer la poussière lunaire pour en extraire de l’oxygène

À l’aube de ce retour durable de l’être humain sur la Lune, l’ISRU s’impose donc comme un pivot stratégique. L’un des défis majeurs est de produire de l’oxygène à partir du régolithe, la couche de sol qui recouvre la Lune, principalement formée de petits fragments de roches et de poussières. La composition du régolithe est complexe. Celui-ci est essentiellement constitué de plusieurs minéraux (plagioclase, pyroxène, olivine) eux-mêmes constitués d’un mélange d’oxydes métalliques, des composés chimiques qui associent de l’oxygène à un autre élément comme du silicium, du fer ou du calcium.

Environ 40 à 45 % de la masse du régolithe est donc composée d’oxygène, ce qui en fait l’élément le plus abondant à la surface de la Lune. L’oxygène est omniprésent, mais il n’existe pas sous forme gazeuse comme dans l’atmosphère terrestre. Pour libérer l’oxygène, il faut briser les liaisons chimiques qui l’attachent aux autres éléments dans les oxydes du sol lunaire.

Une des méthodes envisagées est la pyrolyse, un type de réaction chimique qui permet de décomposer des matériaux grâce à de hautes températures, afin de produire des composés volatils. Appliquée au régolithe, il est possible de le chauffer jusqu’à ce que les oxydes métalliques se vaporisent et se décomposent en oxygène et en métaux.

Sur la Lune, l’énergie thermique serait fournie grâce à la concentration solaire, un procédé qui consiste à utiliser des miroirs ou des lentilles pour focaliser la lumière du Soleil vers une petite zone. Les rayons se rassemblent alors en un faisceau et convergent en un point focal où l’énergie est fortement concentrée, permettant d’atteindre des températures de plusieurs milliers de degrés. Cette méthode prévoit également d’exploiter le vide lunaire, un environnement qui favorise les réactions libérant du gaz. Cela permettra de diminuer la quantité d’énergie nécessaire à la réaction.

Le four solaire, une méthode efficace et peu coûteuse

La Lune a un environnement particulièrement favorable à la pyrolyse solaire. Dépourvue d’atmosphère, la pression à sa surface est extrêmement faible, de l’ordre de 10⁻15 bar. L’absence d’atmosphère offre un second avantage : le rayonnement solaire ne peut pas être absorbé par celle-ci ni bloqué par des nuages. Cela permet d’obtenir des flux solaires concentrés plus élevés que sur Terre. De plus, certaines zones géographiques à son pôle Sud sont exposées à la lumière du Soleil jusqu’à 90 % du temps. Ainsi, en combinant le vide lunaire avec des systèmes de concentration solaire, on peut concevoir un procédé relativement simple, robuste et potentiellement efficace pour extraire de l’oxygène du régolithe.

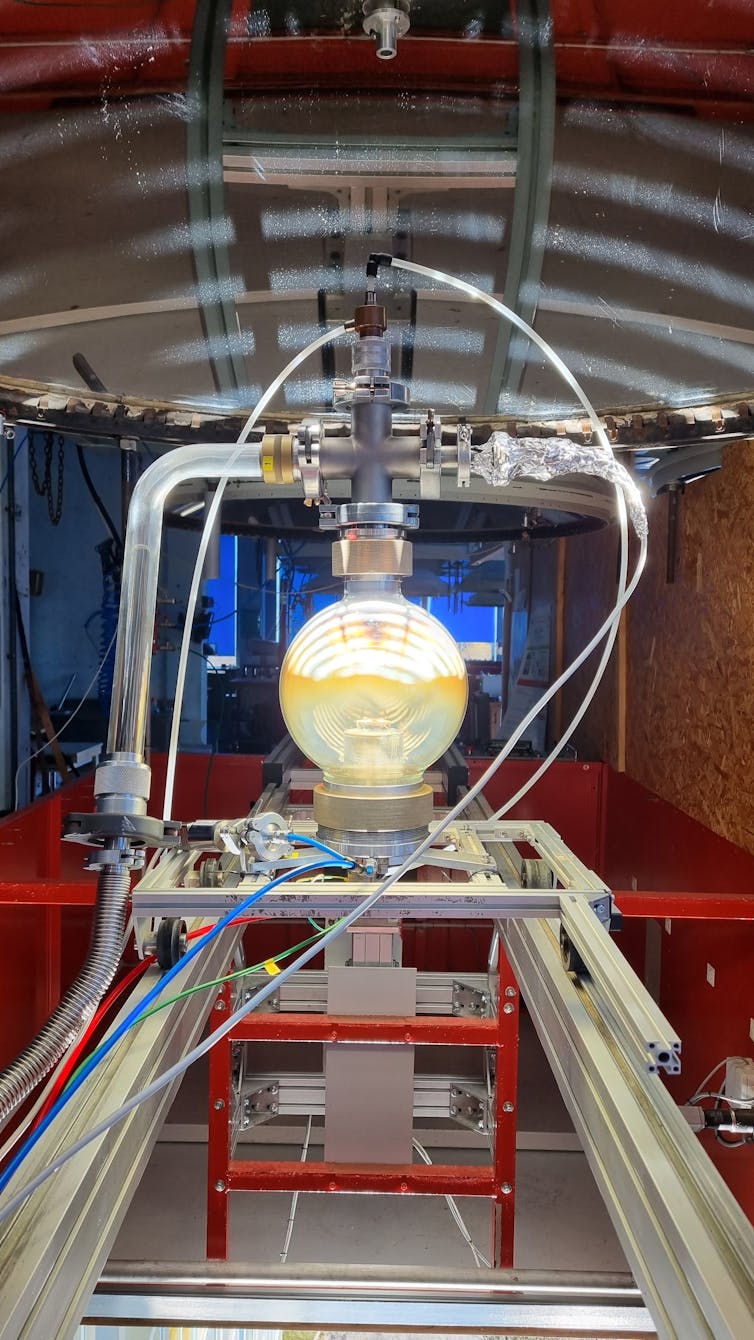

Au sein du laboratoire Procédés, matériaux, énergie solaire (Promes-CNRS), spécialisé dans les technologies de concentration solaire, nous travaillons à la validation du concept de base de la pyrolyse qui pourra à l’avenir être déployé sur la Lune. Implanté sur le site du grand four solaire d’Odeillo (Pyrénées-Orientales) en Occitanie, le laboratoire dispose d’infrastructures expérimentales uniques au monde vouées à l’étude des procédés hautes températures. Parmi ces équipements figurent notamment des paraboles de deux mètres de diamètre permettant de concentrer 10 000 fois les rayons solaires sur une tache d’environ 2 cm de diamètre et d’atteindre des températures de plus de 3 000 °C.

Cette énergie alimente le réacteur de pyrolyse, une enceinte sous vide conçue pour exposer des échantillons de matériaux qui simulent le régolithe lunaire au flux solaire concentré. Les pastilles de simulant sont placées sur un support en cuivre refroidi, tandis qu’une parabole focalise la lumière du Soleil à l’intérieur du réacteur pour assurer leur chauffage. Une pompe à vide maintient une pression d’environ 10 millibars. Une cellule électrochimique permet de déterminer en continu la concentration d’oxygène dans le réacteur.

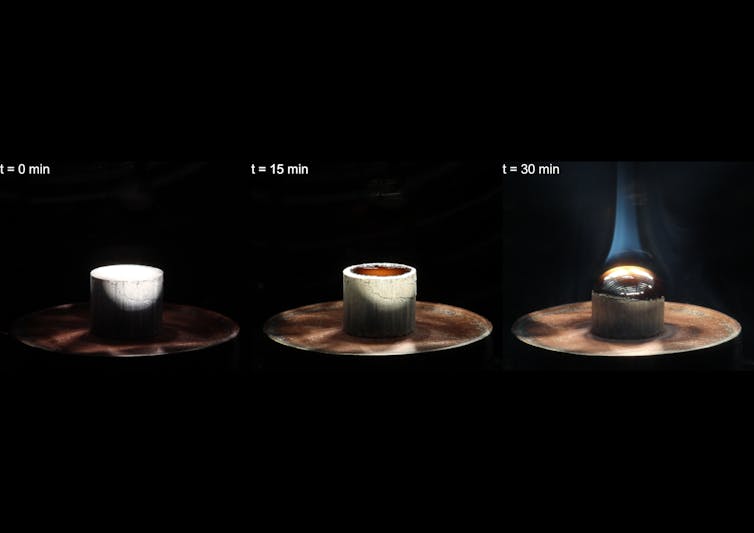

L’échantillon est ensuite progressivement chauffé et commence à fondre aux alentours de 1 200 °C. Le régolithe atteint par la suite des températures d’environ 2 000 °C. Dans ces conditions, les oxydes présents dans l’échantillon commencent à se vaporiser et se dissocient pour libérer de l’oxygène.

D’autres produits en plus de l’oxygène

Lors des premiers essais, 35 mg d’oxygène ont été extraits à partir d’une pastille de 3,38 g, soit environ 1 % de la masse totale. Cela correspond à 2,5 % de l’oxygène contenu dans le simulant de régolithe. Une fois l’expérience achevée, une bille de verre est obtenue à la place de la pastille de régolithe. La fraction de régolithe qui s’est vaporisée lors de l’expérience se condense sur les parois froides du réacteur sous la forme de composés minéraux. Ces espèces sont collectées afin de les caractériser ensuite et de déterminer leur composition chimique.

Après pyrolyse, la bille de verre formée présente une composition chimique différente de celle du simulant de régolithe initial. Les oxydes volatils, qui se sont échappés lors du processus, y sont moins concentrés, à l’inverse des oxydes non volatils. Les espèces les plus volatiles ont été retrouvées dans les dépôts collectés sur les parois du réacteur, où elles se sont condensées lors de la pyrolyse.

Cette observation suggère qu’il serait aussi possible d’utiliser la pyrolyse comme une méthode pour séparer les oxydes dans le régolithe selon le principe de la distillation. Ces coproduits pourraient être exploités pour la fabrication de structures, d’outils ou de matériaux de construction directement sur la Lune, renforçant ainsi l’autonomie des futures missions lunaires.

Passer de la preuve de concept aux conditions réelles

Ces premiers essais ont permis de déterminer un rendement, mais celui-ci reste faible. Les prochaines étapes de développement viseront à réduire la pression à l’intérieur du réacteur, afin de se rapprocher des conditions lunaires. Une pression réduite devrait permettre de diminuer les températures mises en jeu lors de la pyrolyse, afin de vaporiser intégralement l’échantillon et d’augmenter le rendement.

Par la suite, il sera également pertinent de tester différents types de régolithes, ainsi que les minéraux et oxydes individuels qui les composent, afin de mieux comprendre la chimie des réactions. Le réacteur de pyrolyse se devra de fonctionner en continu afin d’exploiter au mieux le jour lunaire. Le procédé peut encore être optimisé. Un contrôle plus précis de la température permettrait de mieux maîtriser les réactions et d’améliorer leur rendement. Une collecte plus efficace des gaz produits viserait à limiter les pertes d’oxygène. Nous espérons également réduire les pertes thermiques en utilisant un creuset et en l’isolant. Enfin, une meilleure condensation des sous-produits permettrait d’identifier et de valoriser les matériaux formés lors de la pyrolyse en plus de l’oxygène.

L’ensemble du système (réacteur, miroirs et dispositifs de concentration solaire) devra en outre être robuste et fiable, capable de résister aux conditions extrêmes de l’environnement lunaire : poussière abrasive, radiations, fortes variations thermiques… Enfin, l’oxygène généré devra être stocké, purifié pour le séparer d’autres éléments qui peuvent être présents dans le gaz et utilisé. Il faut aussi penser à la logistique d’alimentation du réacteur en régolithe, qu’il s’agisse de son extraction, de son transport ou de son utilisation après traitement.

La pyrolyse solaire sous vide est une méthode particulièrement bien adaptée aux conditions lunaires. Elle tire parti du vide naturel de la Lune, demande peu de ressources importées et utilise l’énergie solaire, abondante sur un satellite sans atmosphère. Les tests à Odeillo ont déjà prouvé la faisabilité du concept, mais les rendements doivent encore être améliorés et les défis techniques restent considérables. En produisant localement de l’oxygène et des matériaux, le procédé soutiendrait les futures bases lunaires et réduirait leur dépendance vis-à-vis de la Terre.

Jack Robinot a reçu des financements du CNES et de la région Occitanie.

Sylvain Rodat a reçu des financements de la région Occitanie et un support matériel de l'ESA (Agence spatial européenne) qui a fourni le simulant de régolithe.

Alexis Paillet et Stéphane Abanades ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Time [Fr]

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- L'Autre Quotidien

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- Gauche.Media

- CETRI

- ESSF

- Inprecor

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview