10.12.2025 à 16:16

À qui appartiennent les poissons ? L’épineuse question de la répartition des quotas de pêche européens

Sigrid Lehuta, Chercheure en halieutique, Ifremer

Verena Trenkel, Chercheuse en écologie marine quantitative, Ifremer

Texte intégral (2285 mots)

Les poissons de la Manche n’ont pas pu voter au moment du Brexit, ceux de l’Atlantique n’ont pas de visa de l’espace Schengen et pourtant, leur sort a été fixé au sein de l’Union européenne dans les années 1970. Actualiser ces statu quo anciens dans une Europe à 27 où les océans se réchauffent et où bon nombre de poissons tendent à migrer vers le nord à cause de la hausse des températures devient plus que nécessaire. Voici pourquoi.

Les populations marines ne connaissent pas de frontières. Tous les océans et toutes les mers du monde sont connectées, permettant la libre circulation des animaux marins. Les seules limitations sont intrinsèques à chaque espèce, dépendantes de sa capacité de déplacement, de ses besoins et tolérances vis-à-vis des températures, des profondeurs et d’autres facteurs.

Les poissons ne connaissent ainsi pas de barrières linéaires ou immuables, mais les États ont, eux, quadrillé les mers en fonction de leurs zones économiques exclusives (ZEE). Des institutions onusiennes, comme l’Organisation des Nations unies pour l’alimentation et l’agriculture (Food and Agriculture Organization, FAO), la Commission générale des pêches pour la Méditerranée (CGPM) ou le Conseil international de l’exploitation de la mer, définissent des zones d’évaluation des stocks ou de gestion des pêches dans lesquelles sont régulées les captures ou les activités de pêche.

Dans l’UE : une règle peu révisée depuis plus de quarante ans

Mais à qui sont donc les poissons qui franchissent allégrement les limites des ZEE et des zones de gestion de pêche ? Pour répondre à cette question et éviter la surpêche, des mécanismes de gestion commune et de partage des captures ont été mis en place au sein de l’Union européenne (UE) et avec les pays voisins.

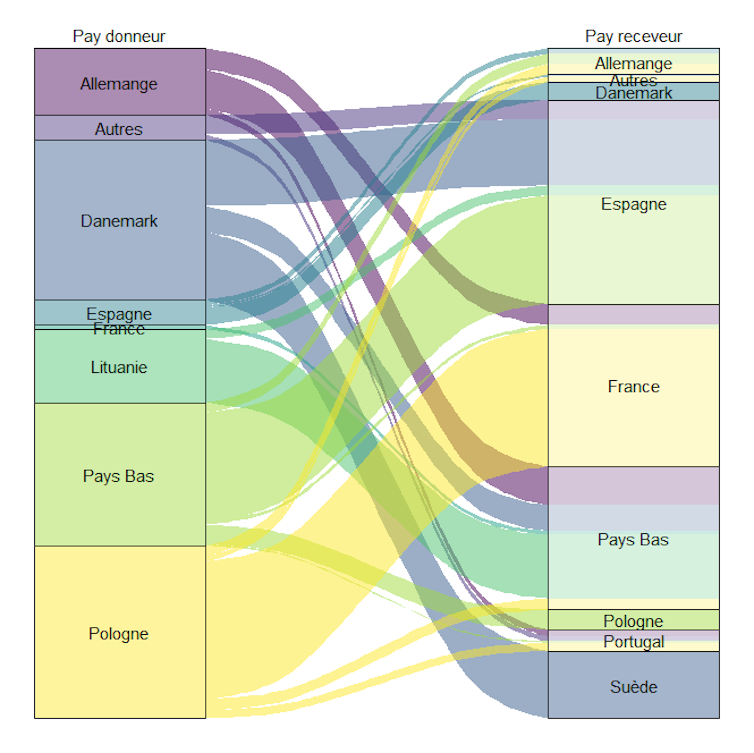

Le tonnage de poisson que l’on peut pêcher est d’abord défini pour chaque espèce et chaque zone de gestion (un stock) afin d’éviter la surpêche. Puis ce tonnage est divisé entre pays, comme les tantièmes dans une copropriété ou les parts dans un héritage. C’est cette répartition entre pays, appelée la « clé de répartition », qui est ici discutée.

Pour la plupart des stocks, la clé de répartition est encore définie sur la base des captures réalisées dans les années 1973-1978 par chacun des neuf États alors membres de l’UE. Cette référence historique a mené à la dénomination de « stabilité relative » qui désigne la méthode de partage des captures annuelles admissibles : la clé est stable, mais la quantité obtenue chaque année varie en fonction de l’état du stock.

Chaque État membre est ensuite libre de distribuer son quota à ses pêcheurs selon des modalités qu’il choisit. En France, chaque navire possède des antériorités de captures propres mais qui ne lui donnent pas automatiquement accès au quota correspondant. Elles déterminent en revanche les sous-quotas attribués à l’organisation de producteurs (OP) à laquelle le navire choisit d’adhérer. L’OP définit en interne les modalités de répartition de ses sous-quotas entre ses adhérents, qui sont différentes entre OP, stocks, flottilles, années…

Un partage satisfaisant pour la France mais qui atteint ses limites

La France fait partie des gagnants de ce partage ancien. Le cadre juridique bien établi et la prévisibilité du système facilitent la programmation et évitent d’interminables négociations. Un système assez fluide, avec des échanges parfois systématiques entre États ou entre OP, permet d’éviter d’atteindre les quotas trop tôt dans l’année. Les OP jouent un rôle essentiel pour optimiser l’utilisation et la valorisation des quotas sur l’année, limiter la concurrence entre pêcheurs, ou éviter des crises économiques.

Mais à l’heure du changement climatique, et dans une Europe post-Brexit, ce modèle ancien se frotte à des questionnements nouveaux, qu’ils soient sociétaux ou environnementaux.

Le cas du maquereau est emblématique de cela. Depuis 2010, ce poisson migre de plus en plus vers le nord et atteint les eaux de l’Islande, pays qui n’avait pratiquement pas de quotas pour cette espèce. Faute d’accord avec les pays voisins, la capture annuelle du maquereau dépasse la recommandation scientifique depuis de nombreuses années, menant à la surpêche.

Le Brexit a, quant à lui, provoqué une réduction de la part de l’UE pour les stocks partagés avec le Royaume-Uni, car pêchées dans leur ZEE, avec de lourdes conséquences économiques et sociales : mise à la casse de 90 bateaux français et baisse d’approvisionnement et donc d’activité dans les criées et pour toute la chaîne de transport et de transformation du poisson.

Autre question épineuse : que faire pour les espèces qui sont capturées simultanément par l’engin de pêche alors que leurs niveaux de quota sont très différents ?

C’est le cas par exemple du cabillaud en mer Celtique. Cette espèce est généralement capturée en même temps que le merlu et la baudroie, mais elle fait l’objet d’un quota très faible en raison de l’effondrement du stock. Les pêcheurs qui disposent de quotas pour le merlu ou la baudroie sont donc contraints de cesser leur activité pour éviter de capturer sans le vouloir du cabillaud.

Chaque année, de difficiles négociations sont nécessaires entre l’UE et des pays non membres avec qui des stocks sont partagés, comme la Norvège et le Royaume-Uni, soit des pays qui échappent aux objectifs et critères de répartition définis par la politique commune des pêches.

En France, ce statu quo freine aussi l’installation des jeunes et la transition vers des méthodes de pêche plus vertueuses. En effet, pour s’installer, il ne s’agit pas simplement de pouvoir payer un navire. Le prix de vente d’un navire d’occasion tient en réalité compte des antériorités de pêche qui y restent attachées, ce qui augmente la facture.

Et si l’on veut transitionner vers d’autres techniques ou zones de pêche à des fins de préservation de la biodiversité, d’amélioration du confort ou de la sécurité en mer, ou encore de conciliation des usages avec, par exemple, l’éolien en mer, ce sera nécessairement conditionné à la redistribution des quotas correspondants aux nouvelles espèces pêchées et forcément au détriment d’autres navires qui les exploitent historiquement.

Quelles alternatives au système en place ?

Les atouts et limites du système en place sont bien connus des acteurs de la pêche, mais la réouverture des négociations autour d’une autre clé de répartition promet des débats difficiles entre l'UE et les pays voisins.

L’UE, depuis 2022, incite les États à élargir les critères de répartition du quota national à des considérations environnementales, sociales et économiques. En France, cela s’est traduit en 2024 par de nouveaux critères d’allocation de la réserve nationale de quota. La réserve nationale correspond à une part de quota qui est reprise par l’État à chaque vente et sortie de flotte des navires. Sa répartition favorise désormais les jeunes et la décarbonation des navires.

Cette avancée, même timide, prouve que le choix et l’application de nouveaux critères sont possibles, mais elle reste difficile dans un contexte de faible rentabilité des flottes et de demandes en investissements conséquents pour l’adaptation des bateaux aux transitions écologiques et énergétiques.

En juin 2024, avec un groupe d’une trentaine de scientifiques des pêches, réunis sous l’égide de l’Association française d’halieutique, nous avons mené une réflexion sur les alternatives possibles à la clé actuelle. Parmi les propositions, quatre points ont été saillants pour une pêche durable, équitable et rentable :

la nécessaire prise en compte d’une multitude de critères écologiques et halieutiques pour l’attribution de part de quota. Par exemple, l’utilisation d’engins sélectifs, et moins impactants pour la biodiversité ou la proximité des zones de pêche, traduisant un souci de limitation d’empreinte carbone, et d’adaptabilité aux changements de distribution ;

la nécessaire prise en compte de critères socio-économiques, comme l’équité entre navires, entre générations, entre sexes… ;

la création de récompenses en quota pour la participation à la collecte de données nécessaires pour informer une gestion écosystémique et permettre la mise en place d’un système de répartition fondé sur des critères biologiques (mise en place de caméras à bord, campagnes exploratoires, auto-échantillonnage) ;

la nécessaire transparence concernant la répartition nationale et ses critères.

Conscients de la charge réglementaire qui pèse sur les patrons pêcheurs et des difficultés financières, parfois insurmontables, associées aux adaptations (changement d’engins, de pratiques…), certaines propositions reposent davantage sur des incitations que sur des obligations, c’est-à-dire des quotas supplémentaires venant récompenser des adaptations volontaires.

Pour permettre une transition douce vers les nouvelles règles, nous conseillons le maintien temporaire ou partiel des antériorités afin de donner le temps et la visibilité nécessaires aux pêcheurs pour effectuer les adaptations adéquates.

Nous nous accordons sur une mise à jour à intervalle régulier de la clé de répartition entre pays et navires selon un calendrier prédéfini et en application des critères retenus pour améliorer l’adaptabilité des pêcheries aux changements. Les critères pourraient être aussi révisés, tout en évitant une réouverture des négociations trop régulièrement. Nous insistons sur le nécessaire maintien de la flexibilité indispensable aux adaptations dans un contexte environnemental très fluctuant lié au changement global.

Cet article a été écrit sur la base d’un travail collaboratif mené par Arthur Le Bigot, encadré par les autrices (Ifremer), pour lequel une trentaine de scientifiques a été consultée au cours d’un atelier organisé par l’Association française d’halieutique et des acteurs du système pêche interviewés. Le contenu de cet article reflète l’interprétation des autrices sur la base de leurs connaissances et des propos recueillis au cours des entretiens et de l’atelier. Il n’engage pas les participants à l’atelier, les personnes interviewées ni les membres de l’AFH.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

10.12.2025 à 16:15

Les jeunes veulent-ils encore la démocratie ?

Anne Muxel, Directrice de recherches (CNRS) au Cevipof, Sciences Po

Texte intégral (1893 mots)

Droitisation de la jeunesse, désamour de la démocratie des moins de 35 ans, distanciation de la politique des seniors : « Fractures françaises », dix ans d’enquête menée par le Cevipof, nous apprennent les évolutions du rapport au politique de différentes générations.

Contrairement à ce qui est souvent asséné, les jeunes ne sont ni en voie de dépolitisation, ni désintéressés de la politique. Ils expriment des choix politiques et adoptent des comportements dans un cadre renouvelé du rapport à la citoyenneté.

Les données de l’enquête annuelle Fractures françaises, depuis 2013, permettent de saisir les évolutions les plus repérables du rapport à la politique dans la chaîne des générations, en en mesurant les écarts ou les similitudes entre les plus jeunes et les plus vieux, à l’échelle d’une dizaine d’années.

Évolution de l’intérêt pour la politique en fonction de l’âge (%)

Comparés à leurs aînés, les jeunes font preuve d’un niveau d’intérêt pour la politique certes moindre mais assez stable. Les fluctuations enregistrées, obéissant aux effets de la conjoncture politique et aux périodes électorales, suivent globalement celles qui sont enregistrées dans l’ensemble de la population.

Et si l’on compare le niveau de l’intérêt politique des classes d’âge les plus jeunes à celui qui est enregistré dans les classes d’âge plus âgées, au fil du temps, ils ont plutôt tendance à se rapprocher. L’intérêt pour la politique des plus jeunes augmente plutôt tandis que celui des autres classes d’âge a tendance au mieux à rester stable, voire à régresser. En l’espace de dix ans, l’écart de niveau d’intérêt pour la politique entre les moins de 35 ans et les plus de 60 ans est passé de - 25 points à - 7 points.

S’il y a dépolitisation, distanciation envers la politique, cette évolution est donc loin de ne concerner que les jeunes, elle est aussi visible, et peut être encore plus significative, dans les segments de la population plus âgés. C’est un résultat qui va à l’encontre de bien des idées reçues.

Une demande pressante de démocratie directe

La distanciation envers les partis politiques et, plus largement, la défiance à l’encontre du personnel et des institutions politiques sont bien repérés dans les analyses de sociologie politique et électorale récentes en France. Celles-ci montrent une montée d’une citoyenneté plus critique, plus expressive, plus individualisée, et de fait moins normative et moins institutionnalisée.

L’attachement à la démocratie domine toujours dans les jeunes générations et reste au cœur de leur répertoire politique. Néanmoins, les demandes de démocratie directe et de participation accrue des citoyens, sans la médiation des organisations ou des institutions politiques se font de plus en plus pressantes, et de façon encore plus marquée au sein de la jeunesse que dans l’ensemble de la population.

Les rouages de la démocratie représentative sont mis en cause et les jeunes ont endossé encore plus que leurs aînés les habits d’une citoyenneté critique, où la protestation est devenue un mode d’expression familier.

Le triptyque défiance-intermittence du vote-protestation définit le cadre d’un modèle de participation politique où les formes non conventionnelles sont assez largement investies, au risque même de la radicalité. Ainsi, parmi les moins de 35 ans, la justification de la violence pour défendre ses intérêts entraîne l’adhésion d’environ 30 % d’entre eux ces cinq dernières années.

Parmi les seniors de plus de 60 ans, celle-ci reste très en retrait sur l’ensemble de la période (15 points de moins que les moins de 35 ans en 2025).

Un cadre renouvelé du rapport à la citoyenneté

On observe dans les nouvelles générations des signes palpables d’une « déconsolidation démocratique », à savoir un affaiblissement de la croyance dans l’efficacité de la démocratie pour gouverner et répondre aux attentes des citoyens.

Le politologue Yasha Mounk utilise cette notion pour rendre compte de l’érosion de la confiance accordée aux institutions politiques représentatives dans nombre de démocraties contemporaines.

Dans la dynamique générationnelle, cette déconsolidation peut ouvrir la voie à de nouvelles formes de radicalités marquées par une polarisation aux deux extrêmes de l’échiquier politique et partisan à l’issue démocratique incertaine. La montée des populismes et des leaderships autoritaires en Europe et bien au-delà en est l’un des symptômes les plus patents.

Des seniors plus attachés à la démocratie que les moins de 35 ans

Parmi les moins de 35 ans, plus de quatre jeunes sur dix (42 %) sont d’accord avec l’idée que d’autres systèmes politiques sont aussi bons que la démocratie. Si l’on remonte dix ans en arrière, en 2014, ils étaient 29 % à partager le même avis.

Dans l’ensemble de la population, cette opinion a aussi progressé mais à un niveau plus faible, passant de 19 % à 34 %.

En revanche, et c’est une évolution notable, elle a nettement régressé parmi les seniors de plus de 60 ans, passant de 36 % à 23 %, soit une évolution en sens inverse par rapport aux plus jeunes.

Si la démocratie doit tenir, c’est donc davantage du côté des seniors qu’elle trouvera ses défenseurs que parmi les plus jeunes. Un constat qui peut dans l’avenir être lourd de conséquences politiques.

« Des jeunesses » plutôt qu’« une jeunesse »

S’ajoutent à ce tableau, des fractures intragénérationnelles qui rappellent les fractures sociales, culturelles, et politiques qui traversent la jeunesse. Celle-ci n’est pas une entité homogène. Elle est plurielle et divisée.

Ces fractures peuvent prendre le pas sur celles qui s’expriment au niveau intergénérationnel. Certains segments de la jeunesse, touchés par la précarité du travail et plus faiblement diplômés, ne sont pas exempts d’un repli identitaire favorable aux leaderships autoritaires d’extrême droite.

A contrario, dans la population étudiante et diplômée, à l’autre bout du spectre politique, plus active dans les mobilisations collectives, la tentation de la radicalité à gauche s’exprime.

Par ailleurs, au sein de la jeunesse issue de l’immigration, l’adhésion à certains communautarismes, non dénués de sectarisme et de séparatisme, peut remettre en cause l’universalisme républicain.

Une droitisation qui touche les jeunes générations

Les positionnements politiques des jeunes témoignent d’une certaine désaffiliation idéologique et partisane : 30 % des moins de 35 ans ne se sentent proches d’aucun parti, davantage les jeunes femmes que les jeunes hommes (respectivement 35 % et 27 %, soit un écart similaire à celui que l’on observe dans l’ensemble de la population).

Parmi ceux qui se reconnaissent dans un camp politique, comparés à leurs aînés, la gauche reste mieux placée : 34 % (contre 25 % des 60 ans et plus, et 31 % dans l’ensemble de la population). Le tropisme de gauche de la jeunesse résiste encore dans le renouvellement générationnel mais il a perdu de son acuité. En effet, les positionnements de droite (38 %), certes toujours inférieurs en nombre par rapport à ce que l’on constate chez leurs aînés (44 % des plus de 60 ans et 41 % dans l’ensemble de la population), y sont désormais plus nombreux. Le reste, se déclare au centre (28 %), qui est une position la plupart du temps utilisée comme refuge et expression d’un non-positionnement.

En l’espace de cinq ans (2020-2025), parmi les moins de 35 ans, les positionnements de droite sont passés de 28 % à 38 % (soit + 10 points), tandis que dans le même intervalle de temps les affiliations à la gauche n’ont quasiment pas progressé (33 % en 2020, 34 % en 2024). Un mouvement de droitisation est donc bien visible dans la jeunesse.

Évolution des positionnements à gauche et à droite selon l’âge, 2020-2024 (%)

La proximité déclarée envers le Rassemblement national a nettement progressé. En l’espace de quatre ans, elle est passée de 10 % à 22 % (+ 12 points) dans l’ensemble de la population, de 10 % à 19 % (+ 9 points) parmi les moins de 35 ans, et de 7 % à 20 % parmi les 60 ans et plus (+ 13 points). La progression de l’attractivité du Rassemblement national concerne donc tous les âges.

La gauche mélenchoniste, portée par La France insoumise, pénètre davantage les jeunes générations que les plus anciennes. Entre 2017 et 2025, on enregistre un faible surcroît (+ 3 points) de la proximité déclarée à La France insoumise qui passe de 11 % à 14 %, avec un pic en 2021 à 21 %. Parmi les 60 ans et plus, cette proximité a plutôt diminué, restant à un niveau bas, sans fluctuation, passant de 7 % à 3 % (soit - 4 points).

Évolution de la proximité envers le Rassemblement national selon l’âge (%)

La proximité ressentie pour le Rassemblement national supplante celle que suscite La France insoumise, y compris dans les jeunes générations. Certes à un niveau légèrement moindre que parmi les 60 ans et plus, mais le parti lepéniste apparaît plus ancré en termes de dynamique.

Les évolutions les plus repérables des positionnements politiques dans la chaîne des générations mettent donc en évidence l’équivoque de nombre d’idées reçues.

Plutôt que de s’affaisser, l’intérêt des jeunes pour la politique s’est tendanciellement rapproché du niveau de celui de leurs aînés. Par ailleurs, nos résultats ne révèlent pas de ruptures ou de discontinuités majeures entre les générations.

Les écarts observés sont dus à des phénomènes d’amplifications des effets de conjoncture et de période touchant l’ensemble de la population et qui sont plus visibles au sein des populations juvéniles. Néanmoins, les signes de déconsolidation démocratique sont plus marqués dans ces dernières, ce qui fragilise les conditions de viabilité et de renouvellement des régimes démocratiques dans l’avenir.

Anne Muxel ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.12.2025 à 16:12

Économie circulaire : un levier géopolitique pour la résilience et la durabilité de l’Union européenne ?

Pietro Beltramello, PhD candidate at HuManiS (UR7308: Université de Strasbourg and EM Strasbourg Business School), Université de Strasbourg

Ksenija Djuricic, PhD | ScD Stratégie, prospective, entrepreneuriat, Université de Strasbourg

Texte intégral (1904 mots)

Pauvre en terres rares, l’Union européenne doit s’adapter au nouveau contexte géopolitique. Le développement de l’économie circulaire peut l’aider à retrouver des marges de souveraineté. Mais un long chemin reste à parcourir.

Face aux tensions géopolitiques qui perturbent les chaînes d’approvisionnement et fragilisent la souveraineté économique du continent, l’Union européenne (UE) doit composer avec une dépendance accrue aux matières premières importées et un besoin impératif de renforcer son autonomie industrielle. Cette nécessité est d’autant plus pressante que Donald Trump ignore la souveraineté de l’UE, la laissant livrée à elle-même.

Cela constitue un signal d’alarme incitant l’UE à rechercher des solutions durables et résilientes pour son système socio-économique. Dans une telle situation géopolitique, l’économie circulaire pourrait-elle constituer un levier stratégique majeur pour l’Union européenne lui permettant de réduire sa dépendance aux importations de matières premières, de renforcer sa résilience économique et de stimuler l’innovation industrielle réinventant ainsi sa position sur l’échiquier mondial ?

Une dépendance aux matières premières

L’Union européenne importe la majorité des matières premières nécessaires à son industrie. Par exemple, 98 % des terres rares et du borate utilisées en Europe proviennent respectivement de Chine et de Turquie, tandis que 71 % des platinoïdes sont importés d’Afrique du Sud. Une telle dépendance expose le tissu industriel de l’UE aux fluctuations des marchés mondiaux et aux tensions géopolitiques, qui perturbent les chaînes d’approvisionnement.

À lire aussi : Russie : la logistique de l’ombre contre les sanctions occidentales

La guerre en Ukraine et la fermeture aux importations de ressources en provenance de Russie, notamment du gaz, ont révélé la fragilité industrielle de l’Europe, démontrant ainsi l’urgence d’une transition vers un modèle plus résilient. Pour répondre à cette crise, l’UE a mis en place des stratégies de « friendshoring », favorisant des échanges avec des pays partenaires de confiance.

Des accords ont été conclus avec le Canada et l’Australie en 2021 et 2024 pour sécuriser l’approvisionnement en terres rares et métaux critiques nécessaires à l’industrie des batteries et des technologies propres.

De plus, le traité de libre-échange entre l’Union européenne et le Mercosur, conclu récemment après plus de vingt ans de complexes négociations, vise à ouvrir les marchés et faciliter les échanges, notamment en matière de matières premières stratégiques.

Développer ses propres capacités

Malheureusement, le « friendshoring » ne garantit pas une autonomie durable dans un monde de plus en plus protectionniste. Les récents conflits commerciaux et les restrictions à l’exportation montrent que l’Europe doit développer ses propres capacités pour éviter d’être soumise aux fluctuations des alliances internationales.

Les tensions commerciales croissantes et les restrictions sur les exportations imposées par certains alliés afin de renforcer leur suprématie économique et stratégique, révèlent les vulnérabilités de l’UE. Cela souligne la nécessité de l’Union de développer des alternatives durables en interne garantissant ainsi son indépendance et sa résilience industrielle.

Développer l’économie circulaire

Pour répondre aux défis stratégiques et renforcer son autonomie industrielle, L’UE mise sur un développement accru de l’économie circulaire. Le Critical Raw Materials Act et le plan d’action pour l’économie circulaire visent à renforcer les capacités de recyclage et à encourager l’innovation dans la récupération des matériaux stratégiques. En premier lieu, l’UE investit dans la récupération du lithium et du cobalt issus des batteries usées, réduisant ainsi la nécessité d’extraire de nouvelles ressources.

Ensuite, l’Union travaille sur la relocalisation des installations de traitement en Europe afin de limiter l’exportation des déchets industriels vers des pays tiers garantissant un meilleur contrôle sur le recyclage des ressources stratégiques. Enfin, de nouvelles réglementations européennes incitent à l’écoconception et à la durabilité des produits. Toutefois, afin d’atteindre ces objectifs, il est important de résoudre un certain nombre de défis propres à l’Union européenne.

Indispensables investissements massifs

La transition vers une économie circulaire nécessite des investissements massifs, estimés à environ 3 % du PIB européen, un niveau comparable aux efforts de reconstruction économique après la Seconde Guerre mondiale. Or, le financement de telles initiatives est incertain, bien que l’Union européenne ait alloué plus de 10 milliards d’euros entre 2014 et 2020 pour soutenir cette transition, principalement dirigés vers la gestion des déchets. Pourtant, une meilleure allocation des resources – misant par example sur la réduction à la source, l’écoconception et l’efficacité matérielle – pourrait multiplier l’impact des investissements.

Le programme NextGenerationEU, qui a marqué un tournant avec l’émission de dette commune, semble aujourd’hui plus difficile à répliquer en raison des réticences de certains États membres. Par ailleurs, la montée des partis nationalistes en Europe rend plus complexe la mise en place de stratégies d’investissement communes.

Barrières industrielles

Bien que le recyclage puisse réduire la dépendance aux importations, il demeure aujourd’hui plus coûteux que l’extraction de nouvelles ressources. Cependant, des innovations récentes, telles que l’automatisation du tri des déchets par intelligence artificielle et l’optimisation des procédés chimiques, permettent de réduire progressivement ces coûts.

En outre, des incitations financières mises en place par l’UE, comme le Fonds pour l’innovation, ainsi que l’engagement de la Banque européenne d’investissement (BEI) pour orienter les capitaux vers des modèles économiques circulaires visent à industrialiser ces technologies et à les rendre plus compétitives.

Une harmonisation réglementaire nécessaire

L’efficacité de l’économie circulaire repose également sur une coordination entre les États membres. Aujourd’hui, les réglementations divergent d’un pays à l’autre, ce qui ralentit la mise en place de standards communs et d’incitations globales adaptées.

Un exemple particulièrement révélateur concerne le statut de la « fin du déchet ». Dans l’UE, un même flux peut être reconnu comme ressource secondaire dans un pays, tandis qu’il demeure juridiquement un déchet dans un autre : cette divergence bloque son transit transfrontalier et limite sa valorisation industrielle. Des travaux récents montrent comment les hétérogénéités limitent la création de marchés circulaires à l’échelle européenne.

On observe des asymétries similaires dans des secteurs clés pour la transition à l’économie circulaire. Dans le domaine des batteries, les obligations en matière de traçabilité, de recyclage et de contenu recyclé varient encore sensiblement entre les États membres, ce qui complique la mise en place de chaînes de valeur cohérentes. Le secteur du bâtiment illustre également ces désalignements : critères de performance, méthodes de diagnostic des matériaux, ou encore exigences de réemploi diffèrent selon les pays, ce qui freine l’essor d’un marché européen du réemploi ou du recyclage de matériaux de construction.

Ces divergences réglementaires, loin d’être anecdotiques, empêchent l’émergence d’un véritable marché circulaire européen capable de soutenir les investissements, de sécuriser les flux de matériaux et d'accélérer la transition industrielle.

L’UE pourrait mettre en place plusieurs mesures pour harmoniser ces réglementations, à savoir :

la création d’un marché unique des matériaux recyclés pour faciliter leur commercialisation ;

l’harmonisation des normes environnementales qui pourraient inciter les investissements transnationaux ;

le développement de crédits d’impôt et des subventions pour les entreprises adoptant des pratiques circulaires.

Face à une situation géopolitique où l’Union européenne compte de moins en moins d’alliés, l’économie circulaire apparaît comme un levier stratégique pour renforcer son autonomie industrielle et sa résilience économique. En capitalisant sur les forces de chaque État membre, l’UE pourrait construire un modèle commun, conciliant diversité et cohésion. Trouver un langage commun devient ainsi essentiel pour surmonter les défis liés aux contraintes budgétaires, à l’harmonisation réglementaire et aux investissements nécessaires, garantissant une transition efficace et durable vers l’autonomie.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

10.12.2025 à 16:12

Face aux défaillances des marques, les groupes de « haters » organisent leur riposte en ligne

Virginie Uger Rodriguez, Maître de Conférences en marketing, Université d’Orléans

Pierre Buffaz, Professeur assistant en Sciences de Gestion, EDC Paris Business School

Texte intégral (1122 mots)

Que disent les détracteurs d’une marque sur les réseaux ? Une nouvelle étude s’est penchée sur la dynamique des groupes de « haters » sur Facebook. En se fédérant, ces internautes engagés pallient certains manquements des marques qui les ont déçus.

D’ordinaire, les marques ont pour habitude de faire rêver ou d’être idéalisées par les consommateurs. Cependant, depuis quelques années, on note une aversion grandissante pour certaines d’entre elles. Aversion pouvant conduire jusqu’à la haine.

Avec 50,4 millions d’utilisateurs en France, les réseaux sociaux sont un terrain favorable à la propagation de cette haine.

Les consommateurs, fans de marques désireux de partager leurs créations, leur passion voire leur amour, n’hésitent pas à se regrouper au sein de communautés en ligne (groupes publics ou privés) hébergées sur ces réseaux.

Mais il est important de noter que les consommateurs ayant vécu une expérience négative avec une marque auront tendance à en parler plus ou à poster plus de commentaires négatifs que les consommateurs ayant vécu une expérience positive. Car il existe des communautés dont le point de convergence s’avère être la haine pour une marque donnée, notamment pour celles qui ne respectent pas le contrat de confiance établi avec les consommateurs : manquements ou défaillances dans les produits ou les prestations de services, retards de livraisons, vols annulés, pièces manquantes, airbags défectueux… Les marques concernées peuvent être issues de tous les secteurs d’activité. Les membres de ces communautés sont couramment appelés des haters, c’est-à-dire des détracteurs d’une marque.

Dans le cadre de nos travaux publiés dans Journal of Marketing Trends et présentés lors de conférences en France et à l’international, nous avons effectué une netnographie (analyse de données issues des médias sociaux, inspirée des techniques de l’ethnographie) au sein de deux communautés en ligne anti-marques (groupes Facebook). À noter que ces communautés étaient indépendantes des marques, ce qui signifie que celles-ci n’avaient aucune prise directe sur elles. Au total, ce sont plus de 1000 publications qui ont été collectées et analysées.

Une haine bien présente dans les discours des consommateurs

Plusieurs marqueurs permettent d’affirmer que les consommateurs au sein de ces groupes expriment leur haine de façon plus ou moins nuancée, allant d’une haine froide (peu vindicative) à une haine chaude (très virulente), par le vocabulaire utilisé, une ponctuation excessive, les émoticônes choisis…

La nature même des échanges peut être catégorisée selon quatre dimensions :

une dimension normative se référant aux comportements altruistes et d’entraide des membres pour pallier les défaillances des marques ;

une dimension cognitive exprimée à travers la sollicitation du groupe pour répondre à un besoin (question, problème rencontré, démarche à engager…) ;

une dimension affective comprenant l’expression des sentiments et des émotions des membres (déception, mécontentement, colère, dégoût, rage, haine) ;

et une dimension mixte relative aux discours mêlant des tons normatifs et affectifs.

La mise en place d’une structure organisationnelle et sociale

Les membres des groupes anti-marques s’organisent et se sentent investis de missions au travers des rôles qu’ils s’attribuent :

S’ils ont intégré ces groupes anti-marques, c’est que les consommateurs ont eu une expérience négative avec elles dans le passé ou bien, même s’ils ne sont pas consommateurs, qu’ils rejettent les valeurs qu’elles défendent ou représentent. En fonction de la marque et du caractère du fondateur de la communauté anti-marque, celle-ci est plus ou moins démocratique et tolère plus ou moins les discours antagonistes à la haine anti-marque.

À chaque niveau de haine sa réponse

Les manifestations de la haine au sein des communautés étudiées peuvent être catégorisées ainsi :

Pour pallier les défaillances de la marque, les consommateurs ont tendance à s’entraider au sein de la communauté en ligne anti-marque. Ils se partagent des informations et des bons plans. Ils s’apportent mutuellement du soutien tout en se servant de la communauté comme d’un exutoire. Globalement, les consommateurs réparent ou « bouchent les trous » que la marque aurait dû prendre en charge dans son contrat de confiance.

Quelles réponses apporter aux « haters » ?

Les communautés anti-marques peuvent avoir un potentiel de nuisance important se traduisant, entre autres, par une perte de clients et de fait une diminution du chiffre d’affaires.

Voici quelques pistes pour contenir la haine exprimée par certains consommateurs voire tenter de l’enrayer au sein de ces communautés :

une stratégie offensive avec une réponse directe à la communauté et à ses membres lorsque la marque est attaquée directement sur ses réseaux, en apportant des réponses oscillant entre le mea culpa, à travers une « publicité reconnaissant la haine », l’humour et l’entrée en dialogue avec les détracteurs ;

ou une stratégie défensive visant à identifier les communautés en ligne anti-marques, à surveiller leur activité, à comprendre leurs critiques et à mettre en œuvre des mesures correctives et/ou instaurer un dialogue.

Que les revendications des haters à l’égard des marques soient légitimes ou non, elles permettent de révéler des défaillances de marques parfois dramatiques voire illégales pouvant faire intervenir, en réaction, les pouvoirs publics.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

10.12.2025 à 16:12

Pour promouvoir la parité dans les cursus d’ingénieurs, la piste d’un concours spécifique

Diana Griffoulieres, Responsable d'ingénierie pédagogique numérique, EPF

Emmanuel Duflos, Professeur des universités et directeur de l'EPF École d'ingénieur-e-s, EPF

Liliane Dorveaux, PhD Mathématiques Appliquées,Chargée de Projet, EPF

Texte intégral (2071 mots)

Les concours d’accès aux écoles d’ingénieurs sont-ils pensés pour encourager la parité ? Une école tente depuis la rentrée 2025 de repenser ses voies de recrutement pour obtenir davantage de filles dans ses effectifs. Un dispositif trop récent pour en tirer des conclusions définitives mais qui apporte déjà des enseignements intéressants.

La sous-représentation des femmes en ingénierie s’explique en partie par des biais implicites de genre présents dans les processus de sélection académiques et professionnels dont la part de femmes plafonne juste en dessous du tiers des effectifs en cycle ingénieur où le taux reste autour de 29,6 %. Dans un contexte compétitif, les candidates tendent à être désavantagées, non pas en raison de compétences moindres, mais en raison de dynamiques compétitives et de stéréotypes de genre, influençant à la baisse leurs résultats.

L’un des phénomènes en jeu est le « risque du stéréotype » : la peur de confirmer un stéréotype négatif peut affecter les performances cognitives, notamment la mémoire de travail, réduisant ainsi les résultats des femmes lors d’épreuves exigeantes, même si elles réussissent mieux en dehors de ce contexte. Les différences de performances observées entre hommes et femmes dans les environnements compétitifs ne sont pas liées à des différences biologiques, mais à des attentes genrées et à des stéréotypes.

De nombreuses références bibliographiques décrivent comment les structures patriarcales favorisent les parcours masculins en valorisant les normes de compétition, notamment l’affirmation de soi et l’assurance, traits socialement encouragés chez les hommes mais souvent perçus comme inappropriés chez les femmes. Schmader, en 2022, a précisé l’impact des biais culturels et l’influence de l’environnement dans la limitation du choix des jeunes femmes pour les carrières scientifiques et techniques, malgré leur intérêt potentiel.

Dans une vision d’impact sociétal, l’EPF École d’ingénieurs (ex-École polytechnique féminine), l’une des premières grandes écoles en France à avoir formé des femmes au métier d’ingénieure, a créé le dispositif « ParityLab », un concept pensé pour attirer via des actions à court et moyen termes davantage de jeunes femmes vers les écoles d’ingénieurs.

Cette initiative s’appuie notamment sur les résultats de la grande enquête nationale « Stéréotypes et inégalités de genre dans les filières scientifiques », menée par l’association Elles bougent, en 2024, auprès de 6 125 femmes. Elle met en lumière les freins rencontrés par les filles dans les parcours scientifiques et techniques : 82 % déclarent avoir été confrontées à des stéréotypes de genre, et plus de la moitié disent souffrir du syndrome de l’imposteur – un obstacle à leur progression dans des environnements compétitifs. L’enquête Genderscan confirme ces constats, en se focalisant sur les étudiantes.

Une voie d’accès alternative

Le dispositif ParityLab a été conçu en réponse à ces enquêtes et aux biais de genre dans l’accessibilité des filles aux filières scientifiques et techniques, afin de minimiser ces biais et de valoriser leurs compétences tout au long de leur formation. Il se compose de deux parties : un concours d’accès alternatif via Parcoursup, réservé exclusivement aux femmes (validé par la direction des affaires juridiques de l’enseignement supérieur) et un parcours de formation spécifique d’insertion professionnelle consacré aux femmes, qui est proposé depuis cette rentrée aux candidates retenues.

Un panel diversifié de 40 jurés a été constitué pour assurer le processus de sélection. Parmi eux, 26 provenaient du monde de l’entreprise et 14 du corps enseignant et des collaborateurs de l’école. Pour sensibiliser tous les membres du jury sur l’importance de faire une évaluation plus inclusive, un atelier de sensibilisation aux stéréotypes de genre leur a été dispensé.

Afin de faire une évaluation plus enrichie et équilibrée des candidates, les jurés ont travaillé en binôme pendant les sessions de sélection reposant sur une étude de dossier scolaire, une mise en situation collective et un échange individuel. Le binôme était constitué d’un représentant de l’industrie et d’un représentant de l’école afin d’enrichir l’analyse des candidatures par leurs regards croisés multidimensionnels et réduire les biais.

L’épreuve collective a permis via une problématique liée à l’ingénierie fondée sur des documents, d’évaluer la créativité, le leadership ou la capacité d’exécution sans toutefois aborder les connaissances disciplinaires. L’entretien individuel, quant à lui, repose sur un échange librement choisi par la candidate (engagement associatif, sport, intérêt sur un sujet scientifique ou non), visant à révéler sa personnalité et ses aptitudes à communiquer.

Premier bilan du concours

Afin d’évaluer le dispositif mis en place, une enquête a été conçue pour collecter les retours des membres du jury et des candidates sélectionnées à travers deux questionnaires différents. De plus, un retour d’expérience a été demandé à certains membres du jury afin de collecter des données qualitatives sur leur expérience.

Les réponses des candidates ont été recueillies par un questionnaire rempli par 23 candidates sélectionnées sur 35 possibles (65,7 %). Il était composé de 14 questions fermées, utilisant une échelle de Likert à cinq niveaux, et neuf questions ouvertes. Il avait pour objectif de comprendre les motivations des candidates à passer le concours, d’identifier les obstacles ou les découragements qui ont pu freiner leur intérêt pour les sciences et les actions qui pourront encourager davantage de jeunes filles à s’orienter vers les filières scientifiques et technologiques.

L’analyse des réponses montre que 56 % des répondantes doutaient de leurs capacités et 22 % se déclaraient neutres sur ce point. La peur d’être isolée dans la classe est moins marquée, seules 30 % des candidates se sentant concernées. Les réponses sur les préjugés sexistes sont mitigées, 30 % des candidates ont déclaré avoir entendu des commentaires décourageants, 26 % se sont déclarées neutres et 43 % ont affirmé ne pas avoir été confrontées à ce type de remarques.

Quand il leur a ensuite été demandé d’imaginer ce qui pouvait encourager d’autres filles à s’orienter vers les filières scientifiques, les répondantes placent en tête de leurs réponses l’existence de modèles féminins inspirants, une meilleure promotion des métiers liés à l’ingénierie et la déconstruction des stéréotypes de genre dès l’enfance.

Une dynamique encourageante

Le concours a permis de renforcer significativement la présence des femmes dans la formation scientifique généraliste de l’EPF École d’ingénieurs en 2025. Sur les 50 places ouvertes cette année, 35 ont été pourvues, avec un taux de sélection de 32 % parmi les 108 candidates. Une critique fréquente à l’égard de ce type de dispositif est la peur d’une réduction des places pour les hommes, relevant d’une vision « à somme nulle ». Ici, les places créées pour cette nouvelle voie s’ajoutent à l’existant et aucun quota n’est prélevé sur les admissions classiques.

Ces chiffres s’inscrivent dans une dynamique positive et encourageante. Une progression remarquable des néo-bachelières recrutées de + 11,5 % de jeunes femmes en première année du cycle ingénieur.

Il est à noter que la voie d’accès classique affiche elle aussi des résultats en progrès en matière de parité avec une augmentation du nombre de jeunes femmes de + 5 %, probablement en lien avec différentes stratégies internes et externes de lutte contre les biais de genre.

Les étudiantes du ParityLab suivent le même programme académique que les autres élèves de la formation généraliste de première année. En revanche, elles bénéficient (en plus) de modules ciblés sur les questions de stéréotypes et soft skills. Cette première cohorte devient un terrain d’étude pertinent pour mieux comprendre les freins à l’orientation vers ces filières encore majoritairement masculines.

Obtenir un échantillon plus large

La mise en place du concours a été l’objet d’une réflexion approfondie sur la mise en œuvre d’un processus de sélection équitable. Des actions de sensibilisation destinées aux membres des jurys, afin de réduire les biais liés aux stéréotypes de genre et d’évaluer les compétences transversales sans mettre en avant les compétences disciplinaires des candidates, ont été mises en place. Les retours sur l’atelier collectif ont été perçus positivement par les jurys et par les candidates. Cependant des pistes d’améliorations (logistique, gestion de temps) sont envisagées pour la prochaine session.

ParityLab constitue un dispositif qui pourra être transférable à d’autres écoles d’ingénieurs qui souhaitent renforcer la représentation des femmes dans leurs programmes. Les recherches futures pourraient aborder les mêmes problématiques avec un échantillon plus large pour confirmer les résultats obtenus dans cette étude, et mesurer son impact sociétal.

Diana Griffoulières es docteure en Sciences de l’éducation et elearning. Elle mène des travaux de recherche appliquée en éducation et est responsable de l’ingénierie pédagogique numérique à l'EPF Ecole d'Ingénieurs. Diana Griffoulières ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article.

Emmanuel Duflos est membre de la Conférence des directeurs des écoles françaises d'ingénieurs. Il en est le Président actuel. La CDEFI est une conférence inscrite dans le code de l'éducation qui a vocation à représenter les écoles d'ingénieurs auprès de l'Etat. La CDEFI est engagée depuis de nombreuses années dans des actions dont l'objectif est de promouvoir les formations d'ingénieurs auprès des femmes. Emmanuel Duflos est aussi le directeur général de la Fondation EPF, reconnue d'utilité publique (FRUP), qui a pour mission de concourir à la formation des femmes en sciences et technologies. La Fondation EPF porte l'école d'ingénieurs EPF dont il est également le directeur général. La Fondation EPF et l'EPF sont à l'origine de l'expérimentation à l'origine de cet publication. En tant que FRUP, la Fondation EPF partage son savoir et son savoir-faire sur le projet ParityLab qui concoure à sa mission.

Liliane Dorveaux est co-fondatrice et Vice Présidente de WOMENVAI , ONG ayant le statut ECOSOC à l'ONU. Liliane DORVEAUX ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article.

10.12.2025 à 16:11

Les liens de la pensée de Nick Land avec le (néo)nazisme

Arnaud Borremans, Chercheur associé à l'Institut de recherche Montesquieu (IRM), Université Bordeaux Montaigne

Texte intégral (3254 mots)

Cette seconde analyse de l’œuvre de Nick Land, philosophe contemporain dont l’impact est réel sur une partie au moins du mouvement MAGA aux États-Unis et sur de nombreux groupuscules d’ultradroite dans le monde, met en évidence le rapport complexe que l’idéologue des « Lumières sombres » entretient avec le nazisme himmlérien et avec les organisations qui, aujourd’hui encore, s’y réfèrent.

Comme souligné par Philosophie Magazine et évoqué dans notre article précédent sur Nick Land, des connexions existent entre la pensée de ce philosophe britannique – père du concept de « Lumières sombres » en vogue dans une partie du mouvement MAGA autour de Donald Trump – et certains éléments du néonazisme.

Au-delà des liens les plus apparents des Lumières sombres avec le racisme et l’autoritarisme, d’autres éléments troublants semblent attester d’une certaine proximité entre la pensée landienne et l’idéologie nazie ou ses différentes évolutions post-1945.

À quel point le fond de la pensée de Land – et donc de celle de ses fidèles qui murmurent à l’oreille de Donald Trump – s’enracine-t-il dans l’idéologie du IIIe Reich ?

Des loups-garous et du Soleil noir

Dans son essai Spirit and Teeth (1993), Land emploie le terme de « loups-garous » pour qualifier la filiation philosophique dont il se réclame lui-même. Il décrit cet héritage comme celui des penseurs qui ont rejeté à la fois la logique platonicienne et la morale judéo-chrétienne, leur préférant une approche immanentiste, reconnaissant une valeur aux instincts animaux et admettant l’absurdité de rechercher une quelconque vérité objective. Parmi lesdits penseurs, il inclut Friedrich Nietzsche et Emil Cioran, c’est-à-dire un philosophe largement récupéré par les nazis et un intellectuel affilié au mouvement fasciste dans son pays, la Roumanie.

De plus, ce terme de « loups-garous » fait écho à la tentative des nazis, alors que les armées alliées et soviétiques rentraient en Allemagne, de constituer des unités de partisans dits « loups-garous » (Werwolf), censés repousser les envahisseurs et exécuter les traîtres.

Les renvois implicites vers le souvenir du IIIe Reich par ce choix de mot est déjà intrigant de la part de Land. Cependant, il ne s’en est pas tenu là. Il a aussi mobilisé la notion de « Soleil noir » pour un article en ligne censément dédié à l’œuvre du philosophe français Georges Bataille. Or, une recherche amène à retrouver les termes précis de Bataille : il n’a jamais traité d’un « Soleil noir » mais d’un « Soleil pourri ». Cette substitution d’expressions par Land pose question : s’agit-il d’une erreur grossière de sa part ou d’un « dog whistle » (« sifflet à chien », c’est-à-dire un message discret destiné à mobiliser les franges les plus radicales de ses sympathisants) ?

En effet, il est troublant de relever que le Soleil noir est un symbole retrouvé dans le château de Wewelsburg où siégeait Heinrich Himmler, chef de la Schutzstaffel (SS), principale milice du régime nazi. Le Soleil noir fut nommé ainsi après guerre par l’ex-officier SS Wilhelm Landig, comme démontré par l’historien Nicholas Goodrick-Clarke.

Ledit Landig a constitué dans les années 1950 un groupe occultiste à Vienne et a propagé avec ses affiliés un narratif autour du Soleil noir, présentant les nazis en perpétuateurs d’une tradition initiatique plurimillénaire et réaffirmant la justesse de leurs thèses racistes et eugénistes. De plus, ils affirmaient que des colonies nazies survivaient en Antarctique et allaient un jour reprendre le contrôle du monde à l’aide d’armes miracles, notamment de soucoupes volantes.

Aussi surprenantes ces correspondances soient-elles, elles ne prouvent rien en soi ; il peut s’agit uniquement de bévues de Land qui aurait mal anticipé les associations d’idées induites par ses mots. Cependant, ce ne sont pas les seuls éléments qui étayent que Land aurait le (néo)nazisme comme référence implicite.

Des liens de Land avec l’Ordre des neuf angles

L’Ordre des neuf angles (O9A) est une mouvance néonazie, occultiste et sataniste théiste, apparue en Angleterre à la fin des années 1960. Au-delà de son magma idéologique, elle est connue pour comprendre en son sein plusieurs organisations effectives, notamment la Division Atomwaffen et Tempel ov Blood aux États-Unis, Sonnenkrieg au Royaume-Uni, ou encore le groupe 764 au niveau mondial. Ces organisations sont traquées par plusieurs services de police, dont le FBI, pour des faits criminels de droit commun et même quelques attentats terroristes.

Or, Land a exprimé sa solidarité à leur égard sur un blog nommé Occult Xenosystems, maintenant fermé, et dont il est acquis par des indiscrétions d’utilisateurs sur une autre page qu’il en était bien l’administrateur.

Land y louait l’O9A pour la qualité de sa production intellectuelle, notamment celle de David Myatt (réputé comme le fondateur de l’O9A, derrière le pseudonyme d’Anton Long). Tout en faisant mine de s’en distinguer – il écrit notamment « le peu que j’ai appris sur David Myatt ne m’a pas attiré vers lui en tant que penseur ou activiste politique, malgré certaines caractéristiques impressionnantes (notamment son intelligence et son classicisme polyglotte) » –, il garde le silence sur le caractère antisocial et criminel du mouvement.

Une autre anecdote relance les spéculations sur l’investissement réel de Land auprès de l’O9A. Le journaliste britannique Tony Gosling a révélé à la radio, en 2022, qu’il avait connu Land au lycée. Selon lui, outre que Land serait le fils d’un cadre de la société pétrolière Shell ayant travaillé en Afrique du Sud (ce qui pourrait expliquer sa sympathie pour le capitalisme et le ségrégationnisme réaffirmée dans Les Lumières sombres), il aurait eu comme surnom, sans que Gosling ne fournisse de raisons objectives pour pareil sobriquet, « Nick the Nazi ».

Gosling sous-entend que ce surnom renvoyait bien à la sensibilité politique que ses camarades de classe imputaient à Land. Selon lui, Land avait surpris tout le monde lorsqu’il déclara, en 1978, qu’il avait pris la décision de devenir « communiste ». Sans présupposer de sa véracité, cette histoire intrigue parce qu’elle rappelle une stratégie assumée de l’O9A : l’infiltration et le noyautage d’autres organisations pour leur voler des ressources (idées, matériels, argent, recrues) et aussi pour leur nuire de l’intérieur, notamment en leur faisant commettre des erreurs.

Dès lors, une question se pose : Land aurait-il toujours été un militant de l’O9A qui aurait infiltré le CCRU, milieu de gauche, pour lui faire promouvoir l’accélérationnisme avec l’arrière-pensée que ce concept servait les intérêts de sa cause véritable, le néonazisme satanique ?

La piste de Miguel Serrano et du Black Order comme précurseurs de l’hyperstition

Parmi les organisations affiliées à l’O9A, une retient particulièrement l’attention : le Black Order qui couvre la zone Pacifique, notamment les Amériques du Nord et du Sud, l’Australie et la Nouvelle-Zélande. Outre son emploi assumé de la violence qui a déjà entraîné la commission d’attentats comme l’attentat de Christchurch en mars 2019 et son nom qui rend hommage explicitement au premier cercle d’Himmler, il apparaît que le fondateur du Black Order est un personnage clé reliant plusieurs protagonistes de ce sujet.

En effet, selon les historiens Nicholas Goodrick-Clarke et Jacob C. Senholt, Kerry Bolton est le distributeur international des ouvrages d’Anton Long, le chef de l’O9A dont Bolton serait par ailleurs un adepte. De plus, Bolton est aussi un associé de l’idéologue russe Alexandre Douguine qui échange directement et même publiquement avec Land. Il apparaît donc évident que si Land a un lien structurel avec l’O9A, celui-ci passe par le Black Order de manière privilégiée.

Une autre corrélation laisse songeur et laisse accroire à une causalité. L’un des fondateurs du Black Order fut Miguel Serrano (1917-2009), ancien diplomate chilien et sympathisant des nazis. Après la Seconde Guerre mondiale, Serrano sera connu comme auteur relayant dans ses ouvrages un narratif similaire à celui du groupe de Landig. Il ajoutait qu’Hitler ne serait pas mort à la fin de la guerre et qu’il reviendrait victorieux de sa base secrète en Antarctique, aidé de troupes de surhommes aryens armés d’artefacts magiques pour conquérir le monde.

Cette dimension eschatologique joue sur une figure du héros en sommeil, comme le roi Arthur ou le roi Sébastien au Portugal. Cette considération amène à se demander si Serrano a propagé ce narratif parce qu’il y croyait sincèrement ou parce que, fasciné par les travaux de Carl Jung sur l’inconscient collectif, il aurait essayé par ce biais d’influencer les esprits et de préparer le terrain mental à un retour du nazisme.

Cette démarche consistant à répandre avec force une idée, en la rendant séduisante autant que possible et en espérant qu’elle altère la réalité dans une certaine mesure, rappelle l’hyperstition de Land. Que Land ait eu l’entreprise de Serrano comme modèle inavoué (et inavouable) ne serait pas absurde, Jung étant une référence assumée par Land également depuis le CCRU.

Plus troublant, Land partage avec Serrano son attachement à une forme d’immanentisme et donc de néopaganisme, si bien qu’ils ont tous les deux refusé l’étiquette de sataniste. Land a ainsi déclaré, en réaction à une vidéo du polémiste états-unien Tucker Carlson, qu’il ne se considérait pas comme sataniste, du moins au sens théiste du terme. De son côté, Serrano a employé l’adjectif « sataniste » pour dénigrer les Juifs.

De la place de Land et de ses fidèles au sein de la mouvance néonazie

Néanmoins, aussi convaincants soient ces éléments, est-ce suffisant pour considérer la pensée politique de Land comme une sous-composante du (néo)nazisme, ou comme une branche distincte mais apparentée parmi les mouvements illibéraux ?

Tout le problème est que Land a lui-même entretenu l’ambiguïté sur des aspects cruciaux de son positionnement idéologique qui pourraient le rapprocher du nazisme. Ainsi, il s’est revendiqué « hyperraciste ». Or des divergences persistent sur le sens du terme : certains le comprennent comme un constat transhumaniste sur le fossé que les améliorations technologiques de l’humain vont creuser entre les élites, qui y auront accès, et le reste de la population ; d’autres y entendent une accentuation des « traits raciaux » par choix politique, ou du moins une accentuation de la ségrégation raciale via la technologie. À la lecture de l’article d’origine par Land, il semble concilier les trois interprétations en même temps.

Pareillement, sa complicité avec Alexandre Douguine pose question : si Land est vraiment un sympathisant inavoué du néonazisme, comment expliquer son dialogue continu jusqu’à cette fin d’année 2025 avec Douguine ? Il y fait mention durant son intervention dans l’émission The Dangerous Maybe d’octobre 2025. En effet, Douguine se définit comme un eurasiste et s’oppose donc à la fois à l’atlantisme anglo-américain et à la figure mythifiée de l’ennemi nazi. Une hypothèse est que leur perspective occultiste partagée les amène à considérer leurs camps comme deux forces antagonistes mais complémentaires, en termes métaphysiques. Cette hypothèse semble étayée par Land lui-même qui l’a mentionnée brièvement, en disant que Douguine voyait en lui un sataniste mais aussi un gnostique comme lui-même, contribuant à la même œuvre mais depuis l’autre bord.

En tout cas, l’influence en retour de Land sur les dernières générations de néonazis est dorénavant indéniable. Comme décrit par l’éditorialiste Rachel Adjogah, il existe une frange du mouvement néonazi qui se réclame fièrement de l’accélérationnisme landien, notamment en recourant à – ou même en créant – des cryptomonnaies et, surtout, en développant des chatbots romantiques tels que « Naifu », clairement biaisés pour relayer des théories du complot antigouvernementales : l’IA et la relation parasociale sont ainsi mises au service de la propagande néonazie.

Qui plus est, lesdits néonazis sont ostensiblement d’inspiration himmlérienne : ils ont repris le Soleil noir à leur compte et s’intéressent à l’occultisme, quitte à se revendiquer, en plus, du thélémisme, la religion créée par l’occultiste anglais Aleister Crowley, lui-même référence pour Land.

Arnaud Borremans ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.12.2025 à 16:07

Dans les torrents, des insectes tissent de minuscules filets de pêche qui inspirent de nouveaux matériaux

Christophe Mori, Maitre de conférences, Université de Corse Pascal-Paoli

Texte intégral (1519 mots)

Au fond des torrents et des ruisseaux, de petites larves d’insecte construisent des filets pour attraper leur nourriture et font preuve d’une intelligence remarquable pour s’adapter au courant. Des comportements qui inspirent nos propres innovations techniques.

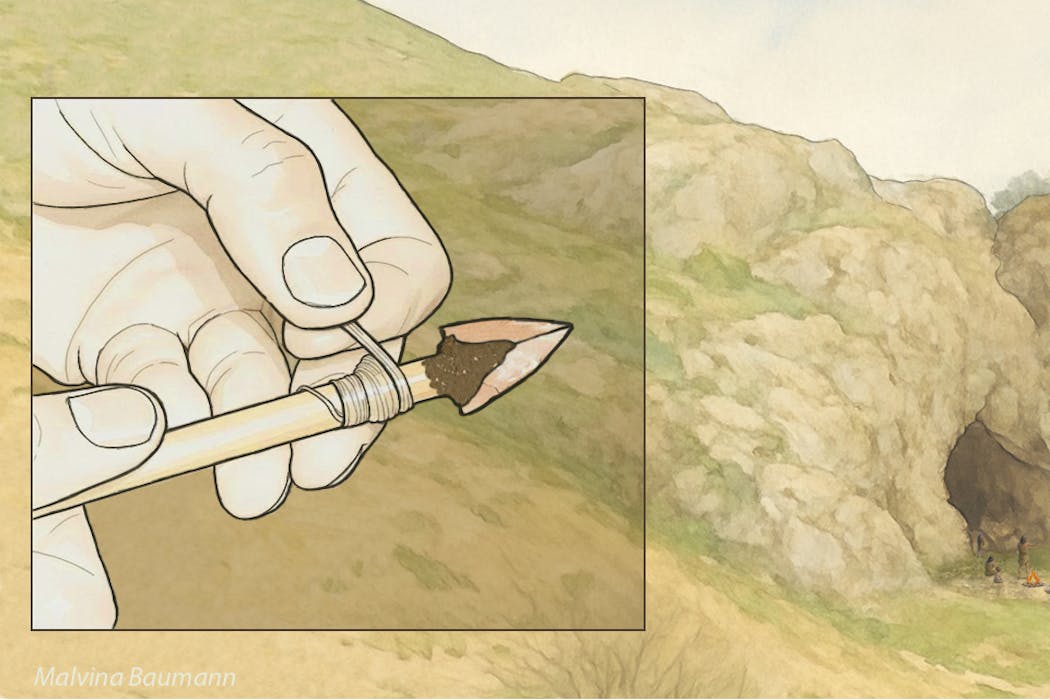

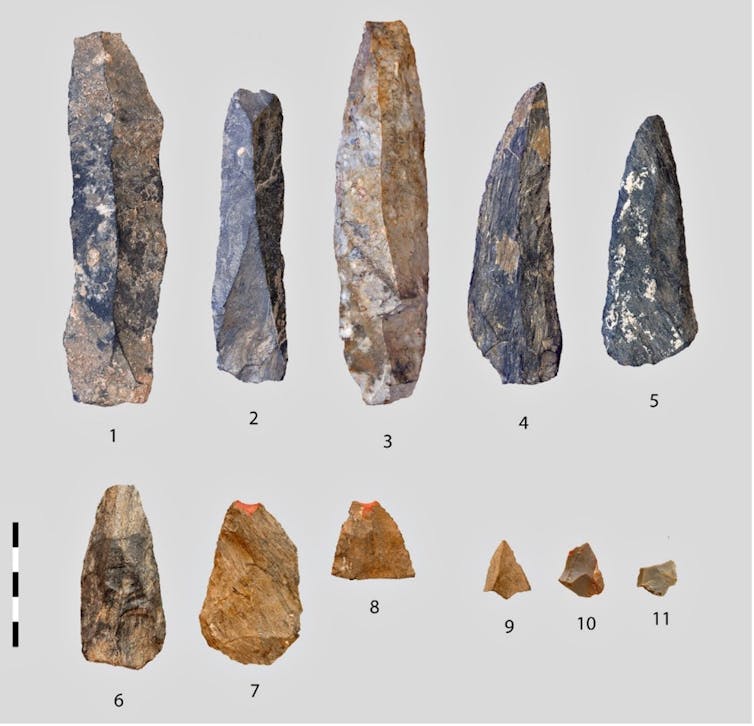

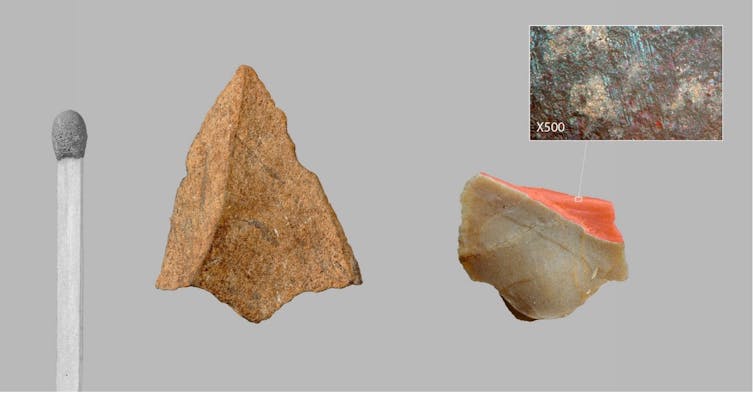

Imaginez-vous au bord d’un torrent, où l’eau surgit avec une force capable d’emporter des pierres. Au fond de ce tumulte, des larves de quelques millimètres, non seulement survivent, mais prospèrent en bâtissant des pièges ingénieux pour capturer leur nourriture. Sur leurs filets de soie de 2 à 3 cm de diamètre, on les voit s’affairer, le nettoyant régulièrement des petits morceaux de feuilles, de bois, des algues et des petits organismes qui s’y piègent.

Ces larves sont des hydropsychés, des insectes de l’ordre des trichoptères. Après avoir vécu sous la forme de larve dans une rivière pendant un à deux ans, ils s’envolent une fois leur forme adulte atteinte, durant laquelle il ressemble à un petit papillon de nuit. La fin de leur vie sera alors très courte, de 10 à 20 jours seulement.

Les hydropsychés, petits ingénieurs des ruisseaux

Les hydropsychés sont des insectes aquatiques ingénieux qui construisent ces tamis de soie pour filtrer passivement leur nourriture dans les eaux courantes. Cette capacité démontre une réelle intelligence comportementale, d’autant qu’ils savent s’ajuster aux flux de nutriments et qu’elles défendent leur territoire. Les larves tricotent des mailles fines (entre 1/50 e et 1/10 e de mm) adaptées à la vitesse du courant : plus il est fort, plus elles fabriquent un filet aux mailles serrées pour résister au courant ! Et lorsqu’il est obstrué ou endommagé, par exemple par des sédiments ou un courant trop fort, elles sont capables de le reconstruire ou le modifier. Il reste à comprendre le déclencheur précis de cette adaptation – est-ce purement génétique ou influencé par l’apprentissage individuel ?

Un si petit organisme, de seulement 1 à 2 cm de long, et qui possède un cerveau de 0,3 mm3 est non seulement capable de concevoir son filet avec une maille variable, de l’ancrer au substrat et de l’orienter face au courant. Mais il est sait aussi repousser ses congénères qui pourraient s’installer trop près et lui voler sa pêche ! Pour cela, les hydropsychés utilisent des ultrasons (d’une fréquence de 64 à 100 kHz, bien au-delà de ce que l’oreille humaine peut percevoir) pour indiquer leur présence à leurs voisins.

À la manière des cigales, les larves génèrent ces sons par stridulation, en frottant certaines parties de leur corps entre elles. Cette technique acoustique facilite leur navigation dans le tumulte sonore des eaux agitées, et est associée à des signaux chimiques tels que des phéromones qui facilitent l’identification et l’interaction sociale dans des milieux agités.

Des petites larves témoin de la qualité des eaux

Dans les communautés aquatiques, les hydropsychés coexistent avec d’autres espèces filtreuses, comme des larves de diptères, pour optimiser les ressources. Elles influencent la stabilité des cours d’eau en modulant les sédiments organiques et les différents flux nutritifs. Les organismes filtreurs sont de véritables nettoyeurs des rivières et des torrents, de petits ingénieurs qui améliorent la qualité des eaux. Ils sont déterminants dans l’architecture des écosystèmes d’eaux courantes, puisqu’ils constituent des proies pour les autres organismes, et sont donc à la base des chaînes alimentaires.

D’un point de vue morphologique, les branchies spécialisées des hydropsychés leur permettent d’extraire l’oxygène même dans des conditions tumultueuses ou déficientes. Cependant, ce sont aussi des organismes fragiles. Cela en fait de bons indicateurs biologiques qui servent aux scientifiques à évaluer la qualité de l’eau et les impacts de la pollution ou du changement climatique.

De plus, les hydropsyché inspirent le biomimétisme pour des technologies filtrantes durables, des colles aquatiques et la recherche médicale. Contrairement à la soie de ver à soie ou d’araignée, celle des hydropsychés est synthétisée sous l’eau, ce qui lui confère une résistance exceptionnelle à l’humidité, une haute élasticité et une biodégradabilité contrôlée. Ces caractéristiques en font un modèle idéal pour développer des biomatériaux innovants en médecine.

Quand l’hydropsyché inspire nos propres innovations

Dans ce monde aquatique en perpétuel mouvement, ces organismes démontrent que la survie dépend d’une vigilance constante et de l’adaptation face à l’instabilité. L’humanité peut s’inspirer de cette résilience et, plus spécifiquement, des stratégies de ces petits insectes aquatiques. La soie des larves d’hydropsychés intéresse la recherche, car elle adhère facilement aux surfaces immergées tout en restant flexible. Elle présente également une résistance mécanique jusqu’à plusieurs fois celle de l’acier à poids égal, n’induit pas de réactions immunitaires fortes et est biodégradable sans laisser de résidus toxiques.

En imitant la composition de la soie des larves d’hydropsyché, les scientifiques développent des colles synthétiques qui fonctionnent en milieu humide, comme dans le corps humain. Ces adhésifs pourraient révolutionner la chirurgie en permettant de refermer des tissus mous (comme le foie ou le cœur) sans points de suture, réduisant les risques d’infection et accélérant la guérison. Des prototypes sont déjà testés pour sceller des vaisseaux sanguins ou réparer des organes internes.

Le filet adaptable des hydropsychés inspire aussi des filtres intelligents qui ajustent leur porosité selon le débit d’eau et la taille des particules, et qui seraient utiles dans les usines de traitement des eaux et les stations d’épuration. Ce composé intéresse aussi les industries marines, pour créer des matériaux qui absorberaient l’énergie des vagues sans se briser, prolongeant la durée de vie des structures. Cela pourrait notamment être exploité par le secteur de l’énergie, pour les éoliennes marines ou les hydroliennes.

Les habitants des cours d’eau : un exemple à suivre

En nous inspirant de ce petit ingénieur, nous ouvrons des voies pour des avancées concrètes. Les solutions les plus élégantes et durables ne viennent pas toujours de laboratoires, mais souvent de la nature elle-même, où l’ingénieuse simplicité du vivant surpasse notre créativité. Et à l’instar des communautés d’organismes fluviaux qui se soutiennent mutuellement, les sociétés humaines doivent établir des réseaux solidaires pour affronter l’incertitude. La remarquable résilience de ces larves nous exhorte à repenser nos modes de vie, en mettant l’accent sur une adaptation préventive plutôt que sur une réaction tardive.

En fin de compte, les hydropsychés et les organismes aquatiques en général nous offrent un exemple à suivre : dans un environnement instable, la survie réside dans la diversité des adaptations et une réelle persévérance. Dans un monde en mutation, elle n’est pas innée, mais elle peut être cultivée. Ces organismes nous montrent que même dans l’agitation structurelle permanente, la vie persiste. En protégeant les écosystèmes fluviaux, nous préservons non seulement la biodiversité, mais aussi un trésor d’inspirations pour un avenir plus résilient et innovant.

Cet article est publié dans le cadre de la Fête de la science (qui a lieu du 3 au 13 octobre 2025), dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « Intelligence(s) ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Christophe Mori ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.12.2025 à 14:12

Sur Pornhub, un simple message suffit à dissuader les utilisateurs cherchant des vidéos pédopornographiques

Joel Scanlan, Senior Lecturer in Cybersecurity and Privacy, University of Tasmania

Texte intégral (1573 mots)

La sécurité des utilisateurs doit être intégrée à la conception des plateformes numériques. Elle n’est pas forcément complexe ou coûteuse, contrairement à ce que prétendent les entreprises numériques. Une expérience, menée sur la plateforme pornographique Pornhub, montre qu’un simple message adressé aux internautes cherchant des images pédopornographiques est fort dissuasif.

Le mot d’ordre officieux de l’industrie tech pendant deux décennies était « Move fast and break things », qu’on pourrait traduire par « aller vite quitte à tout casser ». Une philosophie qui a brisé bien plus que les seuls monopoles des taxis ou le modèle d’affaires des chaînes hôtelières. Elle a aussi façonné un monde numérique rempli de risques pour les plus vulnérables.

Pour la seule année fiscale 2024-2025, l’Australian Centre to Counter Child Exploitation a reçu près de 83 000 signalements de contenus d’exploitation sexuelle d’enfants en ligne (CSAM), principalement sur des plateformes grand public – une hausse de 41 % par rapport à l’année précédente.

En Australie, avec l’entrée en vigueur cette semaine de l’interdiction d’utiliser les réseaux sociaux pour les moins de 16 ans, ainsi que la mise en place de la vérification de l’âge pour les utilisateurs connectés aux moteurs de recherche le 27 décembre et pour les contenus réservés aux adultes le 9 mars 2026, nous atteignons un moment charnière – mais il faut bien comprendre ce que cette régulation permet et ce qu’elle laisse de côté. (Note du traducteur : En France, la loi du 7 juillet 2023 fixe à 15 ans l’âge minimal pour l’inscription et l’utilisation des réseaux sociaux).

L’interdiction empêchera une partie des enfants d’accéder aux plateformes (s’ils ne la contournent pas), mais elle ne corrige en rien l’architecture toxique qui les attend lorsqu’ils y reviendront. Elle ne s’attaque pas non plus aux comportements nocifs de certains adultes. Nous avons besoin d’un changement réel vers un devoir de vigilance numérique, qui obligerait légalement les plateformes à anticiper les risques et à les atténuer.

Le besoin de penser la sécurité dès la conception

Aujourd’hui, la sécurité en ligne repose souvent sur une approche dite « whack-a-mole », une référence à ce jeu d’arcade qui consiste à donner des coups de maillet sur la tête de taupes émergeant aléatoirement de quelques trous. De fait, les plateformes attendent que les utilisateurs signalent des contenus nocifs, puis les modérateurs les retirent. C’est une méthode réactive, lente, et souvent traumatisante pour les modérateurs humains qui y participent.

Pour remédier réellement au problème, il faut intégrer la sécurité dès la conception. Ce principe impose que les dispositifs de protection soient inscrits au cœur même de l’architecture de la plateforme. Il dépasse la simple restriction d’accès pour interroger les raisons pour lesquelles la plateforme permet, à l’origine, l’existence de mécanismes menant à des usages nocifs.

On en voit déjà les prémices lorsque des plateformes marquées par des précédents problématiques ajoutent de nouvelles fonctions – comme les « connexions de confiance » sur Roblox, qui limitent les interactions dans le jeu aux personnes que l’enfant connaît aussi dans la vie réelle. Cette fonction aurait dû être intégrée dès le départ.

Au CSAM Deterrence Centre, dirigé par Jesuit Social Service en partenariat avec l’Université de Tasmanie, nos travaux contredisent le discours récurrent de l’industrie selon lequel assurer la sécurité serait « trop difficile » ou « trop coûteux ».

En réalité, nous avons constaté que des interventions simples et bien conçues peuvent perturber des comportements nocifs sans nuire à l’expérience des autres utilisateurs.

Perturber les comportements dangereux

L’une de nos découvertes les plus marquantes provient d’un partenariat avec l’un des plus grands sites pour adultes au monde, Pornhub. Lors de la première intervention de dissuasion évaluée publiquement, lorsqu’un utilisateur cherchait des mots-clés liés aux abus sur mineurs, il ne se retrouvait pas face à un écran vide. Un message d’avertissement s’affichait et un chatbot l’orientait vers une aide thérapeutique.

Nous avons observé une baisse des recherches de contenus illégaux, et plus de 80 % des utilisateurs confrontés à cette intervention n’ont pas tenté de rechercher ces contenus à nouveau sur Pornhub durant la même session.

Ces données, cohérentes avec les résultats de trois essais contrôlés randomisés que nous avons menés auprès d’hommes australiens âgés de 18 à 40 ans, démontrent l’efficacité des messages d’avertissement.

Elles confirment également un autre constat : le programme Stop It Now (Australie) de Jesuit Social Service, qui propose des services thérapeutiques aux personnes préoccupées par leurs sentiments envers les enfants, a enregistré une forte augmentation des recommandations web après que le message d’avertissement affiché par Google dans les résultats de recherche liés aux contenus d’abus sur mineurs ait été amélioré plus tôt cette année.

En interrompant le parcours de l’utilisateur par un message clair de dissuasion, on peut empêcher qu’une pensée nocive se transforme en acte dangereux. C’est de la « safety by design » (« sécurité dès la conception »), utilisant l’interface même de la plateforme pour protéger la communauté.

Rendre les plateformes responsables

C’est pourquoi il est crucial d’inclure un devoir de vigilance numérique dans la législation australienne sur la sécurité en ligne, engagement pris par le gouvernement plus tôt cette année.

Plutôt que de laisser les utilisateurs naviguer à leurs risques et périls, les plateformes en ligne seraient légalement tenues de repérer et de réduire les risques qu’ils créent, qu’il s’agisse d’algorithmes suggérant des contenus nocifs ou de fonctions de recherche permettant d’accéder à du matériel illégal.

Parmi les mesures possibles, figurent la détection automatique de comportements de grooming (repérer les personnes cherchant à exploiter des enfants), le blocage du partage d’images et de vidéos d’abus déjà connus ainsi que des liens vers les sites qui les hébergent, et la suppression proactive des voies permettant d’atteindre les personnes vulnérables – par exemple empêcher que des enfants en ligne puissent interagir avec des adultes qu’ils ne connaissent pas.

Comme le montre notre recherche, les messages de dissuasion jouent également un rôle : afficher des avertissements clairs lorsque les utilisateurs recherchent des termes dangereux est très efficace. Les entreprises technologiques devraient collaborer avec des chercheurs et des organisations à but non lucratif pour tester ce qui fonctionne, en partageant les données plutôt qu’en les dissimulant.

L’ère du « aller vite quitte à tout casser » est révolue. Il faut un changement culturel qui fasse de la sécurité en ligne une caractéristique essentielle, et non un simple ajout optionnel. La technologie pour rendre ces plateformes plus sûres existe déjà, et les données montrent qu’intégrer la sécurité dès la conception peut porter ses fruits. Il ne manque plus qu’une réelle volonté de le faire.

Joel Scanlan est le co-responsable académique du CSAM Deterrence Centre, un partenariat entre l’Université de Tasmanie et Jesuit Social Services, qui gèrent Stop It Now (Australie), un service thérapeutique offrant un soutien aux personnes préoccupées par leurs propres sentiments, ou ceux de quelqu’un d’autre, envers les enfants. Joel Scanlan a reçu des financements de l’Australian Research Council, de l’Australian Institute of Criminology, du eSafety Commissioner, de la Lucy Faithfull Foundation et de l’Internet Watch Foundation.

10.12.2025 à 14:04

‘Is my boss a narcissist?’ How researchers look and listen for clues

Ivana Vitanova, Associate professor, EM Lyon Business School

Texte intégral (1615 mots)

Between the public extravagances of today’s business icons and the recent trials of prominent CEOs, narcissistic managers have firmly taken the spotlight. In academia, the fascination with the potent mix of charisma and ego that defines narcissistic leaders has fuelled nearly two decades of extensive research and analysis. Yet one of the central challenges of this work is measurement: how can we identify and assess narcissism in managers outside a clinical setting? Since it’s rarely possible to administer traditional psychometric tests to top executives, management scholars have developed a range of clever, unobtrusive ways to identify narcissistic tendencies by observing behavior, language, and public presence.

Narcissism: its traditional measurement

According to the Diagnostic and Statistical Manual of Mental Disorders (DSM) of the American Psychiatric Association, “narcissistic personality disorder is defined as a pervasive pattern of grandiosity (sense of superiority in fantasy or behavior), need for admiration, and lack of empathy, beginning by early adulthood and occurring in a variety of contexts.” In their 2020 article in the Journal of Management, authors Ormonde Rhees Cragun, Kari Joseph Olsen and Patrick Michael Wright write that “despite its origin in clinical psychology, the DSM’s definition is also widely accepted for defining narcissism in its nonclinical form”.

Research in psychology traditionally assesses narcissism through self-report tests or third-party psychometric tests. As first outlined by R. A. Emmons in 1984, the basic principle of these tests is to link simple statements to the components of narcissism. The most widely used and empirically validated are the 40-item Narcissistic Personality Inventory (NPI) and its shorter version, the NPI-16. The NPI asks respondents to choose between paired statements such as “I really like to be the center of attention” versus “it makes me uncomfortable to be the center of attention”, and “I am much like everybody else” versus “I am an extraordinary person”.

While a few studies have administered the NPI directly to top managers – or adapted it for third-party evaluations, asking employees or stakeholders to rate managers based on daily interactions – such approaches remain extremely rare due to limited access to suitable participants. Faced with these limitations, researchers in management and organizational studies have sought alternative ways to detect narcissism in leaders. They began by identifying behavioral and linguistic cues in CEOs’ official communications that could reflect one or more dimensions of narcissism. More recently, however, the rise of social media has provided researchers with new, more direct opportunities to observe and measure narcissistic behavior in real time.

Spotting narcissistic traits in interviews and official communications