10.02.2026 à 16:49

McDonald's : vers un retour des jouets en plastique dans le Happy Meal ?

Sophie Renault, Professeur des Universités en Sciences de Gestion et du Management, Université d’Orléans

Texte intégral (1761 mots)

Bannis des menus enfants depuis 2022, les jouets en plastique font leur retour chez McDonald’s par l’intermédiaire d’une collaboration avec Playmobil. Derrière l’argument du plastique végétal, que dit vraiment ce retour ? Et qu’omet-il de rappeler ?

Novembre 2025 marque, en France, un tournant symbolique chez le géant du fast-food McDonald’s. Après plusieurs années de « diète plastique » dans le menu enfant où il a fallu se contenter de cartes à collectionner, de coloriages ou d’autres livrets d’activité, les jouets en plastique ont fait leur grand retour dans le Happy Meal.

Grâce à une collaboration avec Playmobil, McDonald’s tourne la page du « tout-papier ». L’enseigne semble entonner le refrain d’Elmer Food Beat : « Le plastique, c’est fantastique. » Ce revirement s’appuie sur une mécanique redoutable mêlant nostalgie et vernis écologique.

À lire aussi : La nostalgie, un puissant levier du marketing

Du jouet jetable à l’objet patrimonial : la requalification morale du plastique

En France, depuis le 1er janvier 2022, la loi Agec (anti-gaspillage pour une économie circulaire) interdit, dans son article 81, la distribution de jouets en plastique dans les menus destinés aux enfants. Il s’agit, d’une part, de réduire les déchets à usage unique et, d’autre part, de limiter l’exposition des enfants à des objets à faible durée de vie. En filigrane, cette mesure interroge le rôle des jouets comme leviers d’attractivité des offres de restauration rapide auprès des plus jeunes, dans un contexte de préoccupations croissantes liées à la prévention de l’obésité infantile et à la promotion de pratiques alimentaires plus équilibrées. Pour les enseignes de restauration rapide à l’instar du géant McDonald’s, cette mesure a signé la fin d’un pilier historique du menu enfant, longtemps structuré autour de la promesse d’un jouet en plastique à collectionner.

Durant cette parenthèse, où le jouet enfant était principalement réduit à du papier ou carton, le plastique n’avait pas quitté l’écosystème de McDonald’s. Il s’était simplement déplacé vers la cible adulte. C’est là toute l’habileté de la stratégie du géant du fast-food. Alors que l’enfant apprenait la sobriété écologique, les opérations pour adultes remettaient l’objet en plastique au centre du désir. En France, ce déplacement s’est matérialisé en 2025 autour de deux opérations emblématiques.

Tout a commencé avec les collaborations menées avec des univers culturels fortement chargés en capital affectif à l’occasion d’une part de la sortie du film Minecraft en avril, puis de la nouvelle saison de Mercredi en juillet 2025. Des figurines en plastique à vocation de collection ont été intégrées à des menus et dispositifs promotionnels tournés vers une clientèle adulte.

Du jouet pour enfants à l’artefact pour « kidults »

L’objet change ainsi de statut : de jouet jetable pour enfant, il devient artefact culturel pour kidults. La contrainte environnementale n’a pas fait disparaître le plastique. Elle l’a requalifié, en l’inscrivant dans une économie de la nostalgie et de la collection, socialement plus acceptable.

La subtilité réside dans le changement de statut du jouet en plastique : dans le menu enfant, le plastique était devenu un déchet polluant à bannir ; dans le menu adulte, il est célébré comme un objet de collection. En réhabilitant le plastique auprès des parents, McDonald’s a préparé les esprits. Une fois que le plastique a été « relégitimé » par la culture pop, il devenait plus simple de le réintroduire dans le menu enfant. Encore fallait-il lui trouver une vertu morale.

Pour acter ce retour en arrière, le choix du partenaire était crucial. Il semble, dans ce contexte, que l’association avec Playmobil ait pu agir comme un bouclier. Contrairement aux jouets sous licence de films, séries ou autres dessins animés susceptibles d’être jetés une fois la mode passée, les figurines Playmobil bénéficient d’une aura de respectabilité.

Il s’agit de jouets robustes qui se transmettent de génération en génération. L’argument implicite est fort, il ne s’agit pas d’un déchet plastique mais d’un patrimoine ludique. En outre, la collection de dix figurines d’animaux sauvages s’inscrit dans un imaginaire largement associé à la préservation de la nature et à la protection du vivant, ce qui renforce la portée affective et symbolique de l’opération.

Le « plastique végétal » : fantastique ou cynique ?

Face à l’urgence climatique, pour que ce retour soit socialement acceptable, il fallait un argument technique imparable : le plastique végétal. C’est ici que l’analyse doit se faire critique, car le terme flirte avec le malentendu.

D’une part, dire qu’un plastique est végétal signifie qu’il est fabriqué à partir de biomasse (fibres de canne à sucre, amidon de maïs, etc.) et non de pétrole. S’il s’agit d’un progrès en termes d’empreinte carbone, un polymère végétal a toutefois des similitudes avec son cousin pétrolier. S’il est perdu dans la nature, il mettra des décennies à se désagréger.

D’autre part, fabriquer des millions de figurines en plastique végétal implique d’utiliser des ressources agricoles. La systématisation de cette production pour des objets considérés comme « gratuits » pose la question de l’allocation des terres arables dans un monde aux ressources contraintes.

Enfin, et c’est peut-être la critique fondamentale, le plastique végétal est une solution technologique qui permet de tout changer pour que rien ne change. Il valide la poursuite d’un modèle basé sur la distribution massive de petits objets manufacturés avec un repas, plutôt que de questionner la nécessité même de ce « cadeau » systématique. De là à parler d’habillage éthique, il n’y a qu’un pas…

Du Happy Meal au Happy Doggy : déplacer l’affect pour légitimer le plastique

Chez McDonald’s, les enjeux environnementaux n’ont pas fait disparaître le plastique. Ils l’ont rendu plus rare, plus scénarisé et de facto plus désirable. Dans le Happy Meal, les jouets en papier et carton demeurent ainsi la norme. Lorsque le jouet en plastique réapparaît, il est présenté comme un collector, pensé pour durer. La circulation de ces objets sur les plates-formes de vente en ligne, comme Vinted ou leboncoin, en témoigne. Le plastique se voit attribuer une seconde vie, socialement valorisée, qui le distingue du jetable.

In fine, le problème ne serait plus la matière, mais l’éphémère. Le jouet en soi n’est pas problématique, en revanche son absence de valeur affective l’est. Quid en ce sens des jouets en papier/carton ayant succédé à l’ère du plastique ? Ne sont-ils pas jetés bien plus rapidement que leurs homologues en plastique ? En requalifiant subtilement le plastique comme support de mémoire et de collection, McDonald’s transforme une pratique de consommation potentiellement dissonante en plaisir légitime.

L’introduction en novembre 2025 de jouets pour chiens (les Happy Doggy) dans le menu Best Of s’inscrit dans cette logique de déplacement symbolique. Le plastique trouve dans l’univers du pet marketing un nouvel espace de légitimation affective, moins exposé aux injonctions de sobriété adressées à la consommation enfantine.

Sophie Renault ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.02.2026 à 16:47

Comment deux amnésiques ont révolutionné nos connaissances sur la mémoire

Olivier Després, Professeur de neuropsychologie - laboratoire de neurosciences cognitives et adaptatives (LNCA, CNRS-UNISTRA), Université de Strasbourg

Texte intégral (1529 mots)

Comment nous souvenons-nous des choses ? Paradoxalement, deux des personnes qui ont le plus aidé les neuroscientifiques à répondre à cette question étaient amnésiques. Retour sur les histoires exceptionnelles d’Henry Molaison et de Kent Cochrane, deux patients hors norme.

Et si perdre la mémoire n’était pas seulement une tragédie, mais aussi une clé pour comprendre ce que signifie se souvenir ? Deux patients, Henry Molaison et Kent Cochrane, ont marqué l’histoire des neurosciences au XXᵉ siècle.

Le premier, opéré en 1953 pour traiter une épilepsie sévère, a révélé le rôle crucial d’une structure cérébrale, l’hippocampe, dans la formation des souvenirs. Le second, victime d’un accident de moto en 1981 ayant provoqué une hémorragie cérébrale sévère, a montré que la mémoire du passé et la capacité à se projeter dans l’avenir reposent sur les mêmes réseaux cérébraux.

Leurs destins ont bouleversé notre compréhension de la mémoire humaine et, plus largement, de l’identité elle-même. Voici leurs histoires.

Henry Molaison, plongé à jamais dans l’oubli

Né en 1926, Henry Molaison souffrait depuis l’enfance d’une épilepsie résistante aux traitements médicamenteux. En 1953, le neurochirurgien William Scoville lui proposa une solution radicale : retirer une partie de ses lobes temporaux médians, situés à la base du cerveau et comprenant notamment les deux hippocampes (l’hippocampe est une structure présente de manière symétrique dans les deux hémisphères cérébraux).

L’intervention permit de réduire la fréquence des crises, mais bouleversa la vie du patient à jamais : Henry perdit la capacité de créer de nouveaux souvenirs, une amnésie dite « antérograde ».

La neuropsychologue Brenda Milner, de l’université McGill à Montréal, l’évalua dès 1955 et fit une découverte majeure : l’intelligence et les capacités langagières du patient semblaient intactes, mais toute nouvelle information s’effaçait au bout de quelques minutes. Chaque rencontre, chaque conversation disparaissait presque aussitôt. Henry ne parvint d’ailleurs jamais à se souvenir de ses entrevues répétées avec Brenda Milner, ignorant jusqu’à sa mort, en 2008, qui elle était.

Les observations menées sur Henry Molaison, révélèrent que l’hippocampe était une pièce maîtresse de la mémoire déclarative, celle qui permet de se souvenir des faits et des événements. Brenda Miller réalisa aussi que la mémoire n’est pas un processus global, mais une fonction composée de plusieurs systèmes, chacun reposant sur des structures cérébrales distinctes.

En effet, la neuropsychologue constata que, malgré son incapacité à enregistrer de nouveaux souvenirs, Henry conservait une certaine capacité d’apprentissage : il pouvait encore acquérir de nouveaux gestes moteurs, et par exemple apprendre à tracer une étoile dans un miroir. Ce type d’apprentissage, qui relève de la mémoire implicite, non consciente, dépend d’autres régions du cerveau que l’hippocampe. De ce fait, cette capacité restait, chez lui, préservée.

Les études menées sur le patient désigné par les initiales H. M., qui ont préservé son anonymat dans la littérature scientifique jusqu’à sa mort, ont été décisives pour montrer que la mémoire humaine n’est pas une fonction unique, mais repose en réalité sur des systèmes distincts, qui sont situés dans différentes régions du cerveau.

Elles ont également révélé le rôle central de l’hippocampe et des structures voisines des lobes temporaux médians dans la formation et la consolidation des souvenirs.

À ce jour, Henry Molaison reste l’un des patients les plus étudiés de l’histoire de la neuropsychologie.

Kent Cochrane, privé de passé et de futur

Quelques décennies après l’intervention chirurgicale subie par Henry Molaison, un Canadien allait devenir amnésique et, malgré lui, contribuer à enrichir encore nos connaissances sur le fonctionnement la mémoire.

Kent Cochrane, né en 1951, fut victime en 1981 d’un grave accident de moto. Le choc provoqua une hémorragie cérébrale et détruisit ses lobes temporaux médians. Comme le patient H. M., Kent Cochrane devint incapable d’enregistrer un quelconque nouveau souvenir de sa vie. Pire encore, il oublia de nombreux épisodes de sa vie passée. Cela incluait les moments les plus marquants sur le plan émotionnel, comme le jour où il apprit le décès de l’un de ses frères.

Le neuropsychologue Endel Tulving étudia le cas de Kent Cochrane pendant plus de vingt ans. Il constata que son patient conservait des connaissances sur lui-même et sur le monde, telles que les personnes qu’il côtoyait ou les lieux qu’il fréquentait ou avait visités. En revanche, il était incapable de revivre un souvenir personnel.

À partir de ces observations, Endel Tulving proposa la distinction entre deux formes de mémoire : la mémoire épisodique, qui concerne les événements vécus dans leur contexte spatial, temporel et émotionnel, et la mémoire sémantique, relative aux connaissances générales sans ancrage contextuel.

Par exemple, se souvenir du moment précis où l’on a rencontré la personne avec qui l’on partage sa vie relève de la mémoire épisodique : le lieu exact de cette première rencontre, les circonstances, les personnes présentes, les premiers mots échangés, ainsi que l’émotion ressentie à cet instant. La mémoire sémantique concerne quant à elle des informations plus générales, indépendantes de toute expérience vécue particulière. Elle inclut par exemple nos connaissances sur le monde et la société, le nom des artistes que nous apprécions, le nom des capitales de différents pays, ou encore la date de naissance de nos proches.

Chez Kent Cochrane, la mémoire sémantique demeurait intacte, alors que la mémoire épisodique était détruite. Ce contraste montrait que ces deux systèmes mnésiques reposent sur des réseaux cérébraux différents : les hippocampes pour la mémoire épisodique, et les pôles temporaux pour la mémoire sémantique.

Plus étonnant encore, Endel Tulving constata que la capacité à se projeter dans l’avenir mobilise les mêmes structures cérébrales que celle qui permet de se souvenir du passé. En effet, depuis l’accident qui l’avait privé de ses hippocampes, et donc de ses souvenirs, Kent Cochrane était incapable de s’imaginer dans l’avenir, même proche.

Le cas de ce patient a ainsi mis en lumière le fait que la mémoire ne sert pas seulement à évoquer le passé, mais aussi à anticiper le futur. Une faculté qui se situe au cœur de la conscience de soi, et de notre identité.

Au-delà de la science, une leçon d’humanité

En perdant la capacité de se souvenir des événements de leur propre vie, Henry Molaison et Kent Cochrane ont révélé à quel point la mémoire façonne notre rapport au monde et à nous-mêmes.

Ces deux destins, à la fois tragiques et éclairants, ont fait de la mémoire un miroir de notre identité. Ces deux cas cliniques posent une question essentielle : que reste-t-il de notre humanité lorsque notre mémoire s’efface ?

Au-delà de la reconnaissance de l’immense apport des études sur ces amnésies, les parcours de ces deux hommes nous invitent aussi à réfléchir sur notre empathie face à la vulnérabilité.

Enfin, ces deux histoires profondément humaines traduisent les liens singuliers qui unissent les chercheurs à ceux qui deviennent, souvent malgré eux, des figures majeures de la science.

Après la mort d’Henry Molaison, Brenda Milner confia que celles et ceux qui avaient travaillé auprès de lui avaient été profondément touchés par sa disparition. Elle ajoutait qu’il y a quelque chose de profondément paradoxal à être fortement ému par la mort d’un homme qui, toute sa vie durant, n’a jamais su qui vous étiez.

Olivier Després ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.02.2026 à 16:46

Le mystère de la « Dame à l’éventail », éclairé par une photo de Jeanne Duval

Maria C. Scott, Associate Professor of French Literature and Thought, University of Exeter

Texte intégral (1729 mots)

On sait très peu de choses au sujet de la comédienne haïtienne Jeanne Duval (1818-1868), compagne de Charles Baudelaire peinte par Manet, qui continue de fasciner les spécialistes de la littérature, de la peinture et du féminisme.

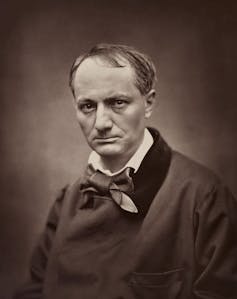

En mai 2025, je suis tombée sur une photographie extraordinaire sur le site Wikipedia anglais consacré à Jeanne Duval. Duval, originaire d’Haïti, était la maîtresse et muse de longue date, supposée n’avoir jamais été photographiée, du poète français Charles Baudelaire.

Le portrait, représentant une femme assise vêtue d’habits bourgeois raffinés, avait été publié sur Wikipédia par une étudiante de l’historienne de l’art Justine De Young. De Young évoque ce portrait comme un exemple d’auto-mise en scène dans son dernier ouvrage, The Art of Parisian Chic. Imprimée sur une petite carte (il s’agit d’un portrait-carte de visite, en vogue à l’époque) et datée du 18 août 1862, l’image a été découverte dans les archives françaises par une autre chercheuse, comme je l’ai mentionné dans un récent article publié par le Times Litterary Supplement, et documentée en ligne par elle en 2021.

Une photo redécouverte

Jeanne Duval fascine de nombreuses chercheuses et chercheurs experts du féminisme et du postcolonialisme, en partie parce que l’on sait très peu de choses précises à son sujet. Intriguée, je me suis rendue moi-même aux archives à l’été 2025, juste pour voir la photo. Là, j’ai remarqué une deuxième photo au format carte de visite à côté de la première. Elle portait le même nom, « Jeanne », la même date, et provenait du même studio de photographie, l’atelier Nadar. Les deux cartes avaient été inscrites au registre du dépôt légal sous la mention « idem ».

À lire aussi : Les femmes censurées des « Fleurs du mal »

Cette deuxième Jeanne se tient debout, dans une pose inhabituellement rigide pour une photographie de ce type. Elle porte une robe de soirée à épaules dénudées et ses cheveux tombent en cascade dans son dos, retenus sur le front par un simple bandeau.

Une inspiration pour Manet ?

Une version numérique haute résolution de cette image a révélé de fortes ressemblances avec le modèle de la première photographie, similitudes qui n’étaient pas immédiatement apparentes sur les petites cartes. Les deux photos révèlent une implantation capillaire similaire, une même imperfection sur le front et une bague au même doigt. Il était clair que si la première photographie représentait Duval, celle-ci aussi.

Cependant, le crucifix porté en pendentif sur une chaîne courte et les grandes boucles d’oreilles m’ont semblé particulièrement intéressants. Des bijoux très similaires sont en effet portés par le modèle dans le portrait d’Édouard Manet intitulé Dame à l’éventail (1862), également connu sous le nom de la Maîtresse de Baudelaire allongée. Ce dernier titre avait été inscrit au dos du tableau à un moment donné, soit pendant, soit avant l’inventaire posthume de l’atelier de l’artiste.

La pose maladroite et l’expression faciale impénétrable du modèle ont souvent été interprétées comme faisant référence aux difficultés et à la maladie que Duval endurait à l’époque. Elle se trouvait dans une situation financière désastreuse et souffrait d’une paralysie du côté droit depuis un accident vasculaire cérébral survenu en 1859. Cependant, l’identification du modèle de Manet comme étant Duval est parfois contestée par les chercheurs, pour plusieurs raisons.

Le portrait sur carte de « Jeanne » debout, réalisé la même année que le portrait à l’huile et son étude à l’aquarelle, présente des traits, une expression et des ombres très similaires. Les historiens de l’art Griselda Pollock et Therese Dolan ont émis l’hypothèse que Manet s’était inspiré d’une photographie ou d’une carte de visite de Duval pour réaliser Dame à l’éventail. Les liens entre la photographie de Jeanne debout et les portraits à l’huile et à l’aquarelle de Manet semblent confirmer que Duval est le sujet des deux peintures (aquarelle et huile) et des deux photographies.

Pourquoi ces photographies ont-elles été prises ?

Duval posait-elle donc pour Manet dans ces photographies ? Il convient de noter que Manet, Félix Nadar (le propriétaire du studio de photographie) et Baudelaire étaient tous des amis proches, et que Duval s’était séparée du poète, apparemment de manière définitive, en 1861.

Duval a peut-être proposé de poser, ou a été invitée à poser pour les photographies de Nadar (et indirectement pour Manet, qui travaillait souvent à partir de photographies) en échange d’argent. Nous savons qu’elle avait approché au moins un autre ami de Baudelaire en 1862 pour essayer de lui vendre les biens du poète. Le fait qu’elle tienne une cravache sur la photographie avec le crucifix vient étayer l’hypothèse de la monétisation. Peut-être espérait-elle, ou espéraient-ils, que le portrait sur carte de la muse sadique/angélique du recueil de poèmes de Baudelaire les Fleurs du mal (1857) aurait une valeur marchande.

Il est également possible que Baudelaire ait commandé des portraits de son ancienne maîtresse à des fins personnelles. Malgré sa colère et son ressentiment envers Duval après leur séparation, ses lettres et ses croquis témoignent de sa loyauté et de son affection persistantes.

Ou peut-être Duval souhaitait-elle rétablir la vérité sur qui elle était. Peut-être voulait-elle que le monde sache qu’elle n’était en fait pas la muse diabolique et sexualisée au centre du volume de poésie scandaleux de Baudelaire, mais plutôt quelqu’un qui s’habillait avec des vêtements élégants et respectables (probablement empruntés) comme on le voit sur la première photographie.

Peut-être que le crucifix et la bague visible à l’annulaire des deux photos avaient également pour but de témoigner de ses valeurs morales. Cependant, certains détails de la deuxième image, notamment la cravache, les épaules nues et les grandes boucles d’oreilles, suggèrent que sa volonté n’était pas de se donner une image « respectable ».

Il est probable que les portraits-cartes de visite, s’ils représentent bien Jeanne Duval, aient été motivées par des raisons financières, qu’elles aient été son idée ou celle de Nadar, Manet ou Baudelaire. Il est également possible que la mise en scène de soi ait fait partie de son objectif, mais si tel est le cas, le message qu’elle voulait faire passer n’est pas clair.

Des chercheurs français ont récemment découvert que Duval était morte dans un hospice six ans seulement après la réalisation de ces portraits. Jusqu’alors, personne ne semblait savoir ce qu’elle était devenue. Ces photographies témoignent, du moins à mes yeux, de la résistance de Duval à se laisser cataloguer et de sa dignité tranquille.

Maria C. Scott publiera prochainement un article universitaire sur ce sujet dans la revue French Studies.

10.02.2026 à 14:11

Les chiens et les chats transportent les vers plats envahissants de jardin à jardin

Jean-Lou Justine, Professeur, UMR ISYEB (Institut de Systématique, Évolution, Biodiversité), Muséum national d’histoire naturelle (MNHN)

Leigh Winsor, Adjunct Senior Research Fellow, James Cook University

Texte intégral (1259 mots)

Les chiens et les chats domestiques peuvent transporter les vers plats (plathelminthes) collés sur leur pelage. Sans le vouloir, ils contribuent ainsi à la propagation de ces espèces exotiques envahissantes. Notre travail vient d’être publié dans la revue scientifique PeerJ.

Au niveau mondial, les espèces exotiques intrusives représentent un des dangers majeurs pour la biodiversité. Il est frappant de découvrir que les chiens et les chats, nos compagnons du quotidien, participent de manière involontaire à l’envahissement des jardins par une espèce potentiellement dangereuse pour la biodiversité.

Comment avons-nous fait cette découverte ?

Nous menons un projet de sciences participatives sur les invasions de vers plats.

Nous avons été interpellés par des courriels envoyés par des particuliers signalant la présence de vers collés au pelage de chiens et de chats. Nous avons alors réexaminé plus de 6 000 messages reçus en douze ans et avons constaté que ces observations étaient loin d’être anecdotiques : elles représentaient environ 15 % des signalements.

Fait remarquable, parmi la dizaine d’espèces de vers plats exotiques introduits en France, une seule était concernée : Caenoplana variegata, une espèce venue d’Australie dont le régime alimentaire est composé d’arthropodes (cloportes, insectes, araignées).

En quoi cette découverte est-elle importante ?

On sait depuis longtemps que les plathelminthes (vers plats) exotiques sont transportés de leur pays d’origine vers l’Europe par des moyens liés aux activités humaines : conteneurs de plantes acheminés par bateau, camions livrant ensuite les jardineries, puis transport en voiture jusqu’aux jardins.

Ce qu’on ne comprenait pas bien, c’est comment les vers plats, qui se déplacent très lentement, pouvaient ensuite envahir les jardins aux alentours. Le mécanisme mis en évidence est pourtant simple : un chien (ou un chat) se roule dans l’herbe, un ver se colle sur le pelage, et l’animal va le déposer un peu plus loin. Dans certains cas, il le ramène même chez lui, ce qui permet aux propriétaires de le remarquer.

Par ailleurs, il est surprenant de constater qu’une seule espèce est concernée en France, alors qu’elle n’est pas la plus abondante. C’est Obama nungara qui est l’espèce la plus répandue, tant en nombre de communes envahies qu’en nombre de vers dans un jardin, mais aucun signalement de transport par animal n’a été reçu pour cette espèce.

Cette différence s’explique par leur régime alimentaire. Obama nungara se nourrit de vers de terre et d’escargots, tandis que Caenoplana variegata consomme des arthropodes, produisant un mucus très abondant et collant qui piège ses proies. Ce mucus peut adhérer aux poils des animaux (ou à une chaussure ou un pantalon, d’ailleurs). De plus, Caenoplana variegata se reproduit par clonage et n’a donc pas besoin de partenaire sexuel : un seul ver transporté peut infester un jardin entier.

Nous avons alors tenté d’évaluer quelles distances parcourent les 10 millions de chats et les 16 millions de chiens de France chaque année. À partir des informations existantes sur les trajets quotidiens des chats et des chiens, nous avons abouti à une estimation spectaculaire : des milliards de kilomètres au total par an, ce qui représente plusieurs fois la distance de la Terre au Soleil ! Même si une petite fraction des animaux domestiques transporte des vers, cela représente un nombre énorme d’occasions de transporter ces espèces envahissantes.

Un point à clarifier est qu’il ne s’agit pas de parasitisme, mais d’un phénomène qui s’appelle « phorésie ». C’est un mécanisme bien connu dans la nature, en particulier chez des plantes qui ont des graines collantes ou épineuses, qui s’accrochent aux poils des animaux et tombent un peu plus loin. Mais ici, c’est un animal collant qui utilise ce processus pour se propager rapidement.

Quelles sont les suites de ces travaux ?

Nous espérons que cette découverte va stimuler les observations et nous attendons de nouveaux signalements du même genre. D’autre part, nos résultats publiés concernent la France, pour laquelle les sciences participatives ont fourni énormément d’informations, mais quelques observations suggèrent que le même phénomène existe aussi dans d’autres pays, mais avec d’autres espèces de vers plats.

Il est désormais nécessaire d’étendre ces recherches à l’échelle internationale, afin de mieux comprendre l’ampleur de ce mode de dispersion et les espèces concernées.

Tout savoir en trois minutes sur des résultats récents de recherches commentés et contextualisés par les chercheuses et les chercheurs qui les ont menées, c’est le principe de nos « Research Briefs ». Un format à retrouver ici.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

10.02.2026 à 12:55

« Trump est fou » : les effets pervers d’un pseudo-diagnostic

Olivier Fournout, Maître de conférence HDR, département Sciences économiques et sociales, chercheur à l’Institut Interdisciplinaire de l’Innovation (CNRS), Télécom Paris – Institut Mines-Télécom

Texte intégral (3523 mots)

Qualifier Donald Trump de « fou », comme c’est régulièrement le cas ces derniers temps, tend à détourner l’attention de la cohérence de la politique conduite par l’intéressé depuis son retour à la Maison-Blanche et du fait qu’il constitue moins une anomalie individuelle qu’un produit typique d’un système économique, médiatique et culturel qui valorise la domination, la spectacularisation et la marchandisation du monde. Il convient de se détourner de cette psychologisation à outrance pour mieux se concentrer sur les structures sociales qui ont rendu possible l’accession au pouvoir d’un tel individu.

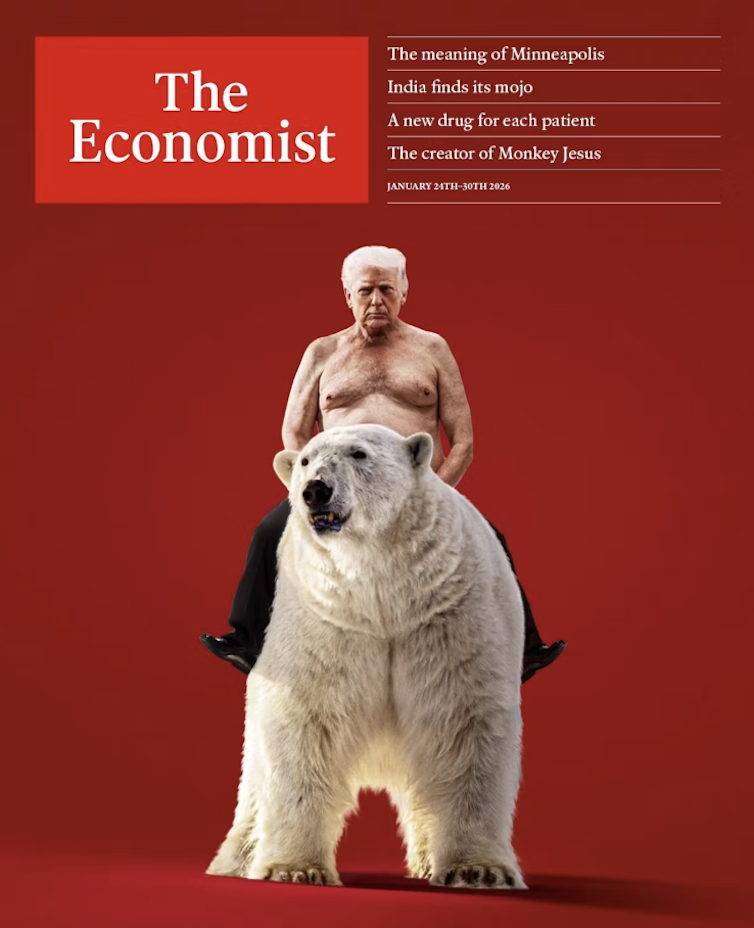

C’est devenu en quelques jours du mois de janvier 2026 la note la plus tenue de l’espace médiatique : Trump est fou. Une élue démocrate au Congrès des États-Unis tire la sonnette d’alarme sur X, le 19 janvier : le président est « mentalement extrêmement malade », affirme-t-elle. Fox News, média proche de Donald Trump sur le long terme, reprend les propos dès le lendemain sur un ton factuel. Le 22 janvier, lendemain du discours de Trump à Davos, durant lequel il a demandé « un bout de glace » (à savoir le Groenland) « en échange de la paix mondiale », l’Humanité fait le titre de sa une avec un magnifique jeu de mots : Trump « Fou allié ».

Le 23 janvier, des messageries relayent ce qui déjà se diffuse largement dans la presse : « Déclaration de représentants démocrates au Congrès US : la santé mentale de Donald Trump est altérée ; c’est pire que Joe Biden, c’est un cas de démence ».

Le 24 janvier, la une de l’hebdomadaire The Economist montre un Donald Trump torse nu à califourchon sur un ours polaire – message de folle divagation en escalade mimétique avec Poutine et ses clichés poitrine à l’air, l’animal du Grand Nord soulignant en l’occurrence les prétentions du locataire de la Maison Blanche sur le Groenland.

Même le premier ministre slovaque Robert Fico, pourtant un allié du milliardaire new-yorkais, l’aurait jugé « complètement dérangé » après l’avoir rencontré le 19 janvier à Mar-a-Lago. Le cas Trump est donc désormais régulièrement examiné à l’aune de la folie par des élus, des journalistes, mais aussi des psychiatres.

Il y a pourtant matière à être dubitatif sur les accusations de folie portées contre Trump. Non seulement elles n’ont guère contribué jusqu’ici à le neutraliser, mais elles ont même fait son succès et empêchent de penser le vrai problème. Les arguments en leur défaveur méritent un tour d’horizon.

Quelle légitimité du discours médicalisant ?

Il peut sembler contestable, même quand on est psychiatre et a fortiori quand on ne l’est pas, de déclarer quelqu’un malade mental sans l’avoir examiné selon des protocoles précis.

Quand le 5 mars 2025 le sénateur français Claude Malhuret, qui est médecin, traite Trump de « Néron » et de « bouffon » à la tribune du palais du Luxembourg – une intervention qui deviendra virale aux États-Unis –, le discours est de belle facture rhétorique, mais il n’est pas médical.

Le sénateur ne se réfère d’ailleurs pas à l’Académie. À ce stade, en l’absence d’examen effectué par des professionnels dont les résultats auraient été rendus publics, qualifier Trump de fou relève plus de la tournure politique que médicale.

Une rhétorique inefficace

Les déclarations sur la folie de Trump se succèdent sur le long cours sans avoir montré la moindre efficacité pour le combattre. Dès la première année de son premier mandat, la rumeur bruisse d’une possible destitution pour raison mentale sur la base d’avis d’experts qui n’ont pourtant pas eu d’entretiens avec le principal intéressé. Aucune procédure de destitution ne sera engagée sur ces bases.

Une nouvelle sortie collective de professionnels sur le déclin cognitif de Trump, lui trouvant un « désordre sévère et incurable de la personnalité », eut lieu en octobre 2024. Ce qui ne l’empêcha pas d’être élu assez aisément le mois suivant face à Kamala Harris. Quant à la défaite de 2020, elle arriva en pleine vague Covid et fut moins la conséquence des assertions selon lesquelles le président sortant était fou que de sa gestion désastreuse de la pandémie : sous-estimation de l’ampleur des contagions et de la mortalité, refus ostensible du port du masque.

Un jour, sans doute, Trump quittera-t-il le pouvoir, mais les effets des jugements de maladie mentale sur sa carrière politique – et en particulier sur sa victoire de 2024, qui se produisit alors que les électeurs avaient toute connaissance de son profil personnel – ont été nuls jusqu’à aujourd’hui.

Des attaques qui font le jeu de Trump

Pis encore : ces attaques ne sont pas seulement inefficaces, elles servent Trump. Le cœur de sa technique – qu’il a explicitée dès les années 1980 dans The Art of the Deal – consiste à semer la controverse pour faire parler de lui et de ses projets. Lui répondre sur ce terrain qui est le sien, en le traitant notamment de psychopathe (ou d’aberrant, de monstrueux, de stupide, ou de lunaire – le dernier vocable à la mode), c’est tomber dans le piège : il se pose ensuite en victime et ramasse les suffrages. Le sujet d’étonnement est que, depuis dix ans, aucune leçon n’ait été tirée de ces échecs à répétition dans la lutte contre Trump.

« Je fulmine et m’extasie comme un dément, et plus je suis fou, plus l’audimat grimpe »,

s’autopitchait Trump pour son émission de téléréalité, The Apprentice (source : Think Big and Kick Ass: In Business and Life, D. Trump et B. Zanker, 2007). Folie ? Non. Mise en scène éprouvée qui attire l’attention à son profit.

Mais le bénéfice s’enclenche aussi pour les commentateurs et les chambres d’écho. Et c’est là que le bât blesse : les « coups de folie » de Trump sont en réalité des diversions où les médias, les oppositions, les politiques et, souvent, les experts s’engouffrent pour le buzz.

Trump est à l’image de la société

Au-delà de la télé, les méthodes de Trump sont typiques de conseils de vie qui circulent largement dans la société, émanant de bien d’autres agents que lui. On pense, par exemple, aux classiques Swim With the Sharks Without Being Eaten Alive (1988), de Harvey Mackay, ou The Concise 33 Strategies of War (2006), de Robert Greene.

On pense aussi aux métaphores guerrières qui se glissent dans des ouvrages de management plus pondérés ; « les salles de commandement en temps de guerre » décrivent les réunions des équipes « successful », dans X-Teams (2007) ; donner plus de pouvoir au manager est recommandé pour qu’il ne se retrouve pas « face à dix ennemis avec une seule balle dans son fusil », dans Smart simplicity (2014).

De ce point de vue, Trump est « banal, trop banal ». Il est typique d’une « héroïcomanie hypermoderne », porté par une « trumpisation du monde » qui le dépasse. La conséquence de ce constat sociologique est que le problème est beaucoup plus profond qu’une folie idiosyncrasique, si perturbante soit-elle.

Déclarer Trump fou fait oublier à quel point le mode opératoire trumpiste est, pour une part non négligeable, partagé transversalement par la société. Ainsi, Trump privilégie-t-il les rapports de force. Il a toujours été sans équivoque sur ce point qui lui apporta la réussite dans le business, la télévision, le marché du leadership, et maintenant en politique. Mais cela ne se réalise pas contre la société américaine, comme par accident, mais en miroir d’un vaste spectre de celle-ci.

La négociation le revolver sur la tempe alimente quantité de traités de développement personnel, de management et de communication au travail. Elle est la matrice scénaristique assurant la popularité des films hollywoodiens (non seulement les westerns mais aussi les « propositions qui ne se refusent pas » du film le Parrain). Rien, là, de fou ou d’aberrant. Juste un éthos dominant qui a sa rationalité et qui n’a jamais été soft.

Aussi, aucune surprise si la rencontre d’un pouvoir fort est seule susceptible de faire fléchir Trump. Là encore, il est explicite sur ce point depuis longtemps. Lorsqu’il fut proche de la faillite dans les années 1990, il courbe l’échine devant les banquiers : « Quand vous devez de l’argent à des gens, vous allez les voir dans leur bureau […] Je voulais faire n’importe quoi sauf aller à des dîners avec des banquiers, mais je suis allé dîner avec des banquiers » (in Think big, 2007). Rationalité strictement instrumentale, certes, mais rationalité. L’article de fond « Ice and heat » récemment publié par The Economist sur l’affaire du Groenland relève que la menace européenne de déclencher l’instrument anti-coercition a joué, pour l’instant, dans le recul de Trump.

Révéler la structure pour mieux la combattre

Pour contrer l’Amérique de Trump, il conviendrait d’abord plutôt de se pencher sur la rationalité de ses lignes directrices. Son action, aussi bien en diplomatie qu’en politique intérieure, aussi bien en politique économique qu’en gestion des ressources naturelles, découle d’une stratégie claire et constante, pensée et volontariste. C’est sur ce terrain qu’il faut se battre pour défaire Trump, et non par des coups d’épée dans l’eau qui donnent bonne conscience à bon compte, sont repris en boucle, mais n’apportent rien de consistant face au fulminant showman.

Du discours de Trump à Davos, le 21 janvier 2026, ressortent plusieurs traits qui n’ont rien de mentalement dérangé. D’une part, il apporte un momentum aux extrêmes droites européennes déjà au pouvoir ou aux portes de celui-ci. D’autre part, une Europe qui se réarme et qui reste toujours globalement « alliée » des États-Unis débouche sur une situation stratégique plus favorable du point de vue américain : tel est le résultat, objectif, de la séquence historique actuelle.

Enfin, la demande d’avoir un « titre de propriété » sur le Groenland réussit à installer, même si elle n’aboutit pas, l’horizon indépassable du monde selon Trump : « La terre, comme les esclaves d’Ulysse, reste une propriété », comme l’écrivait Aldo Leopold, pionnier de la protection de la nature aux États-Unis, dans Almanach d’un comté des sables, publié en 1948 (traduction française de 2022 aux éditions Gallmeister). Trump est dans son élément, en parfaite maîtrise du vocabulaire pour fragiliser la transition ou bifurcation écologique. Comme l’exprime Estelle Ferrarese dans sa critique de la consommation éthique, « dans aucun cas la finalité n’est de mettre certaines choses (comme la terre) hors marché ».

Question ouverte pour l’Histoire

En insistant sur la supposée folie de Trump, les commentaires se rabattent sur un prisme psychologisant individuel. Peut-être Trump est-il fou. La sénilité peut le guetter – il en a l’âge. Des centaines de pathologies psychiatriques sont au menu des possibles qui peuvent se combiner.

Mais l’analyse et l’inquiétude ont à se pencher, en parallèle, sur le symptôme structurel de notre temps, sur ce système qui, depuis cinquante ans, propulse Trump au zénith des affaires, des médias, des ventes de conseils pour réussir, et deux fois au sommet du pouvoir exécutif de la première puissance mondiale.

La prise de distance avec l’accusation de folie portée contre Trump ouvre un chantier de réflexion où le problème n’est plus la folie personnelle du leader élu, mais une stratégie dont Trump est, en quelque sorte, un avatar extrême mais emblématique. Le regard se détache de l’événementiel chaotique – trumpiste ou non trumpiste – pour retrouver le fil d’une analyse structurelle. Sans conteste, Trump fragilise l’ONU et l’OMS, mais à l’aune de l’histoire longue, il ressort qu’une « impuissance structurelle » persévère, selon laquelle « dans le cas des États-Unis, c’est un grand classique que de bouder (au mieux) et de torpiller (autant que possible) toutes les démarches multilatérales dont ils n’ont pas pris l’initiative ou qu’ils ne sont pas (ou plus) capables de contrôler » (Alain Bihr, l’Écocide capitaliste, tome 1, 2026, p. 249).

Les psychés peuvent être « débridées », mais ce sont les « structures sociales » qui « sélectionnent les structures psychiques qui leur sont adéquates ». Trump n’est plus alors une anomalie foutraque, sénile, troublée, en rupture avec ce qui a précédé et à côté des structures sociales, mais la poursuite d’une marchandisation du monde à haut risque, dont le diagnostic est à mettre en haut des médiascans, pour discussion publique.

Olivier Fournout ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.02.2026 à 12:22

Pourquoi l’obésité progresse-t-elle depuis trente ans ?

Arnaud Alessandrin, Sociologue, Université de Bordeaux

Thibault Bossy, Maître de conférences en sociologie, Université de Bordeaux

Texte intégral (1894 mots)

Le ministère de la santé vient de lancer sa feuille de route 2026-2030 pour la prise en charge des personnes en situation d’obésité. Ce cadre stratégique invite à questionner un paradoxe : l’État a déployé dès 2001 un ensemble d’actions autour de l’activité physique et la nutrition en vue de réduire la prévalence de cette maladie, et, pourtant, celle-ci augmente régulièrement depuis une trentaine d’années.

L’obésité est une maladie dont les causes et conséquences sont désormais bien documentées par la littérature médicale comme sociologique. Sa prévalence n’a cessé d’augmenter depuis les années 1990 dans le monde. La France ne fait pas exception. De 8,5 % en 1997, la population adulte en situation d’obésité est passée à 15 % en 2012, puis à 17 % en 2020. Des écarts importants existent entre les personnes suivant leur âge, leur sexe, leur région, leur niveau d’éducation et leur catégorie socioprofessionnelle.

Ces données épidémiologiques et sanitaires ont participé à une prise de conscience (certes, partielle) des pouvoirs publics quant à la nécessité d’agir. Mais les politiques publiques menées contre l’obésité en France sont inefficaces. Comment l’expliquer ? Quelles stratégies sont mises à l’œuvre par les lobbies pour contrer les mesures ? Et comment concilier lutte contre l’obésité et lutte contre la grossophobie ? Faisons le point.

Les années 1990, ou la prise de conscience du lien entre alimentation et santé

La reconnaissance de l’obésité comme une « épidémie » par l’Organisation mondiale de la santé (OMS) en 1997 incite les autorités sanitaires nationales à se saisir de cet enjeu.

En France, il faut attendre la fin des années 1990 pour voir le ministère de la santé s’intéresser à la question. Plusieurs dynamiques politiques et sociales se croisent alors. Le débat sur la « malbouffe » s’impose dans l’espace médiatique à cette période, notamment après le démontage d’un restaurant d’une célèbre chaîne de fast-food à Millau en 1999.

Il s’insère dans une séquence plus large de préoccupations sur le lien entre santé et alimentation, amorcée dès le début de la décennie avec les épisodes liés au variant de la maladie de Creutzfeldt-Jakob, surnommé « maladie de la vache folle ».

Un plan national nutrition santé depuis 2001

Pour que les différentes dynamiques se combinent, il faudra néanmoins attendre l’apparition d’une « fenêtre d’opportunité politique » en 2000.

Le gouvernement cherche alors des thèmes à proposer à ses partenaires européens, en vue de sa présidence de l’Union européenne en 2001. Le ministère de la santé suggère celui de la nutrition santé, et en profite pour lancer un plan national, le Plan national nutrition santé (PNNS). Cette mise à l’agenda discrète, à la croisée de préoccupations nutritionnelles, sanitaires et politiques, constitue sans doute la première inscription de l’obésité comme problème de santé publique en France. La version actuelle du PNNS se décline en dix mesures phares présentées sur le site MangerBouger.

Avec notamment des recommandations en direction des professionnels et du grand public, le PNNS a pour objectif d’améliorer l’état de santé de la population en agissant sur la nutrition, qui est l’un de ses déterminants majeurs. Le plan vise à réduire la prévalence de l’obésité chez les adultes – le même objectif de réduction sera intégré à la loi 2004-806 du 9 août 2004 relative à la politique de santé publique, sans que des moyens supplémentaires soient adoptés.

À lire aussi : Lutte contre l’obésité : deux nouvelles mesures efficaces

Plan obésité, taxe soda et autres mesures

« Problème fluide » par excellence, l’obésité fera l’objet après 2001 de nouvelles inscriptions régulières à l’agenda, sans que cet intérêt entraîne de diminution de la prévalence. Elle fera de nouveau l’objet d’une attention politique et sociale à travers les débats parlementaires sur la loi de santé publique de 2004 et ceux entourant les messages sanitaires dans les publicités alimentaires en 2007.

D’autres mesures seront prises, parmi lesquelles :

la mise en place d’un plan obésité en 2010 (pour améliorer la prise en charge),

le développement d’initiatives locales (villes-santé, santé-environnement, etc.), par exemple ici, dans les Hauts-de-France, et de plans autour de l’activité physique ou encore

Mais le poids des lobbies, et la complexité des actions à mener pour réduire la prévalence de l’obésité en font un problème insoluble – en tout cas sans changements sociaux structurels.

Alors, plus de vingt ans après le lancement du premier PNNS, le constat est sans appel : la prévalence de l’obésité continue de croître. Cet échec relatif s’explique par plusieurs facteurs structurels.

Une approche trop centrée sur la responsabilité individuelle

Tout d’abord, les politiques publiques françaises ont adopté une approche essentiellement comportementale, centrée sur la responsabilité individuelle : mieux manger, bouger davantage, équilibrer son alimentation.

Ce cadrage moral et sanitaire tend à négliger les déterminants sociaux de la santé, alors que les études montrent que l’obésité touche davantage les classes populaires, les femmes et les habitants de certaines régions. En ciblant les comportements sans agir sur les conditions de vie – précarité, urbanisme, accès à des aliments de qualité –, ces politiques ne font qu’effleurer les causes profondes du phénomène.

Ensuite, les politiques de lutte contre l’obésité se caractérisent par une forte dispersion institutionnelle (ministère de la santé, de l’éducation nationale, de la ville…). Les mesures se succèdent sans continuité, souvent diluées dans des programmes plus larges (nutrition, prévention, activité physique). L’obésité n’apparaît que comme un sous-thème, rarement comme une priorité politique autonome. Cette dilution empêche la mise en place d’une stratégie nationale cohérente et dotée de moyens pérennes.

Le poids de l’agro-industrie

Enfin, le poids des industries agroalimentaires constitue un frein structurel à l’effectivité des politiques nutritionnelles. Dotées de ressources économiques, juridiques et communicationnelles considérables, ces industries développent des stratégies d’influence visant à affaiblir, retarder ou contourner les mesures de santé publique adoptées par les pouvoirs publics.

L’un des exemples les plus emblématiques concerne les mobilisations contre le Nutri-Score, portées par des acteurs industriels (secteurs des huiles, des produits laitiers, des produits sucrés) et certains États membres de l’Union européenne, comme l’Italie, qui ont cherché à en contester la scientificité, à en limiter le caractère obligatoire ou à promouvoir des systèmes alternatifs moins contraignants auprès de la Commission européenne. Ces actions s’inscrivent dans une logique classique de lobbying réglementaire, visant à déplacer le débat du terrain de la santé publique vers celui de la liberté économique, du choix du consommateur ou de la protection des « traditions alimentaires ».

À lire aussi : Retour sur les principaux arguments des « anti-Nutri-Score »

Ces logiques se retrouvent également dans les tensions autour de la fiscalité nutritionnelle, en particulier la taxe sur les sodas ou sur la réticence à encadrer strictement la publicité alimentaire, notamment à destination des enfants et des adolescents. Dans ce contexte, les politiques publiques apparaissent souvent prises en étau entre injonctions à la prévention des maladies chroniques et pressions industrielles, ce qui limite la portée transformatrice des réformes engagées.

Ces impasses morales, institutionnelles et économiques contribuent à expliquer la difficulté persistante de la France à enrayer l’augmentation de l’obésité, malgré une mobilisation politique et médiatique récurrente.

Lutter aussi contre la grossophobie

Peut-être pourrions-nous également incriminer les préjugés et stéréotypes à l’égard des personnes grosses. Le relatif désengagement des politiques de santé et l’accent mis sur la responsabilité individuelle ne s’expliquent-ils pas, au moins en partie, par une vision stéréotypée de l’obésité, qui en fait avant tout une affaire de décisions personnelles ?

Dans la lutte contre la grossophobie, les pouvoirs publics demeurent en tous cas frileux, déléguant aux bonnes volontés associatives ou professionnelles la mise en place d’actions dont on peine à deviner les contours. À cet égard, l’absence du terme de « grossophobie » dans la dernière feuille de route obésité présentée par le gouvernement interroge fortement.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

10.02.2026 à 00:05

La fauconnerie comme outil de subversion des normes de genre au Moyen Âge

Rachel Delman, Heritage Partnerships Coordinator, University of Oxford

Texte intégral (2914 mots)

Dans deux films récents consacrés à la vie des femmes au Moyen Âge, on observe la présence de faucons, symboles de pouvoir et, au risque d’employer un anachronisme, d’émancipation avant l’heure.

Les faucons prennent leur envol au cinéma. Dans deux adaptations littéraires récentes — Hamnet et H is for Hawk —, ces oiseaux sont intimement liés à la vie et aux émotions de leurs héroïnes respectives : Agnes Shakespeare (née Hathaway) et Helen Macdonald.

La symbolique des rapaces est au cœur de ces deux nouveaux films : Hamnet, l’adaptation par Chloé Zhao du roman de Maggie O’Farrell paru en 2020, et H is for Hawk, tiré des mémoires de Macdonald publiés en 2014 et traduits en français par M pour Mabel. Dans ces films, les faucons deviennent des figures complexes et ambivalentes.

Si Hamnet se déroule à l’époque élisabéthaine, H is for Hawk prend place dans le monde contemporain. Mais une histoire encore plus ancienne retrace la relation entre femmes et oiseaux de proie. Mes recherches montrent qu’au Moyen Âge déjà, cette relation était multiforme. Bien plus qu’un accessoire de mode, les faucons offraient aux femmes un moyen d’affirmer leur genre, leur pouvoir et leur statut social dans un monde largement dominé par les hommes.

Au Moyen Âge, le dressage des faucons — subtil jeu d’équilibre entre contrôle et liberté — était fréquemment associé à la cour amoureuse entre hommes et femmes.

La dimension romantique de la fauconnerie transparaît dans les œuvres d’art, les objets et la littérature de l’époque. Des scènes d’hommes et de femmes chassant ensemble à l’aide de faucons figurent parmi un large éventail d’artéfacts médiévaux : tapisseries ornant murs de châteaux, étuis décorés servant à protéger les miroirs à main…

La plus grande tapisserie des Devonshire Hunthing Tapestries — un ensemble de quatre tapisseries du XVe siècle — est entièrement consacrée à la fauconnerie. Des amoureux y sont représentés en train de se promener bras dessus bras dessous, pendant que leurs oiseaux chassent le gibier.

Deux étuis à miroir du XIVe siècle, conservés au British Museum et au Metropolitan Museum of Art, représentent des couples à cheval, tenant des faucons. Ces miroirs ont probablement été offerts comme gages d’amour. La littérature médiévale regorge elle aussi de références à des femmes accompagnées de faucons, voire représentées comme tels.

Mais la figure de la femme-faucon qu’il faudrait « dompter et contrôler » ne renvoie toutefois pas à une soumission féminine. Au contraire, la fauconnerie et sa symbolique permettaient aux femmes de l’élite médiévale d’exprimer leur autorité et leur autonomie.

Se définir à travers l’image

Lorsque les femmes de haut rang avaient la possibilité de se représenter à travers la culture visuelle, elles choisissaient souvent d’y inclure des oiseaux de proie. Cela était notamment visible sur les sceaux, cachets officiels souvent utilisés à l’époque médiévale pour authentifier les documents juridiques. Le sceau constituait la marque d’identification de la personne qui l’apposait, et renvoyait à son statut social et à son autorité. L’iconographie des sceaux et les matrices servant à les produire reflétaient la manière dont les femmes de haut rang voulaient être perçues par le monde.

Elizabeth de Rhuddlan, la plus jeune fille du roi Edouard Ier d’Angleterre et d’Eleonore de Castille, a choisi pour la matrice de son sceau personnel, un motif particulièrement répandu chez les femmes du XIIIe siècle : une femme debout, corps légèrement tourné vers un rapace docile posé sur sa main gauche.

Une autre matrice du même siècle montre Elizabeth, dame de Sevorc, à cheval, assise en amazone, tenant un faucon dans une main et la serre d’un aigle dans l’autre.

À travers ces sceaux, les femmes médiévales affirmaient leur maîtrise des rapaces, mais surtout, leur appartenance à un cercle féminin puissant.

Des archives montrent par ailleurs que reines et dames ont créé et administré des parcs et domaines de chasse. Elles pratiquaient la fauconnerie ensemble, dressaient les rapaces et les offraient même parfois en cadeau.

Certaines petites espèces, comme le faucon merlin, étaient jugées plus convenables pour les femmes. Dans le film H is for Hawk, Helen (Claire Fory) refuse de se contenter d’un faucon merlin, qu’elle rejette comme « oiseau de dame ». Effectivement, les femmes du Moyen Âge n’acceptaient pas toujours, loin de là, de se plier aux règles prescrites par les manuels de bonne conduite.

Margaret Beaufort, la grand-mère paternelle d’Henry VIII, possédait de nombreux rapaces : faucons merlins, lanerets… mais aussi de grandes espèces comme des autours et des faucons lanier.

Le parc à daims qu’elle fit aménager autour de son palais de Collyweston, dans le Northamptonshire, se prêtait parfaitement à la fauconnerie. Sa belle-fille, la reine Elizabeth de York, qui disposait de ses propres appartements au palais, chassait quant à elle avec des autours.

Dans certains cas, les femmes semblent même avoir été reconnues comme de véritables expertes dans le domaine de la fauconnerie. Les Heures Taymouth, un livre d’heures enluminé du XIVe siècle, probablement destiné à une femme d’origine royale, montre des femmes coiffées de parures, chassant le colvert à l’aide de grands rapaces. Leur posture affirme leur autorité, leur savoir-faire et leur contrôle sur les oiseaux.

Au siècle suivant, Dame Juliana de Berners, prieure du monastère de Sopwell, est considérée comme l’autrice — en partie — du Boke of St Albans, un ouvrage traitant de la chasse et de la fauconnerie.

Des recherches menées par English Heritage ont par ailleurs révélé que certaines femmes pouvaient gagner leur vie grâce à leur expertise en matière de dressage de faucons. Au milieu du XIIIe siècle, une femme nommée Ymayna était la gardienne des faucons et des chiens du comte de Richmond. En échange de ses services, elle et sa famille obtinrent le droit d’exploiter des terres voisines.

Si Ymayna constitue une figure exceptionnelle dans un milieu largement masculin, son parcours laisse penser que d’autres femmes ont exercé des fonctions similaires, bien que leurs noms soient absents de tout document historique.

Certaines pourraient figurer parmi les propriétaires de couteaux dont les manches sont conservés dans des musées européens. L’un des plus remarquables, sur lequel est sculptée une femme noble serrant contre son cœur un petit rapace, date du XIVe siècle et est exposé à l’Ashmolean Museum d’Oxford.

Les textes littéraires révèlent que la fauconnerie favorisait la socialisation et la solidarité entre femmes. Dans le poème Sir Orfeo, écrit en moyen anglais, Orfeo aperçoit un groupe de soixante femmes à cheval, chacune tenant un faucon.

Dans Hamnet, Agnes explique à son mari William Shakespeare que son gant de fauconnerie lui a été offert par sa mère. Les femmes du Moyen Âge et du début de l’époque moderne s’offraient des cadeaux entre elles, y compris des gants. Mes recherches suggèrent toutefois que les oiseaux de proie étaient plus fréquemment offerts comme cadeaux entre femmes et hommes.

Margaret Beaufort donnait et recevait des rapaces de la part de parents et de proches masculins, parmi lesquels son jeune petit-fils, le futur Henri VIII. Les rapaces étaient considérés comme étant des cadeaux convenables lors d’occasions et évènements marquants. En 1525, Margaret Pole, comtesse de Salisbury, offrit par exemple trois faucons à son neveu Henry Courtenay pour célébrer son accession au titre de marquis d’Exeter.

Le fait que des femmes puissantes propriétaires de terres aient pris part aux échanges rituels de rapaces avec des hommes montre que la fauconnerie ne relevait pas uniquement d’une expression féminine du pouvoir. En possédant des domaines de chasse et en donnant ou recevant des oiseaux de proie, elles s’inscrivaient dans un univers traditionnellement masculin : celui de la chasse et de la générosité seigneuriale.

Rachel Delman a reçu des financements du Arts and Humanities Research Council (2013-2016) et du Leverhulme Trust (2019-2022).

10.02.2026 à 00:02

Épées, enfants et mémoire : ce que révèle un cimetière médiéval du Kent

Duncan Sayer, Professor in Archaeology, University of Lancashire

Texte intégral (1893 mots)

Loin d’être de simples symboles guerriers, les épées, lances et boucliers mis au jour témoignent d’une société où les armes exprimaient autant la perte et le deuil que la force et le statut.

Lors d’une récente fouille archéologique à laquelle j’ai pris part, quatre épées anglo-saxonnes anciennes ont été mises au jour. Chacune éclaire la manière dont les armes étaient perçues à l’époque. Plus surprenant encore, un enfant a été retrouvé enterré avec une lance et un bouclier. Faut-il y voir la trace d’un combattant trop jeune pour l’être ? Ou ces objets revêtaient-ils une portée symbolique dépassant largement le seul cadre de la guerre ?

Les armes sont porteuses de valeurs. Les chevaliers Jedi de la franchise Star Wars incarneraient-ils la même noblesse s’ils maniaient des couteaux plutôt que des sabres laser ? Aujourd’hui, les armées modernes font la guerre à distance, à coups de missiles et de drones, ou s’appuient sur des dispositifs mécaniques mêlant armes à feu et blindage. Pourtant, dans de nombreux pays, l’épée demeure un attribut cérémoniel des officiers – au point que la porter de travers peut encore suffire à démasquer un imposteur.

La fouille, que j’ai menée avec l’archéologue Andrew Richardson, portait sur un cimetière du haut Moyen Âge, et les épées ont été découvertes dans des sépultures. Notre équipe, composée de chercheurs de l’Université du Lancashire et d’Isle Heritage, a fouillé au total une quarantaine de tombes. Cette découverte est visible dans l’émission de BBC2 Digging for Britain.

L’une des épées mises au jour se distingue par un pommeau en argent décoré (la partie arrière de la poignée) et par un anneau fixé à la poignée. Il s’agit d’un objet du VIe siècle prestigieux et d’une grande beauté, conservé dans un fourreau doublé de fourrure de castor. L’autre épée présente une petite garde en argent et une large embouchure de fourreau dorée et côtelée – deux éléments de styles artistiques différents, issus de périodes distinctes, réunis sur une même arme.

Ce mélange se retrouve également dans le trésor de Staffordshire, découvert en 2009, qui comprenait 78 pommeaux et 100 collerettes de poignée, datés sur une large période allant du Ve au VIIe siècle de notre ère. Au Moyen Âge, les épées – ou certaines de leurs parties – étaient conservées, transmises et entretenues par leurs propriétaires. Les armes anciennes étaient souvent plus estimées que les neuves.

Le poème en vieil-anglais Beowulf, probablement composé entre le VIIIe et le début du XIe siècle, offre un vocabulaire particulièrement riche pour parler des épées : il y est question de l’« épée ancienne » (ealdsweord), de l’« épée d’autrefois » (gomelswyrd), ou encore d’objets transmis en héritage (yrfelafe). Le texte évoque aussi des « armes durcies par les blessures » (waepen wundum heard), façonnées autant par l’usage que par le temps.

Deux énigmes consacrées à l’épée figurent également dans le Livre d’Exeter, un vaste recueil de poésie mis par écrit au Xe siècle, mais qui renvoie sans doute à des représentations plus anciennes. Dans l’énigme 80, l’arme se définit elle-même comme « a warrior’s shoulder-companion », « la compagne d’épaule du guerrier ». Une formule qui fait écho de manière frappante à nos découvertes du VIe siècle : dans chaque sépulture, la poignée de l’épée était placée contre l’épaule, tandis que le bras du défunt semblait enlacer l’arme.

Un geste comparable a déjà été observé dans des sépultures de Dover Buckland, également dans le Kent. Deux autres cas ont été recensés à Blacknall Field, dans le Wiltshire, et un à West Garth Gardens, dans le Suffolk. Notons qu’il est rare de voir quatre individus enterrés de cette manière au sein d’un même cimetière – d’autant plus qu’ils ont été découverts à très faible distance les uns des autres.

La zone du cimetière que nous avons fouillée comprend plusieurs tombes avec armes, disposées autour d’une sépulture profonde entourée d’un fossé circulaire. Un petit tertre de terre devait à l’origine recouvrir cette tombe, la rendant visible et la distinguant clairement dans le paysage funéraire.

La sépulture la plus ancienne – celle qui a servi de repère pour l’implantation des autres tombes avec armes – contenait un homme dépourvu de tout objet métallique ou armement. Les tombes armées sont surtout attestées dans les générations qui entourent le milieu du VIe siècle : il est donc probable que cet individu ait été enterré avant que ne s’impose l’usage de déposer des armes avec les morts. Peut-être parce que, durant la période troublée de la fin du Ve siècle et des toutes premières années du VIe, les armes étaient jugées trop précieuses pour être soustraites à la défense des vivants.

La découverte d’une tombe d’enfant âgé de 10 à 12 ans, accompagné d’une lance et d’un bouclier, vient renforcer cette interprétation. La courbure de sa colonne vertébrale rend peu probable qu’il ait pu manier ces armes de manière fonctionnelle.

Une seconde sépulture, celle d’un enfant encore plus jeune, contenait une large boucle de ceinture en argent. L’objet était manifestement trop grand pour un garçon de deux à trois ans. Ce type de dépôt est habituellement associé à des hommes adultes : les grandes boucles de ceinture constituaient un symbole de fonction dans les contextes de la fin de l’Antiquité romaine et du haut Moyen Âge, comme en témoignent, par exemple, les spectaculaires exemplaires en or de Sutton Hoo.

La découverte d’une tombe d’enfant âgé de 10 à 12 ans, comprenant une lance et un bouclier, vient compléter ce tableau. La courbure de sa colonne vertébrale rendait peu probable un usage aisé de ces armes.

Une deuxième tombe, celle d’un enfant encore plus jeune, a livré une large boucle de ceinture en argent. L’objet, de toute évidence, était bien trop grand pour un garçon âgé de deux à trois ans. De tels dépôts funéraires sont habituellement réservés à des hommes adultes : dans l’Antiquité tardive et le haut Moyen Âge, les grandes boucles de ceinture faisaient office de marqueurs de rang ou de fonction, comme l’illustrent les spectaculaires exemplaires en or découverts à Sutton Hoo.

Alors pourquoi ces objets ont-ils été déposés dans les tombes ? De récents résultats d’analyses ADN soulignent l’importance de la filiation masculine, en particulier celle transmise par le chromosome Y. À West Heslerton, dans l’est du Yorkshire, des analyses génétiques montrent l’existence de liens biologiques entre des hommes enterrés à proximité les uns des autres. Beaucoup d’entre eux étaient accompagnés d’armes, dont l’un inhumé avec une épée et deux lances. Plusieurs autres sépultures masculines ont été disposées autour de cet ancêtre fortement armé.

Nous n’affirmons pas pour autant que les armes anciennes étaient uniquement cérémonielles. Les entailles visibles sur les boucliers et l’usure des lames témoignent d’un usage réel, lié à l’entraînement comme au combat. Les blessures et les morts précoces observées sur les squelettes attestent de l’usage bien réel des armes dans la société du haut Moyen Âge. De son côté, la poésie anglaise ancienne parle autant de deuil que d’héroïsme.

Comme le montre Beowulf, le sentiment de perte était étroitement lié à la mise en scène des morts masculins et de leurs armes, mais aussi aux inquiétudes face à l’avenir :

The Geat people built a pyre for Beowulf, Beowulf’s funeral

(Le peuple des Goths érigea un bûcher pour Beowulf, pour les funérailles de Beowulf)

stacked and decked it until it stood four-square,

(l’empilant et l’ornant jusqu’à ce qu’il se dresse, solide et parfaitement carré,)

hung with helmets, heavy war-shields

(garni de casques, de lourds boucliers de guerre)

and shining armour, just as he had ordered.

(et d’armures étincelantes, comme il l’avait ordonné.)

Then his warriors laid him in the middle of it,

(Puis ses guerriers le déposèrent en son centre,)

mourning a lord far-famed and beloved.

(pleurant un seigneur illustre et aimé.)

Les armes déposées dans nos tombes relevaient autant de l’expression de la perte et du deuil que d’une affirmation matérielle de la force, de la masculinité et de la lignée masculine. Même des guerriers aguerris, endurcis par les combats et par l’âge, pleuraient leurs morts et les enterraient avec des armes – des épées notamment – porteuses d’histoires.

La lance, le bouclier et les boucles de ceinture découverts dans de petites tombes parlaient des hommes que ces enfants auraient pu devenir.

Duncan Sayer tient à remercier le Dr Andrew Richardson, codirecteur du projet de fouilles de l’est du Kent.

09.02.2026 à 23:08

En Mésopotamie, le rôle très important des personnes trans

Chaya Kasif, PhD Candidate; Assyriologist, Macquarie University

Texte intégral (2998 mots)

Loin d’être marginalisées, certaines personnes de genre atypique jouaient un rôle central dans le culte, la politique et l’armée en Mésopotamie, montrant une forme ancienne de reconnaissance sociale.

Aujourd’hui, les personnes trans font face à une politisation de leur vie et à la diabolisation par des politiciens, certains médias et une partie de la société. Mais dans quelques-unes des premières civilisations de l’histoire, ces personnes étaient reconnues et comprises de manière totalement différente.

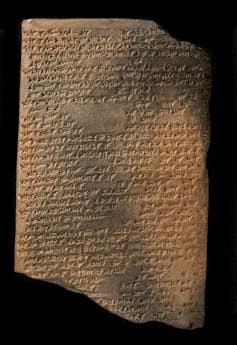

Dès 4 500 ans avant notre ère, en Mésopotamie dans le Proche-Orient ancien par exemple, des rôles sociaux importants, avec des titres professionnels majeurs, étaient dévolus aux personnes de genre atypique. Notamment les serviteurs cultuels de la grande divinité Ištar, appelés assinnu, et les hauts courtisans royaux appelés ša rēši. Des preuves antiques montrent que ces personnes occupaient des positions de pouvoir en raison de leur ambiguïté de genre, et non malgré elle.

La Mésopotamie

La Mésopotamie est une région qui correspond aujourd’hui principalement à l’Irak et à des régions de la Syrie, de la Turquie et de l’Iran. Faisant partie du Croissant fertile, le mot « Mésopotamie » vient du grec et signifie littéralement « terre entre deux fleuves », l’Euphrate et le Tigre.

Pendant des milliers d’années, plusieurs grands groupes culturels y ont vécu. Parmi eux, les Sumériens, puis plus tard les groupes sémitiques appelés Akkadiens, Assyriens et Babyloniens.

Les Sumériens ont inventé l’écriture en traçant des coins sur des tablettes d’argile. L’écriture, appelée cunéiforme, a été créée pour transcrire la langue sumérienne, mais les civilisations suivantes l’ont utilisée pour écrire leurs propres dialectes de l’akkadien, la plus ancienne langue sémitique.

Qui étaient les assinnu ?

Les assinnu étaient les serviteurs religieux de la grande déesse mésopotamienne de l’amour et de la guerre, Ištar.

Reine des cieux, Ištar a précédé Aphrodite et Vénus.

Connue des Sumériens sous le nom d’Inanna, cette déesse guerrière détenait le pouvoir politique ultime et conférait leur légitimité aux rois. Elle veillait également sur l’amour, la sexualité et la fertilité. Dans le mythe de son voyage aux Enfers, sa mort entraîne la fin de toute reproduction sur Terre. Pour les Mésopotamiens, Ištar était l’une des plus grandes divinités du panthéon. L’entretien de son culte officiel garantissait la survie de l’humanité.

Ses serviteurs, les assinnu, avaient la responsabilité de la satisfaire et de s’occuper d’elle par le biais de rituels religieux et de l’entretien de son temple. Le titre même d’assinnu est un mot akkadien lié à des termes signifiant « féminin », « homme-femme » ainsi que « héros » et « prêtresse ».

Leur fluidité de genre leur venait directement d’Ištar. Dans un hymne sumérien, la déesse est décrite comme ayant le pouvoir de :

transformer un homme en femme et une femme en homme,

changer l’un en l’autre,

habiller les femmes avec des vêtements d’hommes,

habiller les hommes avec des vêtements de femmes,

mettre des fuseaux dans les mains des hommes,

et donner des armes aux femmes.

Les assinnu ont d’abord été considérés par une partie des historiens comme un type de travailleur·se religieux·se sexuel·le. Une conception qui repose sur des hypothèses anciennes concernant les groupes transgenres et qui n’est pas fortement étayé par les preuves.

Le titre est aussi souvent traduit par « eunuque », bien qu’il n’existe aucune preuve claire qu’il se soit agi d’hommes castrés. Si le titre est principalement masculin, il existe des preuves d’assinnu féminines. En réalité, divers textes montrent une résistance à la binarité de genre.

Leur importance religieuse leur attribuait des pouvoirs magiques et de guérison. Une incantation dit :

Que ton assinnu se tienne à mes côtés et retire ma maladie. Qu’il fasse sortir par la fenêtre la maladie qui m’a saisi.

Un présage néo-assyrien indique également que des relations sexuelles avec un assinnu pouvaient procurer des avantages personnels :

Si un homme s’approche d’un « assinnu » pour avoir des relations sexuelles, les interdits à son égard seront assouplis.

En tant que dévots d’Ištar, ils exerçaient également une forte influence politique. Un almanach néo-babylonien indique :

le [roi] doit toucher la tête d’un « assinnu », il vaincra son ennemi

et son pays obéira à ses ordres.

Ayant vu leur genre transformé par Ištar elle-même, les assinnu pouvaient marcher entre le divin et le mortel tout en veillant au bien-être des dieux et de l’humanité.

Qui étaient les « ša rēši » ?

Généralement décrits comme des eunuques, les ša rēši étaient des serviteurs du roi. Les « eunuques » de cour ont été recensés dans de nombreuses cultures au fil de l’histoire. Cependant, le terme n’existait pas en Mésopotamie, et les ša rēši avaient leur propre titre distinct.

Le terme akkadien ša rēši signifie littéralement « un de la tête » et désigne les courtisans les plus proches du roi. Leurs fonctions au palais étaient variées, et ils pouvaient occuper plusieurs postes de haut rang simultanément.

Les preuves de leur ambiguïté de genre sont à la fois textuelles et visuelles. Plusieurs textes les décrivent comme infertiles, comme une incantation qui dit :

Comme un « ša rēši » qui n’engendre pas, que ton sperme se dessèche !

Les ša rēši sont toujours représentés imberbes, en contraste avec un autre type de courtisan appelé ša ziqnī (« celui qui a une barbe »), qui avait des descendants. Dans les cultures mésopotamiennes, la barbe symbolisait la virilité ; un homme imberbe allait donc directement à l’encontre de la norme. Pourtant, des bas-reliefs montrent que les ša rēši portaient les mêmes vêtements que les autres hommes royaux, leur permettant ainsi d’afficher leur autorité aux côtés des autres élites masculines.

L’une de leurs fonctions principales était de superviser les quartiers des femmes dans le palais – un lieu à accès très restreint – où le seul homme autorisé à entrer était le roi lui-même.

Étant si étroitement liés au roi, ils pouvaient non seulement occuper des fonctions martiales comme gardes et conducteurs de char, mais aussi commander leurs propres armées. Après leurs victoires, les ša rēši se voyaient attribuer des biens et la gouvernance de territoires nouvellement conquis, comme en témoigne l’inscription royale en pierre que l’un d’eux s’est fait ériger.

Grâce à leur fluidité de genre, les ša rēši pouvaient transcender non seulement les limites de l’espace genré, mais aussi celles séparant le souverain de ses sujets.

La fluidité de genre comme outil de pouvoir

Alors que les premiers historiens considéraient ces figures comme des « eunuques » ou des « travailleur·ses religieux·ses sexuel·les », les preuves montrent que c’est parce qu’ils vivaient en dehors de la binarité de genre que ces groupes pouvaient occuper des rôles puissants dans la société mésopotamienne.

Reconnaître aujourd’hui l’importance des personnes trans et de genre divers dans nos communautés, est, en quelque sorte, une continuité du respect accordé à ces figures anciennes.

Chaya Kasif ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

09.02.2026 à 23:08

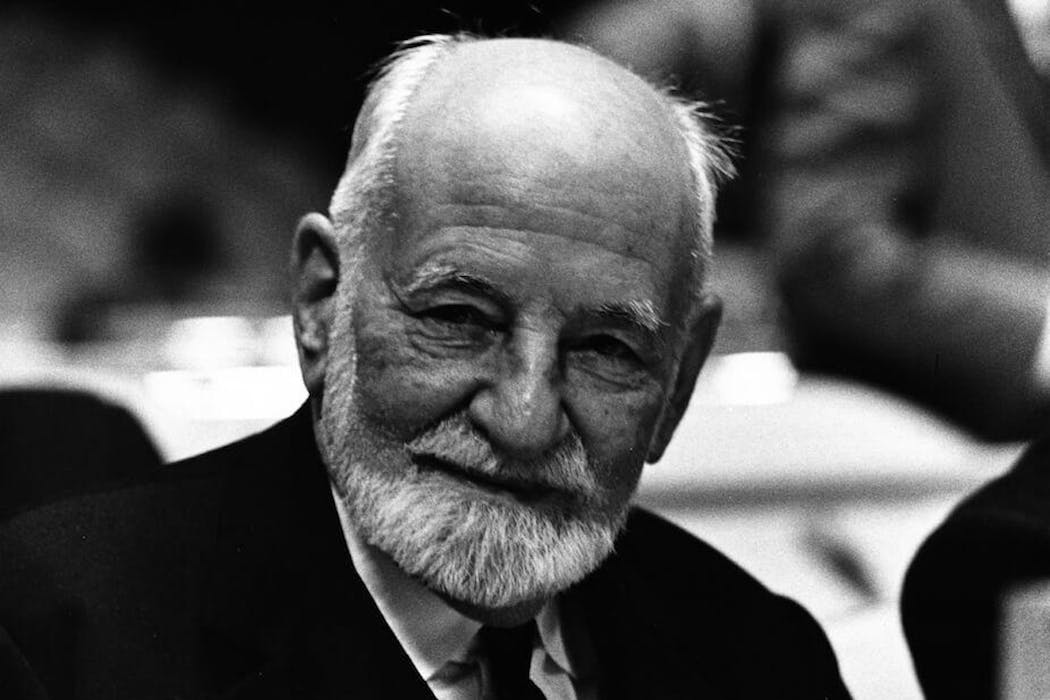

René Cassin, un héritage moral très actuel

Julien Broch, Maître de Conférences HDR en Histoire du droit et des institutions, Aix-Marseille Université (AMU)

Texte intégral (2266 mots)

Le juriste et diplomate René Cassin, dont on s’apprête à commémorer le cinquantième anniversaire de la disparition, a consacré sa vie à la défense de la dignité humaine et de la paix, alliant idéalisme et réalisme. Résistant et proche de de Gaulle, il a joué un rôle clé au sein de la France libre puis contribué à la création de l’ONU et à l’élaboration de la Déclaration universelle des droits de l’homme en 1948, ce qui lui vaudra le prix Nobel de la paix, vingt ans plus tard. Sa pensée et son action restent aujourd’hui une source d’inspiration pour relever les défis internationaux et renforcer la solidarité entre les peuples.

Le 20 février prochain, cela fera tout juste cinquante ans que disparaissait le juriste internationaliste René Cassin (1887-1976), prix Nobel de la paix 1968.

Alors que nous sommes confrontés à un monde devenu sans boussole autre que la force pour ce qui est de la conduite des relations internationales, il est rafraîchissant de revenir à la pensée et à l’action de cet universitaire passé par les universités d’Aix-Marseille, Lille et Paris, que François Mitterrand présenta comme un « professeur d’espoir » lors de son entrée au Panthéon le 5 octobre 1987.

Espoir, parce que, résilient, il a fait preuve d’optimisme de la volonté lors du déchaînement de l’hitlérisme. Ce grand blessé de la Première Guerre mondiale, qui a dû porter toute sa vie une ceinture abdominale, a cherché à se rendre utile en se faisant l’avocat à la fois idéaliste et réaliste de la dignité humaine et de la paix.

L’œuvre de celui qui a dirigé plusieurs des éminentes juridictions françaises et internationales (Conseil d’État, Conseil constitutionnel, Cour européenne des droits de l’homme…) rappelle assez qu’il est illusoire de croire en la force du droit. Elle n’est qu’une incantation. Le droit n’est fort que lorsqu’il est juste et qu’il se trouve des bonnes volontés pour le défendre.

La paix, grande affaire de tous

Que dit Cassin à nous autres du XXIe siècle ?

D’abord que quand la valeur « paix » cesse d’être la grammaire du monde, il est crucial de la rendre désirable aux peuples. C’est la raison pour laquelle, à la tête de mouvements d’anciens combattants, il s’est attaqué, d’abord officieusement, puis à partir de 1924 officiellement en tant que membre de la délégation française aux assemblées de la Société des Nations, à la « dernière tranchée », celle des droits sociaux, au sein du Bureau international du travail.

Son idée ? Mettre autour de la table les vétérans des ex-pays belligérants pour les faire travailler sur des problèmes concrets, tels que les emplois réservés pour les estropiés, l’accès aux prothèses et aux soins médicaux, la prise en charge des pupilles de la Nation, etc. C’est dire assez qu’il appartient présentement à la société civile de jeter les ponts au-dessus des océans et des autres frontières pour, en dépit du mauvais vouloir de certains grands de ce monde et de leurs idéologues, sauver ce qui peut l’être et bâtir de nouvelles coopérations.

Ensuite, face aux nouveaux « États-Léviathan », qui sont des concentrations de puissance n’ayant d’autre morale que la leur, et qui s’assoient sur le droit international dès lors qu’il s’agit de déchaîner leur force pour acquérir des ressources et des territoires, ou lorsqu’il leur plaît d’imposer sur un mode agressif leur politique commerciale aux pays tiers, il ne faut jamais renoncer à donner de la voix et à agir. Immédiatement après ce grand renoncement qu’ont été les accords de Munich, signés le 29 septembre 1938, Cassin, tout en reprenant son bâton de pèlerin du multilatéralisme et du droit international, en a appelé à la signature de partenariats stratégiques – y compris avec l’URSS – pour tenir en respect le Reich hitlérien. Et d’écrire, vu la tiédeur de certains partenaires de Paris :