ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

12.10.2025 à 08:59

Freinage et particules fines : une pollution routière oubliée des évolutions réglementaires ?

Alice Mirailler, Ph.D. Candidate, Laboratoire de Mécanique des Contacts et des Structures LaMCoS, INSA Lyon – Université de Lyon

Ana-Maria Trunfio-Sfarghiu, Chercheuse, INSA Lyon – Université de Lyon

Texte intégral (2369 mots)

Alors que la 50e édition du salon EquipAuto, salon international des pros de l’automobile, s’ouvre à Paris ce 14 octobre, penchons-nous sur l’autre problème de pollution, grandissant, posé par toutes les voitures, même électriques : les émissions hors échappement, dues à l’usure des freins, des pneus et de la chaussée. La question est indépendante de l’enjeu de réduire les émissions à l’échappement des voitures neuves, qui ont déjà fortement diminué du fait des progrès techniques. Une norme européenne, qui doit entrer en vigueur en 2026, entend les réduire, mais sa mise en œuvre pourrait ne pas livrer les effets escomptés.

Au 1er janvier 2024, le parc routier français était constitué de 39,3 millions de voitures particulières, de 6,5 millions de véhicules utilitaires légers (VUL), de 625 000 poids lourds et de 94 000 autobus et autocars en circulation.

Dans les contextes de forte densité du trafic, les émissions polluantes liées au transport routier restent un enjeu majeur de santé publique. En France, les véhicules particuliers sont à l’origine de plus de la moitié des émissions de gaz à effet de serre du secteur des transports. En 2019, ils représentaient 26 % des émissions nationales d’oxyde d’azote (NOx), un polluant irritant pour les voies respiratoires, et 22 % des émissions nationales de CO2.

Si les émissions à l’échappement, dues à la combustion dans les moteurs, ont été progressivement réduites grâce aux normes antipollution successives, une attention croissante est désormais portée aux émissions dites hors échappement, issues notamment de l’usure des freins, des pneus et de la chaussée.

La future norme Euro 7, qui entrera en vigueur à partir de 2026, marque une étape importante en intégrant pour la première fois ces sources de pollution non négligeables… sans pour autant résoudre tous les problèmes.

Émissions hors échappement : de quoi parle-t-on ?

Au cours des dernières années, des recherches scientifiques et industrielles ont permis d’importantes diminutions des émissions à l’échappement des véhicules récents, essence ou diesel. Cela résulte de l’allègement des véhicules, de la réduction de la consommation des moteurs thermiques et de l’installation des filtres à particules (FAP) pour limiter les émissions issues de la combustion du carburant.

Ce qui pèse désormais davantage dans l’empreinte environnementale des voitures, ce sont les émissions hors échappement. Elles regroupent les particules provenant de l’abrasion des freins et des pneus ainsi que de la remise en suspension des poussières sur la chaussée au passage des véhicules.

Si elles ne représentaient que 16 % des particules avec un diamètre inférieur à 10 micromètres (μm) (PM10) totales émises par le transport routier en 1990, cette part a atteint 71 % en 2022. Pour les particules avec un diamètre inférieur à 2,5 μm, ce chiffre est passé de 9 % en 1990 à 57 % en 2022.

Or, les réduire constitue un défi : la sécurité routière dépend justement de l’adhérence des pneus et de l’efficacité du freinage – deux sources inévitables de particules.

Quel impact sur notre santé ?

Lorsque les particules émises par les véhicules sont inhalées, elles se déposent dans différentes régions du système pulmonaire en fonction de leur taille. Les plus dangereuses pour la santé sont les PM1, c’est-à-dire les particules dont le diamètre est inférieur à 1 micromètre, car elles peuvent pénétrer profondément jusqu’aux alvéoles pulmonaires.

Plusieurs études ont démontré que les particules engendrées par le freinage sont des PM1 (de diamètre inférieur à 1 micromètre), voire des particules ultrafines dans le cas des poids lourds (inférieures à 100 nanomètres) et, par conséquent, capables d’atteindre ces alvéoles.

Peu d’études toutefois se sont penchées sur la toxicité des particules non issues de l’échappement sur le système pulmonaire. Pour pallier ce manque, un dispositif innovant a été développé par des scientifiques afin de collecter ces particules pendant deux heures directement dans une solution biologique.

Conçu initialement sous forme de sac à dos pour permettre la collecte en différents points de la ville de Lyon (Rhône), ce système a ensuite été adapté sur un véhicule afin de réaliser des prélèvements en conditions réelles de circulation.

Les premiers résultats suggèrent que les particules de freinage de taille inférieure à 1 micromètre (principalement composées de fer, de cuivre, de baryum et d’antimoine) pourraient présenter un risque sanitaire notable. Leur petite taille leur permet d’interagir avec le surfactant pulmonaire (c’est-à-dire, la matière tensioactive sécrétée dans les poumons) ainsi qu’avec les macrophages alvéolaires. Cette interaction pourrait induire, sur le long terme, une altération progressive de la fonction pulmonaire.

Il est possible qu’une exposition répétée à de faibles doses puisse favoriser le développement de pathologies chroniques, telles que la fibrose pulmonaire, par un processus lent d’accumulation et de réponse inflammatoire persistante.

La norme Euro 7, une réponse appropriée ?

Les émissions hors échappement seront intégrées pour la première fois dans la future norme Euro 7, ce qui constitue une avancée significative vers une évaluation plus complète et rigoureuse des sources de pollution atmosphérique liées aux véhicules.

La norme Euro 7 entrera en vigueur en novembre 2026 pour les voitures et les véhicules utilitaires légers. Pour tous les types de véhicules, la limite maximale des émissions de particules PM10 (de diamètre inférieur à 10 micromètres) serait fixée à 7 mg/km à partir de 2026 et à 3 mg/km à partir de 2035.

L’établissement de cette nouvelle norme soulève cependant une difficulté fondamentale d’ordre physique. Comme évoqué précédemment, des travaux ont démontré que les particules émises lors du freinage sont majoritairement des PM1, avec des tailles inférieures à 1 micromètre. Elles ne tombent donc pas sous le coup de cette réglementation.

De plus, ces particules présentent une masse extrêmement faible, souvent négligeable, ce qui rend les limites actuelles exprimées en milligramme par kilomètre (mg/km) peu adaptées pour quantifier précisément les émissions. Il serait donc pertinent que la réglementation évolue vers une prise en compte fondée sur le nombre de particules émises par kilomètre, afin de mieux refléter la réalité et les impacts potentiels de ces émissions ultrafines.

Les avancées scientifiques et technologiques dans la compréhension et dans la maîtrise des émissions liées au freinage progressent encore à un rythme souvent jugé insuffisant face aux exigences réglementaires et aux impératifs économiques du secteur automobile. En conséquence, les constructeurs proposent actuellement des solutions dont l’efficacité et les impacts restent encore partiellement évalués, parmi lesquelles :

le freinage électromagnétique : il réduit l’usure et les émissions en freinage normal, mais les freins mécaniques restent sollicités lors des freinages d’urgence, engendrant des émissions importantes ;

les filtres à particules à la source : ils peuvent limiter la dispersion des poussières, mais leur impact sur le contact frictionnel entre plaquette et disque – et donc, sur la sécurité – nécessite une validation rigoureuse ;

la modification des matériaux des plaquettes : elle peut réduire leur usure mais également augmenter la production de nanoparticules, dont les effets sanitaires restent mal connus et font l’objet de recherches en cours.

La mobilité électrique, pas forcément une panacée

Selon une analyse publiée par le Centre interprofessionnel technique d'études de la pollution atmosphérique (Citepa), les véhicules électriques émettent un peu moins de particules liées à l’usure des freins grâce au freinage régénératif (c’est-à-dire, s’appuyant sur un système de récupération d’énergie).

Cependant, leur masse plus importante entraîne une augmentation des émissions de particules provenant de l’abrasion des pneus et de la chaussée. Ces deux effets tendent à s’équilibrer, de sorte que les émissions totales de particules des véhicules électriques à grande autonomie sont comparables à celles des véhicules thermiques récents, qui émettent désormais très peu de particules à l’échappement.

Les véhicules électriques soulèvent, par ailleurs, d’importantes interrogations concernant la disponibilité des ressources nécessaires à la fabrication des batteries et concernant les enjeux environnementaux et techniques liés à leur recyclage.

Dès lors, la sobriété apparaît comme l’une des voies les plus cohérentes : réduire nos déplacements lorsque cela est possible et amorcer la transition d’une société centrée sur la consommation vers un modèle plus respectueux de l’environnement.

Ana-Maria TRUNFIO-SFARGHIU a reçu des financements de CNRS et Ministère de la recherche publique (financements liées à la thèse d'Alice Mirailler, son salaire et un petit accompagnement) + chaires INSA Lyon avec VOLVO et MICHELIN

Alice Mirailler ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

11.10.2025 à 09:11

Les adolescents face aux écrans, entre contrôle et « scrolling » : regards croisés de lycéens entre la France et la Chine

Runsen Cao, Doctorant en sciences de l'information et de la communication, Université Bordeaux Montaigne

Texte intégral (1415 mots)

Tout autour du monde, les écrans prennent de plus en plus de place dans la vie des jeunes. Si la manière dont ces derniers sont encadrés diffère d’un pays à l’autre, partout leurs pratiques quotidiennes des écrans les confrontent à nombre de dilemmes. C’est ce que fait ressortir une enquête auprès de lycéens français et chinois.

Le volume de temps et d’engagement consacré « aux écrans » est une des caractéristiques de la culture juvénile actuelle. Si les parents sont animés de multiples craintes concernant les smartphones et autres dispositifs numériques, cette préoccupation n’est pas réservée aux Français. En Chine, où 97,2 % des adolescents ont accès à Internet, même dans les zones rurales, protéger et éduquer les jeunes au numérique constitue également un enjeu de société fondamental.

Or, le contrôle des usages à l’école en Chine est beaucoup plus strict qu’en France. La plupart des lycées chinois interdisent totalement le téléphone personnel. Pour les élèves d’internat, certains établissements proposent des boîtes fermées à l’extérieur des salles de cours pour garder les téléphones jusqu’à la fin de journée.

Au-delà des interdictions et des discours de prévention (la « pause numérique », le rapport de la commission d’enquête parlementaire sur les effets psychologiques de TikTok sur les mineurs, publié le 11 septembre 2025, sans parler des innombrables publications sur les « dangers des écrans ») ou de répression, pourquoi ne pas consulter les adolescents eux-mêmes ? Comment vivent-ils leurs expériences du numérique au quotidien ?

La comparaison entre la France et la Chine sur ce point peut être éclairante, au regard de la différence des contextes de contrôle. Dans le cadre d’une enquête de terrain qualitative conduite auprès de lycéens dans différentes villes de France et de Chine, nous avons pu donner la parole aux adolescents d’environnements sociaux très différents, non seulement sur leurs pratiques mais aussi sur leurs ressentis et sur leurs émotions.

Ennui et sentiment de culpabilité

Pour beaucoup de lycéens français et chinois, passer du temps sur leur téléphone est devenu un automatisme, comme le dit Katherine, élève française en classe de seconde :

« En général, je pense que, lorsqu’on s’ennuie ou qu’on ne sait pas trop quoi faire, on a tout de suite le réflexe de prendre le téléphone. »

C’est particulièrement le cas dans le contexte post-pandémique, selon Xiaoke, élève chinoise de première :

« Je m’ennuyais tellement à la maison et je n’avais pas de moyen de sortir. Du coup je ne pouvais m’amuser qu’avec les produits électroniques*. »

S’ils profitent d’une riche palette de divertissements grâce aux technologies, aux jeux vidéo, aux vidéos (aussi bien les courtes, appelées « shorts », au format vertical, que les longues) ou encore aux messages échangés avec des amis – comme résumé dans l’expression chinoise « jouer (玩 wán) avec le téléphone », qui renvoie à toute activité récréative sur le téléphone (regarder, scroller ou encore « être sur son téléphone » pour la France) –, les adolescents n’entretiennent pas uniquement un rapport ludique au numérique. Ils font la distinction entre ce qui est purement divertissant et ce qui est éventuellement utilitaire, non seulement pour le travail scolaire, mais également pour nourrir leur curiosité sur le monde.

C’est le cas pour cet élève français de terminale, qui perfectionne son anglais à travers la série Peaky Blinders, ou encore pour Hang, élève chinois en première, qui s’intéresse aux vidéos de vulgarisation de savoirs en mathématiques et en philosophie, sur Bilibili (plateforme vidéo chinoise).

Ils sont souvent confrontés à des dilemmes quant à leurs propres usages, mais pas forcément de la même manière. Les lycéens français, qui ont souvent moins de contraintes dans l’usage de leur téléphone, ont conscience d’un usage parfois excessif, notamment à travers le scrolling, qui représente pour certains, comme pour cette élève française en première, une perte de temps :

« Ça ne fait rien, à part bouffer mon temps et mon cerveau. »

Toutefois, il est souvent difficile pour eux de s’arrêter, comme le soulignent beaucoup de recherches, avec le développement d’un sentiment de culpabilité. C’est ce qu’éprouve cette élève française en terminale, qui compense ce sentiment par une stratégie qui consiste à regarder plus de contenus éducatifs et culturels :

« J’essaie de me limiter, je regarde des vidéos culturelles sur YouTube. »

Des « usages de revanche »

Pour les lycéens chinois, face à la réglementation très stricte des usages du téléphone, le dilemme porte sur le choix d’utiliser ou non son téléphone en cachette. La plupart des élèves enquêtés avouent qu’ils ont apporté leur téléphone au lycée malgré l’interdiction. Mais ils ne parviennent pas à en profiter, comme en témoigne un élève chinois en première :

« Autant ne pas l’amener, vu que je n’en profite même pas. »

L’interdiction totale suscite parfois des « usages de revanche », comme évoqué par Lan, lycéen en internat, qui passe quasiment tout son dimanche sur le téléphone, étant donné son usage très limité en cachette dans la semaine.

D’ailleurs, une forme de jeu de cache-cache se met souvent en place avec les parents. Certains, comme Yuan, également en internat, se plaignent d’avoir été « trahis » par les parents qui ont prévenu le lycée qu’il avait probablement apporté son smartphone, car ils ne le trouvaient pas à la maison. D’autres, comme Wan, lycéenne en internat, se félicitent du soutien des parents qui comprennent son besoin de lignes de fuite après une journée d’étude fatigante. Les usages du téléphone reflètent donc aussi la qualité des rapports de confiance avec les parents.

Entre introspection, discipline et contrôle extérieur, les lycéens construisent leur rapport au numérique sous contrainte dans des contextes sociaux différents. L’éducation consiste, pour Kant, en soins, discipline culture. Le philosophe privilégie la référence à cette dernière par rapport aux deux premières. La culture pourrait devenir un point de départ pour repenser l’éducation à l’ère du numérique.

Les jeunes en fin d’adolescence sont non seulement des mineurs dont les pratiques numériques sont à réguler et à éduquer de manière normative, mais également et surtout des sujets en train de se construire à partir d’expériences informationnelles très diverses, qui méritent une attention fine, au-delà des discours de panique. Ces expériences, dans leur diversité, sont largement comparables, voire communes, dépassant les différences des contextes culturels et normatifs.

N. B. : Les prénoms des jeunes cités dans cet article ont été changés pour préserver leur anonymat.

*« Produits électroniques »: l’expression désigne en langue chinoise tous les appareils connectés à Internet.

Runsen Cao ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

11.10.2025 à 08:34

Un sommeil de mauvaise qualité peut accélérer le vieillissement cérébral, selon une nouvelle étude

Abigail Dove, Postdoctoral Researcher, Neuroepidemiology, Karolinska Institutet

Texte intégral (1675 mots)

Une nouvelle étude révèle qu’un sommeil de mauvaise qualité pourrait faire vieillir le cerveau plus vite qu’il ne le devrait – un effet mesurable grâce à l’imagerie cérébrale et lié, en partie, à l’inflammation.

Nous passons près d’un tiers de notre vie à dormir, mais le sommeil est tout sauf une perte de temps. Ce n’est pas une période d’inactivité, mais un processus actif et essentiel qui restaure le corps et protège le cerveau. Lorsque le sommeil est perturbé, le cerveau en subit les conséquences – parfois subtiles, mais qui s’accumulent au fil des années.

Dans une nouvelle étude, mes collègues et moi avons analysé les habitudes de sommeil et les données d’IRM cérébrale de plus de 27 000 adultes britanniques âgés de 40 à 70 ans. Nous avons constaté que les personnes dormant mal présentaient un cerveau qui paraissait sensiblement plus âgé que leur âge réel ne le laisserait supposer.

Mais que signifie exactement le fait qu’un cerveau « paraisse plus vieux » ? Si nous vieillissons tous au même rythme chronologique, notre horloge biologique, elle, peut avancer plus ou moins vite. Grâce aux progrès récents de l’imagerie cérébrale et de l’intelligence artificielle, il est désormais possible aux chercheurs d’estimer l’« âge cérébral » d’une personne à partir des schémas visibles sur ses IRM — tels que la perte de tissu cérébral, l’amincissement du cortex ou encore les lésions des vaisseaux sanguins.

Dans notre étude, cet âge cérébral a été estimé à partir de plus de 1 000 marqueurs d’imagerie. Nous avons d’abord entraîné un modèle d’apprentissage automatique sur les scans des participants les plus en bonne santé — ceux dont le cerveau correspondait le mieux à leur âge chronologique. Une fois le modèle capable de reconnaître les signes d’un vieillissement « normal », nous l’avons appliqué à l’ensemble de la cohorte.

Un âge cérébral supérieur à l’âge réel peut signaler un écart par rapport à un vieillissement sain. Des travaux antérieurs ont déjà établi qu’un cerveau d’apparence plus âgée est associé à un déclin cognitif accéléré, à un risque accru de démence et même à une mortalité prématurée plus élevée.

Le sommeil est un phénomène complexe, et aucune mesure isolée ne peut à elle seule refléter sa qualité globale. Nous nous sommes donc concentrés sur cinq aspects du sommeil autorapportés par les participants : leur chronotype (plutôt « matinal » ou « nocturne »), la durée habituelle du sommeil (de sept à huit heures étant considérées comme optimale), la présence d’insomnie, le ronflement et la somnolence diurne excessive.

Ces facteurs peuvent interagir entre eux. Par exemple, une personne souffrant d’insomnie fréquente peut également ressentir une somnolence diurne plus importante, et avoir un chronotype tardif peut entraîner une durée de sommeil plus courte. En combinant ces cinq paramètres dans un « score de sommeil sain », nous avons obtenu une vision plus complète de la santé globale du sommeil.

Les participants présentant quatre ou cinq comportements sains formaient le groupe au sommeil « sain », ceux ayant deux ou trois comportements sains constituaient le groupe « intermédiaire », et ceux n’en présentant aucun ou un seul appartenaient au groupe au sommeil « médiocre ».

Les résultats étaient clairs : pour chaque point perdu au score de sommeil sain, l’écart entre l’âge cérébral et l’âge chronologique augmentait d’environ six mois. En moyenne, les personnes au sommeil médiocre avaient un cerveau paraissant presque un an plus vieux que prévu, alors que celles au sommeil sain ne présentaient pas de tel écart.

En analysant chaque paramètre séparément, nous avons observé que le chronotype tardif et une durée de sommeil anormale étaient les principaux contributeurs à un vieillissement cérébral accéléré.

Un an peut sembler peu, mais en matière de santé cérébrale, c’est significatif. Même de légères accélérations du vieillissement du cerveau peuvent, à long terme, accroître le risque de déclin cognitif, de démence et d’autres troubles neurologiques.

La bonne nouvelle, c’est que les habitudes de sommeil peuvent être modifiées. Bien que tous les troubles du sommeil ne soient pas faciles à corriger, quelques stratégies simples — maintenir un horaire de coucher régulier, limiter la consommation de caféine, d’alcool et l’utilisation d’écrans avant le coucher, et favoriser un environnement calme et sombre — peuvent améliorer la qualité du sommeil et protéger la santé du cerveau.

Comment le sommeil influence-t-il la santé du cerveau ?

Une explication pourrait résider dans l’inflammation. De plus en plus de preuves indiquent que les troubles du sommeil augmentent le niveau d’inflammation dans l’organisme, ce qui peut nuire au cerveau en endommageant les vaisseaux sanguins, en favorisant l’accumulation de protéines toxiques et en accélérant la mort des cellules cérébrales.

Nous avons pu explorer ce lien grâce aux échantillons sanguins collectés au début de l’étude sur les participants, riches en informations sur différents biomarqueurs inflammatoires. En les intégrant à nos analyses, nous avons constaté que l’inflammation expliquait environ 10 % du lien entre le sommeil et le vieillissement cérébral.

D’autres mécanismes pourraient aussi intervenir

Une autre piste concerne le système glymphatique – le réseau de nettoyage des déchets du cerveau, principalement actif durant le sommeil. Lorsque celui-ci est perturbé ou insuffisant, ce système fonctionne moins bien, laissant s’accumuler des substances nocives.

Il est également possible que le fait de mal dormir augmente le risque d’autres pathologies néfastes pour le cerveau, notamment le diabète de type 2, l’obésité ou les maladies cardiovasculaires.

Notre étude, l’une des plus vastes et complètes du genre, s’appuie sur une population importante, une approche multidimensionnelle de la qualité du sommeil et une estimation détaillée de l’âge cérébral fondée sur des milliers d’indicateurs IRM. Bien que des recherches antérieures aient déjà montré qu’un sommeil de mauvaise qualité est associé au déclin cognitif et à la démence, notre recherche montre aussi qu’il est lié à un cerveau qui semble plus âgé, ce qui est dû, en partie, à l’inflammation.

Le vieillissement cérébral est inévitable, mais nos comportements et nos choix de mode de vie peuvent influencer son évolution. Les implications de nos recherches sont claires : pour préserver la santé de notre cerveau, faisons du sommeil une priorité.

Abigail Dove bénéficie d'un financement de la part d'Alzheimerfonden, Demensfonden et de la Fondation Loo et Hans Osterman pour la recherche médicale.

11.10.2025 à 08:31

Donald Trump et Pete Hegseth appellent 800 généraux à combattre « l’ennemi intérieur »

Olivier Sueur, Enseigne la compétition stratégique mondiale et les enjeux transatlantiques, Sciences Po

Texte intégral (1612 mots)

Jamais l’ensemble des généraux américains n’avaient été convoqués pour écouter le président du pays et leur ministre de tutelle comme ce fut le cas ce 30 septembre à Quantico (Virginie). Cette réunion historique a vu Donald Trump et Pete Hegseth tenir à des hauts gradés silencieux un discours aux intonations martiales et virilistes dont l’objectif réel était de les préparer à diriger des opérations militaires… à l’intérieur même des États-Unis, dans les villes dirigées par des démocrates.

Le 30 septembre 2025, le secrétaire américain à la guerre Pete Hegseth a prononcé devant 800 officiers généraux américains réunis à Quantico, en Virginie, un discours mémorable, qui a été suivi d’une intervention du président – et commandant en chef des armées, Donald Trump.

Cette réunion avait fait en amont l’objet des spéculations les plus folles, et son déroulement nourrit désormais moqueries et parodies sur les réseaux sociaux. Convoquée début septembre, soit avec un préavis très court, une réunion de chefs militaires américains de cette ampleur n’a pas de précédent connu. Elle mérite une véritable analyse pour en comprendre l’exacte signification, de même que son importance structurante pour les trois prochaines années.

Une réunion annoncée au dernier moment, mais préparée depuis longtemps

Commençons par resituer le contexte de cette réunion.

Premièrement, l’administration Trump a procédé à une première épuration parmi les plus hauts gradés de l’armée : le chef d’état-major des armées le général C. Q. Brown, la cheffe d’état-major de la Marine Lisa Franchetti, le directeur du renseignement militaire Jeffrey Kruse, l’amirale commandant les garde-côtes Linda Fagan… une dizaine de départs de responsables de premier plan a été enregistrée depuis février.

Deuxièmement, le secrétaire à la guerre a pris, le 5 mai 2025, une directive ordonnant la réduction du nombre d’officiers généraux cinq étoiles de 20 %, soit un passage de 37 à 30 du nombre d’officiers généraux de la garde nationale d’au moins 20 %, et du nombre d’officiers généraux des forces armées de 10 % (de 838 à environ 700).

Troisièmement, le département de la défense a été rebaptisé « département de la guerre », le 5 septembre 2025, sur décision du président Trump.

Quatrièmement, deux documents structurants pour l’organisation de ce ministère sont en cours d’achèvement cet automne, à savoir la stratégie nationale de défense (National Defense Strategy) et la révision de la configuration mondiale des forces (Global Force Posture Review). Ces documents doivent aboutir à une réduction significative du volume des forces stationnées à l’étranger et se traduire par une bascule de leur déploiement de l’Europe vers l’Indo-Pacifique.

L’annonce d’un « changement de culture »

Au vu de l’ensemble de ces éléments, une forme de nervosité, voire d’appréhension, de la part des participants n’apparaissait pas illégitime. Et ils n’ont pas été déçus : Pete Hegseth a fait de son intervention le « jour de libération des guerriers de l’Amérique », paraphrasant le « jour de la libération » proclamé par Donald Trump, le 2 avril 2025, lors de ses annonces en matière de droits de douanes.

Son objectif révélé dès la première minute de son intervention est d’« avoir les bonnes personnes et la bonne culture au département de la guerre », car c’est le personnel qui fait la politique d’une organisation (« Personnel is policy »). Il dénonce ensuite longuement la « dérive woke » au sein des forces armées américaines – promotions sur la base d’appartenance raciale ou de quotas de genre, politiquement correct, mois de l’identité, programmes Diversity, Equity, and Inclusion (DEI), femmes dans les unités combattantes, transsexuels, gros, barbus, cheveux longs… Bref, tout y passe, et Hegseth promet d’y porter le fer avec énergie.

Tout cela n’est en aucun cas une surprise puisqu’il s’agit ni plus ni moins que de la politique engagée au niveau national par le président Trump – et annoncée lors de sa campagne.

En revanche, ce qui est passionnant dans ce discours, c’est son caractère programmatique. D’abord, le secrétaire à la guerre annonce que ses services se dotent des moyens de mettre en œuvre cette rééducation culturelle des militaires américains à l’égard de l’« idéologie woke » grâce à l’envoi aux participants de dix directives formalisant les orientations énoncées ci-dessus et portant, notamment, sur le rétablissement de standards physiques masculins uniformes en matière de préparation militaire : c’est sur ce modèle qu’eux, officiers généraux, seront évalués.

Ensuite, il annonce à son auditoire que ce changement de culture implique un changement de génération parmi eux, et donc de nouveaux départs, allant jusqu’à inviter ceux qui se sentent en désaccord avec ses propos à démissionner. Dans un contexte de réduction du nombre de postes offerts à la promotion, voilà qui invite à l’introspection.

Ce discours organise le réalignement culturel des forces armées américaines sur les orientations du gouvernement, à l’image de ce qu’indiquait le règlement des armées françaises de 1933 : « Il importe que les ordres soient exécutés littéralement, sans hésitation, ni murmure. »

Objectif désigné : les villes démocrates

Pourquoi ce réalignement ? C’est l’intervention subséquente de Donald Trump qui y répond : bien que particulièrement décousue, elle est l’occasion d’annoncer fort à propos une augmentation des salaires des militaires de 3,8 %, mais surtout de désigner aux officiers généraux leur adversaire, à savoir l’« invasion intérieure » (« Invasion from within »).

De manière spécieuse, le président liste même les cibles qu’il qualifie de « zones de guerre ». Il s’agit des villes tenues par « la gauche radicale démocrate » et nommément désignées : San Francisco, Chicago, New York, Los Angeles, Portland et Seattle. Il prend appui sur les précédents historiques d’utilisation des forces armées pour le maintien de l’ordre intérieur par les présidents George Washington, Abraham Lincoln, Grover Cleveland ou George W. Bush. Il rappelle enfin aux officiers généraux présents, comme l’avait d’ailleurs fait Pete Hegseth à deux reprises, leur serment de prise de fonctions qui prévoit la lutte contre l’ennemi intérieur :

« Je jure [ou affirme] solennellement que je soutiendrai et défendrai la Constitution des États-Unis contre tous les ennemis, étrangers et intérieurs. »

Une insistance à replacer dans le cadre culturel américain, où une importance majeure est accordée aux serments depuis la guerre d’Indépendance et la guerre de Sécession.

Comme on le comprend aisément, la plupart des commentaires ratent l’essentiel. L’administration Trump prépare les forces armées américaines, d’une part, à une intervention massive dans les grandes villes administrées par les démocrates au prétexte de lutter contre les ennemis intérieurs et, d’autre part, à disposer d’une institution militaire à la fois obéissante et partageant les valeurs du gouvernement, en vue des prochaines échéances politiques du pays, notamment électorales… toutes choses qui avaient manqué lors du coup d’État avorté du 6 janvier 2021.

Olivier Sueur ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

11.10.2025 à 08:26

Sommes-nous plus bêtes que nos parents ?

Corentin Gonthier, Professeur de psychologie, Nantes Université

Texte intégral (2689 mots)

Vous avez peut-être entendu parler du déclin de l’intelligence ? C’est cette idée selon laquelle le quotient intellectuel moyen a tendance à diminuer dans le monde occidental. De quoi s’alarmer sur l’état du monde, les politiques publiques, l’éducation et l’avenir de la jeunesse ! Ce déclin existe-t-il vraiment ?

Le déclin de l’intelligence est à la mode depuis quelques années. Le documentaire « Demain, tous crétins ? » diffusé par Arte en 2017 a diffusé cette polémique en France. La presse s'en est rapidement emparée à travers des titres alarmistes, comme « Le QI des Français en chute libre », « Et si l'humanité était en train de basculer dans l'imbécillité ? », ou même « Alerte ! Le QI des Asiatiques explose, le nôtre baisse ».

On s’est inquiété, et comme dans toute panique morale, des coupables ont été désignés. Selon leurs orientations politiques, les commentateurs ont blâmé les pesticides et perturbateurs endocriniens, la désaffection pour la lecture, la réforme de l’orthographe, la construction européenne, ou bien sûr, l’exposition aux écrans.

Une intelligence globale en hausse

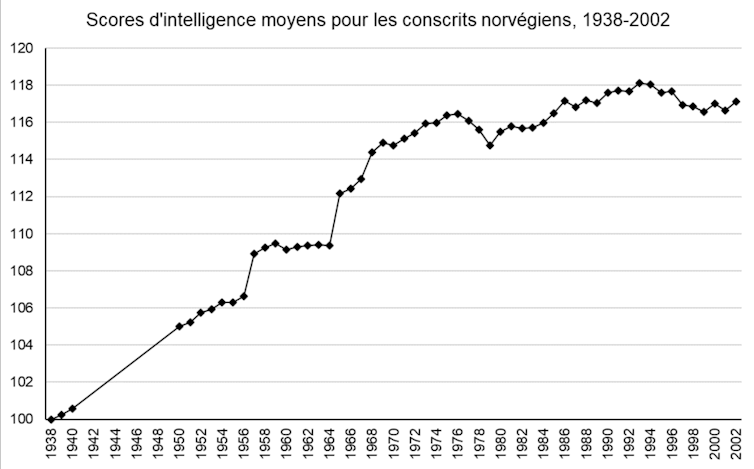

Avant de chercher pourquoi l’intelligence déclinerait, encore faut-il être sûrs qu’elle décline. Cette idée d’une diminution de l’intelligence est pour le moins surprenante, car l’intelligence moyenne a plutôt augmenté au cours du XXe siècle. Plusieurs centaines d’études impliquant des millions de participants dans plus de 70 pays montrent qu’en moyenne, chaque génération fait mieux que la précédente sur les tests d’intelligence. Si on préfère parler en termes de quotient intellectuel (QI : le score global à travers un ensemble d’épreuves d’intelligence – sa moyenne est fixée à 100, la plupart des gens se situent entre 85 et 115), le quotient intellectuel moyen a augmenté d’environ 3 points tous les dix ans depuis le début du XXe siècle.

Cette augmentation de l’intelligence moyenne à chaque génération s’appelle l’effet Flynn. On connaît l’effet Flynn depuis les années 1930, et on l’attribue aux grandes améliorations du XXe siècle , telles que la baisse de la malnutrition et des maladies infantiles, ou le développement de la scolarisation. Aujourd’hui, il est ralenti dans les pays développés, mais continue à pleine vitesse dans les pays en voie de développement (les scores d’intelligence y augmentent deux fois plus vite, environ, que dans le monde occidental).

Que notre effet Flynn ralentisse ou s’interrompe, rien d’étonnant : la scolarisation et les qualités de notre système sanitaire ne progressent plus à grande vitesse. Mais un déclin de l’intelligence ? De petites baisses sont bien retrouvées par une poignée d’études, mais elles sont sans commune mesure avec les gains du XXe siècle. L’exemple de la Norvège (Figure 1) est frappant : ces données de grande qualité (jusqu’au début du XXIe siècle, la Norvège a évalué l’intelligence de l’ensemble de sa population masculine dans le cadre du service militaire obligatoire) montrent bien une petite diminution dans les années 2000, mais elle tient plus de la fluctuation aléatoire.

Une étude pour le moins critiquable

D’où vient, alors, l’idée que l’intelligence s’effondrerait en France ? La littérature ne contient qu’une unique étude d'Edward Dutton et Richard Lynn portant sur un échantillon de 79 personnes. C’est un très petit échantillon pour déclencher une panique morale, bien sûr : 79 personnes ne sont pas vraiment représentatives de la France dans son ensemble. Quand on crée un test d’intelligence, on l’étalonne plutôt sur un échantillon d’au moins 1000 personnes pour avoir une bonne estimation de la moyenne (c’est le cas de l’échelle d’intelligence pour adultes de Wechsler, la WAIS, la plus utilisée en France).

Mais le problème de cette étude est surtout dans sa méthode et dans ses résultats. Notre petit groupe de 79 personnes a passé deux tests d’intelligence en 2009 : un ancien test d’intelligence (la WAIS-III, étalonnée en 1999), et un test plus récent (la WAIS-IV, étalonnée en 2009). En comparant les résultats de ce groupe de 79 personnes à la moyenne de l’échantillon de référence pour chacun de ces tests, Dutton et Lynn constatent que les résultats de ce groupe sont légèrement plus faibles que la moyenne sur l’ancien test d’intelligence, et légèrement plus élevés que la moyenne sur le nouveau test ; ils en déduisent qu’il était plus difficile d’obtenir un bon score sur le test de 1999… donc que l’intelligence moyenne a diminué entre 1999 et 2009.

Sur le principe, le constat de Dutton et Lynn est correct : nous avons tendance à faire moins bien sur les anciens tests d’intelligence (nous avons répliqué ce résultat à un peu plus grande échelle). Mais le problème est qu’il y a d’autres raisons qu’un déclin de l’intelligence pour expliquer que les gens fassent moins bien en 2009 sur un test paru en 1999.

Pour bien comprendre, il faut s’intéresser au contenu du test. Un test d’intelligence de type WAIS est composé d’un ensemble d’épreuves qui mesurent des choses différentes : le raisonnement logique abstrait (ce qu’on entend généralement par « intelligence » : compléter une série de figures géométriques, reproduire un dessin abstrait à l’aide de cubes…), mais aussi les connaissances (vocabulaire, culture générale…), la mémoire, ou encore la vitesse de traitement de l’information. Dans l’étude de Dutton et Lynn, les scores sont en fait rigoureusement stables dans le temps pour le raisonnement logique abstrait, la mémoire ou la vitesse de traitement, qui ne déclinent donc pas : les seuls scores qui sont plus faibles en 2009 qu’en 1999, ce sont les scores de connaissances. On retrouve exactement la même chose dans d’autres pays, comme la Norvège : le raisonnement logique abstrait est constant dans le temps tandis que les scores de connaissance deviennent plus faibles sur les anciens tests.

Les tests doivent régulièrement être mis à jour

L’intelligence générale ne décline donc pas, ni en France ni dans le monde occidental. Dans ce cas peut-on au moins se plaindre que les connaissances ont décliné : la culture se perd, les jeunes n’apprennent plus rien ? Même pas : si les gens font moins bien sur les anciennes versions des tests d’intelligence, c’est tout simplement parce que les questions deviennent obsolètes avec le temps. La WAIS-III demandait aux Français de calculer des prix en francs, de comparer les caractéristiques des douaniers et des instituteurs, de citer des auteurs célèbres du XXe siècle. Avec le temps, ces questions sont devenues plus difficiles. Les scores au test ont baissé, mais pas l’intelligence elle-même. Nous avons montré que cette obsolescence suffit à expliquer intégralement les résultats de Dutton et Lynn.

Voici un petit exemple, tiré du tout premier test d’intelligence : il s’agit d’un texte à compléter, destiné à évaluer la présence d’une déficience chez de jeunes enfants. Pouvez-vous faire aussi bien qu’un enfant de 1905 en retrouvant les neuf mots manquants ?

Il fait beau, le ciel est —1—. Le soleil a vite séché le linge que les blanchisseuses ont étendu sur la corde. La toile, d’un blanc de neige, brille à fatiguer les —2—. Les ouvrières ramassent les grands draps ; ils sont raides comme s’ils avaient été —3—. Elles les secouent en les tenant par les quatre —5— ; elles en frappent l’air qui claque avec —6—. Pendant ce temps, la maîtresse de ménage repasse le linge fin. Elle a des fers qu’elle prend et repose l’un après l’autre sur le —7—. La petite Marie, qui soigne sa poupée, aurait bien envie, elle aussi, de faire du —8—. Mais elle n’a pas reçu la permission de toucher aux —9—.

Les mots « amidonnés » (3), « poêle » (7), et « fers » (9) vous ont probablement posé plus de problèmes qu’à un enfant de 1905 ; mais vous conviendrez sûrement que cette difficulté ne dit pas grand-chose de votre intelligence. Les scores d’intelligence sur ce test ont bien décliné, mais c’est plutôt l’évolution technologique du repassage qui rend le test obsolète. De la même façon, la probabilité qu’une personne dotée d’une intelligence moyenne (QI=100) réponde correctement à une question de la WAIS portant sur la pièce de théâtre Faust était de 27 % en 1999, elle est de 4 % en 2019. Ainsi, les scores aux tests de connaissance déclinent naturellement dans le temps, au fur et à mesure que la culture évolue. C’est même pour cette raison que de nouvelles versions des tests d’intelligence paraissent régulièrement : la WAIS est remise à jour tous les dix ans environ (et la WAIS-V devrait paraître en 2026).

Une « erreur » qui sert un agenda politique

Confondre un déclin de l’intelligence avec l’obsolescence des questions du test, c’est tout de même une grosse erreur. Comment Dutton et Lynn ont-ils pu la commettre ? C’est que l’erreur n’est pas innocente, et que ces deux auteurs ne sont pas tout à fait neutres. La discipline d’Edward Dutton est la théologie, Richard Lynn est connu pour défendre l’idée qu’il existe des différences génétiques d’intelligence entre les sexes et les origines ethniques ; les deux ont été éditeurs en chef d’une célèbre revue suprémaciste blanche (Mankind Quarterly) et leurs travaux alimentent directement les mouvements d’extrême droite.

Pour bien saisir l’agenda politique des auteurs, le mieux est peut-être de citer les explications qu’ils envisagent pour un déclin de l’intelligence. Deux extraits, issus des livres de Richard Lynn pour l’illustrer :

« … un grand nombre de gouvernements occidentaux ont contribué au déclin de l’intelligence depuis les années 1960, à travers une politique d’état-providence encourageant les femmes d’intelligence basse, de mauvaise moralité et de faible éducation à avoir des bébés… ».

« … l’immigration de masse de peuples non-européens en Europe de l’ouest, aux États-Unis et au Canada est un sérieux problème dysgénique… ils ont, en moyenne, une plus faible intelligence et une plus faible moralité… ils deviendront une majorité de la population en Europe de l’ouest… l’intelligence continuera à décliner… et la Chine deviendra une superpuissance mondiale »

Les réformes envisagées par les auteurs pour limiter le déclin de l’intelligence en Europe occidentale sont cohérentes avec leur orientation politique : on y trouve, par exemple, « abolir la sécurité sociale », « se retirer de la convention des Nations unies de 1951 sur l’accueil des réfugiés », ou encore « introduire des politiques publiques pour accroître la fertilité de ces femmes (intelligentes) qui ont été éduquées au point de perdre leur fonction reproductive ».

Aujourd’hui, nous avons la certitude qu’il n’y a pas réellement de déclin de l’intelligence en France, même si l’effet Flynn est bel et bien interrompu. Le déclin de l’intelligence dans le monde occidental n’est pas un sujet scientifique, mais plutôt un sujet politique – un argument idéal que les déclinistes utilisent pour faire peur, désigner des coupables, et promouvoir des réformes hostiles au changement.

Si cette idée a autant de succès, c’est probablement qu’elle parle à nos tendances profondes : au second siècle de notre ère, Hésiode se plaignait déjà que les nouvelles générations laissent plus de place à l’oisiveté que les précédentes. Si nous bénéficions d’un droit inaliénable à critiquer les valeurs et les goûts musicaux de nos enfants, une chose est sûre : ils ne sont pas moins intelligents que nous.

Cet article est publié dans le cadre de la Fête de la science (qui a lieu du 3 au 13 octobre 2025), dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « Intelligence(s) ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Corentin Gonthier ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.10.2025 à 23:42

Pourquoi la « business pride » du Medef n’aura pas lieu

Michel Offerlé, Sociologie du politique, École normale supérieure (ENS) – PSL

Texte intégral (2518 mots)

Les patrons sont sous pression alors que les appels à taxer les hauts patrimoines se multiplient, notamment avec une taxe Zucman sur les plus riches d’entre eux. Un meeting « énorme », censé défendre les intérêts patronaux, devait se tenir ce lundi 13 octobre : il a finalement été reporté par le Medef. Alors que la crise politique perdure, les patrons, généralement adeptes du lobbying discret, semblent remontés, mais divisés et hésitants sur la marche à suivre.

En 2009, Charlie Hebdo faisait sa une avec une caricature de Cabu montrant Laurence Parisot tenant une pancarte proclamant « Nos stock-options », devant un fond : « Sarkozy, t’es foutu le Medef est dans la rue ! » Le Figaro du 5 octobre 1999 éditait une photographie en première page représentant une foule assemblée, avec au premier rang un homme d’une cinquantaine d’années coiffé d’un haut chapeau vert sur le lequel était inscrit, « Respect ».

Ces images de patrons dans la rue sont rares. Ce 13 octobre 2025, les patrons, ou plutôt certains patrons, devaient se réunir au Palais omnisport de Paris-Bercy (Accor Arena) pour une initiative peu banale, annonçant un « meeting énorme ». Patrick Martin, président du Medef, a finalement décidé de reporter ce rendez-vous en raison, selon lui, de la démission du premier ministre Sébastien Lecornu. Pourquoi cette mobilisation et pourquoi cette reculade ?

Lobbying et discrétion patronale

Les patrons ne sont pas professionnellement la catégorie sociale qui se mobilise le plus fréquemment dans la rue ou dans des meetings. Ils utilisent peu l’action collective visible, dans ce que les sociologues appellent « les répertoires de l’action collective ». Ils ont accès (pour les plus grands d’entre eux surtout) à des moyens d’action plus feutrés et plus furtifs (ce qu’on appelle la « quiet politics ») dans toutes ses variétés et dimensions, qui leur permettent d’interpeller les décideurs de manière discrète, voire très privée. C’est ce que l’on désigne habituellement par lobbying.

L’Association française des entreprises privées (Afep) est le parangon de ces tentatives d’influence, mais ses démarches publiques vont pourtant rarement au-delà des communiqués ou des conférences de presse.

Les patrons sont (rarement) dans la rue

Des chefs d’entreprise ont pu participer individuellement à des manifestations de rue (pour l’école privée en 1984 ou contre le mariage pour tous en 2013, mais pas en tant que patrons. On pourra aussi en avoir vu parmi les Bonnets rouges ou les gilets jaunes.

L’appel à la rue est l’apanage des seuls petits patrons qui l’ont utilisé pour des raisons dissemblables, dans les années 1950 lors des mobilisations poujadistes, autour de Gérard Nicoud à la fin des années 1960 ou dans les années 1990 avec la figure controversée de Christian Poucet. La mobilisation par réseaux sociaux des « pigeons » en 2012, suivie, de celles moins relayées de divers volatiles la même année, a fait exception aussi en utilisant des moyens innovants. Il y aura encore des manifestations patronales depuis 2000, celles des buralistes ou localement celles du bâtiment, ou autour du collectif Sauvons nos entreprises en 2014.

Malgré son opposition à la politique du début du quinquennat Hollande, le Medef n’ira pas au-delà de réunions publiques à Lyon, dans le Rhône, (avec cartons jaunes et sifflets) et à Paris (avec des petits drapeaux « Libérez l’entreprise »), et la CGPME d’une opération organisée devant Bercy avec une agence d’événementiel sur le thème du cadenas (« PME cadenASSEZ »).

La lente sortie des restrictions liées au Covid a vu fleurir les actions de rue à Lyon ou encore à Paris en 2020 ou le très original die in de Toulouse, en Haute-Garonne (France Bleu titrait « À Toulouse, place du Capitole, un millier de petits commerçants crient leur peur de mourir », en novembre 2020) initiative prise avec les métiers du spectacle, sur la thématique de la mort des entreprises (les manifestants transportant des cercueils et s’habillant en noir).

Mobilisations exceptionnelles contre la gauche en 1982 et en 1999

Les deux grands meetings de 1982 et de 1999 sont donc exceptionnels. Le 14 décembre 1982, le Conseil national du patronat français (CNPF, ancêtre du Medef) et les autres organisations patronales organisent, contre la politique économique et sociale de la gauche, les « États généraux des entreprises au service de la nation ». Ainsi, 25 000 patrons viennent à Villepinte et « adoptent » la Charte de Villepinte, cahiers de revendications et de propositions. L’opération est aussi interne, le président du CNPF, Yvon Gattaz, est alors contesté par certaines fédérations, et renforce alors sa légitimité :

« Tout le monde est venu, comme le grand Condé est venu auprès de Louis XIV après sa dissidence sous la Fronde », déclarait-t-il avec emphase, en 2007 (entretien avec l’auteur).

Le 4 octobre 1999, c’est contre les 35 heures (« Tout le monde ne chausse pas du 35 ») qu’Ernest-Antoine Seillière, président du tout nouveau Mouvement des entreprises de France (Medef, créé de manière militante l’année précédente à Strasbourg), contribue à rassembler quelque 30 000 personnes selon les organisateurs :

« J’ai monté en province des réunions, des congrès, des shows, des rassemblements absolument sans cesse », affirmait le patron des patrons, tout en soulignant le plaisir qu’il prenait à la tribune (entretien avec l’auteur, 2009).

Dans les deux cas, ce sont une succession de discours militants plus ou moins décapants et de témoignages « d’entrepreneurs de terrain » qui constituent la réussite de ces événements classiques, avec écrans géants et quelques pancartes plus ou moins contrôlées.

Le meeting « énorme » 13 octobre 2025

Le meeting du 13 octobre 2025, annoncé comme « énorme », aurait pu se nourrir de ces précédents, ainsi que des prestations très travaillées de Laurence Parisot (remarquée en 2007 à Bercy ou en 2008 au Parlement européen), et aurait été nécessairement jaugé en fonction des performances passées.

Ses organisateurs avaient tenté d’en formuler la réception :

« Une forme républicaine, pacifique, qui rassemblera le patronat au-delà du Medef. On ne descendra pas dans la rue. On réunira massivement, comme ce fut le cas par le passé, sous forme de meeting, des milliers de chefs d’entreprise de tout profil (…) Pour bien signifier que nous refusons d’être la variable d’ajustement de politiques qui nous paraissent contraires à la bonne marche de l’économie et à l’intérêt du pays », expliquait ainsi Patrick Martin, l’actuel président du Medef.

Il s’agissait pour ce dernier de mettre en scène les récentes propositions issues du « Front économique » dont le dirigeant a pris l’initiative. Mais aussi de proposer ce que l’on pourrait qualifier de « business pride » (marche patronale des fiertés). On ne saurait en effet oublier que cette volonté de mobilisation exprime une cristallisation d’un vieux mal-être patronal français.

En effet, depuis de très nombreuses années, les porte-paroles du patronat et certains grands patrons développent un discours de victimisation, d’incompréhension face à ce qu’ils estiment être la surdité et l’incompétence de l’ensemble des politiques. Il s’agissait donc – non seulement d’interpeller le gouvernement et l’ensemble des partis politiques –, mais aussi d’affirmer la fierté d’être entrepreneur.

(Re)faire entendre la voix des patrons

Les précédentes grandes mobilisations avaient eu lieu sous des gouvernements de gauche. Celle de 2025 a éclos dans une autre conjoncture politique, peu lisible et incertaine. Elle fait écho aux prises de parole répétée des organisations patronales et de patrons médiatiques, dans l’espace public depuis la dissolution (MM. Arnault, Trappier, Pouyanné, Niel, ou encore Leclerc et Pigasse).

Avec la victoire de Donald Trump, les analyses relatives à la « trumpisation des patrons français » se sont multipliées, soulignant l’acceptation latente ou la cooptation de Jordan Bardella, président du Rassemblement national, comme moindre mal face à la menace de La France insoumise (LFI) ou du Nouveau Front populaire (NPF), ou encore face à la taxe Zucman (dont l’auteur a été vilipendé par Patrick Martin et Bernard Arnault) imposant les ultrariches.

Il y a sans doute plusieurs colères patronales, puisque leurs intérêts et leurs quotidiens sont incomparables et plusieurs anticipations de l’avenir (la catégorie patronale est la plus hétérogène de toutes les professions et catégories socioprofessionnelles). Tous les patrons ne peuvent pas se faire entendre de la même manière.

L'ombre du RN sur le meeting

Les déclarations de Michel Picon (président de l’U2P), fréquemment sollicité par les médias, sonnent comme une rupture de l’unité patronale (la « finance » contre « le travail »). La crainte d’une salle peu garnie et atone a sans doute pesé sur cette décision de report, mais la possibilité d’un cavalier seul des petites et moyennes entreprises dans les relations sociales à venir apparaît comme l’une des « peurs » du Medef, dont la représentativité tient plus au bon plaisir de l’État qu’à un rapport des forces militantes.

Il est vraisemblable que certains grands patrons ont rappelé à l’ordre leur « commis » et que certaines fédérations ont donné de la voix au sein du Medef.

L’explication officielle de Patrick Martin, expliquant le report du meeting par sa volonté de contribuer à « l’apaisement du pays » après la démission de Sébastien Lecornu n’est donc pas la seule explication à ce retournement.

L’ombre du RN planait aussi sur le meeting de Bercy. Les petits et tout petits patrons peuvent s’y retrouver, et les grands anticipent de possibles accommodements comparables à ceux de Giorgia Meloni et du patronat italien, quand d’autres radicalisent leur discours par l’acquisition de médias (Vincent Bolloré ou Pierre-Édouard Stérin, voire le raidissement de Bernard Arnault, également propriétaire de journaux).

Reporter le meeting de Bercy, c’est aussi se donner le temps de voir venir. Car les patrons sont suspendus à une conjoncture politique où ils vont devoir choisir : considérer l’arrivée possible au pouvoir du RN comme un danger, ou cultiver la politique du moindre mal.

Michel Offerlé est l’auteur de Ce qu’un patron peut faire, (Gallimard, 2021), et de Patron (Anamosa, 2024).

Michel Offerlé ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Lava

- La revue des médias

- Le Grand Continent

- Le Diplo

- Le Nouvel Obs

- Lundi Matin

- Mouais

- Multitudes

- Politis

- Regards

- Smolny

- Socialter

- The Conversation

- UPMagazine

- Usbek & Rica

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- Contretemps

- A Contretemps

- Alter-éditions

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- Philo Mag

- Terrestres

- Vie des Idées

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview

- Fiabilité 3/5

- Slate

- Ulyces

- Fiabilité 1/5

- Contre-Attaque

- Issues

- Korii

- Positivr

- Regain