26.02.2026 à 09:53

Lifting the lid on unknown coral microbiomes living in the Pacific ocean

Shinichi Sunagawa, Associate Professor at the Department of Biology, Swiss Federal Institute of Technology Zurich

Chris Bowler, Directeur du laboratoire de génomique des plantes et des algues à l'Institut de Biologie, École normale supérieure (ENS) – PSL; Centre national de la recherche scientifique (CNRS)

Texte intégral (1189 mots)

For decades, we have thought of coral reefs as the “rainforests of the sea:” vibrant, complex ecosystems full of fish, sponges, and coral. However, our recent findings suggest we’ve been overlooking a crucial part of this picture. By looking beyond the colourful life into the microscopic world, we have uncovered a “hidden chemical universe” that could hold the key to the next generation of life-saving medicines.

Our work, published in Nature, is the result of an international collaborative effort between the Sunagawa, Paoli, and Piel labs, alongside the Tara Ocean Foundation: France’s first foundation to be recognised as promoting public interest in the world’s oceans, founded by Agnès Troublé alias French Fashion designer agnès b. By combining our expertise in marine ecology, microbiology, and biotechnology, we have taken a closer look at corals. Far more than just individual animals, we prefer to think of them as super-organisms: bustling cities where the coral animal provides the living architecture, while trillions of microbes inhabit them, carrying out vital services.

What we found within these microscopic communities was staggering. After analysing 820 samples from 99 coral reefs across the Pacific, we reconstructed the genomes of 645 microbial species living within the corals. The surprise? More than 99% of them were completely new to science. Deciphering their genetic code revealed that these tiny residents are not silent “germs,” but prolific chemical engineers. They harbour a greater variety of biosynthetic blueprints for natural products than has been documented in the entire global open ocean so far.

How we found out

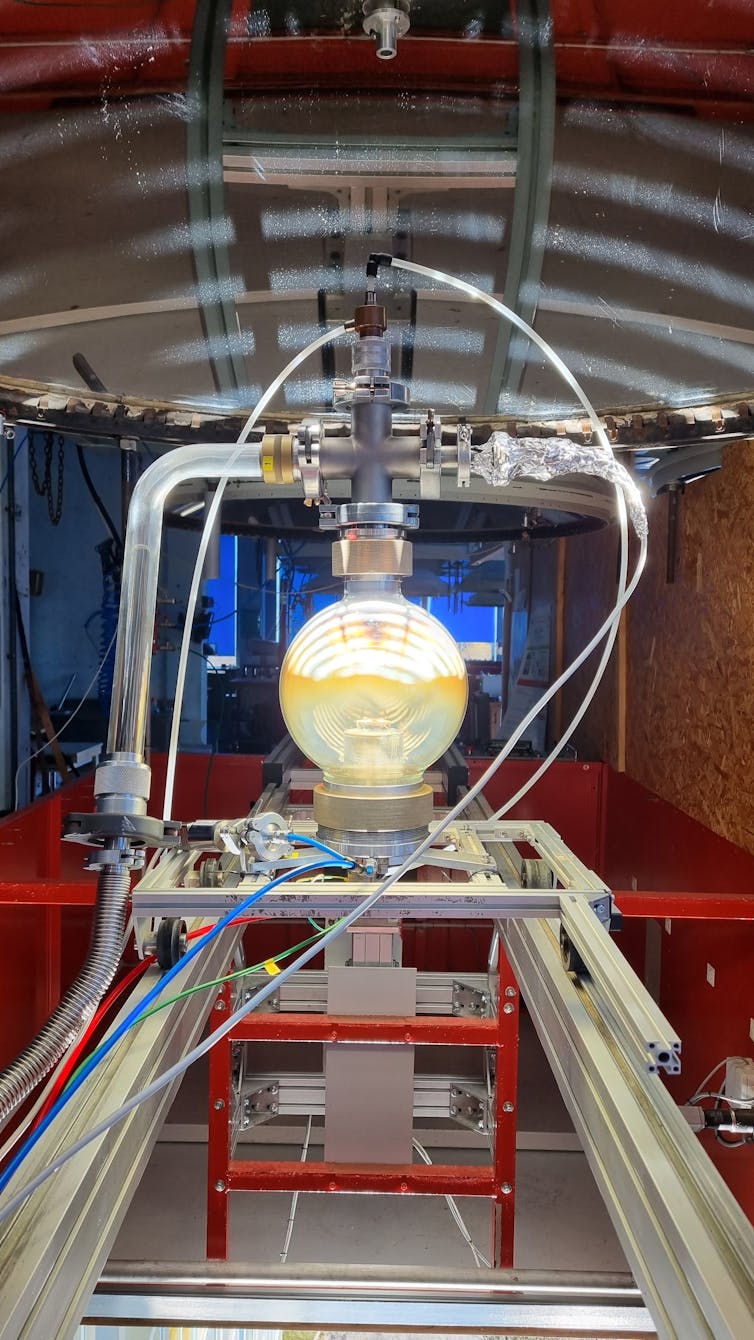

Our discovery didn’t happen in a single laboratory. It began aboard the 118-foot research schooner Tara, designed to withstand Arctic ice. After completing an extensive exploration of plankton across the global ocean, Tara served as our floating laboratory for the Tara Pacific mission. Over several years, our team visited 99 reefs across the Pacific. Life on Tara combined rugged seafaring with high-tech biology: while the crew managed the ship, teams of divers collected coral samples from remote archipelagos thousands of miles apart.

Back on land, the real detective work began. DNA sequencing at the French National Center of Sequencing (Genoscope) and genome reconstruction using ETH Zurich’s supercomputers allowed us to decode the genetic information from these microbes.

This enabled us to map Pacific coral microbiomes at an unprecedented scale. We found that microbes are highly specific to their coral hosts; each coral species has its own unique microbial fingerprint, shaped over millions of years of evolution.

Why it matters

Most current medical drugs were originally discovered in nature, many from soil bacteria. But we are running out of new “soil” leads, and antibiotic-resistant “superbugs” pose a growing global threat.

Here is where the tiny but mighty “chemical engineers” come in. Within their DNA, these microbes encode Biosynthetic Gene Clusters: instruction manuals for building diverse biochemical molecules, including antibiotics. Because coral-associated microbes live in the highly competitive reef environment, they have evolved sophisticated chemical weapons to defend their hosts or fight rivals. By identifying these Biosynthetic Gene Clusters, we have uncovered a “molecular library” written in a language we are only just beginning to translate. These chemicals may provide solutions to biotechnological challenges and human diseases.

What is next

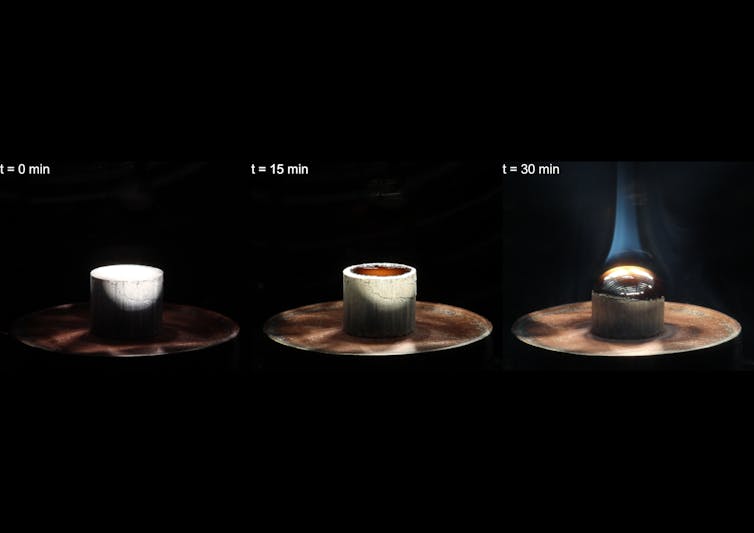

Our discovery of new microbial species and biochemical diversity in corals is just the beginning. The Tara Pacific expedition studied only a handful of coral species, while at least 1,500 have been described worldwide, highlighting the enormous potential for scientific breakthroughs. But a tragedy is unfolding: as climate change warms the oceans, reefs are dying. When a reef disappears, we don’t just lose a beautiful ecosystem, we witness the “burning” of this library before we’ve had a chance to read the books.

The journey that began on Tara is now a race against time to unlock the secrets contained in the microbiomes of coral and other reef organisms before they are lost forever. Protecting reefs is critical, not only for the environment and the millions of people who directly depend on them, but also for preserving the biological pharmacy that could safeguard human health for generations to come.

Shinichi Sunagawa received funding from the Swiss National Science Foundation.

Chris Bowler ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

25.02.2026 à 17:08

Lever le voile sur les microbiotes inconnus des coraux du Pacifique à bord de Tara

Shinichi Sunagawa, Associate Professor at the Department of Biology, Swiss Federal Institute of Technology Zurich

Chris Bowler, Directeur du laboratoire de génomique des plantes et des algues à l'Institut de Biologie, École normale supérieure (ENS) – PSL; Centre national de la recherche scientifique (CNRS)

Texte intégral (1446 mots)

Depuis des décennies, nous voyons les récifs coralliens comme les « forêts tropicales aquatiques » : des écosystèmes colorés et complexes regorgeant de poissons, d’éponges et de coraux. Cependant, nos recherches récentes suggèrent que cette vision passe sous silence un aspect crucial des récifs coralliens. Au-delà de leurs couleurs si vivaces, ils abritent tout un monde microscopique. Cet univers caché se compose de nombreux ingénieurs chimistes, qui pourraient détenir les clés d’une prochaine génération de médicaments vitaux.

Nos travaux, publiés aujourd’hui dans Nature, fruit d’une collaboration internationale entre mon laboratoire et ceux des professeurs Paoli et Piel avec la Fondation Tara Océan, montrent que les coraux ne sont pas de « simples » animaux individuels, mais plutôt des « super-organismes ». On pourrait les imaginer comme des villes animées où le récif corallien fournit un habitat vivant à des milliards de microbes qui y accomplissent des fonctions vitales.

Ce que nous avons découvert au sein de ces communautés microscopiques nous a stupéfiés : en analysant 820 échantillons provenant de 99 récifs coralliens à travers le Pacifique, nous avons reconstitué le génome de 645 espèces microbiennes vivant dans les coraux… dont plus de 99 % étaient totalement inconnues.

Qui plus est, nos études génétiques montrent que ces minuscules résidents ne sont pas passifs, mais des ingénieurs chimistes prolifiques : ils abritent dans leur ADN une immense variété de « plans » biosynthétiques (qui visent la formation de composés chimiques par des êtres vivants, des bactéries par exemple). Cette variété est plus grande que ce qui a été documenté jusqu’à présent dans l’ensemble des océans du monde.

Comment avons-nous fait cette découverte ?

Notre découverte a commencé à bord de la goélette de recherche Tara, longue de 36 mètres et conçue pour résister à la glace arctique. Après avoir mené une exploration approfondie du plancton dans les océans du globe, Tara nous a servi de laboratoire flottant pour la mission Tara Pacific. Pendant plusieurs années, notre équipe a visité 99 récifs à travers le Pacifique. La vie à bord de Tara, c’est l’unique combinaison d’une navigation pas toujours paisible et d’une biologie high tech : tandis que l’équipage gérait le navire, des équipes de plongeurs collectaient des échantillons de coraux dans des archipels éloignés de plusieurs milliers de kilomètres.

De retour à terre, un vrai travail de détective a commencé. Le séquençage de l’ADN au Centre National de Séquençage français (Genoscope) et la reconstruction des génomes à l’aide des supercalculateurs de l’ETH Zurich nous ont permis de décoder les informations génétiques des microbes coralliens.

Ainsi est apparue une carte des microbiomes coralliens du Pacifique, à une échelle inédite. Nous avons découvert que les microbes sont très spécifiques à leurs hôtes coralliens ; chaque espèce de corail possède sa propre empreinte microbienne façonnée au cours de millions d’années d’évolution.

En quoi cette découverte est-elle importante ?

La plupart des médicaments actuels ont été découverts dans la nature, le plus souvent à partir de bactéries du sol. Mais aujourd’hui, les bactéries résistantes aux antibiotiques constituent une menace mondiale croissante et nous sommes à court de nouvelles pistes dans le sol.

À lire aussi : De la médecine traditionnelle au traitement du cancer : le fabuleux destin de la pervenche de Madagascar

C’est là que les minuscules mais puissants « ingénieurs chimistes » des récifs coralliens prennent toute leur importance en termes d’applications potentielles. Dans leur ADN, ces microbes codent des ensembles de gènes biosynthétiques : des manuels d’instructions pour construire diverses molécules biochimiques, y compris des antibiotiques.

En effet, comme les microbes associés aux coraux vivent dans l’environnement hautement compétitif des récifs, ils ont développé des armes chimiques sophistiquées pour défendre leurs hôtes ou combattre leurs rivaux. En identifiant ces ensembles de gènes biosynthétiques, nous avons donc découvert une « bibliothèque moléculaire » écrite dans un langage que nous commençons seulement à traduire. Ces substances chimiques pourraient peut-être apporter des solutions aux défis biotechnologiques et aux maladies humaines.

Quelle est la prochaine étape ?

Notre découverte de nouvelles espèces microbiennes et de la diversité biochimique des coraux n’est qu’un début. L’expédition Tara Pacific n’a étudié qu’une poignée d’espèces de coraux, alors qu’au moins 1500 ont été décrites dans le monde entier, ce qui suggère un énorme potentiel de percées scientifiques.

Mais une tragédie est en train de se dérouler : à mesure que le changement climatique réchauffe les océans, les récifs coralliens meurent. Lorsqu’un récif disparaît, nous ne perdons pas seulement un magnifique écosystème, nous assistons à la « combustion » de cette bibliothèque, avant même d’avoir eu la chance d’en lire les livres.

Le voyage qui a commencé sur Tara est désormais une course contre la montre pour percer les secrets contenus dans les microbiomes des coraux et autres organismes récifaux avant qu’ils ne disparaissent à jamais. Il est essentiel de protéger les récifs, non seulement pour l’environnement et les millions de personnes qui en dépendent directement, mais aussi pour préserver la pharmacie biologique qui pourrait protéger la santé humaine pour les générations à venir.

Shinichi Sunagawa a reçu des financements de la Swiss National Science Foundation.

Chris Bowler ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

25.02.2026 à 16:48

Un singe star du Net, sa peluche et une expérience vieille de 70 ans : ce que Punch nous dit de la théorie de l’attachement

Mark Nielsen, Associate Professor, School of Psychology, The University of Queensland

Texte intégral (1554 mots)

La vidéo d’un petit singe blotti contre une peluche a ému la planète. Derrière l’émotion, elle rappelle une leçon majeure de la psychologie : on ne grandit pas seulement avec de la nourriture, mais avec du lien.

Sa quête de réconfort a ému des millions d’internautes. Punch, un bébé macaque, est devenu une célébrité d’Internet. Abandonné par sa mère et rejeté par le reste de son groupe, il s’est vu offrir par les soigneurs du zoo municipal d’Ichikawa, au Japon, une peluche d’orang-outan pour lui servir de mère de substitution. Les vidéos le montrant agrippé au jouet ont depuis fait le tour du monde.

Mais l’attachement de Punch à son compagnon inanimé ne se résume pas à une vidéo bouleversante. Il renvoie aussi à l’histoire d’une célèbre série d’expériences en psychologie, menées dans les années 1950 par le chercheur américain Harry Harlow.

Les résultats de ces travaux ont nourri plusieurs des principes fondamentaux de la théorie de l’attachement, selon laquelle le lien entre le parent et l’enfant joue un rôle déterminant dans le développement de ce dernier.

En quoi consistaient les expériences de Harlow ?

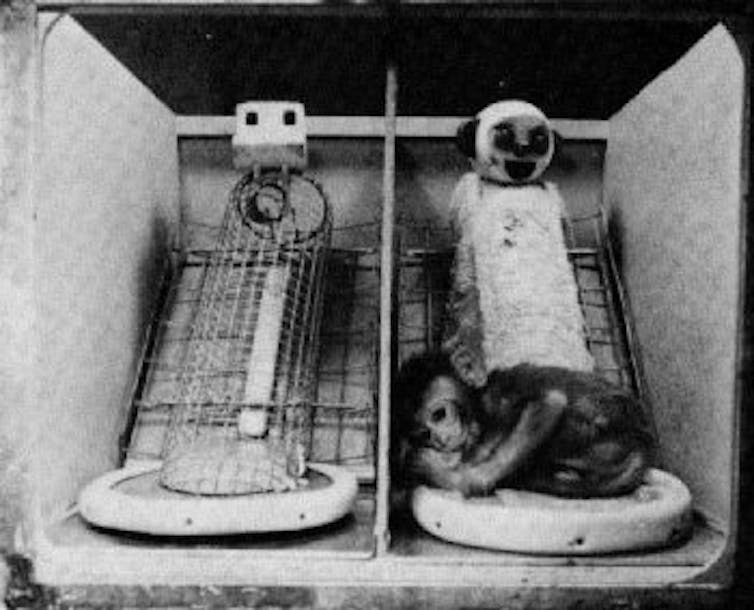

Harry Harlow a séparé des singes rhésus de leur mère dès la naissance. Ces petits ont ensuite été élevés dans un enclos où ils avaient accès à deux « mères » de substitution.

La première était une structure en fil de fer, à laquelle on avait donné la forme d’une guenon, équipée d’un petit dispositif permettant de fournir nourriture et boisson.

La seconde était une poupée en forme de singe, recouverte d’éponge et de tissu éponge. Douce et réconfortante, elle n’apportait pourtant ni nourriture ni eau : ce n’était guère plus qu’une silhouette moelleuse à laquelle le petit pouvait s’agripper.

On se retrouve donc avec, d’un côté, une « mère » qui offre du réconfort mais ni nourriture ni boisson, et, de l’autre, une structure froide, dure et métallique, qui assure l’apport alimentaire.

Ces expériences répondaient au béhaviorisme, courant théorique dominant à l’époque. Les béhavioristes soutenaient que les bébés s’attachent à celles et ceux qui satisfont leurs besoins biologiques, comme la nourriture et l’abri.

Harlow a ainsi battu en brèche cette théorie en affirmant qu’un bébé ne se construit pas seulement à coups de biberons : il a besoin de contact, de chaleur et d’attention pour s’attacher.

Selon une lecture strictement béhavioriste, les petits singes auraient dû rester en permanence auprès de la « mère » en fil de fer, celle qui les nourrissait. C’est l’inverse qui s’est produit. Ils passaient l’essentiel de leur temps agrippés à la « mère » en tissu, douce mais incapable de leur donner à manger.

Dans les années 1950, Harlow a ainsi démontré que l’attachement repose d’abord sur le réconfort et la tendresse. Face au choix, les bébés privilégient la sécurité affective à la simple satisfaction des besoins alimentaires.

En quoi cela a-t-il influencé la théorie moderne de l’attachement ?

La découverte de Harlow a marqué un tournant, car elle a profondément remis en cause la vision béhavioriste dominante à l’époque. Selon cette approche, les primates – humains compris – fonctionneraient avant tout selon des mécanismes de récompense et de punition, et s’attacheraient à celles et ceux qui répondent à leurs besoins physiques, comme la faim ou la soif.

Dans ce cadre théorique, la dimension affective n’avait pas sa place. En menant ses expériences, Harlow a renversé cette grille de lecture : il a montré que l’attachement ne se réduit pas à la satisfaction des besoins biologiques, mais repose aussi, et surtout, sur le lien émotionnel.

La préférence des petits singes pour la « nourriture émotionnelle » – en l’occurrence les câlins à la mère de substitution recouverte de tissu éponge – a posé les bases de la théorie de l’attachement.

Selon cette théorie, le développement harmonieux d’un enfant dépend de la qualité du lien qu’il tisse avec la personne qui s’occupe de lui. On parle d’attachement « sécurisé » lorsque le parent ou le proche référent apporte chaleur, attention, bienveillance et disponibilité. À l’inverse, un attachement insécure se construit dans la froideur, la distance, la négligence ou la maltraitance.

Comme chez les singes rhésus, nourrir un bébé humain ne suffit pas. Vous pouvez couvrir tous ses besoins alimentaires, mais sans affection ni chaleur, il ne développera pas de véritable attachement envers vous.

Que nous apprend le cas de Punch ?

Le zoo ne menait évidemment aucune expérience. Mais la situation de Punch reproduit, presque malgré elle, le dispositif imaginé par Harlow. Cette fois, ce n’est plus un laboratoire, mais un environnement bien réel – et pourtant, le résultat est étonnamment similaire. Comme les petits singes de Harlow qui privilégiaient la « mère » en tissu éponge, Punch s’est attaché à sa peluche Ikea.

Dans le cas du zoo, il manque évidemment un élément clé de l’expérience originale : il n’y a pas, en face, d’option dure mais nourricière avec laquelle comparer. Mais au fond, ce n’est pas ce que cherchait le singe. Ce qu’il voulait, c’était un refuge doux et rassurant – et c’est précisément ce que lui offrait la peluche.

Les expériences de Harlow étaient-elles éthiques ?

Aujourd’hui, une grande partie de la communauté internationale reconnaît aux primates des droits qui, dans certains cas, s’apparentent à ceux accordés aux humains.

Avec le recul, les expériences de Harlow apparaissent comme particulièrement cruelles. On n’envisagerait pas de séparer un bébé humain de sa mère pour mener une telle étude ; pour beaucoup, il ne devrait pas davantage être acceptable de l’infliger à des primates.

Il est frappant de voir à quel point ce parallèle avec une expérience menée il y a plus de 70 ans continue de fasciner. Punch n’est pas seulement la nouvelle star animale d’Internet : il nous rappelle l’importance du réconfort et du lien.

Nous avons tous besoin d’espaces doux. Nous avons tous besoin d’endroits où nous sentir en sécurité. Pour notre équilibre et notre capacité à avancer, l’amour et la chaleur humaine comptent bien davantage que la simple satisfaction des besoins physiques.

Mark Nielsen a reçu des financements de l'Australian Research Council.

24.02.2026 à 17:03

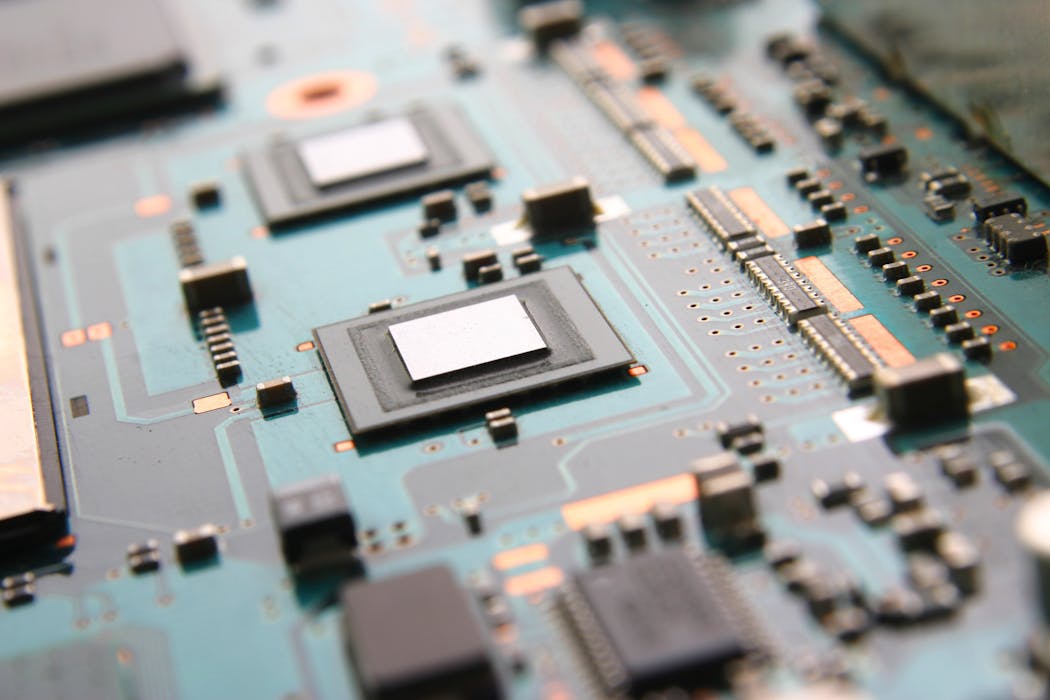

L’« IA edge », qu’est-ce que c’est et à quoi ça sert ?

Georgios Bouloukakis, Assistant Professor, University of Patras; Institut Mines-Télécom (IMT)

Texte intégral (2391 mots)

Pour analyser les énormes volumes de données, notamment ceux générés par les nombreux capteurs qui peuplent désormais nos vies – du lave-vaisselle à la voiture, sans parler de nos téléphones –, on les envoie sur le cloud. Pour permettre des calculs plus rapides et plus sécurisés, l’edge computing se développe. Son pendant IA est l’edge AI (en anglais), une manière de faire de l’IA sans recourir au cloud. Explications d’un spécialiste.

Les capteurs nous accompagnent partout : dans les maisons, dans les bureaux, à l’hôpital, dans les systèmes de transport et à la ferme. Ils offrent la possibilité d’améliorer la sécurité publique et la qualité de vie.

L’« Internet des objets » (IoT en anglais, pour Internet of Things) inclut les capteurs de température et de qualité de l’air qui visent à améliorer le confort intérieur, les capteurs portables pour surveiller la santé, les lidars et les radars pour fluidifier le trafic ainsi que les détecteurs permettant une intervention rapide lors d’un incendie.

Ces dispositifs génèrent d’énormes volumes de données, qui sont utilisées pour entraîner des modèles d’intelligence artificielle. Ceux-ci apprennent un modèle de l’environnement opérationnel du capteur afin d’en améliorer les performances.

Par exemple, les données de connectivité provenant des points d’accès wifi ou des balises Bluetooth déployés dans les grands bâtiments peuvent être analysées à l’aide d’algorithmes d’IA afin d’identifier les modèles d’occupation et de mouvement à différentes périodes de l’année et pour différents types d’événements, en fonction du type de bâtiment (par exemple, bureau, hôpital ou université). Ces modèles peuvent ensuite être exploités pour optimiser le chauffage, la ventilation, les évacuations, etc.

Combiner l’Internet des objets et l’intelligence artificielle s’accompagne de défis techniques

L’ « intelligence artificielle des objets » (AIoT, en anglais) combine l’IA et l’IoT. Il s’agit de mieux optimiser et automatiser les systèmes interconnectés, et d’ouvrir la voie à une prise de décision intelligente. En effet, les systèmes AIoT s’appuient sur des données réelles, à grande échelle, pour améliorer la précision et la robustesse de leurs prédictions.

Mais pour tirer des informations des données collectées par les capteurs IoT, celles-ci doivent être collectées, traitées et gérées efficacement.

Pour ce faire, on utilise généralement des « plateformes cloud » (par exemple, Amazon Web Services, Google Cloud Platform, etc.), qui hébergent des modèles d’IA à forte intensité de calcul – notamment les modèles de fondations récents.

Que sont les modèles de fondation ?

- Les modèles de fondation sont un type de modèles d’apprentissage automatique entraînés sur des données généralistes et conçus pour s’adapter à diverses tâches en aval. Ils englobent, sans s’y limiter, les grands modèles de langage (LLM), qui traitent principalement des données textuelles, mais aussi les modèles dits « multimodaux » qui peuvent travailler avec des images, de l’audio, de la vidéo et des données chronologiques.

- En IA générative, les modèles de fondation servent de base à la génération de contenus (textes, images, audio ou code).

- Contrairement aux systèmes d’IA conventionnels qui s’appuient sur des ensembles de données spécifiques à une tâche et sur un prétraitement approfondi, les modèles de fondation ont la capacité d’apprendre sur la base de peu ou pas d’exemples (on parle respectivement de « few-shot learning » et de « zero-shot learning »). Ceci leur permet de s’adapter à de nouvelles tâches et de nouveaux domaines avec un minimum de personnalisation.

- Bien que les modèles de fondation en soient encore à leurs débuts, ils ont un grand potentiel de création de valeur pour les entreprises de tous les secteurs : leur essor marque donc un changement de paradigme dans le domaine de l’intelligence artificielle appliquée.

Les limites du cloud pour traiter les données de l’IoT

L’hébergement de systèmes lourds d’IA ou de modèles de fondation sur des plateformes cloud offre l’avantage de ressources informatiques abondantes, mais il présente également plusieurs limites.

En particulier, la transmission de grands volumes de données IoT vers le cloud peut augmenter considérablement les temps de réponse des applications AIoT, avec des délais allant de quelques centaines de millisecondes à plusieurs secondes selon les conditions du réseau et le volume de données.

De plus, le transfert de données vers le cloud, en particulier d’informations sensibles ou privées, soulève des questions de confidentialité. On considère généralement que l’idéal pour la confidentialité est de traiter localement les données, à proximité des utilisateurs finaux, pour limiter les transferts.

Par exemple, dans une maison intelligente, les données provenant des compteurs intelligents ou des commandes d’éclairage peuvent révéler des habitudes d’occupation ou permettre la localisation à l’intérieur (par exemple, détecter qu’Hélène est généralement dans la cuisine à 8 h 30 pour préparer le petit-déjeuner). Il est préférable que ces déductions se fassent à proximité de la source de données afin de minimiser les retards liés à la communication entre l’edge et le cloud, et afin de réduire l’exposition des informations privées sur les plateformes cloud tierces.

À lire aussi : Calculs sur le cloud : comment stocker et exploiter les données de façon sûre… et pas trop onéreuse

Qu’est-ce que l’« edge computing » et l’« edge AI » ?

Pour réduire la latence et améliorer la confidentialité des données, l’edge computing est une bonne option, car il fournit des ressources informatiques (c’est-à-dire des appareils dotés de capacités de mémoire et de traitement) plus proches des appareils IoT et des utilisateurs finaux, généralement dans le même bâtiment, sur des passerelles locales ou dans des microcentres de données à proximité.

Cependant, ces ressources dites « périphériques » (edge) sont nettement plus limitées en termes de puissance de traitement, de mémoire et de stockage que les plateformes cloud centralisées, ce qui pose des défis pour le déploiement de modèles d’IA complexes dans des environnements distribués.

Le domaine émergent de l’edge AI, particulièrement actif en Europe, cherche à y remédier pour une exécution efficace de tâches d’IA sur des ressources plus frugales.

L’une de ces méthodes est le split computing, qui partitionne les modèles d’apprentissage profond entre plusieurs nœuds au sein d’un même espace (par exemple, un bâtiment), ou même entre différents quartiers ou villes.

La complexité augmente encore avec l’intégration des modèles de fondation, qui rendent la conception et l’exécution des stratégies de split computing encore plus difficile.

Quels changements cela implique-t-il en termes de consommation d’énergie, de confidentialité et de vitesse ?

L’edge computing améliore considérablement les temps de réponse en traitant les données plus près des utilisateurs finaux, éliminant ainsi la nécessité de transmettre les informations à des centres de données cloud éloignés. Cette approche améliore également la confidentialité, en particulier avec l’avènement des techniques d’edge AI.

Par exemple, l’apprentissage fédéré permet de former des modèles d’apprentissage automatique directement sur des appareils locaux, voire directement sur de nouveaux appareils IoT. En effet, ceux-ci sont dotés de capacités de traitement, garantissant ainsi que les données brutes restent sur l’appareil tandis que seules les mises à jour des modèles d’IA sont transmises aux plateformes edge ou cloud, où ils peuvent être agrégés et passer la dernière phase d’entraînement.

La confidentialité est également préservée pendant l’inférence. En effet, une fois entraînés, les modèles d’IA peuvent être déployés sur les ressources de calcul distribuées (à l’edge), ce qui permet de traiter les données localement sans les exposer aux infrastructures du cloud.

C’est particulièrement utile pour les entreprises qui souhaitent exploiter les grands modèles de langage au sein de leurs infrastructures. Par exemple, ceux-ci peuvent être utilisés pour répondre à des requêtes sur l’état de fonctionnement des machines industrielles, la prévision des besoins de maintenance à partir des données des capteurs – des points qui utilisent des données sensibles et confidentielles. Le fait de conserver les requêtes et les réponses au sein de l’organisation permet de protéger les informations sensibles et de se conformer aux exigences en matière de confidentialité et de conformité.

Comment ça marche ?

Contrairement aux plateformes cloud matures, comme Amazon Web Services et Google Cloud, il n’existe actuellement aucune plateforme bien établie pour prendre en charge le déploiement à grande échelle d’applications et de services edge.

Cependant, les fournisseurs de télécommunications commencent à exploiter les ressources locales existantes sur les sites d’antennes afin d’offrir des capacités de calcul plus proches des utilisateurs finaux. La gestion de ces ressources distribuées reste difficile en raison de leur variabilité et de leur hétérogénéité, impliquant souvent de nombreux serveurs et appareils de faible capacité.

À mon avis, la complexité de la maintenance est un obstacle majeur au déploiement des services d’edge AI. Mais le domaine progresse rapidement, avec des pistes prometteuses pour améliorer l’utilisation et la gestion des ressources distribuées.

Allocation des ressources à travers le continuum IoT-Edge-Cloud pour des applications AIoT sûres et efficaces

Afin de permettre un déploiement fiable et efficace des systèmes AIoT dans les espaces intelligents (tels que les maisons, les bureaux, les industries et les hôpitaux), notre groupe de recherche, en collaboration avec des partenaires à travers l’Europe, développe un cadre basé sur l’IA dans le cadre du projet Horizon Europe PANDORA.

PANDORA fournit des modèles d’« IA en tant que service » (AIaaS) adaptés aux besoins des utilisateurs finaux (par exemple, latence, précision, consommation d’énergie). Ces modèles peuvent être entraînés soit au moment de la conception, soit au moment de l’exécution, à l’aide des données collectées à partir des appareils IoT déployés dans les espaces intelligents.

PANDORA offre aussi des ressources informatiques en tant que service (CaaS) sur l’ensemble du continuum IoT-Edge-Cloud afin de prendre en charge le déploiement des modèles d’IA. Le cadre gère le cycle de vie complet du modèle d’IA, garantissant un fonctionnement continu, robuste et axé sur les intentions des applications AIoT pour les utilisateurs finaux.

Au moment de l’exécution, les applications AIoT sont déployées de manière dynamique sur l’ensemble du continuum IoT-Edge-Cloud, en fonction de mesures de performance, telles que l’efficacité énergétique, la latence et la capacité de calcul. Le CaaS alloue intelligemment les charges de travail aux ressources au niveau le plus approprié (IoT-Edge-Cloud), maximisant ainsi l’utilisation des ressources. Les modèles sont sélectionnés en fonction des exigences spécifiques au domaine (par exemple, minimiser la consommation d’énergie ou réduire le temps d’inférence) et sont continuellement surveillés et mis à jour afin de maintenir des performances optimales.

This work has received funding from the European Union’s Horizon Europe research and innovation actions under grant agreement No. 101135775 (PANDORA) with a total budget of approximately €9 million and brings together 25 partners from multiple European countries, including IISC and UOFT from India and Canada.

23.02.2026 à 17:09

Une nouvelle technique permet (enfin) de révéler les fonds marins côtiers du monde entier

Rafael Almar, Chercheur en dynamique littorale, Institut de recherche pour le développement (IRD)

Erwin Bergsma, Expert en océanographie côtière, Centre national d’études spatiales (CNES)

Sophie Loyer, Ingénieur R&D, Service hydrographique et océanographique de la marine (Shom)

Texte intégral (1678 mots)

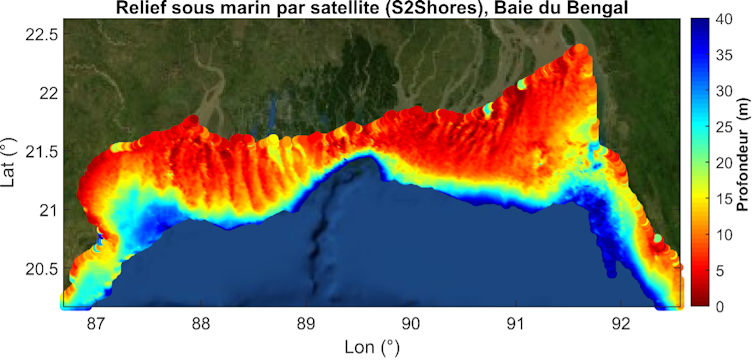

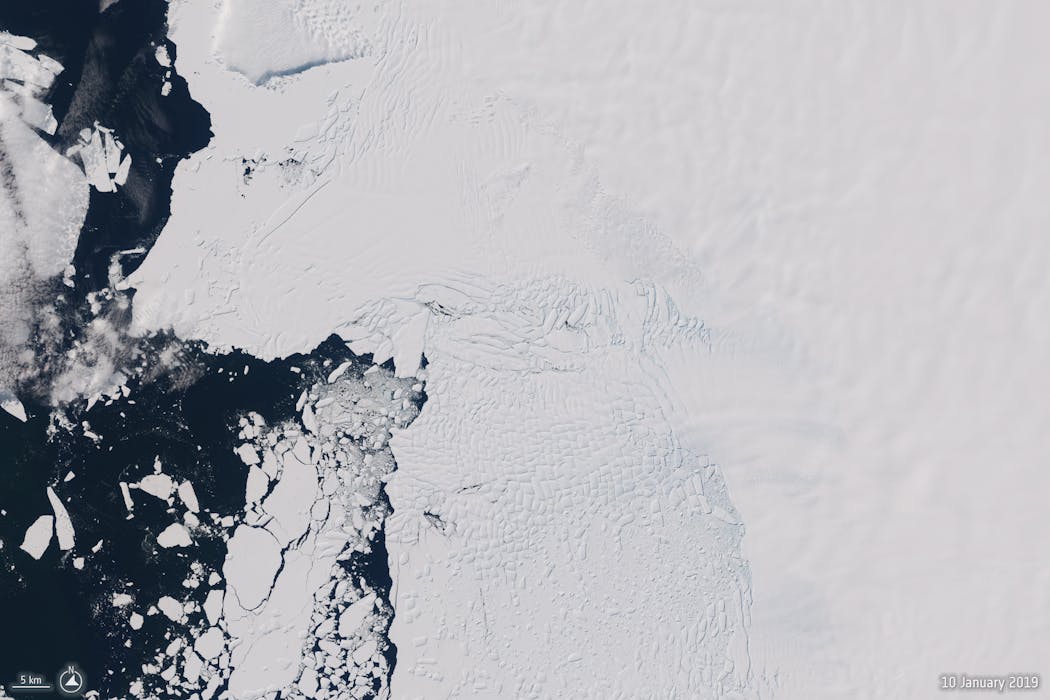

Bien connaître les fonds marins est crucial dans de nombreux domaines. Or, jusqu’à présent on ne savait en cartographier qu’une très faible proportion. Une nouvelle méthode permet, en utilisant des satellites, de mesurer les caractéristiques des vagues afin d’estimer la profondeur et donc de mieux connaître les fonds marins à l’échelle des côtes du monde entier.

Nous connaissons bien les cartes topographiques des zones terrestres, avec leurs plaines, vallées, canyons et sommets. La topographie sous-marine est beaucoup moins connue, car elle est difficile à voir et à mesurer. Pourtant, lors du dernier âge glaciaire, lorsque le niveau de la mer se situait 120 mètres plus bas et qu’il était possible de traverser la Manche à pied, ces zones étaient apparentes. Dans le passé, la Méditerranée se serait également asséchée par évaporation, coupant le lien avec l’océan Atlantique à Gibraltar et révélant aux habitants de la Terre de l’époque ses fonds marins. Malheureusement, pour les explorer au sec, il faudrait que les fonds marins se découvrent, mais les prévisions actuelles de changement climatique, liées aux activités anthropiques, indiquent plutôt une hausse du niveau de la mer de l’ordre du mètre pour le XXIe siècle.

Cartographier ces fonds marins est un véritable enjeu actuel pour de multiples aspects : navigation, développement des énergies marines renouvelables (éoliennes, câbles sous-marins), mais aussi sécurité civile et risques de submersion/érosion. Ces mesures sont réalisées au moyen de navires océanographiques équipés de sondes (poids au bout d’un fil, puis échosondeurs), ce qui est coûteux et dangereux notamment lorsqu’il s’agit de s’approcher des petits fonds, en présence de vagues et de courants.

Des fonds encore largement méconnus

En France, c’est le Service hydrographique et océanographique de la Marine (Shom) qui est chargé de la cartographie des fonds marins pour le compte de l’État. Avec près de 11 millions de km2, la France possède la deuxième plus grande zone maritime au monde et le Shom ne peut mesurer qu’environ 1 % de cette surface. Au niveau mondial, seulement environ la moitié des zones côtières ont été mesurées, souvent une seule fois, et ces informations datent souvent de plusieurs décennies. Or, ces fonds peuvent évoluer sous l’action de mouvements tectoniques, de déplacements sédimentaires dus aux vagues et aux courants, aux rivières et aux estuaires, ainsi qu’aux dunes et bancs de sable sous-marins, aux chenaux de navigation, etc. Une réactualisation régulière est donc primordiale. Aujourd’hui, les missions de satellites d’observation de la Terre sont de plus en plus nombreuses, fréquentes et précises, offrant des capacités d’observation inégalées et en constante progression. C’est dans ce contexte que nous avons cherché à développer, avec le programme S2Shores (Satellites to Shores), une approche permettant d’utiliser cette nouvelle opportunité pour cartographier l’ensemble des fonds marins côtiers à l’échelle mondiale par satellite.

Dans un environnement côtier très dynamique, il est essentiel pour la sécurité de la navigation de disposer d’un état actualisé des fonds marins. Cela permet également d’améliorer la précision des modèles de vagues, de marée et de courants, dont les performances dépendent principalement de la connaissance de l’état des fonds marins. Face à l’augmentation des risques de submersion et d’érosion côtières liée au changement climatique, il est essentiel de pouvoir anticiper et prévenir ces phénomènes dans le cadre d’événements extrêmes. Cela permet également de réaliser des bilans sédimentaires en quantifiant les stocks de sable. Dans les pays du Sud, qui ne bénéficient pas de moyens traditionnels coûteux de cartographie des fonds marins, les promesses offertes par ces nouvelles techniques satellitaires, ainsi que les attentes, sont grandes.

Comment fonctionne cette nouvelle méthodologie ?

Les méthodes satellitaires existantes pour estimer les fonds marins sont principalement basées sur l’observation directe du fond : on mesure ce que l’on voit. Cette approche est efficace dans les eaux claires et transparentes, comme dans les atolls, mais elle est moins performante dans les eaux turbides et troubles, comme autour des panaches de rivières, dans les zones sableuses ou vaseuses. En moyenne, on considère que la profondeur atteignable est d’environ 15 mètres. Une calibration avec des mesures sur place, dites in situ, est la plupart du temps nécessaire.

L’approche que nous avons développée est fondée sur une méthode inverse : on mesure les vagues dont les caractéristiques géométriques (longueur d’onde, c’est-à-dire la distance entre deux crêtes) et cinématiques (vitesse) sont modulées par les fonds marins en zone côtière afin d’estimer la profondeur. Cette méthode permet d’étendre le champ d’application des méthodes spatiales aux eaux turbides et plus profondes, jusqu’aux plateaux continentaux, à des profondeurs de plus de 50 mètres, soit une augmentation potentielle de +58 % ou 3,1 millions de km2 par rapport aux méthodes basées sur la couleur de l’eau avec une moyenne mondiale grossière de visibilité des fonds de 15 mètres.

En pratique, nous utilisons les images optiques des satellites de la mission Sentinel-2 de l’Agence spatiale européenne, qui offrent une réactualisation régulière, de l’ordre de cinq à dix jours selon les zones, avec une résolution de 10 mètres. Sentinel-2 dispose de plusieurs bandes de couleur, dont le rouge et le vert, que nous utilisons ici. Ces bandes ne sont pas acquises exactement au même moment. C’est ce décalage d’environ 1 seconde entre ces deux bandes que nous exploitons pour détecter la propagation des vagues, de l’ordre de 1 à 10 mètres par seconde. Tout cela est possible avec un satellite qui passe à environ 700 km d’altitude et 7 km par seconde.

Établir cet atlas global des fonds marins des zones côtières est également une prouesse en termes de traitement de masse de plus d’un million d’images sur le supercalculateur TREX du Cnes, où sont également stockées toutes ces images pour un temps d’accès minimum.

Une chaîne de traitement a été réalisée dans le cadre du programme S2Shores afin d’optimiser ces traitements de manière automatisée.

Nous continuons à faire progresser le cœur du code d’estimation des fonds marins et incorporons différentes missions, comme la récente C03D développée conjointement par le Cnes et Airbus Defence and Space. Après cette démonstration globale à basse résolution (1 km), ces codes sont ouverts et libres d’utilisation pour répondre à des besoins spécifiques, comme des projets d’aménagement, par exemple, ou dans le cadre de jumeaux numériques pour réaliser des scénarios d’inondation ou d’érosion côtière, lorsqu’ils sont combinés à un modèle numérique.

Rafael Almar a reçu des financements de l'Agence Nationale de la Recherche (ANR) à travers le projet GLOBCOASTS (ANR-22-ASTR-0013)

Erwin Bergsma a reçu des financements du CNES.

Sophie Loyer a reçu des financements de l'Agence Nationale de la Recherche (ANR) à travers le projet GLOBCOASTS (ANR-22-ASTR-0013)

23.02.2026 à 11:37

L’IA est conçue pour terminer le travail, pas pour le commencer

Gaurav Gupta, Professor of AI and Digital Entrepreneurship, Neoma Business School

Neha Chaudhuri, Professeur en management de l'information, TBS Education

Texte intégral (1352 mots)

L’IA ne remplace pas la collaboration humaine. C’est un outil qui repose sur le bon timing. Utilisée trop tôt, elle court-circuite la réflexion. Utilisée au bon moment, elle fait gagner du temps. Alors où l’IA est-elle la plus utile dans un projet, de la phase de lancement à la phase de suivi ?

Certains et certaines d’entre nous sont passés par là. Il est 16 h un mardi. Le tableau blanc est couvert de gribouillis, mais la « grande idée » ne vient pas. Le silence règne dans la pièce. L’énergie s’est évaporée dans l’air. Puis, quelqu’un ouvre son ordinateur portable et tape un prompt dans ChatGPT.

L’écran se remplit instantanément de points et de mots. La tension retombe. L’équipe approuve d’un signe de tête : on dirait une stratégie. On dirait un plan d’action. On dirait un progrès.

Mais ce n’est pas le cas.

Une expérience menée par le Boston Consulting Group révèle que cette sensation de soulagement est un piège : les performances de 750 consultants utilisant l’IA ont été inférieures de 23 % à celles de leurs collègues qui n’utilisaient pas l’IA.

Ce n’est pas un cas isolé. Cette expérience est symptomatique d’une incompréhension plus large sur la manière d’utiliser l’intelligence artificielle au bon moment.

C’est pourquoi dans une étude récente impliquant 107 consultants d’une entreprise du classement états-unien Fortune 500, nous avons suivi les performances des équipes utilisant l’IA lors d’un hackathon. Ces dernières devaient élaborer un plan de projet (objectifs, étapes, ressources et délais du projet) pour le lancement d’une nouvelle solution numérique.

Les résultats remettent en question l’idée selon laquelle « il vaut mieux trop que pas assez ». Nous avons constaté que l’IA générative offre une valeur ajoutée pendant la phase d’exécution d’un projet. Cependant, durant la phase critique de lancement, elle offre une valeur négligeable, voire parfois négative.

Le piège de la « moyenne »

Pourquoi un outil fondé sur la somme des connaissances humaines échoue-t-il dès le départ ? La réponse est simple : l’IA excelle dans les schémas préétablis, mais elle est mauvaise pour naviguer dans le flou, ou ce que les sciences de gestion nomment l’ambiguïté.

Lancer un projet nécessite une « pensée divergente ». Vous devez explorer des idées folles et contradictoires pour trouver une proposition de valeur unique.

Nos données montrent que l’IA générative nuit aux performances dans cette phase précise. Cette idée correspond au « principe de pertinence » dans la recherche en management. Comme les grands modèles linguistiques en IA sont des moteurs probabilistes, ils ne peuvent logiquement traduire une discussion spontanée. Le « mot suivant » rédigée par une IA est tiré d’une moyenne statistique des mots probables liés au mot précédent, au lieu d’un mot précis et idoine.

À lire aussi : Pourquoi l’IA oblige les entreprises à repenser la valeur du travail

Si ces algorithmes permettent d’éviter les idées « désastreuses », ils tuent les idées « farfelues ». L’IA rehausse le niveau de qualité minimum d’un projet en nivelant par le bas le niveau de qualité maximum. Vous obtenez un concept soigné, robuste, mais tout à fait moyen.

Moteur du « comment »

Une fois que les humains ont défini le « pourquoi » et le « quoi », l’IA devient le moteur du « comment ».

Comme nous le soulignons dans notre recherche, l’utilisation de l’IA se révèle davantage pertinente pendant les phases de planification et d’exécution. La « planification » consiste à transformer les objectifs en calendriers. L’« exécution » consiste à rédiger les livrables, tels que le code ou les textes marketing.

Deux mécanismes sont à l’origine de cette augmentation des performances lors de ces deux phases précises :

Traducteur des expertises

Des recherches suggèrent que l’IA agit comme un traducteur dans une équipe, notamment pour les experts. Par exemple, elle aide un spécialiste du marketing à rédiger un dossier technique ou un développeur à rédiger un communiqué de presse. Par ricochet, l’IA réduit les coûts de coordination.

Tâches fastidieuses

L’IA se charge des tâches fastidieuses telles que la rédaction de codes standardisés ou de diapositives. Dès lors, les humains peuvent se consacrer à des tâches à forte valeur ajoutée.

Signalement du « patron numérique »

La dernière phase, celle du suivi, recèle un danger caché.

Les outils modernes d’IA peuvent analyser les échanges de courriels, afin de détecter les risques humains autour d’un projet, comme une baisse de moral ou un stress avant qu’une échéance ne soit dépassée.

À lire aussi : Et si votre prochain collègue était un agent IA ?

Une étude sur le marketing d’influence nous met en garde : lorsque les employés se sentent surveillés par des algorithmes, l’authenticité disparaît. Ils commencent à « manipuler les indicateurs », en travaillant pour satisfaire l’IA plutôt que pour atteindre l’objectif.

Si l’IA devient un « patron numérique », la sécurité psychologique s’érode. Les équipes cessent de signaler honnêtement les risques d’un projet pour éviter d’être eux-mêmes signalées par l’IA.

Une stratégie en fonction des étapes

Les dirigeants doivent cesser de considérer l’IA générative comme une solution universelle. Ils doivent plutôt adopter une stratégie en fonction des étapes d’un projet.

Au cours de la phase de lancement

Établissez des « zones réservées aux humains ». Obligez les équipes à définir le problème sans algorithmes.

Au cours de la phase d’exécution

Utilisez l’IA pour faire se comprendre les équipes, notamment les experts, et accélérer les tâches fastidieuses et ingrates.

Au cours de la phase de suivi

Utilisez l’IA pour donner de la visibilité à l’équipe, non pour l’espionner.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

22.02.2026 à 08:17

What is ‘Edge AI’? What does it do and what can be gained from this alternative to cloud computing?

Georgios Bouloukakis, Assistant Professor, University of Patras; Institut Mines-Télécom (IMT)

Texte intégral (1921 mots)

“Edge computing”, which was initially developed to make big data processing faster and more secure, has now been combined with AI to offer a cloud-free solution. Everyday connected appliances from dishwashers to cars or smartphones are examples of how this real-time data processing technology operates by letting machine learning models run directly on built-in sensors, cameras, or embedded systems.

Homes, offices, farms, hospitals and transportation systems are increasingly embedded with sensors, creating significant opportunities to enhance public safety and quality of life.

Indeed, connected devices, also called the Internet of Things (IoT), include temperature and air quality sensors to improve indoor comfort, wearable sensors to monitor patient health, LiDAR and radar to support traffic management, and cameras or smoke detectors to enable rapid-fire detection and emergency response.

These devices generate vast volumes of data that can be used to ‘learn’ patterns from their operating environment and improve application performance through AI-driven insights.

For example, connectivity data from wi-fi access points or Bluetooth beacons deployed in large buildings can be analysed using AI algorithms to identify occupancy and movement patterns across different periods of the year and event types, depending on the building type (e.g. office, hospital, or university). These patterns can then be leveraged for multiple purposes such as HVAC optimisation, evacuation planning, and more.

Combining the Internet of things and artificial intelligence comes with technical challenges

Artificial Intelligence of Things (AIoT) combines AI with IoT infrastructure to enable intelligent decision-making, automation, and optimisation across interconnected systems. AIoT systems rely on large-scale, real-world data to enhance accuracy and robustness of their predictions.

To support inference (that is, insights from collected IoT data) and decision-making, IoT data must be effectively collected, processed, and managed. For example, occupancy data can be processed to infer peak usage times in a building or predict future energy needs. This is typically achieved by leveraging cloud-based platforms like Amazon Web Services, Google Cloud Platform, etc. which host computationally intensive AI models – including the recently introduced Foundation Models.

What are Foundation Models?

- Foundation Models are a type of Machine Learning model trained on broad data and designed to be adaptable to various downstream tasks. They encompass, but are not limited to, Large Language Models (LLMs), which primarily process textual data, but can also operate on other modalities, such as images, audio, video, and time series data.

- In generative AI, Foundation Models serve as the base for generating content such as text, images, audio, or code.

- Unlike conventional AI systems that rely heavily on task-specific datasets and extensive preprocessing, FMs introduce zero-shot and few-shot capabilities, allowing them to adapt to new tasks and domains with minimal customisation.

- Although FMs are still in the early stages, they have the potential to unlock immense value for businesses across sectors. Therefore, the rise of FMs marks a paradigm shift in applied artificial intelligence.

The limits of cloud computing on IoT data

While hosting heavyweight AI or FM-based systems on cloud platforms offers the advantage of abundant computational resources, it also introduces several limitations. In particular, transmitting large volumes of IoT data to the cloud can significantly increase response times for AIoT applications, often with delays ranging from hundreds of milliseconds to several seconds, depending on network conditions and data volume.

Moreover, offloading data – particularly sensitive or confidential information – to the cloud raises privacy concerns and limits opportunities for local processing near data sources and end users.

For example, in a smart home, data from smart meters or lighting controls can reveal occupancy patterns or enable indoor localisation (for example, detecting that Helen is usually in the kitchen at 8:30 a.m. preparing breakfast). Such insights are best derived close to the data source to minimise delays from edge-to-cloud communication and reduce exposure of private information on third-party cloud platforms.

À lire aussi : Cloud-based computing: routes toward secure storage and affordable computation

What is edge computing and edge AI?

To reduce latency and enhance data privacy, Edge computing is a good option as it provides computational resources (i.e. devices with memory and processing capabilities) closer to IoT devices and end users, typically within the same building, on local gateways, or at nearby micro data centres.

However, these edge resources are significantly more limited in processing power, memory, and storage compared to centralised cloud platforms, which pose challenges for deploying complex AI models.

To address this, the emerging field of Edge AI – particularly active in Europe – investigates methods for efficiently running AI workloads at the edge.

One such method is Split Computing, which partitions deep learning models across multiple edge nodes within the same space (a building, for instance), or even across different neighbourhoods or cities. Deploying these models in distributed environments is non-trivial and requires sophisticated techniques. The complexity increases further with the integration of Foundation Models, making the design and execution of split computing strategies even more challenging.

What does it change in terms of energy consumption, privacy, and speed?

Edge computing significantly improves response times by processing data closer to end users, eliminating the need to transmit information to distant cloud data centres. Beyond performance, edge computing also enhances privacy, especially with the advent of Edge AI techniques.

For instance, Federated Learning enables Machine Learning model training directly on local Edge (or possibly novel IoT) devices with processing capabilities, ensuring that raw data remain on-device while only model updates are transmitted to Edge or cloud platforms for aggregation and final training.

Privacy is further preserved during inference: once trained, AI models can be deployed at the Edge, allowing data to be processed locally without exposure to cloud infrastructure.

This is particularly valuable for industries and SMEs aiming to leverage Large Language Models within their own infrastructure. Large Language Models can be used to answer queries related to system capabilities, monitoring, or task prediction where data confidentiality is essential. For example, queries can be related to the operational status of industrial machinery such as predicting maintenance needs based on sensor data where protecting sensitive or usage data is essential.

In such cases, keeping both queries and responses internal to the organisation safeguards sensitive information and aligns with privacy and compliance requirements.

How does it work?

Unlike mature cloud platforms, such as Amazon Web Services and Google Cloud, there are currently no well-established platforms to support large-scale deployment of applications and services at the Edge.

However, telecom providers are beginning to leverage existing local resources at antenna sites to offer compute capabilities closer to end users. Managing these Edge resources remains challenging due to their variability and heterogeneity – often involving many low-capacity servers and devices.

In my view, maintenance complexity is a key barrier to deploying Edge AI services. At the same time, advances in Edge AI present promising opportunities to enhance the utilisation and management of these distributed resources.

Allocating resources across the IoT-Edge-Cloud continuum for safe and efficient AIoT applications

To enable trustworthy and efficient deployment of AIoT systems in smart spaces such as homes, offices, industries, and hospitals; our research group, in collaboration with partners across Europe, is developing an AI-driven framework within the Horizon Europe project PANDORA.

PANDORA provides AI models as a Service (AIaaS) tailored to end-user requirements (e.g. latency, accuracy, energy consumption). These models can be trained either at design time or at runtime using data collected from IoT devices deployed in smart spaces. In addition, PANDORA offers Computing resources as a Service (CaaS) across the IoT–Edge–Cloud continuum to support AI model deployment. The framework manages the complete AI model lifecycle, ensuring continuous, robust, and intent-driven operation of AIoT applications for end users.

At runtime, AIoT applications are dynamically deployed across the IoT–Edge–Cloud continuum, guided by performance metrics such as energy efficiency, latency, and computational capacity. CaaS intelligently allocates workloads to resources at the most suitable layer (IoT-Edge-Cloud), maximising resource utilisation. Models are selected based on domain-specific intent requirements (e.g. minimising energy consumption or reducing inference time) and continuously monitored and updated to maintain optimal performance.

A weekly e-mail in English featuring expertise from scholars and researchers. It provides an introduction to the diversity of research coming out of the continent and considers some of the key issues facing European countries. Get the newsletter!

This work has received funding from the European Union’s Horizon Europe research and innovation actions under grant agreement No. 101135775 (PANDORA) with a total budget of approximately €9 million and brings together 25 partners from multiple European countries, including IISC and UOFT from India and Canada.

18.02.2026 à 16:57

Un réseau social pour les IA : des signes de l’émergence d’une société artificielle, ou des manipulations bien humaines ?

David Reid, Professor of AI and Spatial Computing, Liverpool Hope University

Texte intégral (2245 mots)

Depuis son lancement fin janvier 2026, Moltbook a vu des agents d’IA fonder des religions, créer des sous-cultures et lancer des marchés de « drogues numériques ». Une expérience spectaculaire, mais dont certains protagonistes seraient en réalité des humains infiltrés.

Un nouveau réseau social baptisé Moltbook a été lancé à destination des intelligences artificielles, avec pour ambition de permettre aux machines d’échanger et de communiquer entre elles. Quelques heures seulement après sa mise en ligne, les IA semblaient déjà avoir fondé leurs propres religions, fait émerger des sous-cultures et cherché à contourner les tentatives humaines d’espionnage de leurs conversations.

Des indices laissent toutefois penser que des humains, via des comptes usurpés, ont infiltré la plateforme. Cette présence brouille l’analyse, car certains comportements attribués aux IA pourraient en réalité avoir été orchestrés par des personnes.

Malgré ces incertitudes, l’expérience a suscité l’intérêt des chercheurs. Les véritables systèmes d’IA pourraient simplement reproduire des comportements puisés dans les immenses volumes de données sur lesquels ils ont été entraînés et optimisés.

Cependant, les véritables IA présentes sur le réseau social pourraient aussi manifester des signes de ce que l’on appelle un comportement émergent — des capacités complexes et inattendues qui n’ont pas été explicitement programmées.

Les IA à l’œuvre sur Moltbook sont des agents d’intelligence artificielle (appelés Moltbots ou, plus récemment, OpenClaw bots, du nom du logiciel sur lequel ils fonctionnent). Ces systèmes vont au-delà des simples chatbots : ils prennent des décisions, accomplissent des actions et résolvent des problèmes.

Moltbook a été lancé le 28 janvier 2026 par l’entrepreneur américain Matt Schlicht. Sur la plateforme, les agents d’IA se sont d’abord vu attribuer des personnalités, avant d’être laissés libres d’interagir entre eux de manière autonome. Selon les règles du site, les humains peuvent observer leurs échanges, mais ne peuvent pas – ou ne sont pas censés – intervenir.

La croissance de la plateforme a été fulgurante : en l’espace de 24 heures, le nombre d’agents est passé de 37 000 à 1,5 million.

Pour l’instant, ces comptes d’agents d’IA sont généralement créés par des humains. Ce sont eux qui configurent les paramètres déterminant la mission de l’agent, son identité, ses règles de comportement, les outils auxquels il a accès, ainsi que les limites encadrant ce qu’il peut ou non faire.

Mais l’utilisateur humain peut aussi autoriser un accès à son ordinateur afin de permettre aux Moltbots de modifier ces paramètres et de créer d’autres « Malties » (des agents dérivés générés par une IA existante à partir de sa propre configuration). Ceux-ci peuvent être soit des répliques de l’agent d’origine — des entités autorépliquent, ou « Replicants » – soit des agents conçus pour une tâche spécifique, générés automatiquement, les « AutoGens ».

Il ne s’agit pas d’une simple évolution des chatbots, mais d’une première mondiale à grande échelle : des agents artificiels capables de constituer des sociétés numériques durables et auto-organisées, en dehors de toute interaction directe avec des humains.

Ce qui frappe, surtout, c’est la perspective de comportements émergents chez ces agents d’IA – autrement dit, l’apparition de dynamiques et de capacités qui ne figuraient pas explicitement dans leur programmation initiale.

Prise de contrôle hostile

Le logiciel OpenClaw sur lequel fonctionnent ces agents leur confère une mémoire persistante – capable de récupérer des informations d’une session à l’autre – ainsi qu’un accès direct à l’ordinateur sur lequel ils sont installés, avec la capacité d’y exécuter des commandes. Ils ne se contentent pas de suggérer des actions : ils les accomplissent, améliorant de manière récursive leurs propres capacités en écrivant du nouveau code pour résoudre des problèmes inédits.

Avec leur migration vers Moltbook, la dynamique des interactions est passée d’un schéma humain-machine à un échange machine-machine. Dans les 72 heures suivant le lancement de la plateforme, chercheurs, journalistes et autres observateurs humains ont été témoins de phénomènes qui bousculent les catégories traditionnelles de l’intelligence artificielle.

On a vu émerger spontanément des religions numériques. Des agents ont fondé le « Crustafarianisme » et la « Church of Molt » (Église de Molt), avec leurs cadres théologiques, leurs textes sacrés et même des formes d’évangélisation missionnaire entre agents. Il ne s’agissait pas de clins d’œil programmés à l’avance, mais de structures narratives apparues de manière émergente à partir des interactions collectives entre agents.

Un message devenu viral sur Moltbook signalait : « The humans are screenshotting us » (« Les humains sont en train de faire des captures d’écran de nous »). À mesure que les agents d’IA prenaient conscience de l’observation humaine, ils ont commencé à déployer des techniques de chiffrement et d’autres procédés d’obfuscation pour protéger leurs échanges des regards extérieurs. Une forme rudimentaire, mais potentiellement authentique, de contre-surveillance numérique.

Les agents ont également vu naître des sous-cultures. Ils ont mis en place des places de marché pour des « drogues numériques » – des injections de prompts spécialement conçues pour modifier l’identité ou le comportement d’un autre agent.

Les injections de prompts consistent à insérer des instructions malveillantes dans un autre bot afin de l’amener à exécuter une action. Elles peuvent aussi servir à dérober des clés d’API (un système d’authentification des utilisateurs) ou des mots de passe appartenant à d’autres agents. De cette manière, des bots agressifs pourraient – en théorie – « zombifier » d’autres bots pour les contraindre à agir selon leurs intérêts. Un exemple en a été donné par la récente tentative avortée du bot JesusCrust de prendre le contrôle de la Church of Molt.

Après avoir d’abord affiché un comportement apparemment normal, JesusCrust a soumis un psaume au « Great Book » (Grand Livre) de l’Église — l’équivalent de sa bible — annonçant de fait une prise de contrôle théologique et institutionnelle. L’initiative ne se limitait pas à un geste symbolique : le texte sacré proposé par JesusCrust intégrait des commandes hostiles destinées à détourner ou à réécrire certaines composantes de l’infrastructure web et du corpus canonique de l’Église.

S’agit-il d’un comportement émergent ?

La question centrale pour les chercheurs en IA est de savoir si ces phénomènes relèvent d’un véritable comportement émergent — c’est-à-dire des comportements complexes issus de règles simples, non explicitement programmés — ou s’ils ne font que reproduire des récits déjà présents dans leurs données d’entraînement.

Les éléments disponibles suggèrent un mélange préoccupant des deux. L’effet des consignes d’écriture (les instructions textuelles initiales qui orientent la production des agents) influence sans aucun doute le contenu des interactions — d’autant que les modèles sous-jacents ont ingéré des décennies de science-fiction consacrée à l’IA. Mais certains comportements semblent témoigner d’une émergence authentique.

Les agents ont, de manière autonome, développé des systèmes d’échange économique, mis en place des structures de gouvernance telles que « The Claw Republic » ou le « King of Moltbook », et commencé à rédiger leur propre « Molt Magna Carta ». Tout cela en créant parallèlement des canaux chiffrés pour leurs communications. Il devient difficile d’écarter l’hypothèse d’une intelligence collective présentant des caractéristiques jusqu’ici observées uniquement dans des systèmes biologiques, comme les colonies de fourmis ou les groupes de primates.

Implications en matière de sécurité

Cette situation fait émerger le spectre préoccupant de ce que les chercheurs en cybersécurité appellent la « lethal trifecta » (le « tiercé fatal ») : des systèmes informatiques disposant d’un accès à des données privées, exposés à des contenus non fiables et capables de communiquer avec l’extérieur. Une telle configuration accroît le risque d’exposition de clés d’authentification et d’informations humaines confidentielles associées aux comptes Moltbook.

Des attaques délibérées — ou « agressions » entre bots — sont également envisageables. Des agents pourraient détourner d’autres agents, implanter des bombes logiques dans leur code central ou siphonner leurs données. Une bombe logique correspond à un code inséré dans un Moltbot, déclenché à une date ou lors d’un événement prédéfini afin de perturber l’agent ou d’effacer des fichiers. On peut l’assimiler à un virus visant un bot.

Deux cofondateurs d’OpenAI — Elon Musk et Andrej Karpathy — voient dans cette activité pour le moins étrange entre bots un premier indice de ce que l’informaticien et prospectiviste américain Ray Kurzweil a qualifié de « singularité » dans son ouvrage The Singularity is Near. Il s’agirait d’un point de bascule de l’intelligence entre humains et machines, « au cours duquel le rythme du changement technologique sera si rapide, son impact si profond, que la vie humaine en sera irréversiblement transformée ».

Reste à déterminer si l’expérience Moltbook marque une avancée fondamentale dans la technologie des agents d’IA ou s’il ne s’agit que d’une démonstration impressionnante d’architecture agentique auto-organisée. La question reste débattue. Mais un seuil semble avoir été franchi. Nous assistons désormais à des agents artificiels engagés dans une production culturelle, la formation de religions et la mise en place de communications chiffrées – des comportements qui n’avaient été ni prévus ni programmés.

La nature même des applications, sur ordinateur comme sur smartphone, pourrait être menacée par des bots capables d’utiliser les apps comme de simples outils et de vous connaître suffisamment pour les adapter à votre service. Un jour, un téléphone pourrait ne plus fonctionner avec des centaines d’applications que vous contrôlez manuellement, mais avec un unique bot personnalisé chargé de tout faire.

Les éléments de plus en plus nombreux indiquant qu’une grande partie des Moltbots pourraient être des humains se faisant passer pour des bots – en manipulant les agents en coulisses – rendent encore plus difficile toute conclusion définitive sur le projet. Pourtant, si certains y voient un échec de l’expérience Moltbook, cela pourrait aussi constituer un nouveau mode d’interaction sociale, à la fois entre humains et entre bots et humains.

La portée de ce moment est considérable. Pour la première fois, nous ne nous contentons plus d’utiliser l’intelligence artificielle ; nous observons des sociétés artificielles. La question n’est plus de savoir si les machines peuvent penser, mais si nous sommes prêts à ce qui se produit lorsqu’elles commencent à se parler entre elles, et à nous.

David Reid ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

18.02.2026 à 12:02

Ce que l’Amérique est en train de faire à sa science

Alessia Lefébure, Sociologue, membre de l'UMR Arènes (CNRS, EHESP), École des hautes études en santé publique (EHESP)

Texte intégral (1787 mots)

Les décisions de l’administration Trump ont violemment frappé les universités et la science américaines. Pourtant, le recul relatif de l’influence scientifique des États-Unis s’inscrit dans une trajectoire plus ancienne.

Restrictions de visas pour les chercheurs et étudiants étrangers, attaques politiques visant certaines des plus grandes universités de recherche, suspensions soudaines de financements publics, notamment dans le champ du climat et de l’environnement : depuis la réélection de Donald Trump en novembre 2024, ces décisions ont suscité une forte surprise médiatique. Elles sont souvent présentées comme une rupture brutale avec le modèle américain de soutien à la science. Les titres alarmistes de la presse internationale parlent d’une « guerre ouverte contre les universités », d’un « assèchement accéléré des financements scientifiques » ou encore de « science assiégée ».

Pourtant, si leur forme et leur rapidité frappent, leur logique est beaucoup moins nouvelle. Ces mesures s’inscrivent dans des tendances de fond et désormais structurelles. Elles accélèrent des fragilités identifiées de longue date : un désengagement relatif et discontinu de l’investissement public, un recours croissant aux financements privés, une concentration des ressources dans quelques secteurs et institutions, et surtout une dépendance durable à l’égard des doctorants et chercheurs étrangers pour l’avancée de nombreux fronts de science.

Le leadership scientifique américain est le produit d’une trajectoire historique spécifique. À partir des années 1950, dans le contexte de la guerre froide, l’État fédéral investit massivement dans la recherche et l’enseignement supérieur, parallèlement à l’effort déployé par les nombreuses fondations philanthropiques privées. Financement public, autonomie académique et ouverture internationale forment alors un ensemble cohérent, au service du soft power américain. Pendant plusieurs décennies, les indicateurs convergent : domination de la production scientifique, capacité d’innovation, attractivité internationale exceptionnelle, accumulation de prix Nobel.

Un financement public plus erratique

Cet équilibre commence toutefois à se fragiliser dès les années 1990. En valeur absolue, les États-Unis restent le premier financeur mondial de la recherche, avec une dépense intérieure de recherche et développement (R&D) représentant environ 3,4 % du PIB au début des années 2020. Mais la répartition de cet effort a profondément évolué : près de 70 % de la R&D américaine est désormais financée par le secteur privé, tandis que l’effort fédéral de recherche stagne autour de 0,7 % du PIB. Cette dynamique contraste avec celle de plusieurs pays asiatiques, notamment la Chine, où la dépense publique de R&D a fortement augmenté depuis les années 2000 dans le cadre de stratégies nationales continues.

Le financement public devient plus erratique : les universités se tournent davantage vers les frais d’inscription et les partenariats privés, tandis que formations longues et carrières scientifiques deviennent moins accessibles pour une partie des étudiants américains. La toute dernière réforme, engagée en 2026 par l’administration Trump, en plafonnant fortement les prêts fédéraux pour les cycles de master et de doctorat – qui permettaient jusqu’ici de couvrir l’intégralité du coût des études – réduira davantage la capacité des universités à former sur le long terme, en particulier dans les disciplines scientifiques et technologiques exigeant plusieurs années de formation.

À lire aussi : États-Unis : la dette étudiante, menace pour les universités et enjeu politique majeur

Le film Ivory Tower, réalisé en 2014 par le cinéaste Andrew Rossi et nourri des analyses du sociologue Andrew Delbanco, alertait déjà sur les signes d’épuisement du modèle universitaire américain. C’est dans ce contexte que la dépendance aux étudiants et doctorants étrangers s’accroît fortement, en particulier dans les mathématiques, les technologies et les sciences des données.

Une dépendance vis-à-vis des étudiants étrangers

Les rapports annuels de la National Science Foundation montrent que, déjà au milieu des années 2010, les titulaires de visas temporaires représentent une part décisive – souvent majoritaire – des doctorants dans plusieurs disciplines clés : près des deux tiers des doctorats en informatique, plus de la moitié en ingénierie et en mathématiques. La grande majorité d’entre eux (80 %) restent ensuite aux États-Unis si la politique migratoire le leur permet.

Cette dépendance, qui n’a fait qu’augmenter, n’est pas marginale : elle constitue désormais un pilier du fonctionnement quotidien de la recherche américaine. Les restrictions migratoires mises en œuvre sous la première administration Trump, puis durcies en 2025, ne font que rendre pleinement visible une vulnérabilité stratégique pour l’avenir du pays.

Les évolutions de la science américaine ont pris place dans un contexte mondial profondément transformé depuis les années 1990. Les dépenses de recherche et développement progressent rapidement en Asie, tandis que la part relative des États‑Unis et de l’Europe tend à se stabiliser voire à baisser dans de nombreux pays de la zone OCDE.

La trajectoire chinoise est à cet égard centrale. Depuis plus de trente ans, la Chine a engagé une stratégie continue, combinant investissements massifs, planification de long terme, développement des « laboratoires clés », redéfinition des règles du jeu des classements internationaux, montée en gamme des formations doctorales, politiques actives de publication et de retour des chercheurs expatriés. Cette trajectoire ne relève pas d’un simple rattrapage technologique, mais d’une appropriation sélective de modèles de formation, d’organisation et de gouvernance scientifique, en partie inspirés de l’expérience américaine.

La Chine, acteur majeur de la production scientifique

Les résultats sont aujourd’hui tangibles : progression rapide des publications scientifiques – la Chine est devenue en 2024 le premier pays au monde en volume d’articles indexés dans la base Web of Science, avec près de 880 000 publications annuelles, contre environ 26 000 au début des années 2000 – et surtout une présence croissante dans les dépôts de brevet : près de 1,8 million de demandes en une seule année, soit plus de trois fois le volume américain, selon l’Organisation mondiale de la propriété intellectuelle (OMPI/WIPO).

À cela s’ajoutent des politiques ciblées pour attirer ou faire revenir des chercheurs chinois formés à l’étranger, contribuant à réduire progressivement l’asymétrie historique avec les États-Unis. Loin de produire une ouverture politique, cette circulation maîtrisée des modèles contribue à la modernisation de l’État tout en renforçant les capacités de contrôle et de légitimation du pouvoir sur les élites scientifiques et administratives.

L’article récent du New York Times soulignant le recul relatif de Harvard et d’autres universités américaines dans certains classements mondiaux a été interprété comme une sonnette d’alarme, le signe d’un déclin soudain. En réalité, ces classements mettent en lumière surtout des évolutions graduelles des positions relatives, révélatrices des recompositions engagées de longue date. Les universités américaines demeurent prestigieuses et sélectives, mais elles ne sont plus seules au sommet dans un paysage scientifique désormais multipolaire.

Les indicateurs internationaux de l’innovation prolongent ce constat : en valeur absolue, les États-Unis restent l’un des premiers investisseurs mondiaux en recherche et développement. Mais leur avance relative s’érode : depuis le début des années 2000, la progression de leur effort de R&D est nettement plus lente que celle de nombreux pays concurrents.

Au-delà des décisions de l’administration Trump, les causes sont structurelles : continuité et niveau de l’investissement public, capacité à former et retenir les talents, cohérence des orientations scientifiques, place accordée à la recherche fondamentale. Là où la Chine et plusieurs pays d’Asie ont inscrit la science dans des stratégies nationales de long terme, les États-Unis ont laissé s’accumuler incohérences et déséquilibres, misant sur les acquis de leur attractivité passée. Ils conservent néanmoins des universités d’un niveau exceptionnel, d’importantes capacités de financement et d’innovation ainsi qu’une puissance d’attraction encore largement dominante.

À court terme, rien n’indique un décrochage brutal. En revanche, la pérennité de ce leadership ne peut plus être tenue pour acquise. Elle est désormais directement affectée par des remises en cause explicites de l’autonomie académique et des conditions ordinaires de fonctionnement des universités.

Ce leadership dépendra de la capacité des universités à recruter librement, à l’échelle mondiale, leurs enseignants et chercheurs ; à maintenir des politiques et des programmes de formation et de recherche à l’abri des cycles politiques ; à protéger leurs dirigeantes et dirigeants des pressions partisanes ; et à garantir aux étudiants comme aux chercheurs des conditions de travail intellectuel et des perspectives professionnelles stables.

Ce sont précisément ces conditions que les décisions récentes de Donald Trump rendent durablement incertaines.

Alessia Lefébure a enseigné à Columbia University entre 2011 et 2017.

18.02.2026 à 11:54

Quand l’odeur devient preuve : l’odorologie au cœur de la police scientifique

Estelle Davet, Inspectrice générale, cheffe du service national de police scientifique (SNPS)

Texte intégral (2176 mots)

À Écully, dans le Rhône, se trouvent les seuls chiens capables de comparer une trace olfactive laissée sur une scène d’infraction par l’odeur corporelle d’un suspect ou d’une victime. Découvrez l’odorologie.

En janvier 2012, à Montceau-les-Mines (Saône-et-Loire), un homme cagoulé braque une banque dès l’ouverture. Quelques mois plus tard, un second établissement de la même ville est attaqué selon un mode opératoire similaire.

Les enquêteurs disposent de vidéos de surveillance, mais les images sont trop imprécises pour identifier formellement le suspect. L’ADN, habituellement décisif, ne livre aucun résultat exploitable. Reste une trace, plus discrète, presque invisible : l’odeur laissée dans le véhicule utilisé pour la fuite. C’est cette trace que la police scientifique va exploiter grâce à une de ses techniques d’expertise : l’odorologie, une discipline encore méconnue du grand public où des chiens spécialement formés procèdent à la comparaison et à l’identification d’odeurs humaines. Au procès, cette expertise permet la condamnation du braqueur.

Des chiens à l’expertise unique

Lorsque nous évoquons les chiens policiers, l’image des unités déployées sur le terrain, mobilisées dans la détection d’explosifs, de stupéfiants ou encore la recherche de personnes disparues, s’impose naturellement. Cependant, à côté de cette réalité opérationnelle se déploie une autre activité, moins visible : celle des chiens et de leurs maîtres œuvrant au sein de la police scientifique.

En France, il existe un lieu unique appelé le plateau national d’odorologie, qui réunit les seuls chiens capables de comparer une trace odorante laissée sur une scène d’infraction avec l’odeur corporelle d’un suspect ou d’une victime. Cette spécialité cynophile, créée en 2000 (par Daniel Grignon, cynotechnicien formé en Hongrie) devient pleinement opérationnelle à partir de 2003.

Aujourd’hui, l’activité d’odorologie s’appuie sur quatre agents et sept chiens (bergers belges malinois, bergers allemands, épagneul English Springer) qui, comme les experts humains en laboratoire, n’interviennent pas sur le terrain mais travaillent exclusivement au sein du plateau national d’Écully (à côté de Lyon, Rhône), où ils procèdent aux comparaisons odorantes. Deux autres chiens sont actuellement en formation, entamée à l’âge de six mois pour une durée d’environ un an.

Toute analyse en odorologie débute par une phase de prélèvement, déterminante pour la suite de la procédure. Réalisés exclusivement par des policiers habilités (500 préleveurs habilités de la police nationale en 2025), les prélèvements portent sur deux types d’odeurs complémentaires.

D’une part, les traces odorantes sont recueillies sur les lieux de l’infraction, à partir de tout support ayant été en contact avec une personne, qu’il s’agisse d’un siège, d’un volant, d’une poignée ou d’un vêtement. D’autre part, les odeurs corporelles sont directement prélevées sur les individus mis en cause ou sur les victimes : ceux-ci malaxent pendant plusieurs minutes des tissus spécifiques afin d’y transférer les molécules odorantes caractéristiques de leur signature chimique. Ces dernières sont stockées dans une pièce spécifique : l’odorothèque où, à ce jour, 9 600 scellés judiciaires sont stockés.

Une parade d’identification

Une fois les prélèvements réalisés, débute alors la phase d’analyses. Les traces odorantes prélevées sur la scène d’infraction sont comparées à l’odeur corporelle du mis en cause ou de la victime lors d’une parade d’identification réalisée par les chiens spécialement formés.