28.11.2025 à 13:13

L’effet ChatGPT : comment, en trois ans, l’IA a redéfini les recherches en ligne

Deborah Lee, Professor and Director of Research Impact and AI Strategy, Mississippi State University

Texte intégral (1881 mots)

Le 30 novembre 2022, OpenAI rendait accessible à tous ChatGPT, l’intelligence artificielle générative sur laquelle elle travaillait depuis sept ans. En trois ans, un geste du quotidien s’est déplacé : au lieu de taper une requête dans Google ou de chercher un tutoriel sur YouTube, des millions de personnes ouvrent désormais ChatGPT pour poser leur question. Ce réflexe nouveau, qui s’impose dans les usages, marque un tournant majeur dans notre rapport à la recherche d’information en ligne.

Il y a trois ans, lorsqu’il fallait réparer un robinet qui fuit ou comprendre l’inflation, la plupart des gens avaient trois réflexes : taper leur question sur Google, chercher un tutoriel sur YouTube ou appeler désespérément un assistant vocal à l’aide.

Aujourd’hui, des millions de personnes adoptent une autre stratégie : elles ouvrent ChatGPT et posent simplement leur question.

Je suis professeure et directrice de la recherche et de la stratégie en matière d’IA à la Mississippi State University Libraries. En qualité de chercheuse spécialisée dans la recherche d’informations, je constate que ce changement dans l’outil vers lequel les gens se tournent en premier pour trouver des informations est au cœur de la manière dont ChatGPT a transformé nos usages technologiques quotidiens.

Près de 800 millions de personnes utilisatrices hebdomadaires

Le plus grand bouleversement n’est pas la disparition des autres outils, mais le fait que ChatGPT soit devenu la nouvelle porte d’entrée vers l’information.

Quelques mois après son lancement, le 30 novembre 2022, ChatGPT comptait déjà 100 millions d’utilisateurs hebdomadaires. Fin 2025, ce chiffre était passé à 800 millions. Cela en fait l’une des technologies grand public les plus utilisées au monde.

Les enquêtes montrent que cet usage dépasse largement la simple curiosité et qu’il traduit un véritable changement de comportement. Une étude réalisée en 2025 par le Pew Research Center (Washington) indique que 34 % des adultes états-uniens ont utilisé ChatGPT, soit environ le double de la proportion observée en 2023. Parmi les adultes de moins de 30 ans, une nette majorité (58 %) l’a déjà testé.

Un sondage AP-NORC rapporte qu’aux États-unis, environ 60 % des adultes qui utilisent l’IA déclarent l’utiliser pour rechercher des informations, ce qui en fait l’usage le plus courant de l’IA. Ce taux grimpe à 74 % chez les moins de 30 ans.

Un bouleversement des usages

Les moteurs de recherche traditionnels restent le socle de l’écosystème de l’information en ligne, mais la manière dont les gens cherchent a, elle, considérablement changé depuis l’arrivée de ChatGPT. Les utilisateurs modifient tout simplement l’outil qu’ils sollicitent en premier.

Pendant des années, Google était le moteur de recherche par défaut pour tout type de requête, de « Comment réinitialiser ma box Internet » à « Expliquez-moi le plafond de la dette ». Ce type de requêtes informatives de base représentait une part importante du trafic. Mais ces petites questions du quotidien, rapides, clarificatrices, celles qui commencent par « Que veut dire… », sont désormais celles que ChatGPT traite plus vite et plus clairement qu’une page de liens.

Et les internautes l’ont bien compris. Une enquête menée en 2025 auprès de consommateurs américains a montré que 55 % des personnes interrogées utilisent désormais les chatbots ChatGPT d’OpenAI ou Gemini AI de Google pour des tâches qu’ils confiaient auparavant à Google Search, avec des taux encore plus élevés au Royaume-Uni.

Une autre analyse portant sur plus d’un milliard de sessions de recherche montre que le trafic issu des plateformes d’IA générative augmente 165 fois plus vite que les recherches classiques, et qu’environ 13 millions d’adultes, aux États-Unis, ont déjà fait de l’IA générative leur outil de prédilection pour explorer le web.

Les atouts de ChatGPT

Cela ne signifie pas que les gens ont cessé d’utiliser Google, mais plutôt que ChatGPT a capté les types de questions pour lesquelles les utilisateurs veulent une explication directe plutôt qu’une liste de résultats. Vous voulez connaître une évolution réglementaire ? Vous avez besoin d’une définition ? Vous cherchez une manière polie de répondre à un email délicat ? ChatGPT offre une réponse plus rapide, plus fluide et plus précise.

Dans le même temps, Google ne reste pas les bras croisés. Ses pages de résultats n’ont plus la même allure qu’il y a trois ans, car le moteur a intégré directement son IA Gemini en haut des pages. Les résumés « AI Overview », placés au-dessus des liens classiques, répondent instantanément à de nombreuses questions simples parfois avec justesse, parfois moins.

Quoi qu’il en soit, beaucoup d’utilisateurs ne descendent jamais plus bas que ce résumé généré par l’IA. Ce phénomène, combiné à l’impact de ChatGPT, explique la forte hausse des recherches « zéro clic ». Un rapport fondé sur les données de Similarweb révèle que le trafic envoyé par Google vers les sites d’information est passé de plus de 2,3 milliards de visites à la mi-2024 à moins de 1,7 milliard en mai 2025, tandis que la part des recherches liées à l’actualité se soldant par zéro clic a bondi de 56 % à 69 % en un an.

La recherche Google excelle dans la mise en avant d’une pluralité de sources et de points de vue, mais ses résultats peuvent paraître brouillons et davantage conçus pour générer des clics que pour offrir une information claire. ChatGPT, à l’inverse, fournit une réponse plus ciblée et conversationnelle, privilégiant l’explication au classement. Mais cette approche se fait parfois au détriment de la transparence des sources et de la diversité des perspectives qu’offre Google.

Côté exactitude, les deux outils peuvent se tromper. La force de Google réside dans le fait qu’il permet aux personnes qui utilisent ChatGPT de recouper plusieurs sources, tandis que l’exactitude de ce dernier dépend fortement de la qualité de la requête et de la capacité de l’utilisateur à reconnaître quand une réponse doit être vérifiée ailleurs.

Enceintes connectées et YouTube

L’impact de ChatGPT dépasse le cadre des moteurs de recherche. Les assistants vocaux comme les enceintes Alexa et Google Home restent très répandus, mais leur taux de possession recule légèrement. Une synthèse des statistiques sur la recherche vocale aux États-Unis pour 2025 estime qu’environ 34 % des personnes âgées de 12 ans et plus possèdent une enceinte connectée, contre 35 % en 2023. La baisse n’est pas spectaculaire, mais l’absence de croissance pourrait indiquer que les requêtes plus complexes se déplacent vers ChatGPT ou des outils similaires. Lorsqu’on souhaite une explication détaillée, un plan étape par étape ou une aide à la rédaction, un assistant vocal qui répond par une phrase courte paraît soudain limité.

En revanche, YouTube reste un mastodonte. En 2024, la plateforme comptait environ 2,74 milliards de personnes utilisatrices, un chiffre en progression constante depuis 2010. Aux États-Unis, près de 90 % des adolescents déclarent utiliser YouTube, ce qui en fait la plateforme la plus utilisée dans cette tranche d’âge. Cependant, le type de contenu recherché est en train de changer.

Les internautes ont désormais tendance à commencer par ChatGPT, puis à se tourner vers YouTube si une vidéo explicative est nécessaire. Pour bon nombre de tâches quotidiennes – « Comprendre mes avantages sociaux », « M’aider à rédiger un email de réclamation » –, ils demandent d’abord à ChatGPT un résumé, un script ou une liste de points clés, puis consultent YouTube uniquement s’ils ont besoin de visualiser un geste ou un processus concret.

Cette tendance se retrouve aussi dans des domaines plus spécialisés. Les développeurs, par exemple, utilisent depuis longtemps les forums comme Stack Overflow pour obtenir des conseils ou des extraits de code. Mais le volume de questions a commencé à chuter fortement après la sortie de ChatGPT, et une analyse suggère que le trafic global a diminué d’environ 50 % entre 2022 et 2024. Lorsqu’un chatbot peut générer un extrait de code et une explication à la demande, moins de gens prennent le temps de poster une question dans un forum public.

Alors, où va-t-on ?

Trois ans après son lancement, ChatGPT n’a pas remplacé l’écosystème technologique, mais il l’a reconfiguré. Le réflexe initial a changé. Les moteurs de recherche restent indispensables pour les explorations approfondies et les comparaisons complexes. YouTube demeure la plateforme incontournable pour voir des personnes réaliser des actions concrètes. Les enceintes connectées continuent d’être appréciées pour leur côté mains libres.

Mais lorsqu’il s’agit d’obtenir rapidement une réponse à une question, beaucoup commencent désormais par l’utilisation d’un agent conversationnel plutôt que par une requête dans un moteur de recherche. C’est là le véritable effet ChatGPT : il n’a pas simplement ajouté une application de plus sur nos téléphones, il a discrètement transformé notre manière de chercher de l’information.

Deborah Lee ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

26.11.2025 à 11:26

Les champignons d’Ötzi, l’homme des glaces du Néolithique

Hubert Voiry, Mycologue, Muséum national d’histoire naturelle (MNHN)

Texte intégral (1974 mots)

On l’oublie trop souvent mais les champignons ont accompagné l’histoire de l’humanité : médecine, géopolitique, psychologie, architecture, gastronomie, ils s’invitent dans de nombreux champs de nos vie depuis le Néolithique.

Dans cet extrait de son ouvrage Dix champignons qui ont changé la vie des hommes (éditions Actes Sud, 2025), le mycologue Hubert Voiry nous parle des deux champignons retrouvés par les archéologues dans la besace d’Ötzi, l’homme préhistorique découvert fortuitement en 1991 à 3 200 mètres d’altitude, dans les Alpes italiennes. Il tâche de comprendre pourquoi cet homme avait, avec lui des amadous et des polypores du bouleau.

Ötzi portait un petit sac en cuir rempli de matière noire. Dans ce sac, il y avait aussi trois outils en silex et un os en forme de poinçon. Au début, on a pensé que la matière noire était de la résine et que ce sac était une sorte de « kit » de réparation d’outils. Or, la substance, une fois séchée, a montré une teinte virant au brun. L’examen microscopique de cet objet a révélé qu’il s’agissait de la chair d’un champignon, l’amadouvier (Fomes fomentarius). Cette chair brune que l’on trouve sous la croûte (la face supérieure) du champignon avait été travaillée manuellement pour obtenir un produit de consistance fibreuse que l’on appelle l’amadou. Mélangées à cette matière, on a détecté aussi des traces de pyrite. Silex, pyrite et amadou ainsi réunis permettent d’allumer le feu et de le conserver.

Ce n’est pas le témoignage le plus ancien de l’usage de l’amadou pour le feu. Celui-ci a en effet été retrouvé en grande quantité associé à des nodules de pyrite sur le site archéologique de Star Carr en Angleterre qui date de près de 10 000 ans. On a fait les mêmes observations dans les fouilles archéologiques de Maglemose au Danemark, site qui remonte à 8 000 ans. Il existe aussi des témoignages plus récents datant de l’âge du bronze en Suisse, dans les sites préhistoriques d’anciens villages lacustres. L’amadou a donc la propriété de produire et de transporter le feu. Contrairement à une idée reçue, les humains de cette époque ne frappaient pas deux silex l’un contre l’autre pour allumer un feu, car les étincelles résultant de leur percussion sont trop éphémères pour enflammer un combustible. Ils avaient recours essentiellement à deux techniques : celle de la friction avec du bois et celle de la percussion, vraisemblablement utilisée par Ötzi. Dans la première, on dispose un morceau de bois à la verticale d’un autre placé au sol. On frotte le morceau de bois sur l’autre en lui donnant un mouvement de rotation avec les mains. Cela produit de la sciure échauffée qui va donner quelques braises. Ensuite, il faudra les mettre en contact avec des brindilles sèches. Ce procédé n’a pas laissé de traces archéologiques. L’autre méthode consiste à utiliser, comme Ötzi, pyrite, silex et amadou. La percussion d’un morceau de disulfure de fer (pyrite ou marcassite) contre une roche dure comme le silex produit des étincelles. L’amadou au contact de l’étincelle est capable de s’embraser facilement du fait de sa structure fibreuse, et le feu peut couver longtemps, ce qui facilite son transport. Il reste à produire des flammes en mettant par exemple en contact l’amadou incandescent avec des herbes très sèches ou des fibres d’écorce.

Pour faciliter l’embrasement, on a perfectionné la technique. L’amadou est débité en tranches fines qui sont amollies à coups de maillet puis qui sont mises à sécher. Au cours des siècles, des traitements au salpêtre ou aux cendres ont été mis au point pour qu’il s’enflamme plus facilement. Le célèbre mycologue Christiaan Hendrik Persoon en donne la description dans son ouvrage Traité sur les champignons comestibles, contenant l’indication des espèces nuisibles paru en 1818. Il précise que les bûcherons des Vosges avaient une technique moins recommandable pour traiter l’amadou : ils enterraient les tranches du “bolet” et les arrosaient pendant un certain temps avec de l’urine.

À partir de l’âge du fer, les morceaux de disulfure sont remplacés par des briquets, petits objets en acier qui au Moyen Âge avaient une forme de crochet aplati. Actuellement, on peut se procurer, dans le commerce, ce type de briquet appelé aussi briquet à silex et ainsi reproduire les gestes de nos ancêtres en frappant l’acier sur un silex aiguisé. On recueille les étincelles avec un morceau d’amadou ou à défaut avec un morceau de coton carbonisé. Les briquets “à amadou” qui apparaissent vers 1840 ne contiennent curieusement pas d’amadou. Le nom a été repris, mais c’est une mèche de coton trempée dans une solution chimique qui joue le rôle de l’amadou.

De nos jours, l’amadou est encore utilisé de façon traditionnelle pour le transport du feu, comme en Autriche lors du Weihfeuertragen, littéralement “le transport de feu consacré”. Le samedi de Pâques, le prêtre catholique réunit les familles de paroissiens autour d’un feu qu’il bénit au cours d’une cérémonie. Ensuite, les enfants récupèrent les braises à l’aide de bidons métalliques et passent dans les maisons du village apporter le feu béni. Pour faciliter le transport, ils ajoutent aux braises des morceaux d’amadou. En plus d’être le polypore le plus efficace pour la fabrication et le transport du feu, grâce à sa chair, l’amadouvier a aussi des vertus médicinales et artisanales, voire spirituelles. Un peuple de l’île d’Hokkaidō au Japon, les Aïnous, procédait, en cas de maladie ou d’épidémie, à un rituel de fumée autour des habitations. Ils faisaient brûler toute la nuit des fructifications de F. fomentarius pour éloigner les démons. Un rite analogue était pratiqué en Sibérie chez les Khantys et en Amérique du Nord dans des tribus amérindiennes.[…]

Le deuxième champignon retrouvé dans les affaires d’Ötzi est le polypore du bouleau, en latin : Fomitopsis betulina. Il se présentait sous forme de deux fragments enfilés sur une lanière de cuir. L’un de forme sphérique et l’autre de forme conique. Le polypore du bouleau, une fois séché, s’enflamme rapidement mais le feu ne couve pas. Ötzi ne l’a pas probablement pas utilisé pour le transport du feu, d’autant qu’il possédait déjà de l’amadou. Quel usage faisait-il donc des morceaux de ce polypore ?

Cette question a naturellement suscité des débats, dont sont ressorties deux grandes hypothèses. La première a été avancée par l’anthropologue italien Luigi Capasso : il suggère que l’Homme des Glaces était conscient de la présence de ses parasites intestinaux et les combattait avec des doses adaptées de Fomitopsis betulina. Ce champignon, qui est comestible – nous en reparlerons plus loin –, était probablement le seul vermifuge disponible à l’époque. L’autre hypothèse est défendue par la biologiste autrichienne Ursula Peintner : elle a fait le rapprochement avec certaines coutumes d’Amérindiens, rapportées par le biologiste américain Robert Blanchette. Ils possédaient des objets décorés avec des morceaux de forme ronde ou ovale d’Haploporus odorus, polypore à l’odeur très suave. Ces fragments étaient enfilés sur des lacets en cuir puis attachés aux tuniques sacrées ou aux colliers des guérisseurs. Ce polypore était aussi considéré comme ayant des vertus médicinales : on le faisait brûler pour produire une fumée agréable pour les personnes malades. Comme souvent dans les traditions, les aspects spirituel et médical sont mêlés. Concernant l’Homme des Glaces, nous avons bien noté que les bouts de F. betulina étaient enfilés sur une lanière de cuir de façon élaborée. S’il s’était agi d’un simple transport, ils auraient été placés sans perforation dans un récipient. On peut donc penser que les morceaux de F. betulina jouaient un rôle spirituel et médicinal. Robert Blanchette évoque aussi l’importance d’un autre champignon, Fomitopsis officinalis, aux propriétés médicinales pour les Amérindiens et leurs chamanes qui l’appellent “le pain des fantômes”. Les chamanes utilisaient des masques sculptés dans ces polypores pour effectuer des rites destinés à guérir certaines maladies. À leur mort, les masques étaient placés à la tête de la tombe et protégeaient l’esprit des chamanes. En Autriche, des fructifications de polypore du bouleau étaient sculptées pour protéger les animaux de ferme de la malchance. Le fragment conique du polypore d’Ötzi pourrait évoquer une sculpture qui n’aurait pas été très bien conservée. On pourrait donc considérer qu’Ötzi était un chamane qui portait sur lui, comme un talisman, ces deux fragments d’un champignon aux vertus médicinales et spirituelles. Rappelons que les affaires d’Ötzi n’ont pas été pillées, ce qui laisse supposer qu’on ne voulait pas s’approprier ses objets : c’était peut-être un personnage important.

Hubert Voiry est l'auteur de l'ouvrage « 10 champignons qui ont changé la vie des hommes », publié aux éditions Actes Sud dont ce texte est tiré.

26.11.2025 à 11:25

L’Univers a-t-il un début ? Le Big Bang contre la théorie de l’état stationnaire

Waleed Mouhali, Enseignant-chercheur en Physique, ECE Paris

Texte intégral (2417 mots)

La question de l’évolution de l’Univers a attisé de nombreux débats au cours de l’histoire de la physique. Au début du XXe siècle, deux camps de scientifiques s’affrontèrent : d’un côté, les tenants d’un Univers stable et ayant toujours existé, de l’autre, les physiciens qui adhèrent au modèle d’un atome primitif, ancêtre de notre théorie du Big Bang.

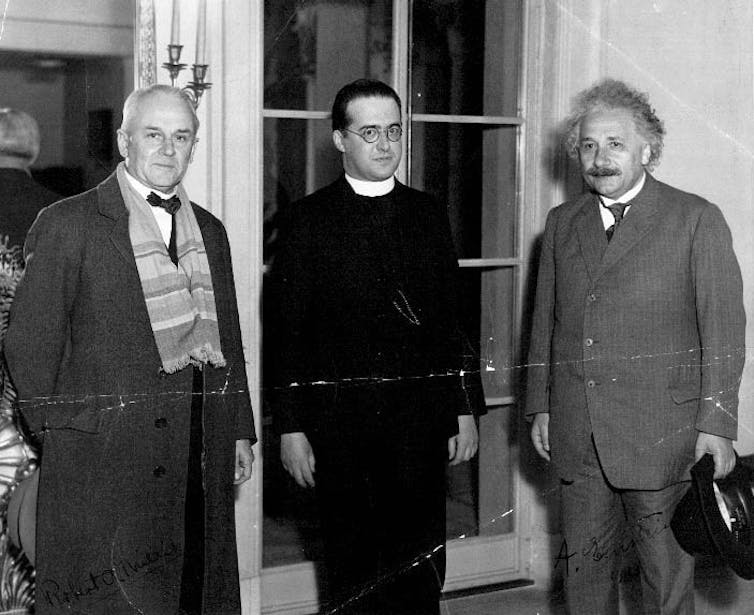

Au cours du XXe siècle, la cosmologie a été bouleversée par deux visions concurrentes du Cosmos. D’un côté, Georges Lemaître proposait l’hypothèse d’un « atome primitif », précurseur du Big Bang, selon laquelle l’Univers a une histoire et un commencement. De l’autre, Fred Hoyle, Thomas Gold et Hermann Bondi défendaient en 1948 une alternative : l’état stationnaire, un modèle où l’Univers, en expansion, reste inchangé à grande échelle grâce à une création continue de matière.

Cette théorie séduisait par son élégance : elle évitait l’idée d’un début absolu et renouait avec de vieilles intuitions philosophiques – puisqu’elles remontent à la Grèce antique – selon lesquelles le Cosmos était éternel et immuable. Mais elle allait bientôt se heurter à l’épreuve des observations. Le déclin de cette théorie fascinante s’inscrit dans une querelle scientifique majeure, au terme de laquelle le modèle de l’atome primitif de Georges Lemaître s’est imposé.

Le modèle de l’état stationnaire : un Univers éternel et immuable

En 1948, Fred Hoyle, Thomas Gold et Hermann Bondi introduisent le modèle cosmologique de l’état stationnaire. Leur approche repose sur deux principes fondamentaux. D’une part, le principe cosmologique parfait : non seulement l’Univers est homogène et isotrope dans l’espace – cela signifie qu’à grande échelle, l’Univers présente les mêmes propriétés en tout point et dans toutes les directions d’observation, aucun lieu ni direction n’est privilégiés – mais il l’est aussi dans le temps – ses propriétés sont globalement les mêmes à toutes les époques. D’autre part, ils postulent la création continue de matière pour compenser l’expansion observée de l’Univers mise en évidence par Hubble, de la matière est continuellement créée à un rythme très faible (de l’ordre d’un atome d’hydrogène par mètre cube tous les milliards d’années).

Ce modèle évite un commencement à l’Univers, et par conséquent la question philosophique et scientifique de la création de quelque chose à partir du néant. Il offre un cadre élégant, statique à grande échelle, dans lequel l’Univers n’a ni origine ni fin. D’un point de vue philosophique, il s’inscrit dans la continuité d’une vision éternelle du Cosmos, une position qui était majoritaire parmi les savants de l’Antiquité jusqu’au XVIIIe siècle, une idée déjà défendue par les stoïciens ou Aristote. À noter qu’Aristote s’interroge sur les limites de l’Univers et rejette l’idée d’un Univers infini, qu’il juge physiquement insoutenable.

Pourquoi le modèle de l’état stationnaire a-t-il séduit ?

Le modèle de l’état stationnaire a longtemps bénéficié d’un certain prestige pour plusieurs raisons. D’abord, sa simplicité philosophique, que l’on vient de décrire, mais aussi sa stabilité mathématique, puisqu’il repose sur des solutions simples des équations cosmologiques formulées par Einstein dans le cadre de sa relativité générale. Enfin, il séduit aussi du fait de son esthétique scientifique : un Univers inchangé dans le temps apparaît comme harmonieux et prévisible.

Le modèle de l’état stationnaire avait donc tout pour plaire. Sûr de sa théorie, c’est Fred Hoyle, en voulant se moquer et tourner en dérision le modèle concurrent de l’atome primitif qu’il considérait comme absurde, qui forge le terme de Big Bang lors d’une émission de radio sur la BBC en 1949. Et pourtant…

Le modèle de l’atome primitif de Lemaître : un précurseur du Big Bang

Avant même la formulation du Big Bang moderne tel que nous le concevons aujourd’hui, le prêtre et physicien belge Georges Lemaître avait développé en 1931 une hypothèse audacieuse : le modèle de l’atome primitif. Selon lui, l’Univers aurait été créé à partir de la désintégration d’un « atome cosmique », un point originel dense et chaud, à l’origine de l’expansion de l’espace. Il complète ainsi un modèle qu’il avait commencé à formuler dès 1927, dans lequel il proposait déjà un Univers en expansion.

Vous avez tout à fait raison sur le point historique concernant Lemaître : dans son article de 1927, il obtient des solutions dynamiques des équations d’Einstein, établit déjà la relation distance-vitesse et en donne une première estimation, à partir notamment des redshifts mesurés par Slipher, sans s’appuyer sur Hubble. Les travaux de Hubble, publiés ensuite, ont surtout apporté la confirmation observationnelle systématique et ont contribué à populariser cette loi aujourd’hui appelée loi de Hubble-Lemaître. Il conçoit un Univers en expansion, mais doté d’un passé à la fois physique et avec un commencement. Lemaître imaginait l’atome primitif comme un noyau contenant toute la matière de l’Univers dont la fission aurait déclenché l’expansion cosmique. Il interprétait les rayons cosmiques, récemment découverts, comme des résidus de cette désintégration initiale. Cette hypothèse s’est avérée inexacte puisqu’ils proviennent en réalité de phénomènes astrophysiques situés dans notre environnement cosmique proche.

Lemaître accepte l’idée d’un début de l’Univers, tout en distinguant clairement cette question cosmologique de la Création au sens religieux, qu’il considère relever d’un tout autre registre. Le modèle de l’atome primitif est le précurseur direct de ce que l’on appellera par découvertes successives le modèle du Big Bang, qui s’imposera plus tard, notamment grâce à ses prédictions observables.

Les preuves observationnelles contre l’état stationnaire

Malgré son attrait initial, le modèle de l’état stationnaire a commencé à vaciller face à des données de plus en plus précises. Le coup le plus dur arrive en 1964, quand Arno Penzias et Robert Wilson détectent par hasard un signal radio bruité provenant de toutes les directions d’observation. Ce bruit, appelé rayonnement cosmologique, est en fait la lueur fossile laissée par l’Univers très jeune, exactement comme l’avaient prédit les partisans du Big Bang. Le modèle stationnaire, lui, n’a aucun moyen d’expliquer un tel vestige. Le fond diffus cosmologique, découvert en 1965, est le témoin le plus direct du Big Bang. Ses détails ont ensuite été étudiés par les satellites COBE (1992), WMAP (2003) et Planck (2009).

D’autres indices vont dans le même sens : les galaxies lointaines – dont l’image qui nous parvient d’elle date du moment où elles étaient encore jeunes – n’ont pas la même apparence que les galaxies actuelles. De plus, les quasars, sortes de noyaux galactiques hyperactifs, étaient bien plus nombreux dans le passé qu’aujourd’hui. Ces différences montrent que l’Univers évolue au fil du temps, contrairement à ce qu’affirmait l’état stationnaire.

Enfin, le Big Bang prédit avec une grande précision les proportions des éléments légers (hélium, deutérium, lithium) formés durant les toutes premières minutes. Les mesures des éléments fossiles qui sont parvenus jusqu’à nous confirment ces valeurs. Le modèle stationnaire, qui n’inclut pas de phase chaude et dense initiale, est incapable de les expliquer.

L’évolution de la cosmologie moderne

Face à ces observations, la communauté scientifique adopte progressivement le modèle du Big Bang comme modèle standard. Pourtant, Fred Hoyle, dans les années 1990, refusant d’abandonner son hypothèse, propose un modèle dit quasi stationnaire, mais il reste marginal.

Aujourd’hui, le modèle ΛCDM (Lambda Cold Dark Matter), une version étendue du Big Bang qui intègre la constante cosmologique, l’idée selon laquelle il existe une minuscule énergie du vide, identique partout, exerçant une pression qui accélère l’expansion de l’Univers, est considéré comme le cadre le plus complet pour décrire l’évolution de l’univers. Introduite par Einstein en 1917 pour contrecarrer l’effet de la gravité dans un Univers qu’il pensait lui-même statique, elle a été réhabilitée sous le nom d’énergie sombre pour expliquer l’accélération observée, est considéré comme le cadre le plus complet pour décrire l’évolution de l’Univers.

Le modèle de l’état stationnaire illustre un cas typique d’élégance théorique confrontée à la rigueur de l’expérimentation. Cette controverse a stimulé les débats, inspiré des développements mathématiques et permis une meilleure compréhension de ce qu’est une bonne théorie scientifique : cohérente, testable, et surtout, réfutable.

Elle rappelle aussi que la science avance non par dogme, mais par confrontation avec la réalité du cosmos. Et si certaines théories comme celle de la simulation ou du multivers flirtent aujourd’hui avec la frontière de ce que l’on est capable de tester, elles perpétuent une tradition millénaire : tenter de comprendre ce qui, depuis toujours, nous dépasse.

Waleed Mouhali ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview