08.12.2025 à 16:16

L’intelligence artificielle au service de la médecine régénérative pour concevoir de nouvelles protéines

Jad Eid, Professeur de biophysique et bio-informatique, École de Biologie Industrielle (EBI)

Texte intégral (2057 mots)

Comment aider notre corps à se réparer après une blessure ? Trouver et produire les bonnes molécules qui stimulent la régénération cellulaire reste un défi pour la médecine régénérative. Mais l’intelligence artificielle assiste maintenant les chercheurs pour réussir à concevoir le composé chimique idéal.

La médecine pourra-t-elle un jour réparer durablement des tissus ou des organes gravement blessés ? Derrière cette question se cache un enjeu central de la médecine régénérative : contrôler finement le comportement des cellules. C’est ce qui permettra de maîtriser des processus déterminants tels que la cicatrisation, la croissance de nouveaux tissus ou encore la capacité des cellules à bien s’accrocher à leur environnement.

Lorsqu’un tissu est endommagé, les cellules ne savent pas, à elles seules, comment s’organiser pour le réparer. Elles s’appuient pour cela sur les signaux présents dans leur environnement immédiat, la matrice extracellulaire. Cette matrice est formée d’un réseau dense de protéines et de sucres qui non seulement soutient physiquement les cellules, mais leur fournit aussi des informations essentielles pour s’orienter, s’agréger ou migrer. À cette échelle, elle joue un rôle comparable à une cartographie biologique : elle indique aux cellules où aller, comment se fixer et quelles fonctions activer pour que la réparation tissulaire puisse se dérouler correctement. Mais parfois, ces mécanismes échouent à régénérer complètement les tissus.

Et si l’intelligence artificielle (IA) pouvait nous aider à franchir un cap dans ce domaine ? Aujourd’hui, les chercheurs explorent une voie émergente : concevoir, avec l’aide de l’IA, de nouvelles protéines capables de guider et de stimuler la régénération des tissus abîmés, là où les cellules ne réagissent plus spontanément. L’objectif est d’imaginer des molécules qui envoient aux cellules les bons signaux, au bon endroit et au bon moment, pour relancer un processus de réparation insuffisant ou défaillant.

Imaginer de nouvelles protéines pour guider les cellules

À terme, cette nouvelle façon de concevoir des protéines, appuyée par l’IA, pourrait contribuer au développement d’implants dits intelligents, de pansements bioactifs ou de thérapies personnalisées capables de dialoguer avec les cellules du patient. On peut imaginer, par exemple, un implant conçu pour interagir finement avec la matrice et les récepteurs cellulaires, afin d’accélérer la régénération d’un tissu après une chirurgie ou une blessure, de manière rapide, contrôlée et durable.

Au sein du laboratoire EBInnov de l’École de biologie industrielle, nous concevons des protéines simplifiées. Plutôt que d’utiliser une protéine naturelle dans son intégralité – qui sera fragile, longue et complexe à produire – nous en découpons les parties utiles qui permettent aux cellules de s’accrocher, de se déplacer vers une zone à réparer ou de recevoir un signal pour activer la cicatrisation. Cette stratégie repose sur le génie génétique : nous modifions et réassemblons l’ADN codant la protéine, puis nous l’exprimons biologiquement en laboratoire grâce à des bactéries modifiées.

Le recours à cette approche est motivé par deux impératifs scientifiques et industriels. D’un côté, nous obtenons une molécule plus simple, plus stable et plus facile à fabriquer que la protéine complète. De l’autre, nous pouvons tester plus précisément les fonctions que nous visons sans être perturbés par des régions de la protéine d’origine qui ne sont pas nécessaires, voire parfois gênantes.

La migration cellulaire se joue à petite échelle : il s’agit d’un déplacement local sur quelques micromètres, réalisé par des cellules de la peau ou du tissu conjonctif qui se dirigent vers une zone lésée pour déclencher la réparation du tissu. Ce guidage repose sur la signalisation cellulaire, un langage biochimique basé sur la reconnaissance et l’échange de motifs moléculaires, permettant aux cellules d’activer les bonnes réponses au bon moment. C’est ce langage que nous essayons d’apprendre et de maîtriser.

Un avantage majeur : tester virtuellement les molécules

Observer expérimentalement la structure 3D et les interactions entre protéines reste aujourd’hui lent et coûteux, car ces approches nécessitent des infrastructures lourdes et de l’expertise. À l’inverse, les méthodes récentes d’IA permettent d’inférer des formes tridimensionnelles très réalistes et très précises à partir de larges jeux de données.

Ces modèles apprennent les règles statistiques et physiques du repliement moléculaire, en s’entraînant sur des milliers de structures biologiques déjà élucidées. Cela fournit un avantage stratégique : évaluer virtuellement si une molécule conçue conservera ses zones d’interaction correctement exposées et atteignables par les récepteurs cellulaires, avant de la produire au laboratoire, réduisant ainsi le nombre d’essais exploratoires nécessaires in vitro.

Cette synergie entre design génétique simplifié, modélisation 3D par IA et simulations d’interactions moléculaires nous permet de rationaliser nos choix expérimentaux et d’anticiper la compatibilité biologique des protéines. Cela accélère aussi la conception de nouvelles biomolécules pour des matériaux thérapeutiques et cosmétiques bioactifs, tout en renforçant une ingénierie moléculaire guidée par les données et la simulation.

Prédire le repliement des protéines grâce à l’IA

Comprendre l’efficacité d’une protéine conçue en laboratoire impose de relier deux échelles : celle du corps humain et celle des interactions moléculaires, où tout se joue à la taille de quelques atomes et de quelques nanomètres. Une protéine est une chaîne d’éléments minuscules, des acides aminés, qui s’assemblent puis se plient spontanément pour former une architecture 3D. C’est cette forme qui lui permet ensuite d’agir comme un point d’ancrage, un message chimique ou un guide pour les cellules qui doivent réparer un tissu.

Un point essentiel est donc la prédiction de la structure tridimensionnelle de la protéine, c’est-à-dire la façon dont elle va se replier dans l’espace en fonction de la séquence d’acides aminés qui la composent. Cette tâche, historiquement difficile, a connu une transformation radicale avec l’émergence des modèles d’intelligence artificielle. Ces modèles sont entraînés sur de vastes bases de données combinant des séquences d’acides aminés et des structures déjà connues expérimentalement. Ils apprennent ainsi à établir un lien statistique entre la séquence et la forme finale de la protéine.

Concrètement, ils sont capables de prédire comment une protéine va se replier, un peu comme si l’on devinait la forme finale d’un origami complexe en ne connaissant que les plis de départ. Ils fournissent une forme 3D plausible en estimant, avec une grande précision, les distances entre acides aminés, les angles de repliement locaux et l’organisation spatiale des différentes régions de la protéine.

Dans notre projet, ces prédictions constituent une première évaluation critique de la cohérence structurale de la molécule que nous concevons expérimentalement. Elles nous permettent d’identifier les zones où les différentes parties de la molécule s’articulent entre elles et de repérer d’éventuels conflits de forme où une zone en gênerait une autre. Nous pouvons aussi localiser des régions potentiellement désordonnées ou trop flexibles et anticiper l’impact de ces caractéristiques sur la stabilité globale de la protéine et sur l’accessibilité de ses zones d’interaction.

Simuler les interactions dans un contexte biologique réaliste

Une molécule n’agit jamais seule : son efficacité dépend de sa capacité à interagir avec d’autres partenaires biologiques, au sein d’un environnement dense comme la matrice extracellulaire, où de nombreuses protéines, récepteurs et signaux coexistent en permanence.

C’est pourquoi, au-delà de la structure isolée, nous avons utilisé des approches de modélisation pour étudier comment notre molécule se comporte au contact de différents partenaires clés de la matrice. Cette phase d’analyse des interactions est essentielle : l’efficacité biologique d’une molécule dépend non seulement de sa capacité à se lier à ses cibles, mais aussi de la stabilité de ces liaisons dans le temps et de leur bonne compatibilité avec les récepteurs concernés.

Pour nous rapprocher des conditions biologiques réelles, nous avons simulé des systèmes complexes proches des tissus réels où des dizaines ou centaines de protéines identiques interagissent en même temps avec leurs cibles. Cela permet d’explorer des phénomènes de coopération entre molécules, de tester la robustesse des contacts lorsqu’elles sont nombreuses et d’analyser comment les domaines actifs se répartissent dans un espace tridimensionnel dense. Cette simulation nous permet de déterminer si les multiples copies de la protéine restent capables d’interagir ensemble sans perdre leur lisibilité biologique et sans se gêner physiquement.

Ces simulations fournissent des indices précieux sur la capacité de la molécule à maintenir des interactions efficaces malgré les contraintes physiques et géométriques de son environnement. Elles nous permettent de rationaliser la conception expérimentale, d’écarter certains scénarios peu prometteurs avant de passer à la paillasse, et ainsi de mieux cibler les expériences in vitro qui seront réellement informatives.

Vers une ingénierie moléculaire augmentée par l’IA

Ces approches ne remplacent pas l’expérience : elles nous permettent surtout de comprendre à l’avance si une molécule produite par génie génétique a la bonne forme, si elle garde ses zones d’action accessibles, et si elle peut maintenir des interactions solides dans un environnement aussi encombré que la matrice extracellulaire du corps humain. En bref, l’IA nous aide à mieux concevoir et à éviter de tester à l’aveugle, pour que les expériences menées ensuite sur de vraies cellules soient plus ciblées, pertinentes et rapides.

Si l’IA ouvre aujourd’hui un champ immense pour concevoir des protéines bioactives et des matériaux capables d’orienter la réparation des tissus, plusieurs verrous persistent encore dans la recherche académique. En premier lieu, il reste difficile de prédire la dynamique de la conformation des protéines sur de très longues échelles de temps. Un autre obstacle réside dans notre capacité à modéliser fidèlement tous les composants d’un tissu réel. Les prochaines étapes consistent donc à renforcer encore cette boucle vertueuse entre IA et biologie expérimentale, en intégrant davantage de données biologiques, en évaluant plus finement la tenue des interactions multiples et en préparant les validations in vitro les plus informatives possible.

Jad Eid ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

05.12.2025 à 13:08

L’intelligence collective : cette symphonie invisible des grandes équipes de football

Yoann Drolez, Maître de conférences en Sciences et techniques des activités physiques et sportives (STAPS), Université de Pau et des pays de l’Adour (UPPA)

Texte intégral (1753 mots)

Pourquoi certaines équipes de football semblent-elles réciter une partition savamment orchestrée, « jouant en harmonie » et enchaînant les actions fluides comme si chaque joueur lisait dans les pensées des autres ? Et pourquoi d’autres, pourtant remplies de stars, donnent parfois l’impression de ne jamais réussir à se connecter ou à se comprendre ? Derrière ces scènes familières pour tout amateur du ballon rond se cache un concept clé : l’intelligence collective.

Alors que le football est aujourd’hui un phénomène culturel mondial, il n’est pas seulement un sport promouvant les talents individuels, mais une véritable aventure cognitive collective pour les joueurs. Concrètement, la cognition décrit l’ensemble des mécanismes nous permettant de produire des pensées et des comportements. Elle englobe notamment la perception, la mémoire, le langage, l’apprentissage, le raisonnement, la résolution de problème ou encore la prise de décision. Une équipe de football est un système cognitif complexe, dont peut émerger une forme d’intelligence collective. Un postulat illustré par le documentaire réalisé en 2006 par Jean-Christophe Ribot.

L’intelligence collective reflète la capacité d’un collectif à produire une performance supérieure à la somme des performances individuelles, à trouver des solutions à des problèmes que les individus ne pourraient résoudre seuls, que ces problèmes soient connus ou inédits. Elle permet au collectif d’être plus fiable (stabilité et régularité des performances dans le temps), plus flexible (il peut faire face à davantage de situations ou à des problèmes plus variés) et plus fort (de meilleures performances absolues). Selon la thèse avancée par Joseph Henrich, la formidable intelligence collective des êtres humains est le fruit de nos compétences culturelles. Seulement, elle n’est pas la propriété exclusive de notre espèce.

L’intelligence collective, un phénomène universel

Pour Émile Servan-Schreiber, l’intelligence collective peut concerner tout groupe, dès lors qu’il est constitué d’entités capables de traiter de l’information et d’interagir entre elles.

Il est important de préciser qu’une telle conception suppose que la conscience de ses actions n’est pas indispensable. Ainsi, l’intelligence collective ne se limite pas à l’être humain : elle est un phénomène universel que l’on observe partout dans la nature. On la retrouve chez de nombreuses espèces animales, voire végétales. Même certains microorganismes « rudimentaires » (le blob ou l’amibe Dictyostelium, par exemple) sont capables de comportements fascinants, mais surtout collectivement intelligents.

Au sein de cette grande variété, Jean-François Noubel différencie plusieurs types d’intelligence collective. La plus parlante est probablement l’intelligence collective « en essaim ». Aussi appelée swarm intelligence, elle est présente chez les insectes sociaux (fourmis, abeilles, termites), ainsi que dans les bancs de poissons et les nuées d’oiseaux. Un nombre important d’individus agit sans plan préétabli, sans que chaque membre ait une vision complète de la situation et sans chef pour coordonner le tout. Leurs interactions reposent alors sur des règles très simples, produisant des comportements collectifs complexes.

Mais celle qui nous intéresse en premier lieu est l’intelligence collective « originelle », présente dans les petits groupes (jusqu’à une dizaine d’individus). Elle nécessite une proximité spatiale et s’appuie généralement sur un objet/lien symbolique ou matériel : la proie dans les meutes de loups en chasse, la mélodie dans un groupe de musique, le ballon dans une équipe de football.

Les multiples facettes de l’intelligence collective

À l’échelle collective comme individuelle, l’intelligence présente de multiples facettes. Elle décrit diverses capacités émergeant des interactions de groupe, produisant des comportements extrêmement variés, qui dépendent à la fois des caractéristiques du collectif (taille, types et fréquence d’interaction, diversités, expérience commune, etc.) et de l’environnement dans lequel il agit. James Surowiecki, auteur de la Sagesse des foules (2008), distingue trois catégories de problèmes que les collectifs peuvent résoudre.

Premièrement, des problèmes de cognition, consistant à estimer, prédire ou identifier une valeur objective. Par exemple : deviner le poids d’un objet, prévoir un résultat électoral, localiser quelque chose.

Deuxièmement, des problèmes de coordination, pour lesquels les membres du collectif doivent adapter leurs actions sans chef pour commander. Nous en faisons régulièrement l’expérience en conduisant une voiture, en circulant à vélo ou en sortant d’une salle de concert.

Enfin, des problèmes de coopération, impliquant des individus dont les intérêts individuels peuvent diverger de ceux du collectif. Il s’agit alors de mettre son action au service du bien commun, à l’instar d’une campagne de vaccination ou des gestes de tri sélectif.

Dans notre thèse, nous avons cherché à démontrer que, pour les équipes de football, l’intelligence collective prend une dimension particulièrement originale, mêlant prise de décision, coordination des mouvements et anticipation des actions.

Une projection collective dans le temps

Imaginez pouvoir vous projeter dans un futur plus ou moins proche, pouvoir deviner ce qui va se produire sous vos yeux. Cette capacité, que l’on nomme anticipation, est déterminante au football. En effet, les joueurs doivent constamment interpréter les actions de leurs adversaires et partenaires pour agir en conséquence. Collectivement, comprendre et deviner ce qui va advenir donne un avantage déterminant aux équipes qui s’adaptent dans l’instant, sans recourir à une communication verbale.

L’exemple des marchés prédictifs montre que les foules sont particulièrement habiles dans l’exercice de prédire certains événements. En agrégeant des informations et des pensées dispersées, cette forme de « pari collectif » peut produire des résultats dépassant les performances d’experts isolés.

Un tel phénomène repose en partie sur la diversité cognitive, autrement dit la combinaison de multiples façons de voir le monde, d’interpréter les choses. C’est l’idée du « théorème de la diversité » formulé par le sociologue américain Scott E. Page : un groupe cognitivement diversifié obtient souvent de meilleurs résultats qu’un groupe composé uniquement d’individus très compétents mais homogènes dans leur façon de penser. Or, qu’en est-il pour les petits groupes qui ne pourraient pas s’appuyer sur le nombre ?

L’étude que nous avons menée sur les équipes de football a montré que, pour des groupes de taille identique, l’expertise individuelle restait un facteur déterminant. En clair, une équipe de débutants est moins performante dans l’anticipation du jeu qu’une équipe d’experts, même si elle dispose d’une certaine diversité cognitive. En parallèle, nous avons observé qu’à expertise moyenne équivalente, une dose de diversité cognitive était bénéfique.

Concrètement, les équipes composées d’une minorité de joueurs « pensant différemment » étaient plus performantes pour deviner collectivement ce qui allait se produire dans un futur immédiat. Sans se concerter, ces dernières prédisaient avec réussite environ deux fois sur trois, ce qui leur conférerait un avantage indéniable sur le terrain.

Un atout dans les situations « critiques »

Compétences individuelles et diversité cognitive semblent bien liées à l’intelligence collective, y compris dans des groupes de petites tailles, confrontés à des situations « critiques ».

Au-delà du plaisir du sport, anticiper collectivement pour agir dans l’urgence est le quotidien de nombreux professionnels : pompiers, urgentistes, militaires. Comprendre les ressorts de leurs interactions, et des facteurs les rendant plus performants est alors déterminant. À ce titre, d’autres études ont souligné l’importance des compétences sociales, comme l’écoute ou la capacité à lire dans les yeux. Autant de pistes à creuser pour former à l’intelligence collective demain.

Cet article est publié dans le cadre de la Fête de la science (qui a lieu du 3 au 13 octobre 2025), dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « Intelligence(s) ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Yoann Drolez ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

04.12.2025 à 14:52

Fabriquer du cartilage humain… à partir de pommes

Karim Boumédiene, Professeur de biochimie et biologie moléculaire, ingénierie tissulaire, Université de Caen Normandie

Texte intégral (1401 mots)

Certaines pathologies induisent une perte de tissus comme du cartilage. Il y a donc un réel besoin de greffons. Et si la solution était de cultiver ce cartilage en laboratoire, à partir des propres cellules du patient (et en se servant de pommes) ?

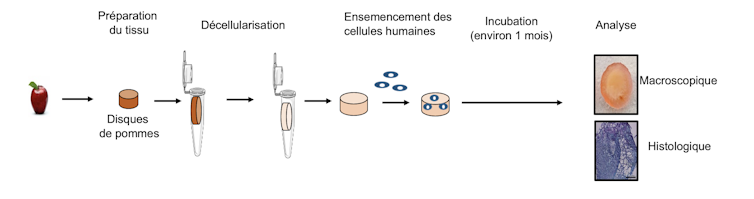

Le laboratoire Bioconnect de l’Université de Caen Normandie, que je dirige avec le Pr Catherine Baugé, vient de publier un article dans la revue de référence Journal of Biological Engineering. Dans cette étude, nous avons utilisé des pommes décellularisées comme biomatériau, combinées avec des cellules souches humaines pour reconstruire du cartilage in vitro (c’est-à-dire dans des boîtes de culture).

Cette approche de confection de tissus fait partie d’une discipline appelée l’ingénierie tissulaire. Elle vise à reconstruire des tissus humains en laboratoire dans le but de les utiliser comme des greffons pour combler des pertes tissulaires.

Cela consiste à implanter des cellules du patient dans des biomatériaux et à incuber l’ensemble dans des conditions adéquates pour former les tissus désirés, tels que l’os, le muscle ou le cartilage par exemple.

De nombreuses pathologies ou traumatismes induisent une altération ou perte des tissus nécessitant une reconstruction. Cela concerne des maladies dégénératives, dans lesquelles les tissus finissent par disparaître (arthrose pour la cartilage, ostéoporose pour l’os par exemple). Il y a donc un besoin important de greffons. Cependant, obtenir des tissus sains implantables est un véritable challenge pour les chirurgiens, devant la rareté ou la compatibilité des donneurs.

Afin de s’en affranchir, l’ingénierie tissulaire se révèle être une stratégie efficace. De plus, lorsque c’est possible, les propres cellules du patient sont ensemencées sur le biomatériau pour reconstruire le tissu endommagé, ce qui évite les risques de rejet immunologique.

La pomme est un excellent échafaudage

Si les chercheurs sont capables de multiplier facilement des cellules en laboratoire dans des boîtes de culture, elles ne s’organisent pas spontanément pour former des tissus et il est nécessaire de les combiner à des biomatériaux. Ces derniers sont utilisés pour jouer le rôle de support et d’échafaudage aux cellules, afin de leur permettre de former un tissu sous forme de volume et, ainsi, faciliter la reconstruction tissulaire.

Il est notamment possible d’utiliser directement des tissus ou organes humains après les avoir « décellularisés », c’est-à-dire débarrassés de leurs cellules. La structure résultante peut alors être ensemencée avec d’autres cellules, généralement saines. Cette stratégie a cependant une limite importante puisqu’il faut disposer de suffisamment de tissus au départ. Depuis une dizaine d’années, des tissus végétaux décellularisés peuvent servir de support pour la reconstruction.

Plusieurs approches ont déjà été réalisées dans notre laboratoire ainsi que d’autres, avec plusieurs types de biomatériaux, mais ici, c’est une première mondiale de reconstruction de cartilage avec un support végétal.

L’idée a émergé il y a quelques années, à la suite de la parution d’un article scientifique d’une équipe canadienne qui a montré que la pomme décellularisée était compatible avec la culture de cellules de mammifères. Aussitôt, nous avons pensé à l’appliquer pour construire du cartilage dont nous sommes spécialistes. Il y a plusieurs avantages à l’utilisation de tels supports issus du règne végétal : disponibilité quasi illimitée, prix très faible, biocompatibilité déjà validée in vivo, possibilité de sculpter le matériau à volonté pour épouser la forme du tissu désiré.

De multiples idées d’applications

Il s’agit là d’un premier pas dans l’utilisation des tissus provenant des plantes pour la reconstruction de tissus humains, même si cela doit être validé par des expériences supplémentaires, d’abord précliniques sur l’animal puis cliniques sur l’humain, pour évaluer le comportement de ces tissus sur le long terme et le bénéfice pour les patients. Les applications pourraient être nombreuses : réparation du cartilage articulaire (après microtraumatismes ou arthrose), reconstruction du cartilage nasal (après un traumatisme, un cancer), ou même auriculaire.

Ainsi, notre étude représente une ouverture importante dans le domaine de l’ingénierie tissulaire pour confectionner des greffons pour la chirurgie reconstructrice, mais également pour limiter le recours aux animaux d’expérimentation. En effet, les tissus ainsi construits en laboratoire peuvent aussi avantageusement être employés pour modéliser plus efficacement les maladies in vitro et tester des traitements dans des modèles dits « organoïdes », permettant ainsi de réduire voire de remplacer les tests in vivo et, par là même, diminuer le recours à l’utilisation de l’expérimentation animale.

Enfin, compte tenu de la très grande diversité dans le règne végétal, il reste aussi à explorer cet énorme potentiel pour notamment déterminer quelle plante (ou quelle partie de plante) pourrait convenir le mieux à la reconstruction de tel ou tel tissu. D’autres végétaux sont d’ores et déjà en cours d’investigation, comme le céleri par exemple.

Karim Boumédiene a reçu des financements de la Fondation des gueules cassées, de la Région Normandie et de l'Université de Caen Normandie.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview