ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

12.10.2025 à 09:01

Les pharmacies disposent de peu de leviers pour se redresser

Aniss Louchez, Docteur en économie, Université de Lille

Texte intégral (1705 mots)

La contraction du marché des médicaments remboursés, principale source de revenus des pharmacies, met leur modèle économique en danger. Ces offices disposent de quelques leviers régulés en raison de la nature même des officines. Lesquels ?

La pharmacie de ville, également appelée officine, est un acteur essentiel de l’offre de soins ambulatoire. Elle joue un rôle essentiel en fournissant des biens médicaux – médicaments et dispositifs médicaux – et des services de prévention, tels que la vaccination, à la population. La pharmacie bénéficie en France d’un monopole légal qui empêche la fourniture de produits de santé par d’autres acteurs.

Cette mesure vise à garantir la qualité des soins, selon l’économiste de la santé Charles Phelps. Elle se justifie par la nécessité de bénéficier d’un expert pour guider le patient selon l’Inspection générale des finances (IGF). La pharmacie est une structure particulière qui doit concilier une mission de santé publique avec l’impératif entrepreneurial d’assurer sa soutenabilité économique.

Cette soutenabilité se fragilise depuis plusieurs décennies. De 2014 à 2024, le nombre de pharmacies est passé de 21 772 à 19 627, selon le Conseil national de l’ordre des pharmaciens (Cnop), soit une baisse de 1 % par an pendant dix ans. Le nombre d’habitants par pharmacie est passé de 3 037 à 3 368 et pourrait atteindre 4 148 en 2050.

Cette contraction objective un malaise économique grandissant qui a motivé les récentes grèves des pharmaciens le 30 mai 2024, 16 août 2025 et 18 septembre 2025, largement suivies par plus de 80 % des pharmacies du pays. Pour comprendre la persistance et l’aggravation de ces tensions, cet article vise à replacer les pharmacies dans leur cadre macroéconomique et présenter les mécanismes d’ajustement à leur disposition.

Croissance de la demande de médicaments

L’activité des pharmacies est principalement adossée au marché du médicament remboursé qui représente 72,3 % du chiffre d’affaires (CA) en 2023, selon le cabinet KPMG. Le reste de l’activité est représenté par trois types de produits. Les médicaments non remboursés et les dispositifs médicaux – 14,6 % du CA –, la parapharmacie – 11,2 % du CA – et les tests et la vaccination Covid – 1,9 % du CA.

La demande de médicaments, principale source de revenus, est portée par le vieillissement de la population qui va se poursuivre jusque 2070, selon l’Insee. Avant 2021, le nombre de boîtes de médicament connaissait une croissance annuelle comprise entre 2,6 et 4,4 %, selon les Comptes nationaux de la Santé (CNS).

Contraction du marché des médicaments

Le marché du médicament s’est contracté de 32,1 milliards à 29,8 milliards d’euros, faisant de ce poste le principal contributeur à la maîtrise des dépenses de santé. Cette contraction est partiellement compensée par les fermetures de pharmacies, stabilisant le chiffre d’affaires moyen entre 1 million et 1,2 million d’euros. La stabilité des recettes masque l’augmentation des charges – salaires, coûts des fournitures, loyers, assurances, logiciels de gestion – portée par l’inflation, et amenant à une réduction des marges.

Cette pression transparaît dans les fermetures dont presque la moitié affectait des pharmacies de moins de 1 million de chiffre d’affaires, selon le Conseil national de l’ordre des pharmaciens (Cnop), alors qu’elles représentaient moins de 14,5 % des pharmacies, selon KPMG.

Dans un contexte de contraction de leur activité principale, il est important de présenter les mécanismes d’ajustement dont disposent les pharmacies.

Mécanismes d’ajustement

Pour assurer sa soutenabilité, une entreprise peut adapter son activité en ajustant les volumes de production et les prix. Ces mécanismes sont régulés en raison de la nature particulière du médicament.

En dehors des préparations magistrales, en raison de l’impératif de qualité, de sécurité et d’efficacité, les pharmacies ne peuvent pas modifier ou développer un médicament, il s’agit du rôle de l’industrie pharmaceutique.

Ajustement par les volumes

La pharmacie ne peut pas augmenter son nombre de boites de médicaments remboursés. Celui-ci est soumis à des prescriptions qui amènent les prescripteurs – médecins, infirmiers, dentistes, etc. – à définir l’activité des pharmacies. L’accentuation des pénuries de médicaments limite les possibilités d’augmentation globale de l’activité. En parallèle, la publicité est quasiment inexistante afin de garantir l’éthique dans la dispensation des soins.

Une pharmacie ne peut que difficilement optimiser sa localisation géographique, en raison de la réglementation. Les créations de nouvelles pharmacies sont quasi impossibles depuis une ordonnance de 2018, faisant suite à un avis de l’Inspection générale interministérielle du secteur social (Igas). Seules les opérations de transfert (déménagement) sont autorisées et régulées, limitant leur recours. Si depuis 2023 l’article L. 162-31-1 du Code de la Sécurité sociale permet la création d’antennes de pharmacie, un local de dispensation déporté dans une autre commune, ce dispositif demeure peu usité. La première ouverture ayant eu lieu en juillet 2024.

Si la vente en ligne sur Internet est perçue comme une solution par l’Igas, celle-ci est également régulée par le Code de la santé publique, adossée à une pharmacie physique et limitée en volume de médicaments impliqués.

Il est à noter que ces enjeux spatiaux amènent principalement à une redistribution du volume d’activité. La captation d’une clientèle supplémentaire se fait au détriment des autres pharmacies, exposant à des risques de cannibalisation entre pharmacies.

Ajustement par les prix

Afin d’assurer une certaine rentabilité, les firmes peuvent adapter leurs prix. La situation des pharmacies quant à ces mécanismes dépend du type de produit.

Les produits remboursés – médicaments et dispositifs médicaux – ont un prix administré, afin de garantir l’accessibilité financière aux traitements pour la population et la société. Cette situation empêche le pharmacien d’ajuster les prix de vente et limite la friction entre pharmacies.

Le pharmacien peut toutefois « négocier » des marges arrière. Si le partage de la valeur est réglementé par des marges administrées, des possibilités de remises sont prévues et plafonnées à 40 % du prix fabricant hors taxe (PFHT). Cela permet de limiter les frictions avec les fournisseurs et le coût de négociation. Ces marges arrière constituent un moyen de soutenir les pharmacies de ville, sans affecter le prix de vente du médicament, au détriment des acteurs en amont de la fourniture de médicaments.

Les médicaments non remboursés ont un prix librement fixé par le pharmacien. L’économiste de la santé Céline Pilorge souligne que les mécanismes de compétition sur les prix sont peu effectifs, sans doute en raison de leur faible part dans le chiffre d’affaires des pharmacies. Il en est de même pour la parapharmacie qui, ne faisant pas partie du monopole pharmaceutique, fait l’objet d’une compétition avec d’autres structures que des pharmacies.

Pérennité des pharmacies en jeu

La pharmacie de ville est un offreur de soins ambulatoire important dans le système de santé. Les dynamiques macroéconomiques de longs termes soulignent la contraction du marché du médicament, principale source de revenus des pharmacies. En face à l’épuisement de mécanismes d’ajustement limités, la pérennité des pharmacies est mise en jeu.

Cette situation interroge sur le partage de la valeur, ainsi que sur le maintien d’un service de santé de proximité pour la population. De plus, la capacité à investir de nouvelles missions de prévention apparaît comme difficile, en l’absence de révision des modes de rémunération des pharmacies.

Aniss Louchez a reçu des financements de l'ISITE-ULNE pour le financement de sa thèse de recherche en économie.

12.10.2025 à 09:00

Quand une idée en économie devient populaire : les ressorts cachés de sa diffusion

Valérie Mignon, Professeure en économie, Chercheure à EconomiX-CNRS, Conseiller scientifique au CEPII, Université Paris Nanterre – Alliance Paris Lumières

Marc Joëts, Profressor of Finance and Machine Learning, IÉSEG School of Management

Texte intégral (1495 mots)

En économie, comme dans d’autres sciences, les idées les plus populaires ou les plus connues sont-elles forcément les meilleures ? La question peut sembler étonnante. Pourtant, s’interroger sur ce qui fait qu’une nouvelle idée, popularisée dans un article, prend ou pas n’est pas anodin.

Toutes les découvertes scientifiques ne connaissent pas le même destin. Certaines deviennent incontournables et marquent durablement leur discipline, tandis que d’autres tombent dans l’oubli. L’économétrie, qui constitue l’atelier statistique des sciences économiques et financières, illustre bien ce phénomène. Elle fournit les outils indispensables pour tester des hypothèses, mesurer l’impact d’une crise, évaluer une réforme fiscale ou toute autre mesure de politique économique, anticiper les mouvements des marchés financiers, etc. Sans ces méthodes, impossible de distinguer une simple coïncidence d’une véritable relation économique. Mais pourquoi certaines innovations en économétrie se diffusent-elles largement alors que d’autres restent confidentielles ou tombent dans l’oubli ?

Des idées populaires

Dans une étude récente, nous analysons plus de 17 000 articles parus entre 1980 et 2020 dans les principales revues d’économétrie afin d’identifier les « ingrédients » qui transforment une idée en « star » académique, c’est-à-dire en référence incontournable.

À lire aussi : Tuer les « zombie papers » : peut-on débarrasser la science des articles rétractés ?

Bien sûr, la qualité scientifique est une condition nécessaire et un facteur clé. Mais elle ne suffit pas. L’histoire de la science est marquée par ce que l’on appelle l’« effet Matthieu » : les chercheurs déjà reconnus ont plus de chances de voir leurs travaux cités et valorisés, indépendamment de leur qualité relative. La visibilité d’une idée dépend donc aussi d’autres facteurs.

Nous montrons ainsi que deux dimensions jouent un rôle décisif, la connectivité thématique et la connectivité sociale. La connectivité thématique renvoie au fait qu’une idée gagne en popularité lorsqu’elle relie plusieurs domaines de recherche, en construisant des ponts entre des approches distinctes (par exemple, entre modèles de volatilité et crises financières). Elle attire alors l’attention de communautés diverses, qui trouvent dans ce croisement des outils utiles à leurs propres travaux.

S’agissant de la connectivité sociale, les chercheurs bien insérés dans les réseaux académiques, souvent grâce aux collaborations et à la cosignature d’articles, voient leurs travaux circuler plus rapidement et plus largement. Publier en équipe accroît les chances d’être lu et cité, car chaque coauteur diffuse l’article dans ses propres cercles. Ainsi, une idée devient populaire quand elle agit comme un pont, à la fois entre thèmes et entre chercheurs.

Les paradoxes de la diffusion

Nos résultats révèlent toutefois un paradoxe. Plus une idée est connectée, plus elle a de chances de devenir populaire et influente… mais seulement jusqu’à un certain point. Au-delà, trop de connexions finissent par brouiller son identité et diluer son impact. Autrement dit, multiplier indéfiniment les collaborations ou les croisements disciplinaires n’assure pas automatiquement plus de succès : l’excès peut au contraire nuire à la lisibilité et à la reconnaissance d’une contribution.

De même, si la cosignature est généralement un atout et un levier puissant de visibilité, la multiplication des auteurs ne garantit pas automatiquement plus de reconnaissance et d’influence. Elle peut même parfois réduire la clarté du message ou affaiblir l’influence individuelle des chercheurs impliqués.

Une science de réseaux

Notre étude met aussi en lumière un effet de temporalité. La connectivité thématique produit ses effets rapidement, dès les premières années suivant la publication. La connectivité sociale, elle, agit davantage sur le long terme : il faut environ six ans pour que les réseaux académiques commencent à amplifier significativement la diffusion d’une idée.

Ces dynamiques différenciées permettent de mieux comprendre comment certaines contributions connaissent un succès immédiat, alors que d’autres s’installent plus progressivement dans la littérature, à mesure que les réseaux de coauteurs et de citations relaient leurs apports. Ainsi, un article novateur reliant plusieurs méthodes peut susciter rapidement l’attention, mais son inscription durable dans la littérature dépendra de la réputation et du réseau de ses auteurs.

La popularité scientifique ne dépend pas seulement de la rigueur ou de l’originalité intrinsèque des travaux. Elle repose aussi sur la capacité à s’inscrire dans des réseaux thématiques et sociaux, et à trouver le bon équilibre entre visibilité et lisibilité.

Une méthodologie originale

Pour parvenir à ces résultats, nous avons mobilisé des méthodes innovantes. À l’aide de techniques de traitement automatique du langage (Structural Topic Models), nous avons cartographié les thématiques des articles et mesuré leur connectivité. Nous avons aussi utilisé des outils d’analyse de réseaux afin de caractériser la position des chercheurs dans les structures de coauteurs. Enfin, nous avons appliqué des modèles économétriques adaptés aux données de citations, en particulier le modèle hurdle negative binomial, qui permet de tenir compte du grand nombre d’articles jamais cités et de la forte dispersion des distributions de citations.

La robustesse de nos résultats a été confirmée par des tests sur d’autres modèles statistiques et par des analyses de sensibilité, renforçant la validité des conclusions.

La finance également concernée

Ces mécanismes ne concernent pas uniquement la communauté scientifique et les revues spécialisées. L’économétrie irrigue l’ensemble de l’économie et de la finance. Ses outils et méthodes sont essentiels pour aider les banques centrales dans leurs décisions de politique monétaire, éclairer la régulation des marchés financiers ou encore évaluer les politiques publiques.

Ainsi, la diffusion, ou au contraire l’oubli, d’une idée en économétrie peut avoir des conséquences bien réelles sur la manière dont nous analysons les phénomènes économiques et dont nous gouvernons nos sociétés. Une innovation méthodologique qui se diffuse largement peut influencer la façon d’évaluer une crise, d’anticiper des bulles financières ou d’apprécier les effets de la transition énergétique.

Notre étude rappelle que la science est aussi une affaire de réseaux. Les idées les plus populaires ne sont pas nécessairement les meilleures, mais celles qui savent tisser des liens entre disciplines et circuler dans les bons cercles académiques. La prochaine grande innovation existe peut-être déjà. Reste à savoir si elle trouvera les ponts nécessaires pour devenir incontournable.

Valérie Mignon est conseiller scientifique au CEPII, membre du Cercle des économistes, présidente de la section 05 (sciences économiques) du CNU et secrétaire générale de l'AFSE.

Marc Joëts ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

12.10.2025 à 08:59

Inondations : satellites et « jumeaux numériques » pour mieux anticiper et agir vite

Raquel Rodriguez Suquet, Ingénieure d'applications d'Observation de la Terre, Centre national d’études spatiales (CNES)

Vincent Lonjou, expert applications spatiales, Centre national d’études spatiales (CNES)

Texte intégral (3370 mots)

Les précipitations violentes accroissent le risque d’inondations rapides et difficiles à prévoir. Pour mieux se préparer, il faut bien connaître le terrain. En combinant de nombreuses techniques d’imagerie satellite et de modélisation, les chercheurs et experts créent des « jumeaux numériques », c’est-à-dire des répliques virtuelles du territoire. Celles-ci permettent de mieux savoir où et quand l’eau peut monter, et quelles infrastructures sont en zone à risque.

Entre le 26 janvier et le 1er février 2025, des crues exceptionnelles ont touché le département de l’Ille-et-Vilaine avec des hauteurs d’eau record par endroits. Au total, 110 communes ont été reconnues en état de catastrophe naturelle, et des milliers de logements, commerces, entreprises, ont été sinistrés.

Un autre département fréquemment touché par les orages est celui du Var. Le département avait déjà essuyé la tempête Alex en 2020 et ses 50 centimètres de précipitations cumulées en 24 heures à Saint-Martin-Vésubie. Cette année, en mai, ce sont 25 centimètres de pluie qui sont tombés au Lavandou en une heure seulement.

Avec le changement climatique, les évènements hydrométéorologiques sont de plus en plus fréquents et de plus en plus intenses. Les inondations constituent un risque naturel majeur — 43 % des risques naturels mondiaux dans le monde entre 1995 et 2015 — avec une augmentation notable des aléas survenus au cours des dernières années.

En associant données de pointe d’observation de la Terre et modèles physiques et numériques, les jumeaux numériques permettent de mieux prédire les inondations et les risques associés, d’estimer les dommages potentiels et de concevoir des mesures de prévention efficaces pour protéger les biens et les populations.

Gestion de crise et anticipation : un rôle pour le secteur spatial en cas d’inondations

Le caractère soudain et rapide des inondations requiert une réponse très rapide des services de gestion de crise et, pour cela, une excellente préparation et anticipation des impacts potentiels de ces crises est nécessaire.

Deux principaux programmes basés sur des données d’observation de la Terre sont au service de la gestion de crise. La Charte internationale Espace et catastrophes majeures est opérationnelle depuis 2020 et met à la disposition des équipes de secours et d’urgence des images satellites dans les heures qui suivent une catastrophe majeure, n’importe où dans le monde.

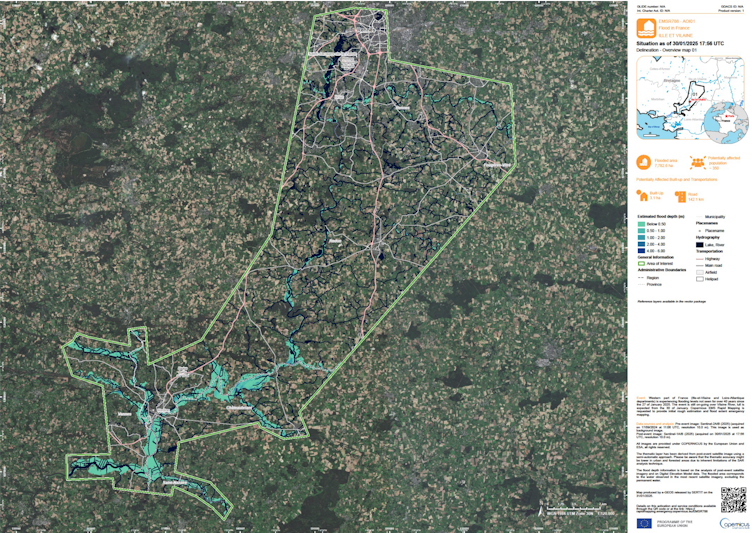

En Europe, le Copernicus Emergency Mapping Service fournit un produit de cartographie rapide en appui à la gestion de crise, et un produit de cartographie de risques et de reconstruction destiné à la prévention de risques, à la préparation de crise et à la gestion post-sinistre. Ce service a par exemple été activé par la protection civile française lors des inondations dans le département d’Ille-et-Vilaine de cette année.

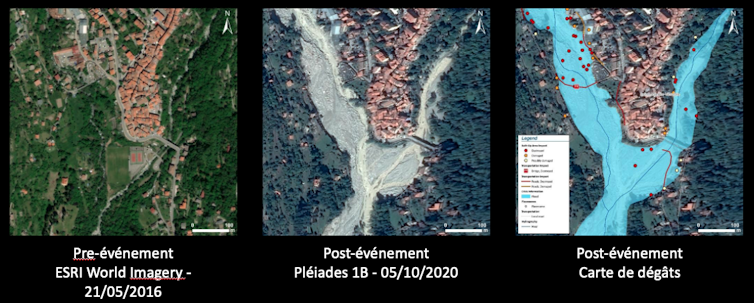

Lors de l’événement majeur concernant la tempête Alex à Saint-Martin-Vésubie en 2020, la sécurité civile française a activé également le service de cartographie rapide dès le 3 octobre 2020. Pour cet événement, le Centre national d’études spatiales (Cnes) a aussi immédiatement programmé les satellites Pléiades (capables de fournir des photographies de très haute résolution dans un temps très court) pour imager la zone pendant 8 jours minimum. Ainsi, en seulement quelques heures, de premières images ont été livrées, permettant au SERTIT de générer la cartographie des dégâts correspondante pour aider à la gestion de crise.

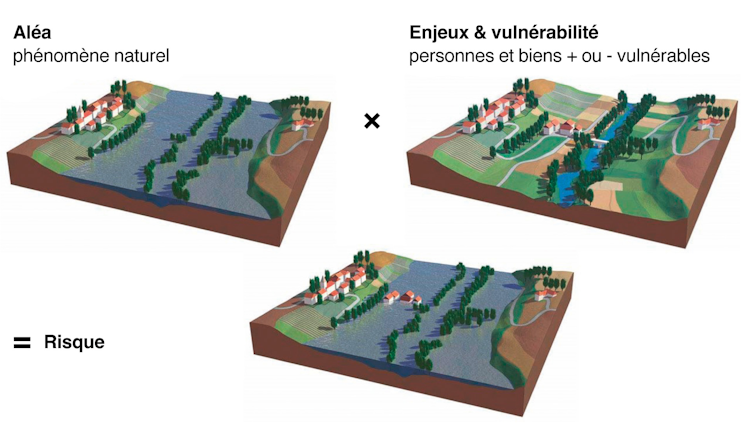

En effet, le risque d’inondation correspond à la conjugaison, en un même lieu, d’un aléa (phénomène naturel aléatoire comme l’inondation) avec les enjeux (humains, biens, économiques et environnementaux) susceptibles de subir des dommages. L’ampleur du risque dépend fortement de la vulnérabilité des enjeux exposés, autrement dit de leur résistance face à un évènement donné.

Outre le contexte climatique, les phénomènes d’inondations sont aggravés depuis des décennies par l’aménagement inadapté du territoire. Populations et biens s’accumulent dans des zones inondables, ce qui provoque notamment la construction de nouvelles routes et centres commerciaux, le développement de l’agriculture intensive, la déforestation ou encore la modification du tracé des cours d’eau. De surcroît, l’imperméabilisation des surfaces amplifie le ruissellement de l’eau et ne fait qu’aggraver encore la situation. Ces aménagements contribuent malheureusement trop souvent encore à la destruction des espaces naturels qui absorbent l’eau en cas de crues et qui sont essentiels au bon fonctionnement des cours d’eau.

Ceci nécessite d’impliquer une chaîne complexe d’acteurs — de l’observation satellite aux équipes sur le terrain.

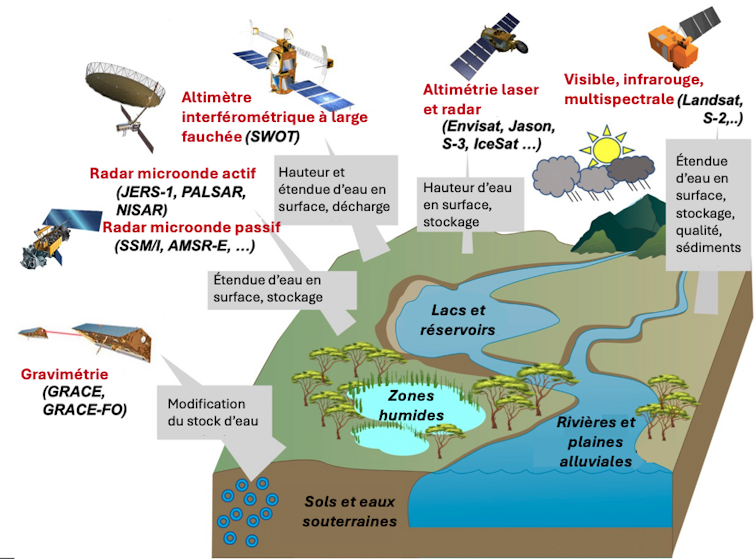

Observer la Terre pour mieux apprécier les risques d’inondation

Les impacts des inondations peuvent être réduits par une meilleure culture du risque, un système d’alerte précoce, une cartographie précise des zones à risque, des prévisions fondées sur la modélisation, ainsi que par des aménagements du territoire et des infrastructures de protection adaptée – en ligne avec la politique de prévention des risques en France.

Ces informations provenant de données (in situ, IoT, drones, satellites, aéroportées…), et de modèles physiques très précis.

Les moyens d’observation in situ permettent de faire des mesures très précises de la hauteur, du débit et de la vitesse de l’eau alors que les moyens aéroportés (drone ou avion) permettent d’observer l’étendue de l’inondation. Or, il est très compliqué – voire impossible – de faire voler un avion ou un drone dans des conditions météorologiques dégradées. Par conséquent, ces observations sont complétées depuis l’espace. Par exemple, l’imagerie radar permet de faire des observations pendant la nuit et à travers les nuages.

Les données satellites apportent de nombreuses informations, par exemple la mesure du niveau d’eau de réservoirs, l’étendue d’eau ou encore la qualité de l’eau.

Malheureusement, aujourd’hui, ces missions ont une faible résolution temporelle par rapport au besoin d’observation des inondations au moment de la crise elle-me : la fréquence de « revisite » des satellites est de quelques jours au mieux. Les satellites Sentinel 2 par exemple permettent de photographier la Terre entière en 5 jours, alors que le satellite SWOT revient sur la même zone tous les 21 jours. De plus, il n’est pas rare que les passages des satellites ne correspondent pas aux dates de pic des crues pendant la gestion de la crise.

Bien entendu, malgré ces limitations actuelles, il est clair que les données satellites sont déjà d’un grand apport pour la prévention des inondations, la préparation de la crise, et l’analyse postimpact de la crise.

Combiner les observations et faire appel aux modélisations

Aujourd’hui, c’est donc une combinaison des données in situ, drone, aéroportées et spatiales qui permet d’améliorer la description des inondations.

Mais l’observation seule ne permet pas de réaliser des prévisions fiables : l’utilisation des modèles physiques est incontournable pour mieux représenter la dynamique de l’écoulement dans son ensemble, pour faire des prévisions à court terme — ainsi que des projections à long terme sous les différents scénarios dans un climat futur.

Ces combinaisons entre données et modèles permettent de fournir des représentations précises de la dynamique d’écoulement de l’événement d’inondation ainsi que des prévisions pour simuler un comportement futur tel qu’un changement climatique, avec plusieurs scénarios possibles, ainsi que le déploiement de stratégies d’adaptations.

C’est ainsi que sont nés les « jumeaux numériques ».

Les jumeaux numériques pour les inondations

Un jumeau numérique est une combinaison d’une « réplique numérique » d’une zone réelle, associée à des capacités de modélisation et de simulation de plusieurs scénarios de phénomènes climatiques.

S’agissant des inondations, l’objectif de ces simulations est de disposer d’un outil d’aide à la décision dans toutes les phases du cycle de gestion du risque : prévention, surveillance et protection ; alerte et gestion de crise ; analyse post-crise ; reconstruction, résilience et réduction de la vulnérabilité.

Un jumeau numérique permet de faire trois familles d’analyses :

What now ? Un scénario de réanalyse des épisodes passés pour améliorer la compréhension de la dynamique des événements (plan de prévention, aménagement du territoire, assurance…) ;

What next ? Un scénario de prévision en temps réel des crues et des inondations qui représente la façon dont les inondations évolueront dans le futur à court terme à partir de l’état actuel (sécurité civile, gestion de crise…) ;

What if ? Un scénario d’évaluation de l’impact de l’inondation qui représente la façon dont le débit des cours d’eau et les étendues inondées pourraient évoluer sous différents scénarios hypothétiques dans le contexte de changement climatique.

Ainsi, l’Agence spatiale européenne (ESA) et la NASA développent des jumeaux numériques à l’échelle globale pour intégrer les données et modèles des environnements naturels et des activités humaines afin d’accompagner les politiques publiques sur les risques naturels.

À titre d’exemple, le CNES et ses partenaires ont mis en place un démonstrateur de jumeau numérique consacré à l’étude des inondations fluviales par débordement, qui permet de surveiller, détecter et prévoir de manière fiable les inondations à une échelle locale et globale, tandis qu’un autre jumeau numérique se concentre sur les zones côtières dans un contexte de changement climatique.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

12.10.2025 à 08:59

Freinage et particules fines : une pollution routière oubliée des évolutions réglementaires ?

Alice Mirailler, Ph.D. Candidate, Laboratoire de Mécanique des Contacts et des Structures LaMCoS, INSA Lyon – Université de Lyon

Ana-Maria Trunfio-Sfarghiu, Chercheuse, INSA Lyon – Université de Lyon

Texte intégral (2369 mots)

Alors que la 50e édition du salon EquipAuto, salon international des pros de l’automobile, s’ouvre à Paris ce 14 octobre, penchons-nous sur l’autre problème de pollution, grandissant, posé par toutes les voitures, même électriques : les émissions hors échappement, dues à l’usure des freins, des pneus et de la chaussée. La question est indépendante de l’enjeu de réduire les émissions à l’échappement des voitures neuves, qui ont déjà fortement diminué du fait des progrès techniques. Une norme européenne, qui doit entrer en vigueur en 2026, entend les réduire, mais sa mise en œuvre pourrait ne pas livrer les effets escomptés.

Au 1er janvier 2024, le parc routier français était constitué de 39,3 millions de voitures particulières, de 6,5 millions de véhicules utilitaires légers (VUL), de 625 000 poids lourds et de 94 000 autobus et autocars en circulation.

Dans les contextes de forte densité du trafic, les émissions polluantes liées au transport routier restent un enjeu majeur de santé publique. En France, les véhicules particuliers sont à l’origine de plus de la moitié des émissions de gaz à effet de serre du secteur des transports. En 2019, ils représentaient 26 % des émissions nationales d’oxyde d’azote (NOx), un polluant irritant pour les voies respiratoires, et 22 % des émissions nationales de CO2.

Si les émissions à l’échappement, dues à la combustion dans les moteurs, ont été progressivement réduites grâce aux normes antipollution successives, une attention croissante est désormais portée aux émissions dites hors échappement, issues notamment de l’usure des freins, des pneus et de la chaussée.

La future norme Euro 7, qui entrera en vigueur à partir de 2026, marque une étape importante en intégrant pour la première fois ces sources de pollution non négligeables… sans pour autant résoudre tous les problèmes.

Émissions hors échappement : de quoi parle-t-on ?

Au cours des dernières années, des recherches scientifiques et industrielles ont permis d’importantes diminutions des émissions à l’échappement des véhicules récents, essence ou diesel. Cela résulte de l’allègement des véhicules, de la réduction de la consommation des moteurs thermiques et de l’installation des filtres à particules (FAP) pour limiter les émissions issues de la combustion du carburant.

Ce qui pèse désormais davantage dans l’empreinte environnementale des voitures, ce sont les émissions hors échappement. Elles regroupent les particules provenant de l’abrasion des freins et des pneus ainsi que de la remise en suspension des poussières sur la chaussée au passage des véhicules.

Si elles ne représentaient que 16 % des particules avec un diamètre inférieur à 10 micromètres (μm) (PM10) totales émises par le transport routier en 1990, cette part a atteint 71 % en 2022. Pour les particules avec un diamètre inférieur à 2,5 μm, ce chiffre est passé de 9 % en 1990 à 57 % en 2022.

Or, les réduire constitue un défi : la sécurité routière dépend justement de l’adhérence des pneus et de l’efficacité du freinage – deux sources inévitables de particules.

Quel impact sur notre santé ?

Lorsque les particules émises par les véhicules sont inhalées, elles se déposent dans différentes régions du système pulmonaire en fonction de leur taille. Les plus dangereuses pour la santé sont les PM1, c’est-à-dire les particules dont le diamètre est inférieur à 1 micromètre, car elles peuvent pénétrer profondément jusqu’aux alvéoles pulmonaires.

Plusieurs études ont démontré que les particules engendrées par le freinage sont des PM1 (de diamètre inférieur à 1 micromètre), voire des particules ultrafines dans le cas des poids lourds (inférieures à 100 nanomètres) et, par conséquent, capables d’atteindre ces alvéoles.

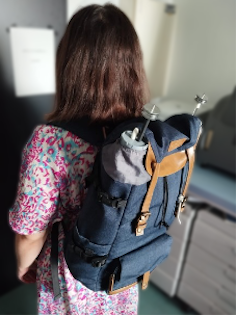

Peu d’études toutefois se sont penchées sur la toxicité des particules non issues de l’échappement sur le système pulmonaire. Pour pallier ce manque, un dispositif innovant a été développé par des scientifiques afin de collecter ces particules pendant deux heures directement dans une solution biologique.

Conçu initialement sous forme de sac à dos pour permettre la collecte en différents points de la ville de Lyon (Rhône), ce système a ensuite été adapté sur un véhicule afin de réaliser des prélèvements en conditions réelles de circulation.

Les premiers résultats suggèrent que les particules de freinage de taille inférieure à 1 micromètre (principalement composées de fer, de cuivre, de baryum et d’antimoine) pourraient présenter un risque sanitaire notable. Leur petite taille leur permet d’interagir avec le surfactant pulmonaire (c’est-à-dire, la matière tensioactive sécrétée dans les poumons) ainsi qu’avec les macrophages alvéolaires. Cette interaction pourrait induire, sur le long terme, une altération progressive de la fonction pulmonaire.

Il est possible qu’une exposition répétée à de faibles doses puisse favoriser le développement de pathologies chroniques, telles que la fibrose pulmonaire, par un processus lent d’accumulation et de réponse inflammatoire persistante.

La norme Euro 7, une réponse appropriée ?

Les émissions hors échappement seront intégrées pour la première fois dans la future norme Euro 7, ce qui constitue une avancée significative vers une évaluation plus complète et rigoureuse des sources de pollution atmosphérique liées aux véhicules.

La norme Euro 7 entrera en vigueur en novembre 2026 pour les voitures et les véhicules utilitaires légers. Pour tous les types de véhicules, la limite maximale des émissions de particules PM10 (de diamètre inférieur à 10 micromètres) serait fixée à 7 mg/km à partir de 2026 et à 3 mg/km à partir de 2035.

L’établissement de cette nouvelle norme soulève cependant une difficulté fondamentale d’ordre physique. Comme évoqué précédemment, des travaux ont démontré que les particules émises lors du freinage sont majoritairement des PM1, avec des tailles inférieures à 1 micromètre. Elles ne tombent donc pas sous le coup de cette réglementation.

De plus, ces particules présentent une masse extrêmement faible, souvent négligeable, ce qui rend les limites actuelles exprimées en milligramme par kilomètre (mg/km) peu adaptées pour quantifier précisément les émissions. Il serait donc pertinent que la réglementation évolue vers une prise en compte fondée sur le nombre de particules émises par kilomètre, afin de mieux refléter la réalité et les impacts potentiels de ces émissions ultrafines.

Les avancées scientifiques et technologiques dans la compréhension et dans la maîtrise des émissions liées au freinage progressent encore à un rythme souvent jugé insuffisant face aux exigences réglementaires et aux impératifs économiques du secteur automobile. En conséquence, les constructeurs proposent actuellement des solutions dont l’efficacité et les impacts restent encore partiellement évalués, parmi lesquelles :

le freinage électromagnétique : il réduit l’usure et les émissions en freinage normal, mais les freins mécaniques restent sollicités lors des freinages d’urgence, engendrant des émissions importantes ;

les filtres à particules à la source : ils peuvent limiter la dispersion des poussières, mais leur impact sur le contact frictionnel entre plaquette et disque – et donc, sur la sécurité – nécessite une validation rigoureuse ;

la modification des matériaux des plaquettes : elle peut réduire leur usure mais également augmenter la production de nanoparticules, dont les effets sanitaires restent mal connus et font l’objet de recherches en cours.

La mobilité électrique, pas forcément une panacée

Selon une analyse publiée par le Centre interprofessionnel technique d'études de la pollution atmosphérique (Citepa), les véhicules électriques émettent un peu moins de particules liées à l’usure des freins grâce au freinage régénératif (c’est-à-dire, s’appuyant sur un système de récupération d’énergie).

Cependant, leur masse plus importante entraîne une augmentation des émissions de particules provenant de l’abrasion des pneus et de la chaussée. Ces deux effets tendent à s’équilibrer, de sorte que les émissions totales de particules des véhicules électriques à grande autonomie sont comparables à celles des véhicules thermiques récents, qui émettent désormais très peu de particules à l’échappement.

Les véhicules électriques soulèvent, par ailleurs, d’importantes interrogations concernant la disponibilité des ressources nécessaires à la fabrication des batteries et concernant les enjeux environnementaux et techniques liés à leur recyclage.

Dès lors, la sobriété apparaît comme l’une des voies les plus cohérentes : réduire nos déplacements lorsque cela est possible et amorcer la transition d’une société centrée sur la consommation vers un modèle plus respectueux de l’environnement.

Ana-Maria TRUNFIO-SFARGHIU a reçu des financements de CNRS et Ministère de la recherche publique (financements liées à la thèse d'Alice Mirailler, son salaire et un petit accompagnement) + chaires INSA Lyon avec VOLVO et MICHELIN

Alice Mirailler ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

11.10.2025 à 09:11

Les adolescents face aux écrans, entre contrôle et « scrolling » : regards croisés de lycéens entre la France et la Chine

Runsen Cao, Doctorant en sciences de l'information et de la communication, Université Bordeaux Montaigne

Texte intégral (1415 mots)

Tout autour du monde, les écrans prennent de plus en plus de place dans la vie des jeunes. Si la manière dont ces derniers sont encadrés diffère d’un pays à l’autre, partout leurs pratiques quotidiennes des écrans les confrontent à nombre de dilemmes. C’est ce que fait ressortir une enquête auprès de lycéens français et chinois.

Le volume de temps et d’engagement consacré « aux écrans » est une des caractéristiques de la culture juvénile actuelle. Si les parents sont animés de multiples craintes concernant les smartphones et autres dispositifs numériques, cette préoccupation n’est pas réservée aux Français. En Chine, où 97,2 % des adolescents ont accès à Internet, même dans les zones rurales, protéger et éduquer les jeunes au numérique constitue également un enjeu de société fondamental.

Or, le contrôle des usages à l’école en Chine est beaucoup plus strict qu’en France. La plupart des lycées chinois interdisent totalement le téléphone personnel. Pour les élèves d’internat, certains établissements proposent des boîtes fermées à l’extérieur des salles de cours pour garder les téléphones jusqu’à la fin de journée.

Au-delà des interdictions et des discours de prévention (la « pause numérique », le rapport de la commission d’enquête parlementaire sur les effets psychologiques de TikTok sur les mineurs, publié le 11 septembre 2025, sans parler des innombrables publications sur les « dangers des écrans ») ou de répression, pourquoi ne pas consulter les adolescents eux-mêmes ? Comment vivent-ils leurs expériences du numérique au quotidien ?

La comparaison entre la France et la Chine sur ce point peut être éclairante, au regard de la différence des contextes de contrôle. Dans le cadre d’une enquête de terrain qualitative conduite auprès de lycéens dans différentes villes de France et de Chine, nous avons pu donner la parole aux adolescents d’environnements sociaux très différents, non seulement sur leurs pratiques mais aussi sur leurs ressentis et sur leurs émotions.

Ennui et sentiment de culpabilité

Pour beaucoup de lycéens français et chinois, passer du temps sur leur téléphone est devenu un automatisme, comme le dit Katherine, élève française en classe de seconde :

« En général, je pense que, lorsqu’on s’ennuie ou qu’on ne sait pas trop quoi faire, on a tout de suite le réflexe de prendre le téléphone. »

C’est particulièrement le cas dans le contexte post-pandémique, selon Xiaoke, élève chinoise de première :

« Je m’ennuyais tellement à la maison et je n’avais pas de moyen de sortir. Du coup je ne pouvais m’amuser qu’avec les produits électroniques*. »

S’ils profitent d’une riche palette de divertissements grâce aux technologies, aux jeux vidéo, aux vidéos (aussi bien les courtes, appelées « shorts », au format vertical, que les longues) ou encore aux messages échangés avec des amis – comme résumé dans l’expression chinoise « jouer (玩 wán) avec le téléphone », qui renvoie à toute activité récréative sur le téléphone (regarder, scroller ou encore « être sur son téléphone » pour la France) –, les adolescents n’entretiennent pas uniquement un rapport ludique au numérique. Ils font la distinction entre ce qui est purement divertissant et ce qui est éventuellement utilitaire, non seulement pour le travail scolaire, mais également pour nourrir leur curiosité sur le monde.

C’est le cas pour cet élève français de terminale, qui perfectionne son anglais à travers la série Peaky Blinders, ou encore pour Hang, élève chinois en première, qui s’intéresse aux vidéos de vulgarisation de savoirs en mathématiques et en philosophie, sur Bilibili (plateforme vidéo chinoise).

Ils sont souvent confrontés à des dilemmes quant à leurs propres usages, mais pas forcément de la même manière. Les lycéens français, qui ont souvent moins de contraintes dans l’usage de leur téléphone, ont conscience d’un usage parfois excessif, notamment à travers le scrolling, qui représente pour certains, comme pour cette élève française en première, une perte de temps :

« Ça ne fait rien, à part bouffer mon temps et mon cerveau. »

Toutefois, il est souvent difficile pour eux de s’arrêter, comme le soulignent beaucoup de recherches, avec le développement d’un sentiment de culpabilité. C’est ce qu’éprouve cette élève française en terminale, qui compense ce sentiment par une stratégie qui consiste à regarder plus de contenus éducatifs et culturels :

« J’essaie de me limiter, je regarde des vidéos culturelles sur YouTube. »

Des « usages de revanche »

Pour les lycéens chinois, face à la réglementation très stricte des usages du téléphone, le dilemme porte sur le choix d’utiliser ou non son téléphone en cachette. La plupart des élèves enquêtés avouent qu’ils ont apporté leur téléphone au lycée malgré l’interdiction. Mais ils ne parviennent pas à en profiter, comme en témoigne un élève chinois en première :

« Autant ne pas l’amener, vu que je n’en profite même pas. »

L’interdiction totale suscite parfois des « usages de revanche », comme évoqué par Lan, lycéen en internat, qui passe quasiment tout son dimanche sur le téléphone, étant donné son usage très limité en cachette dans la semaine.

D’ailleurs, une forme de jeu de cache-cache se met souvent en place avec les parents. Certains, comme Yuan, également en internat, se plaignent d’avoir été « trahis » par les parents qui ont prévenu le lycée qu’il avait probablement apporté son smartphone, car ils ne le trouvaient pas à la maison. D’autres, comme Wan, lycéenne en internat, se félicitent du soutien des parents qui comprennent son besoin de lignes de fuite après une journée d’étude fatigante. Les usages du téléphone reflètent donc aussi la qualité des rapports de confiance avec les parents.

Entre introspection, discipline et contrôle extérieur, les lycéens construisent leur rapport au numérique sous contrainte dans des contextes sociaux différents. L’éducation consiste, pour Kant, en soins, discipline culture. Le philosophe privilégie la référence à cette dernière par rapport aux deux premières. La culture pourrait devenir un point de départ pour repenser l’éducation à l’ère du numérique.

Les jeunes en fin d’adolescence sont non seulement des mineurs dont les pratiques numériques sont à réguler et à éduquer de manière normative, mais également et surtout des sujets en train de se construire à partir d’expériences informationnelles très diverses, qui méritent une attention fine, au-delà des discours de panique. Ces expériences, dans leur diversité, sont largement comparables, voire communes, dépassant les différences des contextes culturels et normatifs.

N. B. : Les prénoms des jeunes cités dans cet article ont été changés pour préserver leur anonymat.

*« Produits électroniques »: l’expression désigne en langue chinoise tous les appareils connectés à Internet.

Runsen Cao ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

11.10.2025 à 08:34

Un sommeil de mauvaise qualité peut accélérer le vieillissement cérébral, selon une nouvelle étude

Abigail Dove, Postdoctoral Researcher, Neuroepidemiology, Karolinska Institutet

Texte intégral (1675 mots)

Une nouvelle étude révèle qu’un sommeil de mauvaise qualité pourrait faire vieillir le cerveau plus vite qu’il ne le devrait – un effet mesurable grâce à l’imagerie cérébrale et lié, en partie, à l’inflammation.

Nous passons près d’un tiers de notre vie à dormir, mais le sommeil est tout sauf une perte de temps. Ce n’est pas une période d’inactivité, mais un processus actif et essentiel qui restaure le corps et protège le cerveau. Lorsque le sommeil est perturbé, le cerveau en subit les conséquences – parfois subtiles, mais qui s’accumulent au fil des années.

Dans une nouvelle étude, mes collègues et moi avons analysé les habitudes de sommeil et les données d’IRM cérébrale de plus de 27 000 adultes britanniques âgés de 40 à 70 ans. Nous avons constaté que les personnes dormant mal présentaient un cerveau qui paraissait sensiblement plus âgé que leur âge réel ne le laisserait supposer.

Mais que signifie exactement le fait qu’un cerveau « paraisse plus vieux » ? Si nous vieillissons tous au même rythme chronologique, notre horloge biologique, elle, peut avancer plus ou moins vite. Grâce aux progrès récents de l’imagerie cérébrale et de l’intelligence artificielle, il est désormais possible aux chercheurs d’estimer l’« âge cérébral » d’une personne à partir des schémas visibles sur ses IRM — tels que la perte de tissu cérébral, l’amincissement du cortex ou encore les lésions des vaisseaux sanguins.

Dans notre étude, cet âge cérébral a été estimé à partir de plus de 1 000 marqueurs d’imagerie. Nous avons d’abord entraîné un modèle d’apprentissage automatique sur les scans des participants les plus en bonne santé — ceux dont le cerveau correspondait le mieux à leur âge chronologique. Une fois le modèle capable de reconnaître les signes d’un vieillissement « normal », nous l’avons appliqué à l’ensemble de la cohorte.

Un âge cérébral supérieur à l’âge réel peut signaler un écart par rapport à un vieillissement sain. Des travaux antérieurs ont déjà établi qu’un cerveau d’apparence plus âgée est associé à un déclin cognitif accéléré, à un risque accru de démence et même à une mortalité prématurée plus élevée.

Le sommeil est un phénomène complexe, et aucune mesure isolée ne peut à elle seule refléter sa qualité globale. Nous nous sommes donc concentrés sur cinq aspects du sommeil autorapportés par les participants : leur chronotype (plutôt « matinal » ou « nocturne »), la durée habituelle du sommeil (de sept à huit heures étant considérées comme optimale), la présence d’insomnie, le ronflement et la somnolence diurne excessive.

Ces facteurs peuvent interagir entre eux. Par exemple, une personne souffrant d’insomnie fréquente peut également ressentir une somnolence diurne plus importante, et avoir un chronotype tardif peut entraîner une durée de sommeil plus courte. En combinant ces cinq paramètres dans un « score de sommeil sain », nous avons obtenu une vision plus complète de la santé globale du sommeil.

Les participants présentant quatre ou cinq comportements sains formaient le groupe au sommeil « sain », ceux ayant deux ou trois comportements sains constituaient le groupe « intermédiaire », et ceux n’en présentant aucun ou un seul appartenaient au groupe au sommeil « médiocre ».

Les résultats étaient clairs : pour chaque point perdu au score de sommeil sain, l’écart entre l’âge cérébral et l’âge chronologique augmentait d’environ six mois. En moyenne, les personnes au sommeil médiocre avaient un cerveau paraissant presque un an plus vieux que prévu, alors que celles au sommeil sain ne présentaient pas de tel écart.

En analysant chaque paramètre séparément, nous avons observé que le chronotype tardif et une durée de sommeil anormale étaient les principaux contributeurs à un vieillissement cérébral accéléré.

Un an peut sembler peu, mais en matière de santé cérébrale, c’est significatif. Même de légères accélérations du vieillissement du cerveau peuvent, à long terme, accroître le risque de déclin cognitif, de démence et d’autres troubles neurologiques.

La bonne nouvelle, c’est que les habitudes de sommeil peuvent être modifiées. Bien que tous les troubles du sommeil ne soient pas faciles à corriger, quelques stratégies simples — maintenir un horaire de coucher régulier, limiter la consommation de caféine, d’alcool et l’utilisation d’écrans avant le coucher, et favoriser un environnement calme et sombre — peuvent améliorer la qualité du sommeil et protéger la santé du cerveau.

Comment le sommeil influence-t-il la santé du cerveau ?

Une explication pourrait résider dans l’inflammation. De plus en plus de preuves indiquent que les troubles du sommeil augmentent le niveau d’inflammation dans l’organisme, ce qui peut nuire au cerveau en endommageant les vaisseaux sanguins, en favorisant l’accumulation de protéines toxiques et en accélérant la mort des cellules cérébrales.

Nous avons pu explorer ce lien grâce aux échantillons sanguins collectés au début de l’étude sur les participants, riches en informations sur différents biomarqueurs inflammatoires. En les intégrant à nos analyses, nous avons constaté que l’inflammation expliquait environ 10 % du lien entre le sommeil et le vieillissement cérébral.

D’autres mécanismes pourraient aussi intervenir

Une autre piste concerne le système glymphatique – le réseau de nettoyage des déchets du cerveau, principalement actif durant le sommeil. Lorsque celui-ci est perturbé ou insuffisant, ce système fonctionne moins bien, laissant s’accumuler des substances nocives.

Il est également possible que le fait de mal dormir augmente le risque d’autres pathologies néfastes pour le cerveau, notamment le diabète de type 2, l’obésité ou les maladies cardiovasculaires.

Notre étude, l’une des plus vastes et complètes du genre, s’appuie sur une population importante, une approche multidimensionnelle de la qualité du sommeil et une estimation détaillée de l’âge cérébral fondée sur des milliers d’indicateurs IRM. Bien que des recherches antérieures aient déjà montré qu’un sommeil de mauvaise qualité est associé au déclin cognitif et à la démence, notre recherche montre aussi qu’il est lié à un cerveau qui semble plus âgé, ce qui est dû, en partie, à l’inflammation.

Le vieillissement cérébral est inévitable, mais nos comportements et nos choix de mode de vie peuvent influencer son évolution. Les implications de nos recherches sont claires : pour préserver la santé de notre cerveau, faisons du sommeil une priorité.

Abigail Dove bénéficie d'un financement de la part d'Alzheimerfonden, Demensfonden et de la Fondation Loo et Hans Osterman pour la recherche médicale.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Lava

- La revue des médias

- Le Grand Continent

- Le Diplo

- Le Nouvel Obs

- Lundi Matin

- Mouais

- Multitudes

- Politis

- Regards

- Smolny

- Socialter

- The Conversation

- UPMagazine

- Usbek & Rica

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- Contretemps

- A Contretemps

- Alter-éditions

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- Philo Mag

- Terrestres

- Vie des Idées

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview

- Fiabilité 3/5

- Slate

- Ulyces

- Fiabilité 1/5

- Contre-Attaque

- Issues

- Korii

- Positivr

- Regain